模式识别第三章

梯度法和准则函数

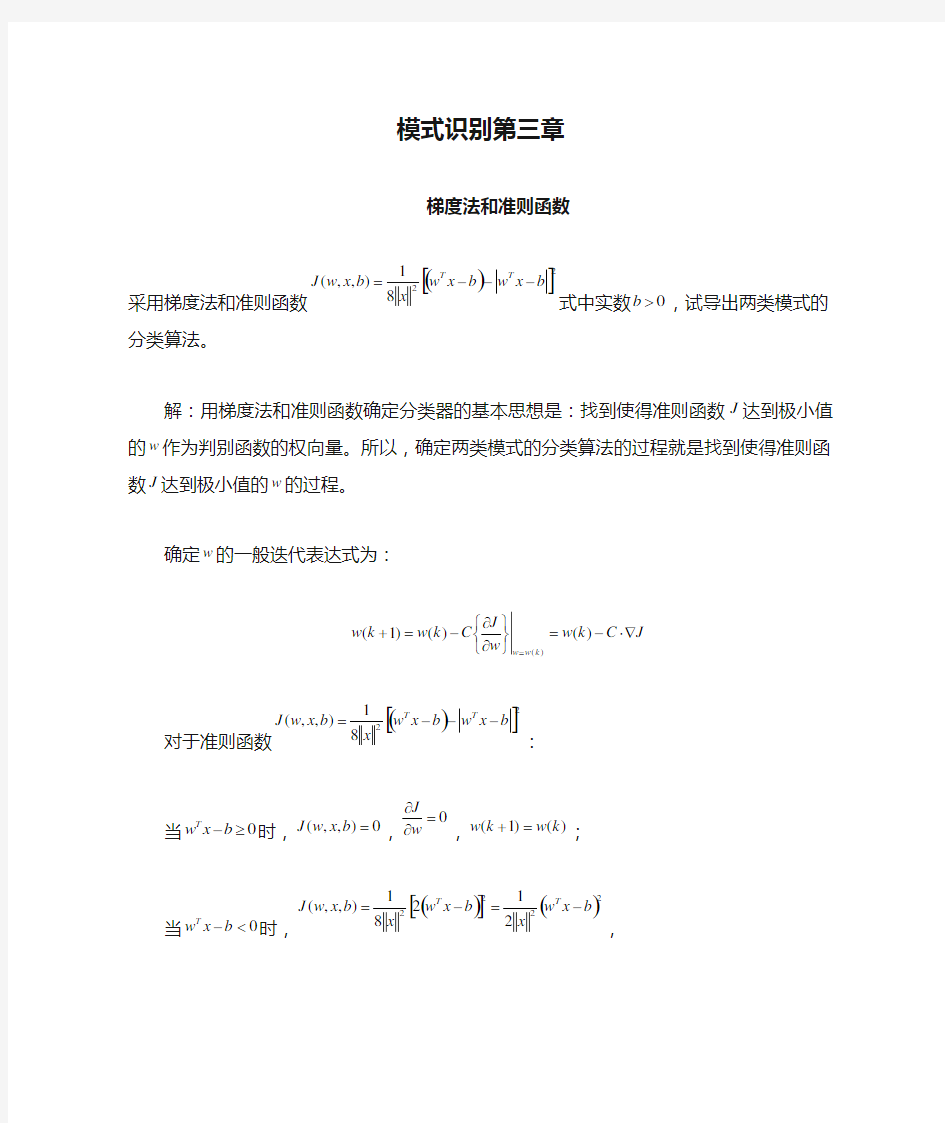

采用梯度法和准则函数()[]2

281

),,(b x w b x w x b x w J T T ---=式中实数0>b ,试导出两类模式的分类算法。

解:用梯度法和准则函数确定分类器的基本思想是:找到使得准则函数J 达到极小值的w 作为判别函数的权向量。所以,确定两类模式的分类算法的过程就是找到使得准则函数J 达到极小值的w 的过程。

确定w 的一般迭代表达式为:

J C k w w J C k w k w k w w ??-=????????-=+=)()()1()

( 对于准则函数()[]2281),,(b x w b x w x b x w J T T ---=

: 当0≥-b x w T 时,0),,(=b x w J ,0=??w

J ,)()1(k w k w =+; 当0<- b x w T 时,()[]()2

22221

281

),,(b x w x b x w x b x w J T T -=-=, ()

x b x w x w J T -=??21, ()x b x w x C k w k w T

-?-=+21

)()1(。 综上所述,()?????<--≥--=+0)(,)(10)(,0)()1(2b x k w if x b x k w x b x k w if C k w k w T T T

·在一个10类的模式识别问题中,有3类单独满足多类情况1,其余的类别满足多类情况2。问该模式识别问题所需判别函数的最少数目是多少? 应该是252142 6 *74132 7=+=+ =++C 其中加一是分别3类 和 7类 ·一个三类问题,其判别函数如下: d1(x)=-x1, d2(x)=x1+x2-1, d3(x)=x1-x2-1 (1)设这些函数是在多类情况1条件下确定的,绘出其判别界面和每一个模式类别的区域。 (2)设为多类情况2,并使:d12(x)= d1(x), d13(x)= d2(x), d23(x)= d3(x)。绘出其判别界面和多类情况2的区域。

(3)设d1(x), d2(x)和d3(x)是在多类情况3的条件下确定的,绘出其判别界面和每类的区域。 ·两类模式,每类包括5个3维不同的模式,且良好分布。如果它们是线性可分的,问权向量至少需要几个系数分量?假如要建立二次的多项式判别函数,又至少需要几个系数分量?(设模式的良好分布不因模式变化而改变。) 如果线性可分,则4个 建立二次的多项式判别函数,则102 5 C 个 ·(1)用感知器算法求下列模式分类的解向量w: ω1: {(0 0 0)T , (1 0 0)T , (1 0 1)T , (1 1 0)T } ω2: {(0 0 1)T , (0 1 1)T , (0 1 0)T , (1 1 1)T } 将属于ω2的训练样本乘以(-1),并写成增广向量的形式。 x ①=(0 0 0 1)T , x ②=(1 0 0 1)T , x ③=(1 0 1 1)T , x ④=(1 1 0 1)T x ⑤=(0 0 -1 -1)T , x ⑥=(0 -1 -1 -1)T , x ⑦=(0 -1 0 -1)T , x ⑧=(-1 -1 -1 -1)T 第一轮迭代:取C=1,w(1)=(0 0 0 0) T 因w T (1) x ① =(0 0 0 0)(0 0 0 1) T =0 ≯0,故w(2)=w(1)+ x ① =(0 0 0 1) 因w T (2) x ② =(0 0 0 1)(1 0 0 1) T =1>0,故w(3)=w(2)=(0 0 0 1)T 因w T (3)x ③=(0 0 0 1)(1 0 1 1)T =1>0,故w(4)=w(3) =(0 0 0 1)T 因w T (4)x ④=(0 0 0 1)(1 1 0 1)T =1>0,故w(5)=w(4)=(0 0 0 1)T 因w T (5)x ⑤=(0 0 0 1)(0 0 -1 -1)T =-1≯0,故w(6)=w(5)+ x ⑤=(0 0 -1 0)T 因w T (6)x ⑥=(0 0 -1 0)(0 -1 -1 -1)T =1>0,故w(7)=w(6)=(0 0 -1 0)T 因w T (7)x ⑦=(0 0 -1 0)(0 -1 0 -1)T =0≯0,故w(8)=w(7)+ x ⑦=(0 -1 -1 -1)T 因w T (8)x ⑧=(0 -1 -1 -1)(-1 -1 -1 -1)T =3>0,故w(9)=w(8) =(0 -1 -1 -1)T 因为只有对全部模式都能正确判别的权向量才是正确的解,因此需进行第二轮迭代。 第二轮迭代: 因w T (9)x ①=(0 -1 -1 -1)(0 0 0 1)T =-1≯0,故w(10)=w(9)+ x ① =(0 -1 -1 0)T

第四章 判别分析 一、填空题 1.进行判别分析时,通常指定一种判别准则,用来判定新样本的归属,按照判 别准则的不同,又有多种判别方法,其中常用的方法有______ _____ _ 、____________ _、 、和 。 2.判别分析按判别的组数来区分,有 和 ;按区分不同总体的所用的数学模型来分,有 和 。 3.Fisher 判别是借助于 的思想,来导出 和建立判别准则。 4.判别分析是根据已掌握的、历史上每个类别的若干样本的数据信息,总结出客观事物分类的规律性,建立 和 。 5.在进行距离判别时,通常采用的距离是 ,它的基本公式为: 。 二、判断题 1.在正态等协差阵的条件下,Bayes 线性判别函数等价于距离判别准则。 ( ) 2.费歇判别和距离判别都对判别变量的分布类型没有要求。 ( ) 3.只有当两个总体的均值有显著差异时,做判别分析才有意义。( ) 4.如果()x ?是费歇判别准则的判别函数,则对于任何β与任意常数γ来说,()γβ?+x 也都是它的线性函数。 ( ) 5.Bayes 判别不仅考虑了各个总体出现的先验概率,而且也考虑到了错判所造成的损失。( ) 6.在进行两类判别时,两总体的协差阵如果相等,那么费歇判别与距离判别是等价的。( ) 7.逐步判别法中筛选变量的过程实质上就是作假设检验,通过检验找出显著变量,剔除不显著变量。( ) 8.在进行距离判别时,通常采用的是马氏距离。( ) 9.设k R R ,,1 为p 维空间p R 上的k 个子集,而且要求互不相交,它们的和集为 p R ,则称k R R ,,1 为p R 的一个划分。而Bayes 判别实质上就是找这个划分。 ( ) 三、简答题 1. 判别分析和聚类分析有何区别与联系?

第四章 函数的连续性 §1 连续性概念 Ⅰ. 教学目的与要求 理解函数连续性的概念(含左连续与右连续),会判别函数间断点的类型. Ⅱ. 教学重点与难点: 重点: 函数连续性的概念. 难点: 函数连续性的概念. Ⅲ. 讲授内容 连续函数是数学分析中着重讨论的一类函数. 从几何形象上粗略地说,连续函数在坐标平面上的图象是一条连绵不断的曲线.当然我 们不能满足于这种直观的认识,而应给出函数连续性的精确定义,并由此出发研究连续函数 的性质.本节中先定义函数在一点的连续性和在区间上的连续性. 一 函数在一点的连续性 定义1 设函数f 在某U ()0x 内有定义.若()x f x x 0 lim →=()0x f , 则称f 在点0x 连续. 例如,函数连续()x f 12+=x 在点2=x 连续,因为 2lim →x ()x f =2 lim →x ()()2512f x ==+ 又如,函数()x f ???=0 ,00,1sin =≠x x x x ,在点0=x 连续,因为 ()()001sin lim lim 00f x x x f x x ===→→ 为引入函数()x f y =在点0x 连续的另一种表述,记0x x x -=?,称为自变量x (在点 0x )的增量或改变量.设()00x f y =,相应的函数y (在点0x )的增量记为: ()()()()0000y y x f x x f x f x f y -=-?+=-=? 注 自变量的增量x ?或函数的增量y ?可以是正数,也可以是0或负数.引进了增 量的概念之后,易见“函数()x f y =在点0x 连续”等价于0lim 0 =?→?y x . 由于函数在一点的连续性是通过极限来定义的,因而也可直接用δε-方式来叙述, 即:若对任给的0>ε,存在0>δ,使得当δ<-0x x 时有 ()()ε<-0x f x f (2) 则称函数f 在点0x 连续.

模式识别大作业 班级 021252 姓名 谭红光 学号 02125128 1.线性投影与Fisher 准则函数 各类在d 维特征空间里的样本均值向量: ∑∈= i k X x k i i x n M 1 ,2,1=i (1) 通过变换w 映射到一维特征空间后,各类的平均值为: ∑∈= i k Y y k i i y n m 1,2,1=i (2) 映射后,各类样本“类内离散度”定义为: 22 ()k i i k i y Y S y m ∈= -∑,2,1=i (3) 显然,我们希望在映射之后,两类的平均值之间的距离越大越好,而各类的样本类内离 散度越小越好。因此,定义Fisher 准则函数: 2 1222 12||()F m m J w s s -= + (4) 使F J 最大的解* w 就是最佳解向量,也就是Fisher 的线性判别式. 从 )(w J F 的表达式可知,它并非w 的显函数,必须进一步变换。 已知: ∑∈= i k Y y k i i y n m 1,2,1=i , 依次代入上两式,有: i T X x k i T k X x T i i M w x n w x w n m i k i k === ∑∑∈∈)1 (1 ,2,1=i (5) 所以:2 21221221||)(||||||||M M w M w M w m m T T T -=-=- w S w w M M M M w b T T T =--=))((2121 (6)

其中:T b M M M M S ))((2121--= (7) b S 是原d 维特征空间里的样本类内离散度矩阵,表示两类均值向量之间的离散度大 小,因此,b S 越大越容易区分。 将(4.5-6) i T i M w m =和(4.5-2) ∑∈= i k X x k i i x n M 1代入(4.5-4)2i S 式中: ∑∈-= i k X x i T k T i M w x w S 22)( ∑∈?--? =i k X x T i k i k T w M x M x w ))(( w S w i T = (8) 其中:T i X x k i k i M x M x S i k ))((--= ∑=,2,1=i (9) 因此:w S w w S S w S S w T T =+=+)(212221 (10) 显然: 21S S S w += (11) w S 称为原d 维特征空间里,样本“类内离散度”矩阵。 w S 是样本“类内总离散度”矩阵。 为了便于分类,显然 i S 越小越好,也就是 w S 越小越好。

学科分类号:___________ 学院 本科学生毕业设计 题目名称:浅析函数连续与一致连续性的判定学生姓名:学号: 系部:数学与应用数学系 专业年级:应用数学专业 指导教师: 2008年5 月9 日

目录 摘要 (1) 关键词 (1) Abstract (1) Key words (1) 1前言 (2) 2函数 (2) 2.1 函数连续性的定义 (2) 2.2 函数在区间上的连续性判定 (3) 2.3 判断函数的连续性常用方法 (4) 2.4 初等函数的连续性 (6) 3 函数的一致连续性 (7) 3.1 函数一致连续性定义 (7) 3.2 函数在任意区间上的一致连续性的判定 (8) 3.3 两种常用的判别方法 (9) 3.4 函数一致连续性的几个条件 (11) 4 函数连续与一致连续性的关系 (14) 5 总结 (16) 参考文献: (17) 致谢 (17)

浅析函数连续与一致连续性的判定 摘要:本文首先从连续函数的定义和连续性定理出发,给出了各种区间上函数连续的条件,并且总结了判断函数连续性的常用方法。然后给出了一致连续函数的定义及相关定理。从G﹒康托尔定理出发,给出了两个关于一致连续性的十分重要的判别方法,并说明了使用一致连续性的充要条件来讨论函数在区间上的一致连续性的方法。最后我们从两者的概念出发,深刻地揭示了它们之间的内在联系,更加深入地理解和掌握函数的连续性与一致连续性。 关键词:初等函数;区间;连续;一致连续;非一致连续 Simply analyze the judgment of function’ continuity and consistent continuity Abstract:Firstly, this article is proceed from the definition of conditions of continuous function and continuity theorem, providing with kinds of function continuously in intervals, and also it summarized the conventional methods of judge function continuity. Then it gives out the definition and some relevant theorems of consistent function. With the G.. cantor theorem, it gives two vital important discriminate methods with were concerned with consistent continuity and it illustrated abundant conditions of using consistent continuity functions in interval. Finally, starting from these two conceptions, it reveals their inner relation profoundly and it makes us understand master continuity and consistent continuity of function more penetrate. Key words: elementary function; interval; continuous; consistent continuous; no consistent continuous

第5章:线性判别函数 第一部分:计算与证明 1. 有四个来自于两个类别的二维空间中的样本,其中第一类的两个样本为(1,4)T 和(2,3)T ,第二类的两个样本为(4,1)T 和(3,2)T 。这里,上标T 表示向量转置。假设初始的权向量a=(0,1)T ,且梯度更新步长ηk 固定为1。试利用批处理感知器算法求解线性判别函数g(y)=a T y 的权向量。 解: 首先对样本进行规范化处理。将第二类样本更改为(4,1)T 和(3,2)T .然后计算错分样本集: g(y 1)=(0,1)(1,4)T = 4 > 0 (正确) g(y 2)=(0,1)(2,3)T = 3 > 0 (正确) g(y 3)=(0,1)(-4,-1)T = -1 < 0 (错分) g(y 4)=(0,1)(-3,-2)T = -2 < 0 (错分) 所以错分样本集为Y={(-4,-1)T ,(-3,-2)T }. 接着,对错分样本集求和:(-4,-1)T +(-3,-2)T = (-7,-3)T 第一次修正权向量a ,以完成一次梯度下降更新:a=(0,1)T + (-7,-3)T =(-7,-2)T 再次计算错分样本集: g(y 1)=(-7,-2)(1,4)T = -15 <0 (错分) g(y 2)=(-7,-2)(2,3)T = -20 < 0 (错分) g(y 3)=(-7,-2)(-4,-1)T = 30 > 0 (正确) g(y 4)=(-7,-2)(-3,-2)T = 25 > 0 (正确) 所以错分样本集为Y={(1,4)T ,(2,3)T }. 接着,对错分样本集求和:(1,4)T +(2,3)T = (3,7)T 第二次修正权向量a ,以完成二次梯度下降更新:a=(-7,-2)T + (3,7)T =(-4,5)T 再次计算错分样本集: g(y 1) = (-4,5)(1,4)T = 16 > 0 (正确) g(y 2) =(-4,5)(2,3)T = 7 > 0 (正确) g(y 3) =(-4,5)(-4,-1)T = 11 > 0 (正确) g(y 4) =(-4,5)(-3,-2)T = 2 > 0 (正确) 此时,全部样本均被正确分类,算法结束,所得权向量a=(-4,5)T 。 2. 在线性感知算法中,试证明引入正余量b 以后的解区(a T y i ≥b)位于原来的解区之中(a T y i >0),且与原解区边界之间的距离为b/||y i ||。 证明:设a*满足a T y i ≥b,则它一定也满足a T y i >0,所以引入余量后的解区位于原来的解区a T y i >0之中。 注意,a T y i ≥b 的解区的边界为a T y i =b,而a T y i >0的解区边界为a T y i =0。a T y i =b 与a T y i =0两个边界之间的距离为b/||y i ||。(因为a T y i =0过坐标原点,相关于坐标原点到a T y i =b 的距离。) 3. 试证明感知器准则函数正比于被错分样本到决策面的距离之和。 证明:感知器准则函数为: ()() T Y J ∈=-∑y a a y 决策面方程为a T y=0。当y 为错分样本时,有a T y ≤0。此时,错分样本到决策面的

第五章作业: 作业一: 设有如下三类模式样本集ω1,ω2和ω3,其先验概率相等,求S w 和S b ω1:{(1 0)T , (2 0) T , (1 1) T } ω2:{(-1 0)T , (0 1) T , (-1 1) T } ω3:{(-1 -1)T , (0 -1) T , (0 -2) T } 答案: 由于三类样本集的先验概率相等,则概率均为1/3。 多类情况的类内散布矩阵,可写成各类的类内散布矩阵的先验概率的加权和,即: ∑∑=== --= c i i i T i i c i i w C m x m x E P S 1 1 }|))(({)(ωω 其中C i 是第i 类的协方差矩阵。 其中1m = ,2m = 则=++=321S w w w w S S S 1/3 + + = 类间散布矩阵常写成: T i i c i i b m m m m P S ))(()(001 --= ∑=ω 其中,m 0为多类模式(如共有c 类)分布的总体均值向量,即:

c i m P x E m i c i i i ,,2,1,,)(}{1 0K =?= =∑=ωω 0m = = 则 T i i c i i b m m m m P S ))(()(001 --= ∑=ω=++ = 作业二: 设有如下两类样本集,其出现的概率相等: ω1:{(0 0 0)T , (1 0 0) T , (1 0 1) T , (1 1 0) T } ω2:{(0 0 1)T , (0 1 0) T , (0 1 1) T , (1 1 1) T } 用K-L 变换,分别把特征空间维数降到二维和一维,并画出样本在该空间中的位置。 答案: =+=∑∑==i i N j j N j j x x m 1 21 1)4 1 4 1 ( 21 将所有这些样本的各分量都减去0.5,便可以将所有这些样本 的均值移到原点,即(0,0,0)点。 新得到的两类样本集为:

模式识别大作业 一.K均值聚类(必做,40分) 1.K均值聚类的基本思想以及K均值聚类过程的流程图; 2.利用K均值聚类对Iris数据进行分类,已知类别总数为3。给出具体的C语言代码, 并加注释。例如,对于每一个子函数,标注其主要作用,及其所用参数的意义,对程序中定义的一些主要变量,标注其意义; 3.给出函数调用关系图,并分析算法的时间复杂度; 4.给出程序运行结果,包括分类结果(只要给出相对应的数据的编号即可)以及循环 迭代的次数; 5.分析K均值聚类的优缺点。 二.贝叶斯分类(必做,40分) 1.什么是贝叶斯分类器,其分类的基本思想是什么; 2.两类情况下,贝叶斯分类器的判别函数是什么,如何计算得到其判别函数; 3.在Matlab下,利用mvnrnd()函数随机生成60个二维样本,分别属于两个类别(一 类30个样本点),将这些样本描绘在二维坐标系下,注意特征值取值控制在(-5,5)范围以内; 4.用样本的第一个特征作为分类依据将这60个样本进行分类,统计正确分类的百分 比,并在二维坐标系下将正确分类的样本点与错误分类的样本点用不同标志(正确分类的样本点用“O”,错误分类的样本点用“X”)画出来; 5.用样本的第二个特征作为分类依据将这60个样本再进行分类,统计正确分类的百分 比,并在二维坐标系下将正确分类的样本点与错误分类的样本点用不同标志画出来; 6.用样本的两个特征作为分类依据将这60个样本进行分类,统计正确分类的百分比, 并在二维坐标系下将正确分类的样本点与错误分类的样本点用不同标志画出来; 7.分析上述实验的结果。 8.60个随即样本是如何产生的的;给出上述三种情况下的两类均值、方差、协方差矩 阵以及判别函数; 三.特征选择(选作,15分) 1.经过K均值聚类后,Iris数据被分作3类。从这三类中各选择10个样本点; 2.通过特征选择将选出的30个样本点从4维降低为3维,并将它们在三维的坐标系中

§2. 凹函数定义及其判定方法2.1 凹函数定义 1.一元凹凸函数定义(y=f(x)) t[0,1]且满足 ①如果对任意∈ X1,X2D(函数定义域),都存在∈ 则称该函数为凹函数。 E.g. 生产函数(生产可能性边际) t[0,1]且满足 X1,X2D(函数定义域),都存在∈ ②如果对任意∈ 则称该函数为凸函数。 E.g. y=1/x 从函数图像任意点的切线判断函数凹凸性: ①凹函数图像上任意点的切线都在图形之上。 ②函数图像上任意点的切线都在图形之下。 2.2 凸集的定义(注;没有凹集) t[0,1]且满足 X1,X2集合S,都存在∈ 如果对任意∈ 则成S为凸集。(任意两点的连线仍在集合内) 推论:f(X)为凹函数是f(X)的上等高集为凸集的充分非必要条件 E.g. 注:f(X)为拟凹函数是f(X)的上等高集为凸集的充分必要条件 2.3 多元情况下(n维空间R)凹函数的判定 以二元为例 E.g. 效用函数(无差异曲线)U(X1,X2) 1)任意点的切平面在图形之上 2)凹函数Hessian矩阵为半负定的 三个概念 ①凹函数——Hessian矩阵半负定 ②严格凹函数——Hessian矩阵负定 ③拟凹函数——加边Hessian矩阵半负定

<结论> 2.4 雅可比矩阵与Hessian矩阵 1)雅可比矩阵 2)Hessian矩阵及其顺序子式 3)顺序子式负半定的充要条件是:所有奇数阶顺序子式行列式小于等于零,所有偶数阶顺序子式行列式大于等于零(先负后正符号间隔) 4)加边Hessian矩阵及其顺序子式 加边Hessian矩阵是Hessian矩阵增广一行一列。 例1 判定函数f(x,y)=xy(x>0,y>0)的凹凸性? 2.5 加边Hessian矩阵的应用——条件极值 在判断一元函数y=f(x)最值时,不仅要满足一阶条件:(极大值&极小值) 还要满足二阶条件:(最大值)(最小值) 同样地,在n元函数y=f(X)中,我们可以用矩阵给出一个紧致的表达式。我们要做的就是在原Hessian矩阵的基础上添加几行几列,然后分析这个增广后的矩阵。 例如:我们最大化y=f(X1,X2,…..Xn),其自变量满足约束条件: g(X1,X2,…..Xn)=0 用拉格朗日乘数法进行求解,条件极值的一阶条件 二阶条件用到的加边Hessian矩阵表示。

作业1 用身高和/或体重数据进行性别分类(一) 基本要求: 用FAMALE.TXT和MALE.TXT的数据作为训练样本集,建立Bayes分类器,用测试样本数据对该分类器进行测试。调整特征、分类器等方面的一些因素,考察它们对分类器性能的影响,从而加深对所学内容的理解和感性认识。 具体做法: 1.应用单个特征进行实验:以(a)身高或者(b)体重数据作为特征,在正态分布假设下利用最大似然法或者贝叶斯估计法估计分布密度参数,建立最小错误率Bayes分类器,写出得到的决策规则,将该分类器应用到测试样本,考察测试错误情况。在分类器设计时可以考察采用不同先验概率(如0.5对0.5, 0.75对0.25, 0.9对0.1等)进行实验,考察对决策规则和错误率的影响。 图1-先验概率0.5:0.5分布曲线图2-先验概率0.75:0.25分布曲线 图3--先验概率0.9:0.1分布曲线图4不同先验概率的曲线 有图可以看出先验概率对决策规则和错误率有很大的影响。 程序:bayesflq1.m和bayeszcx.m

关(在正态分布下一定独立),在正态分布假设下估计概率密度,建立最小错误率Bayes 分类器,写出得到的决策规则,将该分类器应用到训练/测试样本,考察训练/测试错误情况。比较相关假设和不相关假设下结果的差异。在分类器设计时可以考察采用不同先验概率(如0.5 vs. 0.5, 0.75 vs. 0.25, 0.9 vs. 0.1等)进行实验,考察对决策和错误率的影响。 训练样本female来测试 图1先验概率0.5 vs. 0.5 图2先验概率0.75 vs. 0.25 图3先验概率0.9 vs. 0.1 图4不同先验概率 对测试样本1进行试验得图

估计量优良性的若干判别准则 作者 李晓辉 指导老师 胡学平 摘要 未知参数的估计通常有很多种,一个好的估计量应该在多次观测中,其观测值围绕被估计参 数的真值摆动.为正确评价估计量,要建立判别估计量好坏的标准.本文主要总结估计量优良性的若干判别准则,如无偏性、有效性、一致性等。通过本文的研究,进一步了解了估计量优良性的一些判别准则,为今后学习打下了基础。 关键词 无偏性 一致性 有效性 一致最小方差无偏估计 均方误差 1 引言 对于估计量优良性的研究,国内外更多的是将其依托于一个具体的实验或具体的实际问题中去进行比较研究,如在1982年《数学杂志》中,刘学圃写了一篇名为《一类平稳时间序列谱密估计量的优良性质》文章,又如在《统计与信息论坛》中,写了一篇《系统样本差估计量的优良性》,所以说对其的研究更多的是依据于是研究中,通过其试验来体现一个估计量的优良性.当然,单纯对于优良性的研究国内有一篇很是经典的文章—王力宾的《对估计量优劣性评价标准的研究》,他在此文中比较详细地介绍了若干判别准则,大致上分为两类:一类是小样本估计量优良性的若干判别准则,另一类是大样本估计量优良性的判别准则。他也同样在文中详细地叙述了两类之间的联系.其实,一直以来,我国的统计工作者,一直都是把无偏性,有效性,一致性看作是评价估计量优良性的三大标准,但对于其实用性并未进行过较为系统的研究. 评价一个估计量的好坏,不能仅仅依据一次试验的结果,而必须由多次试验的结果来衡量.这是因为估计量是样本的函数,是随机变量。由不同的观测结果,就会求得不同的参数估计值.因此一个好的估计,应在多次试验中体现出优良性.对于一个特定的应用,选择好的估计量与许多因素有关系,最基本的考虑因素就是选择一个好的数据模型,它的复杂性应该足以描述数据的基本特征,但是与此同时要简单的足以允许估计量是最佳的且易于实现.举个简单的例子,对于信号的处理问题,选择一个合适的估计量要从易于现实的最佳估计量开始.如果这种寻找没有效果,那么就应该考察准最佳估计量.对于同一参数,用不同的估计法得到的点估计量不一定相同,那么用哪一种估计法好呢?并且,人们总是希望估计量能代替真实参数.为正确评价估计量,要建立判别估计量好坏的标准.根据不同的要求,评价估计量可以有各种各样的标准.所以,对于一个估计量的优良性进行判别显得尤为重要.对于估计量优良性若干判别准则的研究,为了以后我们进一步的学习和工作都奠定了良好的基础. 2 判别优良性的准则 2.1 估计量的无偏性 2.1.1无偏估计量的定义及定理 定义 设()n ,ξ,,ξξT θ 21?=是未知参数θ的一个估计量,若 () Θθθ, θE ∈?=? 则称()n ,ξ,,ξξT θ 21?=为θ的无偏估计量. 在这里我们要接触一个新的名词:统计量,到底什么是统计量,下面我们来简单介绍一

Homework #2 Note:In some problem (this is true for the entire quarter) you will need to make some assumptions since the problem statement may not fully specify the problem space. Make sure that you make reasonable assumptions and clearly state them. Work alone: You are expected to do your own work on all assignments; there are no group assignments in this course. You may (and are encouraged to) engage in general discussions with your classmates regarding the assignments, but specific details of a solution, including the solution itself, must always be your own work. Problem: In this problem we will investigate the importance of having the correct model for classification. Load file hw2.mat and open it in Matlab using command load hw2. Using command whos, you should see six array c1, c2, c3 and t1, t2, t3, each has size 500 by 2. Arrays c1, c2, c3 hold the training data, and arrays t1, t2, t3 hold the testing data. That is arrays c1, c2, c3 should be used to train your classifier, and arrays t1, t2, t3 should be used to test how the classifier performs on the data it hasn’t seen. Arrays c1 holds training data for the first class, c2 for the second class, c3 for the third class. Arrays t1, t2, t3 hold the test data, where the true class of data in t1, t2, t3 comes from the first, second, third classed respectively. Of course, array ci and ti were drawn from the same distribution for each i. Each training and testing example has 2 features. Thus all arrays are two dimensional, the number of rows is equal to the number of examples, and there are 2 columns, column 1 has the first feature, column 2 has the second feature. (a)Visualize the examples by using Matlab scatter command a plotting each class in different color. For example, for class 1 use scatter(c1(:,1),c1(:,2),’r’);. Other possible colors can be found by typing help plot. (b)From the scatter plot in (a), for which classes the multivariate normal distribution looks like a possible model, and for which classes it is grossly wrong? If you are not sure how to answer this part, do parts (c-d) first. (c)Suppose we make an erroneous assumption that all classed have multivariate normal Nμ. Compute the Maximum Likelihood estimates for the means and distributions()∑, covariance matrices (remember you have to do it separately for each class). Make sure you use only the training data; this is the data in arrays c1, c2, and c3. (d)You can visualize what the estimated distributions look like using Matlab contour(). Recall that the data should be denser along the smaller ellipse, because these are closer to the estimated mean. (e)Use the ML estimates from the step (c) to design the ML classifier (this is the Bayes classifier under zero-one loss function with equal priors). Thus we are assuming that priors are the same for each class. Now classify the test example (that is only those

模式识别第三章 感知器算法 一.用感知器算法求下列模式分类的解向量w : })0,1,1(,)1,0,1(,)0,0,1(,)0,0,0{(:1T T T T ω })1,1,1(,)0,1,0(,)1,1,0(,)1,0,0{(:2T T T T ω 将属于2ω的训练样本乘以(-1),并写成增广向量的形式: T x )1,0,0,0(1 =,T x )1,0,0,1(2=,T x )1,1,0,1(3=,T x )1,0,1,1(4 = T x )1,1-,0,0(5-=,T x )1,1-,1-,0(6-=,T x )1,0,1-,0(7-=,T x )1,1-,1-,1-(8-= 第一轮迭代:取1=C ,T )0,0,0,0()1(=ω 因0)1,0,0,0)(0,0,0,0()1(1==T T x ω不大于0,故T x )1,0,0,0()1()2(1=+=ωω 因1)1,0,0,1)(1,0,0,0()2(2==T T x ω大于0,故T )1,0,0,0()2()3(==ωω 因1)1,1,0,1)(1,0,0,0()3(3==T T x ω大于0,故T )1,0,0,0()3()4(==ωω 因1)1,0,1,1)(1,0,0,0()4(4==T T x ω大于0,故T )1,0,0,0()4()5(==ωω 因1)1,1-,0,0)(1,0,0,0()5(5-=-=T T x ω不大于0,故T x )0,1-,0,0()5()6(5 =+=ωω 因1)1,1-,1-,0)(0,1-,0,0()6(6=-=T T x ω大于0,故T )0,1-,0,0()6()7(==ωω 因0)1,0,1-,0)(0,1-,0,0()7(7=-=T T x ω不大于0,故T x )1-,1-,1,0()7()8(7-=+=ωω 因3)1,1-,1-,1-)(1-,1-,1,0()8(8=--=T T x ω大于0,故T )1-,1-,1,0()8()9(-==ωω 第二轮迭代: 因1)1,0,0,0)(1-,1-,1,0()9(1-=-=T T x ω不大于0,故T x )0,1-,1,0()9()10(1-=+=ωω 因0)1,0,0,1)(0,1-,1-,0()10(2==T T x ω不大于0,故T x )1,1,1,1()10()11(2--=+=ωω 因1)1,1,0,1)(1,1,1,1()11(3=--=T T x ω大于0,故T )1,1,1,1()11()12(--==ωω 因1)1,0,1,1)(1,1,1,1()12(4=--=T T x ω大于0,故T )1,1,1,1()12()13(--==ωω

题1:在一个10类的模式识别问题中,有3类单独满足多类情况1,其余的类别满足多类情况2。问该模式识别问题所需判别函数的最少数目是多少? 答:将10类问题可看作4类满足多类情况1的问题,可将3类单独满足多类情况1的类找出来,剩下的7类全部划到4类中剩下的一个子类中。再在此子类中,运用多类情况2的判别法则进行分类,此时需要7*(7-1)/2=21个判别函数。故共需要4+21=25个判别函数。 题2:一个三类问题,其判别函数如下: d1(x)=-x1, d2(x)=x1+x2-1, d3(x)=x1-x2-1 1.设这些函数是在多类情况1条件下确定的,绘出其判别界面和每一个模式类 别的区域。 2.设为多类情况2,并使:d12(x)= d1(x), d13(x)= d2(x), d23(x)= d3(x)。绘出其 判别界面和多类情况2的区域。 3.设d1(x), d2(x)和d3(x)是在多类情况3的条件下确定的,绘出其判别界面和 每类的区域。 答:三种情况分别如下图所示: 1. 2.

3. 题3:两类模式,每类包括5个3维不同的模式,且良好分布。如果它们是线性可分的,问权向量至少需要几个系数分量?假如要建立二次的多项式判别函数,又至少需要几个系数分量?(设模式的良好分布不因模式变化而改变。) 答:(1)若是线性可分的,则权向量至少需要14N n =+=个系数分量; (2)若要建立二次的多项式判别函数,则至少需要5! 102!3! N = =个系数分量。 题4:用感知器算法求下列模式分类的解向量w : ω1: {(0 0 0)T, (1 0 0)T, (1 0 1)T, (1 1 0)T} ω2: {(0 0 1)T, (0 1 1)T, (0 1 0)T, (1 1 1)T} 解:将属于2w 的训练样本乘以(1)-,并写成增广向量的形式 x1=[0 0 0 1]',x2=[1 0 0 1]',x3=[1 0 1 1]',x4=[1 1 0 1]'; x5=[0 0 -1 -1]',x6=[0 -1 -1 -1]',x7=[0 -1 0 -1]',x8=[-1 -1 -1 -1]'; 迭代选取1C =,(1)(0,0,0,0)w '=,则迭代过程中权向量w 变化如下: (2)(0 0 0 1)w '=;(3)(0 0 -1 0)w '=;(4)(0 -1 -1 -1)w '=;(5)(0 -1 -1 0)w '=;(6)(1 -1 -1 1)w '=;(7)(1 -1 -2 0)w '=;(8)(1 -1 -2 1)w '=;(9)(2 -1 -1 2)w '=; (10)(2 -1 -2 1)w '=;(11)(2 -2 -2 0)w '=;(12)(2 -2 -2 1)w '=;收敛 所以最终得到解向量(2 -2 -2 1)w '=,相应的判别函数为123()2221d x x x x =--+。 题5:用多类感知器算法求下列模式的判别函数: ω1: (-1 -1)T ,ω2: (0 0)T ,ω3: (1 1)T

模式识别作业 班级: 学号: 姓名:

一、实验内容 (1)了解与熟悉模式识别系统的基本组成和系统识别原理。 (2)使用增添特征法对特征进行提取与选择。 (3)编写MATLAB程序,对原始数据特征进行提取与选择,并选择适当的分类器对样本进行训练和分类,得出最后的分类结果以及识别正确率。二、实验原理 模式识别系统的原理图如下: 图1.模式识别系统原理图 对原始样本数据进行一些预处理,使用增添特征法进行特征提取与选择。增添特征法也称为顺序前进法(SFS),每次从未选择的特征中选择一个,使得它与已选特征组合后判据值J最大,直到选择的特征数目达到d。特征选取后用SVM分类器对随机选取的训练样本和测试样本进行分类,最后得出不同特征维数下的最高SVM分类正确率,以及不同特征维数下的最大类别可分性判据。 三、实验方法及程序 clear; clc; load('C:\Users\Administrator\Desktop\homework\ionosphere.mat'); m1=225;m2=126; p1=m1/(m1+m2);p2=m2/(m1+m2); chosen=[]; for j=1:34 [m,n]=size(chosen);n=n+1; J1=zeros(1,33); for i=1:34 Sw=zeros(n,n);Sb=zeros(n,n); S1=zeros(n,n);S2=zeros(n,n); p=any(chosen==i); if p==0 temp_pattern1=data(1:225,[chosen i]); temp_pattern2=data(226:351,[chosen i]);

第一章 绪论 1.什么是模式?具体事物所具有的信息。 模式所指的不是事物本身,而是我们从事物中获得的___信息__。 2.模式识别的定义?让计算机来判断事物。 3.模式识别系统主要由哪些部分组成?数据获取—预处理—特征提取与选择—分类器设计/ 分类决策。 第二章 贝叶斯决策理论 1.最小错误率贝叶斯决策过程? 答:已知先验概率,类条件概率。利用贝叶斯公式 得到后验概率。根据后验概率大小进行决策分析。 2.最小错误率贝叶斯分类器设计过程? 答:根据训练数据求出先验概率 类条件概率分布 利用贝叶斯公式得到后验概率 如果输入待测样本X ,计算X 的后验概率根据后验概率大小进行分类决策分析。 3.最小错误率贝叶斯决策规则有哪几种常用的表示形式? 答: 4.贝叶斯决策为什么称为最小错误率贝叶斯决策? 答:最小错误率Bayes 决策使得每个观测值下的条件错误率最小因而保证了(平均)错误率 最小。Bayes 决策是最优决策:即,能使决策错误率最小。 5.贝叶斯决策是由先验概率和(类条件概率)概率,推导(后验概率)概率,然后利用这个概率进行决策。 6.利用乘法法则和全概率公式证明贝叶斯公式 答:∑====m j Aj p Aj B p B p A p A B p B p B A p AB p 1) ()|()() ()|()()|()(所以推出贝叶斯公式 7.朴素贝叶斯方法的条件独立假设是(P(x| ωi) =P(x1, x2, …, xn | ωi) = P(x1| ωi) P(x2| ωi)… P(xn| ωi)) 8.怎样利用朴素贝叶斯方法获得各个属性的类条件概率分布? 答:假设各属性独立,P(x| ωi) =P(x1, x2, …, xn | ωi) = P(x1| ωi) P(x2| ωi)… P(xn| ωi) 后验概率:P(ωi|x) = P(ωi) P(x1| ωi) P(x2| ωi)… P(xn| ωi) 类别清晰的直接分类算,如果是数据连续的,假设属性服从正态分布,算出每个类的均值方差,最后得到类条件概率分布。 均值:∑==m i xi m x mean 11)( 方差:2)^(11)var(1∑=--=m i x xi m x 9.计算属性Marital Status 的类条件概率分布 给表格计算,婚姻状况几个类别和分类几个就求出多少个类条件概率。 ???∈>=<2 11221_,)(/)(_)|()|()(w w x w p w p w x p w x p x l 则如果∑==21 )()|()()|()|(j j j i i i w P w x P w P w x P x w P 2,1),(=i w P i 2,1),|(=i w x p i ∑==2 1)()|()()|()|(j j j i i i w P w x P w P w x P x w P ∑=== M j j j i i i i i A P A B P A P A B P B P A P A B P B A P 1) ()| ()()|()()()|()|(