一.车速、车流量检测

对车速、车流量的检测需要用多幅连续的动态图像。

1.运动车辆检测

车速与车流量检测的前提是要从图像中准确提取出运动车辆。提取运动车辆一般都是用差分法,常用的有背景差分法和帧间差分法。

背景差分是从图像中选取一帧作为背景帧,通过将当前帧与背景帧图像差分来判断是否有运动车辆;背景差分的主要问题是背景的更新,因为随着时间的变化,静态的背景也会发生改变,所以需要实时地对背景图像更新,现在已经有比较成熟的自适应背景更新算法来解决这一问题。

帧间差分法是通过将当前帧与上一帧图像差分来判断是否有运动车辆;帧差分法可以去除背景图像使保留下来的部分全为运动车辆的图像。但用这种方法当两帧间有重叠部分时重叠部分无法检测出来,使运动目标出现断裂,给后续的处理带来不便。

因此本系统宜采用背景差分并应用自适应背景更新算法来动态更新背景。2.背景差分中背景更新算法

背景差分的关键是要能保证背景图像的准确性,简单而又常用的自适应背景更新算法有以下两种:

A.基于帧间像素灰度变化的背景更新算法

基于帧间像素灰度变化的背景更新算法在具体处理上也可细分为很多种,但都大同小异。这种方法需要先提取出一幅初始的背景图像,可以简单地将第一帧图像作为初始背景图像,也可以将前N帧图像的中值或均值作为初始背景图像。

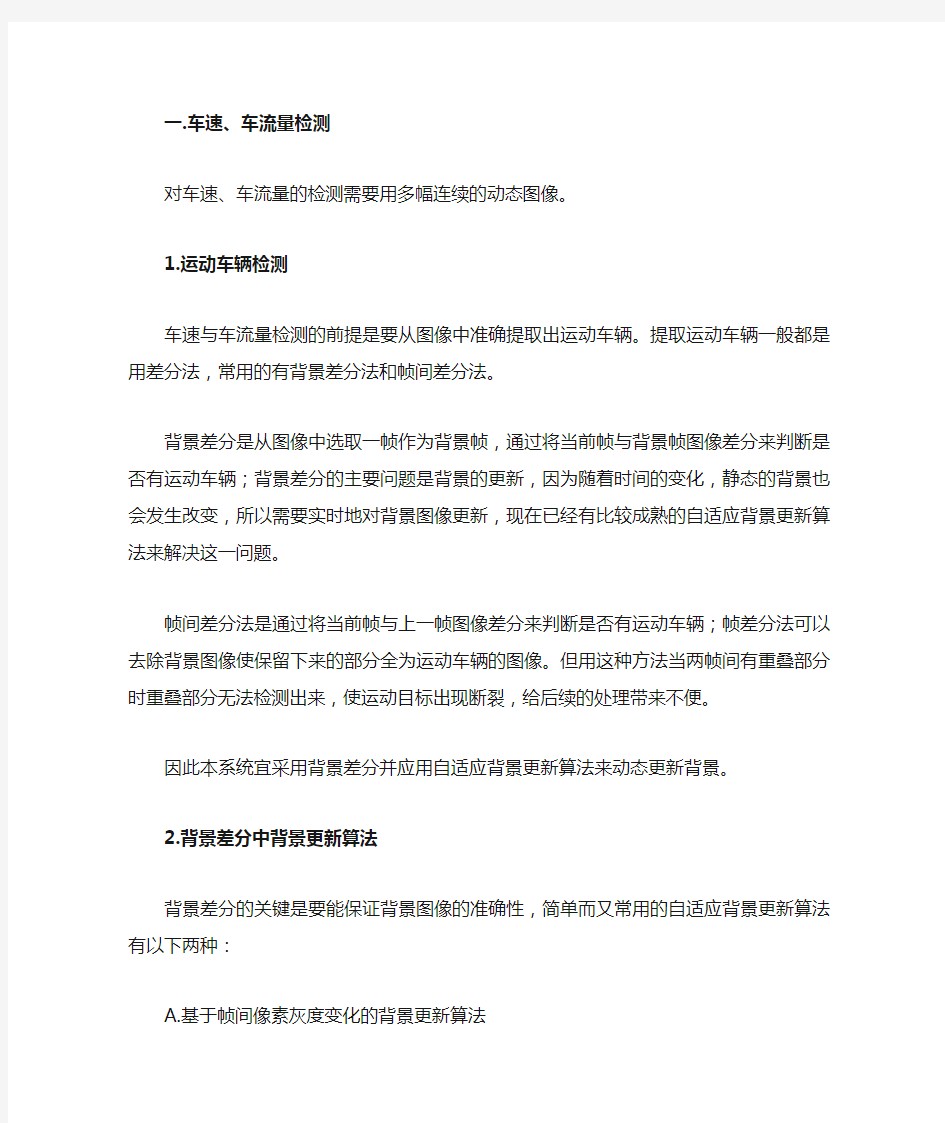

对于背景图像的更新,设B k-1(i,j)为原(i,j)处的原背景图像,B k(I,j)为更新后的背景图像,I k(i,j)为当前实际图像。得到目标二值图像:

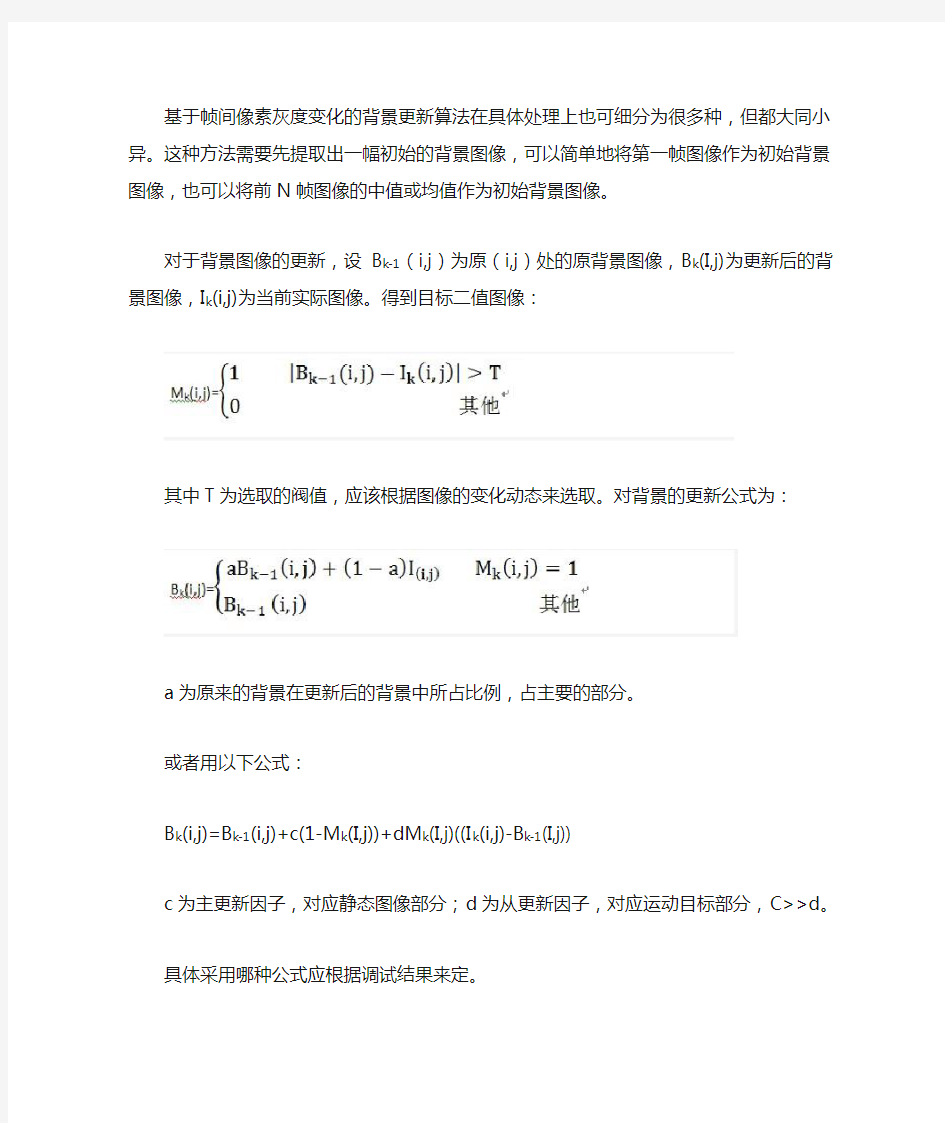

其中T为选取的阀值,应该根据图像的变化动态来选取。对背景的更新公式为:

a为原来的背景在更新后的背景中所占比例,占主要的部分。

或者用以下公式:

B k(i,j)=B k-1(i,j)+c(1-M k(I,j))+dM k(I,j)((I k(i,j)-B k-1(I,j))

c为主更新因子,对应静态图像部分;d为从更新因子,对应运动目标部分,C>>d。具体采用哪种公式应根据调试结果来定。

B.基于像素灰度区间分布的背景更新算法

这种方法类似于统计直方图。对于单像素其值在0~255间,可以将其分为N 个区间,每个区间范围为(0<1 每个每一个区间定义两个参数:区间均值u和区间计数值s k。u k是属于该区间的所有象素值的加权平均;s k是象素值属于该区间的所有图像序列的总数。区间均值是随着图像序列的更新而更新。在计算时,当前帧的数据比之前的数据所占的权重更大,为此引入衰减因子e,之前的数据所占比重按e速率衰减。e越小,衰减得越快。假设当前帧为第n帧,则第k个区间的均值u k的更新公式为: 如果象素值落入第k个区间则更新u k,否则u k保持不变。 为了使得背景估计模型能够更好的跟踪背景的变化,同时也是s k不至于一直累加增大,引入了区间计数值的衰减因子,降低历史信息的影响。定义区间计数衰减因子为f,当前图像象素值对区间计数值的贡献是1,而前一帧图像象素值对区间计数值的贡献是f,以此类推,这样就降低了历史信息的影响。假设当前帧为第n帧,定义第k个区间的计数值s k的更新公式为: 定义了u k、s k后,首先判断当前象素点所属区间k,然后更新u k、s k,找出各区间中s k的最大值,将具有最大s k值的区间u k作为该像素的背景值。 上述两种方法中第一种更适合背景变化较快的场合,而第二种则适合背景变化较慢的场合,具体采用哪种算法可以根据调试的实际效果来定。 3.虚拟检测线法提取车速、车流量 虚拟检测线法就是在图像中选取检测区域,在该区域中检测运动车辆。所有在前面的用背景差分检测运动车辆部分做好了后,这部分就非常简单。 首先需要在整个图像中选取一个虚拟的检测区域,一般选择水平于图像中下部的区域作为检测区域,因为在此位置可以在一定程度上避免前车遮挡后车的问题。检测区域不宜过大也不宜过小,最后选择检测区域高度为普通车长,宽度为车道的宽度。 然后,在检测区域内设置若干条虚拟线用于检测,虚拟线的数目可以根据实 际的需要给出。虚拟线少,检测的速度快,但是容易产生误判;虚拟线多会降低检测速度,但是增强了检测结果的准确性。一条虚拟线就是一行像素。在虚拟线的设置中有一点值得注意,因为路标通常标在车道的正中央,有可能出现检测器穿过路标的现象。一般来说,路标都是比较醒目的,与路面的灰度反差较大。在这种情况下有可能会出现误判,所以尽量不要使虚拟线和路标有交集。 车流量的提取只需要在自适应更新背景的前提下,用背景差分法来检查虚拟检测区内是否有车辆通过,有车辆通过是则进行计数,然后用在一段时间内检测出的车辆数除以时间即可得到车流量。 车速的检测也是通过检测虚拟检测区内有无车辆来实现。由于我们设置的虚拟检测区的图像窗口是和时间的道路位置一一对应的,因此可以知道虚拟检测区所对应的实际道路的物理长度与宽度,其中长度s即为车辆通过该虚拟检测去所走的实际路程,而车辆进入该虚拟检测区的帧数m与车辆离开虚拟检测区的帧数n的差(m-n)即是车辆通过路程s所对应的时间,从而可以算出车辆的车速。 二.车辆排队长度、交通密度检测 对车辆排队长度与交通密度的检测只需要单幅静态图像。 这部分首先要从图像中将车道从其他背景中提取出来,图像中的像素与实际的位置是一一对应的,所以可以在调试时手动设置图像的工作窗口,将其设置在实际的车道内,非工作窗口部分处理图像时不做处理。 车辆排队长度的检测是以道路与车辆的在图像中的灰度值不同为基础,通过将工作窗口内的图像作二值化处理,将图像分割成若干的黑色区域与白色区域。通过选取合适的阀值,二值化后可以将图像中车辆的轮廓部分变为1即黑色,而其他部分为0即白色,从而在一幅静态图像中将车辆和道路分割开,通过计算工作窗口中黑色区域个数即可得到车辆排队长度信息。车辆排队数除以道路长度即得到交通密度。 进行二值化处理时选取合适的阀值是处理结果好坏的关键。比较常用的是Ostu自动阀值分割算法。OTSU算法也称最大类间差法,有时也称之为大津算法,被认为是图像分割中阈值选取的最佳算法,计算简单,不受图像亮度和对比度的影响,因此在数字图像处理上得到了广泛的应用。它是按图像的灰度特性,将图像分成背景和前景两部分。背景和前景之间的类间方差越大,说明构成图像的两部分的差别越大,当部分前景错分为背景或部分背景错分为前景都会导致两部分差别变小。因此,使类间方差最大的分割意味着错分概率最小。 设灰度图像灰度级是L,则灰度范围为[0,L-1],利用OTSU算法计算图像的最佳阈值为:t = Max[w0(t) * (u0(t) - u)2 + w1(t) * (u1(t) - u)2)] 其中:当分割的阈值为t时,w0为背景比例,u0为背景均值,w1为前景比例,u1为前景均值,u为整幅图像的均值。使以上表达式值最大的t,即为分割图像的最佳阈值。 以下是用Ostu算法提取图像阀值的C语言程序具体函数的实现,系统设计时可以作为参考: int otsuThreshold(IplImage *frame) { int width = frame->width; int height = frame->height; int pixelCount[GrayScale]; float pixelPro[GrayScale]; int i,j,pixelSum = width * height, threshold = 0; uchar* data = (uchar*)frame->imageData; for(i = 0; i < GrayScale; i++) { pixelCount[i] = 0; pixelPro[i] = 0; } for(i = 0; i < height; i++) //统计灰度级中每个像素在整幅图像中的个数{ for(j = 0;j < width;j++) { pixelCount[(int)data[i * width + j]]++; } } for(i = 0; i < GrayScale; i++) //计算每个像素在整幅图像中的比例{ pixelPro[i] = (float)pixelCount[i] / pixelSum; } float w0, w1, u0tmp, u1tmp, u0, u1, u, deltaTmp, deltaMax = 0; for(i = 0; i < GrayScale; i++) //遍历灰度级[0,255] { w0 = w1 = u0tmp = u1tmp = u0 = u1 = u = deltaTmp = 0; for(j = 0; j < GrayScale; j++) { if(j <= i) //背景部分 { w0 += pixelPro[j]; u0tmp += j * pixelPro[j]; } else //前景部分 { w1 += pixelPro[j]; u1tmp += j * pixelPro[j]; } } u0 = u0tmp / w0; u1 = u1tmp / w1; u = u0tmp + u1tmp; deltaTmp = w0 * pow((u0 - u), 2) + w1 * pow((u1 - u), 2); if(deltaTmp > deltaMax) { deltaMax = deltaTmp; threshold = i; } } return threshold; } 几种常用边缘检测算法的比较摘要:边缘是图像最基本的特征,边缘检测是图像分析与识别的重要环节。基于微分算子的边缘检测是目前较为常用的边缘检测方法。通过对Roberts,Sobel,Prewitt,Canny 和Log 及一种改进Sobel等几个微分算子的算法分析以及MATLAB 仿真实验对比,结果表明,Roberts,Sobel 和Prewitt 算子的算法简单,但检测精度不高,Canny 和Log 算子的算法复杂,但检测精度较高,基于Sobel的改进方法具有较好的可调性,可针对不同的图像得到较好的效果,但是边缘较粗糙。在应用中应根据实际情况选择不同的算子。 0 引言 边缘检测是图像分析与识别的第一步,边缘检测在计算机视觉、图像分析等应用中起着重要作用,图像的其他特征都是由边缘和区域这些基本特征推导出来的,边缘检测的效果会直接影响图像的分割和识别性能。边缘检测法的种类很多,如微分算子法、样板匹配法、小波检测法、神经网络法等等,每一类检测法又有不同的具体方法。目前,微分算子法中有Roberts,Sobel,Prewitt,Canny,Laplacian,Log 以及二阶方向导数等算子检测法,本文仅将讨论微分算子法中的几个常用算子法及一个改进Sobel算法。 1 边缘检测 在图像中,边缘是图像局部强度变化最明显的地方,它主要存在于目标与目标、目标与背景、区域与区域( 包括不同色彩) 之间。边缘表明一个特征区域的终结和另一特征区域的开始。边缘所分开区域的内部特征或属性是一致的,而不同的区域内部特征或属性是不同的。边缘检测正是利用物体和背景在某种图像特征上的差异来实现检测,这些差异包括灰度、颜色或纹理特征,边缘检测实际上就是检测图像特征发生变化的位置。边缘的类型很多,常见的有以下三种: 第一种是阶梯形边缘,其灰度从低跳跃到高; 第二种是屋顶形边缘,其灰度从低逐渐到高然后慢慢减小; 第三种是线性边缘,其灰度呈脉冲跳跃变化。如图1 所示。 (a) 阶梯形边缘(b) 屋顶形边缘 (b) 线性边缘 图像中的边缘是由许多边缘元组成,边缘元可以看作是一个短的直线段,每一个边缘元都由一个位置和一个角度确定。边缘元对应着图像上灰度曲面N 阶导数的不连续性。如果灰度曲面在一个点的N 阶导数是一个Delta 函数,那么就 万方数据 万方数据 万方数据 916 浙 江大 学 学 报(工学版) 第42卷 取上下两块区域深度的平均值作为该区域的平均深度.在区域划分足够细的情况下,为了防止噪声的干扰,可以再增加区域在行上的深度梯度约束. 1.5整体算法流程 整体算法流程可归纳如下4个部分: 1)输入图像序列,提取Harris角点并用KLT算法进行跟踪,得到在图像序列中都可见的特征点; 2)根据这些特征点在各帧图像中的坐标组成W矩阵,使用改进的因子分解法得到场景的投影重建; 3)在满足DAQ约束的自标定的基础上得到场景的欧氏重建以及摄像机运动; 4)划分图像区域,通过深度信息来确定为障碍 物或者背景. 2试验结果 为了验证所提出障碍物检测算法的有效性,本文进行了真实的室外场景实验.采用图像序列分辨率为720×576,共计400帧.为了获得比较精确的摄像机实际位移以及防止因子分解法的累积计算量过大,以40帧为单位划分原图像序列,得到10个子 序列,对于每个子序列,每隔4帧抽出一帧,采样过后的10帧进行障碍物检测.以其中的一个子序列(200~239帧)为例,图2给出了采样过后该子序列的第一帧和最后一帧(即原序列的第200帧和236帧). (a)第200帧 (b)第236帧 图2子序列中的第一帧和最后一帧 Fig.2 Firstandlastframeinsubsequence 本文首先选取并匹配特征点共1500个(如图3所示),然后用因子分解法得到场景的投影重建(如图4所示).通过满足DAQ约束的自标定求得 DAQ为 n’= 91O OO00 0.000 30.00241.03671.1209 O.00910.06641.12091.2166 进而得到场景的欧氏重建(如图5所示).可以看出 欧氏重建真实地反映了特征点在世界坐标系中的位 置以及摄像的运动(位于欧氏重建三维图的底部的 (a)第200帧(b)第236帧 图3特征点选取与匹配 Fig.3 Featurepointsdetectingandtracking O.5 图4场景的投影重建三维图 Fig.4 Projectivereconstructionof scene 20l5~ 105O 图5场景的欧氏重建三维图 Fig.5 Euclideanreconstructionof scene 小坐标系代表了运动中摄像机光心的位置).最后,将该子序列中的每一帧图像划分为35×28个20像素×20像素的子区域(图像左右各空出10像素,上 面空出16像素作为边界),计算区域深度以及深度梯度,取阈值r,=8,r。=0.3,r。一4,确定障碍物区域,并用黑色块进行标记如图6所示.图7以起始帧、中间一帧和最后一帧为代表,反映了基于整个图像序列(400帧)由远而近的障碍物检测效果. (a)第200帧 (b)第236帧 图6确定并标记障碍物区域 Fig.6 Obstacle area confirmingandlabeling —y 7●』t 4 62 6叭∞∞OO O 万方数据 万方数据 基于肤色检测和背景差分的人手定位和跟踪?2l? 2基于肤色检测和背景差分的人手定位和跟踪算法 2.1基于HSV色彩空间的肤色检测 经过对30张不同光照环境下的肤色照片进行分析可以发现,当照射在皮肤表面的光线强度或曲度发生变化时,获取到的图像中皮肤的H(Hue)分量基本保持在0—0.1和0.9—1.0这两个区间内(如图2所示),实验过程中测试了从阴暗的室内(照度大约为20Ix)到光线条件良好的室外(照度大约为20000lx)不同环境条件的情况。 {雪 糕 图2归一化后的黄种人肤色H值统计直方图而Js(Saturation)分量则随着光照强度的增加逐渐减小,V(Value)分量随着光照强度的增加逐渐增加(如图3所示)。另外,可以发现,.S和y两条曲线关于某一条平行于水平轴的直线基本对称,即:s分量和y分量之和基本保持不变帕j。因此,通过对获取到的图像日分量、Js分量和y分量进行分析后,可以设定合适的阈值进行图像二值化处理,从而实现肤色的检测。 图3不同光照度情况下皮肤的S、y值 本文设定日分量的阈值为0.1和0.9,S分量的阈值为0.2和0.8,即认为日分量在0。0.1和0.9—1.0之间,s分量在0.2—0.6之间的像素点为肤色点,肤色检测的效果如图4所示。 2.2利用背景差分滤除噪声 在进行肤色检测后,已经将人体部分与复杂的背景显著地分离开来,但是由于周围环境中类肤色物体的影响,可能还会带来一些噪声点,如图5中所示。此时,采用了背景差分的方法滤除这些噪声点”1。 图4肤色检测的效果图 I冬I5背景差分后的效果图 背景差分所要解决的首要问题就是如何对环境背景进行建模,这里采用高斯混合模型【7J(GMM,Gaussi— anmixturemodel)对背景进行建模。高斯混合模型是单一高斯几率密度函数的延伸。即对背景图像而言,特定像素M(并,Y)的各个通道的值的大小分布满足多个高斯分布M。(戈,Y)一N(n。,d。),£∈[1,k],其概率模型为 K P(M)=∑咄J×71(M。,niJ,di,j)(1)式中,使用了K个高斯模型来组成混合高斯模型,K的值应根据相应硬件环境进行适当调整;∞“为每个高斯模型的权重;叩为高斯概率密度函数;ni和d“分别为,j 各个高斯模型的期望和均方差 ’7(M。,,t,d)2芝:;——:;丽e一}(村f—n)2e一1(2) %=信二)(3)以上对图像上的每个点都建立了高斯模型。当得到新的一帧以后,就可以将相应位置的点与高斯模型进行匹配,认为在模型期望3倍以内的值都是正确匹配的,其余的就是运动物体上的点,再设置阈值,进行一次二值化即可,如图5所示。 2.3实现手的跟踪 在实现了人手定位后就需要进一步实现跟踪,这里采用了求质心的方法实现跟踪,与物理学中算法类 似,此处质心的确定方法为 万方数据 基于canny 算子的改进边缘检测算法 摘要:本文提出了一种基于Canny 算子的改进边缘检测算法。该算法既具备传统Canny 算子信噪比高、定位精确的优点,又具备较强的去噪能力和较好的边缘检测效果。实验表明,本文算法增强了Canny 算子在噪声干扰情况下的去噪效果,提高了边缘定位的精确度,能够得到更加完整的边缘轮廓。 关键词:Canny 算子,双边滤波,边缘检测 1 引言 边缘检测技术是数字图像处理中的一项重要技术,边缘检测的主要目的就是实现对目标图像的精确定位。边缘是图像的基本特征,是图像分割的重要依据,也是纹理特征的重要信息源和形状特征分析的基础,边缘检测的效果将直接影响到图像理解和识别的性能[1]。经典的边缘检测算子,如Robert 、Prewitt 、Log 等,简单、易于实现,但对噪声敏感、抗干扰性能差,边缘不够精细[2]。相比这些算子,Canny 算子具有更好的信噪比和检测精度,在图像边缘检测领域中具有更加广泛的应用范围。 但是,实际图像中,存在着许多噪声,这时,若仍采用传统 Canny 算子进行边缘检测,会将一些噪声点误作边缘点检测,导致提取的边缘轮廓模糊、不精确,因此,我们需要对传统Canny 算子加以改进。 本文提出了一种基于Canny 算子而改进的边缘检测算法,该算法既可以较好地滤除噪声,又可以提高目标边缘的定位精度、抑制虚假边缘和去除冗余弱边缘,呈现出了一个更为清晰的天之信图像边缘检测结果,比传统Canny 算法具有更好的性能。 2 传统canny 边缘检测算法 Canny 提出了边缘检测性能优劣的3个判断准则[3]: 高信噪比准则:即输出信号的信噪比最大,以降低边缘点判断为非边缘点和非边缘点判为边缘点的概率。信噪比越大,误检率越低。 高定位精度准则:好的定位性能,即检测出的边缘点要尽可能在实际边缘的中心 单边缘相应准则:即单一边缘只有惟一响应,并且对虚假边缘响应应得到最大抑制。 2.1 传统canny 算法边缘检测步骤 1)高斯滤波 用一维高斯函数对原始图像f(x, y)进行低通滤波、噪声滤除,该高斯函数为: 22221 (,)exp 22x y G x y πδδ??+=-???? δ为高斯滤波函数的标准差,控制着平滑程度:σ较小时,滤波器定位精度高,但信噪比低;σ较大时,滤波器情况正好相反。我们要根据实际情况确定δ的大小。 2)计算梯度幅值和方向 传统的Canny 算法采用2×2邻域一阶偏导的有限差分来计算平滑后的图像的梯度幅值和方向: 22 (,)(,)(,)x y M x y G x y G x y =+ 1.void cvSkinSegment(IplImage* img, IplImage* mask){ 2. CvSize imageSize = cvSize(img->width, img->height); 3. IplImage *imgY = cvCreateImage(imageSize, IPL_DEPTH_8U, 1); 4. IplImage *imgCr = cvCreateImage(imageSize, IPL_DEPTH_8U, 1); 5. IplImage *imgCb = cvCreateImage(imageSize, IPL_DEPTH_8U, 1); 6. 7. 8. IplImage *imgYCrCb = cvCreateImage(imageSize, img->depth, img->nChannels ); 9. cvCvtColor(img,imgYCrCb,CV_BGR2YCrCb); 10. cvSplit(imgYCrCb, imgY, imgCr, imgCb, 0); 11.int y, cr, cb, l, x1, y1, value; 12. unsigned char *pY, *pCr, *pCb, *pMask; 13. 14. pY = (unsigned char *)imgY->imageData; 15. pCr = (unsigned char *)imgCr->imageData; 16. pCb = (unsigned char *)imgCb->imageData; 17. pMask = (unsigned char *)mask->imageData; 18. cvSetZero(mask); 19. l = img->height * img->width; 20.for (int i = 0; i < l; i++){ 21. y = *pY; 22. cr = *pCr; 23. cb = *pCb; 24. cb -= 109; 25. cr -= 152 26. ; 27. x1 = (819*cr-614*cb)/32 + 51; 28. y1 = (819*cr+614*cb)/32 + 77; 29. x1 = x1*41/1024; 30. y1 = y1*73/1024; 31. value = x1*x1+y1*y1; 32.if(y<100) (*pMask)=(value<700) ? 255:0; 33.else (*pMask)=(value<850)? 255:0; 34. pY++; 35. pCr++; 36. pCb++; 37. pMask++; 38. } 39. cvReleaseImage(&imgY); 40. cvReleaseImage(&imgCr); 41. cvReleaseImage(&imgCb); 42. cvReleaseImage(&imgYCrCb); 基于粒子滤波算法的目标跟踪及遮挡处理算法 1.1引言 对运动目标物的跟踪也是视觉监控系统中的基础算法之一。目标跟踪的任务是通过对图像序列的处理,准确估计出感兴趣目标物在每个时刻的运动参数,包括位置、大小、速度、加速度以及运动轨迹等,为行为理解等更高层的任务打下基础。本章首先概述目标跟踪算法的基本步骤和难点,并对现有算法作分类简介;然后对实现鲁棒跟踪所必需的工具——在线贝叶斯估计算法作详细介绍;在此基础上详细论述本文使用的跟踪方法,该方法将已有的多种先进算法有机结合,使计算量显著降低,鲁棒性增强;最后对提出的算法进行总结和分析。 1.2 目标跟踪算法概述 目标跟踪算法主要由两个部分组成:(1)目标物表示;(2)运动状态估计。下面对它们分别介绍。 1.2.1目标物表示 目标物表示的核心在于特征的选择和提取,即用什么特征来描述和表示感兴趣目标物。一个好的目标物表示方法应该能够将被跟踪的目标物和背景中的物体以及其它物体区别开来,这正是目标物表示的难点所在。运动目标物所在的环境通常是很杂乱的,其中存在许多与目标物有相似特征的物体。例如:房间内的窗帘、家具等往往与人的皮肤颜色相近;当监控视野中存在多个行人的时候,跟踪器容易将目标行人与其他行人相混淆。下面介绍几种常用的特征。 1.2.1.1颜色特征 颜色是人类辨识物体的重要特征,也是视觉跟踪中最常用的特征之一。颜色特征通常是在一块区域中提取出来的,因此它具有对目标平面旋转、非刚性形变、远离或靠近镜头的尺度变化以及部分遮挡等情形较为鲁棒的优点。另外,由于图像直接由一个个像素的颜色值所表示,因此颜色特征还具有容易提取、计算简单的优点。 最常用的颜色特征是颜色直方图。Comaniciu等人提出了基于颜色直方图的跟踪算法[1][2]。在他们的方法中,颜色直方图受到了核函数的空间加权。这样区域内中心附近的像素对颜色直方图有更大的贡献,使跟踪更加精确,因为区域边 图像处理综合实践 课程设计报告 设计题目:NO1、肤色检测 学院自动化与信息工程学院 专业 班级 姓名 学号 指导教师张志禹 2011 年秋季学期 起止时间:2011年12月25日至2012年1月2日 一、设计思路 肤色检测原理是根据皮肤的固有色彩,在图像中选取相对应的颜 色范围作为皮肤颜色。给定一幅包含人像的彩色图像,将其转换至其它表色系,利用肤色检测算法将皮肤区域以二值图像的形式检测出来并对比算法效果。在本次课程设计中,我们组确定将图像分别转换到HSV 表色系和YCbCr 表色系下,然后将不同表色系下的图像分别转换成相应的二值图,对比观察图像转换结果,以得到实验的实验结论。 1)HSV 表色系下的肤色检测原理 HSV 表色系包含三个属性:图像的色调(Hue),即表示相应的颜色;饱和度(Saturation),即表示颜色的纯度;亮度(Value),即颜色的亮暗程度。所以该表色系是分别对图像的色调,饱和度和亮度进行描述的,根据皮肤的固有色调可以提取出皮肤区域。 图像从Rgb 表色系转换到hsv 表色系固定公式如下: max(,,)V R G B = [min(,,)]/,00,0V R G B V V S V ->?=?=? 60()/,60(2()/),60(4()/), 00360,0 G B SV V R B R SV V G H R G SV V B V H H -=??+-=??=+-=??=?+ 第24卷 第12期2007年12月 公 路 交 通 科 技 Journal of Highway and Transportation Research and Development Vol 24 No 12 Dec 2007 文章编号:1002 0268(2007)12 0127 05 收稿日期:2006 08 01 基金项目:江苏省科技计划高技术研究项目(BG2005008) 作者简介:胡铟(1973-),男,江西南昌人,博士研究生,研究方向为计算机视觉、目标检测及跟踪 (huyinyx@163 com) 基于单目视觉的路面车辆 检测及跟踪方法综述 胡 铟,杨静宇 (南京理工大学,江苏 南京 210094) 摘要:首先介绍了车辆检测算法的3种基本组成部分:检测、验证、跟踪,然后根据算法的组成重点介绍了车辆检测以及跟踪的几种主要算法。车辆检测算法包括基于特征的方法、基于光流场的方法和基于模型的方法,车辆跟踪算法包括基于区域相关的方法、基于活动轮廓的方法、基于特征的方法和MeanShift 快速跟踪算法。根据试验结果对各种车辆检测和跟踪方法的优点、缺点以及实际应用中不同情况下适用范围的局限性进行了综合分析。最后在结论部分总结展望了文中介绍的几种车辆检测和跟踪方法的应用前景,并提出了在实际应用时的一些建议和将来的主要研究和发展方向。 关键词:智能运输系统;车辆检测;单目视觉;跟踪中图分类号:TP391 4 文献标识码:A Veh icle D etection and Tracking Based on Monocu lar Vision HU Yin,YANG Jing yu (Nanjing Universi ty of Science &Technology,Jiangsu Nanjing 210094,China) Abstract :First,the three component of the vehicle detection algori thm including detection, verification and tracking are discussed Then,the algorithm of detection and tracking are discussed with emphasis on composition The vehicle detection algorithm includes feature based,op tical flow based and model based method The vehicle tracking al gorithm includes region correlation based,active contours based,feature based and mean shift based method The meri t and di sadvantage of these algori th ms is discussed accordin g to the result of experimentation Finally,some suggestions for fu ture research and application are presented Key words :Intelligent Transport Systems;vehicle detection;monocular visi on;trackin g 0 引言 近年来随着计算机视觉技术的发展,计算机视觉 在智能交通系统中得到了广泛的应用,如交通事件及流量的监测 [1] 、路面病害检测以及智能车辆的自动导 航等。作为智能交通系统的一个方面,智能车辆利用检测和智能算法去理解车辆的即时环境,并且提示驾驶员部分或完全控制车辆的行驶。 智能车辆的应用领域可以分为: (1)为驾驶员提供建议或警告(碰撞报警)。(2)部分的控制车辆,可以是持续的驾驶辅助, 如行道线的维持,或者是紧急事件的干预,碰撞的紧急避免措施。 (3)完全的控制车辆(自动驾驶系统)。 在过去的几年中,为了研究改良安全性和防止事故的新技术,许多国家和国际间的项目开始启动。车辆事故的统计数据揭示出其他车辆是驾驶员面临的主要威胁。因此研究对驾驶员发出关于行驶环境和可能与其他车辆碰撞的警告辅助系统受到更多的关注。 利用光学传感器的车辆检测是一个极富挑战性的任务,具体说有如下需要解决的难点问题: (1)车型多样:各种形状,大小,颜色; 遮挡检测算法分比较研究 ————————————————————————————————作者:————————————————————————————————日期: 遮挡检测算法分析比较研究-建筑论文 遮挡检测算法分析比较研究 王玉锋全吉成刘宇王宏伟赵秀影 (中国人民解放军空军航空大学航空航天情报系,吉林长春130022)【摘要】真正射影像不仅具有地图的几何精度,可以直接进行地物尺寸和距离的测量,而且具有更好的视觉效果。有效的遮挡检测是真正射影像制作关键环节,国内外学者提出了许多遮挡检测算法,在进行遮挡区域检测的过程中各有优劣。通过对主要的遮挡检测算法原理和处理过程进行对比分析,总结了各个算法的优缺点,为寻求高效准确的遮挡检测算法提供参考,并提供了一些可以改进的建议。 关键词真正射影像;遮挡检测;Z-Buffer算法;PBI算法 A Comparative Study of Occlusion Detection Algorithm WANG Yu-feng QUAN ji-cheng LIU Yu WANG Hong-wei ZHAO Xiu-ying (Aerospace Intelligence department, The aeronautical university of the China People Liberation Airforce, Changchun Jilin 130022, China)【Abstract】True orthophoto has not only the geometric accuracy of map, can be directly measured object size and distance, and has better visual effect. Effective occlusion detection is a key link in true orthophoto production, domestic and foreign scholars have put forward a lot of occlusion detection algorithm, in each have advantages and disadvantages in the process of the occlusion detection. Based on the 一.车速、车流量检测 对车速、车流量的检测需要用多幅连续的动态图像。 1.运动车辆检测 车速与车流量检测的前提是要从图像中准确提取出运动车辆。提取运动车辆一般都是用差分法,常用的有背景差分法和帧间差分法。 背景差分是从图像中选取一帧作为背景帧,通过将当前帧与背景帧图像差分来判断是否有运动车辆;背景差分的主要问题是背景的更新,因为随着时间的变化,静态的背景也会发生改变,所以需要实时地对背景图像更新,现在已经有比较成熟的自适应背景更新算法来解决这一问题。 帧间差分法是通过将当前帧与上一帧图像差分来判断是否有运动车辆;帧差分法可以去除背景图像使保留下来的部分全为运动车辆的图像。但用这种方法当两帧间有重叠部分时重叠部分无法检测出来,使运动目标出现断裂,给后续的处理带来不便。 因此本系统宜采用背景差分并应用自适应背景更新算法来动态更新背景。2.背景差分中背景更新算法 背景差分的关键是要能保证背景图像的准确性,简单而又常用的自适应背景更新算法有以下两种: A.基于帧间像素灰度变化的背景更新算法 基于帧间像素灰度变化的背景更新算法在具体处理上也可细分为很多种,但都大同小异。这种方法需要先提取出一幅初始的背景图像,可以简单地将第一帧图像作为初始背景图像,也可以将前N帧图像的中值或均值作为初始背景图像。 对于背景图像的更新,设B k-1(i,j)为原(i,j)处的原背景图像,B k(I,j)为更新后的背景图像,I k(i,j)为当前实际图像。得到目标二值图像: 其中T为选取的阀值,应该根据图像的变化动态来选取。对背景的更新公式为: a为原来的背景在更新后的背景中所占比例,占主要的部分。 或者用以下公式: 车辆检测技术的介绍 摘要:车辆检测是智能交通的组成部分,是实现智能化监测、控制、分析、决策、调度和疏导的依据。本文分析了智能交通中常用的车辆检测方式、环境适应性和优缺点及线圈检测和视频检测的应用。 1.引言 智能交通系统(Intelligent Transportation Systems,ITS)在我国得到了广泛应用。车辆检测是智能交通系统的组成部分,通过车辆检测方式采集有效的道路交通信息,获得交通流量、车速、道路占有率、车间距、车辆类型等基础数据,有目的地实现监测、控制、分析、决策、调度和疏导。目前,车辆检测器的种类很多,如有线圈检测、视频检测、微波检测、激光检测、声波检测、超声波检测、磁力检测、红外线检测等。本文列举了几种国内智能交通中常用的车辆检测方式、环境适应性以及优缺点。 2.车辆检测方式特点比较 2.1线圈检测方式 通过一个电感器件即环形线圈与车辆检测器构成一个调谐电子系统,当车辆通过或停在线圈上会改变线圈的电感量,激发电路产生一个输出,从而检测到通过或停在线圈上的车辆。线圈检测技术成熟、易于掌握、计数非常精确、性能稳定。缺点是交通流数据单一、安装过程对可靠性和寿命影响很大、修理或安装需中断交通、影响路面寿命、易被重型车辆、路面修理等损坏。另外高纬度开冻期和低纬度夏季路面以及路面质量不好的地方对线圈的维护工作量比较大的。 2.2视频检测方式 视频检测方式是一种基于视频图像分析和计算机视觉技术对路面运动目标物体进行检测分析的视频处理技术。它能实时分析输入的交通图像,通过判断图像中划定的一个或者多个检测区域内的运动目标物体,获得所需的交通数据。该系统的优点是无需破坏路面,安装和维护比较方便,可为事故管理提供可视图像、可提供大量交通管理信息、单台摄像机和处理器可检测多车道。它的缺点是精度不高,容易受环境、天气、照度、干扰物等影响,对高速移动车辆的检测和捕获有一定困难。因为,拍摄高速移动车辆需要有足够快的快门(至少是1/3000S )、 基于深度学习算法的遮挡行人检测 近年来,随着人工智能技术的迅猛发展,机器视觉渗透到我们生活中的各个方面,人们的生活发生了日新月异的变化。行人检测作为其中一项较为基础的识别技术,对安防监控、自动驾驶、新零售等多个领域提供技术支持,具有广泛的应用场景。 本论文主要以SSD目标检测算法为基础,针对遮挡行人这一特定目标,重新设计其网络结构,使其检测性能得到大幅度的提高。本文主要包括以下内容:论文对行人检测的研究难点及现状做了简单的总结,对传统的基于机器学习的行人检测方法以及基于深度学习目标检测算法的相关知识做了梳理。 其中,基于HOG+SVM的行人检测算法是传统方法中最为经典的一种算法,基于深度学习的目标检测算法主要包括RCNN系列、SSD以及YOLO系列三大类。之后,综合考虑检测的速度与性能,采用自建的遮挡行人数据集训练了一个基于SSD目标检测框架的行人检测系统,并用测试集以及重新标注的INRIA测试集对OpenCV中自带的基于HOG+SVM的行人检测系统和训练好的SSD模型进行对比实验。 实验结果表明SSD模型的检测效果要明显好于传统的基于HOG+SVM的行人检测系统,通过深度卷积神经网络学习到的特征更具有鲁棒性。最后,针对遮挡行人检测,对SSD模型的网络结构进行了相应的修改。 (1)在SSD模型的前置网络中,加入了SE-Inception结构,使其能够更加高效的提取特征;(2)重新设计了网络中的先验框,使其能够更加容易的匹配到行人的形状,并对小尺寸的行人采用了密集采样的策略;(3)针对行人中容易出现环境遮挡和相互遮挡的情况,在模型的训练集中加入了遮挡行人的数据,并采用 本文提出了一种基于肤色信息和眼睛粗略定位的人脸检测算法。该算法先对Anil K.Jain 的Cb、Cr椭圆聚类方法进行了改进,用改进的算法进行肤色提取,经过肤色区域的分析,对人脸区域进行预检测,确定人脸可能区域,然后再根据眼睛的粗略定位进一步确定人脸区域。一、肤色分析(skin.m) Anil K.Jain提出的基于YCbCr颜色空间的肤色模型,根据当前点的Cb Cr值判断是否为肤色。 1% Anil K.Jain提出的基于YCbCr颜色空间的肤色模型 2% 根据当前点的Cb Cr值判断是否为肤色 3function result = skin(Y,Cb,Cr) 4% 参数 5 a = 25.39; 6 b = 14.03; 7ecx = 1.60; 8ecy = 2.41; 9sita = 2.53; 10cx = 109.38; 11cy = 152.02; 12xishu = [cos(sita) sin(sita);-sin(sita) cos(sita)]; 13% 如果亮度大于230,则将长短轴同时扩大为原来的1.1倍 14if(Y > 230) 15 a = 1.1*a; 16 b = 1.1*b; 17end 18% 根据公式进行计算 19Cb = double(Cb); 20Cr = double(Cr); 21t = [(Cb-cx);(Cr-cy)]; 22temp = xishu*t; 23value = (temp(1) - ecx)^2/a^2 + (temp(2) - ecy)^2/b^2; 24% 大于1则不是肤色,返回0;否则为肤色,返回1 25if value > 1 26result = 0; 27else 西南交通大学 毕业设计(论文) 基于视频的车流量检测算法研究 专业: 自动化 指导老师: 侯进 二零一零年六月 西南交通大学本科毕业设计(论文)第I页 院系信息科学与技术学院专业自动化 年级2006级姓名安伟 题目基于视频的车流量检测算法研究 指导教师 评语 指导教师(签章) 评阅人 评语 评阅人(签章) 成绩 答辩委员会主任(签章) 年月日 毕业设计任务书 班级自动化2班学生姓名安伟学号2006 专业自动化 发题日期:2010 年1月1 日完成日期:2010 年6 月15 日 题目基于视频的车流量检测算法研究 题目类型:工程设计√技术专题研究理论研究软硬件产品开发 一、设计任务及要求 车流量信息是交通控制中的重要信息,其检测在智能交通系统中占有重要地位。基于视频图像处理技术的车流量检测系统,通过安装在道路旁边或者中间隔离带的支架上的摄像机和图像采集设备将实时的视频信息采入,经过对视频图像的处理分析可以进行车流量的实时检测。基于视频的车流量检测系统有易安装、维护及实现方便等明显的优势,非常有利于交通系统的管理及控制。具体要求如下: 1. 对图像进行预处理 2. 进行车流量的统计 3. 人机界面简单清楚友好 二、应完成的硬件或软件实验 采集视频图像,对图像进行分析处理,完成车流量的统计,与实际通过车辆数目比较,分析本系统的正确检测率。 三、应交出的设计文件及实物(包括设计论文、程序清单或磁盘、实验装置或产品等) 1. 毕业设计论文(必须完全符合学校规范,内容严禁有丝毫的抄袭剽窃) 2. CD-R(含论文,程序,程序使用说明书,演示视频,盘面注明姓名,专业,日期) 3. 英文翻译按学校规定,导师无特殊要求 基于遮挡检测的稠密立体匹配算法 刘小莉,郭永彩 重庆大学光电工程学院,重庆(400044) E-mail :mosqito007@https://www.doczj.com/doc/1315448396.html, 摘 要:在分析现有遮挡检测方法的基础上,利用左右视线的概念,提出新的遮挡检测方法, 在计算视差空间的过程中,引入多窗口法优化视差空间,并详细给出了多窗口法的具体实现 方法。实验结果表明,利用左右视线法检测遮挡的正确性及多窗口法的使用优于非多窗法。 关键词:立体匹配,遮掩,左右视线,多窗口 1. 概述 立体匹配通过寻找同一空间景物在不同视点下的投影图像的像素间的一一对应关系,最 终淂到该景物的视差图,并由此计算出深度/距离,进而完成其它目标任务。立体匹配是目前 计算机研究中的一个难点和热点,在许多计算机视觉的应用中它都是很关键的一个步骤,如 三维重构(3D reconstruction )、基于图形的绘制(image based rendering )等。Daniel Scharstein 和Richard Szeliski [1]对目前常见的一些立体匹配算法和算法评判标准做了一个很好的总结。 所有的算法都面临着一个由遮掩(occluding )所引起的问题,被遮掩区域只在一个摄像 机上成像,如果该区域未被标识为遮掩区,那么就会出现错误的匹配,从而产生错误的视差 图和深度图.目前用于遮挡检测的常用方法有:一种是根据Marr 和Poggio 提出的影像匹配的 唯一性和连续性约束,采用协同匹配算法检测遮挡[2];另一种算法采用自适应窗口[3]和“双向 匹配方法”[4]的算法来检测遮挡区域;Scharstein 和Szelski [5]提出了一个基于贝叶斯估计的影 像匹配模型;还有 就是在动态规划算法中应用顺序性约束来同时获取视差和检测遮挡[6]。 上述算法的关键是采用某种相似性准绳尽量降低被遮掩区域的匹配值[7],即它们没有利 用遮掩的本质,即眼、遮掩物体和被遮掩区1域在一条直线上,所以只是利用了间接的信息, 对复杂场景无能为力,有的算法已经开始考虑这一特性[8],由于在现实的空间三维坐标中, 这个遮掩特性及其不规则,因此需要在视差空间中进行分析。 2. 视差空间与遮掩分析 2.1视差空间 定义2-1:视差空间[9]是一个三维离散的空间,三维视差空间中的点(x,y,d )表示(x,y ) 具有视差d,其值被赋予具有视差d 的匹配估计值。如图所示,视差空间的一个x-D 的切面称 为视差空间图像。 图1 视差空间模型与视差空间图像(DSI ) Fig1 Disparity space and DSI 0引言 人脸检测技术不仅是人脸识别、表情识别、数字视频处理、视频检测等技术的重要前提条件,同时在模式识别、人机交互、智能监控、视频检索等领域引起了广泛的重视[1]。对于人脸检测,国内外研究者们提出了许多有效的人脸检测算法[2] ,大体上可以分为4类:基于知识的方法,不变特征量法,模版匹配方法,基于统计理论的方法。基于知识的方法检测速度较快,如Yang 和Huang 提出了基于镶嵌图的人脸检测方法[3],对于正面人脸的检测精度较高,但不适用于多姿态的人脸检测;基于模板的方法稳定性高且鲁棒性好,如梁路宏等提出的基于仿射模板匹配的方法来检测多姿态人脸,但使用各种倾斜角的模板与输入图像中的每一个可能窗口进行匹配[4],冗余匹配次数太多、检测速度难以提高。为了解决人脸尺寸的不 确定性,许多检测算法往往需在图像的多个分辨率上重复搜索[5],计算开销大。Pau1Viola 和Michael Jones 在2001年提出了一种基于Haar-Like 型特征的Adaboost 人脸检测算法[6],并使用Cascade 结构将第一个真正实时的人脸检测系统成功建立,因该算法具有检测率高,实时性好的优点,成为学术界普遍采用的方法,但该方法需要大量时间进行训练,导致检测系统的灵活性不强。对于复杂背景和人脸姿态未知情况下的人脸检测,很难在检测速度和精度上达到两全的效果。 梁路宏等在人脸检测研究综述中指出[7]:人脸检测研究的趋势是利用多种线索(头发、肤色、器官、轮廓、模板等)综合多种分类方法,启发式信息与统计学习方法相结合。本文算法就利用了基于人脸肤色区域象素分布的统计信息、人脸模板以及人脸特征等线索和分类方法,取得了很快的检测速度和较高的检测率。算法主要包括预处理、人脸粗检和人脸细检 收稿日期:2009-07-20;修订日期:2009-10-28。 智能技术 采用大华自主研发的视频分析算法,该算法利用智能神经网络技术,对视频图像进行分层处理,并借助计算机强大的数据处理功能,对视频画面中的海量数据进行高速分析,过滤掉冗余的信息,分离出对系统有用的关键信息。 神经网络是基于模拟人脑智能特点和结构的一种信息处理系统,它通过对人脑的基本单元的建模和典型的激励函数的设计,来探索模拟人脑神经系统功能的模型,并研制一种具有并行分布处理与存储、高度自适应和自学功能、能分析较为复杂的非线性系统的软件模拟技术。大华视频检测系统采用的视频分析算法主要包括: 牌照定位分析算法:系统从车辆进入检测区域的第一帧开始,逐帧对牌照定位、跟踪、识别,通过对牌照的跟踪,来获取车辆信息,此算法可以保证在有牌照且牌照无污损、无遮挡情况下,准确捕获车辆。 车辆运动轨迹跟踪算法:系统从车辆进入监测区域的第一帧开始,跟踪分析车辆的运动轨迹,通过轨迹跟踪来获取车辆信息。此算法在无首尾相接的情况下,可以保持较高的识别准确率。 车灯运动轨迹跟踪算法:系统采用车灯光线轨迹跟踪技术,通过对车灯光线由远及近的运动轨迹进行跟踪,来确定车辆的运动轨迹,获取车辆的信息。可以保证在不加频闪灯的方式下,具有较高的捕捉率。 白天,系统通过牌照定位分析算法和车辆运行轨迹跟踪算法,双重分析,选择可信度高的识别结果作为最终结果;晚上,系统通过车灯运动轨迹跟踪算法来获取车辆信息。 为了保证系统在任何时段都有较高的捕获率,白天和晚上的算法切换采用双重标准,一是时间、日期,二是环境参数,如亮度等。通过两种参数的综合分析来准确掌握算法的切换时机,完成算法的自动切换,保证系统较高的车辆捕获率。 车辆检测原理 采用基于运动检测的车辆检测方法,其核心原理是通过学习建立道路背景模型,将当前帧图像与背景模型进行背景差分得到运动前景像素点,然后对这些运动前景像素进行处理得到车辆信息。该方法效果的优劣依赖于背景建模算法的性能。其流程图如下所示: 车辆检测流程图 整个检测过程分为以下几个步骤: 1、由高清摄像抓拍主机获取实时的视频流。 2、利用背景差分算法检测运动前景。首先通过初始多帧视频图像的自学习建立一个背景模型,然后对当前帧图像与背景模型进行差分运算,消除背景的影响,从而获取运动目标的前景区域。 基于matlab的图像边缘检测算法研究和仿真 目录 第1章绪论 1 1.1 序言 1 1.2 数字图像边缘检测算法的意义 1 第2章传统边缘检测方法及理论基础 2 2.1 数字图像边缘检测的现状与发展 2 2.2 MATLAB和图像处理工具箱的背景知识 3 2.3 数字图像边缘检测关于边缘的定义 4 2.4 基于一阶微分的边缘检测算子 4 2.5 基于二阶微分的边缘检测算子 7 第3章编程和调试 10 3.1 edge函数 10 3.2 边缘检测的编程实现 11 第4章总结 13 第5章图像边缘检测应用领域 13 附录参考文献 15 第1章绪论 §1.1 序言 理解图像和识别图像中的目标是计算机视觉研究的中心任务,物体形状、物体边界、位置遮挡、阴影轮廓及表面纹理等重要视觉信息在图像中均有边缘产生。图像边缘是分析理解图像的基础,它是图像中最基本的特征。在Marr的计算机视觉系统中,图像边缘提取占据着非常重要位置,它位于系统的最底层,为其它模块所依赖。图像边缘提取作为计算机视觉领域最经典的研究课题,长期受到人们的重视。 图像边缘主要划分为阶跃状和屋脊状两种类型。阶跃状边缘两侧的灰度值变化明显,屋脊状边缘则位于灰度增加与减少的交界处。传统的图像边缘检测方法大多是从图像的高频分量中提取边缘信息,微分运算是边缘检测与提取的主要手段。由于传统的边缘检测方法对噪声敏感,所以实际运用效果有一定的局限性。近年来,越来越多的新技术被引入到边缘检测方法中,如数学形态学、小波变换、神经网络和分形理论等。 Canny于1986年提出基于最优化算法的边缘检测算子,得到了广泛的应用,并成了与其它实验结果作比较的标准。其原因在于他最先建立了优化边缘检测算子的理论基础,提出了迄今为止定义最为严格的边缘检测的三个标准。另外其相对简单的算法使得整个过程可以在较短的时间实现。实验结果也表明,Canny算子在处理受加性高斯白噪声污染的图像方面获得了良好的效果[1]。 §1.2 数字图像边缘检测算法的意义 数字图像处理是控制领域的重要课题,数字图像边缘检测是图像分割、目标区域识别和区域形状提取等图像分析领域十分重要的基础,是图像识别中提取图像特征的一个重要方法。边缘中包含图像物体有价值的边界信息,这些信息可以用于图像理解和分析,并且通过边缘检测可以极降低后续图像分析和处理的数据量。图像理解和分析的第一步往往就是边缘检测,目前它已成为机器视觉研究领域最活跃的课题之一,在工程应用中占有十分重要的地位。 图像的边缘检测技术是数字图像处理技术的基础研究容,是物体识别的重要基础。边缘特征广泛应用于图像分割、运动检测与跟踪、工业检测、目标识别、双目立体视觉等领域。现有边缘检测技术在抑制噪声方面有一定的局限性,在阈值参数选取方面自适几种常用边缘检测算法的比较

单目机器人障碍物检测研究

基于肤色检测和背景差分的人手定位和跟踪

基于canny算子的改进边缘检测算法

OpenCV下肤色检测代码

图像处理算法5_目标跟踪及遮挡处理算法

肤色检测

基于单目视觉的路面车辆检测及跟踪方法综述

遮挡检测算法分比较研究

车速检测算法

车辆检测技术的介绍

基于深度学习算法的遮挡行人检测

基于肤色和眼睛定位的人脸检测算法——MATLAB实现

基于视频的车流量检测算法研究

基于遮挡检测的稠密立体匹配算法

复杂背景下基于肤色分割的人脸检测算法研究

智能交通 - 车辆视频检测原理

基于matlab的图像边缘检测算法研究和仿真设计