k-means 算法

一.算法简介

k -means 算法,也被称为k -平均或k -均值,是一种得到最广泛使用的聚类算法。 它是将各个聚类子集内的所有数据样本的均值作为该聚类的代表点,算法的主要思想是通过迭代过程把数据集划分为不同的类别,使得评价聚类性能的准则函数达到最优,从而使生成的每个聚类内紧凑,类间独立。这一算法不适合处理离散型属性,但是对于连续型具有较好的聚类效果。

二.划分聚类方法对数据集进行聚类时包括如下三个要点:

(1)选定某种距离作为数据样本间的相似性度量

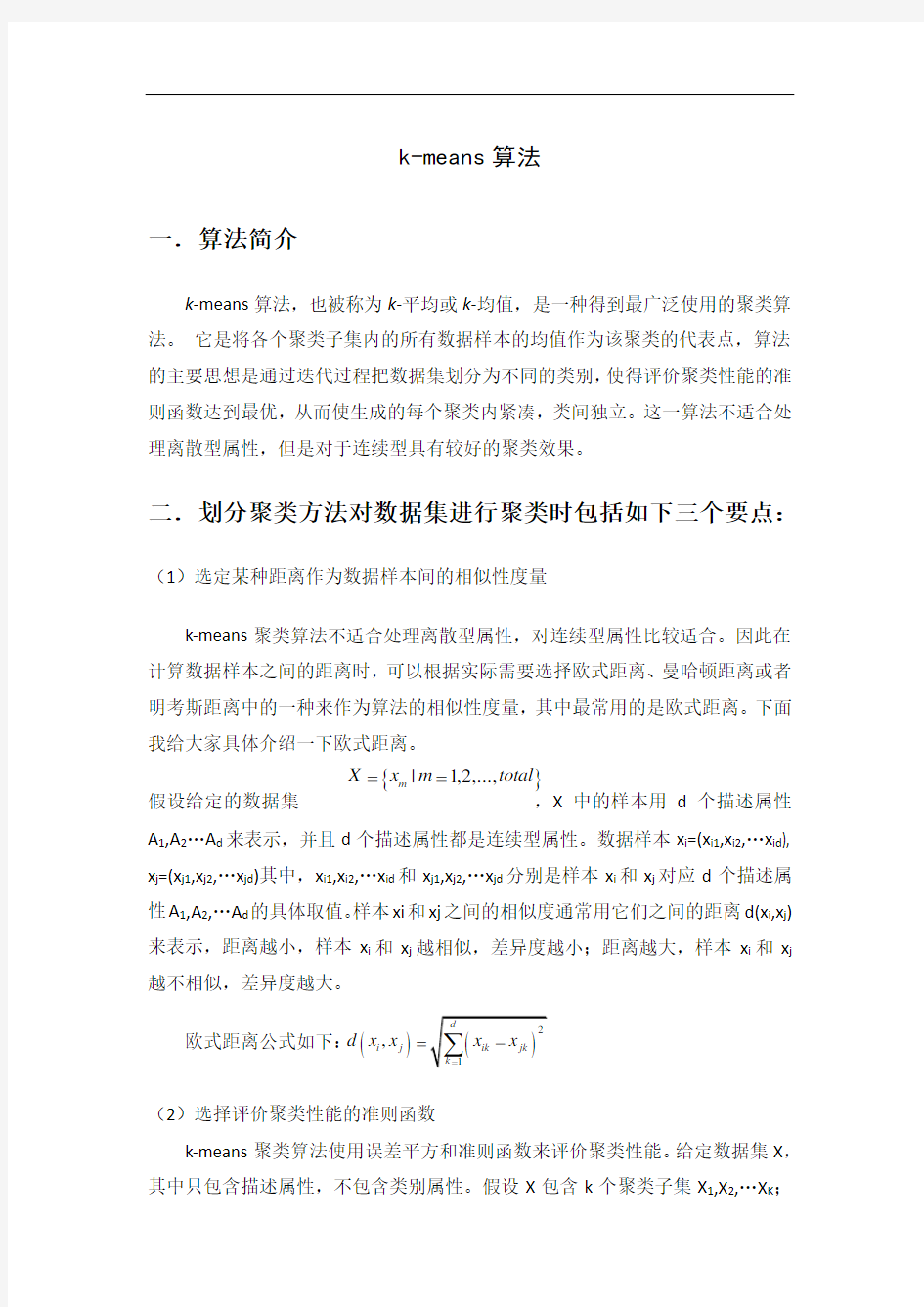

k-means 聚类算法不适合处理离散型属性,对连续型属性比较适合。因此在计算数据样本之间的距离时,可以根据实际需要选择欧式距离、曼哈顿距离或者明考斯距离中的一种来作为算法的相似性度量,其中最常用的是欧式距离。下面我给大家具体介绍一下欧式距离。

假设给定的数据集 ,X 中的样本用d 个描述属性A 1,A 2…A d 来表示,并且d 个描述属性都是连续型属性。数据样本x i =(x i1,x i2,…x id ), x j =(x j1,x j2,…x jd )其中,x i1,x i2,…x id 和x j1,x j2,…x jd 分别是样本x i 和x j 对应d 个描述属性A 1,A 2,…A d 的具体取值。样本xi 和xj 之间的相似度通常用它们之间的距离d(x i ,x j )来表示,距离越小,样本x i 和x j 越相似,差异度越小;距离越大,样本x i 和x j 越不相似,差异度越大。

欧式距离公式如下:

(2)选择评价聚类性能的准则函数

k-means 聚类算法使用误差平方和准则函数来评价聚类性能。给定数据集X ,其中只包含描述属性,不包含类别属性。假设X 包含k 个聚类子集X 1,X 2,…X K ;

{}

|1,2,...,m X x m total ==()

,i j d x x =

各个聚类子集中的样本数量分别为n 1,n 2,…,n k ;各个聚类子集的均值代表点(也称聚类中心)分别为m 1,m 2,…,m k 。

则误差平方和准则函数公式为: (3)相似度的计算根据一个簇中对象的平均值来进行。 1) 将所有对象随机分配到k 个非空的簇中。

2) 计算每个簇的平均值,并用该平均值代表相应的簇。 3) 根据每个对象与各个簇中心的距离,分配给最近的簇。

4) 然后转2),重新计算每个簇的平均值。这个过程不断重复直到满足某个准则函数才停止。

三.算法描述

1. 为中心向量c 1, c 2, …, c k 初始化k 个种子

2. 分组:

a) 将样本分配给距离其最近的中心向量

b) 由这些样本构造不相交( non-overlapping )的聚类 3. 确定中心:

a) 用各个聚类的中心向量作为新的中心 4. 重复分组和确定中心的步骤,直至算法收敛

四.算法流程

输入:簇的数目k 和包含n 个对象的数据库。 输出:k 个簇,使平方误差准则最小。 算法步骤:

1.为每个聚类确定一个初始聚类中心,这样就有K 个初始聚类中心。

2.将样本集中的样本按照最小距离原则分配到最邻近聚类

3.使用每个聚类中的样本均值作为新的聚类中心。

4.重复步骤步直到聚类中心不再变化。

2

1i k

i

i p X E p m =∈=-∑∑

5.结束,得到K 个聚类

五.算法举例

数据对象集合S 见表1,作为一个聚类分析的二维样本,要求的簇的数量k=2。

(1)选择 , 为初始的簇中心,即 , (2)对剩余的每个对象,根据其与各个簇中心的距离,将它赋给最近的簇。 对 : 显然 ,故将 分配给 对于 : 因为 ,所以将 分配给

对于 : 因为 ,所以将 分配给 更新,得到新簇 和 计算平方误差准则,单个方差为

总体平均方差是: (3)计算新的簇的中心。

重复(2)和(3),得到O 1分配给C 1;O 2分配给C 2,O 3分配给C 2 ,O 4分配给

C 2,O 5分配给C 1。更新,得到新簇 和 。 中心为 , 。 单个方差分别为

()10,2O ()20,0O ()110,2M O ==()220,0M O

==3O (

)13, 2.5d M O =

=(

)23, 1.5

d M O ==()()2313,,d M

O d M O ≤3O 2C 4O ()

14,d M O =

=()

24

,5d M O ==()()2414,,d M O d M O ≤4O 2c 5O ()15,5d M O =

=()25,d M O ==()()1525,,d M O d M O ≤5O 1

C {}115,C O O ={}2234,,C O O O =()())(()2

222

10022052225E ????=-+-+-+-=????

227.25

E =122527.2552.25

E E E =+=+=()()()()2,5.2222,2501=++=M ()()()()

20 1.553,000 2.17,0M =++++={}115,C O O ={}2234,,C O O O =()2,5.21=M ()2 2.17,0M =()())(()2222

10 2.522 2.552212.5E ????=-+-+-+-=????

213.15

E =

总体平均误差是: 由上可以看出,第一次迭代后,总体平均误差值~,显着减小。由于在两次迭代中,簇中心不变,所以停止迭代过程,算法停止。

六.k -means 算法的性能分析

k -means 算法的优缺点 主要优点:

1. 是解决聚类问题的一种经典算法,简单、快速。

2. 对处理大数据集,该算法是相对可伸缩和高效率的。因为它的复杂度是0 (n k

t ) , 其中, n 是所有对象的数目, k 是簇的数目, t 是迭代的次数。通常k < 3. 当结果簇是密集的,而簇与簇之间区别明显时, 它的效果较好。 主要缺点 1. 在簇的平均值被定义的情况下才能使用,这对于处理符号属性的数据不适 用。 2. 必须事先给出k (要生成的簇的数目),而且对初值敏感,对于不同的初始值, 可能会导致不同结果。 3. 它对于“躁声”和孤立点数据是敏感的,少量的该类数据能够对平均值产生 极大的影响。 针对K-Means 算法对于不同的初始值,可能会导致不同结果。解决方法: 1.多设置一些不同的初值,对比最后的运算结果)一直到结果趋于稳定结束,比较耗时和浪费资源 2.很多时候,事先并不知道给定的数据集应该分成多少个类别才最合适。这也是 K-means 算法的一个不足。有的算法是通过类的自动合并和分裂,得到较为合理的类型数目 K ,例如 ISODATA 算法。 3. 所谓的gapstatistics ( Gap 统计模型) ISODATA 算法 12 12.513.1525.65 E E E =+=+= ISODATA算法与K-均值算法的比较: 1.K-均值算法通常适合于分类数目已知的聚类,而ISODATA算法则更加灵活; 2.从算法角度看,ISODATA算法与K-均值算法相似,聚类中心都是通过样本均 值的迭代运算来决定的; 3.ISODATA算法加入了一些试探步骤,并且可以结合成人机交互的结构,使其 能利用中间结果所取得的经验更好地进行分类。主要是在选代过程中可将一类一分为二,亦可能二类合二为一,即“自组织”,这种算法具有启发式的特点。 ISODATA算法与K-means相比在下列几方面有改进: 1.考虑了类别的合并与分裂,因而有了自我调整类别数的能力。合并主要发生在某一类内样本个数太少的情况,或两类聚类中心之间距离太小的情况。为此设有最小类内样本数限制,以及类间中心距离参数。若出现两类聚类中心距离小于的情况,可考虑将此两类合并。 分裂则主要发生在某一类别的某分量出现类内方差过大的现象,因而宜分裂成两个类别,以维持合理的类内方差。给出一个对类内分量方差的限制参数,用以决定是否需要将某一类分裂成两类。 2.由于算法有自我调整的能力,因而需要设置若干个控制用参数,如聚类数期望值K、每次迭代允许合并的最大聚类对数L、及允许迭代次数I等。 ISODATA算法基本步骤和思路 选择某些初始值。可选不同的参数指标,也可在迭代过程中人为修改,以将N个模式样本按指标分配到各个聚类中心中去。 计算各类中诸样本的距离指标函数。 (3)~(5)按给定的要求,将前一次获得的聚类集进行分裂和合并处理((4)为分裂处理,(5)为合并处理),从而获得新的聚类中心。 重新进行迭代运算,计算各项指标,判断聚类结果是否符合要求。经过多次迭代后,若结果收敛,则运算结束。 k-means算法初始中心的选取对算法的影响 棋盘格数据集(Checkerboard data set)仅使用其中486个正类数据,并将数据变换到[-1,1]之间,分布情况如下图所示: 原始数据 初始聚类中心均在中心附近 初始聚类中心在平面内随机选取 七.k-means算法的改进方法 k-means算法的改进方法——k-mode 算法 k-modes 算法:实现对离散数据的快速聚类,保留了k-means算法的效率同时将k-means的应用范围扩大到离散数据。 K-modes算法是按照k-means算法的核心内容进行修改,针对分类属性的度量和更新质心的问题而改进。 具体如下: 1.度量记录之间的相关性D的计算公式是比较两记录之间,属性相同为0,不同为1.并所有相加。因此D越大,即他的不相关程度越强(与欧式距离代表的意义是一样的); 2.更新modes,使用一个簇的每个属性出现频率最大的那个属性值作为代表簇的属性值。 k-means算法的改进方法——k-prototype算法 k-Prototype算法:可以对离散与数值属性两种混合的数据进行聚类,在k-prototype中定义了一个对数值与离散属性都计算的相异性度量标准。 K-Prototype算法是结合K-Means与K-modes算法,针对混合属性的,解决2个核心问题如下: 1.度量具有混合属性的方法是,数值属性采用K-means方法得到P1,分类属性采用K-modes方法P2,那么D=P1+a*P2,a是权重,如果觉得分类属性重要,则增加a,否则减少a,a=0时即只有数值属性 2.更新一个簇的中心的方法,方法是结合K-Means与K-modes的更新方法。k-means算法的改进方法——k-中心点算法 k-中心点算法:k -means算法对于孤立点是敏感的。为了解决这个问题,不 采用簇中的平均值作为参照点,可以选用簇中位置最中心的对象,即中心点作为参照点。这样划分方法仍然是基于最小化所有对象与其参照点之间的相异度之和的原则来执行的。 八.K-means算法在图像分割上的简单应用 例1: 图片:一只遥望大海的小狗;此图为100 x 100像素的JPG图片,每个像素可以表示为三维向量(分别对应JPEG图像中的红色、绿色和蓝色通道);将图片分割为合适的背景区域(三个)和前景区域(小狗); 1.使用K-means算法对图像进行分割。 分割后的效果(注:最大迭代次数为20次,需运行多次才有可能得到较好的效果。)例2: 注:聚类中心个数为5,最大迭代次数为10。 聚类中心个数为3 (程序如下) clc clear tic RGB= imread (''); %读入像 img=rgb2gray(RGB); [m,n]=size(img); subplot(2,2,1),imshow(img);title(' 图一原图像') subplot(2,2,2),imhist(img);title(' 图二原图像的灰度直方图') hold off; img=double(img); for i=1:200 c1(1)=25; c2(1)=125; c3(1)=200;%选择三个初始聚类中心 r=abs(img-c1(i)); g=abs(img-c2(i)); b=abs(img-c3(i));%计算各像素灰度与聚类中心的距离 r_g=r-g; g_b=g-b; r_b=r-b; n_r=find(r_g<=0&r_b<=0);%寻找最小的聚类中心 n_g=find(r_g>0&g_b<=0);%寻找中间的一个聚类中心 n_b=find(g_b>0&r_b>0);%寻找最大的聚类中心 i=i+1; c1(i)=sum(img(n_r))/length(n_r);%将所有低灰度求和取平均,作为下一个低灰度中心 c2(i)=sum(img(n_g))/length(n_g);%将所有低灰度求和取平均,作为下一个中间灰度中心 c3(i)=sum(img(n_b))/length(n_b);%将所有低灰度求和取平均,作为下一个高灰度中心 d1(i)=abs(c1(i)-c1(i-1)); d2(i)=abs(c2(i)-c2(i-1)); d3(i)=abs(c3(i)-c3(i-1)); if d1(i)<=&&d2(i)<=&&d3(i)<= R=c1(i); G=c2(i); B=c3(i); k=i; break; end end R G B img=uint8(img); img(find(img img(find(img>R&img img(find(img>G))=255; toc subplot(2,2,3),imshow(img);title(' 图三聚类后的图像') subplot(2,2,4),imhist(img);title(' 图四聚类后的图像直方图') K-means聚类算法 K-means也是聚类算法中最简单的一种了,但是里面包含的思想却是不一般。最早我使用并实现这个算法是在学习韩爷爷那本数据挖掘的书中,那本书比较注重应用。看了Andrew Ng的这个讲义后才有些明白K-means后面包含的EM思想。 聚类属于无监督学习,以往的回归、朴素贝叶斯、SVM等都是有类别标签y的,也就是说样例中已经给出了样例的分类。而聚类的样本中却没有给定y,只有特征x,比如假设 宇宙中的星星可以表示成三维空间中的点集。聚类的目的是找到每个样本x潜在的类别y,并将同类别y的样本x放在一起。比如上面的星星,聚类后结果是一个个星团,星团里面的点相互距离比较近,星团间的星星距离就比较远了。 在聚类问题中,给我们的训练样本是,每个,没有了y。 K-means算法是将样本聚类成k个簇(cluster),具体算法描述如下: 1、随机选取k个聚类质心点(cluster centroids)为。 2、重复下面过程直到收敛 { 对于每一个样例i,计算其应该属于的类 对于每一个类j,重新计算该类的质心 } K是我们事先给定的聚类数,代表样例i与k个类中距离最近的那个类,的值 是1到k中的一个。质心代表我们对属于同一个类的样本中心点的猜测,拿星团模型来解释就是要将所有的星星聚成k个星团,首先随机选取k个宇宙中的点(或者k个星星)作为k个星团的质心,然后第一步对于每一个星星计算其到k个质心中每一个的距离,然后选取 距离最近的那个星团作为,这样经过第一步每一个星星都有了所属的星团;第二步对于 每一个星团,重新计算它的质心(对里面所有的星星坐标求平均)。重复迭代第一步和第二步直到质心不变或者变化很小。 下图展示了对n个样本点进行K-means聚类的效果,这里k取2。 K-means面对的第一个问题是如何保证收敛,前面的算法中强调结束条件就是收敛,可以证明的是K-means完全可以保证收敛性。下面我们定性的描述一下收敛性,我们定义畸变函数(distortion function)如下: J函数表示每个样本点到其质心的距离平方和。K-means是要将J调整到最小。假设当 前J没有达到最小值,那么首先可以固定每个类的质心,调整每个样例的所属的类别来让J函数减少,同样,固定,调整每个类的质心也可以使J减小。这两个过程就是内循环中使J单调递减的过程。当J递减到最小时,和c也同时收敛。(在理论上,可以有多组不同的和c值能够使得J取得最小值,但这种现象实际上很少见)。 K-means 算法的实现与应用举例 1 K-means 方法 K-means 算法如下: S1:初始化,聚类中心k c ,,c c 21,标号集 k I I I 21; S2: 分类: end ;i I I ; c x c x j n i for j j T j i j i k j **1*min arg :1 S3:重新计算聚类中心: end ;x I c k j for j I i i j j 1 :1 S4:迭代S2-S3,直至收敛。 其matlab 程序见附录1。 2实验 实验1 随机生成300个 44, 之间的二维数对,用K-means 算法将其分为两类(其matlab 程序见附录2),如fig1,由图1(b)可看出,离群点对聚类中心的位置有明显的影响。 实验2 随机生成600个二维数对,其中300个落于以(0,0)为圆心的单位圆,另外300 (a) (b) fig1 实验1 个落入(2,2)为圆心的单位圆,用K-means 算法将其分为两类(其matlab 程序见附录2),如fig2(a),而fig2(b)则为在以上实验的基础上增加了30个干扰点之后的分类图,可见K-means 算法不能对其很好的分类,离群点对聚类中心的位置有明显的影响。 实验3 随机生成600个二维数对,其中300个落于以(0,0)为圆心的单位元,另外300个落入以(0,0)为圆心的单位圆,长半径为3短半径为2的圆盘,用K-means 算法将其分为2类(其matlab 程序见附录2),结果见fig3,可见K-means 算法同样不能对其很好的分类。 3 K-means 算法修正 修正一:实验2中增加离群点后,K-means 算法失效,是因为采用2范数计算距离,使计算出的重心与实际重心存在较大的误差。为减小误差,可以采用1-范数计算距离,或是采用中值代替均值计算新的聚类中心,即 k ,j , I i x medium c j i j 1 (a) (b) fig2 实验2 fig3 实验3 k-means 算法 一.算法简介 k -means 算法,也被称为k -平均或k -均值,是一种得到最广泛使用的聚类算法。 它是将各个聚类子集内的所有数据样本的均值作为该聚类的代表点,算法的主要思想是通过迭代过程把数据集划分为不同的类别,使得评价聚类性能的准则函数达到最优,从而使生成的每个聚类内紧凑,类间独立。这一算法不适合处理离散型属性,但是对于连续型具有较好的聚类效果。 二.划分聚类方法对数据集进行聚类时包括如下三个要点: (1)选定某种距离作为数据样本间的相似性度量 k-means 聚类算法不适合处理离散型属性,对连续型属性比较适合。因此在计算数据样本之间的距离时,可以根据实际需要选择欧式距离、曼哈顿距离或者明考斯距离中的一种来作为算法的相似性度量,其中最常用的是欧式距离。下面我给大家具体介绍一下欧式距离。 假设给定的数据集 ,X 中的样本用d 个描述属性A 1,A 2…A d 来表示,并且d 个描述属性都是连续型属性。数据样本x i =(x i1,x i2,…x id ), x j =(x j1,x j2,…x jd )其中,x i1,x i2,…x id 和x j1,x j2,…x jd 分别是样本x i 和x j 对应d 个描述属性A 1,A 2,…A d 的具体取值。样本xi 和xj 之间的相似度通常用它们之间的距离d(x i ,x j )来表示,距离越小,样本x i 和x j 越相似,差异度越小;距离越大,样本x i 和x j 越不相似,差异度越大。 欧式距离公式如下: (2)选择评价聚类性能的准则函数 k-means 聚类算法使用误差平方和准则函数来评价聚类性能。给定数据集X ,其中只包含描述属性,不包含类别属性。假设X 包含k 个聚类子集X 1,X 2,…X K ; {} |1,2,...,m X x m total ==() ,i j d x x = 机器学习算法day02_Kmeans聚类算法及应用课程大纲 Kmeans聚类算法原理Kmeans聚类算法概述 Kmeans聚类算法图示 Kmeans聚类算法要点 Kmeans聚类算法案例需求 用Numpy手动实现 用Scikili机器学习算法库实现 Kmeans聚类算法补充算法缺点 改良思路 课程目标: 1、理解Kmeans聚类算法的核心思想 2、理解Kmeans聚类算法的代码实现 3、掌握Kmeans聚类算法的应用步骤:数据处理、建模、运算和结果判定 1. Kmeans聚类算法原理 1.1 概述 K-means算法是集简单和经典于一身的基于距离的聚类算法 采用距离作为相似性的评价指标,即认为两个对象的距离越近,其相似度就越大。 该算法认为类簇是由距离靠近的对象组成的,因此把得到紧凑且独立的簇作为最终目标。 1.2 算法图示 假设我们的n个样本点分布在图中所示的二维空间。 从数据点的大致形状可以看出它们大致聚为三个cluster,其中两个紧凑一些,剩下那个松散一些,如图所示: 我们的目的是为这些数据分组,以便能区分出属于不同的簇的数据,给它们标上不同的颜色,如图: 1.3 算法要点 1.3.1 核心思想 通过迭代寻找k个类簇的一种划分方案,使得用这k个类簇的均值来代表相应各类样本时所得的总体误差最小。 k个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。 k-means算法的基础是最小误差平方和准则, 其代价函数是: 式中,μc(i)表示第i个聚类的均值。 各类簇内的样本越相似,其与该类均值间的误差平方越小,对所有类所得到的误差平方求和,即可验证分为k类时,各聚类是否是最优的。 上式的代价函数无法用解析的方法最小化,只能有迭代的方法。 1.3.2 算法步骤图解 下图展示了对n个样本点进行K-means聚类的效果,这里k取2。 实验三报告实验三-Kmeans算法实现 北华大学开放实验报告 实验名称:实验三Kmeans算法实现 所属课程:模式识别 班级:信息10—1 学号:36 姓名:张慧 实验三、K_means算法实现 一、背景知识简介: Kmeans算法是一种经典的聚类算法,在模式识别中得到了广泛的应用,基于Kmeans的变种算法也有很多,模糊Kmeans、分层Kmeans 等。 Kmeans和应用于混合高斯模型的受限EM算法是一致的。高斯混合模型广泛用于数据挖掘、模式识别、机器学习、统计分析。Kmeans的迭代步骤可以看成E步和M步,E:固定参数类别中心向量重新标记样本,M:固定标记样本调整类别中心向量。K均值只考虑(估计)了均值,而没有估计类别的方差,所以聚类的结构比较适合于特征协方差相等的类别。 二、k-means聚类算法 k-means 算法接受参数 k ;然后将事先输入的n个数据对象划分为 k个聚类以便使得所获得的聚类满足:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算的。 K-means算法是最为经典的基于划分的聚类方法,是十大经典数据挖掘算法之一。K-means算法的基本思想是:以空间中k个点 为中心进行聚类,对最靠近他们的对象归类。通过迭代的方法,逐次更新各聚类中心的值,直至得到最好的聚类结果。 (1)算法思路: 首先从n个数据对象任意选择 k 个对象作为初始聚类中心;而对于所剩下其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类;然后再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值);不断重复这一过程直到标准测度函数开始收敛为止。一般都采用均方差作为标准测度函数. k个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。 该算法的最大优势在于简洁和快速。算法的关键在于初始中心的选择和距离公式。 (2)算法步骤: step.1---初始化距离K个聚类的质心(随机产生) step.2---计算所有数据样本与每个质心的欧氏距离,将数据样本加入与其欧氏距离最短的那个质心的簇中(记录其数据样本的编号) step.3---计算现在每个簇的质心,进行更新,判断新质心是否与原质心相等,若相等,则迭代结束,若不相等,回到step2继续迭代。 (3)算法流程图 聚类分析K-means算法综述 摘要:介绍K-means聚类算法的概念,初步了解算法的基本步骤,通过对算法缺点的分析,对算法已有的优化方法进行简单分析,以及对算法的应用领域、算法未来的研究方向及应用发展趋势作恰当的介绍。 关键词:K-means聚类算法基本步骤优化方法应用领域研究方向应用发展趋势 算法概述 K-means聚类算法是一种基于质心的划分方法,输入聚类个数k,以及包含n个数据对象的数据库,输出满足方差最小标准的k个聚类。 评定标准:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算。 解释:基于质心的划分方法就是将簇中的所有对象的平均值看做簇的质心,然后根据一个数据对象与簇质心的距离,再将该对象赋予最近的簇。 k-means 算法基本步骤 (1)从n个数据对象任意选择k 个对象作为初始聚类中心 (2)根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分 (3)重新计算每个(有变化)聚类的均值(中心对象) (4)计算标准测度函数,当满足一定条件,如函数收敛时,则算法终止;如果条件不满足则回到步骤(2) 形式化描述 输入:数据集D,划分簇的个数k 输出:k个簇的集合 (1)从数据集D中任意选择k个对象作为初始簇的中心; (2)Repeat (3)For数据集D中每个对象P do (4)计算对象P到k个簇中心的距离 (5)将对象P指派到与其最近(距离最短)的簇; (6)End For (7)计算每个簇中对象的均值,作为新的簇的中心; (8)Until k个簇的簇中心不再发生变化 对算法已有优化方法的分析 (1)K-means算法中聚类个数K需要预先给定 这个K值的选定是非常难以估计的,很多时候,我们事先并不知道给定的数据集应该分成多少个类别才最合适,这也是K一means算法的一个不足"有的算法是通过类的自动合并和分裂得到较为合理的类型数目k,例如Is0DAIA算法"关于K一means算法中聚类数目K 值的确定,在文献中,根据了方差分析理论,应用混合F统计量来确定最佳分类数,并应用了模糊划分嫡来验证最佳分类数的正确性。在文献中,使用了一种结合全协方差矩阵RPCL算法,并逐步删除那些只包含少量训练数据的类。文献中针对“聚类的有效性问题”提出武汉理工大学硕士学位论文了一种新的有效性指标:V(k km) = Intra(k) + Inter(k) / Inter(k max),其中k max是可聚类的最大数目,目的是选择最佳聚类个数使得有效性指标达到最小。文献中使用的是一种称为次胜者受罚的竞争学习规则来自动决定类的适当数目"它的思想是:对每个输入而言不仅竞争获胜单元的权值被修正以适应输入值,而且对次胜单元采用惩罚的方法使之远离输入值。 (2)算法对初始值的选取依赖性极大以及算法常陷入局部极小解 不同的初始值,结果往往不同。K-means算法首先随机地选取k个点作为初始聚类种子,再利用迭代的重定位技术直到算法收敛。因此,初值的不同可能导致算法聚类效果的不稳定,并且,K-means算法常采用误差平方和准则函数作为聚类准则函数(目标函数)。目标函数往往存在很多个局部极小值,只有一个属于全局最小,由于算法每次开始选取的初始聚类中心落入非凸函数曲面的“位置”往往偏离全局最优解的搜索范围,因此通过迭代运算,目标函数常常达到局部最小,得不到全局最小。对于这个问题的解决,许多算法采用遗传算法(GA),例如文献中采用遗传算法GA进行初始化,以内部聚类准则作为评价指标。 (3)从K-means算法框架可以看出,该算法需要不断地进行样本分类调整,不断地计算调整后的新的聚类中心,因此当数据量非常大时,算法的时间开销是非常大 所以需要对算法的时间复杂度进行分析,改进提高算法应用范围。在文献中从该算法的时间复杂度进行分析考虑,通过一定的相似性准则来去掉聚类中心的候选集,而在文献中,使用的K-meanS算法是对样本数据进行聚类。无论是初始点的选择还是一次迭代完成时对数据的调整,都是建立在随机选取的样本数据的基础之上,这样可以提高算法的收敛速度。 数据挖掘课程报告 班级 XXXXXX 学生姓名 XXXXXX 学号 2010100XXXXX 指导教师 XXXXXXX 日期 2013年10月15日 k-means 算法与猫群算法的聚类效果比较分析 摘要:本文在聚类个数k 值预先设定的前提下,分别应用了k-means 算法、猫群算法对储层含油性问题进行聚类分析,比较了这两种算法的聚类效果。实验结果显示:本文所采用的传统的k-means 算法常容易陷入局部最优。而猫群算法在样本数目较小时(如以表oilsk81为例时),是一种快速、高效的识别算法。当样本数目翻倍时,受实际算法代码设计的影响,识别的正确率将会下降,这也充分说明了猫群算法的运算效果受代码和样本大小的影响,有较大的不确定性。 关键词:k-means ;猫群算法;聚类分析; 1 引言 K-means 算法[1]是由J.B. Mac Queen 于1967 年提出的,该算法是一个经典的基于划分的聚类算法,因其算法效率较高,易于其它方法相结合,目前已成为数据挖掘、机器学习、模式识别和数量统计等领域应用最广的聚类算法之一。 近几年来提出了很多的群体智能算法,这些算法都是通过模仿生物界中某些动物的行为演化出来的智能算法[2]。猫群算法作为群体智能算法之一,具有良好的局部搜索和全局搜索能力[3],算法控制参数较少,通过两种模式的结合搜索,大大的提高了搜索优良解的可能性和搜索效率,较其他算法较容易实现,收敛速度快,具有较高的运算速度,易于其他算法结合。但也有出现“早熟”现象的弊端[4]。群体中个体的优化只是根据一些表层的信息,即只是通过适应度值来判断个体的好坏,缺乏深层次的理论分析和综合因素的考虑。由于猫群算法出现较晚,该算法目前主要应用于函数优化问题[5],故在聚类分析研究方面,很有必要对猫群算法进行深入研究。 传统的k-means 算法与新兴的聚类方法猫群算法相比较会有哪些异同点呢,接下来将具体阐述。 2 算法模型 2.1 K-means 算法模型 设对n 个m 维样本集进行聚类,n 个样本集表示为12{,,,}n X X X X = ,其中 12(,,,)i i i im X x x x = ,聚类成k 个分类表示为12{,,}k C C C C = ,其质心表示为1 ,1,2,....j j i x C j z X j k n ∈= =∑, j n 为 j C 中包含的数据点的个数,则聚类的目标是使k 个类满 足以下条件: K-均值分类算法实例 第一步:取K=2,并选 z 1(1)=x 1=(0 0)T z 2(1)=x 2=(1 0)T 第二步:因)1()1(2111z x z x -<-,故)1(11S x ∈ 因)1()1(2212z x z x ->-,故)1(22S x ∈ 因)1()1(2313z x z x -<-,故)1(13S x ∈ …… 得到: S 1(1)={x 1, x 3} S 2(1)={x 2, x 4, x 5, …, x 20} 第三步:计算新的聚类中心 ∑∈??? ? ??=+==)1(311115.00.0)(211)2(S x x x x N z ∑∈???? ??=+++==)1(20422 2233.567.5)(1811)2(S x x x x x N z 第四步:因)1()2(j j z z ≠,j=1,2,返回第二步; 第二步(返回1):由新的聚类中心,得到: 8,,2,1,)2()2(21 =-<-l z x z x l l 20,,10,9,)2()2(21 =->-l z x z x l l 因此 S 1(2)={x 1, x 2, …, x 8} S 2(2)={x 9, x 10, …, x 20} 第三步(返回1):计算聚类中心 ∑∈??? ? ??=+++==)2(82111113.125.1)(811)3(S x x x x x N z ∑∈??? ? ??=+++==)2(2010922233.767.7)(1211 )3(S x x x x x N z 第四步(返回1):因)2()3(j j z z ≠,j=1,2,返回第二步; 第二步(返回2):分类结果与前一次迭代的结果相同,即S 1(4)=S 1(3), S 2(4)= S 2(3); 第三步(返回2):聚类中心与前一次迭代的结果相同; 第四步(返回2):因)3()4(j j z z =,j=1,2,算法收敛,得到最终的聚 类中心。 ??? ? ??=13.125.11z ???? ??=33.767.72z K-means算法简介 K-means算法是典型的基于距离的聚类算法,采用距离作为相似性的评价指标,两个对象的距离越近,其相似度就越大。而簇是由距离靠近的对象组成的,因此算法目的是得到紧凑并且独立的簇。 假设要将对象分成k个簇,算法过程如下: (1) 随机选取任意k个对象作为初始聚类的中心(质心,Centroid),初始代表每一个簇; (2) 对数据集中剩余的每个对象根据它们与各个簇中心的距离将每个对象重新赋给最近的簇; (3) 重新计算已经得到的各个簇的质心; (4) 迭代步骤(2)-(3)直至新的质心与原来的质心相等或小于设定的阈值,算法结束。 随意找几个数据简单模拟(借用当年老师教的方法^_^)算法如下: ,A2,…,A6: 要聚成2类,算法过程如下: (1) 假设选择A1和A2为初始质心; (2) 计算A3-A6与A1和A2的距离,这里用欧氏距离公式d = sqrt((x1-x2)2+(y1- 2 距离的比较,A3、A4、A6都离A2近,A5与A1和A2距离相同,假设A5也分到A2这一簇,因此形成新的两簇: 簇1:A1 簇2:A2,A3,A4,A5,A6 (4) 计算新簇的质心 簇1质心:A1 簇2:新质心“C_temp”计算用每个维度的平均值 2簇: 簇1:A1,A2,A3 簇2:A4,A5,A6 新质心1“C_temp1”:((A1.x+A2.x+A3.x)/3 , (A1.y+A2.y+A3.y)/3)=(1.67, 2) bingoㄟ(??? )ㄏ 簇1:A1,A2,A3 簇2:A4,A5,A6 提示: (1) 在K-means 算法k值通常取决于人的主观经验; (2) 距离公式常用欧氏距离和余弦相似度公式,前者是根据位置坐标直接计算的,主要体现个体数值特征的差异,而后者更多体现了方向上的差异而不是位置上的,cos θ越接近1个体越相似,可以修正不同度量标准不统一的问题; (3) K-means算法获得的是局部最优解,在算法中,初始聚类中心常常是随机选择的,一旦初始值选择的不好,可能无法得到有效的聚类结果。 matlab实现Kmeans聚类算法 1.简介: Kmeans和应用于混合高斯模型的受限EM算法是一致的。高斯混合模型广泛用于数据挖掘、模式识别、机器学习、统计分析。Kmeans 的迭代步骤可以看成E步和M步,E:固定参数类别中心向量重新标记样本,M:固定均值只考虑(估计)了均值,而没有估计类别的方差,所以聚类的结构比较适合于特征协方差相等的类别。 Kmeans在某种程度也可以看成Meanshitf的特殊版本,Meanshift 是所以Meanshift可以用于寻找数据的多个模态(类别),利用的是梯度上升法。在06年的一篇CVPR文章上,证明了Meanshift方法是牛顿拉夫逊算法的变种。Kmeans和EM算法相似是指混合密度的形式已知(参数形式已知)情况下,利用迭代方法,在参数空间中搜索解。而Kmeans和Meanshift相似是指都是一种概率密度梯度估计的方法,不过是Kmean选用的是特殊的核函数(uniform kernel),而与混合概率密度形式是否已知无关,是一种梯度求解方式。 k-means是一种聚类算法,这种算法是依赖于点的邻域来决定哪些点应该分在点,也可以对高维的空间(3维,4维,等等)的点进行聚类,任意高维的空间都可以。 上图中的彩色部分是一些二维空间点。上图中已经把这些点分组了,并使用了不同的颜色对各组进行了标记。这就是聚类算法要做的事情。 这个算法的输入是: 1:点的数据(这里并不一定指的是坐标,其实可以说是向量) 2:K,聚类中心的个数(即要把这一堆数据分成几组) 所以,在处理之前,你先要决定将要把这一堆数据分成几组,即聚成几类。但并不是在所有情况下,你都事先就能知道需要把数据聚成几类的。意味着使用k-means就不能处理这种情况,下文中会有讲解。 把相应的输入数据,传入k-means算法后,当k-means算法运行完后,该算法的输出是: 1:标签(每一个点都有一个标签,因为最终任何一个点,总会被分到某个类,类的id号就是标签) 2:每个类的中心点。 标签,是表示某个点是被分到哪个类了。例如,在上图中,实际上有4中“标签”,每个“标签”使用不同的颜色来表示。所有黄色点我们可以用标签以看出,有3个类离的比较远,有两个类离得比较近,几乎要混合在一起了。 当然,数据集不一定是坐标,假如你要对彩色图像进行聚类,那么你的向量就可以是(b,g,r),如果使用的是hsv颜色空间,那还可以使用(h,s,v),当然肯定可以有不同的组合例如(b*b,g*r,r*b) ,(h*b,s*g,v*v)等等。 在本文中,初始的类的中心点是随机产生的。如上图的红色点所示,是本文随机产生的初始点。注意观察那两个离得比较近的类,它们几乎要混合在一起,看看算法是如何将它们分开的。 类的初始中心点是随机产生的。算法会不断迭代来矫正这些中心点,并最终得到比较靠5个中心点的距离,选出一个距离最小的(例如该点与第2个中心点的距离是5个距离中最小的),那么该点就归属于该类.上图是点的归类结果示意图. 经过步骤3后,每一个中心center(i)点都有它的”管辖范围”,由于这个中心点不一定是这个管辖范围的真正中心点,所以要重新计算中心点,计算的方法有很多种,最简单的一种是,直接计算该管辖范围内所有点的均值,做为心的中心点new_center(i). 如果重新计算的中心点new_center(i)与原来的中心点center(i)的距离大于一定的阈值(该阈值可以设定),那么认为算法尚未收敛,使用new_center(i)代替center(i)(如图,中心点从红色点 班级: 计算机127班 姓名: 潘** 学号: 12*****120 K-means 算法实验报告 K -means 算法, 也被称为k -平均或k -均值算法,是一种得到最广泛使用的聚类算法。 它是将各个聚类子集内的所有数据样本的均值作为该聚类的代表点,算法的主要思想是通过迭代过程把数据集划分为不同的类别,使得评价聚类性能的准则函数达到最优(平均误差准则函数E ),从而使生成的每个聚类(又称簇)内紧凑,类间独立。 欧氏距离 ? 假设给定的数据集 {}total m x X m ,...,2,1|==,X 中的样本用d 个描述属性A 1,A 2…A d (维度)来表示。 ? 数据样本x i =(x i1,x i2,…x id ), x j =(x j1,x j2,…x jd )其中, x i1,x i2,…x id 和x j1,x j2,…x jd 分别是样本x i 和x j 对应d 个描述属性A 1,A 2,…A d 的具体取值。 ? 样本xi 和xj 之间的相似度通常用它们之间的距离d(x i ,x j )来表示,距离越小,样本x i 和x j 越相似,差异度越小;距离越大,样本x i 和x j 越不相似,差异度越大。 欧式距离公式如下: ()()∑=-= d k jk ik j i x x x x d 1 2 , 平均误差准则函数 ? K-means 聚类算法使用误差平方和准则函数来评价聚类性能。给定数据集X ,其中只包含描述属性,不包含类别属性。假设X 包含k 个聚类子集X 1,X 2,…X K ;各个聚类子集中的样本数量分别为n 1,n 2,…,n k ;各个聚类子集的均值代表点(也称聚类中心)分别为m 1,m 2,…,m k 。 ? 误差平方和准则函数公式为: () 2 1 11 x x n d i n i -∑-= = K-means 算法过程 输入:簇的数目k 和包含n 个对象的数据库。 输出:k 个簇,使平方误差准则最小。 算法步骤: KMeans 算法及其修改 1.K-Means 算法原理 K-Means 算法的基本思想是:将N 个对象划分到k 个簇中,分类结果要使得相似度较高的对象划分到同一类簇中,而差异较大的对象存在于不同类簇中。 给定大小为n 的数据集,设V={v 1,v 2,…,v n },令I=1,将n 个对象划分到K 个不同的簇中,使用K-Means 算法聚类的具体算法步骤为: 步骤1 在数据集中随机选取K 个对象作为初始聚类中心c 1,c 2……c k ; 步骤2 计算数据集中每个对象到聚类中心的距离,选取最小距离min|V- c j |,分配到聚类中,其中V={v 1,v 2,…,v n },j=1,2……k; 步骤3 计算每个聚类中的所有对象均值,将此均值作为新的聚类中心,c j = 1 n j X i n j i =1,n j 为第j 类中对象的个数,j=1,2,……k; 步骤4如果每个簇的聚类中心不再发生变化,聚类准则函数 J c = |X i j ?c j |n j i =1k j =1收敛,则算法结束。否则返回步骤2继续迭代。 2.优缺点 K-Means 算法实现起来比较简单、运算速度较快,算法效率较高,能够处理大型数据集,空间复杂度和时间复杂度较低。但同时K-Means 算法也有不足之处,包含以下几点: (1) 聚类结果不确定 K-Means算法初始聚类中心是随机选择的,初始中心点的选择不同会导致最终聚类的效果不同。选取不同的初始聚类中心,会使得最终聚类得到的类簇发生变化。除此之外,K-Means算法一般采用准则函数为目标函数,准则函数中只存在一个全局最小值和N个极小值,这使得在进行计算时,使得算法陷入局部最小的情况,导致最终得到的不是全局最优解。 (2) 聚类个数不确定 K-Means算法中K表示聚类后簇的个数,K的取值决定着聚类的结果。K值的选取需要根据实际的需要来确定,但是通常情况下我们是不知道将原始数据集分为多少个类簇是合适的,所以需要针对不同的实验通过对比选取恰当的K值。 (3) 数据量大、算法时间复杂度较高 K-Means算法的计算过程是一个不断迭代的过程,为了寻找到合适的聚类中心,需要不断的计算和调整才能对数据对象进行有效的分类。这个过程中反复进行大量的对象间距离的计算,所以K-Means聚类算法过程会消耗大量的时间,降低聚类的效率。 3.改进点1: 普通kmeans算法是求出的聚簇之后对簇内的点取平均值,若这个簇形成的图像比较狭窄或其图像并不均匀,则使用平均值生成的点就极有可能偏离聚簇本身,所以本文希望通过求生成的簇的重心,以保证生成的中心点不会偏离聚簇本身并能够更好的代表整个簇。 Matlab的K-均值聚类Kmeans函数 K-means聚类算法采用的是将N*P的矩阵X划分为K个类,使得类内对象之间的距离最大,而类之间的距离最小。 使用方法: Idx=Kmeans(X,K) [Idx,C]=Kmeans(X,K) [Idc,C,sumD]=Kmeans(X,K) [Idx,C,sumD,D]=Kmeans(X,K) 各输入输出参数介绍: X---N*P的数据矩阵 K---表示将X划分为几类,为整数 Idx---N*1的向量,存储的是每个点的聚类标号 C---K*P的矩阵,存储的是K个聚类质心位置 sumD---1*K的和向量,存储的是类间所有点与该类质心点距离之和 D---N*K的矩阵,存储的是每个点与所有质心的距离 [┈]=Kmeans(┈,’Param1’,’Val1’,’Param2’,’Val2’,┈) 其中参数Param1、Param2等,主要可以设置为如下: 1、’Distance’---距离测度 ‘sqEuclidean’---欧氏距离 ‘cityblock’---绝对误差和,又称L1 ‘cosine’---针对向量 ‘correlation’---针对有时序关系的值 ‘Hamming’---只针对二进制数据 2、’Start’---初始质心位置选择方法 ‘sample’---从X中随机选取K个质心点 ‘uniform’---根据X的分布范围均匀的随机生成K个质心 ‘cluster’---初始聚类阶段随机选取10%的X的子样本(此方法初始使用’sample’方法)Matrix提供一K*P的矩阵,作为初始质心位置集合 3、’Replicates’---聚类重复次数,为整数 使用案例: data= 5.0 3.5 1.3 0.3 -1 5.5 2.6 4.4 1.2 0 6.7 3.1 5.6 2.4 1 5.0 3.3 1.4 0.2 -1 5.9 3.0 5.1 1.8 1 5.8 2.6 4.0 1.2 0 [Idx,C,sumD,D]=Kmeans(data,3,’dist’,’sqEuclidean’,’rep’,4) 运行结果: Idx = 1 2 3 1 3 2 C = 5.0000 3.4000 1.3500 0.2500 -1.0000 5.6500 2.6000 4.2000 1.2000 0 6.3000 3.0500 5.3500 2.1000 1.0000 sumD = 0.0300 0.1250 0.6300 D = 0.0150 11.4525 25.5350 K-means 算法 K-means算法是硬聚类算法,是典型的基于原型的目标函数聚类方法的代表,它是数据点到原型的某种距离作为优化的目标函数,利用函数求极值的方法得到迭代运算的调整规则。K-means算法以欧式距离作为相似度测度,它是求对应某一初始聚类中心向量V最优分类,使得评价指标J最小。算法采用误差平方和准则函数作为聚类准则函数。 1.K-means 算法 K-means算法是很典型的基于距离的聚类算法,采用距离作为相似性的评价指标,即认为两个对象的距离越近,其相似度就越大。该算法认为簇是由距离靠近的对象组成的,因此把得到紧凑且独立的簇作为最终目标。 k个初始类聚类中心点的选取对聚类结果具有较大的影响,因为在该算法第一步中是随机的选取任意k个对象作为初始聚类的中 心,初始地代表一个簇。该算法在每次迭代中对数据集中剩余的每个对象,根据其与各个簇中心的距离将每个对象重新赋给最近的簇。当考察完所有数据对象后,一次迭代运算完成,新的聚类中心被计算出来。如果在一次迭代前后,J的值没有发生变化,说明算法已经收敛。 2. 算法过程 1)从N个文档随机选取K个文档作为质心 2)对剩余的每个文档测量其到每个质心的距离,并把它归到最近的质心的类 3)重新计算已经得到的各个类的质心 4)迭代2~3步直至新的质心与原质心相等或小于指定阈值,算法结束 具体如下: 输入:k, data[n]; (1)选择k个初始中心点,例如c[0]=data[0],…c[k-1]=data[k-1]; (2)对于data[0]….dat a[n],分别与c[0]…c[k-1]比较,假定与c[i]差值最少,就标记为i; (3)对于所有标记为i点,重新计算c[i]={ 所有标记为i的data[j]之和}/标记为i的个数; (4)重复(2)(3),直到所有c[i]值的变化小于给定阈值。 3. 工作原理与处理流程 浙江大学算法研究实验报告 数据挖掘 题目:K-means 目录 一、实验内容 (5) 二、实验目的 (7) 三、实验方法 (7) 3.1软、硬件环境说明 (7) 3.2实验数据说明 (7) 图3-1 (7) 3.3实验参数说明/软件正确性测试 (7) 四、算法描述 (9) 图4-1 (10) 五、算法实现 (11) 5.1主要数据结构描述 (11) 图5-1 (11) 5.2核心代码与关键技术说明 (11) 5.3算法流程图 (14) 六、实验结果 (15) 6.1实验结果说明 (15) 6.2实验结果比较 (21) 七、总结 (23) 一、 实验内容 实现K-means 算法,其中该算法介绍如下: k-means 算法是根据聚类中的均值进行聚类划分的聚类算法。 输入:聚类个数k ,以及包含n 个数据对象的数据。 输出:满足方差最小标准的k 个聚类。 处理流程: Step 1. 从n 个数据对象任意选择k 个对象作为初始聚类中心; Step 2. 根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离,并根据最小距离重新对相应对象进行划分; Step 3. 重新计算每个(有变化)聚类的均值(中心对象) Step 4. 循环Step 2到Step 3直到每个聚类不再发生变化为止; k-means 算法的工作过程说明如下:首先从n 个数据对象任意选择k 个对象作为初始聚类中心,而对于所剩下的其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类。然后,再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值),不断重复这一过程直到标准测度函数开始收敛为止。一般都采用均方差作为标准测度函数,具体定义如下: 21∑∑=∈-=k i i i E C p m p (1) 其中E 为数据库中所有对象的均方差之和,p 为代表对象的空间中的一个点,m i 为聚类C i 的均值(p 和m i 均是多维的)。公式(1)所示的聚类标准,旨在使所获得的k 个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。 重点要求:用于聚类的测试级不能仅为单独的一类属性,至少有两种属性值参与聚类。 K-m e a n s聚类算法基 本思想 精品文档 K-means聚类算法基本思想 聚类分析以相似性为基础,在一个聚类中的模式之间比不在同一聚类中的模式之间具有更多的相似性。K-means也是聚类算法中最简单的一种。以星团划分为例,,首先随机选取k个宇宙中的点(或者k个星星)作为k 个星团的质心,然后第一步对于每一个星星计算其到k个质心中每一个的距离,然后选取距离最近的那个星团作为 ,这样经过第一步每一个星星都有了所属的星团;第二步对于每一个星团,重新计算它的质心(对里面所有的 星星坐标求平均)。重复迭代第一步和第二步直到质心不变或者变化很小。 K-means也是聚类算法中最简单的一种了,但是里面包含的思想却是不一般。最早我使用并实现这个算法是在学习韩爷爷那本数据挖掘的书中,那本书比较注重应用。看了Andrew Ng的这个讲义后才有些明白K-means后面包含的EM思想。 聚类属于无监督学习,以往的回归、朴素贝叶斯、SVM等都是有类别标签y的,也就是说样例中已经给出了样例的分类。而聚类的样本中却没有给定y,只有特征x,比如假设宇宙中的星星可以表示成三维空间中的点集。 聚类的目的是找到每个样本x潜在的类别y,并将同类别y的样本x放在一起。比如上面的星星,聚类后结果是一个个星团,星团里面的点相互距离比较近,星团间的星星距离就比较远了。 在聚类问题中,给我们的训练样本是,每个,没有了y。 K-means算法是将样本聚类成k个簇(cluster),具体算法描述如下: 1、随机选取k个聚类质心点(cluster centroids)为。 2、重复下面过程直到收敛 { 对于每一个样例i,计算其应该属于的类 对于每一个类j,重新计算该类的质心 } K是我们事先给定的聚类数,代表样例i与k个类中距离最近的那个类,的值是1到k中的一个。质心 代表我们对属于同一个类的样本中心点的猜测,拿星团模型来解释就是要将所有的星星聚成k个星团,首先随机选取k个宇宙中的点(或者k个星星)作为k个星团的质心,然后第一步对于每一个星星计算其到k个质心中每一个的距 离,然后选取距离最近的那个星团作为,这样经过第一步每一个星星都有了所属的星团;第二步对于每一个星团,重新计算它的质心(对里面所有的星星坐标求平均)。重复迭代第一步和第二步直到质心不变或者变化很小。 下图展示了对n个样本点进行K-means聚类的效果,这里k取2。 收集于网络,如有侵权请联系管理员删除 北华大学开放实验报告 实验名称:实验三Kmeans算法实现 所属课程:模式识别 班级:信息10—1 学号:36 姓名:张慧 实验三、K_means算法实现 一、背景知识简介: Kmeans算法是一种经典的聚类算法,在模式识别中得到了广泛的应用,基于Kmeans的变种算法也有很多,模糊Kmeans、分层Kmeans 等。 Kmeans和应用于混合高斯模型的受限EM算法是一致的。高斯混合模型广泛用于数据挖掘、模式识别、机器学习、统计分析。Kmeans的迭代步骤可以看成E步和M步,E:固定参数类别中心向量重新标记样本,M:固定标记样本调整类别中心向量。K均值只考虑(估计)了均值,而没有估计类别的方差,所以聚类的结构比较适合于特征协方差相等的类别。 二、k-means聚类算法 k-means 算法接受参数k ;然后将事先输入的n个数据对象划分为k个聚类以便使得所获得的聚类满足:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算的。 K-means算法是最为经典的基于划分的聚类方法,是十大经典 数据挖掘算法之一。K-means算法的基本思想是:以空间中k个点为中心进行聚类,对最靠近他们的对象归类。通过迭代的方法,逐次更新各聚类中心的值,直至得到最好的聚类结果。 (1)算法思路: 首先从n个数据对象任意选择k 个对象作为初始聚类中心;而对于所剩下其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类;然后再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值);不断重复这一过程直到标准测度函数开始收敛为止。一般都采用均方差作为标准测度函数. k个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。 该算法的最大优势在于简洁和快速。算法的关键在于初始中心的选择和距离公式。 (2)算法步骤: step.1---初始化距离K个聚类的质心(随机产生) step.2---计算所有数据样本与每个质心的欧氏距离,将数据样本加入与其欧氏距离最短的那个质心的簇中(记录其数据样本的编号) step.3---计算现在每个簇的质心,进行更新,判断新质心是否与原质心相等,若相等,则迭代结束,若不相等,回到step2继续迭代。 (3)算法流程图 k-Means ClusteringK-means算法简介

K-means算法的实现与应用举例

K-MEANS算法(K均值算法)

机器学习kmeans聚类算法与应用

实验三报告实验三-Kmeans算法实现

聚类分析K-means算法综述

数据挖掘报告-Kmeans算法

第二章(K均值算法实例)

K-means算法过程示意介绍

matlab实现Kmeans聚类算法

K-means算法分析实验报告

KMeans算法及其修改

Matlab中Kmeans函数的使用

K-means算法

数据挖掘关于Kmeans算法的研究(含数据集)

K-means聚类算法基本思想讲解学习

实验三报告实验三 Kmeans算法实现

kMeansClustering

On this page…

Introduction to k-Means Clustering Create Clusters and Determine Separation Determine the Correct Number of Clusters Avoid Local Minima

Introduction to k-Means Clustering

k-means clustering is a partitioning method. The function kmeans partitions data into k mutually

exclusive clusters, and returns the index of the cluster to which it has assigned each observation. Unlike hierarchical clustering, k-means clustering operates on actual observations (rather than the larger set of dissimilarity measures), and creates a single level of clusters. The distinctions mean that k-means clustering is often more suitable than hierarchical clustering for large amounts of data.

kmeans treats each observation in your data as an object having a location in space. It finds a

partition in which objects within each cluster are as close to each other as possible, and as far from objects in other clusters as possible. You can choose from five different distance measures, depending on the kind of data you are clustering.

Each cluster in the partition is defined by its member objects and by its centroid, or center. The centroid for each cluster is the point to which the sum of distances from all objects in that cluster

is minimized. kmeanscomputes cluster centroids differently for each distance measure, to

minimize the sum with respect to the measure that you specify.

kmeans uses an iterative algorithm that minimizes the sum of distances from each object to its

cluster centroid, over all clusters. This algorithm moves objects between clusters until the sum cannot be decreased further. The result is a set of clusters that are as compact and well-separated as possible. You can control the details of the minimization using several optional input

parameters to kmeans, including ones for the initial values of the cluster centroids, and for the

maximum number of iterations.

Create Clusters and Determine Separation

The following example explores possible clustering in four-dimensional data by analyzing the results of partitioning the points into three, four, and five clusters.

Note Because each part of this example generates random numbers sequentially, i.e., without setting a new state, you must perform all steps in sequence to duplicate the results shown. If you perform the steps out of sequence, the answers will be essentially the same, but the intermediate results, number of iterations, or ordering of the silhouette plots may differ.