JAVA通过url获取网页内容

- 格式:doc

- 大小:31.00 KB

- 文档页数:2

java url方法Java中的URL类提供了一些方法用于处理URL。

下面是一些常用的URL方法:1. URL(String spec):使用指定的字符串创建URL对象。

2. openStream():打开到此URL的连接并返回一个InputStream,以便从该连接读取数据。

3. openConnection():打开到此URL的连接。

4. getProtocol():获取此URL的协议名称。

5. getHost():获取此URL的主机名。

6. getPort():获取此URL的端口号。

7. getPath():获取此URL的路径部分。

8. getQuery():获取此URL的查询部分。

9. getFile():获取此URL的文件名。

10. toExternalForm():返回此URL的字符串形式。

11. equals(Object obj):比较此URL与指定对象是否相等。

12. hashCode():返回此URL的哈希码值。

13. toString():返回此URL的字符串形式。

14. getContent():获取此URL的内容。

15. getContent(Class[] classes):获取此URL的内容,并将其转换为指定的类。

16. getDefaultPort():获取此URL的默认端口号。

17. getUserInfo():获取此URL的用户信息。

18. getFile():获取此URL的文件名。

19. getRef():获取此URL的锚点。

20. openConnection(Proxy proxy):打开到此URL的连接,并使用指定的代理服务器。

以上是一些常用的URL方法,通过这些方法可以方便地处理URL。

【摘要】:在Java 的网络编程中,我们可以通过创建针对某一资源的URL,然后调用其g etContent()方法来获取资源的内容。

本文通过讨论URL 类的g etContent()方法实现的机制,实现了一个可以处理纯文本文件内容的文本处理器。

【关键词】:URL 解码处理器InternetJava 是针对网络编程的程序设计语言,为了访问Internet 尤其是WWW 网上的资源,Java 提供了支持统一资源定位符URL 访问网络资源的一组类。

使用这些类,用户不需要考虑URL 中标识的各种协议的处理过程,就可以直接获得URL 所指向的资源信息。

而且这些类对HTTP 协议提供了更加广泛的支持,给访问Internet 资源的Java 应用程序开发提供了很大方便。

当用户创建了一个URL 后,最简单的方法就是通过URL 的getContent ()方法来生成一个可利用的Java 对象,从而可以在Java 应用程序中使用它们。

如果某Web 站点上有一个纯文本文件,我们如何将它也生成一个适当的Java 对象呢?本文就通过探讨URL 类getContent()方法的幕后操作和 包中与之相关的几个类和接口,来实现获取纯文本文件内容的getContent()方法。

1. 调用URL 对象getContent()方法时幕后操作的讨论[1]调用一般URL 实例的getContent()方法时,背后实际发生了什么呢?首先,它生成一个与资源的连接,提供一个URLCon-nection 对象。

然后在新的URLConnection 对象上调用getContent ()方法(getContent()也是URLConnection 类的方法)。

URLConnec- tion 对象与一个ContentHandlerF actory 对象相联系,后者能通过其独有的createContentHandler()方法生成适当的内容处理器。

这个工厂化方法所取的变元是一个指定MIME 类型的字符串(String)。

java 爬虫案例Java爬虫案例1. 爬取网页内容Java爬虫可以通过发送HTTP请求获取网页的内容。

可以使用Java 的URLConnection或者HttpClient等工具类库发送GET或POST请求,并获取返回的网页内容。

通过解析网页的HTML结构,可以提取出所需的信息。

2. 提取网页中的链接爬虫可以通过解析网页的HTML结构,提取出所有的链接。

可以使用Java的正则表达式、Jsoup等工具来解析网页。

通过遍历网页中的链接,可以进一步获取其他网页的内容。

3. 爬取图片Java爬虫可以通过解析网页的HTML结构,提取出图片的链接,然后使用Java的IO流将图片保存到本地或者其他存储介质中。

可以使用Java的正则表达式、Jsoup等工具来解析网页,并使用Java 的IO流进行文件的读写操作。

4. 爬取表格数据Java爬虫可以通过解析网页的HTML结构,提取出表格中的数据。

可以使用Java的正则表达式、Jsoup等工具来解析网页,并通过遍历表格的行和列,提取出所需的数据。

5. 登录网站爬取数据有些网站需要登录才能获取到数据,Java爬虫可以模拟登录过程,发送POST请求并携带登录信息,然后获取登录后的网页内容。

可以使用Java的URLConnection或者HttpClient等工具类库发送POST 请求,并获取返回的登录后的网页内容。

6. 爬取动态网页有些网页内容是通过JavaScript动态生成的,Java爬虫可以使用无头浏览器(headless browser)来模拟浏览器的行为,执行JavaScript代码,并获取动态生成的网页内容。

可以使用Java的Selenium等工具来模拟浏览器的行为。

7. 爬取API数据有些网站提供了API接口,Java爬虫可以通过发送HTTP请求并携带相应的参数,获取API返回的数据。

可以使用Java的URLConnection或者HttpClient等工具类库发送HTTP请求,并解析API返回的数据。

java 爬虫案例(最新版)目录1.介绍 Java 爬虫2.Java 爬虫案例一:爬取网站标题和链接3.Java 爬虫案例二:爬取网站内容并解析4.Java 爬虫案例三:爬取网站图片并下载5.总结 Java 爬虫的应用和优势正文一、介绍 Java 爬虫Java 爬虫是一种基于 Java 语言编写的网络爬虫程序,它能够自动地抓取互联网上的数据,为我国互联网行业提供了大量的数据来源。

Java 爬虫具有开发简单、运行稳定、跨平台等优势,因此在我国互联网领域得到了广泛的应用。

二、Java 爬虫案例一:爬取网站标题和链接在这个案例中,我们将使用 Java 爬虫技术,对一个简单的网站进行爬取,获取网站的标题和链接。

具体步骤如下:1.使用 Jsoup 库,导入所需的类和模块。

2.解析网页 HTML 代码,提取标题和链接。

3.将提取到的标题和链接存储到合适的数据结构中,以便后续处理和分析。

三、Java 爬虫案例二:爬取网站内容并解析在这个案例中,我们将进一步学习 Java 爬虫技术,实现对网站内容的爬取和解析。

具体步骤如下:1.使用 Jsoup 库,导入所需的类和模块。

2.解析网页 HTML 代码,提取所需内容。

3.使用正则表达式或其他解析方法,对提取到的内容进行进一步处理和解析。

4.将解析后的数据存储到合适的数据结构中,以便后续处理和分析。

四、Java 爬虫案例三:爬取网站图片并下载在这个案例中,我们将学习如何使用 Java 爬虫技术,爬取网站中的图片并下载到本地。

具体步骤如下:1.使用 Jsoup 库,导入所需的类和模块。

2.解析网页 HTML 代码,提取图片链接。

3.使用 Apache HttpClient 库,实现图片的下载。

4.将下载到的图片保存到本地,以便后续处理和分析。

五、总结 Java 爬虫的应用和优势通过以上三个案例,我们可以看出 Java 爬虫在实际应用中的广泛性。

它可以用于网络数据挖掘、网站数据分析、竞争情报收集等领域。

要获取在线文档数据,可以使用Java的网络编程功能来连接文档所在的服务器,并从服务器上下载文档数据。

以下是一些可能有用的方法:

1. 使用Java的URL类获取文档数据:使用URL类中的openStream()方法可以打开一个与指定URL相关的数据流,然后可以使用Java IO库中的类来读取该数据流并获取文档数据。

2. 使用Java的URLConnection类获取文档数据:使用URLConnection类中的getInputStream()方法可以打开一个与指定URL相关的输入流,然后可以使用Java IO库中的类来读取该输入流并获取文档数据。

3. 使用Java的HttpClient类获取文档数据:HttpClient类可以用于发送HTTP请求并接收HTTP响应。

可以使用HttpClient类中的execute()方法发送HTTP GET请求以获取文档数据,然后可以使用Java IO库中的类来读取响应数据。

4. 使用第三方库来获取文档数据:有许多第三方库可用于从Web上获取数据,例如Jsoup和Apache HttpClient。

这些库通常提供更高级的API和更多的功能,可以使获取在线文档数据变得更加容易和灵活。

无论使用哪种方法,都需要确保在处理完数据后关闭所有打开的资源,例如输入/输出流、套接字和HTTP连接。

这可以通过使用Java

的try-with-resources语句来实现。

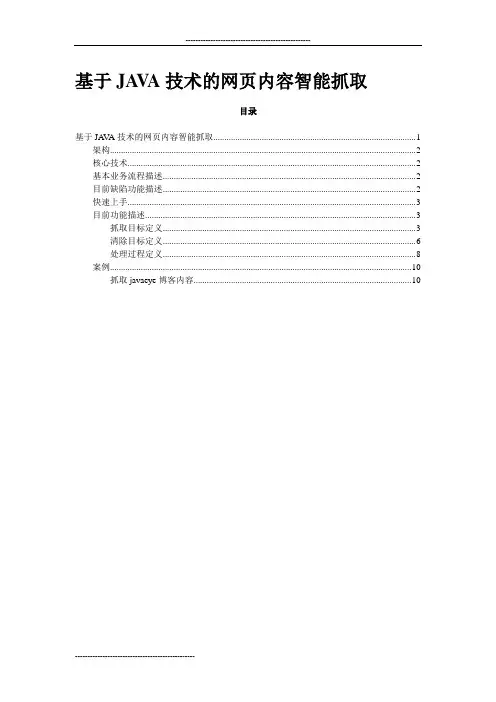

基于JA V A技术的网页内容智能抓取目录基于JA V A技术的网页内容智能抓取 (1)架构 (2)核心技术 (2)基本业务流程描述 (2)目前缺陷功能描述 (2)快速上手 (3)目前功能描述 (3)抓取目标定义 (3)清除目标定义 (6)处理过程定义 (8)案例 (10)抓取javaeye博客内容 (10)架构完全基于java的技术核心技术XML解析,HTML解析,开源组件应用。

应用的开源组件包括:●DOM4J:解析XML文件●jericho-html-2.5:解析HTML文件●commons-httpclient:读取WEB页面内容工具其他必须的辅助引用包括:●commons-codec●commons-logging●jaxen基本业务流程描述●通过XML文件定义抓取目标●通过DOM4J开源组件读取XML配置文件●根据配置文件执行抓取任务●对抓取到的内容根据定义进行解析与处理目前缺陷功能描述●抓取内容如果有分页,则无法获取下一分页●目标页面可能包含有想抓取的信息,但没有抓取的配置选项。

如百度贴吧●目标页面链接定义不够灵活,对于百度贴吧的链接参数以50增加的只能手动定义●没有多线程支持●日志输出比较混乱●错误处理比较简单●程序架构不够清晰,代码略显凌乱●不支持抓取结果存入多个表,目前只能将结果放在一个表中●是否考虑写一个XML类,提供通用的调用XML节点跟解析结果的方法?●规定任务文件的DTD?●通配符替换不支持多个替换快速上手●在/p/playfish/上面将war包下载到本地,导入到eclipse中。

●使用WebContent/sql下的wcc.sql文件建立一个范例数据库●修改src包下wcc.core的dbConfig.txt,将用户名与密码设置成你自己的mysql用户名密码。

●运行SystemCore.java,运行时候会在控制台显示任务执行状况,无参数会执行默认的example.xml的配置文件,如果指定了运行参数则会采用参数指定的配置文件名。

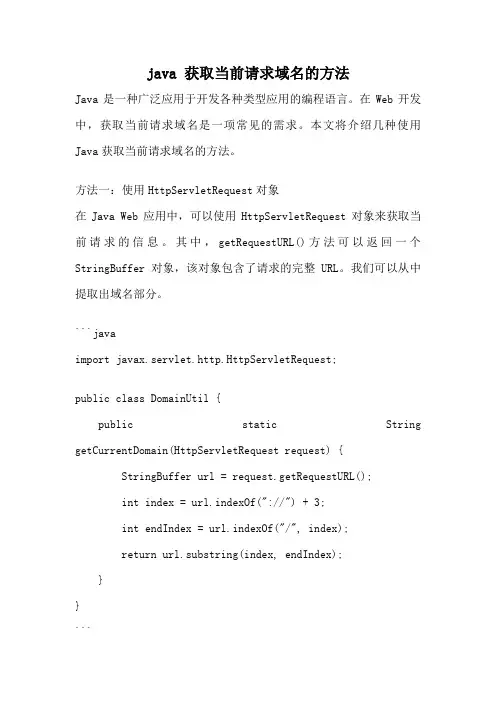

java 获取当前请求域名的方法Java是一种广泛应用于开发各种类型应用的编程语言。

在Web开发中,获取当前请求域名是一项常见的需求。

本文将介绍几种使用Java获取当前请求域名的方法。

方法一:使用HttpServletRequest对象在Java Web应用中,可以使用HttpServletRequest对象来获取当前请求的信息。

其中,getRequestURL()方法可以返回一个StringBuffer对象,该对象包含了请求的完整URL。

我们可以从中提取出域名部分。

```javaimport javax.servlet.http.HttpServletRequest;public class DomainUtil {public static String getCurrentDomain(HttpServletRequest request) {StringBuffer url = request.getRequestURL();int index = url.indexOf("://") + 3;int endIndex = url.indexOf("/", index);return url.substring(index, endIndex);}}```方法二:使用URL对象Java的包中提供了URL类,可以用于解析URL并获取其中的各个部分。

通过创建URL对象,我们可以方便地获取当前请求的域名。

```javaimport .MalformedURLException;import .URL;public class DomainUtil {public static String getCurrentDomain(String url) throws MalformedURLException {URL currentUrl = new URL(url);return currentUrl.getHost();}}```方法三:使用ServletRequest对象在Java Web应用中,ServletRequest是一个通用的请求对象接口。

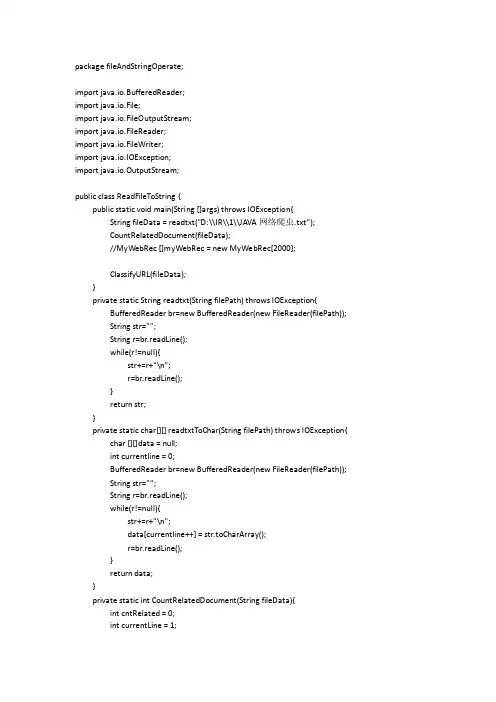

package fileAndStringOperate;import java.io.BufferedReader;import java.io.File;import java.io.FileOutputStream;import java.io.FileReader;import java.io.FileWriter;import java.io.IOException;import java.io.OutputStream;public class ReadFileToString {public static void main(String []args) throws IOException{String fileData = readtxt("D:\\IR\\1\\JAVA网络爬虫.txt");CountRelatedDocument(fileData);//MyWebRec []myWebRec = new MyWebRec[2000];ClassifyURL(fileData);}private static String readtxt(String filePath) throws IOException{ BufferedReader br=new BufferedReader(new FileReader(filePath));String str="";String r=br.readLine();while(r!=null){str+=r+"\n";r=br.readLine();}return str;}private static char[][] readtxtToChar(String filePath) throws IOException{ char [][]data = null;int currentline = 0;BufferedReader br=new BufferedReader(new FileReader(filePath));String str="";String r=br.readLine();while(r!=null){str+=r+"\n";data[currentline++] = str.toCharArray();r=br.readLine();}return data;}private static int CountRelatedDocument(String fileData){int cntRelated = 0;int currentLine = 1;int baiduCnt = 0;int bingCnt = 0;int sogouCnt = 0;int _360Cnt = 0;int State = 0;boolean baiduY[] = new boolean[51];boolean bingY[] = new boolean[51];boolean sogouY[] = new boolean[51];boolean _360Y[] = new boolean[51];char []fileChar = fileData.toCharArray();for(int i = 0; i < fileChar.length;i ++){if(fileChar[i] == '#' && fileChar[i+1] == '*'){State++;System.out.println("分点:"+currentLine);}if(fileChar[i] == '\n')currentLine ++;if(currentLine %3 == 0){if(fileChar[i] == 'Y'||fileChar[i] == 'y'){if(State == 1){baiduCnt ++;baiduY[currentLine/3] = true;}else if(State == 2){bingCnt ++;bingY[currentLine/3 - 50 ] = true;//System.out.println(currentLine/3 - 50);}else if(State == 3){sogouCnt ++;sogouY[currentLine/3 - 100] =true;}else if(State == 4){_360Cnt ++;_360Y[currentLine/3 - 150] = true;}cntRelated++;}}}try{CaculatePR(baiduY,bingY,_360Y,sogouY,cntRelated);}catch(Exception e){e.getMessage();}System.out.println("cntRelated = "+cntRelated);System.out.println("baiduCnt = "+baiduCnt);System.out.println("bingCnt = "+bingCnt);System.out.println("sohuCnt = "+sogouCnt);System.out.println("_360Cnt = "+_360Cnt);System.out.println("currentLine = " + currentLine);return cntRelated;}private static void ClassifyURL(String fileData){String str1[] = fileData.split("\n");for(int i = 0;i < str1.length;i ++){if(str1[i].startsWith("#*"))str1[i] = str1[i].substring(10);}}private static void CaculatePR(boolean baiduY[],boolean bingY[],boolean _360Y[],boolean sogouY[],int cntRelated) throws IOException{double baiduP[] = new double [51];double baiduR[] = new double [51];double bingP[] = new double [51];double bingR[] = new double [51];double sogouP[] = new double [51];double sogouR[] = new double [51];double _360P[] = new double [51];double _360R[] = new double [51];int cntBaidu = 0;int cntBing = 0;int cntSogou = 0;int cnt360 = 0;//System.out.println("Related:"+cntRelated);for(int i = 1;i <= 50;i ++){if(baiduY[i] == true)cntBaidu ++;if(bingY[i] == true)cntBing ++;if(sogouY[i] == true)cntSogou ++;if(_360Y[i] == true)cnt360 ++;baiduP[i] = 1.000000*cntBaidu/i;baiduR[i] = 1.000000*cntBaidu/cntRelated;bingP[i] = 1.000000*cntBing/i;bingR[i] = 1.000000*cntBing/cntRelated;sogouP[i] = 1.000000*cntSogou/i;sogouR[i] = 1.000000*cntSogou/cntRelated;_360P[i] = 1.000000*cnt360/i;_360R[i] = 1.000000*cnt360/cntRelated;//System.out.print(cntBaidu+"\t"+cntBing+"\t"+cntSogou+"\t"+cnt360+"\n");}CaculateMAP(baiduP,bingP,sogouP, _360P);File file = new File("D:/JAVA网络爬虫.txt");FileWriter out = new FileWriter(file); //文件写入流//将数组中的数据写入到文件中。

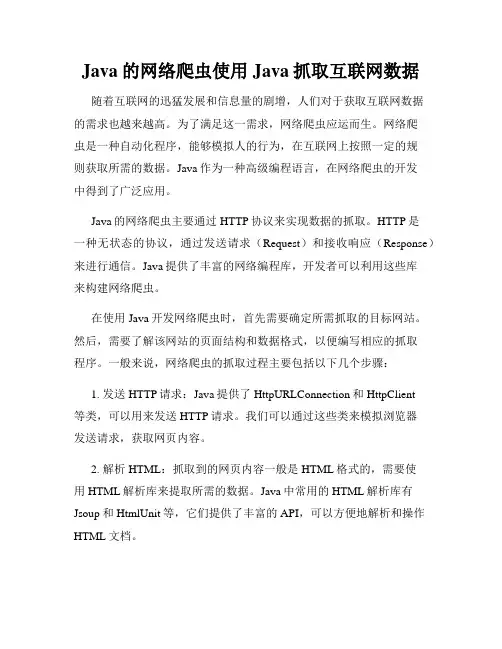

Java的网络爬虫使用Java抓取互联网数据随着互联网的迅猛发展和信息量的剧增,人们对于获取互联网数据的需求也越来越高。

为了满足这一需求,网络爬虫应运而生。

网络爬虫是一种自动化程序,能够模拟人的行为,在互联网上按照一定的规则获取所需的数据。

Java作为一种高级编程语言,在网络爬虫的开发中得到了广泛应用。

Java的网络爬虫主要通过HTTP协议来实现数据的抓取。

HTTP是一种无状态的协议,通过发送请求(Request)和接收响应(Response)来进行通信。

Java提供了丰富的网络编程库,开发者可以利用这些库来构建网络爬虫。

在使用Java开发网络爬虫时,首先需要确定所需抓取的目标网站。

然后,需要了解该网站的页面结构和数据格式,以便编写相应的抓取程序。

一般来说,网络爬虫的抓取过程主要包括以下几个步骤:1. 发送HTTP请求:Java提供了HttpURLConnection和HttpClient等类,可以用来发送HTTP请求。

我们可以通过这些类来模拟浏览器发送请求,获取网页内容。

2. 解析HTML:抓取到的网页内容一般是HTML格式的,需要使用HTML解析库来提取所需的数据。

Java中常用的HTML解析库有Jsoup和HtmlUnit等,它们提供了丰富的API,可以方便地解析和操作HTML文档。

3. 数据处理和存储:通过解析HTML文档,我们可以获取到所需的数据。

接下来,需要对这些数据进行处理和存储。

Java提供了各种数据处理和存储的工具和框架,例如数据库操作工具JDBC、数据分析框架Hadoop等,可以根据实际需求选择合适的工具和框架。

4. 遵守规则和道德准则:在进行网络爬取时,需要遵守一些规则和道德准则。

首先,需要尊重网站的Robots协议,遵守网站的访问频率限制;其次,需要尊重网站的版权和隐私规定,不得将抓取到的数据用于非法或侵犯他人利益的用途。

除了以上基本步骤,Java的网络爬虫还可以通过多线程、代理IP和验证码识别等技术来提高抓取效率和解决一些难题。

java url 解析参数在Java中,解析URL参数通常涉及到使用URL的`getParams()`方法获取`ParameterList`,然后通过这个列表来访问特定的参数。

下面是一个简单的例子,它演示了如何使用Java的标准库解析URL中的参数:```javaimport ;import ;import ;public class URLParamsExample {public static void main(String[] args) {try {URL url = new URL("URLConnection connection = ();List<String> params = ().getNames();for (String param : params) {("Parameter: " + param + ", Value: " + (param));}} catch (Exception e) {();}}}```在这个例子中,我们首先创建了一个URL对象,然后通过`openConnection()`方法获取了与该URL相关的`URLConnection`对象。

然后,我们使用`getParameters().getNames()`方法获取URL参数的名称列表。

最后,我们使用`getParameter(String name)`方法获取每个参数的值。

如果你想使用更现代的库,例如Apache HttpClient,那么解析URL参数会更简单。

下面是一个使用Apache HttpClient的例子:```javaimport ;import ;import ;import ;import ;import ;import ;import ;import ;public class URLParamsApacheExample {public static void main(String[] args) throws URISyntaxException { URI uri = new URIBuilder("List<NameValuePair> params = (uri, "UTF-8");for (NameValuePair param : params) {("Parameter: " + () + ", Value: " + ());}}}```在这个例子中,我们使用了Apache HttpClient库中的`URIBuilder`和`URLEncodedUtils`来解析URL参数。

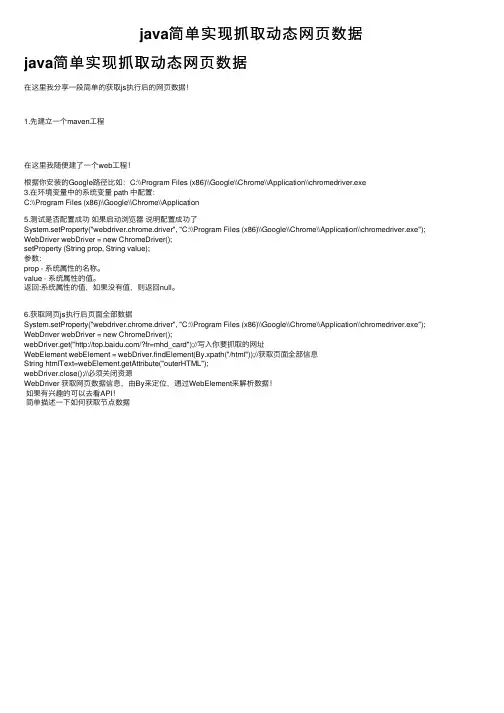

java简单实现抓取动态⽹页数据java简单实现抓取动态⽹页数据在这⾥我分享⼀段简单的获取js执⾏后的⽹页数据!1.先建⽴⼀个maven⼯程在这⾥我随便建了⼀个web⼯程!根据你安装的Google路径⽐如:C:\\Program Files (x86)\\Google\\Chrome\\Application\\chromedriver.exe3.在环境变量中的系统变量 path 中配置:C:\\Program Files (x86)\\Google\\Chrome\\Application5.测试是否配置成功如果启动浏览器说明配置成功了System.setProperty("webdriver.chrome.driver", "C:\\Program Files (x86)\\Google\\Chrome\\Application\\chromedriver.exe"); WebDriver webDriver = new ChromeDriver();setProperty (String prop, String value);参数:prop - 系统属性的名称。

value - 系统属性的值。

返回:系统属性的值,如果没有值,则返回null。

6.获取⽹页js执⾏后页⾯全部数据System.setProperty("webdriver.chrome.driver", "C:\\Program Files (x86)\\Google\\Chrome\\Application\\chromedriver.exe"); WebDriver webDriver = new ChromeDriver();webDriver.get("/?fr=mhd_card");//写⼊你要抓取的⽹址WebElement webElement = webDriver.findElement(By.xpath("/html"));//获取页⾯全部信息String htmlText=webElement.getAttribute("outerHTML");webDriver.close();//必须关闭资源WebDriver 获取⽹页数据信息,由By来定位,通过WebElement来解析数据!如果有兴趣的可以去看API!简单描述⼀下如何获取节点数据。

Java如何实现URL带请求参数(getpost)及得到get和post请求url和参数列表的⽅法具体代码如下所⽰:public static String sendGet(String url,String param){String result = "";try{String urlName = url + "?"+param;//URL U = new URL(urlName);URLConnection connection = U.openConnection();connection.connect();BufferedReader in = new BufferedReader(new InputStreamReader(connection.getInputStream()));String line;while ((line = in.readLine())!= null){result += line;}in.close();}catch(Exception e){System.out.println("Helloword!!"+e);}return result;}public static String sendPost(String url,String param){String result="";try{URL httpurl = new URL(url);HttpURLConnection httpConn = (HttpURLConnection)httpurl.openConnection();httpConn.setDoOutput(true);httpConn.setDoInput(true);PrintWriter out = new PrintWriter(httpConn.getOutputStream());out.print(param);out.flush();out.close();BufferedReader in = new BufferedReader(new InputStreamReader(httpConn.getInputStream()));String line;while ((line = in.readLine())!= null){result += line;}in.close();}catch(Exception e){System.out.println("Helloword!"+e);}return result;}下⾯给⼤家介绍 java得到GET和POST请求URL和参数列表的⽅法在servlet中GET请求可以通过HttpServletRequest的getRequestURL⽅法和getQueryString()得到完整的请求路径和请求所有参数列表,POST的需要getParameterMap()⽅法遍历得到,不论GET或POST都可以通过getRequestURL+getParameterMap()来得到请求完整路径package com.zuidaimaimport java.io.IOException;import java.io.PrintWriter;import java.util.Map;import javax.servlet.ServletException;import javax.servlet.http.HttpServlet;import javax.servlet.http.HttpServletRequest;import javax.servlet.http.HttpServletResponse;public class GetParams extends HttpServlet {private static final long serialVersionUID = 1L;public GetParams() {super();}protected void doGet(HttpServletRequest request,HttpServletResponse response) throws ServletException, IOException {PrintWriter writer = response.getWriter();writer.println("GET " + request.getRequestURL() + " "+ request.getQueryString());Map<String, String[]> params = request.getParameterMap();String queryString = "";for (String key : params.keySet()) {String[] values = params.get(key);for (int i = 0; i < values.length; i++) {String value = values[i];queryString += key + "=" + value + "&";}}// 去掉最后⼀个空格queryString = queryString.substring(0, queryString.length() - 1);writer.println("GET " + request.getRequestURL() + " " + queryString);}protected void doPost(HttpServletRequest request,HttpServletResponse response) throws ServletException, IOException {PrintWriter writer = response.getWriter();Map<String, String[]> params = request.getParameterMap();String queryString = "";for (String key : params.keySet()) {String[] values = params.get(key);for (int i = 0; i < values.length; i++) {String value = values[i];queryString += key + "=" + value + "&";}}// 去掉最后⼀个空格queryString = queryString.substring(0, queryString.length() - 1);writer.println("POST " + request.getRequestURL() + " " + queryString);}}以上代码简单易懂,希望对⼤家学习 java post get url 请求参数的相关⽅法有所帮助,感谢⼤家⼀直以来对⽹站的⽀持,有你们的⽀持,我们会做的更好。

java发送url请求获取返回值的⼆种⽅法下⾯提供⼆种⽅法会使⽤java发送url请求,并获取服务器返回的值第⼀种⽅法:复制代码代码如下:import org.apache.http.HttpEntity;import org.apache.http.HttpResponse;import ValuePair;import org.apache.http.client.HttpClient;import org.apache.http.client.entity.UrlEncodedFormEntity;import org.apache.http.client.methods.HttpPost;import org.apache.http.impl.client.DefaultHttpClient;import org.apache.http.message.BasicNameValuePair;import org.apache.http.params.CoreConnectionPNames;import org.apache.http.util.EntityUtils;publicstaticStringsendUrlRequest(StringurlStr,Stringparam1,Stringparam2)throwsException{ StringtempStr=null;HttpClienthttpclient=newDefaultHttpClient();Propertiesproperties=newProperties();HttpEntityentity=null;StringxmlContent="";try{//设置超时时间httpclient.getParams().setIntParameter(CoreConnectionPNames.CONNECTION_TIMEOUT,20000); httpclient.getParams().setParameter(CoreConnectionPNames.SO_TIMEOUT,20000);//封装需要传递的参数List<NameValuePair>nvps=newArrayList<NameValuePair>();nvps.add(newBasicNameValuePair("mainMemoCode",strmainMemoCode));nvps.add(newBasicNameValuePair("recordPassWord",strrecordPassWord));//客户端的请求⽅法类型HttpPosthttpPost=newHttpPost(urlStr);httpPost.setEntity(newUrlEncodedFormEntity(nvps,"GBK"));HttpResponseresponse=httpclient.execute(httpPost);//获取服务器返回Http的Content-Type的值tempStr=response.getHeaders("Content-Type")[0].getValue().toString();//获取服务器返回页⾯的值entity=response.getEntity();xmlContent=EntityUtils.toString(entity);Stringstrmessage=null;System.out.println(xmlContent);System.out.println(response.getHeaders("Content-Type")[0].getValue().toString());httpPost.abort();}catch(SocketTimeoutExceptione){}catch(Exceptionex){ex.printStackTrace();}finally{httpclient.getConnectionManager().shutdown();}第⼆种⽅法:复制代码代码如下:publicstaticStringsendUrlRequest(StringurlStr,Stringparam1,Stringparam2)throwsException{ HttpURLConnectionurl_con=null;try{URLurl=newURL(urlStr);StringBufferbankXmlBuffer=newStringBuffer();//创建URL连接,提交到数据,获取返回结果HttpURLConnectionconnection=(HttpURLConnection)url.openConnection();connection.setRequestMethod("POST");connection.setDoOutput(true);connection.setRequestProperty("User-Agent","directclient");PrintWriterout=newPrintWriter(newOutputStreamWriter(connection.getOutputStream(),"GBK")); out.println(param);out.close();BufferedReaderin=newBufferedReader(newInputStreamReader(connection.getInputStream(),"GBK"));StringinputLine;while((inputLine=in.readLine())!=null){bankXmlBuffer.append(inputLine);}in.close();tempStr=bankXmlBuffer.toString();}catch(Exceptione){System.out.println("发送GET请求出现异常!"+e);e.printStackTrace();}finally{if(url_con!=null)url_con.disconnect();}returntmpeStr;}。

import java.io.*;

import java.net.URL;

import java.net.URLConnection;

public class TestURL {

public static void main(String[] args) throws IOException {

test4();

test3();

test2();

test();

}

/**

* 获取URL指定的资源。

*

* @throws IOException

*/

public static void test4() throws IOException {

URL url = new

URL("http://lavasoft.blog.51cto.com/attachment/200811/200811271227767778082.jpg");

//获得此 URL 的内容。

Object obj = url.getContent();

System.out.println(obj.getClass().getName());

}

/**

* 获取URL指定的资源

*

* @throws IOException

*/

public static void test3() throws IOException {

URL url = new URL("http://www.hrtsea.com/down/soft/45.htm");

//返回一个 URLConnection 对象,它表示到 URL 所引用的远程对象的连接。

URLConnection uc = url.openConnection();

//打开的连接读取的输入流。

InputStream in = uc.getInputStream();

int c;

while ((c = in.read()) != -1)

System.out.print(c);

in.close();

}

/**

* 读取URL指定的网页内容

*

* @throws IOException

*/

public static void test2() throws IOException {

URL url = new URL("http://www.hrtsea.com/down/soft/45.htm");

//打开到此 URL 的连接并返回一个用于从该连接读入的 InputStream。

Reader reader = new InputStreamReader(new BufferedInputStream(url.openStream()));

int c;

while ((c = reader.read()) != -1) {

System.out.print((char) c);

}

reader.close();

}

/**

* 获取URL的输入流,并输出

*

* @throws IOException

*/

public static void test() throws IOException {

URL url = new URL("http://lavasoft.blog.51cto.com/62575/120430");

//打开到此 URL 的连接并返回一个用于从该连接读入的 InputStream。

InputStream in = url.openStream();

int c;

while ((c = in.read()) != -1)

System.out.print(c);

in.close();

}

}