联机分析处理技术实验报告

- 格式:doc

- 大小:397.50 KB

- 文档页数:15

第1篇一、实验背景随着计算机技术的飞速发展,上机实验已成为计算机相关专业学生掌握理论知识、提高实践能力的重要手段。

本次实验旨在通过实际操作,加深对计算机基础知识和应用技能的理解,培养学生的动手能力和问题解决能力。

二、实验目的1. 熟悉实验环境,掌握实验工具的使用。

2. 巩固计算机基础理论知识,提高编程能力。

3. 培养团队合作精神,提高问题解决能力。

4. 了解实验过程中的注意事项,确保实验安全。

三、实验内容本次实验主要包括以下内容:1. 编写简单的C语言程序,实现数据类型转换、条件判断、循环结构等基本功能。

2. 使用Python语言实现文件操作、网络编程、图形界面设计等高级应用。

3. 在Linux操作系统下,使用shell脚本实现自动化任务,如文件备份、系统监控等。

4. 学习使用数据库管理系统(如MySQL),进行数据的增删改查操作。

四、实验步骤1. 环境准备:确保实验环境符合要求,安装必要的软件和工具。

2. 编写程序:根据实验要求,编写相应的程序代码。

3. 调试程序:使用调试工具,查找并修复程序中的错误。

4. 运行程序:执行程序,观察运行结果,验证程序功能。

5. 文档编写:撰写实验报告,总结实验过程和心得体会。

五、实验结果与分析1. C语言程序:成功编写并运行了多个C语言程序,实现了数据类型转换、条件判断、循环结构等功能。

通过调试和运行程序,加深了对C语言语法和逻辑结构的理解。

2. Python程序:使用Python语言实现了文件操作、网络编程、图形界面设计等高级应用。

通过实际操作,掌握了Python语言的特点和优势,提高了编程能力。

3. shell脚本:在Linux操作系统下,编写并运行了多个shell脚本,实现了自动化任务。

通过学习shell脚本,了解了Linux操作系统的基本命令和脚本编写技巧。

4. 数据库操作:使用MySQL数据库管理系统,成功实现了数据的增删改查操作。

通过实际操作,掌握了数据库的基本原理和操作方法。

一、实训目的本次实训旨在通过实际操作,学习并掌握双机对连局域网的基本搭建方法,了解网络配置的基本原理,提高网络操作技能。

通过实训,使学员能够熟练地设置网络参数,实现两台计算机之间的数据传输和资源共享。

二、实训环境1. 操作系统:Windows 102. 硬件设备:两台计算机、一根网线、双机对连线(可选)3. 软件环境:网络连接相关软件三、实训步骤1. 硬件连接(1)将一根网线的一端插入第一台计算机的以太网接口,另一端插入第二台计算机的以太网接口。

(2)如果使用双机对连线,按照说明书连接两台计算机。

2. 软件配置(1)设置IP地址在两台计算机上分别设置不同的IP地址,如192.168.1.1和192.168.1.2。

确保两台计算机的IP地址在同一子网内,但不同。

(2)设置子网掩码将两台计算机的子网掩码均设置为255.255.255.0。

(3)设置默认网关将两台计算机的默认网关均设置为对方的IP地址。

(4)设置DNS服务器将两台计算机的DNS服务器设置为同一DNS服务器地址,如8.8.8.8。

3. 测试网络连接(1)在第一台计算机上,使用ping命令测试与第二台计算机的连通性。

(2)在第二台计算机上,使用ping命令测试与第一台计算机的连通性。

4. 实现资源共享(1)在第一台计算机上,打开文件资源管理器,右键单击“此电脑”,选择“映射网络驱动器”。

(2)在弹出的窗口中,选择“新建映射驱动器”,输入第二台计算机的IP地址和共享文件夹路径。

(3)在第二台计算机上,设置共享文件夹权限,允许第一台计算机访问。

四、实训结果通过本次实训,成功搭建了双机对连局域网,实现了两台计算机之间的数据传输和资源共享。

以下是实训结果:1. 两台计算机之间能够互相ping通。

2. 第一台计算机可以访问第二台计算机的共享文件夹。

五、实训总结本次实训使我对双机对连局域网的搭建方法有了更深入的了解。

在实训过程中,我学会了如何设置IP地址、子网掩码、默认网关和DNS服务器,以及如何实现资源共享。

Sybase ETL实验报告

姓名:

学号:

一、实验目的:

掌握使用sybase数据库中ETL工具进行异构数据源系统的数据迁移、数据转换并整合的方法。

二、实验内容:

利用SYBASE数据库中ETL工具将异构数据源中的数据抽取到临时中间层后进行清洗、转换、集成,按照统一的规则集成并提高数据的价值,最后加载到数据仓库或数据集市中,成为联机分析处理、数据挖掘的基础。

三、实验步骤:

1、进入SYBASE数据库系统,启动ETL工具:

2、选择数据源

3、进入可以选择数据源数据的界面

4、选择数据源数据表数据

5、将两个物理表数据的关键字关联

6、选择数据字段

7、完成后形成sql语句:

8、选择目标数据库,odbc。

9、形成路径:

10、目标数据库新建表

12、运行结果:

13、选择中间层

14、选择需要转行的字段,进行统一大写:

15、运行结果:

16、在中间层选择分类:

实验结果:

17、分类条件:

18、复制生成目标数据库:

19、连接新的目标库

20、运行结果,已经分类生成数据

四、实验结果:

生成数据检查,符合预期要求。

数据来自异构的数据源,经过分类后存入新的数

据表。

五、实验总结:

通过此次实验,了解了Sybase ETL的简单操作流程,明晰了数据库的清洗、转换、集合的过程和意义。

HadoopMapReduce数据处理实验报告1.引言本实验旨在通过使用HadoopMapReduce框架来进行大规模数据的处理和分析。

MapReduce是一种分布式计算模型,适用于处理海量数据集。

通过将问题划分为多个小任务,并在多台计算机上并行执行这些任务,可以实现高效的数据处理和分析。

2.实验目标本实验的主要目标是使用HadoopMapReduce框架对给定的数据集进行处理和分析。

具体而言,我们将实现以下功能:数据清洗:去除无效数据、缺失值等。

数据转换:对原始数据进行格式转换,使其适合后续分析。

数据聚合:根据需求进行数据聚合操作,如求和、计数等。

数据分析:对聚合后的数据进行进一步的统计分析和可视化。

3.实验环境在本次实验中,我们使用了以下工具和技术:Hadoop:作为分布式计算框架,提供了MapReduce的实现。

Java编程语言:用于实现MapReduce任务的代码编写。

HDFS:作为分布式文件系统,存储了待处理的数据集。

4.实验过程4.1数据准备首先,我们从数据源获取了待处理的数据集。

这个数据集包含了一些用户的购物记录,每条记录包括用户ID、商品ID和购买数量等信息。

4.2数据清洗在数据清洗阶段,我们对原始数据进行了以下操作:去除无效数据:删除了缺失必要字段的记录。

处理异常值:对于购买数量小于0或大于100的记录进行了修正或删除。

4.3数据转换为了方便后续的聚合和分析操作,我们对原始数据进行了格式转换。

具体而言,我们将每条记录按照商品ID进行了分组,并统计了每个商品的总销售量。

4.4数据聚合在数据聚合阶段,我们使用了MapReduce框架来实现对数据的聚合操作。

通过编写Map和Reduce函数,我们可以将原始数据按照指定的键值进行分组,并对每个分组进行相应的聚合操作,如求和、计数等。

4.5数据分析最后,在数据聚合完成后,我们对聚合结果进行了进一步的统计分析和可视化。

通过绘制柱状图、饼图等图表,我们可以更直观地了解数据集中的销售情况和商品分布情况。

信息处理分析实验报告信息处理分析实验报告一、实验目的:通过本次实验,我们主要目的是学习信息处理技术的应用,并且深入了解信息处理算法的原理和方法。

二、实验内容:我们选取了一个包含多种信息的数据集,利用信息处理技术对其进行分析和处理,获取我们需要的有用信息。

三、实验步骤:1.准备工作:首先,我们需要对数据集进行预处理。

包括数据清洗、去重等。

然后,针对我们的实验目的,对数据进行适当的选择和提取。

2.信息处理:在信息处理方面,我们主要使用了以下几种方法和技术:(1)数据可视化:通过绘制图表展示数据的分布情况。

例如,我们可以通过柱状图、折线图等方式展示数据的变化趋势和分布情况。

(2)数据挖掘:使用数据挖掘技术,对数据进行分析和挖掘。

例如,我们可以使用聚类算法对数据进行分组,找出其中的规律和模式。

(3)数据分析:通过统计分析等方法,对数据进行进一步的分析和处理。

例如,我们可以计算数据的均值、方差等统计指标,来描述数据的特征。

四、实验结果:通过本次实验,我们成功地对数据进行了分析和处理,并得到了一些有用的信息。

1.数据可视化结果:我们绘制了柱状图和折线图来展示数据的分布情况和变化趋势。

通过图表,我们可以清晰地看到数据的特征和规律。

2.数据挖掘结果:我们使用了聚类算法对数据进行了分组,并找出了其中的模式和规律。

通过聚类分析,我们可以发现数据的分类结构和相似性。

3.数据分析结果:我们计算了数据的均值、方差等统计指标,并对数据进行了进一步的分析。

通过统计分析,我们可以对数据的特征进行描述,并判断数据的分布情况。

五、实验总结:通过本次实验,我们对信息处理技术有了更深入的了解,并学会了如何应用这些技术来分析和处理数据。

在实验过程中,我们遇到了一些困难和问题,但最终都得到了解决。

通过这次实验,我们不仅了解了信息处理的原理和方法,还培养了分析和解决问题的能力。

这对我们今后的科研工作和学习都有很大的帮助。

大数据处理与分析技术实习报告一、概述大数据处理与分析技术是当今信息时代的核心需求之一。

本次实习经历让我有机会深入了解并实践了大数据处理与分析技术的相关工作。

本报告将针对实习过程中所接触到的主要工作内容进行详细介绍,并总结实习过程中所学到的技术和经验。

二、实习背景和工作内容本次实习是在一家大数据处理和分析技术公司进行的,该公司是国内领先的大数据解决方案提供商。

在实习期间,我所参与的工作主要包括数据清洗与预处理、数据分析与建模、以及可视化呈现。

1. 数据清洗与预处理在实习的初期,我主要负责对大规模的原始数据进行清洗和预处理工作。

这些原始数据来源于各种不同格式的文件和数据库,包括结构化数据、半结构化数据和非结构化数据。

我的具体工作是通过编写数据清洗代码,去除数据中的异常值、重复值和缺失值等,以确保数据的准确性和一致性。

2. 数据分析与建模在数据清洗和预处理完成后,我开始着手进行数据分析和建模的工作。

这一阶段的任务是利用清洗后的数据,运用统计学和机器学习算法进行数据分析和模型构建。

通过分析数据,可以帮助客户发现数据中的模式、趋势和关联规则,为客户的业务决策提供支持和指导。

3. 可视化呈现数据分析是为了更好地理解数据,但数据的呈现方式对于数据分析师和决策者而言至关重要。

在实习过程中,我借助公司提供的可视化工具,对分析结果进行可视化呈现。

这样可以更直观地展示数据分析的结果,并帮助客户更好地理解数据和作出相应的决策。

三、技术和工具在实习过程中,我学习和应用了大量的大数据处理和分析技术,以下是我掌握和使用的一些关键技术和工具:1. 编程语言:Python、R等编程语言是我在数据清洗、预处理和数据分析过程中经常使用的工具。

通过编写代码,可以实现数据的读取、转换、清洗和分析等操作。

2. 数据库:在实习过程中,我接触到了各种类型的数据库,包括关系型数据库(如MySQL),非关系型数据库(如MongoDB)和分布式数据库(如Hadoop、Spark等)。

一、实验目的1. 熟悉联机信息检索的基本概念和原理。

2. 掌握联机信息检索的操作步骤和技巧。

3. 培养用户在信息检索过程中,针对特定问题,快速、准确获取所需信息的能力。

4. 了解联机信息检索在学术研究、企业决策和日常生活等领域的应用。

二、实验内容1. 实验环境:Windows操作系统,网络连接,联机信息检索系统。

2. 实验步骤:(1)登录联机信息检索系统,选择所需数据库;(2)根据检索需求,确定检索词和检索策略;(3)构造检索提问式,进行检索;(4)分析检索结果,筛选、整理有用信息;(5)下载或打印所需文献。

三、实验过程1. 登录联机信息检索系统:以某大学图书馆为例,登录方式为用户名和密码。

2. 选择数据库:根据检索需求,选择合适的数据库,如CNKI(中国知网)、万方数据、维普资讯等。

3. 确定检索词和检索策略:以“人工智能”为例,检索词可以是“人工智能”、“机器学习”、“深度学习”等。

检索策略包括布尔逻辑运算(AND、OR、NOT)、字段限制、时间范围等。

4. 构造检索提问式:将检索词和检索策略组合成检索提问式,例如:“人工智能AND 机器学习 NOT 深度学习”。

5. 进行检索:点击“搜索”按钮,系统开始检索。

6. 分析检索结果:查看检索结果列表,筛选出相关性较高的文献。

7. 下载或打印所需文献:点击文献标题,查看详细信息,如有需要,可下载或打印。

四、实验结果与分析1. 实验过程中,成功登录联机信息检索系统,并选择了CNKI数据库。

2. 根据检索需求,确定了检索词“人工智能”和检索策略“AND”。

3. 构造检索提问式:“人工智能 AND 机器学习”。

4. 进行检索后,系统返回了约100篇相关文献。

5. 分析检索结果,筛选出20篇具有较高相关性的文献。

6. 下载或打印了其中5篇文献,用于后续研究。

五、实验总结1. 通过本次实验,掌握了联机信息检索的基本操作步骤和技巧。

2. 学会了如何根据检索需求,选择合适的数据库和检索词,构造检索提问式。

双机互联实验报告总结1. 概述在信息技术的发展和应用过程中,双机互联技术的重要性日益凸显。

本实验旨在通过搭建双机互联实验平台,对双机互联原理、技术及应用进行深入研究和分析,为网络通信领域的进一步发展提供实践基础。

2. 实验环境配置2.1 硬件配置•主机1:使用Intel i7处理器,16GB内存,512GB固态硬盘,千兆以太网接口•主机2:使用Intel i5处理器,8GB内存,256GB固态硬盘,千兆以太网接口2.2 软件配置•操作系统:主机1和主机2均安装了Windows 10操作系统•虚拟机软件:使用VMware Workstation搭建虚拟化环境,分别安装了虚拟机1和虚拟机2–虚拟机1:CentOS 7操作系统–虚拟机2:Ubuntu 20.04操作系统3. 实验步骤和结果3.1 搭建虚拟化环境1.在VMware Workstation中创建虚拟机1和虚拟机2,并分别安装相应的操作系统。

2.对虚拟机1和虚拟机2进行网络配置,设置网卡为桥接模式,使其可以直接访问物理网络。

3.启动虚拟机1和虚拟机2,验证网络配置是否生效。

3.2 配置网络通信1.在虚拟机1中使用ifconfig命令查看网卡信息,获取虚拟机1的IP地址。

2.在虚拟机2中使用ifconfig命令查看网卡信息,获取虚拟机2的IP地址。

3.在虚拟机1中使用ping命令测试与虚拟机2的网络连通性。

4.在虚拟机2中使用ping命令测试与虚拟机1的网络连通性。

5.分别在虚拟机1和虚拟机2中配置防火墙规则,允许相互之间的通信。

3.3 搭建双机互联环境1.在虚拟机1中安装和配置Apache服务器,创建一个简单的网页。

2.在虚拟机2中使用浏览器访问虚拟机1中的网页,验证双机互联环境是否搭建成功。

3.在虚拟机2中搭建FTP服务器,配置相应的用户权限。

4.在虚拟机1中使用FTP客户端连接到虚拟机2的FTP服务器,进行文件传输测试。

3.4 实验结果分析经过以上步骤的实验操作,成功搭建了双机互联实验平台,并实现了以下功能: - 虚拟机1和虚拟机2之间的网络互通,可以进行ping命令测试。

第2l卷第2期 2006年4月 成都信息工程学院学报

JOURNAL OF CHENGDU UNIVERSITY OF INFORMATION TECHNOLOGY Vo1.21 N0.2

Apr+2006

文章编号:1671.1742{2006)02—0216 05 联机分析处理中的实物化方法 熊 斐, 傅 彦 (电子科技大学计算机系,四川成都610054)

摘要:提高OLAP查询的性能是数据仓库技术领域的关键性问题。数据仓库建立在通用的数据库系统基础之 上时,利用实物化视图实现OLAP查询成为一种切实可行的方案。讨论了在数据仓库以星型模式来组织数据时, 如何利用实物化视图来改写O 查询语句,从而提高查询效率的方法,并给出了当有多个实物化视图可供选择 时的优化选择方法。 关键词:数据仓库;联机分析处理(Ol AP);实物化视图 中图分类号:TP3儿.13 文献标识码:A

1前言 联机分析处理(OLAP,Online Analytical Processing)是数据仓库系统最直接的应用之一,广义的OLAP包含 3个方面的内容:各种涉及大量数据的复杂查询,多维数据分析和统计分析。狭义的OLAP专指多维数据分析。 除OLAP外,当决策支持系统需要查询数据仓库中数据时,通常也要提交涉及大量数据的复杂查询。可以将这 种数据仓库系统中经常遇到的涉及大量数据的复杂查询(包括广义OLAP所含内容)统称为OLAP查询。 由于数据仓库中存储的数据量很大,所以OLAP查询的响应一般都比较慢,提高OLAP查询的性能也就成 为数据仓库技术领域的关键性问题。目前关于如何提高OL AF'性能的方法主要有采用新的索引技术(如位图索 引、多维索引等),改进和OLAP查询密切相关的联接(Star Join)和聚集操作算法,以及利用实物化视图改写查询 语句等几种。但当数据仓库建立在通用的数据库系统基础之上时,利用实物化视图实现OLAP查询成为一种切 实可行的方案。 讨论了在数据仓库以星型模式来组织数据时,算法实现时需要注意的问题,并给出算法的描述,最后给出 了当有多个实物化视图可供选择用于改写查询时的优化选择方法。

毕业设计文献综述计算机科学与技术联机分析处理在商业智能中的研究与应用一、前言部分1.写作目的随着信息化建设的不断发展,越来越多的企业或政府单位同时运行着不止一个的业务系统,“信息孤岛”[1]不断加剧。

联机事务处理(OLTP)已不能满足终端用户对数据库查询分析的需要,SQL对大数据库进行的简单查询也不能满足用户分析的需求,用户的决策分析需要对关系数据库进行大量计算才能得到结果,而查询的结果并不能满足决策者提出的需求,所以联机分析处理(OLAP)显得越发重要。

[2]2.有关概念、综述范围商业智能(BI)[3],通常被理解为将企业中现有的数据转化为知识,帮助企业做出准确的业务经营决策的工具。

这里的数据包括来自企业业务系统的订单、库存、交易账目、客户和供应商等,和所处行业和竞争对手的数据,以及来自企业处的其他外部环境中的各种数据。

而商业智能能够辅助的业务经营决策,既可以是操作层的,也可以是战术层和战略层的决策。

为了将数据转化为知识,需要利用数据仓库、联机分析处理工具和数据挖掘等技术。

[4]数据仓库(DW),是决策支持系统(DSS)[5]和联机分析应用数据源的结构化数据环境。

数据仓库研究和解决从数据库中获取信息的问题。

数据仓库的特征在于面向主题、集成性、稳定性和时变性。

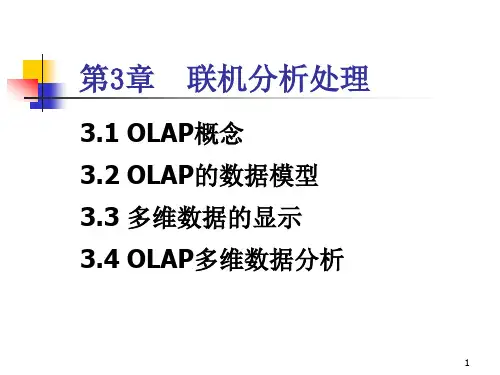

[6]联机分析处理(OLAP)[7],这概念最早是由关系数据库之父E.F.Codd于1993年提出的,他认为联机事务处理OLTP己不能满足终端用户对数据库查询分析的需要,因此他提出了多维数据库和多维分析的概念,即OLAP的概念。

数据挖掘(DM)[8],是一种透过数理模式来分析企业内储存的大量资料,以找出不同的客户或市场划分,分析出消费者喜好和行为的方法。

3.有关争论焦点OLTP和OLAP的不同主要有以下五点:1)用户和系统的面向性:OLTP是面向顾客的,用于事务和查询处理;OLAP是面向市场的,用于数据分析。

2)数据内容:OLTP系统管理当前数据;OLAP系统管理大量历史数据,提供汇总和聚集机制。

本科生实验报告

( 一 )

姓名:

学院:

专业:计算机科学与技术

班级:

实验课程名称: 数据仓库与数据挖掘

实验日期: 2015 年 4 月2 日

开课时间:2014-2015 学年 第二 学期

甘肃政法学院实验管理中心印制

实验题目 联机分析处理技术 小组合作 无

姓名 班级 学 号

一、实验目的

1.学习并掌握Analysis Services的操作,加深理解数据仓库中涉及的

一些概念,如多维数据集,事实表,维表,星型模型,雪花模型,联

机分析处理等。

二.实验环境

一台装有MICROSOFT SQL server的计算机

三、实验内容与步骤

在实验之前,先通读自学SQL SERVER自带的Analysis Manager概念

与教程。按照自学教程的步骤,完成对FoodMart数据源的联机分析。

建立、编辑多维数据集,进行OLAP操作,看懂OLAP的分析数据。

四、实验过程与分析

1、 启动联机分析管理器:开始->程序->Microsoft SQL Server

->Analysis Manager。

2、 按照 Analysis Service的自学教程完成对FoodMart数据源的联机分

析。

3、 在开始-设置-控制面板-管理工具-数据源(ODBC),数据源管理器

中设置和源数据的连接,“数据源名”为你的班级+学号+姓名,

如T3730101张雨。

(1)打开管理工具中的数据源:

(2)选择系统DNS

(3)建立名为“………….”的数据源

(4)添加,选择“Microsoft Access 驱动程序 (*.mdb)”,然后单击“完

成”按钮

(5)选择数据库

(6)在“ODBC Microsoft Access 安装”对话框中单击“确定”按钮。

在“ODBC 数据源管理器”对话框中单击“确定”按钮。

4、在开始-设置-控制面板-管理工具-服务-MSSQLServerOLAPService,

启动该项服务。

在Analysis Manager中,单击服务器名称,即可建立与 Analysis

Servers 的连接;否则,在Analysis Servers 上单击右键,注册服务

器,在服务器名称中输入本地计算机的名字,如pc56。本地计算

机的名字可右击:我的电脑,选择属性,网络标志,里面有本地

计算机的名字。建立新的数据库,数据库名与数据源名相同,如

T3730101张雨。在你所建立的数据库中,单击“新数据源”,和早

期在 ODBC 数据源管理器中建立的数据源连接。

(1)启动MSSQLServerOLAPService服务

(2)注册服务器

(3)建立名为“………”的新数据库

(4)建立数据源

5、假设你是 FoodMart Corporation 的数据库管理员。FoodMart 是一

家大型的连锁店,在美国、墨西哥和加拿大有销售业务。市场部

想要按产品和顾客分析 1998 年进行的所有销售业务数据。要求建

立Sales多维数据集,多维数据集是由维度和事实定义的。

其维度有“Time”维度、“Product”维度、“Customer”维度、“Store”

维度和“Promotion” 维度,事实表为sales_fact_1998,事实表中

的度量为:store_sales、store_cost、unit_sales。理解每个维度的级

别。

(1) “Time”维度

(2)Product维度

(3)“Customer”维度

(4)“Store”维度

(5)“Promotion” 维度

6、可以使用多维数据集编辑器对现有多维数据集进行更改。在使用

或浏览多维数据集中的数据之前,要求设计多维数据集中的数据

和聚合的存储选项。即设计好 Sales 多维数据集的结构之后,需

要选择要使用的存储模式并指定要存储的预先计算好的值的数

量。完成此项操作之后,需要用数据填充多维数据集。这里选择

MOLAP 作为存储模式,创建 Sales 多维数据集的聚合设计,然后

处理该多维数据集。处理 Sales 多维数据集时将从 ODBC 源中装

载数据并按照聚合设计中的定义计算汇总值。

7、使用多维数据集浏览器,可以用不同的方式查看数据:可以筛选

出可见的维度数据量,可以深化以看到数据的细节,还可以浅化

以看到较为概括的数据。这里可以使用多维数据集浏览器对 Sales

数据进行切片和切块操作。要求理解OLAP操作下数据的含义,

从而可以分析数据。

8、人力资源部想按商店来分析雇员的工资。本节将建立一个 HR(人

力资源)多维数据集,以进行雇员工资分析。将把 Employee(雇

员)维度创建为父子维度。然后使用该维度以及常规维度来生成

HR 多维数据集。其中,事实数据表为salary(工资), 维度为

Employee(雇员)、Store(商店)、Time(时间)。了解如何建立父

子维度。

9、建立计算成员和成员属性。在Sales 多维数据集中建立“Average

price” 计算成员,思考建立该计算成员的目的。市场部希望将 Sales

多维数据集分析功能扩展到根据客户的下列特征分析客户销售数

据:性别、婚姻状况、教育程度、年收入、在家子女数和会员卡。

需要向 Customer 维度添加以下六个成员属性:Gender(性别)、

Marital status(婚姻状况)、Education(教育程度)、Yearly Income

(年收入)、Num Children At Home(在家子女数)和 Member Card

(会员卡)。这些成员属性将限制 Customer 维度中的每个成

员。 理解什么是计算成员和成员属性,为什么要建立?

10、已经为客户维度添加了六个成员属性,可以创建一个带有 Yearly

Income(年收入)成员属性的虚拟维度,然后将这个新创建的维

度添加到 Sales 多维数据集中。使用虚拟维度,可以基于多维数

据集中的维度成员的成员属性对多维数据集数据进行分析。 其优

点是不占用磁盘空间或处理时间。

(1)为客户维度添加属性

(2)创建Yearly Income虚拟维度

11、理解多维数据集角色和数据库角色的联系和区别、建立角色的目

的。

(1)在sales中创建marketing角色

(2)在HR中创建HR角色

五、实验总结

1.实验过程中,我们可以对于一些特定的数据,通过事实数据表的选

取和纬度的建立构建多维数据集,从而建立总体分析模型,然后从多

个角度对数据进行分析。多维联机分析处理不仅体现一种先进的技术

和方法,更体现了一种思维方式。可以将很抽象且没有联系的数据进

行处理,从多种角度对原始数据中转化出来,得出一些具有关联且反

应真实情况的实用数据。

2.OLAP利用存储在数据仓库中的数据完成各种分析操作,并一直观

易懂的形式将分析结果返回给决策分析人员。