大型数据中心节能冷却系统

- 格式:doc

- 大小:1.80 MB

- 文档页数:15

数据中心冷板式液冷服务器系统技术要求和测试方法数据中心冷板式液冷服务器系统技术要求和测试方法1. 引言在当今数字化时代,数据中心扮演着关键的角色,承载着海量的数据和运行着各种关键业务。

为了满足数据中心的高效、可靠和节能需求,数据中心服务器的散热技术变得尤为重要。

传统的空气冷却技术已逐渐显现出局限性,而液冷技术因其出色的散热性能,成为了一个热门的选项。

本文将深入探讨数据中心冷板式液冷服务器系统的技术要求和测试方法。

2. 技术要求冷板式液冷服务器系统作为一种高效的散热技术,需要满足一定的技术要求,以确保其正常、可靠地运行。

以下是几个关键的技术要求:2.1 散热性能冷板式液冷服务器系统的散热性能是其最重要的性能指标之一。

散热性能的好坏直接影响到服务器的温度控制和稳定性。

在评估冷板式液冷服务器系统的散热性能时,需要考虑其散热效率、散热平均分布以及温度控制的准确性等指标。

2.2 性能稳定性性能稳定性是冷板式液冷服务器系统的另一个重要要求。

服务器在长时间运行时,需要具备稳定的性能表现,以确保数据中心的正常运营。

对于冷板式液冷服务器系统,稳定性不仅包括其散热性能的稳定,还包括其运行稳定性和故障容忍性。

2.3 节能性能数据中心的能源消耗是一个持续增长的问题,因此冷板式液冷服务器系统需要具备较高的节能性能。

在评估其节能性能时,可以考虑其能效比、能耗控制以及节能措施的实施情况等指标。

3. 测试方法为了评估冷板式液冷服务器系统的性能,特定的测试方法是必要的。

以下是一些常用的测试方法:3.1 散热性能测试散热性能测试是评估冷板式液冷服务器系统的关键测试之一。

该测试可以通过模拟服务器高负载运行状态,测量温度分布和散热效率。

还需要进行长时间稳定性测试,以评估系统在长时间运行时的散热性能。

3.2 性能稳定性测试性能稳定性测试可以通过模拟服务器不同工作负载和环境条件,评估冷板式液冷服务器系统的稳定性能。

该测试可以通过运行不同的负载测试程序,监测系统的性能表现和稳定性。

数据中心液冷系统介绍(1)数据通信设备冷却系统(DatacomEquipmentCoolingSystem-DECS):此系统并不延伸到IT机架之外。

这是一个机架内的回路,用于将来自产热部件(中央处理器、存储器、电源等)的热量传给IT机架内的液冷换热器。

有些配置也许无此回路,让来日冷液分配装置(CoolantDistributionUnit一CDU)的流体百接流向负荷。

此回路也许以单相或两相换热形式进行工作,用热管、热虹吸管、泵送流体与/或蒸气压缩循环促进换热。

数据通信设备中采用的典型液体有:水、乙二醇或丙烯二醇与水的化合物、制冷剂或非导电介质。

数据通信设备冷却系统至少应有集热换热器、排热换热器,另外,也会有一些能进一步强化功能的活动部件,如压缩机/水泵、控制阀、电子控制器等。

(2)工艺冷却系统(TechnologyCoolingSystem-TCS):该系统一般不延伸到IT房间之外,除非在系统配置时将CDU置于数据中心外。

它作为一个专用回路,是要将数据中心内设备冷却系统的热量传递给冷水系统。

此系统尤其受到惟荐,因为它需要处理数据通信设备冷却系统内换热器要求的流体的特殊质量问题--温度、纯度与压力等。

用于工艺冷却回路的典型流体有水、乙二醇或丙烯二醇与水的化合物、制冷剂或非导电介质。

此回路也以单相或两相换热形式进行工作,用热管、热虹吸管、泵送流体与/或蒸气压缩循环促进换热。

工艺冷却系统至少应有集热换热器(多半是数据通信设备冷却系统的集成件)、排热换热器与连接管路。

该系统也会有一些能进一步强化功能的活动部件,如压缩机/水泵、控制阀、电子控制器、过滤器和水力循环附件等。

(3)冷水系统(Chilled-WaterSytem-CWS):此系统是典型的设施级系统,也可能含一个用于IT房间的专用系统。

它主要由数据中心冷水机组与CDU之间的系统组成。

冷水系统包括了冷水机组站房、水泵、水力循环附件和设施级所需的分布管路。

绿色数据中心各系统及绿色节能措施随着互联网和数字化时代的到来,数据中心作为信息技术基础设施的重要组成部分,发挥着越来越重要的作用。

然而,数据中心的运行也带来了巨大的能源消耗和环境负担。

为了减少能源浪费并实现绿色可持续发展,绿色数据中心应运而生。

本文将介绍绿色数据中心各系统及绿色节能措施。

一、电力系统电力系统是数据中心运行的基础,也是能源消耗的主要来源。

绿色数据中心采取了多种措施来提高电力系统的效率和可持续性。

1. 采用高效的UPS(不间断电源系统):传统的UPS效率较低,造成能源浪费。

绿色数据中心采用高效的UPS设备,可提高能源利用率。

2. 优化电力传输:通过降低电压传输损耗、减少电线损耗等方式,优化电力传输,提高供电效率和可靠性。

3. 温控系统:合理的温控系统可以降低设备的散热消耗,提高电力系统的效率。

二、机械与制冷系统机械与制冷系统在绿色数据中心中起到了关键作用,它们能够确保设备的运行稳定性和散热效果。

1. 高效节能的风冷系统:传统的风冷设备能耗较高,绿色数据中心采用高效节能的风冷系统,减少能源消耗。

2. 冷热通道隔离:通过建立冷热通道隔离,避免冷热交叉,可以提高冷却效率,减少制冷设备的负荷。

3. 智能化调控系统:采用智能化调控系统,可以根据设备的负载情况和环境温度合理地调节机械与制冷系统的运行,降低能耗。

三、网络系统网络系统是数据中心的核心,也是能源消耗的重要部分。

为了减少网络设备的能耗,绿色数据中心采取了以下措施:1. 优化网络拓扑结构:合理设计网络拓扑结构,减少设备数量,降低能耗。

2. 节能路由器和交换机:采用节能路由器和交换机,降低设备的功耗。

3. 功率管理与优化:采用功率管理和优化技术,根据实际需求合理配置设备的运行状态,降低能耗。

四、数据存储系统数据存储系统是数据中心核心业务的支撑,也是能源消耗的主要来源。

为了提高数据存储的效率和可持续性,绿色数据中心采取了多种措施:1. 使用固态硬盘(SSD):相比传统的机械硬盘,SSD具有更高的读写速度和更低的功耗,能有效降低数据存储系统的能耗。

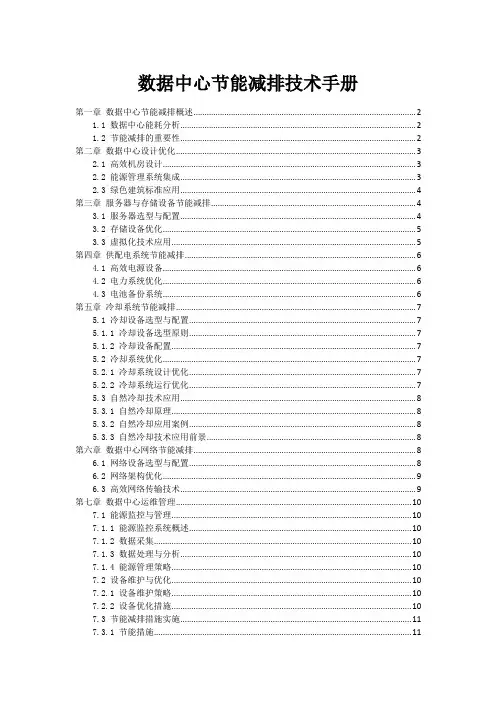

数据中心节能减排技术手册第一章数据中心节能减排概述 (2)1.1 数据中心能耗分析 (2)1.2 节能减排的重要性 (2)第二章数据中心设计优化 (3)2.1 高效机房设计 (3)2.2 能源管理系统集成 (3)2.3 绿色建筑标准应用 (4)第三章服务器与存储设备节能减排 (4)3.1 服务器选型与配置 (4)3.2 存储设备优化 (5)3.3 虚拟化技术应用 (5)第四章供配电系统节能减排 (6)4.1 高效电源设备 (6)4.2 电力系统优化 (6)4.3 电池备份系统 (6)第五章冷却系统节能减排 (7)5.1 冷却设备选型与配置 (7)5.1.1 冷却设备选型原则 (7)5.1.2 冷却设备配置 (7)5.2 冷却系统优化 (7)5.2.1 冷却系统设计优化 (7)5.2.2 冷却系统运行优化 (7)5.3 自然冷却技术应用 (8)5.3.1 自然冷却原理 (8)5.3.2 自然冷却应用案例 (8)5.3.3 自然冷却技术应用前景 (8)第六章数据中心网络节能减排 (8)6.1 网络设备选型与配置 (8)6.2 网络架构优化 (9)6.3 高效网络传输技术 (9)第七章数据中心运维管理 (10)7.1 能源监控与管理 (10)7.1.1 能源监控系统概述 (10)7.1.2 数据采集 (10)7.1.3 数据处理与分析 (10)7.1.4 能源管理策略 (10)7.2 设备维护与优化 (10)7.2.1 设备维护策略 (10)7.2.2 设备优化措施 (10)7.3 节能减排措施实施 (11)7.3.1 节能措施 (11)7.3.2 减排措施 (11)第八章数据中心照明与动力系统 (11)8.1 高效照明系统 (11)8.2 动力系统优化 (12)8.3 节能灯具应用 (12)第九章数据中心废弃物处理与回收 (12)9.1 电子废弃物回收 (12)9.1.1 电子废弃物的分类与特点 (12)9.1.2 电子废弃物的回收流程 (12)9.2 废水处理与回收 (13)9.2.1 废水的来源与特点 (13)9.2.2 废水处理技术 (13)9.2.3 废水回收利用 (13)9.3 废气处理与排放 (13)9.3.1 废气的来源与特点 (13)9.3.2 废气处理技术 (13)9.3.3 废气排放控制 (13)第十章数据中心节能减排发展趋势 (14)10.1 新技术展望 (14)10.2 政策与法规 (14)10.3 行业最佳实践案例 (14)第一章数据中心节能减排概述1.1 数据中心能耗分析数据中心作为支撑现代信息化社会的重要基础设施,其能耗问题日益受到关注。

《数据中心采用冷却塔间接自然冷却技术的能耗分析》篇一一、引言随着信息技术的飞速发展,数据中心作为存储和处理海量数据的场所,其能耗问题日益突出。

为了降低能耗、提高能效,数据中心开始采用各种先进的冷却技术。

其中,冷却塔间接自然冷却技术因其在低环境温度下利用自然冷源实现降温的效果而备受关注。

本文将分析数据中心采用此技术后的能耗变化,以及相应的经济效益和社会环境效益。

二、数据中心现状与冷却技术选择目前,数据中心的能耗主要集中在服务器、存储设备以及冷却系统等方面。

其中,冷却系统的能耗占据相当大的比重。

传统的冷却方式如风冷、水冷等,在高温环境下需要消耗大量能源来维持设备运行。

而冷却塔间接自然冷却技术则通过利用夜间低温自然冷源,降低冷却系统的能耗。

三、冷却塔间接自然冷却技术原理及特点(一)技术原理冷却塔间接自然冷却技术利用夜间低温空气,通过间接换热的方式将数据中心内部的热量传递给冷却水,再由冷却水通过冷却塔散失到大气中。

这种方式在夜间环境温度较低时效果更佳,能够大幅度降低冷却系统的能耗。

(二)技术特点1. 节能环保:利用自然冷源,降低能耗,减少碳排放。

2. 经济效益高:降低运行成本,提高能效。

3. 适用范围广:适用于各种规模的数据中心。

4. 维护成本低:技术成熟,设备维护成本低。

四、能耗分析(一)能耗数据收集与分析为准确分析数据中心采用冷却塔间接自然冷却技术后的能耗变化,我们收集了采用该技术前后的能耗数据。

通过对数据的分析,我们可以看出,在夜间低温时段,采用该技术的数据中心能耗明显降低。

尤其是在夏季高温时段,降温效果更为显著。

(二)能耗对比分析与传统的冷却方式相比,采用冷却塔间接自然冷却技术的数据中心在夜间低温时段的能耗降低了约XX%。

同时,由于减少了风扇、空调等设备的运行时间,也降低了设备维护成本和故障率。

综合来看,采用该技术的数据中心整体能耗降低了约XX%,经济效益显著。

五、经济效益与社会环境效益分析(一)经济效益分析采用冷却塔间接自然冷却技术的数据中心,由于降低了能耗和设备维护成本,可以大幅度提高经济效益。

数据中心常见冷却方式介绍(5):AHU风墙空调数据中心机房内部温湿度环境的控制要依靠室内空调末端得以实现,机房空调具有高效率、高显热比、高可靠性和灵活性的特点,能满足数据中心机房日益增加的服务器散热、湿度恒定控制、空气过滤及其他方面的要求。

随着不同地域PUE的严苛要求以及高密度服务器的广泛应用,数据中心新型的冷却方式被越来越开发及使用。

下面分别介绍几种数据中心传统与新型的冷却方式。

1. AHU风墙空调系统组成AHU(Air Handle Unit)组合式空调箱:主要是抽取室内空气(return air) 和部份新风以控制出风温度和风量来并维持室内温度。

AHU机组组成如下图所示。

机组主要由框架、两到多组冷冻水盘管、室内EC风机、电磁两通调节阀、控制系统、进出风温湿度传感器、室外新风温湿度传感器、室外新风调节阀、室内回风调节阀、加湿系统、冷冻水管路等组成。

图1 AHU机组结构图2. 运行原理2.1 AHU风墙空调本体两种运行模式第一种模式为内循环模式,AHU机组放置在空调机房,侧送风至主机房,冷却IT服务器,热排风经热通道顶部设置的回风口进入吊顶静压箱,回至空调机组。

每台AHU机组配有空气过滤段,多个冷冻水盘管,多个EC风机,控制单元。

第二种运行模式为风侧自然冷却模式,AHU机组放置在空调机房,侧送风至主机房,冷却IT服务器,热排风经热通道顶部设置的回风口进入吊顶静压箱,根据室外空气焓值(温度、湿度计算得出)控制新风、回风、排风的比例,充分利用室外新风,节约能源。

图2 AHU系统原理图2.2 AHU风机转速控制逻辑送风机转速控制主要依据是AHU回风温度进行转速调速,当控制器检测到回风温度升高后,控制器将发指令让风机转速提高,同时根据监测到的送风静压值异常时可晋级停止风机运转。

空调检测到的实际的回风温度与设定的回风温度的差值作为风机转速调节的依据。

图3 风机转速控制逻辑2.3 AHU电磁两通阀控制逻辑冷冻水流量控制主要依据为空调的送风温度,当送风温度高于送风温度设定值时增大水流量;当送风温度低于送风温度设定值时减小水流量;冷冻水流量的控制也可以设为依据远程IT机房的温度值控制。

XFlex模块化间接蒸发冷却数据中心空调新的变化IT设备入口温度要求的变化空调设备回风温度的变化制冷方案的百花齐放风冷液冷机械制冷自然冷Air H 2OGlycol Freon Mix liquid安全能效ScrollMaglevCentrifuger Air sideEvaporativeWater side专业 · 价值 · 信赖w w w .e n v i c o o l .c o m机房设备室外空气室外空气直接蒸发冷间接蒸发冷室外空气室内侧室外侧机房设备室内机冷却塔冷水机组冷冻水系统蒸发冷却-极简的换热流程英维克间接蒸发冷却机组一种高效布水器换热器芯体模块化节能空调直流变频器驱动软件著作权一种数据中心的节能空调系统间接蒸发冷却控制软件著作权北京干湿球温度全年逐时图蒸发冷却ü水在空气中蒸发吸收热量,同时降低空气的温度ü干湿球温度差越大,蒸发冷却能力越强ü一般来讲,干球温度越高,干湿球温差越大最大干湿球温差 17.6℃夏春秋平均干湿球温差4.8℃从利用干球温度到利用干湿球温度蒸发冷却充分利用湿球温度蒸发冷却利用水蒸发降温,使空气温度逼近湿球,有效提高自然冷冷却时间。

张北地区利用蒸发冷却自然冷可减少压缩机运行时间2649小时(30%)北京地区利用蒸发冷却比普通自然冷减少压缩机运行时间2334小时(26%)全年小时数全年小时数模块化节能空调水喷淋蒸发冷却+高效热交换器换热+机械补充制冷水喷淋蒸发冷却+高效热交换器换热高效热交换器自然冷却春秋冬季运行夏秋季运行夏季运行室内回风室内送风室外排风室内回风室内送风室外排风室内回风室内送风室外排风高适用性节能显著模块化设计高效空空换热器智能EVO控制器高效节能制冷解决方案l 最优模式控制l 最优风机控制l 最优备份控制l智能防冻逻辑l 蒸发冷却l 变频压缩机/CW盘管l节水/节能模式l 高热密度数据中心,高达8kW/机柜l 灵活的工作模式l 多变的配置及风口形式l 单层/多层应用l低温应用l 集成设计l简易、快速部署安装l 高效空空换热器l优化的PVC高分子换热器XFlex蒸发冷却单侧送回风双侧送回风英维克 方案,厚积薄发模块化安装,分散独立运行模块化设计制冷设备和IT设备隔离缩短建设周期,减少现场工程量英维克 方案,厚积薄发室外干球温度℃CLF*以上为北京地区数据100%负荷传统高效风冷全年CLF 0.30冷冻水自然冷全年CLF 0.22XFlex全年CLF 0.10不同空调解决方案的全年PUE高效压缩机水冷高效压缩机蒸发冷却技术蒸发冷却技术水侧自然冷间接风侧自然冷风冷空调解决方案间接蒸发冷却方案冷冻水自然冷方案直接蒸发冷却方案大气质量影响湿度影响直接风侧自然冷*以上为北京地区数据100%负荷不不不不不XFlex高效节能室外干球温度/℃机房总负载/kW空调总功率/kW CLF1146859.50.040531464600.0416.61461610.0421114001000.07117.513951100.07918.51396.51320.095新媒体大数据产业基地誉成云创间接蒸发冷却数据中心实验室——70%负荷,室外温度0.5℃,CLF实测值为0.03高效间接换热芯体高效率ØXFlex机组采用专利技术高分子材料换热芯体,换热性能优异寿命长Ø耐腐蚀性强,抗酸性、碱性溶液和腐蚀性气体Ø耐候性强,抗高温,低温,和高低温冲击Ø对水质要求低控制显示系统:1、7.3寸图像化直观显示机组运行状态与被检测机柜进出风温湿度。

数据中心节能关键技术及应用案例在当今数字化时代,数据中心作为信息存储和处理的核心设施,其规模和数量不断增长。

然而,数据中心的高能耗问题也日益凸显,给环境和企业运营成本带来了巨大压力。

因此,研究和应用数据中心节能关键技术成为了迫切的需求。

数据中心的能耗主要来自于 IT 设备、制冷系统、供配电系统等。

其中,IT 设备的能耗占比较大,尤其是服务器的运行。

制冷系统则是为了保证设备在适宜的温度环境下工作,但其能耗也不容小觑。

供配电系统在电能传输和转换过程中也会有一定的损耗。

为了降低数据中心的能耗,以下是一些关键技术及应用案例。

一、服务器虚拟化技术服务器虚拟化是将一台物理服务器虚拟化为多台逻辑服务器,从而提高服务器资源的利用率。

通过虚拟化技术,可以将多个应用程序整合到一台服务器上,减少服务器的数量,降低硬件采购成本和能耗。

例如,某大型互联网公司在其数据中心采用了服务器虚拟化技术。

原本需要数百台物理服务器来运行的业务,经过虚拟化整合后,仅使用了几十台服务器,大大降低了服务器的能耗。

同时,虚拟化技术还提高了服务器的管理效率,减少了维护成本。

二、自然冷却技术自然冷却是利用外界自然环境的低温来降低数据中心的制冷能耗。

常见的自然冷却技术包括新风冷却、冷却塔免费冷却等。

在北方地区,某数据中心利用冬季寒冷的气候条件,采用新风冷却系统。

当室外温度低于室内设定温度时,引入室外冷空气直接为数据中心降温,减少了制冷机组的运行时间。

在夏季温度较高时,则切换回传统制冷方式。

通过这种方式,该数据中心在冬季和过渡季节大幅降低了制冷能耗。

三、液冷技术液冷技术是通过液体代替空气来带走服务器产生的热量。

与传统的风冷技术相比,液冷技术具有更高的散热效率,可以有效降低服务器的温度,从而提高服务器的性能和稳定性。

一家高性能计算数据中心采用了液冷技术。

服务器产生的热量被冷却液迅速带走,冷却液经过热交换器将热量散发到外界。

由于液冷技术的高效散热,该数据中心的服务器能够在更高的功率下运行,同时能耗却得到了有效控制。

数据中心节能改造措施嘿,咱今儿就来聊聊数据中心节能改造措施这档子事儿。

你想啊,那数据中心就好比是个庞大的“用电怪兽”,成天“吃”着大量的电呢!这电可都是咱老百姓辛辛苦苦发出来的呀,可不能就这么白白浪费了。

那怎么个节能改造法呢?咱先来说说冷却系统吧。

就像人热了要吹风扇、开空调一样,数据中心也得有好的冷却办法。

咱能不能想办法让它更高效地降温,少消耗点电呢?比如说采用更先进的冷却技术,就像给它穿上一件“超级凉爽衣”,既能让它凉快,又不怎么耗电。

还有啊,那些设备是不是可以优化一下呢?有些设备可能就跟个“电老虎”似的,特别耗电。

咱能不能找些更节能的设备来替换它们呀?这就好比家里的旧电器,换成新的节能型的,那电费不就省下来了嘛!再说说照明系统吧,那数据中心里也得有照明吧。

咱能不能都换上节能灯泡呢?就像家里把普通灯泡换成节能灯一样,能省不少电呢。

这可不是小数目啊,长年累月下来,那得省多少电呀!然后呢,管理也很重要呀!就像一个大家庭,得有好的管家一样。

对数据中心的运行进行合理的规划和管理,让它在该工作的时候高效工作,该休息的时候也能好好“睡一觉”,不浪费电。

这是不是很有道理呢?你想想,如果每个数据中心都能好好地进行节能改造,那能省下多少电呀!那可都是资源呀,都是为了咱的环境,为了咱的未来呀!这可不是开玩笑的事儿。

咱不能眼睁睁地看着电就这么被浪费掉,得行动起来呀!数据中心节能改造,这不仅是技术问题,更是我们每个人都应该关注的事情。

这关系到我们的生活,我们的地球呀!我们不能总是一味地索取,也得学会节约呀。

就像我们过日子一样,得精打细算,不能大手大脚的。

所以说呀,数据中心节能改造真的太重要啦!这可不是喊喊口号就行的,得实实在在地去做。

让我们一起努力,让数据中心变得更节能、更环保,为我们的地球出一份力吧!这难道不是我们应该做的吗?难道我们不应该重视起来吗?难道我们还能继续坐视不管吗?。

《超大型数据中心冷源群控系统设计与应用》篇一一、引言随着信息技术和网络应用的迅猛发展,超大型数据中心已经成为存储和传输海量数据的核心设施。

冷源系统作为数据中心的重要组成部分,其群控系统的设计与应用直接关系到数据中心的能效、安全与稳定运行。

本文将探讨超大型数据中心冷源群控系统的设计原理、关键技术及其在实际应用中的效果。

二、超大型数据中心冷源群控系统设计原理1. 系统架构设计超大型数据中心的冷源群控系统通常采用分布式架构,通过中央控制器对多个冷源设备进行集中监控与控制。

系统架构包括传感器网络、数据采集与传输模块、中央控制单元以及执行机构等部分。

2. 传感器网络布置传感器网络是冷源群控系统的基础,通过布置在机房、制冷机组、冷却水系统等关键节点的传感器,实时监测温度、湿度、压力、流量等关键参数,为控制策略的制定提供数据支持。

3. 数据采集与传输数据采集模块负责收集传感器网络传回的数据,并进行初步处理。

传输模块将处理后的数据发送至中央控制单元,实现数据的实时共享和远程监控。

4. 中央控制单元中央控制单元是冷源群控系统的核心,它接收数据采集模块发送的数据,根据预设的算法和控制策略,对执行机构发出控制指令,实现冷源设备的智能调控。

三、关键技术及实现方法1. 智能控制算法采用先进的控制算法,如模糊控制、神经网络控制等,根据实时监测的数据,自动调整制冷机组的运行状态,实现能效优化。

2. 故障诊断与预警通过数据分析与模式识别技术,对冷源系统的运行状态进行实时诊断,及时发现潜在故障并发出预警,确保系统安全稳定运行。

3. 能效管理策略制定能效管理策略,根据数据中心的实际负载情况、外部环境温度等因素,动态调整制冷设备的运行模式,降低能耗。

四、应用实践与效果分析1. 应用实践某超大型数据中心采用冷源群控系统后,实现了对制冷机组的智能调控和能效管理。

通过实时监测和数据分析,系统能够自动调整制冷设备的运行参数,确保机房温度的稳定性和能效的最优化。

数据中心 cdu 双相变冷却单元近年来,随着云计算和大数据的快速发展,数据中心的需求愈发增加。

而针对数据中心的冷却技术也变得日益重要。

在这个背景下,数据中心 cdu 双相变冷却单元成为了备受关注的热点之一。

1. 数据中心 cdu 双相变冷却单元的基本概念数据中心 cdu 双相变冷却单元是一种利用双相变技术的冷却设备,可以将热量迅速从数据中心传送出去,以保持服务器和其他设备的正常运行温度。

它利用了水的双相变特性,即水在液态和蒸汽态之间的转化过程中吸收和释放大量热量,从而实现快速而高效的冷却效果。

2. 数据中心 cdu 双相变冷却单元的优势相比传统的空气冷却系统,数据中心 cdu 双相变冷却单元具有许多优势。

它可以实现更高效的冷却效果,减少了能源消耗和运行成本。

由于采用了水冷技术,不再需要大量的空调设备,减少了数据中心的占地面积和建设成本。

双相变冷却单元还具有更大的可靠性和稳定性,可以降低数据中心的故障率和维护成本,提升了整个数据中心的运行效率和可持续性。

3. 实际应用案例数据中心 cdu 双相变冷却单元已经在一些大型数据中心中得到了广泛应用,并取得了显著的效果。

某知名互联网公司在其新建的数据中心中采用了双相变冷却单元,通过庞大的数据统计及监控发现,相较传统空调冷却系统,整个数据中心的耗能指标下降了30%以上,大大降低了运行成本。

4. 个人观点和总结数据中心 cdu 双相变冷却单元作为一种新型的冷却技术,优势明显、应用广泛,并有望在未来数据中心建设中发挥越来越重要的作用。

我相信随着科技的不断进步和人们对能源效率的不断追求,数据中心cdu 双相变冷却单元将会得到更多的关注和推广,为数据中心的可持续发展做出更大的贡献。

通过本次深度的文章撰写,相信我已经更全面、深刻和灵活地理解了数据中心 cdu 双相变冷却单元的相关知识和应用价值。

在第一部分中,我对数据中心 cdu 双相变冷却单元的基本概念进行了简要介绍,并从水的双相变特性出发,解释了其高效冷却的原理。

数据中心工程暖通系统的节能措施本文主要从节能的角度出发,重点阐述可行的节能措施,针对具体工程,可根据实际情况选取合理的节能措施形成一个完整的、有针对性的空调系统。

充分利用室外气候条件由于数据中心的运行时间为全年不间断运行,所以要求空调系统全年运行,但是在北方地区,过渡季及冬季室外空气可以作为天然冷源加以利用,从而极大地降低机械制冷系统的运行时间及费用。

可利用的部分自然冷却和完全自然冷却的时间越长,全年平均的PUE值就越低,意味着越节能。

对于采用冷却塔供冷的系统来说,当室外湿球温度降低到某一值时,使得冷却水供水温度低于冷冻水回水温度2℃时,便开始启动部分自然冷却模式,冷冻水回水经板换另一侧的冷却水冷却降温后再进入制冷机组,相当于降低了冷机的负载率,从而降低了冷机的压缩机功率,达到节能的目的;当室外湿球温度持续降低,使得冷冻水回水经板换另一侧的冷却水冷却降温后温度达到设计供水温度,此时,进入完全自然冷却模式,停止冷机,完全由冷却塔承担所有负荷。

对于采用换热机组等风侧自然冷却的系统来说,我们主要利用室外干球温度,当室外干球温度低于室内设计送风温度2℃时,便可以启动风侧自然冷却的功能,而对于一些干热地区(西北地区气候条件),可通过在室外空气进入换热机组前加喷淋装置,使得室外空气的换热温度尽可能的接近湿球温度,从而延长自然冷却的时间。

设备的变频(1)制冷空调系统中,耗电最大的设备应该是制冷机组,采用变频冷机不仅可以在部分负荷时降低压缩机功率,而且随着室外湿球温度的降低,进入制冷机组的冷却水温度降低,可大大提高冷机的COP值,另外,在数据中心的空调系统中冷机的启动时间直接影响蓄冷罐的选型,而冷机变频可大大缩减启动时间,从而减小蓄冷罐的配备容量;(2)水泵建议设置为变频泵,其频率由末端最不利环路的压差控制,当末端负荷减小时,水泵频率相应减小,从而节省水泵耗电;(3)末端空调的风机设置为EC风机,风机频率根据架空地板内静压或回风温度控制,从而节省大量风机耗电;(4)冷却塔风机采用变频风机,风机频率根据室外湿球温度控制,从而节省大量风机耗电。

数据中心新型冷却方式介绍(1):顶置对流空调系统从2018年开始,北京、上海、深圳等一线城市,陆续出台“PUE新政”。

2018年9月,北京提出全市范围内禁止新建和扩建互联网数据服务、信息处理和存储支持服务数据中心(PUE值在1.4以下的云计算数据中心除外)。

上海也出台类似政策,存量改造数据中心PUE不得高于1.4,新建数据中心PUE限制在1.3以下。

2019年4月,深圳提出PUE1.4以上的数据中心不再享有支持,PUE低于1.25的数据中心,可享受新增能源消费量40%以上的支持。

为了降低PUE,近几年数据中心新型末端冷却方式不断涌现,顶置对流空调、热管、水冷背板、液体冷却等等。

接下来,我将对新型冷却方式进行介绍。

1. 顶置对流空调系统组成顶置对流空调系统组机组主要由框架、冷冻水盘管、进出风温湿度传感器、控制系统、电动压差调节平衡阀、冷冻水管路等组成。

顶置对流空调安装位置为服务器机柜进风面上方,无需设置风机,利用空气的物理特性,冷、热空气自然流动。

某大型数据中心采用这种新型冷却方式。

单排设置20台机柜,2排一组,每排机柜上面设置3台顶置对流空调,每组设置6台顶置对流空调,按5+1冗余模式配置。

图1 顶置对流空调系统示意图一图2 顶置对流空调系统示意图二图3 顶置对流空调接管示意图2.运行原理顶置对流空调安装位置为服务器机柜进风面上方,无需设置风机,利用空气的物理特性,冷、热空气自然流动。

顶置对流空调运行时,气流组织CFD模拟图如下。

15℃低温冷冻水进入顶置对流空调的冷冻水盘管,被机房热空气加热后,成为21℃高温冷冻水,高温冷冻水经冷冻站冷水机组/板式换热器冷却后,再次成为15℃冷冻水,送往机房顶置对流空调,完成冷冻水循环。

服务器自带风扇,会使得热通道内压力大于冷通道。

服务器排出的32℃热风在热通道自然上升,在机柜顶部及顶置对流空调前部集聚,经冷冻水盘管冷却,成为18℃冷风,机组被服务器自带风扇吸入服务器内部降温,完成空气循环。

数据中心机房节能措施一、背景介绍数据中心是现代社会信息化发展的重要基础设施,然而,随着数据中心规模的不断扩大和运营的持续增长,其能耗也越来越高,给环境和企业带来了巨大的压力。

为了减少能源消耗并提高数据中心的节能效果,采取一系列的节能措施是至关重要的。

二、机房节能措施1. 优化机房布局通过合理规划机房空间,确保机柜之间有足够的通风空间,避免热量集中,提高空气流通效果,减少能源消耗。

此外,合理安排机柜的罗列,避免热源集中,减少冷却负荷。

2. 使用高效节能设备选择高效节能的服务器、网络设备和空调设备,以降低能源消耗。

例如,采用能效比高的服务器和网络设备,使用先进的空调系统,如冷水机组和精确控温系统,以提高能源利用率。

3. 优化冷却系统机房的冷却系统是能源消耗的主要来源之一。

采用智能化的冷却系统,如冷热通道隔离、冷热通道隔离门、冷热通道隔离顶板等,可以有效降低冷却能耗。

此外,使用冷水机组和热交换器等设备,可以提高冷却效率。

4. 优化照明系统采用节能的照明设备和智能照明控制系统,如LED灯具和光感应控制器,可以减少照明能耗。

此外,合理规划照明布局,避免过度照明,也是节能的重要措施。

5. 提高能源监测和管理能力通过安装能源监测设备,实时监测数据中心的能耗情况,并采取相应的管理措施,如定期能耗分析、能耗报告和能耗优化建议,以提高能源利用效率。

6. 采用可再生能源数据中心可以考虑采用可再生能源,如太阳能和风能等,作为替代传统能源的选择。

这不仅可以减少对传统能源的依赖,还可以降低碳排放。

7. 优化空调运行策略通过合理调整空调的运行策略,如温度和湿度控制,可以降低空调能耗。

同时,采用智能化的空调控制系统,可以根据机房的实际负荷和温度变化进行自动调节,提高能源利用效率。

8. 加强热回收利用数据中心的服务器和网络设备产生大量的热量,可以通过热回收技术将这些热量利用起来,供暖或者供其他用途,以减少能源浪费。

9. 增加自然通风和散热在机房设计中增加自然通风和散热设备,如风扇和散热塔等,可以利用自然气流进行散热,减少空调的使用,从而降低能源消耗。

数据中心节能降耗解决方案目录一、前言 (2)1.1 背景介绍 (2)1.2 解决方案目的 (3)二、数据中心能源消耗现状分析 (3)2.1 数据中心能源消耗构成 (4)2.2 数据中心能源效率现状 (5)2.3 节能降耗潜力分析 (6)三、数据中心节能降耗解决方案 (7)3.1 空调系统节能改造 (9)3.1.1 高效空调设备应用 (10)3.1.2 智能化空调控制系统 (10)3.2 供电系统节能改造 (12)3.2.1 高效UPS应用 (13)3.2.2 低压直流供电系统 (14)3.3 服务器及存储设备节能优化 (15)3.3.1 低功耗服务器推广 (16)3.3.2 存储设备节能技术 (17)3.4 网络及通信系统节能策略 (18)3.4.1 低功耗网络设备应用 (20)3.4.2 数据中心内部光纤通信优化 (20)3.5 视频监控及照明系统节能改造 (21)3.5.1 智能视频监控系统 (22)3.5.2 节能照明系统应用 (24)四、实施步骤与建议 (25)4.1 实施步骤 (26)4.2 项目实施建议 (28)五、预期效果与评估方法 (29)5.1 预期效果 (30)5.2 评估方法 (31)六、结语 (33)6.1 节能降耗的重要性 (34)6.2 持续改进与创新 (35)一、前言随着信息技术的快速发展,数据中心作为支撑各类业务的重要基础设施,其能源消耗和运营成本不断攀升,已经成为当前社会面临的一大挑战。

在这样的背景下,如何实现数据中心的节能降耗,不仅关系到企业的经济效益,也涉及到社会责任与可持续发展。

本文档旨在探讨并提供一种切实可行的数据中心节能降耗解决方案,以推动行业向绿色、低碳、高效的方向发展。

通过一系列的策略与技术手段,我们旨在降低数据中心的能耗,提高能源利用效率,从而为解决全球能源危机贡献一份力量。

1.1 背景介绍随着云计算、大数据、物联网等技术的快速发展,数据中心作为信息系统的核心基础设施,其建设和运营成本不断攀升。

1 大型数据中心节能冷却系统 鹏博士数据中心事业部 王克宁 李安平 (f81345@gmail.com)

目前就职于微软的数据中心最有影响的专家Christian Belady在2006年提出数据中心能源利用率(PUE)的概念。如今,PUE已发展成为一个全球性的数据中心能耗标准。数据中心的PUE的值等于数据中心总能耗与IT设备能耗的比值,比值越小,表示数据中心的能源利用率越高,该数据中心越符合低碳、节能的标准。 目前国内一些小规模的传统数据中心,PUE值可能高达3左右,这意味着IT设备每消耗1瓦特电力,数据中心基础设施便需要消耗2瓦特电力。据网络上收集的相关信息,目前GDS在建的4个机房在与第三方设计单位签约时,都是按照PUE值等于1.8的标准进行规划的。世纪互联近五年建设的水冷数据中心的 PUE值在1.5左右。鹏博士酒仙桥大型数据中心的PUE 设计值不超过1.5。根据收集相关网站信息,全球最最节能的5个数据中心分别是: ■ 雅虎“鸡窝”式数据中心(PUE=1.08) 雅虎在纽约洛克波特的数据中心,位于纽约州北部不远的尼亚加拉大瀑布,每幢建筑看上去就像一个巨大的鸡窝,该建筑本身就是一个空气处理程序,整个建筑是为了更好的‘呼吸’,有一个很大的天窗和阻尼器来控制气流。 ■ Facebook数据中心(PUE=1.15) Facebook的数据中心采用新的配电设计,免除了传统的数据中心不间断电源(UPS)和配电单元(PDUs),把数据中心的UPS和电池备份功能转移到机柜,每个服务器电力供应增加了一个12伏的电池。同时Facebook也在使用新鲜空气进行自然冷却。 ■ 谷歌比利时数据中心(PUE=1.16) 谷歌比利时数据中心竟然没有空调!根据谷歌公司工程师的说法,比利时的气候几乎可以全年支持免费的冷却,平均每年只有7天气温不符合免费冷却系统的要求。夏季布鲁塞尔最高气温达到66至71华氏度(19-22℃),然而谷歌数据中心的温度超过80华氏度(27℃)。 ■ 惠普英国温耶德数据中心(PUE=1.16) 惠普英国温耶德数据中心利用来自北海的凉爽的海风进行冷却。 ■ 微软都柏林数据中心(PUE=1.25) 微软爱尔兰都柏林数据中心,采用创新设计的“免费冷却”系统和热通道控制,使其PUE值远低于微软其他数据中心的1.6。 从上面可以看出,降低PUE最有效的措施是采用免费自然制冷措施和替代传统的UPS系统。对于数据中心,其能耗一般由IT设备能源消耗、UPS转化能源消耗、制冷系统能源消耗、照明系统和新风系统的能源消耗以及门禁、消防、闭路电视监控等弱电系统能源消耗五部分组成。如果需要降低PUE的值,就需要从以下四个方面采取措施。 ■ 采用转换效率高的UPS系统。目前,新一代数据中心的设计基本采用新型的高频(IGBT技术)UPS系统,电源转换效率和功率因数都比传统的工频(可控硅技术)UPS系统2

有非常大的提升,而且重量轻和体积小。由于UPS的电源转换效率和负载率成正向关系,因此在设计和运维时要尽可能提高UPS的负载率。目前国内电信和联通都在提倡使用高压直流UPS系统,取消了传统意义上UPS的逆变功能,不仅电源转换效率提高3到5个百分点,而且可靠性大大提高。上面介绍Google和Facebook干脆在数据中心取消了传统的UPS系统,把电池和服务器的电源相结合,在正常运营时完全没有额外的能源消耗。 ■ 采用高效节能的绿色制冷系统。主要是采用水冷空调和自然制冷措施,下面做详细介绍。 ■ 采用LED绿色节能光源取代或部分取代传统光源,据了解,目前在世纪互联和鹏博士的数据中心部分机柜上已经安装LED光源。另外就是运维管理,做到人走灯关,根据人员情况确定新风系统的运行时间和风量。 ■ 弱电系统总的能源消耗很小,一般不需要过多关注。但是如果可能的话,最好采用集中的高效直流供电系统,因为一般分布式的小型直流电源系统转换效率低,功率因数也低。

1、适合数据中心的空调系统介绍 由于数据中心的发热量很大且要求基本恒温恒湿永远连续运行,因此能适合其使用的空调系统要求可靠性高(一般设计都有冗余备机)、制冷量大、小温差和大风量。 空调系统的制冷能效比(COP)是指空调器在额定工况下制冷运行时,制冷量与有效输入功率之比。该数值的大小反映出不同空调产品的节能情况。空调系统的制冷能效比数值越大,表明该产品使用时产生相同制冷量时所需要消耗的电功率就越小,则在单位时间内,该空调产品的耗电量也就相对越少。 新的强制性国家标准《房间空气调节器能效限定值及能效等级》(GB12012.3-2010)由国家质检总局、国家标准委于2010年2月26日发布,从6月1日起将在全国范围内实施。此标准规定14000W制冷量以下民用空调器能效等级指标以及试验方法、检验规则、房间空调器产品新的能效限定值、节能评价值等。

国家强制性房间空调器能效等级标准 类型 额定制冷量(CC) 能效等级 1 2 3 整体式 3.30 3.10 2.90

分体式 CC≦4500W 3.60 3.40 3.20 4500W7100W

针对空调系统制的冷能效比,需要特别说明以下两点: ■ 厂家给出的空调系统制冷能效比是在额定的工况条件下测试的,实际工况一般都要比额定工况差很多(包括负载和环境),因此空调系统的实际运行的能效比都要比厂家给出的低很多。 ■ 针对数据中心的空调系统尤其特殊,一是全年不间断运行,工况差别非常的大;二是温度湿度控制精度高,除湿、加湿、加热、小温差大风量等比一般民用空调系统消耗的附加能量更多。 1.1 风冷精密空调 这是数据中心最传统的制冷解决方案,单机制冷能力一般都在50到200KW之间,一个数据机房一般都是安装多台才能满足需要。下面是风冷精密空调的工作原理图。 3

风冷精密空调一般采用涡旋压缩机制冷(一般安装在精密空调内),能效比相对比较低,在北京地区一般在1.5到3之间(夏天低,冬天高)。风冷精密空调在大型数据中心中使用存在以下不足: ■ 安装困难。大量的室外冷凝器安装需要非常大的场地,铜管过长不仅影响制冷效率,成本高,安装难度大,而且影响建筑物外观。室外冷凝器的安装位置受空间限制,极可能出现热岛效应,大大降低制冷效率。 ■ 在夏天室外温度很高时,制冷能力严重下降甚至保护停机。目前国内的数据中心一般采用对室外冷凝器喷水雾或增加凉棚来改善其在夏天的制冷效果。因此数据中心在设计时不能按其额定的制冷量计算,需要留有足够的冗余。 ■ 对于传统多层电信机房,一般把室外冷凝器安装在每层的四周,下层冷凝器的热量将不断向上散发,上层的冷凝器效率将大大降低,热量散不出去,形成严重的热岛效应。据了解,北方某联通数据中心因为热岛效应夏天机房的温度高达35℃以上,大约10%的服务器停机,用户只好运来冰块降温。 ■ 精密空调内部风机盘管的工作温度大大低于露点温度,大量产生冷凝水,为了维持数据中心的湿度,需要启动加湿功能。除湿和加湿都要消耗大量的能源。为了加湿,需要将自来水进行软化,即便如此,还需要经常清洗加湿罐中的水垢。 1.2 离心式水冷空调系统 这是目前新一代大型数据中心的首选方案,其特点是制冷量大并且整个系统的能效比高(一般能效比在3到6之间)。 4

离心式制冷压缩机的构造和工作原理与离心式鼓风机极为相似。但它的工作原理与活塞式压缩机有根本的区别,它不是利用汽缸容积减小的方式来提高气体的压力,而是依靠动能的变化来提高气体压力。离心式压缩机具有带叶片的工作轮,当工作轮转动时,叶片就带动气体运动或者使气体得到动能,然后使部分动能转化为压力能从而提高气体的压力。这种压缩机由于它工作时不断地将制冷剂蒸汽吸入,又不断地沿半径方向被甩出去,所以称这种型式的压缩机为离心式压缩机。压缩机工作时制冷剂蒸汽由吸汽口轴向进入吸汽室,并在吸汽室的导流作用引导由蒸发器(或中间冷却器)来的制冷剂蒸汽均匀地进入高速旋转的工作轮(工作轮也称叶轮,它是离心式制冷压缩机的重要部件,因为只有通过工作轮才能将能量传给气体)。气体在叶片作用下,一边跟着工作轮作高速旋转,一边由于受离心力的作用,在叶片槽道中作扩压流动,从而使气体的压力和速度都得到提高。由工作轮出来的气体再进入截面积逐渐扩大的扩压器(因为气体从工作轮流出时具有较高的流速,扩压器便把动能部分地转化为压力能,从而提高气体的压力)。气体流过扩压器时速度减小,而压力则进一步提高。经扩压器后气体汇集到蜗壳中,再经排气口引导至中间冷却器或冷凝器中。 水冷冷冻机组的工作原理如下: ■ 冷冻水侧:一般冷冻水回水温度为12℃,进入冷冻器与冷媒做热交换后,出水温度为7℃。 冷冻水一般通过风机盘管、组合式空调机组或水冷精密空调机向 IT设备提供冷气。由于数据中心的制冷量大,要求温差小风量大且湿度需要控制,一般采用水冷精密空调机。 ■ 冷却水侧:一般冷却水进水温度为30℃,进入冷凝器与冷媒做热交换后,出水温度为35℃。 冷却水一般使用蒸发式冷却塔通过水蒸发来散热降温。 ■ 冷媒侧: 冷媒以低温低压过热状态进入压缩机,经压缩后成为高温高压过热状态冷媒。 高温高压过热状态冷媒进入冷凝器后,将热传给冷却水而凝结成高压中温液态冷媒。高压中温液态冷媒经膨胀装置,成为低压低温液气混合状态冷媒。 低温低压液气混合状态冷媒进入蒸发器后,与冷冻水进行热交换,冷冻水在此处被冷却,而冷媒则因吸收热量而蒸发,之后以低温低压过热蒸气状态进入压缩机。

离心式制冷压缩机与活塞式制冷压缩机相比较,具有下列优点: ■ 单机制冷量大(350到35000KW之间),在制冷量相同时它的体积小,占地面积少,