单调速率调度算法RMS

- 格式:docx

- 大小:52.93 KB

- 文档页数:8

怎样求信号中的RMS值?上⼀篇介绍怎样评价隔振装置的隔振效果时,对于稳态⼯况使⽤RMS进⾏计算;对于加速⼯况,使⽤overall level进⾏计算。

这时,⼜有⼈在问,怎么得到RMS值?另⼀⽅⾯,RMS计算在信号处理中有多处要⽤到它,⽐⽅计算overalllevel,计算声压级等等。

下⾯,将介绍怎么从时域和频域计算信号的RMS值。

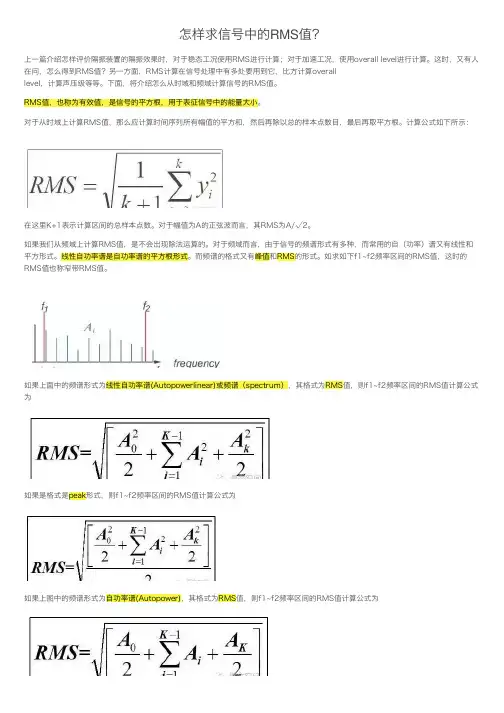

RMS值,也称为有效值,是信号的平⽅根,⽤于表征信号中的能量⼤⼩。

对于从时域上计算RMS值,那么应计算时间序列所有幅值的平⽅和,然后再除以总的样本点数⽬,最后再取平⽅根。

计算公式如下所⽰:在这⾥K+1表⽰计算区间的总样本点数。

对于幅值为A的正弦波⽽⾔,其RMS为A/√2。

如果我们从频域上计算RMS值,是不会出现除法运算的。

对于频域⽽⾔,由于信号的频谱形式有多种,⽽常⽤的⾃(功率)谱⼜有线性和平⽅形式。

线性⾃功率谱是⾃功率谱的平⽅根形式。

⽽频谱的格式⼜有峰值和RMS的形式。

如求如下f1~f2频率区间的RMS值,这时的RMS值也称窄带RMS值。

如果上⾯中的频谱形式为线性⾃功率谱(Autopowerlinear)或频谱(spectrum),其格式为RMS值,则f1~f2频率区间的RMS值计算公式为如果是格式是peak形式,则f1~f2频率区间的RMS值计算公式为如果上图中的频谱形式为⾃功率谱(Autopower),其格式为RMS值,则f1~f2频率区间的RMS值计算公式为如果是格式是peak形式,则f1~f2频率区间的RMS值计算公式为如果上图中的频谱形式为功率谱密度PSD,其格式为RMS值,则f1~f2频率区间的RMS值计算公式为如果是格式是peak形式,则f1~f2频率区间的RMS值计算公式为如果计算整个频率区间的RMS值,则称为overall level,也就是说overall level是整个带宽内的RMS值。

RMS值的另⼀个应⽤是**阶次切⽚**。

对于阶次切⽚⽽⾔,也是计算相应频带内的RMS值,只是,此时,对应的频率宽度为阶次宽度内的RMS值。

无线资源管理主要包括切换控制、功率控制、接入控制、负荷控制以及分组调度等方面的内容。

无线资源管理是3G系统无线网络控制器(RNC)的重要组成部分,其主要作用是负责空中接口资源的分配和使用,确保用户业务的服务质量、系统规划的覆盖区域以及提高系统容量。

在3G的演进过程中,标准化组织3GPP和3GPP2也在不断完善和增强相关技术。

对于分组调度算法,一方面要考虑到算法实现的复杂度,另一方面需要注意对系统性能指标的影响,如公平性、时延、业务的服务质量(QoS)等。

目前采用比较多的调度算法主要有轮循调度、最大载干比调度、比例公平调度三种类型。

在分组通信中,为了获得统计复用增益,需要多个业务流共享带宽。

因此,当多个用户争用资源时,就需要有一种机制来确定服务次序,有效地分配无线资源,这就是分组调度。

由于无线信道时变特性、带宽资源有限和移动台功率受限等因素的影响,无线网络中的分组调度算法有别于有线网络。

调度器首先根据信道状态监视/预测模块提供的信道信息和用户的队列状态,依据一定的调度算法,计算出每个用户的优先级,然后根据优先级对用户数据排队,并分配无线资源,最后送到发射机。

1.Round Robin 轮叫调度(Round-Robin Scheduling)狭义解释:时间片轮转算法的基本思想是,系统将所有的就绪进程按先来先服务算法的原则,排成一个队列,每次调度时,系统把处理机分配给队列首进程,并让其执行一个时间片。

当执行的时间片用完时,由一个计时器发出时钟中断请求,调度程序根据这个请求停止该进程的运行,将它送到就绪队列的末尾,再把处理机分给就绪队列中新的队首进程,同时让它也执行一个时间片。

广义解释:时间片轮转调度是一种最古老,最简单,最公平且使用最广的算法是时间片调度。

每个进程被分配一个时间段,称作它的时间片,即该进程允许运行的时间。

如果在时间片结束时进程还在运行,则CPU将被剥夺并分配给另一个进程。

如果进程在时间片结束前阻塞或结束,则CPU当即进行切换。

基于分时分区操作系统软件架构的应用郑智健;赵刚;孙战;薛建彬;郭燕波【摘要】火控系统在多年的不断发展中渐渐暴露出了开发和维修成本高的弊端,提出通过将分时分区操作系统运用到火控系统中,采用航空领域综合化模块化(IMA)体系的设计方案,按照功能来将软件进行划分,采取通用以及专用的软件模块进行配置,实现系统和子系统任务功能,使其能够实现综合化模块化及应用软件构件化的思路,对极大的降低火控系统今后的开发和维修成本有十分重要的意义.%Fire-control system exposed gradually its disadvantages of for development and maintenance in the years of development.The fire-control system,applying time-sharing and partition system,and if it is used the IMA system in the fire control system,dividing the software on the function and configuring through general and dedicated software,the function of system and subsystem can be realized,will realize integrating,modular and application,and have much point in reducing the cost of fire-control system's development and maintence in the future.【期刊名称】《火力与指挥控制》【年(卷),期】2018(043)003【总页数】4页(P69-72)【关键词】分时分区操作系统;软件IMA【作者】郑智健;赵刚;孙战;薛建彬;郭燕波【作者单位】北方自动控制技术研究所,太原030006;北方自动控制技术研究所,太原030006;北方自动控制技术研究所,太原030006;北方自动控制技术研究所,太原030006;北方自动控制技术研究所,太原030006【正文语种】中文【中图分类】TJ8110 引言近年来,航空领域综合化模块化(IMA)电子系统发展较为迅猛,综合化模块化航空电子系统的主要特点是使用了许多现场可更换模块来完成各种射频部分、信号处理和信息处理功能,这种模块化的设计便于系统容错和系统重构,并且为同类模块的大量生产降低了成本。

托姆斯突名词解释

托姆斯突(Tomasulo's algorithm)是一种用于动态调度并行执

行指令的算法,常用于超标量和乱序执行的处理器设计中。

该算法由罗伯特·托姆斯突(Robert Tomasulo)于1967年提出。

该算法通过将指令的操作数和结果放置在复杂的寄存器重命名表(reservation station)中,来实现指令间的并行执行。

每个

寄存器重命名表都包含一个状态字段,指示该指令是否已经发射、执行或完成。

在托姆斯突的算法中,每个指令都被解耦为三个独立的阶段:发射(issue)、执行(execute)和写回(writeback)。

发射阶段负责将指令从指令缓冲区中移至空闲的寄存器重命名表中。

执行阶段负责将指令实际执行,并处理相关的数据依赖关系。

写回阶段负责将指令的结果写回到相应的目标寄存器中。

托姆斯突的算法充分利用了指令级并行性和数据级并行性,能够在没有数据冲突的情况下并行执行多条指令,提高了处理器的执行效率。

该算法还支持动态调度,即可以根据指令的实际执行情况进行动态调度和重排序,以最大程度地减少流水线的停顿和浪费。

总结起来,托姆斯突是一种用于动态调度并行执行指令的算法,通过寄存器重命名表和多阶段流水线的设计,实现了指令级并行性和数据级并行性,并提高了处理器的执行效率。

操作系统期末考试试卷0250-0252操作系统试卷A0250—0252操作系统试卷A一、简答题(每题5分,共30分)1。

什么是虚拟设备?2。

What’s the differrence between a process and a program?3。

What’s Hyper—Treading technology?4.死锁的必要条件是什么?5.为什么将文件控制块分成主部和次部两部分?6.若系统有同类资源m个,被n个进程共享,问:当m〉n和m〈=n时每个进程最多可以请求多少个这类资源,使系统一定不会发生死锁?为什么?二、填空题(每空1分,共10分)1.操作系统的两个重要特性是:(1) 和(2) .2。

只能在管态下执行的指令称为(3) .处理机状态由目态转换为管态的唯一途径是(4),管态到目态的转换可以通过修改(5) 来实现。

3.进程在其生存期内可以处于如下三种基本状态之一:运行态、就绪态和等待态。

当一个就绪进程(6)时,其状态由就绪变为运行,当一个运行进程被抢占处理机时,其状态由运行变为(7) ,当一个运行进程因某事件受阻时,其状态由运行变为(8) ,当进程所等待的事件已经发生时,该进程状态由(9) 变为就绪。

4。

线程是进程内的一个相对独立的(10).三、计算题(每题10分,共40分)1.设某计算机系统采用虚拟页式存储管理方法,进程的虚拟地址空间为64KB,页面尺寸为4KB。

假设当前进程的页表如右图所示(页表以二进制形式表示),请将虚拟地址8196和2050转换为物理地址。

2。

设某计算机系统采用虚拟页式存储管理方法,内存中为该进程分配4个物理页架,开始时内存页架为空,假设进程在一段时间内的页面访问序列如下:6,0,1,2,0,3,0,4,2,3,0,3,2,1,2,0,1,7,0,1,请画图表示采用以下页面淘汰算法时的缺页中断次数:(1)最佳页面淘汰算法(OPT);(2)先进先出页面淘汰算法(FIFO);(3)使用过最久的先淘汰(LRU)。

从SGD到Adam——常见优化算法总结1 概览虽然梯度下降优化算法越来越受欢迎,但通常作为⿊盒优化器使⽤,因此很难对其优点和缺点的进⾏实际的解释。

本⽂旨在让读者对不同的算法有直观的认识,以帮助读者使⽤这些算法。

在本综述中,我们介绍梯度下降的不同变形形式,总结这些算法⾯临的挑战,介绍最常⽤的优化算法,回顾并⾏和分布式架构,以及调研⽤于优化梯度下降的其他的策略。

2 Gradient descent 变体有3种基于梯度下降的⽅法,主要区别是我们在计算⽬标函数( objective function)梯度时所使⽤的的数据量。

2.1 Batch gradient descent 批梯度下降法计算公式如下:其中η表⽰学习率。

该⽅法在⼀次参数更新时,需要计算整个数据集的参数。

优点:可以保证在convex error surfaces 条件下取得全局最⼩值,在non-convex surfaces条件下取得局部极⼩值。

缺点:由于要计算整个数据集的梯度,因此计算⽐较慢,当数据量很⼤时,可能会造成内存不⾜。

另外,该⽅法也⽆法在线(online)更新模型。

计算的伪代码如下:for i in range ( nb_epochs ):params_grad = evaluate_gradient ( loss_function , data , params )params = params - learning_rate * params_grad其中,params和params_grad均是向量(vector)。

2.2 Stochastic gradient descent(SGD)随机梯度下降计算公式如下:随机梯度下降法每次更新参数时,只计算⼀个训练样本(x(i), y(i))的梯度。

优点:计算速度快,可以⽤于在线更新模型。

缺点:由于每次只根据⼀个样本进⾏计算梯度,因此最终⽬标函数收敛时曲线波动可能会⽐较⼤。

由于SGD的波动性,⼀⽅⾯,波动性使得SGD可以跳到新的和潜在更好的局部最优。

不规则波形的rms和peak的关系

在电子电路和信号处理中,我们经常需要分析信号的能量和幅值。

其中,rms(均方根)和peak(峰值)是两个重要的参数。

然而,当信号的波形不规则时,这两个参数之间的关系并不简单。

rms代表信号的有效值,可以用以下公式计算:rms=sqrt(1/T* ∫(t1 to t2) x^2(t) dt),其中T为采样时间,t1和t2为采样时间段,x(t)为信号在时刻t的幅值。

对于正弦波,rms等于该波的峰值除以sqrt(2)。

但对于不规则波形,rms的计算变得更加复杂。

peak代表信号的最大值。

对于正弦波,peak等于该波的峰值。

但对于不规则波形,peak的计算也变得复杂。

在实际应用中,我们通常需要比较不同波形的能量和幅值。

此时,我们可以通过将rms和peak进行归一化来比较它们。

例如,我们可

以计算出rms的峰值和peak的rms值,并将它们进行比较。

这样做

可以有效地比较不同波形的能量和幅值,并且可以避免由于不规则波形而导致的误差。

总之,不规则波形的rms和peak之间的关系并不简单。

在实际

应用中,我们需要根据具体情况选择合适的归一化方法来比较不同波形的能量和幅值。

- 1 -。

MIMO均衡算法(CMALMSRLS)原理介绍MIMO(Multiple Input Multiple Output)均衡算法是用来解决多输入多输出通信系统中的信号干扰问题的一种方法。

MIMO系统是一种通过在发送和接收端使用多个天线来提高通信性能的技术,它可以同时传输多个信号流,从而提高了系统的传输容量和可靠性。

MIMO均衡算法主要有三种:CMA(Constant Modulus Algorithm)、LMS(Least Mean Square Algorithm)和RLS(Recursive Least Square Algorithm)。

下面将对这三种算法的原理进行详细介绍。

1.CMA算法原理:CMA算法是一种基于判决反馈的盲均衡算法,主要用于消除通信系统中的多径干扰。

其原理基于一种常数模型,即假设接收信号的样本具有常数模量。

CMA算法通过最小化误差信号的功率来估计多径信道,从而实现均衡。

算法的核心思想是根据判决反馈,通过调整均衡器的参数来最小化误差信号的功率。

2.LMS算法原理:LMS算法是一种基于梯度下降法的自适应均衡算法,其主要特点是简单易理解、计算速度快。

LMS算法通过最小化接收信号与期望信号之间的误差来更新均衡器的权重。

算法的核心思想是根据误差信号和输入信号之间的相关性来更新均衡器的参数,从而逐步优化均衡器的性能。

3.RLS算法原理:RLS算法是一种基于递推最小二乘法的自适应均衡算法,其主要特点是收敛速度快、抗干扰性能好。

RLS算法通过最小化误差的均方值来更新均衡器的权重。

算法的核心思想是根据输入信号和误差信号之间的相关性来更新均衡器的参数,从而实现均衡。

相比于LMS算法,RLS算法的计算复杂度较高,但是收敛速度更快,适用于信道条件变化频繁的情况。

总而言之,MIMO均衡算法通过调整均衡器的权重来消除多输入多输出通信系统中的信号干扰,从而提高通信系统的性能。

CMA算法是一种基于判决反馈的盲均衡算法,LMS算法是一种基于梯度下降法的自适应均衡算法,RLS算法是一种基于递推最小二乘法的自适应均衡算法。

操作系统中的调度算法分析操作系统是计算机系统中最为重要的组成部分之一,它负责管理计算机系统的资源,包括硬件和软件资源,并且为其它应用程序提供支持和服务。

在操作系统中,调度算法是其中非常重要的一部分,对于它的优化和改进有着非常重要的意义。

本文将按照类别对操作系统中的调度算法进行详细分析,包括批处理系统中的调度算法、交互式系统中的调度算法、实时系统中的调度算法,以及多处理器系统中的调度算法。

一、批处理系统中的调度算法批处理系统是指能够自动地运行一批作业的操作系统,它是在没有任何人的干预下完成作业的自动化系统。

在批处理系统中的调度算法,其主要目的是使各作业的吞吐率最大,并且减少响应时间和等待时间。

在批处理系统中的调度算法包括先来先服务(FCFS)算法、短进程优先(SJF)算法、最高响应比优先(HRRN)算法等。

1、先来先服务(FCFS)算法先来先服务算法,也称为先到先服务算法,是最简单的一种调度算法。

它的作用是按照进程的到达时间的先后顺序进行服务,先到达的进程先得到服务,后到达的进程则必须等待前面进程的服务结束才能够被执行。

优点是公平、简单,缺点是会导致长作业等待时间长,短作业等待时间短。

2、短进程优先(SJF)算法短进程优先算法,是按照进程的执行时间长度来排序,执行时间越短的进程优先得到服务,它可以使得等待时间总和最小,从而提高系统的吞吐率。

但是,如果遇到长作业,则会导致短作业等待时间过长。

3、最高响应比优先(HRRN)算法最高响应比优先算法,则是综合考虑前两种算法的优点而得到的一种调度算法,它会计算出每个进程的响应比,并且选择响应比最高的进程进行执行。

响应比的计算公式是:响应比 = (等待时间 + 执行时间) / 执行时间该算法可以最大限度地减少等待时间,并且适用于长作业与短作业的服务。

二、交互式系统中的调度算法相比于批处理系统,交互式系统强调用户体验,需要快速响应用户的指令请求。

因此,交互式系统中的调度算法,其主要目的是降低响应时间,尽可能快地处理用户的请求。

高响应比优先调度算法是计算机操作系统中常用的一种调度算法,它能够在多个进程同时竞争CPU资源的情况下,按照一定的规则为这些进程分配CPU时间,以实现优化系统性能的目的。

下面我们将从算法的基本原理、适用场景和实例分析等几个方面,详细解读高响应比优先调度算法。

一、算法的基本原理高响应比优先调度算法是一种非抢占式的调度算法,它根据进程的等待时间和服务时间来确定优先级,从而确定下一个执行的进程。

其基本原理可以概括为以下几点:1. 等待时间越长的进程,其优先级越高。

这是因为等待时间长的进程意味着它已经等待了很久,需要尽快得到CPU资源来执行。

2. 服务时间越短的进程,其优先级越高。

这是因为服务时间短的进程意味着它执行完成的可能性更大,因此应该优先得到CPU资源执行。

二、算法的适用场景高响应比优先调度算法适用于以下场景:1. 系统中的进程具有不同的优先级,需要根据优先级来确定下一个执行的进程。

2. 系统需要尽可能减少进程的等待时间,提高系统的响应速度。

三、例题详解接下来,我们将通过一个具体的例题来详细解读高响应比优先调度算法的应用和具体操作步骤。

假设系统中有3个进程,它们的进程控制块(PCB)信息如下:进程A:等待时间10ms,服务时间20ms进程B:等待时间5ms,服务时间15ms进程C:等待时间8ms,服务时间10ms我们将按照高响应比优先调度算法的原理来确定下一个执行的进程。

1. 计算每个进程的响应比。

响应比的计算公式为(等待时间+服务时间)/服务时间。

进程A:(10+20)/20=1.5进程B:(5+15)/15=1.33进程C:(8+10)/10=1.82. 根据计算得到的响应比来确定下一个执行的进程。

显然,进程C的响应比最高,所以应该被选为下一个执行的进程。

3. 当进程C执行完成后,再按照相同的方法来确定下一个执行的进程,直至所有进程执行完成。

通过以上例题的详解,我们可以清晰地了解高响应比优先调度算法的具体应用操作步骤和执行流程,以及在实际场景中的效果和影响。

HRRN调度算法1. 介绍HRRN(Highest Response Ratio Next)调度算法是一种以响应比为依据进行进程调度的算法。

在计算机操作系统中,进程调度是指根据一定的策略,将CPU的使用权交给某个进程来执行,以提高系统的吞吐量和响应速度。

HRRN调度算法采用动态优先级的方式,根据进程的响应比来确定下一个要执行的进程,从而实现了公平性和高响应速度。

2. 响应比的计算在HRRN调度算法中,每个进程都有一个优先级,优先级的计算是通过进程的等待时间和服务时间来确定的。

等待时间指进程在就绪队列中等待CPU的时间,服务时间指进程已经占用CPU的时间。

响应比通过以下公式来计算:响应比 = (等待时间 + 服务时间) / 服务时间3. 调度过程HRRN调度算法的调度过程如下: 1. 遍历就绪队列中的所有进程,计算每个进程的响应比。

2. 根据计算得到的响应比,选取响应比最高的进程作为下一个执行的进程。

3. 将选中的进程调入CPU执行,更新进程的等待时间和服务时间。

4. 执行完毕后,检查是否有新的进程到达就绪队列,如果有,则将新的进程加入就绪队列。

5. 重复以上步骤,直到所有进程执行完毕。

4. 优点HRRN调度算法具有以下优点: - 公平性:HRRN调度算法会优先选择等待时间较长的进程,确保各个进程都能得到一定的CPU时间,从而实现了公平性。

- 高响应速度:由于HRRN调度算法优先选择响应比最高的进程,因此可以尽可能地减少进程的等待时间,提高系统的响应速度。

5. 缺点HRRN调度算法也存在一些缺点: - 响应比的计算复杂:HRRN调度算法需要计算每个进程的响应比,而响应比的计算涉及到等待时间和服务时间的测量,增加了算法的复杂性。

- 对长作业不友好:由于HRRN调度算法倾向于选择等待时间长的进程,因此对于长作业来说,可能会导致长作业等待时间较长,降低了系统的吞吐量。

6. 示例假设有三个进程A、B和C,它们的服务时间和到达时间如下:进程服务时间到达时间A 5 0B 3 2C 4 4根据HRRN调度算法的计算方法,我们可以计算出每个进程的响应比:进程等待时间服务时间响应比A 0 5 1B 0 3 1.67C 0 4 1.5根据响应比的大小顺序,我们可以确定下一个要执行的进程:1.A进程:由于A进程的响应比最高,将其调入CPU执行。

余蓝涛1(天津大学精密仪器与光电子工程学院天津 300072 )摘要:嵌入式系统对强大实时处理能力的需求和相对紧张的内存及内核资源的现实,对嵌入式操作系统任务调度提出了较高的要求。

因此任务调度的算法的分析,实现和优化,对实现嵌入式系统的实时性有着重大的意义。

从算法提出的理论基础出发,深入分析了经典的单调速率调度算法的思想,特点,具体实现并重点评价了该算法的优点和局限性。

关键词:单调速率调度算法实时嵌入式系统Abstract:The zest for powerful real-time processing of embedded system and the reality of relatively scare memory and kernel resource pave way for the high request for task scheduling. Therefore, the analysis, implementation and optimization of task scheduling algorithm have a vast meaning for the real-time system. Based on theoretical basis of classic rate-monotonic scheduling algorithm, this paper not only analyzes fundamental thought, characteristics, practical implementation of this classic algorithm in depth, but also rate its advantages and disadvantages.Key words: Rate-monotonic Scheduling, Algorithm, Real-time, Embedded System一,引言现在嵌入式系统得到高速的发展。

它的发展为几乎所有的电子产品注入了新的活力。

它在国民经济各领域和我们日常生活中发挥了越来越重要的作用。

嵌入式系统在航天、军事、工控以及家电等方面得到了广泛应用。

囿于体积,能耗,价格等方面的约束,嵌入式系统处理器速度比较慢,存储器容量也有限。

而传统的操作系统为了取得较高的性能,要求硬件设备具有强大的处理能力,大容量的存储能力以及对网络的支持功能,这使得传统的操作系统难以简单地移植到嵌入式系统中。

这就导致了嵌入式操作系统由于受到系统的限制,往往内存资源都非常的有限,要求操作系统的内核都非常的精炼,对于系统中的资源操作系统内核需要进行统一的分配和调度。

嵌入式操作系统调度策略一直以来都是嵌入式操作系统的研究中的一个热点。

任务调度是嵌入式操作系统内核的关键部分,如何进行任务调度,使得各个任务能在其截止期限内得以完成是嵌入式操作系统的一个重要的研究领域。

二,嵌入式实时操作系统绝大部分嵌入式系统都是实时系统,而且多是实时多任务系统。

所谓“实时”,是指系统的正确性不仅仅依赖于计算的逻辑结果而且依赖于结果产生的时间[1][6]。

结果产生的时间就是通常所说的截止期限(deadline),描述系统实时性的指标主要有:a,对紧急事件可预见性的快速响应;1作者简介:余蓝涛(1991-)江西省人天津大学精密仪器与光电子工程学院测控技术与仪器本科生学号:79b,高度的可调度性,所谓调度性是指系统在任务时间需求能够满足下的最高资源利用率,也就是平均每秒的及时执行的任务数量;c,在暂时超负荷情况下的系统稳定性,即当系统超负荷运转导致不能满足所有任务的deadline需求时,仍然能够保证关键任务的deadline需求;[2]对于“实时”而言,截止期限的要求是必须得到满足的,但是区分具体应用场合,这种时限要求的严格程度又有所不同。

如果这种要求是绝对的,即不满足截止期限的要求计算结果就毫无意义甚至可能造成无法预料的结果或系统致命的错误,那就称之为硬实时系统(Hard Real Time System);在硬实时系统中如果出现了这样的情况就意味着巨大的损失和灾难,比如说日本福岛核电站中的堆芯温度控制系统如果没有对堆芯过热做出及时的冷却处理,后果不堪设想。

当不满足截止期限的要求时计算结果的可调度性逐渐减弱但是并不足以造成严重后果,系统仍然继续调度直至任务完成,则称为软实时系统(Soft Real Time System)。

软实时系统是指如果在系统负荷较重的时候允许发生错过deadline 的情况而且不会造成太大的危害比如说程控电话系统允许在100个电话中有一个接不通。

硬实时系统和软实时系统的实现区别主要是,在选择调度算法上选择基于优先级调度的算法足以满足软实时系统的需求而且可以提供高速的响应和大的系统吞吐率,而对硬实时系统来说需要使用的算法就应该是调度方式简单反应速度快的实时调度算法了。

三,优先级调度算法调度,也称dispatcher。

这是内核的主要职责之一,就是确定该轮到哪个任务运行了。

优先级抢占调度算法中,每个任务根据其重要程度的不同而被赋予一定的优先级。

优先级抢占调度算法是指在系统运行过程中高优先级的任务可以中断低优先级的任务,让处在就绪态的优先级最高的任务先运行。

目前多数实时内核采用优先级可抢占的调度算法,主要原因有以下几点:[5]首先,处理异常的任务可能需要抢占正在运行的任务,以便及时对异常做出响应;第二,任务的重要性不同,优先级可抢占使一些重要任务有可能抢占正在运行的任务;第三,允许任务抢占可得到更为有效的调度;根据不同的优先级分配方法,基于优先级的调度算法可以分为如下两种类型:1,静态调度:静态调度是在系统开始运行前进行调度的,严格的静态调度在系统运行时无法对任务进行重新调度。

静态调度的目标是把任务分配到各个CPU,并对每一个CPU给出所要运行任务的静态运行顺序。

静态调度算法实现简单,调度的额外开销小,在系统超载时可预测性好。

但也具有很大的局限性,例如资源利用率低、受系统支持的优先级个数限制以及灵活性和自适应性差等。

2,动态调度:在嵌入式实时系统中,动态调度依赖于任务的优先级。

优先级可以静态分配或者依据不同的特征参数,如截止时间、空闲时间或关键性(即任务的重要程度)等进行动态分配。

动态调度可以是抢占式的或非抢占式的。

当检查到一事件时,动态抢占式算法立即决定是运行与此事件相关的任务,或继续执行当前的任务;对于动态非抢占式算法,它仅仅知道有另一个任务可以运行,在当前任务结束后,它才在就绪的任务中选择一个来运行。

优先级调度算法在实时进程调度中使用很广泛,静态优先级调度算法根据应用的属性来分配优先级,其可控性较强,而动态优先级调度算法在资源分配和调度时具有更大的灵活性。

一个好的调度模型和调度算法应该能够满足以下四个要求:1)易于使用(Ease To Use):在系统中对于分配资源的各种任务,调度算法不需要大量的搜索操作就可以找到可行性调度;2)易于纠偏(Ease To Check):任务程序发生改变时,调度不必从头做起;3)易于扩展(Ease To Extend):一定程度上违反了系统的假设条件时,调度不应该改变;4)应确保可调度性(Must Guarantee Predictability):在给定时间限定的条件下,调度必须能够保证所有任务的执行;静态优先级调度模型是实时系统中比较流行的一种调度模型。

这种模型在系统运行前给每个任务分配固定的优先级和运行周期,当任务到达时向系统发出执行请求,这个请求必须在下一个周期开始之前完成,每个任务的执行情况相互独立。

固定优先级调度模型可描述各种情况下系统的最坏运行情况,用定义好的算法来调度任务,而不需像循环调度模型那样对特定的情况用特定的调度方案,因此使系统便于维护和升级。

[5]单调速率调度算法RMS(Rate Monotonic Scheduling)为每个周期进程指定一个固定不变的优先级,周期最短的进程优先级最高。

周期越短,进程的到达频率越高,优先级也越高,这正是此策略被称为速率单调算法的原因。

RMS算法也可用于多CPU环境,用于分配任务优先级。

这种方法基于哪个任务执行的次数最频繁,执行最频繁的任务优先级最高。

RMS的由来是从硬实时环境的初始定义开始的:1,所有的任务都是周期性的,各个任务请求的deadline 呈周期性,同时具有恒定的时间间隔;2,所有任务都必须在下一次任务请求(即deadline )到来之前完成;3,所有的任务都是独立的,每一次任务请求不依赖于其他任务的执行或者初始化;4,每个任务都存在一个恒定且非时变的执行时间,即CPU 不间断地执行该任务的时间;5,任何非周期的任务属于特殊任务,它们属于初始化或者是恢复错误的事件,仅当它们自身执行的时候才能取代周期性任务,同时非周期性任务不存在有deadline.RMS 调度算法从何而来呢假设使用τ1,τ2,…,τm 表示m 个周期任务,任务申请周期和运行时间分别表示为T 1,T 2,…,T m 和C 1,C 2,…,C m 。

定理1:若所有进程在临界时刻启动的请求都能满足最后期限要求,则整个进程集可调度。

即进程在临界时刻启动的请求响应时间最长。

图1:在τm 执行之前的τ1运行[1] 证明:如图1所示,假定τm 为τ1,τ2,…,τm 优先级最低的任务,在t 1时刻任务τm 发出了运行请求,显然在图1所示的t 1到t 1+T m 时间间隔之间请求运行的周期性占先任务会推迟τm 完成时刻,除非τm 在t 2到来之前完成它。

当t 2向t 1方向移动的时候,τm 任务完成的时刻要么不变,要么被推迟,所以断定,在t 2向t 1方向无线趋近,直至与t 1重合的时候,能够做到τm 完成任务的延时最长。

根据定理1可以假定,有两个任务τ1和τ2,对应的指定周期T 1<T 2。

假设τ1的优先级更高,此时根据定理1,可得:[1]⌊T 2T 1⌋2C 1+C 2≤T 2; 1) 如果假设τ2的优先级更高,此时显然有:C 1+C 2≤T 1; 2)因为有: ⌊T 2T 1⌋C 1+⌊T 2T 1⌋C 2≤⌊T 2T 1⌋T 1≤T 2 2)式导出了1)式,换句话说,只要保证了T 1<T 2 ,不论是τ2的优先级高于τ1,τ1的优先级高于τ2的两种情况下都是可以调度的。

推而广之,那么,似乎在设计调度算法的时候,倘若我们将调度频率独立于运行时间的话,让较高使用频率的任务具有较高的优先级,较低使用频率的任务具有较低的优先级的话,使用这种单调速率的方法来定义固定优先级的任务似乎是更加合理的选择了。