随机森林与支持向量机分类性能比较

- 格式:doc

- 大小:181.00 KB

- 文档页数:7

传统机器学习算法与深度学习在文本分类中的比较文本分类是自然语言处理中的一个重要问题,并得到了广泛的关注和研究。

传统机器学习算法和深度学习算法都在文本分类中扮演着重要的角色。

本文将从机器学习算法和深度学习算法的角度,对二者在文本分类中的比较进行分析。

一、传统机器学习算法在文本分类中的应用传统机器学习算法在文本分类中的应用主要包括朴素贝叶斯、支持向量机、决策树和随机森林等。

这些算法在文本分类中表现出了不错的性能。

(一)朴素贝叶斯算法朴素贝叶斯算法最初用于垃圾邮件识别,效果非常好。

朴素贝叶斯算法是基于贝叶斯定理的一种算法,它假设特征之间是相互独立的,因此称为“朴素”贝叶斯算法。

在文本分类中,我们可以将每个文档看作是一个词语的集合,对每个词语计算它在各类别中的概率,然后利用贝叶斯定理计算出每个类别下文档的概率,选取概率最大的类别作为文档的分类结果。

朴素贝叶斯算法的优点是模型简单,计算速度快,在小样本下表现不错。

但是它的假设过于简单,因此在面对词汇在不同类别中的分布差距较大时,效果会受到影响。

(二)支持向量机支持向量机是一种常见的机器学习算法,在文本分类中也表现出了非常好的性能。

支持向量机通过找到数据的最优分类超平面来进行分类,使得分类结果的边界与数据点之间的距离最大化。

在文本分类中,我们可以先将文本转化为词向量,然后构建出特征空间,通过支持向量机进行分类。

支持向量机的优点是具有很好的鲁棒性和泛化能力,可以处理高维稀疏数据。

在处理文本分类问题时,它也能够在高维空间中找到一个合适的超平面完成分类任务。

但是支持向量机的计算成本较高,对参数的选取也较为敏感。

(三)决策树决策树是一种基于树形结构的机器学习算法,在文本分类中也得到了广泛的应用。

决策树通过对样本特征进行划分,采用自上而下的递归方式生成分类决策树。

在文本分类中,我们可以将每个单词看作是一个特征,根据其在文本中的出现情况进行划分,建立文本分类决策树,进行分类。

随机森林算法在遥感影像分类中的性能分析与改善设计遥感影像分类是利用遥感数据进行地物分类和识别的一种重要方法。

而随机森林算法作为一种强大的机器学习方法,已经在许多领域取得了显著的成功。

本文将对随机森林算法在遥感影像分类中的性能进行分析,并提出改善设计来进一步提高分类的准确性和效率。

首先,我们来分析随机森林算法在遥感影像分类中的性能。

随机森林算法是一种基于决策树的集成学习方法,它通过构建多个决策树,并使用投票或平均的方式来获得最终的分类结果。

相比于单个决策树,随机森林能够在减少过拟合的同时保持较高的分类准确性。

在遥感影像分类中,随机森林算法具有以下性能优势:1. 鲁棒性:遥感影像数据通常包含大量的噪声和干扰,而随机森林算法对于噪声和干扰具有较强的鲁棒性。

它能够自动选择最重要的特征,并根据特征的贡献程度进行分类,从而减少了噪声对分类结果的影响。

2. 高维特征处理能力:遥感影像数据通常具有高维特征,而随机森林算法能够有效处理高维数据,并进行自动特征选择。

它通过选择最佳分割点来构建决策树,从而实现对高维特征的有效利用。

3. 并行计算能力:随机森林算法中每个树都能够独立地构建和分类,因此可以通过并行计算来加速训练和分类的过程。

这使得随机森林算法在大规模遥感影像分类中具有较高的效率。

然而,随机森林算法在遥感影像分类中仍然存在一些挑战和改进的空间。

为了进一步提高性能,我们可以考虑以下改善设计:1. 特征选择:在构建随机森林模型之前,可以使用特征选择方法来选择最具代表性的特征。

这样可以减少特征维度,提高分类的速度和准确性。

一种常用的特征选择方法是基于信息增益或方差的方法。

2. 样本均衡:遥感影像数据中不同类别样本数量可能存在不平衡,这会导致随机森林模型对样本较多的类别具有较高的准确性,而对样本较少的类别准确性较低。

因此,可以采用过采样或欠采样等方法来解决样本不平衡问题,从而提高分类的平衡性。

3. 参数调优:随机森林算法中有一些重要的参数,如树的数量、最大深度和节点分裂准则等。

第40卷第4朗高原气表Vol. 40 N o. 4 2(>2丨年8 月P L A T E A U M E T E O R O L O G Y A—Si,2021刘新伟,蒋盈沙.黄武斌,等.2021.基于雷达产品和随机森林算法的冰苞天气分类识别及预报[J].高原气象.4〇(4): 898- 908. LIU X inw ei, JIANG Yingsha, HUANG W ubin,ct al, 2021. Classified Identification and Nowcast of Hail Weather Based on Radar Products and Random Forest Algorithm J .Plateau Meteorology, 40(4) :898-908. DOI :10. 7522/j. issn. 1000- 0534. 2020.00063.基于雷达产品和随机森林算法的冰雹天气分类识别及预报刘新伟\蒋盈沙2,黄武斌、潘永洁2,李霞2,郭润霞、黄玉霞1U.兰州中心气象台.甘肃兰州730020;2.中N科学院叫北生态环境资源研究院/寒旱区阽Ifli过程4气候变化1点实验宰.什4T尸州730000)摘要:冰s是一种致灾性较强的强对流天气,m作气象业务下.作中对其进行快捷、准确的预警和预报仍有一定的难度本文基于C波段茁达回波资料,构建并应用随机森林模型对冰雹及其伴随强对流天气进行了分类识別及预报结果发现,随机森林模型对训练集(2008 —2017平)中四类冰雹天气(冰雹、冰雹大风、冰雹短强、冰雹大风短强>的平均命中率(?1'(^1)丨丨办£^0扯(^〇11,/500)为90.2%,平均空报比率(False A丨arm R a tio,柯及)为11. 1%对于2018 —2019年的独立样本测试集,模型的平均/>0£>和没/?则分別为72. 8%和34. 7% W此,本文构建的随机森林模甩较为理想应用模型和风暴单体识别与跟踪产品(Strom Cell Identification and Tracking, SCIT)对未来15~60 m in的强对流天气进行预报,结果表明四类冰雹天气的甲_均P O D为74. 8%,平均临界成功指数为60. 8%,平均为24. 4%因此,利用C波段雷达产品,随机森林模咽能高效、自动化且较为准确地分类预箐、预报冰苞及其伴随强对流天气,可应用于天气预报业务工作。

基于几类机器学习模型的房价预测分析周亮锦1 赵明扬2(1.韩山师范学院经济与管理学院金融大数据中心,广东潮州 521000;2.韩山师范学院数学与统计学院,广东潮州 521000)摘要:选取1998年~2019年全国35个大中城市房价及其影响因素的相关数据,分别构建基于 K近邻法、决策树、随机森林和支持向量机的房价预测模型。

通过K折交叉验证和GridSearch对各模型的参数进行寻优操作,从而得到各类模型的最优状态,以期为房价精准预测提供新参考,并为政府的宏观调控提供新思路。

结果表明,从拟合度(R2)来看,最优参数组合(测试集)中K近邻法>随机森林>支持向量机>决策树。

但依据理论,随机森林应是这4类模型中的最优模型。

关键词:机器学习;房价;预测中图分类号:F299.23;F224 文献识别码:A 文章编号:2096-3157(2022)06-0111-06产品品牌,注重地理商标效应。

学习农产品大企业的产品品牌建设方案与营销推广模式,积极利用互联网的信息平台,进行特色产品品牌营销,构建生产流程标准化、质量信息可溯化、产品服务鲜明化、特色产品差异化的大众熟知、质量认可、特色鲜明的农产品特色品牌形象。

各地应积极挖掘、包装本地特色,依托于东北地区生产特色,将榛蘑、松子、黑木耳、杂粮杂豆、优质海产品等具有代表性的优质农产品打造成农产品地理商标,构建长远发展的品牌战略格局[9]。

五、结语本文基于对东北地区农业现状的剖析,面对互联网时代的来临,提出在“互联网+农产品”机制下重塑农业发展运行模式,在人才建设、产业融合、电商平台建设和规范运营等方面提出发展建议。

凭借互联网的东风,东北地区农业应该因时制宜、因地制宜、敢于创新、及时变革,构建适合新时期农业运行模式,这样才能为东北农业发展提供长足动力,为国家农业发展与粮食安全做好护航者与压舱石。

参考文献:[ 1 ]孙倩.中国东北农村土地制度演进及发展研究[D].长春:吉林大学,2019.[ 2 ]孟翰泽.双鸭山市农产品电子商务发展研究[D].哈尔滨:东北农业大学,2019.[ 3 ]牛亚丽.农业产业链高质量发展的治理生态研究:基于“互联网+农业产业链”的融合创新视角[J].经济与管理,2021,35(3):1-10.[ 4 ]宋丽敏,田佳蔚.东北地区人口流动决策的影响因素研究:基于个体特征与经济因素的交互分析[J].人口学刊,2021,43(4):63-73.[ 5 ]张剑宇,谷雨.东北地区高学历人口流失及原因:基于吉林大学2013-2017年毕业生就业数据的分析[J].人口学刊,2018,40(5):55-65.[ 6 ]隋福民.“互联网+农业”还是“农业+互联网”:中国农业发展转型升级的战略选择[J].宁夏社会科学,2020(6):102-107.[ 7 ]张延龙,王明哲,钱静斐,等.中国农业产业化龙头企业发展特点、问题及发展思路[J].农业经济问题,2021(8):135-144.[ 8 ]隋福民.“互联网+农业”还是“农业+互联网”:中国农业发展转型升级的战略选择[J].宁夏社会科学,2020(6):102-107.[ 9 ]徐明.乡村振兴战略背景下吉林省农产品区域品牌培育路径[J].税务与经济,2019(6):106-110.作者简介:孙佳伟,延边大学本科在读;研究方向:企业发展战略,电子商务。

R语言主成分分析在遥感影像分类中的应用与比较研究遥感影像分类是遥感技术中的重要应用领域之一,主成分分析是一种常用的数据降维方法。

本文将探讨R语言主成分分析在遥感影像分类中的应用,并与其他算法进行比较研究。

1. 引言随着遥感影像数据的快速增长,如何高效、准确地提取遥感影像中的地物信息成为研究热点。

主成分分析是一种基于统计原理的降维方法,能够将高维的遥感影像数据转化为较低维度的特征向量。

在遥感影像分类中,主成分分析可以帮助减少数据的冗余信息,提高分类的准确性。

2. R语言主成分分析的原理与步骤主成分分析是一种多元统计分析方法,可以从原始遥感影像数据中提取出最能代表数据变异的主成分。

在R语言中,使用prcomp函数可以实现主成分分析。

具体步骤包括数据预处理、计算协方差矩阵、计算特征值和特征向量、选择主成分、投影数据等。

3. R语言主成分分析在遥感影像分类中的应用(1)特征提取:通过主成分分析,可以获得最具代表性的主成分,即将原始遥感影像数据转换为一组无关变量。

这些主成分可以作为分类模型的输入特征,可以帮助区分不同地物类型。

(2)数据可视化:通过主成分分析,将高维的遥感影像数据降维到二维或三维空间,可以方便地进行数据可视化,帮助我们更好地理解遥感影像中的地物分布和空间关系。

(3)分类性能优化:主成分分析可以减少遥感影像数据的冗余信息,提高分类模型的稳定性和准确性。

通过主成分分析进行特征选择,可以剔除冗余的特征,提高分类模型的性能。

4. R语言主成分分析与其他算法的比较研究为了评估R语言主成分分析在遥感影像分类中的性能,我们将其与其他常用的分类算法进行比较研究,如支持向量机、随机森林等。

比较的指标主要包括分类精度、训练时间、模型复杂度等。

通过对比实验结果,可以评估R语言主成分分析与其他算法在遥感影像分类中的优劣势。

5. 结论与展望本文探讨了R语言主成分分析在遥感影像分类中的应用与比较研究。

结果表明,主成分分析可以有效地提取遥感影像数据的特征,并在遥感影像分类中取得良好的性能。

机器学习实验报告小结引言本次实验旨在通过机器学习算法解决一个二分类问题,并评估各种机器学习模型的性能。

我们首先收集了一个包含大量样本和标签的数据集,然后使用不同的机器学习算法进行训练和测试。

通过实验的结果,我们得出了一些结论并提出了一些建议。

实验方法数据集我们使用了一个包含N个样本的数据集,每个样本包含M个特征和一个二分类标签。

我们将数据集按照7:3的比例划分为训练集和测试集。

特征选择在进行实验之前,我们进行了特征选择,选择了与目标变量相关性最高的M1个特征,以避免维度灾难和降低计算复杂度。

机器学习模型我们使用了以下几种机器学习模型进行实验:1. 逻辑回归2. 决策树3. 支持向量机4. 随机森林5. 神经网络模型训练和评估使用训练集对每个模型进行训练,并在测试集上进行性能评估。

评估指标包括准确率、精确率、召回率和F1-score等。

实验结果模型性能比较在测试集上,不同模型的性能如下:模型准确率精确率召回率F1-score-逻辑回归0.85 0.86 0.84 0.85决策树0.82 0.80 0.85 0.82支持向量机0.84 0.83 0.86 0.85随机森林0.86 0.87 0.85 0.86神经网络0.89 0.88 0.90 0.89从上表可以看出,神经网络模型在准确率、精确率、召回率和F1-score等指标上均取得了最佳性能,其次是随机森林模型。

逻辑回归模型的性能相对较差。

模型优化针对神经网络模型,我们进行了一些优化措施:1. 调整超参数:我们通过调整神经网络的层数、节点数、激活函数和优化算法等参数,以提高模型的性能。

2. 特征工程:我们尝试了不同的特征组合和变换,以提高模型对数据的拟合能力。

3. 数据增强:我们通过对训练集进行数据增强,如随机旋转、翻转和裁剪等操作,以扩大训练样本数量。

经过优化后,神经网络模型在测试集上的性能得到了进一步提升,准确率达到了0.91,且稳定性也有所提高。

光学信息处理技术光学信息处理技术是一种基于光学的信息处理方式,它利用光的干涉、衍射、偏振等特性,实现对信息的获取、转换、加工和存储等操作。

这种技术具有高速度、高精度、高可靠性等优点,因此在现代通信、传感、生物医学等领域得到了广泛应用。

一、光学信息处理技术的基本原理光学信息处理技术主要基于两个基本原理:干涉和衍射。

干涉是指两个或多个光波叠加时,光强分布发生改变的现象。

通过控制干涉的相干性,可以实现信息的叠加、增强或抵消等操作。

衍射是指光波遇到障碍物时产生的空间频率变化现象。

通过控制衍射的图案,可以实现信息的滤波、变换等操作。

二、光学信息处理技术的应用1、光学计算:光学计算利用光的干涉和衍射原理,可以实现高速数学运算和数据处理。

例如,利用光学干涉仪可以实现傅里叶变换等复杂计算。

2、光学传感:光学传感利用光的干涉和偏振原理,可以实现高灵敏度的传感和测量。

例如,利用光学传感技术可以实现生物分子和环境参数的检测。

3、光学通信:光学通信利用光的相干性和偏振原理,可以实现高速、大容量的数据传输。

例如,利用光学通信技术可以实现城域网和长途通信。

4、光学存储:光学存储利用光的干涉和衍射原理,可以实现高密度、高速度的信息存储。

例如,利用光学存储技术可以实现光盘、蓝光等存储介质。

三、光学信息处理技术的未来趋势随着科技的不断发展,光学信息处理技术也在不断创新和进步。

未来,光学信息处理技术将朝着以下几个方向发展:1、高速度、大容量:随着数据量的不断增加,对光学信息处理技术的速度和容量要求也越来越高。

未来的光学信息处理技术将更加注重提高处理速度和扩大存储容量。

2、微型化、集成化:随着微纳加工技术的不断发展,未来的光学信息处理技术将更加注重微型化和集成化。

例如,利用微纳加工技术可以实现光学器件的集成和封装,提高系统的可靠性和稳定性。

3、智能化、自动化:未来的光学信息处理技术将更加注重智能化和自动化。

例如,利用人工智能技术可以实现光学系统的自适应和优化,提高系统的智能化水平。

机器学习在肺癌诊断中的研究和应用

朱勇;晏峻峰

【期刊名称】《计算机与数字工程》

【年(卷),期】2024(52)3

【摘要】肺癌是一种严重危害人类健康的恶行肿瘤,以其高发病率和高死亡率闻名[1]。

如何快速准确地诊断肺癌是肺癌预防和治疗的一大挑战,对人类的生命健康具有重要意义。

论文将机器学习方法中的支持向量机(SVM)、随机森林(RF)与XGBoost模型进行比较分析。

通过模型评估指标中的准确率、召回率、f1值、精确度和ROC曲线对比分析,证明了支持向量机在线性核函数下能较好地预测肺癌,准确率可以达到95.18%。

同时发现随机森林与XGBoost模型的各项性能评估指标在SMOTE算法均衡化后的数据集上均有较高的提升,其准确率可以达到89.16%和90.36%。

在保证准确率的前提下,随机森林和XGBoost较之支持向量机可以更快地得到预测结果,在辅助诊断肺癌中也是很好的模型选择。

【总页数】6页(P751-756)

【作者】朱勇;晏峻峰

【作者单位】湖南中医药大学

【正文语种】中文

【中图分类】TP301.6

【相关文献】

1.基于机器学习的肺癌图像辅助诊断应用研究

2.多项肺癌标志物联合应用在肺癌早期诊断中的应用价值研究

3.机器学习在肺癌液体活检中应用的研究进展

4.肿瘤标志物检测应用于肺癌诊断中的价值与在肺癌中医辨证分型诊断中的应用

5.机器学习在帕金森病诊断中的应用研究

因版权原因,仅展示原文概要,查看原文内容请购买。

机器学习实验报告完整摘要:本实验报告旨在探究机器学习算法在数据集上的表现,并评估不同算法的性能。

我们使用了一个包含许多特征的数据集,通过对数据进行预处理和特征选择,进行了多个分类器的比较实验。

实验结果显示,不同的机器学习算法在不同数据集上的表现存在差异,但在对数据进行适当预处理的情况下,性能可以有所改善。

引言:机器学习是一种通过计算机程序来自动学习并改善性能的算法。

机器学习广泛应用于各个领域,例如医学、金融和图像处理等。

在本实验中,我们比较了常用的机器学习算法,并评估了它们在一个数据集上的分类性能。

方法:1. 数据集我们使用了一个包含1000个样本和20个特征的数据集。

该数据集用于二元分类任务,其中每个样本被标记为正类(1)或负类(0)。

2. 预处理在进行实验之前,我们对数据集进行了预处理。

预处理的步骤包括缺失值填充、异常值处理和数据归一化等。

缺失值填充使用常用的方法,例如均值或中位数填充。

异常值处理采用了离群点检测算法,将异常值替换为合理的值。

最后,我们对数据进行了归一化处理,以确保不同特征的尺度一致。

3. 特征选择为了提高分类性能,我们进行了特征选择。

特征选择的目标是从原始特征中选择出最相关的特征子集。

我们使用了常见的特征选择方法,如相关性分析和特征重要性排序。

通过这些方法,我们选取了最具判别能力的特征子集。

4. 算法比较在本实验中,我们选择了四种常见的机器学习算法进行比较:决策树、逻辑回归、支持向量机(SVM)和随机森林。

我们使用Python编程语言中的机器学习库进行实验,分别训练了这些算法,并使用交叉验证进行评估。

评估指标包括准确率、召回率、F1值和ROC曲线下方的面积(AUC)。

结果与讨论:通过对比不同算法在数据集上的性能,我们得出以下结论:1. 决策树算法在本实验中表现欠佳,可能是由于过拟合的原因。

决策树算法可以生成高度解释性的模型,但在处理复杂数据时容易陷入过拟合的状态。

2. 逻辑回归算法表现较好,在数据集上获得了较高的准确率和F1值。

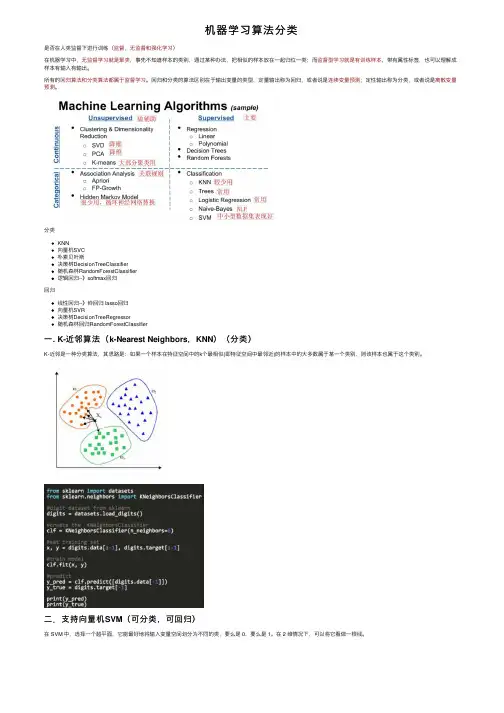

机器学习算法分类是否在⼈类监督下进⾏训练(监督,⽆监督和强化学习)在机器学习中,⽆监督学习就是聚类,事先不知道样本的类别,通过某种办法,把相似的样本放在⼀起归位⼀类;⽽监督型学习就是有训练样本,带有属性标签,也可以理解成样本有输⼊有输出。

所有的回归算法和分类算法都属于监督学习。

回归和分类的算法区别在于输出变量的类型,定量输出称为回归,或者说是连续变量预测;定性输出称为分类,或者说是离散变量预测。

分类KNN向量机SVC朴素贝叶斯决策树DecisionTreeClassifier随机森林RandomForestClassifier逻辑回归--》softmax回归回归线性回归--》岭回归 lasso回归向量机SVR决策树DecisionTreeRegressor随机森林回归RandomForestClassifier⼀. K-近邻算法(k-Nearest Neighbors,KNN)(分类)K-近邻是⼀种分类算法,其思路是:如果⼀个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的⼤多数属于某⼀个类别,则该样本也属于这个类别。

⼆.⽀持向量机SVM(可分类,可回归)在 SVM 中,选择⼀个超平⾯,它能最好地将输⼊变量空间划分为不同的类,要么是 0,要么是 1。

在 2 维情况下,可以将它看做⼀根线。

三.朴素贝叶斯(Naive Bayesian)(分类)计算参考:四. 线性回归算法 Linear Regression(回归)线性回归就是根据已知数据集求⼀线性函数,使其尽可能拟合数据,让损失函数最⼩,常⽤的线性回归最优法有最⼩⼆乘法和梯度下降法。

线性回归⼜分为两种类型,即简单线性回归(simple linear regression),只有 1 个⾃变量;多变量回归(multiple regression),⾄少两组以上⾃变量。

岭回归(也称为 Tikhonov 正则化)是线性回归的正则化版:在损失函数上直接加上⼀个正则项。

如何利用机器学习技术解决多分类问题机器学习是一种强大的技术,可以用于解决各种分类问题,包括多分类问题。

在这篇文章中,我们将探讨如何利用机器学习技术来解决多分类问题。

多分类问题是指将数据分成三个或更多个类别的问题。

例如,我们要根据一封电子邮件的内容来分类它是垃圾邮件、工作相关还是个人邮件。

为了解决这个问题,我们可以使用机器学习算法。

首先,我们需要收集带有标签的数据集。

在多分类问题中,每个数据点都会有一个标签来指示它所属的类别。

为了训练机器学习模型,我们需要足够数量的带有标签的数据点。

这些数据点应该尽可能代表潜在的输入空间,以便模型能够学习各种不同情况下的模式。

一旦我们有了标签数据集,我们可以选择一个适当的机器学习算法来解决多分类问题。

常用的算法包括决策树、随机森林、支持向量机(SVM)和神经网络。

决策树是一种简单而直观的算法。

它通过对特征进行逐步划分来构建一个树状结构,每个节点代表一个特征属性。

在每个节点上,决策树根据该节点的特征属性将数据分成不同的类别。

随机森林是一种基于决策树的集成学习算法,它通过组合多个决策树来提高分类性能。

支持向量机是一种经典的机器学习算法,它通过构建一个超平面来分隔不同的类别。

支持向量机通过最大化边界来寻找最优的超平面,以便对新的数据进行准确分类。

神经网络是一种通过模拟人脑神经元之间的连接来解决问题的算法。

它通常由多个层组成,每个层由若干个神经元组成。

神经网络通过调整神经元之间的连接权重来学习数据的模式。

深度学习是神经网络的一个重要分支,它在图像识别和语音识别等领域取得了巨大的成功。

在选择算法之后,我们需要将数据集分为训练集和测试集。

训练集用于训练模型,测试集用于评估模型的性能。

为了避免过拟合,我们还可以使用交叉验证技术来评估算法的性能。

在训练模型之后,我们可以使用它来对新的数据进行预测。

在多分类问题中,模型将根据已知的模式来预测新的数据点所属的类别。

除了选择适当的算法之外,还有一些方法可以提高多分类问题的性能。

电力系统中的负荷预测方法与准确率评估电力系统是现代社会不可或缺的基础设施之一,负荷预测在电力系统运行与规划中扮演着重要角色。

准确的负荷预测可以帮助电力系统运营商合理安排发电方式、优化电力供应链、提高能源利用效率、稳定电力系统运行。

本文将介绍电力系统中常用的负荷预测方法,并探讨如何评估负荷预测方法的准确率。

一、传统方法1.基于统计模型的负荷预测方法基于统计模型的负荷预测方法是传统的负荷预测方法之一。

该方法利用历史负荷数据,通过统计学方法建立预测模型,并利用该模型预测未来的负荷。

常用的统计模型包括回归模型、时间序列模型等。

这些模型通过分析历史负荷数据中的趋势、周期性等特征来预测未来的负荷。

然而,由于电力系统负荷受多种因素的影响,基于统计模型的负荷预测方法在预测准确性上存在一定的局限性。

2.基于神经网络的负荷预测方法神经网络是一种常用的负荷预测方法,其主要思想是通过模拟人脑神经元的连接和传递机制来建立预测模型。

神经网络通过多层次的神经元相互连接,可以从输入层到输出层实现负荷预测的功能。

该方法具有较强的非线性建模能力,可以识别和捕捉输入数据中的复杂模式和关联关系。

然而,神经网络需要大量的训练数据来优化模型参数,且模型的训练时间较长,对计算资源要求较高。

二、基于机器学习的负荷预测方法1.支持向量机(SVM)方法支持向量机是一种常见的机器学习方法,用于解决分类和回归问题。

在负荷预测中,SVM方法可以根据历史负荷数据的特征,将负荷进行分类并进行预测。

SVM方法通过最大化分类边界来寻找最优的超平面,从而提高负荷预测的准确性。

该方法具有较强的泛化能力,适用于负荷预测中存在多个影响因素的情况。

2.随机森林(Random Forest)方法随机森林是一种集成学习方法,在负荷预测中具有较好的性能。

随机森林通过构建多个决策树,并通过集成这些决策树的结果来进行负荷预测。

每个决策树通过随机选择样本和特征来建立,从而减少过拟合风险。

分类算法总结范文分类算法是机器学习中的一种重要技术,它可以将一组数据按照一定的规则划分成不同的类别。

分类算法有很多种,每种算法都有其特定的适用场景和优缺点。

下面将对几种常见的分类算法进行总结。

1. 朴素贝叶斯算法(Naive Bayes)朴素贝叶斯是一种基于概率和统计的分类算法,它假设特征之间是独立的,并通过计算后验概率来进行分类。

朴素贝叶斯算法简单、易于实现,并且适用于大规模数据集。

然而,朴素贝叶斯算法无法处理特征之间的依赖关系。

2. 决策树算法(Decision Tree)决策树是一种基于树状结构的分类算法,它通过对特征进行逐步划分来实现分类。

决策树算法易于理解和解释,同时可以处理离散和连续型特征。

然而,决策树算法容易过拟合,需要采取相应的剪枝策略。

3. 支持向量机算法(Support Vector Machine,SVM)支持向量机是一种二分类算法,它通过在特征空间中构建最优超平面来进行分类。

支持向量机算法具有良好的泛化性能和鲁棒性,适用于小样本并且具有非线性可分性的数据集。

然而,支持向量机的计算复杂度较高,不适用于大规模数据集。

4. 逻辑回归算法(Logistic Regression)逻辑回归是一种广义线性模型,主要用于解决二分类问题。

逻辑回归算法简单、高效,并且能够输出类别概率。

然而,逻辑回归算法假设特征之间是线性可分的,并且容易受到异常值和噪声的影响。

5. K近邻算法(K-Nearest NeighborsK近邻算法是一种基于距离度量的分类算法,它通过计算样本点与训练集中各个点之间的距离来进行分类。

K近邻算法简单、易于实现,并且适用于多分类问题。

然而,K近邻算法的计算复杂度较高,并且对数据集的规模和维度敏感。

6. 随机森林算法(Random Forest)随机森林是一种集成学习算法,它通过构建多棵决策树并使用投票或平均值来进行分类。

随机森林算法具有较好的泛化性能和鲁棒性,适用于大规模数据集和高维特征。

基于随机森林算法的文本分类研究第一章绪论随着互联网的不断发展,信息爆炸成为了一个普遍存在的现象。

在这么多的信息中,有一部分是需要进行分类的。

文本分类就是解决这个问题的方法之一。

在文本分类中,我们需要对文本进行特征提取,选择分类算法并进行模型训练。

目前,随机森林算法在文本分类中得到了广泛的应用。

因此,本文主要研究基于随机森林算法的文本分类。

第二章随机森林算法的原理随机森林算法是由多个决策树构成的一种集成学习算法。

在随机森林算法中,每个决策树的训练样本是从原始样本中随机选取的,并且每个决策树的特征子集也是从原始特征集中随机选取的。

在训练完成后,随机森林算法会将所有子树的分类结果进行投票,以得出最终的分类结果。

随机森林算法具有以下特点:(1)能够降低过拟合。

由于每个决策树的特征子集和训练样本是随机选取的,因此每个决策树对于训练集的拟合效果是随机的。

而随机森林算法对于多个决策树的分类结果进行投票,可以有效地减少模型的方差,从而避免了过拟合的问题。

(2)能够处理高维数据。

由于随机森林算法只选取一部分特征进行训练,因此能够处理高维数据,避免了维度灾难的问题。

(3)能够评估变量的重要性。

随机森林算法对于每个特征子集进行训练,并且计算每个特征在训练中的重要性,可以帮助我们选择最为重要的特征,从而优化模型。

第三章文本分类方法文本分类是指将文本分成不同的类别。

在文本分类中,我们需要进行特征提取,选择分类算法并进行模型训练。

本节主要介绍文本分类中常用的两种特征提取方法和分类算法。

3.1 特征提取方法在文本分类中,特征提取是非常重要的一步。

常用的两种特征提取方法如下:(1)词袋模型。

词袋模型是指将文本中的每个词作为一个特征,构成一个向量。

在构成向量时,我们需要计算每个词在文本中的出现次数或者出现的频率。

(2)TF-IDF。

TF-IDF是一种统计特征,它将每个词的出现次数和它在整个语料库中的出现频率结合起来,来衡量每个词在文本中的重要性。

软件 2012年33卷 第6期 SOFTWARE 国际IT传媒品牌 - 1 - 随机森林与支持向量机分类性能比较

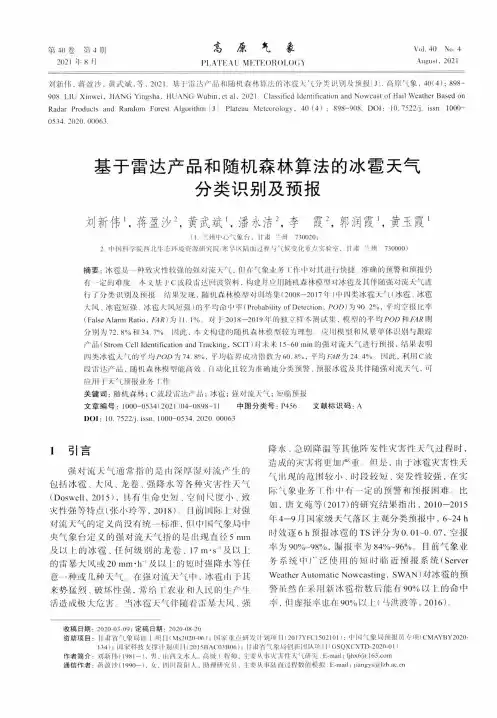

黄 衍,查伟雄 (华东交通大学交通运输与经济研究所,南昌 330013) 摘要:随机森林是一种性能优越的分类器。为了使国内学者更深入地了解其性能,通过将其与已在国内得到广泛应用的支持向量机进行数据实验比较,客观地展示其分类性能。实验选取了20个UCI数据集,从泛化能力、噪声鲁棒性和不平衡分类三个主要方面进行,得到的结论可为研究者选择和使用分类器提供有价值的参考。 关键词:随机森林;支持向量机;分类 中图分类号:O235 文献标识码: A

Comparison on Classification Performance between Random Forests and Support Vector Machine HUANG Yan, ZHA Weixiong (Institute of Transportation and Economics, East China Jiaotong University, Nanchang 330013, China)

【Abstract 】

Random Forests is an excellent classifier. In order to make Chinese scholars fully understand its

performance, this paper compared it with Support Vector Machine widely used in China by means of data experiments to objectively show its classification performance. The experiments, using 20 UCI data sets, were carried out from three main aspects: generalization, noise robustness and imbalanced data classification. Experimental results can provide references for classifiers’ choice and use.

【Key words】Random Forests; Support Vector Machine; classification

0 引言 分类是数据挖掘领域研究的主要问题之一,分类器作为解决问题的工具一直是研究的热点。常用的分类器有决策树、逻辑回归、贝叶斯、神经网络等,这些分类器都有各自的性能特点。本文研究的随机森林[1](Random Forests,RF)是由Breiman提出的一种基于CART决策树的组合分类器。其优越的性能使其在国外的生物、医学、经济、管理等众多领域到了广泛的应用,而国内对其的研究和应用还比较少[2]。为了使国内学者对该方法有一个更深入的了解,本文将其与分类性能优越的支持向量机[3](Support Vector Machine,SVM)进行数据实验比较,客观地展示其分类性能。本文选取了UCI机器学习数据库[4]的20个数据集作为实验数据,通过大量的数据实验,从泛化能力、噪声鲁棒性和不平衡分类三个主要方面进行比较,为研究者选择和使用分类器提供有价值的参考。 1 分类器介绍

1.1 随机森林 随机森林作为一种组合分类器,其算法由以下三步实现: 1. 采用bootstrap抽样技术从原始数据集中抽取ntree个训练集,每个训练集的大小约为原始数据集的三分之二。 2. 为每一个bootstrap训练集分别建立分类回归树(Classification and Regression Tree,CART),共产生ntree棵决策树构成一片“森林”,这些决策树均不进行剪枝(unpruned)。在

作者简介:黄衍(1986-),男,硕士研究生,主要研究方向:数据挖掘与统计分析。 通信联系人:查伟雄,男,博士,教授,主要研究方向:交通运输与经济统计分析。 E-mail: huangyan189@163.com. 软件 2012年33卷 第6期 SOFTWARE 国际IT传媒品牌 - 2 - 每棵树生长过程中,并不是选择全部M个属性中的最优属性作为内部节点进行分支(split),而是从随机选择的mtry≤M个属性中选择最优属性进行分支。 3. 集合ntree棵决策树的预测结果,采用投票(voting)的方式决定新样本的类别。 随机森林在训练过程中的每次bootstrap抽样,将有约三分之一的数据未被抽中,这部分数据被称为袋外(out-of-bag)数据。随机森林利用这部分数据进行内部的误差估计,产生OOB误差(out-of-bag error)。Breiman通过实验证明,OOB误差是无偏估计,近似于交叉验证得到的误差。 随机森林分类器利用基于Breiman随机森林理论的R语言软件包randomForest 4.6-6[5]

来实现。需要设置三个主要的参数:森林中决策树的数量(ntree)、内部节点随机选择属性的个数(mtry)及终节点的最小样本数(nodesize)。 1.2 支持向量机 支持向量机是建立在统计学习理论的VC维理论和结构风险最小原理基础上的,它在解决小样本、非线性及高维模式识别中表现出许多特有的优势,已在众多领域得到了广泛的应用。支持向量机最初是为了求解二分类问题而诞生的,其基本思想可以表述如下。目标是寻找一个最优分类超平面(separating hyperplane),使两类间相邻最近的样本点之间的边缘(margin)最大化。在最大化边缘边界上的样本点被称为支持向量(support vectors),边缘的中间切面为最优分类超平面。被边缘误分的点,其权重将被降低,以减少其影响。当数据线性不可分时,通过核函数将数据点映射到高维空间,使其线性可分。寻找超平面的过程可以转化为求解一个二次规划问题。 支持向量机分类器采用R语言软件包e1071 1.6[6]实现,该软件包是以台湾大学林智仁教授的libsvm[7]源代码为基础开发的。libsvm包含了四种主要的核函数:线性核函数(Linear)、多项式核函数(Polynomial)、径向基核函数(Radial Basis Function,RBF)以及Sigmoid核函数。本文采用径向基核函数,原因有四方面:(1)线性核函数只能处理线性关系,且被证明是径向基核函数的一个特例[8];(2)Sigmoid核函数在某些参数上近似径向基核函数的功能,径向基核函数取一定参数也可得到Sigmoid核函数的性能[9];(3)多项式核函数参数较多,不易于参数优选;(4)本文实验数据均非高维数据,径向基核函数可以适用。径向基核函数支持向量机包含两个重要的参数:惩罚参数Cost和核参数Gamma。此外,libsvm可用于多分类问题,采用的是“一对一”(one-against-one)的策略,即每两类建立一个支持向量机分类器,共建立k(k-1)/2个分类器,k为类别数,最后采用投票的方式决定新样本的类别。 2 分类器性能比较

实验将从三个主要方面比较两个分类器的性能:泛化能力、噪声鲁棒性和不平衡分类。选取UCI机器学习数据库的20个数据集作为实验数据,数据集信息见表1,编号1到10的数据集为二分类,11到20为多分类。为了更好地比较,对两个分类器均进行参数优选。随机森林参数优选过程分两步:(1)在整个训练集上训练,根据OOB误差选择ntree和nodesize,选择标准是使总误差或目标类别误差降到足够低且稳定;(2)采用训练集十折交叉验证(Cross-validation)对参数mtry进行遍历确定最优值,参数选择标准可根据实际问题确定,最低误差或最大AUC(Area under ROC Curve)。支持向量机采用训练集十折交叉验证对参数Cost和Gamma进行网格寻优(Grid-search)确定最优值,参数选择标准同上。两个分类器在每个数据集上均进行10次参数优选。为了判断两个分类器是否有显著差异,引软件 2012年33卷 第6期 SOFTWARE 国际IT传媒品牌 - 3 - 入了非参数置换检验[10, 11](Permutation Test)进行统计比较,显著性水平设置为0.05。全部实验均在R 2.14.1软件平台上完成。 表1 实验数据集信息 Tab.1 Information of experiment data sets 编号 数据集 类别数 属性数 样本数 训练集 测试集

1 Breast Cancer 2 30 569 286 283 2 Vertebral Column 2 6 310 166 144 3 Blood Transfusion 2 4 748 500 248 4 Haberman's Survival 2 3 306 160 146 5 Ionosphere 2 34 351 175 176 6 Parkinsons 2 22 195 102 93 7 MAGIC 2 10 19020 184 18836 8 Pima Indians Diabetes 2 8 768 196 572 9 Connectionist Bench 2 60 208 104 104 10 Heart 2 13 270 121 149 11 Wine 3 13 178 98 80 12 Iris 3 4 150 73 77 13 Cardiotocography 3 21 2126 231 1895 14 Vehicle Silhouettes 4 18 846 206 640 15 Glass 6 9 214 153 61 16 Breast Tissue 6 9 106 56 50 17 Image Segmentation 7 19 2310 254 2056 18 Segmentation 7 18 2310 210 2100 19 Ecoli 8 7 336 212 124 20 Libras Movement 15 90 360 179 181 2.1 泛化能力比较 采用泛化误差作为泛化能力的评价标准。先在训练集上确定最优参数,然后在整个训练集上训练模型,最后利用测试集计算泛化误差,该过程迭代10次。考虑到对数据进行预处理可能影响分类器的性能,分别在预处理前后的数据上进行了实验。预处理的方法主要为异常值归约、0-1归一化等。实验结果见表2和表3,表2为二分类数据实验结果,表3为多分类。表中给出的误差值为10次迭代的平均值,粗体的数值为各分类器的最优值,“前”和“后”表示数据预处理前后,名义胜者是比较两分类器最优值得出的结果。