基于线性插值的图像分块分割算法

- 格式:pdf

- 大小:1023.89 KB

- 文档页数:3

计算双线性变换的简便算法

双线性变换是一种简单而有效的图像缩放技术,它在许多领域中都得到了应用,已被广泛用于图像处理,模拟技术,多媒体等。

它的基本原理就是,在将一幅图像的尺寸缩放时,维持图像中每一个像素点的相对位置不变,以保持图像整体的结构稳定。

双线性变换是采用四点插值方法来进行双线性插值,原图像上的所有像素点都

会被拆分成四个小一点,称为方块点(标杆点),每个标杆点背后的灰度值就是要插值的结果。

在做双线性变换插值时,将被放大的图像上的每一点像素都向它背后的四个标杆点中选取四个像素值,然后用它们的灰度值的加权平均值(居中插值)来得到新像素的颜色值。

由于此算法比较简便,效率也比较高,它比双三次插值计算速度更快,为了满

足多媒体应用的要求,双线性变换算法主要应用在视频处理,它可以精确缩放图像,从而更好地节省计算资源,帮助提高多媒体应用的性能和用户体验。

双线性变换算法是一种高效而可靠的图像处理和数据建模技术,可实现图像的

精准缩放处理,节省空间和计算资源,优化用户体验。

这种技术作为一种图像处理算法,目前已经得到广泛的应用,能有效满足移动互联网的多媒体要求,进一步拓展活跃用户流量,增强用户留存和提升营销成效。

一种基于区域的双三次图像插值算法王会鹏;周利莉;张杰【摘要】采用双三次插值实现图像放大具有较高的图像质量,但运算量很大.在分析常用插值算法的基础上,提出一种基于区域的双三次插值算法.该算法避免进行图像分割,通过被插值点四邻域像素的均值来划分图像的平坦区域和纹理细节复杂区域,采用不同的插值算法进行计算.实验结果表明,与传统的双三次插值算法相比,该算法在保持放大后图像质量的同时,运算量降低10%以上,具有一定的实用价值.【期刊名称】《计算机工程》【年(卷),期】2010(036)019【总页数】3页(P216-218)【关键词】图像放大;双三次插值;基于区域【作者】王会鹏;周利莉;张杰【作者单位】信息工程大学信息工程学院,郑州,450002;信息工程大学信息工程学院,郑州,450002;海军91669,部队,海口,571100【正文语种】中文【中图分类】TP3911 概述随着现代成像设备的不断进步和网络通信技术的飞速发展,数字图像的应用越来越普及。

数字图像处理技术逐渐成为信息处理领域的研究热点,得到了快速的发展。

图像放大是图像处理和应用中的一种常见的操作,也是一些其他更复杂处理的基础,其主要目的是提高放大后图像的分辨率,以满足人们的视觉享受或实际应用要求。

在视频安全监控、遥感成像、高清电视、医学图像等领域,图像放大技术都有重要应用。

插值是实现图像放大的最常用的方法,也是图像超分辨率重建的一个关键步骤[1]。

在实际中广泛采用的有最邻近插值法、双线性插值法、双三次插值法。

其中,双三次插值法的放大效果最好,但运算量远大于前2种算法。

本文主要针对双三次插值的特点进行改进,提出了一种基于区域的双三次插值算法,实现图像放大。

实验结果表明,本文方法在保持放大后图像质量的同时,在一定程度上减少了运算量。

2 常用的图像插值算法最邻近插值、双线性插值和双三次插值是3种比较常见的插值算法[2],在图像处理领域应用广泛,下面对算法原理进行简要分析。

图像编码是将图像数据进行压缩和存储的过程,通过编码算法可以将图像的冗余信息去除,从而减小图像的文件大小。

本文将详细解析图像编码的原理和流程。

一、图像编码的原理图像编码的原理是基于图像的统计特性和人眼视觉系统的特点。

图像的统计特性包括图像的冗余性和图像中不同区域的相关性。

人眼视觉系统对于细节变化敏感,对于一些细微的变化可能无法察觉。

基于这些原理,图像编码可以通过去除冗余信息和利用视觉系统的特点来实现图像数据的压缩。

二、图像编码的流程1. 图像预处理在图像编码前,需要对图像进行一些预处理工作,包括图像的归一化和分块。

图像归一化是将图像的亮度和对比度进行调整,使得图像数据的范围在一定的范围内,从而方便后续的处理。

分块是将图像分割成小块,每个小块可以独立进行编码处理。

2. 图像采样和量化图像编码的第一步是将图像的空间域数据转换到频域数据。

在这一步骤中,图像需要进行采样和量化。

采样是指将连续的图像数据转换为离散的样本,常用的采样方法有最近邻采样和双线性插值采样。

量化是将连续的图像数据映射到有限的离散值集合中,常用的量化方法包括均匀量化和非均匀量化。

3. 数据变换和编码在图像采样和量化之后,可以对图像数据进行变换和编码。

数据变换是将图像数据从空域转换到频域,常用的变换方法有傅里叶变换和离散余弦变换。

变换后的频域数据具有更好的能量集中性,便于后续的压缩编码。

编码是将变换后的频域数据进行压缩编码,常用的编码方法有哈夫曼编码和算术编码。

4. 熵编码和解码经过数据变换和编码后,可以对编码后的数据进行熵编码。

熵编码是一种无损压缩编码方法,通过统计图像数据的概率分布来进行编码。

常用的熵编码方法有游程长度编码和算术编码。

解码是对编码后的数据进行解码和反变换,将解码后的数据转换回空间域。

5. 反量化和反采样解码后的数据进行反量化和反采样,将离散的频域数据转换回连续的图像数据。

反量化是将量化后的数据映射回连续的图像数据,反采样是将采样后的数据进行插值,恢复原始图像的细节。

1、HOG特征:方向梯度直方图(Histogram of Oriented Gradient, HOG)特征是一种在计算机视觉和图像处理中用来进行物体检测的特征描述子。

它通过计算和统计图像局部区域的梯度方向直方图来构成特征。

Hog特征结合SVM分类器已经被广泛应用于图像识别中,尤其在行人检测中获得了极大的成功。

需要提醒的是,HOG+SVM进行行人检测的方法是法国研究人员Dalal 在2005的CVPR上提出的,而如今虽然有很多行人检测算法不断提出,但基本都是以HOG+SVM的思路为主。

(1)主要思想:在一副图像中,局部目标的表象和形状(appearance and shape)能够被梯度或边缘的方向密度分布很好地描述。

(本质:梯度的统计信息,而梯度主要存在于边缘的地方)。

(2)具体的实现方法是:首先将图像分成小的连通区域,我们把它叫细胞单元。

然后采集细胞单元中各像素点的梯度的或边缘的方向直方图。

最后把这些直方图组合起来就可以构成特征描述器。

(3)提高性能:把这些局部直方图在图像的更大的范围内(我们把它叫区间或block)进行对比度归一化(contrast-normalized),所采用的方法是:先计算各直方图在这个区间(block)中的密度,然后根据这个密度对区间中的各个细胞单元做归一化。

通过这个归一化后,能对光照变化和阴影获得更好的效果。

(4)优点:与其他的特征描述方法相比,HOG有很多优点。

首先,由于HOG是在图像的局部方格单元上操作,所以它对图像几何的和光学的形变都能保持很好的不变性,这两种形变只会出现在更大的空间领域上。

其次,在粗的空域抽样、精细的方向抽样以及较强的局部光学归一化等条件下,只要行人大体上能够保持直立的姿势,可以容许行人有一些细微的肢体动作,这些细微的动作可以被忽略而不影响检测效果。

因此HOG特征是特别适合于做图像中的人体检测的。

2、HOG特征提取算法的实现过程:大概过程:HOG特征提取方法就是将一个image(你要检测的目标或者扫描窗口):1)灰度化(将图像看做一个x,y,z(灰度)的三维图像);2)采用Gamma校正法对输入图像进行颜色空间的标准化(归一化);目的是调节图像的对比度,降低图像局部的阴影和光照变化所造成的影响,同时可以抑制噪音的干扰;3)计算图像每个像素的梯度(包括大小和方向);主要是为了捕获轮廓信息,同时进一步弱化光照的干扰。

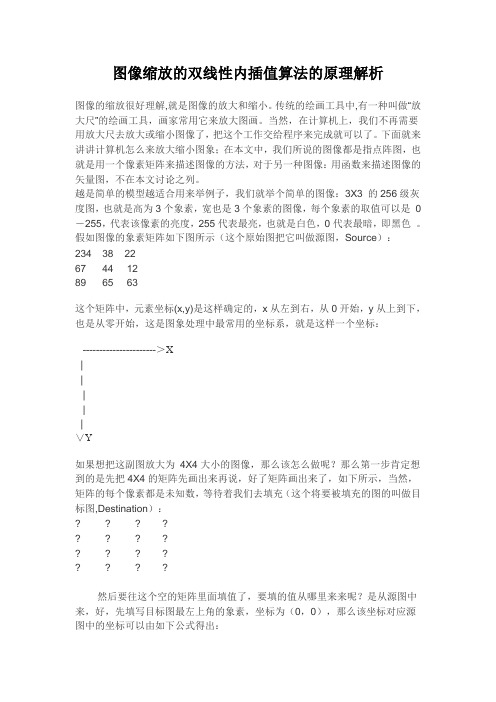

图像缩放的双线性内插值算法的原理解析图像的缩放很好理解,就是图像的放大和缩小。

传统的绘画工具中,有一种叫做“放大尺”的绘画工具,画家常用它来放大图画。

当然,在计算机上,我们不再需要用放大尺去放大或缩小图像了,把这个工作交给程序来完成就可以了。

下面就来讲讲计算机怎么来放大缩小图象;在本文中,我们所说的图像都是指点阵图,也就是用一个像素矩阵来描述图像的方法,对于另一种图像:用函数来描述图像的矢量图,不在本文讨论之列。

越是简单的模型越适合用来举例子,我们就举个简单的图像:3X3 的256级灰度图,也就是高为3个象素,宽也是3个象素的图像,每个象素的取值可以是0-255,代表该像素的亮度,255代表最亮,也就是白色,0代表最暗,即黑色。

假如图像的象素矩阵如下图所示(这个原始图把它叫做源图,Source):234 38 2267 44 1289 65 63这个矩阵中,元素坐标(x,y)是这样确定的,x从左到右,从0开始,y从上到下,也是从零开始,这是图象处理中最常用的坐标系,就是这样一个坐标:---------------------->X|||||∨Y如果想把这副图放大为4X4大小的图像,那么该怎么做呢?那么第一步肯定想到的是先把4X4的矩阵先画出来再说,好了矩阵画出来了,如下所示,当然,矩阵的每个像素都是未知数,等待着我们去填充(这个将要被填充的图的叫做目标图,Destination):? ? ? ?? ? ? ?? ? ? ?? ? ? ?然后要往这个空的矩阵里面填值了,要填的值从哪里来来呢?是从源图中来,好,先填写目标图最左上角的象素,坐标为(0,0),那么该坐标对应源图中的坐标可以由如下公式得出:srcX=dstX* (srcWidth/dstWidth) , srcY = dstY * (srcHeight/dstHeight)好了,套用公式,就可以找到对应的原图的坐标了(0*(3/4),0*(3/4))=>(0*0.75,0*0.75)=>(0,0),找到了源图的对应坐标,就可以把源图中坐标为(0,0)处的234象素值填进去目标图的(0,0)这个位置了。

超分传统算法随着科技的不断发展,图像超分辨率成为了计算机视觉领域的一个重要研究方向。

图像超分辨率是指通过算法将低分辨率图像转换为高分辨率图像,从而提升图像的细节和清晰度。

而超分传统算法则是在图像超分辨率领域中的一种经典算法。

超分传统算法主要分为两类:插值法和重建法。

插值法主要通过对低分辨率图像进行像素间的插值来实现图像的放大。

常见的插值算法有最近邻插值、双线性插值和双三次插值等。

最近邻插值算法简单快速,但会导致图像边缘模糊;双线性插值算法在保持图像边缘清晰的同时也能提升图像的质量;双三次插值算法在保持图像细节的同时也会增加一定的计算成本。

重建法则是通过学习低分辨率图像与高分辨率图像之间的映射关系来实现图像的超分辨率。

其中比较经典的方法有基于边缘的重建法、基于非局部相似性的重建法和基于稀疏表示的重建法等。

基于边缘的重建法主要利用图像的边缘信息来进行超分辨率重建。

它通过对图像的边缘进行增强,然后再进行插值或其他方法进行重建。

这种方法能够有效提升图像的细节和清晰度,但对于纹理和细微结构的提升效果不佳。

基于非局部相似性的重建法则是利用图像中的非局部相似性来进行超分辨率重建。

它通过在图像中搜索与目标图像块相似的块,并将这些相似块进行加权平均来生成高分辨率图像。

这种方法能够有效提升图像的纹理和细节,但计算复杂度较高。

基于稀疏表示的重建法则是利用图像的稀疏性来进行超分辨率重建。

它通过将图像的低分辨率表示为高分辨率表示的稀疏线性组合,然后通过求解稀疏表示问题来得到高分辨率图像。

这种方法能够有效提升图像的细节和清晰度,但对于图像中的纹理和细微结构提升效果有限。

除了上述的传统算法,还有一些基于深度学习的超分辨率算法也取得了很大的成功。

深度学习算法通过构建深度神经网络模型,能够更好地学习到图像的特征和映射关系,从而实现更好的超分辨率效果。

常见的深度学习算法有SRCNN、VDSR和ESPCN等。

总结起来,超分传统算法是图像超分辨率领域的经典算法,主要包括插值法和重建法。

0引言癌症是全球主要死亡原因之一,肺癌死亡率在全球癌症死亡率中位居第一。

2020年中国约有300万人因癌症而去世,其中约有71万人死于肺癌。

通过比较2015—2020年不同癌症类型的新增病例和死亡人数,可以看出肺癌的致死率非常高[1]。

肺癌早期在CT 上表现为肺结节,若是肺癌晚期,患者的5年生存率只有5%,但是若能较早发现肺结节,并能及时治疗,可以很大程度地提高患者生存率,这使得尽早发现肺结节,减少癌症死亡率成为重要研究前沿[2]。

肺结节的大小、形状、轮廓等特征是临床上对肺结节良恶性诊断的重要依据,提高对肺结节分割的准确率,减少由于肺结节位置、形态、大小等差异造成的漏诊率,有助于降低肺癌死亡率。

肺结节的分割方法大体上可以分为传统的肺结节分割方法和深度学习肺结节分割方法。

Kubota 等[3]采用区域生长和距离图的模式进行结节表面描绘,使结节表面与前景相交的凸包构成最终分割。

Liu 等[4]提出了一种基于模糊C 均值(fuzzy C-means ,FCM )聚类和分类学习相结合的快速自适应肺结节分割方法。

Dhara 等[5]通过分析结节核心的强度分布,将肺结节分为实心和非实心类别,提出了2种独立有效的肺结节分割方法。

Nithila 等[6]将基于区域的活动轮廓模型和FCM 相结合,设计出一种具备降低错误率和增加相似性度量优势的肺结节分割方法。

以上提出的传统肺结节分割方法对人工干预的依赖性较强,易出现过分割、欠分割现象,且随着迭代次数的增加,计算复杂度大大增加,难以满足所有类型结节分割的目的,因此不能满足临床需求。

而Ronneberger 等[7]提出的U-Net 网络,可以从非常少的图像中训练至端到端,对肺结节的分割具有良好的效果。

Tong 等[8]通过残差网络对U-Net 网络进行了改进,提高了网络的训练效果。

张倩雯等[9]加入深度残差结构,形成新的网络ResUNet 。

钟思华等[10]采用密集连接的方式对U-Net 网络进行了改进。

三维插值算法用于从给定的离散数据点中估计或计算位于非离散点的值。

以下是两种简单的三维插值算法示例:

1.三线性插值:三线性插值是一种基本的三维插值方法,适用于规则网格结构的离散数据。

假设你有一个立方体网格,每个顶点有一个值。

要估计非顶点位置的值,可以执行以下步骤:

在x、y、z 方向上找到最近的立方体顶点。

对于目标位置,计算它相对于最近的立方体顶点的相对位置。

分别在x、y、z 方向上进行线性插值,然后在z 方向上插值得到最终结果。

这种方法的优点是简单快速,但仅适用于规则网格。

辛普森插值:辛普森插值适用于非规则的离散数据点,它使用三角剖分或其他方法对数据进行分割。

辛普森插值的基本思想是在每个三角形内部使用线性插值。

首先,根据离散数据点生成三角剖分。

对于给定的非离散点,确定它所在的三角形。

在三角形内部使用线性插值,根据目标位置相对于三个顶点的相对位置进行加权平均。

这只是两种简单的三维插值方法,还有其他更复杂的方法,如基于样条曲线或基于Kriging 的插值方法等,可以根据需求选择合适的方法。

在实际应用中,需要考虑数据的特点、精度需求以及计算效率等因素来选择合适的插值算法。