基于深度强化学习的智能车联网应用研究

- 格式:docx

- 大小:37.36 KB

- 文档页数:2

基于GRU和LSTM组合模型的车联网信道分配方法王磊;王永华;何一汕;伍文韬【期刊名称】《电讯技术》【年(卷),期】2024(64)2【摘要】针对车联网中高通信需求和高移动性造成的车对车链路(Vehicle to Vehicle,V2V)间的信道冲突及网络效用低下的问题,提出了一种基于并联门控循环单元(Gated Recurrent Unit,GRU)和长短期记忆网络(Long Short-Term Memory,LSTM)的组合模型的车联网信道分配算法。

算法以降低V2V链路信道碰撞率和空闲率为目标,将信道分配问题建模为分布式深度强化学习问题,使每条V2V 链路作为单个智能体,并通过最大化每回合平均奖励的方式进行集中训练、分布式执行。

在训练过程中借助GRU训练周期短和LSTM拟合精度高的组合优势去拟合深度双重Q学习中Q函数,使V2V链路能快速地学习优化信道分配策略,合理地复用车对基础设施(Vehicle to Infrastructure,V2I)链路的信道资源,实现网络效用最大化。

仿真结果表明,与单纯使用GRU或者LSTM网络模型的分配算法相比,该算法在收敛速度方面加快了5个训练回合,V2V链路间的信道碰撞率和空闲率降低了约27%,平均成功率提升了约10%。

【总页数】8页(P273-280)【作者】王磊;王永华;何一汕;伍文韬【作者单位】广东工业大学自动化学院【正文语种】中文【中图分类】TN929.5【相关文献】1.基于GRU-LSTM组合模型的云计算资源负载预测研究2.基于LSTM模型的APT 攻击信道检测方法3.基扩展模型下基于LSTM神经网络的时变信道预测方法4.基于K-means分层聚类的TCN-GRU和LSTM动态组合光伏短期功率预测5.基于LSTM-GRU-FCN模型的风电功率短期多步预测研究因版权原因,仅展示原文概要,查看原文内容请购买。

智能网联交通之梦——记东南大学—威斯康星大学智能网联交通联合研究院院长冉斌作者:暂无来源:《科学中国人》 2018年第5期2017年12月20日,东南大学与美国威斯康星大学共同组建的智能网联交通联合研究院正式挂牌成立。

国家“千人计划”特聘专家、东南大学教授冉斌出任研究院院长。

“智能网联交通,是智能交通、智能驾驶之后的升级版本,将更注重通过物联网交通应用技术,开发自动公路系统、推广车路一体化技术等,在‘更聪明的人’‘更聪明的车’之后,打造‘更聪明的道路’。

”冉斌说。

这也是联合研究院的立足点。

研究院的建设依托东南大学,联合美国威斯康星大学等国际知名智能网联交通科研机构的科研与人才优势,坚持基础研究与应用研究并重。

冉斌和他的团队将在联合研究院这一平台上广泛开展智能网联交通科学研究、产业转化以及人才培养,努力将研究院建设成为世界一流水平的智能网联交通科研机构,为全球智能交通创造更多技术上的可能。

“我的梦想就是将我多年在美国学习、研究、实践取得的成果传授给更多的中国和其他国家的学生,与世界同行们交流、合作、共同努力,使中国和其他亚太国家的智能网联交通系统达到国际领先水平。

”当联合研究院建设的帷幕拉开,冉斌距离他的梦想又近了一步。

一双慧眼看明白智能交通说起来,随着“人工智能”近年来的持续升温,大众对于21世纪的“智能”并不陌生。

但到底什么是智能交通系统?冉斌认为,智能交通系统就是将多种高新技术有效地综合运用于交通领域,以加强人、车、路三者之间的联系。

交通运输业是中国经济社会发展的基础产业,在优化中国产业布局、促进经济结构调整、降低发展成本、实现低碳发展等方面都具有极其重要的战略作用。

传统的交通工程方法在一定程度上能够缓解交通问题,但是,由于这些方法实施的规则是根据事先建立的日常重复的交通模式而制定的,不能对交通阻塞做出实时的动态反应,也不能根据具体交通情况迅速改变交通处理方案。

“当传统的交通工程方法无法进一步提高路网通行能力时,智能交通系统的好处就体现出来了。

人工智能在交通出行领域的应用及优化方案设计第1章人工智能在交通出行领域的发展概述 (3)1.1 人工智能技术发展背景 (3)1.2 交通出行领域的发展需求 (3)1.3 人工智能在交通出行领域的应用现状 (4)第2章智能交通系统框架设计 (4)2.1 智能交通系统概述 (4)2.2 系统架构设计 (5)2.3 关键技术分析 (5)第3章交通数据采集与处理 (6)3.1 交通数据采集技术 (6)3.1.1 传感器采集技术 (6)3.1.2 通信技术 (6)3.1.3 遥感技术 (6)3.2 数据预处理方法 (6)3.2.1 数据清洗 (6)3.2.2 数据集成 (6)3.2.3 数据变换 (6)3.3 数据存储与管理 (7)3.3.1 数据存储 (7)3.3.2 数据管理 (7)3.3.3 数据安全与隐私保护 (7)第4章车辆识别与追踪技术 (7)4.1 车牌识别技术 (7)4.1.1 车牌识别原理 (7)4.1.2 关键技术 (7)4.1.3 优化方案 (8)4.2 车辆品牌及型号识别 (8)4.2.1 车辆品牌及型号识别原理 (8)4.2.2 关键技术 (8)4.2.3 优化方案 (8)4.3 车辆追踪与监控 (8)4.3.1 车辆追踪与监控原理 (9)4.3.2 关键技术 (9)4.3.3 优化方案 (9)第5章智能交通信号控制 (9)5.1 交通信号控制原理 (9)5.2 人工智能在信号控制中的应用 (9)5.3 优化方案设计 (10)第6章交通预警与处理 (10)6.1.1 智能监控系统 (10)6.1.2 数据分析与处理 (11)6.1.3 交通预警模型 (11)6.2 人工智能在处理中的应用 (11)6.2.1 自动报警与救援 (11)6.2.2 现场勘查 (11)6.2.3 原因分析 (11)6.3 优化方案设计 (11)6.3.1 提高预警准确性 (11)6.3.2 完善处理流程 (11)6.3.3 建立健全法律法规 (11)6.3.4 推广应用与培训 (12)第7章智能导航与路径规划 (12)7.1 智能导航系统 (12)7.1.1 概述 (12)7.1.2 系统架构 (12)7.1.3 功能特点 (12)7.2 路径规划算法 (12)7.2.1 经典路径规划算法 (12)7.2.2 优化算法 (12)7.2.3 融合算法 (12)7.3 实时路况分析与预测 (13)7.3.1 数据来源 (13)7.3.2 数据处理与分析 (13)7.3.3 路况预测 (13)7.3.4 应用案例 (13)第8章公共交通优化与服务 (13)8.1 公共交通调度策略 (13)8.1.1 车辆调度优化 (13)8.1.2 线路调度优化 (13)8.1.3 人员调度优化 (13)8.2 人工智能在公交优化中的应用 (14)8.2.1 客流预测 (14)8.2.2 路径优化 (14)8.2.3 能耗优化 (14)8.3 乘客信息服务 (14)8.3.1 实时公交信息服务 (14)8.3.2 个性化出行推荐 (14)8.3.3 公交服务评价 (14)第9章自动驾驶技术与发展 (14)9.1 自动驾驶技术概述 (15)9.2 人工智能在自动驾驶中的应用 (15)9.2.1 感知技术 (15)9.2.3 控制技术 (15)9.3 自动驾驶汽车的挑战与前景 (15)9.3.1 技术挑战 (15)9.3.2 安全挑战 (16)9.3.3 法律法规与伦理挑战 (16)9.3.4 前景展望 (16)第十章智能交通出行方案综合优化 (16)10.1 优化目标与策略 (16)10.1.1 优化目标 (16)10.1.2 优化策略 (16)10.2 多技术融合与应用 (16)10.2.1 人工智能技术 (16)10.2.2 大数据技术 (17)10.2.3 物联网技术 (17)10.2.4 云计算技术 (17)10.3 案例分析与效果评估 (17)10.3.1 案例一:智能公共交通系统优化 (17)10.3.2 案例二:城市交通信号灯控制系统优化 (17)10.3.3 案例三:共享单车智能调度系统 (17)10.3.4 案例四:无人驾驶出租车系统 (17)第1章人工智能在交通出行领域的发展概述1.1 人工智能技术发展背景计算机技术、大数据、云计算、物联网等新兴技术的迅猛发展,人工智能(Artificial Intelligence, )逐渐成为科技界的热点领域。

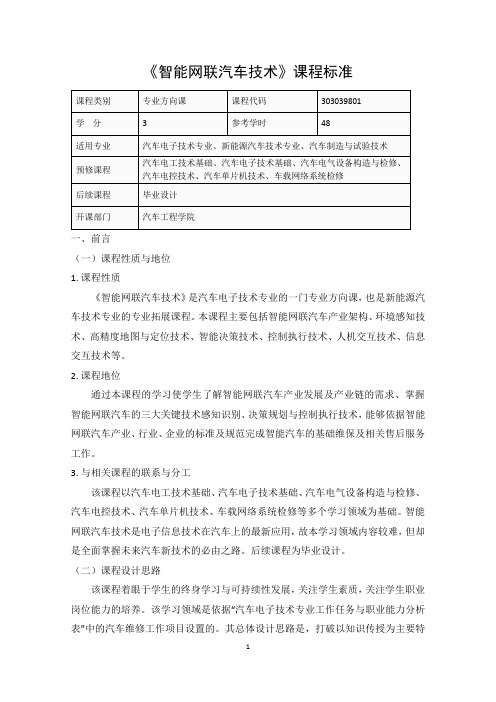

《智能网联汽车技术》课程标准一、前言(一)课程性质与地位1.课程性质《智能网联汽车技术》是汽车电子技术专业的一门专业方向课,也是新能源汽车技术专业的专业拓展课程。

本课程主要包括智能网联汽车产业架构、环境感知技术、高精度地图与定位技术、智能决策技术、控制执行技术、人机交互技术、信息交互技术等。

2.课程地位通过本课程的学习使学生了解智能网联汽车产业发展及产业链的需求、掌握智能网联汽车的三大关键技术感知识别、决策规划与控制执行技术,能够依据智能网联汽车产业、行业、企业的标准及规范完成智能汽车的基础维保及相关售后服务工作。

3.与相关课程的联系与分工该课程以汽车电工技术基础、汽车电子技术基础、汽车电气设备构造与检修、汽车电控技术、汽车单片机技术、车载网络系统检修等多个学习领域为基础。

智能网联汽车技术是电子信息技术在汽车上的最新应用,故本学习领域内容较难,但却是全面掌握未来汽车新技术的必由之路。

后续课程为毕业设计。

(二)课程设计思路该课程着眼于学生的终身学习与可持续性发展,关注学生素质,关注学生职业岗位能力的培养。

该学习领域是依据“汽车电子技术专业工作任务与职业能力分析表”中的汽车维修工作项目设置的。

其总体设计思路是,打破以知识传授为主要特征的传统学科课程模式,转变为以工作任务为中心组织课程内容,并让学生在完成具体项目的过程中学会完成相应工作任务,并构建相关理论知识,发展职业能力。

课程内容突出对学生职业能力的训练,理论知识的选取紧紧围绕工作任务完成的需要来进行,以“必需”、“够用”为度,并融合了相关职业资格证书对知识、技能和态度的要求。

项目设计遵循从简单到复杂,从单一到综合的循序渐进的学习过程。

教学过程中要充分开发学习资源,给学生提供丰富的实践机会。

教学效果评价采取过程评价与结果评价相结合的方式,通过理论与实践相结合,重点评价学生的职业能力。

该课程建议总课时48课时。

各章节课时安排见后续表格。

二、课程目标和任务1.素质目标(1)具备坚定的政治信念,要德智体美劳全面发展;(2)具备良好的职业道德,能够遵纪守法;(3)具备诚实守信、爱岗敬业的品质,具有社会责任心;(4)具备质量意识、安全意识、环保意识、信息素养;(5)具备开拓进取、敢于创业的精神;(6)具备良好的社会适应性,自主学习能力;(7)具备团队协作意识,具备严谨务实的工作作风。

黑芝麻智能科技(上海)有限公司,上海200120摘要:近年来,信息技术的新突破和科学技术的不断转型与升级,深刻的影响着各行各业的发展,汽车行业作为技术密集型行业首当其冲面临着改变。

智能汽车可以通过感知驾驶环境 (人-车-路) 并提供信息和车辆控制, 帮助或替代驾驶员进行最安全、最高效、最舒适的车辆操控。

本文从智能驾驶技术对社会和个人的影响出发,分析了智能汽车技术的关键技术研究和发展现状,并对未来智能汽车技术的发展趋势作出了展望。

关键词:信息技术;智能汽车;关键技术;发展趋势引言近年来, 随着经济的发展和城镇化的推进, 全球汽车保有量和道路里程逐步增加, 诸如交通拥堵、事故、污染、土地资源紧缺等一系列传统汽车无法妥善解决的问题日益凸显。

而被视为有效解决方案的智能汽车技术, 其发展备受瞩目。

美国电气和电子工程师协会 (IEEE) 预测, 至2040年, 自动驾驶车辆所占的比例将达到75%。

汽车交通系统概念将迎来变革, 智能汽车可能颠覆当前的汽车交通运输产业运作模式。

1.智能驾驶技术介绍1.智能驾驶技术定义智能汽车技术是指:通过感知驾驶环境 (人-车-路) 并提供信息或车辆控制, 帮助或替代驾驶员最优 (安全-高效-舒适-便利等) 操控车辆的技术。

它主要包括驾驶辅助和自动驾驶两个方面。

1.2 智能驾驶技术作用智能汽车技术的潜在作用是明显的, 主要包含交通安全、节能环保、道路容量、城市/交通规划、新商业模式等几个方面。

本文从行车安全、环保、道路容量等几个方面, 介绍了不同车辆自动化等级带来的不同程度影响。

下面将主要从自动化等级较高的无人驾驶方面分析一下智能车技术的潜在作用。

1.2.1交通安全在道路基础设施日趋完善、安全度提升空间受限的情况下, 汽车的行驶安全性得到越来越多的重视。

针对自然驾驶的研究表明:78%的行车碰撞事故和65%的临近碰撞事故, 是由于驾驶员分心导致的, 而传统的自主安全系统 (autonomous safety systems) 无法摆脱驾驶员操纵受限制的影响, 在交叉路口安全、行人安全、夜间行车安全等方面存在一定的局限。

汽车行业智能网联汽车技术推广方案第一章智能网联汽车技术概述 (3)1.1 技术背景与定义 (3)1.2 技术发展趋势 (3)第二章智能网联汽车关键技术 (4)2.1 感知技术 (4)2.1.1 车辆周围环境感知 (4)2.1.2 车辆状态感知 (4)2.1.3 驾驶行为感知 (5)2.2 通信技术 (5)2.2.1 车载通信系统 (5)2.2.2 车联网通信系统 (5)2.2.3 卫星通信系统 (5)2.3 控制技术 (5)2.3.1 车辆动力学控制 (5)2.3.2 路径跟踪控制 (5)2.3.3 决策与规划控制 (5)2.4 数据处理与分析技术 (6)2.4.1 数据采集 (6)2.4.2 数据预处理 (6)2.4.3 数据挖掘 (6)2.4.4 数据分析 (6)第三章智能网联汽车系统架构 (6)3.1 系统组成 (6)3.1.1 车载终端 (6)3.1.2 通信系统 (6)3.1.3 数据处理与分析系统 (6)3.1.4 人机交互系统 (7)3.2 功能模块 (7)3.2.1 环境感知模块 (7)3.2.2 驾驶辅助模块 (7)3.2.3 车联网服务模块 (7)3.2.4 自动驾驶模块 (7)3.2.5 能源管理模块 (7)3.3 系统集成 (7)3.3.1 硬件集成 (7)3.3.2 软件集成 (7)3.3.3 通信协议集成 (8)3.3.4 系统测试与优化 (8)第四章智能网联汽车安全与隐私保护 (8)4.1 安全防护措施 (8)4.1.1 车载网络安全 (8)4.1.2 车辆控制系统安全 (8)4.1.3 数据安全 (8)4.2 隐私保护策略 (9)4.2.1 数据最小化原则 (9)4.2.2 数据匿名化处理 (9)4.2.3 用户授权机制 (9)4.2.4 数据安全审计 (9)4.3 安全与隐私保护技术 (9)4.3.1 安全认证技术 (9)4.3.2 加密技术 (9)4.3.3 安全监控技术 (9)4.3.4 隐私保护技术 (9)第五章智能网联汽车标准与法规 (9)5.1 国际标准 (9)5.2 国内法规 (10)5.3 政策支持与推广 (10)第六章智能网联汽车产业链分析 (11)6.1 上游产业 (11)6.1.1 核心技术研发 (11)6.1.2 关键零部件制造 (11)6.1.3 原材料供应 (11)6.2 中游产业 (11)6.2.1 智能网联汽车制造 (12)6.2.2 系统集成 (12)6.2.3 解决方案提供商 (12)6.3 下游产业 (12)6.3.1 销售环节 (12)6.3.2 运营环节 (12)6.3.3 服务环节 (12)第七章智能网联汽车市场与发展前景 (12)7.1 市场规模 (12)7.2 市场竞争格局 (13)7.3 发展前景预测 (13)第八章智能网联汽车推广应用案例 (13)8.1 城市交通 (13)8.1.1 某城市智能网联汽车示范项目 (14)8.1.2 智能停车解决方案 (14)8.2 物流运输 (14)8.2.1 长途货运自动驾驶试点 (14)8.2.2 城市配送无人车应用 (14)8.3 公共交通 (14)8.3.1 智能网联公交车 (14)8.3.2 城市轨道交通信号系统升级 (14)8.3.3 城市共享单车管理 (15)第九章智能网联汽车技术研发与创新 (15)9.1 研发机构与团队建设 (15)9.1.1 研发机构设置 (15)9.1.2 团队建设 (15)9.2 技术创新策略 (15)9.2.1 紧跟国际前沿技术 (15)9.2.2 强化自主研发能力 (16)9.2.3 推动产业链协同创新 (16)9.3 国际合作与交流 (16)9.3.1 加强与国际知名企业和研究机构的合作 (16)9.3.2 参与国际标准制定 (16)9.3.3 扩大国际市场影响力 (17)第十章智能网联汽车产业发展建议 (17)10.1 政策支持与引导 (17)10.2 产业链协同发展 (17)10.3 市场培育与推广 (17)第一章智能网联汽车技术概述1.1 技术背景与定义智能网联汽车技术是近年来汽车行业发展的重点方向,其背景源于全球信息化、网络化进程的不断推进,以及人工智能、大数据、云计算等技术的快速发展。

第44卷第10期2023年10月东北大学学报(自然科学版)JournalofNortheasternUniversity(NaturalScience)Vol.44ꎬNo.10Oct.2023㊀doi:10.12068/j.issn.1005-3026.2023.10.001基于双决斗深度Q网络的自动换道决策模型张雪峰ꎬ王照乙(东北大学理学院ꎬ辽宁沈阳㊀110819)摘㊀㊀㊀要:汽车自动变道需要在保证不发生碰撞的情况下ꎬ以尽可能快的速度行驶ꎬ规则性地控制不仅对意外情况不具有鲁棒性ꎬ而且不能对间隔车道的情况做出反应.针对这些问题ꎬ提出了一种基于双决斗深度Q网络(duelingdoubledeepQ ̄networkꎬD3QN)强化学习模型的自动换道决策模型ꎬ该算法对车联网反馈的环境车信息处理之后ꎬ通过策略得到动作ꎬ执行动作后根据奖励函数对神经网络进行训练ꎬ最后通过训练的网络以及强化学习来实现自动换道策略.利用Python搭建的三车道环境以及车辆仿真软件CarMaker进行仿真实验ꎬ得到了很好的控制效果ꎬ结果验证了本文算法的可行性和有效性.关㊀键㊀词:车道变换ꎻ自动驾驶ꎻ强化学习ꎻ深度学习ꎻ深度强化学习中图分类号:TP391㊀㊀㊀文献标志码:A㊀㊀㊀文章编号:1005-3026(2023)10-1369-08AutomaticLaneChangeDecisionModelBasedonDuelingDoubleDeepQ ̄networkZHANGXue ̄fengꎬWANGZhao ̄yi(SchoolofSciencesꎬNortheasternUniversityꎬShenyang110819ꎬChina.Correspondingauthor:ZHANGXue ̄fengꎬE ̄mail:zhangxuefeng@mail.neu.edu.cn)Abstract:Automaticlanechangeofvehiclesrequiresdrivingatthefastestpossiblespeedwhileensuringnocollisionsituations.Howeverꎬregularcontrolisnotrobustenoughtohandleunexpectedsituationsorrespondtolaneseparation.TosolvetheseproblemsꎬanautomaticlanechangedecisionmodelbasedonduelingdoubledeepQ ̄network(D3QN)reinforcementlearningmodelisproposed.Thealgorithmprocessestheenvironmentalvehicleinformationfedbackbytheinternetofvehiclesꎬandthenobtainsactionsthroughstrategies.Aftertheactionsareexecutedꎬtheneuralnetworkistrainedaccordingtogivenrewardfunctionꎬandfinallytheautomaticlanechangestrategyisrealizedthroughthetrainednetworkandreinforcementlearning.Thethree ̄laneenvironmentbuiltbyPythonandthevehiclesimulationsoftwareCarMakerareusedtocarryoutsimulationexperiments.Theresultsshowthatthealgorithmproposedhasagoodcontroleffectꎬmakingitfeasibleandeffective.Keywords:lanechangeꎻdriverlessvehiclesꎻreinforcementlearningꎻdeeplearningꎻdeepreinforcementleaning㊀㊀自动换道技术在智能驾驶中是重要的环节.近年来ꎬ随着环保观念的深入人心ꎬ新能源的使用逐渐增多.其中ꎬ新能源汽车作为新能源领域的关键技术ꎬ科技感㊁智能驾驶一直以来都是汽车生产商们努力实现的目标.5G的兴起以及应用促进了车联网的发展ꎬ使得实现目标变得更为可能.已有的自动换道决策相关研究主要是基于规则和基于机器学习的模型.基于规则的模型中ꎬ自车(算法控制的智能车)通过环境车(环境中其他车)的位置㊁速度等特征来计算可变车道的优先性㊁必要性以及可行性来做出变道决策.这种模型的代表为Gipps[1]换道模型及许多改进和拓展ꎬ如杨达等[2]在车联网情况下ꎬ以Gipps安全驾驶模型为基础ꎬ充分考虑下层安全条件判断模型对收稿日期:2022-05-22最优车道序列的影响ꎬ获得了安全可行的最优目标车道.基于机器学习的模型则是通过大量的驾驶员换道作业数据ꎬ来进行是否换道㊁换哪条道的监督学习.其中ꎬHou等[3]的随机森林算法和自适应增强算法(Adaboost)和Liu等[4]的支持向量机(SVM)决策模型都取得了较好的换道效果.此类模型相较于规则模型来说ꎬ精度虽然高ꎬ但所需数据量很大ꎬ特征与标签都很多ꎬ难以处理.从2015年开始Deepmind公司使用深度强化学习使得智能体在Atari游戏领域达到了人类水平[5]ꎬ强化学习开始飞速发展以及广泛应用.强化学习已经应用在许多领域ꎬ如王建平等[6]使用强化学习对机器人机械臂的精准控制.赖建辉[7]和舒凌洲等[8]将强化学习应用到交通信号控制领域且取得了很好的效果.孟琭等[9]使用深度Q网络(deepQ ̄networkꎬDQN)算法与目标检测算法结合在射击游戏领域也取得了很好的效果.在汽车自动跟随驾驶领域ꎬYou等[10]在高速公路驾驶场景中采用Q-learning方法进行车辆加速㊁制动㊁超车和转弯等决策.Zhang等[11]使用双深度Q网络(doubledeepQ ̄networkꎬDDQN)来控制车速ꎬ其中控制动作包括加速㊁减速和保持.在自动换道领域ꎬHoel等[12]在汽车的速度控制与换道领域使用了DQNꎬ要注意网络的输入或使用所有环境车的信息ꎬ或使用卷积神经网络提取的特征ꎬ维度很高.Wang等[13]使用深度确定性策略梯度(deepdeterministicpolicygradientꎬDDPG)连续控制车辆ꎬ相对离散控制来说ꎬ难以训练并且鲁棒性较差.本文基于以上研究ꎬ介绍双决斗深度Q网络(duelingdoubledeepQ ̄networkꎬD3QN)相较于其他深度强化学习算法的优势ꎬ讨论了特征复杂度以及奖励函数的设定ꎬ用D3QN对车联网环境观测范围内得到的车流信息和是否换道进行建模.将自车看作智能体ꎬ对智能体获得的车联网信息进行处理ꎬ得到了一个既有效又不冗余的特征ꎻ其次根据实际情况来设定奖励函数ꎬ充分考虑速度与换道的奖励平衡ꎻ最后通过仿真实验来验证算法的有效性以及优势.1㊀准备知识强化学习可以根据不同的标准分为不同的类别ꎬ如根据智能体的学习方法可以分为在线学习(on ̄policy)和离线学习(off ̄policy)ꎬ根据策略的策略梯度的(policygradient ̄based).本文使用的是基于值的离线学习算法Q-learning以及它的变体.1 1㊀Q-learning和DQN强化学习解决的是序列决策问题ꎬ通常由五元组(SꎬAꎬRꎬPꎬγ)表示.智能体在时间t接收一个来自环境的状态st=(x1ꎬx2ꎬ ꎬxn)ɪSꎬ返回一个动作atɪAꎬ其中n为状态的特征数量.环境执行动作at后ꎬ以P(stꎬat)的转移概率返回一个时间t+1的状态st+1和奖励rt+1(rt+1ɪR)ꎬ传送给智能体ꎬ流程如图1所示.图1㊀强化学习流程Fig 1㊀Flowchartofreinforcementlearning基于值的强化学习算法ꎬ会计算出每个状态和动作的Q值ꎬ对于随机策略πꎬ定义为[14]Qπ(stꎬat)=E(r1+γr2+γ2r3+ |S=stꎬA=atꎬπ).(1)其中:E( )为对括号中的变量求期望ꎻγ为折扣因子.如果使用Q-learning来估计最优动作值ꎬ那么Q值就会被式(2)更新为YDQNt=rt+1+γmaxaQ(st+1ꎬaꎻθt).(2)其中:YDQNt为当前时刻的Q值ꎻθt是用来拟合Qπ(sꎬa)函数的参数.DQN实际上就是用多层神经网络来拟合Qπ(sꎬa)ꎬ其中神经网络的参数就是式(2)中的θt.为了便于神经网络的训练ꎬDQN使用了两个小技巧ꎬ即目标网络(targetnetwork)和经验重放(experiencereplay)[5].目标网络的参数为θ-tꎬ它不被训练更新ꎬ而是每过τ步从在线网络复制而来ꎬ每过τ步ꎬθ-t=θt.Q值的更新也转变为YDQNt=rt+1+γmaxaQ(st+1ꎬaꎻθ-t).(3)网络的损失函数如式(4)所示:floss=E(YDQNt-Q(st+1ꎬaꎻθt)2).(4)经验重放会把智能体的观察序列存储在一个记忆容器里ꎬ并且每次从中均匀地取出一部分来更新网络.DQN的流程图如图2所示.1 2㊀DDQN标准的Q-learning和DQN算法中存在着一0731东北大学学报(自然科学版)㊀㊀㊀第44卷的值ꎬ这会使得智能体更倾向于选择被高估的动作ꎬ结果高估了估计值.为了缓解这一现象ꎬDDQN解耦了选择和估计这两个行为[15]ꎬ即YDDQNt=rt+1+γQ(st+1ꎬargmaxaQ(st+1ꎬa:θt)ꎬθ-t).(5)图2㊀DQN流程Fig 2㊀FlowchartofDQN选择动作使用的是在线网络的参数θtꎬ而估计值使用的是目标网络的参数θ-tꎬ这会更准确地估计Q值ꎬ同时获得更优的策略.1 3㊀D3QN算法1 3 1㊀D3QN算法的原理引入状态值函数Vπ和动作优势函数Aπ[16]:Vπ(s)=Ea~π(s)[Qπ(sꎬa)]ꎬ(6)Aπ(sꎬa)=Qπ(sꎬa)-Vπ(s).(7)状态值函数是对该状态所有的动作值求期望ꎬ仅将状态s作为函数的输入ꎬ用来评价某个状态的好坏.优势函数是每个动作值与状态值之差ꎬ为每个动作的相对重要性.容易看出Ea~π(s)[Aπ(sꎬa)]=0.1 3 2㊀D3QN的网络架构D3QN创造性地采用了一个包含函数QꎬVꎬA的网络架构:Qπ(sꎬaꎻθꎬαꎬβ)=Vπ(sꎻθꎬβ)+Aπ(sꎬaꎻθꎬα).(8)其中:θ是3个函数所共有的权重ꎻα为优势函数所特有的参数ꎬ输出维度为动作维度ꎻβ为状态值函数所特有的参数ꎬ输出维度为1.θꎬα和β见图3.为了确保Qπ(sꎬaꎻθꎬαꎬβ)是真实Q值的估计ꎬ需要同时确保状态值函数网络和优势函数网络的输出分别对应状态值和动作优势ꎬ因此对式(8)作以下改变:Q(sꎬaꎻθꎬαꎬβ)=V(sꎻθꎬβ)+(Aπ(sꎬaꎻθꎬα)-1|A|ðaᶄA(sꎬaᶄꎻθꎬα)).(9)其中ꎬ|A|为动作的个数.图3㊀D3QN网络架构Fig 3㊀NetworkarchitectureofD3QN通过D3QN网络架构可以明显看到ꎬ每返回一个Ytꎬ不仅该动作对应的优势函数的参数α会被更新ꎬ整体状态值函数的β都会被更新ꎬ如图4a所示ꎬ而DQN只会更新该动作的Q值ꎬ如图4b所示.图4㊀DQN和D3QN比较Fig 4㊀ComparisonofDQNandD3QN(a) D3QN的一步更新ꎻ(b) DQN的一步更新.2㊀基于D3QN的换道决策模型对强化学习算法所需要的状态空间㊁动作空间和奖励函数等作了详细介绍ꎬ并给出最终的换道决策算法.其中ꎬ状态空间只考虑各个车道自车前面的第一辆环境车的相对车道㊁相对位置和相对速度ꎬ保证环境信息不丢失且足够精炼.奖励函1731第10期㊀㊀㊀张雪峰等:基于双决斗深度Q网络的自动换道决策模型数不仅对严重错误给予惩罚ꎬ也设立了一个奖励函数ꎬ能够保持速度的同时ꎬ尽可能做到避免换道ꎬ保证车辆行驶的舒适性.2 1㊀状态空间本文算法的状态空间并不像其他深度强化学习算法处理端到端自动驾驶那样ꎬ使用自车所获得的图像ꎻ也不像其他车联网自动驾驶那样ꎬ使用所有车辆的相对位置和相对速度[11].因为这两种特征不仅维度很多而且包含着冗余的特征.智能体的状态空间如图5a所示ꎬ考虑三辆车的相对车道㊁相对位置和相对速度ꎬ共9个特征.如果某一车道没有车ꎬ算法会人为地设立一个相对距离很远㊁速度很大的车ꎬ如图5b所示ꎬ图底部的数字指车道.图5㊀状态空间Fig 5㊀Statespace(a) 所有车道均有车ꎻ(b) 部分车道没有车.相对车道其实就是(-2ꎬ-1ꎬ0ꎬ1ꎬ2)中的一个数ꎬ但这对保持汽车不出界是必要的.2 2㊀动作空间动作空间如表1所示ꎬ本文同时考虑了变道以及变速的可能性ꎬ这对于设置奖励函数提供了参考.表1㊀动作空间Table1㊀Actionspace动作环境中执行动作a1~3向左/不/向右变道ꎬ加速度0m/s2a4~6向左/不/向右变道ꎬ加速度0 3m/s2a7~9向左/不/向右变道ꎬ加速度0 7m/s2a10~12向左/不/向右变道ꎬ加速度1m/s2a13~15向左/不/向右变道ꎬ加速度-0 6m/s2a16~18向左/不/向右变道ꎬ加速度-1 4m/s2a19~21向左/不/向右变道ꎬ加速度-2m/s22 3㊀奖励函数执行动作之后ꎬ智能体会从环境中获得一个次控制决策产生影响.毫无疑问ꎬ奖励函数是强化学习中最重要的一环ꎬ如何设置奖励直接影响到算法是否有效㊁速度快慢等.首先设置对于自动驾驶来说严重错误的奖励函数ꎬ如表2所示.表2㊀奖励设置Table2㊀Rewardsetting行为奖励自车出界-120发生碰撞-120驾驶在错误方向-100超速或倒车-100㊀㊀汽车换道时的舒适度主要体现在换道时间㊁纵向加速度㊁横向加速度以及风险ꎬ这4个因素与舒适度成反比[17].由于动作空间是离散的ꎬ本文将换道时间和横向加速度封装成一个换道动作ꎬ因此避免鲁莽驾驶㊁减少换道次数会一定程度上提高舒适度.奖励函数的主要作用是自车尽可能快且安全地行驶.在纵向加速度方面ꎬ权衡了舒适度与通行时间的关系后ꎬ选择提高通行时间的优先级.同样给不安全的行为以很大的惩罚ꎬ提高了风险方面的舒适度.奖励函数如式(10)所示.R(Δv)=25ꎬΔv>15ꎬ不变道ꎻ15ꎬΔv>15ꎬ变道ꎻ53Δvꎬ0<Δv<15ꎬ不变道ꎻΔvꎬ0<Δv<15ꎬ变道ꎻ-53Δvꎬ-15<Δv<0ꎻ-25ꎬΔv<-15.ìîíïïïïïïïïïï(10)其中ꎬΔv是自车速度与巡航速度20m/s之差.可以看出ꎬ同样的速度下ꎬ汽车在不换道时的奖励更多ꎬ这也与实际中期望的避免鲁莽驾驶保持一致ꎬ如图6所示.图6㊀奖励函数Fig 6㊀Rewardfunction2731东北大学学报(自然科学版)㊀㊀㊀第44卷2 4㊀环境车辆本文将环境车辆的驾驶模式设置为智能驾驶员模型(intelligentdivermodelꎬIDM)[18].IDM环境车的加速度是由与前车的速度差和与前车的位置差所决定的.具体形式为dvdt=a=amax1-vvdæèçöø÷δ-s∗(vꎬΔv)saæèçöø÷2æèçöø÷.(11)式中:amax是自由状态下的最大加速度ꎻv为环境车车速ꎻvd为环境车的期望速度ꎻs∗(vꎬΔv)为期望与前车的车头间距ꎻsa为当前实际车头间距.其中ꎬs∗(vꎬΔv)由最小安全距离s0和随速度变化的缓冲距离组成ꎬ具体表达式为s∗(vꎬΔv)=s0+vT+vΔv2bamax.(12)式中:T为时间间隔ꎻb为舒适减速度.sa=xn-1-xn-ln-1.(13)其中ln-1为前车车长.此时环境车速度经过Δt时间后ꎬ为vn(t+Δt)=vn(t)+aΔt.其中vn(t)为时间t时环境车车速.环境车的位置如式(14)所示:xn(t+Δt)=xn(t)vn(t)Δt+12a(Δt)2.(14)2 5㊀探索与策略提升为了让智能体能够广泛地探索到各个动作ꎬ同时保证策略的提升ꎬ在训练之初采取随机策略ꎬ随着神经网络逐渐收敛ꎬ随机度也逐渐衰减ꎬ优先选择Q值更大的动作ꎬ这也是双E(exploration ̄exploitation)问题.本文在动作选择上采用了ε-greedy策略ꎬ智能体以ε的概率随机选择动作ꎬ以(1-ε)的概率选择Q值最大的动作ꎬ随着不断地训练ꎬε逐渐衰减ꎬ直至最小.2 6㊀优先经验回放池在原始的经验回放池中ꎬ每次训练会均匀地抽取一批样本ꎬ这种经验回放池认为所有的样本重要程度都相等.但是在实际训练中ꎬ显然不同的样本对训练的重要程度都是不同的.Schaul等[19]使用TD误差来衡量样本的重要程度ꎬTD误差的绝对值越大ꎬ证明智能体可以从这个样本中学习到更多知识ꎬ也就会赋予样本更大的权重.TD误差δ定义为δ=r(stꎬat)+λQᶄ(st+1ꎬat+1)-Q(stꎬat).(15)其中ꎬQ和Qᶄ分别是评估网络和目标网络.样本j的采样概率为Pj=δλjðδλj.(16)其中:λ是优先级控制系数ꎻδj是样本j的权重系数.2 7㊀算㊀法车联网会获得周边所有汽车的信息ꎬ在此需要先对获得的信息按2 1节处理ꎬ再添加至经验回放池M.其次ꎬ执行动作之后ꎬ会对动作a以及下一个状态sᶄꎬ根据式(8)返回一个奖励.㊀㊀基于D3QN的自动换道决策算法如下:输入:优先经验回放池Mꎬ批度Bꎬ预训练步数pꎬ学习率αꎬ折扣因子γꎬ总训练步数Tꎬ更新频率β.初始化在线网络参数θꎬ目标网络θ-ꎬ环境sꎬ训练步数i=0.Whilei<Tdo根据ε-greedy策略选取动作a执行动作aꎬ得到奖励r和下一个状态sᶄ将(sꎬaꎬrꎬsᶄ)添加到优先经验回放池Ms=sᶄꎬi=i+1If|M|>Bandi>P㊀㊀从经验回放池M中随机抽取B的经验㊀㊀使用经验更新在线网络的参数θ㊀㊀Ifi%β=0㊀㊀㊀㊀更新目标网络θ-=θ㊀㊀EndifEndif算法流程图如图7所示.3㊀仿真实验本文用Python搭建了一个3个车道㊁6个环境车的仿真环境ꎬ如图8和图9所示ꎬ其中代表自车ꎬ代表环境车.神经网络是在这个仿真环境中训练的.㊀㊀自车首先获取所有的环境车信息ꎬ之后对信息采用2 1节所示的方式进行处理ꎬ得到一个9维的特征.在训练以及测试时都使用这9维特征ꎬ即五元组中的S.将这些特征按照2 5节所示的策略得到一个动作Aꎬ之后智能体执行动作Aꎬ得到奖励R和下一时刻状态Sᶄ.算法使用(sꎬaꎬrꎬsᶄ)更新神经网络的参数ꎬ如2 7节算法所示.㊀㊀在图8中ꎬ自车起始于第三车道ꎬ由于距离前车太近ꎬ所以换到中间车道行驶.在距离前车太近时ꎬ自车评估左右车道的前车车速和相对距离ꎬ换到第三车道ꎬ完成行驶.在图9中ꎬ自车起始于第一车道ꎬ距离本车道前车过近ꎬ换到中间车道行驶ꎬ自车评估左右车道3731第10期㊀㊀㊀张雪峰等:基于双决斗深度Q网络的自动换道决策模型图7㊀算法流程图Fig 7㊀Flowchartofalgorithm图8㊀Python仿真示例一Fig 8㊀Pythonsimulationexampleone(a) 速度10m/sꎬ奖励-16ꎻ(b) 速度13m/sꎬ奖励-27ꎻ(c) 速度31m/sꎬ奖励-11ꎻ(d) 速度34m/sꎬ奖励82.图9㊀Python仿真示例二Fig 9㊀Pythonsimulationexampletwo(a) 速度10m/sꎬ奖励-16ꎻ(b) 速度16m/sꎬ奖励-22ꎻ(c) 速度22m/sꎬ奖励-20ꎻ(d) 速度34m/sꎬ奖励106.㊀㊀在图8和图9中都可以明显看到ꎬ自车在快接触到前车时会及时变道ꎬ同时会选择一条能够使自己更快运行的道路.在本车道可以安全驾驶时ꎬ汽车也会保持直行ꎬ不会鲁莽变道.从输出也可以看到ꎬ汽车持续加速直到保持在最快速度.为了验证仿真环境构建的合理性和参数训练的准确性ꎬ本文使用了车联网仿真环境CarMakerꎬ它能够提供环境车的车道㊁距离和速度.将这些特征处理之后ꎬ用Python环境训练得来的参数作出决策.需要注意的是ꎬ在实际仿真中ꎬ用到的计算仅仅是矩阵相乘ꎬ所以不用担心太过复杂的运算导致算力不够而处理不了即时路况.在CarMaker中ꎬ自车会获得所有环境车的相对车道㊁位置和速度.同样地处理为9个特征之后ꎬ只需用特征与神经网络的参数简单地进行矩阵相乘ꎬ得到各个动作的Q值ꎬ在仿真环境中ꎬ智能体只选择Q值最大的动作ꎬ即贪婪系数ε=0.图10和图11为CarMaker仿真环境的两个示例ꎬ其中方格中的车为自车ꎬ其余车为环境车.4731东北大学学报(自然科学版)㊀㊀㊀第44卷本文截取出了汽车换道时的帧ꎬ可以看到ꎬ自车在检测或接近本车道的环境车时ꎬ会主动变道.Python训练出来的参数也可以很好地应用到该环境ꎬ鲁棒性很强.图10㊀CarMaker仿真示例一Fig 10㊀CarMakersimulationexampleone图11㊀CarMaker仿真示例二Fig 11㊀CarMakersimulationexampletwo㊀㊀同时本文给出了算法的超参数ꎬ如表3所示.表3㊀超参数Table3㊀Hyper ̄parameters参数值经验回放池大小10000学习率0 001批度大小32软更新因子0 01折扣因子0 99目标网络更新频率/步100总训练步数65000㊀㊀本文还对DDQNꎬD3QN和SVM换道模型做了对比实验ꎬ如表4所示.其中9info代表特征ꎬ如第2节所介绍的处理之后的9个特征ꎻdefault表示智能体接受所有环境车的信息ꎬ即7个车ꎬ21个特征ꎻSVM的核函数为高斯核ꎬ训练数据为NextGenerationSimulation(NGSIM)中的880个换道样本和1030个车道保持样本.图12可视化了智能体的每训练65次的平均奖励ꎬ可以看出D3QN相较于对比方法而言ꎬ不仅能够获得更高的奖励且更稳定ꎬ还能够在仿真环境中拥有更高的平均完成次数(见表4).由于SVM没有明显的学习过程以及并没有在仿真环境中训练ꎬ在此不做可视化处理.表4㊀四种算法的消融实验Table4㊀Ablationexperimentoffourkindsofalgorithms算法平均奖励最高奖励奖励方差平均完成次数DDQN_9info120 42164 4211524 41846/1000D3QN_9info132 69178 5811198 21897/1000SVM103 77144 9012287 31606/1000D3QN_default73 65120 3414237 16523/1000㊀㊀注:黑体数字为表现最好的结果.5731第10期㊀㊀㊀张雪峰等:基于双决斗深度Q网络的自动换道决策模型图12㊀DDQN与D3QN对比Fig 12㊀ComparisonofDDQNandD3QN4㊀结㊀㊀语本文提出了一种基于D3QN的自动换道算法ꎬ解决了输入特征冗余问题ꎬ并且设置了一个能够平衡换道与变速的奖励函数.在Python以及CarMaker两种环境进行仿真实验ꎬ结果表明ꎬD3QN能够有效地处理自动驾驶的变道和变速问题.同时本文进行了消融实验ꎬ展示了处理后的特征相较于默认特征㊁D3QN相较于DDQN以及强化学习相较于传统机器学习的优势.通过优化奖励以及设置更复杂的路况ꎬ可以使得算法更具有鲁棒性ꎬ同时也可以将其他环境车处理成智能体ꎬ以便于更进一步的博弈ꎬ最终可以解决实际问题.参考文献:[1]㊀GippsPG.Amodelforthestructureoflane ̄changingdecisions[J].TransportationResearchPartB:Methodologicalꎬ1986ꎬ20(5):403-414.[2]㊀杨达ꎬ吕蒙ꎬ戴力源ꎬ等.车联网环境下自动驾驶车辆车道选择决策模型[J].中国公路学报ꎬ2022ꎬ35(4):243-255.(YangDaꎬLyuMengꎬDaiLi ̄yuanꎬetal.Decision ̄makingmodelforlaneselectionofautomatedvehiclesinconnectedvehicleenvironment[J].ChinaJournalofHighwayandTransportꎬ2022ꎬ35(4):243-255.)[3]㊀HouYꎬEdaraPꎬSunC.Situationassessmentanddecisionmakingforlanechangeassistanceusingensemblelearningmethods[J].ExpertSystemswithApplicationꎬ2015ꎬ42(8):3875-3882.[4]㊀LiuYGꎬWangXꎬLiLꎬetal.Anovellanechangedecision ̄makingmodelofautonomousvehiclebasedonsupportvectormachine[J].IEEEAccessꎬ2019ꎬ7:26543-26550.[5]㊀MnihVꎬKavukcuogluKꎬSilverDꎬetal.Human ̄levelcontrolthroughdeepreinforcementlearning[J].Natureꎬ2015ꎬ518(7540):529-533.[6]㊀王建平ꎬ王刚ꎬ毛晓彬ꎬ等.基于深度强化学习的二连杆机械臂运动控制方法[J].计算机应用ꎬ2021ꎬ41(6):1799-1804.(WangJian ̄pingꎬWangGangꎬMaoXiao ̄binꎬetal.Motioncontrolmethodoftwo ̄linkmanipulatorbasedondeepreinforcementlearning[J].JournalofComputerApplicationsꎬ2021ꎬ41(6):1799-1804.)[7]㊀赖建辉.基于D3QN的交通信号控制策略[J].计算机科学ꎬ2019ꎬ46(sup2):117-121.(LaiJian ̄hui.TrafficsignalcontrolbasedondoubledeepQ ̄learningnetworkwithduelingarchitecture[J].ComputerScienceꎬ2019ꎬ46(sup2):117-121.)[8]㊀舒凌洲ꎬ吴佳ꎬ王晨.基于深度强化学习的城市交通信号控制算法[J].计算机应用ꎬ2019ꎬ39(5):1495-1499.(ShuLing ̄zhouꎬWuJiaꎬWangChen.Urbantrafficsignalcontrolbasedondeepreinforcementlearning[J].JournalofComputerApplicationsꎬ2019ꎬ39(5):1495-1499.)[9]㊀孟琭ꎬ沈凝ꎬ祁殷俏ꎬ等.基于强化学习的三维游戏控制算法[J].东北大学学报(自然科学版)ꎬ2021ꎬ42(4):478-483.(MengLuꎬShenNingꎬQiYin ̄qiaoꎬetal.Controlalgorithmofthree ̄dimensionalgamebasedonreinforcementlearning[J].JournalofNortheasternUniversity(NaturalScience)ꎬ2021ꎬ42(4):478-483.)[10]YouCꎬLuJꎬFilevDꎬetal.Highwaytrafficmodelinganddecisionmakingforautonomousvehicleusingreinforcementlearning[C]//2018IEEEIntelligentVehiclesSymposium(IV).Paris:IEEEꎬ2018:1227-1232.[11]ZhangYꎬSunPꎬYinYHꎬetal.Human ̄likeautonomousvehiclespeedcontrolbydeepreinforcementlearningwithdoubleQ ̄learning[C]//2018IEEEIntelligentVehiclesSymposium(IV).Paris:IEEEꎬ2018:1251-1256.[12]HoelCJꎬWolffKꎬLaineL.Automatedspeedandlanechangedecisionmakingusingdeepreinforcementlearning[C]//201821stInternationalConferenceonIntelligentTransportationSystems(ITSC).Maui:IEEEꎬ2018:2148-2155.[13]WangPꎬLiHꎬChanCY.Continuouscontrolforautomatedlanechangebehaviorbasedondeepdeterministicpolicygradientalgorithm[C]//2019IEEEIntelligentVehiclesSymposium(IV).Paris:IEEEꎬ2019:1454-1460.[14]SuttonRꎬBartoA.Reinforcementlearning:anintroduction[M].Cambridge:MITPressꎬ1998.[15]VanHasseltHꎬGuezAꎬSilverD.DeepreinforcementlearningwithdoubleQ ̄learning[C]//ProceedingsoftheAAAIConferenceonArtificialIntelligence.PaloAlto:AAAIꎬ2016:2094-2110.[16]WangZYꎬSchaulTꎬHesselMꎬetal.Duelingnetworkarchitecturesfordeepreinforcementlearning[C]//InternationalConferenceonMachineLearning.NewYork:PMLRꎬ2016:1995-2003.[17]李诗成.考虑乘员个性化舒适性的自动驾驶汽车轨迹规划算法研究[D].广州:华南理工大学ꎬ2021.(LiShi ̄cheng.Researchonautonomousvehicletrajectoryplanningalgorithmconsideringthepersonalizedcomfortofoccupants[D].Guangzhou:SouthChinaUniversityofTechnologyꎬ2021.)[18]TreiberMꎬHenneckeAꎬHelbingD.Congestedtrafficstatesinempiricalobservationsandmicroscopicsimulations[J].PhysicalReviewEꎬ2000ꎬ62:1805-1824.[19]SchaulTꎬQuanJꎬAntonoglouIꎬetal.Prioritizedexperiencereplay[J].arXivPreprintarXivꎬ1511.05952ꎬ2015.6731东北大学学报(自然科学版)㊀㊀㊀第44卷。

智能网联汽车技术专业的课程体系构建与实践摘要:当前智能网联汽车成为我国汽车产业改革发展新的增长点,职业院校汽车类专业纷纷开设智能网联汽车相关课程,希望为智能网联汽车产业培养高素质复合型技术技能人才发挥作用。

基于此,本文阐述了构建智能网联汽车技术专业课程体系的策略,以供参考。

关键词:智能网联汽车;专业课程体系;构建策略引言当前我国高度重视智能网联汽车产业的发展,智能网联汽车已经成为联合众多行业、开展协同创新、构建新型交通和运输的重要载体,在这样的背景下,职业学院应该跟紧行业发展的脚步,及时的调整教育方向,对传统汽车专业进行转型,促进职业学院智能网联汽车技术专业教育的建设与发展。

一、智能网联汽车的关键技术(一)环境感知技术车辆本身状态感知包括行驶速度、行驶方向、行驶状态和车辆位置等,道路感知包括道路类型检测、道路标线识别、道路状况判断、是否偏离行驶轨迹等。

(二)车联网技术长距离无线通信技术用于提供即时的互联网接入,主要用4G、LTE、GPRS等技术。

短距离通信技术有专用短程通信技术(DSRC)、蓝牙、2.4G通信技术等,其中DSRC重要性较高且亟须发展,它可以实现在特定区域内对高速运动下移动目标的识别和双向通信,例如V2V、V2I双向通信,实时传输图像、语音和数据信息等。

(三)智能终端系统操作系统是智能网联汽车智能设备的基础和灵魂。

车载智能终端在操作系统方面的选型,正在发生重大变化,变得越来越重要。

车载终端与手机都是属于智能移动终端,除娱乐、咨询功能之外,其本身信息类功能也越来越收到重视,集成更多的传感器以此来实现更多先进的功能也就成了普遍的现象。

(四)云端计算及服务整合技术通过网络将庞大的计算处理程序自动分拆成无数个较小的子程序,再由多部服务器所组成的庞大系统搜索、计算分析之后将处理结果回传给用户。

通过这项技术,远程的服务供应商可以在数秒之内,完成处理数以千万计甚至数以亿计的信息,达到和“超级电脑”同样强大性能的网络服务。

第1篇一、前言随着科技的飞速发展,无人驾驶技术已成为全球汽车产业的重要发展方向。

回顾过去一年,我国无人驾驶行业取得了显著成果,不仅提升了交通安全水平,也为智能交通体系建设奠定了坚实基础。

在此,我们对无人驾驶行业进行年度总结,以期为未来技术发展提供参考。

二、技术进步与突破1. 感知技术提升:过去一年,我国无人驾驶车辆在感知技术上取得了突破,激光雷达、摄像头、毫米波雷达等传感器融合能力大幅提升,使得车辆在复杂路况下能够更准确地感知周围环境。

2. 决策与控制算法优化:针对无人驾驶车辆在决策与控制方面的难题,研究人员不断优化算法,提高了车辆在复杂场景下的应对能力,降低了事故风险。

3. 人工智能技术应用:人工智能技术在无人驾驶领域的应用不断深入,通过深度学习、强化学习等方法,提高了车辆的适应性和自主学习能力。

三、政策支持与产业布局1. 政策支持:我国政府高度重视无人驾驶产业发展,出台了一系列政策,如《智能汽车创新发展战略》等,为无人驾驶产业发展提供了有力保障。

2. 产业布局:各大企业纷纷布局无人驾驶产业链,从芯片、传感器、控制系统到整车制造,产业链日趋完善。

同时,无人驾驶测试场、示范区等基础设施建设也取得了显著进展。

四、市场应用与示范1. 公共交通领域:无人驾驶公交车、出租车等在多个城市投入运营,为市民提供了便捷、安全的出行服务。

2. 物流领域:无人驾驶卡车、物流车等在特定场景下得到应用,提高了物流效率,降低了运营成本。

3. 个人出行领域:无人驾驶汽车在个人出行领域的应用逐渐普及,为消费者提供了全新的出行体验。

五、挑战与展望1. 技术挑战:尽管无人驾驶技术取得了显著进展,但在复杂路况、极端天气等场景下,仍存在技术瓶颈。

2. 法规标准:无人驾驶相关法规标准尚不完善,制约了无人驾驶产业的快速发展。

3. 安全与伦理:无人驾驶车辆的安全性和伦理问题成为社会关注的焦点。

展望未来,我国无人驾驶产业将继续保持高速发展态势。

基于深度强化学习的智能车联网应用研究

智能车联网是指将车辆与互联网相结合的一种新型应用系统。基于深度

强化学习的智能车联网应用研究旨在通过利用深度强化学习技术,提高车辆

的智能化水平,实现更加安全、高效和可持续的交通系统。

随着科技的不断发展和社会的进步,智能化交通系统已经成为了人们生

活的一部分。智能车联网作为智能交通系统的重要组成部分,将车辆与互联

网相连接,实现了车辆之间的信息交流和协同,为交通管理、安全驾驶、燃

料效率等方面提供了更多的可能性。

深度强化学习是机器学习领域中的一种方法,它通过模仿人类的学习过

程,使计算机能够自主学习和从经验中获得知识。在智能车联网应用研究中,

深度强化学习被用于训练车辆自主决策和优化行为,使其能够根据当前的交

通环境和目标,选择最佳的行驶路线和速度。

智能车联网应用研究的一个重要目标是提高交通安全水平。深度强化学

习可以通过分析海量的交通数据和模拟实验,帮助车辆预测和应对各种交通

情况。例如,当车辆遭遇紧急情况时,深度强化学习可以帮助车辆做出适时

的紧急制动或避让决策,从而避免事故的发生。

此外,智能车联网应用研究还着重于提高交通的效率和环保性。通过利

用深度强化学习,车辆可以根据实时的交通情况和路况信息,合理规划自身

的行驶路径和速度,减少拥堵和排放的产生。同时,智能车联网还可以通过

智能导航系统,为驾驶员提供最短、最快或最经济的行驶路线,提高出行效

率。

除了提高交通安全和效率,智能车联网应用研究还可以对交通管理提供

更多的支持。通过深度强化学习,交通管理部门可以根据车辆的行驶信息和

交通情况,合理规划交通信号灯的控制策略,降低交通拥堵和交通事故的发

生率。此外,深度强化学习还可以通过模拟实验,帮助交通管理部门评估和

优化交通政策和规划。

然而,基于深度强化学习的智能车联网应用也面临着一些挑战和难题。

首先,深度强化学习需要大量的训练数据和计算资源,这对于车联网应用来

说是一大挑战。其次,智能车辆必须能够与其他车辆和交通基础设施进行有

效的通信和信息交换,以实现整体的协同行驶和交通管理。最后,智能车辆

的安全性和隐私保护也是一个重要问题,需要制定相关的保障措施和法律法

规。

综上所述,基于深度强化学习的智能车联网应用研究在提高交通安全、

效率和环保性方面具有巨大的潜力。通过利用深度强化学习技术,智能车辆

可以实现自主决策和优化行驶,为交通系统的智能化提供了更多的可能性。

然而,智能车联网应用的发展还面临着一些挑战,需要进一步的研究和探索。

相信随着科技的进步和社会的发展,智能车联网将为我们的出行带来更加便

捷、安全和节能的未来。