模式识别之二次和线性分类器

- 格式:ppt

- 大小:3.00 MB

- 文档页数:90

![[数学]模式识别方法总结](https://uimg.taocdn.com/9bfe35a6a0116c175f0e484a.webp)

第 1 页第二讲 线性分类器一、 判别函数1、 决策论方法在模式识别中,如果根据模式特征信息,按照决策论的思路,以一定的数量规则来采取不同的分类决策,将待识别的模式划分到不同的类别中去,就称为模式识别的决策论方法。

在决策论方法中,特征空间被划分成不同的区域,每个区域对应一个模式类,称为决策区域(Decision Region )。

当我们判定待识别的模式位于某个决策区域时,就判决它可以划归到对应的类别中。

图1 决策区域需要注意的是:决策区域包含模式类中样本的分布区域,但不等于模式类的真实分布范围。

2、 判别函数如果特征空间中的决策区域边界(Decision Boundary )可以用一组方程0)( x i G来表示,则将一个模式对应的特征向量x 代入边界方程中的)(x i G ,确定其正负符号,就可以确定该模式位于决策区域边界的哪一边,从而可以判别其应当属于的类别,)(x i G 称为判别函数(Discriminant Function )。

判别函数的形式可以是线性的(Linear )或非线性(Non-linear)的。

第 2 页例如图2就显示了一个非线性判别函数,当G (x )>0时,可判别模式x ∈ω1;当G (x )<0时,可判别x ∈ω2。

图2 非线性判别函数非线性判别函数的处理比较复杂,如果决策区域边界可以用线性方程来表达,则决策区域可以用超平面(Hyperplane )来划分,无论在分类器的学习还是分类决策时都比较方便。

例如图3中的特征空间可以用两个线性判别函数来进行分类决策:当G 21(x )>0且G 13(x )>0时,x ∈ω2; 当G 13(x )<0且G 21(x )<0时,x ∈ω3; 当G 21(x )<0 且 G 13(x )>0时,x ∈ω1;当G 21(x )>0且G 13(x )<0时,x 所属类别无法判别。

模式识别:线性分类器一、实验目的和要求目的:了解线性分类器,对分类器的参数做一定的了解,理解参数设置对算法的影响。

要求:1. 产生两类样本2. 采用线性分类器生成出两类样本的分类面3. 对比线性分类器的性能,对比参数设置的结果二、实验环境、内容和方法环境:windows 7,matlab R2010a内容:通过实验,对生成的实验数据样本进行分类。

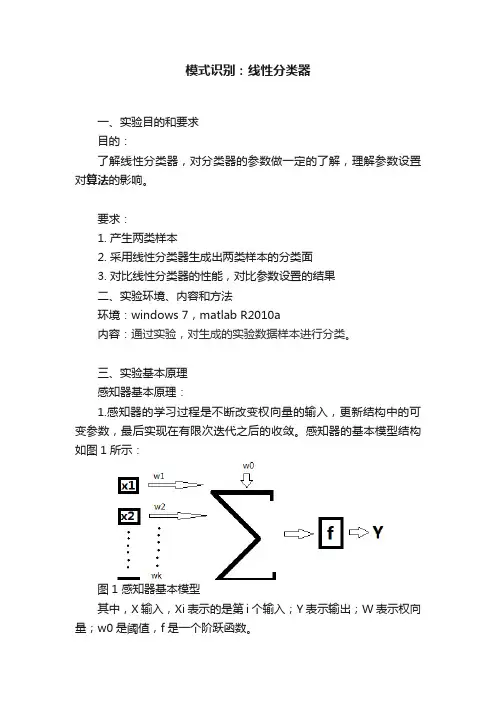

三、实验基本原理感知器基本原理:1.感知器的学习过程是不断改变权向量的输入,更新结构中的可变参数,最后实现在有限次迭代之后的收敛。

感知器的基本模型结构如图1所示:图1 感知器基本模型其中,X输入,Xi表示的是第i个输入;Y表示输出;W表示权向量;w0是阈值,f是一个阶跃函数。

感知器实现样本的线性分类主要过程是:特征向量的元素x1,x2,……,xk是网络的输入元素,每一个元素与相应的权wi相乘。

,乘积相加后再与阈值w0相加,结果通过f函数执行激活功能,f为系统的激活函数。

因为f是一个阶跃函数,故当自变量小于0时,f= -1;当自变量大于0时,f= 1。

这样,根据输出信号Y,把相应的特征向量分到为两类。

然而,权向量w并不是一个已知的参数,故感知器算法很重要的一个步骤即是寻找一个合理的决策超平面。

故设这个超平面为w,满足:(1)引入一个代价函数,定义为:(2)其中,Y是权向量w定义的超平面错误分类的训练向量的子集。

变量定义为:当时,= -1;当时,= +1。

显然,J(w)≥0。

当代价函数J(w)达到最小值0时,所有的训练向量分类都全部正确。

为了计算代价函数的最小迭代值,可以采用梯度下降法设计迭代算法,即:(3)其中,w(n)是第n次迭代的权向量,有多种取值方法,在本设计中采用固定非负值。

由J(w)的定义,可以进一步简化(3)得到:(4)通过(4)来不断更新w,这种算法就称为感知器算法(perceptron algorithm)。

可以证明,这种算法在经过有限次迭代之后是收敛的,也就是说,根据(4)规则修正权向量w,可以让所有的特征向量都正确分类。

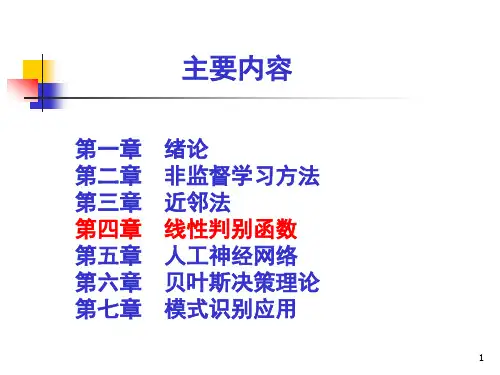

模式识别张学工

基本目的:

(1)使学生熟练掌握模式识别的基本理论和各种方法;

(2)培养学生具有运用模式识别概念和方法解决实际问题的能力。

内容提要:

1、引论(4学时)

模式识别和模式的概念,模式识别系统,模式的基本问题,历史和研究现状。

2、贝叶斯决策与概率密度估计(8学时)

最小错误率贝叶斯决策,最小风险贝叶斯决策,贝叶斯分类器错误率,聂曼-皮尔逊决策,均值向量和协方差矩阵的估计,概率密度的函数逼近和参数估计,正态分布模式的贝叶斯分类器。

3、线性分类器(8学时)

线性判别函数的基本概念,Fisher线性判别,感知器准则函数,最小均方误差准则函数,随机最小错误率线性判别准则函数,支持向量机,多类问题。

4、非线性分类器(8学时)

分段线性判别函数,近邻法,前馈多层神经网络,模拟退火方法,遗传算法。

5、特征选择与提取(8学时)

类别可分性准则,特征选择,基于距离分分性准则的特征提

取,基于K-L变换的特征提取,基于神经网络的特征提取。

6、非监督学习与聚类(8学时)

混合密度和可辨识性,混合正态密度的参数学习方法,k-均值聚类,数据描述与聚类,聚类的准则函数,在线聚类,主成分分析。

教学方式:每周3学时,课堂讲授(90%)、文献阅读和讨论(10%)。

线性分类器算法原理及应用随着人工智能技术的发展,机器学习已成为各行各业的热门话题,许多人也开始关注和了解各种机器学习算法。

其中,线性分类器算法是一种应用较为广泛的算法,本文将为大家介绍它的原理及应用。

一、线性分类器算法的基础知识1.1 算法简介线性分类器算法是一种常见的机器学习算法,主要用于二分类问题(即将数据分为两类)。

它的基本原理是利用线性函数将数据进行分类,其中具体的分类依据是判断某个数据点是否在计算后大于或小于一个阈值。

1.2 基本公式在线性分类器算法中,一个线性函数的基本公式如下所示:Y = b + w1X1 + w2X2 + … + wnXn其中,Y表示样本的类别,b表示偏置项,w1~wn表示权值,X1~Xn表示输入数据的特征值。

当Y大于某个阈值时该样本被归为一类,小于则归为另一类。

1.3 适用场景线性分类器算法适用于多种分类问题,如判断一封邮件是否为垃圾邮件、一个人是否会违约等。

它的应用非常广泛,并且准确率较高。

二、线性分类器算法的实现步骤2.1 数据处理在使用线性分类器算法前,我们需要对数据进行预处理。

首先,需要清洗数据,去除异常值和缺失值等。

然后,对数据进行标准化处理,将数据归一化,避免数据范围的差异性对结果的影响。

2.2 模型训练训练模型是线性分类器算法的核心步骤。

在训练模型前,我们需要将数据集分为训练集和测试集,以验证模型的准确率。

训练模型的过程就是不断调整权值和偏置项,根据损失函数来确定误差,并利用优化算法进行调整。

常见的优化算法包括随机梯度下降法和牛顿法等。

2.3 模型评估模型评估是判断模型是否准确的重要步骤。

在评估模型时,我们需要将测试集输入模型中,通过预测值与实际值的比较来确定模型的准确率。

模型的评估应基于多个指标,如精度、召回率、F1值等。

通过综合考虑这些指标来评估模型的准确性。

三、线性分类器算法应用案例3.1 垃圾邮件分类垃圾邮件是我们在日常生活和工作中难以避免的问题。

监督学习与非监督学习的区别:监督学习方法用来对数据实现分类,分类规则通过训练获得。

该训练集由带分类号的数据集组成,因此监督学习方法的训练过程是离线的。

非监督学习方法不需要单独的离线训练过程,也没有带分类号(标号)的训练数据集,一般用来对数据集进行分析,如聚类,确定其分布的主分量等。

(实例:道路图)就道路图像的分割而言,监督学习方法则先在训练用图像中获取道路象素与非道路象素集,进行分类器设计,然后用所设计的分类器对道路图像进行分割。

使用非监督学习方法,则依据道路路面象素与非道路象素之间的聚类分析进行聚类运算,以实现道路图像的分割。

1、写出K-均值聚类算法的基本步骤,算法:第一步:选K个初始聚类中心,z1(1),z2(1),…,zK(1),其中括号内的序号为寻找聚类中心的迭代运算的次序号。

聚类中心的向量值可任意设定,例如可选开始的K个模式样本的向量值作为初始聚类中心。

第二步:逐个将需分类的模式样本{x}按最小距离准则分配给K个聚类中心中的某一个zj(1)。

假设i=j时,,则,其中k为迭代运算的次序号,第一次迭代k=1,Sj表示第j个聚类,其聚类中心为zj。

第三步:计算各个聚类中心的新的向量值,zj(k+1),j=1,2,…,K求各聚类域中所包含样本的均值向量:其中Nj为第j个聚类域Sj中所包含的样本个数。

以均值向量作为新的聚类中心,可使如下聚类准则函数最小:在这一步中要分别计算K个聚类中的样本均值向量,所以称之为K-均值算法。

第四步:若,j=1,2,…,K,则返回第二步,将模式样本逐个重新分类,重复迭代运算;若,j=1,2,…,K,则算法收敛,计算结束。

线性分类器三种最优准则:Fisher准则:根据两类样本一般类内密集, 类间分离的特点,寻找线性分类器最佳的法线向量方向,使两类样本在该方向上的投影满足类内尽可能密集,类间尽可能分开。

该种度量通过类内离散矩阵Sw和类间离散矩阵Sb实现。

感知准则函数:准则函数以使错分类样本到分界面距离之和最小为原则。