机器学习-5-Bayes分类器

- 格式:pptx

- 大小:1.66 MB

- 文档页数:39

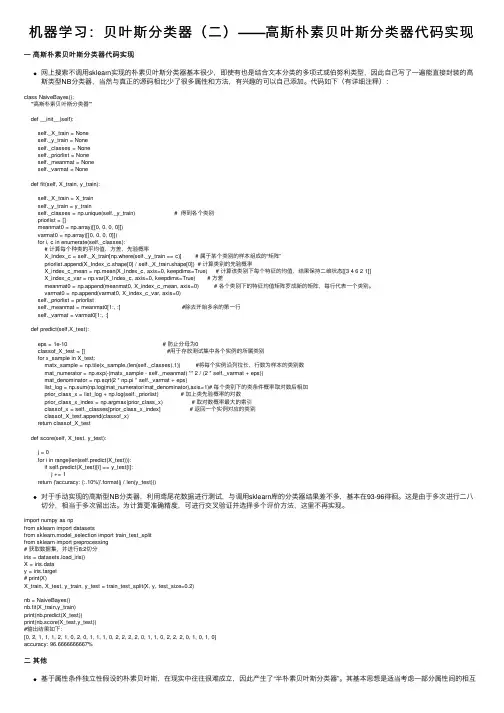

机器学习:贝叶斯分类器(⼆)——⾼斯朴素贝叶斯分类器代码实现⼀⾼斯朴素贝叶斯分类器代码实现⽹上搜索不调⽤sklearn实现的朴素贝叶斯分类器基本很少,即使有也是结合⽂本分类的多项式或伯努利类型,因此⾃⼰写了⼀遍能直接封装的⾼斯类型NB分类器,当然与真正的源码相⽐少了很多属性和⽅法,有兴趣的可以⾃⼰添加。

代码如下(有详细注释):class NaiveBayes():'''⾼斯朴素贝叶斯分类器'''def __init__(self):self._X_train = Noneself._y_train = Noneself._classes = Noneself._priorlist = Noneself._meanmat = Noneself._varmat = Nonedef fit(self, X_train, y_train):self._X_train = X_trainself._y_train = y_trainself._classes = np.unique(self._y_train) # 得到各个类别priorlist = []meanmat0 = np.array([[0, 0, 0, 0]])varmat0 = np.array([[0, 0, 0, 0]])for i, c in enumerate(self._classes):# 计算每个种类的平均值,⽅差,先验概率X_Index_c = self._X_train[np.where(self._y_train == c)] # 属于某个类别的样本组成的“矩阵”priorlist.append(X_Index_c.shape[0] / self._X_train.shape[0]) # 计算类别的先验概率X_index_c_mean = np.mean(X_Index_c, axis=0, keepdims=True) # 计算该类别下每个特征的均值,结果保持⼆维状态[[3 4 6 2 1]]X_index_c_var = np.var(X_Index_c, axis=0, keepdims=True) # ⽅差meanmat0 = np.append(meanmat0, X_index_c_mean, axis=0) # 各个类别下的特征均值矩阵罗成新的矩阵,每⾏代表⼀个类别。

bayes 分类器设置实验总结Bayes 分类器设置实验总结在机器学习领域中,分类算法是一个常见的任务之一。

Bayes 分类器是一种基于概率统计的分类算法,它基于贝叶斯定理对样本进行分类。

在本次实验中,我们将对Bayes 分类器的设置进行实验,并总结实验结果。

一、实验目的Bayes 分类器是一种简单但有效的分类算法,通过实验设置我们的目的是验证Bayes 分类器在不同参数下的分类效果,并探索如何对其进行优化。

我们希望通过实验的设计和分析,能够决定最佳的参数设置,并对Bayes 分类器的性能有更深入的了解。

二、数据集选择在进行实验之前,我们需要选择一个合适的数据集作为实验对象。

数据集应具备以下特点:1. 包含有标签的样本数据:由于Bayes 分类器是一种监督学习算法,我们需要有样本的标签信息来进行分类。

2. 具备多类别分类的情况:我们希望能够测试Bayes 分类器在多类别分类问题上的表现,以便更全面地评估其性能。

三、实验设置1. 数据预处理:根据所选数据集的特点,我们需要对数据进行适当的预处理。

可能的预处理步骤包括特征选择、特征缩放、处理缺失值等。

2. 分类器参数设置:Bayes 分类器的性能会受到不同参数的影响,我们希望通过实验找到最佳的参数设置。

例如,在朴素贝叶斯分类器中,我们可以选择不同的先验概率分布,或者使用不同的平滑技术来处理零概率问题。

3. 评价指标选择:为了评估分类器的性能,我们需要选择合适的评价指标。

常见的评价指标包括准确率、召回率、精确率和F1 分数等。

四、实验结果在实验完成后,我们将根据所选的评价指标对实验结果进行分析和总结。

我们可以比较不同参数设置下的分类器性能,并选择最佳的参数设置。

此外,我们还可以考虑其他因素对分类器性能的影响,如数据预处理方法和样本量等。

五、实验总结在本次实验中,我们通过对Bayes 分类器的设置进行实验,得到了一些有价值的结果和经验。

根据实验结果,我们可以总结以下几点:1. 参数设置的重要性:Bayes 分类器的性能受到参数设置的影响。

基于机器学习的文本分类方法及实用性评估在当今信息爆炸的时代,大量的文本数据使得人们面临一个重要的挑战:如何高效地对海量文本进行分类和分析。

机器学习作为一种能够自动从数据中学习并提取知识的方法,被广泛应用于文本分类任务中。

本文将介绍基于机器学习的文本分类方法以及其在实际应用中的评估。

一、基于机器学习的文本分类方法1. 文本特征表示方法在进行文本分类之前,首先需要将文本数据转化为机器学习算法可以处理的特征向量。

常用的文本特征表示方法有以下几种:(1) 词袋模型 (Bag-of-Words Model): 该模型将文本看作是一组无序的词汇集合,忽略了词语之间的顺序和语法结构,只关注每个词出现的频率。

通过统计每个词在文本中出现的次数或者使用TF-IDF进行权重计算,可以将文本转化为高维稀疏的向量表示。

(2) Word2Vec: Word2Vec是一种基于神经网络的词向量表示方法,通过预训练的神经网络模型将每个词映射到一个固定长度的稠密向量。

Word2Vec考虑了词语的语义信息,可以更好地捕捉词语之间的关系。

(3) 文本主题模型 (Topic Models): 主题模型是一种能够自动发现文本中的主题信息的方法。

通过对文本进行主题建模,可以将文本表示为一个主题分布的向量。

2. 文本分类算法基于机器学习的文本分类算法可以分为有监督和无监督学习算法。

有监督学习算法通过已标注的训练数据学习分类模型,而无监督学习算法则从未标注的数据中自动学习分类规则。

(1) 朴素贝叶斯分类器 (Naive Bayes Classifier): 朴素贝叶斯分类器是一种基于概率的分类方法,假设特征之间相互独立。

该算法通过计算给定特征条件下的类别概率,来预测文本的类别。

(2) 支持向量机 (Support Vector Machine, SVM): SVM是一种二分类模型,通过在特征空间中建立一个最优超平面来进行分类。

其核函数的选取可以应用于非线性文本分类任务。

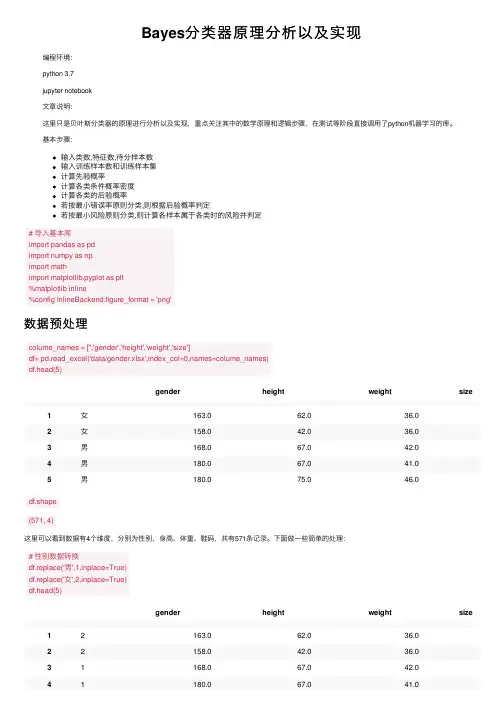

Bayes分类器原理分析以及实现编程环境:python 3.7jupyter notebook⽂章说明:这⾥只是贝叶斯分类器的原理进⾏分析以及实现,重点关注其中的数学原理和逻辑步骤,在测试等阶段直接调⽤了python机器学习的库。

基本步骤:输⼊类数,特征数,待分样本数输⼊训练样本数和训练样本集计算先验概率计算各类条件概率密度计算各类的后验概率若按最⼩错误率原则分类,则根据后验概率判定若按最⼩风险原则分类,则计算各样本属于各类时的风险并判定# 导⼊基本库import pandas as pdimport numpy as npimport mathimport matplotlib.pyplot as plt%matplotlib inline%config InlineBackend.figure_format = 'png'数据预处理colume_names = ['','gender','height','weight','size']df= pd.read_excel('data/gender.xlsx',index_col=0,names=colume_names)df.head(5)gender height weight size1⼥163.062.036.02⼥158.042.036.03男168.067.042.04男180.067.041.05男180.075.046.0df.shape(571, 4)这⾥可以看到数据有4个维度,分别为性别、⾝⾼、体重、鞋码,共有571条记录。

下⾯做⼀些简单的处理:# 性别数据转换df.replace('男',1,inplace=True)df.replace('⼥',2,inplace=True)df.head(5)gender height weight size12163.062.036.022158.042.036.031168.067.042.041180.067.041.0gender height weight size 51180.075.046.0# 男⽣⼥⽣数据分开male_df = df.loc[df['gender']==1]female_df = df.loc[df['gender']==2]female_df.head(5)gender height weight size 12163.062.036.022158.042.036.092160.045.036.0102163.048.037.0112161.045.036.01、单个特征——⾝⾼为了更加深⼊得理解贝叶斯分类器原理,我们从简单的⼀维特征开始。

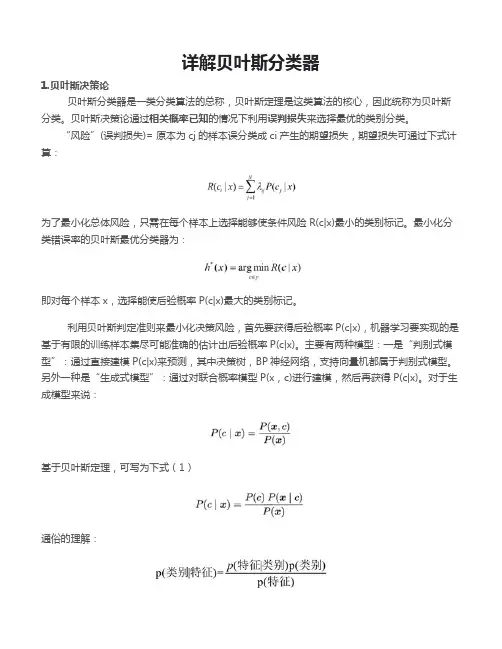

详解贝叶斯分类器1.贝叶斯决策论贝叶斯分类器是一类分类算法的总称,贝叶斯定理是这类算法的核心,因此统称为贝叶斯分类。

贝叶斯决策论通过相关概率已知的情况下利用误判损失来选择最优的类别分类。

“风险”(误判损失)= 原本为cj的样本误分类成ci产生的期望损失,期望损失可通过下式计算:为了最小化总体风险,只需在每个样本上选择能够使条件风险R(c|x)最小的类别标记。

最小化分类错误率的贝叶斯最优分类器为:即对每个样本x,选择能使后验概率P(c|x)最大的类别标记。

利用贝叶斯判定准则来最小化决策风险,首先要获得后验概率P(c|x),机器学习要实现的是基于有限的训练样本集尽可能准确的估计出后验概率P(c|x)。

主要有两种模型:一是“判别式模型”:通过直接建模P(c|x)来预测,其中决策树,BP神经网络,支持向量机都属于判别式模型。

另外一种是“生成式模型”:通过对联合概率模型P(x,c)进行建模,然后再获得P(c|x)。

对于生成模型来说:基于贝叶斯定理,可写为下式(1)通俗的理解:P(c)是类“先验”概率,P(x|c)是样本x相对于类标记c的类条件概率,或称似然。

p(x)是用于归一化的“证据”因子,对于给定样本x,证据因子p(x)与类标记无关。

于是,估计p(c|x)的问题变为基于训练数据来估计p(c)和p(x|c),对于条件概率p(x|c)来说,它涉及x所有属性的联合概率。

2.极大似然估计假设p(x|c))具有确定的形式并且被参数向量唯一确定,则我们的任务是利用训练集估计参数θc,将P(x|c)记为P(x|θc)。

令Dc表示训练集D第c类样本的集合,假设样本独立同分布,则参数θc对于数据集Dc的似然是对进行极大似然估计,就是去寻找能最大化P(Dc|θc)的参数值。

直观上看,极大似然估计是试图在θc所有可能的取值中,找到一个能使数据出现的“可能性”最大的值。

上式的连乘操作易造成下溢,通常使用对数似然:此时参数θc的极大似然估计为在连续属性情形下,假设概率密度函数,则参数和的极大似然估计为:也就是说,通过极大似然法得到的正态分布均值就是样本均值,方差就是的均值,在离散情况下,也可通过类似的方式估计类条件概率。

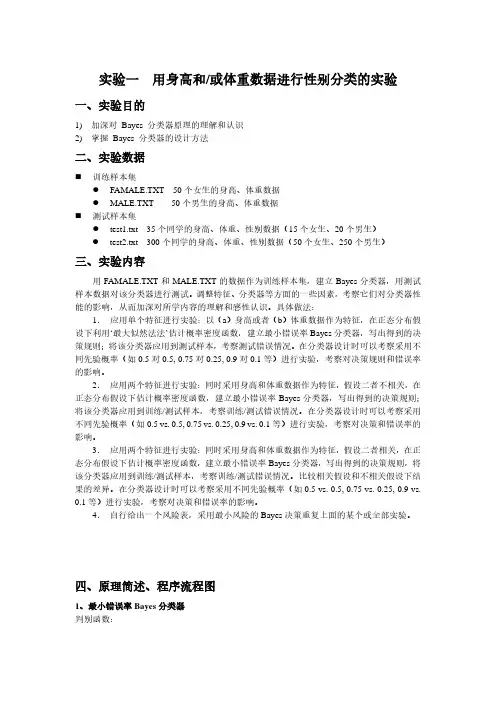

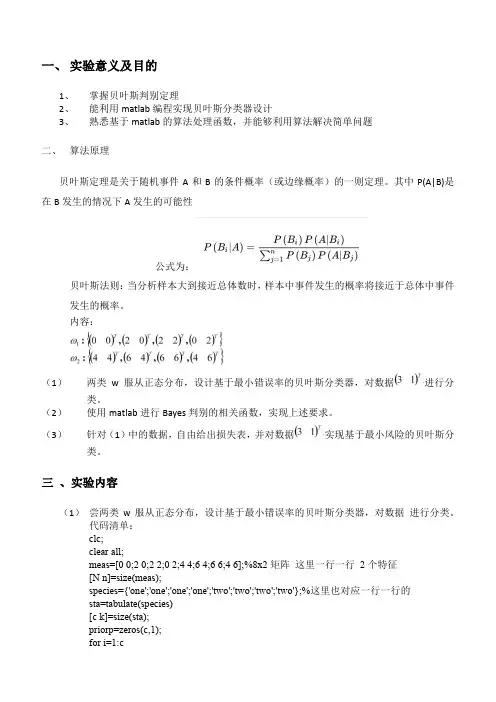

一、实验意义及目的1、掌握贝叶斯判别定理2、能利用matlab编程实现贝叶斯分类器设计3、熟悉基于matlab的算法处理函数,并能够利用算法解决简单问题二、算法原理贝叶斯定理是关于随机事件A和B的条件概率(或边缘概率)的一则定理。

其中P(A|B)是在B发生的情况下A发生的可能性公式为:贝叶斯法则:当分析样本大到接近总体数时,样本中事件发生的概率将接近于总体中事件发生的概率。

内容:(1)两类w服从正态分布,设计基于最小错误率的贝叶斯分类器,对数据进行分类。

(2)使用matlab进行Bayes判别的相关函数,实现上述要求。

(3)针对(1)中的数据,自由给出损失表,并对数据实现基于最小风险的贝叶斯分类。

三、实验内容(1)尝两类w服从正态分布,设计基于最小错误率的贝叶斯分类器,对数据进行分类。

代码清单:clc;clear all;meas=[0 0;2 0;2 2;0 2;4 4;6 4;6 6;4 6];%8x2矩阵这里一行一行2个特征[N n]=size(meas);species={'one';'one';'one';'one';'two';'two';'two';'two'};%这里也对应一行一行的sta=tabulate(species)[c k]=size(sta);priorp=zeros(c,1);for i=1:cpriorp(i)=cell2mat(sta(i,k))/100;%计算概率end%cell2mat(sta(:,2:3)) 提取数组中的数据本来sta数组中数据为矩阵不能直接用%估算类条件概率参数cpmean=zeros(c,n);cpcov=zeros(n,n,c);for i=1:ccpmean(i,:)=mean(meas(strmatch(char(sta(i,1)),species,'exact'),:));%exact精确查找cpmean放的每一类的均值点几类就几行cpcov(:,:,i)=cov(meas(strmatch(char(sta(i,1)),species,'exact'),:))*(N*priorp(i)-1)/(N*priorp(i));end%求(3 1)的后验概率x=[3 1];postp=zeros(c,1);for i=1:cpostp(i)=priorp(i)*exp(-(x-cpmean(i,:))*inv(cpcov(:,:,i))*(x-cpmean(i,:))'/2)/((2*pi)^(n/2)*det(cpcov(:,:,i)));endif postp(1)>postp(2)disp('第一类');elsedisp('第二类');end运行结果:(2)使用matlab进行Bayes判别的相关函数,实现上述要求。

贝叶斯分类器应用实例贝叶斯分类器是一种常用的机器学习算法,其基本原理是根据已有的训练数据,通过统计学方法预测新数据的类别。

贝叶斯分类器的应用非常广泛,其中包括垃圾邮件过滤、情感分析、文本分类等。

在本文中,我将详细介绍贝叶斯分类器在垃圾邮件过滤和情感分析上的应用实例,并介绍其原理和实现步骤。

一、垃圾邮件过滤垃圾邮件过滤是贝叶斯分类器的经典应用之一。

在垃圾邮件过滤中,贝叶斯分类器被用来预测一封邮件是垃圾邮件还是正常邮件。

其原理是根据已有的标记为垃圾邮件或正常邮件的训练数据,计算出某个词语在垃圾邮件和正常邮件中出现的概率,并据此预测新邮件的类别。

具体实现步骤如下:1.收集和准备数据集:需要收集足够数量的已标记为垃圾邮件和正常邮件的数据集,并对其进行预处理,如去除停用词、标点符号等。

2.计算词频:统计每个词语在垃圾邮件和正常邮件中的出现次数,并计算其在两类邮件中的概率。

3.计算条件概率:根据已有的训练数据,计算每个词语在垃圾邮件和正常邮件中的条件概率。

4.计算先验概率:根据已有的训练数据,计算垃圾邮件和正常邮件的先验概率。

5.计算后验概率:根据贝叶斯公式,计算新邮件在垃圾邮件和正常邮件中的后验概率。

6.预测结果:将新邮件归类为垃圾邮件或正常邮件,取后验概率较高的类别。

通过以上步骤,我们可以实现一个简单的垃圾邮件过滤器。

在实际应用中,可以根据需要进行改进,如考虑词语的权重、使用更复杂的模型等。

二、情感分析情感分析是另一个贝叶斯分类器常用的应用领域。

在情感分析中,贝叶斯分类器被用来预测文本的情感倾向,如正面、负面或中性。

具体实现步骤如下:1.收集和准备数据集:需要收集足够数量的已标记为正面、负面或中性的文本数据集,并对其进行预处理,如分词、去除停用词等。

2.计算词频:统计每个词语在正面、负面和中性文本中的出现次数,并计算其在三类文本中的概率。

3.计算条件概率:根据已有的训练数据,计算每个词语在正面、负面和中性文本中的条件概率。

贝叶斯分类器代码贝叶斯分类器是一种基于贝叶斯定理的机器学习算法,它可以用于分类、预测等任务。

在实际应用中,我们通常需要编写代码来实现贝叶斯分类器。

以下是一个简单的贝叶斯分类器代码示例:```import numpy as npclass NaiveBayesClassifier:def __init__(self):self.classes = Noneself.class_priors = Noneself.mean = Noneself.variance = Nonedef fit(self, X, y):self.classes = np.unique(y)n_classes = len(self.classes)# 计算每个类别的先验概率class_counts = np.zeros(n_classes)for i in range(n_classes):class_counts[i] = np.sum(y == self.classes[i])self.class_priors = class_counts / len(y)# 计算每个类别下每个特征的均值和方差n_features = X.shape[1]self.mean = np.zeros((n_classes, n_features)) self.variance = np.zeros((n_classes, n_features))for i in range(n_classes):X_i = X[y == self.classes[i], :]self.mean[i, :] = np.mean(X_i, axis=0)self.variance[i, :] = np.var(X_i, axis=0)def predict(self, X):n_samples, n_features = X.shapey_pred = np.zeros(n_samples)for i in range(n_samples):posteriors = []# 计算每个类别的后验概率for j in range(len(self.classes)):prior = np.log(self.class_priors[j])likelihood = np.sum(np.log(self._gaussian_pdf(X[i, :], self.mean[j, :], self.variance[j, :])))posterior = prior + likelihoodposteriors.append(posterior)# 选择后验概率最大的类别作为预测结果y_pred[i] = self.classes[np.argmax(posteriors)]return y_preddef _gaussian_pdf(self, x, mean, variance):exponent = -0.5 * ((x - mean) ** 2 / variance)coeff = 1.0 / np.sqrt(2.0 * np.pi * variance)return coeff * np.exp(exponent)```该代码实现了一个简单的高斯朴素贝叶斯分类器。

Bayes分类器设计实验⼆ Bayes 分类器设计⼀、实验⽬的通过实验,加深对统计判决与概率密度估计基本思想、⽅法的认识,了解影响Bayes 分类器性能的因素,掌握基于Bayes 决策理论的随机模式分类的原理与⽅法。

⼆、实验内容设计Bayes 决策理论的随机模式分类器。

假定某个局部区域细胞识别中正常(a 1)与⾮正常(a 2)两类先验概率分别为正常状态:P(a 1)=0、9; 异常状态:P(a 2)=0、1。

三、⽅法⼿段Bayes 分类器的基本思想就是依据类的概率、概密,按照某种准则使分类结果从统计上讲就是最佳的。

换⾔之,根据类的概率、概密将模式空间划分成若⼲个⼦空间,在此基础上形成模式分类的判决规则。

准则函数不同,所导出的判决规则就不同,分类结果也不同。

使⽤哪种准则或⽅法应根据具体问题来确定。

四、Bayes 算法1、实验原理多元正太分布的概率密度函数由下式定义112211()exp ()()2(2)T dp X X X µµπ-??=--∑-∑ 由最⼩错误概率判决规则,可得采⽤如下的函数作为判别函数()(|)(),1,2,,i i i g x p X P i N ωω==L这⾥,()i P ω为类别i ω发⽣的先验概率,(|)i p X ω为类别i ω的类条件概率密度函数,⽽N 为类别数。

设类别i ω,i=1,2,……,N 的类条件概率密度函数(|)i p X ω,i=1,2,……,N 服从正态分布,即有(|)i p X ω~(,)i i N µ∑,那么上式就可以写为1122()1()exp ()(),1,2,,2(2)T i i dP g X X X i N ωµµπ-??=--∑-=∑L由于对数函数为单调变化的函数,⽤上式右端取对数后得到的新的判别函数替代原来的判别函数()i g X 不会改变相应分类器的性能。

因此,可取111()()()ln ()ln ln(2)222T i i i i i i d g X X X P µµωπ-=--∑-+-∑- 显然,上式中的第⼆项与样本所属类别⽆关,将其从判别函数中消去,不会改变分类结果。

Bayes分类器设计实验报告模式识别实验报告题⽬: Bayes分类器设计学院计算机科学与技术专业 xxxxxxxxxxxxxxxx学号 xxxxxxxxxxxx姓名 xxxx指导教师 xxxx2015年xx ⽉xx ⽇Bayes 分类器设计装订线⼀、实验⽬的对模式识别有⼀个初步的理解,能够根据⾃⼰的设计对贝叶斯决策理论算法有⼀个深刻地认识,理解⼆类分类器的设计原理。

⼆、实验原理最⼩风险贝叶斯决策可按下列步骤进⾏:(1)在已知及给出待识别的X的情况下,根据贝叶斯公式计算出后验概率:(2)利⽤计算出的后验概率及决策表,按下⾯的公式计算出采取的条件风险(3)对(2)中得到的a个条件风险值进⾏⽐较,找出使其条件风险最⼩的决策,即则就是最⼩风险贝叶斯决策。

三、实验内容假定某个局部区域细胞识别中正常和⾮正常两类先验概率分别为正常状态:P(w1)=;异常状态:P(w2)=。

现有⼀系列待观察的细胞,其观察值为x:已知类条件概率是的曲线如下图:类条件概率分布正态分布分别为N(-2,)、N(2,4)试对观察的结果进⾏分类。

四、实验要求1)⽤matlab完成基于最⼩错误率的贝叶斯分类器的设计,要求程序相应语句有说明⽂字,要求有⼦程序的调⽤过程。

2)根据例⼦画出后验概率的分布曲线以及分类的结果⽰意图。

3)如果是最⼩风险贝叶斯决策,决策表如下:最⼩风险贝叶斯决策表:请重新设计程序,完成基于最⼩风险的贝叶斯分类器,画出相应的条件风险的分布曲线和分类结果,并⽐较两个结果。

五、实验程序最⼩错误率贝叶斯决策分类器设计x=[] pw1= pw2= e1=-2; a1= e2=2;a2=2m=numel(x) %得到待测细胞个数pw1_x=zeros(1,m) %存放对w1的后验概率矩阵pw2_x=zeros(1,m) %存放对w2的后验概率矩阵results=zeros(1,m) %存放⽐较结果矩阵for i = 1:m%计算在w1下的后验概率pw1_x(i)=(pw1*normpdf(x(i),e1,a1))/(pw1*normpdf(x(i),e1,a1)+pw2*normpdf(x(i),e2 ,a2))%计算在w2下的后验概率pw2_x(i)=(pw2*normpdf(x(i),e2,a2))/(pw1*normpdf(x(i),e1,a1)+pw2*normpdf(x(i),e2 ,a2))endfor i = 1:mif pw1_x(i)>pw2_x(i) %⽐较两类后验概率result(i)=0 %正常细胞elseresult(i)=1 %异常细胞endenda=[-5::5] %取样本点以画图n=numel(a)pw1_plot=zeros(1,n)pw2_plot=zeros(1,n)for j=1:npw1_plot(j)=(pw1*normpdf(a(j),e1,a1))/(pw1*normpdf(a(j),e1,a1)+pw2*normpdf(a(j) ,e2,a2))%计算每个样本点对w1的后验概率以画图pw2_plot(j)=(pw2*normpdf(a(j),e2,a2))/(pw1*normpdf(a(j),e1,a1)+pw2*normpdf(a(j) ,e2,a2))endfigure(1)hold onplot(a,pw1_plot,'k-',a,pw2_plot,'r-.')for k=1:mif result(k)==0plot(x(k),,'b*') %正常细胞⽤*表⽰elseplot(x(k),,'rp') %异常细胞⽤五⾓星表⽰end;end;legend('正常细胞后验概率曲线','异常细胞后验概率曲线','正常细胞','异常细胞') xlabel('样本细胞的观察值') ylabel('后验概率') title('后验概率分布曲线')grid onreturn实验内容仿真x = [ , , , , , , , , ,, , , , , , , , , , , , , , ]disp(x)pw1=pw2=[result]=bayes(x,pw1,pw2)最⼩风险贝叶斯决策分类器设计function [R1_x,R2_x,result]=danger(x,pw1,pw2)m=numel(x) %得到待测细胞个数R1_x=zeros(1,m) %存放把样本X判为正常细胞所造成的整体损失R2_x=zeros(1,m) %存放把样本X判为异常细胞所造成的整体损失result=zeros(1,m) %存放⽐较结果e1=-2a1=e2=2a2=2%类条件概率分布px_w1:(-2,)px_w2(2,4)r11=0r12=2r21=4r22=0%风险决策表for i=1:m %计算两类风险值R1_x(i)=r11*pw1*normpdf(x(i),e1,a1)/(pw1*normpdf(x(i),e1,a1)+pw2*normpdf(x(i),e2,a2))+r21*pw2*normpdf(x(i),e2,a2)/(pw1*normpdf(x(i),e1,a1)+pw2*normpdf(x(i),e2 ,a2)) R2_x(i)=r12*pw1*normpdf(x(i),e1,a1)/(pw1*normpdf(x(i),e1,a1)+pw2*normpdf(x(i),e2,a2))+r22*pw2*normpdf(x(i),e2,a2)/(pw1*normpdf(x(i),e1,a1)+pw2*normpdf(x(i),e2。

贝叶斯分类器训练过程一、数据收集贝叶斯分类器训练的第一步是收集用于训练的数据。

数据可以通过多种方式收集,包括公开可用的数据集、内部数据库、或通过用户输入等。

数据收集的目的是获取足够的信息,以便能够训练出准确的分类器。

二、数据预处理在收集到数据后,需要进行预处理,以确保数据的质量和一致性。

预处理可能包括数据清洗、数据转换、数据标准化等步骤。

例如,可能需要对缺失值进行填充,对异常值进行处理,将不同类型的数据进行转换等。

三、特征提取特征提取是贝叶斯分类器训练过程中的重要步骤。

它涉及到从原始数据中提取有用的信息,这些信息将被用于建立分类器的概率模型。

特征可能包括数值型特征、文本型特征、图像特征等。

在提取特征时,应考虑如何利用数据的结构化信息和上下文信息,以便更有效地建立分类器。

四、概率模型建立在提取了特征后,需要建立概率模型。

贝叶斯分类器通常基于朴素贝叶斯(Naive Bayes)算法。

朴素贝叶斯假设特征之间相互独立,通过训练数据来计算特征之间的概率和类别条件概率。

五、模型参数估计在建立了概率模型后,需要对模型参数进行估计。

这通常涉及到使用最大似然估计法或贝叶斯估计法等统计方法,以确定模型参数的最佳值。

参数估计的目的是使模型能够准确地对新数据进行分类。

六、模型评估在模型参数估计完成后,需要对模型进行评估。

评估可以通过使用测试集或交叉验证等方法进行。

评估的目的是确定模型的性能和准确性。

如果模型的性能不佳,可能需要进一步优化模型参数或调整特征提取方法。

七、模型优化如果模型的性能不佳,需要进行模型优化。

这可能涉及到调整模型的参数、改变特征提取方法、引入新的特征等。

优化的目的是提高模型的性能和准确性。

在优化过程中,可能需要反复进行模型评估和调整,直到达到满意的性能为止。

八、模型部署在模型优化完成后,可以将模型部署到实际应用中。

在部署过程中,需要注意如何将模型集成到实际应用中,并确保模型的稳定性和可扩展性。

此外,还需要定期对模型进行更新和维护,以保持其性能和准确性。

贝叶斯分类器设计原理与实现贝叶斯分类器是一种基于贝叶斯定理的机器学习算法,常被用于文本分类、垃圾邮件过滤等任务。

本文将介绍贝叶斯分类器的设计原理和实现。

一、贝叶斯分类器的原理贝叶斯分类器基于贝叶斯定理,该定理描述了在已知一些先验条件下,如何通过新的观测数据来更新我们对于某个事件发生概率的判断。

在分类任务中,我们希望通过已知的特征,预测出一个样本属于某一类别的概率。

在贝叶斯分类器中,我们通过计算后验概率来决定样本的分类。

后验概率是指在已知某个条件下,事件发生的概率。

根据贝叶斯定理,后验概率可以通过先验概率和条件概率来计算。

先验概率是指在没有任何其他信息的情况下,事件发生的概率;条件概率是指在已知其他相关信息的情况下,事件发生的概率。

贝叶斯分类器根据特征的条件独立性假设,将样本的特征表示为一个向量。

通过训练数据,我们可以计算出每个特征在不同类别中的条件概率。

当有一个新的样本需要分类时,我们可以根据贝叶斯定理和特征的条件独立性假设,计算出该样本属于每个类别的后验概率,从而实现分类。

二、贝叶斯分类器的实现贝叶斯分类器的实现主要包括训练和预测两个步骤。

1. 训练过程训练过程中,我们需要从已知的训练数据中学习每个特征在不同类别下的条件概率。

首先,我们需要统计每个类别出现的频率,即先验概率。

然后,对于每个特征,我们需要统计它在每个类别下的频率,并计算出条件概率。

可以使用频率计数或者平滑方法来估计这些概率。

2. 预测过程预测过程中,我们根据已训练好的模型,计算出待分类样本属于每个类别的后验概率,并选择具有最大后验概率的类别作为最终的分类结果。

为了避免概率下溢问题,通常会将概率取对数,并使用对数概率进行计算。

三、贝叶斯分类器的应用贝叶斯分类器在自然语言处理领域有广泛的应用,尤其是文本分类和垃圾邮件过滤。

在文本分类任务中,贝叶斯分类器可以通过学习已有的标记文本,自动将新的文本分类到相应的类别中。

在垃圾邮件过滤任务中,贝叶斯分类器可以通过学习已有的垃圾邮件和正常邮件,自动判断新的邮件是否为垃圾邮件。

文本分类中常见的机器学习模型及使用方法在文本分类问题中,机器学习模型扮演着重要的角色。

这些模型通过学习从已标记的文本数据中提取特征,并根据这些特征将文本分为不同的类别。

在本文中,我们将介绍一些常见的机器学习模型及其使用方法。

1. 朴素贝叶斯分类器(Naive Bayes Classifier)朴素贝叶斯分类器是一种基于贝叶斯定理的概率模型,常用于文本分类任务。

该模型假设文本的特征之间相互独立,从而简化了计算和学习过程。

通常使用词袋模型将文本表示为特征向量,然后使用贝叶斯定理计算给定类别的条件概率,最后选择具有最大概率的类别作为分类结果。

2. 支持向量机(Support Vector Machines,SVM)支持向量机是一种基于统计学习理论的二分类模型,在文本分类中也能得到良好的应用。

SVM通过寻找最佳的超平面将数据分割为不同的类别。

在文本分类中,首先需要将文本表示为特征向量,然后使用SVM模型进行训练和分类。

SVM模型通过最大化两个类别之间的间隔来找到最佳分类边界。

3. 逻辑回归(Logistic Regression)逻辑回归是一种广泛应用于文本分类问题的线性模型,主要用于二分类任务。

逻辑回归通过将特征与权重相乘,并使用sigmoid函数对结果进行映射,从而得到一个概率值。

通常,将概率大于0.5的文本分为正类,概率小于0.5的文本分为负类。

4. 随机森林(Random Forest)随机森林是一种基于决策树的集成学习方法,在文本分类中也有广泛应用。

随机森林通过构建多个决策树,并通过投票的方式来选择最终的分类结果。

在文本分类中,首先需要将文本转化为特征向量,然后使用随机森林模型进行训练和分类。

5. 卷积神经网络(Convolutional Neural Networks,CNN)卷积神经网络是一种深度学习模型,在文本分类中也表现出了强大的能力。

CNN通过多层卷积和池化操作来提取文本中的局部特征,并将这些特征传递给全连接层进行分类。