spark Introduction

- 格式:pdf

- 大小:7.84 MB

- 文档页数:45

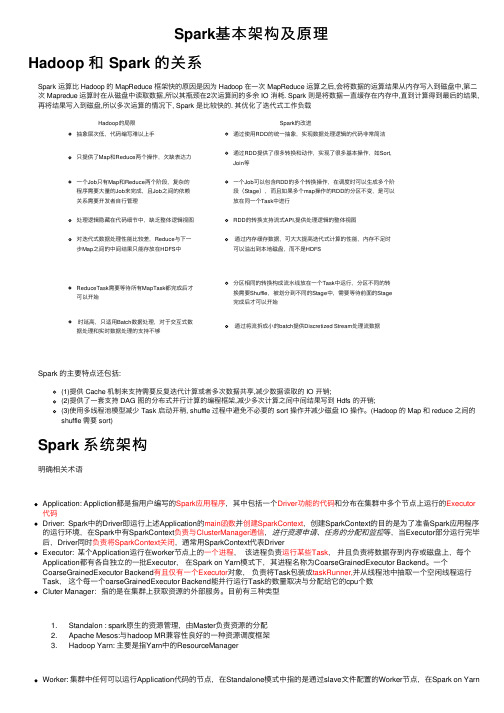

Spark基本架构及原理Hadoop 和 Spark 的关系Spark 运算⽐ Hadoop 的 MapReduce 框架快的原因是因为 Hadoop 在⼀次 MapReduce 运算之后,会将数据的运算结果从内存写⼊到磁盘中,第⼆次 Mapredue 运算时在从磁盘中读取数据,所以其瓶颈在2次运算间的多余 IO 消耗. Spark 则是将数据⼀直缓存在内存中,直到计算得到最后的结果,再将结果写⼊到磁盘,所以多次运算的情况下, Spark 是⽐较快的. 其优化了迭代式⼯作负载Hadoop的局限Spark的改进抽象层次低,代码编写难以上⼿通过使⽤RDD的统⼀抽象,实现数据处理逻辑的代码⾮常简洁只提供了Map和Reduce两个操作,⽋缺表达⼒通过RDD提供了很多转换和动作,实现了很多基本操作,如Sort, Join等⼀个Job只有Map和Reduce两个阶段,复杂的程序需要⼤量的Job来完成,且Job之间的依赖关系需要开发者⾃⾏管理⼀个Job可以包含RDD的多个转换操作,在调度时可以⽣成多个阶段(Stage),⽽且如果多个map操作的RDD的分区不变,是可以放在同⼀个Task中进⾏处理逻辑隐藏在代码细节中,缺乏整体逻辑视图RDD的转换⽀持流式API,提供处理逻辑的整体视图对迭代式数据处理性能⽐较差,Reduce与下⼀步Map之间的中间结果只能存放在HDFS中通过内存缓存数据,可⼤⼤提⾼迭代式计算的性能,内存不⾜时可以溢出到本地磁盘,⽽不是HDFSReduceTask需要等待所有MapTask都完成后才可以开始分区相同的转换构成流⽔线放在⼀个Task中运⾏,分区不同的转换需要Shuffle,被划分到不同的Stage中,需要等待前⾯的Stage 完成后才可以开始时延⾼,只适⽤Batch数据处理,对于交互式数据处理和实时数据处理的⽀持不够通过将流拆成⼩的batch提供Discretized Stream处理流数据Spark 的主要特点还包括:(1)提供 Cache 机制来⽀持需要反复迭代计算或者多次数据共享,减少数据读取的 IO 开销;(2)提供了⼀套⽀持 DAG 图的分布式并⾏计算的编程框架,减少多次计算之间中间结果写到 Hdfs 的开销;(3)使⽤多线程池模型减少 Task 启动开稍, shuffle 过程中避免不必要的 sort 操作并减少磁盘 IO 操作。

Spark大数据处理框架入门与实践概述Spark是现今最流行的大数据处理框架之一,它可以处理多种类型的数据,包括结构化数据、半结构化数据、非结构化数据、日志数据等。

本文将介绍Spark的基本概念与使用方法,并通过实际案例帮助读者快速掌握Spark大数据处理框架。

Spark的基本概念Spark是一种基于内存的分布式计算框架,可以将数据分布在多个节点上进行计算,从而提高计算效率。

Spark的核心理念是弹性分布式数据集(Resilient Distributed Dataset,简称RDD),它是一种分布式的元素集合,通过分布式群集实现高效计算。

RDD 分为两种类型:Spark的高级API中,基于RDD构建的应用程序称为Spark Core。

Spark的优势Speed:Spark使用内存计算,因此速度要比Hadoop快。

Ease of Use:Spark的API非常友好,许多用户花费很短的时间在上手Spark上。

Unified Engine:Spark的统一计算引擎可以处理多个任务,包括批量处理、流处理等。

Real-time stream processing:Spark有流计算框架Spark Streaming,可以进行流处理。

安装Spark安装Java环境下载Spark启动SparkSpark的实践在下面的实践中,我们将从实际的案例开始使用Spark构建项目。

案例描述我们将使用Spark来分析一份数据,该数据是储格拉斯选举数据,包括每个区域的投票情况和每个候选人得票情况。

步骤1:数据探索我们先下载数据并使用Spark来分析。

下载数据分析数据在Spark中,数据可以从多种来源读取,例如HDFS、S3、HTTP等。

对于我们的数据,我们可以使用以下代码从文件中读取。

在将数据读取到Spark中之后,我们可以使用一些API来处理数据。

下面是一些示例代码,用于清理数据并返回有关储格拉斯选举的一些统计信息。

步骤2:数据处理在数据探索之后,我们需要进一步处理数据。

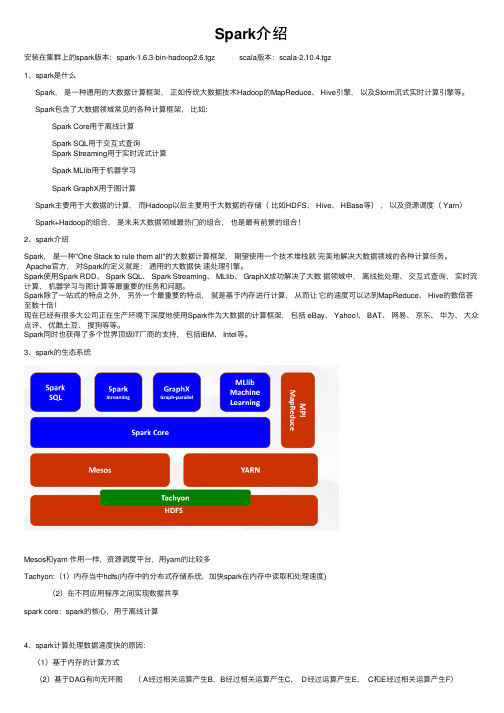

Spark介绍安装在集群上的spark版本:spark-1.6.3-bin-hadoop2.6.tgz scala版本:scala-2.10.4.tgz1、spark是什么Spark,是⼀种通⽤的⼤数据计算框架,正如传统⼤数据技术Hadoop的MapReduce、 Hive引擎,以及Storm流式实时计算引擎等。

Spark包含了⼤数据领域常见的各种计算框架,⽐如:Spark Core⽤于离线计算Spark SQL⽤于交互式查询Spark Streaming⽤于实时流式计算Spark MLlib⽤于机器学习Spark GraphX⽤于图计算Spark主要⽤于⼤数据的计算,⽽Hadoop以后主要⽤于⼤数据的存储(⽐如HDFS、 Hive、 HBase等),以及资源调度( Yarn)Spark+Hadoop的组合,是未来⼤数据领域最热门的组合,也是最有前景的组合!2、spark介绍Spark,是⼀种"One Stack to rule them all"的⼤数据计算框架,期望使⽤⼀个技术堆栈就完美地解决⼤数据领域的各种计算任务。

Apache官⽅,对Spark的定义就是:通⽤的⼤数据快速处理引擎。

Spark使⽤Spark RDD、 Spark SQL、 Spark Streaming、 MLlib、 GraphX成功解决了⼤数据领域中,离线批处理、交互式查询、实时流计算、机器学习与图计算等最重要的任务和问题。

Spark除了⼀站式的特点之外,另外⼀个最重要的特点,就是基于内存进⾏计算,从⽽让它的速度可以达到MapReduce、 Hive的数倍甚⾄数⼗倍!现在已经有很多⼤公司正在⽣产环境下深度地使⽤Spark作为⼤数据的计算框架,包括 eBay、 Yahoo!、 BAT、⽹易、京东、华为、⼤众点评、优酷⼟⾖、搜狗等等。

Spark同时也获得了多个世界顶级IT⼚商的⽀持,包括IBM、 Intel等。

智能水务平台产品介绍1平台概述PLATFORM INTRODUCTION技术服务技术咨询实施方案二次开发对接指导应用领域基建行业隧道监测桥梁监测地质监测房屋监测制造行业设备状态监测产品质量监测生产环境监测环保行业污水处理监测毒害气体监测企业偷排监测医疗行业血液样本监测疫苗监测医疗设备监测农业鱼塘监测农作物监测价值体现数据上云异常检查安全防范主动决策……技术架构数据核心平台传输层采集层分析层hadoop算法文件警戒分析数据看板执行层平台基础架构产品监测排污监测水质监测医疗设备监测隧道监测房屋监测设备运维监测桥梁监测数据核心平台基础设备管理通讯协议管理解析协议管理基础开发SDK SQL 数据库:MYSQL 、ORACLE 、SQLSERVER 等NOSQL :REDIS 、mongodb 等海量数据存储:HDFS 、HBASE等Map Reduc eSpark Storm传输协议私有协议透传MQTTHTTP......PLC DTU 、RTU 智能终端平台技术架构平台技术实现分析报告移动端大屏展示PC 端数据报告图表报表GIS组态分析大数据数据统计算法分析预测分析结果导出变量算法协议算法阀值算法多级计算平台监控项目监控权限管控GIS 监控变量监控监控预警设备监控平台优势分布式高并发多行业自定义算法精细化协议兼容全量/增量加载大数据ApacheLog Ali ECS Hadoop Redis NoSQL分布式计算内存计算筛选算法缓存计算协议对接算法组建存储过程缓存机制平台功能框架深入挖掘物联网技术在基建、工业、环保、农业等行业的应用,结合专业硬件设备组成多个领域专业解决方案;汲取大型物联网数据监测工程运营企业专家建议,实现工程项目精细化分层管理。

高专业度高性能高兼容性全方位服务专业团队打造高性能 高可靠性的数据核心平台,支持上万级别的网关设备同时在线;被动采集频率可达到秒级,主动采集频率可达到毫秒级。

spark知识体系-运⾏架构本篇主要讲解spark运⾏架构,包含如下内容:Spark运⾏架构基本概念ApplicationSpark的应⽤程序,包含⼀个Driver program和若⼲ExecutorSparkContextSpark应⽤程序的⼊⼝,负责调度各个运算资源,协调各个Worker Node的ExecutorDriver Program运⾏Application的main()函数并且创建SparkContextExecutor为Application运⾏在Worker node上的⼀个进程,该进程负责运⾏Task,并且负责将数据存在内存或者磁盘上,每个Application都会申请各⾃的Executor来处理任务Cluster Manager在集群上获取资源的外部服务(例如Standalone,Mesos,Yarn)Worker Node集群中任何可以运⾏Application代码的节点,运⾏⼀个或者多个Executor进程Task运⾏在Executor上的⼯作单元JobSparkContext提交的具体Action操作,常和Action对应Stage每个Job会被拆分很多组task,每组任务被称为Stage,也称TaskSetRDD是Resilient distributed datasets的简称,中⽂为弹性分布式数据集,是Spark最核⼼的模块和类DAGScheduler根据Job构建基本Stage的DAG,并提交Stage给TaskSchedulerTaskScheduler将TaskSet提交给Worker node集群运⾏并返回结果Transformations是Spark API的⼀种类型,Transformation返回值还是⼀个RDD,所有的Transformation采⽤的都是懒策略,如果只是将Transformation 的提交时不会执⾏计算的Action是Spark API的⼀种类型,Action返回值不是⼀个RDD,⽽是⼀个scala集合,计算只有在Action被提交的时候计算才被触发架构设计Standalone模式Spark Standalone模式的集群由Master与Worker节点组成,程序通过与Master节点交互申请资源,Worker节点启动Executor运⾏Driver部分Driver部分主要是对SparkContext进⾏配置、初始化以及关闭。

Spark技术方案1. 引言Spark是一个快速、通用、可扩展的大数据处理框架,可用于大规模数据处理、机器学习和数据分析等任务。

本文档将介绍Spark的技术方案,包括其特点、架构和使用场景等内容。

2. Spark的特点Spark具有如下几个显著的特点:2.1 快速性能Spark采用内存计算,通过将数据存储在内存中进行处理,大幅度减少了磁盘IO的开销,提高了数据处理的速度。

同时,Spark的计算模型基于DAG(有向无环图),可优化任务执行顺序,进一步提升性能。

2.2 通用性Spark支持多种编程语言,包括Java、Scala、Python和R等,使得开发人员能够使用自己熟悉的语言进行开发。

此外,Spark提供了丰富的API和库,可用于处理结构化数据、图数据和流式数据等不同类型的任务。

2.3 可扩展性Spark采用分布式计算的方式,可以在多台机器上进行任务的并行计算。

通过增加计算节点,可以实现对更大规模数据的处理,提高系统的扩展性。

3. Spark的架构Spark的架构分为三个主要组件:驱动器(Driver)、执行器(Executor)和集群管理器(Cluster Manager)。

3.1 驱动器驱动器是Spark程序的主要组成部分,负责整个应用程序的控制和调度。

它负责将任务划分为不同的阶段,并将这些阶段发送到执行器进行计算。

3.2 执行器执行器是在集群上运行的工作节点,负责接收来自驱动器的任务并执行计算。

每个执行器都具有自己的线程池,可以同时运行多个任务。

执行器还负责将计算结果返回给驱动器。

3.3 集群管理器集群管理器负责分配和管理集群资源,以确保Spark应用程序的顺利运行。

常用的集群管理器有Standalone、YARN和Mesos等。

集群管理器负责启动和停止执行器,并监控其状态。

4. Spark的使用场景Spark可以应用于多种大数据处理场景,包括以下几个方面:4.1 批处理Spark支持对大规模数据进行批处理,可以对数据进行转换、过滤和聚合等操作。