遗传算法与蚁群算法简介

- 格式:ppt

- 大小:739.00 KB

- 文档页数:45

简单蚁群算法的实现-遗传算法-瞎整技术简单蚁群算法的实现 很久没有写博客了,⼀直都在忙着⽹站和论⽂的事,最近看了⼏篇蚁群算法的论⽂挺有意思的,总结了⼀下写成⼀篇论⽂附上重要部分的代码,顺便也完成了遗传算法的课程报告,有兴趣的朋友可以看看。

⼀引⾔蚁群算法(ant colony optimization,ACO),⼜称蚂蚁算法,是⼀种⽤来在图中寻找优化路径的机率型技术。

它由Marco Dorigo于1992年在他的博⼠论⽂中引⼊,其灵感来源于蚂蚁在寻找⾷物过程中发现路径的⾏为。

蚁群算法是⼀种模拟进化算法。

初步的研究表明该算法具有许多优良的性质。

针对PID控制器参数优化设计问题,将蚁群算法设计的结果与遗传算法设计的结果进⾏了⽐较,数值仿真结果表明,蚁群算法具有⼀种新的模拟进化优化⽅法的有效性和应⽤价值。

蚁群算法是⼀种求解组合最优化问题的新型通⽤启发式⽅法,该⽅法具有正反馈、分布式计算和富于建设性的贪婪启发式搜索的特点。

正因为蚁群算法有这些优点,很多研究者都在致⼒研究和改过它,本⽂的⽬的正是为了介绍蚁群算法,学习如何编写蚁群算法。

⼆蚁群算法的介绍昆⾍世界中,蚂蚁的组成是⼀种群居的世袭⼤家庭,我们称之为蚁群。

蚂蚁分为世袭制的蚁王(后)和⼯蚁两种,它们具有⾼度组织的社会性,彼此沟通不仅可以借助触觉和视觉的联系,在⼤规模的协调⾏动中还可以借助外激素(有些书称信息素)之类的信息介质。

⾸先我们要理解蚂蚁是如何觅⾷的,蚂蚁平时在巢⽳附近作⽆规则⾏⾛,⼀量发现⾷物并不⽴即进⾷⽽是将之搬回蚁⽳与其它蚂蚁分享,在⾷物⼩时则独⾃搬回蚁⽳,否则就回蚁⽳搬兵,⼀路上会留下外激素,⾷物越⼤外激素的浓度就越⼤,越能吸引其它的蚂蚁过去⼀起搬去⾷物,这样最终就能将⾷物全部搬回蚁⽳。

这个过程⽤程序实现看似⾮常复杂,要编写⼀个“智能”的蚂蚁也看似不太可能,事实上每个蚂蚁只做了⾮常简单的⼯作:检查某个范围内有⽆⾷物,并逐渐向外激素浓的⽅向运动。

遗传算法与蚁群算法结合遗传算法1、基本思想2、算法原理3、代码实现4、结果截图5、总结1·基本思想吸取两个算法的优点,优缺互补,克服两个算法的缺点,利⽤了遗传算法的快速时间效率,优于蚂蚁算法的时间效率。

并且求解精度效率优于遗传算法。

这样就提⾼了两个算法结合的算法时间效率和求解精度。

2、算法原理这个算法的原理是先利⽤遗传算法的快速性、全局收敛性和随机性求出结果,结果产⽣有关问题的初始信息素分布,遗传算法执⾏完在运⽤蚁群算法,在⼀定初始信息素分布的情况下,充分利⽤蚁群算法并⾏性、正反馈性、求解精度效率⾼的特点。

3、代码实现%mainclear;clc;%%%%%%%%%%%%%%%输⼊参数%%%%%%%%N=50; %%城市的个数M=100; %%种群的个数ITER=500; %%迭代次数%C_old=C;m=2; %%适应值归⼀化淘汰加速指数Pc=0.8; %%交叉概率Pmutation=0.05; %%变异概率%%⽣成城市的坐标pos=randn(N,2);%%⽣成城市之间距离矩阵D=zeros(N,N);for i=1:Nfor j=i+1:Ndis=(pos(i,1)-pos(j,1)).^2+(pos(i,2)-pos(j,2)).^2;D(i,j)=dis^(0.5);D(j,i)=D(i,j);endend%%⽣成初始群体popm=zeros(M,N);for i=1:Mpopm(i,:)=randperm(N);%随机排列,⽐如[2 4 5 6 1 3]end%%随机选择⼀个种群R=popm(1,:);figure(1);scatter(pos(:,1),pos(:,2),'rx');%画出所有城市坐标axis([-3 3 -3 3]);figure(2);plot_route(pos,R); %%画出初始种群对应各城市之间的连线axis([-3 3 -3 3]);%%初始化种群及其适应函数fitness=zeros(M,1);len=zeros(M,1);for i=1:M%计算每个染⾊体对应的总长度len(i,1)=myLength(D,popm(i,:));endmaxlen=max(len);%最⼤回路minlen=min(len);%最⼩回路fitness=fit(len,m,maxlen,minlen);rr=find(len==minlen);%找到最⼩值的下标,赋值为rrR=popm(rr(1,1),:);%提取该染⾊体,赋值为Rfor i=1:Nfprintf('%d ',R(i));%把R顺序打印出来endfprintf('\n');fitness=fitness/sum(fitness);distance_min=zeros(ITER+1,1); %%各次迭代的最⼩的种群的路径总长nn=M;iter=0;while iter<=ITERfprintf('迭代第%d次\n',iter);%%选择操作p=fitness./sum(fitness);q=cumsum(p);%累加for i=1:(M-1)len_1(i,1)=myLength(D,popm(i,:));r=rand;tmp=find(r<=q);popm_sel(i,:)=popm(tmp(1),:);end[fmax,indmax]=max(fitness);%求当代最佳个体popm_sel(M,:)=popm(indmax,:);%%交叉操作nnper=randperm(M);% A=popm_sel(nnper(1),:);% B=popm_sel(nnper(2),:);%%for i=1:M*Pc*0.5A=popm_sel(nnper(i),:);B=popm_sel(nnper(i+1),:);[A,B]=cross(A,B);% popm_sel(nnper(1),:)=A;% popm_sel(nnper(2),:)=B;popm_sel(nnper(i),:)=A;popm_sel(nnper(i+1),:)=B;end%%变异操作for i=1:Mpick=rand;while pick==0pick=rand;endif pick<=Pmutationpopm_sel(i,:)=Mutation(popm_sel(i,:));endend%%求适应度函数NN=size(popm_sel,1);len=zeros(NN,1);for i=1:NNlen(i,1)=myLength(D,popm_sel(i,:));endmaxlen=max(len);minlen=min(len);distance_min(iter+1,1)=minlen;fitness=fit(len,m,maxlen,minlen);rr=find(len==minlen);fprintf('minlen=%d\n',minlen);R=popm_sel(rr(1,1),:);for i=1:Nfprintf('%d ',R(i));endfprintf('\n');popm=[];popm=popm_sel;iter=iter+1;%pause(1);end%end of whilefigure(3)plot_route(pos,R);axis([-3 3 -3 3]);figure(4)plot(distance_min);%交叉操作函数 cross.mfunction [A,B]=cross(A,B)L=length(A);if L<10W=L;elseif ((L/10)-floor(L/10))>=rand&&L>10W=ceil(L/10)+8;elseW=floor(L/10)+8;end%%W为需要交叉的位数p=unidrnd(L-W+1);%随机产⽣⼀个交叉位置%fprintf('p=%d ',p);%交叉位置for i=1:Wx=find(A==B(1,p+i-1));y=find(B==A(1,p+i-1));[A(1,p+i-1),B(1,p+i-1)]=exchange(A(1,p+i-1),B(1,p+i-1));[A(1,x),B(1,y)]=exchange(A(1,x),B(1,y));endend%连点画图函数 plot_route.mfunction plot_route(a,R)scatter(a(:,1),a(:,2),'rx');hold on;plot([a(R(1),1),a(R(length(R)),1)],[a(R(1),2),a(R(length(R)),2)]);hold on;for i=2:length(R)x0=a(R(i-1),1);y0=a(R(i-1),2);x1=a(R(i),1);y1=a(R(i),2);xx=[x0,x1];yy=[y0,y1];plot(xx,yy);hold on;endend%染⾊体的路程代价函数 mylength.mfunction len=myLength(D,p)%p是⼀个排列[N,NN]=size(D);len=D(p(1,N),p(1,1));for i=1:(N-1)len=len+D(p(1,i),p(1,i+1));endend%变异函数 Mutation.mfunction a=Mutation(A)index1=0;index2=0;nnper=randperm(size(A,2));index1=nnper(1);index2=nnper(2);%fprintf('index1=%d ',index1);%fprintf('index2=%d ',index2);temp=0;temp=A(index1);A(index1)=A(index2);A(index2)=temp;a=A;end%适应度函数fit.m,每次迭代都要计算每个染⾊体在本种群内部的优先级别,类似归⼀化参数。

简单对⽐遗传算法与蚁群算法求解旅⾏商问题简单对⽐遗传算法与蚁群算法求解旅⾏商问题简单对⽐遗传算法与蚁群算法求解旅⾏商问题1、旅⾏商1.1 旅⾏商问题简介旅⾏商问题(Traveling Saleman Problem)⼜称作旅⾏推销员问题、货郎担问题等,简称为TSP问题,是最基本的路线问题,该问题是在寻求单⼀旅⾏者由起点出发,通过所有给定的需求点之后,最后再回到原点的最⼩路径成本。

最早的旅⾏商问题的数学规划是由Dantzig(1959)等⼈提出,规则虽然简单,但在地点数⽬增多后求解却极为复杂。

TSP问题最简单的求解⽅法是枚举法。

它的解是多维的、多局部极值的、趋于⽆穷⼤的复杂解的空间,搜索空间是n个点的所有排列的集合,⼤⼩为(n-1)!。

有研究者形象地把解空间⽐喻为⼀个⽆穷⼤的丘陵地带,各⼭峰或⼭⾕的⾼度即是问题的极值。

求解TSP,则是在此不能穷尽的丘陵地带中攀登以达到⼭顶或⾕底的过程。

1.2 求解TSP⽅法简介旅⾏推销员的问题属于NP-Complete的问题,所以旅⾏商问题⼤多集中在启发式解法。

Bodin(1983)等⼈将旅⾏推销员问题的启发式解法分成三种:1.2.1 途程建构法(Tour Construction Procedures)从距离矩阵中产⽣⼀个近似最佳解的途径,有以下⼏种解法:(1)最近邻点法(Nearest Neighbor Procedure):⼀开始以寻找离场站最近的需求点为起始路线的第⼀个顾客,此后寻找离最后加⼊路线的顾客最近的需求点,直到最后。

(2)节省法(Clark and Wright Saving):以服务每⼀个节点为起始解,根据三⾓不等式两边之和⼤于第三边之性质,其起始状况为每服务⼀个顾客后便回场站,⽽后计算路线间合并节省量,将节省量以降序排序⽽依次合并路线,直到最后。

(3)插⼊法(Insertion procedures):如最近插⼊法、最省插⼊法、随意插⼊法、最远插⼊法、最⼤⾓度插⼊法等。

⼈⼯智能结课作业-遗传算法粒⼦群寻优蚁群算法解决TSP问题代码已经发布到了github:如果帮到你了,希望给个star⿎励⼀下1 遗传算法1.1算法介绍遗传算法是模仿⾃然界⽣物进化机制发展起来的随机全局搜索和优化⽅法,它借鉴了达尔⽂的进化论和孟德尔的遗传学说。

其本质是⼀种⾼效、并⾏、全局搜索的⽅法,它能在搜索过程中⾃动获取和积累有关搜索空间的知识,并⾃适应的控制搜索过程以求得最优解。

遗传算法操作使⽤适者⽣存的原则,在潜在的解决⽅案种群中逐次产⽣⼀个近似最优解的⽅案,在遗传算法的每⼀代中,根据个体在问题域中的适应度值和从⾃然遗传学中借鉴来的再造⽅法进⾏个体选择,产⽣⼀个新的近似解。

这个过程导致种群中个体的进化,得到的新个体⽐原来个体更能适应环境,就像⾃然界中的改造⼀样。

遗传算法具体步骤:(1)初始化:设置进化代数计数器t=0、设置最⼤进化代数T、交叉概率、变异概率、随机⽣成M个个体作为初始种群P(2)个体评价:计算种群P中各个个体的适应度(3)选择运算:将选择算⼦作⽤于群体。

以个体适应度为基础,选择最优个体直接遗传到下⼀代或通过配对交叉产⽣新的个体再遗传到下⼀代(4)交叉运算:在交叉概率的控制下,对群体中的个体两两进⾏交叉(5)变异运算:在变异概率的控制下,对群体中的个体进⾏变异,即对某⼀个体的基因进⾏随机调整(6)经过选择、交叉、变异运算之后得到下⼀代群体P1。

重复以上(1)-(6),直到遗传代数为 T,以进化过程中所得到的具有最优适应度个体作为最优解输出,终⽌计算。

旅⾏推销员问题(Travelling Salesman Problem, TSP):有n个城市,⼀个推销员要从其中某⼀个城市出发,唯⼀⾛遍所有的城市,再回到他出发的城市,求最短的路线。

应⽤遗传算法求解TSP问题时需要进⾏⼀些约定,基因是⼀组城市序列,适应度是按照这个基因的城市顺序的距离和分之⼀。

1.2实验代码import randomimport mathimport matplotlib.pyplot as plt#读取数据f=open("test.txt")data=f.readlines()#将cities初始化为字典,防⽌下⾯被当成列表cities={}for line in data:#原始数据以\n换⾏,将其替换掉line=line.replace("\n","")#最后⼀⾏以EOF为标志,如果读到就证明读完了,退出循环if(line=="EOF"):break#空格分割城市编号和城市的坐标city=line.split("")map(int,city)#将城市数据添加到cities中cities[eval(city[0])]=[eval(city[1]),eval(city[2])]#计算适应度,也就是距离分之⼀,这⾥⽤伪欧⽒距离def calcfit(gene):sum=0#最后要回到初始城市所以从-1,也就是最后⼀个城市绕⼀圈到最后⼀个城市for i in range(-1,len(gene)-1):nowcity=gene[i]nextcity=gene[i+1]nowloc=cities[nowcity]nextloc=cities[nextcity]sum+=math.sqrt(((nowloc[0]-nextloc[0])**2+(nowloc[1]-nextloc[1])**2)/10)return 1/sum#每个个体的类,⽅便根据基因计算适应度class Person:def__init__(self,gene):self.gene=geneself.fit=calcfit(gene)class Group:def__init__(self):self.GroupSize=100 #种群规模self.GeneSize=48 #基因数量,也就是城市数量self.initGroup()self.upDate()#初始化种群,随机⽣成若⼲个体def initGroup(self):self.group=[]i=0while(i<self.GroupSize):i+=1#gene如果在for以外⽣成只会shuffle⼀次gene=[i+1 for i in range(self.GeneSize)]random.shuffle(gene)tmpPerson=Person(gene)self.group.append(tmpPerson)#获取种群中适应度最⾼的个体def getBest(self):bestFit=self.group[0].fitbest=self.group[0]for person in self.group:if(person.fit>bestFit):bestFit=person.fitbest=personreturn best#计算种群中所有个体的平均距离def getAvg(self):sum=0for p in self.group:sum+=1/p.fitreturn sum/len(self.group)#根据适应度,使⽤轮盘赌返回⼀个个体,⽤于遗传交叉def getOne(self):#section的简称,区间sec=[0]sumsec=0for person in self.group:sumsec+=person.fitsec.append(sumsec)p=random.random()*sumsecfor i in range(len(sec)):if(p>sec[i] and p<sec[i+1]):#这⾥注意区间是⽐个体多⼀个0的return self.group[i]#更新种群相关信息def upDate(self):self.best=self.getBest()#遗传算法的类,定义了遗传、交叉、变异等操作class GA:def__init__(self):self.group=Group()self.pCross=0.35 #交叉率self.pChange=0.1 #变异率self.Gen=1 #代数#变异操作def change(self,gene):#把列表随机的⼀段取出然后再随机插⼊某个位置#length是取出基因的长度,postake是取出的位置,posins是插⼊的位置geneLenght=len(gene)index1 = random.randint(0, geneLenght - 1)index2 = random.randint(0, geneLenght - 1)newGene = gene[:] # 产⽣⼀个新的基因序列,以免变异的时候影响⽗种群 newGene[index1], newGene[index2] = newGene[index2], newGene[index1] return newGene#交叉操作def cross(self,p1,p2):geneLenght=len(p1.gene)index1 = random.randint(0, geneLenght - 1)index2 = random.randint(index1, geneLenght - 1)tempGene = p2.gene[index1:index2] # 交叉的基因⽚段newGene = []p1len = 0for g in p1.gene:if p1len == index1:newGene.extend(tempGene) # 插⼊基因⽚段p1len += 1if g not in tempGene:newGene.append(g)p1len += 1return newGene#获取下⼀代def nextGen(self):self.Gen+=1#nextGen代表下⼀代的所有基因nextGen=[]#将最优秀的基因直接传递给下⼀代nextGen.append(self.group.getBest().gene[:])while(len(nextGen)<self.group.GroupSize):pChange=random.random()pCross=random.random()p1=self.group.getOne()if(pCross<self.pCross):p2=self.group.getOne()newGene=self.cross(p1,p2)else:newGene=p1.gene[:]if(pChange<self.pChange):newGene=self.change(newGene)nextGen.append(newGene)self.group.group=[]for gene in nextGen:self.group.group.append(Person(gene))self.group.upDate()#打印当前种群的最优个体信息def showBest(self):print("第{}代\t当前最优{}\t当前平均{}\t".format(self.Gen,1/self.group.getBest().fit,self.group.getAvg())) #n代表代数,遗传算法的⼊⼝def run(self,n):Gen=[] #代数dist=[] #每⼀代的最优距离avgDist=[] #每⼀代的平均距离#上⾯三个列表是为了画图i=1while(i<n):self.nextGen()self.showBest()i+=1Gen.append(i)dist.append(1/self.group.getBest().fit)avgDist.append(self.group.getAvg())#绘制进化曲线plt.plot(Gen,dist,'-r')plt.plot(Gen,avgDist,'-b')plt.show()ga=GA()ga.run(3000)print("进⾏3000代后最优解:",1/ga.group.getBest().fit)1.3实验结果下图是进⾏⼀次实验的结果截图,求出的最优解是11271为避免实验的偶然性,进⾏10次重复实验,并求平均值,结果如下。

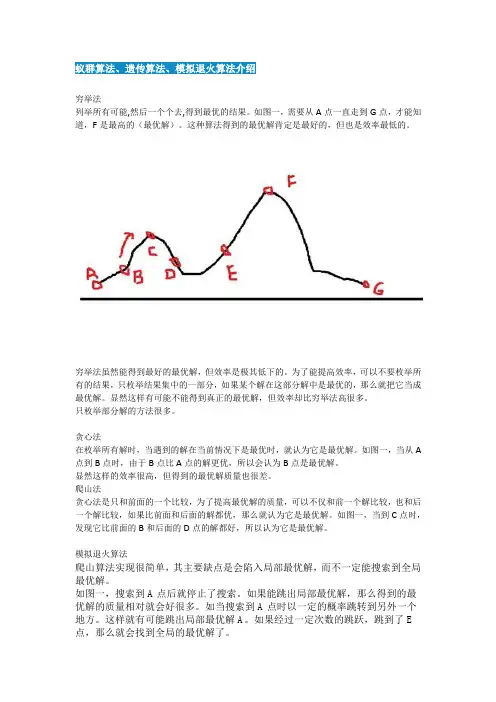

蚁群算法、遗传算法、模拟退火算法介绍穷举法列举所有可能,然后一个个去,得到最优的结果。

如图一,需要从A点一直走到G点,才能知道,F是最高的(最优解)。

这种算法得到的最优解肯定是最好的,但也是效率最低的。

穷举法虽然能得到最好的最优解,但效率是极其低下的。

为了能提高效率,可以不要枚举所有的结果,只枚举结果集中的一部分,如果某个解在这部分解中是最优的,那么就把它当成最优解。

显然这样有可能不能得到真正的最优解,但效率却比穷举法高很多。

只枚举部分解的方法很多。

贪心法在枚举所有解时,当遇到的解在当前情况下是最优时,就认为它是最优解。

如图一,当从A 点到B点时,由于B点比A点的解更优,所以会认为B点是最优解。

显然这样的效率很高,但得到的最优解质量也很差。

爬山法贪心法是只和前面的一个比较,为了提高最优解的质量,可以不仅和前一个解比较,也和后一个解比较,如果比前面和后面的解都优,那么就认为它是最优解。

如图一,当到C点时,发现它比前面的B和后面的D点的解都好,所以认为它是最优解。

模拟退火算法爬山算法实现很简单,其主要缺点是会陷入局部最优解,而不一定能搜索到全局最优解。

如图一,搜索到A点后就停止了搜索。

如果能跳出局部最优解,那么得到的最优解的质量相对就会好很多。

如当搜索到A点时以一定的概率跳转到另外一个地方。

这样就有可能跳出局部最优解A。

如果经过一定次数的跳跃,跳到了E 点,那么就会找到全局的最优解了。

如果这个概率不变,那么就会一直跳跃下去,不会结束。

可以让这个概率逐渐变小,到最后趋于稳定。

这里的概率逐渐减小类似于金属冶炼的退火过程,所以称之为模拟退火算法。

模拟退火算法(Simulated Annealing,SA)最早由Kirkpatrick等应用于组合优化领域,它是基于Mente-Carlo迭代求解策略的一种随机寻优算法,其出发点是基于物理中固体物质的退火过程与一般组合优化问题之间的相似性。

模拟退火算法从某一较高初温出发,伴随温度参数的不断下降,结合概率突跳特性在解空间中随机寻找目标函数的全局最优解,即在局部最优解能概率性地跳出并最终趋于全局最优。

遗传算法蚁群算法粒子群算法模拟退火算法《探究遗传算法、蚁群算法、粒子群算法和模拟退火算法》一、引言遗传算法、蚁群算法、粒子群算法和模拟退火算法是现代优化问题中常用的算法。

它们起源于生物学和物理学领域,被引入到计算机科学中,并在解决各种复杂问题方面取得了良好的效果。

本文将深入探讨这四种算法的原理、应用和优势,以帮助读者更好地理解和应用这些算法。

二、遗传算法1. 概念遗传算法是一种模拟自然选择过程的优化方法,通过模拟生物进化过程,不断改进解决方案以找到最优解。

其核心思想是通过遗传操作(选择、交叉和变异)来优化个体的适应度,从而达到最优解。

2. 应用遗传算法在工程优化、机器学习、生物信息学等领域有着广泛的应用。

在工程设计中,可以利用遗传算法来寻找最优的设计参数,以满足多种约束条件。

3. 优势遗传算法能够处理复杂的多目标优化问题,并且具有全局搜索能力,可以避免陷入局部最优解。

三、蚁群算法1. 概念蚁群算法模拟蚂蚁在寻找食物过程中释放信息素的行为,通过信息素的沉积和蒸发来实现最优路径的搜索。

蚁群算法具有自组织、适应性和正反馈的特点。

2. 应用蚁群算法在路径规划、网络优化、图像处理等领域有着广泛的应用。

在无线传感网络中,可以利用蚁群算法来实现路由优化。

3. 优势蚁群算法适用于大规模问题的优化,具有分布式计算和鲁棒性,能够有效避免陷入局部最优解。

四、粒子群算法1. 概念粒子群算法模拟鸟群中鸟类迁徙时的行为,通过个体间的协作和信息共享来搜索最优解。

每个粒子代表一个潜在解决方案,并根据个体最优和群体最优不断更新位置。

2. 应用粒子群算法在神经网络训练、函数优化、机器学习等领域有着广泛的应用。

在神经网络的权重优化中,可以利用粒子群算法来加速训练过程。

3. 优势粒子群算法对于高维和非线性问题具有较强的搜索能力,且易于实现和调整参数,适用于大规模和复杂问题的优化。

五、模拟退火算法1. 概念模拟退火算法模拟金属退火时的过程,通过接受劣解的概率来跳出局部最优解,逐步降低温度以逼近最优解。

全局优化报告——遗传算法和蚁群算法的比较******学号:**********班级:硕20411遗传算法1.1遗传算法的发展历史遗传算法是一种模拟自然选择和遗传机制的寻优方法。

20世纪60年代初期,Holland教授开始认识到生物的自然遗传现象与人工自适应系统行为的相似性。

他认为不仅要研究自适应系统自身,也要研究与之相关的环境。

因此,他提出在研究和设计人工自适应系统时,可以借鉴生物自然遗传的基本原理,模仿生物自然遗传的基本方法。

1967年,他的学生Bagley在博士论文中首次提出了“遗传算法”一词。

到70年代初,Holland教授提出了“模式定理”,一般认为是遗传算法的基本定理,从而奠定了遗传算法的基本理论。

1975年,Holland出版了著名的《自然系统和人工系统的自适应性》,这是第一本系统论述遗传算法的专著。

因此,也有人把1975年作为遗传算法的诞生年。

1985年,在美国召开了第一届两年一次的遗传算法国际会议,并且成立了国际遗传算法协会。

1989年,Holland的学生Goldberg出版了《搜索、优化和机器学习中的遗传算法》,总结了遗传算法研究的主要成果,对遗传算法作了全面而系统的论述。

一般认为,这个时期的遗传算法从古典时期发展了现代阶段,这本书则奠定了现代遗传算法的基础。

遗传算法是建立在达尔文的生物进化论和孟德尔的遗传学说基础上的算法。

在进化论中,每一个物种在不断发展的过程中都是越来越适应环境,物种每个个体的基本特征被后代所继承,但后代又不完全同于父代,这些新的变化,若适应环境,则被保留下来;否则,就将被淘汰。

在遗传学中认为,遗传是作为一种指令遗传码封装在每个细胞中,并以基因的形式包含在染色体中,每个基因有特殊的位置并控制某个特殊的性质。

每个基因产生的个体对环境有一定的适应性。

基因杂交和基因突变可能产生对环境适应性强的后代,通过优胜劣汰的自然选择,适应值高的基因结构就保存下来。

遗传算法就是模仿了生物的遗传、进化原理,并引用了随机统计原理而形成的。

信息科学中的智能决策模型与算法分析智能决策是信息科学领域中的重要研究方向,它涉及到以人工智能为基础的决策模型和算法的设计与分析。

在当今信息爆炸的时代,人类需要面对海量的数据和信息来做出正确的决策,这就需要智能决策模型和算法的支持。

本文将从智能决策的概念出发,探讨智能决策模型和算法在信息科学中的应用,并进行深入的分析。

一、智能决策的概念智能决策是指利用信息技术和人工智能方法来辅助人们进行决策的过程。

它可以帮助人们从庞大的数据和信息中提取有用的知识,并将其转化为决策的依据。

智能决策模型和算法是实现智能决策的关键,通过识别和利用数据的潜在规律,它们能够自动化地解决决策问题,减少人为因素的干扰,提高决策的准确性和效率。

二、智能决策模型智能决策模型是指对决策问题进行抽象和建模,以便于进行计算和分析的数学模型。

不同的决策问题需要采用不同的智能决策模型来进行描述和求解。

常见的智能决策模型包括机器学习模型、模糊逻辑模型和神经网络模型。

1. 机器学习模型机器学习是一种利用数据和统计方法来构建模型并进行决策的方法。

它通过对大量的样本数据进行学习和训练,自动发现数据中的规律和模式,并将其应用到未知数据的决策中。

常见的机器学习模型包括决策树、支持向量机和深度学习模型。

这些模型在分类、聚类和回归等决策问题中具有广泛的应用。

2. 模糊逻辑模型模糊逻辑是一种能够处理不确定性和模糊性信息的数学工具。

它将模糊的语言和概念用数学的方式进行描述,并利用模糊推理来进行决策。

模糊逻辑模型在模糊决策、模糊控制和模糊优化等问题中得到了广泛的应用。

它能够有效地处理实际决策中存在的模糊和不确定性,提高决策的适应性和鲁棒性。

3. 神经网络模型神经网络是一种模仿生物神经系统结构和功能的数学模型。

它由大量的神经元和它们之间的连接构成,能够以并行的方式进行信息处理和决策。

神经网络模型具有自学习和自适应的能力,通过训练和调整网络的连接权值,它能够将输入信息转化为输出决策。

遗传算法、粒子群算法和蚁群算法都是模拟自然界中某种现象的优化算法,常用于求解各种优化问题。

1. 遗传算法(Genetic Algorithm,GA):遗传算法是一种模拟生物进化过程的优化算法,通过选择、交叉和变异等操作来生成新的解,以达到优化问题的目的。

2. 粒子群算法(Particle Swarm Optimization,PSO):粒子群算法是一种基于群体行为的优化算法,通过粒子间的信息共享和局部搜索来实现全局优化。

3. 蚁群算法(Ant Colony Optimization,ACO):蚁群算法是一种模拟蚂蚁觅食行为的优化算法,通过信息素的作用来实现路径的搜索和优化。

退火算法,蚁群算法,遗传算法1.引言1.1 概述退火算法、蚁群算法和遗传算法都是常见的启发式优化算法,用于解决复杂问题。

这些算法通过模拟自然界中生物的行为或物质的特性,寻找最优解或接近最优解。

退火算法是一种基于物理退火原理的优化算法。

它通过模拟金属在高温下冷却过程中晶格的调整过程,来寻找最优解。

退火算法首先在一个较高的温度下随机生成一个解,然后通过降温过程逐步调整解,并根据一个接受概率在解空间中进行随机搜索。

退火算法具有全局优化能力,可用于解决多种问题,如旅行商问题、图着色问题等。

蚁群算法模拟了蚂蚁在寻找食物时的集体行为。

蚂蚁通过释放信息素与其他蚂蚁进行通信,藉此找到最短路径。

蚁群算法主要包含两个重要步骤:信息素更新和状态转移规则。

信息素更新指的是蚂蚁在路径上释放信息素的过程,而状态转移规则决定了蚂蚁在搜索过程中如何选择路径。

蚁群算法被广泛应用于组合优化问题、路径规划等领域,取得了良好的效果。

遗传算法是模拟生物进化过程的一种优化算法。

它通过模拟自然界中的进化和遗传操作,逐代迭代地搜索最优解。

遗传算法通过编码个体、选择、交叉和变异等操作,形成新的个体,并根据适应度函数评估个体的优劣。

遗传算法以其并行性、全局寻优能力和对问题结构要求不高的特点而被广泛应用于各个领域,如函数优化、机器学习中的特征选取等。

这三种算法都是基于启发式思想的优化方法。

它们可以在解空间中进行搜索,并在搜索过程中逐步优化。

退火算法通过模拟金属冷却过程,蚁群算法通过模拟蚂蚁的集体行为,而遗传算法则模拟了生物的进化过程。

这些算法在不同领域和问题上都取得了较好的效果,为求解复杂问题提供了有效的解决方案。

1.2 文章结构文章结构部分的内容可以包括以下方面的介绍:文章结构本文将会包含三个主要的部分:退火算法、蚁群算法和遗传算法。

每个部分将会包括原理和应用两个小节的介绍。

这些算法是优化问题中常用的启发式算法,它们分别基于不同的思维方式和模拟自然界的现象。