重复数据删除技术-UDSAFE

- 格式:ppt

- 大小:2.69 MB

- 文档页数:37

什么是重复数据删除技术?问:什么是重复数据删除技术?答:一种数据缩减技术,通常用于基于磁盘的备份系统,旨在减少存储系统中使用的存储容量。

它的工作方式是在某个时间周期内查找不同文件中不同位置的重复可变大小数据块。

重复的数据块用指示符取代。

高度冗余的数据集(例如备份数据)从数据重复删除技术的获益极大;用户可以实现10比1至50比1的缩减比。

而且,重复数据删除技术可以允许用户的不同站点之间进行高效,经济的备份数据复制。

重复数据删除In-band和Out-of-band的区别【IT专家网独家】问:我听说基于硬件的重复数据删除产品中有In-band和Out-of-band两种功能,请问这两种功能的区别,哪种更好了?答:首先,让我讲讲基于硬件的重复数据删除产品的好处:基于硬件的重复数据删除产品能减轻与基于软件的重复数据删除产品相关的处理负担。

重复数据删除功能还被融合到其它数据保护硬件中,如备份平台、虚拟磁带库(VTL)系统甚至通用存储系统像网络附加存储(NAS)等。

通常这种方法并不旨在缩小备份窗口或恢复目标,但是一般而言,用户能借此达到最高的压缩级别,从而创造最大的可用存储空间。

至于你提到的In-band和Out-of-band两种更能哪种更好,只能说各有各的优点。

下面是这两种功能的区别和各自的优点:in-band重复数据删除在数据写入存储器时削减数据。

尽管进程处理需要额外的处理能力从而可能扩大备份窗口的大小,但是in-band重复删除是有效率的,因为它只执行一次。

out-of-band重复数据删除是在数据存储完之后执行。

这种方法不会影响备份窗口的大小,并且能缓解对CPU进程处理的关注,从而避免在备份服务器和存储器之间产生瓶颈。

然而,out-of-band重复数据删除在执行过程中使用稍微多一点的磁盘空间。

还有,out-of-band重复数据删除需要花费的时间可能要比实际的备份窗口长。

磁盘竞争是另一个问题,因为用户在重复数据删除过程期间尝试访问存储器,从而降低了磁盘性能。

重复数据删除技术详解(一)在之前的文章“备份系统中的常见功能特性”中简单介绍了下重复数据删除的概念,本文就重复数据删除(也叫数据去重)技术进行深入讲解。

概述重复数据删除(后文简称“重删”)是灾备系统中非常重要的一项能力,它通过删除数据集中的重复数据达到缩减数据量的效果,以此满足日益增长的数据存储需求。

重复数据删除技术在灾备系统中应用十分广泛,当然这项技术本身也不仅仅用于灾备系统,同样应用于存储系统、数据传输和同步、论文查重等场景。

其带来的主要优势包括:•降低数据存储量,节省空间。

•降低网络数据传输量,节省带宽。

•提升存储效率。

•减小备份窗口。

重删基本原理重删的基本原理是通过某种算法计算出数据集中的某部分数据的hash值,以此hash值作为此部分数据的唯一标识(因此也称作指纹)。

当某两部分数据的hash值(指纹)相同时,我们就认为这两部分数据是一致的。

注意:需要尽量确保hash值的唯一性,避免hash值碰撞(即2个不同数据的hash值一致)。

一些厂商为了避免此种情况,可能会采用2种hash算法来确保数据的唯一性。

某些场景下,为了提升效率,还会同时使用强hash和弱hash。

弱hash的计算速度快,但碰撞率高,用于快速找到不同的数据块;强hash的计算速度慢,但碰撞率低(约等于0)。

当2个数据块的弱hash值相同时,会再进行一次强hash值的校验,以此确定数据块内容是否一致。

因为需要对数据进行指纹计算和存储,所以使用重删技术都会需要用到指纹库。

除了指纹库之外,其实还需要记录原数据与实际存储数据之间的映射关系,此种关系一般称为索引信息,有的也叫做元数据信息,元数据信息本文中就不做过多介绍了。

那么如何衡量重复数据删除技术的好坏呢?主要通过两个指标:重复数据删除率和性能。

其中,重复数据删除率(后面简称“重删率”)很大一部分情况下依赖于数据自身的特征。

一般来讲,有固定格式、变化频率低的数据重删率高。

此外,数据量越大,重删率越高;数据切片越小,重删率越高。

重复数据删除技术重复数据删除技术当前,不管是权威机构,还是众厂商,都非常看好重复删除技术。

重复数据删除通过有效地减少数据,消除备份成为降低数据存储成本的重要技术,成为大家关注的焦点。

然而,重复数据删除是否可以在你的存储设备下工作?你如何在海量的数据中应用重复数据删除技术?本专题深入探讨重复数据删除技术,针对各种重复数据删除产中提出评估建议。

为什么需要重复数据删除?随着企业的数据量不断增长,大量的重复数据给存储带来严峻的挑战。

重复数据删除带来了多种好处。

存储量减少,从而降低了存储成本。

这意味着只需更少的磁盘和更低频率的磁盘采购。

更少的数据同时也意味着备份更小。

•重复数据删除迅猛发展•如何通过重复数据删除降低存储成本什么是重复数据删除?重复数据删除,也被称为智能数据压缩或单一实例存储。

它是一种可以减小数据存储需求的手段。

本系列文章将介绍重复数据删除是如何工作的,重复数据删除技术的基本原则和具体实现等相关问题,并列举一些该技术在实际应用中的例子。

•重复数据删除是如何工作的?•确保重复数据删除的高可用性•重复数据删除技术如何缓解存储需求重复数据删除有哪些产品?重复数据删除还是一个新的市场,不同的厂商为客户提供了不同的产品,这也使得实现重复数据删除的方式变得多样化,而客户面临的则是困难的抉择。

让我们来看一下不同的重复数据删除产品及如何评估基于硬件的重复数据删除产品。

•重复数据删除产品一览•如何评估基于硬件的重复数据删除产品•如何评估基于软件的重复数据删除产品重复数据删除技术比较重复数据删除和其他技术有很多相似点和不同点,在这一系列中我们将深入探讨CAS 和重复数据删除,讨论它们的用途并总结这两种技术的优缺点;介绍压缩、重复数据删除和加密的区别,比较和对照in-band(带内)和out-of-band(带外)两种重复数据删除方式,以及它们各自存在的利弊。

•CAS和重复数据删除:归档双雄•压缩、重复数据删除和加密的区别•重复数据删除in-band VS out-of-band重复数据删除迅猛发展存储经理们已经意识到了重复数据删除技术的诸多优点。

重复数据消除技术介绍

为了提高大数据的有效性,去重是一种必要的步骤。

去重技术是一种

从数据集中去掉一些重复项的技术,它的目的是减少数据集中重复出现的项。

去重技术可以有效地缩减数据量,从而提高大数据处理的效率。

去重技术分为基于Hash算法和基于比较算法两大类,其中基于Hash

算法是将具有相同包含特征值的记录哈希到相同的索引位置,然后比较每

个索引位置的记录数。

如果记录数大于1,则表示该索引位置存在重复项,需要将其删除;如果记录数等于1,则表示该索引位置不存在重复项,可

以保留。

相对而言,基于比较算法是将数据集的每一条记录分别与其他记

录进行比较,如果出现相同的特征值,则说明存在重复项,需要将其删除。

去重技术可以有效地缩减大数据集的存储空间和处理时间,因此已经

得到广泛应用。

举例来说,在一些需要存储海量数据的环境中,去重技术

可以有效减少存储空间以及减少读取和处理所需的时间。

此外,在需要找

出有效数据的环境中,去重技术也可以有效筛选有效数据,从而提高数据

处理效率。

另外,去重技术在数据挖掘过程中也得到了广泛的应用,它可以有效

地清除冗余数据。

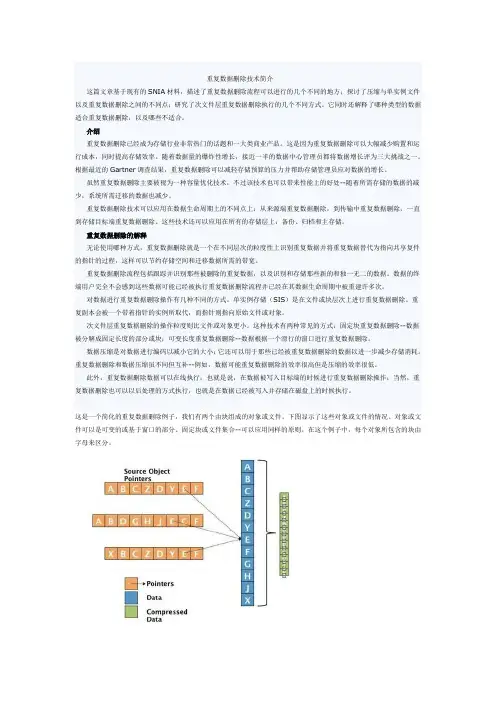

重复数据删除技术简介这篇文章基于现有的SNIA材料,描述了重复数据删除流程可以进行的几个不同的地方;探讨了压缩与单实例文件以及重复数据删除之间的不同点;研究了次文件层重复数据删除执行的几个不同方式。

它同时还解释了哪种类型的数据适合重复数据删除,以及哪些不适合。

介绍重复数据删除已经成为存储行业非常热门的话题和一大类商业产品。

这是因为重复数据删除可以大幅减少购置和运行成本,同时提高存储效率。

随着数据量的爆炸性增长,接近一半的数据中心管理员都将数据增长评为三大挑战之一。

根据最近的Gartner调查结果,重复数据删除可以减轻存储预算的压力并帮助存储管理员应对数据的增长。

虽然重复数据删除主要被视为一种容量优化技术,不过该技术也可以带来性能上的好处--随着所需存储的数据的减少,系统所需迁移的数据也减少。

重复数据删除技术可以应用在数据生命周期上的不同点上:从来源端重复数据删除,到传输中重复数据删除,一直到存储目标端重复数据删除。

这些技术还可以应用在所有的存储层上:备份、归档和主存储。

重复数据删除的解释无论使用哪种方式,重复数据删除就是一个在不同层次的粒度性上识别重复数据并将重复数据替代为指向共享复件的指针的过程,这样可以节约存储空间和迁移数据所需的带宽。

重复数据删除流程包括跟踪并识别那些被删除的重复数据,以及识别和存储那些新的和独一无二的数据。

数据的终端用户完全不会感到这些数据可能已经被执行重复数据删除流程并已经在其数据生命周期中被重建许多次。

对数据进行重复数据删除操作有几种不同的方式。

单实例存储(SIS)是在文件或块层次上进行重复数据删除。

重复副本会被一个带着指针的实例所取代,而指针则指向原始文件或对象。

次文件层重复数据删除的操作粒度则比文件或对象更小。

这种技术有两种常见的方式:固定块重复数据删除--数据被分解成固定长度的部分或块;可变长度重复数据删除--数据根据一个滑行的窗口进行重复数据删除。

数据压缩是对数据进行编码以减小它的大小;它还可以用于那些已经被重复数据删除的数据以进一步减少存储消耗。

删除数据库中重复数据的技巧

一、什么是数据库重复数据

数据库重复数据是指在数据库中出现有多个相同内容的数据,它们可

分为两大类:半重复数据和完全重复数据,其中,半重复数据指可能有一

些差异,比如:存储空间、创建时间或内容存在差异;而完全重复数据指

它们的内容完全一致,它们完全等同于单一的一条数据。

二、数据库重复数据的影响

由于数据库重复数据的出现,会严重影响数据库本身的空间使用、数

据的存储和查询的效率,另外,重复数据的出现也会影响数据的完整性。

1、空间使用率的降低

由于存储了大量的重复数据,数据库空间的使用率会受到严重的影响,从而导致查询、备份和维护性能的下降,以及系统恢复所需时间的增加。

2、影响处理效率

由于大量的重复数据,数据库系统在处理数据和查询时会受到严重影响,从而导致处理效率的降低。

3、影响数据完整性

重复数据会导致数据被重复录入,而这样的数据会影响数据的完整性,由于数据的不同部分存在较大的差异,因此,数据的完整性也会受到一定

程度的影响。

1、建立唯一索引

建立唯一索引是一种比较有效的手段,可以使得表中不允许出现重复数据。

关于“重复数据删除”技术,你还需要知道这些展开全文重复数据删除(De-duplication),简称“去重”,是主流的存储技术之一,通过对比校验技术删除存储设备上重复的数据,只保留其中一份,从而消除冗余数据,优化存储设备的物理空间,从而满足日益增长的数据存储需求。

经过近些年的发展,重复数据删除技术已经很成熟,本文整理了部分知识,有助于大家进一步了解重复数据删除。

一、重复数据删除技术的价值虽然存储介质的价格已经非常廉价,但若能在有限的存储介质上实现更高的存储效率,何乐而不为呢?此外,重复数据删除技术最大的一个收益点是能降低备份大数据量时对各资源的消耗和依赖。

巨量数据的备份不论对生产系统还是备份系统都是一个不小的冲击,况且随着系统的发展,备份系统越来越大,备份的数据越来越多,备份的计划与安排越来越受制于备份数据量的规模。

重复数据删除技术提供了一个物美价廉的解决方案,更提高了整个系统的效率。

也许在很多不太关注重复数据删除技术的工程师心中,重复数据还是那个效率低、成本高的空壳子,但实际上重复数据删除技术早已发展到了一个新的高度。

借个人实施经历中一个真实的案例,看看现如今的重复数据删除技术的性能:一台Windows虚拟机存储着490 GB(有效数据)非结构化文件(文件主要为word/Excel/PPT/PDF 等),日变化量大约15 GB/DAY,虚拟机的配置为2 * 2.8 GHz CPU,8 GB内存,千兆网卡。

部署了一套源端、在线、基于CPU-内存的重复数据删除备份(重复数据删除设备并非物理机而是虚拟机),所有配置均采用默认配置、不作定制优化。

首次备份耗时35 min,消重效率87%,消重时CPU消耗上涨5%,内存占用小于200MB,网络负载约3 MB/S左右。

第二次备份耗时19min,消重效率98%,CPU、内存消耗与首次备份差不多,但网络负载明显下降,偶尔占用1~2MB/S。

(@Li Fei 某保险公司系统架构师)二、主流的几种重复数据删除技术重复数据删除已经不是一个新的话题了,如今各个厂商的存储或备份产品都有这项功能。

重复数据删除技术摘要:近年来,在企业中存储空间的使用往往是惊人的,例如备份数据、文件服务器数据、虚拟化平台数据等。

企业数据量不断增长和数据传输要求也不断地提高,数据中心海量的存储空间和高带宽低延时的传输要求成为当前企业网络存储区域面临了严峻挑战,重复的数据过大过多地保存在存储中,使得存储环境的资源被过渡浪费,同时影响系统的响应时间和网络带宽,如同一份的报表文件占用100M,10个用户将100M的文件存放在文件服务器的不同位置上,这样就占用1000M的空间,其中90%的存储空间被浪费掉。

所有,通过数据重复删除技术,能让特定集内数据高度的冗余性得到提高,同时在大数据时代下提高存储效率和保存更多的数据资源。

关键词:数据重复算法块区1 引言随着社会信息化不断推进,网络时代下的信息存储应用领域越来越广泛,在过去的5年内全球数字化信息量增长了近10倍,企业数据中心的存储需求量越来越庞大,已从之前的GB级向PB级,甚至EB级的需求蔓延。

研究表明,在应用系统所保存的数据中,高达70%的数据是冗余的,而随着时间推移,冗余数据的比例也随之不断上升,为确保能够可靠和长久地保存数据,可能要花费超过10的存储空间和管理成本,与之同时,文件传输的过程中花费的网络带宽资源也高居不下。

因此存储系统中数据高冗余问题受到越来越多研究人员、技术人员的高度关注,如何缩减存储系统数据存储容量已成为一个热门的技术研究课题。

重复数据删除(Data Deduplication)是一种数据缩减技术,智能压缩或单一实例存储,可自动搜索重复数据,将相同数据只保留唯一的一个副本,并使用指向单一副本的指针替换掉其他重复副本,以达到消除冗余数据、降低存储容量需求的存储。

2 重复数据删除技术每一个数据块需要通过散列算法(如MD5 或者SHA-1)为每一个数据产生一个特定的散列值。

将这个散列值与现有的散列值索引相比较,如果它已经存在于索引中,那么这个数据就是重复的,不需要进行存储。

存储系统重复数据删除技术研究综述存储系统中的重复数据是指在存储系统中存在多份相同或非常相似的数据。

重复数据占用了存储空间,增加了存储成本。

同时,重复数据还会降低系统性能,增加数据访问的时间消耗。

因此,重复数据删除是存储系统中一个重要的研究方向。

重复数据删除技术可以分为两大类:基于内容相似度的技术和基于存储位置的技术。

基于内容相似度的技术是通过比较数据的内容,来判断数据是否相似或重复。

这类技术可以进一步细分为基于指纹的技术和基于相似度量的技术。

基于指纹的技术是通过为每个数据生成唯一的指纹,并将指纹存储在索引中来进行重复数据删除的。

常见的指纹生成算法包括MD5、SHA-1等。

基于指纹的技术可以在存储系统中快速检索指纹并进行比对,从而找出重复的数据。

然而,基于指纹的技术由于哈希碰撞的问题,可能会导致误判,即将不同的数据判定为相同的数据。

基于存储位置的技术是通过检查数据的存储位置来判断数据是否重复。

这类技术可以将数据分块存储,并为每个块生成唯一的标识符。

存储系统在写入数据时,可以检查新写入的数据块是否已经存在于存储系统中。

如果存在,则只需记录数据的位置信息,而无需将数据块写入磁盘。

基于存储位置的技术能够高效地删除重复数据,并且可以支持在线重复数据删除,即在数据写入过程中进行删除。

除了以上三类技术,还有一些辅助技术可以与重复数据删除技术结合使用,以提高效果。

例如,压缩算法可以在数据写入时对数据进行压缩,并将压缩后的数据进行存储,从而减少存储空间的占用。

数据分块技术可以将数据拆分成多个较小的块,并进行索引,以提高检索效率。

综上所述,重复数据删除是存储系统中一个重要的研究方向。

各种不同的技术可以用于判断数据是否相似或重复,并进行删除。

在实际应用中,需要根据不同的需求和场景选择合适的技术,并结合辅助技术以提高效果。

随着存储系统的发展,重复数据删除技术将会得到进一步的改进和完善。

重复数据删除的工作原理作者:杨涛就在几年前,一提起备份大家就自然而然地想到磁带,但是在数据量爆炸式增长的今天,磁带技术由于其性能以及可靠性方面的固有缺陷变得越来越不能满足不断变化的业务需求,加之磁盘设备价格的下降,所以有越来越多的用户采用磁盘备份的解决方案。

但这在解决了性能和可靠性问题的同时又引入了新的问题——磁盘不能够象磁盘那样离线保存,不可能无限制的扩充容量,而用户数据增长的趋势却是无限的,并且由于其不能离线保存也导致了远程容灾数据的传送需要占用大量的带宽,这些都在经济上给用户造成了极大的压力。

那么有没有办法来缓解甚至解决这种磁盘容量的有限性和数据增长的无限性造成的矛盾呢?答案是“重复数据删除(Data de-duplication)”技术。

“重复数据删除”也称为“单实例存储(Single Instance Repository,简称SIR)”或者容量优化(Capacity Optimization),顾名思义,其根本作用是消减存储中的重复数据,以使任何一份数据只保存一份实例,达到充分利用存储空间的目的。

它是近年存储领域涌现出来的一门新兴技术,各大竞争厂商都生成其重复删除比可以达到1:20 左右甚至更高,被专家誉为是一种“将会改写存储行业的经济规则”的技术。

然而在实际和用户的接触中,大多数用户对该技术还存在许多疑问,诸如:“和增量备份有何区别”、“会不会造成数据损害”、“会不会影响备份性能”等等。

所以,在这里我们就详细探讨一下重复数据删除的工作原理。

首先,“重复数据删除”和“增量备份”是完全不同的概念。

“增量备份”是指只备份变化的文件;“重复数据删除”则是指只备份不重复的数据。

举个简单的例子说明它们的区别:比如有一个文件型数据库Access的文件finance..mdb ,如果向该库中新插入了几笔记录,那么则意味着该文件发生了变动。

当采用增量备份时会检查该文件的标志位,并将该文件整个重新备份;而如果使用“重复数据删除”技术,则只会备份新插入记录的数据。

重复数据删除进入主存储重复数据删除技术(De-Duplication)通过去除冗余数据来减少数据容量,由于其对磁盘存储使用量的有效降低,显著减少了磁盘存储的需求和能耗,从而降低了磁盘存储的购买成本和使用成本,目前已成为众多存储厂商追逐的目标。

重复数据删除技术自出现至今,几乎都是应用于数据备份和归档等二级存储,而没有应用在主存储中。

这是因为一般重复数据删除技术都是通过软件实现的,它势必会对系统的性能带来不可避免的影响,降低数据存储和读取的速度,而应用系统对主存储中的数据读取速度通常比数据备份时的要求要高得多。

因此,迄今,具有重复数据删除技术的存储产品一般都是针对备份应用的。

不过,近日Hifn公司打破了这一局面,推出了针对Windows服务器的重复数据删除解决方案,使重复数据删除技术不再受应用所限,正式进入主存储应用中。

日前,记者独家采访了Hifn公司亚太区副总裁杨钦铭,详细了解了Hifn 解决方案的特色和优势以及产品策略。

杨钦铭介绍说,Hifn公司推出的BitWackr 250和255高级数据缩减解决方案,使服务器OEM厂商、微软合作伙伴和装机商可以为Windows服务器增加硬件辅助型重复数据删除、数据压缩以及自动精简配置等功能。

服务器安装了BitWackr后,能与NAS、SharePoint、数据保护管理器(DPM)等受益于重复数据删除功能最多的Windows应用程序实现无缝集成。

据了解,Hifn公司在数据加密和数据压缩方面颇具特色,有多项专利技术,正是这些优势帮助了Hifn重复数据删除产品的诞生。

Hifn公司的这项专利技术能够提供实时、在线重复数据删除和数据压缩功能,从而减少写入磁盘的数据。

作为业内首款可以在数据产生时就能进行缩减的容量优化解决方案,BitWackr 250和255可以大大减少企业存储的成本,例如,减少了磁盘容量需求和采购,延长了现有存储设备的使用寿命,提升了投资回报(ROI),减少对存储设备的管理,降低散热和冷却开支以及减少功耗等。

1.1.1.1 重复数据删除重复数据删除〔DeduD5/SHA1等Hash算法为数据块计算指纹〔FP, Fingerprint〕。

可以同时使用两种及以上hash算法计算数据指纹,以获得非常小的数据碰撞发生概率。

具有相同指纹的数据块即可认为是相同的数据块,存储系统中仅需要保存一份。

这样,一个物理文件在存储系统就对应一个逻辑表示,由一组FP组成的元数据。

当进行读取文件时,先读取逻辑文件,然后根据FP序列,从存储系统中取出相应数据块,复原物理文件副本。

Dedupe技术可以帮助众多应用降低数据存储量,节省网络带宽,提高存储效率,减小备份窗口,有效节省本钱。

Dedupe 技术目前最成功的应用领域是数据备份、容灾和归档系统,然而事实上dedupe技术可以用于很多场合,包括在线数据、近线数据、离线数据存储系统,可以在文件系统、卷管理器、NAS、SAN中实施。

Dedupe也可以用数据传输与同步,作为一种数据压缩技术可用于数据打包。

为什么dedupe技术最成功的应用是数据备份领域,而其他领域应用很少呢?这主要由两方面的原因决定的,一是数据备份应用对数据进行屡次备份后,存在大量重复数据,非常适合这种技术。

二是dedupe技术的缺陷,主要是数据平安、性能。

Dedupe使用hash指纹来识别相同数据,存在产生数据碰撞并导致数据不一致性的可能性。

Dedupe需要进行数据块切分、数据块指纹计算和数据块检索,消耗可观的系统资源,对存储系统性能产生影响。

信息呈现的指数级增长方式给存储容量带来巨大的压力,而dedupe是最为行之有效的解决方案,因此固然其在性能和平安方面有一定的缺乏,它大行其道的技术趋势无法改变。

更低碰撞概率的hash函数、多核、GPU、SSD等,这些技术推动dedupe走向成熟,由作为一种产品而转向作为一种功能,逐渐应用到近线和在线存储系统。

ZFS已经原生地支持dedupe技术,我们相信将会不断有更多的文件系统、存储系统支持这一功能。

重复数据删除技术的发展及应用摘要:重复数据删除技术包括相同数据重复数据删除技术和相似数据重复数据删除技术。

相同数据重复数据删除技术主要有:相同文件重复数据删除技术、固定长度分块的重复数据删除技术、基于内容分块(CDC)的重复数据删除技术、基于滑动块的重复数据删除技术和基于数据特征的重复数据消除算法等。

重复数据删除技术适合应用于数据备份系统、归档存储系统、远程灾备系统等场合。

关键词:重复数据删除;存储;智能压缩Abstract:Data de-duplication technology can be used to de-duplicate instances of the same data or similar data. Same data de-duplication includes de-duplication of fixed-length blocks, Content Defined Chunking (CDC), sliding blocks, and characteristic-based elimination of duplicate data algorithm. This technology is especially applicable in data backup systems, archival storage systems, and remote disaster recovery systems.Key words:data de-duplication; storage; intelligent compression重复数据删除也称为智能压缩或单一实例存储,是一种可自动搜索重复数据,将相同数据只保留唯一的一个副本,并使用指向单一副本的指针替换掉其他重复副本,以达到消除冗余数据、降低存储容量需求的存储技术。

本文首先从不同角度介绍重复数据删除技术的分类,然后分别介绍相同数据重复数据删除技术和相似数据重复数据删除技术,并介绍重复数据消除的性能提升方法,最后分析重复数据技术的应用场景。