gensim计算词语相似度公式

- 格式:docx

- 大小:37.07 KB

- 文档页数:3

gensim计算词语相似度原理

gensim的词语相似度计算,是基于潜在语义分析(Latent Semantic Analysis, LSA)的原理来实现的。

基本原理是,将词语映射到多维空间中,然后计算每个词语之间的相似度。

gensim的LSA算法,采用TF-IDF模型,将文档中出现的单词映射到潜在的多维空间中。

TF-IDF模型是一种用来评价某一语料库中某一文档对该语料库中其他文档的重要程度的指标。

它由两部分组成:

1、Term Frequency(TF): 即词频,是指某一个词在文档中出现的频率。

2、Inverse Document Frequency(IDF): 即逆文档频率,是指在语料库中,一个词在一个或多个文档中出现的概率,也就是该词在文档中出现的频率越高,就越不重要;而文档中出现的频率越低,就越重要。

使用TF-IDF模型将单词映射到一个n维空间后,每个单词都可以看做是一个n维矢量,那么两个单词的相似度,就可以用他们之间空间距离来衡量,比如余弦相似度:

cos(vectorA, vectorB) = vectorA · vectorB / (||vectorA|| * ||vectorB||)

即两个词语的相似度为他们的空间向量相乘再除以他们的向量

长度的乘积。

通过以上方法,gensim可以计算出文档中不同单词之间的相似

度,从而推断出文档等同语句的内容。

gensim计算相似句一、引言随着社交媒体和互联网的普及,人们产生的文本数据量不断增加。

如何从这些海量的文本中快速准确地找到相似的句子或文档就成为了一个重要的问题。

gensim是一个用于主题建模和文本相似度计算的Python库,它提供了一种简单有效的方法来计算相似句。

二、准备工作在使用gensim之前,我们需要进行一些准备工作。

首先,我们需要安装gensim库,可以使用pip命令进行安装。

其次,我们需要准备一些文本数据作为计算相似句的输入。

这些数据可以是一篇文章、一段对话或者一组评论等。

接下来,我们需要对这些文本进行预处理,包括分词、去停用词、词干化等操作。

最后,我们需要将预处理后的文本转换成gensim可以处理的格式,一般使用词袋模型或者TF-IDF模型。

三、计算相似句有了准备工作的基础,我们就可以开始计算相似句了。

gensim提供了多种计算相似句的方法,包括基于词袋模型的相似句计算、基于TF-IDF模型的相似句计算以及基于Word2Vec模型的相似句计算。

1. 基于词袋模型的相似句计算词袋模型是一种简单有效的文本表示方法,它将文本表示为一个向量,向量的每个维度代表一个词的出现次数或者TF-IDF值。

在gensim中,我们可以使用TfidfModel或者LsiModel来构建词袋模型。

下面是一个示例代码,演示了如何使用词袋模型计算相似句:```pythonfrom gensim import corpora, models, similarities# 准备文本数据documents = ["我爱北京天安门", "我爱北京故宫", "我爱上海外滩"]# 分词texts = [[word for word in document.split()] for document in documents]# 构建词袋模型dictionary = corpora.Dictionary(texts)corpus = [dictionary.doc2bow(text) for text in texts]# 计算相似句tfidf = models.TfidfModel(corpus)index = similarities.SparseMatrixSimilarity(tfidf[corpus], num_features=len(dictionary))query = "我爱北京天安门"query_bow = dictionary.doc2bow(query.split())sims = index[tfidf[query_bow]]# 输出相似句for i, sim in enumerate(sims):print("句子{}与查询句的相似度为:{}".format(i, sim))```2. 基于TF-IDF模型的相似句计算TF-IDF模型是一种常用的文本表示方法,它将文本表示为一个向量,向量的每个维度代表一个词的TF-IDF值。

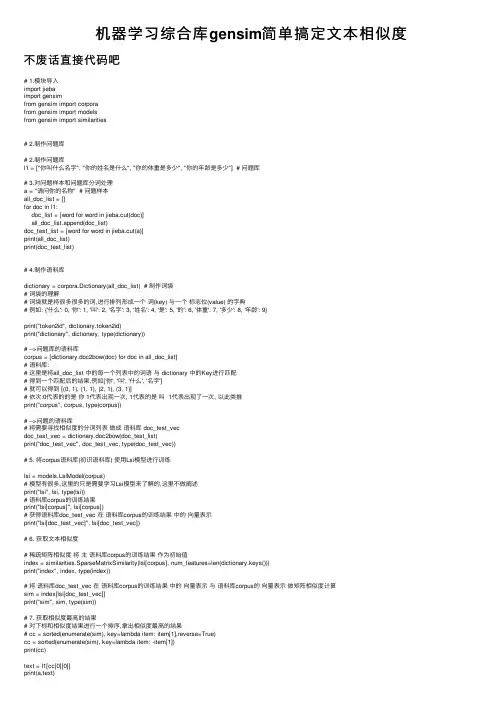

机器学习综合库gensim简单搞定⽂本相似度不废话直接代码吧# 1.模块导⼊import jiebaimport gensimfrom gensim import corporafrom gensim import modelsfrom gensim import similarities# 2.制作问题库# 2.制作问题库l1 = ["你叫什么名字", "你的姓名是什么", "你的体重是多少", "你的年龄是多少"] # 问题库# 3.对问题样本和问题库分词处理a = "请问你的名称" # 问题样本all_doc_list = []for doc in l1:doc_list = [word for word in jieba.cut(doc)]all_doc_list.append(doc_list)doc_test_list = [word for word in jieba.cut(a)]print(all_doc_list)print(doc_test_list)# 4.制作语料库dictionary = corpora.Dictionary(all_doc_list) # 制作词袋# 词袋的理解# 词袋就是将很多很多的词,进⾏排列形成⼀个词(key) 与⼀个标志位(value) 的字典# 例如: {'什么': 0, '你': 1, '叫': 2, '名字': 3, '姓名': 4, '是': 5, '的': 6, '体重': 7, '多少': 8, '年龄': 9}print("token2id", dictionary.token2id)print("dictionary", dictionary, type(dictionary))# -->问题库的语料库corpus = [dictionary.doc2bow(doc) for doc in all_doc_list]# 语料库:# 这⾥是将all_doc_list 中的每⼀个列表中的词语与 dictionary 中的Key进⾏匹配# 得到⼀个匹配后的结果,例如['你', '叫', '什么', '名字']# 就可以得到 [(0, 1), (1, 1), (2, 1), (3, 1)]# 依次:0代表的的是你 1代表出现⼀次, 1代表的是叫 1代表出现了⼀次, 以此类推print("corpus", corpus, type(corpus))# -->问题的语料库# 将需要寻找相似度的分词列表做成语料库 doc_test_vecdoc_test_vec = dictionary.doc2bow(doc_test_list)print("doc_test_vec", doc_test_vec, type(doc_test_vec))# 5. 将corpus语料库(初识语料库) 使⽤Lsi模型进⾏训练lsi = models.LsiModel(corpus)# 模型有很多,这⾥的只是需要学习Lsi模型来了解的,这⾥不做阐述print("lsi", lsi, type(lsi))# 语料库corpus的训练结果print("lsi[corpus]", lsi[corpus])# 获得语料库doc_test_vec 在语料库corpus的训练结果中的向量表⽰print("lsi[doc_test_vec]", lsi[doc_test_vec])# 6. 获取⽂本相似度# 稀疏矩阵相似度将主语料库corpus的训练结果作为初始值index = similarities.SparseMatrixSimilarity(lsi[corpus], num_features=len(dictionary.keys()))print("index", index, type(index))# 将语料库doc_test_vec 在语料库corpus的训练结果中的向量表⽰与语料库corpus的向量表⽰做矩阵相似度计算sim = index[lsi[doc_test_vec]]print("sim", sim, type(sim))# 7. 获取相似度最⾼的结果# 对下标和相似度结果进⾏⼀个排序,拿出相似度最⾼的结果# cc = sorted(enumerate(sim), key=lambda item: item[1],reverse=True)cc = sorted(enumerate(sim), key=lambda item: -item[1])print(cc)text = l1[cc[0][0]]print(a,text)。

gensim库中coherencemodel()计算算法1. 引言1.1 概述本文将介绍gensim库中的coherencemodel()计算算法。

gensim是一个用于主题建模和文档相似度比较的Python库,其提供了丰富的功能和工具来帮助研究人员和开发者处理自然语言处理任务。

其中,coherencemodel()是gensim 库的一个重要功能,它用于评估主题模型的连贯性。

1.2 文章结构本文将分为五个部分来进行讲解。

首先,在引言部分,我们将对文章进行概述,并介绍文章结构。

然后,在第二部分中,我们将详细介绍gensim库以及coherencemodel()的功能和作用。

接下来,在第三部分中,我们将探讨coherencemodel()算法的实现方法和参数调整策略。

在第四部分中,我们将通过应用场景和案例研究来展示gensim库coherencemodel()在实际项目中的应用价值。

最后,在结论部分,我们将总结评估coherencemodel()算法,并展望其未来发展与应用前景。

1.3 目的本文旨在向读者介绍并深入理解gensim库中coherencemodel()计算算法的原理、实现方法以及在自然语言处理任务中的应用。

通过对coherencemodel()算法的学习和掌握,读者可以更好地评估主题模型的连贯性,并将其应用于相关领域中的实际项目中去。

这将有助于改善主题模型的效果并提升研究人员和开发者在自然语言处理领域的工作效率。

2. gensim库中coherencemodel()计算算法2.1 gensim库简介Gensim是一个用于主题建模和自然语言处理的Python库。

它提供了许多功能来处理文本数据,其中包括coherencemodel()函数。

Gensim的设计目标是高效地处理大规模文本数据集,并提供方便的工具来构建和评估主题模型。

2.2 coherencemodel()功能介绍coherencemodel()函数是Gensim库中用于计算主题模型一致性的方法。

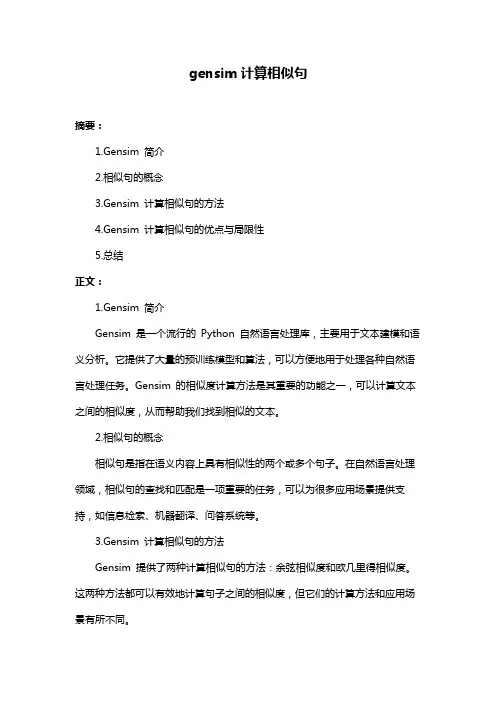

gensim计算相似句摘要:1.Gensim 简介2.相似句的概念3.Gensim 计算相似句的方法4.Gensim 计算相似句的优点与局限性5.总结正文:1.Gensim 简介Gensim 是一个流行的Python 自然语言处理库,主要用于文本建模和语义分析。

它提供了大量的预训练模型和算法,可以方便地用于处理各种自然语言处理任务。

Gensim 的相似度计算方法是其重要的功能之一,可以计算文本之间的相似度,从而帮助我们找到相似的文本。

2.相似句的概念相似句是指在语义内容上具有相似性的两个或多个句子。

在自然语言处理领域,相似句的查找和匹配是一项重要的任务,可以为很多应用场景提供支持,如信息检索、机器翻译、问答系统等。

3.Gensim 计算相似句的方法Gensim 提供了两种计算相似句的方法:余弦相似度和欧几里得相似度。

这两种方法都可以有效地计算句子之间的相似度,但它们的计算方法和应用场景有所不同。

(1)余弦相似度:余弦相似度是一种广泛应用于文本相似度计算的方法,它通过计算两个向量的夹角余弦值来度量它们之间的相似度。

余弦相似度的值范围在-1 到1 之间,值越接近1 表示两个向量越相似。

Gensim 中的`cosine_similarity`函数可以用于计算余弦相似度。

(2)欧几里得相似度:欧几里得相似度是一种基于向量长度和向量内积的相似度度量方法。

它计算两个向量的欧几里得距离与它们长度的乘积,用以衡量它们之间的相似度。

Gensim 中的`euclidean_similarity`函数可以用于计算欧几里得相似度。

4.Gensim 计算相似句的优点与局限性(1)优点:Gensim 提供的相似度计算方法具有较高的准确性和可靠性,可以较好地反映句子之间的语义相似性。

此外,Gensim 还支持预训练模型,可以加速计算过程。

(2)局限性:Gensim 的相似度计算方法主要基于向量空间模型,对于一些复杂的语义关系和多义词处理能力有限。

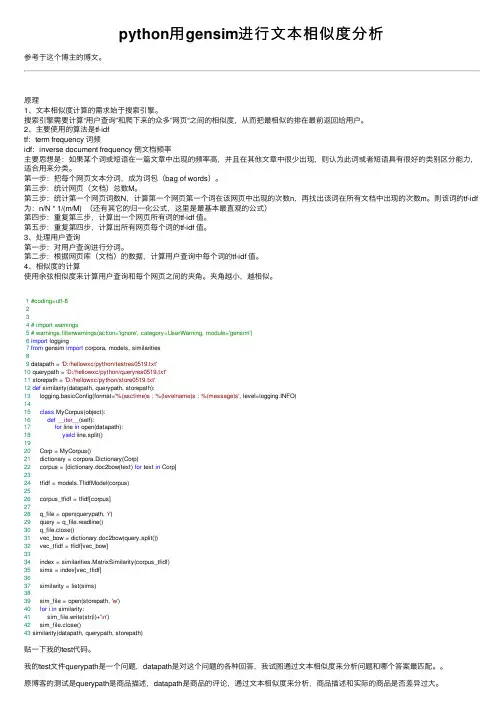

python⽤gensim进⾏⽂本相似度分析参考于这个博主的博⽂。

原理1、⽂本相似度计算的需求始于搜索引擎。

搜索引擎需要计算“⽤户查询”和爬下来的众多”⽹页“之间的相似度,从⽽把最相似的排在最前返回给⽤户。

2、主要使⽤的算法是tf-idftf:term frequency 词频idf:inverse document frequency 倒⽂档频率主要思想是:如果某个词或短语在⼀篇⽂章中出现的频率⾼,并且在其他⽂章中很少出现,则认为此词或者短语具有很好的类别区分能⼒,适合⽤来分类。

第⼀步:把每个⽹页⽂本分词,成为词包(bag of words)。

第三步:统计⽹页(⽂档)总数M。

第三步:统计第⼀个⽹页词数N,计算第⼀个⽹页第⼀个词在该⽹页中出现的次数n,再找出该词在所有⽂档中出现的次数m。

则该词的tf-idf 为:n/N * 1/(m/M) (还有其它的归⼀化公式,这⾥是最基本最直观的公式)第四步:重复第三步,计算出⼀个⽹页所有词的tf-idf 值。

第五步:重复第四步,计算出所有⽹页每个词的tf-idf 值。

3、处理⽤户查询第⼀步:对⽤户查询进⾏分词。

第⼆步:根据⽹页库(⽂档)的数据,计算⽤户查询中每个词的tf-idf 值。

4、相似度的计算使⽤余弦相似度来计算⽤户查询和每个⽹页之间的夹⾓。

夹⾓越⼩,越相似。

1#coding=utf-8234# import warnings5# warnings.filterwarnings(action='ignore', category=UserWarning, module='gensim')6import logging7from gensim import corpora, models, similarities89 datapath = 'D:/hellowxc/python/testres0519.txt'10 querypath = 'D:/hellowxc/python/queryres0519.txt'11 storepath = 'D:/hellowxc/python/store0519.txt'12def similarity(datapath, querypath, storepath):13 logging.basicConfig(format='%(asctime)s : %(levelname)s : %(message)s', level=)1415class MyCorpus(object):16def__iter__(self):17for line in open(datapath):18yield line.split()1920 Corp = MyCorpus()21 dictionary = corpora.Dictionary(Corp)22 corpus = [dictionary.doc2bow(text) for text in Corp]2324 tfidf = models.TfidfModel(corpus)2526 corpus_tfidf = tfidf[corpus]2728 q_file = open(querypath, 'r')29 query = q_file.readline()30 q_file.close()31 vec_bow = dictionary.doc2bow(query.split())32 vec_tfidf = tfidf[vec_bow]3334 index = similarities.MatrixSimilarity(corpus_tfidf)35 sims = index[vec_tfidf]3637 similarity = list(sims)3839 sim_file = open(storepath, 'w')40for i in similarity:41 sim_file.write(str(i)+'\n')42 sim_file.close()43 similarity(datapath, querypath, storepath)贴⼀下我的test代码。

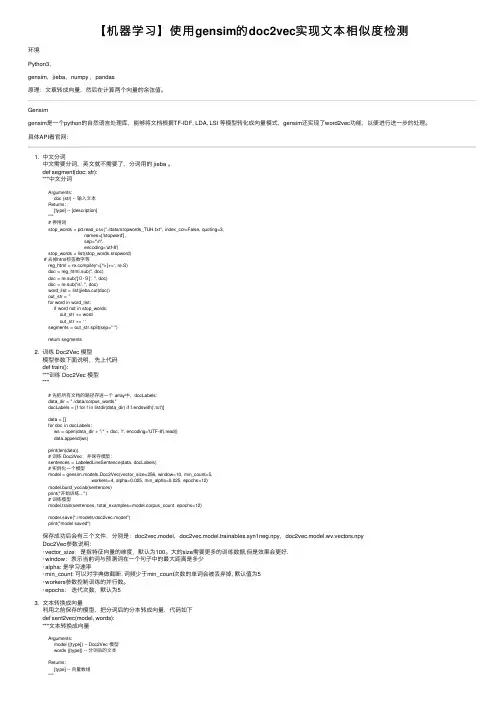

【机器学习】使⽤gensim的doc2vec实现⽂本相似度检测环境Python3,gensim,jieba,numpy ,pandas原理:⽂章转成向量,然后在计算两个向量的余弦值。

Gensimgensim是⼀个python的⾃然语⾔处理库,能够将⽂档根据TF-IDF, LDA, LSI 等模型转化成向量模式,gensim还实现了word2vec功能,以便进⾏进⼀步的处理。

具体API看官⽹:1. 中⽂分词中⽂需要分词,英⽂就不需要了,分词⽤的 jieba 。

def segment(doc: str):"""中⽂分词Arguments:doc {str} -- 输⼊⽂本Returns:[type] -- [description]"""# 停⽤词stop_words = pd.read_csv("./data/stopwords_TUH.txt", index_col=False, quoting=3,names=['stopword'],sep="\n",encoding='utf-8')stop_words = list(stop_words.stopword)# 去掉html标签数字等reg_html = pile(r'<[^>]+>', re.S)doc = reg_html.sub('', doc)doc = re.sub('[0-9]', '', doc)doc = re.sub('\s', '', doc)word_list = list(jieba.cut(doc))out_str = ''for word in word_list:if word not in stop_words:out_str += wordout_str += ' 'segments = out_str.split(sep=" ")return segments2. 训练 Doc2Vec 模型模型参数下⾯说明,先上代码def train():"""训练 Doc2Vec 模型"""# 先把所有⽂档的路径存进⼀个 array中,docLabels:data_dir = "./data/corpus_words"docLabels = [f for f in listdir(data_dir) if f.endswith('.txt')]data = []for doc in docLabels:ws = open(data_dir + "/" + doc, 'r', encoding='UTF-8').read()data.append(ws)print(len(data))# 训练 Doc2Vec,并保存模型:sentences = LabeledLineSentence(data, docLabels)# 实例化⼀个模型model = gensim.models.Doc2Vec(vector_size=256, window=10, min_count=5,workers=4, alpha=0.025, min_alpha=0.025, epochs=12)model.build_vocab(sentences)print("开始训练...")# 训练模型model.train(sentences, total_examples=model.corpus_count, epochs=12)model.save("./models/doc2vec.model")print("model saved")保存成功后会有三个⽂件,分别是:doc2vec.model,doc2vec.model.trainables.syn1neg.npy,doc2vec.model.wv.vectors.npyDoc2Vec参数说明:· vector_size:是指特征向量的维度,默认为100。

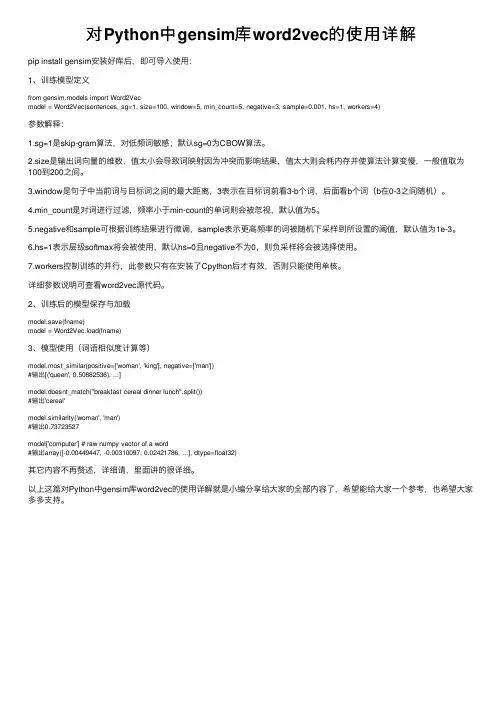

对Python中gensim库word2vec的使⽤详解pip install gensim安装好库后,即可导⼊使⽤:1、训练模型定义from gensim.models import Word2Vecmodel = Word2Vec(sentences, sg=1, size=100, window=5, min_count=5, negative=3, sample=0.001, hs=1, workers=4)参数解释:1.sg=1是skip-gram算法,对低频词敏感;默认sg=0为CBOW算法。

2.size是输出词向量的维数,值太⼩会导致词映射因为冲突⽽影响结果,值太⼤则会耗内存并使算法计算变慢,⼀般值取为100到200之间。

3.window是句⼦中当前词与⽬标词之间的最⼤距离,3表⽰在⽬标词前看3-b个词,后⾯看b个词(b在0-3之间随机)。

4.min_count是对词进⾏过滤,频率⼩于min-count的单词则会被忽视,默认值为5。

5.negative和sample可根据训练结果进⾏微调,sample表⽰更⾼频率的词被随机下采样到所设置的阈值,默认值为1e-3。

6.hs=1表⽰层级softmax将会被使⽤,默认hs=0且negative不为0,则负采样将会被选择使⽤。

7.workers控制训练的并⾏,此参数只有在安装了Cpython后才有效,否则只能使⽤单核。

详细参数说明可查看word2vec源代码。

2、训练后的模型保存与加载model.save(fname)model = Word2Vec.load(fname)3、模型使⽤(词语相似度计算等)model.most_similar(positive=['woman', 'king'], negative=['man'])#输出[('queen', 0.50882536), ...]model.doesnt_match("breakfast cereal dinner lunch".split())#输出'cereal'model.similarity('woman', 'man')#输出0.73723527model['computer'] # raw numpy vector of a word#输出array([-0.00449447, -0.00310097, 0.02421786, ...], dtype=float32)其它内容不再赘述,详细请,⾥⾯讲的很详细。

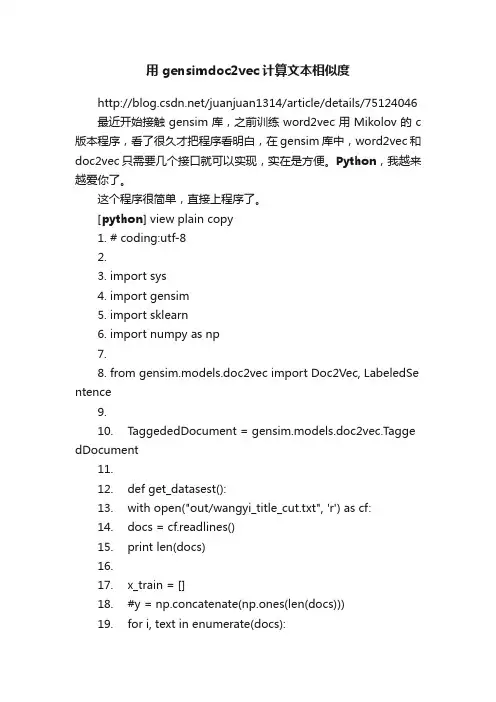

用gensimdoc2vec计算文本相似度/juanjuan1314/article/details/75124046 最近开始接触gensim库,之前训练word2vec用Mikolov的c 版本程序,看了很久才把程序看明白,在gensim库中,word2vec和doc2vec只需要几个接口就可以实现,实在是方便。

Python,我越来越爱你了。

这个程序很简单,直接上程序了。

[python] view plain copy1.# coding:utf-82.3.import sys4.import gensim5.import sklearn6.import numpy as np7.8.from gensim.models.doc2vec import Doc2Vec, LabeledSe ntence9.10.TaggededDocument = gensim.models.doc2vec.Tagge dDocument11.12.def get_datasest():13.with open("out/wangyi_title_cut.txt", 'r') as cf:14.docs = cf.readlines()15.print len(docs)16.17.x_train = []18.#y = np.concatenate(np.ones(len(docs)))19.for i, text in enumerate(docs):20.word_list = text.split(' ')21.l = len(word_list)22.word_list[l-1] = word_list[l-1].strip()23.document = TaggededDocument(word_list, tags=[i])24.x_train.append(document)25.26.return x_train27.28.def getVecs(model, corpus, size):29.vecs = [np.array(model.docvecs[z.tags[0]].reshape(1, si ze)) for z in corpus]30.return np.concatenate(vecs)31.32.def train(x_train, size=200, epoch_num=1):33.model_dm = Doc2Vec(x_train,min_count=1, window = 3, size = size, sample=1e-3, negative=5, workers=4)34.model_dm.train(x_train, total_examples=model_dm.co rpus_count, epochs=70)35.model_dm.save('model/model_dm_wangyi')36.37.return model_dm38.39.def test():40.model_dm = Doc2Vec.load("model/model_dm_wangyi ")41.test_text = ['《', '舞林', '争霸' '》', '十强' '出炉', '复活', '舞者', '澳门', '踢馆']42.inferred_vector_dm = model_dm.infer_vector(test_text )43.print inferred_vector_dm44.sims = model_dm.docvecs.most_similar([inferred_vect or_dm], topn=10)45.46.47.return sims48.49.if __name__ == '__main__':50.x_train = get_datasest()51.model_dm = train(x_train)52.53.sims = test()54.for count, sim in sims:55.sentence = x_train[count]56.words = ''57.for word in sentence[0]:58.words = words + word + ' '59.print words, sim, len(sentence[0])我用了网页的热门娱乐新闻标题作为训练语料,输出结果如下,不知道是迭代次数不够还是怎么的,相似度都很低,不过语料只有4w 条,且都是各式各样的八卦,很相似的句子确实少。

gensim库中coherencemodel()计算算法摘要:1.介绍gensim库2.coherencemodel()函数的作用3.计算算法原理4.参数说明5.使用示例6.总结正文:Gensim库是一个用于主题模型研究的Python库,它提供了许多高效的算法和工具,帮助我们更好地理解和分析大规模文本数据。

其中,coherencemodel()函数是用于计算文本的coherence值,这是一种衡量文本内容连贯性的指标。

coherencemodel()函数的主要作用是根据给定的文本数据,计算出一个描述文本主题的向量,然后计算这个向量与原始文本之间的相似度,得到一个介于-1和1之间的coherence值。

这个值越接近1,表示文本的主题越明确,内容越连贯;越接近-1,表示文本的主题越模糊,内容越不连贯。

coherencemodel()函数的计算算法主要基于Latent Semantic Analysis (LSA)和Generalized LR(GLR)算法。

LSA是一种用于提取文本语义信息的方法,它通过将文本映射到一个高维空间,使得相似的文本在这个空间中距离较近。

GLR算法则是一种用于计算两个向量之间夹角的方法,它可以用来衡量两个向量之间的相似度。

在使用coherencemodel()函数时,我们需要提供一组文本数据作为输入,以及一个模型作为参数。

模型可以是gensim库中提供的任何主题模型,例如LDA、LSA等。

此外,我们还可以选择性地提供一些其他参数,如num_topics(主题数量)、chunksize(分块大小)等,以控制计算过程的性能和精度。

以下是一个使用coherencemodel()函数的示例:```pythonfrom gensim import corporafrom gensim.models import LdaModelfrom gensim.test.utils import datapath# 加载数据dictionary = corpora.Dictionary.load(datapath("test_corpus.dict")) corpus = corpora.MongoCorpus.load(datapath("test_corpus.mm")) # 训练LDA模型um_topics = 2lda_model = LdaModel(corpus, num_topics=num_topics,id2word=dictionary, passes=10)# 计算coherence值coherence = lda_model.coherence_model()print("Coherence:", coherence)```总之,gensim库中的coherencemodel()函数是一个强大的工具,可以帮助我们评估文本数据的连贯性。

gensim是一个用于自然语言处理的Python库,它提供了一些便捷的工具用于处理文本数据,其中包括计算词语相似度的功能。

在gensim 中,词语相似度的计算是基于词向量的,而词向量又是通过Word2Vec等模型得到的。

词语相似度的计算在自然语言处理中有着广泛的应用,比如在信息检索、推荐系统等领域。

因此了解gensim中的词语相似度计算公式对于从事自然语言处理工作的人来说是非常重要的。

在gensim中,词语相似度的计算可以使用`gensim.models.KeyedVectors.similarity`方法,该方法接受两个词语作为参数,并返回它们的相似度分数。

具体来说,该方法是通过计算两个词向量的余弦相似度来实现的。

余弦相似度是一种常用的相似度度量方法,它可以衡量两个向量在方向上的相似程度,取值范围在-1到1之间,其中1表示完全相似,-1表示完全不相似。

下面是gensim计算词语相似度的公式:1. 导入gensim库```pythonimport gensim```2. 加载训练好的词向量模型```pythonmodel =gensim.models.KeyedVectors.load_word2vec_format('path_to_pr etrained_model', binary=True)```其中`path_to_pretrained_model`是训练好的词向量模型文件的路径,该模型可以是通过Word2Vec等算法训练得到的。

3. 计算词语相似度```pythonsimilarity_score = model.similarity('word1', 'word2')```其中`word1`和`word2`分别是两个要比较相似度的词语,`similarity_score`是它们的相似度分数。

需要注意的是,在使用`similarity`方法计算词语相似度时,如果输入的词语不在词向量模型中,则会触发`KeyError`异常。

文本相似度计算的几种方法对比在信息时代,海量的文本数据不断涌现,如何高效地处理和分析这些文本数据成为了一项重要的任务。

文本相似度计算作为文本处理的基础技术之一,被广泛应用于自然语言处理、信息检索、推荐系统等领域。

本文将对几种常见的文本相似度计算方法进行对比,包括余弦相似度、编辑距离、词向量模型等。

一、余弦相似度余弦相似度是一种常用的文本相似度计算方法,它基于向量空间模型,通过计算两个文本向量的夹角来衡量它们之间的相似程度。

具体而言,余弦相似度计算公式如下:cosine_sim = dot(A, B) / (norm(A) * norm(B))其中,dot(A, B)表示向量A和向量B的点积,norm(A)表示向量A的范数。

余弦相似度的取值范围在[-1, 1]之间,值越接近1表示两个文本越相似,值越接近-1表示两个文本越不相似。

二、编辑距离编辑距离是一种基于字符串编辑操作的文本相似度计算方法,它衡量两个字符串之间的差异程度。

编辑距离越小,表示两个字符串越相似。

常见的编辑操作包括插入、删除和替换字符。

编辑距离的计算可以通过动态规划算法来实现,时间复杂度为O(mn),其中m和n分别为两个字符串的长度。

三、词向量模型词向量模型是一种基于词语语义信息的文本相似度计算方法,它将每个词语映射到一个高维向量空间中,使得具有相似语义的词语在向量空间中距离较近。

常见的词向量模型包括Word2Vec和GloVe等。

通过计算两个文本中词语向量的相似度,可以得到文本的相似度。

词向量模型的计算过程可以分为两个步骤:首先,利用大规模语料库训练得到词向量模型;然后,通过计算两个文本中词语向量的平均值或加权平均值来得到文本向量,进而计算文本相似度。

词向量模型在处理语义相似度任务上表现出色,但对于一些特定领域的文本,效果可能不如其他方法。

四、方法对比余弦相似度、编辑距离和词向量模型都是常见的文本相似度计算方法,它们各自具有不同的特点和适用范围。

gensim库中coherencemodel()计算算法(最新版)目录1.介绍 gensim 库和 coherencemodel() 计算算法2.详细解释 coherencemodel() 的计算过程3.举例说明如何使用 coherencemodel() 进行计算4.讨论 coherencemodel() 的应用场景和优势正文gensim 是一个用于构建语义模型的 Python 库,其提供了丰富的算法和工具,使得研究者可以轻松地对大规模文本进行分析和建模。

在gensim 中,coherencemodel() 是一种计算算法,用于度量一个词汇表的凝聚力,即词汇表中词汇的相似度和关联程度。

下面,我们将详细介绍coherencemodel() 的计算过程、应用场景和优势。

coherencemodel() 的计算过程主要基于词汇表中的相似度矩阵。

首先,算法会计算词汇表中每个词汇的词向量,这些词向量通常是通过预训练的词向量模型(如 Word2Vec 或 GloVe)得到的。

然后,算法会计算词汇表中每对词汇的相似度,通常使用余弦相似度作为度量标准。

得到相似度矩阵后,算法会通过一系列的矩阵操作,如对角化、谱聚类等,来计算词汇表的凝聚力。

最终,算法会返回一个凝聚力得分,该得分越接近 1,表示词汇表的凝聚力越强。

在实际应用中,coherencemodel() 常用于评估词汇表的质量。

例如,当我们构建了一个新的词汇表时,我们可以使用 coherencemodel() 来评估该词汇表的凝聚力,从而判断词汇表是否具有良好的质量。

此外,coherencemodel() 还可以用于比较不同词汇表的凝聚力,从而帮助我们选择最佳的词汇表。

coherencemodel() 的优势在于其能够快速、准确地度量词汇表的凝聚力。

相较于其他评估方法,如手动评估、统计分析等,coherencemodel() 更为高效和可靠。

此外,coherencemodel() 还可以处理大规模的词汇表,因此在构建大规模语义模型时,coherencemodel() 是一种理想的评估工具。

Gensim官方教程翻译(四)——相似度查询(SimilarityQueries)/questionfish/article/details/46746947 翻译 2015年07月03日 23:20:41•••仅供个人学习之用,如有错误,敬请指正。

原文地址如果想要开启日志,别忘记设置:>>> import logging>>>logging.basicConfig(format='%(asctime)s : %(levelname)s : %(m essage)s', level=)相似度接口在之前的教程《语料库与向量空间》和《主题与转换》中,我们了解了创建在向量空间创建一个语料库意味着什么,如何在不同的向量空间之间转换。

我们所做的一切都是为了一个共同目标:决定文档对之间的相似度或者一篇特定文档和其他文档之间的相似度(例如用户输入与已索引文档)。

为了展示如何在gensim中做这项工作,让我们使用与之前相同的语料库(这个语料库真的来自于1990年的Deerwester等的《 Indexing by Latent Semantic Analysis》):>>> from gensim import corpora, models, similarities>>> dictionary = corpora.Dictionary.load('/tmp/deerwester.dict')>>> corpus = corpora.MmCorpus('/tmp/deerwester.mm') # comes from the first tutorial, "From strings to vectors">>> print(corpus)MmCorpus(9 documents, 12 features, 28 non-zero entries) 为了模仿Deerwester的例子,我们首先用这个微型语料库来定义一个2维LSI空间:lsi = models.LsiModel(corpus, id2word=dictionary, num_topics=2)现在假设一个用户键入查询“Human computer interaction”,我们应该对我们的九个语料库文档按照与该输入的关联性逆向排序。

Python 文本语义相似度计算一、概述在自然语言处理领域中,文本语义相似度计算是一个重要的问题。

它可以用于文本分类、信息检索、问答系统等多个领域。

Python 作为一种简洁而强大的编程语言,具有丰富的自然语言处理库和工具,为文本语义相似度计算提供了很好的支持。

二、常用的方法1. 基于词向量的方法基于词向量的方法是将文本表示为词的向量,然后计算两个文本向量的相似度。

Word2Vec、GloVe 等词向量模型是常用的工具。

2. 基于句向量的方法基于句向量的方法是将整个句子表示为一个向量,然后计算两个句子向量的相似度。

Doc2Vec、BERT 等模型可以用于生成句向量。

3. 基于语义图的方法基于语义图的方法是构建一个语义图来表示文本之间的关系,然后利用图上的算法计算文本的相似度。

TextRank 等算法是常用的方法。

三、Python 中的工具和库1. GensimGensim 是一个专注于文本语义建模的 Python 库,它包含了Word2Vec、Doc2Vec 等模型的实现。

通过 Gensim,我们可以很容易地计算文本的语义相似度。

2. spaCyspaCy 是一个用于自然语言处理的库,它提供了丰富的功能和语料库,包括词向量、句向量的计算等。

我们可以使用 spaCy 来计算文本的语义相似度。

3. NetworkXNetworkX 是一个用于复杂网络分析的库,我们可以利用它来构建和分析文本的语义图,计算文本之间的相似度。

四、示例代码1. 基于词向量的方法```pythonimport gensimmodel =gensim.models.KeyedVectors.load_word2vec_format('path/to/w ord2vec.bin', binary=True)similarity = model.wv.similarity('文本1', '文本2')print(similarity)```2. 基于句向量的方法```pythonimport spacynlp = spacy.load('en_core_web_md')doc1 = nlp('This is a sentence.')doc2 = nlp('This is another sentence.')similarity = doc1.similarity(doc2)print(similarity)```3. 基于语义图的方法```pythonimport networkx as nximport itertoolstext1 = 'This is a sentence.'text2 = 'This is another sentence.'tokens1 = text1.split()tokens2 = text2.split()graph = nx.Graph()graph.add_nodes_from(tokens1)graph.add_nodes_from(tokens2)for word1, word2 in itertools.product(tokens1, tokens2):if word1 != word2:graph.add_edge(word1, word2)similarity = nx.similarity.graph_edit_distance(graph1, graph2) print(similarity)```五、总结Python 提供了丰富的工具和库,可以很方便地进行文本语义相似度计算。

同义词查找,关键词扩展,使⽤腾讯TencentAILAB的800万词向量,gensim,annoy最近在做⼀个关键词匹配系统,为了更好的效果,添加⼀个关键词扩展的功能。

使⽤Tencent AIlab的800万词向量⽂件。

是⽤gensim模块读取词向量,并找到相似词,占⽤内存⽐较⼤,速度也慢,最好是16g以上的内存和⾼主频的cpuimport gensimwv_from_text = gensim.models.KeyedVectors.load_word2vec_format('./Tencent_AILab_ChineseEmbedding.txt',binary=False)wv_from_text.init_sims(replace=True) # 神奇,很省内存,可以运算most_similarwhile True:keyword = input("输⼊关键词:")w1 = [keyword]print(wv_from_text.most_similar(positive=w1,topn=5)) 会返回5个最相似的词语下⾯这个代码会使⽤annoy模块,这个模块好像不⽀持windows,要使⽤linux系统,32g以上内存加上⾼主频cpu。

from gensim.models import KeyedVectorsimport jsonfrom collections import OrderedDictfrom annoy import AnnoyIndex# 此处加载时间略长,加载完毕后⼤概使⽤了12G内存,后续使⽤过程中内存还在增长,如果测试,请⽤⼤⼀些内存的机器tc_wv_model = KeyedVectors.load_word2vec_format('./Tencent_AILab_ChineseEmbedding.txt', binary=False)# 构建⼀份词汇ID映射表,并以json格式离线保存⼀份(这个⽅便以后离线直接加载annoy索引时使⽤)word_index = OrderedDict()for counter, key in enumerate(tc_wv_model.vocab.keys()):word_index[key] = counterwith open('tc_word_index.json', 'w') as fp:json.dump(word_index, fp)# 开始基于腾讯词向量构建Annoy索引,腾讯词向量⼤概是882万条# 腾讯词向量的维度是200tc_index = AnnoyIndex(200)i = 0for key in tc_wv_model.vocab.keys(): #遍历Tencent词向量的所有词v = tc_wv_model[key]tc_index.add_item(i, v)i += 1# 这个构建时间也⽐较长,另外n_trees这个参数很关键,官⽅⽂档是这样说的:# n_trees is provided during build time and affects the build time and the index size.# A larger value will give more accurate results, but larger indexes.# 这⾥⾸次使⽤没啥经验,按⽂档⾥的是10设置,到此整个流程的内存占⽤⼤概是30G左右tc_index.build(10)# 可以将这份index存储到硬盘上,再次单独加载时,带词表内存占⽤⼤概在2G左右tc_index.save('tc_index_build10.index')# 准备⼀个反向id==>word映射词表reverse_word_index = dict([(value, key) for (key, value) in word_index.items()])# 然后测试⼀下Annoy,⾃然语⾔处理和AINLP公众号后台的结果基本⼀致# 感兴趣的同学可以关注AINLP公众号,查询:相似词⾃然语⾔处理for item in tc_index.get_nns_by_item(word_index[u'⾃然语⾔处理'], 11):print(reverse_word_index[item])# 不过英⽂词的结果好像有点不同for item in tc_index.get_nns_by_item(word_index[u'nlp'], 11):print(reverse_word_index[item])OK,上⾯的代码已经保存好了索引词⽂件,和索引词向量⽂件,下⾯开始使⽤,它和gensim还是有些区别的,就是你查找相似的词必须在Tencent 词向量的词表⾥,否则不能查,⽽gensim就不会有这个问题import jsonfrom annoy import AnnoyIndex# JSON到字典转化f2 = open('tc_word_index.json', 'r')word_index = json.load(f2)# 开始基于腾讯词向量构建Annoy索引,腾讯词向量⼤概是882万条# 腾讯词向量的维度是200tc_index = AnnoyIndex(200)# 加载保存好的索引,带词表内存占⽤⼤概在2G左右tc_index.load('tc_index_build10.index')# 准备⼀个反向id==>word映射词表index_word = dict([(value, key) for (key, value) in word_index.items()])# 查询:相似词⾃然语⾔处理while True:keyword = input("请输⼊关键词:")index = word_index.get(keyword)if index:print("相似词有:")#获取相似的结果和分数 [[结果,,,],[分数,,,]]result = tc_index.get_nns_by_item(index, 10, include_distances=True)#获取分数⼩于0.65的结果sim_keywords = [(index_word[idx],distance) for idx,distance in zip(result[0],result[1]) if distance<0.8]print(sim_keywords)else:print("词表不存在输⼊的关键词!") 分数越⼩越代表相似度⾼请输⼊关键词:价格价格相似词有:[('价格', 0.0), ('价位', 0.6172553896903992), ('价', 0.6483607888221741), ('中价格', 0.6971825361251831), ('价格降', 0.7441657185554504), ('相对价格', 0.7511115074157715), ('选择价格', 0.7584652304649353), ('期望价格', 0.7803905606269836), ('⼼理价位', 0.请输⼊关键词:年龄年龄相似词有:[('年龄', 0.0), ('25岁', 0.7704739570617676)]请输⼊关键词:⾝⾼⾝⾼相似词有:[('⾝⾼', 0.0), ('172cm', 0.6500729918479919), ('169cm', 0.6635174751281738), ('187cm', 0.6728192567825317), ('171cm', 0.6744356155395508), ('166cm', 0.6759911179542542), ('⾝⾼太矮', 0.6901100873947144), ('⾝⾼178', 0.6942415833473206), ('模特⾝⾼请输⼊关键词:体重体重相似词有:[('体重', 0.0), ('标准体重', 0.7117555737495422), ('孕前体重', 0.719347357749939), ('增重', 0.7211400270462036), ('理想体重', 0.7256979942321777), ('70公⽄', 0.7259328961372375), ('60公⽄', 0.7400050759315491), ('孕期体重增加', 0.7469530701637268), ('体请输⼊关键词:。

python的wsd公式

【原创版】

目录

1.WSD 简介

2.Python 中的 WSD 公式库

3.使用 Python 实现 WSD 公式的步骤

4.总结

正文

1.WSD 简介

WSD(Word Similarity Dimension)是一种用于衡量词之间相似度的公式,由 Martin 和 Coman 等人于 2005 年提出。

WSD 通过计算词在语料库中的分布相似度来衡量它们之间的相似度,可以应用于词义消歧、词向量降维、词嵌入等自然语言处理任务。

2.Python 中的 WSD 公式库

在 Python 中,有多个库可以用于计算 WSD,例如:word2vec、GloVe、gensim 等。

其中,word2vec 和 GloVe 是两个非常流行的词向量库,它们都提供了 WSD 的计算方法。

gensim 库则提供了一个更为灵活的词向量模型训练和计算平台,可以用于实现 WSD 公式。

3.使用 Python 实现 WSD 公式的步骤

以下是使用 Python 实现 WSD 公式的简要步骤:

1) 导入所需库:例如,如果你使用 word2vec 库,你需要导入word2vec 库。

2) 加载语料库和词向量模型:从库中加载所需的语料库和词向量模型。

3) 计算 WSD:使用库中提供的函数或方法计算两个词之间的 WSD 值。

4) 应用 WSD:根据需要,将 WSD 值应用于不同的自然语言处理任务。

4.总结

WSD 是一种重要的词相似度度量方法,Python 中有多个库可以用于

实现 WSD 公式。

gensim计算词语相似度公式

Gensim 计算词语相似度公式

在自然语言处理和文本挖掘领域中,计算词语之间的相似度是一个

重要的问题。

Gensim 是一个流行的 Python 库,广泛应用于文本语料库

的相似度计算和主题建模任务中。

在本文中,我们将介绍 Gensim 中用

于计算词语相似度的公式。

一、词向量表示

为了计算词语之间的相似度,首先需要将词语表示为向量。

在Gensim 中,使用 Word2Vec 等算法将词语映射到一个连续的向量空间中。

这些向量被称为“词向量”,其维度通常在数十到数百之间。

二、余弦相似度公式

在连续向量空间中,可以使用余弦相似度公式来衡量两个向量之间

的相似度。

余弦相似度公式如下:

similarity = dot(u, v) / (norm(u) * norm(v))

其中,u 和 v 分别表示两个词语的词向量,dot(u, v) 表示两个向量

的点积,norm(u) 和 norm(v) 分别表示向量的范数。

通过计算两个向量

的点积,除以它们的范数的乘积,可以得到它们的余弦相似度。

三、计算词语相似度

在 Gensim 中,可以使用 `similarity()` 方法来计算两个词语的相似度。

该方法接受两个参数,分别是要计算相似度的词语。

```python

from gensim.models import Word2Vec

# 假设已经训练好了一个 Word2Vec 模型

model = Word2Vec.load("word2vec.model")

word1 = "apple"

word2 = "orange"

similarity_score = model.similarity(word1, word2)

print(f"The similarity score between '{word1}' and '{word2}' is: {similarity_score}")

```

在上述代码中,我们首先导入 `Word2Vec` 类,然后加载了一个预训练好的 Word2Vec 模型。

接下来,我们选择两个词语 "apple" 和"orange",并使用 `similarity()` 方法计算它们的相似度。

最后,我们打印出词语之间的相似度得分。

由于 Gensim 是基于 Python 的库,因此可以方便地与其他自然语言处理任务和机器学习框架结合使用。

总结

本文介绍了 Gensim 中用于计算词语相似度的公式,并提供了一个使用示例。

通过使用 Gensim 提供的功能,我们可以轻松计算词语之间的相似度,从而在各种文本处理任务中获得更好的结果。

因此,

Gensim 是一个非常有用的工具,值得在自然语言处理和文本挖掘项目中使用。