Bumblebee双目测量基本原理

- 格式:docx

- 大小:75.64 KB

- 文档页数:4

双目立体视觉测距软件设计与评测摘要:双目立体视觉测距技术是一种利用两只摄像头来模拟人类双眼视觉,从而实现对物体距离的测量的技术。

在此基础上,设计了一种双目立体视觉测距软件,并对其进行了评测。

本文主要介绍了双目立体视觉测距软件的设计原理、功能特点和技术指标,以及对其进行了实验评测和性能分析。

评测结果表明,该软件具有较高的测距精度和可靠性,可适用于各种实际应用中。

一、引言双目立体视觉是指通过两只摄像头模拟人类双眼的视觉,从而实现对物体的距离、深度等信息的获取。

双目立体视觉测距技术已经在机器人导航、无人驾驶、虚拟现实等领域得到了广泛应用。

为了方便研究人员和工程师使用这一技术,设计了一种双目立体视觉测距软件,并对其进行了评测。

二、双目立体视觉测距软件的设计原理双目立体视觉测距软件的设计原理是基于双目视觉系统的工作原理。

双目视觉系统由左右两只摄像头组成,分别捕捉到左右两幅图像,并通过计算机进行图像处理和分析,最终实现对物体的距离、深度等信息的获取。

软件的设计原理包括以下几个方面:1. 图像采集和预处理:软件首先需要通过左右两只摄像头分别捕捉到左右两幅图像,并进行预处理,如灰度校正、去噪等。

2. 视差计算:通过对左右两幅图像进行特征匹配和视差计算,得到物体在图像中的视差信息。

3. 距离计算:根据视差信息和摄像头的参数,通过三角测量等方法计算得到物体的距离、深度等信息。

4. 显示和输出:软件将测距结果显示在计算机屏幕上,并可以通过接口输出到其他设备中。

三、双目立体视觉测距软件的功能特点双目立体视觉测距软件具有如下功能特点:1. 高精度:软件采用了先进的图像处理和算法技术,具有较高的测距精度,并可以满足不同场景下的测距要求。

2. 实时性:软件能够实时捕捉图像并进行测距计算,能够适用于需要实时响应的应用场景。

3. 多种接口:软件支持多种数据接口,可以方便地与其他设备进行数据交换和通信,如串口、网络等。

4. 友好界面:软件具有友好的用户界面,支持用户对软件的参数设置和操作,便于使用和管理。

基于双目视觉的工程车辆定位与行驶速度检测同志学;赵涛;贺利乐;王消为【摘要】针对工程车辆行驶速度低、滑转率高的特点,提出了一种基于双目序列图像的检测方法,以便快速检测工程车辆的相对位置与实际行驶速度.将双目摄像机安装在车辆上,连续采集周围环境的序列图像;利用SURF(speeded up robust features)特征对已采集到的各帧双目图像进行立体匹配,计算出环境特征点到摄像机坐标系原点的距离,从而实现车辆的相对定位;再对相邻两帧图像进行特征跟踪匹配,根据不同景深将匹配特征点对划分为远距点对和近距点对,分别利用远距点对和近距点对估算车辆运动过程中坐标系的旋转矩阵和平移矢量,并利用Levenberg-Marquardt法进行优化求解;最后根据优化后的旋转矩阵和平移矢量计算出车辆的行驶速度.户外模拟试验结果表明了方法的有效性和可行性.%According to the characteristics of low speed and high slip ratio of construction vehi-cles,a method was proposed based on binocular sequence images in order to quickly detect the relative positions and actual speeds of the vehicles.The vehicle-borne binocular vision sensors were used to collect the image sequences of the surrounding environments continuously.And the distances from the environment feature points to the origins of the camera coordinate systems were calculated through matching the captured each frame binocular images using speeded up robust features(SURF),so as to achieve vehicle relative locations.Meanwhile,the feature points of two adjacent frames were tracked and matched based on SURF,and the matching feature points were divided into far points and near points according to different depths of the fields.The rotation matrix andtranslation vector of the co-ordinate systems in vehicle motions were calculated by using the far points and the near points respec-tively,and then optimized them by Levenberg-Marquardt method.Finally,the velocities of the vehi-cles were estimated according to optimized rotational matrices and translation vectors.The results of outdoor simulation test show the effectiveness and feasibility of the proposed method.【期刊名称】《中国机械工程》【年(卷),期】2018(029)004【总页数】6页(P423-428)【关键词】双目视觉;序列图像;特征跟踪匹配;自车速度估计【作者】同志学;赵涛;贺利乐;王消为【作者单位】西安建筑科技大学机电工程学院,西安,710055;西安建筑科技大学机电工程学院,西安,710055;西安建筑科技大学机电工程学院,西安,710055;西安建筑科技大学机电工程学院,西安,710055【正文语种】中文【中图分类】TP216;TP3910 引言工程车辆作业时的实际行驶速度及相对于作业环境的位置信息对车辆控制至关重要,如何快速检测这些运动参数是值得研究的。

昆虫自由飞行参数的双棱镜虚拟双目测量

胡劲松;程鹏;续伯钦

【期刊名称】《实验力学》

【年(卷),期】2007(22)5

【摘要】通过像机前加一个双棱镜实现单像机的虚拟双目拍摄,根据立体视觉原理可以获取空间点三维信息,该装置被用于测量昆虫自由飞行运动参数。

如果双棱镜和像机摆放得当,可以简化立体视觉测量中对应点匹配这一最难步骤。

实验获得了蜻蜓直飞过程中的一系列运动参数,将这些参数结合起来考察对于研究昆虫飞行机理非常有意义。

特别地,我们对昆虫飞行中翅膀的柔性效应进行了初步讨论。

【总页数】8页(P511-518)

【关键词】双棱镜;立体视觉;自由飞行;三维重构

【作者】胡劲松;程鹏;续伯钦

【作者单位】中国科学技术大学近代力学系

【正文语种】中文

【中图分类】O348

【相关文献】

1.基于虚拟四目的立体视觉固定飞行昆虫运动参数测量系统 [J], 王颖;张广军;陈大志

2.虚拟立体视觉自由飞行昆虫运动参数测量系统 [J], 王颖;张广军;尚鸿雁

3.双目视觉飞行目标落地参数测量 [J], 崔彦平;林玉池;黄银国

4.虚拟多结构光自由飞行昆虫运动参数测量系统 [J], 王颖;王建林

5.9自由度会聚双目立体视觉的虚拟飞行导航 [J], 李自力;夏学知;刘玉亮;彭复员;石雄

因版权原因,仅展示原文概要,查看原文内容请购买。

基于双目视觉机器人自定位与动态目标定位卢洪军【摘要】Aiming at the fact that, the mobile robot based on binocular vision is very easy to be disturbed by the complex environment, such as the influence of noise, illumination change and the occlusion of the robot, which will seriously affect the positioning accuracy of the self localization and the moving objects, the color feature of the HSV model is proposed to accurately segment the artificial landmarks, and the robot position is determined according to the principle of parallax.A method was proposed based on Harris operator which is accurate to the position of a moving object in a complex environment.The dynamic object is detected by the frame difference method.Harris operator was used to extract the feature points on the moving objects, so as to obtain the disparity value, and then to calculate the position of the moving objects.The experimental results show that the self localization and target localization can overcome the external disturbance and have strong adaptability by using this method.The algorithm has good real-time performance.%针对基于双目视觉自定位与动态目标定位极易受复杂环境(如噪声、机器人发生遮挡、光照变化等)的干扰导致移动机器人定位精度低的问题,提出基于HSV颜色模型特征准确分割出人工路标,根据视差原理确定机器人位置.同时提出一种双目机器人基于Harris算子实现在复杂环境下对动态目标精确定位的方法,利用帧间差分法将运动目标检测出来,采用Harris算子在该运动目标上提取特征点,并获得视差值,从而精确的计算出运动目标的位置.实验结果表明,利用该方法进行自定位与目标定位能够克服外界干扰,具有较强的适应性,且算法的实时性好.【期刊名称】《沈阳大学学报》【年(卷),期】2017(029)001【总页数】6页(P37-42)【关键词】双目视觉;目标定位;Harris算子;帧间差分法;HSV模型【作者】卢洪军【作者单位】沈阳工业大学信息科学与工程学院, 辽宁沈阳 110870【正文语种】中文【中图分类】TP391.420世纪末,对目标定位技术主要有基于红外线的定位技术、基于超声波的定位技术和基于频射识别技术等[1].近年来,由于图像处理和计算机视觉的飞速发展,机器视觉的研究越来越受到广大专家和学者的青睐[2].双目立体视觉是机器视觉的一个重要分支,能够直接模仿人类双眼处理外界环境[3],可以代替人类完成危险的工作(如深海探测、火灾救援、核泄漏监测等)[4].而基于双目立体视觉对动态目标检测与定位也是机器视觉领域备受关注的前沿课题之一[5].双目立体视觉定位主要分为六个步骤[6]:①图像获取;②图像预处理;③摄像机标定;④特征点提取;⑤特征点的立体匹配获取视差值;⑥基于视差原理实现机器人定位.特征点提取和立体匹配是实现机器人定位的关键环节.通常的方法是依靠目标的形状、颜色等特征检测目标,并以运动物体的形心或中心作为特征点[7].该方法虽然计算简单,但极易受噪声干扰,只选择一个点作为特征点,一旦该特征点发生遮挡或光照变化等,都会严重影响定位精度.1977年,Moravec提出根据图像的灰度变化来提取图像角点,称为Moravec角点[8].该方法计算相对简单,但对于处于边缘上的点会存在误检,也极易受光照变化的影响.SIFT特征点[9]和CenSurE特征点[10]虽然对尺度、亮度变化不敏感,但在弱纹理等复杂情况下难以提取稳定的特征点,算法复杂度高,计算时间较长.不满足移动机器人对实时性的要求.针对以上缺陷,本文首先利用帧间差分法检测出运动目标,然后在运动目标上基于Harris算法提取多个特征点来实现移动机器人在复杂环境下实时的对运动目标精确定位.机器人整体定位流程如图1所示,移动机器人首先基于HSV颜色模型空间分割出人工路标,实现机器人自定位.然后利用帧间差分法检测出运动目标,根据Harris算法在左右两幅图像上提取特征点,根据区域匹配原理获取视差值,利用视差原理即可求出运动目标的世界坐标,即完成了对运动目标的定位.1.1 人工路标检测(1) HSV颜色模型.RGB色彩空间分别以红色、绿色、蓝色为三原色,通过适当的搭配可以合成成千上万种颜色,是一种常见的颜色表示法.但是RGB色彩空间与人眼的感知差异大,其空间的相似不代表实际颜色的相似.为了能够更准确分割出人工路标,本文采用HSV色彩空间颜色模型,如图2所示.RGB颜色空间转化到HSV色彩空间只是一个简单的非线性变换,计算简单.HSV模型中H代表色调,S代表饱和度,并且独立于亮度信息V.色调H代表颜色信息,取值范围为0~180°,对其设定阈值可以区分不同颜色的路标;饱和度S表示颜色中掺杂白色的程度,取值范围为0~1,S 越大,颜色越深;亮度V表示颜色的明暗程度,取值范围为0~1,V越大,物体亮度越高.(2) 基于颜色特征提取人工路标.由于本文是在室内环境下对移动机器人定位,所以本文设计的人工路标是由红黄蓝三种颜色组成的矩形纸板.如图3a所示为左摄像机拍摄到的带有人工路标的室内环境.根据HSV颜色模型对H、S、V三个分量进行阈值设置即可分割出人工路标,如图3b所示.然后利用图像处理中的形态学操作对分割出的路标进行完善使其效果最佳,如图3c所示.图3d为获取人工路标的中心点,利用视差原理即可得到当前帧机器人的位置.1.2 帧间差分法帧间差分法[11]的思想是对一段连续视频的相邻两帧进行差分运算,从差分运算的结果中得到运动目标的轮廓.该算法的优点是实现简单,对光照变化不敏感,稳定性好.适用于多目标或背景变化较快的场合.图4为在室内环境下用帧间差分法检测到运动物体.结果显示,帧间差分法能够有效的将运动目标检测出来.2.1 双目立体视觉测距原理双目立体视觉的视差原理[12]是利用两台摄像机从两个视点观察同一景物,以获取在不同视角下的感知图像,通过计算空间点在两幅图像中的视差来获取目标物体的三维坐标.2.2 Harris角点检测Harris角点[13]是在Moravec角点的基础进行改进的算法. Harris算子是用高斯函数代替二值窗口函数, 对离中心点越远的像素赋予越小的权重, 以减少噪声的影响. 高斯函数如式(1)所示.Moravec算子只考虑了四个方向的像素值,Harris算子则用Taylor展开式去近似任意方向.图像I(x,y)平移(Δx,Δy)可以一阶近似为在图像I(u,v)中,像点(u,v)平移(Δx,Δy)后的自相关函数为将式(2)代入式(3)可得:其中M如下所示:根据式(5)中矩阵M的特征值可以近似的表示函数C(x,y)的变化特征.矩阵M的特征值需要考虑以下三种情况,如图5所示.(1) 如果矩阵M的两个特征值都比较小,则表征图像灰度变化函数C(x,y)的值也较小,就说明该像素点的邻域内灰度差值不大,图像较平滑,无角点.(2) 如果矩阵M的两个特征值一个较大,一个较小,说明该像素点的曲率也是如此,则该点的窗口区域处于一条边界,无角点.(3) 如果矩阵M的两个特征值都比较大,则图像灰度变化的自相关函数值也较大,该点的窗函数沿任意方向都将引起灰度的剧烈变化,该点即为角点.根据这一准则,只要计算行列式的特征值就可以检测图像中的哪些点是角点.Harris 提出角点的响应函数:det(M)为行列式的值,trace(M)为行列式的迹.而k根据Harris的建议一般取0.04~0.06之间.若Harris角点响应大于阈值,则被认为是角点.Harris角点的生成只涉及到一阶导数,所以该角点对噪声影响、光照变化引起的灰度值变化都不敏感,是一种比较稳定的特征提取算子.3.1 实验环境本文使用的机器人是由北京博创兴盛技术有限公司开发的自主移动机器人旅行家Ⅱ号,如图6所示.该机器人上安装了由加拿大Point Grey Research公司生产的Bumblebee2双目摄像机,其性能参数如表1所示.3.2 传统移动机器人对运动目标定位实验环境为一间办公室,装有双目摄像机Bumblebee2的移动机器人为工作机器人,用于检测运动目标.将另一台机器人视为运动目标,运动速度为0.1 m/s.传统的方法是提取运动目标的中心点,获取视差值,从而给运动目标定位.传统方法仅获取图像中的一个点作为立体匹配的特征点,当该点受到环境的干扰时定位精度会受到极大的影响,图7为传统方法提取运动目标中心点.表2为传统方法对运动目标定位的实验数据,表3为改变光照后传统方法移动机器人对运动目标定位的实验数据.可以得出传统方法机器人定位误差相对较大,一旦光照发生改变,对运动物体定位误差会更加严重.3.3 基于Harris算子机器人对运动目标定位针对传统方法定位精度不足,极易受外界环境的干扰的问题,决定采用基于Harris角点特征提取,即在相机获得的左右两幅图像上基于Harris算子提取多对特征点,如图8所示.表4、表5为基于Harris方法机器人对运动目标定位的实验数据,可以得出基于该方法对运动目标定位误差很小,相对误差降低到1%左右,当光照发生变化时也能实现对运动目标精确定位.最后将每一帧的两幅图像根据区域匹配原理[14]和极限束准则找到正确的匹配点,排出易受噪声干扰的点,从而得到视差值,即可准确的对运动目标定位.(1) 本文研究了机器人基于双目立体视觉实现自定位与对运动目标定位,充分利用双目视差原理,并结合Harris算法和帧间差分法来实现运动目标的精确定位.从仿真结果可以看出,提取多个特征点可以避免只用一个点易受干扰的不足,实现更精确的运动目标定位.(2) 虽然本文在运动目标上提取多个特征点,有效的克服了传统方法的不足.但还存在问题需要改进.首先,需要找到一种更快更准确的特征点立体匹配算法;其次,本文只是将每一帧图像得到的多个视差值做平均值处理,如何有效的将多个视差值融合也是对运动目标精确定位的关键.【相关文献】[1] 李艳. 双视频目标定位技术[J]. 沈阳大学学报(自然科学版), 2016,28(4):302-305. (LI Y. Dual video target location technology[J]. Journal of Shenyang University(Natural Science), 2016,28(4):302-305.)[2] 李天健. 基于机器人视觉的汽车零配件表面缺陷检测算法研究与实现[J]. 沈阳大学学报(自然科学版), 2013,25(6):476-480. (LI T J. Research and implementation of auto parts surface defect detection algorithm bases on robot visio[J]. Journal of Shenyang University (Natural Science), 2013,25(6):476-480.)[3] 杜宇. 三维重建中双目立体视觉关键技术的研究[D]. 哈尔滨:哈尔滨理工大学, 2014:1-5. (DU Y. Research on key technology of binocular stereo vision in three-dimensional reconstruction[D]. Harbin:Harbin University of Science and Technology, 2004:1-5.)[4] 余俊. 基于双目视觉的机器人目标检测与控制研究[D]. 北京:北京交通大学, 2011:1-4. (YU J. Research on target detection and robot control based on binocular vision[D]. Beijing: Beijing Jiaotong University, 2011:1-4.)[5] DESOUZA G N, KAK A C. Vision for mobile robot navigation: A survey[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002,24(2): 237-267.[6] 高栋栋. 基于双目立体视觉定位和识别技术的研究[D]. 秦皇岛:燕山大学, 2013:9-11. (GAO D D. Research on recognizing and locating binocular stereo vision technology[D]. Qinhuangdao:Yanshan University, 2013:9-11)[7] 崔宝侠,栾婷婷,张弛,等. 基于双目视觉的移动机器人运动目标检测与定位[J]. 沈阳工业大学学报, 2016,38(4):421-427. (CUI B X, LUAN T T, ZHANG C, et al. Moving object detection and positioning of robot based on binocular vision[J]. Journal of Shenyang University of Technology, 2016,38(4):421-427.)[8] 邓国栋. 基于多尺度特征的双目立体视觉目标定位[D]. 哈尔滨:哈尔滨工业大学, 2012: 21-22. (DENG G D. Object location of binocular stereo vision base on multi-scale feature[D]. Harbin: Harbin Institute of Technology, 2012:21-22.)[9] LOWE D G. Distinctive image feature from scale-invariant key point[J]. International Journal of Computer Vision, 2004,60(2):91-110.[10] KONOLIGE K, AGRAWAL M, SOLA J. Large-scale visual odometry for roughterrain[C]∥Robotics Research: The 13thInternational Symposium ISRR, 2011,66:201-212.[11] 熊英. 基于背景和帧间差分法的运动目标提取[J]. 计算机时代, 2014(3):38-41. (XIONG Y. Moving object extraction based on background difference and frame differencemethod[J]. Computer Era, 2014(3):38-41.)[12] 林琳. 机器人双目视觉定位技术研究[D]. 西安:西安电子科技大学, 2009:8-10. (LIN L. The research of visual positioning technology on the binocular robot[D]. Xi’an: Xi'an Electronic and Science University, 2009:8-10.)[13] 张从鹏,魏学光. 基于Harris角点的矩形检测[J]. 光学精密工程, 2014,22(8):2259-2266. (ZHANG C P, WEI X G. Rectangle detection base on Harris corner[J]. Optics and Precision Engineering, 2014,22(8):2259-2266.)[14] 罗桂娥. 双目立体视觉深度感知与三维重建若干问题研究[D]. 长沙:中南大学, 2012:48-53. (LUO G E. Some issues of depth perception and three dimension reconstruction from binocular stereo vision[D]. Changsha: Central South University, 2012:48-53.)。

双目测量原理是指通过两个摄像头或相机来获取目标物体的三维空间信息。

它基于人类视觉系统的工作原理,利用两个视点之间的视差来计算目标物体的深度。

双目测量原理的基本步骤如下:

1. 采集图像:使用两个摄像头或相机同时拍摄目标物体的图像。

这两个摄像头或相机需要具有一定的间距,以模拟人类的双眼视觉。

2. 特征点提取:从两个图像中提取出一些特征点,例如角点、边缘等。

这些特征点在两个图像中具有一定的对应关系。

3. 视差计算:通过比较两个图像中特征点的位置差异,可以计算出它们之间的视差。

视差是指同一物体在两个视点下的像素位置差异。

4. 三角测量:利用视差和摄像头之间的几何关系,可以得到目标物体的深度信息。

三角测量是指利用两个视点和目标物体的特征点构成的三角形,通过几何关系计算出目标物体的空间位置。

双目测量原理的优点是可以获取目标物体的三维信息,可以用于距离测量、物体识别和姿态估计等应用。

但也存在一些限制,例如对于光照条件和纹理的要求较高,对于透明物体和反射物体的测量效果较差。

双目测距的原理和公式

双目测距的原理是通过测量两个观察点之间的距离和角度变化,来计算物体之间的实际距离。

其公式可以表示为:l= tanαD/2,其中tanα是角α在普通三角函数中的正切值,D表示两个发射端之间的水平距离。

双目测距的基本原理是利用两个观察端点之间的角度变化来测量物体之间的距离。

具体来说,假设有一个点p,沿着垂直于相机中心连线方向上下移动,则其在左右相机上的成像点的位置会不断变化,即d=x1-x2的大小不断变化,并且点p和相机之间的距离Z跟视差d存在着反比关系。

视差d可以

通过两个相机中心距T减去p点分别在左右图像上的投影点偏离中心点的值获得,所以只要获取到了两个相机的中心距T,就可以评估出p点距离相机的距离。

以上信息仅供参考,如需了解更多信息,建议查阅双目测距相关的书籍和文献。

双目视觉测量系统

双目视觉测量系统工作原理是双目视觉测量的基本原理是由不同位置的2 台摄像机经过移动或旋转拍摄被测物体的同一表面,获取图像对。

通过提取图像上线激光在物体表面投影的中心像素点、像素点的立体匹配,得出测量点在2 幅图像平面上的像素坐标对,利用成像公式计算出被测点的空间坐标。

根据人眼双目成像的原理, 通过双摄像头实现获得立体信息进而提出人脸识别的一种新方法, 并给出实现系统的结构。

专用的全息扫描获得三维数据的方法, 设备昂贵且采样非常不方便,不如本文提出方法耗材简单且取样非常方便。

双目立体视觉传感器的测量原理类似于人类视觉获取信息的方式, 即由两台相对位置固定的摄像机与被测对像构成三角形, 被测对像在两像面上形成立体图像对, 然后利用计算机图像处理技术进行相关特征点匹配, 并通过计算左右两幅图像中相关特征点的视差来获取被测点的空间三维坐标。

双目立体视觉传感器主要是利用三角法测量原理和针孔透视成像理论获得空间被测量特征点在传感器坐标系下的三维坐标, 它主要由左右摆放的两个摄像机组成。

双目视觉技术的原理、结构、特点、发展现状和发展方向分析双目立体视觉是机器视觉的一种重要形式,它是基于视差原理并由多幅图像获取物体三维几何信息的方法。

双目立体视觉系统一般由双摄像机从不同角度同时获得被测物的两幅数字图像,或由单摄像机在不同时刻从不同角度获得被测物的两幅数字图像,并基于视差原理恢复出物体的三维几何信息,重建物体三维轮廓及位置。

双目立体视觉系统在机器视觉领域有着广泛的应用前景。

80年代麻省理工学院人工智能实验室的Marr提出了一种视觉计算理论并应用在双眼匹配上! 使两张有视差的平面图产生有深度的立体图形! 奠定了双目立体视觉发展的理论基础。

相比其他类的体视方法! 如透镜板三维成像,三维显示,全息照相术等! 双目体视直接模拟人类双眼处理景物的方式可靠简便! 在许多领域均极具应用价值! 如微操作系统的位姿检测与控制机器人导航与航测,三维测量学及虚拟现实等。

双目立体视觉原理与结构双目立体视觉三维测量是基于视差原理,图1所示为简单的平视双目立体成像原理图,两摄像机的投影中心的连线的距离,即基线距为b。

摄像机坐标系的原点在摄像机镜头的光心处,坐标系如图1所示。

事实上摄像机的成像平面在镜头的光心后,图1中将左右成像平面绘制在镜头的光心前f处,这个虚拟的图像平面坐标系O1uv的u轴和v轴与和摄像机坐标系的x轴和y轴方向一致,这样可以简化计算过程。

左右图像坐标系的原点在摄像机光轴与平面的交点O1和O2。

空间中某点P在左图像和右图像中相应的坐标分别为P1(u1,v1)和P2(u2,v2)。

假定两摄像机的图像在同一个平面上,则点P图像坐标的Y坐标相同,即v1=v2。

由三角几何关系得到:上式中(xc,yc,zc)为点P在左摄像机坐标系中的坐标,b为基线距,f为两个摄像机的焦距,(u1,v1)和(u2,v2)分别为点P在左图像和右图像中的坐标。

Bumblebee®2 双目视觉系统Point Grey Research's IEEE-1394 (FireWire) Stereo Vision camera systems are provided as complete hardware and software packages. Every Point Grey Stereo Vision camera system includes a free copy of the FlyCapture SDK, which is used for image acquisition and camera control, and the Triclops SDK, which performs image rectification and stereo processing. Additional stereo vision software components are available at no extra cost: the Censys3D SDK, which is ideal for people tracking; and the Multiclops software, which allows integration of multiple cameras into a single coordinate system.The Bumblebee®2 is the next generation Bumblebee® stereo vision camera. It provides a balance between 3D data quality, processing speed, size and price. Developed as a drop-in replacement for the original Bumblebee camera, the Bumblebee2 also features double the frame rate and a GPIO connector for external trigger and strobe functionality.l Sensor: Two Sony 1/3" progressive scan CCDs, Color/BWl Resolution and FPS : 640x480 at 48FPS or 1024x768 at 18FPSl Lenses: 3.8mm (70° HFOV) or 6mm (50° HFOV) focal lengthl Calibration: Pre-calibrated to within 0.05 pixel RMS errorl General Purpose IO: GPIO pins for external trigger / strobeAdditional Features and SpecificationsImage Acquisition 12-bit analog-to-digital converterMultiple cameras on the same 1394 bus automatically sync Faster standard frame ratesOverlapped trigger input, image acquisition and transferImage Processing On-camera conversion to YUV411, YUV422 and RGB formats On-camera control of sharpness, hue, saturation, gamma Pixels contain frame-specific info (e.g. 1394 cycle time)Camera and Device Control Broadcast settings to all cameras on the same busAuto and one-push white balance for easy color balancing Reports the temperature near the imaging sensorMonitors sensor voltages to ensure optimal image quality Fine-tune frame rates for video conversion (e.g. PAL, NTSC) Non-volatile storage of camera default settings and user data General purpose input/output pins for external device control Firmware upgradeable in field via IEEE-1394 interface.Camera Calibration Pre-calibrated for lens distortions and camera mis- alignments. The camera works straight out of the box, as it doesn't require in-field calibration and is guaranteed to stay calibrated. Images are aligned within 0.05 pixel RMS error.The calibration information is pre-loaded on the camera, allowing the software to retrieve the image correction information. This allows seamless swapping of the cameras, or retrieving the correct information when multiple cameras are on the bus.The calibration retention system prevents the unit from losing calibration when the device is subject to mechanical shock and vibrationBW vs Color Benefits of Black & WhiteSpeed: BW models are slightly faster than color due to the timeit takes the color model to convert stippled images into colorimages.Higher Resolution: Color is achieved by interpolating raw pixelvalues. Consequently, BW has higher resolution.Higher Fidelity: Due to the light collection methods used bycolor cameras, BW has higher fidelity.Benefits of ColorColor Differentiation: Being able to differentiate betweendifferent colors could allow a mobile robot to, for example,distinguish a red ball from its surroundings.Color Texture Mapping: Users interested in using the device for3D modeling will probably be interested in having full colortexture maps.l Development Kit Contentsn 4.5 meter, 6-pin to 6-pin, IEEE-1394 cablen IEEE-1394 OHCI PCI Host Adapter 3-port 400Mbps cardn Hirose HR10 12-pin male GPIO connector pre-wired for easy triggering n FlyCapture SDK and Triclops SDK (C/C++ API and device drivers)l Recommended System Configurationn Processoru Recommended – Intel Pentium® 4 2.0 GHz or compatible processoru Minimum – Intel Pentium III 800 MHz or compatible processor n Memoryu Recommended – 512 MB RAMu Minimum - 256 MB RAMn AGP video card with 64 MB video memory (128 MB recommended) n32-bit standard PCI slot for the IEEE-1394 cardl Supported operating systemn Microsoft Windows 2000,XP,Vistan Microsoft Visual C++ 6.0 (to compile and run example code)l Emissions and RoHS Compliancen FCC / CE Compliancen This equipment has been tested and found to comply with the limits fora Class A digital device, pursuant to Part 15 of the FCC Rules. Theselimits are designed to provide reasonable protection against harmfulinterference when the equipment is operated in a commercialenvironment. This equipment generates, uses, and can radiate radiofrequency energy and, if not installed and used in accordance with theinstruction manual, may cause harmful interference to radiocommunications. Operation of this equipment in a residential area islikely to cause harmful interference in which case the user will berequired to correct the interference at his own expense.n You are cautioned that any changes or modifications not expressly approved in this manual could void your authority to operate thisequipment.l RoHS / WEEE Compliancen This product is RoHS and WEEE compliant. .Model and Part Numbers*NOTE: One full KIT must be purchased prior to ordering individual cameras Part Number DescriptionBB2-03S2C-38640x480 Color 3.8mm Bumblebee2 SystemBB2-03S2C-60640x480 Color 6mm Bumblebee2 SystemBB2-03S2M-38640x480 BW 3.8mm Bumblebee2 SystemBB2-03S2M-60640x480 BW 6mm Bumblebee2 SystemBB2-08S2C-381024x768 Color 3.8mm Bumblebee2 SystemBB2-08S2C-601024x768 Color 6mm Bumblebee2 SystemBB2-08S2M-381024x768 BW 3.8mm Bumblebee2 SystemBB2-08S2M-601024x768 BW 6mm Bumblebee2 SystemBB2-DEVKIT Bumblebee2 Development Accessory KitNOTES:First time users are required to purchase a Development Accessory Kit in addition to purchasing the initial camera.。

基于亚像素级角点检测的双目视觉距离测量双目视觉距离测量是一种应用于机器视觉中的技术,它利用双目摄像头拍摄的图像来测量物体的距离。

其中一个关键的技术是亚像素级角点检测,它能提高角点定位的精度,从而提高距离测量的准确性。

亚像素级角点检测是一种精度更高的角点检测方法,能够检测到图像中更加精细的特征点。

它的基本原理是通过对像素级角点坐标的微调来找到亚像素级别的角点。

这样可以提高角点的检测精度,也可以提高测量距离的准确性。

在双目视觉距离测量中,我们使用两个摄像头来捕捉物体的两个不同视角。

通过计算两个视角之间的距离,可以确定物体的距离。

其中,亚像素级角点检测发挥了关键作用,在两个视角之间准确匹配特征点,从而确定物体距离。

首先,我们需要获取双目摄像头拍摄的两个视角图像。

然后,我们使用亚像素级角点检测算法来检测两个图像中的角点。

角点的类型有内角和外角两种,在测量距离时,我们只需要使用内角点。

接着,我们需要对两个视角的特征点进行匹配。

这个匹配过程可以通过计算两个视角之间的视差来完成。

视差是指物体在两个视角中的位置差异,当两个视角的像素在位置上一致时,它们的视差为0。

视差越大,表示物体越远。

最后,我们可以根据视差来计算物体的距离。

视差与物体距离之间存在一定的线性关系,我们可以使用一些公式来计算物体的距离。

计算完成后,我们可以得到物体的精确距离值。

总的来说,亚像素级角点检测在双目视觉距离测量中起到了重要的作用。

它可以提高特征点的定位精度,从而提高距离测量的准确性。

同时,亚像素级角点检测还可以用于其他的机器视觉应用中,比如图像配准、物体跟踪等。

当然,在实际应用中,双目视觉距离测量涉及到很多细节问题,比如摄像头校准、图像噪声处理、误差校正等。

这些都需要仔细处理,才能得到准确可靠的测量结果。

在双目视觉距离测量中,涉及到多个数据因素,包括摄像头参数、视差范围、距离计算公式等。

下面将简单介绍并分析这些关键数据。

1. 摄像头参数双目视觉距离测量需要使用两个摄像头来捕捉物体的两个不同视角。

Point Grey为各种应用领域的立体视觉实践提供硬件和软件工具包,包括完整的立体处理支持—从图像校正和相机位置调整到基本浓度相关性的立体测图技术。

立体视觉工作模式类似于人类视觉中的三维感知。

先是识别对应于多台相机测定的实际场景中相同点的图像像素点,然后通过每个镜头的一条射线进行三角测量,确定各点的3D位置。

相关的立体摄像方法试图获取立体图像中的各像素的对用部分,从而是每个立体图像可以生成数以万计的3D数据值。

1.单一图像集的全场视觉深度测量2.图像到3D数据的实时转换—相机每秒可轻松生成一百万个像素点3.易于与其他机器视觉技术集成—图像和3D数据完全对应4.被动3D感知—无需激光装置或投影机5.镜头偏差和相机位置偏差与校准,无需人工调整或视场内校准6.高品质CCD传感器和IIDC1.31兼容高速1394接口7.灵活的软件环境,提供各级立体处理管线的访问第一阶段:原始图像(Raw image)到校正图像(Rectified image)。

校正图像经IEEE-1394总线传送至PC后进行校正并对准以消除镜头偏差。

第二阶段:校正图像(Rectified image)到边缘图像(Edge image)。

拉普拉斯高斯算子,高斯滤波器用于创建图像亮度未发生偏差的边缘图像。

第三阶段:边缘图像(Edge image)到深度图像(Depth image)对于深度图像中各像素的相关立体图像,采用绝对差之后的标准通过相关性获得边缘图像中的对应像素。

Point Grey立体视觉摄像系统在出厂时经过了镜头偏差和相机位置偏差的校准,以确保符合所有相机标定的一致性要求,并避免视场内校准的需要。

系统校正过程中,外极线对齐误差在0.1*像素RMS的范围内。

标定结果存储在相机上,是主机软件在即使缺少相机规格的情况下也能够检索图像校正信息。

该项功能保证相机的无缝交互和多相机系统使用的便利性。

专门设计的相机包可保护校准不受机械冲击和振动影响。

基于双目视觉的机器人运动目标检测与定位崔宝侠;栾婷婷;张驰;段勇【摘要】针对移动机器人自定位精度低的问题,提出了先由静止的工作机器人进行自定位,再对运动目标进行检测和定位的方法.基于HSV模型颜色特征,工作机器人分割出人工路标并进行自定位,利用帧间差分法将采集到的视频图像序列中相邻两帧作差分运算,提取出运动目标,并通过双目立体视觉视差原理计算出运动目标的绝对坐标,帮助运动目标完成定位.结果表明,该方法定位精度高于传统的移动机器人自定位的定位精度,且算法的实时性好,具有现实的研究意义.【期刊名称】《沈阳工业大学学报》【年(卷),期】2016(038)004【总页数】7页(P421-427)【关键词】双目视觉;移动机器人;帧间差分法;运动目标;人工路标;HSV模型;阈值分割;定位【作者】崔宝侠;栾婷婷;张驰;段勇【作者单位】沈阳工业大学信息科学与工程学院,沈阳110870;沈阳工业大学信息科学与工程学院,沈阳110870;沈阳工业大学信息科学与工程学院,沈阳110870;沈阳工业大学信息科学与工程学院,沈阳110870【正文语种】中文【中图分类】TP391.4双目立体视觉采用的是类似于人的左右眼识别、理解外界的方式,利用左右两部并行排列的CCD镜头分别获取外界图像,对两幅图进行处理以获得外界的3D信息[1].双目立体视觉是计算机视觉研究中的一个重要分支,能直接模仿人类双眼处理客观场景[2],可以代替人类在危险系数较高的场合(如重度污染区、核辐射区以及有炸弹包裹的大楼等)工作[3].定位是其执行其他任务的前提和基础,也是评价机器人性能的关键指标之一[4].目前的双目视觉移动机器人在定位过程中,一般都是采用移动机器人用双目摄像机直接采集路标完成自定位的方法,这种方法简单高效,但是具有一定的缺陷,即双目视觉传感器可能由于过快或不平稳的运动使得采集路标的图像模糊不准确,导致自定位误差较大,而且移动机器人可能运动到阴暗或难以采集路标的位置,会出现无法采集到路标的情况.针对以上缺陷,文中提出了一种新的定位方法,即由另一个机器人代替移动机器人完成定位,负责定位工作的机器人可以在能够检测到路标和移动机器人的位置保持静止状态,利用传感器完成自定位,再为移动机器人进行定位并实时为其传达位置信息.工作机器人整体的定位流程如图1所示,工作机器人首先采集带有移动机器人与人工路标的视频,然后对视频进行两方面的处理:一方面是分割提取人工路标并找到其质心,根据视差原理求出工作机器人与人工路标质心的相对位置,在实验环境中已知人工路标的质心坐标,这样就能求出工作机器人的绝对坐标,从而完成其自定位;另一方面工作机器人通过对视频图像的处理提取出运动目标,也根据视差原理得到工作机器人与移动机器人的相对位置,由于工作机器人的绝对坐标已经得到,因此可以计算出移动机器人的绝对坐标,即完成了工作机器人自定位及对运动目标检测与定位的任务.本文分别介绍人工路标与运动目标的检测方法,并通过实验比较了工作机器人帮助移动机器人自定位法与传统移动机器人自定位法的优劣.1.1 人工路标检测1.1.1 HSV颜色模型RGB色彩空间是一种常见的颜色表示法,通常摄像机拍摄到的图像都是基于RGB 模型,但RGB色彩空间与人眼的感知差异大,其空间的相似不代表实际颜色的相似[5].为了符合人的视觉特征,同时也由于从RGB到HSV的转换是一个简单且快速的非线性变换[6],本文采用HSV色彩空间颜色模型,如图2a所示.在HSV色彩空间颜色模型中,H和S是色度信息,且独立于亮度信息V,这是HSV模型的一个重要优点[7].色调(H)代表颜色信息,取值范围为0~360°,对其设定阈值可以区分不同颜色的路标;饱和度(S)表示颜色的深浅,取值范围为0~1,S越大,颜色越深;亮度(V)表示颜色的明暗程度,取值范围为0~1,V越大,物体亮度越高.将HSV圆柱模型展开成如图2b所示平面模型,色彩从左至右代表模型中H分量沿逆时针方向从0°变化到360°,从下至上代表饱和度S由中心向圆周渐变,最右侧灰度图代表亮度V.1.1.2 基于颜色特征提取人工路标本文设计的人工路标是由红、蓝、黄三种颜色组成的矩形纸板.图3a所示为左目摄像机拍摄到的机器人所处环境示意图;利用HSV颜色模型对H、S、V三分量进行阈值的设置即可将人工路标提取出来(如图3b所示),但效果不理想,人工路标内部有细小的空洞;而利用相关运算对其进行图像处理后,人工路标内部细小的空洞被填平,提取效果较好,如图3c所示.1.2 运动目标检测1.2.1 帧间差分法帧间差分法[8]是通过对视频图像序列中相邻两帧作差分运算来获得运动目标轮廓信息,即对差分结果阈值判断可以采用式(2),即大于阈值的判断为前景,小于阈值的则判断为背景,从而突出运动区域,确定运动目标.帧间差分法的优点是算法实现简单,对光线等场景变化不太敏感,稳定性好.1.2.2 检测结果移动机器人水平向右运动,图4a、b分别为运动过程中双目摄像机左目采集到的第2帧和第3帧视频图像,图4c为利用帧间差分法检测到的运动目标示意图.检测结果显示,帧间差分法能够将运动目标的轮廓提取出来.2.1 双目立体视觉原理利用两台摄像机从两个视点观察同一景物,以获取在不同视角下的感知图像,通过计算空间点在两幅图像中的视差来获取目标物体的三维坐标,该原理即是视差测距原理[9].空间点在双目摄像机中的成像示意图如图5所示.2.2 工作机器人自定位首先,基于HSV颜色特征对采集到的左右两幅图像中的人工路标进行阈值分割,其次,计算左右两幅图像中人工路标的中心点坐标,将其作为一对匹配点,利用双目视觉视差原理计算人工路标在摄像机坐标系下的三维坐标,由于人工路标是人为设置的,其在坐标系下的绝对坐标已知,由此可以得到摄像机坐标系与环境坐标系的转换关系.利用此关系可以计算出工作机器人的绝对坐标,从而完成工作机器人自定位.2.3 运动目标定位目前,视频运动目标定位方法主要有基于区域生长法、水平垂直投影法以及基于模式分类法[10].基于投影定位方法思路简单,易于实现,精确度高,本文采用基于投影的运动目标定位方法.将运动目标的像素值设为255,其余所有点的像素值设为0,通过对含有运动目标的二值图像进行逐行以及逐列扫描,可以得到运动前景对应的像素点在水平方向以及垂直方向的具体分布情况及坐标值.通过逐行扫描可以得到运动目标对应像素的最小行号rmin和最大行号rmax,同理通过逐列扫描可以得到运动目标对应像素的最小列号cmin和最大行号cmax,由此可以得到矩形框的两个对角点(cmin,rmin)和(cmax,rmax),矩形的中心点坐标为式中:xmid为中心坐标的横坐标值;ymid为中心坐标的纵坐标值.将双目摄像机拍摄到的左右两幅图像中的运动目标检测出来,并用矩形框标记,得出运动目标的中心点坐标,将其作为一对匹配点,利用双目立体视觉视差公式即可求出运动目标在摄像机坐标系下的三维坐标.由于已经通过工作机器人自定位得到摄像机坐标系与世界坐标系之间转换关系,因此,可以计算出运动目标在环境坐标系下的绝对坐标,由此完成运动目标定位过程.本文使用的机器人是由北京博创兴盛技术有限公司开发的自主移动机器人旅行家Ⅱ号,该机器人为两轮差动式控制,在机器人本体上安装了由加拿大Point Grey Research公司生产的Bumblebee2双目摄像机,摄像机固定在机器人顶部,以期获得较好的图像采集角度.旅行家Ⅱ号机器人本体如图6所示,Bumblebee2摄像机的性能参数如表1所示.3.1 运动目标检测仿真结果装有双目摄像机Bumblebee2的移动机器人为工作机器人,实验环境中将另一台移动机器人作为运动目标.运动目标在实验环境中分别作纵向运动与横向运动,运动速度为0.1 m/s,如图7所示.墙上贴有由红、蓝、黄三种颜色构成的人工路标,双目摄像机对工作机器人所处环境每1 s采集一帧图像,共采集15帧.图8为检测运动目标纵向运动示意图,图8a~d分别为双目摄像机采集到的原始视频第5帧和第12帧左右两幅图像;图8e~h为利用帧间差分法对运动目标进行检测并用矩形框进行标记的结果示意图.图9为检测运动目标水平运动示意图,图9a~d分别为双目摄像机采集到的原始视频第7帧和第12帧左右两幅图像;图9e~h分别为利用帧间差分法对运动目标进行检测并用矩形框进行标记的结果示意图.3.2 传统移动机器人自定位传统移动机器人纵向与水平运动自定位数据如表2和表3所示.3.3 工作机器人帮助运动目标定位人工路标检测结果数据显示如表4所示,工作机器人自定位数据如表5所示,运动目标纵向运动定位数据如表6所示,运动目标水平运动定位数据如表7所示. 通过与传统机器人自定位数据的对比可以看出,利用工作机器人代替移动机器人进行定位的精度要高于移动机器人自定位的精度.只有极少部分数据显示移动机器人的定位误差更小,但大多数的情形下,采用工作机器人自定位再对运动目标进行检测与定位的方法精度更高.虽然本文所述方法算法较多,但算法比较简单,实时性好,充分满足要求.本文提出的运动目标检测与定位的思路是首先利用定位机器人自定位,再对运动目标定位.实验结果表明,工作机器人自定位相对误差不足1%,运动目标纵向运动与水平运动定位的相对误差在多数情况下低于工作机器人自定位的误差,且算法的实时性较好,具有现实的研究意义.【相关文献】[1]吴若鸿.基于特征匹配的双目立体视觉技术研究 [D].武汉:武汉科技大学,2010.(WU Ruo-hong.Research on binocular stereo vision technology based on feature matching [D].Wuhan:Wuhan University of Science and Technology,2010.)[2]杜宇.三维重建中双目立体视觉关键技术的研究 [D].哈尔滨:哈尔滨理工大学,2014.(DU Yu.Research on key technology of binocular stereo vision in three-dimensional reconstruction [D].Harbin:Harbin University of Science and Technology,2014.)[3]余俊.基于双目视觉的机器人目标检测与控制研究 [D].北京:北京交通大学,2011.(YU Jun.Research on target detection and robot control based on binocular vision[D].Beijing:Beijing Jiaotong University,2011.)[4]张本法,孟祥萍,岳华.移动机器人定位方法概述 [J].山东工业技术,2014(22):250. (ZHANG Ben-fa,MENG Xiang-ping,YUE Hua.Outline of mobile robot localization methods [J].Shandong Industrial Technology,2014(22):250.)[5]黄雁华,武文远,龚艳春,等.量化颜色直方图的改进与应用 [J].光电技术应用,2011,26(4):76-80.(HUANG Yan-hua,WU Wen-yuan,GONG Yan-chun,et al.Improvement and application of color histogrm [J].Electro-optic Technology Application,2011,26(4):76-80.)[6]郭英华.基于HSV色彩空间的图像分割 [J].黑龙江冶金,2011,31(2):35-37.(GUO Ying-hua.Image segmentation based on HSV color space [J].Heilongjiang Metallurgy,2011,31(2):35-37.)[7]陈向东,李平.基于色彩特征的CAMSHIFT视频图像汽车流量监测[J].沈阳工业大学学报,2015,37(2):183-188.(CHEN Xiang-dong,LI Ping.Vehicle flow detection with CAMSHIFT video images basedon color feature [J].Journal of Shenyang University of Technology,2015,37(2):183-188.)[8]张晓慧.视频监控运动目标检测算法的研究与实现 [D].西安:西安电子科技大学,2012. (ZHANG Xiao-hui.Research and implementation on moving object detection algorithm in video surveill ance [D].Xi’an:Xidian University,2012.)[9]靳盼盼.双目立体视觉测距技术研究 [D].西安:长安大学,2014.(JIN Pan-pan.Study on the technology of binocular stereo vision measurement [D].Xi’an:Chang’an University,2014.)[10]张君昌,李明,谷卫东.融合减法聚类与C-均值聚类的目标定位方法 [J].计算机仿真,2012,29(7):269-273.(ZHANG Jun-chang,LI Min,GU Wei-dong.Joint subtractive clustering and C-means clustering object Location algorithm [J].Computer Simulation,2012,29(7):269-273.)。

双目视觉目标检测算法

双目视觉目标检测算法是一种基于双目视觉系统的算法,用于检测图

像中的目标物体。

该算法通过通过分析目标在两个视角下的图像得出

目标的深度信息,进而提高目标检测的精度。

本文将深入探讨双目视

觉目标检测算法的原理和优势。

首先,双目视觉目标检测算法的原理是利用人眼原理,在两个视点下

观察物体从而得到深度信息。

将这一原理应用到计算机视觉领域中,

就可以通过两个摄像头拍摄相同的场景,然后可以根据两个视点中不

同的信息计算出目标的深度信息,从而实现目标的检测和识别。

与单目视觉相比,双目视觉系统得到的图像具有更多的信息。

因为单

目视觉只能在一个视角下观察物体,很难得到物体的深度信息。

因此,在某些场景下,单目视觉系统很难检测到目标,而双目视觉系统可以

克服这一困难,提高目标检测的精度。

除此之外,双目视觉目标检测算法还具有其他优势。

首先,它可以在

复杂的环境下工作,比如光照、阴影和反光等问题。

其次,双目视觉

系统还可以减少物体的遮挡问题,提高检测的召回率。

这是因为双目

视觉系统可以从两个不同的视角下观察物体,遮挡的物体在不同的图

像中的位置不同,使得机器学习算法更容易分辨。

总的来说,双目视觉目标检测算法是一种非常有效的图像处理方法,具有很好的应用前景。

它可以提高目标检测的精度和可靠性,而且可以处理一些单目视觉系统难以处理的场景。

在未来,双目视觉目标检测算法将会在智能驾驶、智能安防、自动化工业控制和医疗影像等领域发挥出更大的作用。

《基于双目立体视觉的测量技术研究》一、引言随着计算机视觉技术的快速发展,双目立体视觉作为一种重要的三维测量技术,已经得到了广泛的应用。

双目立体视觉技术通过模拟人类双眼的视觉系统,利用两个相机从不同角度获取同一场景的图像信息,然后通过图像处理和计算机视觉算法,提取出场景中物体的三维信息。

本文将针对基于双目立体视觉的测量技术进行研究,探讨其原理、方法及应用。

二、双目立体视觉原理双目立体视觉的原理是基于人类双眼的视觉系统。

当人类观察一个物体时,左右眼从不同的角度观察同一物体,由于视角的差异,会在大脑中形成立体的视觉效果。

双目立体视觉技术就是模拟这一过程,通过两个相机从不同的位置获取同一场景的图像,然后利用计算机视觉算法对这两幅图像进行比对和处理,从而得到场景中物体的三维信息。

三、双目立体视觉测量方法双目立体视觉测量方法主要包括以下几个步骤:图像获取、相机标定、特征提取、立体匹配和三维重建。

1. 图像获取:通过两个相机从不同角度获取同一场景的图像。

2. 相机标定:对两个相机进行标定,确定相机的内参和外参,包括相机的焦距、光心位置、畸变系数等。

3. 特征提取:在两幅图像中提取出有用的特征信息,如角点、边缘等。

4. 立体匹配:通过一定的匹配算法,将两幅图像中的特征信息进行匹配,形成对应的点对。

5. 三维重建:根据匹配的点对,利用三角测量原理,计算出场景中物体的三维坐标信息。

四、双目立体视觉测量技术的应用双目立体视觉测量技术具有高精度、高效率、非接触等优点,已经广泛应用于多个领域。

1. 工业检测:双目立体视觉测量技术可以用于工业产品的尺寸检测、缺陷检测等。

2. 机器人导航:双目立体视觉技术可以用于机器人的导航和定位,提高机器人的自主性和智能化程度。

3. 三维重建:双目立体视觉技术可以用于三维重建,为虚拟现实、增强现实等提供技术支持。

4. 医学影像:双目立体视觉技术可以用于医学影像的三维重建和测量,如牙齿、骨骼等结构的测量和分析。

双目立体视觉方法测量雷管药量高度王乐;岳晓峰;宋雷【摘要】Both the operation principle and calibration method of the binocular stereo vision system are introduced .With the binocular vision software CCAS , we calibrate the VS078FC camera . The calibration is with high precision ,short time and practical .The Geomagic studio software is applied to remove the noises in the point cloud images .%介绍了双目立体视觉系统的基本原理、摄像机标定技术以及对得到的点云图进行的后续处理。

采用维视图像的CCAS单双目视觉标定算法软件对所用的VS078FC摄像机进行了标定,结果精确度高,用时短,实用性强。

应用Geomagic studio软件进行点云处理去除噪声,误差小,数据完整。

【期刊名称】《长春工业大学学报(自然科学版)》【年(卷),期】2014(000)002【总页数】4页(P196-199)【关键词】双目立体视觉;摄像机标定;点云处理【作者】王乐;岳晓峰;宋雷【作者单位】长春工业大学机电工程学院,吉林长春 130012;长春工业大学机电工程学院,吉林长春 130012;长春工业大学机电工程学院,吉林长春 130012【正文语种】中文【中图分类】TP3910 引言随着我国经济建设的高速发展,矿山等企业的生产规模不断扩大,以及工程爆破的多样化,对雷管、炸药等火工产品的需求日益增长。

雷管的起爆过程是在外界冲能(电、磁、热等)的激发下,迅速由爆燃转为爆轰,以引爆雷管中的猛炸药,并使之完全爆轰,从而引爆炸药。

Bumblebee 双目测量基本原理

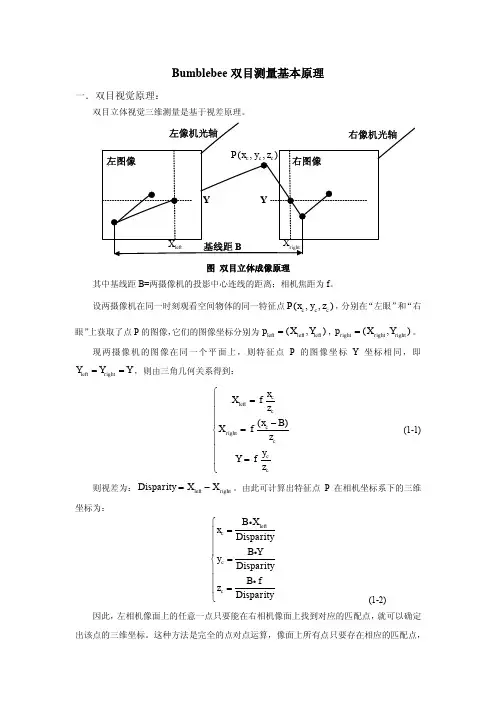

一.双目视觉原理:

双目立体视觉三维测量是基于视差原理。

图双目立体成像原理

其中基线距B=两摄像机的投影中心连线的距离;相机焦距为f 。

设两摄像机在同一时刻观看空间物体的同一特征点(,,)c c c P x y z ,分别在“左眼”和“右眼”上获取了点P 的图像,它们的图像坐标分别为(,)left left left p X Y =,(,)right right right p X Y =。

现两摄像机的图像在同一个平面上,则特征点P 的图像坐标Y 坐标相同,即left right Y Y Y ==,则由三角几何关系得到:

()c left c c right c c c x X f z x B X f z y Y f z ⎧=⎪⎪⎪-=⎨⎪⎪=⎪⎩ (1-1)

则视差为:left right Disparity X X =-。

由此可计算出特征点P 在相机坐标系下的三维坐标为:

left c c c B X x Disparity B Y y Disparity B f z Disparity ⎧=⎪⎪⎪=⎨⎪⎪=⎪⎩ (1-2)

因此,左相机像面上的任意一点只要能在右相机像面上找到对应的匹配点,就可以确定出该点的三维坐标。

这种方法是完全的点对点运算,像面上所有点只要存在相应的匹配点,

就可以参与上述运算,从而获取其对应的三维坐标。

二.立体视觉测量过程

1.图像获取

(1) 单台相机移动获取

(2) 双台相机获取:可有不同位置关系(一直线上、一平面上、立体分布)

2.相机标定:确定空间坐标系中物体点同它在图像平面上像点之间的对应关系。

(1)内部参数:相机内部几何、光学参数

(2)外部参数:相机坐标系与世界坐标系的转换

3.图像预处理和特征提取

预处理:主要包括图像对比度的增强、随机噪声的去除、滤波和图像的增强、伪彩色处理等;

特征提取:常用的匹配特征主要有点状特征、线状特征和区域特征等

4.立体匹配:根据对所选特征的计算,建立特征之间的对应关系,将同一个空间物理点在不同图像中的映像点对应起来。

立体匹配有三个基本的步骤组成:1)从立体图像对中的一幅图像如左图上选择与实际物理结构相应的图像特征;2)在另一幅图像如右图中确定出同一物理结构的对应图像特征;3)确定这两个特征之间的相对位置,得到视差。

其中的步骤2是实现匹配的关键。

5.深度确定

通过立体匹配得到视差图像之后,便可以确定深度图像,并恢复场景3-D信息。

三.Triclops库中的数据流程

Triclops库中的数据流程如下图所示。

系统首先从相机模型中获得raw格式的图像,最终将其处理成深度图像。

在系统中有两个主要的处理模块。

第一个处理模块是一个应用了低通滤波、图像校正和边缘检测的预处理模块。

第二个处理模块用来做立体匹配、结果确认和亚像素插值。

最后的处理结果就是一幅深度图像。

1.预处理(Pre-processing)

为了校正一幅图像,事先对其进行平滑是非常重要的。

所以如果要校正一幅图像,事先将低通滤波器打开是很好的方法。

当然不使用低通滤波器同样可以校正图像,但校正后的图像可能会出现混淆的现象。

如果要提高处理速度,可以将低通滤波器关掉。

2.校正(Rectification )

校正是用来修正镜头所产生的畸变的。

在原始图像中可以看到镜头所带来的这种畸变。

例如,场景中的一条直线在原始图像中会变成一条曲线,这种效果在图像的边角处尤为明显。

校正就是为了修正这种类型的畸变。

进一步来讲,如果没有正确的校正,那么沿着行或者列所做的特征搜索将可能产生错误的结果。

3.边缘检测(Edge detection )

边缘检测为任选特性,它使用亮度的变化来匹配特征。

当系统中的相机具有自动增益功能时,这项功能是非常有用的。

如果每个相机的自动增益的变化是不一致的,那么图像间的绝对亮度是不一致的,而虽然绝对亮度是不一致的,但亮度的变化却是一个常数。

因此边缘检测适用于光照有很大变化的环境当中。

虽然边缘检测可以改善检测的结果,但这相当于又引入了另外的处理步骤,因此要权衡结果的改善状况和速度之间的关系来使用这项功能。

注意,确认功能仅在边缘检测模式下有效。

4.立体处理(Stereo processing )

使用绝对方差相关性计算:

[][][][]22max

min 22min m m m m d right left d d i j I x i y j I x i d y j ==-=-++-+++∑∑

其中:min d 和max d 是最小和最大视差(disparity )

m 是模板尺寸(mask size )

right I 和left I 是右边和左边的图像

5.视差范围(Disparity range )

视差范围是立体算法为了在两幅图像中搜寻最佳匹时,所搜寻的像素的范围。

在Triclops 系统中0个像素的视差代表了无穷远处的物体。

最大的视差定义了能被检测到的最近的物体。

我们需要根据实际的任务来设置合适的视差范围。

减小视差范围可以加快系统的运行速度,并降低误匹配的几率。

6.相关模板(Correlation mask )

相关模板是围绕着一个像素的一个正方形邻域,这个像素就是系统想要为其寻找匹配的像素。

我们可以设定这个相关模板的尺寸。

大的模板会产生更密集更平滑的深度图像,然而,在识别不连续深度位置的精度上会有所欠缺。

另一方面,小的模板所产生的图像较为稀疏且会有更多的噪声,但在定位不连续深度的时候会有上佳的表现。

为了生成相同的结果,模板的尺寸要与被处理图像的分辨率成一定的比例。

就是说为了得到具有可比性的结果,对于160x120图像的5x5的模板,对于320x240图像的时候模板要增大到9x9。

模板的尺寸必须是奇数。

3x3,5x5,7x7是有效的模板尺寸,而4x4,6x6,8x8则是无效的模板尺寸。

Triclops提供了最大为15x15和最小为1x1的模板。

另外,Triclops 中提供了一个新的用于实验的函数:troclopsSetAnyStereoMask,这个函数允许用户设置任意尺寸的相关模板。

7.确认(Validation)

在一些情况下,例如封闭的缺乏变化的质地,是无法建立图像之间的相关的。

如果相关建立的不正确,那么测量的结果也就是不正确的了。

为了避免不正确的测量,系统引入了两个确认的方法:

●质地确认(Texture validation)是基于相关模板的质地的水平的,它决定了视差值是否

有效。

如果质地的水平不足以产生一个正确的匹配,这个像素就会被声明为无效。

●唯一性确认(Uniqueness validation)是指对于一个特定像素的最佳匹配和这个相关模板

下的其他匹配比起来是不是足够好。

即使相关模板的质地满足要求,由于封闭的原因,可能还是得不到正确的匹配。

如果相关的结果不足够强,这个像素就会被声明为无效。

用户可以设定两个阈值来控制确认的严格程度—一个是质地另一个是唯一性。