VMware vSphere配置iSCSI及NFS存储

- 格式:doc

- 大小:1.68 MB

- 文档页数:39

对于整个主机系统,存储可能是其中最为缓慢和复杂的一部分,并且很容易成为整个系统的瓶颈,这对于那些在主机上运行虚拟机的用户,存储可能会使得整个系统变得相当缓慢。

在VMware的虚拟化环境中,存储I/O控制(Storage I/O Control)提供了必要的存储I/O控制,并且可以确保运行关键业务的虚拟机性能不会被其它主机上和其共享I/O资源的虚拟机影响到。

VMware存储I/O管理最初在vSphere4.1中引入,将vSphere的存储资源控制提升到一个更高的标准。

在vSphere5中,存储I/O管理得到进一步增强,可以支持NFS数据存储和集群内的I/O共享。

在vSphere4.1之前的版本中,存储资源控制可以在每台主机的虚拟机级别进行设置,所使用的共享功能提供按优先级排序的存储资源访问。

虽然对于单台主机这种方式可行,但很多场景下许多主机会共享数据存储,但是由于每台主机各自运作,控制虚拟机对磁盘资源的访问,某台主机上的虚拟机可能会限制其它主机上对磁盘资源的使用。

以下是一个出现问题的例子:• 主机A有大量非关键业务的虚拟机,占用数据存储1,其磁盘共享设置为“正常”。

• 主机B运行一个关键业务的SQL服务器虚拟机,同样占用数据存储1,其磁盘共享设置为“高”。

• 主机A上的非关键虚拟机启动一项事物,初始了一个内部磁盘I/O;由于主机A中的资源并不紧张,该虚拟机可以占用其所需的所有存储I/O资源。

• 数据存储1收到主机A上的虚拟机大量的I/O资源请求。

• 结果主机B上关键业务SQL虚拟机的存储性能受到影响。

存储I/O控制的工作机制存储I/O控制通过在数据存储级别增强存储资源控制解决这一问题,所有集群内的主机和虚拟机访问数据存储时都对虚拟机进行优先级排序后才能访问存储资源。

因此,当有更高优先级的虚拟机,即使是在其它主机上,需要更多的存储资源时,一个低或正常优先级的虚拟机会被限速。

存储I/O控制可以在任何数据存储上激活,并且一旦激活,会通过拥堵的阈值测量存储子系统的延迟。

如何在VMware环境中实施、配置iSCSI存储通过这篇文章你将学到:学会如何在VMware环境中实施、配置iSCSI存储。

遵循这些最佳实践,让你的iSCSI数据存储获得最大的性能和可靠性。

在VMware环境下实施iSCSI存储是许多数据存储专业人员在2011年将要考虑的。

他们中的很多人听到有关iSCSI和FC存储好处的对比已经很多年了,而现在他们讨论的是,当使用VMware时如何配置iSCSI。

在价格方面,通常实施iSCSI存储比FC存储便宜;性能方面,通过使用10Gb以太网,iSCSI的性能提高了,这也是iSCSI存储最主要的好处。

不好的一面是,实施iSCSI存储通常会带来额外的CPU开销。

不过,VMware已经改写了theiSCSI软件启动堆栈,从而更有效地利用CPU周期,与VMware Infrastructure 3(VI3)相比,这带来了显着的效率和吞吐量的提高。

在VMware环境下使用iSCSI存储的最佳实践一旦iSCSI磁盘配置好了,虚拟机(VMs)就可以使用它们了。

以下列出的最佳实践可以帮助你在VMware环境中的iSCSI数据存储获得最大的性能和可靠性。

iSCSI存储的性能高度依赖于网络的健康和使用。

为了达到最佳效果,你应该总是通过专用的网络将iSCSI的流量分离出来。

你只能在一个ESX服务器主机上配置一个软件启动器。

配置为iSCSI提供连接的vSwitch时,使用多个物理网卡来提供冗余。

确保你将VMkernel(虚拟机内核)接口与vSwitch 的网卡绑定在一起,这样多路径配置才正确。

确保你在iSCSI vSwitch上使用的网卡连接到不同的网络交换机,以消除单点故障。

vSphere支持使用存储协议的巨型帧,但它只对那些拥有非常大I/O的特定工作量有好处。

此外,你的后端存储必须能够处理RAID组中拥有大量主轴(大于15)增加的吞吐量,否则你也看不到任何好处。

如果你的I/O小并且你的存储是主轴方向的(spindle-bound),使用巨型帧你将看到你的性能很少或者没有提高在某些情况下。

VMware连接共享存储的方式有三种,SAN,IP SAN(也就是iSCSI) 和NAS(NFS)。

这篇文章不是介绍这3者的区别的,关于SAN和NAS的区别,请去google一下。

其次,这篇文章也不考察FC SAN,如果你的环境中已经有了支持MPIO的SAN并且有足够的存储空间,那么尽量利用起来吧。

因为很多文章都指出:NAS/NFS是低I/O需求工作负载的理想介质,光纤则是针对高需求工作负载的理想选择。

(这里有一篇可供参考的译文:http://stor /387/8638887.shtml)那么,对于VMware来说,NFS好还是iSCSI好呢?看了不少文档,包括NetApp和VMwar e都没有明确的说孰优孰劣。

比较笼统的一个说法是,看你自己熟悉哪一种环境。

【成本】首先,不能不考虑的最重要的因素是成本。

如果从头构建一个存储网络,那么成本应该是FC S AN > HW iSCSI > SW iSCSI = NFS 。

在这里,我们没有考虑10G以太网和FCoE。

还是因为10G的设备和配件都太贵。

现实案例:在我们单位的环境中,因为考虑成本的因素,没有SAN(SAN通常都比较贵,你必须购买专用的HBA卡,至少2个SAN Switch,并且还要为你的存储配备FC SAN接口)。

我们内部的存储网络环境主要就是2种:iSCSI和NFS。

MS Cluster Service(比如email 和MS SQL)用的是iSCSI,Oracle DB用的是NFS。

于是,我们的VWware就剩下了2个选择,iSCSI和NFS。

(硬件的iSCSI因为CPU资源并不是瓶颈,吞吐量上也没有优势,出于成本考虑也放弃掉了)成本上:SW iSCSI 和NFS打平手。

【性能】NFS是基于IP的,但是不是基于IP的存储协议,在网络开销方面似乎要略大一些。

但是性能测试却表明,NFS和iSCSI几乎不相上下(读性能相当,写性能略差)。

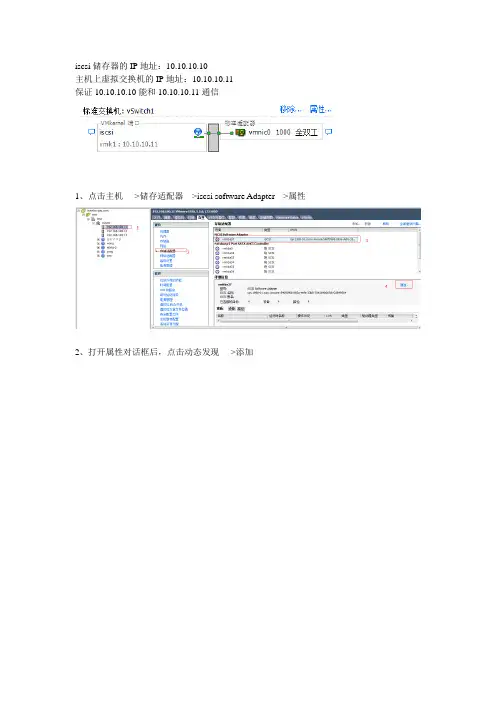

iscsi储存器的IP地址:10.10.10.10主机上虚拟交换机的IP地址:10.10.10.11保证10.10.10.10能和10.10.10.11通信1、点击主机---->储存适配器--->iscsi software Adapter--->属性2、打开属性对话框后,点击动态发现---->添加3、输入ISCSI服务器的IP地址,点击确定点击是,重新扫描说明:如果在“储存器”中没有找到可用的ISCSI存储,请检查前面的虚拟交换机的端口地址是否正确,以及在存储服务器中添加的ISCSI目标、卷、IP地址的对应关系是否正确,然后再次重新扫描iscsi设备。

4、添加储存。

点击主机--->储存器---->添加储存器输入存储器的名称,(在Vcenter中显示的名称)完成后,就可以在存储器中看到添加的存储。

创建虚拟机模板:window server 2003 与window xp 属于相同架构,创建模板的方法相同。

window server 2008 与window 7 、window Vista 属于相同架构,创建模板的方法相同。

部署window server 2003模板:1、安装window server 2003 系统2、安装完系统,安装VMware tools、安装常用软件(输入法、WinRAR),不要再模板中安装杀毒软件。

3、运行gpedit.msc或点击开始---管理工具----本地安全策略。

登录时不需要按CTL+ALT+DELETE就可以登录。

4、将window server 2003 中的support/tools 文件夹中deploy.cat展开后的结果复制到Vcenter的C:\Documents and Setting\All Users\Application Date\VMware VirtualCenter\sysgrep\srv2003 中设置虚拟机随主机一同启动在exsi虚拟机中使用U盘或其他外设1、将U盘插在主机上2、添加硬件设备3、添加USB控制器该类型最大允许在虚拟机中添加2个USB设备(2端口的USB设备)然后添加USB设备,从列表中选择可用的USB设备。

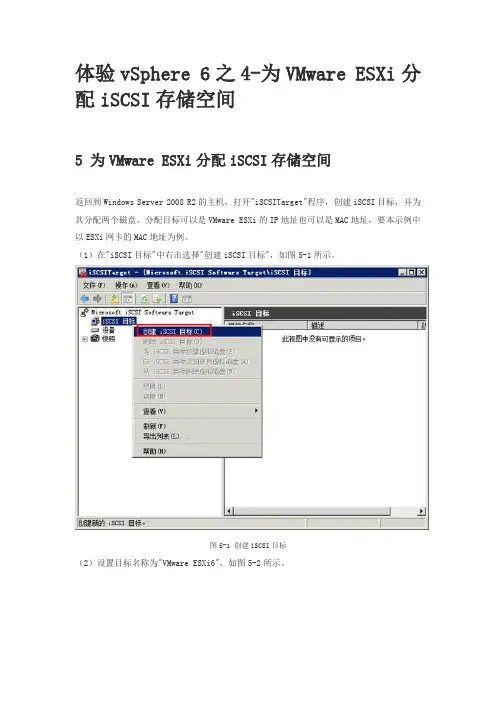

体验vSphere 6之4-为VMware ESXi分配iSCSI存储空间5 为VMware ESXi分配iSCSI存储空间返回到Windows Server 2008 R2的主机,打开"iSCSITarget"程序,创建iSCSI目标,并为其分配两个磁盘。

分配目标可以是VMware ESXi的IP地址也可以是MAC地址,要本示例中以ESXi网卡的MAC地址为例。

(1)在"iSCSI目标"中右击选择"创建iSCSI目标",如图5-1所示。

图5-1 创建iSCSI目标(2)设置目标名称为"VMware ESXi6",如图5-2所示。

图5-2 设置目标名称(3)在"iSCSI发起程序标识符"对话框中,单击"高级"按钮,如图5-3所示。

图5-3 高级(4)在"高级标识符"对话框中单击"添加"按钮,如图5-4所示。

图5-4 添加(5)在"添加/编辑标识符"对话框中,在"标识符类型"下拉列表中选择"MAC地址",并在值中添加VMware ESXi服务器网卡的MAC地址,如图5-5所示。

图5-5 MAC地址(6)如果要查看网卡的MAC地址,可以选中每一个网卡,单击"高级"按钮,在弹出的对话框中,显示MAC地址,如图5-6所示。

图5-6 显示MAC地址(7)对于两台ESXi主机、每个主机4个网卡来说,一共8个MAC地址,都要添加到列表中,如图5-7所示。

图5-7 添加网卡的MAC地址(8)添加目标之后,向iSCSI目标中创建虚拟磁盘,如图5-8所示。

图5-8 创建虚拟磁盘(9)将虚拟磁盘保存在D盘一个文件夹,例如VHD-iSCSI文件夹中,如图5-9所示。

图5-9 设置虚拟磁盘保存位置(10)添加的第一个磁盘文件名为esxi6.vhd,如图5-10所示。

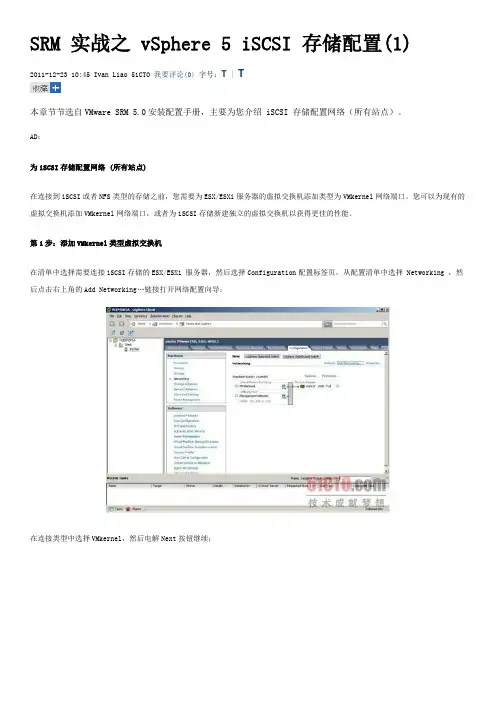

SRM 实战之 vSphere 5 iSCSI 存储配置(1)2011-12-23 10:45 Ivan Liao 51CTO 我要评论(0)字号:T | T本章节节选自VMware SRM 5.0安装配置手册,主要为您介绍 iSCSI 存储配置网络(所有站点)。

AD:为iSCSI存储配置网络 (所有站点)在连接到iSCSI或者NFS类型的存储之前,您需要为ESX/ESXi服务器的虚拟交换机添加类型为VMkernel网络端口。

您可以为现有的虚拟交换机添加VMkernel网络端口,或者为iSCSI存储新建独立的虚拟交换机以获得更佳的性能。

第1步:添加VMkernel类型虚拟交换机在清单中选择需要连接iSCSI存储的ESX/ESXi 服务器,然后选择Configuration配置标签页,从配置清单中选择 Networking ,然后点击右上角的Add Networking…链接打开网络配置向导;在连接类型中选择VMkernel,然后电解Next按钮继续;第2步:为虚拟交换机选择上行网络适配器使用独立的网络适配器作为iSCSI存储连接将会获得更佳的性能。

在此文档示例中将使用vmnic1 作为iSCSI存储连接适配器,vmnic0 默认已经被用于虚拟机以及管理控制台连接;给新建的虚拟交换机端口/端口组命名;第3步:为VMkernel配置连接设置输入IP地址,网络掩码以及配置网关,然后完成配置;新增的vSwitch1交换机中命名为VMK-iSCSI的端口用于iSCSI连接,使用ESX/ESXi服务器的第二块物理网卡vmnic1作为上行网络适配器。

请确定此网络适配器在生产中与您iSCSI存储服务器连接在同一物理交换机,并相应修改防火墙设置。

添加以及配置iSCSI软件适配器(所有站点)vSphere 5默认没有配置 iSCSI 软件适配器,您必须手工添加。

第1步:添加 iSCSI 软件适配器在vSphere Client中选择ESX/ESXi服务器,然后选择 Configuration 标签,在配置清单中选择Storage Adapters ,然后点击Add…链接;点击OK按钮确认添加iSCSI软件适配器;vSphere Client提示您需要在添加适配器后进行配置以访问iSCSI目标。

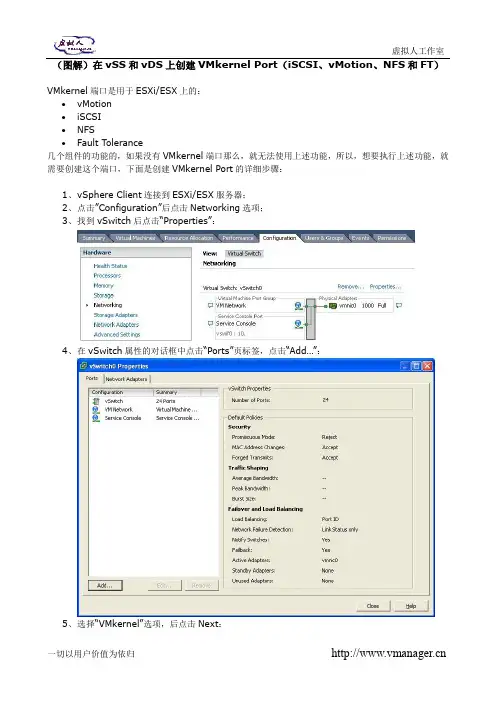

(图解)在vSS和vDS上创建VMkernel Port(iSCSI、vMotion、NFS和FT)

VMkernel端口是用于ESXi/ESX上的:

∙vMotion

∙iSCSI

∙NFS

∙Fault Tolerance

几个组件的功能的,如果没有VMkernel端口那么,就无法使用上述功能,所以,想要执行上述功能,就需要创建这个端口,下面是创建VMkernel Port的详细步骤:

1、v Sphere Client连接到ESXi/ESX服务器;

2、点击”Configuration”后点击Networking选项;

3、找到vSwitch后点击“Properties”:

4、在vSwitch属性的对话框中点击“Ports”页标签,点击“Add…”:

5、选择“VMkernel”选项,后点击Next:

6、为VMkernel Port设置一个标签(名字),可以根据自己的爱好设定。

然后如果有VLAN则输入

VLAN ID,没有则算;如果需要利用这个VMkernel做vMotion或Fault Tolerance则勾选相关选项,否则不选,然后点击Next:

7、输入VMkernel Port的IP地址、子网掩码和相关的缺省网关后点击Next:

8、最后一次检索相关配置,如果没问题则点击Finish完成配置:

9、创建好之后,可以在vSwitch的Properties里面查看相关的配置信息:

10、到这里就完成所有的VMkernel相关的创建啦,以后如果需要查看相关信息可以在ESXi/ESX

服务器的“Configuration”页标签后查看“Networking”里的相关信息。

vSphere环境下iSCSI存储的最佳实践下面罗列的一些关于iSCSI存储系统的最佳实践,有助于我们在使用过程中获得最佳的性能和可用性。

●iSCSI存储系统的性能表现与网络的健康程度和利用率密切相关,为了追求最佳的效果,准备一个独立的网络环境,完全隔离iSCSI数据流是必要的。

●每台ESX server主机只能配置一个软件initiator。

为iSCSI连接配置vSwitch时,可以利用多个物理网络端口形成冗余结构。

如果想正确的配置多路径,还要确保VMkernel接口与vSwithc中的网络端口有正确的绑定关系。

●确保iSCSI vSwitch的网络端口与一个独立的网络交换机连接,以降低网络单点故障所带来的影响。

●vSphere支持存储协议中使用jumbo frames(巨帧),但是jumbo frames的优势只在一些非常特殊的环境中才能发挥出来,比如I / O的尺寸非常大的数据流。

此外,后端的存储系统必须能够处理较大的吞吐量,比如RAID组中磁盘的数量大于等于15个,否则我们将看不到任何效果。

如果I / O尺寸太小或者磁盘数量不够,那么使用jumbo frames的效果会很差,甚至感觉不到任何性能的提升。

在某些环境下,jumbo frames还可能会造成性能的衰减,所以在启用jumbo frames 之前和之后做两次性能测试,比较jumbo frames产生的影响是必要的。

还有一个需要注意的问题是,整个连接环节中,每一个端到端的组件都必须支持并且打开jumbo frames功能,包括物理网络端口和网络交换机、vSwitch(虚拟交换机)、VMkernel端口、以及iSCSI目标端。

其中任何一个环节没有设置jumbo frames,jumbo frames都不会起作用。

●使用最新的Paravirtual SCSI总线控制器(PVSCSI)作为虚拟机的磁盘控制器,可以带来最大的吞吐带宽和性能,超过传统上常用的标准LSI Logic以及BusLogic总线控制器。

试用vSphere 6(四):配置数据中心(添加ESXi 主机、新建数据中心\集群等)2015 年3 月2 日, 下午11:13 —————————————————————————————————————————-一、VMware vSphere 6(RC版)安装配置系列文章:1、试用vSphere 6(一):安装ESXi 6 RC版2、试用vSphere 6(二):使用vSphere Client 6.0管理ESXi主机3、试用vSphere 6(三):安装vCenter 6(独立数据库)之:域控服务器安装与配置4、试用vSphere 6(三):安装vCenter 6(独立数据库)之:数据库服务器安装与配置5、试用vSphere 6(三):安装vCenter 6(独立数据库)之:vCenter安装与配置6、试用vSphere 6(四):配置数据中心(添加ESXi主机、新建数据中心\集群等)7、试用vSphere 6(五):ESXi主机添加iSCSI存储8、试用vSphere 6(六):VCSA(6.0.0.2175370)的安装与配置二、VMware vSphere 6 RC版下载三、整个实验环境如下:数据中心名称:DataCenterESXi集群名称:Cluster域:vsphere6.local业务网网络:192.168.232.0/24,网关:192.168.232.2iSCSI网络:192.168.222.0/24ESXi主机01:192.168.232.100,iSCSI网卡:192.168.222.100,主机名:esxi01ESXi主机02:192.168.232.101,iSCSI网卡:192.168.222.101,主机名:esxi02域控服务器01:192.168.232.201,主机名:dc01域控服务器02:192.168.232.202,主机名:dc02vCenter数据库服务器:192.168.232.203,主机名:vcdbvCenter服务器:192.168.232.204,主机名:vCenteriSCSI服务器:192.168.222.10四、实验拓扑图:—————————————————————————————————————————-完成了vCenter服务器的安装后,可以开始添加ESXi主机以及其它配置的进行,首先在域控服务器中,按照规划将两个ESXi主机的A记录完成添加,两台分别为esxi01和esxi02,如下图完成后,使用vSphere Client管理客户端分别连接两个ESXi主机,进入配置->DNS和路由,再点击属性,如下图按照规划填写相应内容,名称为esxi01,域为vsphere6.local,DNS即为两台域控(232.201和232.202),如下图,另一台也相同配置。

vSphere下如何添加iSCSI存储Step 1:为软件iSCSI创建VMkernel端口。

●vSwitch连接的网卡要求是千兆适配器。

IP地址与iSCSI可在相同的子网,也可在不同的网络,但要求可路由到iISCSI storage。

Step 2:启用软件iSCSI启动器●Configuration>Storage Adapters选项中,选择要配置的iSCSI启动器,然后单击属性。

●单击[Configure],此时将打开常规属性对话框,显示启动器的状态、默认名称和别名。

●要启用启动器,请选择已启用。

●要更改启动器的默认iSCSI名称,请输入新的名称。

●单击确定保存更改。

Step 3:配置 iSCSI 启动器的发现地址●在iSCSI属性配置中选择[Dynamic Discovery],单击[Add].●输入iSCSI存储系统的IP地址或DNS名称。

在主机与此系统建立“发送目标”会话后,新发现的任何目标均将出现在“静态发现”列表中。

●点击[CHAP]。

●选择[Do no use CHAP],点击[OK]。

返回上一级菜单。

●再点击[OK]确定以上选项。

●提示适配器总线发生变化,建议重新扫描。

点击[Yes]进行扫描。

●自动扫描后,新发现的LUN将显示在设备列表上。

●也可选择手动扫描。

点击右上方[Rescan]进行扫描。

Step 4:创建 VMFS 数据存储前提条件:创建数据存储之前,必须安装和配置存储器所需的全部适配器。

重新扫描适配器以发现新增的存储设备。

适用于添加本地存储、iSCSI存储及SAN存储。

●打开Configuration>Storage选项,显示主机已有的VMFS分区信息。

●点击右上方[Add Storage]。

●对于iSCSI存储存储选择[Disk/LUN]。

●点击[Next]。

●点击[Next]。

●如果要格式化的磁盘是空白磁盘,则“Current Disk Layout”页面将自动显示整个磁盘空间,以进行存储器配置。

vSphere 4•一、概述在部署了vSphere 后,大部分企业享存储往往比本地存储提供更好的I/O 共享存储作为先决条件。

ESX 支持FC SA 储,取决于应用系统的数量以及并发价格也依次递推;本篇就简单介绍一下提示:由于各家存储厂商的产品配• 二、FC SAN Storage 配置1、配置前准备:首先为ESX 主机配置光接口速度选配,考虑到冗余,一般会为接好,连接时注意极性;最后在存储上关存储的配置文档FC HBA 卡2、ESX FC SAN 配置:首先确认光纤卡是否re 4系列之八:Storage 分企业会选择使用共享存储来承载虚拟机及其数据,性能(尤其在多虚拟机环境下);2、vSphere FC SAN 、iSCSI SAN 和NFS NAS 这3种类型的共享存储并发I/O 量,其中FC SAN 性能最好,其次是iSCSI SAN 绍一下以上3种共享存储在ESX 中的配置置。

产品配置不同,所以此处不讲存储端的配置,只讲配置光纤存储卡,常见的光纤存储卡的速度有2G 般会为每台ESX 主机配置2块光纤卡;然后把ESX 光纤存储上为ESX 服务器划分LUN ,并和ESX 服务器光纤卡卡是否已被ESX 识别,如下:配置,这主要考量到2点:1、共ere 中的一些高可用性功能需要享存储;具体实施中选择何种存I SAN ,最后是NFS NAS ,当然讲ESX 端的配置;、4G 和8G ,请根据存储端的光纤卡和存储端使用光纤线连光纤卡关联,具体步骤可查看相点击上图中的“重新扫描”:如果存储端以及连接等都OK ,扫描后,提示:如果无法扫描到存储,首先应检查一看产品文档扫描到存储设备后,切换到“存储器”标签 选择存储类型为“磁盘/LUN”,会发现新的存储,如下: 检查一下光纤线极性连接是否正确,光纤卡一般都有标签,点击“添加存储器”般都有指示灯显示状态,具体查选择磁盘,下一步(由于实验环境所限,以下截图使用iSCSI存储,光纤存储的添加和此完全相同)输入数据存储(卷)的名称选择格式化块的大小,不同块大小支持的单个文件大小不同,VMFS-3最大支持的单个文件大小为2TB到添加好的存储 (卷)提示:在首台ESX 主机上添加并格储•三、iSCSI SAN Storage 配置1、iSCSI 存储简介:iSCSI 是把SCSI 储一般分为服务器端(Target )和客户端一般称作iSCSI HBA 卡,因为SCSI 指令集并且可显著降低iSCSI 对主机CPU 的使用硬件兼容性网站);本文只介绍ESX 使用iSCSI HBA 卡2、ESX iSCSI 存储配置:1.) ESX 软Initiator 使用专用的VMker 点击vSwitch“属性”加并格式化共享存储后,后续在其他ESX 主机中只需CSI 指令集封装在以太网协议中,通过现有的IP 网络来客户端连接器(Initiator ),其中Initiator 可以分为硬件和指令集的装载通过HBA 卡完成,所以硬件Initiator 的使用率;ESX 已内置软件Initiator ,并且也支持iSCSI H 使用软Initiator 连接iSCSI 存储。

4.2.1 VMware vSphere存储概述无论在传统架构还是在虚拟化架构中,存储都是重要的设备之一。

只有正确配置、使用存储,vSphere的高级特性(包括vSphere vMotion、vSphere DRS、vSphere HA等)才可以正常运行。

实验拓扑如图1-111所示。

图1-111 配置vSphere使用iSCSI存储1.VMware vSphere支持的存储类型VMware ESXi主机可以支持多种存储方法,包括:●本地SAS/SATA/SCSI存储●光纤通道(Fibre Channel,FC)●使用软件和硬件发起者的iSCSI●以太网光纤通道(FCoE)●网络文件系统(NFS)其中,本地SAS/SATA/SCSI存储也就是ESXi主机的内置硬盘,或通过SAS线缆连接的磁盘阵列,这些都叫做直连存储(Direct-Attached Storage,DAS)。

光纤通道、iSCSI、FCoE、NFS均为通过网络连接的共享存储,vSphere 的许多高级特性都依赖于共享存储,如vSphere vMotion、vSphere DRS、vSphere HA等。

各种存储类型对vSphere 高级特性的支持情况见表1-1。

表1-1 各种存储类型对vSphere高级特性的支持情况要部署vSphere虚拟化系统,不能只使用直连存储,必须选择一种网络存储方式作为ESXi主机的共享存储。

对于预算充足的大型企业,建议采用光纤通道存储,其最高速度可达16Gb/s。

对于预算不是很充足的中小型企业,可以采用iSCSI存储。

2.vSphere数据存储数据存储是一个可使用一个或多个物理设备磁盘空间的逻辑存储单元。

数据存储可用于存储虚拟机文件、虚拟机模板和ISO镜像等。

vSphere的数据存储类型包括VMFS、NFS和RDM三种。

(1)VMFSvSphere虚拟机文件系统(vSphere Virtual Machine File System,VMFS)是一个适用于许多vSphere部署的通用配置方法,它类似于Windows的NTFS和Linux的EXT4。

vSphere ESXi主机配置iSCSI存储vSphere ESXi主机一般连接的存储类型有光纤存储、iSCSI存储两类。

本次案例为iSCSI存储连接ESXi主机的配置。

案例环境:ESXi主机通过以太网络来连接iSCSID存储,并获取到存储空间,拓扑如下:首先完成iSCSI存储与交换机的配置,由四根千兆网线连接,两边都做端口捆绑,总带宽为4*1000Mbps。

存储映射出来10个5T的lun给两台ESXi虚拟机。

存储对外的iSCSI服务地址为172.19.134.102,后面ESXi主机会通过这个地址来连接存储。

然后开始ESXi主机的iSCSI配置,每台ESXi主机由两块网卡连接至iSCSI存储交换机,形成冗余,具体配置如下:首先添加iscsi虚拟交换机,因为有两块网卡,所以对应分别添加两个iscsi 虚拟交换机,进入“配置”->“网络”配置界面,如下图,点击“添加网络…”按扭选择添加“VMkernel”,如下图:选择其中一块iSCSI网卡,如下图写入标签名称,其它不用更改,如下图按照规划写入第一块iSCSI网卡的通信IP,如下图点击完成创建第一块iSCSI通信网卡。

使用同样的方法创建第二块iSCSI网卡,完成后,应该会得到如下图红框中的配置。

创建完两个iSCSI标准交换机后,开始配置与存储的连接。

首先添加ESXi自带的软iscsi网卡适配器,如下图,进入“配置”->“存储适配器”,点击右上角的“添加”按扭添加完成后,会看到上图中的网卡,再点击“属性”按扭。

在弹出的对话框中选择“网络配置”开始添加刚才创建的两个VMkernel iSCSI虚拟交换机,如下图,点击“添加”按扭开始添加。

如下图,选择第一块iSCSI卡再用同样的方法添加第二块iSCSI卡,完成后就能在VMkernel端口绑定框中看到添加的网卡,如下图所示。

路径状态这里为未使用,是因为还没添加存储。

接下来开始添加iSCSI存储,切换到“动态发现”选项,如下图,点击“添加”,准备将前面提到的存储服务地址172.19.134.102添加进配置中在弹出的对话框中输入iSCSI存储服务地址172.19.134.102,端口默认为3260不更改,点击确定即可。

VMware vSphere 4.1虚拟化学习手册8:配置iSCSI及NFS存储

上一篇([VMware vSphere 4.1虚拟化学习手册7:存储基础] )介绍了VMware vSphere存储,这里看看如何配置iscsi及NFS共享存储。

FC SAN的配置和iscsi 配置方法基本一致,这里由于环境限制不做介绍。

测试环境如下:

•两台esx Server

•一台windows 2008做vCenter

•freenas做iscsi服务器

iSCSI存储简介:

iSCSI 是把SCSI指令集封装在以太网协议中,通过现有的IP网络来传输存储数据;iSCSI存储一般分为服务器端(Target)和客户端连接器(Initiator),其中Initiator可以分为硬件和软件2种,硬件Initiator一般称作iSCSI HBA 卡,因为SCSI指令集的装载通过HBA卡完成,所以硬件Initiator比软件Initiator效率更高,并且可显著降低iSCSI对主机 CPU的使用率;ESX已内置软件Initiator,并且也支持iSCSI HBA卡(具体可参考vSphere硬件兼容性网站)。

这里我们使用的是FreeNAS作为iSCSI服务器的软件iSCSI方式。

VMware vSphere中配置iSCSI需要建立一个单独的存储网络来走存储流量,参

考[VMware vSphere 4.1虚拟化学习手册5:虚拟交换机vSwitch]

首先添加VMkernel,这个网络是专门用来走iSCSI和NFS存储数据的

选择VMkernel使用的vSwitch

设置VMkernel使用的名称及是否用作vMotion

配置VMkernel的IP地址及网关

确认添加VMkernel配置

完成配置之后再vSwitch0下多了一个VMkernel的虚拟端口。

接下来添加iscsi存储器

开启软件iscsi功能

在动态发现中输入iscsi服务器地址,如果只是要加入iscsi服务器中的某块硬盘可以选择静态发现

添加成功之后就可以看到新增了一个iscsi software adapter的存储适配器及这块适配器下的两个iscsi硬盘

接下来添加存储器,也就是我们存储虚拟机的存储空间

选择磁盘/LUN

选择可用的iSCSI磁盘

显示选择的磁盘状况

为数据存储起一个名称

选择块大小及容量

确认添加

添加完成之后再存储数据中就可以看到新增加的iscsi空间了

接着在看看如何配置NFS存储

关于NFS的介绍可以参考:[Redhat Linux下NFS的配置及操作] 再添加一个存储控制器,选择网络文件系统

输入服务器地址,nfs的目录,再给数据存储起个名称

确认配置

配置完成之后可以在数据存储中看到新增的nfs1

在同一个数据中心中,只要一台服务器添加了iscsi共享存储,其他服务器会自动添加这些iscsi共享存储,也就是只需要添加一次就可以了。

VMware vSphere 4.1虚拟化学习手册11:使用Converter工具V2V、P2V导入虚拟机

VMware vCenter Converter简介

VMware vSphere是企业级的虚拟平台,当VMware vSphere基础架构搭建好后,如何把现有跑在物理机上的应用迁移到虚拟机上,如何将其他平台的虚拟机迁移到VMware vSphere上,或者将其他格式的系统迁导入到VMware vSphere上,

VMware提供了解决方案VMware vCenter Converter工具,此工具可以实现P2V (物理机在线或离线迁移到虚拟机)、V2V(VMware各虚拟机产品之间或和hyper-V之间的转换),以及把第三方的备份镜像迁移入虚拟机(Symantec backup exec System Recovery的备份文件)。

VMware vCenter Converter版本及组件

版本vCenter Converter分Enterprise和Standalone 2个版本,前者属于vSphere Enterprise授权,后者是免费版;2者功能上几乎相同,前者安装后所有操作界面集成在vCenter中,后者则是单独的操作界面;后者支持迁移最新的Windows Server 2008 R2和windows 7

vCenter Converter Enterprise版还有一个可引导的光盘版,用于离线冷迁移使用;

vCenter Converter Enterprise安装文件集成在vCenter安装包里,Standalone 可在官方免费下载;

组件

vCenter Converter安装包主要分以下3个组件:

vCenter Converter服务器端:实现整个迁移过程的核心组件,执行虚拟机格式装换和重新配置等关键任务;

vCenter Converter客户端:用户操作界面,用于连接服务器端执行相关任务;

vCenter Converter Agent:在迁移过程中安装在源机器上,用于数据抓取和传送,迁移结束后会自动卸载;

VMware vCenter Converter的安装

插入VIM光盘,执行安装程序“vCenter Converter”

安装vCenter Converter欢迎界面安装协议

选择安装路径

输入vCenter的服务器地址及账号

安全证书确认

确认vCenter端口

指定vCenter的使用的名称确认开始安装

安装完成

到vCenter的插件管理界面中启用vCenter Converter插件

开始安装vCenter Converter Client

确认安装

vCenter Converter Client安装完成

通过vCenter Converter导入现有虚拟机V2V 右键点击导入计算机

选择导入虚拟机的源类型,通过Converter可以把物理机、VMware其他产品生成的虚拟机、hyper-v虚拟机、备份镜像等迁移到vSphere 环境中,这里选择导入VMware Workstation虚拟机,指定虚拟机文件所在位置,必须vCenter Converter可以访问的到。

指定导入后虚拟机所在的esx的服务器,虚拟机的名称,存储空间等信息

编辑高级选项

确认导入配置

进行到这里基本就完成了v2v的虚拟机导入了,接下来就是等待导入完成了。

通过vCenter Converter导入现有物理机P2V

同样是选择导入计算机,选择源类型为“已启动的计算机”,物理机需要开通WMI服务,另外建议将物理机的防火墙关闭。

确认安全证书

选择物理机导入后的位置、计算机名、存储空间

剩下的配置和前面导入虚拟机一致。