正则化的最小二乘估计及其应用

- 格式:pdf

- 大小:217.14 KB

- 文档页数:5

基本最小二乘法全文共四篇示例,供读者参考第一篇示例:基本最小二乘法(Least Squares Method)是统计学中一种常用的参数估计方法,其基本思想是通过最小化实际观测值与理论值之间的残差平方和来求得模型参数。

最小二乘法常用于回归分析、拟合曲线以及解决线性方程组等问题。

最小二乘法的核心思想是寻找使得误差的平方和最小的参数估计值。

具体来说,假设有n个数据点(x_1,y_1), (x_2,y_2), …, (x_n,y_n),要拟合这些数据点,可以假设它们之间存在某种函数关系y=f(x),通过最小化残差平方和的方法来确定函数f(x)的参数值。

最小二乘法的数学表达式可以用下面的公式来表示:\min_{\beta} \sum_{i=1}^{n} (y_{i} - \beta^{T}x_{i})^{2}y_{i}是实际观测值,x_{i}是自变量,\beta是要求解的参数向量。

最小二乘法的优势在于它是一种封闭解的方法,能够直接获得参数的解析解,而不需要通过迭代算法来求解。

最小二乘法对于数据中的离群点具有一定的鲁棒性,能够有效地排除异常值的影响。

最小二乘法在实际应用中有着广泛的应用。

在回归分析中,最小二乘法可以用来拟合数据点并预测新的输出值;在信号处理中,最小二乘法可以用来估计信号的频率和幅度;在机器学习和人工智能领域,最小二乘法也被广泛应用于线性回归、岭回归等算法。

最小二乘法也存在一些限制。

最小二乘法要求数据满足线性关系,并且误差项服从正态分布。

如果数据不符合这些假设,最小二乘法的结果可能会出现偏差。

最小二乘法对数据中的离群点较为敏感,如果数据中存在大量离群点,最小二乘法的结果可能会受到影响。

为了解决最小二乘法的这些限制,人们提出了许多改进的方法。

岭回归(Ridge Regression)和Lasso回归(Lasso Regression)是两种常见的正则化方法,可以在最小二乘法的基础上引入惩罚项来减少模型的复杂度,并提高模型的泛化能力。

最小二乘法在参数估计与拟合中的应用研究引言:最小二乘法是一种常用的数学方法,广泛应用于参数估计与数据拟合等领域。

本文将探讨最小二乘法的原理及其在实际问题中的应用,旨在展示其在参数估计与拟合中的重要性和实用性。

一、最小二乘法的原理最小二乘法是一种通过最小化误差平方和来确定参数的方法。

其基本思想是,通过找到使得实际观测值与理论值之间差距最小的参数组合,来对数据进行拟合和估计。

二、参数估计中的最小二乘法参数估计是统计学中的重要问题,通过最小二乘法可以有效地进行参数估计。

以线性回归为例,假设我们有一组观测数据,其中自变量和因变量之间存在线性关系。

通过最小二乘法,我们可以找到最佳的拟合直线,从而估计出回归方程中的参数。

三、拟合问题中的最小二乘法在数据拟合问题中,最小二乘法也发挥着重要的作用。

以曲线拟合为例,假设我们有一组离散的数据点,我们希望找到一条曲线来拟合这些数据。

通过最小二乘法,我们可以选择合适的曲线模型,并通过调整模型的参数来使得拟合曲线与实际数据之间的误差最小化。

四、最小二乘法在实际问题中的应用最小二乘法在各个领域都有广泛的应用。

在物理学中,最小二乘法可用于测量实验数据与理论模型之间的偏差。

在经济学中,最小二乘法可用于估计经济模型中的参数,从而进行经济预测和政策制定。

在工程学中,最小二乘法可用于信号处理、图像处理和控制系统设计等领域。

五、最小二乘法的优缺点最小二乘法作为一种常用的参数估计和数据拟合方法,具有一定的优点和缺点。

其优点在于简单易用、计算效率高,并且在许多实际问题中表现良好。

然而,最小二乘法也存在一些缺点,比如对异常值敏感,对数据分布的假设要求较高等。

六、结论最小二乘法作为一种重要的数学方法,在参数估计与拟合中发挥着关键作用。

通过最小化误差平方和,我们可以得到最佳的参数估计和数据拟合结果。

然而,在实际应用中需要注意最小二乘法的局限性,并结合具体问题进行合理选择。

总结:本文介绍了最小二乘法在参数估计与拟合中的应用研究。

最小二乘法的原理及其应用一、研究背景在科学研究中,为了揭示某些相关量之间的关系,找出其规律,往往需要做数据拟合,其常用方法一般有传统的插值法、最佳一致逼近多项式、最佳平方逼近、最小二乘拟合、三角函数逼近、帕德(Pade逼近等,以及现代的神经网络逼近、模糊逼近、支持向量机函数逼近、小波理论等。

其中,最小二乘法是一种最基本、最重要的计算技巧与方法。

它在建模中有着广泛的应用,用这一理论解决讨论问题简明、清晰,特别在大量数据分析的研究中具有十分重要的作用和地位。

随着最小二乘理论不断的完善,其基本理论与应用已经成为一个不容忽视的研究课题。

本文着重讨论最小二乘法在化学生产以及系统识别中的应用。

二、最小二乘法的原理人们对由某一变量t或多个变量t1--..tn构成的相关变量y感兴趣。

如弹簧的形变与所用的力相关,一个企业的盈利与其营业额,投资收益和原始资本有关。

为了得到这些变量同y之间的关系,使用不相关变量去构建y,使用如下函数模型Vm=f*"q;f1,*■・[Ip),q个相关变量或p个附加的相关变量去拟和。

通常人们将一个可能的、对不相关变量t的构成都无困难的函数类型充作函数模型(如抛物线函数或指数函数)。

参数x是为了使所选择的函数模型同观测值y相匹配。

(如在测量弹簧形变时,必须将所用的力与弹簧的膨胀系数联系起来)。

其目标是合适地选择参数,使函数模型最好的拟合观测值。

一般情况下,观测值远多于所选择的参数。

其次的问题是怎样判断不同拟合的质量。

高斯和勒让德的方法是,假设测量误差的平均值为00令每一个测量误差对应一个变量并与其它测量误差不相关(随机无关)。

人们假设,在测量误差中绝对不含系统误差,它们应该是纯偶然误差,围绕真值波动。

除此之外,测量误差符合正态分布,这保证了偏差值在最后的结果y上忽略不计。

确定拟合的标准应该被重视,并小心选择,较大误差的测量值应被赋予较小的权。

并建立如下规则:被选择的参数,应该使算出的函数曲线与观测值之差的平方和最小。

最小二乘估计及其应用在许多实际问题中,我们需要从已知的数据集中预测一些未知的结果,这时候统计学中的回归分析就派上用场了。

回归分析旨在通过输入变量(预测因子)和输出变量(预测结果)之间的数学关系,来预测未知值。

其中最小二乘估计(Least Squares Estimation)是回归分析的一种基本方法,也广泛应用于其他实际问题中。

最小二乘估计是一种方法,通过最小化预测数据与实际数据之间的误差平方和来构建回归方程。

这个方法可以用于线性回归和非线性回归,因为这两种回归方法都需要预测数据与实际数据之间的误差平方和尽可能的小。

最小二乘估计的核心思想是,找到一条线/曲线(回归方程),使该线/曲线与每个实际数据点的距离之和最小。

这个距离也称为残差(Residual),表示预测值与真实值之间的差异,而误差平方和则是所有残差平方和的总和。

在线性回归中,最小二乘估计会找到一条直线(回归直线),使得直线上所有数据点到该直线的距离之和最小。

回归方程可以用以下公式表示:y = β0 + β1x其中y是输出变量,β0是y截距,β1是y与x之间的斜率,x是输入变量。

β0和β1的值是通过最小化残差平方和来估计。

非线性回归中,最小二乘估计会找到一条曲线(回归曲线),使得曲线上所有数据点到该曲线的距离之和最小。

在这种情况下,回归方程的形式不再是y=β0 + β1x,而是通过一些非线性函数(如指数、幂函数等)来表示。

这时候,估计β0和β1的完整算法由于模型的非线性而变得更加复杂,但最小二乘估计仍然是其中一个核心算法。

最小二乘估计可以应用于多种实际问题中。

在金融领域,最小二乘估计可用于计算资产回报和风险之间的关系。

在医学研究中,最小二乘估计可用于研究某种疾病与多个因素(如年龄、性别、生活方式)之间的关系。

在电子商务领域,最小二乘估计可用于分析客户购买行为,以制定更有效的市场营销战略。

总的来说,最小二乘估计可以应用于所有需要预测未知值的领域中。

牛顿内点法求解h 正则化的最小二乘问题王侦倪,邱欢(西安石油大学电子工程学院,陕西西安,710065 )摘要:本文主要描述了一种用于求解大规模A 正则LSP 的专用内点方法,该方法使用预条件共轭梯度算法来计算搜索方向,内点方法可以在短时间内解决大量稀疏问题,其中包含一百万个变量和观察值并且可以通过利用这些变换的快速算法来有效 地解决大量密集问题,并用实验证明了该算法。

关键词:内点法;共轭梯度法;稀疏Newton interior point method for solving regularized least squares problemWang Zhenni , Qiu Huan(School of electronic engineering , Xi*an Petroleum University , X if an Shaanxi , 710065)Abstract : This paper mainly describes a special interior point method for solving large-scale regular LSPs. This method uses the preconditioned conjugate gradient algorithm to calculate the search direction. Theinterior point method can solve a large number of sparse problems in a short time, including one hundred Thousands of variables and observations and can effectively solve a large number of intensive problems by using these transformations of fast algorithm, and experimentally proved the algorithm.Keywords : Interior point m e t h o d ; Conjugate gradient m e t h o d ; Sparse1公式介绍一个线性模型如下所示:y = Ax + v其中,jce J T 是未知向量,是观测向量,v e /T 是噪声,d e iT "”是字典矩阵。

基于同伦正则化的最小二乘支持向量机张瑞【摘要】最小二乘支持向量机作为一种新颖的人工智能技术,已越来越广泛地运用于各个学科领域,其本质是一种正则化方法.近几年出现了一种新的正则化方法:同伦正则化,该方法已在多个方面得到了很好的应用.作者通过研究,将这种新的正则化方法应用于最小二乘支持向量机,建立了一种新的模型.该模型与最小二乘支持向量机相比,其最大的优点就是大大缩短了正则化参数的优化时间.【期刊名称】《黑龙江科技信息》【年(卷),期】2018(000)031【总页数】2页(P12-13)【关键词】最小二乘支持向量机;同伦正则化;支持向量机【作者】张瑞【作者单位】山东理工大学数学与统计学院,山东淄博 255049【正文语种】中文【中图分类】TP181最小二乘支持向量机是由Suykens于1999年提出[1],它是支持向量机的一个变种,其优点是将支持向量机的二次规划问题转变成线性方程组的求解问题,在分类和回归等问题中得到了广泛的应用[2-5]。

最小二乘支持向量机与支持向量机都采用的都是正则化思想,都有一个共同的问题就是正则化参数难以优化。

近几年出现了一种新的正则化方法:同伦正则化,该方法已在理论及应用方面得到了发展[6-8]。

我们将这种新的正则化方法应用于最小二乘支持向量机,得到了一种新的模型,该模型与与最小二乘支持向量机相比,其优点就是实验设计简单,而且能大大缩短了正则化参数的优化时间。

1 最小二乘支持向量机简介设已知训练集对于非线性可分的分类问题,最小二乘支持向量机构造如下的优化问题:式中, ξi为松弛因子。

上述优化问题最终转化为求解线性方程:其中称为核函数。

求出a与b,得到非线性预测模型:2 基于同伦正则化的最小二乘支持向量机两个函数f(x)和g(x)同伦是指引入一个参数λ ,得到一个全新的函数:L(x)=(1- λ ) f(x)+ λ g(x)中,其中参数λ 的取值范围为(0,1)。

将该思想引入到最小二乘支持向量机中,模型如下:引入同伦最小二乘问题的拉格朗日函数是:求这个函数关于原始变量的微分,得到:将②式代入①式容易得出矩阵方程:表1 试验中用到的UCI数据集数据集, 维数, 训练集的个数, 测试集的个数,banana, 2, 200, 100,heart, 13, 170, 100,German, 20, 200, 100,thyroid, 5, 140,75,titanic, 3, 150, 100,表2 在标准UCI数据集上分类的最大精度及对应的参数,数据集, ,精度, ,同伦正则化参数, 修改后的高斯核参数,banana, 0.9500, ,,,,,0.6470, ,,,,,,,0.3236,heart,0.8300, ,,,,,0.0002, ,,,,,,,0.1962,German, 0.8300, ,,,,,0.3530, ,,,,,,,0.0590,thyroid, 0.9867, ,,,,,0.0002, ,,,,,,,0.3530,titanic, 0.8200, ,,,,,0.0001, ,,,,,,,0.0100,计算得化简得:因为:化简移项可得:将④式代入③式可求α另外,最常用的核函数是高斯核:对其修改为3 实验结果分析实验所用的数据集是标准的UCI数据集,见表1。

最小二乘估计随着空间技术的发展,人类的活动开始进入了太空,对航天器(包括人造地球卫星、宇宙飞船、空间站和空间探测器等)的观测手段和轨道确定提出了很高的精度要求。

在计算技术高速发展的推动下,各种估计理论也因此引入到轨道估计方法中。

大约在1795年高斯在他那著名的星体运动轨道预报研究工作中提出了最小二乘法。

最小二乘法就成了估计理论的奠基石。

最小二乘估计不涉及观测数据的分布特性,它的原理不复杂,数学模型和计算方法也比较简单,编制程序不难,所以它颇受人们的重视,应用相当广泛。

对于严格的正态分布数据,最小二乘估值具有最优一致无偏且方差最小的特性。

实践证明,在没有粗差的情况下,大部分测量数据基本上符合正态分布。

这是最小二乘估计至今仍作为估计理论核心的基础。

最早的轨道确定就是利用最小二乘法,用全部观测数据确定某一历元时刻的轨道状态的“最佳”估值,即所谓的批处理算法定轨。

长期以来,在整个天体力学领域之中,各种天体的定轨问题,几乎都是采用这一方法。

卫星精密定轨的基本原理为:利用含有误差的观测资料和不精确的数学模型,通过建立观测量与卫星状态之间的数学关系,参数估计得到卫星状态及有关参数的最佳估值。

参数估计的基本问题就是对一个微分方程并不精确知道的动力学过程,用不精确的初始状态*0X 和带有误差的观测资料,求解其在某种意义下得卫星运动状态的“最佳”估值0ˆX 。

常用的参数估计方法有两种,最小二乘法和卡尔曼滤波方法。

最小二乘法是在得到所有的观测数据之后,利用这些数据来估计初始时刻状态量的值,由于用到的观测数据多、计算方法具有统计特性,因此该方法精度高。

卡尔曼滤波在观测数据更新后,利用新的观测数据对状态量进行改进得到这一观测时刻的状态量,卡尔曼滤波适用于实时处理。

卫星精密定轨输运高精度的事后数据处理,通常采用最小二乘法进行参数估计。

记观测量的权阵为 P 。

利用加权最小二乘法计算总的观测方程方程0y Hx ε=+,得1()T T x H PH H Py -=卫星的参考状态为**000ˆX X x =+ 在精密定轨的过程中,由于状态方程和观测方程在线性化过程中会产生误差,上式的解算需要通过不断的迭代。

总体最小二乘正则化算法的载荷识别张磊;曹跃云;杨自春;何元安【期刊名称】《振动与冲击》【年(卷),期】2014(000)009【摘要】载荷识别中存在病态矩阵求逆的不稳定性将导致解严重失真。

在总体最小二乘(Total Least Squares TLS)算法的思想上进行Tikhonov正则化,构造载荷识别的目标函数。

然后利用共轭梯度(Conjunction Gradient CG)法解算该目标函数的最优化问题,提出一种算法易实现、收敛性能好、存储量小,且能全面考虑随机误差影响的CG-TLS正则化算法。

经仿真和试验探讨了传递函数矩阵病态产生的原因,借助条件数优选振动响应点,最终检验CG-TLS正则化算法与常用的两种正则化算法在不同噪声水平时载荷识别的效果。

结果表明,CG-TLS正则化算法载荷识别效果最优,与真实值吻合好,并具有良好的鲁棒性。

因此,应用CG-TLS正则化算法实现载荷识别极具实际意义。

【总页数】6页(P159-164)【作者】张磊;曹跃云;杨自春;何元安【作者单位】海军工程大学动力工程学院,武汉 430033;海军工程大学动力工程学院,武汉 430033;海军工程大学动力工程学院,武汉 430033;中国船舶工业集团公司船舶系统工程部,北京 100036【正文语种】中文【中图分类】TH113;TB122【相关文献】1.共轭梯度最小二乘迭代正则化算法在冲击载荷识别中的应用 [J], 卢立勤;乔百杰;张兴武;陈雪峰2.基于正则化约束总体最小二乘的单站DOA-TDOA无源定位算法 [J], 赵拥军;赵勇胜;赵闯3.病态总体最小二乘的混合正则化算法 [J], 孙同贺;闫国庆4.病态总体最小二乘模型的正则化算法 [J], 袁振超;沈云中;周泽波5.基于子结构技术和Landweber迭代正则化的载荷识别 [J], 周凤;缪炳荣;李泽;杨昌休因版权原因,仅展示原文概要,查看原文内容请购买。

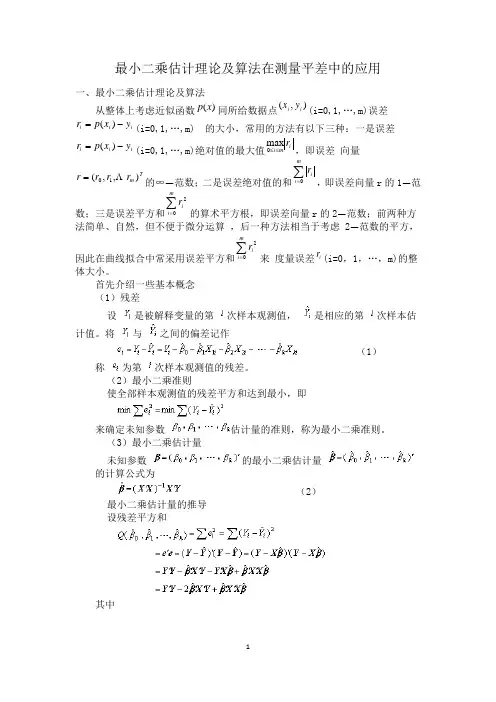

最小二乘估计理论及算法在测量平差中的应用一、最小二乘估计理论及算法从整体上考虑近似函数同所给数据点(i=0,1,…,m)误差(i=0,1,…,m)(i=0,1,…,m)绝对值的最大值,即误差 向量的∞—范数;二是误差绝对值的和,即误差向量r 的1—范数;三是误差平方和的算术平方根,即误差向量r 的2—范数;前两种方法简单、自然,但不便于微分运算 ,后一种方法相当于考虑 2—范数的平方,因此在曲线拟合中常采用误差平方和来 度量误差(i=0,1,…,m)的整体大小。

首先介绍一些基本概念 (1)残差设 是被解释变量的第 次样本观测值, 是相应的第 次样本估计值。

将与之间的偏差记作(1)称 为第 次样本观测值的残差。

(2)最小二乘准则使全部样本观测值的残差平方和达到最小,即来确定未知参数估计量的准则,称为最小二乘准则。

(3)最小二乘估计量 未知参数 的最小二乘估计量的计算公式为(2) 最小二乘估计量的推导 设残差平方和其中)(x p ),(i i y x i i i y x p r -=)(i i i y x p r -=)(im i r ≤≤0max Tm r r r r ),,(10 =∑=mi ir∑=mi ir02∑=mi ir02ir它是阶残差列向量。

为了得到最小二乘估计量,我们对上式进行极小化移项后,得正规方程组根据基本假定5.,存在,用左乘正规方程组两边,得的最小二乘估计量式(4)的无偏估计量随机误差项的方差的无偏估计量为(3)称作回归估计的均方误差,而(4)称作回归估计的标准误差。

(5)的方差(5)其中,,于是每个的方差为,而是矩阵对角线上对应的第个元素,。

(6)方差的估计量方差的估计量为(6)则每个方差的估计量为,(7)标准差的估计量为,(8)数据拟合的具体作法是:对给定数据 (i=0,1,…,m),在取定的函数类中,求,使误差(i=0,1,…,m)的平方和最小,即=从几何意义上讲,就是寻求与给定点(i=0,1,…,m)的距离平方和为最(图1)。

正则化方法求解最小二乘解

最小二乘是最常用的线性参数估计方法,早在高斯的年代,就用开对平面上的点拟合线对高维空间的点拟合超平面。

考虑超定方程其中b为数据向量,A为m*n数据矩阵并且m>n,假定数据向量存在误差和观测值无关,即b=b,+e为了抑制误差对矩阵方程求解的影响,引入一校正向量△b用它去”扰动“有误差数据向量b,使校正项尽可能小,同时通过强合Ax=b +△b补偿存在与数据向量b中的不确定性(噪声或者误差)使得b+△b=bo+e+△b→b,从而实现Ax=b +△b→

Ax=bo 的转换使校正向量尽可能小,则可以实现无误差的矩阵Ax=b。

的求解矩阵方程的这一求解思想可以用下面的优化问题进行描述

d0min|Obl|l2 = ||Ax-b||2 = (Ax -b)T(Ax -b)这个方法就称之为最小二乘法ordinary least squares OLS)。

回归分析中最小二乘估计的收敛速度

最小二乘估计是统计学中有效的数据分析方法,用于拟合有限的观测实例,以

求确定系统的最佳参数。

其中,最关键的一点是最小二乘法的收敛速度,它决定了算法可以到达最优解所需要的最短时间。

回归分析是一种定量分析方法,可以用于评估两个变量之间的依赖关系。

最小

二乘法是一种广泛使用的近似算法,由于其简单易行的性质,所以,它被广泛用于确定回归模型最终参数值。

针对最小二乘估计的收敛速度,有几种常见的方法可以加快该速度,其中最著

名的一种就是贝叶斯估计法。

贝叶斯估计法对最小二乘法的收敛速度有显著的影响,并比后者发现最优解的速度更快。

此外,正则化方法也可以促进最小二乘法的收敛速度。

正则化方法可以有效减

少参数的数量,使最小二乘法更有能力确定接近最优解的参数。

因此,正则化技术可以有效减少模型的复杂度,加快最小二乘估计的收敛速度。

另一种提高最小二乘估计收敛速度的方法是使用特征归一化技术,这往往可以

彻底改变期望函数的结构,推动最小二乘法更快地接近最优解。

综上所述,可以看到,最小二乘估计的收敛速度是一个极为重要的因素,通过

运用贝叶斯估计、正则化技术和特征归一化方法可以大幅度提高最小二乘法的收敛速度。

因此,在实践中,我们有必要更加重视这一因素,以期达到最优解的更快收敛。

正则最小二乘法正则最小二乘法一、概述正则最小二乘法(Regularized Least Squares)是一种常见的机器学习算法,用于解决线性回归中的过拟合问题。

它通过在损失函数中添加一个正则项来约束模型参数,从而避免模型过度拟合训练数据。

二、最小二乘法最小二乘法(Least Squares)是一种常用的线性回归方法,它通过最小化预测值与真实值之间的均方误差来求解模型参数。

其数学表达式如下:$\min_{w} \frac{1}{2} ||Xw - y||^2$其中,$w$ 是模型参数向量,$X$ 是输入特征矩阵,$y$ 是真实值向量。

三、过拟合问题在机器学习中,过拟合是指模型在训练集上表现良好但在测试集上表现较差的现象。

这是因为模型在训练时过度关注训练数据中的噪声和异常值,导致泛化能力较弱。

四、正则项为了避免过拟合问题,我们可以在损失函数中添加一个正则项来限制模型参数。

常见的正则项有 L1 正则和 L2 正则。

L1 正则项:$\lambda ||w||_1$L2 正则项:$\frac{\lambda}{2} ||w||^2$其中,$\lambda$ 是正则化参数,用于控制正则项的权重。

五、正则最小二乘法正则最小二乘法将最小二乘法和正则项结合起来,通过最小化如下损失函数来求解模型参数:$\min_{w} \frac{1}{2} ||Xw - y||^2 + \alpha R(w)$其中,$R(w)$ 是正则项,$\alpha$ 是正则化参数。

L1 正则最小二乘法:$\min_{w} \frac{1}{2} ||Xw - y||^2 + \lambda ||w||_1$L2 正则最小二乘法:$\min_{w} \frac{1}{2} ||Xw - y||^2 + \frac{\lambda}{2} ||w||^2$ 六、优缺点优点:1. 可以有效避免过拟合问题。

2. 可以提高模型的泛化能力。

缺点:1. 需要调节正则化参数 $\alpha$ 或 $\lambda$ 的值。

正则化最小二乘法介绍正则化最小二乘法是一种用于解决线性回归问题的技术。

在实际应用中,我们经常会面临到训练数据集中存在多个自变量,而且这些自变量之间可能存在相关性的情况。

为了解决这个问题,我们可以使用正则化最小二乘法来进行回归分析,以得到更稳定、更具有泛化能力的模型。

正则化介绍在回归问题中,正则化是一种控制模型复杂度的技术。

它通过在损失函数中引入一个正则化项,来惩罚模型中的高权重值,从而降低模型的复杂度。

正则化可以有效地防止模型出现过拟合的现象,提高模型的泛化能力。

常见的正则化技术包括:L1正则化(Lasso)、L2正则化(Ridge)以及弹性网络(ElasticNet)等。

L1正则化通过在损失函数中引入权重的绝对值之和,来惩罚模型中的高权重值;L2正则化则是通过在损失函数中引入权重的平方和,来惩罚模型中的高权重值;而弹性网络则是L1正则化和L2正则化的结合。

最小二乘法介绍最小二乘法是一种寻找最佳拟合直线的方法。

它的基本思想是,通过最小化实际观测值与预测值之间的残差平方和,来确定模型中的参数。

最小二乘法在线性回归问题中被广泛应用,并且具有良好的数学性质。

最小二乘法的公式为:θ = (X^T X)^-1 X^T y,其中θ代表模型中的参数,X代表观测值的特征矩阵,y代表观测值的目标值。

通过求解这个方程,我们可以得到最佳的参数估计值。

然而,最小二乘法存在一个问题,即当训练数据中存在多个自变量之间存在相关性时,最小二乘法会导致参数估计值的方差变得很大,从而降低模型的泛化能力。

这时候,正则化最小二乘法就可以发挥作用了。

正则化最小二乘法的原理正则化最小二乘法通过在最小二乘法的目标函数中加入一个正则化项,来控制模型中的权重。

这个目标函数可以表示为:J(θ) = (y - Xθ)^T(y - Xθ) +α||θ||,其中α是一个正则化参数,||θ||表示θ的范数(可以是L1范数或L2范数)。

通过引入正则化项,正则化最小二乘法可以在保持模型拟合程度良好的同时,减小模型中的高权重值。

最小二乘法曲线数据拟合

首先,最小二乘法的基本原理是通过最小化拟合曲线与实际数

据之间的误差平方和来确定最佳拟合曲线的参数。

这意味着拟合曲

线的参数将被调整,以使拟合曲线上的点与实际数据点的残差之和

最小化。

其次,最小二乘法可以用于拟合各种类型的曲线,例如线性曲线、多项式曲线、指数曲线等。

对于线性曲线拟合,最小二乘法可

以得到最佳拟合直线的斜率和截距;对于多项式曲线拟合,最小二

乘法可以确定最佳拟合多项式的系数;对于指数曲线拟合,最小二

乘法可以找到最佳拟合曲线的底数和指数。

此外,最小二乘法还可以通过添加约束条件来进行拟合。

例如,可以通过添加正则化项来控制拟合曲线的复杂度,以避免过拟合问题。

常见的正则化方法包括岭回归和Lasso回归。

在实际应用中,最小二乘法曲线数据拟合可以用于许多领域,

如经济学、统计学、物理学等。

它可以用于分析趋势、预测未来值、估计参数等。

例如,在经济学中,最小二乘法可以用于拟合经济模型,以评估不同因素对经济指标的影响。

最后,最小二乘法的计算通常可以通过数值方法来实现,例如

使用最小二乘法的矩阵形式求解线性方程组,或者使用迭代算法来

拟合非线性曲线。

总结起来,最小二乘法是一种常用的数据拟合方法,通过最小

化拟合曲线与实际数据之间的误差平方和来确定最佳拟合曲线的参数。

它可以适用于各种类型的曲线拟合,并可以通过添加约束条件

来进行拟合。

在实际应用中,最小二乘法可以用于分析趋势、预测

未来值、估计参数等。

最小二乘法的计算可以通过数值方法来实现。

最小二乘正则化反演代码最小二乘正则化反演是一种常用的地球物理方法,能够从实测数据中反演出地下结构模型。

该方法结合了最小二乘和正则化原理,能够有效地抑制噪声的影响,提高反演结果的稳定性和可靠性。

在反演过程中,需要编写相应的代码实现算法。

本文将从几个方面介绍最小二乘正则化反演代码的编写。

1. 数据预处理反演之前需要对实测数据进行处理,包括去除噪声、校正仪器响应、进行滤波等。

这些处理的代码通常是比较基础的数据处理方法。

在实现过程中需要特别注意参数的选择,以保证处理效果和反演结果的准确性。

2. 反演算法最小二乘正则化反演的核心是反演算法的实现。

可以采用多种数值方法,如迭代法、共轭梯度法、牛顿法等。

不同方法的适用条件和效率各不相同,需要根据具体情况选择。

反演算法的实现需要了解数值分析和优化方法的相关知识,能够熟练掌握常见的数值算法库,并且适当地进行改进,以达到更好的反演效果。

3. 正则化参数的选择正则化参数是最小二乘正则化反演中的重要参数,它直接影响反演结果的稳定性和可靠性。

通常正则化参数需要通过试错法进行选择,即尝试不同的参数值,比较反演结果和实际情况的拟合度,选择最优参数值。

在实现过程中需要合理选择取值范围和步长,以尽量减少试错次数和时间。

4. 反演结果的可视化反演结束后,需要对反演结果进行可视化处理,将结果以图形的形式呈现出来。

这包括反演模型的三维可视化、剖面展示、误差分析等。

可视化结果的好坏影响着反演结果的解释和模型的应用。

因此,在代码实现时需要考虑可视化库的选择和自定义调试接口的设计。

以上是最小二乘正则化反演代码实现的主要方面,还有许多细节和技巧需要注意。

由于反演问题的复杂性和多样性,编写高质量的反演代码需要一定的数值分析和物理学基础,需要经过大量的实践和调试才能得到稳定和准确的结果。