实时音频采集与播放技术的研究

- 格式:pdf

- 大小:274.30 KB

- 文档页数:6

一、实验目的1. 掌握音频的基本概念和分类。

2. 熟悉音频的采集、处理和播放方法。

3. 了解音频在各个领域的应用。

二、实验原理音频是一种通过声波传播的信息,它是人类日常生活中不可或缺的一部分。

音频信号可以通过声波采集设备(如麦克风)转换为电信号,再通过音频处理设备(如音频工作站)进行编辑、合成等操作,最后通过扬声器等设备播放出来。

三、实验器材1. 电脑一台2. 麦克风一个3. 音频编辑软件(如Audacity)4. 扬声器一对5. 音频线若干四、实验步骤1. 音频采集(1)将麦克风插入电脑的音频接口。

(2)打开音频编辑软件,设置采样率、采样位数等参数。

(3)进行语音录制,录制过程中注意保持录音环境安静。

2. 音频处理(1)打开音频编辑软件,导入采集到的音频文件。

(2)对音频进行剪辑、降噪、均衡等处理。

(3)合成音效,如添加背景音乐、人声混音等。

3. 音频播放(1)将音频文件导出为适合播放的格式。

(2)打开播放器,选择音频文件进行播放。

(3)调整音量、播放速度等参数,以达到最佳播放效果。

五、实验结果与分析1. 音频采集实验中采集到的音频信号清晰,无明显杂音。

2. 音频处理通过音频编辑软件对采集到的音频进行了剪辑、降噪、均衡等处理,使音频质量得到了显著提升。

3. 音频播放播放器成功播放了处理后的音频文件,音质清晰,无明显失真。

六、实验总结1. 通过本次实验,掌握了音频的基本概念和分类,了解了音频的采集、处理和播放方法。

2. 熟练掌握了音频编辑软件的使用,能够对音频进行简单的剪辑、降噪、均衡等处理。

3. 认识到音频在各个领域的广泛应用,如教育、娱乐、广告等。

4. 意识到在音频采集、处理和播放过程中,要注意保持录音环境安静,选择合适的设备,以达到最佳效果。

5. 在实验过程中,发现了一些问题,如麦克风质量较差导致采集到的音频信号噪声较大,这需要在今后的实验中加以改进。

七、实验建议1. 提高麦克风质量,以降低采集到的音频信号噪声。

电子信息工程中的智能音视频处理技术研究在当今数字化和信息化的时代,电子信息工程领域取得了飞速的发展,其中智能音视频处理技术作为一项关键的技术,正逐渐改变着我们的生活和工作方式。

音视频信息作为一种直观、丰富的信息载体,在通信、娱乐、安防、医疗等众多领域都有着广泛的应用。

而智能音视频处理技术的出现,更是为这些应用带来了更高的效率、更好的质量和更多的可能性。

智能音视频处理技术是一个综合性的学科领域,它融合了数字信号处理、图像处理、模式识别、机器学习、计算机视觉等多个学科的知识和技术。

其主要目的是对音视频数据进行有效的采集、编码、传输、存储、分析和处理,以提取有用的信息,实现各种智能化的任务,如语音识别、图像识别、目标跟踪、情感分析等。

在音视频数据的采集方面,随着传感器技术的不断进步,高清摄像头、麦克风阵列等设备能够获取更加清晰、准确的音视频信号。

同时,多模态数据的采集,如结合音频和视频的同步采集,为后续的处理和分析提供了更丰富的信息来源。

采集到的音视频数据通常需要进行编码压缩,以减少数据量,便于存储和传输。

常见的音视频编码标准如H264、H265 等,通过采用先进的压缩算法,在保证一定质量的前提下,大大降低了数据量。

在音视频数据的传输过程中,网络技术的发展起到了至关重要的作用。

高速的有线网络和无线网络使得音视频数据能够实时、流畅地传输。

然而,网络带宽的限制和不稳定仍然是一个挑战,这就需要采用自适应的传输策略,根据网络状况动态调整音视频的码率和帧率,以保证良好的用户体验。

音视频数据的存储也是一个重要的环节。

大量的音视频数据需要高效的存储系统来管理,如分布式存储、云存储等技术的应用,不仅提供了大容量的存储空间,还保证了数据的安全性和可靠性。

对于音视频数据的分析和处理,这是智能音视频处理技术的核心部分。

语音识别技术能够将语音信号转换为文字,为语音控制、语音输入等应用提供支持。

图像识别技术则可以对视频中的物体、场景进行识别和分类,实现智能监控、自动驾驶等功能。

简述多媒体应用的技术领域一、引言多媒体应用是指利用计算机技术,将音频、视频、图像等多种形式的信息进行处理和集成,以达到更好的传递和展示效果的应用。

在现代社会中,多媒体应用已经广泛应用于各个领域,如教育、娱乐、广告等。

本文将从技术领域出发,全面详细地介绍多媒体应用的相关技术。

二、音频技术1. 音频采集技术音频采集是指将声音信号转换为数字信号的过程。

采集设备包括麦克风、话筒等。

常见的音频采集格式有WAV、MP3等。

2. 音频编码技术音频编码是指将数字信号压缩为更小的数据量以便于传输和存储。

常见的音频编码格式有AAC、MP3等。

3. 音频播放技术音频播放是指将数字信号转换为模拟信号并通过扬声器输出。

常见的音频播放软件有Windows Media Player、iTunes等。

三、视频技术1. 视频采集技术视频采集是指将摄像机或其他设备捕捉到的图像转换为数字信号的过程。

常见的视频采集格式有AVI、MOV等。

2. 视频编码技术视频编码是指将数字信号压缩为更小的数据量以便于传输和存储。

常见的视频编码格式有H.264、MPEG-4等。

3. 视频播放技术视频播放是指将数字信号解码为图像并通过显示器输出。

常见的视频播放软件有Windows Media Player、VLC等。

四、图像技术1. 图像采集技术图像采集是指将相机或其他设备捕捉到的图像转换为数字信号的过程。

常见的图像采集格式有JPEG、PNG等。

2. 图像处理技术图像处理是指对数字信号进行各种操作,如去噪、增强等。

常用的图像处理软件有Adobe Photoshop、GIMP等。

3. 图像显示技术图像显示是指将数字信号转换为模拟信号并通过显示器输出。

常见的图像显示设备有液晶显示器、CRT显示器等。

五、交互技术交互技术是指利用计算机实现与用户之间的互动。

多媒体应用中,交互技术主要体现在用户与应用之间的交互上,如鼠标点击、键盘输入等。

六、总结综上所述,多媒体应用的技术领域涵盖了音频、视频、图像等多个方面。

音视频流媒体传输技术的原理与实现随着信息技术的飞速发展,音视频流媒体传输技术的应用变得越来越广泛。

音视频流媒体传输技术可以实现丰富多彩的媒体内容传输,如实时直播、点播、视频会议等。

本文将从原理和实现两个方面深入探讨音视频流媒体传输技术。

一、原理音视频流媒体传输技术的原理是将媒体内容通过网络传输,同时实时解码播放。

具体来说,音视频流媒体传输技术主要包括以下几个环节:(1)音视频采集:音视频内容首先通过摄像头、麦克风等采集设备获取。

(2)编码压缩:采集到的音视频内容需要进行编码压缩,以减少媒体数据量,提高传输效率。

常用的编码格式有H.264、H.265、AAC等。

(3)流媒体协议:传输压缩后的音视频数据需要基于一定的协议进行传输,以确保数据的完整性和实时性。

常用的协议有RTSP、RTMP、HTTP Live Streaming(HLS)、Dynamic Adaptive Streaming over HTTP(DASH)等。

(4)网络传输:通过互联网进行数据传输,需要考虑网络带宽、网络延迟等因素,以确保媒体数据的稳定流畅传输。

(5)解码播放:接收端收到数据后需要解码播放,以还原采集时的音视频内容。

常见的解码器有ffmpeg、VLC、Windows Media Player等。

以上环节是音视频流媒体传输技术的基本原理。

在实现中,还需要考虑不同设备的兼容性、安全性、传输延迟等问题。

二、实现音视频流媒体传输技术的实现需要涉及硬件设备、软件平台和网络环境等多个方面。

(1)硬件设备:音视频内容的采集需要相应的硬件设备,如摄像头、麦克风等。

接收端需要相应的解码器或播放器,如数字电视机顶盒、电视、电脑等。

(2)软件平台:音视频流媒体传输技术的实现需要相应的软件平台,如流媒体服务器、流媒体客户端等。

常见的流媒体服务器有Wowza、Nginx-rtmp、Adobe Media Server等。

流媒体客户端有VLC、HLS.js、DASH.js等。

音频信号的采集与处理技术综述音频信号的采集与处理技术在现代通信、音乐、语音识别和声音处理等领域有着广泛的应用。

本文将对音频信号的采集与处理技术进行综述,为读者介绍相关的原理、方法和应用。

一、音频信号的采集技术音频信号的采集是指将声音转化为数字形式,以便后续的处理和存储。

主要的音频信号采集技术包括模拟声音录制、数字声音录制和实时音频采集。

模拟声音录制是早期常用的技术,通过麦克风将声音转化为电信号,再经过放大、滤波等处理,最终得到模拟音频信号。

然而,由于模拟信号具有易受干扰、难以传输和存储等缺点,逐渐被数字声音录制技术所取代。

数字声音录制技术利用模数转换器(ADC)将模拟音频信号转化为数字形式,再进行压缩和编码,最终得到数字音频文件。

这种技术具有抗干扰性强、易于传输和存储的优点,广泛应用于音乐录制、广播电视和多媒体等领域。

实时音频采集技术是指能够实时地获取声音信号,并进行处理和分析。

这种技术常用于声音识别、语音合成和实时通信等场景,要求采样率高、延迟低,并能够处理多通道信号。

二、音频信号的处理技术音频信号的处理技术包括音频编码、音频增强和音频分析等方面。

这些技术能够对音频信号进行压缩、去噪、降噪和特征提取等操作,提高音频的质量和准确性。

音频编码技术是指将音频信号转化为数字数据的过程,常用的编码方法有PCM编码、MP3编码和AAC编码等。

PCM编码是一种无损编码方法,能够保持原始音频信号的完整性;而MP3和AAC编码则是有损压缩方法,能够在降低数据量的同时保持较高的音质。

音频增强技术用于提高音频信号的清晰度和可听性。

常见的音频增强方法包括降噪、回声消除和均衡器等。

降噪技术通过滤波和频域分析等方法,减少环境噪声对音频信号的影响;回声消除技术通过模型估计和滤波等方法,抑制声音的反射和回声;均衡器技术则用于调整音频信号的频率和音量,使其在不同场景下具有更好的效果。

音频分析技术用于提取音频信号的特征和信息。

常用的音频分析方法包括频谱分析、时域分析和时频分析等。

用DirectSound实现声音的实时采集、处理与播放

汤春林;左勇;张传华

【期刊名称】《计算机技术与发展》

【年(卷),期】2003(013)0z2

【摘要】DirectSound应用编程接口是DirectX应用编程接口的一个组件.文章介绍了DirectSound的基本原理,并就使用DirectSound在计算机网络中实时捕获、处理和播放声音进行了介绍和探讨.

【总页数】4页(P112-114,118)

【作者】汤春林;左勇;张传华

【作者单位】中国空气动力研究与发展中心通信修理所,四川,绵阳,621000;中国空

气动力研究与发展中心通信修理所,四川,绵阳,621000;中国空气动力研究与发展中

心通信修理所,四川,绵阳,621000

【正文语种】中文

【中图分类】TN912

【相关文献】

1.利用DirectSound实现音频的流式播放控制 [J], 赵亮;王庆敏;朱瑞娟

2.利用DirectSound实现游戏中的音效播放 [J], 宋丽敏

3.Windows95环境下声音的实时采集,处理,播放 [J], 韩雪梅

4.Windows95环境下声音的实时采集,处理,播放 [J], 韩雪梅

5.用Direct Sound实现声音的实时采集、处理与播放 [J], 汤春林;左勇;张传华

因版权原因,仅展示原文概要,查看原文内容请购买。

单片机音频处理与音频应用实现声音的采集和输出随着科技的不断发展,单片机在嵌入式系统中的应用越来越广泛。

其中,音频处理与音频应用是单片机应用领域的重要组成部分。

本文将介绍单片机音频处理的基本原理以及如何利用单片机实现声音的采集和输出。

一、单片机音频处理的基本原理在单片机中实现音频处理的基本原理是:通过外部音频信号接口将声音输入单片机,然后通过单片机内部的音频处理模块对声音进行数字化处理,最后通过外部音频信号接口将处理后的声音输出。

具体来说,音频信号首先需要经过模拟-数字转换(ADC)模块将模拟信号转换为数字信号。

ADC模块将模拟信号采样,并对每个采样值进行数字编码,以表示声音的幅度。

然后,采样得到的数字信号将被传送到单片机的处理单元进行数字信号处理。

处理单元可以对声音进行增益调节、滤波处理、降噪等操作。

最后,处理完成的数字信号通过数字-模拟转换(DAC)模块转换为模拟信号,再通过外部音频信号接口输出。

二、实现声音的采集和输出1. 声音的采集为了实现声音的采集,我们需要选择适合的音频采集模块,正确认识它的工作原理,然后将其与单片机相连。

音频采集模块通常包括麦克风、放大器和ADC模块。

麦克风用于将声音信号转换为电信号,放大器用于增强电信号,ADC模块则将电信号转换为数字信号。

在选取音频采集模块时,需要考虑采样率、分辨率等参数,以及所需的电源供应和接口类型等因素。

根据需求选择合适的模块,并将其与单片机相连,以实现声音的采集。

2. 声音的输出要实现声音的输出,我们同样需要选择适合的音频输出模块,并将其与单片机相连。

音频输出模块通常包括DAC模块、放大器和扬声器。

DAC模块将数字信号转换为模拟信号,放大器用于增强模拟信号,扬声器则将模拟信号转换为声音信号输出。

在选取音频输出模块时,同样需要考虑采样率、分辨率等参数,以及所需的电源供应和接口类型等因素。

根据需求选择合适的模块,并将其与单片机相连,以实现声音的输出。

多媒体技术实训课程学习总结音视频采集与处理算法的实际应用在多媒体技术的发展中,音视频的采集与处理算法起到了至关重要的作用。

在多媒体技术实训课程中,我深入学习了音视频采集与处理算法,并通过实际应用加深了对其应用的理解和掌握。

本文将对我在多媒体技术实训课程中学习音视频采集与处理算法的实际应用进行总结。

一、音视频采集技术音视频采集是多媒体技术中的重要环节,它是将声音与图像转化为数字信号的过程。

在实训课程中,我学习了音视频采集的基本原理和常见的方法。

通过使用采集设备和相应的软件,我了解了如何通过摄像头和麦克风对音视频进行实时采集。

通过设置采样率、帧率和分辨率等参数,我可以根据实际需求进行音视频采集设置。

此外,我还学习了音视频数据的压缩与编码技术,以提高采集效率和节约磁盘空间。

二、音视频处理算法在音视频采集的基础上,我学习了音视频处理算法,它是对采集的音视频数据进行处理和优化的关键环节。

在实训课程中,我熟悉了常用的音视频处理算法,如噪声滤波、图像增强、视频编辑等。

通过使用相应的软件工具,我可以对音频进行降噪处理,提高音频的清晰度和质量;同时,对于图像处理,我学会了应用边缘检测、色彩处理等算法来提高图像的锐度和色彩还原度;在视频编辑方面,我掌握了剪辑、合成和转场等技术,以创作出更加生动和有吸引力的视频作品。

三、音视频采集与处理算法的实际应用在实训课程中,我进行了一系列的实际应用,运用音视频采集与处理算法解决了一些实际问题。

以音频处理为例,我遇到了一个音频录制的问题,由于录制环境噪声较大,导致录制的音频质量较差。

通过应用噪声滤波算法,我成功将噪声降低,并使音频更加清晰。

这使我意识到音视频处理算法在实际生活中的巨大潜力,它可以在语音识别、音频恢复等领域发挥重要作用。

在视频处理方面,我进行了一个视频剪辑的实际应用。

通过使用剪辑软件,我将一段原始视频剪辑成多个片段,并通过添加转场效果和音乐配乐等手段,使视频更加生动和吸引人。

音频处理算法研究与实现引言:音频处理算法是指通过对音频信号的采集、分析和处理,达到对音频信号进行增强、编辑、修复、分离等目的的一系列算法。

随着数字音频技术的发展和多媒体应用的广泛应用,音频处理算法在音乐、语音识别、影视制作等领域发挥着重要的作用。

本文将介绍音频处理算法的研究与实现。

一、音频采集与预处理音频采集是指通过麦克风等设备将声音转换为电信号的过程。

在采集音频信号时,常常会受到环境噪声的干扰,因此预处理是非常重要的环节。

预处理算法包括降噪、滤波、均衡等处理,通过这些算法可以有效地减少信号中的噪声并提升信号质量。

二、音频特征提取与分析音频特征提取是指从音频信号中提取出具有代表性的特征,用于后续的音频分析和处理。

常用的音频特征包括时域特征、频域特征和时频域特征。

时域特征包括音频信号的幅度、时域波形和自相关函数等;频域特征包括音频信号的频谱、功率谱和频率矩等;时频域特征是时域和频域特征的结合,常用的时频域特征包括短时傅里叶变换(STFT)和小波变换等。

三、音频增强与修复音频增强和修复是指通过相应的算法对音频信号进行去噪、降低回声、提升清晰度等处理,从而改善音频的质量。

其中,去噪算法是最为常见和重要的处理方法之一。

去噪算法可以通过降低信号的噪声功率、采用自适应滤波器等方法来减少噪声对音频信号的干扰。

此外,回声抑制算法、失真修复算法等也是音频增强与修复中常见的算法。

四、音频分离与音源定位音频分离是指将混合的多个音频信号进行分离,分离出各个独立的音频源。

常见的音频分离算法包括盲源分离、独立成分分析(ICA)等。

音源定位是指通过对音频信号进行处理,确定音频信号来源的方位角度。

音源定位算法通常利用麦克风阵列的位置关系以及声波传播时间差等信息来实现。

五、音频编解码与压缩音频编解码是指将音频信号进行压缩编码以减少存储空间或传输带宽的过程。

目前最常用的音频编解码算法是MP3、AAC等。

这些编解码算法通过对音频信号进行压缩,使得音频文件的体积更小,同时尽量保持音频质量不受明显损失。

计算机音频处理实现声音的捕捉与处理在计算机音频处理领域,声音的捕捉与处理是一个重要的研究课题。

通过合适的技术手段,可以实现对声音的准确捕捉以及实时处理,从而满足人们对于高质量声音的需求。

本文将介绍计算机音频处理的基本原理,以及常见的声音捕捉与处理技术。

一、计算机音频处理基本原理计算机音频处理是利用数字信号处理技术对声音进行采集和处理的过程。

它主要涉及到声音的数字化、编码、解码和重构等过程。

具体来说,计算机音频处理包括以下几个步骤:1. 声音的数字化:将模拟声音信号转换为数字信号。

这一过程需要先对声音进行采样,即在时间轴上等间隔地记录声音的幅度值,并将其转换为二进制码。

2. 声音的编码:将数字化的声音信号进行编码,以便将其存储或传输。

常见的编码方式有脉冲编码调制(PCM)、自适应差分编码(ADPCM)、声音压缩编码等。

3. 声音的解码:将编码后的声音信号解码为原始的数字信号。

解码的过程是编码的逆过程,通过采样率和量化位数的恢复,将压缩或编码后的信号恢复为原始的数字信号。

4. 声音的重构:将数字信号转换回模拟声音信号。

这一过程需要使用数字模拟转换器(DAC),将数字信号恢复为模拟声音信号。

基于以上原理,我们可以实现对声音的准确捕捉与处理。

二、声音的捕捉技术声音的捕捉是指将外界的声音转换为计算机可以处理的数字信号。

常见的声音捕捉技术有以下几种:1. 麦克风捕捉:利用麦克风将声音转换为电信号,并经过模拟到数字的转换,将其输入到计算机。

麦克风的选择应根据不同的需求,包括灵敏度、频率响应等参数。

2. 数字信号输入:一些设备具有直接输入数字信号的接口,例如USB、HDMI等。

通过这些接口,可以将数字音频设备(如数字话筒、音频接口等)直接连接到计算机,实现声音的捕捉。

3. 声音采集卡:声音采集卡是专门用于声音捕捉的硬件设备,它可以将外界的声音转换为计算机可以处理的数字信号,并提供丰富的接口和功能,以满足不同的需求。

音频技术在广播中的应用研究广播作为一种重要的信息传播方式,在人们的日常生活中扮演着不可或缺的角色。

从早期的无线电广播到如今的数字化广播,音频技术的不断发展和创新为广播带来了翻天覆地的变化。

音频技术的应用不仅提升了广播的音质和传播效果,还丰富了广播的内容和形式,满足了听众日益多样化的需求。

一、音频技术的发展历程广播音频技术的发展可以追溯到 20 世纪初。

最初,无线电广播采用的是模拟信号传输,音质较为粗糙,容易受到干扰。

随着技术的进步,调频(FM)广播的出现显著提高了音质,减少了噪音和失真。

进入 21 世纪,数字音频技术逐渐成为主流。

数字音频信号具有更高的保真度、更强的抗干扰能力和更灵活的处理方式。

例如,数字音频广播(DAB)能够提供更多的频道选择和更高质量的声音,为听众带来了全新的听觉体验。

二、音频采集技术在广播中的应用音频采集是广播制作的第一步,其质量直接影响到最终的播出效果。

在广播中,常用的音频采集设备包括麦克风、录音笔等。

麦克风是最基本的音频采集工具。

不同类型的麦克风适用于不同的场景和声音源。

例如,动圈式麦克风适用于现场演出和嘈杂环境,电容式麦克风则对声音细节有更好的捕捉能力,常用于录音棚等安静环境。

为了获得高质量的音频采集效果,还需要注意录音环境的声学处理。

合理的声学装修可以减少反射声和混响,提高声音的清晰度和可懂度。

此外,随着移动设备的普及,利用智能手机进行音频采集也变得越来越常见。

一些广播节目会鼓励听众通过手机录制声音素材,增加了节目与听众的互动性。

三、音频编码与压缩技术在广播传输过程中,为了提高传输效率和节省带宽,音频编码与压缩技术至关重要。

常见的音频编码格式如 MP3、AAC 等,通过去除音频信号中的冗余信息,在保证一定音质的前提下减小文件大小。

这样可以在有限的带宽内传输更多的音频内容。

同时,动态比特率编码技术能够根据音频信号的复杂程度动态调整编码比特率,进一步优化传输效率。

在网络广播中,自适应流媒体技术会根据网络状况自动调整音频质量,确保听众能够流畅地收听节目。

-2017-0引言实时音视频数据采集和网络传输系统应用广泛,如视频会议、远程教育、实时视频监控、视频通话等。

多媒体技术的发展过程中产生了各种各样的文件格式和数据压缩格式,实时音视频数据采集和传输技术的发展历程和多媒体技术的发展历程类似,也有各种不同的采集技术和传输技术可供选择,根据实际问题的需要,选择合适的技术设计音视频数据实时采集和传输系统,是十分重要的。

在Windows 环境下,实时音视频采集可以使用采集设备(如采集卡)自带的SDK 进行,此类方法的优点是使用方便,缺点是硬件相关性强,不够灵活,不能适应复杂应用场合的需要。

更常用的是使用微软公司提供的VFW (video for Windows )、DirectShow 和Windows Media 。

1使用VFW 进行音视频数据的实时采集为解决数字音视频应用领域的问题,微软公司在1992年推出了VFW [7],应用程序使用VFW 提供的接口可以方便地实现音视频数据实时采集、编辑、播放等通用功能以及开发各种复杂的应用。

在VC++6.0上使用VFW 要包含文件vfw.h 和vfw32.lib 。

视频捕获功能主要存在于VFW 的AVICAP 模块,应用程序创建一个A VICAP 窗口,并通过向窗口发送消息来控制窗口的行为。

AVICAP 对视频捕获提供全面的支持,如将捕获到的数据写入磁盘文件和预览,然而,对于其它非文件型的使用则不够灵活,视频的格式和属性不可以在程序运行过程中通过编程进行改变,只能通过对话框进行设置。

在将实时音视频数据采集到文件的场合,VFW 重点支持的是A VI 文件。

使用VFW 进行音视频捕获的主要步骤为[6]:创建捕获窗口、注册回调函数、获取捕获窗口的缺省设置、设置捕获窗口参数、与捕获设备连接并获取捕获设备能力、设置捕获窗口显示模式、捕获视频数据到文件或者缓存,工作完毕,断开与捕获设备的连接。

VFW 的其它主要功能包括音视频数据的压缩和解压、A VI 文件的编辑处理、以及图像显示(DrawDib 模块)。

webrtc播放原理WebRTC(Web Real-Time Communication)是一种用于实时音视频通信的技术。

它允许通过网页浏览器进行高质量的音频和视频通信,无需额外的插件或软件安装。

WebRTC 的播放原理涉及以下几个关键组件和流程:1. 媒体采集:WebRTC 可以通过设备的摄像头和麦克风采集音频和视频数据。

通过网页浏览器提供的 API,应用程序可以获取到采集到的媒体数据。

2. 编码和解码:为了在网络上传输音频和视频数据,WebRTC 会对媒体数据进行编码。

常见的编码格式包括 H.264 用于视频和 Opus 用于音频。

在接收端,WebRTC 会对编码的数据进行解码,以还原出原始的音频和视频信号。

3. 网络传输:编码后的音频和视频数据通过实时传输协议(RTP)在网络上进行传输。

RTP 负责将数据分割成小块(数据包),并为每个数据包添加时间戳和顺序号,以确保数据的实时性和顺序性。

4. 信令和协商:在进行实际的媒体传输之前,WebRTC 涉及信令和协商过程。

通过信令通道(通常使用 SIP、SDP 等协议),通信方之间交换信息,如媒体能力、网络地址等,以协商和建立连接。

5. 媒体播放:接收端接收到 RTP 数据包后,WebRTC 会将其解码并呈现在网页浏览器中。

视频数据可以显示在视频元素中,音频数据可以通过浏览器的音频输出进行播放。

WebRTC 还包括一些其他功能,如回音消除、降噪、带宽自适应等,以提高通信质量。

它旨在提供跨平台、低延迟、高质量的实时音视频通信体验。

需要注意的是,WebRTC 的具体实现和工作方式可能因浏览器和环境而有所差异。

上述描述提供了一个基本的概述,实际情况可能更加复杂。

多媒体数据的获取和处理技术研究随着移动互联网的高速发展,多媒体技术在我们的生活中扮演着越来越重要的角色。

我们通过网络观看视频、听取音乐、在社交媒体上分享照片和视频都是基于多媒体技术的。

多媒体数据的获取和处理技术的研究对于多媒体应用的发展和创新起到了重要的作用。

一、多媒体数据的获取技术研究多媒体数据的获取是指将音频、视频、图像等不同格式的多媒体数据从各种媒介中提取出来。

目前,多媒体数据的获取技术主要包括三类:图像采集技术、音频采集技术和视频采集技术。

1. 图像采集技术图像采集技术是将静态的图像从物理形态转换为数字形态的过程。

常见的图像采集设备包括相机、扫描仪等。

其中,数码相机是当今应用最广泛的图像采集设备之一。

数码相机将光学信号转换为数字信号,通过不同的接口将数字信号传输到计算机中进行处理。

采用数码相机进行图像采集可以大大提高图像的精度和稳定性,并且可以通过调节不同的参数,如曝光、快门等来达到不同的图像效果。

2. 音频采集技术音频采集技术是将声波信号转换为数字信号的过程。

常见的音频采集设备包括麦克风、录音棚等。

在音频采集过程中需要考虑音频的采样率、量化精度、声道数以及录音环境等因素。

在采集过程中,需要注意保持录音环境的噪声水平,避免产生噪声对音频质量的影响。

3. 视频采集技术视频采集技术是将模拟视频信号转换为数字信号的过程。

常见的视频采集设备包括摄像头、视频捕捉卡等。

在视频采集过程中,需要考虑分辨率、帧率、色深等因素。

相对于模拟视频信号,数字视频信号具有更高的精度和稳定性,并且可以进行更加精细的编辑和处理,因此在视频应用中越来越受到广泛的应用。

二、多媒体数据的处理技术研究多媒体数据的处理是指对采集到的音频、视频、图像等多媒体数据进行处理和编辑,以便于展示和应用。

在多媒体数据的处理过程中,需要考虑到多媒体数据的巨大量以及不同格式之间的兼容性问题。

常见的多媒体数据处理技术主要包括音视频编解码技术、图像处理技术以及数据压缩技术等。

实时音频采集与播放技术的研究荣治国陈松乔(中南大学信息工程学院 湖南 长沙 410083)【摘 要】介绍了音频采集、播放的三种技术,分别给出实现模型,并对三种技术作出对比分析,以此提出了声音实时传输的依据。

【关键词】声音采集、播放;媒体控制器;DIRECTSOUND;实时传输在信息化日益加速的今天,数字多媒体的应用越来越广泛,随着宽带网概念深入人心,数字多媒体进入到了一个更广阔的空间,许多应用课题都围绕着两者展开,其中可视电话、电话会议系统和视频会议系统发展迅速,这些都要涉及到多媒体数据通信。

在多媒体数据通信中,要求有良好的实时性,能够对多媒体数据进行细节的操作,如压缩、实时流传输等。

而在这些应用之中,因为现实的网络状况还难以满足较好的实时视频通讯,音频数据在其中就更显重要,本文对比分析了实时音频采集和播放技术,以期为音频数据通讯提供参考。

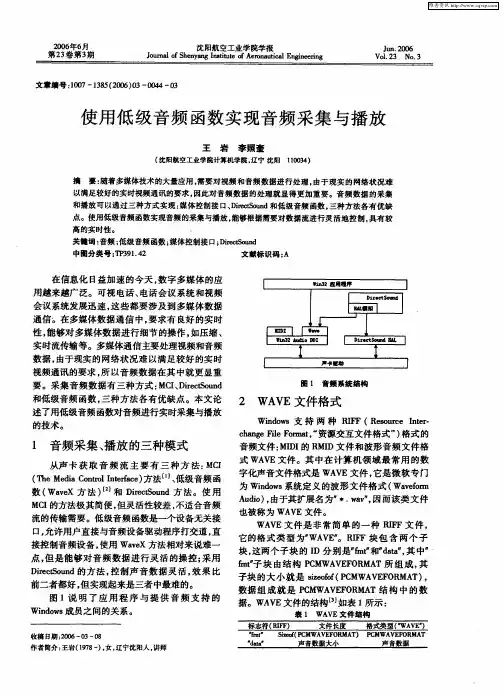

1 音频采集、播放的三种模式Windows通过高级音频函数、媒体控制接Array口MCI[1、2]设备驱动程序;低级音频函数MIDI Mapper、低级音频设备驱动;以及DirectSound提供了音频服务,可以从声卡获取音频流。

图1说明了应用程序与提供音频支持的Windows成员之间的关系。

使用MCI的方法极其简便,灵活性较差;使用低级音频函数的方法相对来说难一点,但是能够对音频数据进行灵活的操控;而采用DirectSound的方法,控制声音数据灵活,效果比前二者都好,但实现起来是三者中最难的。

下面我将分别介绍如何用三者实现音频的实时采集和播放。

2 使用MCI方法实现音频采集与播放用MCI方法是很方便的,它对媒体设备控制主要通过命令接口函数mciSendCommand ()或者字符串接口函数mciSendString()来完成的,这两个函数的作用相同。

命令接口函数比命令字符串使用起来要复杂,但它为MCI提供了更为强大的控制能力,下面就介绍命令接口函数的使用。

2.1命令接口函数的原型MCIERROR mciSendCommand(MCIDEVICEID IDDevice,UINT uMsg,DWORD fdwCommand,DWORD dwParam);具体参数的介绍请参阅MSDN[3]。

2.2用MCI采集声音的步骤首先设置适当的参数用MCI_OPEN命令打开声音设备准备录音,发送录音MCI_RECORD命令信息开始录音,录音完成之后发送MCI_SA VE_FILE命令将声音信息写入WA V文件,结束后发送MCI_STOP命令关闭设备。

2.3用MCI播放声音的方法与录音类似,先在MCI_OPEN_PARMS中设置要播放的文件并发送MCI_OPEN命令打开声音设备,发送MCI_PLAY命令消息播放,结束后发送MCI_STOP命令关闭设备。

3 使用低级音频函数WaveX低层音频服务及重要的数据结构低级音频服务控制着不同的音频设备,这些设备包括WAVE、MIDI和辅助音频设备[4]。

低级音频服务包括如下内容:(1)查询音频设备;(2)打开和关闭设备驱动程序;(3)分配和准备音频数据块;(4)管理音频数据块;(5)应用MMTIME结构;(6)处理错误。

3.1用到的Windows消息及数据结构使用低级音频函数之所以能够对各个声音数据块操作,要归功于Windows的消息映射[5],Windows在采集、播放完一个数据块之后就会发送有关的消息。

重要的消息有:MM_WIM_CLOSE、MM_WIM_DATA、MM_WIM_OPEN、MM_WOM_CLOSE、MM_WOM_DONE、MM_WOM_OPEN、WIM_CLOSE、WIM_DONE、WIN_OPEN、MOM_CLOSE、WOM_DONE、WOM_OPEN这些消息都定义在mmsystem.h头文件中,具体意义请参阅MSDN。

重要的数据结构:(1) PCM波形音频格式PCMWA VEFORMAT(2) 波形数据格式WA VEFORMAT(3) 波形数据缓冲区格式WA VEHDR在声音采集与回放之前,先要检查音频设备的能力,设置相应的音频参数,通常设为22.05KHz采样频率,8位立体声方式,试验表明:这样设置可使数据量适中,音效不错。

在波形数据格式参数中,WFormatTag用来设置wav格式;nChannels用来设置声道个数;nSamplesPerSec用来设置采样频率;nAvgBytesPerSec用来设置每秒所需字节数;nBlockAlign 用来设置每个采样点所需总字节数wBitsPerSample用来设置每个采样点所需Bit数。

3.2使用低层函数采集、播放声音的方法使用低层的声音函数对声音进行采集、回放时,声音是存放在一个内存数据块中,当采集缓冲区中数据满时(得到MM_WIM_DATA消息)以及回放缓冲区中数据为空(得到MM_WOM_DONE消息)时,用户可以采用相应的消息映射函数来处理相应的过程。

声音采集与回放的一般步骤是:首先检查设备的能力,看该设备所具有的声音处理能力;然后我们就可以使用waveInOpen或waveOutOpen函数打开录音或放音设备;打开相应的设备后,再为相应的录音或放音设备准备相应的数据结构,这是关键的一步,因为要使声卡正确采集播放,必须在程序中建立一种与之通信的标准,这种标准就是声音文件的格式,所以一定要保证数据缓冲区的格式符合wav 标准;相应的数据结构准备好之后就可以使用waveInStart 函数进行录音或waveOutWrite 函数将录好的声音数据播放;对录音以及放音缓冲区内容使用后,释放使用的内存单元;所有任务完成后,应该关闭相应的设备。

3.3 实时采集、播放的流程图及声音采集程序图2、低级音频采集流程 图3、低级音频播放流程下面是声音采集的程序。

MMRESULT mmReturn = ::waveInOpen(&m_hRecord, WA VE_MAPPER,//打开声音设备&m_WaveFormatEx, ::GetCurrentThreadId(), 0,CALLBACK_THREAD);。

//准备wave数据结构mmReturn=::waveInPrepareHeader(m_hRecord,lpHdr, sizeof(WA VEHDR));//为音频输入准备声音数据缓冲区mmReturn = ::waveInAddBuffer(m_hRecord, lpHdr, sizeof(WA VEHDR));//将缓冲区加入接收队列mmReturn = ::waveInStart(m_hRecord);//开始从音频设备进行输入。

//如果输入数据缓冲区满,系统会发出MM_WIM_DATA 消息,在该消息的处理函数中可以对声音数据进行处理,包括播放、存储或者网络发送,处理完毕要清空数据缓冲区再加入输入队列直至结束。

如果要存储文件,先要写好WA V 文件头,然后在对消息MM_WIM_DATA 的响应中依次写入数据:::mmioWrite(m_hFile, soundbuffer, cbLength);最后要释放内存单元,关闭声音设备:::waveInUnprepareHeader(m_hRecord, lpHdr, sizeof(WA VEHDR));If(lpHdr)delete lpHdr;WaveInClose(m_hRecord);·······声音的播放过程与采集非常相似,在此不再赘述。

4 使用DirectSound这是三者中效率最高的的一种方式,DirectSound[6]是以组件方式提供的,由于Microsoft已经为它定制了Lib 文件(Dsound.lib ),这样在程序中只要包含头文件dsound.h 就可以了,编程简化了很多。

录音是通过接口:IDirectSoundCapture 和IDirectSoundCaptureBuffer ;声音的播放是通过接口:IDirectSound 和IDirectSoundBuffer 。

此外,还需要用到接口IDirectSoundNotify ,这是用来接收回放或者录音通知信息的。

4.1 DirectSound 的原理框图图4、DirectSound 播放原理 图5、DirectSound 录音原理从图中可以看出,通知是通过IDirectSoundNotify 来实现的,输入输出缓冲可以设置为硬件缓冲或者软件缓冲,缓冲的大小也可以设置。

以播放为例,程序中先分配一块缓冲,用要输出的数据填满缓冲,然后启动输出系统,就开始了不断的循环,声卡每放完一个缓冲就给程序发一个消息(实际和WaveX 一样使用事件驱动机制),程序就可以继续往该缓冲写数据。

声音采集与播放的过程类似,程序分配一块缓冲,启动声音输入系统,开始循环,声卡写完一个缓冲就发送消息给程序,然后程序读出缓冲区数据并存储,声卡继续填写数据。

4.2用DirectSound 实现采集与播放DirectSound 的使用首先要创建IDirectSound 对象,像普通的COM 对象一样可以用CoCreateInstance 来创建,简单的方法是使用以下代码:LPDIRECTSOUND lpds; //LPDIRECTSOUND 等价于IDirectSound *HRESULT hr = DirectSoundCreate(NULL,&lpds,NULL); 创建了DireceSound 之后就需要创建DirectSoundBuffer 对象,可以用IDirectSound::CreateSoundBuffer(LPCDSBUFFERDESC lpcDSBufferDesc,LPLPDIRECTSOUNDBUFFER lplpDirectSoundBuffer,Iunknown FAR*pUnkOuter);来创建,其中第一个参数很关键,LPCDSBUFFERDESC 结构中由dwBufferBytes 定义了缓冲区的大小,由lpwfxFormat 规定了声音数据的结构。

使用此方法创建IDirectSoundBuffer 对象就不需要再调用Initialize 了,因为在内部已经调用了该函数。

DirectSound 的其他重要接口还有Initialize 、SetCooperativeLevel 、GetCaps 、Compact 等。

IDirectSoundNotify 对象可通过IDirectSoundBuffer 对象的QueryInterface 获得,调用如下:LPDIRECTSOUNDNOTIFY lpDsNotify;HRESULT hr =lpDsbSecondary->QueryInterface(IID_IdirectSoundNotify,(LPVOID*)&lpDsNotify);该对象只有一个函数,原型如下:HRESULT SetNotificationPositions(DWORD cPositionNotifies,LPCDSBPOSITIONNODIFY lpcPositionNotifies);此函数用来设置通知,第一个参数表示第二个参数的指针指向的结构数组的长度。