第3章 搜索引擎性能评价

- 格式:doc

- 大小:33.00 KB

- 文档页数:13

搜索引擎的主要性能评价指标

根据建立搜索引擎评价指标体系的若干原则,我们认为可以建立以下搜索引擎主要性能评价指标,它包含以下几个部分:

1.搜索引擎索引库的相关评价指标索引数据库的构成是搜索引擎检索性能优劣的基础,由此我们把它摆在评价指标的第一部分来考虑。

搜索引擎索引库的评价指标应该包括索引标引数量、标引的文件种类、标引深度和更新频率等方面。

由于索引标引数量我们难以检测,可以通过本文后面提到的“相关查全率”来间接反映,故这里把它剔除。

索引标引深度内含几方面的内容,如全面索引或部分索引、是否考虑超文本的不同标记所表示的不同含义和是否收集页面中的超链接等,而且索引数据库标引的深度直接影响检索效果,所以我们把它细分为三方面。

2 .搜索引擎检索功能的相关指标搜索引擎检索功能的评价指标主要包括:基本检索、高级检索、目录式浏览检索和其他功能检索。

搜索引擎性能评价何晓艳;朱俊东【摘要】@@ 搜索引擎是当今网络信息检索的主要工具,它在满足人们从互联网上快速、准确、全面的获取信息的需求方面发挥了重要的作用.但是,由于各种搜索引擎所采用的技术和服务对象的不同,它们之间的各项性能差异很大.因此,通过对搜索引擎进行合理的评价,不仅有利于用户的选择与使用,而且有利于其本身的改进和发展.目前大多数评价方法主要以描述为主,通常只能对搜索引擎进行定性或部分定量描述,不能系统、全面的对不同搜索引擎进行综合评价.因此,建立搜索引擎综合评价体系,通过数学方法进行综合评价,具有较大的现实意义和应用前景.【期刊名称】《河北联合大学学报(医学版)》【年(卷),期】2010(012)002【总页数】2页(P279-280)【关键词】搜索引擎;评价指标体系;多级模糊综合评价【作者】何晓艳;朱俊东【作者单位】华北煤炭医学院信息中心,河北唐山,063000;华北煤炭医学院信息中心,河北唐山,063000【正文语种】中文【中图分类】G633.67搜索引擎是当今网络信息检索的主要工具,它在满足人们从互联网上快速、准确、全面的获取信息的需求方面发挥了重要的作用。

但是,由于各种搜索引擎所采用的技术和服务对象的不同,它们之间的各项性能差异很大。

因此,通过对搜索引擎进行合理的评价,不仅有利于用户的选择与使用,而且有利于其本身的改进和发展。

目前大多数评价方法主要以描述为主,通常只能对搜索引擎进行定性或部分定量描述,不能系统、全面的对不同搜索引擎进行综合评价。

因此,建立搜索引擎综合评价体系,通过数学方法进行综合评价,具有较大的现实意义和应用前景。

根据对搜索引擎基本结构、基本原理和主要功能的分析,我们把搜索引擎评价指标定义为索引构成、检索功能、检索效果、检索结果和用户交互五类[1,2]。

1.1 索引构成指标①标引数量 (万个)。

②标引范围 (种)。

标引范围由 FTP文件、WWW文件、Newsgroup文件、USENET文件和全文标引构成。

搜索引擎检索功能的性能评价研究搜索引擎作为现代社会获取信息的重要工具,其检索功能的性能直接影响着用户的信息获取体验。

随着互联网信息的爆炸式增长,搜索引擎检索功能的重要性日益凸显。

本文将介绍搜索引擎检索功能的基本概念、作用及其发展现状,并综述当前的性能评价研究现状、常用指标和评价方法,最后对比不同指标或评价方法的优缺点,分析其适用场景和应用前景,并提出未来发展方向。

搜索引擎检索功能是指搜索引擎通过一定的算法和策略,从互联网海量的信息中提取出与用户输入的关键词相关的有用信息。

这些信息可以是网页、图片、视频等多种形式。

搜索引擎检索功能的主要作用是帮助用户快速、准确地找到所需信息,提高信息获取的效率和准确性。

随着互联网信息的不断增加,搜索引擎检索功能的性能也面临着越来越大的挑战。

对于搜索引擎检索功能的性能评价研究,当前常用的指标包括准确率、召回率、F1得分、平均绝对误差等。

其中,准确率是指检索到的结果中与用户输入关键词相关的比例,召回率是指所有与关键词相关的结果中被检索到的比例,F1得分是准确率和召回率的调和平均数,平均绝对误差则反映了检索结果与真实结果之间的差异。

还有一些新的评价指标,如语义匹配度、用户满意度等,但这些指标的客观性较差,主观性较强。

评价方法方面,主要有基于排序的评价方法和基于分类的评价方法。

基于排序的评价方法是根据检索结果与用户输入关键词的相关程度对结果进行排序,将排在前面的结果视为更有用的结果。

常见的基于排序的评价方法有PageRank算法、BM25算法等。

而基于分类的评价方法则是将检索结果分为与关键词相关的类别和无关的类别,通过分类准确率等指标来评价检索结果的性能。

不同指标或评价方法都有其优缺点。

准确率和召回率是经典的指标,简单易懂,但无法全面反映检索结果的性能。

F1得分则在一定程度上解决了这个问题,但仍然存在一定的局限性。

平均绝对误差指标直观易懂,但计算复杂度较高且无法反映检索结果的全局性能。

搜索引擎的特点与评价标准一、搜索引擎的分类搜索引擎按其工作方式主要分为三种,分别是全文搜索引擎、目录索引类搜索引擎和元搜索引擎。

全文搜索引擎是名副其实的搜索引擎,国外具有代表性的有Google、Fast/AllTheWeb、AltaVista、Inktomi、Teoma、WiseNut等,百度(Baidu)目前所做的应该属于全文搜索引擎。

由于它们都是通过从互联网上提取的各个网站的信息(以网页文字为主)而建立的数据库中,检索与用户查询条件匹配的相关记录,然后按一定的排列顺序将结果返回给用户。

虽然百度拥有自己的检索程序,并自建网页数据库,搜索结果直接从自身的数据库中调用,但它们所能提供的信息绝大程度上由它所搜索的网站决定的。

评价标准及其局限性在搜索引擎的发展初期,人们对它的要求较低,只要它能把互连网上相关的网站搜出来,搜到的网站尽量多一点,无关的网站能少一点就能满足。

所以那时候,人们评测搜索引擎的方法是用几个关键词,测试对比它们的搜索速度、搜索数量和无关网站的多少。

简单说就是全、快、准。

而那时的搜索引擎技术大家差别不大,所以这样的评测方法是可行的。

此后,独特的搜索引擎技术此起彼伏,层出不穷,到现在明显处于战国时代。

但是,人们的评测方法却没多大变化,现在常见的评测还是简单的用几个关键词比较搜索速度、搜索结果数量和各自介绍的搜索准确性。

搜索引擎的评价标准与目前搜索引擎的发展状况并非完全吻合。

下面,我们就目前常用的评价指标进行分别介绍。

第一,搜索引擎的查全率。

既然是搜索引擎,当然比较搜索的范围就应该首当其冲。

但是,由于收录网页的数量都是各搜索引擎自己宣布的,未可全信,而同一个关键词的搜索结果却是显而易见的,所以一般的评测都以这个为准。

但以这个为准仍有很多不足之处,因为多数象样一点的搜索引擎都可以找出一批关键词来证明它的搜索结果是最全的。

因为网页索引数量虽然有大小,但robot和spider程序不同,索引范围和索引标准也不尽相同,在最大的搜索引擎上搜不到的有可能在小得多的搜索引擎上搜到。

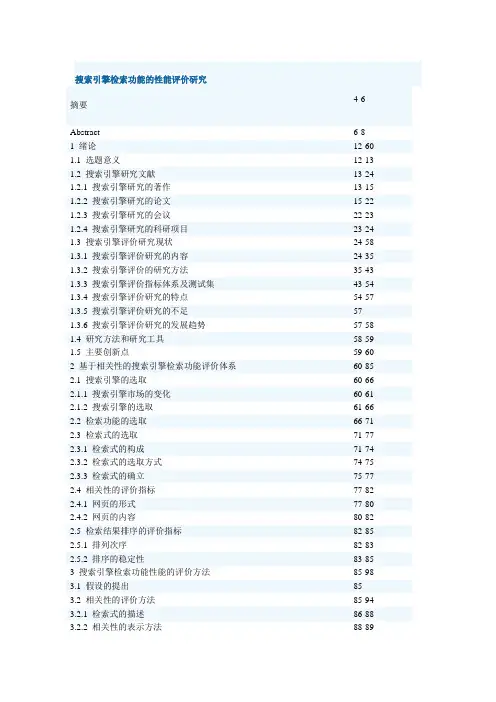

搜索引擎检索功能的性能评价研究4-6 摘要Abstract 6-8 1 绪论12-60 1.1 选题意义12-13 1.2 搜索引擎研究文献13-24 1.2.1 搜索引擎研究的著作13-15 1.2.2 搜索引擎研究的论文15-22 1.2.3 搜索引擎研究的会议22-23 1.2.4 搜索引擎研究的科研项目23-24 1.3 搜索引擎评价研究现状24-58 1.3.1 搜索引擎评价研究的内容24-35 1.3.2 搜索引擎评价的研究方法35-43 1.3.3 搜索引擎评价指标体系及测试集43-54 1.3.4 搜索引擎评价研究的特点54-57 1.3.5 搜索引擎评价研究的不足57 1.3.6 搜索引擎评价研究的发展趋势57-58 1.4 研究方法和研究工具58-591.5 主要创新点59-602 基于相关性的搜索引擎检索功能评价体系60-85 2.1 搜索引擎的选取60-66 2.1.1 搜索引擎市场的变化60-61 2.1.2 搜索引擎的选取61-66 2.2 检索功能的选取66-71 2.3 检索式的选取71-77 2.3.1 检索式的构成71-74 2.3.2 检索式的选取方式74-75 2.3.3 检索式的确立75-77 2.4 相关性的评价指标77-82 2.4.1 网页的形式77-80 2.4.2 网页的内容80-82 2.5 检索结果排序的评价指标82-85 2.5.1 排列次序82-832.5.2 排序的稳定性83-853 搜索引擎检索功能性能的评价方法85-98 3.1 假设的提出85 3.2 相关性的评价方法85-94 3.2.1 检索式的描述86-88 3.2.2 相关性的表示方法88-893.2.3 相关性的计算方法89-903.2.4 数据采集方法90-943.2.5 数据分析方法943.3 检索结果排序的评价方法94-984 搜索引擎检索功能的检索效率评价98-1374.1 Google检索功能的检索效率评价98-1034.2 Yahoo!检索功能的检索效率评价103-1074.3 MSN/Live/Bing检索功能的检索效率评价107-1114.4 百度检索功能的检索效率评价111-1154.5 谷歌检索功能的检索效率评价115-1204.6 中英文搜索引擎检索效率比较分析120-1374.6.1 搜索引擎的题名检索效率120-1234.6.2 搜索引擎普通检索效率123-1264.6.3 搜索引擎短语检索效率126-1294.6.4 搜索引擎PDF检索效率129-1324.6.5 搜索引擎URL检索效率132-1375 搜索引擎检索功能的检索结果排序评价137-1555.1 Google检索结果排序评价137-1405.2 Yahoo!检索结果排序评价140-1435.3 MSN/Live/Bing检索结果排序评价143-1475.4 百度检索结果排序评价147-1505.5 谷歌检索结果排序评价150-1545.6 中英文搜索引擎检索结果排序质量比较154-1555.6.1 英文搜索引擎的检索结果排序质量比较1545.6.2 中文搜索引擎的检索结果排序质量比较154-1556 基于实证的中文搜索引擎优化策略155-1606.1 Web2.0对搜索引擎的影响1556.2 搜索引擎评价中发现的问题155-1576.3 中文搜索引擎优化对策157-160参考文献160-171读博期间参与的科研课题及发表的论文171-172致谢172-174Study on the Evaluation of Performance of Search Engines' Fea 【英文题名】tures【作者】费巍;【导师】彭斐章; 张进;【学位授予单位】武汉大学;【学科专业名称】图书馆学【学位年度】2010【论文级别】博士【网络出版投稿人】武汉大学【网络出版投稿时间】2010-09-03【关键词】搜索引擎; 信息检索; 评价; 相关性; 排序; 优化;【英文关键词】search engine; information retreieval; evaluation; relevance; ranking; optimization;【中文摘要】搜索引擎评价研究是信息检索领域研究的热点之一,网络信息和信息检索技术的发展推动了搜索引擎实践的发展。

信息资源开发与管理实验报告实验名称:检索性能评价姓名:** 学号:2016***** 专业:信息管理与信息系统班级:16***指导教师:**实验成绩:批阅教师签字:一、实验目的通过绘制P-R图、11点插值图和计算MAP比较百度和谷歌的检索性能,加强对单个查询检索性能评价方法的应用能力,进一步巩固和理解课堂中所学的信息检索性能评价方法。

二、实验内容与实验步骤(一)实验内容以百度、谷歌为例,在两个搜索引擎中输入同一个Query,并设定该Query的相关文档总数为*** 篇。

查看前20条返回的记过的相关性,对检索性能进行评价,并绘制P-R图、11点插值图,分别计算百度和谷歌的MAP。

(二)实验步骤1.复习信息检索评价方法原理及P-R图、11点插值图绘制方法,学习并掌握使用Excel绘制图表方法;2.在百度、谷歌中分别输入相同的检索词,统计前20个结果hit情况并计算对应的precision、recall值及11点对应的precision值;3.绘制P-R图、11点插值图,计算MAP;4.评价并比较谷歌和百度的检索性能。

三、实验环境1.操作系统:windows 72.软件:Excel2007四、实验过程与分析1.在百度和谷歌中输入检索词:tcp/ip协议工作原理,得到检索结果部分如下图1所示:2.用Excel分别统计不同搜索引擎前20个结果的hits、presicion、recall、和11点对应的值。

如图所示:3.绘制百度、谷歌P-R图并比较。

百度、谷歌P-R图分析:******************5.绘制百度、谷歌的11点插值图并比较检索性能。

百度、谷歌11点插值图分析:**************************6.分别计算百度和谷歌的MAP。

(1)百度MAP=(1/1+2/2+3/3+4/7+5/8+6/9+7/10+8/17+9/20)/20=(2)谷歌MAP=五、实验结果总结与思考。

搜索引擎的主要性能评价指标1.搜索引擎建立索引的方法数据库中的索引一般是按照倒排文档的文件格式存放的,在建立倒排索引的时候,不同的搜索引擎有不同的选项。

有些搜索引擎对于信息页面建立全文索引:而有些只建立摘要部分,或者是段落前面部分的索引。

还有些搜索引擎,如Google建立索引的时候,同时还考虑超文本的不同标记所表示的不同含义,如粗体、大字体显示的东西往往比较重要:放在"锚"链接中的信息往往是它所指向页面的信息的概括,所以用它来作为所指向的页面的重要信息。

Google、Infbseek还在建立索引的过程中收集页面中的超链接。

这些超链接反映了收集到的信息之间的空间结构,利用这些结果可以提高页面相关度判别的准确度。

由于索引不同,在检索信息时产生的结果会不同。

2.搜索引擎的受欢迎程度搜索引擎的受欢迎程度体现了用户对搜索引擎的偏爱程度,知名度高、性能稳定和搜索质量好的搜索引擎很受用户的青睐。

搜索引擎的受欢迎程度也会随着它的知名度和服务水平的变化而动态地变化。

搜索引擎的服务水平与它所收集的信息量、信息的新颖度和查询的精确度相关。

随着各种新的搜索技术的出现,智能化的、支持多媒体检索的搜索引擎将越来越受到用户的欢迎。

3.搜索引擎的检索功能搜索引擎所支持的检索功能的多少及其实现的程度,直接决定了检索效果的好坏,所以网络检索工具除了要支持诸如布尔检索、邻近检索、截词检索、字段检索等基本的检索功能之外,更应该根据网上信息资源的变化,及时地应用新技术、新方法,提高高级检索功能。

另外,由于中文信息持有的编码不统一问题,所以如果搜索引擎能够实现不同内码之间的自动转换,用户就能全面检索大陆及港台地区乃至全世界的中文信息。

这样不但可以提高搜索引擎的质量,而且会得到用户的支持。

4.搜索引擎的检索效果检索效果可以从响应时间、查全率、查准率和相关度方面来衡量。

响应时间是用户输入检索式开始查询到检出结果的时间:查全率是指一次要求搜索结果中符合用户要求的数目与用户查询相关的总数之比:查准率是指一次搜索结果集中符合用户要求的数目与该词搜索结果总数之比:相似度是指用户查询与搜索结果之间相似度的一种度量二查准率是一个复杂的概念,一方面表示搜索引擎对搜索结果的排序,另一方面却体现了搜索引擎对垃圾网页的抗干扰能力。

搜索引擎评估搜索引擎评估搜索引擎是人们获取信息的重要工具,而搜索引擎的质量直接影响到用户能否快速、准确地找到所需信息。

因此,对搜索引擎的评估显得尤为重要。

本文将从搜索结果质量、搜索速度和用户体验三方面对搜索引擎进行评估。

首先,搜索结果质量是评估搜索引擎的重要指标之一。

搜索引擎的主要任务是根据用户输入的关键词,返回与之相关的结果。

因此,搜索引擎的搜索结果应该尽可能的与用户的意图相匹配,且排在前面的结果更具权威性和准确性。

搜索结果质量的评估可以通过衡量搜索引擎返回的结果的相关性、权威性和准确性来进行。

相关性可以通过用户点击率和停留时间来衡量,高点击率且长停留时间的结果意味着搜索结果与用户需求的匹配度高。

权威性可以通过评估搜索结果中的网站信誉和可信度来进行。

准确性则可通过评估搜索结果中是否存在拼写错误、错误的关键词匹配等来进行。

其次,搜索速度是衡量搜索引擎质量的另一个重要指标。

现代社会的快节奏要求搜索引擎能够快速返回搜索结果。

搜索引擎的速度取决于其搜索算法的设计和处理能力。

搜索引擎评估可通过对搜索过程中的响应时间进行衡量来进行,响应时间越短,搜索引擎的速度越快。

最后,用户体验是评估搜索引擎的重要方面之一。

搜索引擎应该为用户提供良好的搜索体验,包括用户界面设计、搜索建议和搜索策略等。

用户界面设计应简洁、清晰,方便用户操作。

搜索建议可以提供用户输入关键词时的提示和自动补全功能,以提高用户搜索的精确度。

搜索策略可以通过为用户提供各类筛选和排序功能来帮助用户进一步找到自己需要的信息。

综上所述,对搜索引擎进行评估涉及搜索结果质量、搜索速度和用户体验三个方面。

评估搜索引擎的质量需要综合考虑这些指标,以期为用户提供更好的搜索服务。

通过评估搜索引擎的质量,可以指导搜索引擎的改进和优化,提高其搜索效果和用户满意度。

搜索引擎性能评价研究的开题报告一、研究背景随着互联网的快速发展,搜索引擎已成为我们日常网上活动中不可或缺的一部分。

随着搜索引擎使用量不断增长,对其性能的要求也越来越高。

较好的搜索引擎性能可以提高用户搜索满意度、减少用户等待时间、提高搜索结果准确度等。

因此,搜索引擎性能评价研究具有重要的理论和实践意义。

目前,国内外学者在搜索引擎性能评价研究方面进行了一定的探索,涉及到了搜索引擎响应时间、搜索结果准确度、搜索引擎性能优化等多个方面。

但是,目前对于搜索引擎性能评价研究的综述不多,并且对搜索引擎性能评价的实验方法、指标、评价准则等缺乏系统和细致的研究。

因此,本研究将对搜索引擎性能评价的相关问题进行探索,并提出可行的评价方法和评价指标,为搜索引擎优化和搜索结果提供参考。

二、研究目的1.总结当前国内外搜索引擎性能评价研究的主要方法、指标及评价准则。

2.探讨搜索引擎性能评价的多维度评价体系及其评价指标体系,为评价指标的选择提供依据。

3.设计实验验证评价指标体系的可行性,提出搜索引擎性能评价的具体实现方法。

三、研究内容1.搜索引擎性能评价的基本概念和方法,包括对指标、评价准则和评价方法的概述和分类,对相关理论的分析和总结。

2.搜索引擎性能评价的相关指标体系,在分析现有指标体系的基础上,提出本次研究的新指标,并对这些指标进行分析和说明。

3.搜索引擎性能评价的实验设计和实施,实验室实验设计和实施以及互联网实验平台的调研和开发,研究性能评价的实现方法。

4.对实验结果进行分析和解释,包括对搜索引擎性能评价结果的统计数据、结果分析和解释,并对实验结果进行可再现性比较。

四、研究意义1.推进搜索引擎性能评价研究的深入,为搜索引擎性能优化提供科学依据。

2.为搜索引擎优化提供可参考的评价指标和准则,可以提高搜索引擎的搜索质量和性能。

3.可以为相关领域和业界提供有关搜索引擎性能评价方面的参考资料和解决方案。

五、研究方法本研究将采用文献调研、实验设计、数据分析等方法,并主要使用MATLAB、Python等工具进行数据分析和实验设计。

搜索引擎评估体系搜索引擎是当今时代找寻信息手段的主要工具,它的功能强大,能够帮助用户查询到有价值的信息,并可以快速获取结果。

随着技术的不断改进,搜索引擎的发展也越来越完善,它可以对用户提供更准确、更全面的搜索结果。

然而,搜索引擎的质量不断地受到高要求。

为了确保搜索引擎的质量,搜索引擎评估体系是必不可少的。

搜索引擎评估体系是检测搜索引擎性能的基础方法,它可以有效评估搜索引擎在各个方面的性能,包括搜索引擎的可用性、准确性、流畅性以及安全性等。

它能够检测出搜索引擎存在的问题,提出优化和改进的建议,从而提高搜索引擎的性能。

搜索引擎评估体系主要包括测试方法、评估方法和报告反馈三个部分。

测试方法要求使用各种测试工具进行测试,它可以模拟真实的用户使用情况,确保搜索引擎的可用性。

评估方法则是将搜索引擎的性能分析,分析准确性、流畅性等性能,检测出可能存在的问题。

报告反馈则是将测试结果汇总,反馈到开发团队,以便在发现问题的基础上改进搜索引擎的性能。

此外,搜索引擎评估体系还要求定期对搜索引擎进行安全测试,以确保用户在使用搜索引擎时能够安全可靠。

评估报告中可以看出搜索引擎存在的安全问题,以及如何解决安全问题的建议,提高搜索引擎的安全性。

搜索引擎评估体系的重要性不可忽视。

它可以有效改善搜索引擎的性能,从而满足用户的需求,实现产品的优化,助力搜索引擎文化发展。

值得一提的是,通过搜索引擎评估体系还可以得到可信度高的评估结果,从而更好地服务于用户。

综上所述,搜索引擎评估体系是确保搜索引擎质量的重要手段,它能够帮助企业提高搜索引擎的性能,满足用户的需求,实现对搜索引擎的优化。

只有将搜索引擎评估体系作为搜索引擎的核心,才能不断改进搜索引擎的质量,从而实现强大的搜索引擎文化。

实验:搜索引擎性能评价小组成员:黄婷苏壳肖方定山一、实验目的:依据MAP, P@10, MRR等评价指标对各个搜索引擎(白度、搜狗、必应)的查询性能进行评测,对搜索引擎满足不同信息需求的情况加以比较。

■二、实验方案:1.构建查询样例集合:(1)构建查询样例集合规模:100个查询热门程度:冷门/热门类型:导航类/信息类/事务类(2: 5: 3)(2)根据个人经验,撰写每个查询样例的信息需求内容2.构建Pooling:(1)抓取各个搜索引擎对步骤一查询词的查询结果抓取的搜索引擎:五个中文搜索引擎(白度、搜狗、必应)抓取范兩:查询结果的前30位结果注:pooling method的大概意思是查询结果去重3.构造标准答案集合:(1)根据步骤1中撰写好的信息需求,对Pooling里的结果进行标注,标注为“答案”和“非答案”两类即可4.查询性能评价:I(1)根据标注结果,依据MAP, P@10, MRR等评价指标对各个搜索引擎的查询性能进行评价(2)对搜索引擎满足不同信息需求的情况加以比较5.扩展内容:(1)可以尝试对搜索引擎处引擎处理非中文查询、有错别字查询等情况的不同策略进行分析、比较三、实验结果及分析:根据实验结果及□的,详细分析实验结果。

1.实验结果:口度:Bing国内版:综合比较:2.结果分析:(1)导航类搜索词对于导航类搜索关键词,RR 一般用作评价导航类的查询需求,用于表示用户在知道LI标前需要浏览的结果数II,可以看到,搜狗事务类的MRR指标偏高,可以发现,当用户想要搜索的信息为已知资源,主页,资源等信息时,搜索引擎可能会更倾向于返回给用户一些官方的主页信息,以使用户能够尽快找到口标,对于导航类信息的其他指标,相差也不大,但是P@10的指标值差异有些明显,搜狗和白度的P@10值是较好的,而必应的结果则稍差,查看原始搜索结果标记,三大搜索引擎都加入了对应的百科,问答平台,而必应的结果还夹朵了不少"同名的广告”,以“清华大学oj”词条为例,必应的结果中有不少标题虽是“清华大学oj”等信息,但实际是一些培训机构的页面,必应并没有做这方面的剔除,使得结果首页多了不少奇怪的“广告”,影响了搜索体验。

搜索引擎的评价标准搜索引擎是当今互联网时代最重要的工具之一,它们的质量和效果直接影响着用户的搜索体验和信息获取。

因此,对搜索引擎的评价标准也变得至关重要。

在评价搜索引擎的质量时,我们需要考虑以下几个方面:1. 检索结果的准确性。

搜索引擎的首要任务是提供准确的搜索结果。

用户希望能够在输入关键词后迅速找到他们需要的信息。

因此,搜索引擎的评价标准之一就是检索结果的准确性。

一个好的搜索引擎应当能够根据用户的搜索意图,准确地呈现相关的网页、文章或其他资源,避免出现大量无关或低质量的内容。

2. 检索速度和响应时间。

除了准确性,搜索引擎的检索速度和响应时间也是评价的重要指标。

用户不希望花费过多的时间等待搜索结果的显示,他们期望能够在输入关键词后立即看到相关的内容。

因此,一个高质量的搜索引擎应当具有快速的检索速度和响应时间,确保用户能够快速地获取信息。

3. 搜索结果的多样性和覆盖范围。

搜索引擎的评价标准还包括搜索结果的多样性和覆盖范围。

一个好的搜索引擎应当能够覆盖广泛的信息资源,包括网页、图片、视频、新闻等多种形式的内容,并且能够呈现多样化的搜索结果,满足用户不同的需求。

4. 用户体验和界面设计。

除了搜索结果的质量,搜索引擎的用户体验和界面设计也是评价的重要方面。

一个好的搜索引擎应当具有清晰简洁的界面设计,便于用户进行操作和浏览搜索结果。

同时,搜索引擎还应当具有智能的搜索建议和纠错功能,帮助用户更快地找到他们需要的信息。

5. 隐私保护和信息安全。

随着互联网的发展,用户对于隐私保护和信息安全的关注也越来越高。

因此,搜索引擎的评价标准还应当包括对于用户隐私的保护和信息安全的考虑。

一个好的搜索引擎应当能够保护用户的个人信息,避免泄露和滥用,并且能够过滤恶意网站和垃圾信息,确保用户的信息安全。

综上所述,搜索引擎的评价标准涵盖了多个方面,包括检索结果的准确性、检索速度和响应时间、搜索结果的多样性和覆盖范围、用户体验和界面设计,以及隐私保护和信息安全。

第3章搜索引擎性能评价第3章搜索引擎性能评价搜索引擎的性能评价是性能改进的重要环节。

“实验”、“评价”、“改进”三者间的关系如下图所示。

搜索引擎系统评价? 客观、公平、全面。

? 借鉴信息检索的Cranfield 评价体系,结合互联网应用特点,总结出了一些评价方案。

搜索引擎评价与Cranfield 评价体系搜索引擎评价的角度? 商业市场角度:通过用户使用调查,获取评价数据,形成市场调查、行业发展、市场监测报告;? 学术研究角度,基于信息检索评价技术框架的搜索引擎性能评价。

信息检索评价? 检索效果(Effectiveness)、效率(Efficiency); ? 信息检索系统评价主要针对检索效果(Effectiveness)而非效率(Efficiency); 对搜索引擎系统的评价,也主要针对检索效果(Effectiveness)。

相关研究? 1955年,Kent提出了“准确率/召回率”的信息检索评价框架;? 20世纪50年代末到60年代,英国Cranfield 工程建立了基于查询样例集、正确答案集、语料库的评测方案。

其评价方法一般称为Cranfield方法框架。

1 Cranfield体系的三个环节:? 查询样例集合确定:抽取最能表示用户信息需求的一部分查询样例,构建一个规模恰当的集合;? 正确答案集合标注:针对查询样例集合,在语料库中寻找对应的答案;? 将查询样例集合、语料库输入检索系统,系统反馈检索结果,利用评价指标对检索系统结果和正确答案的接近程度进行评价,给出用数值表示的评价结果。

Cranfield体系的四个因素:? 语料库集合;? 查询样例集合;? 正确答案集合;? 评价指标。

使用Cranfield评价体系评价搜索引擎? 不需准备专门的语料库集合;? 对搜索引擎系统,语料库集合就是万维网数据的全体;? 搜索引擎可利用网页抓取子系统自行获取万维网数据。

? 需要构建查询样例集合、正确答案集合、评价指标。

查询样例集合构建定义:查询样例集合是评价搜索引擎性能时,模拟用户实际需求提出的查询(query)集合。

查询样例集合构建的三原则:真实性、代表性、信息需求表述的完整性。

1 查询样例集合构建的真实性构建查询样例集合时采用真实的搜索引擎用户查询? 反映用户的真实信息需求; 2 ? 保证评价的结果与用户的真实感受相吻合。

国内外的信息检索系统评测,重视查询样例集合真实性? 文本信息检索会议(TREC)采用微软Live 或Yahoo !等搜索引擎提供的真实查询样例;? 北京大学网络中心组织的搜索引擎与网络信息挖掘(SEWM )评测也采用了来自天网搜索引擎的真实查询样例。

获取真实的搜索引擎用户日志有困难,解决办法? 通过搜索引擎公开发布的用户行为日志样例来获取真实查询;? 借助搜索引擎提供的热门查询展示服务来获取真实的用户查询。

://// 具有足够的代表性吗? 2 查询样例集合构建的代表性代表性是指构建的查询样例集合要能够反映用户群体的查询偏好? 人力、物力资源的限制,构建的查询样例集合规模不能太大? 如何用少量的查询样例集合代表大多数用户的查询偏好?? 需分析搜索引擎用户查询频率的分布情况。

搜索引擎处理的用户查询数目十分庞大3 ? 2003年,谷歌每日处理的查询请求数达到亿个。

? 本书作者对某中文搜索引擎网站一个月内的部分查询日志进行了分析,结果表明,这部分查询日志的查询请求数达到了10多亿个。

这些数量庞大的查询请求并非两两不同,而是集中在若干个查询上。

? 作者分析的搜索引擎查询日志中,“百度”这一查询的查询请求次数就达18 万次以上。

? 观察查询频率的分布时发现,查询频率最高的一部分查询集中了大多数的用户查询请求。

? 查询日志涉及的独立查询数共1500万个,查询频度最高的10000个查询就集中了超过56%的用户查询请求。

? 说明搜索引擎查询频度的分布符合“二八定律”。

用户查询频率的分布规律的存在:? 使用高频查询样例集合代表大多数用户的查询请求;? “搜索风云榜”的存在,使得既具有合理性,也具有可行性。

缺点:查询样例集合构建没顾及查询频度低的用户查询。

最好,既控制好样例集合的规模,又保证各种查询频度的用户查询数据能够被采样到。

4 3 查询样例集合构建中信息需求表述的完整性搜索引擎交互方式“关键词查询+选择性浏览”特点、原因? 用户用简单的关键词作为查询提交给搜索引擎;? 用户希望少用键盘输人、多用鼠标点击进行交互;? 80%的英文用户,95%以上的中文用户不用“高级查询”功能;? 查询所包含的平均词数为个? 搜索引擎不是反馈检索目标页面,而是可能的检索目标页面列表;难以通过简单的关键词准确的理解用户的查询意图,只能将有可能满足用户需求的结果集合以列表的形式返回,无法提供准确的检索目标。

? 用户浏览列表,选择满足信息需求的内容、浏览。

搜索引擎用户信息需求的类别:导航类:用户检索时具有确定的检索目标页面,目的是查找某个已知存在的页面资源。

“清华大学本科招生网”:“导航类”信息需求信息类:用户检索时没有确定的检索目标页面,目的是查找与某个主题相关的信息。

“手足口病症状”:“信息类”信息需求。

事务类:用户检索时没有确定的检索目标页面,目的是查找与某个特定需求相关的资源。

“潜伏在线观看”:“事务类”信息需求例:同一个“魔兽争霸”查询请求,三种可能性都存在。

问题: 5? 同一个查询请求,有可能信息需求却截然不同。

? 这对搜索引擎处理用户查询造成了很大的困难;? 对构建查询样例集合的过程设置了障碍。

如果没有确定用户的信息需求,则无法准确地确定用户的查询目标页面。

解决的办法:( l)尽量选取信息需求描述得比较明确的用户查询。

? “清华大学本科招生网”:是明确的“导航类”信息需求; ? “潜伏在线观看”:是明确的“事务类”信息需求; ? “手足口病症状”:是“信息类”信息需求。

但应在满足“真实性”和“代表性”的前提下进行。

(2)对查询样例集合的信息需求类别加以规定。

TREC : Home Page Finding(主页查找)、Named Page Finding(命名网页查找)子任务是针对“导航类”信息需求设定的评测任务;Topic Distillation(主题提取)子任务则是针对“信息类”需求而设定的评测任务。

国内的SEWM 评测也沿袭了这一评测体系,将评测任务分为主题提取和导航搜索两个子任务。

( 3) 可以对每个查询的信息需求给予详细的描述。

构建查询样例集合时,不仅可以列出查询文本,而且还可以撰写对应查询的信息需求描述,以便在进行后续的目标页面集合构建时有章可循。

根据研究,导航类、信息类、事务类信息需求在用户使用搜索引擎行为中的比例约为20%、50%、30%,查询样例集合中相应信息需求样例的比例要符合这个比例关系。

6 正确答案集合构建定义:正确答案集合就是对应查询样例集合的目标页面集合。

Cranfield 评测方法中,正确答案是依照查询样例从语料库集合中标注出满足查询样例信息需求的文档。

查询样例网页对搜索引擎的性评价任务,语料库集合为全体万维网数据。

2002年,Web有100亿静态页面、1500亿动态页面。

TREC统计,在800万文档集合上,针对1个查询样例的正确答案评判,需9个人月。

那么对100亿静态页面进行针对一个查询样例的标注,需要一千个人年。

TREC的“结果池过滤技术”( pooling technology) (l)根据数据规模的大小,选择适当的查询结果集合规模N。

(2)对于某个查询样例Q,使用不同的待评测系统(T1,T2,…,Tn)对大规模文档集合进行检索,并分别得出各自的查询结果集合(RC1,RC2,…,RCn) ,其中| RCi |= N , ( i = 1,2,…,n)。

(3)构建结果池,pool = RC1 ∪RC2∪…∪RCn。

(4)对上述结果池中的结果进行标注,其中符合查询样例Q的信息需求的集合即为Q的正确答案集合。

搜索引擎评价指标7 传统信息检索系统的评价指标为“准确率/召回率”。

定义如下两个文档集合:Retrieved集合,待评测检索系统处理查询样例后返回的结果集合。

Relevant集合,正确答案集合。

准确率( Precision ,查准率)定义为:准确率衡量的是检索系统所返回的结果列表中正确答案的比例召回率(Recall ,查全率)定义为:召回率衡量的是正确答案集合中有多大比例的答案在检索系统返回的结果列表中。

检索系统的准确率、召回率同时都高:? 大部分正确答案被检索系统找到;? 返回的结果列表中非正确答案较少。

提高准确率与提高召回率,存在一定矛盾:8 搜索引擎性能评价中常用的评价指标。

1. 前n选精度( Precision at n , P@n ) 搜索引擎返回的结果序列前n位结果中正确答案的比例。

例: P@10= 表示在搜索引擎系统返回的前10篇结果文档中有4篇是正确答案。

于导航类信息需求对应的正确答案唯一,因此P @ n 指标通常用来评测信息类或者事务类查询的性能。

2. 前n选成功率( Success at n , S@n) 搜索引擎结果序列的前n篇结果文档中是否有正确答案。

例如S @ 10=1 :前10个结果中有某个结果是正确答案,可以满足用户需求。

S @ 10 =0:前10个结果中没有正确答案。

不存在S@10的数值既不为1,也不为0的情况。

3 首现正确答案排序倒数(Reciprocal Rank of First Correct Answer , RR) 定义:首现正确答案排序倒数是指检索系统返回的结果序列中第一个满足用户需求文档出现序号的倒数。

RR=1表示检索系统返回的结果中,第一个结果就满足用户需求。

RR通常用来评价导航类信息需求的性能,因为这类信息需求对应的查询样例只要有一个正确答案就可以满足用户需求。

9 例:下图的三个结果序列,正确答案出现的数目,以及除排名最靠前的正确答案之外的正确答案在结果序列中的排序都是一致的,其差别只在于首次出现的正确答案的结果排序。

“首现正确答案排序”分别为1、2、3 ,其对应的“首现正确答案排序倒数”分别为1、、。

4. 平均准确率(Average Precision , AP) 定义:平均准确率(AP)是指检索系统返回每一个正确答案文档时准确度的平均值10 例:下图两个结果序列,正确答案文档数目为 6 ,通过评价”前N位”结果构成的结果集合对应的”准确率/召回率”可以得到图中所示的准确率和召回率数值。

结果序列1中第1、3、4、5、6、10位为正确答案文档。

准确率的平均值:AP = (+ + ++ +)/6 = 结果序列2中第l、3、4、5、6位为正确答案文档。

AP = ( 1. 00 + + + + ) / 6 = 0. 68 “平均准确率”不仅考虑正确答案在结果序列中的排序情况,还考虑了结果序列返回的正确答案数目,因此,它是一个综合了准确率与召回率两方面的因素的评价指标。