基于libsvm的中文文本分类原型

- 格式:doc

- 大小:62.00 KB

- 文档页数:8

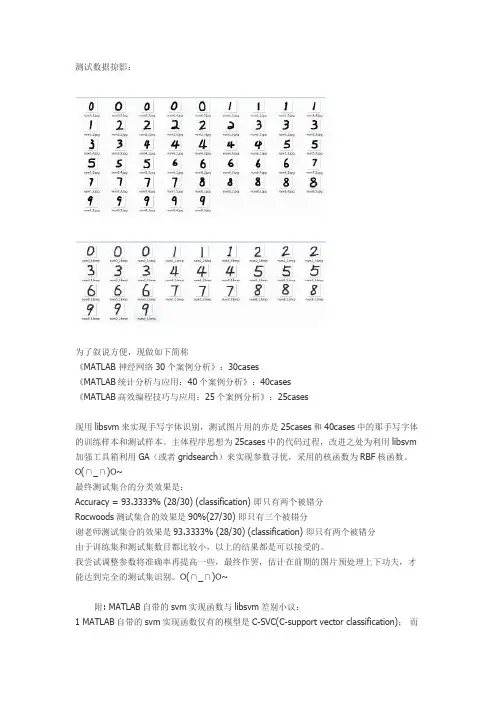

测试数据掠影:为了叙说方便,现做如下简称《MATLAB 神经网络30个案例分析》:30cases《MATLAB统计分析与应用:40个案例分析》:40cases《MATLAB高效编程技巧与应用:25个案例分析》:25cases现用libsvm来实现手写字体识别,测试图片用的亦是25cases和40cases中的那手写字体的训练样本和测试样本。

主体程序思想为25cases中的代码过程,改进之处为利用libsvm 加强工具箱利用GA(或者gridsearch)来实现参数寻优,采用的核函数为RBF核函数。

O(∩_∩)O~最终测试集合的分类效果是:Accuracy = 93.3333% (28/30) (classification) 即只有两个被错分Rocwoods测试集合的效果是90%(27/30) 即只有三个被错分谢老师测试集合的效果是93.3333% (28/30) (classification) 即只有两个被错分由于训练集和测试集数目都比较小,以上的结果都是可以接受的。

我尝试调整参数将准确率再提高一些,最终作罢,估计在前期的图片预处理上下功夫,才能达到完全的测试集识别。

O(∩_∩)O~附: MATLAB自带的svm实现函数与libsvm差别小议:1 MATLAB自带的svm实现函数仅有的模型是C-SVC(C-support vector classification);而libsvm工具箱有C-SVC(C-support vector classification),nu-SVC(nu-support vector classification),one-class SVM(distribution estimation),epsilon-SVR(epsilon-support vector regression),nu-SVR(nu-support vector regression)等多种模型可供使用。

基于SVM的文本分类算法研究随着互联网技术的发展,信息爆炸的时代已经来临。

人们需要从庞大的信息中筛选出自己所需要的信息。

这时,文本分类技术就显得尤为重要。

文本分类作为信息挖掘的一部分,其在广告推荐、情感分析、垃圾短信识别、新闻分类等领域有着广泛的应用。

SVM(Support Vector Machine)是一种非常流行的分类算法。

它集结了数学、统计、信息论和计算机科学等多个学科的知识,被视为机器学习中最强大的有监督学习算法之一。

其主要思想是通过构造一个最优的超平面将数据进行分类。

本文旨在研究基于SVM的文本分类算法,并探讨其在实际应用中的优点和不足之处。

一、文本分类技术概述文本分类是指将文本自动分类为事先定义的类别之一的任务。

随着互联网的发展和应用,文本分类技术得到了越来越多的关注和研究,主要包括以下几个方面:1. 特征提取:将文本转化为计算机可以理解的形式,通常使用的方法有词袋模型、TF-IDF模型等。

2. 分类算法:将文本进行分类,目前主要使用的算法有贝叶斯分类、K近邻分类、支持向量机分类等。

3. 样本准备:建立训练集和测试集,并对文本进行预处理,包括去除停止词、词干提取等。

4. 模型评估与调优:对模型进行评估和优化,以提高分类准确率。

二、基于SVM的文本分类算法支持向量机(SVM)是一种分类和回归分析的机器学习算法,通过寻找最优超平面实现分类。

SVM算法是一种二分类模型,但可以通过多个SVM模型相结合实现多分类。

在文本分类领域中,SVM算法广泛使用,并成为文本分类算法的首选之一。

SVM算法的主要特点在于能够处理高维数据,并具有良好的泛化能力,这使得它在文本分类中更具有优势。

与其他分类算法相比,SVM具有更少的超参数需要调整,使得其应用更加便捷。

本文所研究的基于SVM的文本分类算法,主要包含以下几个步骤:1. 文本预处理:对文本进行去除HTML标签、停用词过滤、词干提取、向量化等操作,以准备好分类任务所需的数据。

学号:2009030114哈尔滨师范大学学士学位论文题目基于支持向量机的文本分类算法研究与实现学生李慧颖指导教师李红宇副教授年级2009级专业计算机科学与技术系别计算机科学与技术学院计算机科学与信息工程学士学位论文题目基于支持向量机的文本分类算法研究与实现学生李慧颖指导教师李红宇副教授年级2009级专业计算机科学与技术系别计算机科学与技术学院计算机科学与信息工程哈尔滨师范大学2013年5月摘要:随着计算机与通讯技术的飞速发展,互联网上的电子文档信息急剧增加。

这就使得文本的自动分类越来越受人们的重视,而支持向量机和文本分类问题有着良好的结合点,从而使得基于支持向量机的文本分类成为这个领域的研究热点。

支持向量机是一种基于结构风险最小化准则的分类学习机模型,它的应用十分广泛。

虽然支持向量机算法的性能在许多实际问题的应用中得到了验证,但是还存在着一些需要改进的地方,如:训练算法速度慢、测试阶段运算量大等。

关键词:支持向量机;文本分类;学习机模型目录第一章引言 (1)1.1研究背景及意义 (1)1.2 国内外研究现状 (1)1.2.1 文本分类研究现状 (1)1.2.2 SVM研究现状 (2)1.3 文本内容研究 (3)第二章文本分类 (4)2.1 文本自动分类概述 (4)2.2 文本分类所涉及的技术领域 (4)2.2.1 文本分类与自然语言处理 (4)2.2.2 文本分类与文本挖掘 (5)2.2.3 文本分类与机器学习 (5)2.2.4 文本分类与模式识别 (5)2.3 文本分类的关键技术 (6)2.3.1 文本表示 (6)2.3.2 特征选择 (7)2.3.3 权重计算 (9)2.3.4 常用的文本分类算法 (9)2.4 文本分类的应用 (11)第三章支持向量机 (13)3.1 支持向量机简介 (13)3.2 支持向量分类机 (14)3.2.1 线性可分问题 (14)3.2.2 近似线性可分问题 (15)3.2.3 线性不可分问题 (15)3.3 支持向量机的应用步骤 (16)3.4基于支持向量机文本分类方法的优势 (17)3.5基于支持向量机文本分类方法中存在的问题 (17)第四章小波变换在支持向量机分类中的应用 (19)4.1 问题的提出 (19)4.2降维相关的研究工作 (19)4.3 小波分析 (20)4.3.1 离散小波变换 (20)4.3.2 小波的定义 (21)4.4 一维哈尔小波变换 (21)4.4.1 哈尔基函数 (22)4.4.2 哈尔小波函数 (22)4.4.3 函数的规范化 (23)4.4.4 哈尔基的结构 (24)4.5 哈尔小波变换的应用 (24)4.5.1 哈尔小波变换的过程 (24)4.5.2 哈尔小波变换的应用 (24)4.6 哈尔小波变换在本文中的应用 (26)4.6.1 小波变换的应用 (27)4.7 实验及结果分析 (28)4.7.1 实验平台及环境 (28)4.7.2 实验步骤 (28)4.7.3 实验目的 (29)4.7.4 结果分析 (29)第五章总结 (33)5.1 文本总结 (33)5.2 工作展望 (33)参考文献: (34)Absatrct: . (35)第一章引言1.1研究背景及意义所谓的文本自动分类,最初是应信息检索(Information Retrieval,IR)系统的要求出现的。

基于SVM的文本分类任务实例分析近年来,随着数据时代的到来,文本分类技术在信息处理、智能搜索、情感分析等领域得到了广泛的应用。

基于SVM(Support Vector Machine)的文本分类是一种有效的文本分类方法,具有准确性高、泛化能力强等特点。

本文将通过实例分析,深入研究和探讨基于SVM的文本分类任务。

一、SVM简介SVM是机器学习中的一种算法,其基本思想是找到一个最优的超平面,将数据点分为不同的类别。

SVM是一种清晰、有效、可靠的算法,其在非线性分类、文本分类、图像识别等领域都有着广泛的应用。

二、文本分类文本分类(Text Classification)是指将文本信息自动分类到预定义的类别中。

文本分类技术对于实现自动化的信息处理、智能搜索、情感分析等领域具有重要的意义。

文本分类任务具体分为训练和预测两个部分,通过训练使得机器学习算法获取不同类别的文本特征,完成模型的构建和训练,最终实现对未知文本的分类和预测。

三、基于SVM的文本分类实例分析在本文中,我们以20 Newsgroup数据集作为实验数据,该数据集包含来自20个不同新闻组的18,846篇新闻文章,其中分别包含11,314篇训练文本和7,532篇测试文本。

我们使用Python语言和scikit-learn库实现了基于SVM的文本分类实例。

1.数据预处理在进行文本分类之前,我们需要对原始文本进行预处理。

预处理步骤包括去除标点、停用词等无用信息,进行向量化处理,将文本转化为数值型数据。

2.特征提取特征提取是文本分类中非常重要的一步,它决定了文本表示的质量和分类效果的好坏。

我们使用TF-IDF(Term Frequency-Inverse Document Frequency)作为特征提取的方法。

TF-IDF是一种用于度量文本中词语重要性的方法,它考虑了某一词语在文档中出现的频率以及在整个语料库中出现的频率。

3.模型构建和训练SVM算法是一种监督学习算法,我们需要先构建一个训练集,将文本特征和对应的分类标签建立映射。

基于SVM的手写体相似汉字识别

宫蓉蓉

【期刊名称】《电脑与信息技术》

【年(卷),期】2008(016)004

【摘要】支持向量机作为一种新的机器学习方法,由于其建立在结构风险最小化准则之上,而不仅仅是使经验风险达到最小,从而使支持向量分类器具有较好的推广能力.并且,由于支持向量机算法是一个凸二次优化问题,能够保证找到的极值解就是全局最优解.文章首先讨论了基于支持向量机的手写体相似汉字识别过程.然后,针对支持向量机识别手写汉字所遇到的问题进行了分析和阐述,并在此基础上提出了基于最小距离分类器分类的两级分类策略.最后,针对理论进行了实验仿真.实验结果有力证明了本文提出的基于svM的相似汉字识别方法的有效性.

【总页数】3页(P37-39)

【作者】宫蓉蓉

【作者单位】长沙民政职业技术学院软件学院,湖南长沙,410004

【正文语种】中文

【中图分类】TP391

【相关文献】

1.一种动态剪枝二叉树SVM的脱机手写体汉字识别方法研究 [J], 徐小丽;范程华;樊敏

2.基于SVM的多特征手写体汉字识别技术 [J], 周庆曙;陈劲杰;纪鹏飞

3.SVM多值分类器在脱机手写体相似汉字识别中的应用 [J], 封筠;王彦芳;杨扬;王小平;刘永军

4.一种不确定性二叉树 SVM 的脱机手写体汉字识别研究 [J], 范程华;徐小丽;蒋先伟;鲁世斌

5.基于融合特征和LS-SVM的脱机手写体汉字识别 [J], 高彦宇;杨扬;陈飞

因版权原因,仅展示原文概要,查看原文内容请购买。

基于SVM的中文文本分类算法研究与实现的开题报告一、研究背景在现代社会中,数据信息的爆炸性增长与互联网技术的迅猛发展给人们带来了海量的数据信息,这就要求我们对于这些数据信息进行分类处理,以便于对数据信息进行更加有效的管理。

而文本分类技术则是对文本进行自动分类的一种应用技术。

目前,文本分类技术已广泛应用于情感分析、新闻分类、文本检测等领域。

支持向量机(SVM)作为一种非常有效的模式识别技术,已经被广泛应用于文本分类领域。

然而,中文文本分类问题的研究相对较少。

一方面,中文语言的特殊性会影响文本分类技术的性能;另一方面,中文语言的特殊性也为中文文本分类问题的研究提供了更多的挑战和机遇。

因此,本研究将着重研究中文文本分类算法的性能优化问题,并将采用SVM算法对中文文本进行分类处理,探索SVM在中文文本分类中的优化实现方式。

二、研究目的与意义本研究的目的是探讨SVM算法在中文文本分类中的性能优化问题,并提出相应的实现方法。

具体来说,将探讨以下几点:1、研究基于SVM的中文文本分类算法的基本原理与实现方法。

2、探索中文文本特征的提取方法,探讨中文文本特征的选取与处理。

3、研究基于SVM的中文文本分类器的性能优化问题,并提出相应的解决方案。

本研究的意义在于:1、探索SVM在中文文本分类中的性能优化方式,为中文文本分类技术的发展提供有益的参考。

2、通过对中文文本特征的选取与处理,提高中文文本分类算法的准确率,使其更加适用于中文自然语言处理领域。

3、提高中文文本分类的效率和性能,为中文文本分类技术的应用提供更加可靠和有效的支持。

三、研究内容和方法本研究的主要内容包括:1、研究中文文本分类算法的基本原理和实现方法,包括中文文本特征的提取和处理、分类器的选择、分类器的训练和测试等。

2、实现基于SVM的中文文本分类算法,并通过实验验证算法的性能。

3、优化基于SVM的中文文本分类算法,提高算法的准确率和效率。

本研究的主要研究方法包括:1、收集中文文本分类的相关文献资料,研究中文文本分类算法的基本原理和实现方法,了解相关的技术和方法等。

Java实现基于SVM的文本分类算法案例分析1. 简介本文将介绍如何使用Java语言实现基于支持向量机(Support Vector Machine, SVM)的文本分类算法。

SVM是一种常用于模式识别和机器学习的机器学习方法,它被广泛应用于文本分类、图像分类等领域。

在本文中,我们将使用Java编程语言来实现一个文本分类的案例。

2. 数据准备在进行文本分类之前,我们首先需要准备训练数据和测试数据。

训练数据是用来训练分类模型的数据,测试数据是用来测试分类模型的数据。

为了简化问题,我们假设已经有了一组已经标注好的文本数据集,其中包含了一些文本样本和对应的分类标签。

3. 特征提取为了能够让计算机理解和处理文本数据,我们需要将文本数据转换成计算机可以处理的向量表示。

常用的文本特征提取方法有词袋模型和TF-IDF模型。

在本案例中,我们将使用TF-IDF模型来进行特征提取。

4. 数据预处理在进行特征提取之前,我们需要对原始文本数据进行一些预处理工作。

预处理包括去除文本中的标点符号、停用词和数字,并进行词干化等处理。

这些预处理的目的是为了减少噪音和提高文本特征的有效性。

5. 特征选择在进行文本分类之前,我们还需要进行特征选择。

特征选择的目的是为了选取那些对分类任务最具有区分性和重要性的特征。

常用的特征选择方法有卡方检验和互信息等。

在本案例中,我们将使用卡方检验来进行特征选择。

6. 使用SVM进行文本分类在进行特征提取和选择之后,我们可以开始使用SVM进行文本分类了。

SVM是一种有监督学习方法,它通过将数据映射到高维空间,构建一个最优的超平面来实现分类。

在本案例中,我们将使用Java编程语言中的开源机器学习库来实现SVM算法。

7. 模型训练与评估在实现了SVM算法之后,我们需要用训练数据来训练模型,并用测试数据来评估模型的性能。

评估模型性能的指标包括准确率、召回率和F1值等。

通过评估模型的性能,我们可以了解模型在分类任务上的表现情况。

利⽤LibSVM进⾏⼆类⽂本分类系列

作者转载使⽤等请注明出处

笔者按:此系列博⽂仅对于Libsvm⼆分类做⼊门性的介绍,并⾮研究libsvm的专业⽔准⽂章。

⾄于如何⽤libsvm进⾏回归,多分类,笔者⽬前还没有涉及,请您查阅libsvm的相关⽂档说明。

这⾥给出⽂本预处理模块(Python语⾔编写);调⽤libsvm进⾏⽂本分类模块采⽤C语⾔编写;实验结果处理模块(Matlab)

⽤此份代码做的实验:

⽂本预处理部分主要功能:帮助读者能够快速⽤我的这套程序形成Libsvm格式数据,做实验。

分类部分代码完成的主要功能:完成⼯程中调⽤libsvm进⾏⽂本分类,并返返回准确率。

实验结果出来模块:完成数据统计,结果分析,画图等功能。

基于SVM的中文文本分类相关算法的研究与实现的开题报告一、选题背景和意义随着互联网和信息技术的发展,人们面临着海量的文本信息,如何快速、准确地获取和处理这些信息,成为了信息化时代的严峻挑战。

文本分类是对文本信息进行自动分类的一种重要手段。

它在网络搜索、情感分析、广告推荐、知识发现等领域中发挥着重要的作用。

中文文本分类是文本分类领域的一个热点问题,中文语言的复杂性和多义性给中文文本分类带来了较大的挑战。

支持向量机(SVM)是一种基于统计学习理论的分类算法,在文本分类领域中得到了广泛应用。

SVM 采用核函数映射方式处理高维数据,使数据在低维空间中得到很好的分类效果。

因此,基于SVM的中文文本分类算法可以较好地解决中文文本分类问题。

二、研究内容和技术路线1. 研究内容本文主要研究基于SVM的中文文本分类算法,包括以下内容:(1)中文分词:分别探究jieba分词、THULAC分词等中文分词工具的特点和效果,选取最适合文本分类的分词工具。

(2)特征表示:采用词袋模型对中文文本进行特征表示,探究TF-IDF、词频、文本长度等特征表示方法的效果。

(3)特征选择:采用信息增益、卡方检验等特征选择方法,选择最相关的特征词。

(4)SVM模型:使用libsvm工具库构建SVM分类模型,探究线性核函数、高斯核函数等核函数对分类效果的影响。

(5)分类效果评估:采用准确率、召回率、F1值等指标对分类结果进行评估。

2. 技术路线(1)数据采集和预处理:获取中文文本数据集,进行数据预处理和清洗。

(2)中文分词:尝试jieba分词和THULAC分词等中文分词工具,对比分词效果。

(3)特征表示和选择:选取最优的特征表示方法和特征选择方法。

(4)SVM模型构建:使用libsvm工具库构建SVM分类模型,探究不同核函数对分类效果的影响。

(5)分类效果评估:采用准确率、召回率、F1值等指标进行分类效果评估。

三、研究计划和时间安排1. 研究计划具体的研究计划如下:(1)文献调研和资料收集(1个月)。

基于SVM的中文文本分类系统的设计与实现张昭楠【摘要】互联网已经成为现代生活中不可或缺的一部分,网络上的信息量也在以数倍的速度快速增长。

无论是企事业单位,学校,或者科研院校等等机构中,都积累了非常多的资料,这些资料绝大多数都以文档的形式存在。

所以,如何将数以万计且排序混乱的文本信息,按照一定的规则和形式进行统一的管理,以达到方便使用和管理的目的成为了一个不得不去解决的问题。

本文就是在SVM,即支持向量机方法的基础上,设计了一个中文文本分类系统。

介绍了系统的需求分析,并对系统进行了详细设计,从概念的初始化设计到之后的详细设计,实现了基于SVM的中文文本分类系统的最终目的,达到了设计要求。

%The internet has become an indispensable part in modern life, the amount of information on the network also several times at the speed of fast growth. Both the enterprises and institutions, schools, or scientific research in colleges and universities, and so on organization, have accumulated a lot of information, the information is mostly in the form of document. So, in the face of these massive amounts of text document information, how to effectively manage and utilize them becomes a have to solve the problem. This article is in the SVM, namely, on the basis of support vector machine (SVM) method, a Chinese text classification system is designed. Introduces the system requirement analysis, and has carried on the detailed design of system, after the initialization of the concept of design to detailed design, realized the ultimate goal of Chinese text classification system based on SVM, and has reached the design requirements.【期刊名称】《电子设计工程》【年(卷),期】2016(024)016【总页数】3页(P139-141)【关键词】文本分类;支持向量机;文本表示;特征选择【作者】张昭楠【作者单位】陕西职业技术学院陕西西安 710000【正文语种】中文【中图分类】TN99随着信息化时代的全面降临,信息资源也已经和能源,物质等常规资源占有同样重要的地位。

基于SVM的中文文本分类系统研究的开题报告一、选题的背景和意义随着信息技术的发展,网络上的文本数据量越来越庞大,如何从中提取出有用的信息成为了一个重要的问题。

中文文本分类是文本挖掘的一个研究领域,其目的是将中文文本按照预定义的类别进行分类,以便于信息的整理和利用。

目前,中文文本分类已经在很多领域得到了广泛的应用,例如情感分析、Web 页面分类、新闻分类等。

支持向量机(SVM)是一种经典的机器学习算法,其具有良好的分类性能和泛化能力。

SVM在中文文本分类中也有很好的应用效果,例如在J. Han等人的研究中,采用SVM进行中文文本分类的实验结果表明,SVM算法对中文文本分类的效果优于朴素贝叶斯算法。

本文将研究基于SVM的中文文本分类系统,旨在通过实验验证SVM 算法在中文文本分类中的效果,并进行相应的改进。

此外,还将探讨数据预处理、特征选择和模型优化等问题,以提高系统的分类性能和应用效果,为中文文本分类技术的发展贡献一份力量。

二、研究的内容和方法2.1 研究内容本论文将研究基于SVM的中文文本分类系统,具体包括以下内容:1.中文文本分类的基本概念和相关技术2.支持向量机算法的原理和应用3.数据预处理、特征选择和模型优化4.基于SVM的中文文本分类实验设计5.实验结果分析和对比6.针对实验结果对系统进行改进和优化2.2 研究方法本论文将采用实验研究法,具体包括以下步骤:1.收集中文文本分类的相关数据集2.进行数据预处理,包括中文分词、去除停用词、词干提取等3.特征选取,包括互信息、卡方检验、信息增益等方法4.采用SVM算法进行中文文本分类,并进行模型参数的优化5.对实验结果进行评估和对比6.针对实验结果对系统进行改进和优化三、预期的结果和贡献通过实验研究,本论文预期达到以下结果:1.验证SVM算法在中文文本分类中的效果,并与其他算法进行比较2.探索数据预处理、特征选择和模型优化等技术对系统分类性能的影响3.改进和优化系统算法,提高中文文本分类的应用效果本论文的主要贡献在于基于SVM的中文文本分类系统的设计、实验和应用。

基于SVM模型的文本分类算法研究随着互联网技术的发展,大数据时代已经到来。

数据的爆炸性增长使得我们需要更多的工具和技术来处理和分析这些数据,以便更好地利用数据。

其中文本数据是其中重要的一种形式。

文本分类算法则是文本数据分析中最重要的部分之一。

本文将介绍基于SVM模型的文本分类算法研究。

一. 文本分类算法的基本概念文本分类算法,也称为文本挖掘,是一种将文本数据根据其语义内容归类的技术。

这种技术对于组织和管理大量文本数据非常重要。

例如,新闻文章、社交媒体上的评论、产品评论、电子邮件和其他在线内容都可以通过文本分类算法进行自动归类和组织。

文本分类算法通过分类器,将文本数据划分为预定义的类别。

利用文本分类算法,我们可以对大量文本数据进行快速准确的处理和分析。

文本分类算法中主要的两个概念是“特征提取”和“分类器”。

文本的自然语言表示方式是一长串单词,如何选择文本中最有代表性的特征就显得至关重要。

常见的特征提取包括文本降维、词袋模型和tf-idf方法。

而在特征提取之后,需要建立一个能够将文本分类的紫用分类器,常用的分类器有朴素贝叶斯分类器、决策树分类器和支持向量机分类器。

二. SVM模型支持向量机(Support Vector Machine,SVM)是一种广泛应用于模式识别的分类算法,主要用于二元分类和基于其构建的多元分类。

SVM的目标是在超空间中找到样本集的最优划分超平面,即将样本集分成两个不同的部分。

SVM分类器具有非常高的精度和泛化能力,并在文本分类中得到广泛应用。

在SVM模型中,计算的过程可以描述如下。

假设有一个超平面:$f(x)=\textbf{w}·\textbf{x}+b=0$其中:$\textbf{w}$ 为超平面法向量;$b$ 为偏差项;$\textbf{x}$ 为输入样本;在分类时,对于任意一个样本 $\textbf{x}$,其类别可以表示为:$y=\text{sign}(f(\textbf{x}))$其中,$\text{sign}$ 为符号函数,用于判断超平面的位置。

文章编号:1006-2475(2006)08-0005-04收稿日期:2005-09-15作者简介:马金娜(1979-),女,河南项城人,上海理工大学管理学院硕士研究生,研究方向:文本挖掘;田大钢(1958-),男,江西人,副教授,研究方向:决策支持系统,数据挖掘,优化计算。

基于SVM 的中文文本自动分类研究马金娜,田大钢(上海理工大学管理学院,上海 200093)摘要:详细介绍了进行文本分类的过程,并着重介绍了一种新的基于结构风险最小化理论的分类算法)))支持向量机,通过实验比较支持向量机算法和传统的KNN 算法应用于文本分类的效果,证实了支持向量机在处理文本分类问题上的优越性。

关键词:文本分类;支持向量机;特征提取中图分类号:TP391 文献标识码:AResearch on C hinese -text Automatic C lassification Based on SVMMA Jin -na,TIAN Da -gang(College of Management,University of Shanghai for Science and Technology,Shanghai 200093,China)Abstract:T his paper describes the course of text classification and a new efficient classification algorith m )))Support Vector Machine.In the end,S VM and the tradi tional tex-t classification algorithm )))KNN are applied to Chinese -text automatic classi fication,it is proved that the S VM is superior.Key words:text classification;SVM;feature selection0 引 言所谓/数据丰富但知识缺乏0的现状导致了数据挖掘(Data Mining)技术研究的兴起,数据挖掘是从海量的结构化信息中抽取或挖掘隐含信息和知识的重要方法和途径[1]。

基于libsvm的中文文本分类原型支持向量机(SupportVectorMachine)是Corte和Vapnik于1995年首先提出的,它在解决小样本、非线性及高维模式识别中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中。

支持向量机方法是建立在统计学习理论的VC维理论和结构风险最小原理基础上的,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度,Accuracy)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以期获得最好的推广能力(或称泛化能力)。

SVM理论的学习,请参考japer的博客更多案例到W某公zhonghao:datadw文本分类,大致分为如下几件事情:样本,分词,特征提取,向量计算,分类训练,测试和调试1.样本选择2.分词Bamboo分词,这是基于CRF++的分词模块,既然是研究统计学习,分词也得用基于统计的不是,如果还是用一字典来分词,那就太out啦。

因为咱主要目的是研究分类,不是分词,就不要去搞分词的训练了,如果想训练可以看我的另外一篇博客:CRF++中文分词指南可以试试:/opt/bamboo/bin/bamboo-pcrf_egfilename,如果成功证明装好了。

稍微注意以下,搜狗的词库是gb2312的,所以,请转为utf8,再分词,这是python写的函数:输入一个文件名,转为utf8,再分词,分词文件以.eg为后缀。

[python]viewplaincopy1.defeg(fn):2.ifnoto.path.ifile(fn+'.utf8'):3.cmd='iconv-fgb2312-tutf8-c%>%.utf8'%(fn,fn)4.printcmd5.o.ytem(cmd)6.cmd='/opt/bamboo/bin/bamboo-pcrf_eg%.utf8>%.eg'%(fn,fn)7.printcmd8.o.ytem(cmd)分词结果如下:一家刚刚成立两年的网络支付公司,它的目标是成为市值100亿美元的上市公司这家公司叫做快钱,说这句话的是快钱的CEO关国光他之前曾任网易的高级副总裁,负责过网易的上市工作对于为什么选择第三方支付作为创业方向,他曾经对媒体这样说:“我能看到这个胡同对面是什么,别人只能看到这个胡同”自信与狂妄只有一步之遥――这几乎是所有创业者的共同特征,是自信还是狂妄也许需要留待时间来考证3.特征提取vm不是在高维模式识别具有优势吗,咋还要特征提取呢,把所有词都当成特征不就行了吗?对于词库来说,十几万的词是很常见的,把对类别区分度(GDP,CPI,股票对经济类的区分度就高,其他一些高频词,如我们,大家,一起等就没有区分度)高的词挑选出来,一来可以减少计算量,二来应该是可以提高分类效果。

基于libsvm的手写字体识别——30cases与40cases&25cases“联谊”第三弹By faruto2010/6/2“联谊”案例:30cases第12、13章(libsvm分类相关),25cases案例18——9.3.5(用matlab自带的svm实现手写字体识别),40cases案例39(用贝叶斯判别实现手写字体识别)现用libsvm来实现手写字体识别,测试图片用的亦是25cases和40cases中的那手写字体的训练样本和测试样本。

主体程序思想为25cases中的代码过程,改进之处为利用libsvm 加强工具箱利用GA(或者gridsearch)来实现参数寻优,采用的核函数为RBF核函数。

O(∩_∩)O~最终测试集合的分类效果是:Accuracy = 93.3333% (28/30) (classification) 即只有两个被错分Rocwoods测试集合的效果是90%(27/30) 即只有三个被错分谢老师测试集合的效果是93.3333% (28/30) (classification) 即只有两个被错分由于训练集和测试集数目都比较小,以上的结果都是可以接受的。

我尝试调整参数将准确率再提高一些,最终作罢,估计在前期的图片预处理上下功夫,才能达到完全的测试集识别。

O(∩_∩)O~附: MATLAB自带的svm实现函数与libsvm差别小议:1 MATLAB自带的svm实现函数仅有的模型是C-SVC(C-support vector classification);而libsvm工具箱有C-SVC(C-support vector classification),nu-SVC(nu-support vectorclassification),one-class SVM(distribution estimation),epsilon-SVR(epsilon-support vector regression),nu-SVR(nu-support vector regression)等多种模型可供使用。

基于libsvm的中文文本分类原型支持向量机(Support Vector Machine)是Cortes和Vapnik于1995年首先提出的,它在解决小样本、非线性及高维模式识别中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中。

支持向量机方法是建立在统计学习理论的VC 维理论和结构风险最小原理基础上的,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度,Accuracy)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以期获得最好的推广能力(或称泛化能力)。

SVM理论的学习,请参考jasper的博客。

LIBSVM 是台湾大学林智仁(Chih-Jen Lin)博士等开发设计的一个操作简单、易于使用、快速有效的通用SVM 软件包,可以解决分类问题(包括C−SVC 、ν−SVC ),回归问题(包括ε − SVR 、v− SVR )以及分布估计(one − class − SVM ) 等问题,提供了线性、多项式、径向基和S 形函数四种常用的核函数供选择,可以有效地解决多类问题、交叉验证选择参数、对不平衡样本加权、多类问题的概率估计等。

LIBSVM是一个开源的软件包,。

他不仅提供了LIBSVM 的C++语言的算法源代码,还提供了Python、Java、R、MATLAB、Perl、Ruby、LabVIEW以及C#.net 等各种语言的接口,可以方便的在Windows 或UNIX 平台下使用,也便于科研工作者根据自己的需要进行改进(譬如设计使用符合自己特定问题需要的核函数等)。

更多案例到WX 公zhong hao : datadw文本分类,大致分为如下几件事情:样本,分词,特征提取,向量计算,分类训练,测试和调试。

1.样本选择搜狗语料/labs/dl/c.html,下精简版吧,如果实验用用,这足够了,你要下107M的也可以。

当然,你也可以自己找语料,不过麻烦点而已,把各大门户网站的对应频道下的文章都爬下来。

2.分词Bamboo分词,这是基于CRF++的分词模块,既然是研究统计学习,分词也得用基于统计的不是,如果还是用一字典来分词,那就太out啦。

/p/nlpbamboo/wiki/GettingStarted。

安装完毕bamboo,还要下载训练好的模型(这个模型是基于人民日报1月语料)/p/nlpbamboo/downloads/list,下载index.tar.bz2,解压到/opt/bamboo/index下。

因为咱主要目的是研究分类,不是分词,就不要去搞分词的训练了,如果想训练可以看我的另外一篇博客:CRF++中文分词指南。

可以试试:/opt/bamboo/bin/bamboo -p crf_seg filename,如果成功证明装好了。

稍微注意以下,搜狗的词库是gb2312的,所以,请转为utf8,再分词,这是python写的函数:输入一个文件名,转为utf8,再分词,分词文件以.seg为后缀。

[python]view plain copy1.def seg(fn):2.if not os.path.isfile(fn+'.utf8'):3. cmd = 'iconv -f gb2312 -t utf8 -c %s > %s.utf8' %(fn,fn)4.print cmd5. os.system(cmd)6. cmd = '/opt/bamboo/bin/bamboo -p crf_seg %s.utf8 > %s.seg' % (fn,fn)7.print cmd8. os.system(cmd)分词结果如下:一家刚刚成立两年的网络支付公司,它的目标是成为市值100亿美元的上市公司。

这家公司叫做快钱,说这句话的是快钱的CEO 关国光。

他之前曾任网易的高级副总裁,负责过网易的上市工作。

对于为什么选择第三方支付作为创业方向,他曾经对媒体这样说:“ 我能看到这个胡同对面是什么,别人只能看到这个胡同。

” 自信与狂妄只有一步之遥―― 这几乎是所有创业者的共同特征,是自信还是狂妄也许需要留待时间来考证。

3.特征提取svm不是在高维模式识别具有优势吗,咋还要特征提取呢,把所有词都当成特征不就行了吗?对于词库来说,十几万的词是很常见的,把对类别区分度(GDP,CPI,股票对经济类的区分度就高,其他一些高频词,如我们,大家,一起等就没有区分度)高的词挑选出来,一来可以减少计算量,二来应该是可以提高分类效果。

据说,开方检验(CHI)信息增益(IG)对于挑选特征好,我选择的是CHI。

两者的概念,请google。

首先统计词在文档中的次数[python]view plain copy1.#ingore some term2.def ingore(s):3.return s == 'nbsp'or s == ' 'or s == ' 'or s == '/t'or s == '/n' /4.or s == ','or s == '。

'or s == '!'or s == '、'or s == '―'/5.or s == '?'or s == '@'or s == ':' /6.or s == '#'or s == '%'or s == '&' /7.or s == '('or s == ')'or s == '《'or s == '》' /8.or s == '['or s == ']'or s == '{'or s == '}' /9.or s == '*'or s == ','or s == '.'or s == '&' /10.or s == '!'or s == '?'or s == ':'or s == ';'/11.or s == '-'or s == '&'/12.or s == '<'or s == '>'or s == '('or s == ')' /13.or s == '['or s == ']'or s == '{'or s == '}'14.15.#term times16.def getterm(fn):17. fnobj = open(fn,'r')18. data = fnobj.read()19. fnobj.close()20. arr = data.split(' ')21. docterm = dict()22.for a in arr:23. a = a.strip(' /n/t')24.if not ingore(a) and len( a.decode('utf-8')) >=2:25. times = docterm.get(a)26.if times:27. docterm[a] = times + 128.else:29. docterm[a] = 130.return docte31.#cls_term:cls,term,artcount32.#term_cls:term,cls,artcount33.def stat(cls,fn,cls_term,term_cls):34. docterm = getterm(fn)35. termdi = cls_term.get(cls)36.if not termdi:37. termdi = dict()38. cls_term[cls] = termdi39.#term,times40.for t in docterm.iterkeys():41. artcount = termdi.get(t)42.if not artcount:43. artcount = 044. termdi[k] = artcount + 145. clsdi = term_cls.get(t)46.if not clsdi:47. clsdi = {}48. term_cls[k] = clsdi49. artcount = clsdi.get(cls)50.if not artcount:51. artcount = 052. clsdi[cls] = artcount + 1分别计算每个词的a/b/c/da:在这个分类下包含这个词的文档数量b:不在该分类下包含这个词的文档数量c:在这个分类下不包含这个词的文档数量d:不在该分类下,且不包含这个词的文档数量因为前面统计了每个类下,每个词,文章数和每个词,每个类,文章数。

所以很容易得到a,b,c,d的值。

z1 = a*d - b*cx2 = (z1 * z1 * float(N)) /( (a+c)*(a+b)*(b+d)*(c+d) )计算之后,排序,并取出前1000个词(这里指的每个类别的特征词)。

li = sorted(termchi.iteritems(), key=lambda d:d[1], reverse = True)循环每个分类,并把每个类别的特征合并(合并成一个文件,作为特征词典),合并后存为feature文件,第一列是序号,第二列是对应的词,序号就是特征号。

1 逐项2 深市3 九寨沟4 岛内5 期望6 第20分钟7 合理8 谢杏芳9 赛迪10 毛泽东注:特征选择的目的就是选择在该类下,不在其他类下的特征,但是重复是避免不了的,合并的文件肯定是排重过的。

先选择每个类下的1000个词,假如10个类,则共选择10 * 1000个词,然后去重,并生成特征的唯一id。

4.训练和测试样本组织搜狐语料的1990篇中的1890作为训练集,100篇作为测试集,分别形成train和test文件,libsvm的训练集的格式为:lable1 index1:featureValue1 index2:featureValue2 index3:featureValue3 ...lable2 index1:featureValue1 index2:featureValue2 index3:featureValue3 ...对应到文本分类上就是:类别ID 特征序号(第3步计算的特征序号):特征值(TFIDF值)......如,我摘了一行,这是一篇文章的例子,8就是类别ID,189是特征“189 指导"的序号,0.171153是特征值:8 189:0.171153 253:0.081381 298:0.630345 504:0.135512 562:79.423503 578:0.072219 698:0.078896 710:0.036074 740:0.215368 868:0.263524 1336:0.114355 1365:0.076494 1372:0.085780 1555:0.572497 1563:3.932806 1598:0.114717 1685:0.1298701972:0.193693 2282:0.061828 2865:0.026699 2897:0.099020 3040:0.0396213041:0.258073 3191:0.091276 3377:0.125544 3454:0.062189 3623:0.1396983653:0.128304 3932:2.990233 4353:0.202133 4394:0.312992 4420:0.3563544424:0.482424 4522:0.447795 4675:3.618182 4767:0.065334 4848:0.2704174875:0.213588 4941:0.407453 5004:0.070447 5125:0.717893 5214:3.2222995250:0.052897 5251:0.281352 5310:2.010101 5357:0.203956 5474:0.0340375504:0.193900 5861:0.859426 6120:1.320504 6129:0.107941 6364:0.1842256373:0.287843 6379:0.080727 6385:0.712241 6847:0.209023 7007:0.1478027121:1.320504 7547:0.248161 7636:0.108981采用TFIDF的算法,数据处理和特征选择类似,计算每个类,每篇文档,每个词的次数,以包含这个词的文档数。