信息论基础教程

- 格式:ppt

- 大小:2.54 MB

- 文档页数:195

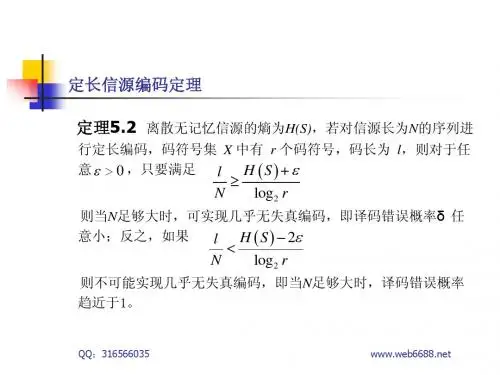

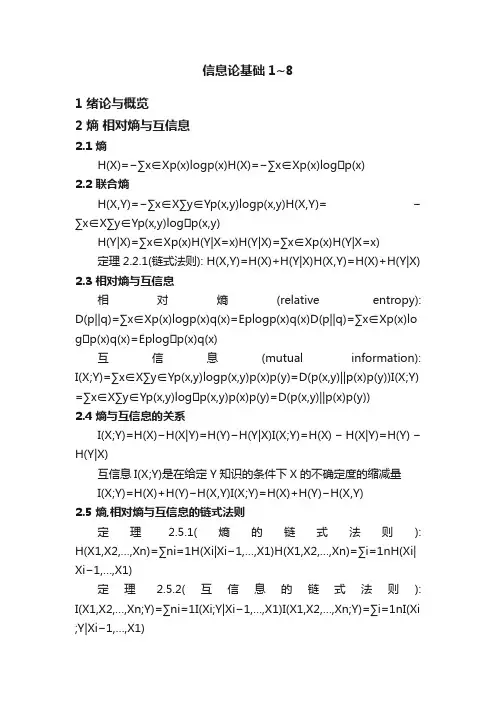

信息论基础1~81 绪论与概览2 熵相对熵与互信息2.1 熵H(X)=−∑x∈X p(x)logp(x)H(X)=−∑x∈Xp(x)logp(x)2.2 联合熵H(X,Y)=−∑x∈X∑y∈Y p(x,y)logp(x,y)H(X,Y)=−∑x∈X∑y∈Yp(x,y)logp(x,y)H(Y|X)=∑x∈X p(x)H(Y|X=x)H(Y|X)=∑x∈Xp(x)H(Y|X=x)定理2.2.1(链式法则): H(X,Y)=H(X)+H(Y|X)H(X,Y)=H(X)+H(Y|X) 2.3 相对熵与互信息相对熵(relative entropy): D(p||q)=∑x∈X p(x)logp(x)q(x)=Eplogp(x)q(x)D(p||q)=∑x∈Xp(x)lo gp(x)q(x)=Eplogp(x)q(x)互信息(mutual information): I(X;Y)=∑x∈X∑y∈Y p(x,y)logp(x,y)p(x)p(y)=D(p(x,y)||p(x)p(y))I(X;Y) =∑x∈X∑y∈Yp(x,y)logp(x,y)p(x)p(y)=D(p(x,y)||p(x)p(y))2.4 熵与互信息的关系I(X;Y)=H(X)−H(X|Y)=H(Y)−H(Y|X)I(X;Y)=H(X)−H(X|Y)=H(Y)−H(Y|X)互信息I(X;Y)是在给定Y知识的条件下X的不确定度的缩减量I(X;Y)=H(X)+H(Y)−H(X,Y)I(X;Y)=H(X)+H(Y)−H(X,Y)2.5 熵,相对熵与互信息的链式法则定理 2.5.1(熵的链式法则): H(X1,X2,...,X n)=∑ni=1H(Xi|X i−1,...,X1)H(X1,X2,...,Xn)=∑i=1nH(Xi| Xi−1, (X1)定理 2.5.2(互信息的链式法则): I(X1,X2,...,X n;Y)=∑ni=1I(Xi;Y|X i−1,...,X1)I(X1,X2,...,Xn;Y)=∑i=1nI(Xi ;Y|Xi−1, (X1)条件相对熵: D(p(y|x)||q(y|x))=∑x p(x)∑yp(y|x)logp(y|x)q(y|x)=Ep(x,y)logp(Y|X)q( Y|X)D(p(y|x)||q(y|x))=∑xp(x)∑yp(y|x)logp(y|x)q(y|x)=Ep(x,y)logp (Y|X)q(Y|X)定理 2.5.3(相对熵的链式法则): D(p(x,y)||q(x,y))=D(p(x)||q(x))+D(p(y|x)||q(y|x))D(p(x,y)||q(x,y))=D( p(x)||q(x))+D(p(y|x)||q(y|x))2.6 Jensen不等式及其结果定理2.6.2(Jensen不等式): 若给定凸函数f和一个随机变量X,则Ef(X)≥f(EX)Ef(X)≥f(EX)定理2.6.3(信息不等式): D(p||q)≥0D(p||q)≥0推论(互信息的非负性): I(X;Y)≥0I(X;Y)≥0定理2.6.4: H(X)≤log|X|H(X)≤log|X|定理2.6.5(条件作用使熵减小): H(X|Y)≤H(X)H(X|Y)≤H(X)从直观上讲,此定理说明知道另一随机变量Y的信息只会降低X的不确定度. 注意这仅对平均意义成立. 具体来说, H(X|Y=y)H(X|Y=y) 可能比H(X)H(X)大或者小,或者两者相等.定理 2.6.6(熵的独立界): H(X1,X2,…,X n)≤∑ni=1H(Xi)H(X1,X2,…,Xn)≤∑i=1nH(Xi)2.7 对数和不等式及其应用定理 2.7.1(对数和不等式): ∑ni=1ailogaibi≥(∑ni=1ai)log∑ni=1ai∑ni=1bi∑i=1nailogaibi≥(∑i =1nai)log∑i=1nai∑i=1nbi定理2.7.2(相对熵的凸性): D(p||q)D(p||q) 关于对(p,q)是凸的定理2.7.3(熵的凹性): H(p)是关于p的凹函数2.8 数据处理不等式2.9 充分统计量这节很有意思,利用统计量代替原有抽样,并且不损失信息.2.10 费诺不等式定理2.10.1(费诺不等式): 对任何满足X→Y→X^,X→Y→X^, 设Pe=Pr{X≠X^},Pe=Pr{X≠X^}, 有H(Pe)+Pe log|X|≥H(X|X^)≥H(X|Y)H(Pe)+Pelog|X|≥H(X|X^)≥H(X|Y)上述不等式可以减弱为1+Pe log|X|≥H(X|Y)1+Pelog|X|≥H(X|Y)或Pe≥H(X|Y)−1log|X|Pe≥H(X|Y)−1log|X|引理 2.10.1: 如果X和X’独立同分布,具有熵H(X),则Pr(X=X′)≥2−H(X)Pr(X=X′)≥2−H(X)3 渐进均分性4 随机过程的熵率4.1 马尔科夫链4.2 熵率4.3 例子:加权图上随机游动的熵率4.4 热力学第二定律4.5 马尔科夫链的函数H(Yn|Y n−1,…,Y1,X1)≤H(Y)≤H(Y n|Y n−1,…,Y1)H(Yn|Yn−1,…,Y1,X1)≤H(Y)≤H(Yn|Yn−1,…,Y1)5 数据压缩5.1 有关编码的几个例子5.2 Kraft不等式定理5.2.1(Kraft不等式): 对于D元字母表上的即时码,码字长度l1,l2,…,l m l1,l2,…,lm必定满足不等式∑iD−li≤1∑iD−li≤15.3 最优码l∗i=−log Dpili∗=−logDpi5.4 最优码长的界5.5 唯一可译码的Kraft不等式5.6 赫夫曼码5.7 有关赫夫曼码的评论5.8 赫夫曼码的最优性5.9 Shannon-Fano-Elias编码5.10 香农码的竞争最优性5.11由均匀硬币投掷生成离散分布6 博弈与数据压缩6.1 赛马6.2 博弈与边信息6.3 相依的赛马及其熵率6.4 英文的熵6.5 数据压缩与博弈6.6 英语的熵的博弈估计7 信道容量离散信道: C=maxp(x)I(X;Y)C=maxp(x)I(X;Y)7.1 信道容量的几个例子7.2 对称信道如果信道转移矩阵p(y|x)p(y|x) 的任何两行相互置换,任何两列也相互置换,那么称该信道是对称的.7.3 信道容量的性质7.4 信道编码定理预览7.5 定义7.6 联合典型序列7.7 信道编码定理7.8 零误差码7.9 费诺不等式与编码定理的逆定理7.10 信道编码定理的逆定理中的等式7.11 汉明码7.12 反馈容量7.13 信源信道分离定理8 微分熵8.1 定义h(X)=−∫Sf(x)logf(x)dxh(X)=−∫Sf(x)logf(x)dx均匀分布 h(X)=logah(X)=loga正态分布h(X)=1/2log2πeδ2h(X)=1/2log2πeδ2 8.2 连续随机变量的AEP8.3 微分熵与离散熵的关系8.4 联合微分熵与条件微分熵8.5 相对熵与互信息8.6 微分熵, 相对熵以及互信息的性质。

信息论基础教程(一)

信息论基础教程

一、引言

1.什么是信息论?

2.由来和应用领域

二、信息的定义

1.信息的测量单位

2.信息的数学表示

三、信息的熵

1.熵的概念

2.熵的计算公式

3.熵的性质

四、信息的压缩与编码

1.无损压缩与编码

2.哈夫曼编码

3.香农编码

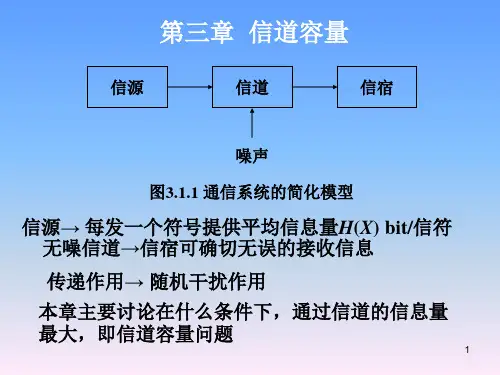

五、信道容量

1.信道模型

2.信道容量的计算

3.极限定理

六、误差检测和纠正

1.奇偶校验

2.海明码

七、信息论在通信领域的应用

1.数据压缩

2.信道编码

3.无线传输

八、信息论的未来发展

1.量子信息论

2.生物信息学

以上是详细的信息论基础教程大纲,通过Markdown格式的标题副标题形式来展现。

文章采用列点的方式生成,遵守规则的前提下准确

描述了信息论的基础知识,包括信息的定义和测量、熵的概念和计算、

信息的压缩与编码、信道容量、误差检测和纠正等内容。

同时,还介绍了信息论在通信领域的应用以及未来的发展方向。

信息论基础教程信息论基础教程1. 什么是信息论•信息论是一门研究信息传输与处理的数学理论。

•信息论的概念由克劳德·香农于1948年提出。

2. 信息的定义与表示•信息是用来消除不确定性的东西。

•信息可以用概率来表示。

信息的定义•定义:信息是用来消除不确定性的核心内容。

•信息量的多少与不确定性的减少程度成正比。

信息的表示•使用比特(bit)作为计量单位。

•一个比特可以表示一个二进制信息(0或1)。

•信息量的大小与比特数目成正比。

•信息熵是衡量信息量的概念。

•能量守恒定律:信息熵不会减少,只会增加。

信息熵的计算公式•信息熵的计算公式为:H(X) = -Σp(x)log2p(x),其中p(x)为事件x发生的概率。

信息熵的含义•信息熵越大,信息量越多,不确定性越高。

•信息熵越小,信息量越少,不确定性越低。

4. 信道容量•信道容量是信息传输的极限。

•信道容量的计算需要考虑信道的带宽和信噪比。

信道容量的计算公式•信道容量的计算公式为:C = Blog2(1 + SNR),其中B为信道带宽,SNR为信噪比。

信道容量的含义•信道容量表示一个信道能够传输的最大信息量。

•信噪比越高,信道容量越大。

•香农定理是信息论的核心定理。

•香农定理给出了可靠传输信息的极限。

香农定理的表达式•香农定理的表达式为:C = Blog2(1 + SNR)。

香农定理的应用•香农定理可以用来优化通信系统的设计。

•香农定理可以用来判断信息传输的可靠性。

以上为信息论基础教程的概要,希望对你的学习有所帮助。

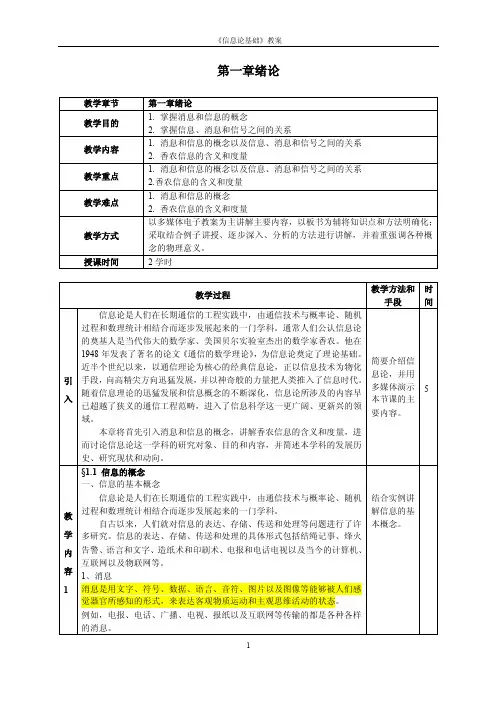

信息论基础教程课程设计一、课程目标本课程旨在通过讲解信息论的基础概念,让学生掌握信息的传输、存储和处理的原理和方法,为学生打下信息科学的基础。

二、教学内容1.信息的基本概念和符号表示2.信源及其特性3.信道及其分类4.信源编码5.信道编码6.信息不等式7.奇异性定理8.香农信道容量定理三、教学方法本课程采用多种教学方法,包括讲授、演示、讨论和实践操作等。

1.讲授:讲述信息论基础概念、信源、信道、编码等知识点,以及它们之间的关系。

2.演示:通过实验演示信源和信道,帮助学生深入理解信息论概念和方法。

3.讨论:引导学生在课堂上进行讨论,交流彼此的理解和经验。

4.实践操作:通过编写代码实现信息源编码、信道编码等实践操作,加深学生对知识点的理解。

四、教学评价1.考勤和平时作业:出勤率占30%,平时作业占10%。

2.期末考试:占60%。

3.评价标准:根据出勤率、平时作业和考试成绩,综合评估学生对信息论基础知识的掌握程度。

五、参考教材1.Cover T, Thomas J, Elements of information theory.Wiley inter-science, 1991.2.王峰. 信息论基础 [M]. 清华大学出版社, 2004.六、教学日程课时内容1 信息论基本概念2 信源及其特性3 信道及其分类4 信源编码5 信道编码6 信息不等式课时内容7 奇异性定理8 香农信道容量定理9 实践操作——信息源编码10 实践操作——信道编码11 复习12 期末考试七、教学效果预期1.学生通过本课程学习,能够掌握信息论基本概念,理解信源、信道、编码等概念之间的关系。

2.学生能够熟练运用信息源编码和信道编码方法,实现基本的信息处理功能。

3.学生能够使用信息不等式、奇异性定理等方法分析信息的传输、存储和处理效率,更好地理解信息论的应用。

4.期望学生在期末考试中取得良好的成绩,为进一步学习信息科学和技术打下坚实基础。

信息论基础教程李亦农李梅编著北京邮电大学出版社・北京・内容简介信息论是研究信息传输和信息处理过程中的一般规律的一门学科,也是现代信息通信领域的一门基础理论。

本书以香农的3个编码定理为中心,重点讲述了相关的基本概念、基本原理和基本方法。

本书是作者根据多年教学经验编著而成的。

鉴于目前学生可选择的课程越来越多,每门课的学时数不会很大,因此本书只讲述经典香农信息论的内容,而没有涉及过多分支。

图书在版编目(CIP)数据信息论基础教程/李亦农,李梅编著.—北京:北京邮电大学出版社,2004ISBN7-5635-0910-0Ⅰ.信...Ⅱ.①李...②李...Ⅲ.信息论—高等学校—教材Ⅳ.G201中国版本图书馆CIP数据核字(2004)第060781号书名:信息论基础教程编著:李亦农李梅责任编辑:李欣一出版者:北京邮电大学出版社(北京市海淀区西土城路10号)邮编:100876电话:622821**********电子信箱:publish@经销:各地新华书店印刷:北京市忠信诚胶印厂印数:1—5000册开本:787mm×1092mm1/16印张:14.75字数:321千字版次:2005年1月第1版2005年1月第1次印刷2006年2月第2次印刷ISBN7-5635-0910-0/T N・331定价:22.00元・如有印装质量问题,请与北京邮电大学出版社发行部联系・前言信息论是研究信息传输和信息处理过程中一般规律的一门学科,也是现代信息科学和通信科学领域的一门基础理论,因此目前各高等院校相关专业的本科生、研究生都开有信息论这门专业基础课。

本书是作者参考借鉴了众多国内外优秀的信息论教材及参考书之后根据多年教学实践的经验编著而成的。

鉴于目前学生可选择的课程越来越多,而每门课的学时数较少,因此本书只讲述了经典香农信息论的内容,而没有涉及过多的分支。

本书可作为通信、电子、计算机专业本科生教材使用,也可作为相关专业科研人员的参考书。