python爬虫设置代理ip池_图文教程

- 格式:doc

- 大小:320.50 KB

- 文档页数:8

Python网络爬虫的反爬虫机制与绕过方法在互联网时代,信息的快速获取对于各行各业都具有重要意义。

Python作为一种强大且灵活的编程语言,被广泛应用于网络爬虫的开发领域。

然而,随着网站所有者对于大规模数据爬取的限制加强,爬虫面临越来越多的反爬虫机制。

本文将介绍Python网络爬虫常见的反爬虫机制以及相应的绕过方法。

一、IP限制为了限制爬虫对网站的频繁请求,许多网站采用IP限制措施。

通过监测访问IP的频率、访问时间间隔等方式,网站可以判断某个IP是否为爬虫,并对其进行限制。

为了绕过IP限制,可以采取以下方法:1. 使用代理IP:通过使用代理服务器进行访问,可以隐藏真实的IP 地址,从而规避IP限制。

Python中有许多开源库可以帮助我们实现代理IP的使用,如requests、urllib等。

2. 随机切换IP:通过频繁切换IP地址,使得爬虫的访问模式更像是正常用户的行为。

可以使用IP池等技术来实现IP的随机切换。

二、User-Agent限制除了IP限制外,许多网站还会通过User-Agent来判断请求是否为爬虫。

User-Agent是一个HTTP请求头字段,用于标识请求的用户代理软件。

为了绕过User-Agent限制,可以采取以下方法:1. 伪装User-Agent:在进行网络请求时,将User-Agent设置为浏览器的User-Agent,使得请求看起来像是由浏览器发起的。

可以使用Python中的库,如faker等,来生成各种浏览器的User-Agent。

2. 随机切换User-Agent:通过定期更换User-Agent,使得爬虫请求的User-Agent不断变化,从而降低被识别为爬虫的概率。

三、验证码许多网站为了防止爬虫爬取敏感信息,会在登录或重要操作时添加验证码。

验证码是为了识别当前请求是否为人类操作的一种手段。

对于爬虫来说,识别和绕过验证码是一项较为困难的任务。

以下是一些绕过验证码的方法:1. 使用打码平台:可以借助第三方的打码平台,通过将验证码图片上传给平台进行识别,然后获取识别结果,并提交给目标网站。

selenium设置proxy、...本⽂介绍了selenium设置proxy、headers的⽅法,把phantomjs、Chrome、Firefox⼏个浏览器的设置⽅法都总结⼀下,分享给⼤家,也给⾃⼰留个笔记phantomjs设置ip⽅法1:service_args = ['--proxy=%s' % ip_html, # 代理 IP:prot (eg:192.168.0.28:808)'--proxy-type=http', # 代理类型:http/https‘--load-images=no', # 关闭图⽚加载(可选)'--disk-cache=yes', # 开启缓存(可选)'--ignore-ssl-errors=true' # 忽略https错误(可选)]driver = webdriver.PhantomJS(service_args=service_args)⽅法2:browser=webdriver.PhantomJS(PATH_PHANTOMJS)# 利⽤DesiredCapabilities(代理设置)参数值,重新打开⼀个sessionId,我看意思就相当于浏览器清空缓存后,加上代理重新访问⼀次urlproxy=webdriver.Proxy()proxy.proxy_type=ProxyType.MANUALproxy.http_proxy='1.9.171.51:800'# 将代理设置添加到webdriver.DesiredCapabilities.PHANTOMJS中proxy.add_to_capabilities(webdriver.DesiredCapabilities.PHANTOMJS)browser.start_session(webdriver.DesiredCapabilities.PHANTOMJS)browser.get('/ic.asp')print('1: ',browser.session_id)print('2: ',browser.page_source)print('3: ',browser.get_cookies())还原为系统代理# 还原为系统代理proxy=webdriver.Proxy()proxy.proxy_type=ProxyType.DIRECTproxy.add_to_capabilities(webdriver.DesiredCapabilities.PHANTOMJS)browser.start_session(webdriver.DesiredCapabilities.PHANTOMJS)browser.get('/ic.asp')设置请求头⽅法2import random,requests,jsonfrom selenium import webdriverfrom mon.desired_capabilities import DesiredCapabilitiesfrom mon.proxy import ProxyType#随机获取⼀个ipdef proxies():r = requests.get("http://120.26.166.214:9840/JProxy/update/proxy/scoreproxy")rr = json.loads(r.text)hh = rr['ip'] + ":" + "8907"print(hh)return hhips =proxies()#设置phantomjs请求头和代理⽅法⼀:#-------------------------------------------------------------------------------------# 设置代理service_args = ['--proxy=%s' % ips, # 代理 IP:prot (eg:192.168.0.28:808)'--ssl-protocol=any', #忽略ssl协议'--load - images = no', # 关闭图⽚加载(可选)'--disk-cache=yes', # 开启缓存(可选)'--ignore-ssl-errors=true' # 忽略https错误(可选)]#设置请求头user_agent = ("Mozilla/5.0 (Macintosh; Intel Mac OS X 10_8_4) " +"AppleWebKit/537.36 (KHTML, like Gecko) Chrome/29.0.1547.57 Safari/537.36")dcap = dict(DesiredCapabilities.PHANTOMJS)dcap["erAgent"] = user_agentdriver = webdriver.PhantomJS(executable_path=r"C:\soft\phantomjs-2.1.1-windows\bin\phantomjs.exe",desired_capabilities=dcap,service_args=service_args)driver.get(url='')page=driver.page_sourceprint(page)#设置phantomjs请求头和代理⽅法⼆:#-------------------------------------------------------------------------------------desired_capabilities = DesiredCapabilities.PHANTOMJS.copy()# 从USER_AGENTS列表中随机选⼀个浏览器头,伪装浏览器desired_capabilities["erAgent"] = (random.choice('请求头池'))# 不载⼊图⽚,爬页⾯速度会快很多desired_capabilities["phantomjs.page.settings.loadImages"] = False# 利⽤DesiredCapabilities(代理设置)参数值,重新打开⼀个sessionId,我看意思就相当于浏览器清空缓存后,加上代理重新访问⼀次url proxy = webdriver.Proxy()proxy.proxy_type = ProxyType.MANUALproxy.http_proxy = random.choice('ip池')proxy.add_to_capabilities(desired_capabilities)phantomjs_driver = r'C:\phantomjs-2.1.1-windows\bin\phantomjs.exe'# 打开带配置信息的phantomJS浏览器driver = webdriver.PhantomJS(executable_path=phantomjs_driver,desired_capabilities=desired_capabilities)driver.start_session(desired_capabilities)driver.get(url='')page=driver.page_sourceprint(page)# 隐式等待5秒,可以⾃⼰调节driver.implicitly_wait(5)# 设置10秒页⾯超时返回,类似于requests.get()的timeout选项,driver.get()没有timeout选项# 以前遇到过driver.get(url)⼀直不返回,但也不报错的问题,这时程序会卡住,设置超时选项能解决这个问题。

Python爬虫实战教学第一章:爬虫基础知识Python爬虫是一种自动爬取网站信息的技术,可以用来获取大量数据。

在进行Python爬虫实战前,我们首先需要了解一些基础知识。

1.1 爬虫的原理爬虫的原理是通过发送HTTP请求到目标网站,然后解析网页获取所需的信息。

可以使用Python的第三方库,如Requests库来发送HTTP请求,并使用正则表达式或者解析库(如BeautifulSoup、XPath等)来解析网页。

1.2 HTTP请求与响应在Python中,我们可以使用Requests库发送HTTP请求,并获取响应内容。

可以设置请求头、请求体、代理IP等信息,以模拟浏览器的行为。

1.3 网页解析网页解析是爬虫的核心部分,常用的解析方法有正则表达式、BeautifulSoup、XPath等。

使用这些方法可以从网页中提取出所需的信息。

这些解析方法各有特点,根据不同的场景选择合适的方法。

第二章:爬虫实战准备在进行爬虫实战之前,我们需要做一些准备工作。

2.1 安装Python和相关库首先,我们需要安装Python,并安装相关的第三方库,如Requests、BeautifulSoup等。

可以使用pip命令来安装这些库。

2.2 确定爬取目标在进行爬虫实战之前,我们需要明确我们要爬取的目标,确定目标网站的URL和需要提取的信息。

2.3 分析网页在确定目标网站后,我们需要分析网页的结构,找出目标信息所在的位置、标签等。

可以使用浏览器的开发者工具来分析网页。

第三章:实战案例一——爬取天气信息3.1 网页分析首先,我们需要分析天气网站的网页结构,找出所需的天气信息所在的位置。

可以使用浏览器的开发者工具来分析。

3.2 发送HTTP请求使用Requests库发送HTTP请求到天气网站,并获取响应内容。

3.3 解析网页使用解析库(如BeautifulSoup)来解析网页,提取出所需的天气信息。

3.4 数据处理与存储对提取出的天气信息进行数据处理(如去除空白字符、转换格式等),并将数据保存到本地文件或者数据库。

Python异步爬⾍requests和aiohttp中代理IP的使⽤爬⾍要想爬的好,IP代理少不了。

现在⽹站基本都有些反爬措施,访问速度稍微快点,就会发现IP被封,不然就是提交验证。

下⾯就两种常⽤的模块来讲⼀下代理IP的使⽤⽅式。

话不多说,直接开始。

requests中代理IP的使⽤:requests中使⽤代理IP只需要添加⼀个proxies参数即可。

proxies的参数值是⼀个字典,key是代理协议(http/https),value就是ip和端⼝号,具体格式如下。

try:response = requests.get('https:///ip', headers=headers,proxies={'https':'https://221.122.91.74:9401'}, timeout=6)print('success')# 检测代理IP是否使⽤成功# 第⼀种⽅式,返回发送请求的IP地址,使⽤时要在 get() 添加 stream = True# print(response.raw._connection.sock.getpeername()[0])# 第⼆种⽅式,直接返回测试⽹站的响应数据的内容print(response.text)except Exception as e:print('error',e)注意:peoxies的key值(http/https)要和url⼀致,不然会直接使⽤本机IP直接访问。

aiohttp中代理IP的使⽤:由于requests模块不⽀持异步,迫不得已使⽤aiohttp,掉了不少坑。

它的使⽤⽅式和requests相似,也是在get()⽅法中添加⼀个参数,但此时的参数名为proxy,参数值是字符串,且字符串中的代理协议,只⽀持http,写成https会报错。

这⾥记录⼀下我的纠错历程。

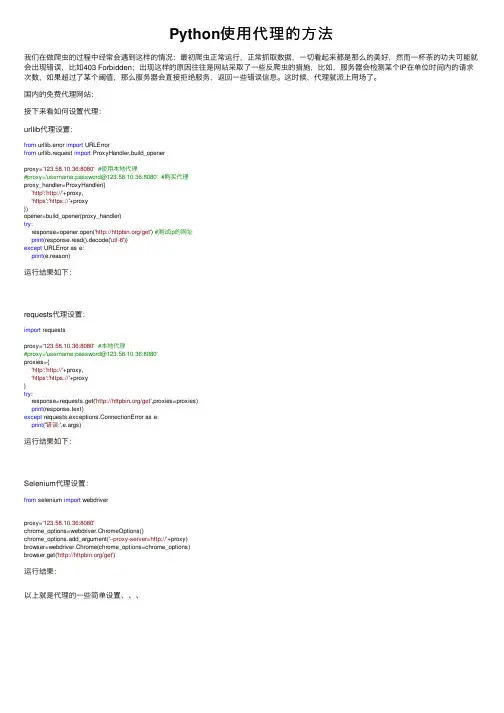

Python使⽤代理的⽅法我们在做爬⾍的过程中经常会遇到这样的情况:最初爬⾍正常运⾏,正常抓取数据,⼀切看起来都是那么的美好,然⽽⼀杯茶的功夫可能就会出现错误,⽐如403 Forbidden;出现这样的原因往往是⽹站采取了⼀些反爬⾍的措施,⽐如,服务器会检测某个IP在单位时间内的请求次数,如果超过了某个阈值,那么服务器会直接拒绝服务,返回⼀些错误信息。

这时候,代理就派上⽤场了。

国内的免费代理⽹站:接下来看如何设置代理:urllib代理设置:from urllib.error import URLErrorfrom urllib.request import ProxyHandler,build_openerproxy='123.58.10.36:8080'#使⽤本地代理#proxy='username:password@123.58.10.36:8080' #购买代理proxy_handler=ProxyHandler({'http':'http://'+proxy,'https':'https://'+proxy})opener=build_opener(proxy_handler)try:response=opener.open('/get') #测试ip的⽹址print(response.read().decode('utf-8'))except URLError as e:print(e.reason)运⾏结果如下:requests代理设置:import requestsproxy='123.58.10.36:8080'#本地代理#proxy='username:password@123.58.10.36:8080'proxies={'http':'http://'+proxy,'https':'https://'+proxy}try:response=requests.get('/get',proxies=proxies)print(response.text)except requests.exceptions.ConnectionError as e:print('错误:',e.args)运⾏结果如下:Selenium代理设置:from selenium import webdriverproxy='123.58.10.36:8080'chrome_options=webdriver.ChromeOptions()chrome_options.add_argument('--proxy-server=http://'+proxy)browser=webdriver.Chrome(chrome_options=chrome_options)browser.get('/get')运⾏结果:以上就是代理的⼀些简单设置、、、。

Python网络爬虫实践教程一、什么是网络爬虫网络爬虫,也称为网络蜘蛛或网络机器人,是一种自动获取互联网信息的程序工具。

通过模拟浏览器行为,爬虫程序可以访问网页、提取网页中的数据,在大规模数据采集、搜索引擎、数据分析等领域发挥着重要作用。

二、网络爬虫的基本原理网络爬虫的基本原理是通过发送HTTP请求,并解析响应得到的HTML文档来获取网页数据。

首先,我们需要使用Python中的requests库发送网络请求,并获得服务器的响应。

然后,通过解析HTML文档,提取出我们需要的数据。

三、准备工作在开始编写网络爬虫之前,我们需要安装Python以及相关的库。

首先,需要安装Python解释器和pip包管理工具。

然后,使用pip安装requests、beautifulsoup和lxml等库。

四、发送HTTP请求在编写爬虫程序之前,我们需要了解如何使用Python发送HTTP请求。

使用requests库发送GET请求非常简单,只需要调用get方法,并提供目标网址即可。

如果需要发送POST请求,同样使用post方法,并在参数中传递需要提交的数据。

五、解析HTML文档解析HTML文档是爬虫中非常重要的一步。

Python提供了多种解析HTML的库,其中比较常用的是beautifulsoup和lxml。

通过指定解析器,我们可以轻松地提取出HTML文档中的各个元素,并进行进一步的处理。

六、处理反爬机制为了阻止爬虫程序的访问,许多网站采取了反爬机制,例如设置验证码、限制IP访问频率等。

对于这些反爬措施,我们可以通过使用代理IP、设置请求头信息、使用验证码识别技术等方法来绕过。

七、数据存储与分析在爬虫过程中,我们通常需要将获取的数据进行存储和分析。

常用的数据存储方式包括将数据保存到数据库、文本文件、Excel 表格或者CSV文件中。

而要对数据进行分析,可以使用Python中的数据分析库,如pandas、numpy等。

八、实践案例:爬取豆瓣电影数据为了更好地理解网络爬虫的实践过程,我们以爬取豆瓣电影数据为例进行讲解。

python爬虫proxy代理的使用方法Python爬虫:Proxy代理的使用方法Introduction(引言)在进行网络爬虫开发时,常常会遇到一些访问限制,比如IP封禁,频率限制等。

为了绕过这些限制,我们需要使用代理服务器(Proxy Server)来隐藏我们的真实IP地址,从而实现匿名访问和规避限制。

在本文中,我们将介绍如何使用Python爬虫来使用Proxy代理。

1. 什么是Proxy代理?Proxy代理服务器是一种充当客户端与目标服务器之间的中间服务器,将客户端的请求转发给目标服务器,并将响应返回给客户端。

通过使用代理服务器,我们可以间接访问目标服务器,隐藏我们的真实IP地址,并绕过一些访问限制。

2. Proxy代理的类型Proxy代理可以分为以下几种类型:- HTTP Proxy:代理服务器接收HTTP请求,并转发给目标服务器。

- HTTPS Proxy:代理服务器接收HTTPS请求,并转发给目标服务器。

- SOCKS Proxy:一种网络传输协议,它可以将TCP/IP数据包转发到任何位置,并且不承认任何与协议无关的内容。

在爬虫开发中,我们常常会使用HTTP Proxy来实现代理功能。

3. 获取Proxy代理在使用Proxy代理之前,我们需要获取可用的代理服务器地址。

有很多在线提供免费代理服务器地址的网站,比如"下面是一个简单的示例,展示如何从"pythonimport requestsfrom bs4 import BeautifulSoupdef get_proxies():url = "response = requests.get(url)soup = BeautifulSoup(response.text, "html.parser")table = soup.find("table", attrs={"id": "proxylisttable"})rows = table.tbody.find_all("tr")proxies = []for row in rows:columns = row.find_all("td")ip = columns[0].textport = columns[1].textproxy = f"{ip}:{port}"proxies.append(proxy)return proxies4. 使用Proxy代理进行爬虫获取到可用的代理服务器地址后,我们可以使用Python的requests库来实现Proxy代理功能。

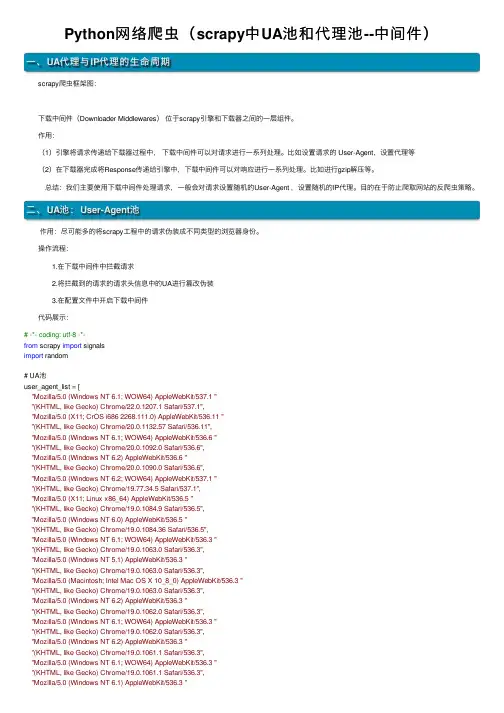

Python⽹络爬⾍(scrapy中UA池和代理池--中间件)⼀、UA代理与IP代理的⽣命周期 scrapy爬⾍框架图: 下载中间件(Downloader Middlewares)位于scrapy引擎和下载器之间的⼀层组件。

作⽤:(1)引擎将请求传递给下载器过程中,下载中间件可以对请求进⾏⼀系列处理。

⽐如设置请求的 User-Agent,设置代理等(2)在下载器完成将Response传递给引擎中,下载中间件可以对响应进⾏⼀系列处理。

⽐如进⾏gzip解压等。

总结:我们主要使⽤下载中间件处理请求,⼀般会对请求设置随机的User-Agent ,设置随机的IP代理。

⽬的在于防⽌爬取⽹站的反爬⾍策略。

⼆、UA池:User-Agent池 作⽤:尽可能多的将scrapy⼯程中的请求伪装成不同类型的浏览器⾝份。

操作流程: 1.在下载中间件中拦截请求 2.将拦截到的请求的请求头信息中的UA进⾏篡改伪装 3.在配置⽂件中开启下载中间件 代码展⽰:# -*- coding: utf-8 -*-from scrapy import signalsimport random# UA池user_agent_list = ["Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.1 ""(KHTML, like Gecko) Chrome/22.0.1207.1 Safari/537.1","Mozilla/5.0 (X11; CrOS i686 2268.111.0) AppleWebKit/536.11 ""(KHTML, like Gecko) Chrome/20.0.1132.57 Safari/536.11","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.6 ""(KHTML, like Gecko) Chrome/20.0.1092.0 Safari/536.6","Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.6 ""(KHTML, like Gecko) Chrome/20.0.1090.0 Safari/536.6","Mozilla/5.0 (Windows NT 6.2; WOW64) AppleWebKit/537.1 ""(KHTML, like Gecko) Chrome/19.77.34.5 Safari/537.1","Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/536.5 ""(KHTML, like Gecko) Chrome/19.0.1084.9 Safari/536.5","Mozilla/5.0 (Windows NT 6.0) AppleWebKit/536.5 ""(KHTML, like Gecko) Chrome/19.0.1084.36 Safari/536.5","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1063.0 Safari/536.3","Mozilla/5.0 (Windows NT 5.1) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1063.0 Safari/536.3","Mozilla/5.0 (Macintosh; Intel Mac OS X 10_8_0) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1063.0 Safari/536.3","Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1062.0 Safari/536.3","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1062.0 Safari/536.3","Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1061.1 Safari/536.3","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1061.1 Safari/536.3","Mozilla/5.0 (Windows NT 6.1) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1061.1 Safari/536.3","Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1061.0 Safari/536.3","Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/535.24 ""(KHTML, like Gecko) Chrome/19.0.1055.1 Safari/535.24","Mozilla/5.0 (Windows NT 6.2; WOW64) AppleWebKit/535.24 ""(KHTML, like Gecko) Chrome/19.0.1055.1 Safari/535.24"]class ImgpilelineproDownloaderMiddleware(object):# 拦截正常的请求def process_request(self, request, spider):# UA伪装request.headers['User-Agent'] = random.choice(user_agent_list)return None# 拦截响应def process_response(self, request, response, spider):return response# 拦截发⽣异常的请求对象def process_exception(self, request, exception, spider):return request # 重新发送请求三、IP代理池 作⽤:尽可能多的将scrapy⼯程中的请求的IP设置成不同的。

selenium+python设置爬⾍代理IP的⽅法1. 背景在使⽤selenium浏览器渲染技术,爬取⽹站信息时,⼀般来说,速度是很慢的。

⽽且⼀般需要⽤到这种技术爬取的⽹站,反爬技术都⽐较厉害,对IP的访问频率应该有相当的限制。

所以,如果想提升selenium抓取数据的速度,可以从两个⽅⾯出发:第⼀,提⾼抓取频率,出现验证信息时进⾏破解,⼀般是验证码或者⽤户登录。

第⼆,使⽤多线程 + 代理IP,这种⽅式,需要电脑有⾜够的内存和充⾜稳定的代理IP 。

2. 为chrome设置代理IPfrom selenium import webdriverchromeOptions = webdriver.ChromeOptions()# 设置代理chromeOptions.add_argument("--proxy-server=http://202.20.16.82:10152")# ⼀定要注意,=两边不能有空格,不能是这样--proxy-server = http://202.20.16.82:10152browser = webdriver.Chrome(chrome_options = chromeOptions)# 查看本机ip,查看代理是否起作⽤browser.get("/ip")print(browser.page_source)# 退出,清除浏览器缓存browser.quit()注意事项:第⼀,代理IP最好是稳定的固定IP,不要选动态IP。

我们常⽤的爬⾍IP是⾼匿名动态IP,是通过拨号动态产⽣的,时效性很短,⼀般在1~3分钟。

对于scrapy这种并发度很⾼,⼜不需要登录的爬⾍来说,⾮常合适,但是在浏览器渲染类爬⾍中并不适⽤。

第⼆,代理IP的速度。

因为selenium爬⾍采⽤的是浏览器渲染技术,本⾝速度就很慢。

如果选择的代理IP速度较慢,就会⼤⼤增加爬取的时间。

Python网络爬虫中的Charles技巧随着互联网技术的飞速发展,网络爬虫作为一种自动化数据采集工具,被越来越广泛地应用于各个领域,如商业竞争情报收集、搜索引擎优化、舆情监测等。

而Charles作为一款流量调试工具,其在网络爬虫中的应用也逐渐受到了重视。

Charles是一款跨平台、功能强大的代理服务器,其可以让用户在计算机与互联网之间进行数据的拦截和修改。

在网络爬虫中,利用Charles可以帮助用户更好地进行数据截取和分析,从而提高爬取效率和精度。

以下是Python网络爬虫中利用Charles进行数据拦截和分析的一些技巧。

一、配置Charles代理服务器在使用Charles进行网络爬虫数据拦截和分析之前,首先需要在本地配置Charles代理服务器。

打开Charles软件,点击菜单栏的“Proxy”选项,选择“Proxy Settings”。

在弹出的“Proxy Settings”窗口中,可以配置代理服务器端口号和SSL代理设置等信息。

其中,代理服务器端口号需要与Python爬虫中requests模块的代理端口号一致。

二、截取请求和响应数据在使用Python爬虫进行数据采集时,常常需要先发送请求获取相应的数据。

此时,可以通过Charles来截取请求数据和响应数据,从而更好地了解数据请求和响应的过程。

首先,需要在Charles的菜单栏中选择“Proxy”选项,然后选择“Recording Settings”。

在弹出的窗口中,可以选择要记录的请求和响应,以及存储记录的文件夹路径等信息。

在这里可以选择要记录的文件类型,例如html、css、js、json等。

当选择好要记录的文件类型后,点击“OK”完成设置。

此时,当Python爬虫发送请求时,Charles就会记录请求和响应的过程。

三、修改请求数据和响应数据当我们需要修改Python爬虫发送的请求数据或者修改服务器返回的响应数据时,可以通过Charles来实现。

Python网络爬虫中的IP代理与UserAgent设置网络爬虫是一种自动化程序,能够模拟人类用户的行为,访问网页并抓取其中的数据。

然而,在实际应用中,使用爬虫不可避免地会遭遇一些限制和阻碍。

为了解决这些问题,我们可以使用IP代理和UserAgent设置。

一、IP代理的作用和原理IP代理是一种通过中间服务商的代理服务器进行访问的方法。

在使用爬虫时,通过修改请求的IP地址,我们可以绕过网站的访问限制,保护自己的真实IP地址。

为了设置IP代理,我们首先需要找到可用的代理IP地址。

有很多第三方网站提供免费的代理IP列表,我们可以在这些网站上获取代理IP地址和端口号。

然后,我们需要使用Python的requests库来设置代理。

下面是一个设置IP代理的示例代码:```pythonimport requestsproxy = {'http': 'http://ip:port','https': 'https://ip:port'response = requests.get(url, proxies=proxy)```在上述代码中,我们需要将`ip:port`替换成真实的代理IP地址和端口号。

通过将`proxy`参数传递给`requests.get()`方法,我们就可以通过代理服务器发送请求并获取到响应。

二、UserAgent设置的作用和原理UserAgent是HTTP协议中的一个头部字段,用于标识客户端(通常是浏览器)的身份信息。

有些网站会根据UserAgent的不同来限制或者允许访问。

在实际爬取网页时,有些网站会检查UserAgent字段,如果发现是爬虫的UserAgent,那么就拒绝该请求。

为了解决这个问题,我们可以设置一个正常浏览器的UserAgent来模拟真实用户的访问。

下面是一个设置UserAgent的示例代码:```pythonimport requestsheaders = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'response = requests.get(url, headers=headers)```在上述代码中,我们需要将`User-Agent`字段的值替换成真实浏览器的UserAgent字符串。

Python是一种功能强大的编程语言,其灵活性和易用性使其成为许多开发者的首选。

在网络爬虫和数据抓取等应用程序中,使用代理是一种常见的方法,可以通过代理服务器向目标全球信息站发出请求,隐藏真实IP位置区域,从而防止被封禁和提高访问速度。

在Python中,有多种方法可以实现代理功能。

本文将介绍Python中常见的代理写法及其用法。

1. 使用urllib库实现代理在Python中,urllib库是一个常用的HTTP请求库,可以用来发送HTTP请求和处理HTTP响应。

使用urllib库实现代理的方法如下:```pythonimport urllib.requestproxy_handler = urllib.request.ProxyHandler({'网络协议': 'xxx '网络协议s': 'xxx})opener = urllib.request.build_opener(proxy_handler)urllib.request.install_opener(opener)response = urllib.request.urlopen('xxxprint(response.read())```在上面的代码中,首先创建一个ProxyHandler对象,该对象接受一个字典类型的参数,参数中包含代理服务器的IP位置区域、端口号和认证信息。

然后使用build_opener方法创建一个Opener对象,并使用install_opener方法将Opener对象设置为全局默认的Opener,这样在后续的HTTP请求中都会使用这个Opener对象来发送请求。

最后使用urlopen方法发送HTTP请求,即可实现代理功能。

2. 使用requests库实现代理除了urllib库,Python中还有一个常用的HTTP请求库叫做requests,它提供了更加便捷和高级的HTTP请求和响应处理功能。

Python爬⾍爬取新浪微博内容⽰例【基于代理IP】本⽂实例讲述了Python爬⾍爬取新浪微博内容。

分享给⼤家供⼤家参考,具体如下:⼀般做爬⾍爬取⽹站,⾸选的都是m站,其次是wap站,最后考虑PC站。

当然,这不是绝对的,有的时候PC站的信息最全,⽽你⼜恰好需要全部的信息,那么PC站是你的⾸选。

⼀般m站都以m开头后接域名,所以本⽂开搞的⽹址就是 。

前期准备1.代理IP2.抓包分析通过抓包获取微博内容地址,这⾥不再细说,不明⽩的⼩伙伴可以⾃⾏百度查找相关资料,下⾯直接上完整的代码完整代码:# -*- coding: utf-8 -*-import urllib.requestimport json#定义要爬取的微博⼤V的微博IDid='1259110474'#设置代理IPproxy_addr="122.241.72.191:808"#定义页⾯打开函数def use_proxy(url,proxy_addr):req=urllib.request.Request(url)req.add_header("User-Agent","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0")proxy=urllib.request.ProxyHandler({'http':proxy_addr})opener=urllib.request.build_opener(proxy,urllib.request.HTTPHandler)urllib.request.install_opener(opener)data=urllib.request.urlopen(req).read().decode('utf-8','ignore')return data#获取微博主页的containerid,爬取微博内容时需要此iddef get_containerid(url):data=use_proxy(url,proxy_addr)content=json.loads(data).get('data')for data in content.get('tabsInfo').get('tabs'):if(data.get('tab_type')=='weibo'):containerid=data.get('containerid')return containerid#获取微博⼤V账号的⽤户基本信息,如:微博昵称、微博地址、微博头像、关注⼈数、粉丝数、性别、等级等def get_userInfo(id):url='https:///api/container/getIndex?type=uid&value='+iddata=use_proxy(url,proxy_addr)content=json.loads(data).get('data')profile_image_url=content.get('userInfo').get('profile_image_url')description=content.get('userInfo').get('description')profile_url=content.get('userInfo').get('profile_url')verified=content.get('userInfo').get('verified')guanzhu=content.get('userInfo').get('follow_count')name=content.get('userInfo').get('screen_name')fensi=content.get('userInfo').get('followers_count')gender=content.get('userInfo').get('gender')urank=content.get('userInfo').get('urank')print("微博昵称:"+name+"\n"+"微博主页地址:"+profile_url+"\n"+"微博头像地址:"+profile_image_url+"\n"+"是否认证:"+str(verified)+"\n"+"微博说明:"+description+"\n"+"关注⼈数:"+str(guanzhu)+"\n"+"粉丝数:"+str(fensi)+"\n"+"性别:"+gender+"\n"+"微#获取微博内容信息,并保存到⽂本中,内容包括:每条微博的内容、微博详情页⾯地址、点赞数、评论数、转发数等def get_weibo(id,file):i=1while True:url='https:///api/container/getIndex?type=uid&value='+idweibo_url='https:///api/container/getIndex?type=uid&value='+id+'&containerid='+get_containerid(url)+'&page='+str(i)try:data=use_proxy(weibo_url,proxy_addr)content=json.loads(data).get('data')cards=content.get('cards')if(len(cards)>0):for j in range(len(cards)):print("-----正在爬取第"+str(i)+"页,第"+str(j)+"条微博------")card_type=cards[j].get('card_type')if(card_type==9):mblog=cards[j].get('mblog')attitudes_count=mblog.get('attitudes_count')comments_count=mblog.get('comments_count')created_at=mblog.get('created_at')reposts_count=mblog.get('reposts_count')scheme=cards[j].get('scheme')text=mblog.get('text')with open(file,'a',encoding='utf-8') as fh:fh.write("----第"+str(i)+"页,第"+str(j)+"条微博----"+"\n")fh.write("微博地址:"+str(scheme)+"\n"+"发布时间:"+str(created_at)+"\n"+"微博内容:"+text+"\n"+"点赞数:"+str(attitudes_count)+"\n"+"评论数:"+str(comments_count)+"\n"+"转发数:"+str(reposts_count)+"\n")i+=1else:breakexcept Exception as e:print(e)passif __name__=="__main__":file=id+".txt"get_userInfo(id)get_weibo(id,file)爬取结果更多关于Python相关内容可查看本站专题:《》、《》、《》、《》、《》、《》及《》希望本⽂所述对⼤家Python程序设计有所帮助。

Python网络爬虫的常见问题与解决方法Python网络爬虫是一种强大的工具,用于从互联网上获取数据。

然而,在实践中,我们可能会遇到一些常见的问题。

本文将介绍几个常见的问题,并提供相应的解决方法。

一、网站反爬虫机制许多网站为了保护自己的数据,会设置反爬虫机制,以阻止爬虫程序的访问。

常见的反爬虫机制包括IP封锁、User-Agent检测和验证码验证等。

要解决这些问题,可以采取以下方法:1. 使用代理IP:通过使用代理IP来隐藏真实的请求IP,防止被封锁。

2. 修改User-Agent:通过修改请求头中的User-Agent,使其模拟常见的浏览器请求。

3. 解析验证码:对于需要验证码验证的网站,可以使用OCR技术或者借助第三方工具解析验证码。

二、动态网页的数据获取动态网页是指通过JavaScript等技术生成内容的网页。

传统的爬虫程序往往无法获取动态生成的数据。

要解决这个问题,可以采取以下方法:1. 使用Selenium:Selenium是一种自动化测试工具,可以模拟浏览器行为,并获取动态生成的数据。

2. 分析Ajax请求:使用开发者工具分析网页的Ajax请求,直接请求这些接口获取数据。

3. 使用第三方API:有些网站提供API接口,可以直接请求这些接口获取需要的数据。

三、网站结构变动许多网站的页面结构会不断变化,导致爬虫程序无法正确解析网页。

要解决这个问题,可以采取以下方法:1. 使用正则表达式:通过编写适应性强的正则表达式来解析网页,以适应不同结构的变动。

2. 使用XPath或CSS选择器:XPath和CSS选择器是一种解析HTML的语言,可以精确地选择所需的元素。

3. 使用BeautifulSoup库:BeautifulSoup是一个Python库,可以方便地解析HTML和XML文档。

四、数据存储和管理获取到的数据需要进行存储和管理,以便后续分析和使用。

要解决这个问题,可以采取以下方法:1. 使用数据库:将数据存储到数据库中,以便进行查询和管理。

如何避免被网站封禁的Python爬虫技巧随着互联网的发展,网络数据的获取变得越来越重要。

Python作为一种常用的编程语言,被广泛应用于网络数据爬取。

然而,随之而来的一个问题是,许多网站为了保护自己的数据和服务器,会对爬虫进行限制,甚至封禁爬虫ip地址。

本文将介绍一些避免被网站封禁的Python爬虫技巧,帮助你利用Python编写更有效、更稳定的爬虫程序。

一、编写合理的爬虫程序1. 遵守网站的爬虫规则在开始爬取一个网站之前,应该先了解该网站的爬虫规则,例如robots.txt文件中的规定。

遵守网站的规则,不访问不允许爬取的页面,不发送过于频繁的请求,可以降低被封禁的风险。

2. 设置合理的请求头模拟浏览器的行为是一个常见的爬虫技巧。

通过设置合理的用户代理(User-Agent),可以让爬虫程序看起来更像一个正常的浏览器请求,减少被封禁的可能性。

3. 控制访问频率连续发送过多的请求会引起网站的注意,并可能触发封禁机制。

为了避免这种情况,可以在代码中设置合适的时间间隔,控制请求的频率。

可以使用time模块来实现此功能。

二、使用代理服务器1. 使用公开的代理服务器使用公开的代理服务器可以隐藏你的真实ip地址,降低被封禁的风险。

可以通过一些代理服务器提供商或者代理IP网站获取免费的代理IP地址,然后在爬虫程序中使用代理IP进行爬取。

2. 购买私人代理对于一些重要的项目或者需要长期稳定运行的爬虫程序,可以考虑购买私人代理。

相比免费的公开代理,私人代理通常更稳定、更安全。

购买私人代理的好处是可以获得唯一的IP地址,减少被封禁的风险。

三、使用验证码识别技术一些网站为了防止机器人访问,会设置验证码。

对于这类情况,可以使用验证码识别技术,自动解决验证码,继续进行爬取。

常见的验证码识别技术包括图像处理、深度学习等。

四、IP地址轮换通过轮换不同的IP地址,可以绕过网站的封禁机制。

可以使用代理服务器或者VPN来实现IP地址的轮换。

python爬虫设置代理ip池_图文教程

前言

随着大数据时代的到来,爬虫已经成了获取数据的必不可少的方式,做过爬虫的想必都深有体会,爬取的时候莫名其妙IP 就被网站封掉了,毕竟各大网站也不想自己的数据被轻易地爬走。

对于爬虫来说,为了解决封禁IP 的问题,一个有效的方式就是使用代理,使用代理之后可以让爬虫伪装自己的真实IP,如果使用大量的随机的代理进行爬取,那么网站就不知道是我们的爬虫一直在爬取了,这样就有效地解决了反爬的问题。

那么问题来了,使用什么代理好呢?这里指的代理一般是HTTP 代理,主要用于数据爬取。

现在打开搜索引擎一搜HTTP 代理,免费的、付费的太多太多品牌,我们该如何选择呢?看完这一篇文章,想必你心中就有了答案。

对于免费代理,其实想都不用想了,可用率能超过10% 就已经是谢天谢地了。

真正靠谱的代理还是需要花钱买的,那这么多家到底哪家可用率高?哪家响应速度快?哪家比较稳定?哪家性价比比较高?为此,我对市面上比较流行的多家付费代理针对可用率、爬取速度、爬取稳定性、价格、安全性、请求限制等做了详细的评测,让我们来一起看一下到底哪家更强!

测评目标:618IP代理。

选择这家做为评测对象

本次测评主要分析代理的可用率、响应速度、稳定性、价格、安全性、使用频率等因素,下面我们来一一进行说明。

可用率

可用率就是提取的这些代理中可以正常使用的比率。

假如我们无法使用这个代理请求某个网站或者访问超时,那么就代表这个代理不可用,在这里我的测试样本大小为500,即提取500 个代理,看看里面可用的比率多少。

响应速度

响应速度可以用耗费时间来衡量,即计算使用这个代理请求网站一直到得到响应所耗费的时间。

时间越短,证明代理的响应速度越快,这里同样是500 个样本,计算时只对正常可用的代理做统计,计算耗费时间的平均值。

稳定性

由于爬虫时我们需要使用大量代理,如果一个代理响应速度特别快,很快就能得到响应,而下一次请求使用的代理响应速度特别慢,等了三十秒才得到响应,那势必会影响爬取效率,所以我们需要看下商家提供的这些代理稳定性怎样,总不能这一个特别快,下一个又慢的不行。

所以这里我们需要统计一下耗费时间的方差,方差越大,证明稳定性越差。

价格

价格,这个当然是需要考虑的内容,如果一个代理不论是响应速度还是稳定性都特别不错,但是价格非常非常高,这也是不可接受的。

安全性

这的确也是需要考虑的因素,比如一旦不小心把代理提取的API 泄露出去了,别人就肆意使用我们的API 提取代理使用,而一直耗费的是我们的套餐。

另外一旦别人通过某些手段获取了我们的代理列表,而这些代理是没有安全验证的,这也会导致别人偷偷使用我们的代理。

在生产环境上,这方面尤其需要注意。

使用频率

有些代理套餐在API 调用提取代理时有频率限制,有的代理套餐则会限制请求频率,这些因素都会或多或少影响爬虫的效率,这部分因素我们也需要考虑进来。

测评标准

要做标准的测评,那就必须在标准的测评环境下进行,且尽可能排除一些杂项的干扰,如网络波动、传输延迟等一系列的影响。

主机选取

由于我的个人笔记本是使用WiFi 上网的,所以可能会有网络波动,而且实际带宽其实并不太好把控,因此它并不适合来做标准评测使用。

评测需要在一个网络稳定的条件下进行,而且多个代理的评测环境必须相同,在此我选择了一台腾讯云主机作为测试,主机配置如下:

这样我们就可以保证一个标准统一的测试环境了。

现取现测

另外在评测时还需要遵循一个原则,那就是现取现测,即取一个测一个。

现在很多付费代理网站都提供了API 接口,我们可以一次性提取多个代理,但是这样会导致一个问题,每个代理在提取出来的时候,商家是会尽量保证它的可用性的,但过一段时间,这个代理可能就不好用了,所以假如我们一次性提取出来了100 个代理,但是这100 个代理并没有同时参与测试,后面的代理就会经历一个的等待期,过一段时间再测这些代理的话,肯定会影响后半部分代理的有效性,所以这里我们将提取的数量统一设置成1,即请求一次接口获取一个代理,然后立即进行测试,这样可以保证测试的公平性,排除了不同代理有效期的干扰。

时间计算

由于我们有一项是测试代理的响应速度,所以我们需要计算程序请求之前和得到响应之后的时间差,这里我们使用的测试Python 库是requests,所以我们就计算发起请求和得到响应之间的时间差即可,时间计算方法如下所示:

这里used_time 就是使用代理请求的耗时,这样测试的就仅仅是发起请求到得到响应的时间。

测试链接

测试时我们也需要使用一个稳定的且没有反爬虫的链接,这样可以排除服务器的干扰,这里我们使用百度来作为测试目标。

超时限制

在测试时免不了的会遇到代理请求超时的问题,所以这里我们也需要统一一个超时时间,这里设置为60 秒,如果使用代理请求百度,60 秒还没有得到响应,那就视为该代理无效。

测试数量

要做测评,那么样本不能太小,如只有十几次测试是不能轻易下结论的,这里我选取了一个适中的测评数量500,即每个套餐获取500 个代理进行测试。

测评过程

嗯,测评过程这边主要说一下测评的代码逻辑,首先测的时候是取一个测一个的,所以这里定义了一个test_proxy() 方法:

这里需要传入一个参数proxy,代表一个代理,即IP 加端口组成的代理,然后这里使用了requests 的proxies 参数传递给get() 方法。

对于代理无效的检测,这里判断了ProxyError, ConnectTimeout, SSLError, ReadTimeout, ConnectionError 这几种异常,如果发生了这些异常统统视为代理无效,返回错误。

如果在timeout 60 秒内得到了响应,那么就计算其耗费时间并返回。

在主程序里,就是获取API 然后统计结果了,代码如下:

这里加了一些判断,如is_proxy() 方法判断了获取的是不是符合有效的代理规则,即判断它是不是IP 加端口的形式,这样可以排除API 返回一些错误信息的干扰。

另外这里设置了total_count 和valid_count 变量,只有符合代理规则的代理参与了测试,这样才算一次有效测试,total_count 加一,如果测试可用,那么valid_count 加一并记录耗费时间。

最后调用了stats_results 方法进行了统计:

这里使用了Numpy 来统计了耗费时间的均值和方差,分别反映代理的响应速度和稳定性。

嗯,就这样,利用这个方法我对各个不同的代理套餐逐一进行了测试。

最好结果:

通过可用率响应速度稳定性价格安全性统计,我们可以发现这个是非常不错的,推荐指数100%,不许你买到不好的东西。