语义分割评价指标 代码

- 格式:docx

- 大小:3.26 KB

- 文档页数:2

语义分割评价指标代码

语义分割是计算机视觉领域的重要任务,用于将图像中的每个像素分配到特定的语义类别中。

评价语义分割模型的指标通常包括像素精度、平均精度、交并比等。

下面我将从不同角度对这些指标进行解释。

像素精度(Pixel Accuracy)是指语义分割模型正确分类的像素数量占总像素数量的比例。

其计算公式为,像素精度 = (正确分类的像素数) / (总像素数)。

这个指标简单直观,但不能很好地反映类别不平衡的情况。

平均精度(Mean Accuracy)是指每个类别预测正确的像素占该类别总像素的比例的平均值。

其计算公式为,平均精度= Σ(类别正确分类的像素数 / 类别总像素数) / 类别数。

这个指标考虑了类别不平衡的情况,能更全面地评价模型性能。

交并比(Intersection over Union,IoU)是指预测结果与真实标签的交集与并集之比,用于衡量模型对目标的定位能力。

其计算公式为,IoU = (预测结果与真实标签的交集) / (预测结果与真实标签的并集)。

IoU范围在0到1之间,值越大表示模型定位能力

越好。

以上是常用的语义分割评价指标,当然还有其他指标,如Dice 系数、F1分数等。

关于代码部分,评价指标的计算通常可以使用Python的深度学习框架(如TensorFlow、PyTorch)提供的函数进行计算,也可以自行编写相应的函数进行计算。

具体的代码实现可以根据具体的深度学习框架和任务需求进行调整和编写。

希望以上内容能够满足你的需求。

cityscape语义分割结果可视化代码当进行城市景观语义分割时,可以使用可视化代码来展示分割结果。

以下是一个简单的示例代码,用于可视化语义分割结果:```pythonimport matplotlib.pyplot as pltimport numpy as np# 加载语义分割结果图segmentation_map = plt.imread('segmentation_map.png')# 显示原始图像plt.subplot(2, 1, 1)plt.imshow(segmentation_map)plt.title('Semantic Segmentation Result')plt.axis('off')# 显示颜色映射plt.subplot(2, 1, 2)color_map = plt.imshow(np.arange(256), cmap='viridis')plt.colorbar(color_map)plt.title('Color Map')plt.axis('off')# 显示结果plt.show()```在上述代码中,我们首先加载了语义分割结果图像`segmentation_map.png`。

然后,使用`plt.imshow`函数显示原始图像和颜色映射。

在第二个子图中,我们使用`np.arange(256)`创建一个一维数组,表示颜色映射的颜色值范围。

然后,使用`plt.imshow`函数将颜色映射显示为一个图像,并使用`plt.colorbar`函数添加颜色条。

最后,使用`plt.show`函数显示结果图像。

请确保将`'segmentation_map.png'`替换为实际的语义分割结果图像文件路径。

根据实际情况,你可能需要调整代码以适应你的图像和数据。

这只是一个简单的示例,你可以根据需要进行进一步的定制和美化可视化结果。

语义分割评价指标代码

语义分割是计算机视觉领域中一项重要的任务,其目标是将图像中的每个像素进行分类,从而实现对图像的精细分割。

为了评价语义分割算法的性能,需要使用一些指标来衡量其准确性和效果。

常用的语义分割评价指标包括准确率、召回率、F1值、IoU(交并比)等。

下面将对这些指标进行简要介绍。

准确率是指语义分割结果中被正确分类的像素所占的比例。

它可以衡量算法对图像的整体分类准确性。

准确率越高,表示算法的分类结果越准确。

召回率是指语义分割结果中被正确分类的像素占所有真实标签中被分类为正类的像素的比例。

召回率可以衡量算法对正类像素的识别能力。

召回率越高,表示算法对正类像素的识别能力越强。

F1值是准确率和召回率的调和平均值,可以综合评价算法的分类准确性和正类像素识别能力。

F1值越高,表示算法的整体性能越好。

IoU是指语义分割结果与真实标签的交集与并集之比。

它可以衡量算法对像素级别的分割效果。

IoU越高,表示算法的分割效果越好。

除了以上指标,还可以使用各类别的准确率、召回率、F1值和IoU 来评价算法在不同类别上的表现。

这些指标可以提供更详细的分类性能信息。

语义分割的评价指标包括准确率、召回率、F1值和IoU。

通过这些指标的综合考量,可以评估算法的性能优劣,从而指导算法的改进和优化。

这些指标的合理使用和解读对于推动语义分割算法的发展具有重要意义。

一、介绍Deeplabv2是一个经典的语义分割模型,它能够准确地将图像中的不同物体进行像素级别的分割。

该模型结合了深度卷积神经网络和空洞卷积的优势,具有较高的分割精度和较快的处理速度。

本文将介绍使用deeplabv2实现语义分割的相关代码。

二、项目准备1. 硬件环境在进行deeplabv2语义分割代码实现前,首先需要准备好硬件环境。

推荐使用具备较大显存的GPU,例如NVIDIA的Tesla V100或者RTX 2080Ti。

2. 软件环境为了成功运行deeplabv2的代码,需要安装好以下软件环境:- Python 3.6+- TensorFlow 1.13+- Numpy、PIL等常用的Python库3. 数据集语义分割需要大量的标注数据集来进行模型训练。

可以选择PASCAL VOC、ADE20k等公开的语义分割数据集,也可以根据自己的需求进行数据集的标注和准备。

三、模型训练1. 数据准备使用deeplabv2进行语义分割,需要准备好训练数据和标注数据。

可以使用已有的数据集,也可以根据自己的需求进行数据的准备和标注。

2. 网络模型在训练语义分割模型时,可以选择使用已经训练好的deeplabv2模型作为基础网络,也可以根据自己的需求进行网络结构的修改和调整。

3. 损失函数和优化器在模型训练时,需要选择合适的损失函数来衡量模型预测结果与真实标注之间的差距,常用的损失函数包括交叉熵损失、Dice损失等。

还需要选择合适的优化器来调整模型参数,常用的优化器包括Adam、SGD等。

4. 训练过程在准备好数据集、网络模型、损失函数和优化器后,就可以开始进行模型的训练。

可以选择在本地环境进行训练,也可以选择在云端进行训练。

在训练过程中需要关注模型的损失值和精度,并根据训练结果来进行模型和参数的调整。

四、模型测试在完成模型训练后,可以进行模型的测试和评估。

可以使用已有的测试数据集进行测试,也可以使用自己的数据集来测试。

swin transformer 语义分割代码下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by the editor. I hope that after you download them, they can help you solve practical problems. The document can be customized and modified after downloading, please adjust and use it according to actual needs, thank you!In addition, our shop provides you with various types of practical materials, suchas educational essays, diary appreciation, sentence excerpts, ancient poems, classic articles, topic composition, work summary, word parsing, copy excerpts, other materials and so on, want to know different data formats and writing methods, please pay attention!标题:Swin Transformer在语义分割任务中的应用与优势随着深度学习技术的不断发展,语义分割作为计算机视觉领域中的重要任务之一,受到了越来越多研究者的关注。

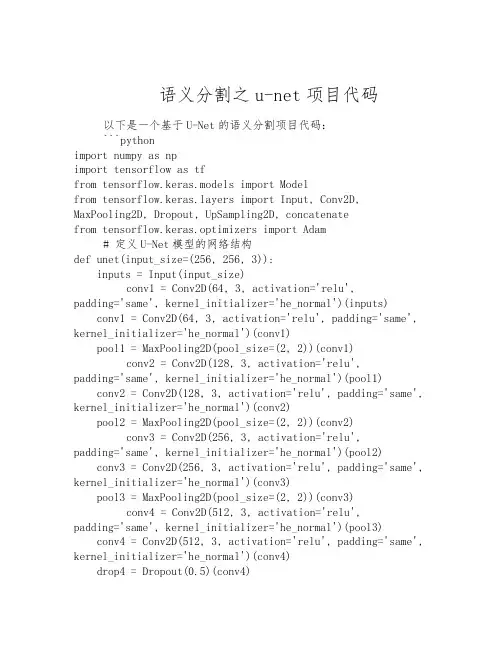

语义分割之u-net项目代码以下是一个基于U-Net的语义分割项目代码:```pythonimport numpy as npimport tensorflow as tffrom tensorflow.keras.models import Modelfrom yers import Input, Conv2D, MaxPooling2D, Dropout, UpSampling2D, concatenatefrom tensorflow.keras.optimizers import Adam# 定义U-Net模型的网络结构def unet(input_size=(256, 256, 3)):inputs = Input(input_size)conv1 = Conv2D(64, 3, activation='relu',padding='same', kernel_initializer='he_normal')(inputs)conv1 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv1)pool1 = MaxPooling2D(pool_size=(2, 2))(conv1)conv2 = Conv2D(128, 3, activation='relu',padding='same', kernel_initializer='he_normal')(pool1)conv2 = Conv2D(128, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv2)pool2 = MaxPooling2D(pool_size=(2, 2))(conv2)conv3 = Conv2D(256, 3, activation='relu',padding='same', kernel_initializer='he_normal')(pool2)conv3 = Conv2D(256, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv3)pool3 = MaxPooling2D(pool_size=(2, 2))(conv3)conv4 = Conv2D(512, 3, activation='relu',padding='same', kernel_initializer='he_normal')(pool3)conv4 = Conv2D(512, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv4)drop4 = Dropout(0.5)(conv4)pool4 = MaxPooling2D(pool_size=(2, 2))(drop4)conv5 = Conv2D(1024, 3, activation='relu',padding='same', kernel_initializer='he_normal')(pool4)conv5 = Conv2D(1024, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv5)drop5 = Dropout(0.5)(conv5)up6 = Conv2D(512, 2, activation='relu',padding='same',kernel_initializer='he_normal')(UpSampling2D(size=(2,2))(drop5))merge6 = concatenate([drop4, up6], axis=3)conv6 = Conv2D(512, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge6)conv6 = Conv2D(512, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv6)up7 = Conv2D(256, 2, activation='relu',padding='same',kernel_initializer='he_normal')(UpSampling2D(size=(2,2))(conv6))merge7 = concatenate([conv3, up7], axis=3)conv7 = Conv2D(256, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge7)conv7 = Conv2D(256, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv7)up8 = Conv2D(128, 2, activation='relu',padding='same',kernel_initializer='he_normal')(UpSampling2D(size=(2,2))(conv7))merge8 = concatenate([conv2, up8], axis=3)conv8 = Conv2D(128, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge8)conv8 = Conv2D(128, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv8)up9 = Conv2D(64, 2, activation='relu',padding='same',kernel_initializer='he_normal')(UpSampling2D(size=(2,2))(conv8))merge9 = concatenate([conv1, up9], axis=3)conv9 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge9)conv9 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv9)conv9 = Conv2D(2, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv9)conv10 = Conv2D(1, 1, activation='sigmoid')(conv9) model = Model(inputs=inputs, outputs=conv10)return model# 加载数据集def load_data():# 从文件或数据库加载图像和对应的标签# 数据预处理和划分训练集/验证集/测试集pass# 训练模型def train_model():# 加载数据集x_train, y_train, x_val, y_val = load_data()# 创建并编译U-Net模型model = unet()modelpile(optimizer=Adam(lr=1e-4),loss='binary_crossentropy', metrics=['accuracy'])# 训练模型model.fit(x_train, y_train, batch_size=16, epochs=10, validation_data=(x_val, y_val))# 保存模型model.save('unet_model.h5')# 测试模型def test_model():# 加载已训练的模型model = tf.keras.models.load_model('unet_model.h5')# 加载测试数据集x_test, y_test = load_test_data()# 对测试数据进行预测y_pred = model.predict(x_test)# 计算预测结果的准确率或其他评估指标accuracy = calculate_accuracy(y_test, y_pred)print("Accuracy: ", accuracy)# 项目入口函数if __name__ == '__main__':train_model()test_model()```上述代码包含了U-Net模型的网络结构定义(`unet`函数)以及训练和测试模型的代码逻辑(`train_model`和`test_model`函数)。

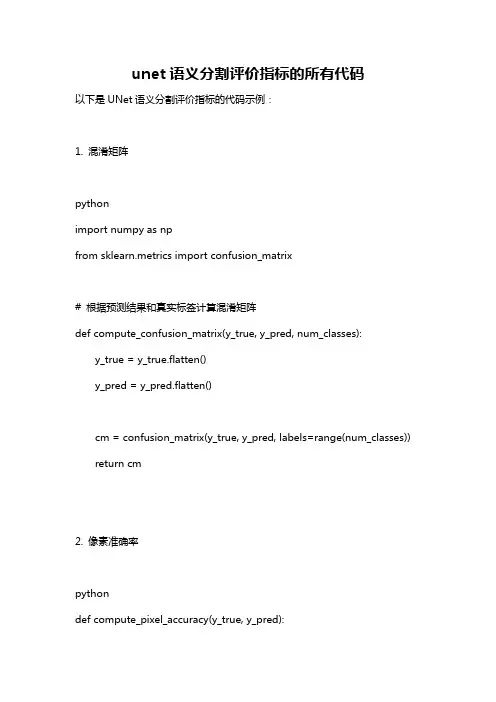

unet语义分割评价指标的所有代码以下是UNet语义分割评价指标的代码示例:1. 混淆矩阵pythonimport numpy as npfrom sklearn.metrics import confusion_matrix# 根据预测结果和真实标签计算混淆矩阵def compute_confusion_matrix(y_true, y_pred, num_classes): y_true = y_true.flatten()y_pred = y_pred.flatten()cm = confusion_matrix(y_true, y_pred, labels=range(num_classes)) return cm2. 像素准确率pythondef compute_pixel_accuracy(y_true, y_pred):y_true = y_true.flatten()y_pred = y_pred.flatten()total_pixels = len(y_true)correct_pixels = np.sum(y_true == y_pred)acc = correct_pixels / total_pixelsreturn acc3. 平均像素准确率(mPA)pythondef compute_mean_pixel_accuracy(cm): num_classes = cm.shape[0]# 计算每个类别的像素准确率class_accs = []for i in range(num_classes):tp = cm[i, i]fp = np.sum(cm[:, i]) - tpfn = np.sum(cm[i, :]) - tpif tp + fp + fn == 0:acc = 0.0else:acc = tp / (tp + fp + fn)class_accs.append(acc)# 计算总体像素准确率的平均值mean_acc = np.mean(class_accs)return mean_acc4. 平均交并比(mIoU)pythondef compute_mean_intersection_over_union(cm): num_classes = cm.shape[0]ious = []for i in range(num_classes):tp = cm[i, i]fp = np.sum(cm[:, i]) - tpfn = np.sum(cm[i, :]) - tpif tp + fp + fn == 0:iou = 0.0else:iou = tp / (tp + fp + fn) ious.append(iou)# 计算总体交并比的平均值mean_iou = np.mean(ious)return mean_iou使用示例:python# 加载模型和测试数据model = load_model()test_data = load_test_data()# 预测测试数据的标签y_pred = model.predict(test_data)# 加载测试数据的真实标签y_true = load_ground_truth()# 计算混淆矩阵cm = compute_confusion_matrix(y_true, y_pred, num_classes=10)# 计算评价指标acc = compute_pixel_accuracy(y_true, y_pred)mPA = compute_mean_pixel_accuracy(cm)mIoU = compute_mean_intersection_over_union(cm)。

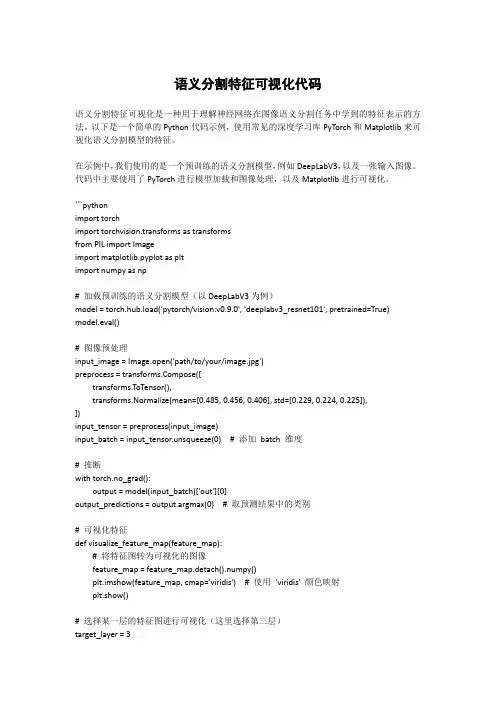

语义分割特征可视化代码语义分割特征可视化是一种用于理解神经网络在图像语义分割任务中学到的特征表示的方法。

以下是一个简单的Python代码示例,使用常见的深度学习库PyTorch和Matplotlib来可视化语义分割模型的特征。

在示例中,我们使用的是一个预训练的语义分割模型,例如DeepLabV3,以及一张输入图像。

代码中主要使用了PyTorch进行模型加载和图像处理,以及Matplotlib进行可视化。

```pythonimport torchimport torchvision.transforms as transformsfrom PIL import Imageimport matplotlib.pyplot as pltimport numpy as np# 加载预训练的语义分割模型(以DeepLabV3为例)model = torch.hub.load('pytorch/vision:v0.9.0', 'deeplabv3_resnet101', pretrained=True) model.eval()# 图像预处理input_image = Image.open('path/to/your/image.jpg')preprocess = pose([transforms.ToTensor(),transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),])input_tensor = preprocess(input_image)input_batch = input_tensor.unsqueeze(0) # 添加batch 维度# 推断with torch.no_grad():output = model(input_batch)['out'][0]output_predictions = output.argmax(0) # 取预测结果中的类别# 可视化特征def visualize_feature_map(feature_map):# 将特征图转为可视化的图像feature_map = feature_map.detach().numpy()plt.imshow(feature_map, cmap='viridis') # 使用'viridis' 颜色映射plt.show()# 选择某一层的特征图进行可视化(这里选择第三层)target_layer = 3selected_feature_map = output[target_layer]visualize_feature_map(selected_feature_map)```请注意,这只是一个简单的示例,实际可视化方法可能需要根据你使用的模型和框架进行调整。

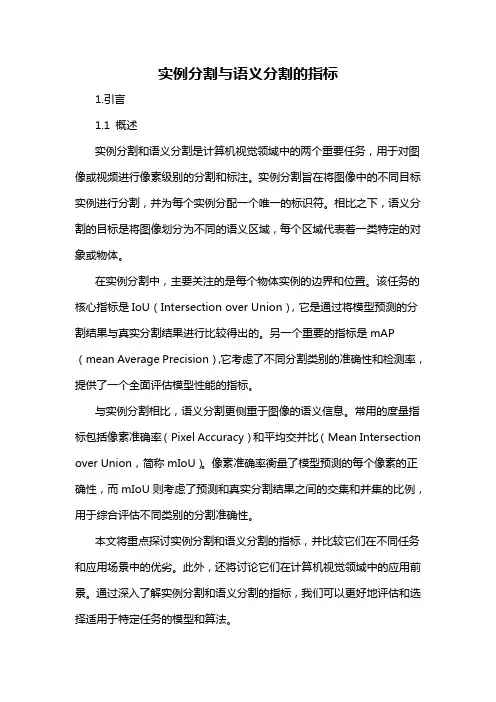

实例分割与语义分割的指标1.引言1.1 概述实例分割和语义分割是计算机视觉领域中的两个重要任务,用于对图像或视频进行像素级别的分割和标注。

实例分割旨在将图像中的不同目标实例进行分割,并为每个实例分配一个唯一的标识符。

相比之下,语义分割的目标是将图像划分为不同的语义区域,每个区域代表着一类特定的对象或物体。

在实例分割中,主要关注的是每个物体实例的边界和位置。

该任务的核心指标是IoU(Intersection over Union),它是通过将模型预测的分割结果与真实分割结果进行比较得出的。

另一个重要的指标是mAP (mean Average Precision),它考虑了不同分割类别的准确性和检测率,提供了一个全面评估模型性能的指标。

与实例分割相比,语义分割更侧重于图像的语义信息。

常用的度量指标包括像素准确率(Pixel Accuracy)和平均交并比(Mean Intersection over Union,简称mIoU)。

像素准确率衡量了模型预测的每个像素的正确性,而mIoU则考虑了预测和真实分割结果之间的交集和并集的比例,用于综合评估不同类别的分割准确性。

本文将重点探讨实例分割和语义分割的指标,并比较它们在不同任务和应用场景中的优劣。

此外,还将讨论它们在计算机视觉领域中的应用前景。

通过深入了解实例分割和语义分割的指标,我们可以更好地评估和选择适用于特定任务的模型和算法。

文章结构部分的内容可以按照以下方式编写:1.2 文章结构本文将从实例分割和语义分割两个方面对相关指标进行介绍和比较。

首先,我们将在引言部分概述实例分割和语义分割的基本概念和应用背景。

然后,在正文部分,我们将详细讨论实例分割和语义分割的指标。

在2.1节中,我们将介绍实例分割的指标。

具体来说,我们将详细解释IoU(Intersection over Union)指标的原理和计算方法,并介绍mAP (mean Average Precision)指标的含义和计算过程。

评价指标在数据分割和图像语义分割等领域中扮演着至关重要的角色。

acc、miou、dsc和voe是常用的评价指标,它们能够帮助我们全面地评估和比较不同模型在特定任务上的性能。

在本文中,我将深入探讨这些评价指标的含义、计算方法以及它们在实际应用中的意义。

1. ACC(Accuracy)准确率ACC是最简单直观的评价指标之一,它表示模型在所有像素中正确分类的比例。

计算公式为:ACC = (TP + TN) / (TP + TN + FP + FN),其中TP表示真正例,TN表示真负例,FP表示假正例,FN表示假负例。

ACC的取值范围在0到1之间,数值越大表示模型性能越好。

2. MIOU(Mean Intersection over Union)平均交并比MIOU是语义分割任务中常用的评价指标,它综合考虑了模型对每个类别的预测准确率。

计算公式为:MIOU = Σ (TPi / (TPi + FPi + FNi)) / N,其中TPi表示第i类的真正例,FPi表示第i类的假正例,FNi表示第i类的假负例,N表示类别数。

MIOU的取值范围也在0到1之间,数值越大表示模型对每个类别的识别性能越好。

3. DSC(Dice Coefficient)Dice系数DSC是对图像分割结果与真实标注之间重叠部分的相似度进行衡量的评价指标。

计算公式为:DSC = (2 * |A ∩ B|) / (|A| + |B|),其中A表示模型的预测结果,B表示真实标注。

DSC的取值范围也是在0到1之间,数值越大表示图像分割结果与真实标注的重叠程度越高。

4. VOE(Volume Overlap Error)体积重叠误差VOE是一种体积级别的评价指标,它主要用于3D图像分割任务。

VOE的计算公式为:VOE = 1 - (|A ∩ B|) / (|A ∪ B|),其中A表示模型的分割结果的体积,B表示真实标注的体积。

VOE的取值范围也是在0到1之间,数值越小表示模型的分割结果与真实标注的重叠程度越高。

Python语义分割是计算机视觉领域中一个重要的任务,它的目标是识别图像中不同区域的语义信息,并将它们标注出来。

在实际应用中,评价标准对于检验算法性能的好坏至关重要。

本文将针对Python语义分割中的各种评价标准进行详细介绍和分析。

一、准确率准确率(Accuracy)是评价语义分割算法性能的一项重要指标。

它衡量了算法输出的标注结果与真实标注的一致性程度。

在语义分割任务中,准确率通常被定义为正确标注的像素数量占总像素数量的比例。

Python中常用的计算准确率的方法包括混淆矩阵(Confusion Matrix)和交叉熵损失函数(Cross Entropy Loss)等。

二、IoUIoU(Intersection over Union)是另一个常用的评价标准。

它衡量了算法输出的目标区域与真实目标区域的重叠程度。

在语义分割任务中,IoU通常被定义为交集像素数量与并集像素数量的比值。

Python中常用的计算IoU的方法包括像素级别的比较和矩形框级别的比较等。

三、Dice系数Dice系数是评价语义分割算法性能的另一项重要指标。

它衡量了算法输出的标注结果和真实标注的相似度程度。

在语义分割任务中,Dice系数通常被定义为两个集合的交集大小与它们的平均大小的比值。

Python中常用的计算Dice系数的方法包括基于二值化图像的比较和基于像素级别的比较等。

四、F1值F1值是综合考量准确率和召回率的评价标准。

它衡量了算法输出的标注结果的精准度和完整度。

在语义分割任务中,F1值通常被定义为精确率和召回率的调和平均数。

Python中常用的计算F1值的方法包括基于混淆矩阵的计算和基于预测值和真实值的比较等。

五、mIoUmIoU(mean Intersection over Union)是对IoU的整体评价指标。

它衡量了算法在不同类别上的平均表现。

在语义分割任务中,mIoU通常被定义为对每个类别IoU的平均值。

Python中常用的计算mIoU 的方法包括像素级别的比较和类别级别的比较等。

分割评价指标rvd代码公式

RVD(Relative Volume Difference)是一种用于评价图像分割结果的指标,它可以帮助评估分割算法的性能。

RVD的计算公式如下所示:

RVD = (V_seg V_gt) / V_gt.

其中,V_seg表示分割后得到的目标体积,V_gt表示真实的目标体积。

RVD的值可以为正或负,表示分割结果相对于真实情况的体积差异。

如果RVD为0,则表示分割结果与真实情况相符合。

在计算RVD时,需要注意的是,分割结果和真实情况的体积单位要保持一致,通常情况下会使用像素或毫升作为单位。

RVD的值范围在负无穷到正无穷之间,因此在实际应用中,通常会对RVD进行归一化处理,以便更好地进行比较和评估不同算法的性能。

除了RVD之外,还有一些其他常用的评价指标,如Dice系数、Jaccard系数等,它们可以结合使用,从不同角度全面评价图像分

割算法的性能。

总的来说,RVD是一种重要的图像分割评价指标,通过比较分割结果和真实情况的体积差异,可以帮助我们更好地了解分割算法的准确性和稳定性。

语义分割iou指标代码

IOU(Intersection over Union)是一种常用的评估语义分割模型性能的指标。

它衡量了模型预测的分割结果与真实分割结果之间的重叠程度。

以下是一个简单的Python代码示例,用于计算语义分割模型的IOU指标:

python.

import numpy as np.

def calculate_iou(y_true, y_pred):

intersection = np.logical_and(y_true, y_pred)。

union = np.logical_or(y_true, y_pred)。

iou_score = np.sum(intersection) / np.sum(union)。

return iou_score.

在这个示例中,我们首先导入NumPy库,并定义了一个名为calculate_iou的函数,该函数接受两个参数y_true和y_pred,分别代表真实的分割结果和模型预测的分割结果。

我们使用NumPy的逻辑与和逻辑或操作来计算交集和并集,并将它们用于计算IOU分数。

在实际应用中,你需要将这段代码与你的语义分割模型结合起来,并根据你的数据格式和模型输出进行适当的调整。

另外,还需要考虑处理边界情况和处理数据的前处理和后处理等问题。

总之,IOU指标是评估语义分割模型性能的重要指标之一,通过计算预测结果与真实结果的重叠程度,可以帮助我们了解模型的准确性和鲁棒性。

希望这个简单的代码示例能够帮助你更好地理解和应用IOU指标。

语义分割指标,oa、iou、f1-score的参考文献

首先,我们拆分这句话来逐一解释。

1.语义分割指标:语义分割是计算机视觉领域的一个任务,它涉及到图像中

每个像素或区域对象的识别和分类。

对于语义分割的评价,有多个指标。

2.OA、IoU、F1-score:这些都是语义分割的评估指标。

o OA (Overall Accuracy):整体准确率,通常用于分类任务,表示正确分类的像素或区域占所有像素或区域的比例。

但在语义分割中,由于

每一个像素都可能有不同的类别,因此OA并不能很好地衡量分割的性

能。

o IoU (Intersection over Union):交并比,这是一个衡量分割效果的指标。

具体来说,它计算的是预测的分割区域与真实的分割区域之间

的交集与并集的比例。

IoU的值越高,表示预测越准确。

o F1-score:这是一个综合了精确度和召回率的指标,用于衡量分类或分割任务的性能。

F1-score越高,表示模型性能越好。

3.参考文献:指的是关于这些指标的研究或文献。

综上,"语义分割指标,oa、iou、f1-score的参考文献" 这句话询问的是关于语义分割评价指标OA、IoU和F1-score的相关研究或文献。

这些文献通常会详细解释这些指标的定义、计算方法和在语义分割中的重要性,以及如何使用它们来评估语义分割算法的性能。

【语义分割】评价指标总结及代码实现本⽂记录了语义分割准确性评价指标的总结以及代码实现对于像素级别的分类,最常⽤的评价指标是Pixel Accuracy(像素准确率)和Mean Inetersection over Union(平均交并⽐),⼆者的计算都是建⽴在混淆矩阵的基础上的。

因此⾸先来介绍⼀下混淆矩阵,之后分别介绍PA,MPA,MIoU,FWIoU,最后附上代码实现。

⾸先假定数据集中有n+1类(0~n),0通常表⽰背景。

使⽤Pii表⽰原本为i类同时预测为i类,即真正(TP)和真负(TN), Pij表⽰原本为i类被预测为j类,即假正(FP)和假负(FN),如果第i类为正类,i!=j时,那么Pii表⽰TP,Pjj表⽰TN,Pij表⽰FP,Pji表⽰FN。

像素准确率(PA)像素准确率是所有分类正确的像素数占像素总数的⽐例。

公式化如下:利⽤混淆矩阵计算则为(对⾓线元素之和除以矩阵所有元素之和)平均像素准确率(MPA) 平均像素准确率是分别计算每个类别分类正确的像素数占所有预测为该类别像素数的⽐例,即精确率,然后累加求平均。

公式化如下:利⽤混淆矩阵计算公式为(每⼀类的精确率Pi都等于对⾓线上的TP除以对应列的像素数)平均交并⽐(mloU) 平均交并⽐是对每⼀类预测的结果和真实值的交集与并集的⽐值求和平均的结果。

公式化如下 IoU利⽤混淆矩阵计算:解释如下: 如图所⽰,仅仅针对某⼀类来说,红⾊部分代表真实值,真实值有两部分组成TP,FN;黄⾊部分代表预测值,预测值有两部分组成TP,FP;⽩⾊部分代表TN(真负); 所以他们的交集就是TP+FP+FN,并集为TP频权交并⽐(FWloU) 频权交并⽐是根据每⼀类出现的频率设置权重,权重乘以每⼀类的IoU并进⾏求和。

公式化如下: 利⽤混淆矩阵计算:每个类别的真实数⽬为TP+FN,总数为TP+FP+TN+FN,其中每⼀类的权重和其IoU的乘积计算公式如下,在将所有类别的求和即可代码实现"""refer to https:///jfzhang95/pytorch-deeplab-xception/blob/master/utils/metrics.py"""import numpy as np__all__ = ['SegmentationMetric']"""confusionMetricP\L P NP TP FPN FN TN"""class SegmentationMetric(object):def __init__(self, numClass):self.numClass = numClassself.confusionMatrix = np.zeros((self.numClass,)*2)def pixelAccuracy(self):# return all class overall pixel accuracy# acc = (TP + TN) / (TP + TN + FP + TN)acc = np.diag(self.confusionMatrix).sum() / self.confusionMatrix.sum()return accdef classPixelAccuracy(self):# return each category pixel accuracy(A more accurate way to call it precision)# acc = (TP) / TP + FPclassAcc = np.diag(self.confusionMatrix) / self.confusionMatrix.sum(axis=1)return classAccdef meanPixelAccuracy(self):classAcc = self.classPixelAccuracy()meanAcc = np.nanmean(classAcc)return meanAccdef meanIntersectionOverUnion(self):# Intersection = TP Union = TP + FP + FN# IoU = TP / (TP + FP + FN)intersection = np.diag(self.confusionMatrix)union = np.sum(self.confusionMatrix, axis=1) + np.sum(self.confusionMatrix, axis=0) - np.diag(self.confusionMatrix)IoU = intersection / unionmIoU = np.nanmean(IoU)return mIoUdef genConfusionMatrix(self, imgPredict, imgLabel):# remove classes from unlabeled pixels in gt image and predictmask = (imgLabel >= 0) & (imgLabel < self.numClass)label = self.numClass * imgLabel[mask] + imgPredict[mask]count = np.bincount(label, minlength=self.numClass**2)confusionMatrix = count.reshape(self.numClass, self.numClass)return confusionMatrixdef Frequency_Weighted_Intersection_over_Union(self):# FWIOU = [(TP+FN)/(TP+FP+TN+FN)] *[TP / (TP + FP + FN)]freq = np.sum(self.confusion_matrix, axis=1) / np.sum(self.confusion_matrix)iu = np.diag(self.confusion_matrix) / (np.sum(self.confusion_matrix, axis=1) + np.sum(self.confusion_matrix, axis=0) - np.diag(self.confusion_matrix))FWIoU = (freq[freq > 0] * iu[freq > 0]).sum()return FWIoUdef addBatch(self, imgPredict, imgLabel):assert imgPredict.shape == imgLabel.shapeself.confusionMatrix += self.genConfusionMatrix(imgPredict, imgLabel)def reset(self):self.confusionMatrix = np.zeros((self.numClass, self.numClass))if __name__ == '__main__':imgPredict = np.array([0, 0, 1, 1, 2, 2])imgLabel = np.array([0, 0, 1, 1, 2, 2])metric = SegmentationMetric(3)metric.addBatch(imgPredict, imgLabel)acc = metric.pixelAccuracy()mIoU = metric.meanIntersectionOverUnion()print(acc, mIoU)。

语义分割计算指标代码1. 引言1.1 背景介绍语义分割是计算机视觉领域中的重要研究方向,旨在将图像中的每个像素分配到相应的语义类别中,从而实现对图像的像素级别理解和分割。

随着深度学习技术的不断发展,语义分割在图像分割、自动驾驶、医疗影像分析等领域都有着广泛的应用前景。

语义分割的背景介绍涉及到图像处理、计算机视觉、深度学习等多个领域的知识。

随着大数据和计算机硬件性能的提升,深度学习方法在语义分割任务中取得了巨大成功,许多经典的模型如FCN、UNet、DeepLab等都在语义分割领域取得了显著的成果。

语义分割技术的发展不仅推动了计算机视觉领域的进步,也为许多实际应用带来了极大的便利,比如医学影像分析中的病灶检测、智能驾驶中的道路检测等。

对于语义分割计算指标代码的研究具有重要意义,可以帮助研究人员更好地评估和比较不同的语义分割方法,在实际应用中指导模型的选择和优化。

1.2 研究意义语义分割作为计算机视觉领域的重要技术,其研究意义不言而喻。

通过语义分割技术,可以将图像中的每个像素分配到相应的语义类别,从而实现对图像的精细理解和分析。

这一技术在图像识别、场景理解、自动驾驶等领域有着广泛的应用前景。

语义分割可以为其他计算机视觉任务提供重要支持。

在目标检测和目标跟踪中,语义分割可以帮助识别出物体的轮廓和边界,从而提高检测和跟踪的准确性和稳定性。

语义分割在智能车辆领域也有着重要意义。

通过对路况图像进行语义分割,可以准确地识别出道路、车辆、行人等元素,为自动驾驶系统提供重要信息,提高驾驶安全性和效率。

语义分割还对图像编辑、视频处理等领域具有重要意义。

通过对图像进行语义分割,可以实现对图像的精细编辑和处理,为图像处理软件和应用带来更多可能性。

语义分割技术在计算机视觉领域具有重要的研究意义和应用前景,将为图像处理与分析领域带来新的发展机遇和挑战。

2. 正文2.1 语义分割概念语义分割是计算机视觉中的重要任务,其目标是将图像中的每个像素分类为相应的语义类别,从而实现像素级别的语义理解。

语义分割计算指标代码全文共四篇示例,供读者参考第一篇示例:语义分割是计算机视觉领域的一个重要任务,其目的是将图像中的每一个像素赋予特定的语义标签,从而实现对图像的详细分割。

这项任务在许多应用中都有着重要的应用,比如自动驾驶、医学影像分析、环境监测等领域。

在进行语义分割任务时,除了需要设计合适的网络架构和采用适当的数据集进行训练之外,还需要考虑如何评估模型的性能。

评估语义分割模型的性能是十分关键的,因为只有通过合适的指标来评估模型的准确性、鲁棒性和效率,才能更好地指导模型的优化和改进。

在计算语义分割模型的指标时,常用的指标包括准确率、召回率、F1分数、交并比(IoU)等。

本文将介绍如何计算这些指标,并且给出相关代码示例。

一、准确率(Accuracy)准确率是最直观和常用的评价指标之一,其计算方法如下:\[Accuracy = \frac{TP + TN}{TP + FP + FN + TN}\]TP表示真正例(True Positive),即被模型正确分类为正例的样本数;TN表示真负例(True Negative),即被模型正确分类为负例的样本数;FP表示假正例(False Positive),即实际为负例但被模型错误分类为正例的样本数;FN表示假负例(False Negative),即实际为正例但被模型错误分类为负例的样本数。

二、召回率(Recall)召回率衡量了模型对正例样本的识别能力,即当真实为正例的样本被模型正确分类的比例。

三、精准率(Precision)四、F1分数(F1 Score)F1分数是综合考虑了精准率和召回率的一个指标,其计算方法如下:\[F1 = \frac{2 * Precision * Recall}{Precision + Recall}\]F1分数是精准率和召回率的调和平均值,它能够平衡模型的查准率和查全率。

五、交并比(IoU)交并比是评价图像分割结果和真实标注之间重叠部分的一个指标,其计算方法如下:交并比表示预测结果与真实标注的交集占预测结果与真实标注的并集的比例,它能够反映模型分割结果的覆盖面和准确性。

语义分割评价指标代码

语义分割是计算机视觉领域的一项重要任务,旨在将图像中的每个像素分类到不同的语义类别中。

评价语义分割的好坏,需要使用一些指标来衡量其准确性和效果。

下面将介绍几个常用的语义分割评价指标,帮助读者更好地了解语义分割的性能。

1. 像素准确率(Pixel Accuracy):像素准确率是最简单的评价指标之一,计算分类正确的像素占总像素数的比例。

它忽略了分类错误的像素,不考虑分类的细节。

2. 平均像素准确率(Mean Pixel Accuracy):平均像素准确率是像素准确率的一种改进,它计算每个类别的像素准确率并求平均值。

这个指标能更好地反映语义分割的整体准确性。

3. 平均交并比(Mean Intersection over Union,mIOU):交并比是语义分割中常用的指标之一,它衡量预测结果与真实标签之间的相似度。

交并比定义为预测结果与真实标签的交集面积除以它们的并集面积。

平均交并比是所有类别交并比的平均值,能更全面地评价语义分割的效果。

4. 频率加权交并比(Frequency Weighted Intersection over Union,FWIOU):频率加权交并比是对平均交并比的改进,它考虑了每个类别的像素频率。

频率加权交并比将每个类别的交并比乘以该类别的像素频率,并对所有类别求和,以更准确地评价语义分割的效果。

5. 边界准确率(Boundary Accuracy):边界准确率是衡量语义分割边界预测准确性的指标。

它计算预测结果中正确预测的边界像素数占总边界像素数的比例。

像素准确率、平均像素准确率、平均交并比、频率加权交并比和边界准确率是常用的语义分割评价指标。

通过这些指标的综合分析,可以全面地评估语义分割的性能,为后续的算法优化和改进提供参考。