拉格朗日神经网络解决非凸优化问题

- 格式:pdf

- 大小:162.15 KB

- 文档页数:2

matlab解决凸优化和拉格朗日对偶方法

Matlab是一个强大的数值计算和科学编程工具,提供了丰富的函数和工

具箱来解决各种数学优化问题,包括凸优化和拉格朗日对偶方法。

在Matlab中,我们可以使用内置函数和工具箱来解决凸优化问题。

凸优

化是一类非常重要且广泛应用的数学优化问题,其目标是最小化或最大化凸

函数,在给定一些约束条件下,求解最优解。

Matlab中最常用的凸优化函数是"cvx"工具箱。

该工具箱提供了一套简洁

而强大的函数,可以轻松地定义凸优化问题,并使用内置的求解算法进行求解。

通过该工具箱,用户可以快速解决线性规划、二次规划、半定规划和凸

二次规划等问题。

除了凸优化,Matlab也提供了功能强大的函数来解决拉格朗日对偶方法。

拉格朗日对偶方法是一种用于解决约束优化问题的有效技术。

它通过将原问

题转化为拉格朗日函数,并通过求解对偶问题来近似求解原问题。

在Matlab中,我们可以使用"quadprog"函数来解决带约束的二次规划问题,其中可通过添加约束条件和求解问题的对偶问题来实现拉格朗日对偶方法。

此外,Matlab还提供了其他一些函数和工具箱,如"fmincon"和"linprog",这些函数可以用于解决不同类型的优化问题。

Matlab是一个功能强大的工具,可以通过其内置函数和工具箱来解决凸

优化和拉格朗日对偶方法。

无论是解决线性规划问题还是非线性优化问题,Matlab都提供了易于使用且高效的求解方法,可以帮助研究人员和工程师解

决复杂的数学优化问题。

一种非线性凸优化的神经网络算法作者:吴炎翰来源:《科学与财富》2019年第01期摘要:在日常生活、工程应用和研宄数学中,优化问题普遍存在。

对于优化问题的高效求解一直为学者探究,自1986年Hopfield 和Tank 提出优化问题可以利用神经网络求解之后,人们广泛关注并不断研究这样一种高效的优化求解方法[1][4]。

本文在凸优化理论,Lyapunov 稳定性理论的背景前提下,利用Karush-Kuhn-Tucker (KKT)条件转换并构造了一个递归神经网络模型,研究了如何利用神经网络求解含等式与不等式约束条件的凸优化问题。

关键词:递归神经网络;非线性凸优化;KKT条件1 论述凸优化问题和Karush-Kuhn-Tucker(KKT)条件1.1 凸优化,由于其已经证明的性质——局部最优解即为全局最优解——以及拉格朗日对偶性[2]被广泛用于线性回归、插值拟合等问题。

将无法求解或难以求解的优化问题(如Linear-Fractional规划,整数规划)转化为凸优化问题是近年来学者和业界工程师广泛研究并使用的解决手段。

接下来,我们看如下带有等式和不等式(非线性)约束条件的凸优化问题:其中,f(x)是可微凸函数, G(x)≤0 , Hx=0分别是凸优化问题的等式约束条件和不等式约束条件,不失一般性地,令H是一个行满秩矩阵( rank(H)=m1.2 Karush-Kuhn-Tucker(KKT)条件,是非线性优化问题下对Lagrange乘数法的推广。

可以将含等式约束优化问题扩展至含有不等式约束条件的问题。

那么,对于上述凸优化问题,其KKT条件为:定义拉格朗日函数L(x)=f(x)+g(x)Ta+h(x)Tb,若x是该优化问题的一个最优解,那么存在a∈Rm, b∈Rl,使得下面的式子成立:1)aTg(x)=02)L(a,b,x)对x求导为零3)h(x)=02 针对上述凸优化,欲通过神经网络求解,我们需要将其转换为一个动力系统,通过对KKT条件的推导,我们构造了递归神经网络模型:其中y=[y+g(x)]+易证该神经网络动力系统是李雅普诺夫(Lyapunov)稳定的,且可以从任意初始点收敛于上述凸优化的最优解。

拉格朗日神经网络解决带等式和不等式约束的非光滑非凸优化问题喻昕;许治健;陈昭蓉;徐辰华【摘要】Nonconvex nonsmooth optimization problems are related to many fields of science and engineering applications, which are research hotspots. For the lack of neural network based on early penalty function for nonsmooth optimization problems, a recurrent neural network model is proposed using Lagrange multiplier penalty function to solve the nonconvex nonsmooth optimization problems with equality and inequality constrains. Since the penalty factor in this network model is variable, without calculating initial penalty factor value, the network can still guarantee convergence to the optimal solution, which is more convenient for network computing. Compared with the traditional Lagrange method, the network model adds an equality constraint penalty term, which can improve the convergence ability of the network. Through the detailed analysis, it is proved that the trajectory of the network model can reach the feasible region in finite time and finally converge to the critical point set. In the end, numerical experiments are given to verify the effectiveness of the theoretic results.%非凸非光滑优化问题涉及科学与工程应用的诸多领域,是目前国际上的研究热点.该文针对已有基于早期罚函数神经网络解决非光滑优化问题的不足,借鉴Lagrange乘子罚函数的思想提出一种有效解决带等式和不等式约束的非凸非光滑优化问题的递归神经网络模型.由于该网络模型的罚因子是变量,无需计算罚因子的初始值仍能保证神经网络收敛到优化问题的最优解,因此更加便于网络计算.此外,与传统Lagrange方法不同,该网络模型增加了一个等式约束惩罚项,可以提高网络的收敛能力.通过详细的分析证明了该网络模型的轨迹在有限时间内必进入可行域,且最终收敛于关键点集.最后通过数值实验验证了所提出理论的有效性.【期刊名称】《电子与信息学报》【年(卷),期】2017(039)008【总页数】6页(P1950-1955)【关键词】拉格朗日神经网络;收敛;非凸非光滑优化【作者】喻昕;许治健;陈昭蓉;徐辰华【作者单位】广西大学计算机与电子信息学院南宁 530004;广西大学计算机与电子信息学院南宁 530004;广西大学计算机与电子信息学院南宁 530004;广西大学电气工程学院南宁 530004【正文语种】中文【中图分类】TP183作为解决优化问题的并行计算模型,递归神经网络在过去的几十年里受到了极大的关注,不少神经网络模型被提出。

凸优化和非凸优化发展历史-回复凸优化和非凸优化是数学和计算机科学领域中非常重要的问题。

在这篇文章中,我将为您介绍凸优化和非凸优化的发展历史,并解释它们的重要性以及应用领域。

我将从最早的相关工作开始,一直到最近的进展。

凸优化问题是指目标函数为凸函数,约束条件为凸集合的优化问题。

凸函数具有许多良好的性质,例如全局最小化的局部最小值就是全局最优值。

凸优化问题的研究可以追溯到早期的数学家如欧拉和拉格朗日。

然而,凸优化问题的系统研究始于20世纪40年代。

1947年,美国数学家格舍尔提出了线性规划问题的理论基础,奠定了凸优化问题的基本框架。

他的工作使得线性规划问题的解决方法成为可能,同时也为非线性优化问题的研究奠定了基础。

随后的几十年里,线性规划问题的理论和方法得到了快速发展,且被广泛应用于工程、经济、运筹学等领域。

然而,非线性优化问题的研究相对较晚开始。

1951年,美国数学家贡萨维尔提出了以KKT(Karush-Kuhn-Tucker)条件为基础的非线性规划问题的理论框架。

KKT条件是非线性优化问题的必要条件和充分条件,对于解决非线性优化问题起到了重要的作用。

在此之后,非线性优化问题的研究逐渐得到了加强。

1957年,美国数学家梅尔茨发表了非线性优化问题的一般性理论,引发了该领域的广泛研究。

在20世纪70年代,凸优化问题的研究得到了重要发展。

1972年,美国数学家罗克发表了凸优化问题的重要性质和算法,引发了广泛的研究兴趣。

与此同时,追溯到20世纪60年代,美国教授霍普(T.J.Ho)在图论中引入离散优化问题,并定义了多项式时间算法,并推动了离散优化问题的研究。

这些工作成为凸优化问题领域的里程碑,为凸优化问题的研究奠定了基础。

凸优化问题的研究得到了迅速发展,特别是在20世纪80年代以后。

1983年,内罗斯提出了内罗斯定理,它是线性规划问题解的存在性证明。

内罗斯定理为凸优化问题的理论研究提供了基础,成为凸优化问题理论的一个重要突破。

凸优化问题的神经网络算法研究第一章引言凸优化问题是一类在数学和工程领域中广泛应用的问题。

在实际应用中,凸优化问题的解决对于提高效率、降低成本、优化资源分配等方面具有重要意义。

神经网络算法作为一种强大的工具,近年来在解决凸优化问题方面展现出了巨大潜力。

本章将介绍研究背景和意义,并对文章的结构进行概述。

第二章凸优化问题概述本章将对凸优化问题进行概述,包括定义、性质和求解方法等方面。

首先介绍了凸集和凸函数的定义,并讨论了常见的几何性质,如拟凸性和强凸性。

然后介绍了常见的求解方法,包括梯度下降法、牛顿法和内点法等。

第三章神经网络算法简介本章将简要介绍神经网络算法及其在机器学习领域中的应用。

首先介绍了神经网络模型及其基本结构,并讨论了常见的神经网络训练算法,如反向传播算法和随机梯度下降算法。

然后介绍了神经网络在分类、回归和聚类等任务中的应用。

第四章神经网络在凸优化问题中的应用本章将详细介绍神经网络在解决凸优化问题中的应用。

首先讨论了将凸优化问题转化为神经网络模型的方法,并介绍了常见的转化技巧,如拉格朗日松弛和支持向量机等。

然后讨论了神经网络在约束优化、凸二次规划和线性规划等问题中的应用。

第五章神经网络算法性能分析本章将对神经网络算法在解决凸优化问题中的性能进行分析。

首先讨论了算法收敛性和稳定性等方面的指标,并介绍了常见的评估方法,如收敛速度和误差分析等。

然后通过实验对比,评估了神经网络算法与传统求解方法在不同场景下的性能差异。

第六章神经网络算法改进与扩展本章将讨论如何改进和扩展神经网络算法以提高其在解决凸优化问题中的效果。

首先介绍了常见改进技术,如正则化、批归一化和参数初始化等。

然后讨论了如何将神经网络算法与其他优化算法相结合,以提高求解效率和稳定性。

第七章实际应用与案例分析本章将通过实际应用和案例分析,展示神经网络算法在解决凸优化问题中的实际效果。

以图像处理、信号处理和金融风险管理等领域为例,介绍了神经网络算法在不同领域中的应用情况和效果。

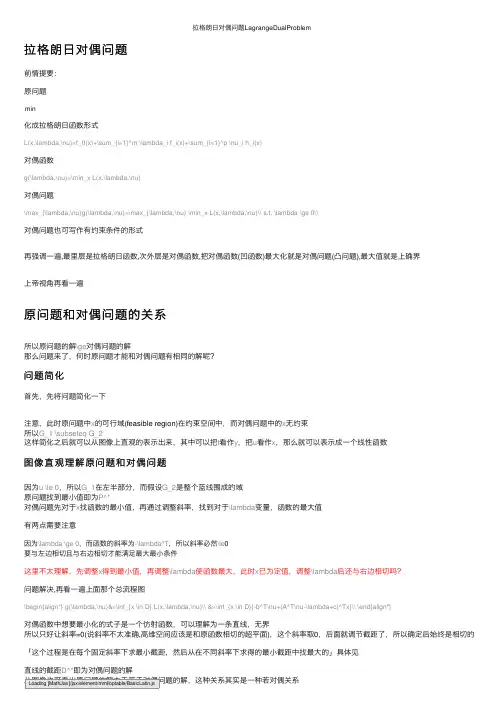

拉格朗⽇对偶问题LagrangeDualProblem拉格朗⽇对偶问题前情提要:原问题min化成拉格朗⽇函数形式L(x,\lambda,\nu)=f_0(x)+\sum_{i=1}^m \lambda_i f_i(x)+\sum_{i=1}^p \nu_i h_i(x)对偶函数g(\lambda,\nu)=\min_x L(x,\lambda,\nu)对偶问题\max_{\lambda,\nu}g(\lambda,\nu)=\max_{\lambda,\nu} \min_x L(x,\lambda,\nu)\\ s.t. \lambda \ge 0\\对偶问题也可写作有约束条件的形式再强调⼀遍,最⾥层是拉格朗⽇函数,次外层是对偶函数,把对偶函数(凹函数)最⼤化就是对偶问题(凸问题),最⼤值就是上确界上帝视⾓再看⼀遍原问题和对偶问题的关系所以原问题的解\ge对偶问题的解那么问题来了,何时原问题才能和对偶问题有相同的解呢?问题简化⾸先,先将问题简化⼀下注意,此时原问题中x的可⾏域(feasible region)在约束空间中,⽽对偶问题中的x⽆约束所以G_1 \subseteq G_2这样简化之后就可以从图像上直观的表⽰出来,其中可以把t看作y,把u看作x,那么就可以表⽰成⼀个线性函数图像直观理解原问题和对偶问题因为u \le 0,所以G_1在左半部分,⽽假设G_2是整个蓝线围成的域原问题找到最⼩值即为P^*对偶问题先对于x找函数的最⼩值,再通过调整斜率,找到对于\lambda变量,函数的最⼤值有两点需要注意因为\lambda \ge 0,⽽函数的斜率为-\lambda^T,所以斜率必然\le0要与左边相切且与右边相切才能满⾜最⼤最⼩条件这⾥不太理解,先调整x得到最⼩值,再调整\lambda使函数最⼤,此时x已为定值,调整\lambda后还与右边相切吗?问题解决,再看⼀遍上⾯那个总流程图\begin{align*} g(\lambda,\nu)&=\inf_{x \in D} L(x,\lambda,\nu)\\ &=\inf_{x \in D}{-b^T\nu+(A^T\nu-\lambda+c)^Tx}\\ \end{align*}对偶函数中想要最⼩化的式⼦是⼀个仿射函数,可以理解为⼀条直线,⽆界所以只好让斜率=0(说斜率不太准确,⾼维空间应该是和原函数相切的超平⾯),这个斜率取0,后⾯就调节截距了,所以确定后始终是相切的「这个过程是在每个固定斜率下求最⼩截距,然后从在不同斜率下求得的最⼩截距中找最⼤的」具体见直线的截距D^*即为对偶问题的解从图像也可看出原问题的解⼤于等于对偶问题的解,这种关系其实是⼀种若对偶关系Loading [MathJax]/jax/element/mml/optable/BasicLatin.js那么什么条件下原问题和对偶问题是等价的呢?强对偶关系不难想象,可⾏域的范围是⼀个凸集时,两值相等(注意:斜率⼀定\le 0)但是,G为凸集只是强对偶的充分⾮必要条件⽐如下图的可⾏域范围是⾮凸集,但原问题和对偶问题依然等价Slater条件其中relint \ D为只有满⾜了Slater条件,凸优化问题才是强对偶问题,是充分条件KKT条件KKT条件是强对偶问题的必要条件如果x在可⾏域内,g_i(x)是松弛的,此时的g_i(x) \le 0,\lambda_i=0, \lambda_ig(i)=0如果最⼩值点不在可⾏域内,那么极值点在边界上,g_i(x)=0,\lambda_ig(i)=0上述的紧致和松弛也就对应着前⾯强对偶关系的两种情况的图像拉格朗⽇对偶问题的好处为什么费尽周折的去转化成对偶问题呢?因为原问题不⼀定是凸优化问题然⽽转化成的应⽤最后再回到机器学习的应⽤中在求的时候,就是将原问题转化为对偶问题处理的转化成对偶问题,先将P的形式定下来,就是确定了模型,然后再调整\lambda,也就是调参的过程但在神经⽹络中,由于有隐藏层的存在,调整参数\lambda后,x,y的值不再是已经确定的了,还要重新计算,所以求最⼩值的过程其实与最⼤化相互耦合所以从整体来看并不是凸优化问题,但通过反向传播,在最后的输出层上形成⼀个局部的凸优化问题神经⽹络相当于⼀个筛选器,把现实中⾮凸优化的问题转化成凸优化问题,通过隐藏层只留下凸优化的因素,送到最后的输出层Reference。

利用拉格朗日函数能解带约束的优化问题

拉格朗日函数在互联网领域受到了广泛的应用。

拉格朗日函数也称为拉格朗日乘子法,是一种能够解决带有约束条件的优化问题的有效方法,它把原始最优化问题转变成了无约束的优化问题。

在互联网领域,拉格朗日函数可以用来解决供应链管理、营销活动优化以及网

络布局问题等等。

传统的优化算法如动态规划,贪心算法,复杂度很高也难以满足多约束条件的要求。

而拉格朗日函数可以从抽象的角度考虑问题,将约束条件纳入其中,以最小化目标函数为优化目标,有效地解决了优化问题。

此外,拉格朗日函数还具有很强的灵活性,相对于传统的求解算法,它可以给

出一系列更为复杂的约束条件,以及一些非线性条件,因此在考虑约束更加复杂的问题时有更多的优势。

例如,我们可以考虑多个不同的技术路径,比较不同的成本,看看该采用何种技术,同时考虑另外一些经济约束条件等等。

另外,拉格朗日函数还可以帮助企业优化成本,消除系统中各种冗余因素,有

效地实现节约,提升经济效益。

因此,拉格朗日函数在互联网领域的应用将有助于企业实现平衡发展。

总的来说,拉格朗日乘子法可以满足复杂的优化问题,具有较强的鲁棒性和较

高的效率。

拉格朗日函数的应用已经越来越多,在众多的约束条件下,使用拉格朗日乘子法能够有效的解决问题,取得更好的优化结果,为企业带来更多的经济效益。

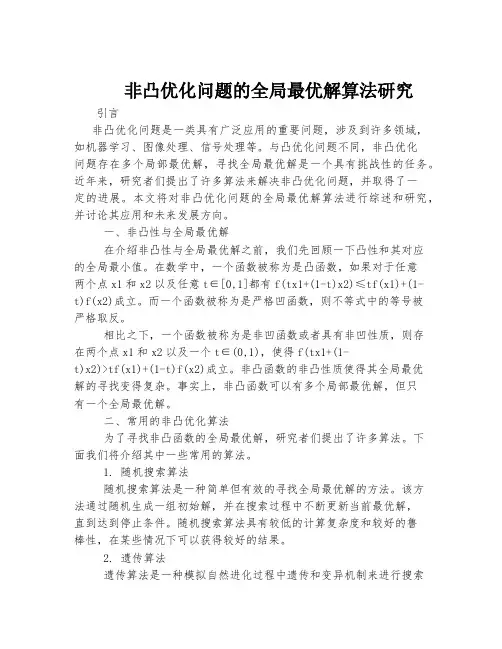

非凸优化问题的全局最优解算法研究引言非凸优化问题是一类具有广泛应用的重要问题,涉及到许多领域,如机器学习、图像处理、信号处理等。

与凸优化问题不同,非凸优化问题存在多个局部最优解,寻找全局最优解是一个具有挑战性的任务。

近年来,研究者们提出了许多算法来解决非凸优化问题,并取得了一定的进展。

本文将对非凸优化问题的全局最优解算法进行综述和研究,并讨论其应用和未来发展方向。

一、非凸性与全局最优解在介绍非凸性与全局最优解之前,我们先回顾一下凸性和其对应的全局最小值。

在数学中,一个函数被称为是凸函数,如果对于任意两个点x1和x2以及任意t∈[0,1]都有f(tx1+(1-t)x2)≤tf(x1)+(1-t)f(x2)成立。

而一个函数被称为是严格凹函数,则不等式中的等号被严格取反。

相比之下,一个函数被称为是非凹函数或者具有非凹性质,则存在两个点x1和x2以及一个t∈(0,1),使得f(tx1+(1-t)x2)>tf(x1)+(1-t)f(x2)成立。

非凸函数的非凸性质使得其全局最优解的寻找变得复杂。

事实上,非凸函数可以有多个局部最优解,但只有一个全局最优解。

二、常用的非凸优化算法为了寻找非凸函数的全局最优解,研究者们提出了许多算法。

下面我们将介绍其中一些常用的算法。

1. 随机搜索算法随机搜索算法是一种简单但有效的寻找全局最优解的方法。

该方法通过随机生成一组初始解,并在搜索过程中不断更新当前最优解,直到达到停止条件。

随机搜索算法具有较低的计算复杂度和较好的鲁棒性,在某些情况下可以获得较好的结果。

2. 遗传算法遗传算法是一种模拟自然进化过程中遗传和变异机制来进行搜索和优化问题求解的方法。

该方法通过模拟自然选择、交叉和变异等过程来生成新一代个体,并通过适应度评估来选择具有较好适应度值的个体作为下一代进化种群中继续繁衍。

遗传算法具有较强的全局搜索能力和较好的鲁棒性,但其计算复杂度较高。

3. 粒子群优化算法粒子群优化算法是一种模拟鸟群搜索和迁徙行为的优化方法。

松弛的增广拉格朗日法解带线性约未的凸优化问题

增广拉格朗日法解带线性约束的凸优化问题是一种求解凸优化问题的最优化方法,其关键是合理地将凸优化问题分解成一个线性规划问题,通过求解线性规划来求解凸优化问题,其过程非常简洁易懂。

增广拉格朗日法解带线性约束的凸优化问题,其基本思路是:首先将目标函数和约束条件分别写成拉格朗日函数和约束函数,然后将原问题转化为极小化拉格朗日函数的增广优化问题,用凸优化问题求解增广优化问题。

经过上述步骤,凸优化问题转换成一个线性规划问题,也就可以用线性规划的方法求解拉格朗日函数的最小值,以解决凸优化问题。

增广拉格朗日法解带线性约束的凸优化问题有几个关键步骤:第一,将原始优化问题转化为增广优化问题;第二,将增广优化问题线性化;第三,求解线性规划问题,以求解凸优化问题。

增广拉格朗日法解带线性约束的凸优化问题是一种简单而有效的凸优化求解方法,它利用增广拉格朗日法将凸优化问题转化为一个线性规划问题,再用线性规划的方法求解,在实际的工程应用中,可以节省许多求解时间,提高计算效率。

使用生物神经网络来解决多变量优化问题本文旨在研究如何使用生物神经网络(BNNs)来解决多变量优化问题。

优化问题是数学和工程实践中经常遇到的一类问题,求解此类问题的方法被称为优化方法。

在本文中,我们将研究如何使用BNNs来解决多变量优化问题,并与其他优化方法进行对比。

首先,让我们回顾一下多变量优化问题的定义。

多变量优化问题是指根据一定的目标函数,在必要的约束条件下,在变量的取值范围内,求得该目标函数的最优的变量取值组合,使得目标函数获得最大或最小的值。

传统上,优化问题的解决依赖于搜索算法,包括梯度下降、牛顿迭代和模拟退火等不同种类的算法。

近年来,BNNs作为一种有效的机器学习工具,正在被用于优化问题的解决。

BNNs将来自生物网络的结构耦合到神经网络中,结构包括神经元、联结权重和外部激励信号。

BNNs被设计用来建模基于观测数据的复杂运动、感知过程或非线性函数的非线性优化问题。

例如,它可以用来模拟汽车中的发动机,以根据发动机的最佳性能参数找到最优的性能参数。

此外,BNNs的另一个优势是它的可扩展性和快速计算速度。

使用BNNs解决优化问题时,网络参数的搜索空间可以更快地被探索,由此可以得出更好的解决方案。

而且,BNNs提供了一种易于实现和灵活运行的并行化方案,以最大化计算性能,进而提高优化算法的效率。

综上所述,我们可以发现BNNs比传统的优化方法提供更高的解决多变量优化问题的效率,它的可扩展性和快速计算速度可以更快地找出更好的解决方案。

因此,BNNs可以被用作一种有效的工具来解决多变量优化问题。

在实际应用中,BNNs可以被用于求解非凸优化问题,其中目标函数在变量空间内具有多个局部最优点。

这类优化问题在工程、金融和科学分析优化等方面具有广泛的应用,因此,BNNs可以用于解决大量的优化问题。

一种具体的应用是进行组合优化。

组合优化问题要求在一定的边界条件和约束条件之内,尽可能的改变变量值,使得目标函数得到最优化。

非凸优化问题的二次规划算法研究非凸优化问题是在实际问题中经常遇到的一类优化问题,而二次规划算法是解决非凸优化问题的一种有效方法。

本文将对非凸优化问题的二次规划算法进行深入研究,探讨其原理、方法和应用。

一、引言非凸优化问题在实际应用中具有广泛的应用背景和重要意义。

然而,由于其复杂性和困难性,如何高效地求解非凸优化问题一直是研究者们关注的焦点。

二次规划算法作为求解非凸优化问题的一种常用方法,在实践中取得了显著的成果。

本文将对二次规划算法进行系统研究和分析。

二、非凸优化问题概述1.非凸性概念非凸性是指优化问题中的目标函数在某些点上的二阶导数大于零,导致函数曲线呈现出不连续的凸凹特性。

在非凸优化问题中,存在多个局部最优解,而全局最优解往往难以求解。

2.非凸优化问题分类根据问题形式,非凸优化问题可分为线性非凸优化问题、二次非凸优化问题、非线性非凸优化问题等。

此外,根据目标函数的性质,非凸优化问题还可以分为严格非凸优化问题、弱非凸优化问题等。

3.非凸优化问题解决难点非凸优化问题的解决难点主要包括:局部最优解的存在、目标函数的复杂性、求解过程的不稳定性等。

这些难点使得非凸优化问题在很多实际应用中难以求解。

三、二次规划算法原理1.二次规划模型定义二次规划(Quadratic Programming,简称QP)问题是指具有二次目标函数和线性约束条件的优化问题。

二次规划问题可以表示为:minimize f(x) = ax^2 + bx + csubject to g_i(x) <=0, i =1, ..., m2.二次规划模型转换为标准形式为了方便求解,我们将二次规划问题转化为标准形式。

首先,将二次目标函数中的x替换为新的变量y,然后将原问题中的线性约束条件转化为二次规划问题的标准形式。

3.二次规划模型特点分析二次规划问题的特点主要包括:目标函数为二次函数,具有开口向上的抛物线形状;线性约束条件表示的是超平面,将可行域划分为多个子区域;在某些子区域内,二次规划问题可能具有多个局部最优解。

拉格朗日中值定理可以用来证明许多函数在某些条件下的极值。

它告诉我们,如果一个函数在某一点处有一个极值,那么在这个点处导函数为零。

这个定理可以用来证明多元函数的极值,也可以用来证明单元函数的极值。

这个定理在微积分中有很多应用,例如在证明函数的最值,证明函数的单调性,求极值点,求函数的泰勒展开等。

另外,拉格朗日中值定理还有很多应用在统计学,机器学习等领域。

例如在线性回归中,使用拉格朗日乘子法可以求得最小二乘法解。

此外,拉格朗日中值定理还可以用于凸优化问题的求解。

凸优化是一类最优化问题,其中目标函数和约束条件都是凸函数。

拉格朗日乘子法就是一种用于求解凸优化问题的方法,它通过构造拉格朗日函数来求解原问题的最优解。

拉格朗日中值定理在支持向量机(SVM)算法中也有应用,SVM是一种二分类模型,它通过构造最大间隔分离超平面来对数据进行划分。

拉格朗日乘子法可以用来求解SVM 中的对偶问题,从而得到最优解。

总的来说,拉格朗日中值定理是一种非常强大的工具,可以用来证明许多函数的性质,并在微积分,机器学习,统计学,优化等领域有广泛应用。

此外,拉格朗日中值定理在深度学习中也有应用。

深度学习是一种机器学习方法,其中包含多层神经网络,它可以用来解决各种复杂的学习问题。

深度学习中的网络参数是需要学习的,而拉格朗日中值定理可以用来证明其存在全局最优解。

同时,拉格朗日中值定理在强化学习中也有应用。

强化学习是一种机器学习方法,它可以让智能体在不断尝试和试错的过程中学习如何执行任务。

拉格朗日中值定理可以用来证明在强化学习中存在全局最优策略。

总之,拉格朗日中值定理是一个非常强大的理论工具,它在微积分,机器学习,统计学,优化,深度学习和强化学习等领域都有着广泛的应用。

小型微型计算机系统Journal of Chinese Computer Systems 2020年12月第12期 Vol.41 N o.12 2020一种解决非光滑非凸优化问题的暂态混沌神经网络喻昕,汪炎林,徐柳明,伍灵贞(广西大学计算机与电子信息学院,南宁530004)E-mail :****************摘要:提出了一个新的递归神经网络模型,目标是解决一类带等式与不等式约束的非光滑非凸优化问题.证明了当可行域有 界时,递归神经网络能在有限时间内收敛到可行域,并且能最终收敛到优化问题的一个关键点•并针对一般的递归神经网络在 解决非凸优化问题过程中容易陷入局部最优解的情况,本文的递归神经网络扩展为暂态混沌神经网络,能通过混沌遍历收敛到 优化问题的全局最优点.最终通过实验验证了提出模型的有效性和全局寻优能力.关键词:神经网络;非凸优化问题;暂态混沌神经网络;最优解中图分类号:T P183 文献标识码:A文章编号:1000-1220(2020)12-2522>07Transient Chaotic Neural Network for Nonsmooth and Nonconvex Optimization ProblemsY U X i n.W A N G Yan-lin,XU Liu-m i n g,W U Ling-zhen(Department of Computer and Electronic Information,Guangxi University,Nanning 530004 .China)Abstract:A new r e c u r r e n t n e u r a l network model i s proposed t o s o l v e a c l a s s of nonsmooth nonconvex o p t i m i z a t i o n problems with e-q u a l i t y and i n e q u a l i t y c o n s t r a i n t s I t i s proved t h a t when t h e f e a s i b l e r e g i o n i s bounded,t h e r e c u r r e n t n e u r a l network can converge t o t h e f e a s i b l e r e g i o n i n f i n i t e time and f i n a l l y t o a key p o i n t of t h e o p t i m i z a t i o n problem.For t h e g e n e r a l r e c u r r e n t n e u r a l network i s easy t o f a l l i n t o t h e l o c a l optimal s o l u t i o n i n t h e p r oc es s of s o l v i n g t h e nonconvex o p t i m i z a t i o n problem,t h e r e c u r r e n t n e u r a l network i n t h i s paper i s extended t o t h e t r a n s i e n t c h a o t i c n e u r a l network,which can converge t o t h e g l o b a l optimal s o l u t i o n of t h e o p t i m i z a t i o n problem through c h a o t i c ergodic.F i n a l l y,t h e e f f e c t i v e n e s s and g l o b a l o p t i m i z a t i o n a b i l i t y of t h e proposed model a r e v e r i f i e d by e x p e r iments.Key words:n e u r a l network;nonconvex o p t i m i z a t i o n problems;t r a n s i e n t c h a o t i c n e u r a l network;optimal s o l u t i o ni前言在科学与工程应用中,优化问题作为一类重点问题在最 近几十年内得到了广泛的关注与发展.在1986年,由Hopfield 和 Tank⑴提出一种Hopfield 神经网络(Hopfield Neural Network,H N N)作为解决优化问题的并行计算模型,引起了大家的兴趣并开始广泛应用.Zhang等人利用Laga-range乘子法创建了一个新的递归神经网络来处理凸光滑非 线性优化问题,Xia等人[3]提出了基于投影方法的递归神经 网络用以解决光滑凸(伪凸)优化问题.不久后,应用范围从光滑问题发展到非光滑优化问题,如 L i等人[4]在基于Clark次梯度的递归神经网络模型之中引人 投影方法以解决R"上闭凸子集的非凸非光滑优化问题.Liu 等人[5]尝试投影方法建立递归神经网络模型解构线性等式 和R"上闭凸子集共同约束的非光滑非凸优化问题.Bian等 人[6]也开始利用光滑递归神经网络来解决非光滑非凸的优 化问题,使用光滑逼近技术即用一个与目标函数逼近的光滑 函数构造光滑神经网络模型.Y u等人[7]基于微分包含的思 想,建立了一个不依赖罚参数的神经网络模型用以解决非光 滑非凸优化问题.然而上述的模型的本质仍是基于“梯度”或“次梯度”下 降的动力系统,无法避免“陷人”局部最优解.尤其是当优化 的目标函数是非凸时会存在多处局部最优解,这将无法保证 获得全局最优解.为了解决这个问题,Aihara等人[8]受生物神经元混沌特 性的启发,于1990年在H N N中增加一个自反馈项以引人混 沛机制开创了混纯神经网络(Chaotic Neural Network,C N N).此后,C h e n和Aihara[9]将模拟退火优化算法引人到C N N中提出了暂态混纯神经网络(T r a n s i e n t l y Chaotic Neural Net-work,T C N N).T C N N的动力系统对自反馈链接权值敏感,它 可以类比模拟退火算法中一直衰减的温度.当“温度”较大 时,整个系统处于“粗搜索”阶段,搜索过程符合混沌动态的 特性,会按照混沌轨道进行遍历,并且不受目标函数的限制,能克服陷人局部最优解;当“温度”开始减少并达到一定程度 时,系统进入“细搜索”阶段,这时的自反馈权值对系统的影 响变得很小,这时的神经网络类似于以粗搜索得到的解为初始点,根据_梯度下降机制在小范围进行搜索,并 收敛到一个平衡点,最终T C N N会收敛到一个全局最优解.TCNN提出后,不少学者对此展开研究.文献[1〇,11]分 别将TCNN应用于解决组播路由和蜂窝信道分配等组合优收稿日期:2〇2〇>01-14收修改稿日期:202(M)3>09基金项目:国家自然科学基金项目(61862004)资助.作者简介:喻昕,男,1973年 生,博士,教授,CCF会员,研究方向为神经网络、优化计算;汪炎林,男,1995年生,硕士,研究方向为神经网络;徐柳明,男,1994年生,硕士,研究 方向为神经网络;伍灵贞,女,1995年生,硕士,研究方向为神经网络.喻昕等:一种解决非光滑非凸优化问题的暂态混沌神经网络2523 12期化问题;Zhang等人0]利用小波函数作为激活函数的T C N N 来解决函数优化问题;Babak等人[|3]利用T C N N改进了反应 曲面法在函数优化问题中应用的性能.借助脑电波的生物机制,分析不同频率的正弦信号叠加 形成的脑电波模型,H u等人[14]用变频正弦(Frequency Conv e r s i o n Sinusoidal,F C S)函数与 Sigmoid 函数加权和作为混纯 神经元的激励函数,建立了一个新的神经网络模型一变频正 弦混沛神经网络(Frequency Conversion S i n u s o i d a l Chaotic Neural Network,F C S C N N)模型,并在文献[15,16]进一步分 析和优化了这种新的模型.综上,为了解决非凸非光滑优化问题,本文提出一个能收 敛到优化问题关键点集的递归神经网络,并在此基础上构建 了一个暂态混沌神经网络,用于实现非凸优化问题的全局寻优.2预备知识考虑如下问题:min f(x)s.t.g(x)^0A x-b(1)当j c= U,;c2,T e R",/:R”—R,目标函数是正则 的,但可以是非凸的和非光滑的,= (A U) ,g2(x),…,SPU))T:1R R P 是 P-维向量值函数U= 1,2,…,P)是凸的,但可能是非光滑的,A e R是满行秩矩阵,而且办=(办1,2,"-九)^1?'我们假设优化问题(1)具有至少一个局部最小解.定义:\ = |x:衮U)矣0!S2 = \x:Ax= b\贝I J S= \n s2,S= U e R"j U)«0,/U= 是优化问题 (1)的可行域.为便于后续的证明,首先给出下面两个假设:假设1.存在一个点i e R",满足i e i n t(\)n\,使得 i>0.其中 min-gy+(i).假设2.存在义€11”,;*>0,使得;^池(451)门152,5(=5 (i,r).其中 5(i,r) = U e R n:||x- i|| 矣rl.在假设1和2成立的前提下,根据罚函数思想,对\引人罚函数=$111狀丨0,容;(文)丨,则U:Z)U)系0丨=5■卜因为以;〇〇1,2,:",/〇是凸的,那么1)(;〇为凸函数,且对任 意 a:e R n:0,x e i n t(5,)明u)=,;玉)[0,1]啤⑴,xebd(s')Z[0,l]^y(^)+I d g j(x)1X^S lVsJ〇(*);«■/+(*)这里:U) = U e 11,2,…,pi :g;(A:) >〇1,U) = b'e|l,2r__,p|:&(j c)=0|定义1.若对于集合£C R"上的任意点;c,都存在一个非 空集合R j c)C R",则;c—F(j c)是£—R"上的集值映射.若对 于任意的开集V3F(;c。

几类非凸优化问题的松弛定界方法几类非凸优化问题的松弛定界方法一、引言在实际应用中,很多问题涉及到求解非凸优化问题,例如机器学习、图像处理、模式识别等。

这类问题通常存在多个局部最优解,难以通过传统的优化方法得到全局最优解。

由于非凸优化问题的复杂性,传统的算法会因陷入局部最优解而无法找到全局最优解。

因此,为了解决非凸优化问题,研究人员提出了一系列的松弛定界方法。

本文将介绍几种常见的非凸优化问题的松弛定界方法。

二、分枝定界法分枝定界法是解决非凸优化问题的经典方法之一。

它通过将原优化问题分解为若干个子问题,并对子问题进行求解,进而得到全局最优解。

具体而言,分枝定界法的步骤如下:1. 将原问题分解为若干个子问题;2. 对每个子问题进行求解,得到一个下界;3. 根据得到的下界,对子问题进行限界,排除无用的子问题;4. 重复第2、3步,直到找到全局最优解或无法继续分解为止。

分枝定界法的核心思想是通过限制搜索空间,逐步逼近全局最优解。

但是,分枝定界法的计算复杂度较高,当问题规模较大时,所需时间也会相应增加。

三、拉格朗日松弛法拉格朗日松弛法是一种常用于求解非凸优化问题的方法。

它通过将约束条件转化为拉格朗日松弛函数,从而将原问题转化为一个无约束问题。

具体而言,拉格朗日松弛法的步骤如下: 1. 将原优化问题的约束条件转化为拉格朗日松弛函数;2. 对于每个拉格朗日乘子,求解一个近似问题;3. 将得到的近似问题进行求解,得到一个可行解;4. 根据可行解更新拉格朗日乘子;5. 重复第2、3、4步,直到收敛于全局最优解。

拉格朗日松弛法的优点是能够转化为无约束问题,方便求解。

但是,由于近似问题的求解可能只是得到一个局部最优解,所以需要进行多次迭代以逼近全局最优解。

四、割平面法割平面法是一种常见的非凸优化问题的松弛定界方法,它利用了原问题的凹凸性质,通过添加新的约束条件逐步逼近全局最优解。

具体步骤如下:1. 求解原问题的凸松弛问题,得到初步解;2. 判断初步解是否满足原问题的约束条件,如果满足则为全局最优解,否则进行下一步;3. 添加新的约束条件,将问题进一步约束,得到一个更加凸的松弛问题;4. 重复第2、3步,直到满足原问题的约束条件,或者无法继续添加新的约束条件为止。