数值并行算法矩阵运算

- 格式:ppt

- 大小:3.10 MB

- 文档页数:28

GPU并行库矩阵运算随着科学技术的不断发展,计算机的性能越来越强大。

在这个过程中,GPU (Graphics Processing Unit) 作为一种强大的并行计算设备,受到了越来越多的关注。

GPU可以同时执行多个任务,因此在需要处理大量数据或进行复杂计算的情况下,GPU可以比CPU 更快地完成任务。

在GPU并行计算中,矩阵运算是一个非常重要的领域。

矩阵是一种二维数组,它可以用来表示线性方程组和转换矢量等。

矩阵乘法是矩阵运算中最基本的运算之一,它涉及到大量的数据和计算,因此非常适合在GPU上进行并行计算。

为了实现高效的矩阵运算,GPU并行库应运而生。

GPU并行库是一种用于GPU并行计算的软件库,它提供了一系列函数和工具,以帮助程序员在GPU上实现高效的并行计算。

在GPU并行库中,矩阵运算被广泛支持。

例如,CUDA (Compute Unified Device Architecture) 是一种由NVIDIA提供的GPU并行计算平台和编程模型,它提供了一些优化后的矩阵运算函数,如cuBLAS (CUDA Basic Linear Algebra Subprograms) 和cuSPARSE (CUDA Sparse Matrix) 等。

这些函数使用高效的算法和数据结构,能够在GPU上实现高效的矩阵运算。

除了CUDA外,OpenCL (Open Computing Language) 也是一种支持GPU并行计算的平台和编程模型。

OpenCL提供了一些矩阵运算函数,如clBLAS (OpenCL Basic Linear Algebra Subprograms) 和clSPARSE (OpenCL Sparse Matrix) 等。

这些函数和CUDA中的函数类似,也能够在GPU上实现高效的矩阵运算。

此外,一些深度学习框架如TensorFlow和PyTorch等也提供了GPU并行计算的支持,并且提供了一些优化后的矩阵运算操作。

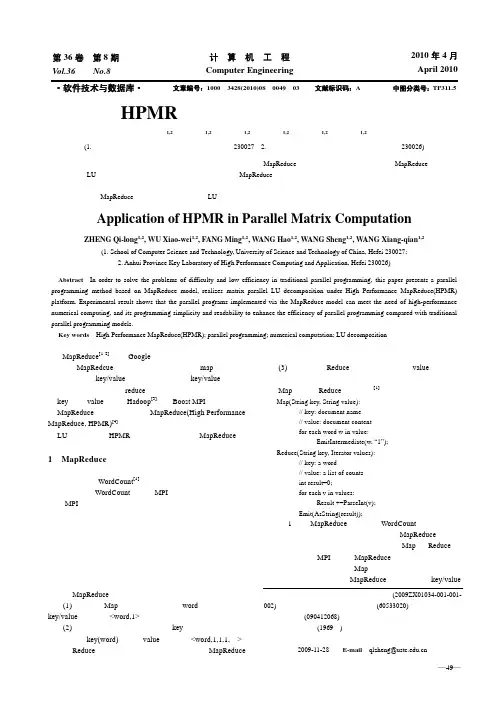

并行计算中稠密矩阵运算一、引言稠密矩阵运算是并行计算中的重要领域之一,在科学计算、数据分析和机器学习等领域都得到了广泛应用。

本文将从并行计算的角度出发,探讨稠密矩阵运算在并行计算中的应用及其相关技术。

二、并行计算中的稠密矩阵运算稠密矩阵运算主要涉及到矩阵乘法、矩阵分解、矩阵求逆、特征值计算等方面。

在并行计算中,这些运算的主要挑战来自于如何最大化利用计算资源,提高计算效率,同时避免死锁和其他并发问题。

基于并行化思想的稠密矩阵计算方法主要有两种:数据并行和任务并行。

数据并行将矩阵分割成若干块,同时将计算任务分配到多个处理器上进行计算。

任务并行则将矩阵分解成若干个子任务,每个子任务在独立的处理器上进行计算。

1. 矩阵分块技术矩阵可以利用分块技术进行分割,将稠密矩阵分成若干小块,再将小块分别分配到不同的处理器上进行计算。

这样做可以减少整个计算任务中的通信量,提高计算效率。

2. 并行矩阵乘法矩阵乘法是并行计算中最基本也是最常见的操作之一。

并行矩阵乘法的实现主要利用了任务并行:将矩阵乘法的运算过程分解成若干个子任务,每个子任务在独立的处理器上进行计算。

3. 并行矩阵分解在处理大型稠密矩阵时,往往需要将其分解成较小的分块矩阵进行计算。

目前,常用的并行矩阵分解方法主要有LU分解、QR 分解、SVD分解等。

1. 科学计算在科学计算中,稠密矩阵运算广泛应用于数值模拟、图像处理、计算流体动力学等领域。

高效的并行稠密矩阵计算能够大幅缩短计算时间,提高计算精度。

2. 数据分析数据分析中常常需要对大量数据进行稠密矩阵运算,例如特征值分解、主成分分析等。

并行计算可以在较短的时间内处理大量数据,加速数据分析的过程。

3. 机器学习在机器学习中,基于稠密矩阵的数据处理和计算是必不可少的。

并行计算能够大幅缩短计算时间,提高机器学习模型的训练速度和性能。

五、总结并行计算中的稠密矩阵运算是高性能计算的一个重要领域。

通过使用数据并行和任务并行等技术,可以最大化利用计算资源,提高计算效率。

矩阵计算和迭代算法在数值计算中扮演着非常重要的角色。

它们被广泛应用于计算机科学、物理学、工程学等领域。

本文将讨论矩阵计算和迭代算法在数值计算中的应用,并且介绍一些相关的算法和方法。

首先,让我们了解一下矩阵计算的基本概念。

矩阵是由若干个数按照一定的规律排列成的一个矩形的数组。

矩阵的大小由它的行数和列数确定。

矩阵可以进行加法、减法、乘法等基本运算,而这些运算可以在数值计算中广泛应用。

矩阵计算在数值计算中有许多应用,其中最重要的应用之一是线性方程组的求解。

线性方程组是由一组线性方程构成的方程组,例如:a₁₁x₁ + a₁₂x₂ + a₁₃x₃ = b₁a₂₁x₁ + a₂₂x₂ + a₂₃x₃ = b₂a₃₁x₁ + a₃₂x₂ + a₃₃x₃ = b₃其中,x₁、x₂、x₃是未知数,a₁₁、a₁₂、a₁₃等是已知的系数,b₁、b₂、b₃是已知的常数。

矩阵可以非常方便地表示这个方程组,例如用向量表示法:Ax = b其中,A是一个矩阵,x和b是向量。

对于这个方程组,我们可以利用矩阵计算的方法,比如矩阵的求逆、矩阵的行变换等来求解未知数。

除了线性方程组的求解,矩阵计算还广泛应用于最小二乘问题的求解。

最小二乘法是一种数学优化问题的解法,主要用于拟合数据和估计参数。

在实际问题中,往往存在多个数据点,这些数据点可能存在噪声或误差。

最小二乘法可以通过最小化误差的平方和来找到最优的拟合曲线或参数。

迭代算法在数值计算中也扮演着重要的角色。

迭代算法是一种通过迭代逼近的方法求解数学问题的算法。

迭代算法的基本思想是从一个初始值开始,通过不断迭代来逼近问题的解。

迭代算法往往在每一次迭代中都使用前一次迭代的结果来计算新的值,直到满足收敛条件。

迭代算法在数值计算中有广泛的应用,其中最著名的应用之一是求解非线性方程的根。

非线性方程是指方程中包含未知数的幂、指数、对数等非线性项的方程。

对于非线性方程,往往不存在解析解,因此需要借助迭代算法来进行数值求解。

c语言mpi并行计算矩阵乘法

C语言中的MPI(Message Passing Interface)是一种用于编写并行程序的标准,它允许多个进程在不同的计算节点上进行通信和协作。

矩阵乘法是一个经典的并行计算问题,可以通过MPI来实现并行化。

首先,我们需要将矩阵乘法的计算任务分配给不同的进程。

可以将两个矩阵分别分块,然后将这些块分配给不同的进程。

每个进程负责计算其分配到的部分,并将结果发送回主进程。

在C语言中,可以使用MPI库来实现这一过程。

首先,需要初始化MPI环境,并确定每个进程的编号和总进程数。

然后,主进程可以负责将矩阵分块并发送给其他进程,其他进程则接收并进行计算。

计算完成后,结果可以发送回主进程,由主进程进行汇总。

需要注意的是,在并行计算中,需要考虑数据通信的开销以及负载均衡等问题。

合理地分配任务和减少通信开销是并行计算中需要考虑的重要问题。

另外,还可以考虑使用一些优化技术来提高并行矩阵乘法的性

能,比如使用非阻塞通信、优化数据布局以减少通信量、使用多级并行等技术。

总之,使用C语言和MPI实现矩阵乘法的并行计算需要考虑任务分配、数据通信、性能优化等多个方面,需要综合考虑并合理设计并行算法。

高性能计算中并行矩阵运算技术的使用教程与性能评估概述高性能计算是通过使用并行计算技术来加速计算任务的处理速度。

其中,矩阵运算是高性能计算中的重要一环。

本文将介绍并行矩阵运算技术的使用教程,并提供性能评估的相关内容。

一、并行矩阵运算技术的基本原理并行矩阵运算技术利用计算机系统中的多个处理器或计算节点并行计算矩阵运算任务,以提高计算效率。

其基本原理可以归纳为以下几个方面:1.任务划分:将待运算的矩阵划分为多个小块,分配给不同的处理器或计算节点。

每个处理器或计算节点独立计算相应的小块,从而实现任务的并行处理。

2.数据通信:在任务划分后,处理器或计算节点之间需要进行数据通信,以传递所需的数据。

常见的通信方式包括点对点通信和集合通信。

3.任务调度:处理器或计算节点之间的任务调度是保证并行矩阵运算效率的关键。

合理的任务调度可以减少通信开销,提高并行计算的效率。

二、并行矩阵运算技术的使用教程以下将介绍并行矩阵运算技术的使用教程,包括任务划分、数据通信、任务调度等方面的内容。

1. 任务划分任务划分是并行矩阵运算技术的重要一环。

通常情况下,将矩阵均匀地划分为多个小块是常用的策略。

具体步骤如下:(1)确定矩阵的维度:首先确定待运算的矩阵的维度,如N×N。

(2)确定划分的方式:根据计算资源的分配情况和任务的复杂度,选择适当的划分方式,如按行划分、按列划分或按块划分等。

(3)划分矩阵:根据选择的划分方式,将矩阵划分为若干个小块,分配给不同的处理器或计算节点。

2. 数据通信数据通信是并行矩阵运算中的关键步骤,用于在处理器或计算节点之间传递所需的数据。

以下是几种常见的数据通信方式:(1)点对点通信:在点对点通信中,两个处理器或计算节点之间进行数据交换。

常见的通信方式包括发送和接收操作,用于在处理器之间传递所需的数据。

(2)集合通信:集合通信用于在多个处理器或计算节点之间进行数据的全局交换。

常见的集合通信操作包括广播、散射、聚集和规约等。

矩阵相乘-并行算法LT行度。

对于一个n×n的方阵,棋盘划分最多可以使用n^2个处理器进行并行计算,但使用按行或列分解最多可以使用n个。

对矩阵相乘采用棋盘式划分的算法通常称作Cannon算法。

A)行列划分又叫带状划分(Striped Partitioning),就是将矩阵整行或者整列分成若干个组,每个组指派给一个处理器。

下图所例为4个CPU,8×8矩阵的带状划分。

在带状划分情况下,每个CPU将会均匀分配到2行(列)数据。

8×8矩阵变成了一个1×4或4×1的分块矩阵,每个CPU所属的分块矩阵大小为8×2或2×8。

B)棋盘划分就是将矩阵分成若干个子矩阵,每个子矩阵指派给一个处理器,此时任一处理器均不包含整行或者整列。

下图所示即为4个处理器情况下8×8矩阵的棋盘划分,其中处理器阵列为2×2,每个处理器分配到的子矩阵大小为4×4。

矩阵划分成棋盘状可以和处理器连成二维网孔相对应。

对于一个n×n维矩阵和p×p的二维处理器阵列,每个处理器均匀分配有(n/p)×(n/p)=n^2/p^2个元素。

使用棋盘式划分的矩阵相乘算法一般有两种,Cannon算法和Summa算法。

SUMMA算法能够计算m*l的A矩阵和l*n的B矩阵相乘(m、l、n可不相等),而cannon算法只能实现n*n的A矩阵和n*n的B矩阵相乘,具有很大的局限性。

3.2、算法原理A) 行划分法假设是M*N,计算前,将矩阵N发送给所有从进程,然后将矩阵M分块,将M中数据按行分给各从进程,在从进程中计算M中部分行数据和N的乘积,最后将结果发送给主进程。

这里为了方便,有多少进程,就将M分了多少块,除最后一块外的其他数据块大小都相等,最后一块是剩下的数据,大小大于等于其他数据块大小,因为矩阵行数不一定整除进程数。

最后一块数据在主进程中计算,其他的在从进程中计算。

超级计算技术中的并行算法与矩阵运算在现代科学和工程领域中,超级计算技术发挥着至关重要的作用。

为了解决复杂问题,超级计算机采用了并行算法和矩阵运算等技术,以实现高效的计算和分析。

本文将探讨超级计算技术中的并行算法和矩阵运算,并分析其应用与发展趋势。

首先,我们来了解一下超级计算技术中的并行算法。

并行算法是指将复杂的计算任务分解成多个子任务,然后并发地运行于多个计算单元上,以提高计算效率和性能。

并行算法的设计需要考虑任务分解、通信和同步等关键问题。

常用的并行算法包括分治法、并行排序和并行搜索等。

对于矩阵运算来说,超级计算技术也发挥着重要的作用。

矩阵运算是指对矩阵进行基本的数学运算,诸如加法、减法、乘法和求逆等。

这些矩阵运算在科学计算、图像处理和人工智能等领域中广泛应用。

超级计算技术能够利用并行算法加速矩阵运算的速度,提高计算效率。

在超级计算技术中,矩阵乘法是一种常见且重要的矩阵运算。

矩阵乘法的基本思想是将两个矩阵相乘,得到一个新的矩阵。

然而,传统的矩阵乘法算法在大规模矩阵计算时效率较低,因此需要并行算法的支持。

并行矩阵乘法算法采用了多种策略,如按块分配、循环分配和网络划分等,以充分利用计算资源。

除了矩阵乘法,超级计算技术还可以应用于其他矩阵运算,如矩阵分解和特征值计算等。

矩阵分解是将一个矩阵分解成多个部分矩阵的过程,常见的矩阵分解包括LU分解、QR分解和SVD分解。

这些分解可以帮助我们更好地理解和处理复杂的数学问题。

而特征值计算则是计算一个矩阵的特征值和特征向量,对于解决线性方程组和优化问题都具有重要意义。

随着科学技术的不断发展,超级计算技术中的并行算法和矩阵运算也在不断演进。

首先,随着计算单元和存储器的不断增加,我们可以使用更大规模的矩阵进行计算,从而解决更加复杂的科学问题。

其次,新的并行算法和矩阵运算技术的提出,使得超级计算机能够更快速地处理大规模数据,实现更高效的计算。

最后,超级计算技术的发展也推动了云计算和人工智能等领域的进步,使得计算资源得到充分利用。

GPU并行库矩阵运算是一种高性能计算的方法,它利用了GPU 的并行计算能力,在处理大规模矩阵运算时具有明显的优势。

在本文中,将对GPU并行库矩阵运算进行详细阐述。

一、GPU并行计算原理GPU的并行计算能力主要来自于其大量的处理单元和内存带宽。

GPU的处理器结构通常分为多个流处理器,每个流处理器由多个CUDA核心组成。

这些CUDA核心可以同时执行相同的指令,从而实现并行计算。

此外,GPU还配备了高速的内存,能够快速读取和写入数据,从而保证数据的高效传输。

二、矩阵运算概述矩阵是一种常见的数据结构,广泛应用于数学、物理、工程等领域。

矩阵运算是指对矩阵进行加减乘除等数学运算的过程。

在实际应用中,往往需要处理大规模的矩阵,这就需要借助GPU的并行计算能力进行高效处理。

三、GPU并行库矩阵运算实现1、选择适当的并行库在实现GPU并行库矩阵运算时,需要选择适当的并行库。

当前比较常用的GPU并行库有CUDA、OpenCL、ROCm等。

其中,CUDA是由NVIDIA公司开发的GPU编程平台,具有广泛的应用和强大的支持。

因此,在实际应用中,CUDA是最为常见的选择。

2、GPU并行库矩阵加法矩阵加法是指将两个矩阵按元素相加得到一个新的矩阵。

在GPU并行库中,可以利用线程块和线程的并行计算能力,将矩阵加法分配到不同的线程上进行计算。

具体实现时,可以将每个线程块负责处理一部分数据,然后将结果写入到全局内存中。

这样就可以充分利用GPU的并行计算能力,提高矩阵加法的计算效率。

3、GPU并行库矩阵乘法矩阵乘法是指将两个矩阵相乘得到一个新的矩阵。

在GPU并行库中,可以采用类似于矩阵加法的方式,将矩阵乘法分配到不同的线程上进行计算。

具体实现时,可以将每个线程块负责处理一部分数据,然后将结果写入到全局内存中。

在实现过程中,需要注意线程块的大小和矩阵的维度关系,从而充分利用GPU的并行计算能力,提高矩阵乘法的计算效率。

四、GPU并行库矩阵运算应用实例在实际应用中,GPU并行库矩阵运算具有广泛的应用。

超级计算技术中的并行计算算法介绍超级计算技术在当前信息时代发挥着越来越重要的作用,它通过高速的计算和数据处理能力,解决了许多科学、工程和商业领域中的复杂问题。

而并行计算算法作为超级计算技术的核心,扮演着关键的角色。

本文将介绍超级计算技术中的并行计算算法,包括数据并行、任务并行和管道并行等常见的算法类型。

首先,我们来介绍数据并行算法。

数据并行算法是指将大规模数据划分为小块,分配给多个处理器同时处理的算法。

其中最常见的是矩阵乘法算法。

在这个算法中,将两个大型矩阵划分为若干个小矩阵,并将这些小矩阵分配到多个处理器上进行计算。

每个处理器负责计算自己所分配的小矩阵的部分,并将结果返回。

最后,将这些局部结果进行合并,得到最终的矩阵乘积。

数据并行算法的优势在于可以充分利用多个处理器的计算能力,加快计算速度。

其次,任务并行算法是指将大型任务划分为多个子任务,分配到不同的处理器上同时执行的算法。

每个子任务可以是相同的也可以是不同的,它们可以独立地执行。

一个经典的例子是并行搜索算法。

在这个算法中,将搜索任务划分成若干个子任务,每个子任务在不同的处理器上搜索不同的部分。

当一个子任务找到目标时,它会立即通知其他的子任务,从而提高搜索的效率。

任务并行算法的优势在于可以充分利用多个处理器的并行执行能力,提高整体的处理速度。

最后,管道并行算法将大型任务划分为多个连续的阶段,每个阶段由一个处理器负责。

每个处理器在完成自己的阶段后,将结果传递给下一个处理器,形成连续的任务流水线。

一个常见的应用是图像处理。

在这个算法中,图像处理任务通常包括多个连续的阶段,如图像读取、预处理、滤波和后处理等。

每个阶段由不同的处理器完成,并将结果传递给下一个处理器。

管道并行算法的优势在于可以并行地执行多个任务,并充分利用处理器的处理速度。

总结来说,超级计算技术中的并行计算算法包括数据并行、任务并行和管道并行等多种类型。

数据并行算法适用于大规模数据的并行计算,任务并行算法适用于大型任务的并行执行,而管道并行算法适用于连续的多阶段任务的并行处理。

引言21世纪是一个人类文明飞速发展的世纪,随着科学技术的飞速发展,需处理的信息量正成倍的增加,从而需要更大的存储空间及更快更好的信息处理方式。

本世纪应用最广贡献最大的当属计算机。

计算速率快计算精确度高是它的主要特点。

从最初的冯·诺依曼计算机到现在的超级计算机,虽然计算机发展的速度飞快,但对于越来越大的信息处理需求,单机的性能已经远远不能满足我们这个信息时代飞速发展的需求。

正如乱世出英雄,并行计算在这样一个时间就是一切的时代开始大放光彩,成为推动社会发展的强大动力。

一.并行计算的定义并行计算(Parallel Computing)是指同时使用多种计算资源解决计算问题的过程,是提高计算机系统计算速度和处理能力的一种有效手段。

它的基本思想是用多个处理器来协同求解同一问题,即将被求解的问题分解成若干个部分,各部分均由一个独立的处理机来并行计算。

并行计算系统既可以是专门设计的、含有多个处理器的超级计算机,也可以是以某种方式互连的若干台独立计算机构成的集群。

N台计算机应该能够提供N倍计算能力,不论当前计算机的速度如何,都可以期望被求解的问题在1/N的时间内完成,这便是并行计算的最初基于的想法。

显然,这只是一个理想的情况,因为被求解的问题在通常情况下都不可能被分解为完全独立的各个部分,而是需要进行必要的数据交换和同步。

尽管无法达到理想状态下的情况,但并行计算仍可使整个计算机系统的性能得到实质性的改进,其改进的程度则取决于欲求解问题本身的并行程度。

为执行并行计算,计算资源应包括一台配有多处理机(并行处理)的计算机、一个与网络相连的计算机专有编号,或者两者结合使用。

二.并行计算的优点和工作原理并行计算能快速解决大型且复杂的计算问题。

此外还能利用非本地资源,节约成本― 使用多个“廉价”计算资源取代大型计算机,同时克服单个计算机上存在的存储器限制。

为提高计算效率,并行计算处理问题一般分为以下三步:(1)将工作分离成离散独立部分,有助于同时解决;(2)同时并及时地执行多个程序指令;(3)将处理完的结果返回主机经一定处理后显示输出。