SPSS关联模型步骤

- 格式:docx

- 大小:773.57 KB

- 文档页数:18

多因素logistic回归分析spssLogistic回归分析是一种用来研究影响离散变量的因素的方法,该方法的输出是一个logistic模型,这一模型可以用于预测变量的值,即预测该变量的值有多高的概率会取各种可能的取值。

简言之,logistic回归分析的主要目的是把客观的结果(例如,是否改变某个政策,是否感染某种疾病等)变成可预测的离散变量,以便分析影响客观结果的各种因素。

Spss可以提供多因素logistic回归分析,这种分析可用于识别影响离散变量(例如,是否改变某个政策,是否感染某种疾病等)的多个因素之间的关联。

该分析需要有一个组合变量作为自变量,以及一个离散变量作为因变量。

例如,如果您要研究性别和年龄两个因素如何影响某种疾病的发生率,那么性别和年龄两个因素就是组合变量,而疾病的发生率则是因变量。

1.建立变量和分类(上述示例中需要建立性别和年龄两个变量,以及分类变量的可能的取值)。

2.执行logistic回归分析。

打开spss,并在“分析”菜单中打开多元分析,然后点击“逻辑回归”,并选择您要研究的变量和分类。

3.生成回归模型和检验其统计学意义。

在spss中,您可以使用类似“回归系数”之类的描述性统计学方法来估算回归模型,并可以使用“p-值”来判断回归模型中各变量的统计学意义。

4.Interpret模型。

根据p值判断各变量的统计学意义,进而分析影响离散变量的多个因素之间的关联。

四、总结Logistic回归分析是一种用来研究影响离散变量的因素的方法,spss可以提供多因素logistic回归分析,这种分析可用于识别影响离散变量的多个因素之间的关联,spss中步骤:建立变量和分类,执行logistic回归分析,生成回归模型和检验其统计学意义,Interpret模型。

SPSS非参数检验之一卡方检验一、卡方检验的概念和原理卡方检验是一种常用的非参数检验方法,用于检验两个或多个分类变量之间的关联性。

它利用实际观察频数与理论频数之间的差异,来判断两个变量是否独立。

卡方检验的原理基于卡方分布,在理论上,如果两个变量是独立的,那么它们的观测频数应该等于理论频数。

卡方检验通过计算卡方值来度量观察频数与理论频数之间的差异程度,进而判断两个变量是否独立。

卡方值的计算公式为:卡方值=Σ((观察频数-理论频数)²/理论频数)其中,观察频数为实际观察到的频数,理论频数为理论上计算得到的频数。

二、卡方检验的步骤卡方检验的步骤包括以下几个方面:1.建立假设:首先需要建立原假设和备择假设。

原假设(H0)是两个变量之间独立,备择假设(H1)是两个变量之间存在关联。

2.计算理论频数:根据原假设和已知数据,计算出各组的理论频数。

3.计算卡方值:利用卡方值的计算公式,计算观察频数与理论频数之间的差异。

4.计算自由度:自由度的计算公式为自由度=(行数-1)*(列数-1)。

5.查表或计算P值:根据卡方值和自由度,在卡方分布表中查找对应的临界值,或者利用计算机软件计算P值。

6.判断结果:判断P值与显著性水平的关系,如果P值小于显著性水平,则拒绝原假设,认为两个变量存在关联;如果P值大于显著性水平,则接受原假设,认为两个变量是独立的。

三、卡方检验在SPSS中的应用在SPSS软件中,进行卡方检验的操作相对简单。

下面以一个具体的案例来说明:假设我们有一份数据,包括了男性和女性在健康习惯(吸烟和不吸烟)方面的调查结果。

我们想要检验性别与吸烟习惯之间是否存在关联。

1.打开SPSS软件,导入数据。

2.选择"分析"菜单,点击"拟合度优度检验"。

3.在弹出的对话框中,将两个变量(性别和吸烟习惯)拖入"因子"栏目中。

4.点击"统计"按钮,勾选"卡方拟合度"。

SPSS典型相关分析案例典型相关分析(Canonical Correlation Analysis,CCA)是一种统计方法,用于研究两组变量之间的相关性。

它可以帮助研究人员了解两组变量之间的关系,并提供有关这些关系的详细信息。

在SPSS中,可以使用典型相关分析来探索两个或多个变量之间的关系,并进一步理解这些变量如何相互影响。

下面我们将介绍一个典型相关分析的案例,以展示如何在SPSS中执行该分析。

案例背景:假设我们有一个医学研究数据集,包含30名患者的多个生物标记物和他们的疾病严重程度评分。

我们希望了解这些生物标记物与疾病严重程度之间的关系,并查看是否可以建立一个线性模型来预测疾病严重程度。

以下是执行这个案例的步骤:第1步:准备数据首先,我们需要准备数据,确保所有变量都是数值型。

在SPSS中,我们可以通过检查数据集的描述性统计信息或查看变量视图来做到这一点。

第2步:导入数据在SPSS中,我们可以通过选择菜单中的"File"选项,然后选择"Open"来导入数据集。

我们应该选择包含待分析数据的文件,并确保正确指定变量的类型。

第3步:执行典型相关分析要执行典型相关分析,我们可以选择菜单中的"Analyze"选项,然后选择"Canonical Correlation"。

在弹出的对话框中,我们应该选择我们希望研究的生物标记物变量和疾病严重程度评分变量。

然后,我们可以选择一些选项,如方差-协方差矩阵、相关矩阵和判别系数,并点击"OK"执行分析。

第4步:解释结果完成分析后,SPSS将提供几个输出表。

我们应该关注典型相关系数和标准化典型系数,以了解两组变量之间的关系。

我们可以使用这些系数来解释生物标记物如何与疾病严重程度相关联,并找到最重要的变量。

此外,我们还可以使用SPSS提供的其他统计结果来进一步解释模型的效果和预测能力。

SPSS关联模型步骤以下是使用SPSS进行关联模型的步骤:1. 导入数据:将需要分析的数据导入SPSS软件。

数据可以是在SPSS中创建的新数据集,也可以是从其他文件格式(如Excel、CSV等)导入的数据。

2.数据清理:对导入的数据进行清理,包括去除缺失值、异常值和重复值。

这些不规范的数据可能会影响到分析的准确性和可靠性。

3.确定研究目标:明确要研究的变量和问题,为进一步的分析做好准备。

例如,如果想了解一些变量和其他变量之间的相关性,可以将其设为因变量,其他变量设为自变量。

4.选择关联分析方法:根据研究目标和数据类型,选择适当的关联分析方法。

SPSS软件提供了多种关联分析方法,如相关系数分析、回归分析和因子分析等。

5.进行关联分析:根据所选的关联分析方法进行具体的分析。

例如,如果选择相关系数分析,可以通过选择“分析”菜单中的“相关”选项,然后选择相关系数类型(如皮尔逊相关系数或斯皮尔曼等级相关系数)和变量,进行相关性分析。

6.解释结果:完成关联分析后,需要解释和解读分析结果。

可以查看相关系数矩阵和散点图等图表,来帮助理解变量之间的关系。

对于回归分析,可以查看回归方程和系数,分析自变量对因变量的影响程度和方向。

8.模型预测和推断:根据建立的关联模型,可以进行变量的预测和推断。

通过输入自变量的值,可以预测因变量的概率或数值。

此外,还可以通过进行方差分析和假设检验等统计测试,对模型中的变量进行推断。

9.结果报告和解释:最后,将分析结果进行报告和解释,包括所使用的方法和假设、分析结果和结论。

为了更好地理解分析结果,可以使用图表和表格等可视化工具,使结果更加直观和易懂。

总之,SPSS关联模型是一种有力的统计工具,可以帮助研究人员探索变量之间的关系,并预测和推断未知的变量值。

根据上述步骤,使用SPSS进行关联模型分析可以使分析过程更加系统和准确。

关联模型构建步骤关联模型构建通常指的是在数据挖掘领域中,通过分析大量数据来发现不同变量(或项)之间的有趣关联、频繁模式或相关规则的过程。

以Apriori算法为例,构建关联模型的一般步骤如下:1.数据预处理:1)数据清洗:去除无关信息、缺失值填充或删除、异常值处理等。

2)数据转换:将数据转化为适合进行关联分析的形式,例如离散化处理。

2.确定最小支持度与置信度:1)最小支持度是项目集出现的频率下限,只有支持度大于这个阈值的项目集才被认为是频繁项集。

2)置信度是衡量规则可信程度的指标,即如果A发生,则B发生的概率。

3.生成频繁项集:1)应用Apriori性质或者FP-Growth算法等方法,从单个项开始逐步生成频繁项集。

2)根据设定的支持度阈值,过滤掉不满足条件的项集。

4.挖掘关联规则:1)从频繁项集中生成关联规则,对于每个频繁项集,计算其所有可能的后继项集的支持度和置信度。

2)只保留那些满足用户设置的置信度阈值的规则。

5.评估与解释结果:1)对挖掘出的关联规则进行排序和解读,找出最具有商业价值或研究意义的规则。

2)可能需要进一步优化,比如引入提升度、兴趣度等其他评价指标筛选规则。

6.应用与验证:将挖掘出的关联规则应用于实际业务场景中,如制定营销策略、优化库存管理等,并通过实际效果反馈来验证规则的有效性。

请注意,上述步骤是一个通用的关联规则学习过程,具体实施时会根据所使用的数据挖掘工具或软件(如SPSS Modeler、R语言、Python中的mlxtend库或pandas库等)以及实际问题的需求来进行调整。

相关分析和回归分析SPSS实现SPSS(统计包统计分析软件)是一种广泛使用的数据分析工具,在相关分析和回归分析方面具有强大的功能。

本文将介绍如何使用SPSS进行相关分析和回归分析。

相关分析(Correlation Analysis)用于探索两个或多个变量之间的关系。

在SPSS中,可以通过如下步骤进行相关分析:1.打开SPSS软件并导入数据集。

2.选择“分析”菜单,然后选择“相关”子菜单。

3.在“相关”对话框中,选择将要分析的变量,然后单击“箭头”将其添加到“变量”框中。

4.选择相关系数的计算方法(如皮尔逊相关系数、斯皮尔曼等级相关系数)。

5.单击“确定”按钮,SPSS将计算相关系数并将结果显示在输出窗口中。

回归分析(Regression Analysis)用于建立一个预测模型,来预测因变量在自变量影响下的变化。

在SPSS中,可以通过如下步骤进行回归分析:1.打开SPSS软件并导入数据集。

2.选择“分析”菜单,然后选择“回归”子菜单。

3.在“回归”对话框中,选择要分析的因变量和自变量,然后单击“箭头”将其添加到“因变量”和“自变量”框中。

4.选择回归模型的方法(如线性回归、多项式回归等)。

5.单击“统计”按钮,选择要计算的统计量(如参数估计、拟合优度等)。

6.单击“确定”按钮,SPSS将计算回归模型并将结果显示在输出窗口中。

在分析结果中,相关分析会显示相关系数的数值和统计显著性水平,以评估变量之间的关系强度和统计显著性。

回归分析会显示回归系数的数值和显著性水平,以评估自变量对因变量的影响。

值得注意的是,相关分析和回归分析在使用前需要考虑数据的要求和前提条件。

例如,相关分析要求变量间的关系是线性的,回归分析要求自变量与因变量之间存在一定的关联关系。

总结起来,SPSS提供了强大的功能和工具,便于进行相关分析和回归分析。

通过上述步骤,用户可以轻松地完成数据分析和结果呈现。

然而,分析结果的解释和应用需要结合具体的研究背景和目的进行综合考虑。

如何使用SPSS作数据分析SPSS(Statistical Package for the Social Sciences)是一种常用的统计分析软件,广泛应用于社会科学领域的数据分析。

本文将介绍如何使用SPSS进行数据分析的基本步骤和常用功能。

一、数据导入与清洗在使用SPSS进行数据分析之前,首先需要将数据导入软件,并对数据进行清洗,确保数据的准确性和完整性。

以下是数据导入与清洗的步骤:1. 打开SPSS软件,并创建一个新的数据文件。

2. 选择导入数据的方式,可以是从Excel、csv等格式导入,也可以手动输入数据。

3. 导入数据后,检查数据是否包含缺失值或异常值。

可以使用SPSS的数据清洗工具进行处理,比如删除缺失值或替代为合适的值。

4. 检查数据的变量类型,确保每个变量的类型正确,比如分类变量、连续变量等。

5. 对需要的变量进行重命名,并添加变量标签,便于后续分析的理解和解释。

二、数据描述统计分析数据描述统计是对数据的基本特征进行概括和描述的分析方法。

SPSS提供了丰富的数据描述统计功能,如均值、标准差、频数分布等。

以下是数据描述统计分析的步骤:1. 运行SPSS软件,打开已经导入并清洗好的数据文件。

2. 选择"统计"菜单下的"描述统计"选项。

3. 在弹出的对话框中,选择需要进行描述统计分析的变量,并选择所需的统计指标,如均值、标准差等。

4. 点击"确定"进行计算,SPSS将输出所选变量的描述统计结果,包括均值、标准差、中位数等。

三、相关性分析相关性分析用于衡量两个或多个变量之间的相关程度,常用于探究变量之间的关系。

SPSS提供了多种相关性分析方法,如皮尔逊相关系数、斯皮尔曼相关系数等。

以下是相关性分析的步骤:1. 打开已导入的数据文件。

2. 选择"分析"菜单下的"相关"选项。

3. 在弹出的对话框中,选择需要进行相关性分析的变量,并选择所需的相关系数方法。

S P S S关联模型步骤精选文档TTMS system office room 【TTMS16H-TTMS2A-TTMS8Q8-SPSS Clementines 预测分析模型----啤酒+尿片故事的实现机理(使用11版本实现)SPSS Clenmentines提供众多的预测模型,这使得它们可以应用在多种商业领域中:如超市商品如何摆放可以提高销量;分析商场营销的打折方案,以制定新的更为有效的方案;保险公司分析以往的理赔案例,以推出新的保险品种等等,具有很强的商业价值。

超市典型案例如何摆放超市的商品引导消费者购物从而提高销量,这对大型连锁超市来说是一个现实的营销问题。

关联规则模型自它诞生之时为此类问题提供了一种科学的解决方法。

该模型利用数据挖掘的技术,在海量数据中依据该模型的独特算法发现数据内在的规律性联系,进而提供具有洞察力的分析解决方案。

通过一则超市销售商品的案例,利用“关联规则模型”,来分析商品交易流水数据,以其发现合理的商品摆放规则,来帮助提高销量。

关联规则简介关联规则的定义关联规则表示不同数据项目在同一事件中出现的相关性,就是从大量数据中挖掘出关联规则。

有关数据挖掘关联规则的具体理论依据这里不做详细讲解,大家可以参看韩家炜的数据挖掘概论。

为了更直观的理解关联规则,我们首先来看下面的场景。

一个市场分析人员经常要考虑这样一个问题:哪些商品是频繁被顾客同时购买的?顾客1:牛奶+面包+谷类顾客2:牛奶+面包+糖+鸡蛋顾客3:牛奶+面包+黄油顾客4:糖+鸡蛋以上的情景类似于当年沃尔玛做的市场调查:啤酒+尿片摆放在同一个货架上,销售业绩激增的着名关联规则应用。

市场分析员分析顾客购买商品的场景,顾客购买面包同时也会购买牛奶的购物模式就可用以下的关联规则来描述:面包 => 牛奶 [ 支持度 =2%, 置信度 =60%] (式 1)式 1中面包是规则前项(Antecedent),牛奶是规则后项 (Consequent)。

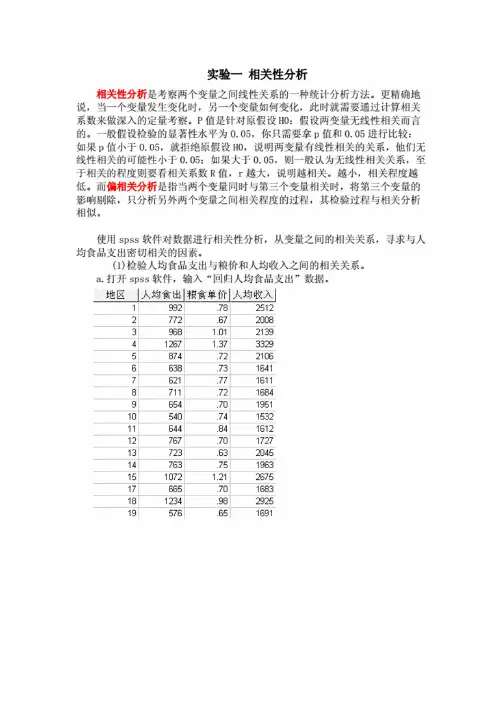

实验一相关性分析相关性分析是考察两个变量之间线性关系的一种统计分析方法。

更精确地说,当一个变量发生变化时,另一个变量如何变化,此时就需要通过计算相关系数来做深入的定量考察。

P值是针对原假设H0:假设两变量无线性相关而言的。

一般假设检验的显著性水平为0.05,你只需要拿p值和0.05进行比较:如果P值小于0.05,就拒绝原假设H0,说明两变量有线性相关的关系,他们无线性相关的可能性小于0.05:如果大于0.05,则一般认为无线性相关关系,至于相关的程度则要看相关系数R值,r越大,说明越相关。

越小,相关程度越低。

而偏相关分析是指当两个变量同时与第三个变量相关时,将第三个变量的影响剔除,只分析另外两个变量之间相关程度的过程,其检验过程与相关分析相似。

使用spss软件对数据进行相关性分析,从变量之间的相关关系,寻求与人均食品支出密切相关的因素。

(1)检验人均食品支出与粮价和人均收入之间的相关关系。

a.打开spss软件,输入“回归人均食品支出”数据。

地区1|人均食出|粮食单价|人均收入|1992.7825122772.6720083968 1.01213941267 1.3733295874.7221066638.7316417621.7716118711.7216849654.70195110540.74153211644.84161212767.70172713723.63204514763.751963151072 1.21267517665.701683181234.98292519576.65169120733.84192921968 1.49203222717.80190623716.72170524627.61154225829.701987261016 1.04235926650.78176427928 1.01208728650.83195929852.72210130609.681877b.在 spss 的菜单栏中选择点击 Analyze —correlate — Bivariate,弹出一个对话窗口。

数学建模SPSS双变量相关性分析

关键词:数学建模相关性分析SPSS

摘要:在数学建模中,相关性分析是很重要的一部分,尤其是在双变量分析时,要根据变量之间的联系建立评价指标,并且通过这些指标来进行比对赋值而做出评价结果。

本文由数学建模中的双变量分析出发,首先阐述最主要的三种数据分析:Pearson系数,Spearman系数和Kendall系数的原理与应用,再由实际建模问题出发,阐述整个建模过程和结果。

r s=

∑(P i−P ave)(Q i−Q ave)√∑(P i−P ave)2(Q i−Q ave)2

在SPSS中打开数据,点击:分析—>相关—>双变量,打开对话窗口,选择需要分析的两个变量、Spearman秩相关系数分析以及双侧检验。

需要说明两点:

(1)因各体重与各体质数据之间的相关性正负未知,需选用双侧检验;

(2)除了数据满足非正态分布以外,Spearman秩相关系数分析还需要数据分级,以计算秩。

但在SPSS中程序会自动生成秩,无需再手动分级。

注意要保证总体相关系数ρ与样本相关系数r保持一致,还须考虑Sig值。

由数据,Sig<0.5表示接受原假设,即Rho>|r|。

Sig<0.5则拒绝原假设,两者不相关。

而r值则代表了正负相关性,以及相关性大小。

结果见表。

表一、关于顾客满意调查数据的收集本次问卷调研的对象为居住在某大学校内的各类学生(包括全日制本科生、全日制硕士和博士研究生),并且近一个月内在校内某超市有购物体验的学生。

调查采用随机拦访的方式,并且为避免样本的同质性和重复填写,按照性别和被访者经常光顾的超市进行控制。

问卷内容包括7个潜变量因子,24项可测指标,7个人口变量,量表采用了Likert10级量度,如对1正向的,采用Likert10级量度从“非常低”到“非常高”二、缺失值的处理采用表列删除法,即在一条记录中,只要存在一项缺失,则删除该记录。

最终得到401条数据,基于这部分数据做分析。

三、数据的的信度和效度检验1.数据的信度检验信度(reliability)指测量结果(数据)一致性或稳定性的程度。

一致性主要反映的是测验内部题目之间的关系,考察测验的各个题目是否测量了相同的内容或特质。

稳定性是指用一种测量工具(譬如同一份问卷)对同一群受试者进行不同时间上的重复测量结果间的可靠系数。

如果问卷设计合理,重复测量的结果间应该高度相关。

由于本案例并没有进行多次重复测量,所以主要采用反映内部一致性的指标来测量数据的信度。

折半信度(split-half reliability)是将测量工具中的条目按奇偶数或前后分成两半,采用Spearman-brown公式估计相关系数,相关系数高提示内部一致性好。

然而,折半信度系数是建立在两半问题条目分数的方差相等这一假设基础上的,但实际数据并不一定满足这一假定,因此信度往往被低估。

Cronbach在1951年提出了一种新的方法(Cronbach's Alpha系数),这种方法将测量工具中任一条目结果同其他所有条目作比较,对量表内部一致性估计更为慎重,因此克服了折半信度的缺点。

本章采用SPSS16.0研究数据的内部一致性。

在Analyze菜单中选择Scale下的Reliability Analysis(如图7-1),将数据中在左边方框中待分析的24个题目一一选中,然后点击,左边方框中待分析的24个题目进入右边的items方框中,使用Alpha 模型(默认),得到图7-2,然后点击ok即可得到如表7-3的结果,显示Cronbach's Alpha系数为0.892,说明案例所使用数据具有较好的信度。

定性数据的建模分析含SPSSSPSS(统计分析软件)是一个强大的数据分析工具,可以用于处理和分析各种数据类型,包括定性数据。

定性数据是指描述性或标称性的数据,可以通过分类或标记来表示。

在使用SPSS进行定性数据的建模分析时,通常会采用以下步骤:2.变量设定:根据问题的需要,将定性变量定义为分类变量。

在SPSS中,可以将定性变量设置为名义尺度或有序尺度,以便进行后续的分析。

3.描述性统计分析:使用SPSS的统计功能,可以计算出定性变量的各个类别的频数、比例、平均值等。

这些描述性统计分析可以帮助我们了解定性数据的分布情况和整体趋势。

4.单一样本假设检验:如果我们想要分析定性变量的一些类别是否与总体均值或一些预设值有显著差异,可以使用SPSS的单一样本假设检验功能。

这可以帮助我们确定一些类别的重要性或影响力。

5.交叉分析和卡方检验:交叉分析可以帮助我们研究两个或更多变量之间的关系。

在SPSS中,可以使用交叉表和卡方检验来计算出不同类别之间的关联性和显著性。

6.因子分析:如果我们想要找出影响定性变量的主要因素或维度,可以使用SPSS的因子分析功能。

因子分析可以帮助我们将多个相关变量合并成几个较为独立的维度。

7.多元逻辑回归分析:多元逻辑回归分析可以帮助我们了解定性变量对一些二元结果变量的影响。

在SPSS中,可以使用逻辑回归功能建立模型,并得出各个变量的回归系数和显著性。

8.建立预测模型:如果我们希望根据定性变量来预测一些连续变量的值,可以使用SPSS的预测建模工具,比如线性回归、岭回归、决策树等。

以上是使用SPSS进行定性数据建模分析的基本步骤。

通过这些分析,我们可以深入了解定性数据的特征和关联性,并可以进行预测和决策支持。

需要注意的是,分析结果只是从给定数据中推断出的结论,需要结合实际情况进行解释和应用。

spss相关性分析SPSS相关性分析在统计学领域中起着重要的作用。

通过该方法,我们可以了解两个或多个变量之间是否存在某种关联、这种关联的强度如何,以及这种关联是否具有统计学上的显著性。

相关性分析可以帮助我们理解变量之间的关系,并为我们提供基础数据来进行更深入的研究和预测。

本文将重点讨论SPSS相关性分析的原理、使用方法和结果解读。

首先,我们来了解一下相关性的概念。

相关性是指两个或多个变量之间的关系程度。

当两个变量的值在一定程度上随着彼此的变化而变化时,我们就说它们之间存在相关关系。

相关性的强度可以从零到一之间的相关系数来衡量,其中零表示无关,一表示完全正相关,负一表示完全负相关。

SPSS是一款功能强大的统计软件,具有广泛的应用领域。

在进行相关性分析之前,我们需要确保数据已经导入SPSS中,并且变量是数值型的。

接下来,我们可以按照以下步骤进行相关性分析。

第一步是选择相关性分析。

在SPSS软件中,我们可以通过导航菜单选择“分析”->“相关”->“二变量”来进行分析。

第二步是选择变量。

在相关性分析中,我们需要选择需要进行分析的两个变量。

可以通过将变量从“可用变量”框中拖动到“相关变量”框中来选择变量。

第三步是确定其他选项。

在进行相关性分析之前,我们可以选择一些其他选项来获取更多的统计信息。

比如,我们可以选择“描述性统计”,以获得平均值、标准差等信息。

我们还可以选择“双尾检验”或“单尾检验”来确定相关关系的显著性。

第四步是进行分析和解读结果。

一旦我们完成了选择变量和其他选项,就可以点击“确定”按钮开始进行分析。

SPSS会生成相关系数和p值,用于衡量两个变量之间的关系和显著性。

相关系数的取值范围为-1到1,接近-1表示负相关,接近1表示正相关,接近0表示无相关。

p值小于0.05被认为是显著的,这意味着两个变量之间的关系不是由于偶然发生的。

通过以上步骤,我们可以在SPSS中进行相关性分析,并获得相关系数和显著性水平。

灰色预测模型可针对数量非常少(比如仅4个),数据完整性和可靠性较低的数据序列进行有效预测,其利用微分方程来充分挖掘数据的本质,建模所需信息少,精度较高,运算简便,易于检验,也不用考虑分布规律或变化趋势等。

但灰色预测模型一般只适用于短期预测,只适合指数增长的预测,比如人口数量,航班数量,用水量预测,工业产值预测等。

灰色预测模型有很多,G M(1,1)模型使用最为广泛。

灰色关联预测分析G M(1,1)通常可分为以下四个步骤:(1)级比值检验此步骤目的在于数据序列是否有着适合的规律性,是否可得到满意的模型等,该步骤仅为初步检验,意义相对较小。

(2)后验差比检验在进行模型构建后,会得到后验差比C值,该值为残差方差/数据方差;其用于衡量模型的拟合精度情况,C值越小越好,一般小于0.65即可。

(3)模型拟合和预测进行模型构建后得到模型拟合值,以及最近12期的预测值。

(4)模型残差检验模型残差检验为事后检验法。

主要查看相对误差值和级比偏差值。

相对误差值=预测拟合值与残差值的差值绝对值/原始值。

相对误差值越小越好,一般情况下小于20%即说明拟合良好。

级比偏差值也用于衡量拟合情况和实际情况的偏差,一般该值小于0.2即可。

一、研究背景取某地1986年~1992共7年的道路交通噪声平均声级数据进行预测。

二、操作步骤选择【综合评价】--【灰色预测模型】。

将指标项放入分析框中,点击开始分析。

灰色模型预测三、结果解读(1)G M(1,1)模型级比值表格首先,计算级比值,级比值介于区间[0.982,1.0098]时说明数据适合模型构建。

从上表可知,针对城市交通噪声/d B(A)进行G M(1,1)模型构建,结果显示:级比值的最大值为1.010,在适用范围区间[0.982,1.0098]之外,意味着本数据进行G M(1,1)可能得不到满意的模型。

但从数据来看,1.01非常接近于1.0098,因此有理由接着进行建模。

(2)后验差比检验后验差比C值用于模型精度等级检验,该值越小越好,一般C值小于0.35则模型精度等级好,C值小于0.5说明模型精度合格,C值小于0.65说明模型精度基本合格,如果C值大于0.65,则说明模型精度等级不合格。

SPSSClementines 预测分析模型----啤酒+尿片故事的实现机理(使用11版本实现)SPSSClenmentines 提供众多的预测模型,这使得它们可以应用在多种商业领域中:如超市商品如何摆放可以提高销量;分析商场营销的打折方案,以制定新的更为有效的方案;保险公司分析以往的理赔案例,以推出新的保险品种等等,具有很强的商业价值。

超市典型案例如何摆放超市的商品引导消费者购物从而提高销量,这对大型连锁超市来说是一个现实的营销问题。

关联规则模型自它诞生之时为此类问题提供了一种科学的解决方法。

该模型利用数据挖掘的技术,在海量数据中依据该模型的独特算法发现数据内在的规律性联系,进而提供具有洞察力的分析解决方案。

通过一则超市销售商品的案例,利用“关联规则模型”,来分析商品交易流水数据,以其发现合理的商品摆放规则,来帮助提高销量。

关联规则简介关联规则的定义关联规则表示不同数据项目在同一事件中出现的相关性,就是从大量数据中挖掘出关联规则。

有关数据挖掘关联规则的具体理论依据这里不做详细讲解,大家可以参看韩家炜的数据挖掘概论。

为了更直观的理解关联规则,我们首先来看下面的场景。

一个市场分析人员经常要考虑这样一个问题:哪些商品是频繁被顾客同时购买的?顾客1:牛奶+面包+谷类顾客2:牛奶+面包+糖+鸡蛋顾客3:牛奶+面包+黄油顾客4:糖+鸡蛋以上的情景类似于当年沃尔玛做的市场调查:啤酒+尿片摆放在同一个货架上,销售业绩激增的著名关联规则应用。

市场分析员分析顾客购买商品的场景,顾客购买面包同时也会购买牛奶的购物模式就可用以下的关联规则来描述:面包=> 牛奶[ 支持度=2%, 置信度=60%] (式1)式1中面包是规则前项(Antecedent),牛奶是规则后项(Consequent)。

实例数(Instances)表示所有购买记录中包含面包的记录的数量。

支持度(Support)表示购买面包的记录数占所有的购买记录数的百分比。

提供众多的预测模型,这使得它们可以应用在多种商业领域中:如超市商品如何摆放可以提高销量;分析商场营销的打折方案,以制定新的更为有效的方案;保险公司分析以往的理赔案例,以推出新的保险品种等等,具有很强的商业价值。

超市典型案例如何摆放超市的商品引导消费者购物从而提高销量,这对大型连锁超市来说是一个现实的营销问题。

关联规则模型自它诞生之时为此类问题提供了一种科学的解决方法。

该模型利用数据挖掘的技术,在海量数据中依据该模型的独特算法发现数据内在的规律性联系,进而提供具有洞察力的分析解决方案。

通过一则超市销售商品的案例,利用“关联规则模型”,来分析商品交易流水数据,以其发现合理的商品摆放规则,来帮助提高销量。

关联规则简介关联规则的定义关联规则表示不同数据项目在同一事件中出现的相关性,就是从大量数据中挖掘出关联规则。

有关数据挖掘关联规则的具体理论依据这里不做详细讲解,大家可以参看韩家炜的数据挖掘概论。

为了更直观的理解关联规则,我们首先来看下面的场景。

一个市场分析人员经常要考虑这样一个问题:哪些商品是频繁被顾客同时购买的?顾客1:牛奶+面包+谷类顾客2:牛奶+面包+糖+鸡蛋顾客3:牛奶+面包+黄油顾客4:糖+鸡蛋以上的情景类似于当年沃尔玛做的市场调查:啤酒+尿片摆放在同一个货架上,销售业绩激增的著名关联规则应用。

市场分析员分析顾客购买商品的场景,顾客购买面包同时也会购买牛奶的购物模式就可用以下的关联规则来描述:面包 => 牛奶 [ 支持度 =2%, 置信度 =60%] (式 1)式 1中面包是规则前项(),牛奶是规则后项 ()。

实例数()表示所有购买记录中包含面包的记录的数量。

支持度()表示购买面包的记录数占所有的购买记录数的百分比。

规则支持度()表示同时购买面包和牛奶的记录数占所有的购买记录数的百分比。

置信度()表示同时购买面包和牛奶的记录数占购买面包记录数的百分比。

提升()表示置信度与已知购买牛奶的百分比的比值,提升大于1 的规则才是有意义的。

关联规则式 1的支持度 2% 意味着,所分析的记录中的 2% 购买了面包。

置信度 60% 表明,购买面包的顾客中的 60% 也购买了牛奶。

如果关联满足最小支持度阈值和最小置信度阈值,就说关联规则是有意义的。

这些阈值可以由用户或领域专家设定。

就顾客购物而言,根据以往的购买记录,找出满足最小支持度阈值和最小置信度阈值的关联规则,就找到顾客经常同时购买的商品。

此处进行关联规则应用可以使用两种数据格式:1,交易数据格式,2,表格格式。

1.交易格式123342.表格格式1 TFFF2 FTFF3 FTTF4 FFFT关联规则挖掘算法、和序列节点是常用的关联规则挖掘算法,它们都可以使用交易格式和表格格式数据进行挖掘处理。

其中算法,处理速度快,对包含的规则数没有限制,是一种最有影响的挖掘关联规则的方法。

本次试验将使用11 自带的安装目录下的文件夹下的 1n 数据。

希望分析出哪些商品会和啤酒一起购买,以此来合理安排商品的摆放,进而提高啤酒的销量。

此数据属于表格格式数据,每条记录表示顾客的一次购物。

记录的字段包括卡号、顾客基本信息、付款方式和商品名称(每个商品一个字段 , 该商品字段值为 T, 表示购买该商品 , 值为 F 表示未购买,具体可参考表 2, 表格格式数据)。

商品名称都有(水果蔬菜),(生鲜肉),(奶制品),(罐装蔬菜),(罐装肉),(冻肉),(啤酒), (酒类),(软饮),(鱼), (甜食)。

首先打开,会出现一张空白的流界面,这时用户可以在里面创建自己的流。

第一步,为流添加一个数据节点,这里选择自带的数据。

将界面下方选项卡的“数据源”选项中的“可变文件”拖放到空白界面中,双击打开,在文件选项卡中选择自带的数据1n,如图所示。

点击确定按钮,这时就成功的创建了数据节点。

第二步,为流添加类型节点,类型节点是显示和设置数据每个字段的类型、格式和角色。

从界面下方的“字段选项”卡中,将“类型”节点拖放到界面中,接着将数据节点和类型节点连接起来,或者直接在“字段选项”卡中双击“类型”节点,将两者连接起来。

这时双击打开“类型”节点,此时“类型”节点中显示了数据的字段和其类型,点击“类型”节点界面上的“读取值”按钮,这时会将数据节点中的数据读取过来。

如下图所示。

接着可以为参与建模的数据字段设置角色,角色分“输入”,“目标”,“两者”和“无”。

输入表示该字段可供建模使用,目标表示该字段为建模的预测目标,两者表示该字段为布尔型的输入字段,无表示该字段不参与建模。

节点需要一个或多个输入字段和一个或多个目标字段,输入字段和输出字段必须是符号型字段。

在此可以选择一个或多个字段为目标字段,表明该模型的预测目标字段;对于建模节点,也可以不设置目标字段,则需要在建模节点中设置“后项”。

第三步,为流添加过滤节点,将不参与的字段排除在外。

该步骤为可选步骤。

从“字段选项”卡中选择“过滤”节点,并将其拖入到界面中,将“过滤”节点加入到流中。

双击打开“过滤”节点,在不参与建模字段的箭头上点击,会出现一个红叉,表示该字段被过滤掉了,不参与建模,如图所示。

对于一些与建模关系不大的节点可以将其过滤掉,比如卡号、性别、家乡和年龄字段。

第四步,有了这些前期的准备过程,接下来就可以开始创建关联规则模型节点了,在此之前,让我们先添加一个图形节点——网络节点,建立此节点的目的是为了让用户首先可以直观的看到商品之间的关联程度,有一个感性认识。

选择“图形”选项卡中的“网络”节点,将此拖入界面,将“网络”节点加入流中,与“过滤”节点连接起来。

双击打开网络节点,在“字段”列表中选择添加字段,可以将所有的商品字段添加进来;也可以点击“仅显示真值标志”,将只显示那些“两者”的字段,如图所示。

点击“选项”卡,进入选项设置,用户可以在此设置链接数量的显示范围,不显示一些链接数量低的链接,如图所示。

点击“运行”按钮,这时会生成一个商品之间关联程度(链接数量)的网络图,用户可以在下方的调节杆上调节链接数量的显示范围。

上图中,线的粗细和深浅代表联系的强弱,可以直观的看到和,联系程度比较强。

第五步,添加“建模”节点到流中,开始关联规则模型设置和使用的篇章。

首先点击界面下方“建模”选项卡,再点击,节点拖放到界面中,连接该节点到过滤节点上,或者双击节点。

接着设置节点的参数,建立关联规则模型。

双击打开节点,如下图所示。

该“字段”选项卡,是设置参与建模的字段和目标字段的,可以看到其中包括两个选项,“使用类型节点设置”和“使用定制设置”,这里将为用户分别呈现两种选项的使用方法。

这里无论选择哪个选项,都需要将市场分析员重点关注的商品包括在其中,其他商品可以不包括。

如果用户选择“使用定制设置”选项,则需要将啤酒设置在“后项”列表中,将其他重点关注的商品设置在“前项”列表中,如下图所示。

这里,分区允许您使用指定字段将数据分割为几个不同的样本,分别用于模型构建过程中的训练、测试和验证阶段。

如果设置了“分区”,除了在此选择分区字段外,还需要在“模型”选项卡中,勾上“使用分区数据”的选择框。

关于“分区”的概念、作用和使用方法,本文不做详细介绍。

除此,“使用事务处理格式”选择框,是针对于事务性数据的,如果数据为交易格式,需要勾上此选择框,但本示例的数据为表格格式,故无需选择。

设置好了字段后,点击“模型”选项卡,进入模型设置。

如下图所示。

用户可以在“模型名称”处为本模型设置一个名字,如果想使用分区功能,则需要勾上“使用分区数据”选项。

用户为规则模型设置一个最低条件支持度,那么模型将从所有规则中选择那些为真,并且其对应的记录的百分比大于此值的规则。

如果您获得的规则适用于非常小的数据子集,请尝试增加此设置。

接着,用户需要为模型设置一个最小规则置信度,表明正确预测的百分比。

置信度低于指定标准的规则将被放弃。

如果您获得的规则太多,请尝试增加此设置。

如果您获得的规则太少(甚至根本无法获得规则),请尝试降低此设置。

用户还可以为任何规则指定“最大前项数”。

这是一种用来限制规则复杂性的方式。

如果规则太复杂或者太具体,请尝试降低此设置。

对于“仅包含标志变量的真值”选项,如果对于表格格式的数据选择了此选项,则在生成的规则中只会出现真值。

这样使得规则更容易理解。

该选项不适用于事务格式的数据。

为了提高建模性能,设置了“优化”选项供用户选择。

选择“速度”可指示算法从不使用磁盘溢出,以便提高性能。

选择“内存”可指示算法在合适的时候,以牺牲某些速度为代价使用磁盘溢出。

接下来,进入“专家”选项卡,对于一般用户,则选择“简单”选项;而对于高级用户,则可以通过此页面进行微调,如下图所示。

此时,我们已经创建好了关联规则模型的整个流,点击工具栏的绿色箭头,运行该流,会生成一个“模型”节点,该节点里包含了模型运行结果。

整个运行后的流图,如下图所示。

第六步,在得到了运行结果后,我们双击打开生成的“模型”节点,点击“显示 / 隐藏标准菜单”下拉框,选择“显示所有”,结果如下图所示。

从结果可以看出,通过关联规则模型挖掘出了三个规则,分别是规则一,购买了冻肉()和罐装蔬菜()的顾客都会购买啤酒();其中,第一列代表结果,而下一列代表条件,后面的列包含规则信息,如置信度、支持度和提升等。

购买了冻肉和罐装蔬菜的顾客会购买啤酒,此规则中购买了冻肉和罐装蔬菜的记录有 173 条,占 17.3%。

而在购买了冻肉和罐装蔬菜的顾客中会有 84.393% 的顾客会购买啤酒,并且提升为2.88,表明此规则的相关性很强,部署能力和置信度类似,可以不考虑。

通过对规则信息的分析和了解,建议将置信度和提升作为选择规则的标准,因为置信度能反映出规则预测的准确程度,提升值越大,规则的相关性越强。

据此,可以将规则一作为分析结果。

结论因此可以将啤酒和冻肉、罐装蔬菜放在一起销售,这也正好和前面的网络节点图的显示相一致。

有了以上的方法和算法,我们可以解决诸如游戏商城内的道具礼包销售策略制定,橱窗道具位置摆放的问题,原本粗放的分析方式单一的通过销量和排行来制定策略和商城策略是不能真实反应用户的需求和心理。