粒子群优化与神经网络的结合

- 格式:ppt

- 大小:223.00 KB

- 文档页数:20

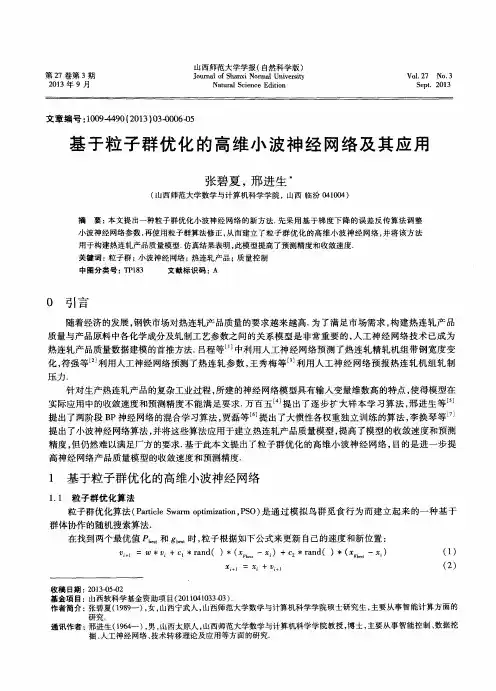

基于粒子群优化的BP神经网络【摘要】人工神经网络的优化学习是其研究中的一个重要课题。

将粒子群优化算法用于BP神经网络的学习,将粒子优化算法的全局搜索和BP神经网的局部搜索相结合,并设计一网络实例加以训练,达到了比较满意的效果。

【关键词】粒子群优化算法BP神经网络BP算法BP网络(Back Propagation Network)是用途最为广泛的一类神经网络,具有很强的信息处理能力。

但是,由于BP算法的基本思想是最小二乘法,采用的是梯度搜索技术,难免存在收敛速度慢、局部极小等问题。

粒子群优化算法(Particle Swarm Optimaziton,简称PSO )是由Kennedy J和Eberhart R C于1995年提出的一种优化算法,源于对鸟群和鱼群群体运动行为的研究。

由于其容易理解,易于实现,不要求目标函数和约束条件是可微的,并能以较大概率求得全局最优解,目前已在许多优化问题中得到成功应用。

由于它具有并行计算的特点,而且可以提高计算速度。

因此,可以用粒子群优化算法来优化BP网络。

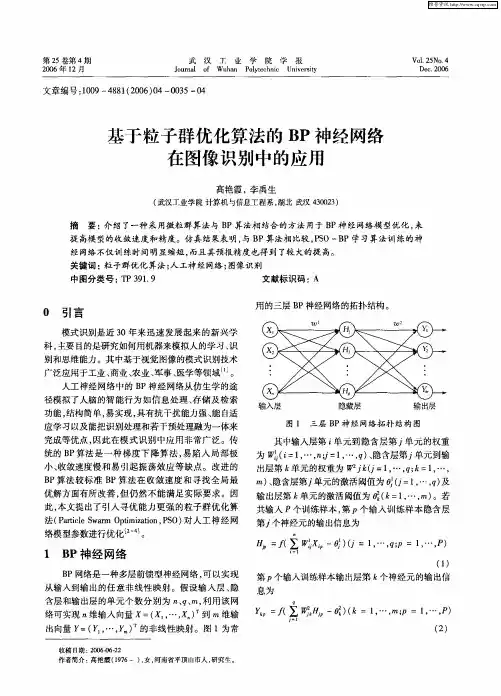

一、BP神经网络及其算法BP网络是一种具有三层或三层以上的单向传播的多层前馈网络,其拓扑结构如图1。

图1 拓扑结构图BP算法的执行步骤如下:(1)对各层权系数置一个较小Wij的非零随机数。

(2)输入一个样本X=(X1,X2,…,x n),以及对应期望输出) Y=(y1,y2,…,yn)。

(3)计算各层的输出。

对于第k 层第i个神经元的输出有:Uki=∑WijXk-1i,Xki=f(Uki)(一般为sigmoid 函数,即f(x)=1/(1-epx(-x))。

(4)求各层的学习误差dki。

对于输出层,有,k=m,dmi=Xmi(1-Xmi)(Xmi-Ymi)。

对于其他各层,有dxi=Xki(1-Xki)∑Wijdk+1i。

(5)修正权系数Wij。

Wij (t+1)=Wij-η•dki•Xk-1j。

粒子群算法与神经网络结合的优化算法研究随着人工智能和数据分析的快速发展,优化算法作为一种重要的数学方法,在各个领域中得到了广泛应用。

其中,粒子群算法和神经网络结合的优化算法,已经成为优化问题的一种新思路。

粒子群算法是一种优化算法,灵感来源于鸟群捕食的策略。

鸟群在进行捕食时,会根据周围环境和食物的分布情况,不断调整自己的方向和速度。

同样,粒子群算法中的“粒子”,也会根据周围其他粒子的信息和当前环境的优化目标,去更新自己所处的位置和速度。

神经网络作为另一种常用的数学方法,其本质是一种多层次的非线性函数。

神经网络通常被用来解决分类、识别和预测等问题。

其通过对输入变量的权重和偏差进行变化,不断调整模型参数,从而优化预测的准确性和泛化能力。

将这两种方法进行结合,即可形成一种有效的优化算法。

具体而言,粒子群算法可以用来寻找神经网络中的最优参数,从而提高模型的性能。

而神经网络则可以作为粒子群算法的优化目标,通过反馈神经网络预测误差,不断调整粒子的位置和速度。

这种结合方法的好处在于,能够同时利用粒子群算法的全局优化和神经网络的非线性优势。

在一些特定的优化问题中,甚至可以得到比单一方法更优秀的解决方案。

另外,在实际应用中,这种结合方法也有着很大的潜力。

例如,在智能物流中,可以运用粒子群算法从一堆货物中找出最优的装载方式,在这个过程中可以利用神经网络为每个货物进行分类,不断调整粒子,从而更好地进行装载。

在医学影像诊断中,可以利用神经网络对医学影像进行自动识别和分析,然后通过粒子群算法优化多个相关参数,从而提高诊断准确率。

总之,粒子群算法和神经网络结合的优化算法,在各个领域中有着重要的应用和价值。

虽然这种结合方法还处于起步阶段,但我们相信在不久的将来,它们将会得到更广泛的应用,并为我们带来更加稳健、高效和准确的优化算法。

arima-pso-lstm模型的基本原理

ARIMA-PSO-LSTM是一种将ARIMA模型、粒子群优化(Particle Swarm Optimization,PSO)和长短期记忆神经网络(Long Short-Term Memory,LSTM)结合起来的时间序列预

测模型。

ARIMA模型是一种经典的时间序列建模方法,通过对时间序

列数据的差分和自回归移动平均模型的拟合来预测未来的数值。

ARIMA模型适用于具有稳定的平均值和方差的时间序列数据。

PSO是一种启发式优化算法,模拟了鸟群觅食的行为,通过

迭代搜索最优解空间。

在ARIMA-PSO-LSTM中,PSO用于优化ARIMA模型中的参数。

LSTM是一种适用于时间序列数据的循环神经网络,具有记忆

单元和门控机制,可以有效地捕捉时间序列数据中的长期依赖关系。

LSTM可以通过训练数据集来学习时间序列的模式,并

进行预测。

ARIMA-PSO-LSTM模型的基本原理是:首先,使用ARIMA

模型对时间序列数据进行拟合,并通过PSO算法优化ARIMA

模型中的参数。

然后,将优化后的ARIMA模型作为LSTM的输入,并使用训练数据对LSTM进行训练。

最后,使用训练

好的模型对未来的时间序列数据进行预测。

ARIMA-PSO-LSTM模型的优点在于可以充分发挥ARIMA模

型和LSTM模型的优势,通过优化ARIMA模型的参数和利用

LSTM捕捉时间序列数据的长期依赖关系,提高了时间序列预测的准确性和泛化能力。

基于粒子群优化的深度神经网络分类算法董晴;宋威【摘要】针对神经网络分类算法中节点函数不可导,分类精度不够高等问题,提出了一种基于粒子群优化(PSO)算法的深度神经网络分类算法.使用深度学习中的自动编码机,结合PSO算法优化权值,利用自动编码机对输入样本数据进行编解码,为提高网络分类精度,以编码机本身的误差函数和Softmax分类器的代价函数加权求和共同作为PSO算法的评价函数,使编码后的数据更加适应分类器.实验结果证明:与其他传统的神经网络相比,在邮件分类问题上,此分类算法有更高的分类精度.%Aiming at problem that classification precision of neural network algorithm is not very high and node function doesn't have derivate,a new classification algorithm of deep neural network based on particle swarm optimization(PSO) is e autoencoder of deep study,and combined with PSO algorithm to optimize the weight,coder and decoder for input sample data using autoencoder.In order to improve the classification precision of network,take the error function of autoencoder and cost function of softmax classifier weight sum as evaluation function of PSO algorithm in common,making coded data more adapter to the classifier.The experimental results show that compared with other traditional neural network,the classification algorithm has higher classification precision on Email classification.【期刊名称】《传感器与微系统》【年(卷),期】2017(036)009【总页数】5页(P143-146,150)【关键词】深度神经网络;自动编码机;粒子群优化算法;分类【作者】董晴;宋威【作者单位】江南大学物联网工程学院,江苏无锡214122;江南大学物联网工程学院,江苏无锡214122【正文语种】中文【中图分类】TP183近年来,神经网络的研究一直受到学者们的关注,如感知机[1],反向传播(back propogation,BP)神经网络[2],径向基函数(radial basis function,RBF)神经网络及其各种改进算法[3~5]等。

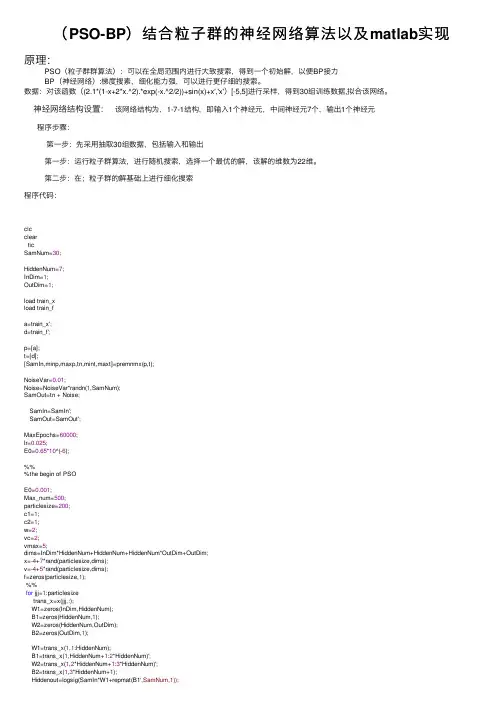

(PSO-BP)结合粒⼦群的神经⽹络算法以及matlab实现原理:PSO(粒⼦群群算法):可以在全局范围内进⾏⼤致搜索,得到⼀个初始解,以便BP接⼒BP(神经⽹络):梯度搜素,细化能⼒强,可以进⾏更仔细的搜索。

数据:对该函数((2.1*(1-x+2*x.^2).*exp(-x.^2/2))+sin(x)+x','x')[-5,5]进⾏采样,得到30组训练数据,拟合该⽹络。

神经⽹络结构设置:该⽹络结构为,1-7-1结构,即输⼊1个神经元,中间神经元7个,输出1个神经元程序步骤:第⼀步:先采⽤抽取30组数据,包括输⼊和输出第⼀步:运⾏粒⼦群算法,进⾏随机搜索,选择⼀个最优的解,该解的维数为22维。

第⼆步:在;粒⼦群的解基础上进⾏细化搜索程序代码:clcclearticSamNum=30;HiddenNum=7;InDim=1;OutDim=1;load train_xload train_fa=train_x';d=train_f';p=[a];t=[d];[SamIn,minp,maxp,tn,mint,maxt]=premnmx(p,t);NoiseVar=0.01;Noise=NoiseVar*randn(1,SamNum);SamOut=tn + Noise;SamIn=SamIn';SamOut=SamOut';MaxEpochs=60000;lr=0.025;E0=0.65*10^(-6);%%%the begin of PSOE0=0.001;Max_num=500;particlesize=200;c1=1;c2=1;w=2;vc=2;vmax=5;dims=InDim*HiddenNum+HiddenNum+HiddenNum*OutDim+OutDim;x=-4+7*rand(particlesize,dims);v=-4+5*rand(particlesize,dims);f=zeros(particlesize,1);%%for jjj=1:particlesizetrans_x=x(jjj,:);W1=zeros(InDim,HiddenNum);B1=zeros(HiddenNum,1);W2=zeros(HiddenNum,OutDim);B2=zeros(OutDim,1);W1=trans_x(1,1:HiddenNum);B1=trans_x(1,HiddenNum+1:2*HiddenNum)';W2=trans_x(1,2*HiddenNum+1:3*HiddenNum)';B2=trans_x(1,3*HiddenNum+1);Hiddenout=logsig(SamIn*W1+repmat(B1',SamNum,1));Networkout=Hiddenout*W2+repmat(B2',SamNum,1);Error=Networkout-SamOut;SSE=sumsqr(Error)f(jjj)=SSE;endpersonalbest_x=x;personalbest_f=f;[groupbest_f i]=min(personalbest_f);groupbest_x=x(i,:);for j_Num=1:Max_numvc=(5/3*Max_num-j_Num)/Max_num;%%v=w*v+c1*rand*(personalbest_x-x)+c2*rand*(repmat(groupbest_x,particlesize,1)-x);for kk=1:particlesizefor kk0=1:dimsif v(kk,kk0)>vmaxv(kk,kk0)=vmax;else if v(kk,kk0)<-vmaxv(kk,kk0)=-vmax;endendendendx=x+vc*v;%%for jjj=1:particlesizetrans_x=x(jjj,:);W1=zeros(InDim,HiddenNum);B1=zeros(HiddenNum,1);W2=zeros(HiddenNum,OutDim);B2=zeros(OutDim,1);W1=trans_x(1,1:HiddenNum);B1=trans_x(1,HiddenNum+1:2*HiddenNum)';W2=trans_x(1,2*HiddenNum+1:3*HiddenNum)';B2=trans_x(1,3*HiddenNum+1);Hiddenout=logsig(SamIn*W1+repmat(B1',SamNum,1));Networkout=Hiddenout*W2+repmat(B2',SamNum,1);Error=Networkout-SamOut;SSE=sumsqr(Error);f(jjj)=SSE;end%%for kk=1:particlesizeif f(kk)<personalbest_f(kk)personalbest_f(kk)=f(kk);personalbest_x(kk)=x(kk);endend[groupbest_f0 i]=min(personalbest_f);if groupbest_f0<groupbest_fgroupbest_x=x(i,:);groupbest_f=groupbest_f0;endddd(j_Num)=groupbest_fendstr=num2str(groupbest_f);trans_x=groupbest_x;W1=trans_x(1,1:HiddenNum);B1=trans_x(1,HiddenNum+1:2*HiddenNum)';W2=trans_x(1,2*HiddenNum+1:3*HiddenNum)';B2=trans_x(1,3*HiddenNum+1);%the end of PSO%%for i=1:MaxEpochs%%Hiddenout=logsig(SamIn*W1+repmat(B1',SamNum,1));Networkout=Hiddenout*W2+repmat(B2',SamNum,1);Error=Networkout-SamOut;SSE=sumsqr(Error)ErrHistory=[ SSE];if SSE<E0,break, enddB2=zeros(OutDim,1);dW2=zeros(HiddenNum,OutDim);for jj=1:HiddenNumfor k=1:SamNumdW2(jj,OutDim)=dW2(jj,OutDim)+Error(k)*Hiddenout(k,jj);endendfor k=1:SamNumdB2(OutDim,1)=dB2(OutDim,1)+Error(k);enddW1=zeros(InDim,HiddenNum);dB1=zeros(HiddenNum,1);for ii=1:InDimfor jj=1:HiddenNumfor k=1:SamNumdW1(ii,jj)=dW1(ii,jj)+Error(k)*W2(jj,OutDim)*Hiddenout(k,jj)*(1-Hiddenout(k,jj))*(SamIn(k,ii));dB1(jj,1)=dB1(jj,1)+Error(k)*W2(jj,OutDim)*Hiddenout(k,jj)*(1-Hiddenout(k,jj));endendendW2=W2-lr*dW2;B2=B2-lr*dB2;W1=W1-lr*dW1;B1=B1-lr*dB1;endHiddenout=logsig(SamIn*W1+repmat(B1',SamNum,1));Networkout=Hiddenout*W2+repmat(B2',SamNum,1);aa=postmnmx(Networkout,mint,maxt);x=a;newk=aa;figureplot(x,d,'r-o',x,newk,'b--+')legend('原始数据','训练后的数据');xlabel('x');ylabel('y');toc注:在(i5,8G,win7,64位)PC上的运⾏时间为30s左右。

基于粒子群优化算法的神经网络架构搜索与参数优化方法

研究

近年来,神经网络在深度学习领域取得了巨大的成功。

然而,设计一个有效的神经网络架构仍然是一个具有挑战性的问题。

传统的人工设计方法需要大量的经验和时间,而且很难找到最佳的架构。

为了解决这个问题,研究人员提出了一种基于粒子群优化算法的神经网络架构搜索与参数优化方法。

粒子群优化算法是一种模仿鸟群寻找食物的行为而发展起来的优化算法。

它通过不断地迭代搜索空间中的解空间,从而找到最佳的解。

在这个方法中,每个粒子代表一个神经网络架构。

每个粒子都有一个位置和速度,位置表示当前的网络架构,速度表示网络架构的变化方向。

粒子群中的每个粒子根据当前的位置和速度更新自己的位置,并根据一个评价函数计算其适应度。

适应度高的粒子将会被保留下来,并作为下一次迭代的起点。

为了进一步优化神经网络的性能,该方法还引入了参数优化。

在每次更新粒子位置之前,通过使用梯度下降算法对神经网络的参数进行优化。

这样可以在搜索过程中同时优化网络架构和参数,从而得到更好的结果。

通过在多个数据集上的实验证明,基于粒子群优化算法的神经网络架构搜索与参数优化方法相比于传统的方法具有更高的准

确性和更快的收敛速度。

该方法能够自动地搜索到最佳的网络架构和参数,在各种任务中都取得了良好的结果。

总之,基于粒子群优化算法的神经网络架构搜索与参数优化方法为神经网络的设计提供了一种新的思路。

它能够自动地找到最佳的架构和参数,并在各种任务中取得优秀的性能。

这一方法的研究为深度学习的发展提供了新的方向,有望在未来得到更广泛的应用。

基于改进粒子群算法优化CNN-LSTM神经网络的传染病预测刘彩云;聂伟;孟金葆;张涛【期刊名称】《湖州师范学院学报》【年(卷),期】2024(46)4【摘要】针对新型传染病发展趋势的预测精度问题,提出一种改进粒子群(PSO)算法优化卷积神经网络(CNN)与长短期记忆神经网络(LSTM)相结合的预测模型.首先,将原始粒子群优化算法中最优惯性权重的调整方式由迭代次数的线性关系转变为非线性关系,并对学习因子进行线性更新,以寻找最优参数,从而更准确地模拟粒子群的社会学习能力,进而平衡算法的全局优化能力,提高收敛速度;其次,以发酵时间较长的新型冠状肺炎为研究对象,构建CNN-LSTM神经网络预测模型,利用CNN层提取其特征信息后降维作为LSTM层输入,并通过预测模块实现对研究对象的指标训练和预测,从而提高模型的预测精度;最后,与原始LSTM模型的预测误差,如均方根误差(RMSE)、平均绝对误差(MAE)、均方误差(MSE)等指标进行对比.研究结果表明,在训练集上,与原始LSTM模型相比,经过改进的PSO算法优化CNN-LSTM组合神经网络模型,其在RMSE、MAE和MSE三个指标上分别降低了73.0%、62.3%、92.7%;在测试集上,这3个指标分别降低了23.0%、29.8%、40.7%.这说明该模型具有更小的误差和较好的预测效果.该研究结果可为实现传染病传播趋势的精准预测提供新的思路和方法.【总页数】12页(P37-48)【作者】刘彩云;聂伟;孟金葆;张涛【作者单位】铜陵学院数学与计算机学院;铜陵职业技术学院信息工程系【正文语种】中文【中图分类】TP39【相关文献】1.一种基于改进粒子群算法优化BP神经网络的预测方法2.基于改进的粒子群算法优化反向传播神经网络的热舒适度预测模型3.基于改进粒子群算法优化小波神经网络的\r短时交通流预测4.基于改进粒子群算法优化BP神经网络的甜菜产量预测方法5.基于改进粒子群算法优化模糊神经网络的炉膛结渣预测研究因版权原因,仅展示原文概要,查看原文内容请购买。

bp粒子群算法

众所周知,BP(Backpropagation)神经网络和粒子群算法(Particle Swarm Optimization,PSO)是两种不同的优化算法。

BP是一种监督学习算法,用于训练神经网络,而PSO是一种优化算法,通常用于寻找函数的全局最小值。

如果你想将这两者结合使用,一种常见的方法是使用PSO来优化神经网络的权重。

这个组合通常称为BP-PSO算法。

以下是一个简单的描述:

初始化粒子群:每个粒子表示神经网络的一组权重。

初始化时,每个粒子在权重空间中随机选择初始位置和速度。

计算适应度:使用每个粒子的权重来构建神经网络,并计算其在训练集上的适应度。

适应度通常由神经网络的误差或损失函数衡量。

更新粒子的速度和位置:使用PSO算法更新每个粒子的速度和位置,以寻找更好的权重组合。

这包括考虑个体最优位置和群体最优位置。

重复迭代:重复步骤2和3,直到达到预定的迭代次数或适应度阈值。

输出结果:选择适应度最好的粒子对应的权重,作为优化后的神经网络的权重。

请注意,BP-PSO是一种启发式算法,其性能在不同问题上可能会有所不同。

调整算法的参数,如粒子数量、迭代次数等,可能对最终结果产生影响。

基于PSO的BP神经网络研究基于粒子群优化(Particle Swarm Optimization,PSO)的反向传播(Backpropagation,BP)神经网络是一种常用的机器学习算法。

该方法结合了PSO和BP神经网络的优点,通过优化网络的权重和偏差来提高BP神经网络的性能。

在这篇文章中,我们将深入探讨基于PSO的BP神经网络的研究。

首先,我们来了解一下BP神经网络。

BP神经网络是一种多层前馈神经网络,通过一种称为反向传播的算法来学习和优化网络的权重和偏差。

BP神经网络具有一个或多个隐藏层,每个隐藏层都有一定数量的神经元。

每个神经元的输出由输入层和上一层的神经元的输出加权和经过一种非线性激活函数计算得到。

通过反向传播算法计算误差,并使用梯度下降法来更新权重和偏差,以最小化误差。

然而,传统的BP神经网络容易陷入局部最小值,并且需要大量的计算资源和时间来调整网络的权重和偏差。

为了解决这些问题,研究人员提出了基于PSO的BP神经网络。

PSO算法模拟了鸟群觅食的行为,每个个体(粒子)都有一定的位置和速度。

PSO算法通过更新每个粒子的位置和速度来最优解。

在基于PSO的BP神经网络中,每个粒子代表一个BP神经网络的权重和偏差。

PSO算法通过迭代更新,使粒子在空间中移动,以寻找最佳解决方案。

在基于PSO的BP神经网络中,每个粒子的适应度值由其对应的BP神经网络的误差计算得到。

通过比较每个粒子的适应度值,PSO算法可以找到全局最优解或接近最优解的解决方案。

基于PSO的BP神经网络具有许多优点。

首先,PSO算法具有全局能力,可以避免陷入局部最小值。

其次,PSO算法的并行计算能力可以加速网络的训练过程。

此外,PSO算法的参数设置相对较少,使得算法易于实现和使用。

然而,基于PSO的BP神经网络也有一些挑战和限制。

首先,初始化粒子群的位置和速度可能会影响到算法的收敛性和性能。

其次,PSO算法可能需要大量的迭代次数来最优解。