MapReduce基本概念

- 格式:doc

- 大小:26.00 KB

- 文档页数:4

MapReduce是一种大数据处理模型,用于并行处理大规模的数据集。

它由Google在2004年提出,并成为Apache Hadoop的核心组件之一。

MapReduce模型的设计目的是为了简化并行计算任务,使得开发人员可以在分布式系统上高效地处理大规模数据。

MapReduce模型的基本概念如下:1. 输入数据集:MapReduce将输入数据集分割成多个小数据块,并且每个数据块可以由一个或多个键值对组成。

2. 映射 Map)函数:映射函数是并行处理输入数据块的核心操作。

它将输入数据块的每个键值对进行处理,并生成一系列中间键值对。

映射函数可以根据需求进行自定义操作,比如提取关键词、计数等。

3. 中间数据集:MapReduce将映射函数生成的中间键值对根据键进行分组,将具有相同键的值组合在一起,形成中间数据集。

4. 归约 Reduce)函数:归约函数对每个中间键值对的值列表进行处理,并生成最终的输出结果。

归约函数通常是进行聚合操作,比如求和、求平均值等。

5. 输出数据集:MapReduce将归约函数处理后的结果保存在输出数据集中。

MapReduce模型的工作过程如下:1. 切分输入数据集:将大规模的输入数据集切分成多个小数据块,并分配给不同的计算节点。

2. 映射:每个计算节点将分配到的数据块使用映射函数进行处理,并生成中间键值对。

3. 分组:根据中间键的值,将相同键的中间值进行分组,以便后续的归约操作。

4. 归约:每个计算节点对分组后的中间值进行归约操作,生成最终的输出结果。

5. 合并输出结果:将所有计算节点的输出结果进行合并,形成最终的输出数据集。

MapReduce模型的优点包括:- 可扩展性:可以处理非常大规模的数据,并利用分布式计算资源进行并行处理,提高处理效率。

- 容错性:MapReduce具备容错机制,当某个计算节点发生故障时,可以重新分配任务到其他节点上。

- 灵活性:开发人员可以根据具体需求自定义映射和归约函数,实现各种数据处理操作。

Hadoop大数据开发基础教案Hadoop介绍教案第一章:Hadoop概述1.1 课程目标了解Hadoop的定义、发展历程及应用场景掌握Hadoop的核心组件及其作用理解Hadoop在大数据领域的优势1.2 教学内容Hadoop的定义与发展历程Hadoop的核心组件:HDFS、MapReduce、YARN Hadoop的应用场景与优势1.3 教学方法讲解与案例分析相结合互动提问,巩固知识点1.4 课后作业简述Hadoop的发展历程及其在大数据领域的优势。

第二章:HDFS(分布式文件系统)2.1 课程目标掌握HDFS的架构与工作原理了解HDFS的优势与局限性掌握HDFS的常用操作命令2.2 教学内容HDFS的架构与工作原理HDFS的优势与局限性HDFS的常用操作命令:hdfs dfs, hdfs dfsadmin2.3 教学方法讲解与实践操作相结合案例分析,理解HDFS的工作原理2.4 课后作业利用HDFS命令练习文件的与。

第三章:MapReduce编程模型3.1 课程目标掌握MapReduce的基本概念与编程模型理解MapReduce的运行原理与执行过程学会使用MapReduce解决大数据问题3.2 教学内容MapReduce的基本概念:Mapper、Reducer、Shuffle与Sort MapReduce的编程模型:Map阶段、Shuffle阶段、Reduce阶段MapReduce的运行原理与执行过程3.3 教学方法讲解与编程实践相结合剖析经典MapReduce案例,理解编程模型3.4 课后作业编写一个简单的MapReduce程序,实现单词计数功能。

第四章:YARN(资源管理器)4.1 课程目标掌握YARN的基本概念与架构了解YARN的工作原理与调度策略掌握YARN的资源管理与优化方法4.2 教学内容YARN的基本概念与架构YARN的工作原理与调度策略YARN的资源管理与优化方法4.3 教学方法讲解与案例分析相结合实操演练,掌握YARN的资源管理方法4.4 课后作业分析一个YARN集群的资源使用情况,提出优化方案。

黑马程序员hadoop笔记Hadoop是当前最流行的大数据处理框架之一,具备高可靠性、高扩展性和高效性等特点。

本文将全面介绍Hadoop的相关内容,包括其基本概念、架构设计、应用场景以及使用方法等。

1. Hadoop的基本概念Hadoop是一个开源的分布式计算平台,其核心由Hadoop分布式文件系统(HDFS)和MapReduce计算框架组成。

HDFS采用主从架构,支持海量数据的分布式存储和处理;MapReduce则是一种分布式计算模型,提供了高效的数据处理能力。

2. Hadoop的架构设计Hadoop采用了分布式存储和计算的架构设计,主要包括主节点(NameNode)和多个工作节点(DataNode)组成。

主节点负责管理整个系统的元数据信息,存储在内存中,而工作节点则负责存储和计算任务的执行。

3. Hadoop的应用场景Hadoop广泛应用于大规模数据处理和分析领域。

它可以处理各种类型的数据,包括结构化数据、半结构化数据和非结构化数据等。

常见的应用场景包括日志分析、推荐系统、搜索引擎和数据仓库等。

4. Hadoop的使用方法使用Hadoop进行数据处理通常需要编写MapReduce程序,它由Mapper和Reducer两个组件组成。

Mapper负责将输入数据切分成若干键值对,然后执行相应的逻辑处理;Reducer负责对Mapper的输出结果进行归纳和聚合。

在编写MapReduce程序时,我们需要定义数据的输入和输出路径,并指定Mapper和Reducer的逻辑处理方式。

通过Hadoop提供的命令行工具和API,可以方便地操作Hadoop集群,提交任务并监控任务的执行状态。

本文对Hadoop的概念、架构设计、常见应用场景和使用方法进行了简要介绍。

Hadoop作为一种强大的大数据处理框架,具备高可靠性和高扩展性,适用于处理大规模数据和复杂计算任务。

通过深入学习和掌握Hadoop的知识,我们可以更好地应对现实中的数据挑战,并开展相关的数据分析和应用开发工作。

MapReduce编程一、实验目的1、理解MapReduce编程模型基本知识2、掌握MapReduce开发环境的搭建3、掌握MapReduce基本知识,能够运用MapReduce进行基本的开发二、实验原理MapReduce 是Hadoop两个最基础最重要的核心成员之一。

它是大规模数据(TB 级)计算的利器,Map 和Reduce 是它的主要思想,来源于函数式编程语言。

从编程的角度来说MapReduce分为Map函数和Reduce函数,Map负责将数据打散,Reduce负责对数据进行聚集,用户只需要实现map 和reduce 两个接口,即可完成TB级数据的计算。

Hadoop Map Reduce的实现采用了Master/Slave 结构。

Master 叫做JobTracker,而Slave 叫做TaskTracker。

用户提交的计算叫做Job,每一个Job会被划分成若干个Tasks。

JobTracker负责Job 和Tasks 的调度,而TaskTracker负责执行Tasks。

常见的应用包括:日志分析和数据挖掘等数据分析应用,另外,还可用于科学数据计算,如圆周率PI 的计算等。

MapReduce 框架的核心步骤主要分两部分:Map 和Reduce。

当你向MapReduce 框架提交一个计算作业时,它会首先把计算作业拆分成若干个Map 任务,然后分配到不同的节点上去执行,每一个Map 任务处理输入数据中的一部分,当Map 任务完成后,它会生成一些中间文件,这些中间文件将会作为Reduce 任务的输入数据。

Reduce 任务的主要目标就是把前面若干个Map 的输出汇总到一起并输出。

按照以上基本的描述,其工作图如下。

从工作流程来讲,MapReduce对应的作业Job首先把输入的数据集切分为若干独立的数据块,并由Map组件以Task的方式并行处理。

处理结果经过排序后,依次输入给Reduce 组件,并且以Task的形式并行处理。

hadoop的基本操作命令Hadoop是目前最流行的分布式计算框架之一,其强大的数据处理能力和可扩展性使其成为企业级应用的首选。

在使用Hadoop时,熟悉一些基本操作命令是必不可少的。

以下是Hadoop的基本操作命令:1. 文件系统命令Hadoop的文件系统命令与Linux系统类似,可以用于管理Hadoop的文件系统。

以下是一些常用的文件系统命令:- hdfs dfs -ls:列出文件系统中的文件和目录。

- hdfs dfs -mkdir:创建一个新目录。

- hdfs dfs -put:将本地文件上传到Hadoop文件系统中。

- hdfs dfs -get:将Hadoop文件系统中的文件下载到本地。

- hdfs dfs -rm:删除文件系统中的文件或目录。

- hdfs dfs -du:显示文件或目录的大小。

- hdfs dfs -chmod:更改文件或目录的权限。

2. MapReduce命令MapReduce是Hadoop的核心计算框架,用于处理大规模数据集。

以下是一些常用的MapReduce命令:- hadoop jar:运行MapReduce作业。

- hadoop job -list:列出所有正在运行的作业。

- hadoop job -kill:终止正在运行的作业。

- hadoop fs -copyFromLocal:将本地文件复制到Hadoop文件系统中。

- hadoop fs -copyToLocal:将Hadoop文件系统中的文件复制到本地。

- hadoop fs -rmr:删除指定目录及其所有子目录和文件。

3. YARN命令YARN是Hadoop的资源管理器,用于管理Hadoop集群中的资源。

以下是一些常用的YARN命令:- yarn node -list:列出所有节点的状态。

- yarn application -list:列出所有正在运行的应用程序。

- yarn application -kill:终止正在运行的应用程序。

hadoop基本概念一、hadoop基本概念hadoop包括两个核心组成:HDFS:分布式文件系统,存储海量的数据MapReduce:并行处理框架,实现任务分解和调度。

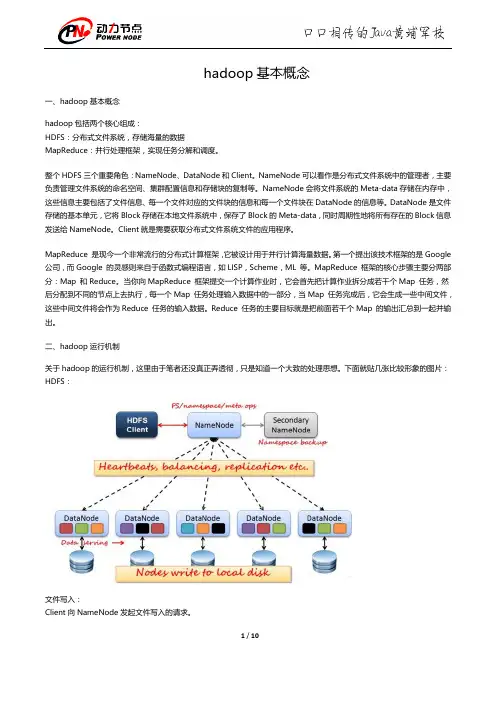

整个HDFS三个重要角色:NameNode、DataNode和Client。

NameNode可以看作是分布式文件系统中的管理者,主要负责管理文件系统的命名空间、集群配置信息和存储块的复制等。

NameNode会将文件系统的Meta-data存储在内存中,这些信息主要包括了文件信息、每一个文件对应的文件块的信息和每一个文件块在DataNode的信息等。

DataNode是文件存储的基本单元,它将Block存储在本地文件系统中,保存了Block的Meta-data,同时周期性地将所有存在的Block信息发送给NameNode。

Client就是需要获取分布式文件系统文件的应用程序。

MapReduce 是现今一个非常流行的分布式计算框架,它被设计用于并行计算海量数据。

第一个提出该技术框架的是Google 公司,而Google 的灵感则来自于函数式编程语言,如LISP,Scheme,ML 等。

MapReduce 框架的核心步骤主要分两部分:Map 和Reduce。

当你向MapReduce 框架提交一个计算作业时,它会首先把计算作业拆分成若干个Map 任务,然后分配到不同的节点上去执行,每一个Map 任务处理输入数据中的一部分,当Map 任务完成后,它会生成一些中间文件,这些中间文件将会作为Reduce 任务的输入数据。

Reduce 任务的主要目标就是把前面若干个Map 的输出汇总到一起并输出。

二、hadoop运行机制关于hadoop的运行机制,这里由于笔者还没真正弄透彻,只是知道一个大致的处理思想。

下面就贴几张比较形象的图片:HDFS:文件写入:Client向NameNode发起文件写入的请求。

NameNode根据文件大小和文件块配置情况,返回给Client它所管理部分DataNode的信息。

Hive Join的基本原理Hive是建立在Hadoop之上的数据仓库基础架构,它提供了一个类似于SQL的查询语言,称为HiveQL,用于在大规模数据集上进行数据查询和分析。

Hive的查询语言HiveQL支持各种操作,包括数据的连接(join),这是在数据仓库中非常常见和重要的操作之一。

Hive的连接操作是通过执行MapReduce任务来实现的。

在理解Hive Join的基本原理之前,我们需要先了解一些与Hive MapReduce有关的基本概念。

1. MapReduce的基本概念MapReduce是一种用于处理大规模数据集的分布式计算模型,它将任务分为两个阶段:Map阶段和Reduce阶段。

Map阶段负责将输入数据切分为若干个独立的数据块,并对每个数据块执行一次Map函数,生成中间结果。

Reduce阶段负责对Map阶段输出的中间结果进行合并和处理,最终生成最终的结果。

MapReduce模型的基本原理是将计算任务分发到多个节点上并行执行,每个节点独立处理自己的数据块,最后将结果合并得到最终的结果。

这种并行处理的方式使得MapReduce非常适合处理大规模数据集。

2. Hive Join的基本原理在Hive中,连接操作是通过执行多个MapReduce任务来实现的。

下面我们将详细介绍Hive Join的基本原理。

2.1 Map阶段在Hive中,连接操作的Map阶段主要负责将输入数据进行切分,并为每个输入数据块执行一次Map函数。

具体而言,对于连接操作,Hive将需要连接的两个表的数据分别切分为若干个数据块,并将每个数据块的键值对发送到不同的Map任务中。

在Map阶段,Hive会使用连接条件将两个表的数据进行匹配。

例如,如果是基于等值连接,Hive会将具有相同连接键的数据块发送到同一个Map任务中。

如果是基于范围连接,Hive会将满足范围条件的数据块发送到同一个Map任务中。

在Map阶段,Hive会对每个数据块执行Map函数,将输入数据转换为键值对形式的数据。

Hadoop实训报告引言Hadoop是一个开源的分布式计算平台,用于处理大规模数据集的存储和分析。

在本次实训中,我们学习了Hadoop的基本概念和使用方法,并通过实践掌握了Hadoop的各种组件及其功能。

实训内容1. Hadoop概述首先,我们学习了Hadoop的基本概念和架构。

Hadoop由HDFS(Hadoop分布式文件系统)和MapReduce两个核心组件组成。

HDFS用于存储大规模数据集,并提供高可靠性和容错性。

MapReduce是一种分布式计算模型,用于将数据分成多个小块,在集群中并行处理。

2. Hadoop安装与配置接下来,我们进行了Hadoop的安装与配置。

首先,我们下载了Hadoop的安装包,并解压到本地目录。

然后,我们配置了Hadoop的环境变量,使其能够在命令行中被识别。

3. Hadoop集群搭建为了更好地理解Hadoop的分布式特性,我们搭建了一个Hadoop集群。

我们使用了三台虚拟机,分别作为一个主节点和两个从节点。

在主节点上配置了HDFS和MapReduce的相关文件,并在从节点上配置了对应的通信信息。

4. Hadoop基本操作在学习了Hadoop的基本概念和架构后,我们开始进行一些基本的Hadoop操作。

首先,我们学习了Hadoop的文件操作命令,如上传、下载、删除等。

然后,我们学习了Hadoop的作业操作命令,如提交作业、查看作业状态等。

5. Hadoop应用开发在掌握了Hadoop的基本操作后,我们开始进行Hadoop应用的开发。

我们使用Java语言编写了一个简单的MapReduce程序,用于统计一个文本文件中的单词出现次数。

通过编写这个程序,我们更深入地理解了MapReduce的工作原理和应用。

6. Hadoop性能优化最后,我们学习了Hadoop的性能优化方法。

我们通过调整各种参数和配置文件,来提高Hadoop的运行效率和并行性能。

我们还学习了如何监控Hadoop集群的运行状态,并根据监控结果进行调整和优化。

人工智能基础智慧树知到课后章节答案2023年下武汉学院武汉学院第一章测试1.一般公认人工智能的鼻祖是谁?()答案:图灵2.人工智能这一学科正式产生是()。

答案:1956年3.智力包括()。

答案:集中精力的能力;学习的能力;控制情绪的能力第二章测试1.用搜索求解问题的方法,就是数学中的建模方法。

()答案:错2.用搜索求解问题一定可以找到最优解。

()答案:错3.启发式信息按其形式可分为()和()。

____,____。

答案:null4.通过搜索实现问题求解的基本步骤是定义()、()和()。

____,____,____。

答案:null5.搜索图分为()和()两种。

____,____。

答案:null6.状态表示可以是()。

答案:矩阵;列表;树结构第三章测试1.与或图中包含的关系有()。

答案:And/Or;And;Or2.如果问题有解,即S0→Sg存在一条路径,A*算法一定能找到最优解()答案:对3.根据图对应的实际问题背景,图又可分为()和()。

____,____。

答案:null4.在通用图搜索算法的第6步,为什么产生n的一切后继节点构成的集合M中,其中不包括n的先辈点?答案:null5.在通用图搜索算法的第7.2步,若P∈G,为什么要确定是否更改Tree中P到n的指针。

null6.什么是A算法答案:null第四章测试1.下棋是非零和博弈。

()答案:错2.极小极大搜索算法在扩展搜索树时,是以深度优先的方式。

()答案:错3.极小极大搜索算法是以自顶向下的方式扩展搜索树,以自底向上的方式倒推评价值()答案:对4.α-β剪枝法的搜索过程中,α值永不上升,β值永不下降()错5.下棋的评价函数的要求是有利于程序方的势态,f(P)取()值,有利于对方的势态,f(P)取()值。

____,____。

答案:null6.博弈算法MinMax的基本思想,当轮到Min走步的结点时,Max应考虑f(p)取极()值;当轮到Max走步的结点时,Max应考虑f(p)取极()值。

文章标题:深入探讨MapReduce的基础运用和原理一、引言MapReduce是一种用于处理和生成大规模数据集的分布式计算框架,它能够有效地处理海量数据,提高数据处理的效率和速度。

本文将深入探讨MapReduce的基础运用和原理,帮助读者更深入地理解和掌握这一重要的数据处理技术。

二、MapReduce的基本概念1. Map阶段:在MapReduce中,Map阶段是数据处理的第一步,它将输入的数据集合拆分成若干个独立的任务,并将这些任务分配给不同的计算节点进行并行处理。

在Map阶段,我们需要编写Map函数来对输入的数据进行处理,通常是将数据进行分割和映射。

2. Shuffle阶段:Shuffle阶段是MapReduce中非常重要的一部分,它负责将Map阶段输出的结果进行分区和排序,然后将相同key的数据进行分组,以便于后续Reduce阶段的处理。

3. Reduce阶段:Reduce阶段是MapReduce的最后一步,它接收Shuffle阶段输出的数据,并将具有相同key的数据进行合并和聚合,最终输出最终的处理结果。

三、MapReduce的基础运用1. 数据处理:MapReduce可以高效地处理海量数据,如日志文件、文本数据等,通过Map和Reduce两个阶段的处理,可以实现对数据的分析和计算,例如词频统计、数据过滤等。

2. 分布式计算:MapReduce能够将数据集分解成多个小的任务,分配给多个计算节点进行并行处理,因此可以充分利用集群的计算资源,提高数据处理的速度和效率。

3. 容错性:MapReduce具有很强的容错性,当集群中的某个计算节点发生故障时,系统能够自动将任务重新分配给其他正常的节点进行处理,保证任务的顺利完成。

四、MapReduce的原理分析1. 并行计算模型:MapReduce采用了流水线式的并行计算模型,将数据处理划分成不同的阶段,每个阶段都可以并行执行,从而充分利用集群的计算资源。

基于mapreduce的课程设计一、课程目标知识目标:1. 学生能理解MapReduce编程模型的基本原理,掌握其核心概念,如Map、Reduce函数以及Shuffle过程。

2. 学生能够运用MapReduce进行数据处理和分析,掌握相关算法的并行化设计。

3. 学生了解大数据处理中MapReduce的优势和局限性,并能够结合实际场景选择合适的处理方法。

技能目标:1. 学生能够独立编写简单的MapReduce程序,实现对大规模数据的处理。

2. 学生通过动手实践,掌握使用MapReduce进行数据分析的基本技巧,如调试、优化和性能评估。

3. 学生能够运用所学知识解决实际问题,设计并实现小型的数据处理项目。

情感态度价值观目标:1. 学生通过学习MapReduce,培养对分布式计算和大数据技术的兴趣,激发探求新技术的好奇心。

2. 学生通过团队协作完成任务,增强合作意识和团队精神,认识到团队合作的重要性。

3. 学生通过本课程的学习,认识到技术对于解决现实问题的价值,增强利用科技改变生活的信心。

课程性质分析:本课程为信息技术或计算机科学相关学科的高级课程,旨在帮助学生掌握大数据处理的基本方法,培养学生解决实际问题的能力。

学生特点分析:学生应为高中年级或大学低年级,具备一定的编程基础,对数据结构和算法有一定的了解,具备基本的逻辑思维能力。

教学要求:课程注重理论与实践相结合,鼓励学生动手实践,通过案例教学,提高学生的实际操作能力和问题解决能力。

教学过程中,强调学生的主体地位,引导学生主动探索,激发学生的学习兴趣。

通过分解课程目标为具体学习成果,使教学设计和评估更具针对性。

二、教学内容1. MapReduce基本概念:介绍MapReduce编程模型,阐述其在大数据处理中的应用场景,对比传统数据处理方法,突出MapReduce的优势。

- 教材章节:第1章 大数据处理概述2. MapReduce编程原理:详细讲解Map、Reduce函数的作用和实现,以及Shuffle过程。

一、MapReduce简介1.1 课程目标理解MapReduce的概念和原理掌握MapReduce编程模型了解MapReduce在Hadoop中的作用1.2 教学内容MapReduce定义MapReduce编程模型(Map、Shuffle、Reduce阶段)MapReduce的优势和局限性Hadoop中的MapReduce运行机制1.3 教学方法理论讲解实例演示学生实操1.4 教学资源PPT课件Hadoop环境MapReduce实例代码1.5 课后作业分析一个大数据问题,尝试设计一个简单的MapReduce解决方案二、Hadoop环境搭建与配置2.1 课程目标学会在本地环境搭建Hadoop掌握Hadoop配置文件的基本配置理解Hadoop文件系统(HDFS)的存储机制2.2 教学内容Hadoop架构简介Hadoop环境搭建步骤Hadoop配置文件介绍(如:core-site.xml、hdfs-site.xml、mapred-site.xml)HDFS命令行操作2.3 教学方法讲解与实操相结合学生分组讨论问答互动2.4 教学资源PPT课件Hadoop安装包Hadoop配置文件模板HDFS命令行操作指南2.5 课后作业搭建本地Hadoop环境,并配置Hadoop文件系统三、MapReduce编程基础3.1 课程目标掌握MapReduce编程的基本概念理解MapReduce的运行原理3.2 教学内容MapReduce编程入口(Java)MapReduce关键组件(Job, Configuration, Reporter等)MapReduce编程实践(WordCount案例)MapReduce运行流程解析3.3 教学方法理论讲解与实操演示代码解析学生实践与讨论3.4 教学资源PPT课件MapReduce编程教程WordCount案例代码编程环境(Eclipse/IntelliJ IDEA)3.5 课后作业完成WordCount案例的编写与运行分析MapReduce运行过程中的各个阶段四、MapReduce高级特性4.1 课程目标掌握MapReduce的高级特性了解MapReduce在复杂数据处理中的应用4.2 教学内容MapReduce高级数据处理(如:排序、分组合并等)MapReduce性能优化策略(如:数据分区、序列化等)复杂场景下的MapReduce应用(如:多层嵌套、自定义分区等)4.3 教学方法理论讲解与实操演示代码解析与优化学生实践与讨论4.4 教学资源PPT课件MapReduce高级特性教程性能优化案例代码编程环境(Eclipse/IntelliJ IDEA)4.5 课后作业优化WordCount程序的性能分析复杂场景下的MapReduce应用案例5.1 课程目标了解MapReduce在大数据处理领域的应用趋势掌握进一步学习MapReduce的途径5.2 教学内容MapReduce编程要点回顾MapReduce在实际项目中的应用案例大数据处理领域的新技术与发展趋势(如:Spark、Flink等)5.3 教学方法知识点梳理与讲解案例分享学生提问与讨论5.4 教学资源PPT课件实际项目案例相关技术资料5.5 课后作业结合实际项目,分析MapReduce的应用场景六、MapReduce编程实战(一)6.1 课程目标掌握MapReduce编程的实战技巧学会分析并解决实际问题理解MapReduce在不同场景下的应用6.2 教学内容实战案例介绍:倒排索引构建MapReduce编程实战:倒排索引的MapReduce实现案例分析:倒排索引在搜索引擎中的应用6.3 教学方法实操演示与讲解学生跟随实操案例分析与讨论6.4 教学资源PPT课件实战案例代码搜索引擎原理资料6.5 课后作业完成倒排索引的MapReduce实现分析MapReduce在搜索引擎中的应用七、MapReduce编程实战(二)7.1 课程目标进一步掌握MapReduce编程的实战技巧学会分析并解决复杂问题了解MapReduce在不同行业的应用7.2 教学内容实战案例介绍:网页爬虫数据处理MapReduce编程实战:网页爬虫数据的抓取与解析案例分析:MapReduce在网络爬虫领域的应用7.3 教学方法实操演示与讲解学生跟随实操案例分析与讨论7.4 教学资源PPT课件实战案例代码网络爬虫原理资料7.5 课后作业完成网页爬虫数据的MapReduce实现分析MapReduce在网络爬虫领域的应用八、MapReduce性能优化8.1 课程目标掌握MapReduce性能优化的方法与技巧学会分析并提升MapReduce程序的性能理解MapReduce性能优化的意义8.2 教学内容性能优化概述:MapReduce性能瓶颈分析优化方法与技巧:数据划分、序列化、并行度等性能优化案例:WordCount的性能提升8.3 教学方法理论讲解与实操演示代码解析与优化学生实践与讨论8.4 教学资源PPT课件性能优化教程性能优化案例代码编程环境(Eclipse/IntelliJ IDEA)8.5 课后作业分析并优化WordCount程序的性能研究其他MapReduce性能优化案例九、MapReduce在大数据处理中的应用9.1 课程目标理解MapReduce在大数据处理中的应用场景学会分析并解决实际问题掌握MapReduce与其他大数据处理技术的比较9.2 教学内容大数据处理场景:日志分析、分布式文件处理等MapReduce应用案例:日志数据分析MapReduce与其他大数据处理技术的比较9.3 教学方法理论讲解与实操演示案例分析与讨论学生提问与互动9.4 教学资源PPT课件大数据处理案例资料MapReduce与其他技术比较资料9.5 课后作业分析MapReduce在日志数据分析中的应用研究MapReduce与其他大数据处理技术的优缺点10.1 课程目标了解MapReduce技术的发展趋势掌握进一步学习MapReduce的途径10.2 教学内容MapReduce编程要点回顾MapReduce技术的发展趋势:YARN、Spark等拓展学习资源与推荐10.3 教学方法知识点梳理与讲解技术发展趋势分享学生提问与讨论10.4 教学资源PPT课件技术发展趋势资料拓展学习资源列表10.5 课后作业制定个人拓展学习计划重点和难点解析:一、MapReduce简介理解MapReduce的概念和原理掌握MapReduce编程模型了解MapReduce在Hadoop中的作用二、Hadoop环境搭建与配置学会在本地环境搭建Hadoop掌握Hadoop配置文件的基本配置理解Hadoop文件系统(HDFS)的存储机制三、MapReduce编程基础掌握MapReduce编程的基本概念学会编写MapReduce应用程序理解MapReduce的运行原理四、MapReduce高级特性掌握MapReduce的高级特性学会优化MapReduce程序性能了解MapReduce在复杂数据处理中的应用六、MapReduce编程实战(一)掌握MapReduce编程的实战技巧学会分析并解决实际问题理解MapReduce在不同场景下的应用七、MapReduce编程实战(二)进一步掌握MapReduce编程的实战技巧学会分析并解决复杂问题了解MapReduce在不同行业的应用八、MapReduce性能优化掌握MapReduce性能优化的方法与技巧学会分析并提升MapReduce程序的性能理解MapReduce性能优化的意义九、MapReduce在大数据处理中的应用理解MapReduce在大数据处理中的应用场景学会分析并解决实际问题掌握MapReduce与其他大数据处理技术的比较了解MapReduce技术的发展趋势掌握进一步学习MapReduce的途径本教案主要涵盖了MapReduce编程的基础知识、Hadoop环境搭建、编程实战、高级特性、性能优化以及应用场景等内容。

hdfs和mapreduce综合实训HDFS和MapReduce是Hadoop生态系统中的两个核心组件,它们分别负责存储和处理大数据。

在Hadoop的综合实训中,学生们通常需要通过搭建Hadoop集群、编写MapReduce程序等方式来深入了解HDFS和MapReduce的工作原理和应用场景。

在实训开始前,学生们需要先了解Hadoop的基本概念和架构,包括HDFS、MapReduce、YARN等组件。

然后,他们需要在自己的电脑或虚拟机上安装Hadoop,并配置好环境变量、SSH等。

接着,他们需要搭建Hadoop集群,包括一个NameNode和多个DataNode。

在搭建集群的过程中,学生们需要注意配置文件的修改、端口的开放等问题。

搭建好集群后,学生们需要编写MapReduce程序来处理数据。

MapReduce是一种分布式计算模型,它将大数据分成多个小数据块,并在集群中的多个节点上并行处理这些数据块。

MapReduce程序通常包括两个部分:Map和Reduce。

Map负责将输入数据转换成键值对,Reduce负责对键值对进行聚合和计算。

学生们需要根据实际需求编写MapReduce程序,并在集群上运行测试。

在实训的过程中,学生们还需要学习Hadoop的监控和调优技术。

Hadoop提供了多种监控工具,如Hadoop Web界面、Ganglia等,可以帮助学生们实时监控集群的运行状态。

此外,学生们还需要了解Hadoop的调优技术,如调整MapReduce任务的并行度、调整HDFS的块大小等,以提高集群的性能和稳定性。

总的来说,HDFS和MapReduce综合实训是一项非常有挑战性的任务,需要学生们具备一定的编程和系统管理能力。

通过这项实训,学生们可以深入了解Hadoop的工作原理和应用场景,掌握大数据处理的基本技能,为未来从事大数据相关工作打下坚实的基础。

Hadoop大数据开发基础教案Hadoop教案MapReduce入门编程教案第一章:Hadoop概述1.1 Hadoop简介了解Hadoop的发展历程理解Hadoop的核心价值观:可靠性、可扩展性、容错性1.2 Hadoop生态系统掌握Hadoop的主要组件:HDFS、MapReduce、YARN理解Hadoop生态系统中的其他重要组件:HBase、Hive、Pig等1.3 Hadoop安装与配置掌握Hadoop单机模式安装与配置掌握Hadoop伪分布式模式安装与配置第二章:HDFS文件系统2.1 HDFS简介理解HDFS的设计理念:大数据存储、高可靠、高吞吐掌握HDFS的基本架构:NameNode、DataNode2.2 HDFS操作命令掌握HDFS的基本操作命令:mkdir、put、get、dfsadmin等2.3 HDFS客户端编程掌握HDFS客户端API:Configuration、FileSystem、Path等第三章:MapReduce编程模型3.1 MapReduce简介理解MapReduce的设计理念:将大数据处理分解为简单的任务进行分布式计算掌握MapReduce的基本概念:Map、Shuffle、Reduce3.2 MapReduce编程步骤掌握MapReduce编程的四大步骤:编写Map函数、编写Reduce函数、设置输入输出格式、设置其他参数3.3 典型MapReduce应用掌握WordCount案例的编写与运行掌握其他典型MapReduce应用:排序、求和、最大值等第四章:YARN资源管理器4.1 YARN简介理解YARN的设计理念:高效、灵活、可扩展的资源管理掌握YARN的基本概念:ResourceManager、NodeManager、ApplicationMaster等4.2 YARN运行流程掌握YARN的运行流程:ApplicationMaster申请资源、ResourceManager 分配资源、NodeManager执行任务4.3 YARN案例实战掌握使用YARN运行WordCount案例掌握YARN调优参数设置第五章:Hadoop生态系统扩展5.1 HBase数据库理解HBase的设计理念:分布式、可扩展、高可靠的大数据存储掌握HBase的基本概念:表结构、Region、Zookeeper等5.2 Hive数据仓库理解Hive的设计理念:将SQL查询转换为MapReduce任务进行分布式计算掌握Hive的基本操作:建表、查询、数据导入导出等5.3 Pig脚本语言理解Pig的设计理念:简化MapReduce编程的复杂度掌握Pig的基本语法:LOAD、FOREACH、STORE等第六章:Hadoop生态系统工具6.1 Hadoop命令行工具掌握Hadoop命令行工具的使用:hdfs dfs, yarn命令等理解命令行工具在Hadoop生态系统中的作用6.2 Hadoop Web界面熟悉Hadoop各个组件的Web界面:NameNode, JobTracker, ResourceManager等理解Web界面在Hadoop生态系统中的作用6.3 Hadoop生态系统其他工具掌握Hadoop生态系统中的其他工具:Azkaban, Sqoop, Flume等理解这些工具在Hadoop生态系统中的作用第七章:MapReduce高级编程7.1 二次排序理解二次排序的概念和应用场景掌握MapReduce实现二次排序的编程方法7.2 数据去重理解数据去重的重要性掌握MapReduce实现数据去重的编程方法7.3 自定义分区理解自定义分区的概念和应用场景掌握MapReduce实现自定义分区的编程方法第八章:Hadoop性能优化8.1 Hadoop性能调优概述理解Hadoop性能调优的重要性掌握Hadoop性能调优的基本方法8.2 HDFS性能优化掌握HDFS性能优化的方法:数据块大小,副本系数等8.3 MapReduce性能优化掌握MapReduce性能优化的方法:JVM设置,Shuffle优化等第九章:Hadoop实战案例9.1 数据分析案例掌握使用Hadoop进行数据分析的实战案例理解案例中涉及的技术和解决问题的方法9.2 数据处理案例掌握使用Hadoop进行数据处理的实战案例理解案例中涉及的技术和解决问题的方法9.3 数据挖掘案例掌握使用Hadoop进行数据挖掘的实战案例理解案例中涉及的技术和解决问题的方法第十章:Hadoop项目实战10.1 Hadoop项目实战概述理解Hadoop项目实战的意义掌握Hadoop项目实战的基本流程10.2 Hadoop项目实战案例掌握一个完整的Hadoop项目实战案例理解案例中涉及的技术和解决问题的方法展望Hadoop在未来的发展和应用前景重点和难点解析重点环节1:Hadoop的设计理念和核心价值观需要重点关注Hadoop的设计理念和核心价值观,因为这是理解Hadoop生态系统的基础。

1)MapReduce概念MapReduce其实是两个分离的概念:map和reduce。

首先看一个简单的例子。

例如,现在需要计算1w篇文章中字母‘w’的数量。

这些文章以键值对(key/value)的形式存储DocumentID(key), DocumentContent(Value)1, "This is an article" //假设这篇文章中含有“w”字母5个2, "This is another article" // 含有“w”字母8个...10000, "This is the last article" //含有“w”字母9个下面是两段伪代码:map(String key, String value):// key: document name// value: document contentsfor each word w in value:EmitIntermediate(w, "1");map函数将被应用到每一个键值对。

因此第一次调用为map(1, "This is a article"),最后一次是map(10000, "This is the last article")。

全部map函数运行完毕后,将输出一个中间结果集:w, "5" //第一次调用的结果w, "8"..w, "9" //第1w次接下来工作交给了reduce函数:reduce(String key, Iterator values):// key: a word// values: a list of countsint result = 0;for each v in values:result += ParseInt(v);Emit(AsString(result));reduce函数将被应用到每一个要查询的字母上。

在此例中只有一个,"w"。

此时只调用一次, reduce("w", ["5", "8"....."9"])。

reduce做的仅仅是将数列中的所有数字相加,就得到了1w篇文章中w字母的个数。

⇧过程很简单,但里面蕴含的寓意值得深思:1,首先,因为map是对每一个键值对分别进行计算(即,map函数用来分别统计每一篇文章中w的个数),而相互之间没有什么关联。

因此map函数可以实现很高的并行度,map函数的调用可以被灵活分散到多个服务器。

map的输入一般是:(<k1, v1>)。

如上例为(int DocumentID, string ArticleContent)输出是(<k2, v2>)。

如上例是(string Word, int count).因此输出结果的key:k2通常不再是k1。

k1的信息在大部分情况下并不需要,所以会被丢弃。

例如我们通常不再需要DocumentID了。

2,其次,reduce函数实际的作用是汇总。

此时对于字母w,reduce函数的工作已不能再被划分(只有一次调用),因此reduce的并行度并不高。

但想象一下,现在的工作是统计1w篇文章中“word“,”hello“,”good“....”no“等1w个单词出现的次数,就会需要1w次reduce调用。

因此reduce在执行大量复杂任务时,仍然能实现很高的并行度。

reduce的输入一般是(<k2, list(v2)>)。

上例中即为(string Word, list<int> count).输出为(<k3, v3>)。

在上例中reduce函数就是将list<int> sum了一下,所以k2=k3.但并非所有的应用都是这样的。

⇧至此,对map和reduce给出概念:Map 函数,由用户编写,处理输入的键值对,输出一系列键值对形式的中间结果。

MapReduce架构按照每一个中间结果的key,group出另一个中间结果(即将w,"5" w, "8" ...w,"9"汇总成w,[”5“,”8“...."9"])并传递给reduce函数。

Reduce函数,也由用户编写,将键值对形式的中间结果作为输入参数。

它按key将value merge到一起(可以是求和,求平均值等多种操作),形成一个较小的结果集。

注意在实际应用中,map函数和reduce函数都可以有多个,被成为mapper和reducer。

⇧最后是MapReduce的工作过程(非常重要!)1.The MapReduce library in the user program first shards the input files into M pieces oftypically 16megabytes to 64 megabytes (MB) per piece. It then starts up many copies of theprogram on a clusterof machines.2.One of the copies of the program is special: the master. The rest are workers that areassigned workby the master. There are M map tasks and R reduce tasks to assign. The master picks idle workers and assigns each one a map task or a reduce task.3.A worker who is assigned a map task reads the contents of the corresponding input shard. Itparses key/value pairs out of the input data and passes each pair to the user-defined Mapfunction. The intermediate key/value pairs produced by the Map function are buffered in memory.4.Periodically, the buffered pairs are written to localdisk, partitioned into R regions by thepartitioning function. The locations of these buffered pairs on the local disk are passed back tothe master, who is responsible for forwarding these locations to the reduce workers.这里通常会使用一个partition函数。

5.When a reduce worker is notified by the master about these locations, it uses remoteprocedure calls to read the buffered data from the local disks of the map workers. When areduce worker has read all intermediatedata, it sorts it by the intermediate keys so that alloccurrences of the same key are grouped together. If the amount of intermediate data is toolarge to fit in memory, an external sort is used.6.The reduce worker iterates over the sorted intermediate data and for each uniqueintermediate key encountered,it passes the key and the corresponding set of intermediatevalues to the user's Reduce function.The output of the Reduce function is appended to a finaloutput file for this reduce partition.7.When all map tasks and reduce tasks have beencompleted, the master wakes up the userprogram.At this point, the MapReduce call in the user program returns back to the user code. After successful completion, the output of the MapReduce execution is available in the R output files.注意这里是R个outputfile,也就是mapper计算出结果后,被partition函数分成的R个region。

To detect failure, the master pings every worker periodically. If no responseis received from a worker in a certain amount oftime, the master marks the worker as failed. Any maptasks completed by the worker are reset back to their initialidle state, and therefore become eligible for schedulingon other workers. Similarly, any map task or reducetask in progress on a failed worker is also reset to idleand becomes eligible for rescheduling.Completed map tasks are re-executed when failure occurs becausetheir output is stored on the local disk(s) of thefailed machine and is therefore inaccessible. Completedreduce tasks do not need to be re-executed since theiroutput is stored in a global fille system.Hadoop就是当前最流行的开源MapReduce框架。