pyrosim_slideshow

- 格式:pdf

- 大小:1.53 MB

- 文档页数:16

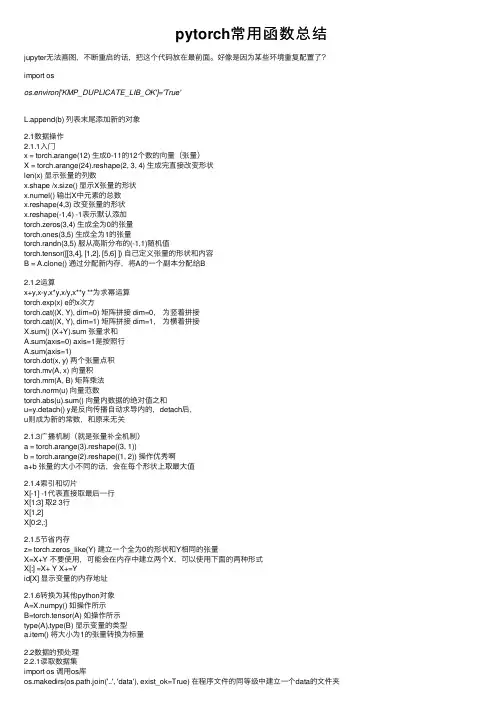

pytorch常⽤函数总结jupyter⽆法画图,不断重启的话,把这个代码放在最前⾯。

好像是因为某些环境重复配置了?import osos.environ['KMP_DUPLICATE_LIB_OK']='True'L.append(b) 列表末尾添加新的对象2.1数据操作2.1.1⼊门x = torch.arange(12) ⽣成0-11的12个数的向量(张量)X = torch.arange(24).reshape(2, 3, 4) ⽣成完直接改变形状len(x) 显⽰张量的列数x.shape /x.size() 显⽰X张量的形状x.numel() 输出X中元素的总数x.reshape(4,3) 改变张量的形状x.reshape(-1,4) -1表⽰默认添加torch.zeros(3,4) ⽣成全为0的张量torch.ones(3,5) ⽣成全为1的张量torch.randn(3,5) 服从⾼斯分布的(-1,1)随机值torch.tensor([[3,4], [1,2], [5,6] ]) ⾃⼰定义张量的形状和内容B = A.clone() 通过分配新内存,将A的⼀个副本分配给B2.1.2运算x+y,x-y,x*y,x/y,x**y **为求幂运算torch.exp(x) e的x次⽅torch.cat((X, Y), dim=0) 矩阵拼接 dim=0,为竖着拼接torch.cat((X, Y), dim=1) 矩阵拼接 dim=1,为横着拼接X.sum() (X+Y).sum 张量求和A.sum(axis=0) axis=1是按照⾏A.sum(axis=1)torch.dot(x, y) 两个张量点积torch.mv(A, x) 向量积torch.mm(A, B) 矩阵乘法torch.norm(u) 向量范数torch.abs(u).sum() 向量内数据的绝对值之和u=y.detach() y是反向传播⾃动求导内的,detach后,u则成为新的常数,和原来⽆关2.1.3⼴播机制(就是张量补全机制)a = torch.arange(3).reshape((3, 1))b = torch.arange(2).reshape((1, 2)) 操作优秀啊a+b 张量的⼤⼩不同的话,会在每个形状上取最⼤值2.1.4索引和切⽚X[-1] -1代表直接取最后⼀⾏X[1:3] 取2 3⾏X[1,2]X[0:2,:]2.1.5节省内存z= torch.zeros_like(Y) 建⽴⼀个全为0的形状和Y相同的张量X=X+Y 不要使⽤,可能会在内存中建⽴两个X,可以使⽤下⾯的两种形式X[:] =X+ Y X+=Yid[X] 显⽰变量的内存地址2.1.6转换为其他python对象A=X.numpy() 如操作所⽰B=torch.tensor(A) 如操作所⽰type(A),type(B) 显⽰变量的类型a.item() 将⼤⼩为1的张量转换为标量2.2数据的预处理2.2.1读取数据集import os 调⽤os库os.makedirs(os.path.join('..', 'data'), exist_ok=True) 在程序⽂件的同等级中建⽴⼀个data的⽂件夹data_file = os.path.join('..', 'data', 'house_tiny.csv') 在data⽂件夹中,建⽴⼀个house_tiny的csv格式的数据with open(data_file, 'w') as f: 数据的写⼊格式如下f.write('NumRooms,Alley,Price\n') # 列名f.write('NA,Pave,127500\n') # 每⾏表⽰⼀个数据样本f.write('2,NA,106000\n')f.write('4,NA,178100\n')f.write('NA,NA,140000\n')import pandas as pd 调⽤pandas库data = pd.read_csv(data_file) csv数据的读⼊格式如下。

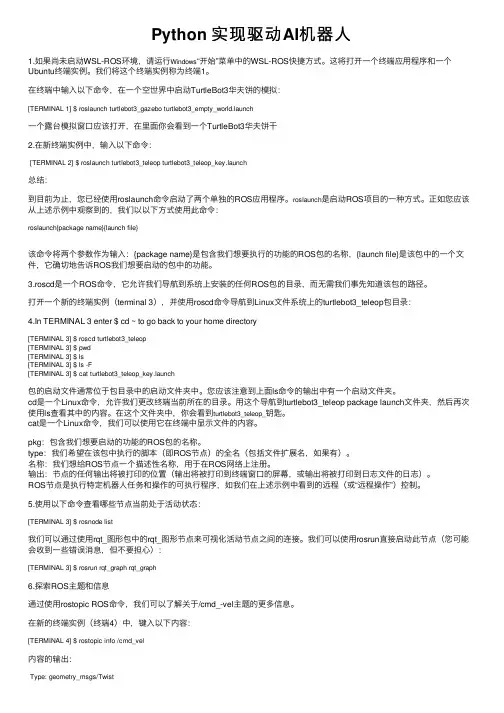

Python 实现驱动AI机器⼈1.如果尚未启动WSL-ROS环境,请运⾏Windows“开始”菜单中的WSL-ROS快捷⽅式。

这将打开⼀个终端应⽤程序和⼀个Ubuntu终端实例。

我们将这个终端实例称为终端1。

在终端中输⼊以下命令,在⼀个空世界中启动TurtleBot3华夫饼的模拟:[TERMINAL 1] $ roslaunch turtlebot3_gazebo turtlebot3_empty_unch⼀个露台模拟窗⼝应该打开,在⾥⾯你会看到⼀个TurtleBot3华夫饼⼲2.在新终端实例中,输⼊以下命令:[TERMINAL 2] $ roslaunch turtlebot3_teleop turtlebot3_teleop_unch总结:到⽬前为⽌,您已经使⽤roslaunch命令启动了两个单独的ROS应⽤程序。

roslaunch是启动ROS项⽬的⼀种⽅式。

正如您应该从上述⽰例中观察到的,我们以以下⽅式使⽤此命令:roslaunch{package name}{launch file}该命令将两个参数作为输⼊:{package name}是包含我们想要执⾏的功能的ROS包的名称,{launch file}是该包中的⼀个⽂件,它确切地告诉ROS我们想要启动的包中的功能。

3.roscd是⼀个ROS命令,它允许我们导航到系统上安装的任何ROS包的⽬录,⽽⽆需我们事先知道该包的路径。

打开⼀个新的终端实例(terminal 3),并使⽤roscd命令导航到Linux⽂件系统上的turtlebot3_teleop包⽬录:4.In TERMINAL 3 enter $ cd ~ to go back to your home directory[TERMINAL 3] $ roscd turtlebot3_teleop[TERMINAL 3] $ pwd[TERMINAL 3] $ ls[TERMINAL 3] $ ls -F[TERMINAL 3] $ cat turtlebot3_teleop_unch包的启动⽂件通常位于包⽬录中的启动⽂件夹中。

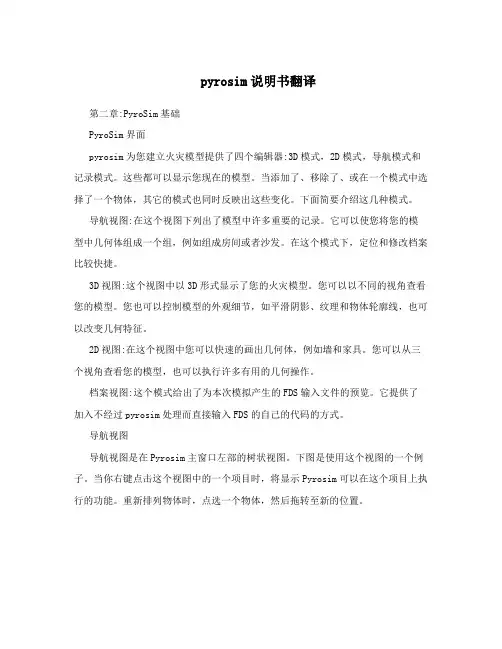

pyrosim说明书翻译第二章:PyroSim基础PyroSim界面pyrosim为您建立火灾模型提供了四个编辑器:3D模式,2D模式,导航模式和记录模式。

这些都可以显示您现在的模型。

当添加了、移除了、或在一个模式中选择了一个物体,其它的模式也同时反映出这些变化。

下面简要介绍这几种模式。

导航视图:在这个视图下列出了模型中许多重要的记录。

它可以使您将您的模型中几何体组成一个组,例如组成房间或者沙发。

在这个模式下,定位和修改档案比较快捷。

3D视图:这个视图中以3D形式显示了您的火灾模型。

您可以以不同的视角查看您的模型。

您也可以控制模型的外观细节,如平滑阴影、纹理和物体轮廓线,也可以改变几何特征。

2D视图:在这个视图中您可以快速的画出几何体,例如墙和家具。

您可以从三个视角查看您的模型,也可以执行许多有用的几何操作。

档案视图:这个模式给出了为本次模拟产生的FDS输入文件的预览。

它提供了加入不经过pyrosim处理而直接输入FDS的自己的代码的方式。

导航视图导航视图是在Pyrosim主窗口左部的树状视图。

下图是使用这个视图的一个例子。

当你右键点击这个视图中的一个项目时,将显示Pyrosim可以在这个项目上执行的功能。

重新排列物体时,点选一个物体,然后拖转至新的位置。

在导航视图中使用菜单3D视图运用3D视图可以迅速得到模型的视觉外观。

导航选项包括标准CAD控制模式,Smokeview型的控制,游戏型的控制查看模型。

3D轨道导航点击激活3D轨道导航。

这个模式的控制方式与许多CAD程序的控制模式相似。

旋转3D模型:点击后,左键点击模型并移动鼠标,模型将会随着您点选的点选转。

点选(或按住ALT键)并竖向移动鼠标。

选择后点击并拖动来定义缩放范围。

点选(或按住SHIFt键)并拖动,可以移动模型在窗口中的位置。

选择物体并点击定义在选择物体周围更小的视线范围可改变视图的焦点。

点击恢复包括整个模型的视角。

在任何时刻都可点击(或同时按下CTRL+R)复位模型。

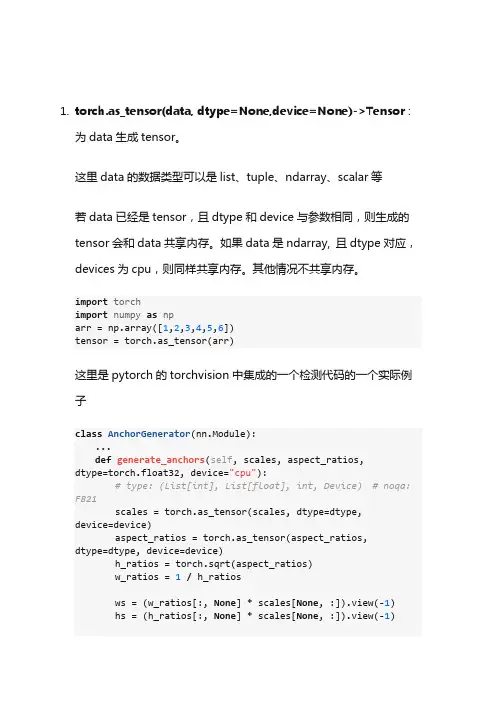

1.torch.as_tensor(data, dtype=None,device=None)->Tensor :为data生成tensor。

这里data的数据类型可以是list、tuple、ndarray、scalar等若data已经是tensor,且dtype和device与参数相同,则生成的tensor会和data共享内存。

如果data是ndarray, 且dtype对应,devices为cpu,则同样共享内存。

其他情况不共享内存。

import torchimport numpy as nparr = np.array([1,2,3,4,5,6])tensor = torch.as_tensor(arr)这里是pytorch的torchvision中集成的一个检测代码的一个实际例子class AnchorGenerator(nn.Module):...def generate_anchors(self, scales, aspect_ratios, dtype=torch.float32, device="cpu"):# type: (List[int], List[float], int, Device) # noqa: F821scales = torch.as_tensor(scales, dtype=dtype,device=device)aspect_ratios = torch.as_tensor(aspect_ratios,dtype=dtype, device=device)h_ratios = torch.sqrt(aspect_ratios)w_ratios =1/ h_ratiosws = (w_ratios[:, None] * scales[None, :]).view(-1) hs = (h_ratios[:, None] * scales[None, :]).view(-1)base_anchors = torch.stack([-ws, -hs, ws, hs], dim=1) / 2return base_anchors.round()2. torch.meshgrid()函数的用法torch.meshgrid()函数是用来生成网格的,因此也可以用于坐标生成。

1. 运行一个FDS例子1.1 启动PyroSim(并打开Example Guide, Chapter 1)。

具体就不多说了,开始>程序>…………下面是PyroSim启动时的截图,上面有中文“火”的写法,但是看起来似乎是源自日文汉字(Kanji)的火。

但是开发PyroSim的Thunderhead engineering是一家位于美国的公司。

1.2 建立网格选择Model > Edit Grid ... 在跳出的面板上点New。

把网格的边界设置为Min X = 0,Max X = 10,Min Y = 0,Max Y = 10,Min Z = 0,Max Z = 10。

同时把网格数量设为X cells = 20,Y cells = 20,Z cells = 20。

如下图所示:在FDS里面,基本形状只能是长方体的(尽管通过长方体的组合,能模拟复杂的几何形状)。

网格也只能是正交网格(点确定后可以看到)。

这个例子是模拟风洞内的燃烧,风洞尺寸为10米*10米*10米。

每边划分成20个网格,总共有8000个网格。

在FDS中,由于求解器的特殊要求,每边划分的单元数通常要求是2,3或5的倍数。

点击OK后,网格就生成了,如下图所示:1.3 定义粒子这里的粒子并不是通常CFD软件里的拉格朗日粒子,只是为了后处理方便而定义的示踪粒子。

选择Model > Edit Particles ...,然后点New。

不要选Particle Have Mass,这样粒子没有质量,仅是示踪粒子。

选中Color Particles During Animation,使用默认的颜色,红色。

这样在结果中会有红色的示踪粒子。

1.4 建立面实际上,在建立网格的时候,我们已经得到了计算模型。

这里的面是用来定义边界条件。

要注意的是,这里仅仅定义边界条件,而没有给模型中的面指定边界条件。

也就是说只定义边界上的物理条件,但并没有和模型中的边界联系起来。

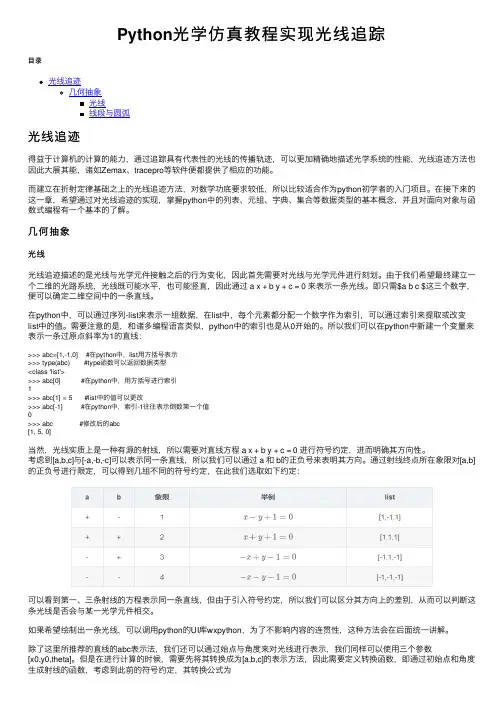

Python光学仿真教程实现光线追踪⽬录光线追迹⼏何抽象光线线段与圆弧光线追迹得益于计算机的计算的能⼒,通过追踪具有代表性的光线的传播轨迹,可以更加精确地描述光学系统的性能,光线追迹⽅法也因此⼤展其能,诸如Zemax、tracepro等软件便都提供了相应的功能。

⽽建⽴在折射定律基础之上的光线追迹⽅法,对数学功底要求较低,所以⽐较适合作为python初学者的⼊门项⽬。

在接下来的这⼀章,希望通过对光线追迹的实现,掌握python中的列表、元组、字典、集合等数据类型的基本概念,并且对⾯向对象与函数式编程有⼀个基本的了解。

⼏何抽象光线光线追迹描述的是光线与光学元件接触之后的⾏为变化,因此⾸先需要对光线与光学元件进⾏刻划。

由于我们希望最终建⽴⼀个⼆维的光路系统,光线既可能⽔平,也可能竖直,因此通过 a x + b y + c = 0 来表⽰⼀条光线。

即只需$a b c $这三个数字,便可以确定⼆维空间中的⼀条直线。

在python中,可以通过序列-list来表⽰⼀组数据,在list中,每个元素都分配⼀个数字作为索引,可以通过索引来提取或改变list中的值。

需要注意的是,和诸多编程语⾔类似,python中的索引也是从0开始的。

所以我们可以在python中新建⼀个变量来表⽰⼀条过原点斜率为1的直线:>>> abc=[1,-1,0] #在python中,list⽤⽅括号表⽰>>> type(abc) #type函数可以返回数据类型<class 'list'>>>> abc[0] #在python中,⽤⽅括号进⾏索引1>>> abc[1] = 5 #list中的值可以更改>>> abc[-1] #在python中,索引-1往往表⽰倒数第⼀个值>>> abc #修改后的abc[1, 5, 0]当然,光线实质上是⼀种有源的射线,所以需要对直线⽅程 a x + b y + c = 0 进⾏符号约定,进⽽明确其⽅向性。

第1章安装准备安装PyroSim为了工作,通过本教程,您必须能够运行PyroSim。

您可以从互联网下载PyroSim,将可获得免费试用。

单位除非另有说明,在本教程中所给予的指示,将承担PyroSim的现行SI 单位制。

如果PyroSim是使用不同的单位系统,模拟不会产生预期的结果。

为了确保您使用的是SI单位:1、在View菜单上,单击Units。

2、在Units的子菜单,确认SI是选定的。

你可以在任何时候,SI和英制单位之间切换。

数据存储在原有存储系统,所以当你切换单位时,不会损失精度。

操作的三维图像为了旋转(spin)三维模型:选择然后在模型上单击左键并移动鼠标。

该模型会旋转,就像您选择球体上的一个点。

放大zoom:选择(或按住ALT键)和垂直拖动鼠标。

选择然后按一下拖动以定义一个缩放框。

移动move模式:选择(或按住Shift键)并拖动来重新定位模型窗口。

改变重点:选择对象(S),然后选择定义一个较小的“查看选定对象周围的领域。

选择将重置,包括整个模型。

在任何时候,选择(或按Ctrl + R),将重置模型。

您还可以使用Smokeview和以人为本的控制。

请参阅用户手册为PyroSim说明。

FDS的概念和术语材料用于定义材料热性能和热解行为。

表面表面是用来定义在您的FDS模型的固体物体和通风口的属性。

在混合物或层表面可以使用先前定义的材料。

默认情况下,所有的固体物体和通风口都是有惰性的,一个固定的温度,初始温度。

障碍物障碍物的根本在火灾动力学模拟的几何表示(FDS)[FDS- SMV的官方网站]。

障碍物两点定义在三维的矩形固体空间。

表面特性,被分配到每个面对的阻挠。

设备和控制逻辑可以定义创建或删除在模拟过程中的一个障碍。

当创建一个模型,障碍物的几何形状并不需要相匹配的几何网格的解决方案中使用。

然而,产品安全的解决方案将配合所有几何解决方案网状。

在FDS分析,阻塞所有的面转移到对应最近的网状细胞。

python计算滑动验证旋转角度输出最佳角度代码滑动验证是一种常见的验证码形式,通过用户在屏幕上滑动指定的图形或滑块,以验证用户是否为真实用户而不是机器人。

在滑动验证过程中,通常会存在一些干扰元素,如旋转角度。

在本文中,我们将使用Python编写代码来计算滑动验证码中的最佳旋转角度。

为了完成这个任务,我们将使用OpenCV库来处理图像,并使用NumPy库进行数值计算和数组操作。

首先,我们需要安装这两个库。

如果你还没有安装,可以使用以下命令来安装它们:```pip install opencv-pythonpip install numpy```安装完成后,我们可以开始编写代码。

首先,我们需要导入所需的库:```pythonimport cv2import numpy as np```接下来,我们需要加载滑动验证码的图片。

请确保图片文件位于当前工作目录下,或者您可以使用完整的文件路径。

假设图片文件的名称为"captcha.png",我们可以使用以下代码加载这个图片:```pythonimage = cv2.imread("captcha.png")```在加载图片后,我们需要对图片进行一些预处理,以便后续的旋转角度计算。

首先,我们将图片转换为灰度图像:```pythongray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)```在这一步骤中,我们使用`cv2.cvtColor`函数将彩色图像转换为灰度图像。

接下来,我们需要对灰度图像进行二值化处理,以便更好地检测边缘:```python_, binary = cv2.threshold(gray, 127, 255,cv2.THRESH_BINARY_INV)```在这一步骤中,我们使用`cv2.threshold`函数将灰度图像转换为二值图像,并且反转颜色。

`cv2.threshold`函数的参数解释如下:- `gray`:输入的灰度图像- `127`:用于分割图像的阈值- `255`:超过阈值的像素值应该被设置的值- `cv2.THRESH_BINARY_INV`:指定阈值模式为二值化,并且反转颜色完成这些预处理步骤之后,我们就可以开始计算最佳旋转角度了。

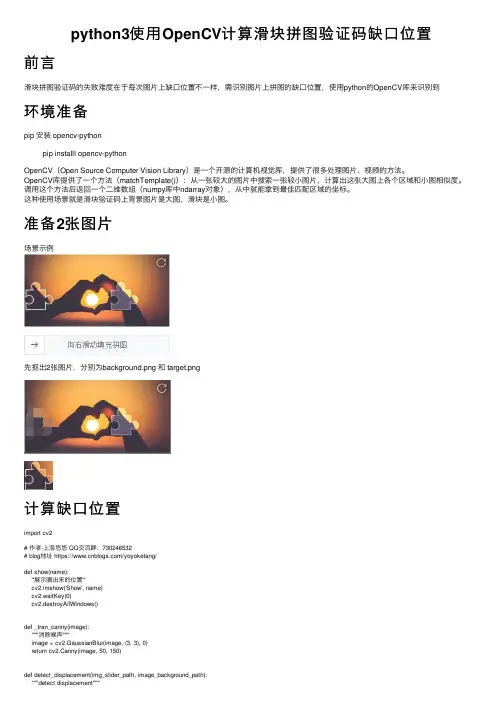

python3使⽤OpenCV计算滑块拼图验证码缺⼝位置前⾔滑块拼图验证码的失败难度在于每次图⽚上缺⼝位置不⼀样,需识别图⽚上拼图的缺⼝位置,使⽤python的OpenCV库来识别到环境准备pip 安装 opencv-pythonpip installl opencv-pythonOpenCV(Open Source Computer Vision Library)是⼀个开源的计算机视觉库,提供了很多处理图⽚、视频的⽅法。

OpenCV库提供了⼀个⽅法(matchTemplate()):从⼀张较⼤的图⽚中搜索⼀张较⼩图⽚,计算出这张⼤图上各个区域和⼩图相似度。

调⽤这个⽅法后返回⼀个⼆维数组(numpy库中ndarray对象),从中就能拿到最佳匹配区域的坐标。

这种使⽤场景就是滑块验证码上背景图⽚是⼤图,滑块是⼩图。

准备2张图⽚场景⽰例先抠出2张图⽚,分别为background.png 和 target.png计算缺⼝位置import cv2# 作者-上海悠悠 QQ交流群:730246532# blog地址 https:///yoyoketang/def show(name):'''展⽰圈出来的位置'''cv2.imshow('Show', name)cv2.waitKey(0)cv2.destroyAllWindows()def _tran_canny(image):"""消除噪声"""image = cv2.GaussianBlur(image, (3, 3), 0)return cv2.Canny(image, 50, 150)def detect_displacement(img_slider_path, image_background_path):"""detect displacement"""# # 参数0是灰度模式image = cv2.imread(img_slider_path, 0)template = cv2.imread(image_background_path, 0)# 寻找最佳匹配res = cv2.matchTemplate(_tran_canny(image), _tran_canny(template), cv2.TM_CCOEFF_NORMED) # 最⼩值,最⼤值,并得到最⼩值, 最⼤值的索引min_val, max_val, min_loc, max_loc = cv2.minMaxLoc(res)top_left = max_loc[0] # 横坐标# 展⽰圈出来的区域x, y = max_loc # 获取x,y位置坐标w, h = image.shape[::-1] # 宽⾼cv2.rectangle(template, (x, y), (x + w, y + h), (7, 249, 151), 2)show(template)return top_leftif __name__ == '__main__':top_left = detect_displacement("target.png", "background.png")print(top_left)运⾏效果看到⿊⾊圈出来的地⽅就说明找到了缺⼝位置调试完成后去掉 show 的这部分代码# 展⽰圈出来的区域# x, y = max_loc # 获取x,y位置坐标# w, h = image.shape[::-1] # 宽⾼# cv2.rectangle(template, (x, y), (x + w, y + h), (7, 249, 151), 2)# show(template)缺⼝的位置只需得到横坐标,距离左侧的位置top_left为184。

Python中的多媒体处理和可视化技巧随着计算机技术和互联网的快速发展,多媒体处理和可视化的技术在各个领域中得到了广泛应用。

Python作为一种强大的编程语言和流行的数据处理工具,也可以用于实现各种多媒体处理和可视化技巧。

本文将从Python中的多媒体文件处理、音频处理、图像处理和可视化四个方面进行探讨。

一、Python中的多媒体文件处理多媒体文件处理是多媒体技术的重要分支之一。

Python中有许多库可以用于多媒体文件的处理,其中最为常用的就是Pillow库。

Pillow库是Python Imaging Library(简称PIL)的继承版本,它提供了多种图像处理方法,包括图像格式转换、图像缩放、图像旋转、图像剪裁等功能。

Pillow库还提供了图像的滤波操作。

在图像处理中,滤波是一种重要的技术,用于增强图像的对比度、增加图像的细节等。

Pillow库中包含了各种常用的滤波器,如模糊滤波器、锐化滤波器、边缘检测滤波器等。

除了Pillow库,Python中还有很多其他的多媒体文件处理库,如pydub库可以用于音频文件处理,moviepy库可以用于视频文件处理等。

这些库的出现极大地方便了Python中多媒体文件的处理。

二、Python中的音频处理音频处理是Python中的另一重要应用领域。

Python中的音频处理主要涉及音频文件的读取、编辑和生成。

Python中最常用的音频处理库是pydub库。

pydub库可以读取多种音频格式,如WAV、MP3、AIFF等,并提供了对这些音频文件的基本编辑操作,如剪裁音频、混音音频、调整音量等。

此外,pydub库还可以将多个音频文件合并为一个文件,并将音频文件导出为多种格式。

除了pydub库,Python中还有其他的音频处理库,如audiolazy库可以用于音频数据的实时处理,LibROSA库可以用于音频信号的分析、特征提取和可视化等。

三、Python中的图像处理Python中的图像处理可以分为静态图像处理和动态图像处理两类。

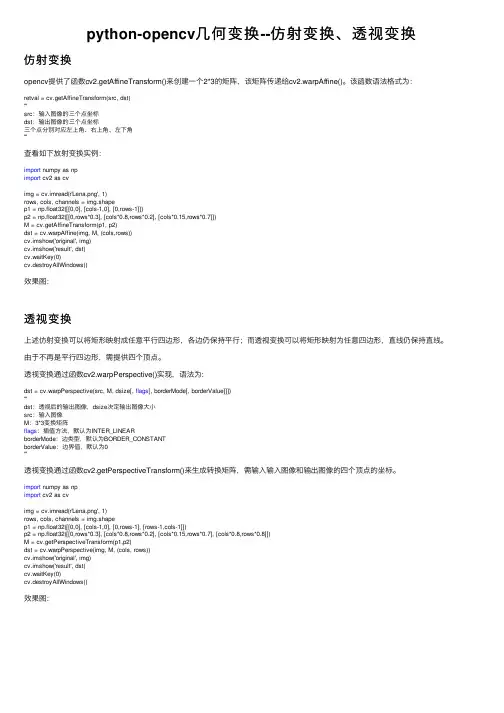

python-opencv⼏何变换--仿射变换、透视变换仿射变换opencv提供了函数cv2.getAffineTransform()来创建⼀个2*3的矩阵,该矩阵传递给cv2.warpAffine()。

该函数语法格式为:retval = cv.getAffineTransform(src, dst)'''src:输⼊图像的三个点坐标dst:输出图像的三个点坐标三个点分别对应左上⾓、右上⾓、左下⾓'''查看如下放射变换实例:import numpy as npimport cv2 as cvimg = cv.imread(r'Lena.png', 1)rows, cols, channels = img.shapep1 = np.float32([[0,0], [cols-1,0], [0,rows-1]])p2 = np.float32([[0,rows*0.3], [cols*0.8,rows*0.2], [cols*0.15,rows*0.7]])M = cv.getAffineTransform(p1, p2)dst = cv.warpAffine(img, M, (cols,rows))cv.imshow('original', img)cv.imshow('result', dst)cv.waitKey(0)cv.destroyAllWindows()效果图:透视变换上述仿射变换可以将矩形映射成任意平⾏四边形,各边仍保持平⾏;⽽透视变换可以将矩形映射为任意四边形,直线仍保持直线。

由于不再是平⾏四边形,需提供四个顶点。

透视变换通过函数cv2.warpPerspective()实现,语法为:dst = cv.warpPerspective(src, M, dsize[, flags[, borderMode[, borderValue]]])'''dst:透视后的输出图像,dsize决定输出图像⼤⼩src:输⼊图像M:3*3变换矩阵flags:插值⽅法,默认为INTER_LINEARborderMode:边类型,默认为BORDER_CONSTANTborderValue:边界值,默认为0'''透视变换通过函数cv2.getPerspectiveTransform()来⽣成转换矩阵,需输⼊输⼊图像和输出图像的四个顶点的坐标。

python实现Simhash算法1、simhash步骤simhash包含分词、hash、加权、合并、降维五⼤步骤simhash代码如下:import jiebaimport jieba.analyseimport numpy as npclass SimHash(object):def simHash(self, content):seg = jieba.cut(content)# jieba.analyse.set_stop_words('stopword.txt')# jieba基于TF-IDF提取关键词keyWords = jieba.analyse.extract_tags("|".join(seg), topK=10, withWeight=True)keyList = []for feature, weight in keyWords:# print('feature:' + feature)print('weight: {}'.format(weight))# weight = math.ceil(weight)weight = int(weight)binstr = self.string_hash(feature)print('feature: %s , string_hash %s' % (feature, binstr))temp = []for c in binstr:if (c == '1'):temp.append(weight)else:temp.append(-weight)keyList.append(temp)listSum = np.sum(np.array(keyList), axis=0)if (keyList == []):return '00'simhash = ''for i in listSum:if (i > 0):simhash = simhash + '1'else:simhash = simhash + '0'return simhashdef string_hash(self, source):if source == "":return 0else:temp = source[0]temp1 = ord(temp)x = ord(source[0]) << 7m = 1000003mask = 2 ** 128 - 1for c in source:x = ((x * m) ^ ord(c)) & maskx ^= len(source)if x == -1:x = -2x = bin(x).replace('0b', '').zfill(64)[-64:]return str(x)def getDistance(self, hashstr1, hashstr2):'''计算两个simhash的汉明距离'''length = 0for index, char in enumerate(hashstr1):if char == hashstr2[index]:continueelse:length += 1return length1.1分词分词是将⽂本⽂档进⾏分割成不同的词组,⽐如词1为:今天星期四,词2为:今天星期五得出分词结果为【今天,星期四】【今天,星期五】1.2hashhash是将分词结果取hash值星期四hash为:0010001100100000101001101010000000101111011010010001100011011110今天hash为:0010001111010100010011110001110010100011110111111011001011110101星期五hash为:00100011001000001010011010100000001011110110100100000000100100011.3加权1.4合并1.5降维降维是将合并的结果进⾏降维,如果值⼤于0,则置为1⼩于0 则置为0,因此得到的结果为:2、simhash⽐对⼀般simhash采⽤海明距离来进⾏计算相似度,海明距离计算如下:对于A,B两个n维⼆进制数⼆者的海明距离为:其中:举例:1000与1111的海明距离为3到此这篇关于python实现Simhash算法的⽂章就介绍到这了,更多相关python实现Simhash算法内容请搜索以前的⽂章或继续浏览下⾯的相关⽂章希望⼤家以后多多⽀持!。

Python的物理仿真和动效果Python是一种简单易学的编程语言,它具有强大的库和模块,可以实现各种不同的功能。

其中,物理仿真和动效果是Python编程中常见且重要的应用之一。

本文将介绍Python中的物理仿真和动效果的相关知识,并展示一些实例。

一、物理仿真的基本原理物理仿真是指使用数学模型和计算机算法来模拟真实世界中的物理现象。

在Python中,物理仿真常通过牛顿力学的基本原理来进行。

牛顿第二定律 F=ma 可以描述物体在外力作用下的运动状态。

结合欧拉法或者Runge-Kutta法等数值计算方法,可以根据初始条件和外力情况,实现对物体运动轨迹的仿真和预测。

二、使用Python进行物理仿真Python提供了一些强大的库和模块,如NumPy和SciPy,可以方便地进行数学计算和科学计算。

这些库和模块提供了丰富的函数和工具,可以用于解决物理仿真问题。

比如,可以使用NumPy中的数组和矩阵操作,实现对物体位置和速度的计算;可以使用SciPy中的ODEINT函数,求解微分方程,得到物体的运动轨迹。

三、动效果的实现方法除了物理仿真,Python还可以用于实现各种动效果,如动画、过渡效果等。

在Python中,可以使用一些特定的库和模块,如Matplotlib和Pygame,来实现这些动效果。

Matplotlib是一个强大的绘图库,可以用于生成各种图表和动画;Pygame是一个游戏开发库,可以用于实现游戏动画等。

四、物理仿真和动效果的应用领域1. 游戏开发:物理仿真和动效果在游戏开发中扮演着重要的角色。

通过使用Python进行物理仿真和动效果的计算,可以使得游戏中的物体运动更加逼真,并增加游戏的可玩性和视觉效果。

2. 电影动画:Python在电影动画制作中也有广泛的应用。

通过使用Python进行物理仿真和动效果的计算,可以模拟真实世界中的物理特性,如重力、碰撞等,使得电影动画更加真实和生动。

3. 科学研究:物理仿真和动效果在科学研究中也有重要的应用。

基于Pytorch版yolov5的滑块验证码破解思路详解前⾔本⽂将使⽤pytorch框架的⽬标识别技术实现滑块验证码的破解。

我们这⾥选择了yolov5算法例:输⼊图像输出图像可以看到经过检测之后,我们能很准确的定位到缺⼝的位置,并且能得到缺⼝的坐标,这样⼀来我们就能很轻松的实现滑动验证码的破解。

⼀.前期⼯作yolov系列是常⽤的⽬标检测算法,yolov5不仅配置简单,⽽且在速度上也有不⼩的提升,我们很容易就能训练我们⾃⼰的数据集。

YOLOV5 Pytorch版本GIthub⽹址感谢这位作者的代码。

下载之后,是这样的格式---data/Annotations/ 存放图⽚的标注⽂件(.xml)images/ 存放待训练的图⽚ImageSets/ 存放划分数据集的⽂件labels/ 存放图⽚的⽅框信息其中只需要修改Annotations和images两个⽂件夹。

⾸先我们将待训练的图⽚放⼊images数据集已上传百度云提取码: wqi8然后我们需要对其进⾏标注,告诉计算机我们希望它识别什么内容。

这时候我们需要精灵标注这款软件。

免费⽽且功能强⼤,五星好评!第⼀步选择images⽂件夹,第⼆步有⼏类就写⼏类,建议⽤英⽂。

这⾥只有⼀类,即为缺失快的位置,命名为target。

注意标注的时候要左右恰好卡住,不然获得的坐标就不精准。

标注完成后,点击导出,⽂件格式不⽤动,直接点确定,就会在images/outputs⽂件夹⽣成我们的标注⽂件。

全部复制到Annotations⽂件夹即可。

回到主⽬录,运⾏makeTxt.py和voc_label.py,makeTxt直接运⾏即可,voc_label需要修改classes的值,这次只有⼀targetimport xml.etree.ElementTree as ETimport pickleimport os# os.listdir() ⽅法⽤于返回指定的⽂件夹包含的⽂件或⽂件夹的名字的列表from os import listdir, getcwdfrom os.path import joinsets = ['train', 'test', 'val']classes = ['target'] #之前标注时有⼏个类,这⾥就输⼊⼏个类"""............"""进⼊data⽂件夹,修改coco.yaml的内容# COCO 2017 dataset # Download command: bash yolov5/data/get_coco2017.sh# Train command: python train.py --data ./data/coco.yaml# Dataset should be placed next to yolov5 folder:# /parent_folder# /coco# /yolov5# train and val datasets (image directory or *.txt file with image paths)train: ../coco/train2017.txt # 118k imagesval: ../coco/val2017.txt # 5k imagestest: ../coco/test-dev2017.txt # 20k images for submission to https:///competitions/20794# number of classesnc: 1# class namesnames: ['target']# Print classes# with open('data/coco.yaml') as f:# d = yaml.load(f, Loader=yaml.FullLoader) # dict# for i, x in enumerate(d['names']):# print(i, x)再进⼊models⽂件夹,修改yolov5s.yaml的内容nc: 1 # number of classesdepth_multiple: 0.33 # model depth multiplewidth_multiple: 0.50 # layer channel multiple"""''''''''''''"""⾄此配置环节终于结束了,可以开始训练了!打开train.py,我们⼀般只需要修改–weights,–cfg,–data,–epochs⼏个设置即可parser = argparse.ArgumentParser()parser.add_argument('--weights', type=str, default='yolov5s.pt', help='initial weights path')parser.add_argument('--cfg', type=str, default='models/yolov5s.yaml', help='model.yaml path')parser.add_argument('--data', type=str, default='data/coco.yaml', help='data.yaml path')parser.add_argument('--hyp', type=str, default='data/hyp.scratch.yaml', help='hyperparameters path')parser.add_argument('--epochs', type=int, default=300)parser.add_argument('--batch-size', type=int, default=16, help='total batch size for all GPUs')parser.add_argument('--img-size', nargs='+', type=int, default=[640, 640], help='[train, test] image sizes')parser.add_argument('--rect', action='store_true', help='rectangular training')parser.add_argument('--resume', nargs='?', const=True, default=False, help='resume most recent training')parser.add_argument('--nosave', action='store_true', help='only save final checkpoint')parser.add_argument('--notest', action='store_true', help='only test final epoch')parser.add_argument('--noautoanchor', action='store_true', help='disable autoanchor check')parser.add_argument('--evolve', action='store_true', help='evolve hyperparameters')parser.add_argument('--bucket', type=str, default='', help='gsutil bucket')parser.add_argument('--cache-images', action='store_true', help='cache images for faster training')parser.add_argument('--image-weights', action='store_true', help='use weighted image selection for training')parser.add_argument('--device', default='', help='cuda device, i.e. 0 or 0,1,2,3 or cpu')parser.add_argument('--multi-scale', action='store_true', help='vary img-size +/- 50%%')parser.add_argument('--single-cls', action='store_true', help='train multi-class data as single-class')parser.add_argument('--adam', action='store_true', help='use torch.optim.Adam() optimizer')parser.add_argument('--sync-bn', action='store_true', help='use SyncBatchNorm, only available in DDP mode')parser.add_argument('--local_rank', type=int, default=-1, help='DDP parameter, do not modify')parser.add_argument('--log-imgs', type=int, default=16, help='number of images for W&B logging, max 100')parser.add_argument('--log-artifacts', action='store_true', help='log artifacts, i.e. final trained model')parser.add_argument('--workers', type=int, default=4, help='maximum number of dataloader workers')parser.add_argument('--project', default='runs/train', help='save to project/name')parser.add_argument('--name', default='exp', help='save to project/name')parser.add_argument('--exist-ok', action='store_true', help='existing project/name ok, do not increment')opt = parser.parse_args()直接运⾏train.py,开始训练!。

Pytorch模型量化介绍PyTorch是一个基于Python的科学计算库,它是深度学习领域的一个重要工具。

模型量化是指将模型中的参数和激活值由32位浮点数转换为低精度的表示形式,以减少模型的计算和存储需求,提高模型的执行效率。

模型量化的优点是显而易见的。

首先,它可以减少模型的内存占用和计算需求,使得模型能够在资源有限的设备上更高效地运行。

其次,低精度的表示形式可以减少模型在传输过程中的带宽需求,使得模型能够更快地传输,适应于边缘设备和移动设备等带宽有限的环境。

此外,模型量化还可以提高模型的训练速度,使得模型能够更快地收敛和收敛到更好的结果。

PyTorch提供了一些工具和技术来帮助开发者进行模型量化。

其中最常用的是将模型参数转换为低精度格式的量化操作,例如将32位浮点数转换为8位整数。

PyTorch还为量化操作提供了一组优化算法,例如基于梯度裁剪的量化算法和基于误差传播的量化算法,这些算法可以通过迭代优化模型的精度和效率。

此外,PyTorch还提供了一些量化工具,例如用于计算模型的输入和输出范围的量化器和用于评估模型精度和效率的量化测量器。

在进行模型量化之前,开发者需要确定模型的量化策略。

常见的策略包括权重量化和激活量化。

权重量化是指将模型中的权重参数转换为低精度格式,例如将32位浮点数转换为8位整数。

激活量化是指将模型中的激活值转换为低精度格式,例如将32位浮点数转换为8位整数。

权重量化和激活量化可以单独使用,也可以同时使用。

在进行模型量化之后,开发者可以通过一些技术来进一步优化模型的精度和效率。

例如,可以使用训练时量化技术将量化误差引入模型的训练过程中,从而提高模型的精度。

另外,还可以使用自适应量化技术根据模型的不同部分和输入数据的不同分布来调整量化的精度,从而提高模型的效率。

此外,还可以使用量化感知训练技术通过构建一个量化模型和一个高精度模型之间的连接来优化模型的精度和效率。

总之,PyTorch提供了丰富的工具和技术来帮助开发者进行模型量化。

Layered(分层)Layered surfaces are composed of one or more material definitions. Materials includesolid andliquid substances such as concrete(混泥土), pine(松木), and ethanol(乙醇).BackingThe backing of a surface is the boundary condition behindthe surface. The default value, Air Gap represents an air gap, Exposed will allow the surface to transfer heat into the space behind the wall, and Insulated prevents any heat loss from the back of the material.Material CompositionWithin a layer (row), you can specify multiple materials based on mass fraction. For example, to specify a layer that is just brick, type 1.0 BRICK (assuming you have created a material called BRICK). To specify a layer of wet brick, you could enter 0.95 BRICK; 0.05 WATER. Each material is separated by a semi-colon.Porous(能穿透)The property is generally used to create a fan using a thin obstruction.Enable LeakageThis option allows you to select two pressure zones for leakage across the surface.Air LeakAir leak surfaces can be used to create a permeable barrier between two pressure zones. The porous option is available to allow air movement to occur across this obstructions using this surface.Adding Textures to SurfacesYou can add textures to surfaces to increase the realism of your model. Some default textures are provided or you can import your own. The Room Fire example demonstrates using a wood texture for a pine floor and hanging a picture on a wall. Your textures will be automatically displayed in PryoSim; to display textures in Smokeview, select Textures on the Show/Hide menu.To define a texture:1. On the Model menu, click Edit Surface s....2. Either create or edit the surface to which you want to add a texture.3. Click on the Texture box.4. Either select a pre-defined texture or click the Import... button and select your own image file.5. The image you selected will be displayed. Under the image, click the Details tab. Set theWidth and the Height values to correspond to size to be used in the PyroSim model.Obstruction PropertiesSmoothPrevents vorticity(漩涡)from being generated at the corners. This option is used to prevent flow problems along angled walls due to the stair-stepped(楼梯), rectilinear geometry used by FDS.Record BNDFWhen this option is selected, this object is included in boundary data output.Chapter 14. Activation EventsActivation events使用状况:1.模拟门在某个时间打开;2.模拟窗在某个时间打开;3.模拟通风系统在某个时间开启;Chapter 15. Output ControlsSolid Profiles测量固体的温度和密度。

python实现三维拟合的⽅法如下所⽰:from matplotlib import pyplot as pltimport numpy as npfrom mpl_toolkits.mplot3d import Axes3Dfig = plt.figure()ax = Axes3D(fig)#列出实验数据point=[[2,3,48],[4,5,50],[5,7,51],[8,9,55],[9,12,56]]plt.xlabel("X1")plt.ylabel("X2")#表⽰矩阵中的值ISum = 0.0X1Sum = 0.0X2Sum = 0.0X1_2Sum = 0.0X1X2Sum = 0.0X2_2Sum = 0.0YSum = 0.0X1YSum = 0.0X2YSum = 0.0#在图中显⽰各点的位置for i in range(0,len(point)):x1i=point[i][0]x2i=point[i][1]yi=point[i][2]ax.scatter(x1i, x2i, yi, color="red")show_point = "["+ str(x1i) +","+ str(x2i)+","+str(yi) + "]"ax.text(x1i,x2i,yi,show_point)ISum = ISum+1X1Sum = X1Sum+x1iX2Sum = X2Sum+x2iX1_2Sum = X1_2Sum+x1i**2X1X2Sum = X1X2Sum+x1i*x2iX2_2Sum = X2_2Sum+x2i**2YSum = YSum+yiX1YSum = X1YSum+x1i*yiX2YSum = X2YSum+x2i*yi# 进⾏矩阵运算# _mat1 设为 mat1 的逆矩阵m1=[[ISum,X1Sum,X2Sum],[X1Sum,X1_2Sum,X1X2Sum],[X2Sum,X1X2Sum,X2_2Sum]]mat1 = np.matrix(m1)m2=[[YSum],[X1YSum],[X2YSum]]mat2 = np.matrix(m2)_mat1 =mat1.getI()mat3 = _mat1*mat2# ⽤list来提取矩阵数据m3=mat3.tolist()a0 = m3[0][0]a1 = m3[1][0]a2 = m3[2][0]# 绘制回归线x1 = np.linspace(0,9)x2 = np.linspace(0,12)y = a0+a1*x1+a2*x2ax.plot(x1,x2,y)show_line = "y="+str(a0)+"+"+str(a1)+"x1"+"+"+str(a2)+"x2"plt.title(show_line)plt.show()以上这篇python实现三维拟合的⽅法就是⼩编分享给⼤家的全部内容了,希望能给⼤家⼀个参考,也希望⼤家多多⽀持。