DE算法概述 - 副本

- 格式:pptx

- 大小:224.08 KB

- 文档页数:9

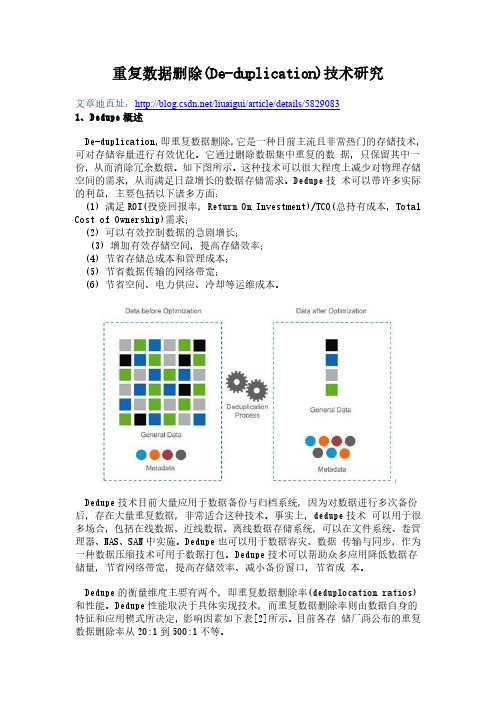

重复数据删除(De-duplication)技术研究文章地直址:/liuaigui/article/details/58290831、Dedupe概述De-duplication,即重复数据删除,它是一种目前主流且非常热门的存储技术,可对存储容量进行有效优化。

它通过删除数据集中重复的数据,只保留其中一份,从而消除冗余数据。

如下图所示。

这种技术可以很大程度上减少对物理存储空间的需求,从而满足日益增长的数据存储需求。

Dedupe技术可以带许多实际的利益,主要包括以下诸多方面:(1) 满足ROI(投资回报率,Return On Investment)/TCO(总持有成本,Total Cost of Ownership)需求;(2) 可以有效控制数据的急剧增长;(3) 增加有效存储空间,提高存储效率;(4) 节省存储总成本和管理成本;(5) 节省数据传输的网络带宽;(6) 节省空间、电力供应、冷却等运维成本。

Dedupe技术目前大量应用于数据备份与归档系统,因为对数据进行多次备份后,存在大量重复数据,非常适合这种技术。

事实上,dedupe技术可以用于很多场合,包括在线数据、近线数据、离线数据存储系统,可以在文件系统、卷管理器、NAS、SAN中实施。

Dedupe也可以用于数据容灾、数据传输与同步,作为一种数据压缩技术可用于数据打包。

Dedupe技术可以帮助众多应用降低数据存储量,节省网络带宽,提高存储效率、减小备份窗口,节省成本。

Dedupe的衡量维度主要有两个,即重复数据删除率(deduplocation ratios)和性能。

Dedupe性能取决于具体实现技术,而重复数据删除率则由数据自身的特征和应用模式所决定,影响因素如下表[2]所示。

目前各存储厂商公布的重复数据删除率从20:1到500:1不等。

2、Dedupe实现要点研发或应用Dedupe技术时应该考虑各种因素,因为这些因素会直接影响其性能和效果。

第六章、数据同步算法研究1、引言基于LAN或WAN的网络应用之间进行数据传输或者同步非常普遍,比如远程数据镜像、备份、复制、同步,数据下载、上传、共享等等,最为简单的做法自然就是对数据进行完全复制。

然而,数据在网络上来回被复制多次后就会存在大量副本,很多情形下这些文件副本之间仅有很小的差异,很可能是从同一个文件版本演化而来。

如果对文件进行完全复制,在文件较大的情况下,会占用大量网络带宽,同步时间也会较长。

目前,广域网WAN的带宽与访问延迟仍然是急需解决的问题,完全复制使得很多网络应用无法提供良好的服务质量,比如分布式文件系统(DFS)、云存储(Cloud Storage)。

Rsync与RDC(Remote Differential Compression)是两种最为常见的数据同步算法,它们仅传输差异数据,从而节省网络带宽并提高效率。

本文基于这两种算法思想并借助重复数据删除(De-duplication)技术,对数据同步算法进行深入研究与分析,并研发了原型系统。

首先介绍rsync与RDC算法,然后详细描述算法设计与相应的数据结构,并重点分析文件分块、差异编码、文件同步算法,最后简介推拉两种应用模式。

2、相关工作Rsync是类Unix环境下的一个高效的远程文件复制(同步)工具,它通过著名的Rsync算法来优化流程,减少了数据通信量并提高文件传输效率。

假设现在有两台计算机Alpha和Beta ,计算机Alpha能够访问A文件,计算机Beta能够访问B文件,文件A和B非常相似,计算机Alpha和Beta通过低速网络互联。

它的大致流程如下(详细过程请参考Rsync作者Andrew Tridgell的tech_report.ps):1、Beta将文件B分割成连续不重叠的固定大小数据块S,最后一个数据块上可能会小于S字节;2、Beta对于每一个数据块,计算出两个校验值,一个32位的弱滚动校验和一个128位的MD4校验;3、Beta将校验值发送给Alpha;4、Alpha通过搜索文件A的所有大小为S的数据块(偏移量可以任意,不一定非要是S的倍数),来寻找与文件B的某一块有着相同的弱校验码和强校验码的数据块。

oceanbase副本概念(二)OceanBase副本概念简述概念•副本副本是指在分布式数据库系统中将数据在不同节点上进行冗余复制的过程。

副本可以提供数据的高可用性和冗余,保证数据不会因为单点故障而丢失。

•OceanBaseOceanBase是阿里巴巴集团自主研发的一种分布式数据库系统。

它是以分布式共识和存储为核心的新一代数据库系统,具备高可用、高可扩展、高并发和高性能的特点。

相关内容•副本复制在OceanBase中,副本复制是通过将数据同时写入多个副本节点来实现的。

当客户端向主节点写入数据时,主节点会将数据复制给其他副本节点,确保数据在不同节点上的冗余存储。

•副本选主OceanBase采用了一种副本选主的机制来保证数据的一致性。

副本选主过程中,通过Raft选举算法选举出新的主节点,确保在主节点故障或网络分区情况下仍能确保数据的一致性。

•副本追赶当主节点发生故障或网络异常时,新选出的主节点需要进行副本追赶。

副本追赶过程中,新的主节点会通过日志同步的方式将数据同步给其他副本节点,使其与新主节点的数据保持一致。

•副本一致性OceanBase通过Raft共识算法来保证副本节点之间的一致性。

Raft算法采用了分布式日志复制的方式,在副本节点之间进行数据同步,确保数据的一致性和可靠性。

•副本容灾OceanBase的副本容灾机制可以保证在节点故障或网络异常情况下,数据仍能正常访问。

当副本节点发生故障时,系统会自动选择其他副本节点进行数据访问,保证数据的高可靠性和可用性。

•副本数据同步OceanBase采用了增量数据同步和全量数据同步相结合的方式来实现副本数据的同步。

增量数据同步是通过复制主节点的日志来实现的,而全量数据同步则是在副本追赶阶段进行的,确保副本节点与主节点的数据一致。

•副本就近原则OceanBase会将副本节点尽可能地放置在离主节点近的位置,以减少数据传输的延迟。

副本就近原则可以提高数据访问的性能和效率,使系统能更好地应对高并发和大规模数据的需求。

极码:主要概念和实用译码算法摘要极码代表一类新兴的纠错码,他的功率接近一个离散无记忆信道的容量。

本文旨在说明其生成与解码技术的原则。

与传统能力编码策略不同,它试图让代码尽可能随机,极性代码遵循不同的原理,这也是由香农通过创建一个典型共同组提出的。

信道极化,一个概念的核心,就是极性代码,在数字世界中的马太效应之中被直观地阐述,对极性编码的构造方法进行了详细的概述。

极性码蝴蝶结构介绍中,源位相关,证明SC算法的使用为有效的解码。

从概念和实践的角度研究了供应链解码技术。

最先进的解码算法,如BP和一些广义的SC解码,也在一个广泛的框架下解释了。

仿真结果表明,极性码的级联与CRC码的性能优于Turbo码和LDPC码。

一些在实际情况下有前途的研究方向在最后也被讨论。

摘要 (1)引言 (1)通道极化 (2)编码和结构 (4)编码原则 (5)通道选择 (6)连续取消解码 (7)解码原理 (8)简单SC译码过程 (9)更有力的译码算法 (10)提高的SC译码过程 (10)CRC-AIDED解码 (12)置信传播解码 (12)ML或MAP解码 (12)优点和缺点 (13)极性码的缺点 (14)未来的研究方向 (15)结论 (16)附录 (16)引言在过去的六年中见证了数字通信编码理论的成功。

克劳德·香农著名的信道编码定理断言代码的存在,信息可以在可靠的噪声信道上传输速率信道容量。

三个基本想法背后的信道编码定理的证明是:(1).随机选择的代码(2).对于大型代码长度的联合渐近等分(AEP)之间的传输码字和接收序列。

(3).最优最大似然(ML)解码或次优联合典型的解码。

联合AEP在证明过程中扮演着重要的角色,在某种意义上,它保证接收到的序列与共同典型传输码字相似,并且共同典型解码错误的概率消失。

当然随机编码也很重要,但只是为了便于数学证明好的代码的存在。

逼近能力与实际编/解码复杂度是编码理论的一个主要挑战。

幸运的是,在过去的二十年里许多“turbo-like”代码家族,如涡轮码和低密度奇偶校验(LDPC)码,已经被发现实现这一目标。

des加密算法的轮结构,并注明每一步过程中输入和输出的比特数。

DES加密算法的轮结构是一种对称分组密码算法,采用了密钥和明文的混淆、扩散和逐位混淆等操作。

其轮结构包括初始置换、Feistel结构的重复轮、逆初始置换,每一步过程中输入和输出的比特数如下所示。

初始置换:输入为64比特,输出为64比特。

Feistel结构的重复轮:输入为64比特,输出为64比特。

逆初始置换:输入为64比特,输出为64比特。

DES加密算法的轮结构主要分为三个步骤,以下将一步一步回答中括号内的问题。

1. 初始置换:初始置换是对明文进行初始的置换操作,将输入的64比特明文按照预定的置换表进行重排,产生置换后的比特串。

初始置换的目的是将明文分散到不同的位置,增加加密的强度并减少明文的相关性。

输入为64比特明文,输出为64比特置换后的结果。

2. Feistel结构的重复轮:Feistel结构是DES加密算法的核心部分,通过对明文进行多轮的混合和置换操作,实现密文的生成。

每一轮中,明文被分为左右两个32比特的部分,然后进行以下操作:- 右半部分进行扩展:通过置换表将右半部分32比特的输入扩展为48比特。

- 扩展的结果与轮密钥进行异或运算:扩展结果与当前轮的子密钥进行异或操作,得到48比特的结果。

- 48比特的结果进行S盒替代:将48比特的结果划分为8个6比特的部分,分别通过8个不同的S盒进行替代,得到32比特的结果。

- S盒替代结果进行P置换:通过置换表对S盒替代结果进行重排,得到32比特的结果。

- 左半部分与P置换结果进行异或运算:左半部分与P置换结果进行异或操作,得到最终的结果。

重复上述的操作,直到达到指定的轮数。

输入为64比特明文,输出为64比特密文。

3. 逆初始置换:逆初始置换是对加密后的比特串进行逆操作,通过按照逆置换表进行重新排列,得到最终的密文。

逆初始置换的目的是恢复密文的排列,使得解密时可以还原为明文。

输入为64比特密文,输出为64比特逆置换后的结果。

MD5加密算法与SHA加密算法2、MD5加密2.1?概述Message Digest Algorithm MD5(中文名为消息摘要算法第五版)为计算机安全领域广泛使用的一种散列函数,用以提供消息的完整性保护。

该算法的文件号为RFC1321(R.Rivest,MIT Laboratory for Computer Science and RSA Data Security Inc. April 1992).MD5的全称是Message-Digest Algorithm 5(信息-摘要算法),在90年代初由MITLaboratory for Computer Science和RSA Data Security Inc的RonaldL. Rivest开发出来,经MD2、MD3和MD4发展而来。

MD5用于确保信息传输完整一致。

是计算机广泛使用的杂凑算法之一(又译摘要算法、哈希算法),主流编程语言普遍已有MD5实现。

将数据(如汉字)运算为另一固定长度值,是杂凑算法的基础原理,MD5的前身有MD2、MD3和MD4。

MD5的作用是让大容量信息在用数字签名软件签署私人密钥前被"压缩"成一种保密的格式(就是把一个任意长度的字节串变换成一定长的十六进制数字串)。

2.2?算法原理对MD5算法简要的叙述可以为:MD5以512位分组来处理输入的信息,且每一分组又被划分为16个32位子分组,经过了一系列的处理后,算法的输出由四个32位分组组成,将这四个32位分组级联后将生成一个128位散列值。

在MD5算法中,首先需要对信息进行填充,使其位长对512求余的结果等于448。

因此,信息的位长(Bits Length)将被扩展至N*512+448,N为一个非负整数,N可以是零。

填充的方法如下,在信息的后面填充一个1和无数个0,直到满足上面的条件时才停止用0对信息的填充。

然后,在这个结果后面附加一个以64位二进制表示的填充前信息长度。