第4章-单符号离散信道

- 格式:ppt

- 大小:1.44 MB

- 文档页数:117

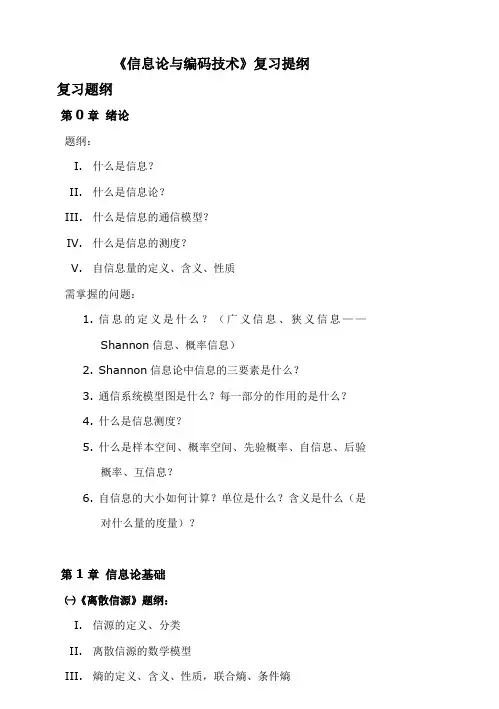

《信息论与编码技术》复习提纲复习题纲第0章绪论题纲:I.什么是信息?II.什么是信息论?III.什么是信息的通信模型?IV.什么是信息的测度?V.自信息量的定义、含义、性质需掌握的问题:1.信息的定义是什么?(广义信息、狭义信息——Shannon信息、概率信息)2.Shannon信息论中信息的三要素是什么?3.通信系统模型图是什么?每一部分的作用的是什么?4.什么是信息测度?5.什么是样本空间、概率空间、先验概率、自信息、后验概率、互信息?6.自信息的大小如何计算?单位是什么?含义是什么(是对什么量的度量)?第1章信息论基础㈠《离散信源》题纲:I.信源的定义、分类II.离散信源的数学模型III.熵的定义、含义、性质,联合熵、条件熵IV.离散无记忆信源的特性、熵V.离散有记忆信源的熵、平均符号熵、极限熵VI.马尔科夫信源的定义、状态转移图VII.信源的相对信息率和冗余度需掌握的问题:1.信源的定义、分类是什么?2.离散信源的数学模型是什么?3.信息熵的表达式是什么?信息熵的单位是什么?信息熵的含义是什么?信息熵的性质是什么?4.单符号离散信源最大熵是多少?信源概率如何分布时能达到?5.信源的码率和信息率是什么,如何计算?6.什么是离散无记忆信源?什么是离散有记忆信源?7.离散无记忆信源的数学模型如何描述?信息熵、平均符号熵如何计算?8.离散有记忆多符号离散平稳信源的平均符号熵、极限熵、条件熵(N阶熵)的计算、关系和性质是什么?9.什么是马尔科夫信源?马尔科夫信源的数学模型是什么?马尔科夫信源满足的2个条件是什么?10.马尔科夫信源的状态、状态转移是什么?如何绘制马尔科夫信源状态转移图?11.马尔科夫信源的稳态概率、稳态符号概率、稳态信息熵如何计算?12.信源的相对信息率和冗余度是什么?如何计算?㈡《离散信道》题纲:I.信道的数学模型及分类II.典型离散信道的数学模型III.先验熵和后验熵IV.互信息的定义、性质V.平均互信息的定义、含义、性质、维拉图VI.信道容量的定义VII.特殊离散信道的信道容量需掌握的问题:1.信道的定义是什么?信道如何分类?信道的数学模型是什么?2.二元对称信道和二元删除信道的信道传输概率矩阵是什么?3.对称信道的信道传输概率矩阵有什么特点?4.根据信道的转移特性图,写出信道传输概率矩阵。

第一章测试1.信息论由哪位科学家创立()。

A:傅里叶B:香农C:奈奎斯特D:冯诺依曼答案:B2.点对点通信模型包含以下哪些部分()。

A:译码器B:信源C:信宿D:信号答案:ABC3.信息就是消息。

()A:对B:错答案:B4.连续信源分为,,。

答案:5.研究信息论的目的是:提高信息传输的_,_,、,达到信息传输的最优化。

答案:第二章测试1.某一单符号离散信源的数学模型为,则其信息熵为()。

A:1比特/符号B:0.1比特/符号C:0.88比特/符号D:0.08 比特/符号答案:A2.单符号信源具有以下哪些特点()。

A:无记忆B:连续C:有记忆D:平稳答案:AD3.熵函数具有以下哪些基本性质()。

A:对称性B:随机性C:连续性答案:ACD4.信源要含有一定的信息,必须具有随机性。

()A:错B:对答案:B5.信息熵表示信源X每发一个符号所提供的平均信息量。

()A:错B:对答案:B第三章测试1.以下等式或不等式关系成立的是()。

A:B:C:D:答案:A2.单符号离散无记忆的N次扩展信道,有以下哪两种特点()。

A:无预感性B:无记忆性C:平稳性D:对称性答案:AB3.后向信道矩阵中任·一行之和为1。

()A:错B:对答案:B4.信道容量指信道的最大信息传输率。

()A:错B:对答案:B5.互信息量等于_与_比值的对数。

答案:第四章测试1.某信源输出信号的平均功率和均值均被限定,则其输出信号幅值的概率密度函数是以下哪种分布时,信源达到最大差熵值()。

A:高斯分布B:均匀分布C:指数分布答案:A2.某信源的峰值功率受限,则概率密度满足以下哪个个条件时,差熵达到最大值()。

A:均匀分布B:泊松分布C:高斯分布D:指数分布答案:A3.连续信道的平均互信息不具有以下哪些性质()。

A:非负性B:连续性C:上凸性D:极值性答案:B4.差熵具有以下哪两个性质()。

A:条件差熵值大于无条件差熵B:差熵必为负值C:条件差熵值小于无条件差熵D:差熵可为负值答案:CD5.一维高斯分布连续信源是瞬时功率受限的一类连续平稳信源。

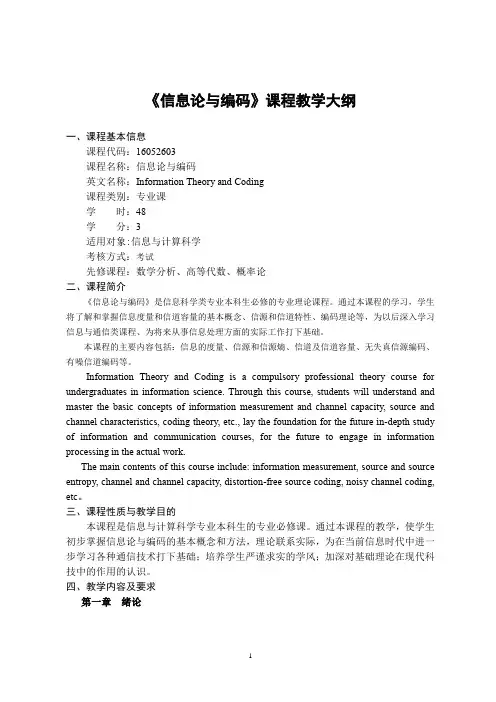

《信息论与编码》课程教学大纲一、课程基本信息课程代码:16052603课程名称:信息论与编码英文名称:Information Theory and Coding课程类别:专业课学时:48学分:3适用对象:信息与计算科学考核方式:考试先修课程:数学分析、高等代数、概率论二、课程简介《信息论与编码》是信息科学类专业本科生必修的专业理论课程。

通过本课程的学习,学生将了解和掌握信息度量和信道容量的基本概念、信源和信道特性、编码理论等,为以后深入学习信息与通信类课程、为将来从事信息处理方面的实际工作打下基础。

本课程的主要内容包括:信息的度量、信源和信源熵、信道及信道容量、无失真信源编码、有噪信道编码等。

Information Theory and Coding is a compulsory professional theory course for undergraduates in information science. Through this course, students will understand and master the basic concepts of information measurement and channel capacity, source and channel characteristics, coding theory, etc., lay the foundation for the future in-depth study of information and communication courses, for the future to engage in information processing in the actual work.The main contents of this course include: information measurement, source and source entropy, channel and channel capacity, distortion-free source coding, noisy channel coding, etc。

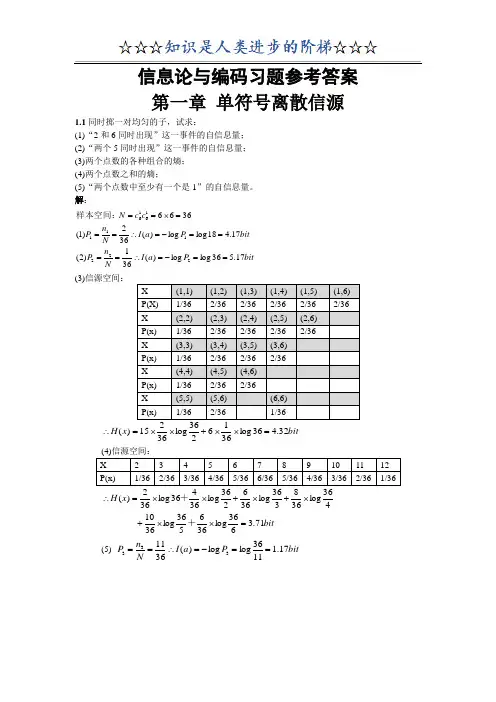

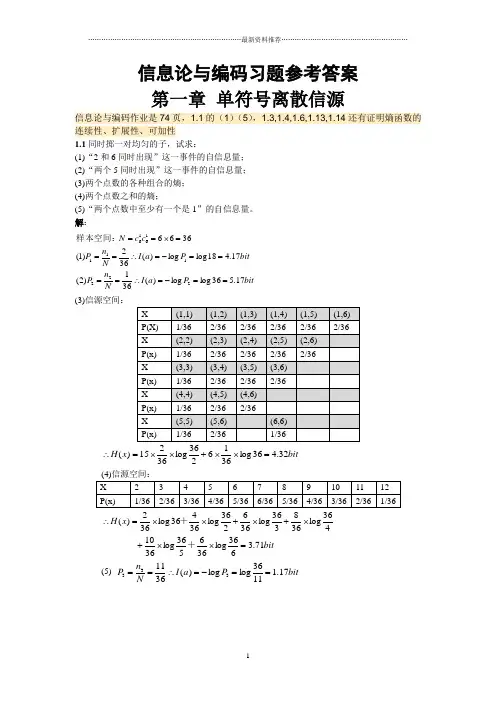

信息论与编码习题参考答案 第一章 单符号离散信源信息论与编码作业是74页,1.1的(1)(5),1.3,1.4,1.6,1.13,1.14还有证明熵函数的连续性、扩展性、可加性1.1同时掷一对均匀的子,试求:(1)“2和6同时出现”这一事件的自信息量; (2)“两个5同时出现”这一事件的自信息量; (3)两个点数的各种组合的熵; (4)两个点数之和的熵;(5)“两个点数中至少有一个是1”的自信息量。

解:bitP a I N n P bit P a I N n P c c N 17.536log log )(361)2(17.418log log )(362)1(36662221111616==-=∴====-=∴===⨯==样本空间:(3)信源空间:bit x H 32.436log 3616236log 36215)(=⨯⨯+⨯⨯=∴ bitx H 71.3636log 366536log 3610 436log 368336log 366236log 36436log 362)(=⨯⨯+⨯+⨯+⨯⨯=∴++ (5) bit P a I N n P 17.11136log log )(3611333==-=∴==1.2如有6行、8列的棋型方格,若有两个质点A 和B ,分别以等概落入任一方格内,且它们的坐标分别为(Xa ,Ya ), (Xb ,Yb ),但A ,B 不能同时落入同一方格内。

(1) 若仅有质点A ,求A 落入任一方格的平均信息量; (2) 若已知A 已落入,求B 落入的平均信息量; (3) 若A ,B 是可辨认的,求A ,B 落入的平均信息量。

解:bita P a P a a P a I a P A i 58.548log )(log )()(H 48log )(log )(481)(:)1(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率bitb P b P b b P b I b P A i 55.547log )(log )()(H 47log )(log )(471)(:B ,)2(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率是落入任一格的情况下在已知 bitAB P AB P AB H AB P AB I AB P AB i i i i i i i 14.11)4748log()(log )()()(log )(471481)()3(47481=⨯=-=-=∴⨯=∑⨯=是同时落入某两格的概率1.3从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%.如果你问一位男士:“你是否是红绿色盲?”他的回答可能是:“是”,也可能“不是”。

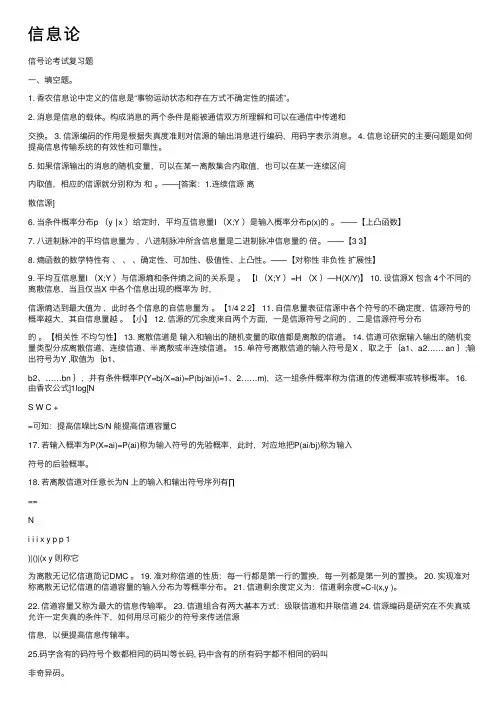

信息论信号论考试复习题⼀、填空题。

1. ⾹农信息论中定义的信息是“事物运动状态和存在⽅式不确定性的描述”。

2. 消息是信息的载体。

构成消息的两个条件是能被通信双⽅所理解和可以在通信中传递和交换。

3. 信源编码的作⽤是根据失真度准则对信源的输出消息进⾏编码,⽤码字表⽰消息。

4. 信息论研究的主要问题是如何提⾼信息传输系统的有效性和可靠性。

5. 如果信源输出的消息的随机变量,可以在某⼀离散集合内取值,也可以在某⼀连续区间内取值,相应的信源就分别称为和。

——[答案:1.连续信源离散信源]6. 当条件概率分布p (y ∣x )给定时,平均互信息量I (X;Y )是输⼊概率分布p(x)的。

——【上凸函数】7. ⼋进制脉冲的平均信息量为,⼋进制脉冲所含信息量是⼆进制脉冲信息量的倍。

——【3 3】8. 熵函数的数学特性有、、、确定性、可加性、极值性、上凸性。

——【对称性⾮负性扩展性】9. 平均互信息量I (X;Y )与信源熵和条件熵之间的关系是。

【I (X;Y )=H (X )—H(X/Y)】 10. 设信源X 包含 4个不同的离散信息,当且仅当X 中各个信息出现的概率为时,信源熵达到最⼤值为,此时各个信息的⾃信息量为。

【1/4 2 2】 11. ⾃信息量表征信源中各个符号的不确定度,信源符号的概率越⼤,其⾃信息量越。

【⼩】 12. 信源的冗余度来⾃两个⽅⾯,⼀是信源符号之间的,⼆是信源符号分布的。

【相关性不均匀性】 13. 离散信道是输⼊和输出的随机变量的取值都是离散的信道。

14. 信道可依据输⼊输出的随机变量类型分成离散信道、连续信道、半离散或半连续信道。

15. 单符号离散信道的输⼊符号是X ,取之于{a1、a2…… an };输出符号为Y ,取值为{b1、b2、……bn },并有条件概率P(Y=bj/X=ai)=P(bj/ai)(i=1、2……m),这⼀组条件概率称为信道的传递概率或转移概率。

填空1.人们研究信息论的目的是为了 高效、可靠、安全 地交换和利用各种各样的信息。

2.信息的 可度量性 是建立信息论的基础。

3.统计度量 是信息度量最常用的方法。

4.熵 是香农信息论最基本最重要的概念。

5.事物的不确定度是用时间统计发生 概率的对数 来描述的。

6.单符号离散信源一般用随机变量描述,而多符号离散信源一般用 随机矢量 描述。

7.一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为 其发生概率对数的负值 。

8.自信息量的单位一般有 比特、奈特和哈特 。

9.必然事件的自信息是 0 。

10.不可能事件的自信息量是 ∞ 。

11.两个相互独立的随机变量的联合自信息量等于 两个自信息量之和 。

12.数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量 趋于变小 。

13. 离散平稳无记忆信源X 的N 次扩展信源的熵等于离散信源X 的熵的 N 倍 。

14. 离散平稳有记忆信源的极限熵,=∞H )/(lim 121-∞→N N N X X X X H 。

15. 对于n 元m 阶马尔可夫信源,其状态空间共有 n m 个不同的状态。

16. 一维连续随即变量X 在[a ,b]区间内均匀分布时,其信源熵为 log 2(b-a ) 。

17.平均功率为P 的高斯分布的连续信源,其信源熵,H c (X )=eP π2log 212。

18.对于限峰值功率的N 维连续信源,当概率密度 均匀分布 时连续信源熵具有最大值。

19.对于限平均功率的一维连续信源,当概率密度 高斯分布 时,信源熵有最大值。

20.若一离散无记忆信源的信源熵H (X )等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为 3 。

21.若把掷骰子的结果作为一离散信源,则其信源熵为 log 26 。

22.同时掷两个正常的骰子,各面呈现的概率都为1/6,则“3和5同时出现”这件事的自信息量是 log 218(1+2 log 23)。