SPSS第五章 回归分析

- 格式:doc

- 大小:1.46 MB

- 文档页数:43

SPSS回归分析SPSS(统计包统计软件,Statistical Package for the Social Sciences)是一种强大的统计分析软件,广泛应用于各个领域的数据分析。

在SPSS中,回归分析是最常用的方法之一,用于研究和预测变量之间的关系。

接下来,我将详细介绍SPSS回归分析的步骤和意义。

一、回归分析的定义和意义回归分析是一种对于因变量和自变量之间关系的统计方法,通过建立一个回归方程,可以对未来的数据进行预测和预估。

在实际应用中,回归分析广泛应用于经济学、社会科学、医学、市场营销等领域,帮助研究人员发现变量之间的关联、预测和解释未来的趋势。

二、SPSS回归分析的步骤1. 导入数据:首先,需要将需要进行回归分析的数据导入SPSS软件中。

数据可以以Excel、CSV等格式准备好,然后使用SPSS的数据导入功能将数据导入软件。

2. 变量选择:选择需要作为自变量和因变量的变量。

自变量是被用来预测或解释因变量的变量,而因变量是我们希望研究或预测的变量。

可以通过点击"Variable View"选项卡来定义变量的属性。

3. 回归分析:选择菜单栏中的"Analyze" -> "Regression" -> "Linear"。

然后将因变量和自变量添加到正确的框中。

4.回归模型选择:选择回归方法和模型。

SPSS提供了多种回归方法,通常使用最小二乘法进行回归分析。

然后,选择要放入回归模型的自变量。

可以进行逐步回归或者全模型回归。

6.残差分析:通过检查残差(因变量和回归方程预测值之间的差异)来评估回归模型的拟合程度。

可以使用SPSS的统计模块来生成残差,并进行残差分析。

7.结果解释:最后,对回归结果进行解释,并提出对于研究问题的结论。

要注意的是,回归分析只能描述变量之间的关系,不能说明因果关系。

因此,在解释回归结果时要慎重。

回归分析spss回归分析是一种常用的统计方法,用于探究变量之间的关系。

它通过建立一个数学模型,通过观察和分析实际数据,预测因变量与自变量之间的关联。

回归分析可以帮助研究者得出结论,并且在决策制定和问题解决过程中提供指导。

在SPSS(统计包括在社会科学中的应用)中,回归分析是最常用的功能之一。

它是一个强大的工具,用于解释因变量与自变量之间的关系。

在进行回归分析之前,我们需要收集一些数据,并确保数据的准确性和可靠性。

首先,我们需要了解回归分析的基本概念和原理。

回归分析基于统计学原理,旨在寻找自变量与因变量之间的关系。

在回归分析中,我们分为两种情况:简单回归和多元回归。

简单回归适用于只有一个自变量和一个因变量的情况,多元回归适用于多个自变量和一个因变量的情况。

在进行回归分析之前,我们需要确定回归模型的适用性。

为此,我们可以使用多种统计性检验,例如检验线性关系、相关性检验、多重共线性检验等。

这些检验可以帮助我们判断回归模型是否适用于收集到的数据。

在SPSS中进行回归分析非常简单。

首先,我们需要打开数据文件,然后选择“回归”功能。

接下来,我们需要指定自变量和因变量,并选择适当的回归模型(简单回归或多元回归)。

之后,SPSS将自动计算结果,并显示出回归方程的参数、标准误差、显著性水平等。

在进行回归分析时,我们需要关注一些重要的统计指标,例如R方值、F值和P值。

R方值表示自变量对因变量的解释程度,它的取值范围在0到1之间,越接近1表示模型的拟合效果越好。

F值表示回归模型的显著性,P值则表示自变量对因变量的影响是否显著。

我们通常会将P值设定为0.05作为显著性水平,如果P值小于0.05,则我们可以认为自变量对因变量有显著影响。

此外,在回归分析中,我们还可以进行一些额外的检验和分析。

比如,我们可以利用残差分析来检查回归模型的拟合优度,以及发现可能存在的异常值和离群点。

此外,我们还可以进行变量选择和交互效应的分析。

数据统计分析软件SPSS的应用(五)——相关分析与回归分析数据统计分析软件SPSS的应用(五)——相关分析与回归分析数据统计分析软件SPSS是目前应用广泛且非常强大的数据分析工具之一。

在前几篇文章中,我们介绍了SPSS的基本操作和一些常用的统计方法。

本篇文章将继续介绍SPSS中的相关分析与回归分析,这些方法是数据分析中非常重要且常用的。

一、相关分析相关分析是一种用于确定变量之间关系的统计方法。

SPSS提供了多种相关分析方法,如皮尔逊相关、斯皮尔曼相关等。

在进行相关分析之前,我们首先需要收集相应的数据,并确保数据符合正态分布的假设。

下面以皮尔逊相关为例,介绍SPSS 中的相关分析的步骤。

1. 打开SPSS软件并导入数据。

可以通过菜单栏中的“File”选项来导入数据文件,或者使用快捷键“Ctrl + O”。

2. 准备相关分析的变量。

选择菜单栏中的“Analyze”选项,然后选择“Correlate”子菜单中的“Bivariate”。

在弹出的对话框中,选择要进行相关分析的变量,并将它们添加到相应的框中。

3. 进行相关分析。

点击“OK”按钮后,SPSS会自动计算所选变量之间的相关系数,并将结果输出到分析结果窗口。

4. 解读相关分析结果。

SPSS会给出相关系数的值以及显著性水平。

相关系数的取值范围为-1到1,其中-1表示完全负相关,1表示完全正相关,0表示没有相关关系。

显著性水平一般取0.05,如果相关系数的显著性水平低于设定的显著性水平,则可以认为两个变量之间存在相关关系。

二、回归分析回归分析是一种用于探索因果关系的统计方法,广泛应用于预测和解释变量之间的关系。

SPSS提供了多种回归分析方法,如简单线性回归、多元线性回归等。

下面以简单线性回归为例,介绍SPSS中的回归分析的步骤。

1. 打开SPSS软件并导入数据。

同样可以通过菜单栏中的“File”选项来导入数据文件,或者使用快捷键“Ctrl + O”。

2. 准备回归分析的变量。

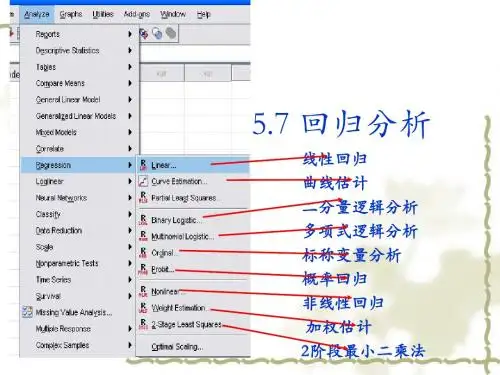

SPSS-回归分析回归分析(⼀元线性回归分析、多元线性回归分析、⾮线性回归分析、曲线估计、时间序列的曲线估计、含虚拟⾃变量的回归分析以及逻辑回归分析)回归分析中,⼀般⾸先绘制⾃变量和因变量间的散点图,然后通过数据在散点图中的分布特点选择所要进⾏回归分析的类型,是使⽤线性回归分析还是某种⾮线性的回归分析。

回归分析与相关分析对⽐:在回归分析中,变量y称为因变量,处于被解释的特殊地位;;⽽在相关分析中,变量y与变量x处于平等的地位。

在回归分析中,因变量y是随机变量,⾃变量x可以是随机变量,也可以是⾮随机的确定变量;⽽在相关分析中,变量x和变量y都是随机变量。

相关分析是测定变量之间的关系密切程度,所使⽤的⼯具是相关系数;⽽回归分析则是侧重于考察变量之间的数量变化规律。

统计检验概念:为了确定从样本(sample)统计结果推论⾄总体时所犯错的概率。

F值和t值就是这些统计检定值,与它们相对应的概率分布,就是F分布和t分布。

统计显著性(sig)就是出现⽬前样本这结果的机率。

标准差表⽰数据的离散程度,标准误表⽰抽样误差的⼤⼩。

统计检验的分类:拟合优度检验:检验样本数据聚集在样本回归直线周围的密集程度,从⽽判断回归⽅程对样本数据的代表程度。

回归⽅程的拟合优度检验⼀般⽤判定系数R2实现。

回归⽅程的显著性检验(F检验):是对因变量与所有⾃变量之间的线性关系是否显著的⼀种假设检验。

回归⽅程的显著性检验⼀般采⽤F 检验。

回归系数的显著性检验(t检验): 根据样本估计的结果对总体回归系数的有关假设进⾏检验。

1.⼀元线性回归分析定义:在排除其他影响因素或假定其他影响因素确定的条件下,分析某⼀个因素(⾃变量)是如何影响另⼀事物(因变量)的过程。

SPSS操作2.多元线性回归分析定义:研究在线性相关条件下,两个或两个以上⾃变量对⼀个因变量的数量变化关系。

表现这⼀数量关系的数学公式,称为多元线性回归模型。

SPSS操作3.⾮线性回归分析定义:研究在⾮线性相关条件下,⾃变量对因变量的数量变化关系⾮线性回归问题⼤多数可以化为线性回归问题来求解,也就是通过对⾮线性回归模型进⾏适当的变量变换,使其化为线性模型来求解。

SPSS分析技术:线性回归分析相关分析可以揭示事物之间共同变化的一致性程度,但它仅仅只是反映出了一种相关关系,并没有揭示出变量之间准确的可以运算的控制关系,也就是函数关系,不能解决针对未来的分析与预测问题。

回归分析就是分析变量之间隐藏的内在规律,并建立变量之间函数变化关系的一种分析方法,回归分析的目标就是建立由一个因变量和若干自变量构成的回归方程式,使变量之间的相互控制关系通过这个方程式描述出来。

回归方程式不仅能够解释现在个案内部隐藏的规律,明确每个自变量对因变量的作用程度。

而且,基于有效的回归方程,还能形成更有意义的数学方面的预测关系。

因此,回归分析是一种分析因素变量对因变量作用强度的归因分析,它还是预测分析的重要基础。

回归分析类型回归分析根据自变量个数,自变量幂次以及变量类型可以分为很多类型,常用的类型有:线性回归;曲线回归;二元Logistic回归技术;线性回归原理回归分析就是建立变量的数学模型,建立起衡量数据联系强度的指标,并通过指标检验其符合的程度。

线性回归分析中,如果仅有一个自变量,可以建立一元线性模型。

如果存在多个自变量,则需要建立多元线性回归模型。

线性回归的过程就是把各个自变量和因变量的个案值带入到回归方程式当中,通过逐步迭代与拟合,最终找出回归方程式中的各个系数,构造出一个能够尽可能体现自变量与因变量关系的函数式。

在一元线性回归中,回归方程的确立就是逐步确定唯一自变量的系数和常数,并使方程能够符合绝大多数个案的取值特点。

在多元线性回归中,除了要确定各个自变量的系数和常数外,还要分析方程内的每个自变量是否是真正必须的,把回归方程中的非必需自变量剔除。

名词解释线性回归方程:一次函数式,用于描述因变量与自变量之间的内在关系。

根据自变量的个数,可以分为一元线性回归方程和多元线性回归方程。

观测值:参与回归分析的因变量的实际取值。

对参与线性回归分析的多个个案来讲,它们在因变量上的取值,就是观测值。

SPSS回归分析实验⽬的:1、学会使⽤SPSS的简单操作。

2、掌握回归分析。

实验内容: 1.相关分析。

线性回归相关关系指⼀⼀对应的确定关系。

设有两个变量 x 和 y ,变量 y 随变量 x ⼀起变化,并完全依赖于 x ,当变量 x 取某个数值时, y 依确定的关系取相应的值,则称 y 是 x 的函数,记为 y = f (x),其中 x 称为⾃变量,y 称为因变量。

且各观测点落在⼀条线上。

2.回归分析,重点考察考察⼀个特定的变量(因变量),⽽把其他变量(⾃变量)看作是影响这⼀变量的因素,并通过适当的数学模型将变量间的关系表达出来利⽤样本数据建⽴模型的估计⽅程对模型进⾏显著性检验进⽽通过⼀个或⼏个⾃变量的取值来估计或预测因变量的取值。

3.逐步回归,将向前选择和向后剔除两种⽅法结合起来筛选⾃变量。

在增加了⼀个⾃变量后,它会对模型中所有的变量进⾏考察,看看有没有可能剔除某个⾃变量。

如果在增加了⼀个⾃变量后,前⾯增加的某个⾃变量对模型的贡献变得不显著,这个变量就会被剔除。

按照⽅法不停地增加变量并考虑剔除以前增加的变量的可能性,直⾄增加变量已经不能导致SSE显著减少在前⾯步骤中增加的⾃变量在后⾯的步骤中有可能被剔除,⽽在前⾯步骤中剔除的⾃变量在后⾯的步骤中也可能重新进⼊到模型中。

4.哑变量回归,也称虚拟变量。

⽤数字代码表⽰的定性⾃变量。

哑变量可有不同的⽔平。

哑变量的取值为0,1。

实验步骤:1. 相关分析SPSS操作,【分析】→【相关-双变量】,将各变量选⼊【变量】。

1 CORRELATIONS2 /VARIABLES=销售收⼊⼴告费⽤3 /PRINT=TWOTAIL NOSIG4 /MISSING=PAIRWISE.相关性分析 2.回归分析SPSS操作,【分析】→【回归-线性】,将因变量选⼊【因变量】,将⾃变量选⼊【⾃变量】。

需要预测时,【保存】→【预测值】,选中【未标准化】→【预测区间】,选中【均值】→【单值】→【置信区间】,选择置信⽔平。

SPSS第五章-回归分析一元回归分析在数学关系式中只描述了一个变量与另一个变量之间的数量变化关系,则称其为一元回归分析。

其回归模型为y 称为因变量,x称为自变量,称为随机误差,a,b 称为待估计的回归参数,下标i表示第i个观测值。

如果给出a和b的估计量分别为,,则经验回归方程:一般把称为残差,残差可视为扰动的“估计量”。

例子:湖北省汉阳县历年越冬代二化螟发蛾盛期与当年三月上旬平均气温的数据如表1-1,分析三月上旬平均温度与越冬代二化螟发蛾盛期的关系。

表1-1 三月上旬平均温度与越冬代二化螟发蛾盛期的情况表年份1961 1962 1963 1964 1965 1966 1967 1968 1969 1970 三月上旬平均温度8.6 8.3 9.7 8.5 7.5 8.4 7.3 9.7 5.4 5.5 越冬代二化螟发蛾 3 5 3 1 4 4 5 2 7 5盛期(6月30日为0)数据保存在“DATA6-1.SAV”文件中。

1)准备分析数据在数据编辑窗口中输入数据。

建立因变量历期“历期”在SPSS数据编辑窗口中,创建“年份”、“温度”和“发蛾盛期”变量,并把数据输入相应的变量中。

或者打开已存在的数据文件“DATA6-1.SAV”。

2)启动线性回归过程单击SPSS主菜单的“Analyze”下的“Regression”中“Linear”项,将打开如图1-1所示的线性回归过程窗口。

设置控制变量“Selection Variable”为控制变量输入栏。

控制变量相当于过滤变量,即必须当该变量的值满足设置的条件时,观测量才能参加回归分析。

当你输入控制变量后,单击“Rule”按钮,将打开如图1-2所示的对话。

图1-2“Rule”对话框在“Rule”对话框中,右边的“Value”框用于输入数值,左边的下拉列表中列出了观测量的选择关系,其中各项的意义分别为:•“equal to”等于。

•“not equal to”不等于。

SPSS回归分析SPSS(Statistical Package for the Social Sciences)是一种用来进行统计分析的软件,其中包括回归分析。

回归分析是一种用来找出因变量与自变量之间关系的统计方法。

在回归分析中,我们可以通过控制自变量,预测因变量的值。

SPSS中的回归分析提供了多种模型,其中最常用的是线性回归分析。

线性回归分析模型假设因变量与自变量之间存在线性关系。

在执行回归分析前,需要明确因变量和自变量的选择。

通常,因变量是我们要预测或解释的变量,而自变量是用来解释或预测因变量的变量。

首先,我们需要导入数据到SPSS。

在导入数据前,要确保数据的结构合适,缺失值得到正确处理。

然后,在SPSS中打开回归分析对话框,选择线性回归模型。

接下来,我们需要指定因变量和自变量。

在指定因变量和自变量后,SPSS会自动计算回归模型的系数和统计指标。

其中,回归系数表示自变量的影响程度,统计指标(如R方)可以衡量模型的拟合程度。

在执行回归分析后,我们可以进一步分析回归模型的显著性。

一种常用的方法是检查回归系数的显著性。

SPSS会为每个回归系数提供一个t检验和相应的p值。

p值小于其中一显著性水平(通常是0.05)可以认为回归系数是显著的,即自变量对因变量的影响是有意义的。

此外,我们还可以通过分析残差来检查模型的适当性。

残差是观测值与回归模型预测值之间的差异。

如果残差分布服从正态分布,并且没有明显的模式(如异方差性、非线性),则我们可以认为模型是适当的。

最后,我们可以使用SPSS的图表功能来可视化回归模型。

比如,我们可以绘制散点图来展示自变量和因变量之间的关系,或者绘制残差图来检查模型的适当性。

总之,SPSS提供了强大的回归分析功能,可以帮助我们探索变量之间的关系并预测因变量的值。

通过进行回归分析,我们可以得到有关自变量对因变量的影响的信息,并评估模型的拟合程度和适用性。

一元回归分析在数学关系式中只描述了一个变量与另一个变量之间的数量变化关系,则称其为一元回归分析。

其回归模型为y 称为因变量,x称为自变量,称为随机误差,a,b 称为待估计的回归参数,下标i表示第i个观测值。

如果给出a和b的估计量分别为,,则经验回归方程:一般把称为残差,残差可视为扰动的“估计量”。

例子:湖北省汉阳县历年越冬代二化螟发蛾盛期与当年三月上旬平均气温的数据如表1-1,分析三月上旬平均温度与越冬代二化螟发蛾盛期的关系。

表1-1 三月上旬平均温度与越冬代二化螟发蛾盛期的情况表数据保存在“DATA6-1.SAV”文件中。

1)准备分析数据在数据编辑窗口中输入数据。

建立因变量历期“历期”在SPSS数据编辑窗口中,创建“年份”、“温度”和“发蛾盛期”变量,并把数据输入相应的变量中。

或者打开已存在的数据文件“DATA6-1.SAV”。

2)启动线性回归过程单击SPSS主菜单的“Analyze”下的“Regression”中“Linear”项,将打开如图1-1所示的线性回归过程窗口。

图1-1 线性回归对话窗口3) 设置分析变量设置因变量:本例为“发蛾盛期”变量,用鼠标选中左边变量列表中的“发蛾盛期”变量,然后点击“Dependent”栏左边的向右拉按钮,该变量就自动调入“Dependent”显示栏里。

设置自变量:选择一个变量作为自变量进入“Independent(S)”框中。

用鼠标选中左边变量列表中的“温度”变量,然后点击“Independent(S)”栏左边的向右拉按钮,该变量就自动调入“Independent(S)”显示栏里。

注:SPSS中一元回归和多元回归以及多元逐步回归都是使用同一过程,所以该栏可以输入多个自变量。

设置控制变量“Selection Variable”为控制变量输入栏。

控制变量相当于过滤变量,即必须当该变量的值满足设置的条件时,观测量才能参加回归分析。

当你输入控制变量后,单击“Rule”按钮,将打开如图1-2所示的对话。

图1-2“Rule”对话框在“Rule”对话框中,右边的“Value”框用于输入数值,左边的下拉列表中列出了观测量的选择关系,其中各项的意义分别为:∙“equal to”等于。

∙“not equal to”不等于。

∙“less than”小于。

∙“less than or equal”小于或等于。

∙“greater than”大于。

∙“greater than or equal”大于或等于。

本例的控制变量是“计算”,将它选入“Selection Variable”变量栏里,在“Rule”对话框中选择“equal to”=1。

选择标签变量“Case Labels”框用于选择观测量的标签变量。

在输出结果中,可显示该观测量的值,通过该变量的值可查看相应的观测量。

本例子选择“年份”为标签变量。

选择加权变量在主对话框中单击“WLS”按钮,将在主对话框下方展开一个输入框,该框用于输入加权变量。

本例子没有加权变量,因此不作任何设置。

4)回归方式在“Method”框中选择一种回归分析方式。

其中,各项的意义为:∙全进入“Enter”所选择的自变量将全部进入建立的回归方程中,该项为默认方式。

∙逐步进入“Stepwise”根据“Options”对话框中的设置,在方程中加入或剔除单个变量直到所建立的方程中不再含有可加入或剔除的变量为止。

∙后进入“Remove”将进入方程中的自变量同时剔除。

∙先进入“Backward”自变量框中所有的变量同时进入方程中,然后根据“Options”对话框中的设置,剔除某个变量,直到所建立的方程中不再含有可剔除的变量为止。

∙条件进入“Forward”根据“Options”对话框中的设置,在方程中每次加入一个变量,直至加入所有符合条件的变量为止。

本例子是一元回归,只能选第一项。

5)设置输出统计量单击“Statistics”按钮,将打开如图1-3所示的对话框。

该对话框用于设置相关参数。

其中各项的意义分别为:图1-3 “Statistics”对话框①“Regression Coefficients”回归系数选项:“Estimates”输出回归系数和相关统计量。

“Confidence interval”回归系数的95%置信区间。

“Covariance matrix”回归系数的方差-协方差矩阵。

本例子选择“Estimates”输出回归系数和相关统计量。

②“Residuals”残差选项:“Durbin-Watson”Durbin-Watson检验。

“Casewise diagnostic”输出满足选择条件的观测量的相关信息。

选择该项,下面两项处于可选状态:“Outliers outside standard deviations”选择标准化残差的绝对值大于输入值的观测量;“All cases”选择所有观测量。

本例子都不选。

③ 其它输入选项“Model fit”输出相关系数、相关系数平方、调整系数、估计标准误、ANOVA表。

“R squared change”输出由于加入和剔除变量而引起的复相关系数平方的变化。

“Descriptives”输出变量矩阵、标准差和相关系数单侧显著性水平矩阵。

“Part and partial correlation”相关系数和偏相关系数。

“Collinearity diagnostics”显示单个变量和共线性分析的公差。

本例子选择“Model fit”项。

6)绘图选项在主对话框单击“Plots”按钮,将打开如图1-4所示的对话框窗口。

该对话框用于设置要绘制的图形的参数。

图中的“X”和“Y”框用于选择X轴和Y轴相应的变量。

图1-4“Plots”绘图对话框窗口左上框中各项的意义分别为:∙“DEPENDNT”因变量。

∙“ZPRED”标准化预测值。

∙“ZRESID”标准化残差。

∙“DRESID”删除残差。

∙“ADJPRED”调节预测值。

∙“SRESID”学生氏化残差。

∙“SDRESID”学生氏化删除残差。

“Standardized Residual Plots”设置各变量的标准化残差图形输出。

其中共包含两个选项:“Histogram”用直方图显示标准化残差。

“Normal probability plots”比较标准化残差与正态残差的分布示意图。

“Produce all partial plot”偏残差图。

对每一个自变量生成其残差对因变量残差的散点图。

本例子不作绘图,不选择。

7) 保存分析数据的选项在主对话框里单击“Save”按钮,将打开如图1-5所示的对话框。

图1-5 “Save”对话框①“Predicted Values”预测值栏选项:Unstandardized 非标准化预测值。

就会在当前数据文件中新添加一个以字符“PRE_”开头命名的变量,存放根据回归模型拟合的预测值。

Standardized 标准化预测值。

Adjusted 调整后预测值。

S.E. of mean predictions 预测值的标准误。

本例选中“Unstandardized”非标准化预测值。

②“Distances”距离栏选项:Mahalanobis: 距离。

Cook’s”: Cook距离。

Leverage values: 杠杆值。

③“Prediction Intervals”预测区间选项:Mean: 区间的中心位置。

Individual: 观测量上限和下限的预测区间。

在当前数据文件中新添加一个以字符“LICI_”开头命名的变量,存放预测区间下限值;以字符“UICI_”开头命名的变量,存放预测区间上限值。

Confidence Interval:置信度。

本例选中“Individual” 观测量上限和下限的预测区间。

④“Save to New File”保存为新文件:选中“Coefficient statistics”项将回归系数保存到指定的文件中。

本例不选。

⑤ “Export model information to XML file”导出统计过程中的回归模型信息到指定文件。

本例不选。

⑥“Residuals” 保存残差选项:“Unstandardized”非标准化残差。

“Standardized”标准化残差。

“Studentized”学生氏化残差。

“Deleted”删除残差。

“Studentized deleted”学生氏化删除残差。

本例不选。

⑦“Influence Statistics” 统计量的影响。

“DfBeta(s)”删除一个特定的观测值所引起的回归系数的变化。

“Standardized DfBeta(s)”标准化的DfBeta值。

“DiFit” 删除一个特定的观测值所引起的预测值的变化。

“Standardized DiFit”标准化的DiFit值。

“Covariance ratio”删除一个观测值后的协方差矩隈的行列式和带有全部观测值的协方差矩阵的行列式的比率。

本例子不保存任何分析变量,不选择。

8)其它选项在主对话框里单击“Options”按钮,将打开如图1-6所示的对话框。

图1-6 “Options”设置对话框①“Stepping Method Criteria”框用于进行逐步回归时内部数值的设定。

其中各项为:“Use probability of F”如果一个变量的F值的概率小于所设置的进入值(Entry),那么这个变量将被选入回归方程中;当变量的F值的概率大于设置的剔除值(Removal),则该变量将从回归方程中被剔除。

由此可见,设置“Use probability of F”时,应使进入值小于剔除值。

“Ues F value”如果一个变量的F值大于所设置的进入值(Entry),那么这个变量将被选入回归方程中;当变量的F值小于设置的剔除值(Removal),则该变量将从回归方程中被剔除。

同时,设置“Use F value”时,应使进入值大于剔除值。

②“Include constant in equation”选择此项表示在回归方程中有常数项。

本例选中“Include constant in equation”选项在回归方程中保留常数项。

③“Missing Values”框用于设置对缺失值的处理方法。

其中各项为:“Exclude cases listwise”剔除所有含有缺失值的观测值。

“Exchude cases pairwise”仅剔除参与统计分析计算的变量中含有缺失值的观测量。

“Replace with mean”用变量的均值取代缺失值。

本例选中“Exclude cases listwise”。

9)提交执行在主对话框里单击“OK”,提交执行,结果将显示在输出窗口中。

见表1-2至表1-5。

10) 结果分析结果:表1-2 给出了回归的方法是全回归模式,模型编号为1,自变量是“温度”,因变量是“发蛾盛期”。