大数据研发工程师30求职简历模板

- 格式:docx

- 大小:22.75 KB

- 文档页数:4

数据开发求职信怎么写简历

尊敬的招聘经理,

我是一名具有三年数据开发经验的数据专业人士,对您公司所招聘的数据开发岗位深感兴趣。

通过我的经验和技能,我相信我可以为贵公司带来价值并实现企业目标。

在我过去的工作经历中,我主要负责数据收集、清洗、处理和分析工作。

我熟练运用SQL、Python等编程语言来提取和处理数据,能够设计和维护ETL流程和数据仓库,确保数据的准确性和完整性。

在数据分析方面,我熟练掌握数据可视化工具如Tableau和Power BI,能够通过图表和报告对数据进行解读和分析,提供决策支持。

我还具备良好的沟通和团队合作能力,能够与不同部门的同事协作,共同完成数据相关的项目任务。

我注重细节和结果,善于解决问题和应对挑战,能够在压力下高效工作并完成任务。

我也持续学习和接受新知识,不断提升自己的技能和能力。

我对数据开发领域充满热情,并且相信数据在企业决策中的重要性。

我希望能够加入贵公司的团队,与同事们共同努力,为企业的发展和成功贡献自己的力量。

衷心希望能够有机会与贵公司进一步交流,期待能够成为贵公司的一员。

谢谢您抽出宝贵时间阅读我的求职信,期待您的回复。

此致礼敬XXX。

大数据专业个人简历模板范文个人信息姓名:XXX性别:男出生日期:XXXX年X月X日联系方式:XXXXXXXXEmail:XXXXXX教育背景XXXX年-XXXX年,XXXX大学,计算机科学与技术专业,本科学位工作经历XXXX年-至今,XXXX公司,大数据工程师主要工作内容:1. 参与公司大数据平台的规划与设计,负责数据存储、数据处理和数据分析等方面的工作;2. 使用Hadoop、Spark等大数据处理框架,负责大数据的ETL、数据清洗、数据挖掘等工作;3. 对数据进行分析和建模,为业务部门提供数据支持,提高数据可视化和数据分析效率;4. 负责大数据平台的维护和优化工作,确保平台的稳定性和高效性;5. 参与公司大数据项目的开发和实施,为业务部门提供技术支持和解决方案。

项目经验XXXX年-XXXX年,某电商平台大数据分析项目项目描述:该项目主要利用大数据技术对电商平台的用户行为进行分析,提高用户体验和销售额。

工作职责:1. 收集和清洗用户行为数据,建立用户画像和用户行为模型;2. 使用Spark和Hive等工具进行数据分析和挖掘,发现用户行为规律和商业价值;3. 对分析结果进行可视化展示,为业务部门提供数据分析报告和决策支持;4. 优化数据流程和数据模型,提高数据处理效率和准确性。

技能清单1. 熟练掌握Hadoop、Spark、Hive等大数据处理框架,具有丰富的大数据处理经验;2. 熟悉数据分析和数据挖掘技术,具有良好的数据建模和数据分析能力;3. 具有良好的编程能力,熟练掌握Java、Python等编程语言;4. 具有较强的沟通能力和团队合作能力,能够有效地与业务部门合作,解决问题并提供解决方案;5. 具有较强的学习能力和技术更新能力,能够快速适应新的技术和工作环境。

自我评价本人性格开朗,善于与他人沟通和合作,具有良好的团队意识和责任心。

在大数据领域有较丰富的工作经验和专业知识,能够独立完成大数据项目的规划和实施工作。

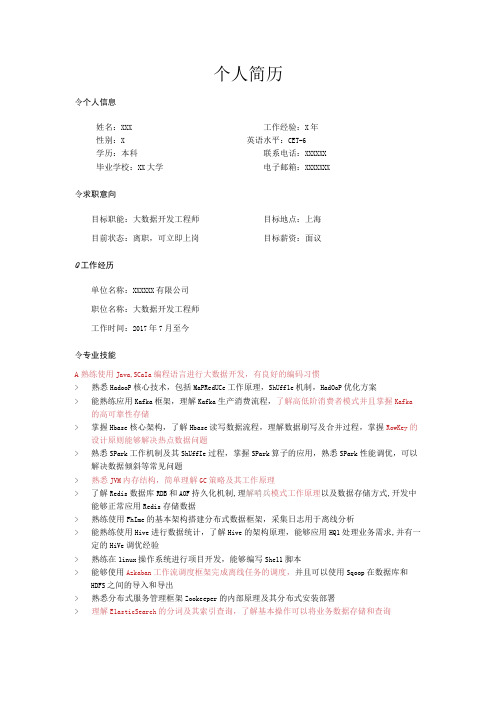

个人简历令个人信息姓名:XXX 工作经验:X年性别:X 英语水平:CET-6学历:本科联系电话:XXXXXX毕业学校:XX大学电子邮箱:XXXXXXX令求职意向目标职能:大数据开发工程师目标地点:上海目前状态:离职,可立即上岗目标薪资:面议Q工作经历单位名称:XXXXXX有限公司职位名称:大数据开发工程师工作时间:2017年7月至今令专业技能A熟练使用Java,SCaIa编程语言进行大数据开发,有良好的编码习惯>熟悉HadooP核心技术,包括MaPRedUCe工作原理,ShUff1e机制,HadOoP优化方案>能熟练应用Kafka框架,理解Kafka生产消费流程,了解高低阶消费者模式并且掌握Kafka 的高可靠性存储>掌握Hbase核心架构,了解Hbase读写数据流程,理解数据刷写及合并过程,掌握RowKey的设计原则能够解决热点数据问题>熟悉SPark工作机制及其ShUffIe过程,掌握SPark算子的应用,熟悉SPark性能调优,可以解决数据倾斜等常见问题>熟悉JVM内存结构,简单理解GC策略及其工作原理>了解Redis数据库RDB和AOF持久化机制,理解哨兵模式工作原理以及数据存储方式,开发中能够正常应用Redis存储数据>熟练使用FhIme的基本架构搭建分布式数据框架,采集日志用于离线分析>能熟练使用Hive进行数据统计,了解Hive的架构原理,能够应用HQ1处理业务需求,并有一定的HiVe调优经验>熟练在1inux操作系统进行项目开发,能够编写She11脚本>能够使用Azkaban工作流调度框架完成离线任务的调度,并且可以使用Sqoop在数据库和HDFS之间的导入和导出>熟悉分布式服务管理框架Zookeeper的内部原理及其分布式安装部署>理解E1asticSearch的分词及其索引查询,了解基本操作可以将业务数据存储和查询◊项目经验>项目名称:可可宝贝数仓分析开发环境:IDEA+JDK+Maven+Git项目架构:Nginx,F1ume,HDFS,Hive,Spark,Sqoop项目描述:该项目是对针对用户在客户端产生的基本用户信息,收藏点赞等行为数据,经过离线采集,存储和分析来实现用户日活,用户留存,TOPN热门视频等需求。

数据工程师简历模板姓名:XXX联系方式:XXXXXXXX电子邮箱:XXXXX教育背景- 学位:XXX大学,XXXX学位,专业:数据科学与工程,毕业时间:XXXX年- 学位:XXX大学,XXXX学位,专业:计算机科学与技术,毕业时间:XXXX年专业技能- 精通数据挖掘和机器学习算法,包括聚类、分类、回归等- 熟悉大数据处理技术,如Hadoop、Spark等- 熟练掌握数据清洗和预处理技术,包括数据清洗、特征选择、特征构建等- 良好的编程能力,熟悉Python、R等主流编程语言- 熟悉数据库管理和SQL语言- 具备数据可视化技能,熟悉Tableau、matplotlib等数据可视化工具工作经历公司名称:XXX科技有限公司职位:数据工程师任职时间:XXXX年至今工作职责:- 负责设计和实现数据处理流程,包括数据清洗、特征选择、特征构建等- 开发数据分析和挖掘模型,进行数据分析和模型评估- 维护和优化数据流水线,保证数据处理的高效性和稳定性- 参与团队讨论,协助解决数据相关的技术难题项目经验项目名称:XXX电商平台用户画像项目项目描述:该项目旨在分析用户行为数据,挖掘用户的购物偏好和行为特征,为企业提供个性化推荐和精准营销服务。

工作职责:- 使用Python对原始用户数据进行清洗和预处理,包括数据去重、缺失值处理等- 运用机器学习算法构建用户购物偏好模型和个性化推荐模型- 使用Spark进行大规模数据处理和模型训练,提高算法的计算效率- 利用Tableau对分析结果进行可视化,为企业决策提供数据支持个人项目项目名称:XXX交通流量预测项目描述:该项目旨在通过分析历史交通数据,预测未来交通流量,为城市交通规划和管理提供参考。

工作职责:- 收集和清洗历史交通数据,包括交通流量、天气、节假日等信息- 基于时间序列分析方法构建交通流量预测模型,并进行模型评估和调优- 利用数据可视化工具展示预测结果,辅助决策者了解交通状况证书与荣誉- XXXX证书,获得时间:XXXX年- XXXX证书,获得时间:XXXX年自我评价本人具备扎实的数据工程知识和丰富的实践经验,熟悉大数据处理技术和数据挖掘算法,能够快速理解和解决数据相关的问题。

大数据开发工程师简历个人信息姓名:[XXXXX]电话:XXX-XXXX-XXXX邮箱:**************现居地址:[XXXXX]教育背景XXXX年XX月- XXXX年XX月XXX大学计算机科学与技术专业本科主修课程:数据结构、算法、数据库原理、计算机网络、操作系统、大数据技术等工作经历XXXX年XX月-至今XXX公司大数据开发工程师主要工作内容:1. 负责大数据平台的搭建、部署和运维,提高平台的稳定性和可用性;2. 负责数据采集、清洗、整合和存储等工作,确保数据质量和可用性;3. 运用大数据技术,对海量数据进行挖掘和分析,为业务部门提供数据支持和优化建议;4. 参与公司大数据项目的开发和实施,与团队成员协作完成项目目标;5. 针对业务需求,提出创新性的大数据解决方案,并付诸实践。

项目经验1. 大数据平台搭建与运维项目描述:本项目旨在为公司搭建一个稳定、高效的大数据平台,提供数据采集、处理、存储和分析等功能。

我负责平台的部署、优化和运维,确保数据的及时处理和准确分析。

我在项目中负责的工作:* 平台架构设计,选用Hadoop、Spark等开源框架进行搭建;* 平台部署和配置,包括硬件和软件的安装和配置;* 优化数据处理流程,提高数据处理效率;* 监控平台运行状态,及时发现和解决问题,确保平台的稳定性和可用性。

项目成果:成功搭建了大数据平台,并投入使用。

经过不断优化,平台的处理能力得到显著提升,满足了公司的数据处理需求。

2. 客户行为分析系统项目描述:本项目旨在通过对客户的行为进行分析,为公司提供客户洞察和优化建议。

我负责数据的采集、清洗和整合,以及模型的设计和实现。

我在项目中负责的工作:* 设计数据采集方案,开发数据采集程序;* 对数据进行清洗和整合,提高数据的质量和可用性;* 设计分析模型,运用机器学习等技术对数据进行挖掘和分析;* 撰写分析报告,为公司提供优化建议。

项目成果:成功开发了客户行为分析系统,提供了准确的数据分析和优化建议。

大数据技术个人简历模板个人信息姓名:性别:出生年月:联系电话:电子邮件:教育背景(最近的学历写在最前面,依次往后排列)- xxxx年-xxxx年:本科/硕士/博士毕业院校(所学专业)- xxxx年-xxxx年:本科/硕士/博士毕业院校(所学专业)- xxxx年-xxxx年:本科/硕士/博士毕业院校(所学专业)技能与能力- 精通大数据技术,熟悉Hadoop、Spark等大数据框架- 熟悉Python/Java等编程语言,具备良好的编程能力- 具备数据清洗、数据挖掘和数据分析的经验,熟悉常见的数据处理工具和算法- 熟悉数据库管理系统,能够使用SQL进行数据查询和管理- 具备良好的数据可视化能力,能够使用Tableau等工具将数据可视化展示工作经历(按时间倒序排列,包括实习经历和项目经验)公司名称/实习单位:xxxx职位/岗位:xxxx时间:xxxx年-xxxx年- 负责xxxx项目的设计与开发,实现了数据清洗、数据挖掘和数据可视化功能- 使用Hadoop和Spark框架进行大规模数据处理和分析,优化了数据处理效率并提升了系统性能- 运用机器学习算法进行数据分析,提取出关键特征并建立预测模型,提供了准确的数据决策支持公司名称/实习单位:xxxx职位/岗位:xxxx时间:xxxx年-xxxx年- 参与xxxx大数据平台的开发与维护工作,解决了数据处理和存储的问题,提高了系统稳定性- 设计并实现了数据监控系统,能够实时监测数据质量和数据异常情况,及时进行处理和修复- 建立数据仓库和数据模型,优化数据查询和分析的性能,提供了高效的数据支持项目经验(按时间倒序排列,描述自己参与的一些重要项目,包括项目背景、工作职责、取得的成果等)- 项目名称:xxxx时间:xxxx年-xxxx年项目描述:xxxx职责与贡献:xxxx取得的成果:xxxx- 项目名称:xxxx时间:xxxx年-xxxx年项目描述:xxxx职责与贡献:xxxx取得的成果:xxxx荣誉和证书(列举自己曾获得的荣誉、证书等)- xxxx荣誉称号- xxxx证书自我评价(对自己的技能、经验、专业能力进行评价,展示自己的优势和特点,注意突出与大数据技术相关的能力)具有扎实的大数据技术功底,熟练掌握常见的大数据处理工具和算法,拥有丰富的数据清洗、挖掘和分析经验。

数据库开发工程师简历(精选6篇)数据库开发工程师简历 1个人信息姓名:性别:出生年月:联系方式:(电子邮箱和电话号码等)教育背景学历:专业:毕业时间:所在学校:工作经历公司名称及职位:工作内容简述:(具体项目及贡献)起止时间: (20某某年月)技能与证书熟练掌握的编程语言(如Java、Python等)熟练掌握的'数据库管理系统(如MySQL、Oracle等)熟练掌握的数据库设计和优化工具(如SQL Server Management Studio、Visual Studio等)掌握NoSQL数据库技术(如MongoDB、Cassandra等)(如有)掌握数据仓库和ETL技术(如SSIS、SSAS等)(如有)具备数据库管理员(DBA)证书(如有)项目经验项目名称及描述:在项目中承担的职责及成果:项目周期及规模:所用技术栈及工具:与团队成员及外部单位的合作经历及沟通方式:在项目中遇到的挑战及解决方案:通过该项目的收获及个人成长:其他英语水平:(如CET-6、TOEFL等)(如有)获得过的荣誉或奖项:(如有)兴趣爱好及个人特长:(如有)自我评价及总结:(针对个人职业发展的反思与展望)数据库开发工程师简历 2个人信息姓名:国籍:中国目前所在地:广州民族:汉族户口所在地:江西身材: 170 cm 64 kg婚姻状况:已婚年龄: 32诚信徽章:人才测评:求职意向及工作经历人才类型:普通求职应聘职位:软件工程师、电信交换/网络工程师、数据库工程师/管理员:工作年限: 9职称:初级求职类型:全职可到职日期:随时月薪要求:面议希望工作地区:广州个人工作经历:公司名称:起止年月:20某某-11 ~广州某某技术有限公司公司性质:民营企业所属行业:计算机软件担任职务:项目经理工作描述:在中国银行华南信息中心项目管理部任职项目经理,负责中行新一代核心银行系统在华南部署实施的项目管理,工作范围包括协调各方制定项目实施计划,资源配置管理,制定针对核心应用系统迁移过程全程监控策略,协调华南五省分行科技部门与总行信息中心以及业务部门的沟通离职原因:公司名称:起止年月:20某某-05 ~ 20某某-10广州某某技术有限公司公司性质:国有企业所属行业:通信/电信/网络设备担任职务:项目经理工作描述:领导项目团队负责浙江电信综合调度系统、湖南电信服务能力前置系统及中山电信DTS系统项目实施离职原因:公司名称:起止年月:20某某-03 ~ 20某某-04广州京华网络有限公司公司性质:民营企业所属行业:计算机软件担任职务:开发工程师工作描述:进行系统需求调研,系统的的`基础需求收集,提供技术解决方案、安排团队人员进行报表开发、系统测试和培训工作离职原因:公司名称:起止年月:20某某-07 ~ 20某某-02广东源天工程公司公司性质:国有企业所属行业:计算机硬件担任职务:网络工程师工作描述:负责公司网络搭建、服务器安装配置、地铁设备监控系统搭建离职原因:志愿者经历:教育背景毕业院校:东华理工学院最高学历:本科获得学位: 学士毕业日期: 20某某-07-01所学专业一:计算机科学与技术所学专业二:受教育培训经历:起始年月终止年月学校(机构)专业获得证书证书编号20某某-09 20某某-07东华理工学院计算机科学与技术语言能力外语:英语一般国语水平:精通粤语水平:良好工作能力及其他专长8年以上IT行业工作经验,其中5年项目管理实践;在电信、金融行业IT 应用开发、系统运维领域具备丰富的项目管理;优秀的项目管理及协调能力,能够有效控制项目人员、时间、任务和质量,擅于在复杂的内外部环境中推动项目进展;精通Oracle、DB2 数据库,PL/SQL开发,熟悉LINUx服务器、熟悉BOSS、WebLogic应用安装、集群配置,熟悉软件测试流程;详细个人自传良好逻辑思维、表达和沟通能力,具有团队工作精神,能在工作压力下保持高效工作状态;数据库开发工程师简历 3基本信息姓名:性别:婚姻状况:民族:户籍:年龄:现所在地:身高:联系电话:电子邮箱:求职意向希望岗位:数据库工程师/管理员工作年限:2职称:无职称求职类型:全职到岗时间:随时工作经验20某某年3月—至今某某有限公司,担任oracle工程师。

大数据研发工程师简历姓名:XX毕业院校:XX 大学(一本)目前城市:北京E-mai1:*****************H 应聘方向工作性质全职应聘职位:大数据研发工程师求职地点:北京H 工作经历单位名称XXXXXX 商务有限公司 职位名称大数据研发工程师 工作时间2016.5-2019.2 H 职业技能1 .熟练掌握HadoopHdfs 存储流程,Yarn 调度机制,MapReduce 工作原理,高可用部署,mr 运行性能调优。

2 .熟练掌握hive 数仓结构,熟练HQ1开窗及UDTF 函数应用,熟悉HQ1优化执行手段。

、3 .熟练掌握f1ume,有使用多层F1Ume 搭建高可用和容灾架构的经验。

4 .熟练使用Sqoop 将数据在Hdfs 和关系型数据库之间转移。

5 .熟练使用Kafka 实现分布式,大吞吐集群,熟悉Kafka 高低阶API 差别,掌握Kafka 一致性机制以及一次性语意。

6 .熟练使用SParkCore,SparkSqI»SParkStreaming 编码,涉及过SParkM11ib 编程,熟悉Spark 任务提交执行流程及内存调优。

7 .熟练使用Sca1a,Java8进行业务代码编写。

8 .熟练使用1in11X 操作系统,能够编写SheI1脚本。

9 .熟练使用Crontab,AZkaban 进行任务调度。

10 .理解HbaSe 数据存储原理,有处理过HRegiOn 热点问题,ROWkey 设计等开发设计经验。

11 .熟练使用Mysq1数据库操作,以及使用RediS 做缓存处理。

12 .了解日asticsearch 搜索引擎及MongoDB 数据库基本操作。

B 项目经历 项目一:猎趣电商分析系统软件架构: 性 另I 」:X 年龄:XX 联系电话:XXXX薪资要求:面议Nginx+F1ume+Zookeeper÷Spark+Hadoop+Spingboot+Hive+Mysq1开发环境:IDEA+JDK1.8+Maven+Git项目描述:该项目通过对电商网站的用户行为数据进行埋点,根据平台统计数据,辅助PM和后端人员分析现有的产品情况,并根据用户行为数据分析的结果来改善展示以及调整公司的战略和业务。

大数据开发工程师岗位-简历

基本信息

自我评价

我是一名具备广泛大数据开发经验的工程师,致力于构建高效的数据处理和分析系统。

我拥有扎实的编程技能,熟练掌握大数据技术栈,包括Hadoop、Spark和Kafka等。

我在数据仓库设计和ETL流程优化方面有丰富经验,能够处理海量数据并提供高性能的数据解决方案。

我擅长与跨职能团队合作,了解业务需求并提供创新的数据解决方案。

我渴望继续深入研究新的大数据技术,并在项目中应用它们,以为公司创造更多的价值。

工作经历

技能

•

大数据技术栈,包括Hadoop 、Spark

、Kafka 和Hive 。

•

数据仓库设计和优化,使用SQL 和NoSQL 数据库。

•

数据处理和清洗,使用Python 、Scala 和Spark 。

•

ETL 流程开发和维护。

•

团队协作和跨职能沟通,解决复杂的数据问题。

教育背景

兴趣爱好

除了工作,我热衷于探索新的大数据技术和挑战。

我经常参加技术研讨会和培训,保持在领域的领先地位。

在业余时间,我喜欢户外活动,特别是徒步和露营,欣赏大自然的美丽。

我也是一名音乐爱好者,喜欢弹吉他和钢琴,以发展创造力和表达情感。

大数据简历模板个人信息。

姓名,XXX。

性别,男。

出生日期,19XX年XX月。

联系电话,XXXXXXXX。

电子邮箱,**************。

通讯地址,XXXXXXXXX。

教育背景。

XXXX年-XXXX年 XXX大学专业,XXXX 学士学位。

XXXX年-XXXX年 XXX大学专业,XXXX 硕士学位。

工作经历。

XXXX年-XXXX年公司名称职位,大数据分析师。

负责公司内部大数据的收集、清洗、分析和应用。

参与制定公司的大数据战略规划。

与其他部门合作,为业务决策提供数据支持。

XXXX年-XXXX年公司名称职位,数据工程师。

负责数据仓库的设计和维护。

参与大数据平台的搭建和优化。

开发数据处理和分析的相关工具和系统。

项目经历。

XXXX年-XXXX年项目名称。

负责项目的数据采集和处理。

运用大数据技术进行数据分析和建模。

提供数据可视化和报告,为决策提供支持。

技能。

精通Hadoop、Spark等大数据处理框架。

熟悉Python、R等数据分析和建模工具。

具备良好的数据挖掘和统计分析能力。

了解机器学习和深度学习相关知识。

获奖情况。

XXXX年获得XXX大奖学金。

XXXX年参与XXX大数据竞赛获得一等奖。

自我评价。

本人具备扎实的数据分析和处理能力,熟练运用各种大数据处理工具和技术,有丰富的项目经验和团队合作经验。

对数据分析有着浓厚的兴趣,善于发现数据背后的规律,能够为业务决策提供有力的支持。

以上就是一份优秀的大数据简历模板,希望能够对大家在求职过程中有所帮助。

祝大家找到心仪的工作!。

大数据开发工程师

姓名:XXX 年龄:XX

毕业院校:XX大学手机:XXXXX

E-Maikxxxxxx籍贯:xx×xx

XXXXXXX有限公司

大数据开发工程师2016年1月-—2019年2月

工作技能:

1、熟练掌握HDFS f Yarn f MapReduce工作机制与运行原理,MR程序调优,HadOOP集群搭建,高可用部署。

2、熟悉Zookeeper集群搭建与Zookeeper内部选举机制。

3、熟练掌握Hive数仓工具,熟练应用HQ1操作数据仓库,自定义过UDF函数,熟练窗口函数,用户定义表函数exp1ode与其他类型函数,理解HQ1运行流程与相应优化措施

4、熟练使用F1ume日志采集工具,熟悉F1ume的运行原理。

有基于多层次F1ume结构经验,自定义过F1ume 拦截器。

5、耨东掌握Kafka工作流程搭建过Kafka集群熟悉Kafka的高级与低级API的差异与SParkStreaming对接时方案的选取。

6、了解HBase基于分布式,高并发的列式存储。

理解Hbase底层数据存储原理与HRegione热点问题。

7、熟悉Sq。

P数据的导入导出,并结合AZkaban任务调度工具使用。

8、熟悉Sca1a编程语言,熟悉Sca1a的隐式转换,熟悉模式匹配和样例类的使用,以及常用算子的使用。

9、熟悉Spark的Transformation算子与Action算子熟悉Spark的架构与提交流程启定义过SparkSq1o的UDF 函数,熟悉SparkStreaming对流的按批次处理,熟悉DStream的有状态与无状态的转换。

10、瞬Java编程语言,熟悉JVM内存结构,了解JVM调优。

11、熟悉MySq1Redies x EIasticSearch的使用,熟悉SQ10

12、熟悉1inux操作系统,熟练1inux常用命令,编写过She1I脚本,使用过Crontab o

项目经验:

项目名称:开卷有益业务平台离线数仓

开发环境:IDEA+JDK1.8+Sca1a2.12.1+Maven

软件架构:Hadoop+Hive+Sca1a+SparkCore+SparkSq1

项目描述:针对公司APP日志采集系统收集的数据与公司APP业务数据库收集的数据落盘到Hive后,对数据做分层处理。

对原始数据层的数据做降维作,然后在数据服务层形成跨主题宽表。

最后依据叫仓库中的数据,形成各项数据报表辅助公司APP现状,指导决策,为产品的迭代提供支持。

负责内容:

1、对数据采集到Hive的原始数据做数据清洗(去空,脏数据,操过极限值范围的数据)。

2、参与讨论数据仓库的分层设计与维度设计。

3、参与需求分析与讨论,处理运营部门提出的业务需求。

如每日,每周,每月活跃用户,用户留存,用户复购,

ToPN排名。

4、使用Sqoop把Hive中提取的数据导入到公司BI系统,用于业务部门分析。

技术要点:

1、对ODS层原始数据做数据清洗,并更改压缩格式与存储格式到DWD,减少I/O,提高数据压缩效果。

2、在数据服务层成形跨主题的宽表,存储大量数据,提高查询效率。

3、针对不同的表数据信息使用全量同步策略与增量同步策略

3、根据运营部门提出的需求形成面向实现的数据表嫄,并通过Sq。

P把嫄导入公司B1系统。

4、针对数据倾斜问题,若小文件过多则则设置相应参数合并小文件,若文件过大,任务逻辑复杂,考虑增加M叩数

项目名称:开卷有益实时数仓系统

开发环境:IDEA+JDK18+Sca1a2.12.1+Maven

软件架构:NginX+Tomact+ZOokeePer+Kafka+Spark+Sca1a+Redies+Easticsearch

项目描述:公司APP应用通过埋点方式收集用户信息,并把收集的日志信息发送到统计业务服务器(NginX),然后Nginx服务器轮询日志数据并把日志数据发送到日志服务器(TomCat),日志服务器会把不同的日志类型数据发送给kafka集群的不同的topic中。

最后通过消费topic里的数据按业务需求分别发送到Redies缓存服务器与ES报表数据库中,最后把ES中的数据发布出来。

负责内容:

1、参与讨论Redies缓存服务器与ES报表系统的字段设计与表设计。

2、参与针对实时数据处理的需求讨论。

处理运营部门提出的需求。

如每日订单交易数与交易量的实时查寻、每日

设备的活跃用户数并分时统计,统计各类小说一小时内的阅读量,每天各地区各城市小说阅读量实时统计3、负责后台接口的开发,根据前端请求的报文,发布Easticsearch的查询结果,响应前台服务。

技术要点:

1、通过SparkStreaming消费不同kafkaTOPie,利用SparkStream配合redies去重处理。

2、由于需要支持查询用户下单明细,需要使用IK分词器。

并确认分词字段。

3、由于运营需要用户实时的单日订量及收入,由于交易方式是调用的第三方支付接口,无法通过前端埋点实时获取,最后搭建了Cana1实时监控业务服务器的bin1og日志。

4、对于XtchDurationp批处理时间的设定,如果设置过短,会产生数据不断堆积,导致SParkStreaming发生阻塞。

数据少时,反而会频繁的提交作业,需要合理设置,我们一般设置在1~10S.

6、Spark中的RDD和SparkStreaming中的Dstream,如果被反复的使用,最好利用cache(),将该数据流缓存起来,防止过度的调度资源造成的网络开销。

7、Task默认的并行度是由spark.defau1t.para11e1ism参数决定的,可以通过设置task并行度提高性能。

项目名称:开卷有益推荐系统

开发环境:IDEA+JDK18+Sca1a2.12.1+Maven

软件架构:Zookeeper+Kafka+Spark+Redies+ES

项目描述:根据公司APP应用的点击行为进行用户偏好数据采集,通过F1ume经行日志采集,实时发送至kafka集群,kafka作为流式数据的缓存组件,接收来自F1ume的数据采集请求,并将数据推送至sparkstream 做实时推荐。

通过从数仓系统处理过的数据导入Mysq1业务DB的健做离线推荐。

负责内容:

1、负责数据的采集与数据的整理,为算法工程师提供数据支持。

2、根据业务需求,参与技术选型与可行性分析,指标分析的讨论。

3、参与统计推荐模块,离线推荐模块,实时推荐模块的开发。

技术要点:

1利用数仓中的用户评分数据,计算一些可以预先进行统计和计算的指标,为前端业务提供响应的数据支撑。

2、使用A1S算法对评分矩阵做矩阵分解,根据应用APP的隐语义特征计算APP应用与用户的特征,并将。

相关度提取出来形成应用相关度矩阵,为实时推荐准备。

3、利用应用相似度矩阵,根据用户最新的评分或点击行为做实时推荐。

4、使用spark计算每个门类的平均评分最高的应用来解决冷启动。

项目名称:开卷有益日志采集系统开发环境:IDEA+JDK1.8+Sca1a2.12.1+Maven

软件架构:NginX+Tomcat+F1ume+Kaka+Hadoop+Sqoop+Azkaban

项目描述:公司APP日志通过埋点方式收集信息并把日志信息发送到Nginx负载均衡服务器,Nginx通过轮询的

方式发送数据到公司的日志采集系统,日志系统对接双层F1ume,做数据聚合与分流。

最终数据落盘到HDFS o公司业务系统数据库的数据直接通过Sqoop导入HDFS0

负责内容:

1、日志数据的采集,通过双层F1ume落盘至HDFS e

2、通过FIUme采集的数据在第二层根据日志类型做拦截与分流。

3、业务数据库数据通过Sqoop导入至HDFS,并编写Job通过Azkaban定时导入数据到HDFS o

4、利用HQ1把HDFS的数据导入Hive中,并通生成she11脚本,通过Azkaban定时调用。

技术要点:

1、使用F1umeSource使用tai1dir监控文件,记录处理过的OffSet,即使F1ume宕机文件也不会从头读取。

2、负责FIUme拦截器编写,通过拦截器拦接收的日志字端判断日志类型,并在Event里的header(K,V)里添加日志类型,并在根据选择器发送给不同的FIUme达到分流效果。

3、TaiIdirSource重复获取数据问题。

因为重命名后的文件名仍然符合正则表达。

需要对源码经行修改,UpdateTaiIFiIes方法修改if(tf==nu11)Tai1Fi1e类的UpdatePos方法修改为if(this.inode==inode)o

4、当F1ume监控的日志文件被移走或删除,f1ume仍然会继续雌,不会释放资源。

最后查出的原因是IdIeTimeout默认值为120000ms,类似默认等待时间。

可以根据实际情况进行修改。

5、Kafka性能参数配置可以通过BrOker里的work.threads设置broker处理消息的最大线程数。

设置produce写入数据时刷写数据到磁盘的策略Iogfushjnterva1messages=IOOOO调整读取刷写大小。