第三讲 数据预处理

- 格式:ppt

- 大小:983.50 KB

- 文档页数:67

数据预处理方法和内容摘要:一、数据预处理的重要性二、数据预处理的方法1.数据清洗2.数据转换3.数据规范化三、数据预处理的内容1.缺失值处理2.异常值处理3.数据类型转换4.数据归一化四、实际应用案例分析五、总结与展望正文:数据预处理是数据分析过程中至关重要的一个环节,它直接影响到后续数据分析的结果和质量。

数据预处理主要包括数据清洗、数据转换和数据规范化等方法。

一、数据预处理的重要性数据预处理的重要性体现在以下几个方面:1.提高数据质量:通过对原始数据进行清洗、转换和规范化等操作,可以消除数据中的错误和异常,提高数据的准确性和可靠性。

2.方便后续分析:经过预处理的数据更容易进行统计分析和建模,从而提高数据分析的效果。

3.提高模型预测精度:数据预处理可以消除数据中的噪声和异常值,降低模型的过拟合风险,提高预测精度。

二、数据预处理的方法1.数据清洗:数据清洗是指对数据中的错误、缺失、异常等进行处理的过程。

主要包括删除重复记录、填补缺失值、处理异常值等。

2.数据转换:数据转换是指将原始数据转换为适合分析的数据形式。

主要包括数据类型转换、数据结构调整等。

3.数据规范化:数据规范化是指将数据按照一定的标准进行归一化处理,使数据具有可比性和一致性。

主要包括数据归一化和标准化等。

三、数据预处理的内容1.缺失值处理:缺失值处理是数据预处理中的一个重要环节。

常用的方法有:均值填充、中位数填充、众数填充、线性插值、三次样条插值等。

2.异常值处理:异常值处理是为了消除数据中的异常点,常用的方法有:箱线图法、z分数法、3σ法则等。

3.数据类型转换:数据类型转换是将数据从一种类型转换为另一种类型。

例如,将字符串转换为数字、将日期转换为数值等。

4.数据归一化:数据归一化是将数据缩放到一个统一的区间范围内。

常用的方法有:最大最小归一化、z分数归一化、分位数归一化等。

四、实际应用案例分析以房价预测为例,首先对原始数据进行缺失值处理、异常值处理和数据类型转换,然后对数据进行归一化处理,最后进行建模分析和预测。

数据预处理是数据分析的重要环节,它通过对原始数据进行一系列的处理操作,使得数据更加规范、准确,提高数据分析的效率和准确性。

以下是数据预处理的基本内容:1. 数据清洗:数据清洗是数据预处理的重要步骤,它的主要任务是处理缺失值、异常值和重复值。

对于缺失值,可以通过填充缺失值、删除含有缺失值的行或列、或者使用插值等方法进行处理;对于异常值,可以通过3σ原则、箱型图等方法检测并处理异常值;对于重复值,可以通过删除重复值、只保留一个重复值、或者使用聚合函数等方法进行处理。

2. 数据转换:数据转换是指将原始数据转换成适合进行数据分析的形式。

常见的数据转换包括数据类型转换、数据编码、数据映射等。

例如,将分类变量进行编码,将连续变量进行离散化等。

3. 数据集成:数据集成是指将来自不同数据源的数据进行整合,形成一个统一的数据集。

在数据集成的过程中,需要注意解决数据的冲突和不一致性问题,保证数据的准确性和完整性。

4. 数据归一化:数据归一化是指将不同量级的数据进行规范化处理,使得它们的量级和范围大致相同,方便后续的数据分析和算法处理。

常见的归一化方法有最小-最大归一化、Z-score归一化等。

5. 数据重塑:数据重塑是指通过调整数据的形状、大小和维度等方式,使得数据更适合特定的数据分析需求。

例如,对数据进行排序、排序、切片、重组等操作。

6. 数据可视化:数据可视化是指通过图形、图表等形式将数据进行可视化展示,帮助用户更好地理解和分析数据。

常见的可视化工具包括折线图、柱状图、散点图等。

7. 数据随机化:数据随机化是指在数据预处理过程中,将数据进行随机排序或打乱,以便于进行随机试验或交叉验证等分析方法。

8. 数据降维:数据降维是指通过减少数据的维度或特征数量,降低数据的复杂性,提高数据处理的速度和效率。

常见的数据降维方法有主成分分析(PCA)、线性判别分析(LDA)等。

报告中的数据预处理和异常值处理技巧一、数据预处理的重要性及步骤1.1 数据预处理的定义和作用1.1.1 数据预处理的定义数据预处理是指在进行数据分析之前,对原始数据进行清洗、转换和集成等处理操作,以提高数据质量和分析结果的可靠性。

1.1.2 数据预处理的作用数据预处理可以帮助我们消除数据中的噪声、填补缺失值、数据转换和归一化等,使得数据能够满足分析的要求,提高数据挖掘的效果。

1.2 数据预处理的步骤1.2.1 数据清洗数据清洗是指通过删除重复值、处理缺失值、处理异常值等方式,使得数据集更加干净、可靠。

1.2.2 数据集成数据集成是指将多个数据源中的数据合并,生成一个一致、完整的数据集。

1.2.3 数据转换数据转换是指将原始数据转换为适合分析的形式,如对数据进行平滑、聚集、离散化等操作。

1.2.4 数据归一化数据归一化是指将数据转换为统一的尺度,避免不同变量之间的量纲差异带来的问题。

二、异常值的定义和检测方法2.1 异常值的定义异常值是指与其他观测值明显不同的值,可能是由数据录入错误、传输错误或者真实数据中的特殊情况引起的。

2.2 异常值的检测方法2.2.1 基于统计方法的异常值检测统计方法通过假设检验或者计算异常值得分的方式来判断一个观测值是否为异常值,常见的方法包括均值检测、箱线图法和Z-Score法等。

2.2.2 基于机器学习的异常值检测机器学习模型可以通过训练数据集来判断观测值是否为异常值,常用的方法包括KNN算法、孤立森林算法和自编码器等。

三、缺失值的处理方法3.1 缺失值的定义和分类3.1.1 缺失值的定义缺失值是指在数据采集过程中未能成功获取到的值,常用的表示方式包括NaN、NULL或者空白。

3.1.2 缺失值的分类缺失值可分为完全随机缺失、随机缺失和非随机缺失三种情况。

3.2 缺失值的处理方法3.2.1 删除含有缺失值的观测行如果缺失值的比例较小,可以直接删除含有缺失值的观测行,但会丢失部分信息。

医学功能成像技术第三讲磁共振波谱技术吕维雪本讲座撰写人吕维先生浙江大学教授MRS是一种比MRI更广泛的技术临床的质子MRI只是核磁共振(NMR)非常丰富的物理现象的一种应用这是因为在组织中有许多感兴趣的化合物而不仅仅是水或脂肪的质子水和脂肪的特征固然对于诊断非常有用但它们不能提供足够的信息来肯定地区分正常的和病理的组织能够无损伤地获得特定的代谢物和化学物质以及它们在这些化合物中特定原子位置上的吸收和变化的信息是对于正常的和病理的过程理解和定征十分有用的大量信息不仅是对诊断有用而且对于疾病过程生化细节的解释对于治疗的发展有重大的推动力根据MR的原理可以知道MR提供的信息包括内在T1和T2弛豫的性质自旋密度血液和脑脊髓液(CSF)流弥散灌注局域氧合局域含铁膜通透性以及造影剂在加负荷或刺激或在病理状态下的动态过程新的发展和解释还在继续如脑功能性激活的定位原则上对每一种MRS可见的特定代谢物都能得到大部分这种信息MRS比MRI可以得到的更多的信息中都是由于能获得非质子原子核的信息对其每一种都有一个可见的生物分子谱并且往往代表了代谢的不同方面(如能量的区室化的运动学的)用现有技术可以确定分子结构和形态的细节局域的pH和温度生化的路径以及代谢的运动学这些技术都可以用于评价脑功能的状态和响应获取MRS信息通常要牺牲其它类型的信息之所以会这样是因为不能把一个病人放在磁场里很长的时间来完成各种各样的测量实际上常见的情况是牺牲空间信息(分辨率)来换取化学信息随着设备和测量技术的进步这种代价会有所降低MRS技术的发展是向能够产生每个体素有细致的化学谱图目前这些体素的分辨率受信噪比感兴趣代谢物的浓度以及可用的扫描时间的限制一磁共振波谱的原理MRS 的基本原理和MRI 是一样的都是基于信号频率直接由磁场强度决定场强愈高谐振频率愈高方法上的最大差别在于MRS 信号是在不加梯度磁场时采集的即没有位置编码频率一般MRS 波谱图是一幅强度频率曲线(图1)习惯上信号频率向左是增加从感兴趣体积(VOI)所记录到的信号是不同频率信号分量的总和用傅氏变换可将其转换成一系列频率分量的峰值(图2)人体组织中大部分感兴趣代谢物的毫克分子浓度比组织中水的浓度小10000倍这个比例说明了为什么通常由组织中纯质子信号形成的图像中观察不到所发生的代谢变化因此把代谢物的信号从水和脂肪的信号中分离出来成了MRS 信号处理中的难点在MRS 中很重要的一个概念是化学位移(Chemicalshift)1946年物理学家FelixBlock 和EdwardPurcell 发现某核子的谐振频率w0是直接与该核子所处的磁场强度成比例的同时信号的幅值是与被测核子的数目成比例即00B γω= (1) 式中B 0为磁场的强度; 为一比例常数称为磁旋比(Gyromagneticratio)是每种不同类型原子核的特性1H 13C 31P 等在同样的磁场中有不同的谐振频率但如果对一个分子的一部分质子进行测量时会发现信号的谐振频率与纯质子时的谐振频率有差异这种差异相当于核子受到一个不同的磁场强度B 有效的作用:B 有效=B 0+B 局域 (2)造成B 局域的主要因素是:(1) 围绕核子旋转的电子的磁场;(2) 附近核子的磁场式(1)亦适用于B 局域所以测得的信号频率测为: 测=B 0+B 局域=B 0(1+) (3) 比例常数称为对核子的化学位移通常它是以所加磁场中频率的ppm 来表示因而它与所加磁场无关并在一定程度上与所用的测量仪器无关这就有利于使测量结果标准化MRS 中的另一个重要现象是峰分裂(Peak Splitting)由于峰分裂的过程从MRS 可以得到更多化学信息的细节如果测量的谱有足够的分辨率则可以观察到许多峰分裂成一组组的单个峰信号峰的分裂是由于相邻核子间自旋自旋耦合现象造成图3是峰分裂的一个例子峰分裂的类型与化学结构有关有机化学家可以根据峰分裂的形式判定所测的是什么分子/化合物波谱的模式是独特的犹如指纹一样长期研究的积累已建立起了相当规模的波谱模式数据库并支持对愈来愈复杂的结构的定征研究以及对动物和人体的活体研究二测量的基本方法最初的和最基本的测量方法是把发射器和接收器的射频调谐到一特定的频率测量返回的信号幅值把频率做一小的变化再重复测量从而可以做出一个幅值频率的图即MR波谱更先进和有效的方法是发射一个广谱的RF信号并测量整个量程的返回信号然后用傅氏变换得出各频率分量的幅值MRI和MRS之间的主要区别是MRS是在没有读出梯度磁场下采集的而梯度磁场在MRI中是作为图像的频率编码的由于生化信号(除水和脂肪外)微弱因而受到信噪比的限制所以大部分MRS使用重复测量的数据来取平均由于代谢物的波谱信号微弱所以对MRS的磁场有较高的要求磁铁的设计应使磁场强度的均匀性在0.1ppm以内并有足够大的空间以容纳待测试的物体当被测试物体放入磁场时磁场强度的均匀性将受到影响因此MRS系统必须有某种措施来微调磁场以使对每一所研究的物体都能保持磁场的均匀性这一过程称为Shimming意即引入偏置磁场以改善磁场的均匀性在磁共振扫描仪安装时是靠用小的金属块来改变磁力线的路径以达到要求的均匀性由于磁共振成像(MRI)的信号大磁场不均匀度相对于大的梯度磁场来讲要小得多因此问题不大但对于波谱测量则情况将有所不同因为原则上没有办法区分出位移是由磁场不均匀造成还是由化学位移造成而两者在量级上是接近的所以磁场的不均匀度必须是小于所希望的波谱分辨率对于波谱测量来讲因磁场均匀性受被测物体的影响因此对磁场的微调(Shimming)在对每个被测物体测量前都有进行而且是交互式的它往往占了整个测量过程的大部分时间微调是通过调节流过磁铁中若干微调线圈的电流来实现所以MRS系统与MRI系统在硬件上的一个主要差别是有没有这些微调线圈以及如何有效地进行调节由以上所述可以知道这个磁场微调过程本身是一个高维的数值优化问题掌握微调技术是MRS操作人员最重要的培训内容MRS信号检测时另一个要解决的微调是抑制水的信号在人体组织中水的浓度(100M)比大部分感兴趣代谢物的浓度(10mM)大得多所以如果不采取措施抑制水的信号的话则代谢物的信号将被完全淹没现在已有几种抑制水信号的方法这些方法都是基于水和代谢物之间的性质差别的其中之一为采用频率选择性脉冲这类方法是利用水和代谢物之间化学偏移的不同最常用的方法是用对化学位移有选择性的射频脉冲它与成像技术中的层面选择脉冲相类似(图4)这种方法用一个有限带宽的射频脉冲去激励有相应谐振频率的那些组织在成像技术中由层面选择脉冲激发的自旋决定了其在梯度磁场中的位置而当没有梯度磁场时所激发的自旋决定于它们的化学位移在频域选择性脉冲(而非空域)中组成RF脉冲的带宽是根据只选有限化学试样来确定的最常用的这种方法是发射一以水的峰为中心的窄带脉冲接着用水的90º激发以消除水的信号当水的磁化开始恢复并尚不能激发时对其它的试样作激发和测量这种方法由于不能得到理想的脉冲波形(如截止频率不够陡)因而仍有残余的水信号在采集了数据以后对数据的处理也有许多要注意的地方MRS的数据处理由四步组成: (1)预处理(2)傅氏变换(3)后处理(4)数据分析预处理包括去除直流分量数据补零以及对傅氏变换后的频谱插值有时还将数据乘一指数函数以改善信噪比等第二步的傅氏变换是众所周知的在后处理中两种经常使用的处理为复数数据的相位校正和对涡流效应的校正相位校正的目的是校正傅氏变换实数部分的频谱使计算幅值谱的时候谱峰不会变宽在做波谱成像时对每个体素都要作相位校正当体素数目大的时候需要开发自动相位校正的方法在MRS检测时邻近的金属器件会感生涡流并造成波谱的相位失真在做波谱成像时这种失真将和磁场不均匀一起使失真更严重现在已提出了几种相位校正的方法最后一步是数据分析数据分析的目的是化学位移的定量谱分析以及计算代谢物的绝对浓度或相对浓度三磁共振波谱的显示方法要适合临床应用就应有能有效显示所测得数据的方法这应该是多维数据可视化的问题波谱是一维信号它反映某一体积(感兴趣体积VOI)中的波谱信息必须要把它和周围的组织联系起来才能更好地做生理病理的解释现在常用的有几种方法一种方法如图5所示把一个体素的位置显示在三个正交截面的MR图像上第二种由于化学位移的信噪比低所以要用较大的体素来提高信噪比化学位移成像的空间分辨率低或图像的体素数不大时有可能用一个体素的阵列在每个体素中都显示出其波谱如图6所示当然这种方法在阵列较大时使用就很不方便并且解释困难第三种方法如图7所示这种方法显示一种(灰度图像)或几种(彩色图像)所测的化合物用该化合物峰下的面积来作图像中体素的参量这样波谱中的任何一个峰(对应某代谢物)都可以做出一幅图像同样因化学位移成像的分辨率不高难以确定相应的解剖结构为此往往把它叠加在高分辨率的解剖图像上如MR图像直接用化学位移成像也是可能的因为采集波谱信息意味着不能再用位置的频率编码了于是既要想得到谱的信息又要得到空间的信息就要利用信息的相位编码与大部分的成像序列一样做相位编码需要进行反复的采集这就使成像时间变长图8为一维和二维相位编码成像的示意图在这个相位编码的体积中每一个体素都有完整的化学波谱理论上这些波谱的分辨率和频率宽度是和非成像波谱测量时的一样因而根据这些信息也可以作出任一波峰的图像不过事实上由于成像时间过长以及代谢物信号强度的限制分辨率达不到一般成像的空间分辨率典型的过程是对每一相位编码步做一次完整的信号采集(决定于TR的长短)对于一维的化学位移成像采集数据组的典型反复是用具有正交饱和带宽的层面选择性激发以选定感兴趣几个中的一个列相位编码就是在这一列上进行的化学位移成像的一个主要优点是能更好地定义测量波谱的区域由于许多完整的局域波谱是同时采集的因此所获得的信号比较大信噪比亦较高在基于单个体素的采集中是从单个体素采集N个不同信号而在化学位移成像(CSI)中是整个区域的信号采集N次每次有不同的相位编码最后对每个相位编码的区域作傅氏变换在定位局域的波谱方面一种很成功的反复是施加一个序列的层面选择RF脉冲使得只在一限定的区域内的自旋得到激发并产生信号这个感兴趣(VOI)区域的位置和大小决定于三个正交层面的相交区(图9)图中这个相交区是方形的不过实际形状是决定于选择脉冲在层面上的形状的实现局域检测的方法有多种其中之一称为 STEAM (STimulated Echo Acquisition Mode)的方法常用于脑的MRS研究中在此方法中三个相互垂直的层面分别用三个90º Sinc形RF脉冲激发(图10)只有在三个激发层面的交集中的自旋受到全部三个RF脉冲激发并产生回波所有其它的回波信号都被梯度脉冲破坏只有VOI中激发的回波被采集第一个90º脉冲把所有的磁化转到xy平面第二个90º脉冲把50%的磁化转回到xz和yz平面其余50%的磁化在第二和第三个RF脉冲之间的TM在xy平面中是失相的并对激发回波信号没有贡献在TM期间xz和yz平面中的磁化将按T弛豫时间衰减TM应短以免造成太大的信号损失第三个90º脉冲把磁化1转回xy平面它经过TE/2间隔给出激发的回波信号CSI的主要缺点是一个体素的信号受外界信号的影响这是由于离散和有限取样的结果这种伪像其实在其它成像技术中也是存在的只是在CSI中每个体素的点扩散函数对相邻体素的影响更大使得空间定位的准确度降低CSI的另一个问题是它受磁场不均匀度和梯度造成的涡流影响大它们使谐振频率谱宽谱的形状发生畸变同时由于数据是在一个较大的区域中采集的自然对磁场的均匀度微调的要求都提高了四应用举例MRS可以无损地对活体获取生物化学信息因而对于确定肿瘤的类型有很大的价值确定肿瘤的性质恶性程度及其在空间的分布对神经外科医师做出诊断决定是否要做切除手术甚至手术的导航都是十分关键的到目前为止取活检样本做组织病理学的定征仍是黄金标准但因活检是创伤性的取样的数目不允许很多而且有些部位做穿刺有相当的危险(出血)这些因素不能不影响到用活检作诊断的准确性加权(272ms)质子磁共振波谱可以观察到六种主要的化学从活体脑肿瘤的T2共振这些共振主要是由以下代谢物产生:(1) 四甲基胺主要是3.2ppm的含氯磷脂质(Cho)它参与膜的合成和退化;(2) 肌肉素和3ppm的磷酸肌酸(Cr)它在能量代谢中起重要作用;(3) N-乙酰基组主要来自2ppm的N-乙酰基天氡氨酸它是神经标记物;(4) 1.4ppm的丙氨酸(Ala)它是某些肿瘤中找到的高浓度氨基酸;(5) 1.3ppm的乳酸盐(LA)它是由于异常酶化过程造成的或厌氧性醇解的指标;(6) 0.9ppm的脂类(Lip)和其它大分子如蛋白质(较少程度)基于各类脑肿瘤在这六种共振的波谱模式会有所不同的考虑所以可以利用对MRS作模式分析和识别就有可能对肿瘤定征图11是一个中年病人的MR图像(左上角)两个位置的MRS波谱(左下)以及整个感兴趣区内(黄框所示)中代谢物NA Cho的分布(右)病变处的波谱模式与低级别星形细胞瘤的模式很相似病人再次发作后做的活检证实了是低级别星形细胞瘤在Cho图像上显示出在MR图像最暗区一侧的区域是肿瘤最活跃的部分五前景不熟悉MRS的人往往把它看成是一种奇怪的技术是离临床应用很远的技术其实并非如此MRS和MRI都基于同一基本原理都可以有自己对临床实践的贡献特别是在对脑的功能性激活的研究方面随着MRI/MRS集成系统的增加它们两者之间的差别将不再那么明显新的系统将使MRS的临床应用有更快的发展多种原子核和化学试样的MRS测量已经显示了能提供脑功能生化机理方面的信息以往只能用放射示踪方法得到的速率和吸收的信息现在可以用NMR的方法得到同时所产生的MRS生化信息是与MRI的解剖学结果紧密联系在一起的这些方法在常规临床应用中的潜能扩展了昂贵的MRI设备的有用性MRS/MRI技术的关系有一点像生物技术和基因工程的关系虽然已经开发了很强大的工具但是要完全实现它还需要对正常的和病理的复杂过程有细致的理解不断地开发和应用这些工具将扩展这种理解并使生理学和医学从经验性向定量发展未完待续。

数据的预处理方法数据的预处理是指在进行数据分析或建立模型之前,对原始数据进行清洗、转换和集成等一系列操作的过程。

数据的预处理对于保证数据质量、提高模型性能以及得到准确的分析结果非常重要。

下面将详细介绍数据的预处理方法。

1. 数据清洗:数据清洗是数据预处理的第一步,主要包括处理数据中的缺失值、异常值和重复值。

- 处理缺失值:可以采用三种方法来处理缺失值,包括删除含有缺失值的样本、删除含有过多缺失值的特征以及用合适的方法填充缺失值。

填充缺失值的方法包括用平均值、中位数、众数或者是前后数据进行插值等。

- 处理异常值:异常值的处理可以采用删除或者替换的方法。

删除异常值的方法是删除超过一定范围的数据,例如3倍标准差之外的值,或者是根据专业知识定义异常值的范围。

替换异常值的方法包括用平均值、中位数或者是插值等。

- 处理重复值:重复值的处理可以采用删除的方法,即删除重复的数据。

2. 数据转换:数据转换是对数据进行标准化和转换的过程,主要包括对数据进行缩放、离散化和编码等。

- 数据缩放:数据缩放的目的是将不同单位和量纲的数据转换到一个相同的尺度上,以消除量纲对模型的影响。

常见的数据缩放方法有标准化和归一化。

标准化将数据按照均值为0,方差为1的方式进行缩放,而归一化将数据映射到0和1之间。

- 数据离散化:数据离散化是将连续型数据转化为离散型数据的过程。

离散化的方法包括等宽离散化和等频离散化。

等宽离散化将数据按照相同的宽度进行划分,而等频离散化将数据按照相同的频率进行划分。

- 数据编码:数据编码是将非数值型数据转化为数值型数据的过程。

常见的数据编码方法有独热编码和标签编码。

独热编码将每个类别编码成一个向量,其中只有一个元素为1,而其他元素为0,而标签编码将每个类别编码成一个整数。

3. 数据集成:数据集成是将多个数据源的数据集成为一个一致的数据集的过程。

数据集成主要包括数据清洗、数据转换和数据匹配等。

- 数据清洗:数据集成的第一步是对数据进行清洗,包括处理缺失值、异常值和重复值等。

数据预处理的概念

数据预处理的概念数据预处理是指在进行数据分析和建模之前对原始数据进行清洗、转换和整理的过程。

它是数据分析的关键步骤之一,能够提高数据质量和准确性,从而有效地支持决策和预测。

数据预处理包括数据清洗。

在这一步骤中,我们需要检查数据中是否存在缺失值、异常值和重复值。

缺失值可能会影响分析结果的准确性,因此我们需要决定如何处理这些缺失值,比如删除或填充。

异常值可能是由于数据采集错误或其他原因导致的,我们需要识别并决定如何处理这些异常值。

重复值可能会导致分析结果的偏差,因此我们需要去除重复值,确保数据的唯一性。

数据预处理还包括数据转换。

在这一步骤中,我们需要将数据转换为适合分析的形式。

例如,对于分类变量,我们可以将其转换为虚拟变量,以便在建模过程中使用。

对于数值变量,我们可以进行标准化或归一化处理,以消除不同变量之间的量纲差异。

数据预处理还包括数据整理。

在这一步骤中,我们需要对数据进行排序、合并或分割,以便更好地支持分析和建模。

例如,我们可以根据时间顺序对数据进行排序,以便进行时间序列分析。

我们还可以将多个数据集合并在一起,以便进行更全面的分析。

数据预处理是数据分析的重要环节,它能够提高数据质量和准确性,为决策和预测提供可靠的支持。

通过数据清洗、转换和整理,我们能够更好地理解和利用数据,从而取得更好的分析结果。

数据的预处理包括哪些内容数据的预处理是数据分析的第一步,它是指在进行数据分析之前对原始数据进行清洗、转换和集成等操作,以便为后续的分析建模工作提供高质量的数据。

数据的预处理内容非常丰富,主要包括数据清洗、数据转换、数据集成和数据规约等几个方面。

首先,数据清洗是数据预处理的重要环节。

在实际的数据分析工作中,原始数据往往存在着各种问题,比如缺失值、异常值、重复值和错误值等。

因此,数据清洗的主要目标是识别和处理这些问题,以确保数据的质量和完整性。

对于缺失值,可以采取删除、插补或者不处理等方式进行处理;对于异常值,可以采取删除、平滑或者替换等方式进行处理;对于重复值和错误值,可以直接删除或者进行修正处理。

其次,数据转换也是数据预处理的重要环节。

数据转换主要是指对原始数据进行变换,以便为后续的分析建模工作提供更加合适的数据形式。

常见的数据转换包括标准化、归一化、离散化和数据变换等。

标准化和归一化是将数据按比例缩放,以便使其落入特定的范围;离散化是将连续型数据转换为离散型数据;数据变换是对原始数据进行函数变换,以便使其满足分析建模的要求。

另外,数据集成也是数据预处理的重要环节。

数据集成是指将多个数据源的数据合并为一个一致的数据集的过程。

在实际的数据分析工作中,数据往往来自不同的数据源,因此需要进行数据集成以便为后续的分析建模工作提供统一的数据形式。

数据集成的主要工作包括数据清洗、数据转换和数据合并等。

最后,数据规约也是数据预处理的重要环节。

数据规约是指通过选择、投影、聚集和归约等方式对原始数据进行简化,以便为后续的分析建模工作提供更加高效的数据形式。

常见的数据规约包括属性选择、数据投影、数据聚集和数据归约等。

综上所述,数据的预处理包括数据清洗、数据转换、数据集成和数据规约等几个方面。

通过对原始数据进行清洗、转换和集成等操作,可以为后续的分析建模工作提供高质量的数据,从而提高数据分析的准确性和有效性。

因此,数据的预处理是数据分析工作中不可或缺的重要环节。

数据的预处理方法1.1数据预处理概述1.1.1数据预处理的目的由于人的错误、测量设备的限制或数据收集过程的漏洞等都可能导致各种问题,从而导致数据的值乃至整个数据对象都可能会丢失。

因此,为了高质量的数据挖掘结果,必须进行数据预处理。

数据预处理的目的是为信息处理过程提供干净、准确、简洁的数据,从而提高数据质量、信息处理率和准确性,使数据挖掘的过程更加有效,更加容易,同时也提高挖掘结果的质量。

数据预处理的对象主要是清理其中的噪声数据、空缺数据和不一致数据。

常用的数据预处理技术主要包括:数据清洗、相关分析和数据变换等。

1.1.2数据预处理的基本流程从对不同的源数据进行预处理的功能来分,数据预处理主要包括数据清理、数据集成、数据变换、数据归约等4个基本的功能。

在实际的数据预处理过程中,这4中功能不一定都用得到,而且他们的使用也没有先后顺序,某种预处理可能先后要多次进行。

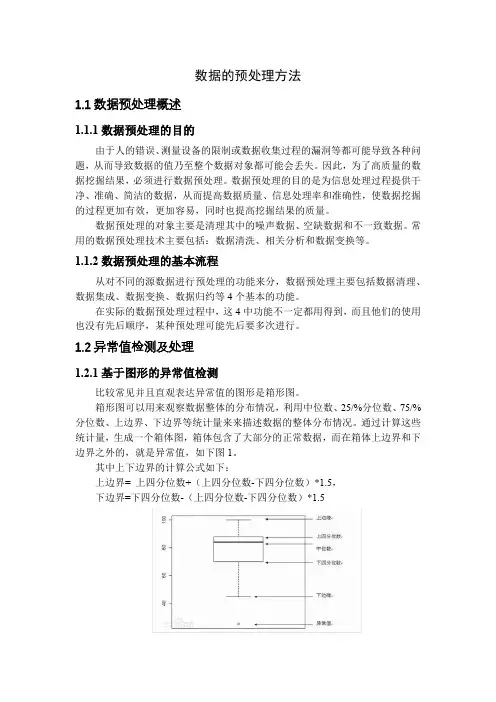

1.2异常值检测及处理1.2.1基于图形的异常值检测比较常见并且直观表达异常值的图形是箱形图。

箱形图可以用来观察数据整体的分布情况,利用中位数、25/%分位数、75/%分位数、上边界、下边界等统计量来来描述数据的整体分布情况。

通过计算这些统计量,生成一个箱体图,箱体包含了大部分的正常数据,而在箱体上边界和下边界之外的,就是异常值,如下图1。

其中上下边界的计算公式如下:上边界= 上四分位数+(上四分位数-下四分位数)*1.5,下边界=下四分位数-(上四分位数-下四分位数)*1.5图1 箱形图此外,也有有基于分布的方法。

在上、下α分位点之外的值认为是异常值(如图2)。

图2 正态分布图1.2.2基于业务经验的异常值检测除了通过图形采用直观方法检测异常值以外,有时还可以结合相关业务知识判断某个或某些值是否异常。

比如某些污染物检测值已经超过了仪器检测的上限,或者一些指标值已经超出了可能的范围。

对于这些异常情况,并不需要借助大量样本构造图形,而只需要单个的数据本身就可以判断其是否异常。

第三章数据预处理当今现实世界的数据库极易受噪声、缺失值和不一致数据的侵扰,因为数据库太大(常常多达数兆兆字节,甚至更多)。

“如何对数据进行预处理,提高数据质量,从而提高挖掘结果的质量?如何对数据预处理,使得挖掘过程更加有效、更加容易?”有大量数据预处理技术。

数据清理可以清除数据中的噪声,纠正不一致。

数据集成将数据由多个数据源合并成一致的数据存储,如数据仓库。

数据归约可以通过如聚集、删除冗余特征或聚类来降低数据的规模。

数据变换(例如,规范化)可以用来把数据压缩到较小的区间,如0.0到1.0。

这可以提高涉及距离度量的挖掘算法的精确率和效率。

这些技术不是相互排斥的,可以一起使用。

例如,数据清理可能涉及纠正错误数据的变换,如通过把一个数据字段的所有项都变换成公共格式进行数据清理。

1、数据预处理:概述1.1 数据质量:为什么要对数据预处理数据如果能满足其应用要求,那么它是高质量的。

数据质量涉及许多因素,包括准确性、完整性、一致性、时效性、可信性和可解释性。

不正确、不完整和不一致的数据是现实世界大型数据库和数据仓库的共同特点。

导致不正确的数据(即具有不正确的属性值)可能有多种原因:收集数据的设备可能出故障;人或计算机的错误可能在数据输入时出现;当用户不希望提交个人信息时,可能故意向强制输入字段输入不正确的值(例如,为生日选择默认值“1月1日”)。

这称为被掩盖的缺失数据。

错误也可能在数据传输中出现。

这可能是由于技术的限制。

不正确的数据也可能是由命名约定或所用的数据代码不一致,或输入字段(如日期)的格式不一致而导致。

不完整数据的出现可能有多种原因。

有些感兴趣的属性,如销售事务数据中顾客的信息,并非总是可以得到的。

其它数据没有包含在内,可能只是因为输入时认为是不重要的。

相关数据没有记录可能是由于理解错误,或者因为设备故障。

与其它记录不一致的数据可能已经被删除。

此外,历史或修改的数据可能被忽略。

缺失的数据,特别是某些属性上缺失值的元组,可能需要推导出来。

数据预处理是指在进行数据挖掘和分析之前,对原始数据进行清洗、转换和集成的过程。

数据预处理的目的是为了提高数据的质量,使得数据更加适合进行后续的分析和挖掘工作。

数据预处理包括多个步骤和方法,下文将对数据预处理的概念和预处理流程方法进行简要介绍。

一、数据预处理概念数据预处理是指对原始数据进行清洗、转换和集成的过程,其目的是为了提高数据质量,使得数据更适合进行后续的挖掘和分析工作。

原始数据往往存在各种问题,如缺失值、噪声、不一致性等,需要通过数据预处理来解决这些问题,从而得到高质量、可靠的数据。

数据预处理是数据挖掘中非常重要的一个环节,其质量直接影响到后续挖掘和分析的结果。

如果原始数据存在较多的问题,直接进行挖掘和分析往往会导致结果的不准确性和不稳定性。

数据预处理是数据挖掘工作中必不可少的一个环节。

二、数据预处理流程方法1. 数据清洗数据清洗是数据预处理的第一步,其目的是去除原始数据中的错误、噪声和不一致性。

数据清洗包括以下几个方面的工作:(1)处理缺失值:对缺失值进行填充或者删除,以保证数据的完整性和准确性。

(2)处理异常值:对超出合理范围的数值进行修正或删除,以消除数据的噪声和干扰。

(3)处理重复值:去除重复的数据,以防止数据重复统计和分析。

2. 数据转换数据转换是数据预处理的第二步,其目的是将原始数据转换为适合挖掘和分析的形式。

数据转换包括以下几个方面的工作:(1)数据平滑:对数据进行平滑处理,以减少数据的波动和不稳定性。

(2)数据聚集:将数据进行聚集操作,以便进行更高效的分析和挖掘。

3. 数据集成数据集成是数据预处理的第三步,其目的是将多个数据源的数据进行集成,形成一个整体的数据集。

数据集成包括以下几个方面的工作:(1)数据合并:将多个数据表中的数据进行合并,形成一个完整的数据集。

(2)数据匹配:对不同数据源的数据进行匹配,以解决数据一致性和完整性的问题。

4. 数据变换数据变换是数据预处理的最后一步,其目的是将经过清洗、转换和集成的数据进行变换,使得数据更适合进行后续的挖掘和分析工作。

数据预处理介绍

数据预处理是指在进行数据分析和建模之前,对原始数据进行初步的清洗、整理和转换,以便于后续工作的进行。

数据预处理的目的是减少数据分析和建模过程中的误差和偏差,提高数据分析和建模的准确性和可信度。

数据预处理包括以下主要步骤:

1. 数据清洗:删除重复数据、填补缺失值、处理异常值等,以确保数据的完整性和准确性。

2. 数据整合:将多个数据源的数据整合到一起,以便于后续的统一处理。

3. 数据变换:对数据进行变换,比如对数变换、指数变换等,以便于后续的分析和建模。

4. 数据归一化:对数据进行归一化处理,使得不同的数据之间具有可比性。

5. 特征选择:从原始数据中选择有意义的特征进行分析和建模。

6. 数据采样:从原始数据中采样一部分数据进行分析和建模。

数据预处理是数据分析和建模的重要环节,它不仅能提高数据分析和建模的准确性和可信度,还能节省时间和成本,提高工作效率。

- 1 -。

数据预处理是在进行数据分析或建立机器学习模型之前对原始数据进行清洗、转换和集成的一系列处理步骤。

它的目的是将原始数据转化为适合于后续分析和建模的形式,并处理数据中的异常、缺失或错误。

以下是数据预处理的主要内容:1. 数据清洗:- 处理缺失值:检测并处理数据中的缺失值,可以通过删除含有缺失值的样本、使用插补方法填充缺失值,或使用专门算法进行处理。

- 处理异常值:检测和处理数据中的异常值,可以通过统计方法或基于规则的方法进行检测,并根据具体情况采取合适的处理方式,如删除异常值或使用插补方法代替异常值。

- 处理噪声数据:通过平滑、滤波或采样等方法处理存在随机误差或噪声的数据。

2. 数据转换:- 特征选择:选择对于分析或建模任务最相关的特征,减少数据维度。

可以使用特征选择算法,如基于统计的方法、机器学习的方法等。

- 特征缩放:将不同尺度的特征缩放到相同的范围,以防止某些特征对模型影响过大。

常用的方法有标准化和归一化等。

- 特征编码:将非数值型数据(如分类变量)转换为数值型数据,以便模型处理。

常用的方法有独热编码、标签编码等。

3. 数据集成:- 整合多个数据源:将来自不同来源的数据整合到一个数据集中,保证数据的一致性和完整性。

- 解决数据冲突:处理来自不同数据源的数据冲突或不一致性问题,例如重复数据的处理和冲突解决。

4. 数据规范化:- 数据规范化:将数据转换为特定的范围或分布,以符合模型的输入要求。

例如,对数变换、正态化等。

5. 数据可视化:- 可视化数据:使用图表、图像等可视化工具对数据进行可视化,以便更好地理解数据特征、趋势和关系。

可视化有助于发现数据中的模式和异常。

数据预处理在数据分析和机器学习中起着重要的作用,能够提高模型的准确性和稳定性。

但是,具体的数据预处理步骤和方法取决于数据的特征和任务的要求,需要根据具体情况进行选择和调整。