第2章数据预处理资料

- 格式:ppt

- 大小:1.94 MB

- 文档页数:12

数据挖掘概念与技术_课后题答案数据挖掘⼀⼀概念概念与技术Data MiningConcepts andTechniques习题答案第1章引⾔1.1什么是数据挖掘?在你的回答中,针对以下问题:1.2 1.6定义下列数据挖掘功能:特征化、区分、关联和相关分析、预测聚类和演变分析。

使⽤你熟悉的现实⽣活的数据库,给岀每种数据挖掘功能的例⼦。

解答:特征化是⼀个⽬标类数据的⼀般特性或特性的汇总。

例如,学⽣的特征可被提岀,形成所有⼤学的计算机科学专业⼀年级学⽣的轮廓,这些特征包括作为⼀种⾼的年级平均成绩(GPA: Grade point aversge)的信息,还有所修的课程的最⼤数量。

区分是将⽬标类数据对象的⼀般特性与⼀个或多个对⽐类对象的⼀般特性进⾏⽐较。

例如,具有⾼GPA的学⽣的⼀般特性可被⽤来与具有低GPA的⼀般特性⽐较。

最终的描述可能是学⽣的⼀个⼀般可⽐较的轮廓,就像具有⾼GPA的学⽣的75%是四年级计算机科学专业的学⽣,⽽具有低GPA的学⽣的65%不是。

关联是指发现关联规则,这些规则表⽰⼀起频繁发⽣在给定数据集的特征值的条件。

例如,⼀个数据挖掘系统可能发现的关联规则为:major(X, Computi ng scie nee” S own s(X, personalcomputer ” [support=12%, confid en ce=98%]其中,X是⼀个表⽰学⽣的变量。

这个规则指出正在学习的学⽣,12% (⽀持度)主修计算机科学并且拥有⼀台个⼈计算机。

这个组⼀个学⽣拥有⼀台个⼈电脑的概率是98% (置信度,或确定度)。

分类与预测不同,因为前者的作⽤是构造⼀系列能描述和区分数据类型或概念的模型(或功能),⽽后者是建⽴⼀个模型去预测缺失的或⽆效的、并且通常是数字的数据值。

它们的相似性是他们都是预测的⼯具:分类被⽤作预测⽬标数据的类的标签,⽽预测典型的应⽤是预测缺失的数字型数据的值。

聚类分析的数据对象不考虑已知的类标号。

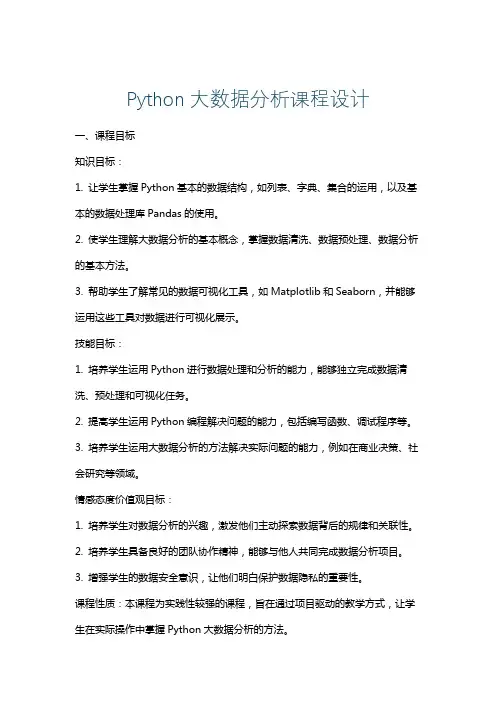

Python大数据分析课程设计一、课程目标知识目标:1. 让学生掌握Python基本的数据结构,如列表、字典、集合的运用,以及基本的数据处理库Pandas的使用。

2. 使学生理解大数据分析的基本概念,掌握数据清洗、数据预处理、数据分析的基本方法。

3. 帮助学生了解常见的数据可视化工具,如Matplotlib和Seaborn,并能够运用这些工具对数据进行可视化展示。

技能目标:1. 培养学生运用Python进行数据处理和分析的能力,能够独立完成数据清洗、预处理和可视化任务。

2. 提高学生运用Python编程解决问题的能力,包括编写函数、调试程序等。

3. 培养学生运用大数据分析的方法解决实际问题的能力,例如在商业决策、社会研究等领域。

情感态度价值观目标:1. 培养学生对数据分析的兴趣,激发他们主动探索数据背后的规律和关联性。

2. 培养学生具备良好的团队协作精神,能够与他人共同完成数据分析项目。

3. 增强学生的数据安全意识,让他们明白保护数据隐私的重要性。

课程性质:本课程为实践性较强的课程,旨在通过项目驱动的教学方式,让学生在实际操作中掌握Python大数据分析的方法。

学生特点:考虑到学生所在年级的知识深度,本课程将结合学生的认知水平和兴趣,采用由浅入深的教学策略。

教学要求:教师在教学过程中应注重理论与实践相结合,关注学生的学习进度,及时调整教学方法和节奏,确保学生能够达到课程目标。

同时,注重培养学生的主动学习能力,提高他们的创新思维和解决问题的能力。

通过课程学习,使学生能够将所学知识应用于实际项目,实现具体的学习成果。

二、教学内容1. Python基础数据结构:列表、字典、集合的创建与操作,重点讲解Pandas 库中的DataFrame和Series对象的使用。

教材章节:第1章 Python基础2. 数据导入与清洗:读取不同格式的数据文件,如CSV、Excel等,对数据进行缺失值处理、重复值处理和异常值检测。

《数据科学导论》复习资料本页仅作为文档封面,使用时可以删除This document is for reference only-rar21year.March《数据科学》课程期末复习资料《数据科学》课程讲稿章节目录:第一章导论第一节了解数据科学的基本概念第二节了解数据科学的应用第三节了解数据科学的过程第四节掌握数据科学的方法第二章数据获取及预处理第一节了解获取数据的途径和方法第二节掌握数据质量检验的方法第三节掌握数据清洗第四节掌握数据集成第五节掌握数据规约第六节掌握数据变换第三章数据分析第一节了解探索性数据分析的概念第二节掌握单变量分析方法第三节掌握多变量分析方法第四节掌握样本相似性与相异性分析的方法第四章特征工程第一节了解特征的介绍和创建过程第二节了解降维的基本概念第三节掌握主成分分析-PCA第四节掌握奇异值分解-SVD第五节了解特征选择的基本概念第六节掌握过滤式方法第七节了解产生特征子集的搜索策略第八节了解封装式方法第九节了解嵌入式方法第五章关联规则算法第一节了解关联规则的基本概念第二节掌握频繁项集的产生过程第三节掌握Apriori算法第六章分类算法第一节了解分类问题基本概念第二节掌握k近邻算法第三节了解贝叶斯定理第四节掌握朴素贝叶斯第五节了解决策树的基本概念第六节了解决策树-特征选择第七节了解决策树-剪枝算法第七章线性回归算法第一节了解线性回归的基本概念第二节掌握一元线性回归第三节掌握多元线性回归第八章人工神经网络第一节了解神经网络的基本概念第二节掌握感知机的学习算法第三节掌握多层感知机-反向传播算法第九章聚类算法第一节了解聚类问题的介绍第二节掌握层次聚类第三节掌握K-means聚类第四节了解BFR聚类一、客观部分:(单项选择、判断)(一)、选择部分1、通过构造新的指标-线损率,当超出线损率的正常范围,则可以判断这条线路的用户可能存在窃漏电等异常行为属于数据变换中的(C)A.简单函数变换B.规范化C.属性构造D.连续属性离散化★考核知识点: 数据变换参见讲稿章节:2-6附(考核知识点解释):数据变换是对数据进行规范化处理,将数据转换成“适当的”形式,更适用于任务及算法需要。

数据的预处理包括哪些内容数据的预处理是数据分析的第一步,它是指在进行数据分析之前对原始数据进行清洗、转换和集成等操作,以便为后续的分析建模工作提供高质量的数据。

数据的预处理内容非常丰富,主要包括数据清洗、数据转换、数据集成和数据规约等几个方面。

首先,数据清洗是数据预处理的重要环节。

在实际的数据分析工作中,原始数据往往存在着各种问题,比如缺失值、异常值、重复值和错误值等。

因此,数据清洗的主要目标是识别和处理这些问题,以确保数据的质量和完整性。

对于缺失值,可以采取删除、插补或者不处理等方式进行处理;对于异常值,可以采取删除、平滑或者替换等方式进行处理;对于重复值和错误值,可以直接删除或者进行修正处理。

其次,数据转换也是数据预处理的重要环节。

数据转换主要是指对原始数据进行变换,以便为后续的分析建模工作提供更加合适的数据形式。

常见的数据转换包括标准化、归一化、离散化和数据变换等。

标准化和归一化是将数据按比例缩放,以便使其落入特定的范围;离散化是将连续型数据转换为离散型数据;数据变换是对原始数据进行函数变换,以便使其满足分析建模的要求。

另外,数据集成也是数据预处理的重要环节。

数据集成是指将多个数据源的数据合并为一个一致的数据集的过程。

在实际的数据分析工作中,数据往往来自不同的数据源,因此需要进行数据集成以便为后续的分析建模工作提供统一的数据形式。

数据集成的主要工作包括数据清洗、数据转换和数据合并等。

最后,数据规约也是数据预处理的重要环节。

数据规约是指通过选择、投影、聚集和归约等方式对原始数据进行简化,以便为后续的分析建模工作提供更加高效的数据形式。

常见的数据规约包括属性选择、数据投影、数据聚集和数据归约等。

综上所述,数据的预处理包括数据清洗、数据转换、数据集成和数据规约等几个方面。

通过对原始数据进行清洗、转换和集成等操作,可以为后续的分析建模工作提供高质量的数据,从而提高数据分析的准确性和有效性。

因此,数据的预处理是数据分析工作中不可或缺的重要环节。

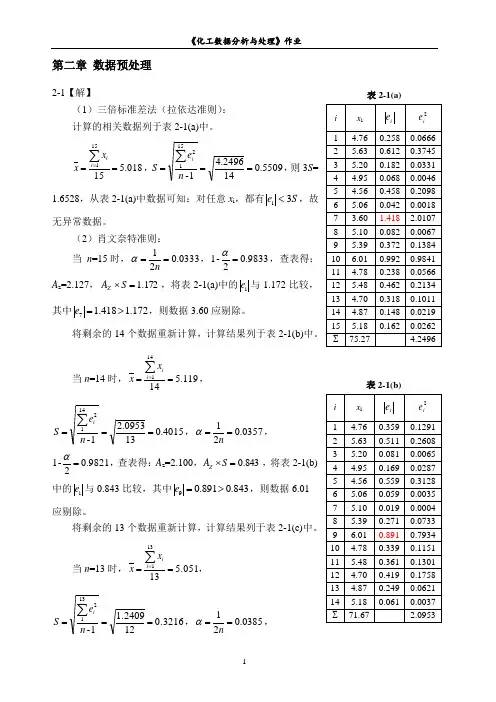

第二章 数据预处理2-1【解】(1)三倍标准差法(拉依达准则): 计算的相关数据列于表2-1(a)中。

018.515151==∑=i i x x ,5509.0142496.41-1512===∑n e S i ,则3S = 1.6528,从表2-1(a)中数据可知:对任意x i ,都有S e 3i <,故无异常数据。

(2)肖文奈特准则:当 n =15时,0333.021==n α,9833.02-1=α,查表得:A z =2.127,172.1=⨯S A Z ,将表2-1(a)中的i e 与1.172比较,其中172.1418.17>=e ,则数据3.60应剔除。

将剩余的14个数据重新计算,计算结果列于表2-1(b)中。

当n =14时,119.514141==∑=i ixx ,0154.0130953.21-1412===∑n eS i,0357.021==n α,9821.02-1=α,查表得:A z =2.100,843.0=⨯S A Z ,将表2-1(b)中的i e 与0.843比较,其中843.0891.09>=e ,则数据6.01应剔除。

将剩余的13个数据重新计算,计算结果列于表2-1(c)中。

当n =13时, 5.05131311==∑=i ix x ,0.3216211.24091-3112===∑n e S i ,8503.021==nα,表2-1(a)表2-1(b)0898.02-1=α,查表得:A z =2.070,666.0=⨯S A Z ,将表2-1(c)中的i e 与0.666比较,对任意x i ,都有S A e ⨯<z i ,则剩余的13个数据都符合本方法的要求,属于正常数据。

综上,3.60和6.01为异常数据。

(3)格拉布斯准则:将测量数据按由小到大的顺序排列,并算出g i 列于表2-1(d)中。

其中018.5=x ,5509.0=S ,Se g i i =。

统计学(第五版)贾俊平课后习题答案(完整版)第一章思考题1.1什么是统计学统计学是关于数据的一门学科,它收集,处理,分析,解释来自各个领域的数据并从中得出结论。

1.2解释描述统计和推断统计描述统计;它研究的是数据收集,处理,汇总,图表描述,概括与分析等统计方法。

推断统计;它是研究如何利用样本数据来推断总体特征的统计方法。

1.3统计学的类型和不同类型的特点统计数据;按所采用的计量尺度不同分;(定性数据)分类数据:只能归于某一类别的非数字型数据,它是对事物进行分类的结果,数据表现为类别,用文字来表述;(定性数据)顺序数据:只能归于某一有序类别的非数字型数据。

它也是有类别的,但这些类别是有序的。

(定量数据)数值型数据:按数字尺度测量的观察值,其结果表现为具体的数值。

统计数据;按统计数据都收集方法分;观测数据:是通过调查或观测而收集到的数据,这类数据是在没有对事物人为控制的条件下得到的。

实验数据:在实验中控制实验对象而收集到的数据。

统计数据;按被描述的现象与实践的关系分;截面数据:在相同或相似的时间点收集到的数据,也叫静态数据。

时间序列数据:按时间顺序收集到的,用于描述现象随时间变化的情况,也叫动态数据。

1.4解释分类数据,顺序数据和数值型数据答案同1.31.5举例说明总体,样本,参数,统计量,变量这几个概念对一千灯泡进行寿命测试,那么这千个灯泡就是总体,从中抽取一百个进行检测,这一百个灯泡的集合就是样本,这一千个灯泡的寿命的平均值和标准差还有合格率等描述特征的数值就是参数,这一百个灯泡的寿命的平均值和标准差还有合格率等描述特征的数值就是统计量,变量就是说明现象某种特征的概念,比如说灯泡的寿命。

1.6变量的分类变量可以分为分类变量,顺序变量,数值型变量。

变量也可以分为随机变量和非随机变量。

经验变量和理论变量。

1.7举例说明离散型变量和连续性变量离散型变量,只能取有限个值,取值以整数位断开,比如“企业数”连续型变量,取之连续不断,不能一一列举,比如“温度”。

应用时间序列分析实验报告实验名称第二章时间序列的预处理一、上机练习2.4.1绘制时序图data example2_1;input price1 price2;time=intnx('month','01jul2004'd,_n_-1);format time date.;cards;12.85 15.2113.29 14.2312.41 14.6915.21 13.2714.23 16.7513.56 15.33;proc gplot data=example2_1;plot price1*time=1 price2*time=2/overlay;symbol1c=black v=star i=join;symbol2c=red v=circle i=spline;run;语句说明:(1)“proc gplot data=example2_1;”是告诉系统,下面准备对临时数据集example2_1中的数据绘图。

(2)“plot price1*time=1 price2*time=2/overlay;”是要求系统要绘制两条时序曲线。

(3)“symbol1c=black v=star i=join;”,symbol语句是专门指令绘制的格式。

输出的时序图见下图:两时间序列重叠显示时序图2.4.2 平稳性与纯随机性检验1、平稳性检验为了判断序列是否平稳,除了需要考虑时序图的性质,还需要对自相关图进行检验。

SAS系统ARIMA过程中的IDENTIFY语句可以提供非常醒目的自相关图。

data example2_2;input freq@@;year=intnx ('year','1jan1970'd,_n_-1);format year year4.;cards;97 154 137.7 149 164 157 188 204 179 210 202 218 209204 211 206 214 217 210 217 219 211 233 316 221 239215 228 219 239 224 234 227 298 332 245 357 301 389;proc arima data=example2_2;identify var=freq;run;语句说明:(1)“proc arima data=example2_2;”是告诉系统,下面要对临时数据集example2_2中的数据进行ARIMA程序分析。

化工数据分析与处理(课后作业)第一章 误差原理与概率分布1、某催化剂车间用一台包装机包装硅铝小球催化剂,额定标准为每包净重25公斤,设根据长期积累的统计资料,知道包装机称得的包重服从正态分布,又其标准差为σ=0.75公斤,某次开工后,为检验包装机的工作是否正常,随机抽取9包催化剂复核其净重分别为:试问包装机目前的工作状况如何? 解:先做原假设 假设H 0:μ=μ0构造统计量:Z =nx /σμ--~N(0,1)-x =∑x i /n=25.45σ=0.75μ=μ0=25 得:Z =1.8查表得:Φ ( 1.8 ) = 0.9641给出适当的α ,取α=0.05,1- α = 0.95 < 0.9641 落在大概率解范围内接受H 0则 μ=μ0 ,即包装机目前工作正常。

气总平均值的0.95置信区间。

解:因为P =1-α=0.95 所以α=1-0.95=0.05σ不知,所以只能用t 分布 即用S 代替σ S 2=1)(--∑-n x x i =0.048515789 S=0.220263-x =3.21令T =nS x /μ--~t(n-1,2α)则有:P(-At <T <At)=1-α=1-0.05n-1=20-1=192α=0.025 查表得:At (19,0.025)=2.0930估计区间为:P(-x -At(n-1, 2α)*n S <μ<-x +At(n-1, 2α)*nS =0.95所以:3.21-2.0930*200.220263<μ<3.21+2.0930*200.220263即:3.21-0.100425<μ<3.21+0.100425所以:3.109575<μ<3.3104253、某厂化验室用A,B 两种方法测定该厂冷却水中的含氯量(ppm ),每天取样一次,下面是试问:这两种方法测量的结果有无显著的差异?一般可取显著水平α=0.01. 解:因为是用两种方法来测同一个溶液,故把所测氯含量为母体。

《大数据导论》课程期末复习资料《大数据导论》课程讲稿章节目录:第1章大数据概述(1)大数据的概念(2)大数据的特征(3)大数据的数据类型(4)大数据的技术(5)大数据的应用第2章大数据采集与预处理(1)大数据采集(2)大数据预处理概述(3)数据清洗(4)数据集成(5)数据变换(6)数据规约第3章大数据存储(1)大数据存储概述(2)数据存储介质(3)存储系统结构(4)云存储概述(5)云存储技术(6)新型数据存储系统(7)数据仓库第4章大数据计算平台(1)云计算概述(2)云计算平台(3)MapReduce平台(4)Hadoop平台(5)Spark平台第5章大数据分析与挖掘(1)大数据分析概述(2)大数据分析的类型及架构(3)大数据挖掘(4)大数据关联分析(5)大数据分类(6)大数据聚类(7)大数据分析工具第6章大数据可视化(1)大数据可视化概述(2)大数据可视化方法(3)大数据可视化工具第7章社交大数据(1)社交大数据(2)国内社交网络大数据的应用(3)国外社交网络大数据的应用第8章交通大数据(1)交通大数据概述(2)交通监测应用(3)预测人类移动行为应用第9章医疗大数据(1)医疗大数据简介(2)临床决策分析应用(3)医疗数据系统分析第10章大数据的挑战与发展趋势(1)大数据发展面临的挑战(2)大数据的发展趋势一、客观部分:(单项选择、多项选择)(一)、单项选择1.以下不是NoSQL数据库的是()A.MongoDBB。

HBaseC.CassandraD。

DB2★考核知识点:NoSQL与NewSQL主流系统参考讲稿章节:3.7附1.1。

1(考核知识点解释):目前市场上主要的NoSQL数据存储工具有:BigTable、Dynamo 、Hbase、MongoDB、CouchDB、Hypertable还存在一些其他的开源的NoSQL数据库,Neo4j、Oracle Berkeley DB、Apache Cassandra等另外,NewSQL数据库。

数据预处理总结

一、数据清洗

数据清洗是数据预处理的重要步骤,其主要目的是去除数据中的噪声、无关信息以及错误数据,以确保数据的质量和准确性。

数据清洗的过程包括:数据去重、数据格式转换、缺失值处理、异常值检测等。

二、特征选择

特征选择是从原始特征中选取出与目标变量最相关的特征,以降低数据的维度和提高模型的性能。

特征选择的方法包括:过滤法、包装法、嵌入式法等。

三、缺失值处理

缺失值处理是数据预处理的常见问题,对于缺失的数据,可以采用填充缺失值的方法,如使用均值、中位数、众数等填充,或者使用插值、回归等方法预测填充。

四、异常值检测

异常值是指与大多数数据明显不同的数据点,它们可能会对模型的性能产生负面影响。

异常值检测的方法包括:基于统计的方法、基于距离的方法、基于密度的方等。

五、特征缩放

特征缩放是指将特征的取值范围调整到一个共同的范围内,如[0,1]或[-1,1]。

特征缩放的方法包括:最小-最大缩放、Z-score标准化、对数变换等。

六、数据规范化

数据规范化的目的是将数据的取值范围限制在一个小的区间内,以提高模型的收敛速度和稳定性。

数据规范化的方法包括:Min-Max规范化、小数定标规范化等。

七、编码转换

编码转换是指将分类变量转换为机器学习算法可以处理的格式。

常见的编码转换方法包括:独热编码、标签编码等。