最速下降法简介

- 格式:pptx

- 大小:455.60 KB

- 文档页数:15

最速下降法姓名:沈东东 班级:研1404 学号:1415033005一、最速下降法的原理目标函数:(1)n f R R n →>在决策变量的当前点()k n x R ∈处的一阶Taylor 展开式为()()()()()()()k k k T f x f x g x δδοδ+=++式中,()()k n g x R ∈为f 在点()k x 处的梯度向量。

当扰动量n R δ∈充分小时,有()()()()()()k k k T f x f x g x δδ+≈+设新的迭代点为(1)()k k x x δ+=+,于是得到(1)()()()()()k k k T f x f x g x δ+-≈为了使(1)k x +处的目标函数值比()k x 处有所下降,需要满足()()0k T g x δ<此外,梯度向量()()k g x 和扰动量δ的内积可以表示为()()()()cos k T k g x g x δδθ=式中,θ为两向量之间的夹角。

若要使目标函数值的下降量尽可能大,可知δ的方向应该为梯度方向的负方向,即cos 1θ=-。

函数f 在点()k x 处的负梯度方向称为该点的最速下降方向。

在每次迭代时都取最速下降方向作为搜索方向的方法就称为最速下降法。

二、最速下降法的特点1.若()k x 不是极小点,则f 在点()k x 处的最速下降方向总是下降方向。

2.如果每次迭代时都用精确搜索方法得到最佳步长作为搜索步长,则寻优过程中相邻的最速下降方向是正交的。

3最速下降法产生的迭代点序列在一定条件下是线性收敛的,其收敛性质与极小点*x 处的Hesse 矩阵有关。

三、最速下降法的计算步骤最速下降法的计算步骤如下:步骤1:已知待求问题的目标函数()f x ,选择初始点(0)x ,并设定精度要求tol ,令:0k =。

步骤2:计算()f x 在点()k x 处的梯度向量()()k g x ,得到最速下降方向()()()k k d g x =-。

最速下降法(Steepest Descent Method)是一种数值优化算法,用于求解无约束优化问题的最小值。

下面是最速下降法的一般解题步骤:

1.定义目标函数:首先,需要明确要优化的目标函数。

这个函数通常表示为f(x),其中

x 是优化变量。

2.初始化起始点:选择一个合适的起始点x0,作为最速下降法的初始点。

3.计算梯度:计算目标函数在当前点的梯度,即∇f(x)。

这可以通过对目标函数进行偏

导数计算得到。

4.确定搜索方向:将梯度反向取负作为搜索方向d,即d = -∇f(x)。

5.确定步长:确定沿着搜索方向移动的步长,也称为学习率或步长因子。

常见的选择

方法有固定步长、线性搜索和精确线搜索等。

6.更新当前点:根据步长和搜索方向,更新当前点x,即x = x + αd,其中α 表示步

长。

7.判断终止条件:判断是否满足终止条件,可以是达到预定的迭代次数、目标函数值

变化很小或梯度变化很小等。

8.若不满足终止条件,则返回第3步,重新计算梯度,并重复3-7步骤,直到满足终

止条件。

最速下降法的关键在于选择合适的步长和搜索方向。

步长过大可能导致无法收敛,步长过小可能导致收敛速度慢。

搜索方向的选择应该保证在当前点能够使目标函数值下降最快。

需要注意的是,最速下降法可能会陷入局部最小值,而无法达到全局最小值。

为了克服这个问题,可以考虑使用其他优化算法,如共轭梯度法、牛顿法等。

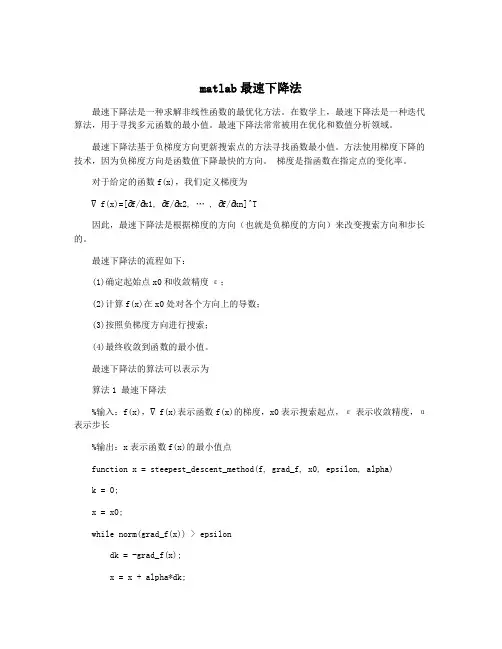

matlab最速下降法最速下降法是一种求解非线性函数的最优化方法。

在数学上,最速下降法是一种迭代算法,用于寻找多元函数的最小值。

最速下降法常常被用在优化和数值分析领域。

最速下降法基于负梯度方向更新搜索点的方法寻找函数最小值。

方法使用梯度下降的技术,因为负梯度方向是函数值下降最快的方向。

梯度是指函数在指定点的变化率。

对于给定的函数f(x),我们定义梯度为∇f(x)=[∂f/∂x1, ∂f/∂x2, … , ∂f/∂xn]^T因此,最速下降法是根据梯度的方向(也就是负梯度的方向)来改变搜索方向和步长的。

最速下降法的流程如下:(1)确定起始点x0和收敛精度ε;(2)计算f(x)在x0处对各个方向上的导数;(3)按照负梯度方向进行搜索;(4)最终收敛到函数的最小值。

最速下降法的算法可以表示为算法1 最速下降法%输入:f(x),∇f(x)表示函数f(x)的梯度,x0表示搜索起点,ε表示收敛精度,α表示步长%输出:x表示函数f(x)的最小值点function x = steepest_descent_method(f, grad_f, x0, epsilon, alpha)k = 0;x = x0;while norm(grad_f(x)) > epsilondk = -grad_f(x);x = x + alpha*dk;k = k + 1;endend其中,norm是向量的范数,grad_f表示函数f的梯度,alpha是步长因子,可以通过试验或线搜索确定。

在上述算法中,基于梯度的每一步都保证了函数值下降。

算法的停止条件通常是达到预定的精度或规定的最大迭代次数。

最速下降法的优缺点优点:(1)相对简单,易于理解和实现;(2)算法的执行速度相对较快。

(1)可能会在迭代过程中陷入局部最小值;(2)需要对步长因子α进行调整;(3)在非线性函数的优化中,最速下降法可能需要许多迭代才能收敛,导致计算量大。

最速下降法是一种通用的非线性优化算法,广泛应用于各种数学和工程问题中。

机器学习算法系列最速下降法牛顿法拟牛顿法最速下降法、牛顿法和拟牛顿法都是常用的机器学习优化算法。

它们在求解函数最小化问题中起到关键作用。

1. 最速下降法(Gradient Descent):最速下降法是一种基于函数梯度的迭代优化算法。

其核心思想是沿着负梯度方向以步长α更新参数,直到达到收敛条件。

最速下降法的步骤如下:1)选择初始参数值;2)计算目标函数的梯度;3)沿着负梯度方向更新参数;4)重复步骤2和步骤3,直到达到停止条件。

最速下降法的优点是简单易实现,但它可能会面临局部最小值的问题,收敛速度较慢。

2. 牛顿法(Newton's Method):牛顿法是一种二阶优化算法,利用目标函数的一阶和二阶导数信息来更新参数。

它通过二阶导数矩阵(即Hessian矩阵)来指导方向和步长的选择。

牛顿法的步骤如下:1)选择初始参数值;2)计算目标函数的一阶和二阶导数;3)解线性方程(Hessian矩阵和梯度的乘积);4)更新参数;5)重复步骤2-步骤4,直到达到停止条件。

牛顿法的优点是收敛速度快,但它需要计算二阶导数矩阵,计算量较大,且可能收敛到非全局最小值。

3. 拟牛顿法(Quasi-Newton Methods):拟牛顿法是一种基于牛顿法思想的近似优化算法。

与牛顿法不同,拟牛顿法通过正定矩阵来近似二阶导数矩阵,从而避免了计算复杂的二阶导数矩阵。

拟牛顿法最经典的算法是BFGS算法(Broyden-Fletcher-Goldfarb-Shanno),它通过近似更新逆Hessian矩阵的方式来求解优化问题。

拟牛顿法的步骤如下:1)选择初始参数值和初始逆Hessian矩阵的估计;2)计算目标函数的梯度;3)更新参数;4)更新逆Hessian矩阵的估计;5)重复步骤2-步骤4,直到达到停止条件。

拟牛顿法的优点是避免了计算二阶导数矩阵,计算复杂度相对较低,且具有较好的收敛性质。

总结来说,最速下降法适用于简单的优化问题,牛顿法适用于二次型问题,而拟牛顿法在保持收敛速度的同时减少了计算复杂度。

matlab 最速下降法MATLAB 最速下降法最速下降法是一种求解无约束优化问题的基本方法,也是一种迭代算法。

该方法的基本思想是:在当前点处,沿着当前点到最优解的方向,走一步能够使目标函数值下降最快的方向,即负梯度方向。

因此,最速下降法也被称为梯度下降法。

MATLAB 是一种强大的数学计算软件,可以用于求解各种数学问题,包括最速下降法。

在 MATLAB 中,可以使用 fminunc 函数来实现最速下降法。

该函数的基本语法如下:[x,fval,exitflag,output] = fminunc(fun,x0,options)其中,fun 是目标函数,x0 是初始点,options 是选项参数。

该函数的返回值包括最优解 x、目标函数值 fval、退出标志 exitflag 和输出信息 output。

下面是一个使用 fminunc 函数求解 Rosenbrock 函数的例子:fun = @(x) 100*(x(2)-x(1)^2)^2 + (1-x(1))^2;x0 = [-1.2,1];options =optimoptions('fminunc','Display','iter','Algorithm','quasi-newton');[x,fval,exitflag,output] = fminunc(fun,x0,options);在上面的例子中,Rosenbrock 函数是一个经典的无约束优化问题,其目标函数为:f(x) = 100*(x2-x12)2 + (1-x1)2该函数的最优解为 (1,1),最小值为 0。

使用 fminunc 函数求解该问题,可以得到最优解 x = (1,1),最小值 fval = 2.9387e-11。

需要注意的是,最速下降法是一种基本的优化方法,但其收敛速度较慢,容易陷入局部最优解。

数学软件与实验结课作业------最速下降法班级:071111学号:07111008 07111012 07111057姓名:李咏邹仁朋宋郝开摘要最速下降法又称梯度法,早先求解无约束多元函数极值的数值方法,是1847年由著名数学家Cauchy给出的,它是解析法中最古老的一种,是最优化方法的基础。

它工作量较少,且储存变量不多,初始点要求也不高,但效率不高。

最速下降法多用来解觉n元函数的无约束非线性规划问题。

利用负梯度方向来决定每次迭代的新的搜索方向,使得每次迭代能使待优化的目标函数逐步减小,从而最终找到最优解。

最速下降法的基本思想是:从当前点x k出发,取函数f(x)在点x k 处下降最快的方向作为我们的搜索方向p k,由f(x)的Taylor 展式知(x k) - f (x k +t p k) = -tÑf (x k)T p k+ o‖( t p k‖),略去t的高阶无穷小项不计,可见取p k= -Ñf (x k)时,函数值下降得最多。

从而,构造出最速下降法的迭代步骤求解。

最速下降法的一种简单形式是:x(k+1)=x(k)-a*g(k),其中a称为学习速率,可以是较小的常数。

g(k)是x(k)的梯度。

一、问题描述求解最优化问题是通常采用两种方法:1.解析解法——利用函数的导数构造迭代公式使之收敛到极值点的方法;2.直接解法——根据数学原理,用尽可能少的计算量直接比较函数值的大小,来确定函数极值的方法。

在最优化计算方法中,要求解12(,,,)n y f x x x = 的局部最小值,选用解析解法,采用如下的方法进行迭代计算:先给出初始点000012(,,,)n x x x =x ,然后根据其梯 度方向0()f ∇x ,计算一元函数0010()min (())y f f λλλ≥=-⋅∇x x ,并得到1001()f λ=-⋅∇x x x 。

如此反复迭代,最终收敛于局部最优点。

实现该算法。

最优化Armijo算法确定步长的最速下降法资料最速下降法是最优化算法中最简单、最基础的一种方法,但其收敛速度较慢且容易陷入局部最优解。

因此,在最速下降法的基础上,可以通过引入步长的方法来提高算法的收敛速度。

而Armijo算法就是一种常见的用于确定步长的方法。

最速下降法基础假设我们要最小化目标函数f(x),那么最速下降法的思路就是从一个初始点x0开始,不断朝着负梯度方向进行迭代,直到找到最优解x∗,即:$x_{k+1} = x_k - \\alpha_k \ abla f(x_k)$其中,ablaf(x k)是f(x)在x k处的梯度,$\\alpha_k$ 是步长(也称为学习率),表示每次迭代的步长大小。

但这里还有一个问题:如何确定每次迭代的步长呢?Armijo算法Armijo算法是一种基于梯度下降法的步长确定方法。

它的思路是,每次迭代的步长不应该过大,否则容易导致超出收敛区域。

同时,步长也不应该过小,否则收敛速度会变得非常缓慢。

因此,步长的大小应该恰到好处,即在一定范围内找到一个最优的步长大小。

具体地,Armijo算法通过二分搜索的方法,在可行步长范围内找到一个最优的步长 $\\alpha_k$。

具体过程如下:1.首先初始化 $\\alpha_0$,并设定一些参数,如尝试步长大小t、可行步长下界 $\\tau$ 和函数下降的最小比例 $\\gamma$。

2.计算目标函数f(x k−t ablaf(x k)),以及根据一定准则确定下一个$\\alpha$。

3.如果 $f(x_k - \\alpha_k\ abla f(x_k))$ 函数值比f(x k)减小了一些比例$\\gamma$,则认为当前 $\\alpha_k$ 是可行的步长。

4.如果当前 $\\alpha_k$ 不是可行的步长,则将其折半,即 $\\alpha_k\\leftarrow \\alpha_k/2$,直到找到一个可行的步长为止。

最速下降法原理及其算法实现最速下降法(Gradient Descent)是一种常用的优化算法,用于寻找函数的最小值。

它是一种迭代的方法,每次迭代都沿着负梯度方向更新参数,以减小目标函数的值。

在本文中,我们将介绍最速下降法的原理和算法实现。

1.最速下降法原理假设有一个目标函数f(x),其中x是一个向量。

我们的目标是找到使得f(x)最小的x。

最速下降法的思想是从任意初始点x0开始迭代,按照梯度方向更新参数,直到达到最优解。

具体地,设f(x)的梯度为g(x),即g(x)=∇f(x)。

最速下降法的迭代公式为:x(n+1)=x(n)-α*g(x(n))其中,x(n)表示第n次迭代的参数向量,α是迭代步长,也称为学习率。

每次迭代时,我们沿着梯度方向更新参数,α控制更新的步长。

我们期望通过不断迭代,逐渐逼近最优解。

2.最速下降法算法实现步骤1:初始化参数。

选择初始点x(0),设定学习率α,设定最大迭代次数。

步骤2:迭代过程。

重复以下步骤,直到达到最大迭代次数或满足收敛条件:a)计算梯度g(x(n))=∇f(x(n))。

b)更新参数。

根据迭代公式进行更新,x(n+1)=x(n)-α*g(x(n))。

c)判断终止条件。

比较f(x(n+1))和f(x(n))的差异,如果差异小于一定阈值,停止迭代。

步骤3:输出结果。

输出最优参数x*,即使得f(x)最小的参数。

需要注意的是,在实际应用中,我们可能需要进行一些改进来提高最速下降法的性能。

例如,可以使用线来自适应地选择学习率以保证每次更新获得合理的进展。

此外,为了加快收敛速度,可以使用加速算法,如动量法、Nesterov 加速梯度法等。

3.总结。

最速下降法步长公式最速下降法是一种优化算法,在数学和计算机科学等领域有着广泛的应用。

而其中的步长公式则是决定算法效率和准确性的关键因素之一。

先来说说什么是最速下降法。

想象一下你在一个山坡上,想要尽快到达山底,但是周围雾气弥漫,你看不到太远的地方,只能感受到当前位置的坡度。

最速下降法就是根据这个局部的坡度信息,一步一步地往山下走。

而步长呢,就相当于你每一步迈出去的大小。

在数学表达式中,最速下降法的迭代公式是这样的:$x_{k + 1} = x_k - \alpha_k \nabla f(x_k)$,这里的$\alpha_k$就是步长。

步长要是选得太大,可能一步就迈过了最低点,然后又得往回走;步长要是选得太小,那下山的速度就会特别慢,浪费好多时间和精力。

给大家举个我曾经在教学中的例子吧。

有一次,我给学生们布置了一个用最速下降法求解函数最小值的作业。

有个学生特别积极,上来就选了一个特别大的步长,结果呢,函数值不但没下降,反而跳来跳去,就像一只没头的苍蝇到处乱撞。

我就问他:“你这步子迈这么大,不怕一脚踩空吗?”他挠挠头,不好意思地笑了。

后来,经过仔细的分析和调整,他终于找到了合适的步长,顺利地求出了最小值。

再来说说步长公式的常见形式。

一种常见的步长公式是通过线搜索来确定的,也就是沿着下降方向不断尝试不同的步长,直到找到使得函数值下降最多的那个步长。

这就有点像你在黑暗中摸索着找路,不断试探着往前迈一小步,看看是不是走对了方向。

还有一种比较简单的方法是固定步长法,就是事先给定一个固定的步长值。

但这种方法往往效果不太好,因为很难提前知道一个适用于所有情况的固定步长。

在实际应用中,选择合适的步长公式可不是一件容易的事儿。

这得考虑到函数的性质、计算的效率,还有精度的要求等好多因素。

比如说,如果函数的曲率变化比较大,那可能就需要更灵活的步长选择策略;如果对计算速度要求很高,可能就得在精度上做一些妥协,选择相对简单但快速的步长公式。

最速梯度下降法梯度下降法作为一种优化算法,可以用于解决众多的机器学习问题。

在梯度下降法的基础上,最速梯度下降法进一步优化了求解速度,同时也增强了算法的收敛性。

本文就对最速梯度下降法做一些详细介绍和分析。

最速梯度下降法的简介最速梯度下降法(Steepest Descent)是一种梯度下降优化算法,也是最早被提出的一种梯度下降法,旨在最小化一个连续可导的目标函数。

该算法通过沿负梯度方向迭代的方式优化模型,支持凸函数和非凸函数的优化,是一种常用的凸性和非凸性优化方法。

它在支持芯片设计、信号处理、图像处理和机器学习等任务中都有广泛应用。

最速梯度下降法的原理最速梯度下降法的原理是以梯度下降法为基础的,通过选择目标函数每一步的最优步长进行更新,从而加速了收敛,因此被称为最速算法。

梯度下降法是通过计算目标函数的梯度,沿着梯度方向不断移动,从而实现最小化目标函数的优化过程。

因此,最速梯度下降法也依赖于目标函数的梯度,每一步的向量更新可通过以下公式来计算:x^{(k+1)}=x^{(k)}-\alpha_k\bigtriangledownf(x^{(k)})其中, x^{(k)} 代表第 k 步迭代时的位置,\bigtriangledown f(x^{(k)}) 代表在 x^{(k)} 处的梯度,α_{k} 代表步长。

在这个迭代过程中,如果选择合适的步长,就可以实现最速收敛。

最速梯度下降法针对性地选择每一步的最优步长,因此提高了收敛速度和稳定性。

损失函数在某些情况下也会很坚固,因此,当损失函数是凸函数的时候,最速梯度下降法总是能够找到全局最优解。

最速梯度下降法的优缺点最速梯度下降法的优点主要有以下几点:1. 实现简单:由于是在梯度下降法的基础上进行优化,因此非常容易理解和实现。

2. 收敛速度快: 由于算法能够准确地选择每一步的最优步长,因此收敛速度更快。

3. 对于许多不平滑和非凸函数的优化都很有效。

但是,最速梯度下降法也有其缺点:1. 选取步长困难: 最速梯度下降法每一次都要找到最优的步长,但是这个步长很难求出。

最速下降法(sd);共轭梯度法

最速下降法(SD)和共轭梯度法(CG)都是求解非线性优化问题中的常用算法。

最速下降法是基于梯度方向的一种搜索方法,在每一步所需找到函数在当前点的最陡方向,并沿着该方向走一步,直到达到要求的精度为止。

该方法速度快,收敛性好,但容易陷入“zigzag”现象,即由于步长过大或过小,导致序列在搜索方向上反复飞奔而收敛缓慢,同时,最速下降法对函数“弯曲性”敏感,函数梯度变化太快时收敛缓慢。

共轭梯度法是一种基于梯度方向的线性搜索方法,其优势在于快速收敛,准确性高。

其核心思想是,由于函数在一般性条件下不是QUADRATIC FUNCTION,因此,图像往往不是一个明显的"碗状",而是一个复杂的非线性图形。

在这种情况下,最速下降法很容易落入“zigzag”现象,收敛速度慢。

而共轭梯度法可以从不同方向进行极小值点的搜索,进而明显提高收敛速度。

总之,最速下降法适用于方向比较简单的情况,而共轭梯度法适用于方向较为复杂的情况。

根据不同的情况进行选择,可以有效地提高求解的效率和精度。

最速下降法收敛阶

最速下降法是一种经典的优化算法,它可以在短时间内找到函数的最佳解。

但是,最速下降法的求解效率与收敛速度也成为该算法应用的瓶颈之一,因此提高最速下降法的收敛阶对于优化算法的发展也是至关重要的。

下面将介绍最速下降法的收敛阶。

1. 最速下降法简介

最速下降法是一种基于负梯度方向的优化算法。

它的基本思想是沿着函数的梯度方向,不断地迭代寻找函数的最小值。

最速下降法在求解非线性方程和非线性规划问题中应用非常广泛。

2. 最速下降法的收敛阶

最速下降法的收敛阶决定了该算法求解的速度和效率。

当最速下降法的迭代次数 n 趋近于无穷大时,其收敛误差的下限为 O(1/n) 或O(1/n^2),称为一阶或二阶收敛。

具体来说,当最速下降法的收敛阶为一阶时,其收敛速度较慢,迭代次数需要很大才能达到期望的精度。

而当最速下降法的收敛阶为二阶时,其收敛速度较快,收敛精度达到期望的精度所需要的迭代次数会大大减少。

3. 最速下降法收敛阶的提高

为了提高最速下降法的收敛阶,有些学者提出了一些改进方法,例如共轭梯度法、Broyden-Fletcher-Goldfarb-Shanno (BFGS) 算法等。

通过这些改进方法,可以在保证算法求解精度的前提下,加速最速下降法的求解速度。

4. 结语

最速下降法作为一种基础的优化算法,其收敛阶的提高是优化算法发展的一个重要方向。

通过改进算法的迭代方式和步长来提高算法的收敛性能,可以更快地求解非线性方程和非线性规划问题。