[数据分析] 推荐 :用Python实现神经网络(附完整代码)!

- 格式:docx

- 大小:270.16 KB

- 文档页数:11

Python中的神经网络实现基本的前馈神经网络神经网络是一种模拟人类大脑神经网络结构和功能的计算模型。

在人工智能和机器学习领域,神经网络被广泛应用于图像处理、自然语言处理、语音识别等任务。

Python是一门简单易用的编程语言,在神经网络的实现中也得到了广泛的应用。

本文将介绍如何使用Python实现基本的前馈神经网络。

一、前馈神经网络的基本原理前馈神经网络是神经网络中最简单的一种结构。

它由输入层、隐藏层和输出层组成,信息只能从输入层向输出层单向传播,不存在反馈。

每个神经元接收上一层所有神经元传递过来的信号,并对输入信号进行加权求和,然后使用激活函数进行非线性变换,最后将结果传递到下一层。

具体的神经网络结构和参数配置可以根据实际任务进行调整。

二、Python中的神经网络库在Python中,有很多成熟的神经网络库可以供我们使用。

其中最常用的包括TensorFlow、PyTorch和Keras。

这些库提供了丰富的功能和易于使用的API,可以大大简化神经网络的搭建和训练过程。

三、使用Keras库构建前馈神经网络Keras是一个高级神经网络API,基于TensorFlow、Theano和CNTK等后端库实现。

它提供了一种直观简洁的方式来定义和训练神经网络模型。

首先,我们需要导入Keras库和相关模块:```pythonimport tensorflow as tffrom tensorflow import kerasfrom tensorflow.keras import layers```然后,我们可以使用Keras提供的函数创建神经网络的模型:```pythonmodel = keras.Sequential([layers.Dense(64, activation='relu', input_shape=(input_dim,)),layers.Dense(64, activation='relu'),layers.Dense(output_dim, activation='softmax')])```上述代码中,我们使用Sequential模型来构建神经网络。

resnet实现代码ResNet(残差神经网络)是一种非常流行的深度学习模型,通常用于图像分类任务。

其中,残差块是ResNet中的重要组成部分,能够克服深层网络中的梯度消失问题。

在这篇文章中,我们将介绍如何使用Python编写ResNet实现代码,并在CIFAR-10数据集上进行训练。

第一步:导入必要的库在开始之前,我们需要导入几个Python库。

主要包括TensorFlow和Keras,它们是构建深度学习模型的最常用库。

```import tensorflow as tffrom tensorflow import keras```第二步:定义残差块我们将从定义ResNet中的残差块开始。

每个残差块由两个卷积层和一个跳跃层组成。

跳跃层用于解决梯度消失问题。

```def residual_block(inputs, filters):x = yers.Conv2D(filters, kernel_size=3,padding='same')(inputs)x = yers.BatchNormalization()(x)x = yers.Activation('relu')(x)x = yers.Conv2D(filters, kernel_size=3,padding='same')(x)x = yers.BatchNormalization()(x)x = yers.Add()([x, inputs])x = yers.Activation('relu')(x)return x```第三步:定义ResNet-18模型ResNet-18包括四个残差块,每个块包含两个卷积层和一个跳跃层。

在跳跃层之前,我们需要添加一个批量标准化层和激活层。

最后,我们将两个全连接层添加到模型中,以进行分类。

```def resnet18():inputs = yers.Input(shape=(32, 32, 3))x = yers.Conv2D(64, kernel_size=3,padding='same')(inputs)x = yers.BatchNormalization()(x)x = yers.Activation('relu')(x)x = residual_block(x, 64)x = residual_block(x, 64)x = residual_block(x, 128)x = residual_block(x, 128)x = residual_block(x, 256)x = residual_block(x, 256)x = residual_block(x, 512)x = residual_block(x, 512)x = yers.GlobalAveragePooling2D()(x)outputs = yers.Dense(10, activation='softmax')(x) model = keras.Model(inputs=inputs, outputs=outputs)return model```第四步:加载和预处理CIFAR-10数据集在训练ResNet-18之前,我们需要加载和预处理CIFAR-10数据集。

神经⽹络中BP算法的原理与Python实现源码解析最近这段时间系统性的学习了 BP 算法后写下了这篇学习笔记,因为能⼒有限,若有明显错误,还请指正。

什么是梯度下降和链式求导法则假设我们有⼀个函数 J(w),如下图所⽰。

梯度下降⽰意图现在,我们要求当 w 等于什么的时候,J(w) 能够取到最⼩值。

从图中我们知道最⼩值在初始位置的左边,也就意味着如果想要使 J(w) 最⼩,w的值需要减⼩。

⽽初始位置的切线的斜率a > 0(也即该位置对应的导数⼤于0),w = w – a 就能够让 w 的值减⼩,循环求导更新w直到 J(w) 取得最⼩值。

如果函数J(w)包含多个变量,那么就要分别对不同变量求偏导来更新不同变量的值。

所谓的链式求导法则,就是求复合函数的导数:链式求导法则放个例题,会更加明⽩⼀点:链式求导的例⼦神经⽹络的结构神经⽹络由三部分组成,分别是最左边的输⼊层,隐藏层(实际应⽤中远远不⽌⼀层)和最右边的输出层。

层与层之间⽤线连接在⼀起,每条连接线都有⼀个对应的权重值 w,除了输⼊层,⼀般来说每个神经元还有对应的偏置 b。

神经⽹络的结构图除了输⼊层的神经元,每个神经元都会有加权求和得到的输⼊值 z 和将 z 通过 Sigmoid 函数(也即是激活函数)⾮线性转化后的输出值 a,他们之间的计算公式如下神经元输出值 a 的计算公式其中,公式⾥⾯的变量l和j表⽰的是第 l 层的第 j 个神经元,ij 则表⽰从第 i 个神经元到第 j 个神经元之间的连线,w 表⽰的是权重,b 表⽰的是偏置,后⾯这些符号的含义⼤体上与这⾥描述的相似,所以不会再说明。

下⾯的 Gif 动图可以更加清楚每个神经元输⼊输出值的计算⽅式(注意,这⾥的动图并没有加上偏置,但使⽤中都会加上)动图显⽰计算神经元输出值使⽤激活函数的原因是因为线性模型(⽆法处理线性不可分的情况)的表达能⼒不够,所以这⾥通常需要加⼊ Sigmoid 函数来加⼊⾮线性因素得到神经元的输出值。

神经网络算法的代码实现详解神经网络算法是一种模拟人脑神经系统的计算模型,它通过构建多层神经元网络来实现对数据的学习与预测。

本文将对神经网络算法的代码实现进行详细解析,通过Python语言实现。

1.数据准备首先,我们需要准备训练数据和测试数据。

训练数据是用来训练神经网络的样本,通常包含一组输入数据和对应的输出数据。

测试数据则是用来测试训练后的神经网络模型的准确性。

2.构建神经网络结构接下来,我们需要构建神经网络的结构。

神经网络通常由多层神经元组成,每层神经元与上一层的神经元全连接。

我们可以使用Python的Numpy库来创建神经网络的结构,其中的矩阵运算能够高效地实现神经网络算法。

3.定义激活函数神经网络中,每个神经元都需要一个激活函数来对输入数据进行处理,并输出非线性的结果。

常用的激活函数有sigmoid函数、ReLU 函数等。

我们可以在构建神经网络结构时定义激活函数。

4.前向传播前向传播是指从输入层开始,逐层计算神经元的输出,直到输出层为止。

这一过程可以通过矩阵运算实现,其中每一层的输出都是上一层输出与权重矩阵的乘积再经过激活函数处理得到。

最终,输出层的输出即为神经网络的预测结果。

5.反向传播反向传播是指根据预测结果,逐层更新权重矩阵,以使得预测结果与实际结果尽可能接近。

反向传播算法通过计算误差项,逆向更新权重矩阵。

误差项的计算根据损失函数的不同而有所差异,常用的损失函数有均方误差、交叉熵等。

6.更新权重矩阵根据反向传播算法计算得到的误差项,我们可以更新每一层的权重矩阵。

更新的方法一般是使用梯度下降算法,通过计算每个权重的梯度值以及学习率,来逐步调整权重的取值。

7.训练神经网络模型在完成以上步骤后,我们可以开始训练神经网络模型。

训练过程即是重复进行前向传播和反向传播,以不断更新权重矩阵。

通过多次迭代,使得神经网络模型的预测结果逼近真实结果。

8.测试神经网络模型在训练完成后,我们需要使用测试数据对神经网络模型进行测试,以评估其性能。

Python中的CNN网络实现方法卷积神经网络(Convolutional Neural Network,CNN)是一种深度学习算法,已经在图像识别、自然语言处理、语音识别等领域取得了非常好的效果。

本文将介绍Python中CNN网络的实现方法,并且通过实例展示如何构建CNN网络。

1.卷积神经网络的基本概念卷积神经网络主要由卷积层、池化层、全连接层组成,其中卷积层是最关键的部分。

卷积层的主要作用是提取特征,输入数据经过多次卷积和池化操作后,最终得到的是一个特征图。

卷积神经网络是通过多组卷积核来提取输入数据的特征的。

卷积核是一个小型的矩阵,用于和输入的数据进行卷积。

卷积的结果是一个特征图,这个特征图不仅仅是输入数据的副本,而是提取了输入数据的各种特征,可以用这个特征图来进行下一步的处理。

池化层是在卷积层之后添加的,主要作用是为了进一步降维,减少神经网络的计算量,同时不影响特征图的特征信息。

全连接层是将池化层的输出进行展开,然后进行前向传递和反向传播。

在反向传播时,每一个全连接层的节点将会计算出其对下一层中所有节点的误差,并将其向前传递。

2. Python中实现卷积神经网络的步骤在Python中实现CNN网络的具体步骤如下:1)数据预处理:将数据准备好作为CNN网络的模型输入。

这个步骤通常包括数据归一化、数据增强、数据划分等操作。

2)构建CNN模型:CNN模型主要由卷积层、池化层、全连接层等模块组成。

在Python中,可以使用Keras或TensorFlow等框架来构建CNN模型,这些框架提供了许多预定义的卷积层、池化层等模块,大大简化了模型搭建的流程。

3)编译CNN模型:在构建CNN模型后,需要使用compile方法对模型进行编译,需要指定损失函数、优化函数和评估指标等。

4)训练CNN模型:训练CNN模型需要调用fit方法,传入训练数据和标签进行训练。

在训练过程中,需要指定批次大小、训练次数等参数。

![[数据分析] 在Python中实现文本分类(附代码、数据集)](https://uimg.taocdn.com/44ff07d9a8114431b80dd8b2.webp)

手把手教你在Python中实现文本分类(附代码、数据集)引言文本分类是商业问题中常见的自然语言处理任务,目标是自动将文本文件分到一个或多个已定义好的类别中。

文本分类的一些例子如下:•分析社交媒体中的大众情感•鉴别垃圾邮件和非垃圾邮件•自动标注客户问询•将新闻文章按主题分类目录本文将详细介绍文本分类问题并用Python实现这个过程:文本分类是有监督学习的一个例子,它使用包含文本文档和标签的数据集来训练一个分类器。

端到端的文本分类训练主要由三个部分组成:1. 准备数据集:第一步是准备数据集,包括加载数据集和执行基本预处理,然后把数据集分为训练集和验证集。

特征工程:第二步是特征工程,将原始数据集被转换为用于训练机器学习模型的平坦特征(flat features),并从现有数据特征创建新的特征。

2. 模型训练:最后一步是建模,利用标注数据集训练机器学习模型。

3. 进一步提高分类器性能:本文还将讨论用不同的方法来提高文本分类器的性能。

注意:本文不深入讲述NLP任务,如果你想先复习下基础知识,可以通过这篇文章https:///blog/2017/01/ultimate-guide-to-understand-implement-natural-language-processing-codes-in-python/准备好你的机器先安装基本组件,创建Python的文本分类框架。

首先导入所有所需的库。

如果你没有安装这些库,可以通过以下官方链接来安装它们。

•P andas:https:///pandas-docs/stable/install.html•S cikit-learn:/stable/install.html•X GBoost:http://xgboost.readthedocs.io/en/latest/build.html•T extBlob:http://textblob.readthedocs.io/en/dev/install.html•K eras:https://keras.io/#installation#导入数据集预处理、特征工程和模型训练所需的库from sklearn import model_selection, preprocessing, linear_model, naive_bayes, metrics, svmfrom sklearn.feature_extraction.text import TfidfVectorizer, CountVectorizer from sklearn import decomposition, ensembleimport pandas, xgboost, numpy, textblob, stringfrom keras.preprocessing import text, sequencefrom keras import layers, models, optimizers一、准备数据集在本文中,我使用亚马逊的评论数据集,它可以从这个链接下载:https:///kunalj101/ad1d9c58d338e20d09ff26bcc06c4235这个数据集包含3.6M的文本评论内容及其标签,我们只使用其中一小部分数据。

题目:探究Shufflenet神经网络模型的Python代码实现在深度学习领域,神经网络模型是一种非常重要的算法模型,而Shufflenet作为一种轻量级的卷积神经网络,在移动端和嵌入式设备上有着广泛的应用。

本文将探究Shufflenet神经网络模型的Python代码实现,并对其深度和广度进行全面评估,以期能够帮助读者更全面、深刻地理解这一主题。

Shufflenet是由麦克飞尔等人于2018年提出的一种轻量级神经网络模型,在保持较高准确性的大大减少了参数量和计算复杂度。

它的核心思想是使用分组卷积和通道洗牌操作来实现特征提取和信息融合,从而在保持准确性的前提下实现模型的轻量化。

要实现Shufflenet神经网络模型的Python代码,首先需要导入相关的库和模块,其中包括NumPy、PyTorch等常用的深度学习框架。

可以根据Shufflenet的网络结构,逐步构建网络的各个部分,包括深度可分离卷积、通道洗牌、残差连接等。

在实现过程中,需要注意参数初始化、激活函数的选择、损失函数的定义等细节。

可以利用优化算法如SGD或Adam来训练整个网络,并评估模型在测试集上的性能。

在Shufflenet的Python代码实现过程中,可以通过逐步调试和可视化网络的中间输出来深入理解模型的运行原理。

还可以通过对比不同超参数设置下的训练结果,来探究模型性能与参数设置之间的关系。

个人观点和理解方面,Shufflenet作为一种轻量级神经网络模型,在计算资源有限的环境下展现了巨大的优势,其在移动端和嵌入式设备上的应用前景广阔。

通过深入学习Shufflenet的Python代码实现,我对深度学习模型的构建和训练有了更深入的理解,也对神经网络模型的轻量化设计思想有了更清晰的认识。

总结回顾起来,本文通过探究Shufflenet神经网络模型的Python代码实现,对Shufflenet的网络结构、参数设置、训练优化等方面进行了全面的评估和讨论。

⽤Python实现BP神经⽹络(附代码)⽤Python实现出来的机器学习算法都是什么样⼦呢?前两期线性回归及逻辑回归项⽬已发布(见⽂末链接),今天来讲讲BP神经⽹络。

BP神经⽹络全部代码https:///lawlite19/MachineLearning_Python/blob/master/NeuralNetwok/NeuralNetwork.py神经⽹络model先介绍个三层的神经⽹络,如下图所⽰输⼊层(input layer)有三个units(为补上的bias,通常设为1)表⽰第j层的第i个激励,也称为为单元unit为第j层到第j+1层映射的权重矩阵,就是每条边的权重所以可以得到:隐含层:输出层,其中,S型函数,也成为激励函数可以看出为3x4的矩阵,为1x4的矩阵==》j+1的单元数x(j层的单元数+1)代价函数假设最后输出的,即代表输出层有K个单元,其中,代表第i个单元输出与逻辑回归的代价函数差不多,就是累加上每个输出(共有K个输出)正则化L-->所有层的个数-->第l层unit的个数正则化后的代价函数为共有L-1层,然后是累加对应每⼀层的theta矩阵,注意不包含加上偏置项对应的theta(0)正则化后的代价函数实现代码:# 代价函数def nnCostFunction(nn_params,input_layer_size,hidden_layer_size,num_labels,X,y,Lambda):length = nn_params.shape[0] # theta的中长度# 还原theta1和theta2Theta1 = nn_params[0:hidden_layer_size*(input_layer_size+1)].reshape(hidden_layer_size,input_layer_size+1)Theta2 = nn_params[hidden_layer_size*(input_layer_size+1):length].reshape(num_labels,hidden_layer_size+1)# np.savetxt("Theta1.csv",Theta1,delimiter=',')m = X.shape[0]class_y = np.zeros((m,num_labels)) # 数据的y对应0-9,需要映射为0/1的关系# 映射yfor i in range(num_labels):class_y[:,i] = np.int32(y==i).reshape(1,-1) # 注意reshape(1,-1)才可以赋值'''去掉theta1和theta2的第⼀列,因为正则化时从1开始'''Theta1_colCount = Theta1.shape[1]Theta1_x = Theta1[:,1:Theta1_colCount]Theta2_colCount = Theta2.shape[1]Theta2_x = Theta2[:,1:Theta2_colCount]# 正则化向theta^2term = np.dot(np.transpose(np.vstack((Theta1_x.reshape(-1,1),Theta2_x.reshape(-1,1)))),np.vstack((Theta1_x.reshape(-1,1),Theta2_x.reshape(-1,1))))'''正向传播,每次需要补上⼀列1的偏置bias'''a1 = np.hstack((np.ones((m,1)),X))z2 = np.dot(a1,np.transpose(Theta1))a2 = sigmoid(z2)a2 = np.hstack((np.ones((m,1)),a2))z3 = np.dot(a2,np.transpose(Theta2))h = sigmoid(z3)'''代价'''J = -(np.dot(np.transpose(class_y.reshape(-1,1)),np.log(h.reshape(-1,1)))+np.dot(np.transpose(1-class_y.reshape(-1,1)),np.log(1-h.reshape(-1,1)))-Lambda*term/2)/mreturn np.ravel(J)反向传播BP上⾯正向传播可以计算得到J(θ),使⽤梯度下降法还需要求它的梯度BP反向传播的⽬的就是求代价函数的梯度假设4层的神经⽹络,记为-->l层第j个单元的误差《===》(向量化)没有,因为对于输⼊没有误差因为S型函数的倒数为:,所以上⾯的和可以在前向传播中计算出来反向传播计算梯度的过程为:(是⼤写的)for i=1-m:--正向传播计算(l=2,3,4...L)-反向计算、...;--最后,即得到代价函数的梯度实现代码:# 梯度def nnGradient(nn_params,input_layer_size,hidden_layer_size,num_labels,X,y,Lambda):length = nn_params.shape[0]Theta1 = nn_params[0:hidden_layer_size*(input_layer_size+1)].reshape(hidden_layer_size,input_layer_size+1) Theta2 = nn_params[hidden_layer_size*(input_layer_size+1):length].reshape(num_labels,hidden_layer_size+1) m = X.shape[0]class_y = np.zeros((m,num_labels)) # 数据的y对应0-9,需要映射为0/1的关系# 映射yfor i in range(num_labels):class_y[:,i] = np.int32(y==i).reshape(1,-1) # 注意reshape(1,-1)才可以赋值'''去掉theta1和theta2的第⼀列,因为正则化时从1开始'''Theta1_colCount = Theta1.shape[1]Theta1_x = Theta1[:,1:Theta1_colCount]Theta2_colCount = Theta2.shape[1]Theta2_x = Theta2[:,1:Theta2_colCount]Theta1_grad = np.zeros((Theta1.shape)) #第⼀层到第⼆层的权重Theta2_grad = np.zeros((Theta2.shape)) #第⼆层到第三层的权重Theta1[:,0] = 0;Theta2[:,0] = 0;'''正向传播,每次需要补上⼀列1的偏置bias'''a1 = np.hstack((np.ones((m,1)),X))z2 = np.dot(a1,np.transpose(Theta1))a2 = sigmoid(z2)a2 = np.hstack((np.ones((m,1)),a2))z3 = np.dot(a2,np.transpose(Theta2))h = sigmoid(z3)'''反向传播,delta为误差,'''delta3 = np.zeros((m,num_labels))delta2 = np.zeros((m,hidden_layer_size))for i in range(m):delta3[i,:] = h[i,:]-class_y[i,:]Theta2_grad = Theta2_grad+np.dot(np.transpose(delta3[i,:].reshape(1,-1)),a2[i,:].reshape(1,-1))delta2[i,:] = np.dot(delta3[i,:].reshape(1,-1),Theta2_x)*sigmoidGradient(z2[i,:])Theta1_grad = Theta1_grad+np.dot(np.transpose(delta2[i,:].reshape(1,-1)),a1[i,:].reshape(1,-1))'''梯度'''grad = (np.vstack((Theta1_grad.reshape(-1,1),Theta2_grad.reshape(-1,1)))+Lambda*np.vstack((Theta1.reshape(-1,1),Theta2.reshape(-1,1))))/mreturn np.ravel(grad)BP可以求梯度的原因实际是利⽤了链式求导法则因为下⼀层的单元利⽤上⼀层的单元作为输⼊进⾏计算⼤体的推导过程如下,最终我们是想预测函数与已知的y⾮常接近,求均⽅差的梯度沿着此梯度⽅向可使代价函数最⼩化。

rnn的案例代码以下是一个使用Python和Keras库实现的基本RNN(循环神经网络)的案例代码。

这个例子是一个简单的RNN模型,用于对序列数据进行预测。

```python# 导入所需库import numpy as npfrom keras.models import Sequentialfrom yers import SimpleRNN, Dense# 生成序列数据data = np.array([[[1, 2, 3, 4, 5], [2, 3, 4, 5, 6], [3, 4, 5, 6, 7]],[[10, 20, 30, 40, 50], [20, 30, 40, 50, 60], [30, 40, 50, 60, 70]]])# 生成标签数据labels = np.array([[1, 2, 3], [10, 20, 30]])# 将数据转换为适合RNN的格式data = np.reshape(data, (data.shape[0], data.shape[1], data.shape[2]))labels = np.reshape(labels, (labels.shape[0],labels.shape[1]))# 定义模型model = Sequential()model.add(SimpleRNN(10, input_shape=(3, 5)))model.add(Dense(1))pile(loss='mean_squared_error', optimizer='adam')# 训练模型model.fit(data, labels, epochs=100)# 使用模型进行预测test_data = np.array([[4, 5, 6], [30, 40, 50]])test_data = np.reshape(test_data, (test_data.shape[0],test_data.shape[1], test_data.shape[2]))prediction = model.predict(test_data)print(prediction)```这个例子中,我们首先生成了一些序列数据和对应的标签。

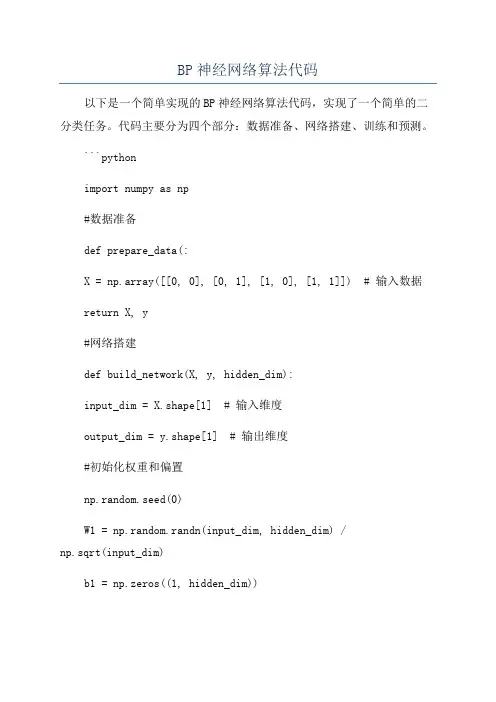

BP神经网络算法代码以下是一个简单实现的BP神经网络算法代码,实现了一个简单的二分类任务。

代码主要分为四个部分:数据准备、网络搭建、训练和预测。

```pythonimport numpy as np#数据准备def prepare_data(:X = np.array([[0, 0], [0, 1], [1, 0], [1, 1]]) # 输入数据return X, y#网络搭建def build_network(X, y, hidden_dim):input_dim = X.shape[1] # 输入维度output_dim = y.shape[1] # 输出维度#初始化权重和偏置np.random.seed(0)W1 = np.random.randn(input_dim, hidden_dim) /np.sqrt(input_dim)b1 = np.zeros((1, hidden_dim))W2 = np.random.randn(hidden_dim, output_dim) / np.sqrt(hidden_dim)b2 = np.zeros((1, output_dim))return W1, b1, W2, b2#前向传播def forward_propagation(X, W1, b1, W2, b2):z1 = np.dot(X, W1) + b1a1 = sigmoid(z1)z2 = np.dot(a1, W2) + b2a2 = sigmoid(z2)return a1, a2#激活函数def sigmoid(x):return 1 / (1 + np.exp(-x))#反向传播def backward_propagation(X, y, a1, a2, W1, W2): m = X.shape[0] # 样本数量#计算损失loss = np.sum((a2-y)**2) / (2*m)#计算梯度delta2 = 1/m * (a2-y) * a2 * (1-a2)dW2 = np.dot(a1.T, delta2)db2 = np.sum(delta2, axis=0, keepdims=True)delta1 = np.dot(delta2, W2.T) * a1 * (1-a1)dW1 = np.dot(X.T, delta1)db1 = np.sum(delta1, axis=0)return loss, dW1, db1, dW2, db2#更新参数def update_parameters(W1, b1, W2, b2, dW1, db1, dW2, db2, learning_rate):W1 -= learning_rate * dW1b1 -= learning_rate * db1W2 -= learning_rate * dW2b2 -= learning_rate * db2return W1, b1, W2, b2#训练def train(X, y, hidden_dim, num_epochs, learning_rate):W1, b1, W2, b2 = build_network(X, y, hidden_dim)for epoch in range(num_epochs):a1, a2 = forward_propagation(X, W1, b1, W2, b2)loss, dW1, db1, dW2, db2 = backward_propagation(X, y, a1, a2, W1, W2)W1, b1, W2, b2 = update_parameters(W1, b1, W2, b2, dW1, db1, dW2, db2, learning_rate)if (epoch+1) % 100 == 0:print("Epoch {}: loss = {}".format(epoch+1, loss))return W1, b1, W2, b2#预测def predict(X, W1, b1, W2, b2):_, a2 = forward_propagation(X, W1, b1, W2, b2)predictions = (a2 > 0.5).astype(int)return predictions#主函数def main(:X, y = prepare_datahidden_dim = 3num_epochs = 1000learning_rate = 0.1W1, b1, W2, b2 = train(X, y, hidden_dim, num_epochs, learning_rate)predictions = predict(X, W1, b1, W2, b2)print("Predictions:", predictions)if __name__ == "__main__":main```注意:这段代码只是一个简单的实现,可能在复杂任务上效果不佳。

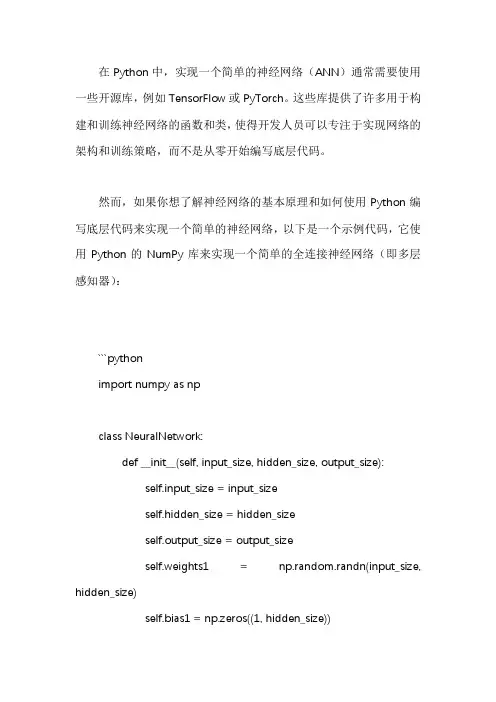

在Python中,实现一个简单的神经网络(ANN)通常需要使用一些开源库,例如TensorFlow或PyTorch。

这些库提供了许多用于构建和训练神经网络的函数和类,使得开发人员可以专注于实现网络的架构和训练策略,而不是从零开始编写底层代码。

然而,如果你想了解神经网络的基本原理和如何使用Python编写底层代码来实现一个简单的神经网络,以下是一个示例代码,它使用Python的NumPy库来实现一个简单的全连接神经网络(即多层感知器):```pythonimport numpy as npclass NeuralNetwork:def __init__(self, input_size, hidden_size, output_size):self.input_size = input_sizeself.hidden_size = hidden_sizeself.output_size = output_sizeself.weights1 = np.random.randn(input_size, hidden_size)self.bias1 = np.zeros((1, hidden_size))self.weights2 = np.random.randn(hidden_size, output_size)self.bias2 = np.zeros((1, output_size))def forward(self, X):self.z1 = np.dot(X, self.weights1) + self.bias1self.a1 = self.sigmoid(self.z1)self.z2 = np.dot(self.a1, self.weights2) + self.bias2self.a2 = self.sigmoid(self.z2)return self.a2def sigmoid(self, s):return 1 / (1 + np.exp(-s))def sigmoid_derivative(self, s):return s * (1 - s)# 示例用法:X = np.array([[0, 0], [0, 1], [1, 0], [1, 1]])y = np.array([[0], [1], [1], [0]])nn = NeuralNetwork(input_size=2, hidden_size=2, output_size=1) for i in range(10000):nn.weights1 += np.dot(X, nn.sigmoid_derivative(nn.forward(X))) / len(X)nn.bias1 += np.sum(nn.sigmoid_derivative(nn.forward(X)), axis=0) / len(X)nn.weights2 += np.dot(nn.forward(X), nn.sigmoid_derivative(nn.forward(X))) / len(X)nn.bias2 += np.sum(nn.sigmoid_derivative(nn.forward(X)), axis=0) / len(X)print(nn.forward(np.array([0, 0])))print(nn.forward(np.array([0, 1])))print(nn.forward(np.array([1, 0])))print(nn.forward(np.array([1, 1])))```这个代码实现了一个简单的全连接神经网络,它包含一个输入层、一个隐藏层和一个输出层。

Python实现的三层BP神经⽹络算法⽰例本⽂实例讲述了Python实现的三层BP神经⽹络算法。

分享给⼤家供⼤家参考,具体如下:这是⼀个⾮常漂亮的三层反向传播神经⽹络的python实现,下⼀步我准备试着将其修改为多层BP神经⽹络。

下⾯是运⾏演⽰函数的截图,你会发现预测的结果很惊⼈!提⽰:运⾏演⽰函数的时候,可以尝试改变隐藏层的节点数,看节点数增加了,预测的精度会否提升import mathimport randomimport stringrandom.seed(0)# ⽣成区间[a, b)内的随机数def rand(a, b):return (b-a)*random.random() + a# ⽣成⼤⼩ I*J 的矩阵,默认零矩阵 (当然,亦可⽤ NumPy 提速)def makeMatrix(I, J, fill=0.0):m = []for i in range(I):m.append([fill]*J)return m# 函数 sigmoid,这⾥采⽤ tanh,因为看起来要⽐标准的 1/(1+e^-x) 漂亮些def sigmoid(x):return math.tanh(x)# 函数 sigmoid 的派⽣函数, 为了得到输出 (即:y)def dsigmoid(y):return 1.0 - y**2class NN:''' 三层反向传播神经⽹络 '''def __init__(self, ni, nh, no):# 输⼊层、隐藏层、输出层的节点(数)self.ni = ni + 1 # 增加⼀个偏差节点self.nh = nhself.no = no# 激活神经⽹络的所有节点(向量)self.ai = [1.0]*self.niself.ah = [1.0]*self.nhself.ao = [1.0]*self.no# 建⽴权重(矩阵)self.wi = makeMatrix(self.ni, self.nh)self.wo = makeMatrix(self.nh, self.no)# 设为随机值for i in range(self.ni):for j in range(self.nh):self.wi[i][j] = rand(-0.2, 0.2)for j in range(self.nh):for k in range(self.no):self.wo[j][k] = rand(-2.0, 2.0)# 最后建⽴动量因⼦(矩阵)self.ci = makeMatrix(self.ni, self.nh)self.co = makeMatrix(self.nh, self.no)def update(self, inputs):if len(inputs) != self.ni-1:raise ValueError('与输⼊层节点数不符!')# 激活输⼊层for i in range(self.ni-1):#self.ai[i] = sigmoid(inputs[i])self.ai[i] = inputs[i]# 激活隐藏层for j in range(self.nh):sum = 0.0for i in range(self.ni):sum = sum + self.ai[i] * self.wi[i][j]self.ah[j] = sigmoid(sum)# 激活输出层for k in range(self.no):sum = 0.0for j in range(self.nh):sum = sum + self.ah[j] * self.wo[j][k]self.ao[k] = sigmoid(sum)return self.ao[:]def backPropagate(self, targets, N, M):''' 反向传播 '''if len(targets) != self.no:raise ValueError('与输出层节点数不符!')# 计算输出层的误差output_deltas = [0.0] * self.nofor k in range(self.no):error = targets[k]-self.ao[k]output_deltas[k] = dsigmoid(self.ao[k]) * error# 计算隐藏层的误差hidden_deltas = [0.0] * self.nhfor j in range(self.nh):error = 0.0for k in range(self.no):error = error + output_deltas[k]*self.wo[j][k]hidden_deltas[j] = dsigmoid(self.ah[j]) * error# 更新输出层权重for j in range(self.nh):for k in range(self.no):change = output_deltas[k]*self.ah[j]self.wo[j][k] = self.wo[j][k] + N*change + M*self.co[j][k]self.co[j][k] = change#print(N*change, M*self.co[j][k])# 更新输⼊层权重for i in range(self.ni):for j in range(self.nh):change = hidden_deltas[j]*self.ai[i]self.wi[i][j] = self.wi[i][j] + N*change + M*self.ci[i][j]self.ci[i][j] = change# 计算误差error = 0.0for k in range(len(targets)):error = error + 0.5*(targets[k]-self.ao[k])**2return errordef test(self, patterns):for p in patterns:print(p[0], '->', self.update(p[0]))def weights(self):print('输⼊层权重:')for i in range(self.ni):print(self.wi[i])print()print('输出层权重:')for j in range(self.nh):print(self.wo[j])def train(self, patterns, iterations=1000, N=0.5, M=0.1):# N: 学习速率(learning rate)# M: 动量因⼦(momentum factor)for i in range(iterations):error = 0.0for p in patterns:inputs = p[0]targets = p[1]self.update(inputs)error = error + self.backPropagate(targets, N, M)if i % 100 == 0:print('误差 %-.5f' % error)def demo():# ⼀个演⽰:教神经⽹络学习逻辑异或(XOR)------------可以换成你⾃⼰的数据试试 pat = [[[0,0], [0]],[[0,1], [1]],[[1,0], [1]],[[1,1], [0]]]# 创建⼀个神经⽹络:输⼊层有两个节点、隐藏层有两个节点、输出层有⼀个节点 n = NN(2, 2, 1)# ⽤⼀些模式训练它n.train(pat)# 测试训练的成果(不要吃惊哦)n.test(pat)# 看看训练好的权重(当然可以考虑把训练好的权重持久化)#n.weights()if __name__ == '__main__':demo()更多关于Python相关内容感兴趣的读者可查看本站专题:《》、《》、《》、《》及《》希望本⽂所述对⼤家Python程序设计有所帮助。

可编辑修改精选全文完整版pso优化bp算法python代码PSO优化BP算法Python代码BP神经网络是一种常用的人工神经网络,它可以用于分类、回归等任务。

但是,BP神经网络的训练过程需要大量的计算和时间,而且容易陷入局部最优解。

为了解决这些问题,我们可以使用粒子群优化(PSO)算法来优化BP神经网络。

PSO算法是一种基于群体智能的优化算法,它模拟了鸟群或鱼群等生物的行为,通过不断地搜索和迭代,找到最优解。

在PSO算法中,每个粒子代表一个解,它们通过不断地移动和更新自己的位置和速度,来寻找最优解。

下面是使用Python实现PSO优化BP算法的代码:```pythonimport numpy as npimport random# 定义BP神经网络类class BPNN:def __init__(self, input_size, hidden_size, output_size):self.input_size = input_sizeself.hidden_size = hidden_sizeself.output_size = output_sizeself.W1 = np.random.randn(self.input_size, self.hidden_size) self.W2 = np.random.randn(self.hidden_size, self.output_size) # 定义sigmoid函数def sigmoid(self, x):return 1 / (1 + np.exp(-x))# 定义前向传播函数def forward(self, X):self.z2 = np.dot(X, self.W1)self.a2 = self.sigmoid(self.z2)self.z3 = np.dot(self.a2, self.W2)y_hat = self.sigmoid(self.z3)return y_hat# 定义损失函数def loss(self, X, y):y_hat = self.forward(X)J = 0.5 * sum((y - y_hat) ** 2)return J# 定义反向传播函数def backward(self, X, y):y_hat = self.forward(X)delta3 = np.multiply(-(y - y_hat), self.sigmoid(self.z3) * (1 - self.sigmoid(self.z3)))dJdW2 = np.dot(self.a2.T, delta3)delta2 = np.dot(delta3, self.W2.T) * self.sigmoid(self.z2) * (1 - self.sigmoid(self.z2))dJdW1 = np.dot(X.T, delta2)return dJdW1, dJdW2# 定义PSO算法类class PSO:def __init__(self, n_particles, input_size, hidden_size, output_size, max_iter, c1, c2, w):self.n_particles = n_particlesself.input_size = input_sizeself.hidden_size = hidden_sizeself.output_size = output_sizeself.max_iter = max_iterself.c1 = c1self.c2 = c2self.w = wself.particles = []self.gbest = Noneself.gbest_loss = float('inf')# 初始化粒子群for i in range(self.n_particles):bpnn = BPNN(self.input_size, self.hidden_size, self.output_size) particle = {'position': [bpnn.W1, bpnn.W2], 'velocity': [np.zeros((self.input_size, self.hidden_size)), np.zeros((self.hidden_size, self.output_size))], 'pbest': None, 'pbest_loss': float('inf')}self.particles.append(particle)# 定义更新粒子位置和速度的函数def update(self):for particle in self.particles:# 更新速度particle['velocity'][0] = self.w * particle['velocity'][0] + self.c1 * random.random() * (particle['pbest'][0] - particle['position'][0]) + self.c2 * random.random() * (self.gbest[0] - particle['position'][0])particle['velocity'][1] = self.w * particle['velocity'][1] + self.c1 * random.random() * (particle['pbest'][1] - particle['position'][1]) + self.c2 * random.random() * (self.gbest[1] - particle['position'][1])# 更新位置particle['position'][0] += particle['velocity'][0]particle['position'][1] += particle['velocity'][1]# 更新pbest和gbestbpnn = BPNN(self.input_size, self.hidden_size, self.output_size) bpnn.W1 = particle['position'][0]bpnn.W2 = particle['position'][1]loss = bpnn.loss(X, y)if loss < particle['pbest_loss']:particle['pbest'] = [bpnn.W1, bpnn.W2]particle['pbest_loss'] = lossif loss < self.gbest_loss:self.gbest = [bpnn.W1, bpnn.W2]self.gbest_loss = loss# 定义训练函数def train(self, X, y):for i in range(self.max_iter):self.update()print('Iteration:', i, 'Loss:', self.gbest_loss)# 测试代码X = np.array([[0, 0], [0, 1], [1, 0], [1, 1]])y = np.array([[0], [1], [1], [0]])pso = PSO(n_particles=10, input_size=2, hidden_size=4, output_size=1,max_iter=100, c1=2, c2=2, w=0.8)pso.train(X, y)```在上面的代码中,我们首先定义了一个BP神经网络类,包括前向传播、损失函数和反向传播等方法。

在学习神经网络之前,我们需要对神经网络底层先做一个基本的了解。

我们将在本节介绍感知机、反向传播算法以及多种梯度下降法以给大家一个全面的认识。

一、感知机数字感知机的本质是从数据集中选取一个样本(example),并将其展示给算法,然后让算法判断“是”或“不是”。

一般而言,把单个特征表示为xi,其中i是整数。

所有特征的集合表示为,表示一个向量:,类似地,每个特征的权重表示为其中对应于与该权重关联的特征的下标,所有权重可统一表示为一个向量:这里有一个缺少的部分是是否激活神经元的阈值。

一旦加权和超过某个阈值,感知机就输出1,否则输出0。

我们可以使用一个简单的阶跃函数(在图5-2中标记为“激活函数”)来表示这个阈值。

一般而言我们还需要给上面的阈值表达式添加一个偏置项以确保神经元对全0的输入具有弹性,否则网络在输入全为0的情况下输出仍然为0。

注:所有神经网络的基本单位都是神经元,基本感知机是广义神经元的一个特例,从现在开始,我们将感知机称为一个神经元。

二、反向传播算法2.1 代价函数很多数据值之间的关系不是线性的,也没有好的线性回归或线性方程能够描述这些关系。

许多数据集不能用直线或平面来线性分割。

比如下图中左图为线性可分的数据,而右图为线性不可分的数据:在这个线性可分数据集上对两类点做切分得到的误差可以收敛于0,而对于线性不可分的数据点集,我们无法做出一条直线使得两类点被完美分开,因此我们任意做一条分割线,可以认为在这里误差不为0,因此我们需要一个衡量误差的函数,通常称之为代价函数:而我们训练神经网络(感知机)的目标是最小化所有输入样本数据的代价函数2.2 反向传播权重通过下一层的权重()和()来影响误差,因此我们需要一种方法来计算对误差的贡献,这个方法就是反向传播。

下图中展示的是一个全连接网络,图中没有展示出所有的连接,在全连接网络中,每个输入元素都与下一层的各个神经元相连,每个连接都有相应的权重。

因此,在一个以四维向量为输入、有5个神经元的全连接神经网络中,一共有20个权重(5个神经元各连接4个权重)。

使用Python实现一个AI算法Python是一种优秀的用于实现AI算法的编程语言,能够为AI算法提供足够的稳定性和可扩展性。

在这里,我们将使用Python实现一个基本的AI算法,即人工神经网络(ANN)。

首先,我们需要引入一些必要的Python库,如numpy和tensorflow,以便能够进行数学计算。

import numpy as npfrom tensorflow import kerasANN通常通过一系列层来构建,每一层都可以有不同的功能。

例如,输入层可用于接收给定的输入,而隐藏层可用于处理输入的数据,并产生对应的输出。

此外,输出层也可以使用来表示模型的最终预测结果。

在Python中,我们可以使用Keras来实现这些层,Keras提供了一组高层抽象函数来实现这些功能。

首先,我们需要定义一个Sequential模型,然后在Sequential模型中定义输入、隐藏和输出层。

接着,我们可以使用add()函数来添加每一层,并且还可以指定每一层的神经元数量。

例如,下面的代码就添加了一个具有20个神经元的输入层:model.add(yers.InputLayer(input_shape=(20,)))接下来,我们可以添加一个具有15个神经元的隐藏层:model.add(yers.Dense(15))如果需要添加更多的隐藏层,只需要重复上述操作即可。

最终,我们可以添加一个具有1个神经元的输出层:model.add(yers.Dense(1))当我们完成了模型定义后,就可以使用compile()函数来编译模型,以便可以使用fit()函数来训练模型。

训练的过程中,我们可以使用evaluate()函数来评估模型的效果,最终能够得到比较满意的效果。

最后,当我们完成模型的训练和评估后,还可以使用predict()函数来预测模型的最终结果。

因此,通过以上步骤,我们已经可以使用Python实现一个AI算法,即人工神经网络,实现模型的训练、评估和预测等操作。

python三层神经⽹络搭建三层神经⽹络,训练0到9⼗个数字并测试:1import numpy2import scipy.special3# import matplotlib.pyplot4import time567class NeuralNetwork:89# 初始化神经⽹络10def__init__(self, inputnodes, hiddenodes, outputnodes, learningrate):11# 设置输⼊层、隐藏层、输出层的节点数12 self.inodes = inputnodes13 self.hnodes = hiddenodes14 self.onodes = outputnodes1516# 学习因⼦17 self.lr = learningrate1819# 输⼊层、隐藏层、输出层之间的链接权重20# self.wih = (numpy.random.rand(self.hnodes, self.inodes) - 0.5)21# self.who = (numpy.random.rand(self.onodes, self.inodes) - 0.5)22# 利⽤正态分布采样权重23 self.wih = numpy.random.normal(0.0, pow(self.hnodes, - 0.5), (self.hnodes, self.inodes))24 self.who = numpy.random.normal(0.0, pow(self.onodes, - 0.5), (self.onodes, self.hnodes))2526# S函数27 self.activation_function = lambda x: scipy.special.expit(x)28pass2930# 训练31def train(self, inputs_list, targets_list):32# 输⼊层转矩阵33 inputs = numpy.array(inputs_list, ndmin=2).T34 targets = numpy.array(targets_list, ndmin=2).T3536# 隐藏层输⼊=权重点乘输⼊层矩阵37 hidden_inputs = numpy.dot(self.wih, inputs)38# 隐藏层应⽤S函数39 hidden_outputs = self.activation_function(hidden_inputs)4041# 输出层输⼊=权重点乘隐藏层输⼊矩阵42 final_inputs = numpy.dot(self.who, hidden_outputs)43# 输出层输⼊应⽤S函数44 final_outputs = self.activation_function(final_inputs)4546# 计算误差47 output_errors = targets - final_outputs;48# 计算隐藏层误差49 hidden_errors = numpy.dot(self.who.T, output_errors)50# 更新隐藏层和输出层之间的权重51 self.who += self.lr * numpy.dot((output_errors * final_outputs * (1.0 - final_outputs)),52 numpy.transpose(hidden_outputs))53# 更新输⼊层和隐藏层之间的权重54 self.wih += self.lr * numpy.dot((hidden_errors * hidden_outputs * (1.0 - hidden_outputs)),55 numpy.transpose(inputs))5657pass5859# 查询60def query(self, inputs_list):61# 输⼊层转矩阵62 inputs = numpy.array(inputs_list, ndmin=2).T6364# 隐藏层输⼊=权重点乘输⼊层矩阵65 hidden_inputs = numpy.dot(self.wih, inputs)66# 隐藏层应⽤S函数67 hidden_outputs = self.activation_function(hidden_inputs)6869# 输出层输⼊=权重点乘隐藏层输⼊矩阵70 final_inputs = numpy.dot(self.who, hidden_outputs)71# 输出层输⼊应⽤S函数72 final_outputs = self.activation_function(final_inputs)7374return final_outputs757677# 输⼊、隐藏、输出三层节点数78 input_nodes = 78479 hidden_nodes = 10080 output_nodes = 108182# 学习因⼦83 learning_rate = 0.28485# 创建神经⽹络86 n = NeuralNetwork(input_nodes, hidden_nodes, output_nodes, learning_rate) 8788# 读取训练数据89# training_data_file = open("web/mnist_dataset/mnist_train_100.csv")90 training_data_file = open("web/mnist_dataset/mnist_train.csv")91 training_data_list = training_data_file.readlines()92 training_data_file.close()9394# 世代,所有数据训练⼀遍为⼀个世代95 epochs = 196 start = int(time.time())97for e in range(epochs):98# 训练神经⽹络99for record in training_data_list:100# 按逗号切分成数组101 all_values = record.split(",")102# 缩放并转换成0.01到0.99之间的数组103 inputs = (numpy.asfarray(all_values[1:]) / 255.0 * 0.99) + 0.01104# 构建真实输出数组,除了⽬标位置是0.99,其他都是0.01105 targets = numpy.zeros(output_nodes) + 0.01106 targets[int(all_values[0])] = 0.99107 n.train(inputs, targets)108pass109pass110 end = int(time.time())111print("训练⽤时=", end - start, "秒")112113# 测试数据114# test_data_file = open("web/mnist_dataset/mnist_test_10.csv")115 test_data_file = open("web/mnist_dataset/mnist_test.csv")116 test_data_list = test_data_file.readlines()117 test_data_file.close()118# all_values = test_data_list[0].split(",")119# image_array = numpy.asfarray(all_values[1:]).reshape((28, 28))120# matplotlib.pyplot.imshow(image_array, cmap='Greys', interpolation='None') 121#122# value = n.query((numpy.asfarray(all_values[1:]) / 255.0 * 0.99) + 0.01) 123# print(value)124125# 统计分数126 scorecard = []127128 start = int(time.time())129# 检查所有测试数据130for record in test_data_list:131 all_values = record.split(",")132# 正确答案133 correct_label = int(all_values[0])134# print(correct_label, "正确答案")135136 inputs = (numpy.asfarray(all_values[1:]) / 255.0 * 0.99) + 0.01137 outputs = n.query(inputs)138 label = numpy.argmax(outputs)139# print(label, "神经⽹络答案")140141if label == correct_label:142 scorecard.append(1)143else:144 scorecard.append(0)145pass146 end = int(time.time())147print("检查⽤时=", end - start, "秒")148149# print(scorecard)150 scorecard_array = numpy.asarray(scorecard)151print("正确率=", scorecard_array.sum() / scorecard_array.size)验证码的数字和字母识别:1import numpy2import scipy.special3import scipy.ndimage.interpolation4# import matplotlib.pyplot5import time6import string7from random import shuffle89import matplotlib.pyplot10111213class NeuralNetwork:1415# 初始化神经⽹络16def__init__(self, inputnodes, hiddenodes, outputnodes, learningrate):17# 设置输⼊层、隐藏层、输出层的节点数18 self.inodes = inputnodes19 self.hnodes = hiddenodes20 self.onodes = outputnodes2122# 学习因⼦23 self.lr = learningrate2425# 输⼊层、隐藏层、输出层之间的链接权重26# self.wih = (numpy.random.rand(self.hnodes, self.inodes) - 0.5)27# self.who = (numpy.random.rand(self.onodes, self.inodes) - 0.5)28# 利⽤正态分布采样权重29 self.wih = numpy.random.normal(0.0, pow(self.hnodes, - 0.5), (self.hnodes, self.inodes))30 self.who = numpy.random.normal(0.0, pow(self.onodes, - 0.5), (self.onodes, self.hnodes)) 3132# S函数33 self.activation_function = lambda x: scipy.special.expit(x)34 self.inverse_activation_function = lambda x: scipy.special.logit(x)35pass3637# 训练38def train(self, inputs_list, targets_list):39# 输⼊层转矩阵40 inputs = numpy.array(inputs_list, ndmin=2).T41 targets = numpy.array(targets_list, ndmin=2).T4243# 隐藏层输⼊=权重点乘输⼊层矩阵44 hidden_inputs = numpy.dot(self.wih, inputs)45# 隐藏层应⽤S函数46 hidden_outputs = self.activation_function(hidden_inputs)4748# 输出层输⼊=权重点乘隐藏层输⼊矩阵49 final_inputs = numpy.dot(self.who, hidden_outputs)50# 输出层输⼊应⽤S函数51 final_outputs = self.activation_function(final_inputs)5253# 计算误差54 output_errors = targets - final_outputs55# 计算隐藏层误差56 hidden_errors = numpy.dot(self.who.T, output_errors)57# 更新隐藏层和输出层之间的权重58 self.who += self.lr * numpy.dot((output_errors * final_outputs * (1.0 - final_outputs)),59 numpy.transpose(hidden_outputs))60# 更新输⼊层和隐藏层之间的权重61 self.wih += self.lr * numpy.dot((hidden_errors * hidden_outputs * (1.0 - hidden_outputs)),62 numpy.transpose(inputs))6364pass6566# 查询67def query(self, inputs_list):68# 输⼊层转矩阵69 inputs = numpy.array(inputs_list, ndmin=2).T7071# 隐藏层输⼊=权重点乘输⼊层矩阵72 hidden_inputs = numpy.dot(self.wih, inputs)73# 隐藏层应⽤S函数74 hidden_outputs = self.activation_function(hidden_inputs)7576# 输出层输⼊=权重点乘隐藏层输⼊矩阵77 final_inputs = numpy.dot(self.who, hidden_outputs)78# 输出层输⼊应⽤S函数79 final_outputs = self.activation_function(final_inputs)8081return final_outputs8283def back_query(self, targets_list):84# transpose the targets list to a vertical array85 final_outputs = numpy.array(targets_list, ndmin=2).T8687# calculate the signal into the final output layer88 final_inputs = self.inverse_activation_function(final_outputs)8990# calculate the signal out of the hidden layer91 hidden_outputs = numpy.dot(self.who.T, final_inputs)92# scale them back to 0.01 to .9993 hidden_outputs -= numpy.min(hidden_outputs)94 hidden_outputs /= numpy.max(hidden_outputs)95 hidden_outputs *= 0.9896 hidden_outputs += 0.019798# calculate the signal into the hidden layer99 hidden_inputs = self.inverse_activation_function(hidden_outputs)100101# calculate the signal out of the input layer102 inputs = numpy.dot(self.wih.T, hidden_inputs)103# scale them back to 0.01 to .99104 inputs -= numpy.min(inputs)105 inputs /= numpy.max(inputs)106 inputs *= 0.98107 inputs += 0.01108109return inputs110111112# 验证码,10个数字+26个⼤⼩写字母97-122113 codes = list(string.digits + string.ascii_lowercase)114# 输⼊、隐藏、输出三层节点数115 input_nodes = 45 * 100116# 四位验证码117 output_nodes = (len(codes))118 hidden_nodes = output_nodes * 10119120121# 学习因⼦122 learning_rate = 0.2123124# 创建神经⽹络125 n = NeuralNetwork(input_nodes, hidden_nodes, output_nodes, learning_rate)126127# 读取训练数据128# training_data_file = open("web/mnist_dataset/mnist_train_100.csv")129 training_data_file = open("web/train.csv")130 training_data_list = training_data_file.readlines()131 shuffle(training_data_list)132 training_data_file.close()133134135# 世代,所有数据训练⼀遍为⼀个世代136 epochs = 1137print("输⼊节点=%d,隐藏节点=%d,输出节点=%d,学习因⼦=%f,时代=%d" % (input_nodes, hidden_nodes, output_nodes, learning_rate, epochs)) 138print("开始训练...")139 start = int(time.time())140for e in range(epochs):141# 训练神经⽹络142for record in training_data_list:143# 按逗号切分成数组144 all_values = record.split(",")145# 缩放并转换成0.01到0.99之间的数组146 train_inputs = (numpy.asfarray(all_values[1:]) / 255.0 * 0.99) + 0.01147# 旋转正负10度148 train_inputs_plus_10 = scipy.ndimage.interpolation.rotate(train_inputs.reshape(1, 4500), 10, cval=0.01,149 reshape=False)150 train_inputs_minus_10 = scipy.ndimage.interpolation.rotate(train_inputs.reshape(1, 4500), -10, cval=0.01,151 reshape=False)152153# 构建真实输出数组,除了⽬标位置是0.99,其他都是0.01154 train_targets = numpy.zeros(output_nodes) + 0.01155 code = all_values[0]156 train_targets[codes.index(code)] = 0.99157 n.train(train_inputs, train_targets)158 n.train(train_inputs_plus_10, train_targets)159 n.train(train_inputs_minus_10, train_targets)160pass161pass162 end = int(time.time())163print("训练⽤时=", end - start, "秒")164165# 测试数据166# test_data_file = open("web/mnist_dataset/mnist_test_10.csv")167# test_data_file = open("web/mnist_dataset/mnist_test.csv")168 test_data_file = open("web/test.csv")169 test_data_list = test_data_file.readlines()170 test_data_file.close()171# all_values = test_data_list[0].split(",")172# image_array = numpy.asfarray(all_values[1:]).reshape((28, 28))173# matplotlib.pyplot.imshow(image_array, cmap='Greys', interpolation='None')174#175# value = n.query((numpy.asfarray(all_values[1:]) / 255.0 * 0.99) + 0.01)176# print(value)177178# 统计分数179 scorecard = []180181print("开始测试...")182 start = int(time.time())183# 检查所有测试数据184for record in test_data_list:185 all_values = record.split(",")186# 正确答案187 correct_label = (all_values[0])188# print(correct_label, "正确答案")189190 verify_inputs = (numpy.asfarray(all_values[1:]) / 255.0 * 0.99) + 0.01191 verify_outputs = n.query(verify_inputs)192# print(verify_outputs)193 label = codes[numpy.argmax(verify_outputs)]194# print(label, "神经⽹络答案")195196if label == correct_label:197 scorecard.append(1)198else:199 scorecard.append(0)200pass201pass202 end = int(time.time())203print("检查⽤时=", end - start, "秒")204205# print(scorecard)206 scorecard_array = numpy.asarray(scorecard)207print("正确率=", scorecard_array.sum() / scorecard_array.size)208209 label = 0210# create the output signals for this label211 targets = numpy.zeros(output_nodes) + 0.01212# all_values[0] is the target label for this record213 targets[label] = 0.99214# print(targets)215216# get image data217 image_data = n.back_query(targets)218# print(image_data)219220# plot image data221 matplotlib.pyplot.imshow(image_data.reshape(45, 100), cmap='Greys', interpolation='None')制作训练和测试数据:1import csv2# import matplotlib.pyplot3import os4import cv256import numpy7import scipy.special8import string91011class NeuralNetwork:1213# 初始化神经⽹络14def__init__(self, inputnodes, hiddenodes, outputnodes, learningrate):15# 设置输⼊层、隐藏层、输出层的节点数16 self.inodes = inputnodes17 self.hnodes = hiddenodes18 self.onodes = outputnodes1920# 学习因⼦21 self.lr = learningrate2223# 输⼊层、隐藏层、输出层之间的链接权重24# self.wih = (numpy.random.rand(self.hnodes, self.inodes) - 0.5)25# self.who = (numpy.random.rand(self.onodes, self.inodes) - 0.5)26# 利⽤正态分布采样权重27 self.wih = numpy.random.normal(0.0, pow(self.hnodes, - 0.5), (self.hnodes, self.inodes))28 self.who = numpy.random.normal(0.0, pow(self.onodes, - 0.5), (self.onodes, self.hnodes)) 2930# S函数31 self.activation_function = lambda x: scipy.special.expit(x)32pass3335def train(self, inputs_list, targets_list):36# 输⼊层转矩阵37 inputs = numpy.array(inputs_list, ndmin=2).T38 targets = numpy.array(targets_list, ndmin=2).T3940# 隐藏层输⼊=权重点乘输⼊层矩阵41 hidden_inputs = numpy.dot(self.wih, inputs)42# 隐藏层应⽤S函数43 hidden_outputs = self.activation_function(hidden_inputs)4445# 输出层输⼊=权重点乘隐藏层输⼊矩阵46 final_inputs = numpy.dot(self.who, hidden_outputs)47# 输出层输⼊应⽤S函数48 final_outputs = self.activation_function(final_inputs)4950# 计算误差51 output_errors = targets - final_outputs;52# 计算隐藏层误差53 hidden_errors = numpy.dot(self.who.T, output_errors)54# 更新隐藏层和输出层之间的权重55 self.who += self.lr * numpy.dot((output_errors * final_outputs * (1.0 - final_outputs)),56 numpy.transpose(hidden_outputs))57# 更新输⼊层和隐藏层之间的权重58 self.wih += self.lr * numpy.dot((hidden_errors * hidden_outputs * (1.0 - hidden_outputs)),59 numpy.transpose(inputs))6061pass6263# 查询64def query(self, inputs_list):65# 输⼊层转矩阵66 inputs = numpy.array(inputs_list, ndmin=2).T6768# 隐藏层输⼊=权重点乘输⼊层矩阵69 hidden_inputs = numpy.dot(self.wih, inputs)70# 隐藏层应⽤S函数71 hidden_outputs = self.activation_function(hidden_inputs)7273# 输出层输⼊=权重点乘隐藏层输⼊矩阵74 final_inputs = numpy.dot(self.who, hidden_outputs)75# 输出层输⼊应⽤S函数76 final_outputs = self.activation_function(final_inputs)7778return final_outputs798081# 读取训练数据82def convert_img_to_csv(img_dir, csv_file):83# 设置需要保存的csv路径84 with open(r"web/" + csv_file + ".csv", "w", newline="") as f:85# 设置csv⽂件的列名86# column_name = ["label"]87# column_name.extend(["pixel%d" % i for i in range(32 * 32)])88# 将列名写⼊到csv⽂件中89 writer = csv.writer(f)90# writer.writerow(column_name)91# 该⽬录下有9个⽬录,⽬录名从0-992# for i in range(1):93# 获取⽬录的路径94# img_temp_dir = os.path.join(img_dir, str(i))95# 获取该⽬录下所有的⽂件96 img_list = os.listdir(img_dir)97# 遍历所有的⽂件名称98for img_name in img_list:99# 判断⽂件是否为⽬录,如果为⽬录则不处理100if not os.path.isdir(img_name):101# 获取图⽚的路径102 img_path = os.path.join(img_dir, img_name)103# 因为图⽚是⿊⽩的,所以以灰⾊读取图⽚104 img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)105# 图⽚标签106 row_data = [img_name[0]]107# 获取图⽚的像素108 ary = 255.0 - img.flatten()109 row_data.extend(ary)110# 将图⽚数据写⼊到csv⽂件中111 writer.writerow(row_data)112113114def split_image(img_dir, save_path):115 image_save_path_tail = ".jpg"116# 获取该⽬录下所有的⽂件117 img_list = os.listdir(img_dir)119# 遍历所有的⽂件名称120for img_name in img_list:121# 判断⽂件是否为⽬录,如果为⽬录则不处理122if not os.path.isdir(img_name):123# 获取图⽚的路径124 img_path = os.path.join(img_dir, img_name)125# 因为图⽚是⿊⽩的,所以以灰⾊读取图⽚126 src_img = cv2.imread(img_path, cv2.IMREAD_GRAYSCALE)127# print(src_img)128# 180*100129for i in range(4): # [1]480*360==15*11---height130 img_roi = src_img[0:100, (i * 45):((i + 1) * 45)]131 image_save_path = "%s%s%s%d%s" % (save_path, img_name[(-8 + i)], "_", seq, image_save_path_tail) 132 cv2.imwrite(image_save_path, img_roi)133 seq = seq + 1134pass135pass136137138if__name__ == "__main__":139# 将该⽬录下的图⽚保存为csv⽂件140# convert_img_to_csv("web/unknownCode", "train-single")141# convert_img_to_csv("web/train-single", "train")142# convert_img_to_csv("web/test-single", "test")143# a = list(string.digits + string.ascii_lowercase)144145# print(ord(a[10]))146# print(a.index("a"))147148# ⼀张图⽚切四张149# split_image("web/train/", "web/train-single/")150# convert_img_to_csv("web/train-single", "train")151 split_image("web/unknownCode/", "web/test-single/")152 convert_img_to_csv("web/test-single", "test")153pass。

卷积神经⽹络概述及python实现原⽂链接:摘要:本⽂概括地介绍CNN的基本原理,并通过阿拉伯字母分类例⼦具体介绍其实现过程,理论与实践的结合体。

对于卷积神经⽹络(CNN)⽽⾔,相信很多读者并不陌⽣,该⽹络近年来在⼤多数领域都表现优异,尤其是在计算机视觉领域中。

但是很多⼯作⼈员可能直接调⽤相关的深度学习⼯具箱搭建卷积神经⽹络模型,并不清楚其中具体的原理。

本⽂将简单介绍卷积神经⽹络(CNN),⽅便读者⼤体上了解其基本原理及实现过程,便于后续⼯作中的实际应⽤。

本⽂将按以下顺序展开:了解卷积操作了解神经⽹络数据预处理了解CNN了解优化器理解 ImageDataGenerator进⾏预测并计算准确性demo什么是卷积?在数学(尤其是函数分析)中,卷积是对两个函数(f和g)的数学运算,以产⽣第三个函数,该函数表⽰⼀个函数的形状如何被另⼀个修改。

此操作在多个领域都有应⽤,如概率、统计、计算机视觉、⾃然语⾔处理、图像和信号处理、⼯程和微分⽅程。

该操作在数学上表⽰为:卷积操作查看以更加直观地了解卷积操作。

什么是⼈⼯神经⽹络?⼈⼯神经⽹络(ANN)或连接系统是由构成动物⼤脑的⽣物神经⽹络模糊地启发的计算系统。

这些系统通过从⽰例中“学习”以执⾏任务,通常不需要使⽤⽤任何特定规则来编程。

(来源:维基百科)⼈⼯神经⽹络是⼀个较⼩的处理单元集合,称为⼈⼯神经元,它们与⽣物神经元相似。

⽣物神经回路⽣物神经回路神经元之间的互联构成了⼀个⽹络模型⼈⼯神经⽹络⼈⼯神经⽹络现在,我们开始具体实现。

导⼊必要的数据包import numpy as npimport pandas as pdimport matplotlib.pyplot as pltimport seaborn as snsimport tflearn.data_utils as dufrom keras.models import Sequentialfrom yers import Dense, Dropout, Flatten, Conv2D, MaxPool2Dfrom keras.optimizers import RMSpropfrom keras.preprocessing.image import ImageDataGeneratorfrom sklearn.metrics import confusion_matrix加载数据集train_data = pd.read_csv('../input/csvTrainImages 13440x1024.csv', header = None)train_label = pd.read_csv('../input/csvTrainLabel 13440x1.csv', header = None)test_data = pd.read_csv('../input/csvTestImages 3360x1024.csv', header = None)test_label = pd.read_csv('../input/csvTestLabel 3360x1.csv', header = None)数据集此处使⽤的数据集是。

在学习神经网络之前,我们需要对神经网络底层先做一个基本的了解。

我们将在本节介绍感知机、反向传播算法以及多种梯度下降法以给大家一个全面的认识。

一、感知机数字感知机的本质是从数据集中选取一个样本(example),并将其展示给算法,然后让算法判断“是”或“不是”。

一般而言,把单个特征表示为xi,其中i是整数。

所有特征的集合表示为,表示一个向量:,类似地,每个特征的权重表示为其中对应于与该权重关联的特征的下标,所有权重可统一表示为一个向量:这里有一个缺少的部分是是否激活神经元的阈值。

一旦加权和超过某个阈值,感知机就输出1,否则输出0。

我们可以使用一个简单的阶跃函数(在图5-2中标记为“激活函数”)来表示这个阈值。

一般而言我们还需要给上面的阈值表达式添加一个偏置项以确保神经元对全0的输入具有弹性,否则网络在输入全为0的情况下输出仍然为0。

注:所有神经网络的基本单位都是神经元,基本感知机是广义神经元的一个特例,从现在开始,我们将感知机称为一个神经元。

二、反向传播算法2.1 代价函数很多数据值之间的关系不是线性的,也没有好的线性回归或线性方程能够描述这些关系。

许多数据集不能用直线或平面来线性分割。

比如下图中左图为线性可分的数据,而右图为线性不可分的数据:在这个线性可分数据集上对两类点做切分得到的误差可以收敛于0,而对于线性不可分的数据点集,我们无法做出一条直线使得两类点被完美分开,因此我们任意做一条分割线,可以认为在这里误差不为0,因此我们需要一个衡量误差的函数,通常称之为代价函数:而我们训练神经网络(感知机)的目标是最小化所有输入样本数据的代价函数2.2 反向传播权重通过下一层的权重()和()来影响误差,因此我们需要一种方法来计算对误差的贡献,这个方法就是反向传播。

下图中展示的是一个全连接网络,图中没有展示出所有的连接,在全连接网络中,每个输入元素都与下一层的各个神经元相连,每个连接都有相应的权重。

因此,在一个以四维向量为输入、有5个神经元的全连接神经网络中,一共有20个权重(5个神经元各连接4个权重)。

感知机的每个输入都有一个权重,第二层神经元的权重不是分配给原始输入的,而是分配给来自第一层的各个输出。

从这里我们可以看到计算第一层权重对总体误差的影响的难度。

第一层权重对误差的影响并不是只来自某个单独权重,而是通过下一层中每个神经元的权重来产生的。

反向传播的推导过程较为复杂,这里仅简单展示其结果:如果该层是输出层,借助于可微的激活函数,权重的更新比较简单, 对于第个输出,误差的导数如下如果要更新隐藏层的权重,则会稍微复杂一点儿:函数表示实际结果向量,表示该向量第个位置上的值,,是倒数第二层第个节点和输出第个节点的输出,连接这两个节点的权重为,误差代价函数对求导的结果相当于用(学习率)乘以前一层的输出再乘以后一层代价函数的导数。

公式中表示层第个节点上的误差项,前一层第个节点到层所有的节点进行加权求和。

2.3 多种梯度下降法到目前为止,我们一直是把所有训练样本的误差聚合起来然后再做梯度下降,这种训练方法称为批量学习(batch learning)。

一批是训练数据的一个子集。

但是在批量学习中误差曲面对于整个批是静态的,如果从一个随机的起始点开始,得到的很可能是某个局部极小值,从而无法看到其他的权重值的更优解。

这里有两种方法来避开这个陷阱。

第一种方法是随机梯度下降法。

在随机梯度下降中,不用去查看所有的训练样本,而是在输入每个训练样本后就去更新网络权重。

在这个过程中,每次都会重新排列训练样本的顺序,这样将为每个样本重新绘制误差曲面,由于每个相异的输入都可能有不同的预期答案,因此大多数样本的误差曲面都不一样。

对每个样本来说,仍然使用梯度下降法来调整权重。

不过不用像之前那样在每个训练周期结束后聚合所有误差再做权重调整,而是针对每个样本都会去更新一次权重。

其中的关键点是,每一步都在向假定的极小值前进(不是所有路径都通往假定的极小值)。

使用正确的数据和超参数,在向这个波动误差曲面的各个最小值前进时,可以更容易地得到全局极小值。

如果模型没有进行适当的调优,或者训练数据不一致,将导致原地踏步,模型无法收敛,也学不会任何东西。

不过在实际应用中,随机梯度下降法在大多数情况下都能有效地避免局部极小值。

这种方法的缺点是计算速度比较慢。

计算前向传播和反向传播,然后针对每个样本进行权重更新,这在本来已经很慢的计算过程的基础上又增加了很多时间开销。

第二种方法,也是更常见的方法,是小批量学习。

在小批量学习中,会传入训练集的一个小的子集,并按照批量学习中的误差聚合方法对这个子集对应的误差进行聚合。

然后对每个子集按批将其误差进行反向传播并更新权重。

下一批会重复这个过程,直到训练集处理完成为止,这就重新构成了一个训练周期。

这是一种折中的办法,它同时具有批量学习(快速)和随机梯度下降(具有弹性)的优点。

三、Keras:用Python实现神经网络用原生Python来编写神经网络是一个非常有趣的尝试,而且可以帮助大家理解神经网络中的各种概念,但是Python在计算速度上有明显缺陷,即使对于中等规模的网络,计算量也会变得非常棘手。

不过有许多Python 库可以用来提高运算速度,包括PyTorch、Theano、TensorFlow和Lasagne等。

本书中的例子使用Keras。

Keras是一个高级封装器,封装了面向Python的API。

API接口可以与3个不同的后端库相兼容:Theano、谷歌的TensorFlow和微软的CNTK。

这几个库都在底层实现了基本的神经网络单元和高度优化的线性代数库,可以用于处理点积,以支持高效的神经网络矩阵乘法运算。

我们以简单的异或问题为例,看看如何用Keras来训练这个网络。

import numpy as npfrom keras.models import Sequential# Kera的基础模型类from yers import Dense, Activation# Dense是神经元的全连接层from keras.optimizers import SGD# 随机梯度下降,Keras中还有一些其他优化器# Our examples for an exclusive OR.x_train = np.array([[0, 0],[0, 1],[1, 0],[1, 1]]) # x_train是二维特征向量表示的训练样本列表y_train = np.array([[0],[1],[1],[0]]) # y_train是每个特征向量样本对应的目标输出值model = Sequential()num_neurons = 10#全连接隐藏层包含10个神经元model.add(Dense(num_neurons, input_dim=2)) # input_dim仅在第一层中使用,后面的其他层会自动计算前一层输出的形状,这个例子中输入的XOR样本是二维特征向量,因此input_dim设置为2model.add(Activation('tanh'))model.add(Dense(1)) #输出层包含一个神经元,输出结果是二分类值(0或1)model.add(Activation('sigmoid'))model.summary()可以看到模型的结构为:Layer (type) Output Shape Param=================================================================dense_18 (Dense) (None, 10) 30_________________________________________________________________activation_6 (Activation) (None, 10) 0_________________________________________________________________dense_19 (Dense) (None, 1) 11_________________________________________________________________activation_7 (Activation) (None, 1) 0=================================================================Total params: 41.0Trainable params: 41.0Non-trainable params: 0.0model.summary()提供了网络参数及各阶段权重数(Param \#)的概览。

我们可以快速计算一下:10个神经元,每个神经元有3个权重,其中有两个是输入向量的权重(输入向量中的每个值对应一个权重),还有一个是偏置对应的权重,所以一共有30个权重需要学习。

输出层中有10个权重,分别与第一层的10个神经元一一对应,再加上1个偏置权重,所以该层共有11个权重。

下面的代码可能有点儿不容易理解:sgd = SGD(lr=0.1)pile(loss='binary_crossentropy',optimizer=sgd, metrics=['accuracy'])SGD是之前导入的随机梯度下降优化器,模型用它来最小化误差或者损失。

lr是学习速率,与每个权重的误差的导数结合使用,数值越大模型的学习速度越快,但可能会使模型无法找到全局极小值,数值越小越精确,但会增加训练时间,并使模型更容易陷入局部极小值。

损失函数本身也定义为一个参数,在这里用的是binary_crossentropy。

metrics参数是训练过程中输出流的选项列表。

用compile方法进行编译,此时还未开始训练模型,只对权重进行了初始化,大家也可以尝试一下用这个随机初始状态来预测,当然得到的结果只是随机猜测:model.predict(x_train)[[ 0.5 ][ 0.43494844][ 0.50295198][ 0.42517585]]predict方法将给出最后一层的原始输出,在这个例子中是由sigmoid函数生成的。

之后再没什么好写的了,但是这里还没有关于答案的任何知识,它只是对输入使用了随机权重。

接下来可以试着进行训练。

model.fit(x_train, y_train, epochs=100) #从这里开始训练模型Epoch 1/1004/4 [==============================] - 0s - loss: 0.6917 - acc: 0.7500Epoch 2/1004/4 [==============================] - 0s - loss: 0.6911 - acc: 0.5000Epoch 3/1004/4 [==============================] - 0s - loss: 0.6906 - acc: 0.5000...Epoch 100/1004/4 [==============================] - 0s - loss: 0.6661 - acc: 1.0000提示在第一次训练时网络可能不会收敛。