一元线性回归-方差分析-显著性分析

- 格式:docx

- 大小:77.32 KB

- 文档页数:5

方差分析与回归分析的原理方差分析和回归分析是统计学中常用的两种数据分析方法,它们都用于研究变量之间的相互关系,但是基于不同的背景和目的,其原理和应用也有所不同。

首先,我们来了解一下方差分析。

方差分析是一种用于比较两个或多个群体均值差异的统计方法。

它基于对总体方差的分解来分析不同因素对群体之间差异的贡献程度。

具体来说,方差分析将总体方差分解为组内变异和组间变异两部分,然后通过计算F统计量来判断组间变异是否显著大于组内变异。

方差分析可以用于很多场景,比如医疗研究中分析不同药物对疾病治疗效果的差异、教育研究中比较不同教学方法对学生成绩的影响等。

在进行方差分析时,需要明确一个自变量(也称为因素或处理)和一个因变量(也称为响应变量)。

自变量是被研究者主动操作或选择的变量,而因变量是根据自变量的不同取值而发生变化的变量。

方差分析的基本原理是通过对不同组之间的变异进行比较,来判断组间是否存在统计显著差异。

方差分析的核心思想是使用F统计量来判断组间变异与组内变异的比例是否显著大于1。

通过计算F值并与临界值进行比较,可以得出结论是否存在显著差异。

如果F值大于临界值,则可以拒绝原假设,表明不同组之间存在显著差异;如果F值小于临界值,则接受原假设,认为组间差异不显著。

接下来,我们来了解一下回归分析。

回归分析是统计学中用于研究变量之间关系的一种方法。

它研究的是一个或多个自变量对因变量的影响程度和方向。

回归分析可以用于预测未来趋势、解释变量之间的关系、探究因果关系以及确定主要影响因素等。

回归分析分为线性回归和非线性回归两种。

线性回归是最常用的一种回归方法,它假设自变量与因变量之间存在线性关系。

以一元线性回归为例,我们假设因变量Y可以用一个自变量X的线性函数来表示,即Y = β0 + β1X + ε,其中β0和β1是回归系数,ε是误差项,代表了未被自变量解释的因素。

通常,回归分析的目标是估计出回归系数的值,并利用这些系数来解释因变量与自变量之间的关系。

回归方程的显著性检验回归方程的显著性检验的目的是对回归方程拟合优度的检验。

F检验法是英国统计学家Fisher提出的,主要通过比较两组数据的方差S2,以确定他们的精密度是否有显著性差异。

回归方程显著性检验具体方法为:由于y的偏差是由两个因素造成的,一是x变化所引起反应在S回中,二是各种偶然因素干扰所致S残中。

将回归方程离差平方和S回同剩余离差平方和S残加以比较,应用F检验来分析两者之间的差别是否显著。

如果是显著的,两个变量之间存在线性关系;如果不显著,两个变量不存在线性相关关系。

n个观测值之间存在着差异,我们用观测值yi与其平均值的偏差平方和来表示这种差异程度,称其为总离差平方和,记为由于所以式中称为回归平方和,记为S回。

称为残差平方和,记为。

不难证明,最后一项。

因此S总=S回+S残上式表明,y的偏差是由两个因素造成的,一是x变化所引起,二是各种偶然因素干扰所致。

事实上,S回和S残可用下面更简单的关系式来计算。

具体检验可在方差分析表上进行。

这里要注意S回的自由度为1,S残的自由度为n-2,S总的自由度为n-1。

如果x与y有线性关系,则其中,F(1,n-2)表示第一自由度为1,第二自由度为n-2的分布。

在F表中显著性水平用表示,一般取0.10,0.05,0.01,1-表示检验的可靠程度。

在进行检验时,F值应大于F表中的临界值Fα。

若F<0.05(1,n-2),则称x与y 没有明显的线性关系,若F0.05(1,n-2)<F<F0.01(1,n-2),则称x与y有显著的线性关系;若F>F0.01(1,n-2),则称x与y有十分显著的线性关系。

当x与y有显著的线性关系时,在表2-1-2的显著性栏中标以〝*〞;当x与y有十分显著的线性关系时,标以〝**〞。

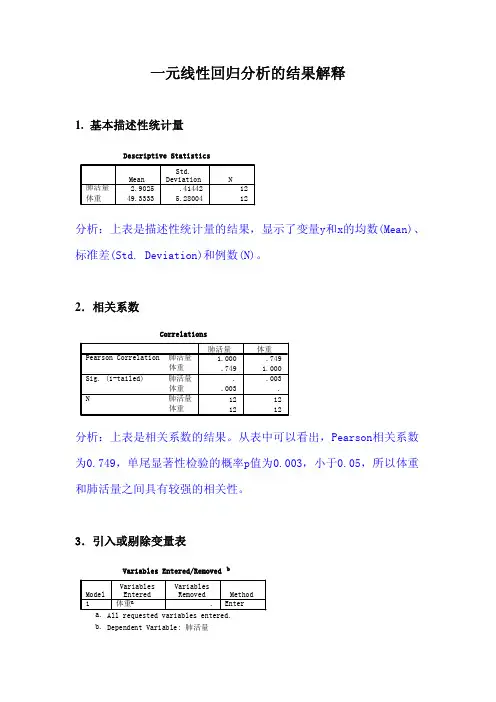

一元线性回归分析的结果解释1.基本描述性统计量分析:上表是描述性统计量的结果,显示了变量y和x的均数(Mean)、标准差(Std. Deviation)和例数(N)。

2.相关系数分析:上表是相关系数的结果。

从表中可以看出,Pearson相关系数为0.749,单尾显著性检验的概率p值为0.003,小于0.05,所以体重和肺活量之间具有较强的相关性。

3.引入或剔除变量表分析:上表显示回归分析的方法以及变量被剔除或引入的信息。

表中显示回归方法是用强迫引入法引入变量x的。

对于一元线性回归问题,由于只有一个自变量,所以此表意义不大。

4.模型摘要分析:上表是模型摘要。

表中显示两变量的相关系数(R)为0.749,判定系数(R Square)为0.562,调整判定系数(Adjusted R Square)为0.518,估计值的标准误差(Std. Error of the Estimate)为0.28775。

5.方差分析表分析:上表是回归分析的方差分析表(ANOVA)。

从表中可以看出,回归的均方(Regression Mean Square)为1.061,剩余的均方(Residual Mean Square)为0.083,F检验统计量的观察值为12.817,相应的概率p 值为0.005,小于0.05,可以认为变量x和y之间存在线性关系。

6.回归系数分析:上表给出线性回归方程中的参数(Coefficients)和常数项(Constant)的估计值,其中常数项系数为0(注:若精确到小数点后6位,那么应该是0.000413),回归系数为0.059,线性回归参数的标准误差(Std. Error)为0.016,标准化回归系数(Beta)为0.749,回归系数T检验的t统计量观察值为3.580,T检验的概率p值为0.005,小于0.05,所以可以认为回归系数有显著意义。

由此可得线性回归方程为:y=0.000413+0.059x7.回归诊断分析:上表是对全部观察单位进行回归诊断(CasewiseDiagnostics-all cases)的结果显示。

一元线性回归在公司加班制度中的应用院(系):专业班级:学号姓名:指导老师:成绩:完成时间:一元线性回归在公司加班制度中的应用一、实验目的掌握一元线性回归分析的基本思想和操作,可以读懂分析结果,并写出回归方程,对回归方程进行方差分析、显著性检验等的各种统计检验 二、实验环境SPSS21.0 windows10.0 三、实验题目一家保险公司十分关心其总公司营业部加班的程度,决定认真调查一下现状。

经10周时间,收集了每周加班数据和签发的新保单数目,x 为每周签发的新保单数目,y 为每周加班时间(小时),数据如表所示y3.51.04.02.01.03.04.51.53.05.01. 画散点图。

2. x 与y 之间大致呈线性关系?3. 用最小二乘法估计求出回归方程。

4. 求出回归标准误差σ∧。

5. 给出0β∧与1β∧的置信度95%的区间估计。

6. 计算x 与y 的决定系数。

7. 对回归方程作方差分析。

8. 作回归系数1β∧的显著性检验。

9. 作回归系数的显著性检验。

10.对回归方程做残差图并作相应的分析。

11.该公司预测下一周签发新保单01000x =张,需要的加班时间是多少?12.给出0y的置信度为95%的精确预测区间。

13.给出()E y的置信度为95%的区间估计。

四、实验过程及分析1.画散点图如图是以每周加班时间为纵坐标,每周签发的新保单为横坐标绘制的散点图,从图中可以看出,数据均匀分布在对角线的两侧,说明x和y之间线性关系良好。

2.最小二乘估计求回归方程用SPSS 求得回归方程的系数01,ββ分别为0.118,0.004,故我们可以写出其回归方程如下:0.1180.004y x =+3.求回归标准误差σ∧由方差分析表可以得到回归标准误差:SSE=1.843 故回归标准误差:2=2SSEn σ∧-,2σ∧=0.48。

4.给出回归系数的置信度为95%的置信区间估计。

由回归系数显著性检验表可以看出,当置信度为95%时:0β∧的预测区间为[-0.701,0.937], 1β∧的预测区间为[0.003,0.005].0β∧的置信区间包含0,表示0β∧不拒绝为0的原假设。

年份自变量数据xi应变量数据yi2006 1.681 2.837.502007 1.886 3.568.502008 1.931 3.7311.002009 2.028 4.1113.452010 2.274 5.1715.322011 2.435 5.9316.222012 2.523 6.3717.132013 2.599 6.7519.002014 2.614 6.8321.0120152.8358.0422.12y=-14.225+12.869x回归检验年份应变量统计数据yi 应变量模拟数据偏差平方20067.57.4158.1420078.510.0543.8920081110.6317.02200913.4511.87 2.81201015.3215.040.04201116.2217.11 1.20201217.1318.24 4.022*******.2215.02201421.0119.4234.63201522.1222.2648.93偏差平方和TSS225.69可决系数年份自变量数据xi应变量数据yi2006 1.687.50-0.6002007 1.898.50-0.39520081.9311.00-0.350一元线性回归模型方程1、方差分析2、相关系数检验2009 2.0313.45-0.2532010 2.2715.32-0.0072011 2.4416.220.1542012 2.5217.130.2422013 2.6019.000.3182014 2.6121.010.3332015 2.8422.120.554相关系数临界值年份自变量数据xi应变量数据yi应变量模拟数据2006 1.687.507.412007 1.898.5010.052008 1.9311.0010.632009 2.0313.4511.872010 2.2715.3215.042011 2.4416.2217.112012 2.5217.1318.242013 2.6019.0019.222014 2.6121.0119.4220152.8422.1222.26显著性检验参数回归标准差Sy3、t检验参数b的标准差Sb判断参数年份自变量数据xi 应变量数据yi2006 1.687.502007 1.898.502008 1.9311.002009 2.0313.452010 2.2715.322011 2.4416.222012 2.5217.132013 2.6019.002014 2.6121.012015 2.8422.12自变量变化条件2016 3.032017 3.252018 3.472019 3.7220203.9836.945y=-14.225+12.869x区间预测32.317查t分布表的显著性水平的数值t(a/2,n-2)4、点预测与区间预测12.6122.806151.25053.31516.0321.2427.2834.8439.50 2.28143.2249.3854.9262.7159.540.00825.79 2.39220.240.14010.57 2.4830.010.0783.950.7969.73 1.24216.790.05018.412.54250.910.020回归平方和RSS残差平方和ESS215.949.750.0095.68%应变量偏差自变量与应变量偏差应变量偏差平方4.5720.36058.141-6.625 2.6140.15643.891-4.1251.4420.12217.016应变量y可以用自变量x来解释的百分-1.6750.4230.064 2.8060.195-0.0010.0000.0381.0950.1690.024 1.1992.0050.4860.059 4.0203.875 1.2340.10115.0165.885 1.9620.11134.6336.995 3.8780.30748.93016.779 1.304225.6880.978判断结果0.6320.010.3602.390.1560.140.1222.480.0640.080.0000.800.0241.240.0590.050.1012.540.1110.020.307n a 9.75 1.30100.0513.310判断结果1.219表明回归系数显著性不条件:自由度(n-2)和显著性水平a(一般取a-0.05)下的查表值变量x与y之间的0.96702.306年增长速度为7%2.87541.574结论有95%的可能性在(32.32,41.57)的区间内2.0072.306性水平为a,自由度为n-2的数值t(a/2,n-2)361.72012.869-14.225的百分比为95.68%变量x和y正相关之间的线性关系成立著性不为0,参数t通过检验。

从统计学看线性回归(2)——⼀元线性回归⽅程的显著性检验⽬录1. σ2 的估计2. 回归⽅程的显著性检验 t 检验(回归系数的检验) F 检验(回归⽅程的检验) 相关系数的显著性检验 样本决定系数 三种检验的关系⼀、σ2 的估计 因为假设检验以及构造与回归模型有关的区间估计都需要σ2的估计量,所以先对σ2作估计。

通过残差平⽅和(误差平⽅和)(1)(⽤到和,其中)⼜∵(2)∴(3)其中为响应变量观测值的校正平⽅和。

残差平⽅和有n-2 个⾃由度,因为两个⾃由度与得到的估计值与相关。

(4)(公式(4)在《线性回归分析导论》附录C.3有证明)∴σ2的⽆偏估计量:(5)为残差均⽅,的平⽅根称为回归标准误差,与响应变量y 具有相同的单位。

因为σ2取决于残差平⽅和,所以任何对模型误差假设的违背或对模型形式的误设都可能严重破坏σ2的估计值的实⽤性。

因为由回归模型残差算得,称σ2的估计值是模型依赖的。

⼆、回归⽅程的显著性检验 ⽬的:检验是否真正描述了变量 y 与 x 之间的统计规律性。

假设:正态性假设(⽅便检验计算)1. t 检验 ⽤t 检验来检验回归系数的显著性。

采⽤的假设如下:原假设 H0:β1 = 0 (x 与 y 不存在线性关系)对⽴假设 H1:β1 ≠ 0 回归系数的显著性检验就是要检验⾃变量 x 对因变量 y 的影响程度是否显著。

下⾯我们分析接受和拒绝原假设的意义。

(1)接受 H0:β1 = 0 (x 与 y 不存在线性关系) 此时有两种情况,⼀种是⽆论 x 取值如何, y 都在⼀条⽔平线上下波动,即,如下图1,另⼀种情况为, x 与 y 之间存在关系,但不是线性关系,如图2。

图 1图 2 (2)拒绝 H0:β1 = 0 (x 对解释 y 的⽅差是有⽤的) 拒绝原假设也有两种情况,⼀种是直线模型就是合适的,如图 3,另⼀种情况为存在 x 对 y 的线性影响,也可通过 x 的⾼阶多项式得到更好的结果,如图 4。

一、一元线性回归(一)基本公式如果预测对象与主要影响因素之间存在线性关系,将预测对象作为因变量y,将主要影响因素作为自变量x,即引起因变量y变化的变量,则它们之间的关系可以用一元回归模型表示为如下形式:y=a+bx+e其中:a和b是揭示x和y之间关系的系数,a为回归常数,b为回归系数e是误差项或称回归余项。

对于每组可以观察到的变量x,y的数值xi,yi,满足下面的关系:yi =a+bxi+ei其中ei是误差项,是用a+bxi去估计因变量yi的值而产生的误差。

在实际预测中,ei是无法预测的,回归预测是借助a+bxi得到预测对象的估计值yi。

为了确定a和b,从而揭示变量y与x之间的关系,公式可以表示为:y=a+bx公式y=a+bx是式y=a+bx+e的拟合曲线。

可以利用普通最小二乘法原理(ols)求出回归系数。

最小二乘法基本原则是对于确定的方程,使观察值对估算值偏差的平方和最小。

由此求得的回归系数为:b=[∑xiyi—x∑yi]/∑xi2—x∑xia=-b式中:xi、yi分别是自变量x和因变量y的观察值,、分别为x和y的平均值.=∑xi/ n ; = ∑yi/ n对于每一个自变量的数值,都有拟合值:yi’=a+bxiyi’与实际观察值的差,便是残差项ei=yi一yi’(二)一元回归流程三)回归检验在利用回归模型进行预测时,需要对回归系数、回归方程进行检验,以判定预测模型的合理性和适用性。

检验方法有方差分析、相关检验、t检验、f检验。

对于一元回归,相关检验与t检验、f检验的效果是等同的,因此,在一般情况下,通过其中一项检验就可以了。

对于多元回归分析,t检验与f检验的作用却有很大的差异。

1.方差分析通过推导,可以得出:∑(yi—y-)2= ∑(yi—yi’)2+∑(yi—y-)2其中:∑(yi—y-)2=tss,称为偏差平方和,反映了n个y值的分散程度,又称总变差。

∑(yi—yi’)2=rss,称为回归平方和,反映了x对y线性影响的大小,又称可解释变差。

线性回归与方差分析线性回归和方差分析是统计学中常用的两种数据分析方法。

虽然它们在数据处理和分析的角度有所不同,但都有助于我们理解变量之间的关系,从而做出科学的推断和预测。

本文将就线性回归和方差分析进行深入探讨。

一、线性回归线性回归是一种用于建立两个或多个变量之间关系的统计模型的方法。

它通过拟合最佳拟合直线,以便预测一个变量(因变量)与一个或多个其他变量(自变量)之间的关系。

对于简单线性回归,我们考虑一个自变量和一个因变量的情况。

我们使用最小二乘法来找到最佳拟合直线,以使预测值与实际观测值的误差平方和最小化。

最佳拟合直线可以通过回归方程来表示,其中自变量和系数之间存在线性关系。

例如,假设我们想研究身高与体重之间的关系。

我们可以收集一组数据,其中身高是自变量,体重是因变量。

通过拟合最佳拟合直线,我们可以预测给定身高的人的体重。

二、方差分析方差分析是一种用于比较三个或更多组之间差异的统计方法。

它将观测值的总变异分解为组内变异和组间变异,以确定组间的差异是否显著。

在方差分析中,我们将一组观测值分成几个组,并计算每个组的观测值的平均值。

然后,我们计算总平均值,以检查组间和组内的差异。

如果组间差异显著大于组内差异,我们可以得出结论认为不同组之间存在显著差异。

例如,假设我们想研究不同施肥处理对植物生长的影响。

我们将植物分成几个组,分别施用不同类型的肥料。

通过测量植物生长的指标(如高度或质量),我们可以使用方差分析来比较各组之间的差异。

三、线性回归与方差分析的联系尽管线性回归和方差分析是两种不同的统计方法,但它们在某些方面也存在联系。

首先,线性回归可以被视为方差分析的特例。

当我们只有一个自变量时,线性回归与方差分析的目标是相同的,即确定因变量与自变量之间的关系。

因此,我们可以将简单线性回归模型看作是方差分析的一种形式。

其次,线性回归和方差分析都涉及到模型建立和参数估计。

线性回归通过拟合回归方程来建立模型,并估计回归系数。

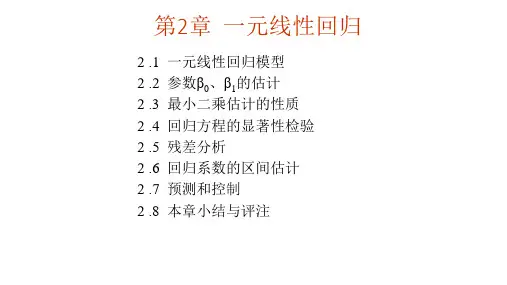

第二节 一元线性回归分析回归是分析变量之间关系类型的方法,按照变量之间的关系,回归分析分为:线性回归分析和非线性回归分析。

本节研究的是线性回归,即如何通过统计模型反映两个变量之间的线性依存关系。

回归分析的主要内容:1. 从样本数据出发,确定变量之间的数学关系式;2. 估计回归模型参数;3. 对确定的关系式进行各种统计检验,并从影响某一特定变量的诸多变量中找出影响显著的变量。

一、一元线性回归模型:一元线性模型是指两个变量x 、y 之间的直线因果关系。

(一)理论回归模型:εββ++=x y 10理论回归模型中的参数是未知的,但是在观察中我们通常用样本观察值),(i i y x 估计参数值10,ββ,通常用10,b b 分别表示10,ββ的估计值,即称回归估计模型:x b b y10ˆ+= 二、模型参数估计:用最小二乘法估计10,b b :⎪⎩⎪⎨⎧-=--=∑∑∑∑∑xb y b x x n y x xy n b 10221)( 三.回归系数的含义(2)回归方程中的两个回归系数,其中b0为回归直线的启动值,在相关图上变现为x=0时,纵轴上的一个点,称为y 截距;b1是回归直线的斜率,它是自变量(x )每变动一个单位量时,因变量(y )的平均变化量。

(3)回归系数b1的取值有正负号。

如果b1为正值,则表示两个变量为正相关关系,如果b1为负值,则表示两个变量为负相关关系。

四.回归方程的评价与检验:当我们得到一个实际问题的经验回归方程后,还不能马上就进行分析与预测等应用,在应用之前还需要运用统计方法对回归方程进行评价与检验。

进行评价与检验主要是基于以下理由:第一,在利用样本数据估计回归模型时,首先是假设变量y 与x 之间存在着线性关系,但这种假设是否存在需要进行检验;第二,估计的回归方程是否真正描述了变量y 与x 之间的统计规律性,y 的变化是否通过模型中的解释变量去解释需要进行检验等。

一般进行检验的内容有:1.经济意义的检验:利用相关的经济学原理及我们所积累的丰富的经验,对所估计的回归方程的回归系数进行分析与判断,看其能否得到合理的解释。

一元线性回归分析及方差分析与显著性检验

某位移传感器的位移x 与输出电压y 的一组观测值如下:(单位略)

设x 无误差,求y 对x 的线性关系式,并进行方差分析与显著性检验。

(附:F 0。

10(1,4)=4.54,F 0。

05(1,4)=7.71,F 0。

01(1,4)=21.2)

回归分析是研究变量之间相关关系的一种统计推断法。

一. 一元线性回归的数学模型

在一元线性回归中,有两个变量,其中 x 是可观测、可控制的普通变量,常称它为自变量或控制变量,y 为随机变量,常称其为因变量或响应变量。

通过散点图或计算相关系数判定y 与x 之间存在着显著的线性相关关系,即y 与x 之间存在如下关系:

y =a +b ∗x +ε (1)

通常认为ε~N (0,δ2)且假设δ2与x 无关。

将观测数据(x i ,y i ) (i=1,……,n)代入(1)再注意样本为简单随机样本得:

{y i =a +b ∗x i +εi

ε1⋯εn 独立同分布N (0,σ2)

(2) 称(1)或(2)(又称为数据结构式)所确定的模型为一元(正态)线性回归模型。

对其进行统计分析称为一元线性回归分析。

模型(2)中 EY= a +b ∗x ,若记 y=E(Y),则 y=a+bx,就是所谓的一元线性回归方程,其图象就是回归直线,b 为回归系数,a 称为回归常数,有时也通称 a 、b 为回归系数。

设得到的回归方程

根据最小二乘原理可求得回归系数b 0和b 。

对照第五章最小二乘法的矩阵形式,令

⎪⎪⎪⎪⎪⎭

⎫ ⎝⎛=⎪

⎪⎭

⎫

⎝⎛=⎪⎪⎪⎪⎪⎭

⎫

⎝⎛=⎪⎪⎪

⎪⎪⎭⎫ ⎝⎛=v v v V b b b x x x X y y y Y 2102121ˆ111

则误差方程的矩阵形式为

对照X A L V -=,设测得值

Y X X X b T T 1)(-=

将测得值分别代入上式,可计算得

,)()

)((2

2

1

1

1

xx

xy N

t N t t t t t t t t l l x x N y x y x N b =

--=

∑∑∑∑∑===x b y x x N y x x y x b N N

t t t t t t t t t t t -=--=

∑∑∑∑∑∑====2

21

111

2

0)()

)(())((

其中

2

2

2

1

1112

11

2

12

1

1)(1)()

)((1)()()(1)(1∑∑∑∑∑∑∑∑∑∑∑∑=========-=-=-=--=-=-==

=

N

t N N

t t yy N

t t N

t t N

t t t t N

t t xy N

t t N

t t N

t t xx N t t

t t

y y y y l y x N y x y y x x l x N x x x l y

N

y x

N x

二、回归方程的方差分析及显著性检验

问题:这条回归直线是否符合y 与x 之间的客观规律回归直线的预报精度如何?

解决办法:

方差分析法—分解N 个观测值与其算术平均值之差的平方和;从量值上区别多个影响因素;用F 检验法对所求回归方程进行显著性检验。

(一)回归方程的方差分析

总的离差平方和(即N 个观测值之间的变差)

∑=-=yy t l y y S 2)(可以证明:

S=U+Q

其中

∑=-=xy t bl y y U 2)(xy yy t t bl l y

y Q -=-=∑2)ˆ(,Q U —回归平方和,反映总变差中由于x 和y 的线性关系而引起 y 变化的部分。

Q —残余平方和,反映所有观测点到回归直线的残余误差,即其它因素对y 变差的影响。

(二)回归方程显著性检验— F 检验法

基本思路:方程是否显著取决于U 和Q 的大小,U 越大Q 越小说明y 与x 的线性关系愈密切。

计算统计量F

Q

U

Q F ν/=

对一元线性回归,应为

)

2/(-=

N Q F

查F 分布表,根据给定的显著性水平α和已知的自由度1和N-2进行检验: 若,0.01的水平上高度显著。

0.05的水平上显著。

0.1的水平上显著。

(三)残余方差与残余标准差

残余方差:排除了x 对y 的线性影响后,衡量y 随机波动的特征量。

22-=

N σ

残余标准差:

含义:

σ

越小,回归直线的精度越高。

程序如下:

test=[1 5 10 15 20 25;

0.1051 0.5262 1.0521 1.5775 2.1031 2.6287] N=length(test(1,:));

sx=0;sx2=0;sy=0;sy2=0;sxy=0;Lxy=0;Lyy=0; for i=1:N

sx=sx+test(1,i); sx2=sx2+test(1,i)^2;

sy=sy+test(2,i);

sy2=sy2+test(2,i)^2;

sxy=sxy+test(1,i)*test(2,i);

Lxy=Lxy+(test(1,i)-sum(test(1,:))/N)*(test(2,i)-sum(test(2,:)/N));

Lyy=Lyy+(test(2,i)-sum(test(2,:))/N)^2;

end

r=[N,sx;sx,sx2]\[sy;sxy];

a=r(1);b=r(2);

U=b*Lxy;

Q=Lyy-U;

F=(N-2)*U/Q;

x=test(1,:);y=a+b*x;eq=sum(test(2,:))/N;

ssd=0;ssr=0;

for i=1:N

ssd=ssd+(test(2,i)-y(i))^2;

ssr=ssr+(y(i)-eq)^2;

end

sst=ssd+ssr;

RR=ssr/sst;

str=[blanks(5),'y=','(',num2str(a),')','+','(',num2str(b),')','*x'];

disp(' ')

disp('回归方程为')

disp(str)

disp('R^2拟合优度校验')

strin=['R^2=',num2str(RR)];

disp(strin)

disp('方差检验:')

strin=['sgm^2=',num2str(sgm)];

disp(strin)

disp('F-分布显著性校验')

stri=['F计算值',num2str(F),blanks(4),'自由度f1=1,f2=',num2str(N-2)];

disp(stri)

disp('注:请对照F-分布表找到所需置信水平下的F临界值Fa,若F>Fa,则通过检验。

') yy=a+b*test(1,:);

plot(test(1,:),test(2,:),'r.'),hold on

plot(test(1,:),yy,'b-'),hold off

title(str)

结果如下:

test =

1.0000 5.0000 10.0000 15.0000 20.0000 25.0000

0.1051 0.5262 1.0521 1.5775 2.1031 2.6287

回归方程为:

y=(0.0003321)+(0.10514)*x

R^2拟合优度检验:

R^2=1

方差检验:

sgm^2=8.1002e-008

F-分布显著性检验:

F计算值:56408931.6024 自由度:f1=1,f2=4

注:请对照F-分布表找到所需置信水平下的F临界值Fa,若F>Fa,则通过检验。

(注:可编辑下载,若有不当之处,请指正,谢谢!)。