计算机集群系统高速互连技术浅析

- 格式:doc

- 大小:83.50 KB

- 文档页数:5

互连技术在大规模数据中心的应用随着互联网技术的不断发展,大数据的时代已经到来,大规模的数据中心也成为了现代社会中不可或缺的核心设施。

而在这些数据中心中,互连技术的应用显得尤为重要。

那么互连技术在大规模数据中心中的应用又有哪些呢?这就是本文所要探讨的问题。

一、互连技术是什么在谈及互连技术的应用之前,我们首先需要了解一下互连技术的概念。

互连技术指的是在多种设备之间建立高速、可靠的连接的技术,主要包括网络互连技术和数据互连技术。

网络互连技术是指在计算机网络中将多台计算机连接起来,允许它们进行通信和共享资源。

而数据互连技术则是指在多个数据存储设备之间建立高效的数据交换通路,允许数据快速地在设备之间传输和存储。

二、互连技术在大规模数据中心中的应用1. 提高数据中心性能在大规模数据中心中,互连技术可以提高数据中心的性能。

通过建立高速、可靠的网络互连通路,可以使多台计算机之间的通信和数据交互更加高效,从而降低网络延迟、提升数据传输速度和数据处理能力,提高数据中心的性能。

2. 实现可扩展性随着数据中心规模的扩大,很多传统的互连技术已经无法满足日益增长的网络流量和用户需求。

而像InfiniBand、RoCE(RDMA over Converged Ethernet)等新兴的互连技术则逐渐成为了大规模数据中心的主流技术之一,这些技术以高速、低延迟、可扩展性等特点而被广泛采用。

3. 提高数据安全性在大规模数据中心中,数据的安全性尤为重要。

而像InfiniBand这样的互连技术采用了硬件级别的加密技术,可以对数据进行保护,从而提高数据的安全性。

4. 提高能源效率作为大规模数据中心的重要组成部分,能源效率也是一个不可忽视的因素。

而一些新兴的互连技术,如RoCE v2, DCB等技术,可以通过带宽共享、端口虚拟化等方式提高数据中心的能效。

三、结论综上所述,互连技术在大规模数据中心中有着广泛的应用前景。

通过合理、先进的互连技术,不仅可以提高数据中心的性能和数据安全性,还可以实现可扩展性和提高能源效率,为数据中心的发展带来了更大的便利和前景。

高速互连系统的信号完整性研究高速互连系统的信号完整性研究互联网的飞速发展带来了大规模的数据交换需求,而高速互连系统在这个过程中扮演了至关重要的角色。

高速互连系统的信号完整性研究成为了当前的热点领域之一。

本文将从信号完整性的定义、相关的影响因素以及研究方法等方面探讨高速互连系统的信号完整性研究。

高速互连信号的完整性是指信号从发送器到接收器之间保持其预期的波形、振幅和时序的能力。

而信号完整性的研究则是为了保证高速互连的稳定工作,减少信号失真、抖动和干扰等问题。

信号完整性受到许多因素的影响,其中包括传输介质、信号源、信号传播路径、阻抗匹配、功率供应和环境条件等。

传输介质的选择对信号完整性有着重要的影响,常见的传输介质包括电路板、电缆和光纤等。

不同的传输介质对信号的传播速度、阻抗匹配以及抗噪声能力有着不同的要求。

此外,信号源的发射功率和波形也会对信号完整性产生影响。

同时,信号传播路径中的噪声、衰减以及耦合也是需要考虑的因素。

阻抗匹配是保证信号在传播过程中能够尽可能损失小、反射小的重要手段。

稳定的功率供应也是保证信号完整性的关键。

最后,环境条件包括温度、湿度和干扰等也会对信号完整性产生一定的影响。

在高速互连系统的信号完整性研究中,有许多研究方法和技术被广泛应用。

其中,仿真和测试是最常用的手段之一。

通过仿真可以对信号完整性进行快速、准确的分析和评估。

常见的仿真方法包括时域仿真和频域仿真等。

时域仿真可以提供波形、时序和抖动等信息,频域仿真则可以提供频谱和功率谱等信息。

测试是验证仿真结果的重要手段,常见的测试方法包括眼图测量、串扰测量和时钟抖动测量等。

此外,还有一些辅助手段如信号完整性分析软件和噪声抑制技术等也可以用于提高高速互连系统的信号完整性。

除了仿真和测试外,优化设计也是高速互连系统信号完整性研究中的重要方法。

通过合理的设计,可以优化信号传输路径,减少阻抗不匹配和信号反射,提高系统的抗干扰能力。

常见的优化设计方法包括信号预加重、匹配网络设计和功耗优化等。

集群系统的硬件与互连从理论上讲,集群系统可以是任何计算机网络群的集合。

但为运行和维护方便,提高集群系统的可靠性,往往采用某厂家的系列机作为集群系统的硬件。

对于DEC公司的集群系统,硬件可以是AlphaAXP或VAX体系结构,或这两种体系结构混合的系统。

本节介绍集群系统硬件的互连与DEC的有特色的外存没备。

1.Open VMS集群的互连Open VMSCluster系统是由多个CPU和外存设备系统通过一条或多条物理通信链路连接而构成的系统。

这里所说的物理通信链路,即所谓互连。

在具有多条互连的情况下,集群各节点间彼此通信,选用的链路是当时可供使用的最快链路。

当互连发生故障时,Open VMS Cluster软件会自动而且透明地切换到替用的互连上。

Open VMS Cluster可使用的互连方案有∶CI互连;Digital公司的存储设备系统互连(DSSI);以太网;光纤分布数据接口(FDDI)。

以太网与FDDI均是工业标准互连。

DSSI与CI是根据许可证提供的Digital公司的互连。

如果在一套Open VMS Cluster集群系统中使用的是多种类型互连,则称为混合式互连的Open VMS Cluster集群系统。

(1)CI互连。

CI互连是Digital公司的高速双通路接口,专用于在计算机房环境中计算机与HSC 及HSJ子系统之间的高速互连。

一套CI是由若干个分组组成,包括∶星形耦合器、CI 端口控制器(适配器)、及宽频带CI 电缆。

电缆长度限制与数据库∶CI互连电缆长度限制为45m。

双通路上的每个通路可支持70Mbits/s的速率,因而最高数据率为140Mbits/s。

CT互连具有下述优点∶CI为较大的处理机和I/O密集型应用环境提供具有最高速率的Open VMS Cluster集群系统通信通路。

为高效共享外存设备提供最高外存容量的扩充能力,最大容量可达10bytes的数据。

使用冗余的双路独立的CI 传送与接收电缆可使Open VMS Cluster集群互连具有最高的可用性,单路连接发生故障时,不会致使Open VMSCluster中的各节点的连通性切断,因为系统会自动地转到仍正常工作的另一连接上去。

计算机网络互连技术探究在当今数字化的时代,计算机网络互连技术的重要性日益凸显。

它如同无形的桥梁,将世界各地的计算机和设备连接在一起,实现信息的快速传递和资源的共享。

无论是我们日常的网上购物、社交娱乐,还是企业的运营管理、科研创新,都离不开这一技术的支撑。

计算机网络互连技术,简单来说,就是让不同的计算机网络能够相互通信和交换数据。

这并非是一项简单的任务,因为不同的网络可能具有不同的硬件架构、操作系统、通信协议等。

要实现它们之间的无缝连接,需要解决诸多技术难题。

首先,我们来谈谈网络协议。

网络协议就像是网络世界中的“交通规则”,规定了数据如何在网络中传输、如何被处理等。

常见的网络协议包括 TCP/IP 协议。

TCP 协议负责确保数据的可靠传输,就好像是快递员要保证包裹准确无误地送达目的地;而 IP 协议则负责为数据找到正确的路径,如同给包裹贴上正确的地址标签。

网络拓扑结构也是计算机网络互连中的一个关键因素。

常见的拓扑结构有总线型、星型、环型、树型和网状型等。

总线型结构简单成本低,但一旦总线出现故障,整个网络就可能瘫痪;星型结构易于管理和维护,但中心节点的负担较重;环型结构数据传输效率高,但某个节点的故障可能影响整个环;树型结构适合分层管理,但层级过多可能导致数据传输延迟;网状型结构可靠性高,但构建和维护成本也高。

在实际应用中,往往会根据具体需求选择合适的拓扑结构,或者采用多种拓扑结构的组合。

接着,我们来看看网络互连设备。

路由器是实现网络互连的重要设备之一,它能够根据网络地址将数据包转发到正确的目的地。

就像是一个智能的交通指挥员,根据目的地为数据选择最佳的路径。

交换机则用于在局域网内快速转发数据帧,提高网络的传输效率。

还有网关,它能够连接不同类型的网络,实现异构网络之间的通信。

在计算机网络互连中,IP 地址的分配和管理也至关重要。

IP 地址就像是网络中设备的“身份证号码”,通过它才能准确找到目标设备。

IPv4 地址由于数量有限,已经不能满足日益增长的网络需求,IPv6 应运而生。

计算机网络互连技术探究一、引言计算机网络作为现代计算机应用领域中最为基础的一个分支,是许多领域中不可或缺的一环。

然而,单一的计算机网络已经不再满足人们对于网络互连的需求,为了满足不同地域、不同组织之间的数据交流,人们提出了计算机网络互连的概念,也就是将不同的计算机网络通过一定的技术手段互相连接起来,实现资源共享、数据传输和信息交流等多样化的应用,这也是网络技术市场发展的方向之一,不断地推动着网络行业的升级和进步。

本文将会从计算机网络互连的概念入手,围绕其核心技术展开分析,并结合实际应用场景进行深入讨论,以期向读者展示这一重要技术的特点和未来发展趋势。

二、计算机网络互连的概念计算机网络互连是指通过各种不同的技术手段,将不同的计算机网络进行互联互通的过程。

由于互联互通的对象涉及多个网络、多个服务器和多个终端设备,因此该过程涉及到网络层次结构、通信协议、传输介质等多重因素的综合作用,可以说是计算机网络技术的重要组成部分,也是计算机网络应用领域中的关键概念之一。

计算机网络互连主要通过以下几种方式实现:1.网桥或交换机一些中小型的企业或办公场所中,常常利用自身的局域网结构,将其与其他局网络通过网桥或交换机连接起来,形成一个更大规模的网络。

网桥或交换机可以自动学习端口表,使得过往数据经过这些设备可以更快速地达到目的地,同时还能够识别传递的数据包的源MAC地址,并过滤不必要的流量,减轻网络拥堵的情况。

2.路由器路由器是用于实现不同网络之间的互连和通信的一种必要设备,主要通过处理分组交换和网路层互连的方式实现。

通过路由器,不同的IP地址分配的网络就可以实现互联互通,从而实现数据和资源的共享。

3.虚拟专用网络(VPN)虚拟专用网络是一种将多个分布式网络通过公共网络连接起来的技术,通过加密技术和安全隧道协议,使得多个不同网络之间的数据传输变得更加安全、私密和高效,同时也方便组织内部的成员进行远程工作和协作。

4.网关网关是一种实现不同网络之间互联和数据传输的重要设备,在各种互联网技术中也被广泛使用。

浅析网络集群现象

网络集群是指将多台计算机通过网络连接在一起,形成一个整体的计算资源池,以实现高可用、高性能、高可扩展性和资源共享的目的。

在网络集群中,有一些常见的现象。

1. 低延迟:在网络集群中,虽然数据需要经过多个节点传递,但由于节点之间的连接速度快、传输效率高,能够缩短数据传输的时间,从而实现低延迟的效果。

2. 高可用性:网络集群中的多个计算机系统级联组成,一个节点出现问题不会导致整个系统崩溃,其他节点可以顶替其工作,从而保证了高可用性。

3. 高性能:网络集群中的计算机资源被整合在一起,可以利用多台计算机的计算能力,共同完成大规模计算任务,从而达到高性能的效果。

4. 负载均衡:在网络集群中,通过负载均衡技术,将任务分配到不同的节点上,可以使每个节点的负载均衡,避免资源的过度集中,从而提高系统的稳定性和可靠性。

5. 可扩展性:网络集群架构具有良好的可扩展性,可以随时增加新的节点,通过增加计算机资源来满足更高的性能要求。

6. 数据同步:在网络集群中,由于数据存储在多个节点中,需要实现数据同步,以保证所有节点看到的数据都是一致的。

综上所述,网络集群架构是一种强大的计算资源架构,能够实现高可用、高性能和资源共享等目的,对于需要大规模计算和处理的应用场景非常适合。

《计算机网络》第07章网络互连技术在当今数字化的时代,计算机网络已经成为我们生活和工作中不可或缺的一部分。

而网络互连技术,则是构建复杂、高效网络的关键所在。

网络互连,简单来说,就是将多个独立的网络连接在一起,使它们能够相互通信和资源共享。

这就好比把一个个孤立的小岛用桥梁连接起来,形成一个庞大的陆地。

想象一下,如果每个网络都孤立存在,信息只能在有限的范围内流通,那将会是多么的不便。

实现网络互连的设备有很多,其中路由器是最为常见和重要的一种。

路由器就像是网络中的交通警察,它根据网络地址和路由协议,决定数据包的传输路径。

当一个数据包从一个网络发送到另一个网络时,路由器会检查数据包的目标地址,并根据预先设定的路由表,将其转发到正确的方向。

网络互连技术中,IP 协议是核心之一。

IP 地址就像是网络中设备的“身份证号码”,它唯一标识了网络中的每一个节点。

IPv4 地址我们都比较熟悉,由四个 0 到 255 之间的数字组成,例如 19216811。

然而,随着网络的快速发展,IPv4 地址资源已经日益匮乏,IPv6 应运而生。

IPv6 地址长度为 128 位,极大地扩展了地址空间,为未来的网络发展提供了充足的资源。

子网掩码也是网络互连中一个重要的概念。

它与IP 地址配合使用,用于确定网络地址和主机地址的划分。

通过子网掩码,我们可以将一个大的网络划分为多个子网,提高网络的管理效率和安全性。

在网络互连中,还有多种不同类型的网络,比如局域网(LAN)和广域网(WAN)。

局域网通常覆盖较小的范围,如一个办公室、一栋楼或者一个校园。

而广域网则可以跨越城市、国家甚至大洲,将分布在不同地理位置的网络连接起来。

网络互连技术还涉及到不同的网络拓扑结构。

常见的拓扑结构有总线型、星型、环型、树型和网状型等。

每种拓扑结构都有其特点和适用场景。

例如,总线型结构简单,但可靠性较低;星型结构易于管理和维护,但中心节点容易成为瓶颈。

网络互连的过程中,数据链路层的作用也不可忽视。

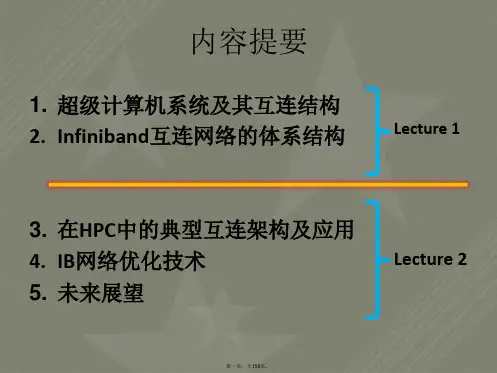

高性能互连技术在超级计算中的应用探索第一章:引言超级计算是指那些能够以极高的速度进行大规模计算和数据处理的计算机系统。

在超级计算中,高性能互连技术扮演着关键的角色。

本文将探索高性能互连技术在超级计算中的应用。

第二章:高性能互连技术概述高性能互连技术是指用于将计算节点、存储节点和网络节点相互连接的技术。

传统计算机系统主要使用总线结构进行互连,但总线结构在处理大规模数据时存在性能瓶颈。

而高性能互连技术采用基于网络的结构,能够提供更高带宽和更低延迟的传输能力。

第三章:超级计算中的网络拓扑在超级计算中,选择合适的网络拓扑结构是至关重要的。

常见的网络拓扑结构包括树状结构、环状结构、网状结构等。

每种拓扑结构都有其优缺点,需要根据实际需求进行选择。

第四章:高性能互连技术的应用4.1 高性能互连在超级计算中的节点互连高性能互连技术可以实现超级计算中节点间的高速互连,使得节点之间能够快速共享计算资源和存储资源。

常见的高性能互连技术包括InfiniBand、Ethernet等。

4.2 高性能互连在超级计算中的存储系统互连超级计算中需要大规模的存储系统来支持数据的存储和访问。

高性能互连技术可以实现存储系统的高速互连,提供更高的带宽和更低的延迟。

例如,使用高性能互连技术可以将多个存储节点组成分布式存储系统,提高存储系统的性能和可扩展性。

4.3 高性能互连在超级计算中的网络互连超级计算中的计算节点、存储节点和网络节点之间需要进行大量的数据传输。

高性能互连技术可以实现网络节点之间的高速互连,提供更高的传输带宽和更低的传输延迟。

目前,使用高性能互连技术的网络设备如交换机和路由器已经得到广泛的应用。

第五章:高性能互连技术的挑战与未来发展高性能互连技术在超级计算中的应用面临着一些挑战。

首先,高性能互连技术需要支持大规模的节点互连,这要求网络设备具有更高的扩展性。

其次,高性能互连技术需要在短距离和长距离的传输中都能提供高性能。

此外,高性能互连技术还需要考虑能耗和故障容忍性等因素。

高性能计算中的互连网络设计和优化随着人工智能、大数据和云计算等技术的发展,高性能计算已经成为了当今计算机领域的一个重要研究方向,而在高性能计算中互连网络则是不可或缺的部分。

互连网络的设计与优化就显得至关重要。

本文将结合相关理论和实践介绍高性能计算中互连网络的设计原则、优化方法等内容。

先进高速计算机互连网络概述作为一种计算机机房内部网络技术,互连网络是用于连接各种计算设备(如服务器、存储系统)之间的可编程网络解决方案。

以实现大规模的高速互连为主要特点的高速互连计算集群是当今当今科研计算领域响应重大需求而产生的新型高水平计算平台。

高速互连计算集群主要为用户提供大规模并行处理和高性能计算服务。

与普通计算机网络相对应,互连网络有很多优势。

对于计算要求严格、数据吞吐量较大的计算工作来说,随着机架尺寸的扩大,传统网络技术的瓶颈随机架尺寸的扩大变得越来越突出。

这决定了高速互连计算集群是未来科学研究计算方向的主要方向之一。

高速互连计算集群克服了传统机房网络的限制,将计算单元全部放在机架中,并与互联网通过高速接口连接起来。

通过不同接口相互连接的方式,使其支持多种计算形式。

这些计算形式包括传统互连方式、硬件互连方式等。

除此之外,高速互连计算集群还具备自适应性能和优化算法,可有效消除跨越计算和存储系统的性能瓶颈。

这种先进的互连网络拥有高速、低延迟、高可扩性和高带宽的特点,是高性能计算的重要研究方向。

高性能计算中互连网络设计原则针对高性能计算中互连网络设计,需要遵循以下原则:(1)互连网络基本原则:在互连网络设计中,应以简单、可靠、稳定和可伸缩为基本原则。

这样可以保证系统的整体性能和稳定性,并具有可扩展性。

(2)距离的影响:在互连网络的设计中,应考虑节点之间的距离对网络的影响。

理论上,距离越近的节点,数据传输速度越快,网络延迟也越低。

因此,在互连网络设计时应该注意。

(3)带宽的选择:要根据应用需求和应用类型选择合适的带宽。

高性能计算机集群系统设计与实现随着计算机技术的不断发展和进步,越来越多的科学研究和工程计算需要使用高性能计算机来完成。

高性能计算机集群系统是目前实现高性能计算的主流形式之一。

本文将探讨高性能计算机集群系统的设计与实现,并介绍其中的一些重要技术和关键问题。

一、高性能计算机集群系统的概述高性能计算机集群系统是一种由多个计算机互联而成的计算机系统,它们通过高速网络互连,协同完成大规模的计算任务。

该系统具有高性能、高可靠性、高可扩展性等优点,被广泛应用于科学计算、工程模拟、人工智能等领域。

高性能计算机集群系统通常由两部分组成:计算节点和管理节点。

计算节点是集群中的计算单元,每个计算节点都可以独立地完成计算任务。

它们通过高速网络互连,协同工作,实现高性能计算。

管理节点则负责集群的初始化、维护和管理,并为计算节点提供操作系统、文件系统、任务调度器等服务。

二、高性能计算机集群系统的硬件设计高性能计算机集群系统的硬件设计是实现高性能计算的关键。

首先,计算节点需要采用高性能的处理器和内存,以实现高效的计算。

其次,高速网络是实现集群系统高性能的重要因素。

高速网络可以快速、可靠地传输大量数据,支持计算节点之间的远程访问。

此外,集群系统的存储也是关键的硬件组成部分。

集群中的计算节点需要可靠的本地存储来运行计算任务,并且需要一个共享的分布式文件系统来存储数据和程序。

最后,集群系统还需要可靠的电源和冷却系统,以确保计算节点的稳定运行。

三、高性能计算机集群系统的软件设计高性能计算机集群系统的软件设计是实现高性能计算的另一个重要因素。

首先,为不同的硬件节点提供统一的操作系统和软件环境是至关重要的,以便计算节点可以以相同的方式运行计算任务。

其次,为了有效地利用计算资源,集群系统需要一个高效的任务调度系统,以根据任务的类型、优先级和资源需求等因素,将任务分配给适当的计算节点。

同时,集群系统还需要一个高效的分布式文件系统,以支持数据和程序共享。

高性能计算机集群中的数据传输技术研究随着信息技术的不断发展,高性能计算机集群已逐渐成为各个领域科学计算和工程仿真的重要工具。

这种计算机系统的特点在于它由众多的计算节点和存储节点组成,它们通过网络相互连接,实现高速计算和数据传输。

在高性能计算机集群系统中,数据传输的速度和效率至关重要。

因此,不断的研究和优化数据传输技术是非常有必要的。

高性能计算机集群中的数据传输技术主要包括基于硬件和基于软件的解决方案。

基于硬件的数据传输技术采用高速网络接口卡、网络交换机等设备来实现高速数据传输。

常用的高速网络接口卡有Infiniband、Myrinet和10 Gigabit以太网等。

这些接口卡可以提供非常高的带宽和低延迟,可以满足高性能计算机集群中的大量数据传输需求。

除了高速网络接口卡,网络交换机也是高性能计算机集群中必不可少的组件。

网络交换机的作用是将不同节点之间传输的数据包进行交换,使其能够快速准确到达目的节点。

上述硬件技术的优点在于它们能够显著提高系统的传输效率,但同时也存在一定的局限性。

硬件技术需要大量的投资和维护成本,并且不同的硬件之间兼容性也会受到一定的限制。

基于软件的数据传输技术则不同于硬件技术,它使用软件算法来优化数据传输。

在高性能计算机集群中最常用的基于软件的传输协议是MPI(Message Passing Interface)。

MPI是一种面向消息的通信框架,它允许在不同节点之间进行点对点数据传输,还能支持进程之间的组播和广播等功能。

MPI协议采用了流水线算法、排队算法、剪枝算法等一系列算法来实现高效的数据传输。

另外,近年来,研究人员还提出了一些新的软件技术,如RDMA (Remote Direct Memory Access),RDMA可以大大减少CPU参与的传输过程,最大限度地减少网络传输延迟,提高传输效率。

除此之外,对于集群数据传输的优化,还可以采用数据分区和负载均衡等技术。

数据分区指的是将待计算的巨型数据集分成若干个块,分别分配到不同的计算节点上进行处理,这样可以大大减少计算节点之间的数据传输量。

集群高速互连网络分析

李涛;陈宇明;赵精龙;倪长顺;杨愚鲁

【期刊名称】《计算机科学》

【年(卷),期】2005(032)010

【摘要】集群是当今高性能计算领域的重要发展方向,高速互连网络是构建高性能集群系统的关键技术,它是影响集群系统整体性能的关键因素.本文对几种用于集群互连的高带宽、低延迟高速互连网络进行了分析与比较,最后指出了高速互连网络的未来发展.

【总页数】3页(P20-22)

【作者】李涛;陈宇明;赵精龙;倪长顺;杨愚鲁

【作者单位】南开大学计算机科学与技术系,天津300071

【正文语种】中文

【中图分类】TP3

【相关文献】

1.复杂系统可靠控制中的潜在问题互连神经网络分析方法 [J], 胡昌华;刘丙杰

2.产业集群、集群网络分析与经济结构调整——湖南省产业集群的实证分析 [J], 孟斌斌;李湘黔

3.基于社会网络分析方法的产业集群研究——以河南省虞城县南庄村钢卷尺产业集群为例 [J], 李二玲;李小建

4.企业网络分析方法述评与探讨——兼论网络分析方法在产业集群研究中的应用[J], 李二玲;潘少奇

5.复杂性理论和网络分析方法在产业集群创新能力问题中的应用--基于江苏省三个产业集群的实证研究 [J], 吴先华;郭际;胡汉辉

因版权原因,仅展示原文概要,查看原文内容请购买。

计算机集群系统高速互连技术浅析1. 引言高性能计算机在科研领域和关键业务处理方面占有举足轻重的地位,但是支持这类应用的解决方案,多趋向于专有的昂贵的专有系统,并且整体性能也并不总是灵活的、高效的,可扩展性更是乏善可陈。

计算机群集的出现使这种状况得到了显著的改善,集群系统的使用已经有十几年的历史。

作为最早的群集技术设计师之一, G. Pfister 对群集的定义是,"一种并行或分布式的系统,由全面互连的计算机集合组成,可作为一个统一的计算资源使用"。

[1]在大规模并行计算和机群等高性能计算系统中,处理器之间或计算节点之间的快速互联网络的重要程度并不亚于处理器本身,网络是集群中各个节点相互连接和协同工作的基础。

随着双核处理器的出现、PCI-Express总线的发展、超级计算机的规模越来越大以及数据库集群的发展、金融分析的精确度的增加,制造业、石油、气象、生物等仿真技术的发展等,使得高带宽、低延时、高性能、低价格的网络互联方案变得日益重要。

在实际的集群系统中,通常采用两套彼此独立的网络。

一套是普通百兆以太网,用于系统管理和文件服务等普通网络通信;另一套是高速网,主要负责并行计算的消息传递和数据交换。

在TOP500中,集群的高速网主要有千兆以太网(Gigabyte Ethernet)、10G Ethernet、Quadrics、Myrinet、Infiniband、PathScale的Infinipath、IBM的SP网络、Dolphin SCI、SGI的Numa-Link、Gray的RapidArray 等[2],其中最为广泛使用的高速通信网络有千兆以太网、Myrinet、Infiniband等三种[2]。

下面就这三种网络在带宽、延迟、功能支持和技术优势等方面进行详细的阐述。

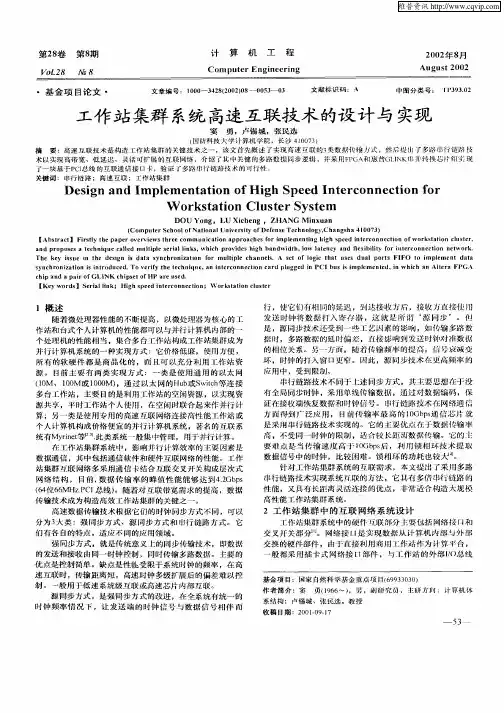

2.几种互联技术的比较与分析2.1 千兆以太网千兆以太网是对IEEE 802.3以太网标准的扩展,在基于以太网协议的基础之上,将快速以太网的传输速率(100Mbps)提高了10倍,达到了1 Gbps。

为了能够把网络速度从原先的100Mbps提升到1 Gbps,对物理接口进行一些改动。

为了确保与以太网技术的向后兼容性,千兆以太网遵循了以太网对数据链路层以上部分的规定。

在数据链路层以下,千兆以太网融合了IEEE 802.3/以太网和ANSI X3T11光纤通道两种不同的网络技术,实现了速度上飞跃。

图1所示为三者之间的构成关系。

图1 三种网络技术构成关系图这样,千兆以太网不但能够充分利用光纤通道所提供的高速物理接口技术,而且保留了IEEE 802.3/以太网帧的格式,在技术上可以相互兼容,同时还能够支持全双工或半双工模式(通过CSMA/CD)。

千兆以太网是现在应用最广泛的网络,可用于Linux集群管理,也可用于Linux集群节点间数据交换和通信,但其网络带宽和延迟不如专用网络,只能在节点通信负载不大的应用环境中得到广泛应用。

千兆以太网支持系统到系统之间线速传输,达到约800Mbps的实际数据传送速率,报文收/发时延在60微秒左右。

报文收/发延时(或称为ping pong延时)用报文发出到接受到对方回应之间的时间间隔的一半来计算。

时延包括交换机的时延(收发双向均为10微秒左右)和接收方主机的收发延时(包括TCP/IP协议栈的处理和缓存到缓存的传送,这些均需要通过软件处理)。

千兆以太网的特点是搭建容易,可以以较低的成本满足大部分应用需求。

目前,出现了万兆以太网技术,可以以8G到10Gbps的速度输入输出数据。

并且网交换部件和芯片组的最新技术进步缩短了以太网的传输延迟,一些局域网设备的延迟降低到了300纳秒。

2.2 MyrinetMyrinet是Myricom公司私有的交换式集群互连技术,该技术原来为大容量并行处理器系统设计的。

Myrinet的基本组成部分是16端口矩阵式交换芯片,通过‘胖树’结构组成较大的交换机和交换阵列。

Myrinet交换机和主机适配器的端口速率为2Gbps。

Myrinet GM 为低级报文层支持收发和RDMA操作。

主机端口执行“操作系统旁路”固化微码将协议处理工作从主机CPU卸载下来。

Myrinet 网络的设计目标是要在局域网环境中获得系统域网络的性能。

因此,它采用了MPP 系统中数据包通信和交换技术,在设计时充分考虑了并行系统内部互连网络传输距离近、出错率低的应用环境,使用简化的链路控制协议实现数据传送,减小了数据传输时的协议开销;采用无阻塞的Clos 网络拓扑结构,减少了数据包在网络中的冲突;网络适配器处理机对网络的自动映像和路由选择功能,可以提高网络的可靠性。

Myrinet 网络自从开发成功以来,以其高带宽、低延时和良好的可扩展性,带宽可达200MB/秒,延迟小于10us,成为构造大规模集群系统的理想选择,在历届TOP500中都占有较大份额。

2.3 InfiniBandInfiniBand简称IBA,由Mellanox公司提出,是一种新的I/O总线技术,用于取代目前的PCI总线。

InfiniBand技术是一种开放标准的高带宽、高速网络互联技术。

该技术通过一种交换式通信组织(Switched Communications Fabric)提供了较局部总线技术更高的性能。

InfiniBand总线拓扑结构是基于分组交换点到点连接的fat tree结构,有很好的扩展功能。

它既能以PCB的形式提供芯片与芯片的互联,还能以电缆线的形式提供“out of the box”设备与设备之间的互联。

通过硬件提供了可靠的传输层级的点到点连接,并在线路上支持消息传递和内存映像技术。

可用于连接处理器节点和I/O节点组成系统级网络。

InfiniBand的目标是减小I/O的复杂程度。

InfiniBand体系结构中包含5个基本层,自下向上依次是物理层、数据链路层、网络层、传输层和上层软件应用层,其中前4层是通过硬件完成的[3]。

由于硬件承担了原来由CPU完成的许多I/O通信工作,因此在处理并发的多路通信任务时,不会像其他通信协议那样产生额外开销。

在InfiniBand结构中还单独定义了一个Subnet Manager的概念,用来配置网络单元、错误报告、链接错误排除、机箱管理等。

Infiniband每个单独的链接通道是4根信号线,2根输入、2根输出,每个数据方向是2.5Gb/s的带宽。

目前的DDR方式能够达到单通道单方向5Gb/s带宽,在DDR方式下的双向带宽是10Gb/s。

而且不同的通道之间还可以组合成为一个端口,这样带宽就可以成倍地增长。

在I/O技术层面,InfiniBand 还具有两个非常关键的特性:一是物理层设备低功耗,二是“箱外带宽”(Bandwidth Out of the Box)。

一个InfiniBand结构的铜介质物理层设备(PHY)每一个端口只需要0.25瓦,而一个千兆以太网物理层设备每一个端口需要2瓦的功耗。

Infiniband 完备的通信协议和网络底层的实现技术借鉴了以太局域网、光纤通道存储网络和广域网络的研究经验,因此具有很强的通用性。

从InfiniBand技术的发展前景来看,随着基于QDR(四位数据率) InfiniBand技术的产品推向市场,InfiniBand网卡的单端口带宽将达到40Gbps、80Gbps或120Gbps,相信InfiniBand技术将会变得越来越普及。

2.4 技术优势对比InfiniBand和Myrinet之间有许多类似的方面:都通过内部“胖树”结构用相对小的矩阵式交换芯片来组建较大的独立交换机。

独立交换机通过外部“胖树”结构再联合起来满足更大规模的应用要求。

所有这些交换机均使用“直通”交换技术减少交换时延,RDMA旁路系统内核处理降低时延和CPU使用率。

尽管有很多的相似之处,在主机适配器体系结构上仍然有许多显著差异,如表1中的数据显示。

采用完全“胖树”结构的大型集群需要大量的交换机和繁重的布线工作,例如一个1024个节点的典型集群结构,需要使用了24个交换机节点,每台交换机提供128个端口。

这个配置的每个链路带宽均相同,因此共计有964条交换机互连链路。

InfiniBand、Myrinet都比千兆以太网提供了更好的带宽、时延和CPU使用率。

但是,由于相对小规模的交换矩阵芯片,端口数较多的交换机的内部可能会变得非常复杂。

整个集群需要的交换机数量将很多,交换机之间互连的布线也将非常复杂。

因此,具体选择哪种互连技术将必须根据实际应用的特点在性能和复杂性/成本上作出权衡。

表1 InfiniBand和Myrinet参数对比互联网络的考虑因素主要有延时、带宽、价格、功能支持。

一般来讲,互联系统的价格与延时成反比,而与带宽成正比。

为了节省费用,应该针对不同的应用配置不同的互联系统。

由于各种应用的需求不同,对于互联方式的延时和带宽的要求也不一样。

有些高性能计算的应用需要每个节点之间非常频繁地交换数据,但每次的数据量并不很大,在设计时就需要使用低延时的互联网络,而对带宽的要求则不高。

反之,有些应用节点之间的数据交换不是非常频繁,但每次交换的数据量非常大,则需要考虑使用高带宽的互联网络,对延时要求则不高。

下表中就前面阐述的三种互联技术的特性进行对比。

表2 互联技术特性对比3 结束语Myrinet作为经典的高速网络在TOP500中一直占有较大份额,但在2005年被迅速增长的千兆以太网超过;而Infiniband方兴未艾,从2003年出现以来,每年以大约三倍速度增长,发展势头甚至超过了千兆以太网。

2006年初,2.6.15版本的Linux 核心发布,它包含了一个InfiniBand(IB) SRP存储驱动程序。

增加这个驱动器意味着,Linux 系统能够通过一个IB网络和存储对话。

该驱动程序的推出,将极大鼓舞基于IB系统的Linux 集群的迅速发展。

可以预测,未来几年Infiniband将成为Linux集群高速网络的增长点。