最优化问题的算法迭代格式

- 格式:docx

- 大小:37.26 KB

- 文档页数:5

最优化问题——梯度下降法1、⽆约束最优化问题求解此问题的⽅法⽅法分为两⼤类:最优条件法和迭代法。

2、最优条件法我们常常就是通过这个必要条件去求取可能的极⼩值点,再验证这些点是否真的是极⼩值点。

当上式⽅程可以求解的时候,⽆约束最优化问题基本就解决了。

实际中,这个⽅程往往难以求解。

这就引出了第⼆⼤类⽅法:迭代法。

最优条件法:最⼩⼆乘估计3、迭代法(1)梯度下降法(gradient descent),⼜称最速下降法(steepest descent)梯度下降法是求解⽆约束最优化问题的⼀种最常⽤的⽅法。

梯度下降法是迭代算法,每⼀步需要求解⽬标函数的梯度向量。

必备条件:函数f(x)必须可微,也就是说函数f(x)的梯度必须存在优点:实现简单缺点:最速下降法是⼀阶收敛的,往往需要多次迭代才能接近问题最优解。

算法A.1(梯度下降法)输⼊:⽬标函数f(x),梯度函数g(x)=▽f(x),计算精度ε;输出:f(x)的极⼩点x*总结:选取适当的初值x(0),不断迭代,更新x的值,进⾏⽬标函数的极⼩化,直到收敛。

由于负梯度⽅向是使函数值下降最快的⽅向,在迭代的每⼀步,以负梯度⽅向更新x的值,从⽽达到减少函数值的⽬的。

λk叫步长或者学习率;梯度⽅向g k=g(x(k))是x=x(k)时⽬标函数f(x)的⼀阶微分值。

学习率/步长λ的确定:当f(x)的形式确定,我们可以通过求解这个⼀元⽅程来获得迭代步长λ。

当此⽅程形式复杂,解析解不存在,我们就需要使⽤“⼀维搜索”来求解λ了。

⼀维搜索是⼀些数值⽅法,有0.618法、Fibonacci法、抛物线法等等,这⾥不详细解释了。

在实际使⽤中,为了简便,也可以使⽤⼀个预定义的常数⽽不⽤⼀维搜索来确定步长λ。

这时步长的选择往往根据经验或者通过试算来确定。

步长过⼩则收敛慢,步长过⼤可能震荡⽽不收敛。

如下图:当⽬标函数是凸函数时,梯度下降法的解是全局最优解。

但是,⼀般情况下,往往不是凸函数,所以其解不保证是全局最优解。

交替方向法求解最优化问题

交替方向法(Alternating Direction Method, 简称ADM)是一种用于求解优化问题的迭代算法。

它主要用于求解具有约束条件的优化问题,特别是线性或凸优化问题。

ADM算法的基本思路是将原始问题转化为一系列子问题,然后通过迭代交替地求解这些子问题,直到收敛到最优解。

具体来说,ADM算法的迭代过程如下:

1. 初始化原始问题的变量。

2. 迭代求解子问题1:固定其他变量,只优化其中一个变量。

3. 迭代求解子问题2:固定其他变量,只优化另一个变量。

4. 重复步骤2和步骤3直到收敛。

ADM算法的收敛性在一些条件下是保证的,尤其是对于凸优化问题。

需要注意的是,ADM算法对于特定的优化问题可能需要设计不同的子问题求解方法。

因此,在具体应用中,需要根据问题的特点和要求进行算法的设计和实现。

总之,交替方向法是一种求解最优化问题的迭代算法,其基本

思路是交替迭代求解问题的子问题,通过优化不同的变量来逼近最优解。

《最优化方法》课程设计题目:BFGS算法分析与实现院系:数学与计算科学学院专业:统计学姓名学号:左想 **********指导教师:***日期: 2014 年 01 月 22 日摘要在求解无约束最优化问题的众多算法中,拟牛顿法是颇受欢迎的一类算法。

尤其是用于求解中小规模问题时该类算法具有较好的数值效果。

BFGS 算法被认为是数值效果最好的拟牛顿法,其收敛理论的研究也取得了很好的成果. 在一定的条件下,BFGS 算法具有全局收敛性和超线性收敛速度。

然而,对于大规模最优化问题来求解,包括 BFGS 算法在内拟牛顿法具有明显的缺陷。

有许多的例子表明,一旦处理问题很大时,一些对小规模问题非常成功的算法变得毫无吸引力。

究其原因,主要是由于在中小型问题一些不太重要的因素在求解大规模问题时,变得代价很高。

随着速度更快及更复杂的计算机的出现,增强了我们的计算处理能力。

同时也为我们设计算法带来了新的课题。

并行计算机的发展为求解大规模最优化问题提供了一条新途径。

关键词:BFGS 拟牛顿法;无约束最优化问题;大规模问题AbstractQuasi-Newton methods are welcome numerical methods for solving optimization problems. They are particularly effective when applied to solve small or middle size problems. BFGS method is regarded as the most effective quasi-Newton method due toits good numerical perfor mance. It also possesses very good global and superlinear con vergen ceproperties. On the other hand, however, when applied to solve larg escaleproblems, quasi-Newton methods including BFGS method don ot perform well. Themajor drawback for a quasi-Newton method, when used to solve large scaleoptimization problem, is that the matrix gener ated by the method does not retain thesparsity of the Hessian matrix of the objective function. There are examples showing that many success methods for solving small-sized optimization become unattractive once the problem to be tackled is large. An important reason for thisfeature is that some process that is important for small problems may become veryexpensive for large scale problems.The fast development of computer has enhanced our ability to solve large scaleproblems. In particular, the parallel computer provides us a new way to solve largescale problems efficiently. In recent years, there has been growing interest in the studyin parallel methods. It has been found that many good methods that are efficient forsolving small and middle size problems can be parallized.Key Words: BFGS quasi-Newton method; unconstrained optimization problem, large scale problem目录1、引言 ........................................................................................ 错误!未定义书签。

牛顿法牛顿法作为求解非线性方程的一种经典的迭代方法,它的收敛速度快,有内在函数可以直接使用。

结合着matlab 可以对其进行应用,求解方程。

牛顿迭代法(Newton Newton’’s s method method )又称为牛顿-拉夫逊方法(Newton-Raphson method ),它是牛顿在17世纪提出的一种在实数域和复数域上近似求解方程的方法,其基本思想是利用目标函数的二次Taylor 展开,并将其极小化。

牛顿法使用函数()f x 的泰勒级数的前面几项来寻找方程()0f x =的根。

牛顿法是求方程根的重要方法之一,其最大优点是在方程()0f x =的单根附近具有平方收敛,而且该法还可以用来求方程的重根、复根,此时非线性收敛,但是可通过一些方法变成线性收敛。

收敛。

牛顿法的几何解释:牛顿法的几何解释:方程()0f x =的根*x 可解释为曲线()y f x =与x 轴的焦点的横坐标。

如下图:轴的焦点的横坐标。

如下图:设k x 是根*x 的某个近似值,过曲线()y f x =上横坐标为k x 的点k P 引切线,并将该切线与x 轴的交点轴的交点 的横坐标1k x +作为*x 的新的近似值。

鉴于这种几何背景,牛顿法亦称为切线法。

牛顿法亦称为切线法。

2 牛顿迭代公式:(1)最速下降法:x-d gk k×Gg sks×GGd 101x x x -(1)令k k G v I k G -=+,其中:,其中:0k v =,如果k G 正定;0,k v >否则。

否则。

(2)计算_k G 的Cholesky 分解,_T k k k k G L D L =。

(3)解_k k G d g =-得k d 。

(4)令1k k k x x d +=+牛顿法的优点是收敛快,缺点一是每步迭代要计算()()'k k f x f x 及,计算量较大且有时()'k fx 计算较困难,二是初始近似值0x 只在根*x附近才能保证收敛,如0x 给的不合适可能不收敛。

第九章经典最优化方法9.1 最优化的基本概念最优化方法是一门古老而又年青的学科。

这门学科的源头可以追溯到17世纪法国数学家拉格朗日关于一个函数在一组等式约束条件下的极值问题(求解多元函数极值的Lagrange乘数法)。

19世纪柯西引入了最速下降法求解非线性规划问题。

直到20世纪三、四十年代最优化理论的研究才出现了重大进展,1939年前苏联的康托洛维奇提出了解决产品下料和运输问题的线性规划方法;1947年美国的丹奇格提出了求解线性规划的单纯形法,极大地推动了线性规划理论的发展。

非线性规划理论的开创性工作是在1951年由库恩和塔克完成的,他们给出了非线性规划的最优性条件。

随着计算机技术的发展,各种最优化算法应运而生。

比较著名的有DFP和BFGS无约束变尺度法、HP广义乘子法和WHP约束变尺度法。

最优化问题本质是一个求极值问题,几乎所有类型的优化问题都可概括为如下模型:给定一个集合(可行集)和该集合上的一个函数(目标函数),要计算此函数在集合上的极值。

通常,人们按照可行集的性质对优化问题分类:如果可行集中的元素是有限的,则归结为“组合优化”或“网络规划”,如图论中最短路、最小费用最大流等;如果可行集是有限维空间中的一个连续子集,则归结为“线性或非线性规划”;如果可行集中的元素是依赖时间的决策序列,则归结为“动态规划”;如果可行集是无穷维空间中的连续子集,则归结为“最优控制”。

线性规划与非线性规划是最优化方法中最基本、最重要的两类问题。

一般来说,各优化分支有其相应的应用领域。

线性规划、网络规划、动态规划通常用于管理与决策科学;最优控制常用于控制工程;非线性规划更多地用于工程优化设计。

前面提到的算法是最优化的基本方法,它们简单易行,对于性态优良的一般函数,优化效果较好。

但这些经典的方法是以传统微积分为基础的,不可避免地带有某种局限性,主要表现为:①大多数传统优化方法仅能计算目标函数的局部最优点,不能保证找到全局最优解。

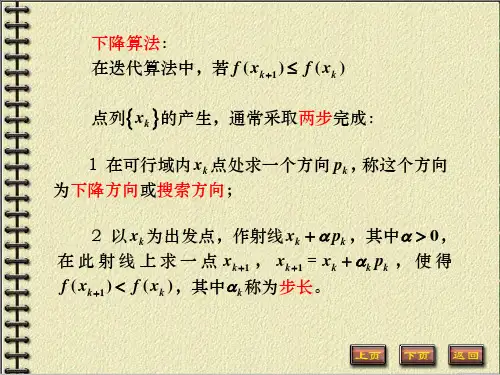

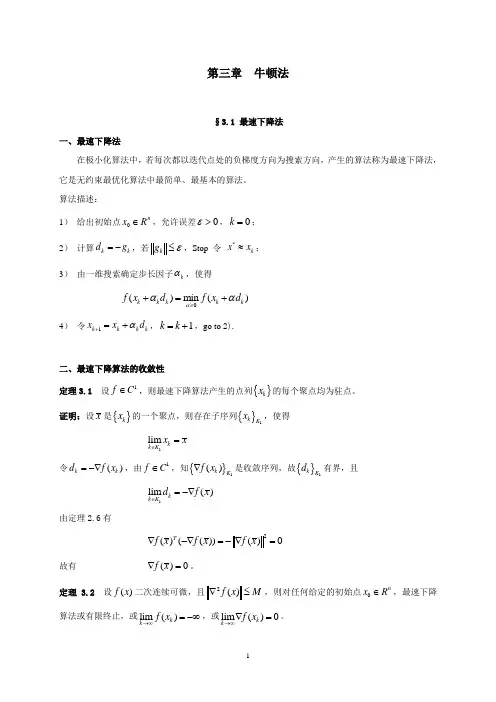

第三章 牛顿法§3.1 最速下降法一、最速下降法在极小化算法中,若每次都以迭代点处的负梯度方向为搜索方向,产生的算法称为最速下降法,它是无约束最优化算法中最简单、最基本的算法。

算法描述:1) 给出初始点0n x R ∈,允许误差0ε>,0k =; 2) 计算k k d g =-,若k g ε≤,Stop 令 *k x x ≈; 3) 由一维搜索确定步长因子k α,使得()min ()k k k k k f x d f x d ααα≥+=+4) 令1k k k k x x d α+=+,1k k =+,go to 2).二、最速下降算法的收敛性定理3.1 设1f C ∈,则最速下降算法产生的点列{}k x 的每个聚点均为驻点。

证明:设x 是{}k x 的一个聚点,则存在子序列{}1k K x ,使得1lim k k K x x ∈=令()k k d f x =-∇,由1f C ∈,知{}1()k K f x ∇是收敛序列,故{}1k K d 有界,且1lim ()k k K d f x ∈=-∇由定理2.6有2()(())()0Tf x f x f x ∇-∇=-∇=故有 ()0f x ∇=。

定理 3.2 设()f x 二次连续可微,且2()f x M ∇≤,则对任何给定的初始点0n x R ∈,最速下降算法或有限终止,或lim ()k k f x →∞=-∞,或lim ()0k k f x →∞∇=。

证明:不妨设k ∀,()0k f x ∇≠。

由定理2.5有211()()()2k k k f x f x f x M+-≥∇ 于是 []120101()()()()()2kk k i i i i i f x f x f x f x f x M -+==-=-≥∇∑∑令k →∞,由{()}k f x 为单调下降序列,则要么lim ()k k f x →∞=-∞,要么 lim ()0k k f x →∞∇=。

迭代法求解最优化问题的一般步骤

迭代法求解最优化问题的一般步骤如下:

1. 确定目标函数:首先确定最优化问题的目标函数,即求解问题的优化目标。

2. 确定约束条件:确定最优化问题的约束条件,包括等式约束和不等式约束。

约束条件可以对变量的取值范围进行限制。

3. 初始化变量:为问题中的变量选择一个初始值,通常可以随机选择或通过经验来确定。

4. 进行迭代计算:根据迭代算法,重复计算变量的值,直到满足停止准则。

在每一步迭代中,需要根据当前变量的值来更新变量。

5. 停止准则:定义一个停止准则来判断迭代是否结束。

常用的停止准则有:达到最大迭代次数、目标函数值的变化小于某个阈值、约束条件的满足程度较高等。

6. 输出结果:当迭代结束时,得到近似的最优解。

根据问题的要求,可以输出变量的值、目标函数值以及满足约束条件的程度等。

需要注意的是,迭代法并不保证能够找到全局最优解,而只能找到局部最优解。

因此,在应用迭代法求解最优化问题时,需要结合具体问题的特点来选择合适的迭代方法和停止准则。

第二章 一维搜索§2.1. 引言一、精确与非精确一维搜索如前所述,最优化算法的迭代格式为:1k k k k x x d α+=+因而算法的关键就是选择合适的搜索方向,然后再确定步长因子k α。

若设()()k k f x d ϕαα=+现在的问题是从k x 出发,沿k d 方向搜索,希望找到k α,使得()(0)k ϕαϕ<,这就是所谓的一维搜索或称为线搜索(line search )问题。

⑴ 若求得的k α,使目标函数沿方向k d 达到最小,即使得()min ()k k k k k f x d f x d ααα>+=+或 0()min ()k αϕαϕα>=,则称为最优一维搜索,或精确一维搜索。

相应的k α称为最优步长因子。

⑵ 如果选取k α,使目标函数获得可以接受的改善,即()()0k k k k f x f x d α-+>,则称之为近似一维搜索,或非精确一维搜索。

注:精确搜索与非精确搜索在最优化算法中均广泛应用,它们存在各自的优缺点。

二、一维搜索的基本框架一维搜索实际上是一元函数的极值问题,其基本的解决框架是: ⑴ 确定包含最优解的初始搜索区间;⑵ 采用某些区间分割技术或插值方法不断缩小搜索区间,最后得到解。

注:值得注意的是,这样得到的解大多数情况下均为近似解。

因此,即便采用精确一维搜索策略,只要应用了数值方法,最终得到的结果都不一定是真正数学意义上的最佳步长因子。

初始搜索区间的确定定义2.1 设:R R ϕ→,*[0,)α∈+∞是函数()ϕα的最小值点,即*()min ()αϕαϕα≥=。

若存在闭区间[,][0,)a b ⊂+∞,使 *[,]a b α∈,则称[,]a b 为一维极小化问题0min ()αϕα≥的搜索区间。

确定初始搜索区间的进退法基本思想:从一点出发,按一定步长探测,试图找到函数值呈高-低-高变化的三点。

具体地,从初始点0α出发,取初始步长为0h 。

最优化问题的算法迭代格式什么是最优化问题?最优化问题是指在给定约束条件下寻找某个目标函数取得最大值或最小值的问题。

这类问题在实际应用中非常广泛,例如在工程、经济学、物理学等领域中都会遇到最优化问题。

最优化问题的分类最优化问题可以根据目标函数和约束条件的性质进行分类。

根据目标函数的性质,最优化问题可以分为线性规划、非线性规划、整数规划等。

根据约束条件的性质,最优化问题可以分为等式约束问题和不等式约束问题。

传统的最优化问题求解方法在传统的最优化问题求解方法中,常用的方法有穷举法、梯度下降法、牛顿法等。

这些方法的共同点是需要迭代求解,通过不断迭代逼近最优解。

其中,穷举法是一种朴素的求解方法,通过枚举所有可能的解,并计算目标函数的取值来找到最优解。

然而,穷举法的计算复杂度通常很高,不适用于大规模的最优化问题。

迭代法求解最优化问题为了解决传统方法中计算复杂度高的问题,研究者们逐渐提出了一系列迭代算法来求解最优化问题。

迭代法通过不断更新解的估计值来逼近最优解。

迭代法的主要思想是从一个初始解开始,通过一定的迭代格式来计算下一个解的估计值,直到满足终止条件为止。

在迭代法中,需要确定三个要素:初始解、迭代格式和终止条件。

初始解的选择通常对最后的结果有一定的影响,较好的初始解可以加速算法的收敛速度。

迭代格式是指通过给定的规则来计算下一个解的估计值,不同的迭代格式适用于不同类型的最优化问题。

终止条件是指满足一定条件时终止迭代过程,通常可以选择解的变化不超过一定阈值,或者迭代次数达到一定的上限。

常见的最优化问题迭代算法1. 梯度下降法梯度下降法是一种常用的迭代算法,用于求解无约束的最优化问题。

梯度下降法的思想是通过沿着目标函数梯度的反方向移动,不断逼近最优解。

具体来说,梯度下降法通过以下迭代格式计算下一个解的估计值:x k+1=x k−α∇f(x k)其中,x k+1是下一个解的估计值,x k是当前解的估计值,α是步长,∇f(x k)是目标函数在x k处的梯度。

最优化问题的算法迭代格式

最优化问题的算法迭代格式

最优化问题是指在一定的条件下,寻找使某个目标函数取得极值(最大值或最小值)的变量取值。

解决最优化问题的方法有很多种,其中较为常见的是迭代法。

本文将介绍几种常用的最优化问题迭代算法及其格式。

一、梯度下降法

梯度下降法是一种基于负梯度方向进行搜索的迭代算法,它通过不断地沿着目标函数的负梯度方向进行搜索,逐步接近极值点。

该方法具有收敛速度快、易于实现等优点,在许多应用领域中被广泛使用。

1. 算法描述

对于目标函数 $f(x)$,初始点 $x_0$ 和学习率 $\alpha$,梯度下降算法可以描述为以下步骤:

- 计算当前点 $x_k$ 的梯度 $\nabla f(x_k)$;

- 更新当前点 $x_k$ 为 $x_{k+1}=x_k-\alpha\nabla f(x_k)$;

- 如果满足停止条件,则输出结果;否则返回第 1 步。

2. 算法特点

- 沿着负梯度方向进行搜索,能够快速收敛;

- 学习率的选择对算法效果有重要影响;

- 可能会陷入局部极小值。

二、共轭梯度法

共轭梯度法是一种基于线性方程组求解的迭代算法,它通过不断地搜索与当前搜索方向共轭的新搜索方向,并在该方向上进行一维搜索,逐步接近极值点。

该方法具有收敛速度快、内存占用少等优点,在大规模问题中被广泛使用。

1. 算法描述

对于目标函数 $f(x)$,初始点 $x_0$ 和初始搜索方向 $d_0$,共轭梯度算法可以描述为以下步骤:

- 计算当前点 $x_k$ 的梯度 $\nabla f(x_k)$;

- 如果满足停止条件,则输出结果;否则进行下一步;

- 计算当前搜索方向 $d_k$;

- 在当前搜索方向上进行一维搜索,得到最优步长 $\alpha_k$;

- 更新当前点为 $x_{k+1}=x_k+\alpha_k d_k$;

- 计算新的搜索方向 $d_{k+1}$;

- 返回第 2 步。

2. 算法特点

- 搜索方向与前面所有搜索方向都正交,能够快速收敛;

- 需要存储和计算大量中间变量,内存占用较大;

- 可以用于非线性问题的求解。

三、牛顿法

牛顿法是一种基于二阶导数信息进行搜索的迭代算法,它通过不断地利用目标函数的局部二次近似来逐步接近极值点。

该方法具有收敛速度快、精度高等优点,在许多应用领域中被广泛使用。

1. 算法描述

对于目标函数 $f(x)$,初始点 $x_0$,牛顿法可以描述为以下步骤:

- 计算当前点 $x_k$ 的梯度 $\nabla f(x_k)$ 和 Hessian 矩阵

$H(x_k)$;

- 如果满足停止条件,则输出结果;否则进行下一步;

- 解线性方程组 $H(x_k) d_k=-\nabla f(x_k)$ 得到搜索方向 $d_k$;- 在当前搜索方向上进行一维搜索,得到最优步长 $\alpha_k$;

- 更新当前点为 $x_{k+1}=x_k+\alpha_k d_k$;

- 返回第 2 步。

2. 算法特点

- 利用了二阶导数信息,收敛速度快;

- 需要计算和存储 Hessian 矩阵,内存占用较大;

- 可能会陷入局部极小值。

四、拟牛顿法

拟牛顿法是一种基于二阶导数信息的近似方法,它通过不断地更新Hessian 矩阵的近似来逐步接近极值点。

该方法具有收敛速度快、不

需要计算和存储Hessian 矩阵等优点,在许多应用领域中被广泛使用。

1. 算法描述

对于目标函数 $f(x)$,初始点 $x_0$ 和初始 Hessian 近似矩阵 $B_0$,拟牛顿法可以描述为以下步骤:

- 计算当前点 $x_k$ 的梯度 $\nabla f(x_k)$;

- 如果满足停止条件,则输出结果;否则进行下一步;

- 解线性方程组 $B_k d_k=-\nabla f(x_k)$ 得到搜索方向 $d_k$;- 在当前搜索方向上进行一维搜索,得到最优步长 $\alpha_k$;

- 更新当前点为 $x_{k+1}=x_k+\alpha_k d_k$;

- 计算新的 Hessian 近似矩阵 $B_{k+1}$;

- 返回第 2 步。

2. 算法特点

- 不需要计算和存储 Hessian 矩阵,内存占用较小;

- 可以用于非线性问题的求解;

- 可能会陷入局部极小值。

五、总结

本文介绍了最优化问题的几种常用迭代算法及其格式,包括梯度下降法、共轭梯度法、牛顿法和拟牛顿法。

这些算法各有优缺点,应根据具体问题选择合适的算法进行求解。

同时,学习率和停止条件的选择对算法效果也有重要影响,需要根据实际情况进行调整。