第三章 回归分析

- 格式:pdf

- 大小:540.17 KB

- 文档页数:32

第三章_回归分析基本方法最小二乘法回归分析是统计学中一种通过建立变量之间的关系模型来预测或解释变量之间关系的方法。

最常用的回归分析方法之一是最小二乘法。

最小二乘法是一种通过最小化观测值与预测值之间的误差平方和来估计模型参数的方法。

最小二乘法的基本原理是寻找一条直线或曲线,使得该直线或曲线上的点到各观测值的距离之和最小。

最小二乘法的数学表达式可以表示为:$$\min_{\beta_0,\beta_1,...,\beta_k} \sum_{i=1}^{n}(y_i -(\beta_0 + \beta_1x_{i1} + ... + \beta_kx_{ik}))^2$$其中,$y_i$为观测值,$x_{ij}$为自变量,$\beta_0$为截距,$\beta_1$到$\beta_k$为模型参数。

在实际应用中,最小二乘法可以应用于各种回归模型,如简单线性回归、多元线性回归、非线性回归等。

简单线性回归是最简单的回归模型,假设自变量和因变量之间存在线性关系。

简单线性回归的数学表达式为:$$y = \beta_0 + \beta_1x + \epsilon$$其中,$y$为因变量,$x$为自变量,$\beta_0$为截距,$\beta_1$为斜率,$\epsilon$为误差项。

通过最小二乘法求解简单线性回归模型的参数$\beta_0$和$\beta_1$,可以得到回归方程的估计值。

利用回归方程,可以对因变量进行预测或解释。

多元线性回归是简单线性回归的扩展,假设自变量和因变量之间存在线性关系,但自变量有多个。

多元线性回归的数学表达式为:$$y = \beta_0 + \beta_1x_1 + \beta_2x_2 + ... + \beta_kx_k + \epsilon$$其中,$y$为因变量,$x_1$到$x_k$为自变量,$\beta_0$为截距,$\beta_1$到$\beta_k$为斜率,$\epsilon$为误差项。

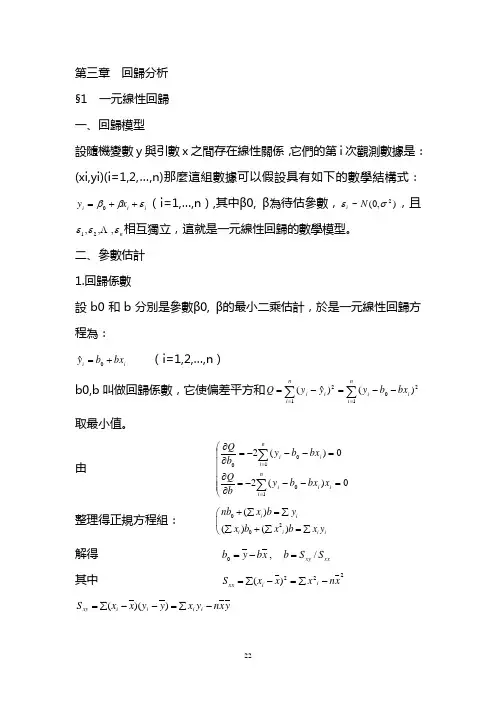

第三章 回歸分析 §1 一元線性回歸 一、回歸模型設隨機變數y 與引數x 之間存在線性關係,它們的第i 次觀測數據是:(xi,yi)(i=1,2,…,n)那麼這組數據可以假設具有如下的數學結構式:i i i x y εββ++=0(i=1,…,n ),其中β0, β為待估參數,),0(~2σεN i ,且n εεε,,,21 相互獨立,這就是一元線性回歸的數學模型。

二、參數估計 1.回歸係數設b0和b 分別是參數β0, β的最小二乘估計,於是一元線性回歸方程為:i i bx b y+=0ˆ (i=1,2,…,n ) b0,b 叫做回歸係數,它使偏差平方和∑∑==--=-=ni i i ni i i bx b y yy Q 12012)()ˆ(取最小值。

由 ⎝⎛=---=∂∂=---=∂∂∑∑==0)(20)(210100ni i i i ni i i x bx b y b Q bx b y b Q整理得正規方程組: 020()()()i ii i i inb x b y x b x b x y +∑=∑⎛∑+∑=∑⎝解得 xx xy S S b x b y b /,0=-= 其中 222)(x n x x x S i i xx -∑=-∑=y x n y x y y x x S i i i i xy -∑=--∑=))((另外 y n y y y S i i yy -∑=-∑=22)( 2.最小二乘估計b0,b 的統計性質 (1)E(b)= β,E(b0)= β0即b0,b 分別是β0,β的無偏估計 (2)22()/()i D b x x σ=∑-22201()[/()]i D b x x x nσ=+∑-即回歸係數b0,b 與σ2,x 的波動大小有關,b0還與n 有關,這就是說,x 值越分散,數據越多,估計b0,b 越精確。

三、假設檢驗 1.回歸方程顯著性檢驗欲檢驗y 與x 之間是否有線性關係,即檢驗假設H0:β=0。

第三章回归分析基本方法最小二乘法回归分析是统计学中一种常用的方法,主要用于研究一个或多个自变量与因变量之间关系的强度和方向。

在回归分析中,最常用的方法是最小二乘法。

最小二乘法是一种通过最小化观测值与拟合值之间的平方误差来估计参数的方法。

其基本思想是通过找到使得平方误差最小的参数值来拟合数据。

最小二乘法可以应用于各种类型的回归模型,包括简单线性回归和多元线性回归。

在简单线性回归中,我们研究一个自变量与一个因变量之间的关系。

假设我们有一组观测数据(x_i,y_i),其中x_i为自变量的取值,y_i为相应的因变量的取值。

我们想要找到一条直线来拟合这些数据点,使得误差最小化。

最小二乘法的目标是找到最合适的斜率和截距来拟合数据,最小化残差平方和。

具体而言,假设我们的模型为y=β_0+β_1*x,其中β_0为截距,β_1为斜率。

我们的目标是找到最合适的β_0和β_1来最小化残差平方和,即最小化∑(y_i-(β_0+β_1*x_i))^2最小二乘法的求解过程是通过对残差平方和关于β_0和β_1求偏导数,令偏导数为0,得到关于β_0和β_1的方程组。

通过求解这个方程组,我们可以得到最佳的β_0和β_1的估计值。

在多元线性回归中,我们考虑多个自变量与一个因变量之间的关系。

假设我们有p个自变量,我们的模型可以表示为y=β_0+β_1*x_1+β_2*x_2+...+β_p*x_p。

最小二乘法的求解过程与简单线性回归类似,只是需要求解一个更复杂的方程组。

最小二乘法在回归分析中的应用非常广泛。

它可以用于预测和建模,也可以用于建立因果关系的推断。

此外,最小二乘法还可以用于进行参数估计和统计检验。

总结起来,最小二乘法是一种基本的回归分析方法,通过最小化观测值与拟合值之间的平方误差来估计参数。

它在简单线性回归和多元线性回归中都有广泛应用,是统计学中重要的工具之一。