手机射频参数校准简介

- 格式:ppt

- 大小:1.02 MB

- 文档页数:5

一、生产线对每一个PCBA进行射频参数校准的必要性由于PCBA元器件之间的硬件偏差导致的射频接收发射参数的偏差GSM规范苛刻的射频指标要求,包括接收电平,发射功率,频率误差等。

二、校准基本原理-利用软件参数的方法来补偿硬件一致性偏差带来的射频参数偏差。

MTK软件提供可以用来存储射频校准参数的数据结构(对应CAL.ini文件)和校准软件工具ATE。

手机在实际网络工作的时候会调用这些已经校准的参数来优化射频的性能。

三、手机射频参数校准的内容和合格范围:手机的射频包括接收机,发射机和频率合成器电路,软件校准也是针对这三部分的硬件参数进行校准的频率合成器校准(即AFC校准),手机的频率合成器由PLL锁相环构成.射频校准原理和设置-AFC校准由锁相环的原理知道,在锁相环锁定以后RF VCO的输出频率:Fvco=26M/N,即RFVCO的频率稳定度和频率精度由26MHz晶体振荡器的频率精度决定,所以校准射频频率合成器的频率精度就等于是校准26MHz晶体振荡器的频率精度。

GSM规范要求手机的发射和接收信道频率精确度要在0.1ppm之内,手机通过接收基站的频率校准信道的信息,然后通过AFC去控制射频的VCTCXO可以将射频的频率误差控制在0.1ppm之内。

可是每个TCXO之间存在着硬件偏差,所以需要校准。

AFC校准参数:Initial DAC value;Slope;AFC初始DAC值Initial value,该值的范围从0~8191,对应AFC控制电压0~2.8V,校准完以后该值应该对应常温频率误差等于0的值,如三星TCXO校准完以后Initial value为4750压控灵敏度slope,AFC slope为单位DAC值能改变的射频频率误差,比如三星TCXO slope为2.7代表AFC DAC值每增加/减少1,对应的射频频率将增加/减少2.7Hz,手机通过比较本身产生的射频频率跟基站广播信道频率的误差计算出应该增加或者减少的AFC DAC值,从而保持跟基站频率同步,跟基站的频率误差控制在0.1ppm之内。

射频(RF)指标的定义和要求1 接收灵敏度(Rx sensitivity)(1)定义接收灵敏度是指收信机在满足一定的误码率性能条件下收信机输入端需输入的最小信号电平。

衡量收信机误码性能主要有帧删除率(FER)、残余误比特率(RBER)和误比特率(BER)三个参数。

这里只介绍用残余误比特率(RBER)来测量接收灵敏度。

残余误比特率(RBER)的定义为接收到的错误比特与所有发送的的数据比特之比。

(2)技术要求●对于GSM900MHz频段接收灵敏度要求:当RF输入电平为一102dBm时,RBER不超过2%。

测量时可测试实际灵敏度指标。

根据多款移动电话的测试结果来看:当RBER=2%时,若RF输入电平为-l09一l07dBm,则接收灵敏度为优;若RF输入电平为-l07一l05dBm,则接收灵敏度为良好;若RF输入电平为-105一l02dBm,则接收灵敏度为一般;若RF输入电平>-l02dBm,则接收灵敏度为不合格。

●对于DCSl800MHz频段接收灵敏度要求:当RF输入电平为-l00dBm,RBER不超过2%。

测量时可测试实际灵敏度指标。

根据多款移动电话的测试结果来看:当RBER=2%时,若RF输入电平为一l08一-105dBm,则接收灵敏度为优;若RF输入电平为一105-- -l03dBm,则接收灵敏度为良好;若RF输入电平为-l03一 -100dBm,则接收灵敏度为一般;若RF输入电平为>-l00 dB mm,则接收灵敏度为不合格。

2频率误差Fe、相位误差峰值Pepeak、相位误差有效值PeRMS(1)定义测量发射信号的频率和相位误差是检验发信机调制信号的质量。

GSM调制方案是高斯最小移频键控(GMSK),归一化带宽为BT=0.3。

发射信号的相位误差定义为:发信机发射信号的相位与理论上最好信号的相位之差。

理论上的相位轨迹可根据一个己知的伪随机比特流通过GMSK脉冲成形滤波器得到。

频率误差定义为考虑了调制和相位误差的影响以后,发射信号的频率与该绝对射频频道号(ARFCH)对应的标称频率之间的差。

GSM RF Test Parameters Introduction一.射频测试项目TX功率测试:Power vs Time, Power vs PCL1.发射载频包络(Power Ramp):Power vs Time1)、定义:发信载频包络是指发信载频功率相对于时间的关系。

由于 GSM 系统是一个 TDMA的系统,八个用户共用一个频点,手机只在分配给它的时间内打开,然后必须及时关闭,以免影响相邻时隙的用户。

由于这一原因,GSM 规范对一个时隙中的 RF突发的幅度包络作了规定,对于时隙中间有用信号的平坦度也作了相应的规定,这个幅度包络在 577us 的一个时隙内,其动态范围大于 70dB,而时隙有用部分平坦度应小于±1dB。

2)、目的:该测试主要是验证发射机发射的载频包络在一个时隙期间是否严格满足 GSM 规定的TDMA 时隙幅度的上升沿、下降沿及幅度平坦部分与模块的吻合程度。

手机发射突发信号的上升与下降部分应在+4dB--30dB,模块范围之内,顶部起伏部分应在±1dB 模板范围之内。

若突发信号超出模板范围,将会对临近时隙的用户产生干扰。

3)、测量:(1)、仪器连接如图一,点测或耦合测试;(2)、测试原理及方法:首先由 MS 按照一般的呼叫建立过程在一个绝对射频频道号(ARFCN)为 60~65之间的 TCH信道上建立一个呼叫,并将该 MS的功率控制电平设置为其最大功率等级设置该MS的时间提前量(TA)值为 0。

在综合测试仪CMU200设置BCCH AND TCH信道,选择并激活RF POWER RAMP 即可测试功率/时间特性。

对于移动台,有两种基本格式的突变:常规突发和接入突发,因而需要分别加以验证两种格式发信载频包络。

将 GSM规定的常规突发功率/时间模板与该突发的工作包络相比较,看其上升沿、下降沿及幅度平坦度是否在功率/时间模板的要求之内。

GSM 频段选 975、65、124 三个频段,功率级别选最大 LEVEL5;DCS频段选 512、700、885 三个频段,功率级别选最大 PCL LEVEL进行测试。

手机校准基本原理1 手机校准的原因一台手机,有大大小小几百个元器件,这些元器件即使是同一批次也会存在差异。

手机大批量生产,也不可能做到每台手机的性能完全一模一样。

所以我们需要一套校准方法,对这些由于硬件的不一致性所带来的偏差进行微调,从而使得手机能符合GSM通讯规范。

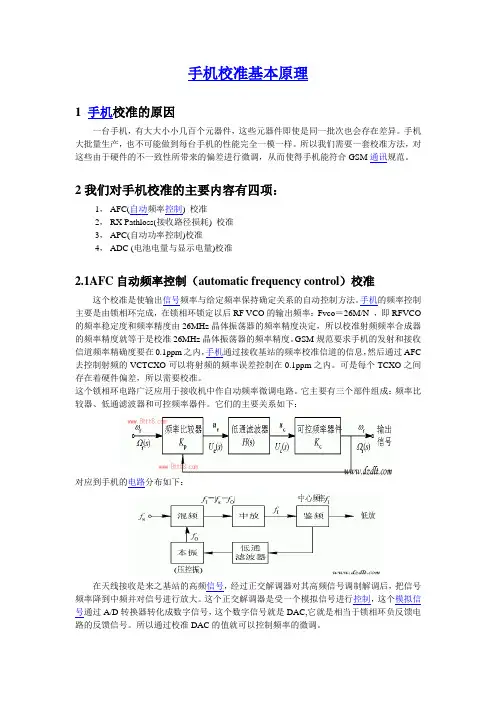

2我们对手机校准的主要内容有四项:1,AFC(自动频率控制) 校准2,RX Pathloss(接收路径损耗) 校准3,APC(自动功率控制)校准4,ADC (电池电量与显示电量)校准2.1AFC自动频率控制(automatic frequency control)校准这个校准是使输出信号频率与给定频率保持确定关系的自动控制方法。

手机的频率控制主要是由锁相环完成,在锁相环锁定以后RF VCO的输出频率:Fvco=26M/N ,即RFVCO 的频率稳定度和频率精度由26MHz晶体振荡器的频率精度决定,所以校准射频频率合成器的频率精度就等于是校准26MHz晶体振荡器的频率精度。

GSM规范要求手机的发射和接收信道频率精确度要在0.1ppm之内,手机通过接收基站的频率校准信道的信息,然后通过AFC 去控制射频的VCTCXO可以将射频的频率误差控制在0.1ppm之内。

可是每个TCXO之间存在着硬件偏差,所以需要校准。

这个锁相环电路广泛应用于接收机中作自动频率微调电路。

它主要有三个部件组成:频率比较器、低通滤波器和可控频率器件。

它们的主要关系如下:对应到手机的电路分布如下:在天线接收是来之基站的高频信号,经过正交解调器对其高频信号调制解调后,把信号频率降到中频并对信号进行放大。

这个正交解调器是受一个模拟信号进行控制,这个模拟信号通过A/D转换器转化成数字信号,这个数字信号就是DAC,它就是相当于锁相环负反馈电路的反馈信号。

所以通过校准DAC的值就可以控制频率的微调。

AFC(自动频率控制)校准的方法,就是通过寻找合适的ADC值,对信号从天线经过解调到中频放大到TRx的过程中的频率差值进行细微的校准。

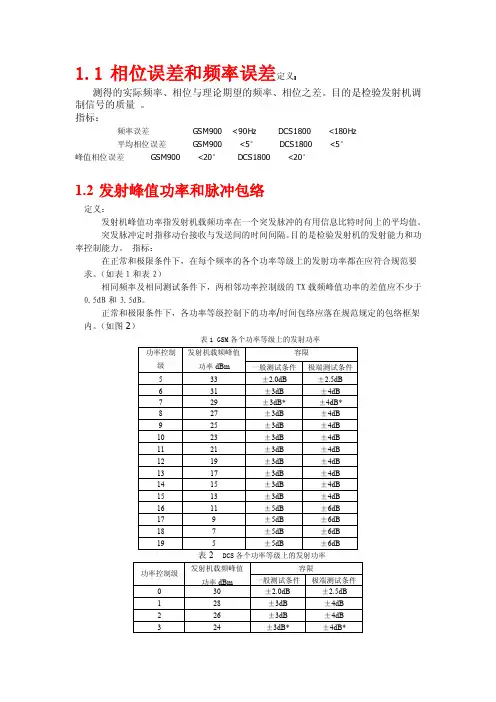

1.1相位误差和频率误差定义:测得的实际频率、相位与理论期望的频率、相位之差。

目的是检验发射机调制信号的质量。

指标:频率误差GSM900<90Hz DCS1800 <180Hz平均相位误差GSM900 <5°DCS1800 <5°峰值相位误差GSM900 <20°DCS1800 <20°1.2发射峰值功率和脉冲包络定义:发射机峰值功率指发射机载频功率在一个突发脉冲的有用信息比特时间上的平均值。

突发脉冲定时指移动台接收与发送间的时间间隔。

目的是检验发射机的发射能力和功率控制能力。

指标:在正常和极限条件下,在每个频率的各个功率等级上的发射功率都在应符合规范要求。

(如表1和表2)相同频率及相同测试条件下,两相邻功率控制级的TX载频峰值功率的差值应不少于0.5dB和3.5dB。

正常和极限条件下,各功率等级控制下的功率/时间包络应落在规范规定的包络框架内。

(如图2)表1 GSM各个功率等级上的发射功率DCS各个功率等级上的发射功率图1 常规突发脉冲功率/时间包络1.3发射输出频谱定义:调制谱:由连续调制和宽带噪声在标称载频的邻近频带上产生的频谱。

开关谱:由于功率切换而在标称载频的邻近频带上产生的频谱。

指标:表3 GSM调制谱指标表4 DCS调制谱指标表5 开关谱指标1.4接收机适用的输入电平范围定义:指接收机在满足规定的BER或FER条件下,接收机可使用的输入电平范围。

指标:接收机的RF输入电平范围满足:静态:-102dBm ~-15dBm (GSM900)-100dBm ~-23dBm(GSM1800)多径:- 102dBm~-40dBm(GSM900)-100dBm~-48dBm(GSM1800-1.53.系统设置:●Com SettingComport 为实际使用的串口。

Baudrate设为115200。

●Tester Setting将“Type”设为实际使用的测试仪类型(CMU200\AG8960)。

1.手机校准测试的项目内容有哪些?手机校准主要是针对RF参数的校准,比如AFC、AGC、APC,另外,还有电池ADC的校准、温度校准,要看不同平台的要求,校准的项目也不同,但是大体相同。

AFC校准是为了保证手机的时钟频率能正确的与网络同步。

AGC校准手机从天线端接收到的信号强度大约在–110dBm至–10dBm之间(这可能会稍微超出GSM05.05定义的范围),但BBC基带转换器(BaseBand Converter)输入信号的可接受动态范围没有这么大,AGC校准是为了保证输入到手机BBC的信号强度在BBC的可操作范围内。

APC校准影响功率的一般有两个参数,一个是Power Ramp(时间包络) 它表现了一个时隙的打开和关闭是否合理,另一个是PA Offset。

前者会对输出频谱和TimeMask(时隙)产生影响,因此,在研发阶段就要调好Power Ramp; 而后者,在Power Ramp固定的情况下,直接影响输出功率的大小。

APC校准就是调整PA Offset,保证手机的发射功率在各频段,各功率等级都能满足GSM05.05规范。

ADC的校准在我们的Windows Mobile设备上,锂离子电池的电量都是以“电量计”的形式显示的。

从电量计中,我们可以准确的读出设备中的电池还有多少剩余电量,精确到以1%为单位。

Windows Mobile设备长久以来一直以这种方式显示电池的电量信息。

很多人可能都遇到过在设备出现低电量报警之后软启动,电量计又显示还剩20-30%电量的问题,或者是系统提示已经充满电,但是电池电量计只显示到90%,而不是100%。

这时,我们就需要动手对电池的电量进行重新校准了。

也就是电池电量的显示与实际不符合。

2.校准的原理\算法是怎样的?校准的简单原理就是:由于器件不一致、温度变化、器件老化等因素的影响,即使是基于同样的平台同样的设计,也会表现出不同的电性能。

为了消除这种影响,每个手机在出厂之前都要对这些参数进行测量计算得到一些参数误差数据,并把这些误差数据存储到一定的存储介质(一般为EEPROM)里,在手机正常使用过程中,CPU会读取这些数据并利用一定的算法对需要补偿的参数进行补偿。

在几秒内完成手机射频校准—— R&SCMU200 创新的智能校准技术摘要在生产过程中 ,手机的射频校准要求对发射机、接收机和VCO 在全频率和功率范围内进行校准。

传统的校准过程需要几十秒的时间。

罗德与施瓦茨公司(R&S 的CMU200 独具智能校准选件(Smart Alignment ,CMU-K47, 采用了创新的测试方法,只需几秒就能完成手机的射频校准。

从而大大缩短测试时间 ,提高手机产量。

一、手机射频校准简介不论是 GSM/GPRS ,还是 cdma2000或 WCDMA 手机 ,其射频校准都可以分为发射机功率校准、接收机增益校准和 VCO ( 压控振荡器校准三部分。

发射机功率校准是让手机在不同频率下发射不同功率的信号 ,测试仪测量手机的实际发射功率 ,从而在全频段内校准手机的发射功率 ,如图 :接收机增益校准是让测试仪在不同的频率下发射不同功率的标准信号,手机测量接收信号强度RSSI 。

从而校准手机接收通路的增益,校准循环流程与发射机部分类似。

VCO 校准可以有两种方法。

方法一是让测试仪发射标准频率的信号,手机根据标准信号调整其 VCO ; 方法二是让手机在未与网络同步的条件下发射指定频率的信号 ,测试仪测出其频率误差 ,从而调整手机的 VCO 。

如果使用传统的校准方法 ,测试程序通过串行口或 USB 接口命令手机不断地改变频率和功率,并基于测试仪的测量结果计算相应的调整值,再写入手机的非挥发性RAM 里。

这样校准一个手机往往需要几十秒的时间。

而且 ,频段越多 ,测试的频率 / 功率越多 ,其耗时越长。

特别是 cdma2000和 WCDMA 手机 ,由于对功率的要求很严 , 要进行很多次不同频率 /功率下的射频校准 ,耗时会更长。

减少校准频率 /功率个数可以缩短测试时间 ,但其风险是可能会降低手机质量 ,必须谨慎对待。

因而 ,手机生产测试的要面对问题是 :如何既提高测试速度又能保证测试质量。

在几秒内完成手机射频校准——R&SCMU200创新的智能校准技术摘要在生产过程中,手机的射频校准要求对发射机、接收机和VCO 在全频率和功率范围内进行校准。

传统的校准过程需要几十秒的时间。

罗德与施瓦茨公司(R&S 的CMU200独具智能校准选件(Smart Alignment ,CMU-K47,采用了创新的测试方法,只需几秒就能完成手机的射频校准。

从而大大缩短测试时间,提高手机产量。

一、手机射频校准简介不论是GSM/GPRS ,还是cdma2000或WCDMA 手机,其射频校准都可以分为发射机功率校准、接收机增益校准和VCO (压控振荡器校准三部分。

发射机功率校准是让手机在不同频率下发射不同功率的信号,测试仪测量手机的实际发射功率,从而在全频段内校准手机的发射功率,如图:接收机增益校准是让测试仪在不同的频率下发射不同功率的标准信号,手机测量接收信号强度RSSI 。

从而校准手机接收通路的增益,校准循环流程与发射机部分类似。

VCO校准可以有两种方法。

方法一是让测试仪发射标准频率的信号,手机根据标准信号调整其VCO ;方法二是让手机在未与网络同步的条件下发射指定频率的信号,测试仪测出其频率误差,从而调整手机的VCO 。

如果使用传统的校准方法,测试程序通过串行口或USB接口命令手机不断地改变频率和功率,并基于测试仪的测量结果计算相应的调整值,再写入手机的非挥发性RAM里。

这样校准一个手机往往需要几十秒的时间。

而且,频段越多,测试的频率/功率越多,其耗时越长。

特别是cdma2000和WCDMA手机,由于对功率的要求很严,要进行很多次不同频率/功率下的射频校准,耗时会更长。

减少校准频率/功率个数可以缩短测试时间,但其风险是可能会降低手机质量,必须谨慎对待。

因而,手机生产测试的要面对问题是:如何既提高测试速度又能保证测试质量。

CMU200的智能校准选件可以解决这个问题,它巧妙利用手机的时隙/帧结构,可以在不减少测试频率/功率个数的前提下大大缩短手机射频校准时间,从而在不降低测试质量的前提下提高手机产量。

GSM手机射频指标及测试之一1推荐1)频率误差定义发射机的频率误差是指测得的实际频率与理论期望的频率之差。

它是通过测量手机的I/Q信号并通过相位误差做线性回归,计算该回归线的斜率即可得到频率误差。

频率误差是唯一要求在衰落条件下也要进行测试的发射机指标。

测试目的通过测量发射信号的频率误差可以检验发射机调制信号的质量和频率稳定度。

频率误差小,则表示频率合成器能很快地切换频率,并且产生出来的信号足够稳定。

只有信号频率稳定,手机才能与基站保持同步。

若频率稳定达不到要求(±0.1PPm),手机将出现信号弱甚至无信号的故障,若基准频率调节范围不够,还会出现在某一地方可以通话但在另一地方不能正常通话的故障。

GSM频段选1、62、124三个信道,功率级别选最大LEVEL5;DCS频段选512、698、885三个信道,功率级别选最大LEVEL0进行测试。

GSM频段的频率误差范围为+90HZ——-90HZ,频率误差小于40HZ时为最好,大于40HZ 小于60HZ时为良好,大于60HZ小于90HZ时为一般,大于90HZ时为不-合格;DCS频段的频率误差范围为+180H Z——-180HZ,频率误差小于80HZ时为最好,大于80HZ小于100HZ时为良好,大于100HZ小于180HZ时为一般,大于180HZ时为不合格。

2)相位误差定义发射机的相位误差是指测得的实际相位与理论期望的相位之差。

理论上的相位轨迹可根据一个已知的伪随机比特流通过0.3GMSK脉冲成形滤波器得到。

相位轨迹可看作与载波相位相比较的相位变化曲线。

连续的1将引起连续的90度相位的递减,而连续的0将引起连续的90度相位的递增。

峰值相位误差表示的是单个抽样点相位误差中最恶略的情况,而均方根误差表示的是所有点相位误差的恶略程度,是一个整体性的衡量。

测试目的通过测试相位误差了解手机发射通路的信号调制准确度及其噪声特性。

可以看出调制器是否正常工作,功率放大器是否产生失真,相位误差的大小显示了I、Q数位类比转换器和高斯滤波器性能的好坏。

手机射频测试的主要参数有:1)发射功率等级TX power level(5~19)2)频率误差frequency FER3)相位误差Phase PER4)射频频谱RF Spectrum5)开关谱SwitchSpectrum6)接受灵敏度RX Sensitivity7)调制谱Modulation Spectrum测试系统需要的主要设备:1)模拟基站的综合测试仪如德国罗德&施瓦茨(R&S)公司的CMU200、Aeroflex的PXI30002)通信专用电源如2304A双通道移动通讯高速电源,该电源在脉冲负载变化时展现了他显著的电压稳定性,同时能够测量负载电流。

对于测试需电池供电的无线通讯设备(例如便捷式电话),在非常短的时间间隔内经历真实的负载变化而言,这种电源是最优化的。

3)手机夹具等4)测试开发软件labview或VB等labview快速方便测试过程实际测量系统的工作过程是:1.手机开机,寻找与模拟基站CMU之间的频率同步;2.对PS(电源)与CMU或PXI3000进行初始化;3.初始化正确完成后在MSC上注册手机IMSI号;4.建立MS对BS(基站)的呼叫;5.当呼叫成功时,开始测量手机GSM900参数;6.首先测量信道1三个功率等级(Lv5,Lv10,Lv15)的发射功率;7.若符合标准,进入信道1的FER(频率误差)与PER(相位误差)测量;8.按同样的步骤测量信道62、123的发射功率、FER与PER;9.测量GSM900的Modulation Spectrum(调制谱)、SwitchSpectrum(开关谱);从GSM900切换到DCS1800;10.测量信道512,69 8,885的各发射功率,FER,PER,ModulationSpectrum和SwitchSpectrum;11.在测量过程中如果任何参数不符合标准,立即显示FAIL并生成报告退出,全部测试完毕显示PASS并生成报告退出。