hadoop教程Hive执行过程

- 格式:pptx

- 大小:500.21 KB

- 文档页数:35

hql执行流程HQL执行流程1. 概述HQL(Hive Query Language)是Hive中用来进行数据查询和操作的一种类似SQL的语言。

在Hive中,用户使用HQL来描述需要进行的数据查询和操作,然后Hive会将HQL转化为MapReduce作业来执行。

2. HQL执行流程简述HQL执行流程主要分为以下几个步骤:•HQL查询解析:首先,Hive将用户提交的HQL进行解析,分析HQL中的语法结构和语义,生成查询执行计划。

•优化器处理:接下来,HQL查询执行计划会被传递给优化器(Optimizer),优化器会根据一系列优化规则对查询执行计划进行优化,以提高查询性能。

•生成物理执行计划:优化器处理之后,会生成物理执行计划(Physical Execution Plan)。

物理执行计划是一个由一系列MapReduce任务组成的有向无环图,每个任务负责执行特定的操作。

•作业提交:生成的物理执行计划被提交给Hadoop集群,由集群管理器(如YARN)负责将任务分配给可用的计算资源。

•任务执行:在Hadoop集群中,每个MapReduce任务会进行数据的读取、计算和写出等操作,直到任务完成。

•结果返回:当所有任务都执行完毕后,结果会被返回到Hive客户端或存储在HDFS或其他存储系统中。

3. 详细解析HQL查询解析在这个阶段,Hive会对用户提交的HQL进行解析,检查语法和语义的正确性。

如果HQL存在语法错误或不符合Hive的语义规范,解析步骤会失败,提示错误信息给用户。

优化器处理在查询解析成功后,Hive会将查询执行计划传递给优化器进行优化。

优化器会根据一系列的优化规则对查询执行计划进行优化,以提高查询的性能。

例如,优化器可以通过适当的重新排序、合并操作来减少数据的读取和写入次数,从而提高查询的效率。

生成物理执行计划优化器处理完成后,会生成物理执行计划。

物理执行计划是一个有向无环图(DAG),每个节点代表一个MapReduce任务,节点之间的边表示数据的依赖关系。

hive工作原理流程Hive工作原理流程Hive是一个基于Hadoop的数据仓库基础架构工具,用于处理大规模数据集。

它提供了类似于SQL的查询语言,称为HiveQL,使用户可以使用类似于传统关系型数据库的方式来处理和分析数据。

Hive工作原理流程可以分为数据导入、数据处理和数据导出三个主要步骤。

1. 数据导入在Hive中,数据通常是从外部存储系统(如HDFS)导入的。

首先,用户需要创建一个外部表,定义表的模式和数据存储位置。

然后,通过Hive的LOAD命令将数据加载到创建的表中。

在加载数据之前,Hive还支持数据预处理操作,例如数据清洗、转换和分区等。

当数据成功加载到表中后,就可以进行后续的数据处理操作。

2. 数据处理Hive的数据处理主要通过HiveQL查询语言来实现。

用户可以使用HiveQL编写类似于SQL的查询语句,对表中的数据进行查询、过滤、聚合和排序等操作。

Hive将HiveQL查询转换为一系列的MapReduce任务,并在Hadoop集群上执行这些任务。

在查询过程中,Hive会根据表的元数据信息进行优化,例如使用分区和索引来提高查询性能。

同时,Hive还支持自定义函数和用户自定义聚合函数(UDF和UDAF),以满足特定的数据处理需求。

3. 数据导出在数据处理完成后,用户可以将结果数据导出到外部存储系统或其他应用程序中进行进一步分析或展示。

Hive提供了多种导出数据的方式,例如INSERT操作、CTAS(Create Table As Select)语句和INSERT OVERWRITE语句等。

用户可以根据需要选择合适的导出方式,并定义导出数据的格式和存储位置。

在导出数据之前,Hive还支持数据转换和格式化操作,以满足导出需求。

Hive的工作原理流程可以概括为数据导入、数据处理和数据导出三个主要步骤。

通过定义表结构和加载数据,用户可以在Hive中进行数据处理操作,使用HiveQL查询语言对数据进行查询、过滤和聚合等操作。

hive except all 实现原理-概述说明以及解释1. 引言1.1 概述Hive是一个基于Hadoop的数据仓库工具,可以方便地进行数据查询、分析和管理。

它使用类SQL语言HiveQL来操作数据,提供了类似于关系型数据库的查询语法和功能。

在大数据处理领域,Hive已经成为一个非常重要的工具,被广泛应用于数据仓库、数据分析和数据挖掘等领域。

在使用Hive进行数据处理时,经常需要进行数据对比和去重操作。

其中,EXCEPT ALL操作是常用的一种数据操作方法,可以帮助用户实现两个数据集之间的差集运算,并且保留重复记录。

本文将重点介绍Hive中的EXCEPT ALL操作的实现原理,帮助读者更好地理解Hive的使用和优化数据处理效率。

1.2 文章结构本文将首先对Hive进行概述,介绍其概念和特点。

然后详细讨论EXCEPT ALL操作在Hive中的应用,分析其操作原理和实现方式。

最后,结合实际案例,探讨EXCEPT ALL操作在数据处理中的应用场景,并展望未来可能的发展方向。

整篇文章将围绕着Hive中的EXCEPT ALL操作展开,为读者提供全面深入的了解和分析。

1.3 目的:在本文中,我们的主要目的是深入探讨hive中的EXCEPT ALL操作的实现原理。

我们将首先介绍Hive的概念和基本原理,然后详细分析EXCEPT ALL操作的语法和功能。

通过深入研究EXCEPT ALL操作的实现原理,我们可以更好地理解Hive中数据处理的机制,进一步提升我们在数据处理和查询优化方面的能力。

同时,通过对EXCEPT ALL操作的实现原理进行分析,我们可以更好地应用这一操作符来解决实际业务中的数据处理问题,提高数据处理的效率和准确性。

通过本文的学习,读者将能够深入了解Hive中EXCEPT ALL操作的内部工作原理,从而更好地应用于实际数据处理场景中。

2. 正文2.1 Hive概述Hive是一个基于Hadoop框架的数据仓库工具,它提供了类似于SQL 的查询语言HiveQL,使得用户可以通过简单的SQL语句在Hadoop集群上进行数据分析和查询。

hive运行机制流程

Hive是一个基于Hadoop的数据仓库工具,它使用类SQL语言(HQL)将数据处理作为一个查询任务。

下面是Hive的运行机制流程。

1. 建立数据仓库

首先需要建立数据仓库,Hive将数据存储在Hadoop分布式文件系统(HDFS)上,因此需要先在Hadoop上建立一个数据仓库,然后在Hive中定义一个与HDFS上相应目录路径对应的库。

2. 创建表

在Hive中使用HQL语句创建表,定义表的列名、类型和表的存储格式等信息。

此时只是在Hive元数据库中定义了一个表的结构,表的数据并没有写入到物理存储介质中。

3. 导入数据

可以使用Hive提供的LOAD DATA或INSERT语句将数据导入到建立的表中。

当数据导入到表中后,表中的数据才可以被查询和处理。

4. 执行SQL语句

使用HQL语句查询表中的数据。

Hive会将HQL语句转换成MapReduce作业,并将作业提交到Hadoop集群上执行。

Hadoop集群会根据MapReduce的执行过程,在每个节点上分配任务并运行,最终将结果返回给Hive。

5. 保存结果

执行完HQL语句后,Hive会将结果写入到HDFS中的相应路径下。

总结:

Hive的运行机制流程包括建立数据仓库、创建表、导入数据、执行SQL语句以及保存结果。

Hive将HQL语句转换成MapReduce作业运行在Hadoop集群上,最终将结果写入到HDFS中的相应路径下。

hive安装配置实验实训报告一、实验目的本实验旨在通过实际操作,掌握Hive的安装与配置过程,了解Hive的基本功能和使用方法,为后续的大数据处理和分析奠定基础。

二、实验环境1.硬件环境:高性能计算机,至少4核CPU、8GB内存、50GB 硬盘。

2.软件环境:Ubuntu 18.04操作系统,Java Development Kit (JDK) 1.8,Apache Hadoop 2.7.3。

三、实验步骤1.安装与配置Hadoop:首先,在实验环境中安装Hadoop,并配置Hadoop集群。

确保NameNode、SecondaryNameNode、DataNode等节点正常运行。

2.安装Hive:使用apt-get命令安装Hive。

在安装过程中,选择与Hadoop版本兼容的Hive版本。

3.配置Hive:编辑Hive的配置文件hive-site.xml,配置Hive连接到Hadoop集群的相关参数。

4.初始化Hive元数据:运行Hive的元数据初始化脚本,创建Hive元数据库。

5.启动Hive服务:使用以下命令启动Hive的元数据库、Metastore和HiveServer2等服务。

1.元数据库:hive --service metastore &2.Metastore:hive --service metastore &3.HiveServer2:hive --service hiveserver2 &6.测试Hive:使用Hive的命令行工具进入Hive交互式查询环境,执行简单的SQL查询语句,测试Hive是否安装成功。

四、实验结果与分析经过上述步骤,我们成功在实验环境中安装和配置了Hive。

通过执行简单的SQL查询语句,验证了Hive的基本功能。

具体而言,我们执行了以下查询语句:1.创建数据库:CREATE DATABASE mydatabase;2.选择数据库:USE mydatabase;3.创建表:CREATE TABLE mytable (id INT, name STRING);4.插入数据:INSERT INTO TABLE mytable VALUES (1, 'Alice'), (2, 'Bob');5.查询数据:SELECT * FROM mytable;6.删除表:DROP TABLE mytable;7.删除数据库:DROP DATABASE mydatabase;通过这些查询语句的执行,我们验证了Hive的基本功能,包括数据库管理、表创建、数据插入、数据查询、表删除和数据库删除等。

hive的sql执行流程

Hive的SQL执行流程大致可以分为以下几个步骤:

1. SQL解析与编译:Hive首先将输入的SQL查询语句进行解析,将其转化为抽象语法树(AST)。

然后,这个AST会被转换成逻辑执行计划。

在编译阶段,Hive会进行一些优化,比如重新排序操作,以改进查询的效率。

2. 元数据访问:在编译阶段,Hive会访问元数据(metadata)来获取表的结构、列的数据类型等信息。

这些信息对于后续的查询优化和执行非常重要。

3. 生成物理执行计划:基于逻辑执行计划和元数据信息,Hive会生成物理

执行计划。

物理执行计划包含了如何实际执行查询的具体步骤,例如数据的加载、过滤、连接等操作。

4. 执行物理计划:物理执行计划被提交给执行引擎来执行。

这个阶段包括数据加载、过滤、排序、连接等操作,这些操作可能会涉及到Hive的不同组件,比如Hive Metastore、HiveServer2等。

5. 结果输出:查询完成后,结果会被返回给客户端。

如果查询是SELECT类型的,结果会被返回给客户端;如果查询是INSERT类型的,结果会被写入到HDFS或者其他存储系统中。

6. 清理:最后,Hive会进行一些清理工作,比如释放资源、清理临时文件等。

以上就是Hive的SQL执行流程。

需要注意的是,这个流程可能会因为Hive的不同版本或者配置有所不同。

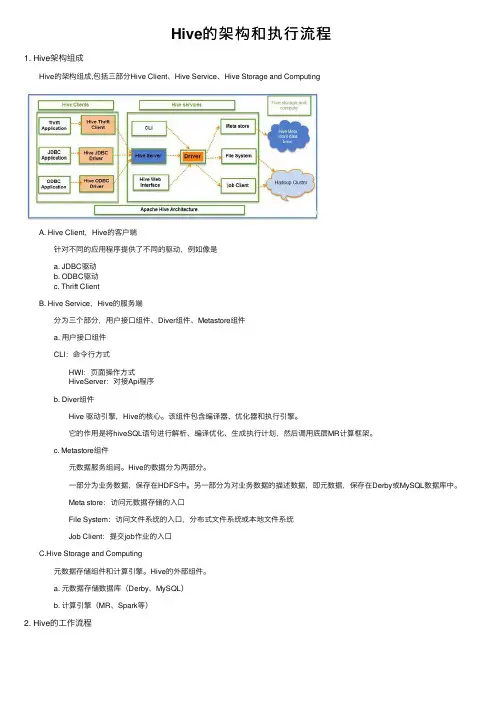

Hive的架构和执⾏流程1. Hive架构组成 Hive的架构组成,包括三部分Hive Client、Hive Service、Hive Storage and Computing A. Hive Client,Hive的客户端 针对不同的应⽤程序提供了不同的驱动,例如像是 a. JDBC驱动 b. ODBC驱动 c. Thrift Client B. Hive Service,Hive的服务端 分为三个部分,⽤户接⼝组件、Diver组件、Metastore组件 a. ⽤户接⼝组件 CLI:命令⾏⽅式 HWI:页⾯操作⽅式 HiveServer:对接Api程序 b. Diver组件 Hive 驱动引擎,Hive的核⼼。

该组件包含编译器、优化器和执⾏引擎。

它的作⽤是将hiveSQL语句进⾏解析、编译优化、⽣成执⾏计划,然后调⽤底层MR计算框架。

c. Metastore组件 元数据服务组间。

Hive的数据分为两部分。

⼀部分为业务数据,保存在HDFS中。

另⼀部分为对业务数据的描述数据,即元数据,保存在Derby或MySQL数据库中。

Meta store:访问元数据存储的⼊⼝ File System:访问⽂件系统的⼊⼝,分布式⽂件系统或本地⽂件系统 Job Client:提交job作业的⼊⼝ C.Hive Storage and Computing 元数据存储组件和计算引擎。

Hive的外部组件。

a. 元数据存储数据库(Derby、MySQL) b. 计算引擎(MR、Spark等)2. Hive的⼯作流程 A. 详细执⾏流程 a. 通过⽤户接⼝组件,如命令⾏⽅式、页⾯操作⽅式或不同驱动程序(JDBC、ODBC等)的客户端。

向Hive Driver发送执⾏命令。

⽬的是获取查询结果。

b. 获取查询计划,Driver拿到执⾏命令后,会向Complier(编译器)获取查询计划 c. 获取元数据信息,编译器⽣成查询计划,⾸先要获取相关的元数据信息。

hive工作原理Hive是一种基于Hadoop的数据仓库和分析系统,用于管理和查询大型数据集,其特点是可以使用类似SQL语句管理和查询数据,能够将复杂的数据分析任务简化成几条SQL语句就可以完成,从而极大地简化了复杂数据挖掘和大数据分析的工作,是当今最流行的大数据处理技术之一。

Hive的工作原理是通过将查询语句转换成MapReduce程序来执行。

当用户输入Hive SQL时,它将被转换成一系列的MapReduce操作,从而完成查询的任务。

Hive将用户输入的SQL语句转换成MapReduce以提高性能,以降低运行时间。

Hive由两部分组成:一部分是MapReduce程序,另一部分是Hive 服务器,用于管理查询和存储结果。

MapReduce程序用于执行HiveSQL 语句,根据用户的查询,返回查询结果。

Hive服务器是一个守护进程,用于管理查询,并将查询的结果返回给用户。

Hive服务器从HDFS 中检索数据,并在服务器上执行查询,并将结果返回给用户。

此外,它还可以将查询结果保存到HDFS中,以便用户可以在以后使用。

Hive的执行通常包括以下步骤:首先,Hive将用户输入的Hive SQL转换成MapReduce操作;然后,Hive将该MapReduce操作提交到HadoopDistributedFileSystem(HDFS),启动MapReduce任务;最后,MapReduce任务执行完毕后,Hive将结果返回给用户。

Hive支持自定义函数(UDF),使用户可以根据自己的需要定义函数,以便满足自己的数据挖掘需求。

UDFs可以用于更改数据的类型,操作或转换数据,计算数据的统计信息,等等,实现了更复杂的数据分析需求。

Hive还支持用户定义自定义存储格式,可以将数据存储在不同的格式中,以方便查询,比如压缩格式和分区表格式。

使用这种方式,Hive可以提高数据存储和查询的效率,从而提高系统性能。

Hive支持对HDFS上的数据进行并行处理,支持多种数据查询和分析,支持自定义函数,以及支持自定义存储格式,实现了大数据分析的高效性、准确性和可靠性的查询分析,为当今大数据时代的数据分析提供了一种理想的工具。

hive的读写流程一、数据的读取流程在Hive中,数据的读取流程主要包括以下几个步骤:1. 元数据的读取:Hive首先会读取元数据信息,元数据包括表的结构、分区信息、数据存储位置等。

元数据通常存储在关系型数据库中,如MySQL或Derby。

2. 解析SQL语句:Hive会解析用户提交的SQL语句,根据语法规则和元数据信息,确定查询的表、列和条件等。

3. 查询优化:Hive会对查询语句进行优化,包括选择合适的查询计划、调整查询顺序、剪枝无用的列或分区等。

优化的目标是提高查询性能和减少资源消耗。

4. 数据的读取:在优化后的查询计划中,Hive会根据数据存储位置和分区信息,从Hadoop集群的数据节点上读取数据。

数据可以存储在HDFS、HBase或其他存储系统中。

5. 数据的转换和处理:在读取数据后,Hive会根据查询语句中的转换函数、聚合函数或自定义函数,对数据进行转换和处理。

这些处理过程可以包括数据类型转换、数据过滤、数据排序等。

6. 结果的返回:经过数据转换和处理后,Hive会将查询结果返回给用户。

用户可以选择将结果保存到本地文件系统或其他存储系统中。

二、数据的写入流程在Hive中,数据的写入流程与读取流程类似,也包括以下几个步骤:1. 元数据的读取:与读取流程一样,Hive首先会读取元数据信息,确定写入数据的表结构和存储位置等。

2. 解析SQL语句:Hive会解析用户提交的SQL语句,确定写入数据的表和列等。

3. 数据的转换和处理:用户可以通过INSERT语句将数据写入Hive 表中。

在写入数据前,Hive可以对数据进行转换和处理,如数据类型转换、数据过滤、数据排序等。

4. 数据的划分和存储:Hive支持将数据按照分区进行存储,可以提高查询效率。

在写入数据时,用户可以选择指定数据的分区信息,或者使用动态分区功能。

5. 数据的排序和压缩:Hive支持对数据进行排序和压缩,可以提高查询性能和减少存储空间。

Hive详细教程为什么选择Hive?基于Hadoop的⼤数据的计算/扩展能⼒⽀持SQL like查询语⾔统⼀的元数据管理简单编程Hive的安装1.1在hadoop⽣态圈中属于数据仓库的⾓⾊。

他能够管理hadoop中的数据,同时可以查询hadoop中的数据。

本质上讲,hive是⼀个SQL解析引擎。

Hive可以把SQL查询转换为MapReduce中的job来运⾏。

hive有⼀套映射⼯具,可以把SQL转换为MapReduce中的job,可以把SQL中的表、字段转换为HDFS中的⽂件(夹)以及⽂件中的列。

这套映射⼯具称之为metastore,⼀般存放在derby、mysql中。

1.2 hive在hdfs中的默认位置是/user/hive/warehouse,是由配置⽂件hive-conf.xml中属性hive.metastore.warehouse.dir决定的。

2.hive的安装(1)解压缩、重命名、设置环境变量(2)在⽬录$HIVE_HOME/conf/下,执⾏命令mv hive-default.xml.template hive-site.xml重命名在⽬录$HIVE_HOME/conf/下,执⾏命令mv hive-env.sh.template hive-env.sh重命名(3)修改hadoop的配置⽂件hadoop-env.sh,修改内容如下:exportHADOOP_CLASSPATH=.:$CLASSPATH:$HADOOP_CLASSPATH:$HADOOP_HOME/bin (4)在⽬录$HIVE_HOME/bin下⾯,修改⽂件hive-config.sh,增加以下内容:export JAVA_HOME=/usr/local/jdkexport HIVE_HOME=/usr/local/hiveexport HADOOP_HOME=/usr/local/hadoop3.安装mysql(1)删除linux上已经安装的mysql相关库信息。

一、Hadoop简介1. 教学目标(1) 了解Hadoop的定义和发展历程(2) 掌握Hadoop的核心组件及其作用(3) 理解Hadoop在大数据领域的应用场景2. 教学内容(1) Hadoop的定义和发展历程(2) Hadoop的核心组件:HDFS、MapReduce、YARN(3) Hadoop的应用场景3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 引入话题:大数据与Hadoop(2) 讲解Hadoop的定义和发展历程(3) 介绍Hadoop的核心组件及其作用(4) 分析Hadoop的应用场景(5) 总结本节课的重点内容二、HDFS操作1. 教学目标(1) 掌握HDFS的基本概念和架构(2) 学会使用HDFS客户端进行文件操作(3) 了解HDFS的配置和优化方法2. 教学内容(1) HDFS的基本概念和架构(2) HDFS客户端的使用方法(3) HDFS的配置和优化方法3. 教学方法(1) 讲授(2) 实操演示(3) 互动讨论4. 教学步骤(1) 讲解HDFS的基本概念和架构(2) 演示HDFS客户端的使用方法(3) 介绍HDFS的配置和优化方法(4) 进行实操练习(5) 总结本节课的重点内容三、MapReduce编程模型1. 教学目标(1) 理解MapReduce的编程模型和原理(2) 掌握MapReduce的基本操作和编程步骤(3) 了解MapReduce的优缺点和适用场景2. 教学内容(1) MapReduce的编程模型和原理(2) MapReduce的基本操作和编程步骤(3) MapReduce的优缺点和适用场景3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 讲解MapReduce的编程模型和原理(2) 介绍MapReduce的基本操作和编程步骤(3) 分析MapReduce的优缺点和适用场景(4) 进行案例实操(5) 总结本节课的重点内容四、YARN架构与资源管理1. 教学目标(1) 理解YARN的架构和功能(2) 掌握YARN的资源管理和调度机制(3) 了解YARN的应用场景和优势2. 教学内容(1) YARN的架构和功能(2) YARN的资源管理和调度机制(3) YARN的应用场景和优势3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 讲解YARN的架构和功能(2) 介绍YARN的资源管理和调度机制(3) 分析YARN的应用场景和优势(4) 进行案例实操(5) 总结本节课的重点内容五、Hadoop生态系统简介1. 教学目标(1) 了解Hadoop生态系统的概念和组成(2) 掌握Hadoop生态系统中常用组件的功能和应用场景(3) 理解Hadoop生态系统的发展趋势2. 教学内容(1) Hadoop生态系统的概念和组成(2) Hadoop生态系统中常用组件:Hive、HBase、Pig、Sqoop、Flume(3) Hadoop生态系统的发展趋势3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 讲解Hadoop生态系统的概念和组成(2) 介绍Hadoop生态系统中常用组件的功能和应用场景(3) 分析Hadoop生态系统的发展趋势(六、Hive大数据处理平台1. 教学目标(1) 理解Hive的概念和架构(2) 掌握Hive的基本操作和数据处理能力(3) 了解Hive的应用场景和优缺点2. 教学内容(1) Hive的概念和架构(2) Hive的基本操作:表的创建、数据的导入和导出(3) Hive的数据处理能力:查询、统计、分析(4) Hive的应用场景和优缺点3. 教学方法(1) 讲授(2) 实操演示(3) 互动讨论4. 教学步骤(1) 讲解Hive的概念和架构(2) 演示Hive的基本操作(3) 介绍Hive的数据处理能力(4) 分析Hive的应用场景和优缺点(5) 进行实操练习(6) 总结本节课的重点内容七、HBase分布式数据库1. 教学目标(1) 理解HBase的概念和架构(2) 掌握HBase的基本操作和数据管理能力(3) 了解HBase的应用场景和优缺点2. 教学内容(1) HBase的概念和架构(2) HBase的基本操作:表的创建、数据的增删改查(3) HBase的数据管理能力:数据一致性、并发控制、灾难恢复(4) HBase的应用场景和优缺点3. 教学方法(1) 讲授(2) 实操演示(3) 互动讨论4. 教学步骤(1) 讲解HBase的概念和架构(2) 演示HBase的基本操作(3) 介绍HBase的数据管理能力(4) 分析HBase的应用场景和优缺点(5) 进行实操练习(6) 总结本节课的重点内容八、Pig大数据脚本语言1. 教学目标(1) 理解Pig的概念和架构(2) 掌握Pig的基本操作和数据处理能力(3) 了解Pig的应用场景和优缺点2. 教学内容(1) Pig的概念和架构(2) Pig的基本操作:LOAD、STORE、FILTER(3) Pig的数据处理能力:数据转换、数据清洗、数据分析(4) Pig的应用场景和优缺点3. 教学方法(1) 讲授(2) 实操演示(3) 互动讨论4. 教学步骤(1) 讲解Pig的概念和架构(2) 演示Pig的基本操作(3) 介绍Pig的数据处理能力(4) 分析Pig的应用场景和优缺点(5) 进行实操练习(6) 总结本节课的重点内容九、Sqoop数据迁移工具1. 教学目标(1) 理解Sqoop的概念和架构(2) 掌握Sqoop的基本操作和数据迁移能力(3) 了解Sqoop的应用场景和优缺点2. 教学内容(1) Sqoop的概念和架构(2) Sqoop的基本操作:导入、导出数据(3) Sqoop的数据迁移能力:关系数据库与Hadoop之间的数据迁移(4) Sqoop的应用场景和优缺点3. 教学方法(1) 讲授(2) 实操演示(3) 互动讨论4. 教学步骤(1) 讲解Sqoop的概念和架构(2) 演示Sqoop的基本操作(3) 介绍Sqoop的数据迁移能力(4) 分析Sqoop的应用场景和优缺点(5) 进行实操练习(6) 总结本节课的重点内容十、Flume数据采集系统1. 教学目标(1) 理解Flume的概念和架构(2) 掌握Flume的基本操作和数据采集能力(3) 了解Flume的应用场景和优缺点2. 教学内容(1) Flume的概念和架构(2) Flume的基本操作:配置文件编写、组件部署(3) Flume的数据采集能力:日志数据十一、日志数据处理实战1. 教学目标(1) 理解日志数据处理的重要性(2) 掌握使用Hadoop生态系统工具处理日志数据的方法(3) 能够设计日志数据处理流程2. 教学内容(1) 日志数据的特点和处理需求(2) 使用Hadoop生态系统中的工具(如LogParser, Flume, Hive, Pig)处理日志数据(3) 案例分析:构建一个简单的日志数据分析流程3. 教学方法(1) 讲授(2) 实操演示(3) 案例分析(4) 互动讨论4. 教学步骤(1) 讲解日志数据的特点和处理需求(2) 演示如何使用Hadoop生态系统工具处理日志数据(3) 通过案例分析,让学生设计一个简单的日志数据分析流程(4) 学生实操练习,应用所学知识处理实际日志数据(5) 总结本节课的重点内容,强调日志数据处理的最佳实践十二、大数据可视化分析1. 教学目标(1) 理解大数据可视化的重要性(2) 掌握使用可视化工具进行大数据分析的方法(3) 能够设计有效的大数据可视化方案2. 教学内容(1) 大数据可视化的概念和作用(2) 常用的大数据可视化工具:Tableau, QlikView, D3.js等(3) 如何选择合适的可视化工具和设计原则3. 教学方法(1) 讲授(2) 实操演示(3) 案例分析(4) 互动讨论4. 教学步骤(1) 讲解大数据可视化的概念和作用(2) 演示常用的大数据可视化工具的使用方法(3) 分析如何选择合适的可视化工具和设计原则(4) 通过案例分析,让学生设计一个大数据可视化方案(5) 学生实操练习,应用所学知识创建可视化分析(6) 总结本节课的重点内容,强调大数据可视化的最佳实践十三、大数据安全与隐私保护1. 教学目标(1) 理解大数据安全的重要性(2) 掌握大数据安全和隐私保护的基本概念(3) 了解大数据安全与隐私保护的技术和策略2. 教学内容(1) 大数据安全与隐私保护的基本概念(2) 大数据安全威胁和风险分析(3) 大数据安全和隐私保护技术和策略:加密、访问控制、匿名化等3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 讲解大数据安全与隐私保护的基本概念(2) 分析大数据安全威胁和风险(3) 介绍大数据安全和隐私保护技术和策略(4) 通过案例分析,让学生了解如何实施大数据安全与隐私保护(5) 总结本节课的重点内容,强调大数据安全和隐私保护的最佳实践十四、大数据应用案例分析1. 教学目标(1) 理解大数据在不同行业的应用(2) 掌握大数据解决方案的设计思路(3) 能够分析大数据应用案例,提取经验教训2. 教学内容(1) 大数据在各行业的应用案例:金融、医疗、零售、物流等(2) 大数据解决方案的设计思路和步骤(3) 分析大数据应用案例,提取经验教训3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 讲解大数据在各行业的应用案例(2) 分析大数据解决方案的设计思路和步骤(3) 通过案例分析,让学生提取大数据应用的经验教训(4) 学生实操练习,分析特定行业的大数据应用案例(5) 总结本节课的重点内容,强调大数据应用的最佳实践十五、大数据的未来趋势与职业规划1. 教学目标(1) 理解大数据发展的未来趋势(2) 掌握大数据行业职业规划的方向(3) 能够根据个人兴趣和能力规划大数据相关职业发展路径2. 教学内容(1) 大数据发展的未来趋势:技术、应用、产业等(2) 大数据行业职业规划的方向重点和难点解析本文主要介绍了Hadoop大数据开发基础教案,包括Hadoop基础操作、HDFS 操作、MapReduce编程模型、YARN架构与资源管理、Hadoop生态系统简介、Hive大数据处理平台、HBase分布式数据库、Pig大数据脚本语言、Sqoop数据迁移工具、Flume数据采集系统、日志数据处理实战、大数据可视化分析、大数据安全与隐私保护、大数据应用案例分析以及大数据的未来趋势与职业规划等十五个章节。

#hadoop⼊门第六篇:Hive实例前⾔ 前⾯已经讲了如何部署在hadoop集群上部署hive,现在我们就做⼀个很⼩的实例去熟悉HIVE QL.使⽤的数据是视频播放数据包括视频编码,播放设备编码,⽤户账号编码等,我们在这个数据基础上做⼀些简单查询统计等。

这是20170901 14点的部分播放⽇志动起来同步数据 实际上我这块数据是通过flume收集⽇志到hdfs上的,后续我也会简单介绍⼀下怎么通过flume收集⽇志到hdfs。

当然,下载我们的样例数据以后也可以通过${HADOOP_HOME}/bin/hdfs dfs -put命令建⽴相关⽬录:⽐如我的放在${HADOOP_HOME}/bin/hdfs dfs -mkdir /user/admin/logs/video_play/20170901/14 每层建⽴,最好两层是对应的表分区day ,hour建表:create external table log_video_play_request (logindex string,request_date string,video_auiddigest string,puiddigest string ,ver int,auiddigest string comment 'account identify',duiddigest string comment 'device identify',device_sign string ,xy_app_key string,ip string,port bigint,user_agent string, fromparameter string,zone bigint,sns_name string,sns_type bigint,country_code string,consume_country_code string,play_duration bigint,video_duration bigint,trace_id string,review_state int)partitioned by (day string ,hour string) row format delimitedfields terminated by '&'stored as textfilelocation '/user/admin/logs/video_play'接下来就是hive表加载数据了,⼤家可以参考这篇博⽂在这⾥⼤家在hive⾥⾯执⾏alter table log_video_play_request add partition(day='20170901',hour='14');注:select * from .. limit 10;试⼀下,如果结果为空,使⽤Load data inpath '/user/admin/logs/vide_play/20170901/14' overwrite into table log_video_play_request partition(day='20170901',hour='14')hive QL DDL语句表操作语句通⽤建表语句CREATE [EXTERNAL] TABLE [IF NOT EXISTS] table\_name[(col\_name data\_type [col\_comment],...)][COMMENT table\_comment][PARTITIONED BY (col\_name data\_type [col\_comment], col\_name data\_type [COMMENT col\_comment],...)][ROW FORMAT row\_format][STORED AS file\_format][LOCATION hdfs\_path]重命名表: ALTER TABLE table_name RENAME TO new_table_name添加字段:ALTER TABLE table_name ADD COLUMNS(col_name data_type [COMMENT col_comment],...)添加或者删除分区: ALTER TABLE table_name ADD PARTITION(pt1='xx',....) LOCATION 'hdfs_path'ALTER TABLE table_name DROP PARTITION(....)删除表: DROP TABLE table_name其他操作语句创建/删除视图 hive不⽀持物化视图,⽽从数仓的⾓度来说视图应⽤场景基本没有 CREATE VIEW [col_name] as SELECT ...创建/删除函数 udf udaf等后续会专门介绍show/describe: show paratitios table_name describe table_name[DOT col_name] describle table_name partition_spechive QL DML语句插⼊数据到表向数据表中加载⽂件:LOAD DATA [LOCAL] INPATH 'filepath' [OVERWRITE]INOT TABLE table\_name[PARTITION (partcol1=val1,partcol2=val2 ...)]将查询结果插⼊数据表中INSERT OVERWRITE TABLE tablename [PARTITION (partcol1=val1,partcol2=val2 ...)]select ....SQL操作基本语法:select where groupby distinct having join 等多路插⼊: multi insertFROM srcinsert overwrite table1 select ... where ...insert overwrite table2 select ... where ...多路插⼊还是很常见并且⾮常好的应⽤,⼀张⽇志表往往有多次的计算,⽤multi insert 可以节省多次的IO开销实例根据我们上⾯的log_video_play_requestselect * from log\_video\_play\_request where day = 20170901 limit 10;#查看各个模块播放select count(1) as total ,fromparameter from log\_video\_play\_request where day = 20170901 group by fromparameter order by total desc limit 100;#查看top创作者(视频被播放次数最多的⽤户)select count(1) as total,video\_auiddigest from log\_video\_play\_request where day = 20170901 group by video\_auiddigest order by total desc limit 100;。

简述hive的执行流程下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by theeditor. I hope that after you download them,they can help yousolve practical problems. The document can be customized andmodified after downloading,please adjust and use it according toactual needs, thank you!In addition, our shop provides you with various types ofpractical materials,such as educational essays, diaryappreciation,sentence excerpts,ancient poems,classic articles,topic composition,work summary,word parsing,copy excerpts,other materials and so on,want to know different data formats andwriting methods,please pay attention!Hive 是基于 Hadoop 的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单的 SQL 查询功能。

Hive和Hadoop是大数据生态系统中两个流行的工具,它们合作为存储,处理和分析大量数据提供了强大的评台。

在本篇文章中,我们将探讨Hive和Hadoop的工作原则及其如何相互补充,以便能够进行有效的数据处理和分析。

Hadoop是一个开源的分布式处理框架,旨在处理分布式服务器集裙的大量数据。

它基于MapReduce编程模型,该模型能够对集裙中多个节点的数据进行平行处理。

Hadoop的核心组件包括用于存储数据的Hdoop分布式文件系统(HDFS)和并行处理数据的MapReduce 框架。

另Hive是Hadoop顶部建设的数据仓库基础设施,提供类似SQL的接口,用于查询和分析存储在Hadoop的数据。

它允许用户编写SQL 查询与存储在Hadoop的数据互动,使得SQL—savvy分析师和数据科学家更容易与大数据合作。

Hive和Hadoop的工作原则是密切交织在一起的。

当用户通过蜂巢提交SQL查询时,该查询会被蜂巢查询编译器翻译成一系列的MapReduce工作。

这些 MapReduce 任务随后在 Hadoop 集裙上执行,该集裙处理数据并将结果返回 Hive 。

然后蜂巢以表格格式向用户介绍查询结果,使用户易于分析和可视化数据。

Hive和Hadoop如何合作的一个例子是数据储存和商业情报。

在传统的数据存储环境中,分析师和数据工程师经常使用基于SQL的工具来查询和分析存储在集中数据库中的数据。

然而,随着数据量的持续增长,传统的数据仓库可能难以跟上现代数据的规模和复杂性。

这是哈多普和蜂巢游戏的地方通过利用Hadoop的分布式处理能力和Hive的类似SQL的接口,各组织可以建立一个可扩展和成本效益高的数据存储解决方案,可以处理现代应用程序和系统产生的大量数据。

数据可以被摄入Hadoop的分布式文件系统,使用MapReduce框架并行处理,并使用Hive的SQL接口进行询问和分析。

临Τ 蜂巢提供了丰富的工具和图书馆生态系统,可以扩展其功能,如与Apache Spark进行实时处理的集成,以及支持机器学习和数据可视化工具。

hive 执行计划Hive执行计划。

Hive执行计划是指Hive在执行用户提交的HQL(Hive Query Language)时,生成的查询执行计划。

了解Hive执行计划对于优化查询性能和调试查询问题非常重要。

本文将介绍Hive执行计划的生成过程、执行计划的内容和如何解读执行计划。

生成过程。

当用户提交一个HQL查询时,Hive会先进行语法分析和语义分析,然后生成逻辑执行计划。

接着,Hive会根据逻辑执行计划进行优化,生成最终的物理执行计划。

最后,Hive会根据物理执行计划调用相应的执行引擎执行查询,获取查询结果。

执行计划内容。

Hive执行计划包括以下内容:1. 查询的逻辑计划,包括查询涉及的表、连接方式、过滤条件等逻辑信息。

2. 查询的物理计划,包括查询的具体执行方式,如MapReduce、Tez等执行引擎的执行计划。

3. 查询的优化信息,包括优化器对查询进行的优化操作,如谓词下推、Join重排等。

4. 查询的统计信息,包括表的大小、数据分布等统计信息,用于优化查询执行计划。

解读执行计划。

要正确解读执行计划,需要了解以下几点:1. 执行顺序,查看执行计划中各个操作的执行顺序,了解查询的执行流程。

2. 数据倾斜,查看执行计划中各个阶段的数据倾斜情况,及时发现和解决数据倾斜问题。

3. 执行统计信息,查看执行计划中的统计信息,了解查询涉及的表的大小、数据分布等信息,对查询进行优化。

4. 执行引擎选择,查看执行计划中使用的执行引擎,了解查询的具体执行方式,对比不同执行引擎的性能。

优化查询性能。

通过解读执行计划,可以发现查询中存在的性能问题,并进行相应的优化:1. 优化查询逻辑,根据执行计划中的逻辑信息,优化查询的SQL语句,减少不必要的计算和数据读取。

2. 优化数据倾斜,根据执行计划中的数据倾斜情况,采取相应的解决措施,如调整数据分布、增加分区等。

3. 选择合适的执行引擎,根据执行计划中的执行引擎选择,比较不同执行引擎的性能,选择最适合的执行引擎。

【原创】⼤数据基础之Hive(2)HiveSQL执⾏过程之SQL解析过程Hive SQL解析过程SQL->AST(Abstract Syntax Tree)->Task(MapRedTask,FetchTask)->QueryPlan(Task集合)->Job(Yarn)SQL解析会在两个地⽅进⾏:⼀个是SQL执⾏前compile,具体在pile,为了创建QueryPlan;⼀个是explain,具体在ExplainSemanticAnalyzer.analyzeInternal,为了创建ExplainTask;SQL执⾏过程1 compile过程(SQL->AST(Abstract Syntax Tree)->QueryPlan)org.apache.hadoop.hive.ql.Driverpublic int compile(String command, boolean resetTaskIds, boolean deferClose) {...ParseDriver pd = new ParseDriver();ASTNode tree = pd.parse(command, ctx);tree = ParseUtils.findRootNonNullToken(tree);...BaseSemanticAnalyzer sem = SemanticAnalyzerFactory.get(queryState, tree);...sem.analyze(tree, ctx);...// Record any ACID compliant FileSinkOperators we saw so we can add our transaction ID to// them later.acidSinks = sem.getAcidFileSinks();("Semantic Analysis Completed");// validate the plansem.validate();acidInQuery = sem.hasAcidInQuery();perfLogger.PerfLogEnd(CLASS_NAME, PerfLogger.ANALYZE);if (isInterrupted()) {return handleInterruption("after analyzing query.");}// get the output schemaschema = getSchema(sem, conf);plan = new QueryPlan(queryStr, sem, perfLogger.getStartTime(PerfLogger.DRIVER_RUN), queryId,queryState.getHiveOperation(), schema);...compile过程为先由ParseDriver将SQL转换为ASTNode,然后由BaseSemanticAnalyzer对ASTNode进⾏分析,最后将BaseSemanticAnalyzer传⼊QueryPlan构造函数来创建QueryPlan;1)将SQL转换为ASTNode过程如下(SQL->AST(Abstract Syntax Tree))org.apache.hadoop.hive.ql.parse.ParseDriverpublic ASTNode parse(String command, Context ctx, boolean setTokenRewriteStream)throws ParseException {if (LOG.isDebugEnabled()) {LOG.debug("Parsing command: " + command);}HiveLexerX lexer = new HiveLexerX(new ANTLRNoCaseStringStream(command));TokenRewriteStream tokens = new TokenRewriteStream(lexer);if (ctx != null) {if ( setTokenRewriteStream) {ctx.setTokenRewriteStream(tokens);}lexer.setHiveConf(ctx.getConf());}HiveParser parser = new HiveParser(tokens);if (ctx != null) {parser.setHiveConf(ctx.getConf());}parser.setTreeAdaptor(adaptor);HiveParser.statement_return r = null;try {r = parser.statement();} catch (RecognitionException e) {e.printStackTrace();throw new ParseException(parser.errors);}if (lexer.getErrors().size() == 0 && parser.errors.size() == 0) {LOG.debug("Parse Completed");} else if (lexer.getErrors().size() != 0) {throw new ParseException(lexer.getErrors());} else {throw new ParseException(parser.errors);}ASTNode tree = (ASTNode) r.getTree();tree.setUnknownTokenBoundaries();return tree;}2)analyze过程(AST(Abstract Syntax Tree)->Task)org.apache.hadoop.hive.ql.parse.BaseSemanticAnalyzerpublic void analyze(ASTNode ast, Context ctx) throws SemanticException {initCtx(ctx);init(true);analyzeInternal(ast);}其中analyzeInternal是抽象⽅法,由不同的⼦类实现,⽐如DDLSemanticAnalyzer,SemanticAnalyzer,UpdateDeleteSemanticAnalyzer,ExplainSemanticAnalyzer等;analyzeInternal主要的⼯作是将ASTNode转化为Task,包括可能的optimize,过程⽐较复杂,这⾥不贴代码;3)创建QueryPlan过程如下(Task->QueryPlan)org.apache.hadoop.hive.ql.QueryPlanpublic QueryPlan(String queryString, BaseSemanticAnalyzer sem, Long startTime, String queryId,HiveOperation operation, Schema resultSchema) {this.queryString = queryString;rootTasks = new ArrayList<Task<? extends Serializable>>(sem.getAllRootTasks());reducerTimeStatsPerJobList = new ArrayList<ReducerTimeStatsPerJob>();fetchTask = sem.getFetchTask();// Note that inputs and outputs can be changed when the query gets executedinputs = sem.getAllInputs();outputs = sem.getAllOutputs();linfo = sem.getLineageInfo();tableAccessInfo = sem.getTableAccessInfo();columnAccessInfo = sem.getColumnAccessInfo();idToTableNameMap = new HashMap<String, String>(sem.getIdToTableNameMap());this.queryId = queryId == null ? makeQueryId() : queryId;query = new org.apache.hadoop.hive.ql.plan.api.Query();query.setQueryId(this.queryId);query.putToQueryAttributes("queryString", this.queryString);queryProperties = sem.getQueryProperties();queryStartTime = startTime;this.operation = operation;this.autoCommitValue = sem.getAutoCommitValue();this.resultSchema = resultSchema;}可见只是简单的将BaseSemanticAnalyzer中的内容拷贝出来,其中最重要的是sem.getAllRootTasks和sem.getFetchTask;2 execute过程(QueryPlan->Job)org.apache.hadoop.hive.ql.Driverpublic int execute(boolean deferClose) throws CommandNeedRetryException {...// Add root Tasks to runnablefor (Task<? extends Serializable> tsk : plan.getRootTasks()) {// This should never happen, if it does, it's a bug with the potential to produce// incorrect results.assert tsk.getParentTasks() == null || tsk.getParentTasks().isEmpty();driverCxt.addToRunnable(tsk);...// Loop while you either have tasks running, or tasks queued upwhile (driverCxt.isRunning()) {// Launch upto maxthreads tasksTask<? extends Serializable> task;while ((task = driverCxt.getRunnable(maxthreads)) != null) {TaskRunner runner = launchTask(task, queryId, noName, jobname, jobs, driverCxt);if (!runner.isRunning()) {break;}}...private TaskRunner launchTask(Task<? extends Serializable> tsk, String queryId, boolean noName,String jobname, int jobs, DriverContext cxt) throws HiveException {...TaskRunner tskRun = new TaskRunner(tsk, tskRes);...tskRun.start();...tskRun.runSequential();...Driver.run中从QueryPlan中取出Task,并逐个launchTask,launchTask过程为将Task包装为TaskRunner,并最终调⽤TaskRunner.runSequential,下⾯看TaskRunner:org.apache.hadoop.hive.ql.exec.TaskRunnerpublic void runSequential() {int exitVal = -101;try {exitVal = tsk.executeTask();...这⾥直接调⽤Task.executeTaskorg.apache.hadoop.hive.ql.exec.Taskpublic int executeTask() {...int retval = execute(driverContext);...这⾥execute是抽象⽅法,由⼦类实现,⽐如DDLTask,MapRedTask等,着重看MapRedTask,因为⼤部分的Task都是MapRedTask:org.apache.hadoop.hive.ql.exec.mr.MapRedTaskpublic int execute(DriverContext driverContext) {...if (!runningViaChild) {// we are not running this mapred task via child jvm// so directly invoke ExecDriverreturn super.execute(driverContext);}...这⾥直接调⽤⽗类⽅法,也就是ExecDriver.execute,下⾯看:org.apache.hadoop.hive.ql.exec.mr.ExecDriverprotected transient JobConf job;...public int execute(DriverContext driverContext) {...JobClient jc = null;MapWork mWork = work.getMapWork();ReduceWork rWork = work.getReduceWork();...if (mWork.getNumMapTasks() != null) {job.setNumMapTasks(mWork.getNumMapTasks().intValue());}...job.setNumReduceTasks(rWork != null ? rWork.getNumReduceTasks().intValue() : 0);job.setReducerClass(ExecReducer.class);...jc = new JobClient(job);...rj = jc.submitJob(job);this.jobID = rj.getJobID();这⾥将Task转化为Job提交到Yarn执⾏;SQL Explain过程另外⼀个SQL解析的过程是explain,在ExplainSemanticAnalyzer中将ASTNode转化为ExplainTask:org.apache.hadoop.hive.ql.parse.ExplainSemanticAnalyzerpublic void analyzeInternal(ASTNode ast) throws SemanticException {...ctx.setExplain(true);ctx.setExplainLogical(logical);// Create a semantic analyzer for the queryASTNode input = (ASTNode) ast.getChild(0);BaseSemanticAnalyzer sem = SemanticAnalyzerFactory.get(queryState, input);sem.analyze(input, ctx);sem.validate();ctx.setResFile(ctx.getLocalTmpPath());List<Task<? extends Serializable>> tasks = sem.getAllRootTasks();if (tasks == null) {tasks = Collections.emptyList();}FetchTask fetchTask = sem.getFetchTask();if (fetchTask != null) {// Initialize fetch work such that operator tree will be constructed.fetchTask.getWork().initializeForFetch(ctx.getOpContext());}ParseContext pCtx = null;if (sem instanceof SemanticAnalyzer) {pCtx = ((SemanticAnalyzer)sem).getParseContext();}boolean userLevelExplain = !extended&& !formatted&& !dependency&& !logical&& !authorize&& (HiveConf.getBoolVar(ctx.getConf(), HiveConf.ConfVars.HIVE_EXPLAIN_USER) && HiveConf.getVar(conf, HiveConf.ConfVars.HIVE_EXECUTION_ENGINE).equals("tez"));ExplainWork work = new ExplainWork(ctx.getResFile(),pCtx,tasks,fetchTask,sem,extended,formatted,dependency,logical,authorize,userLevelExplain,ctx.getCboInfo());work.setAppendTaskType(HiveConf.getBoolVar(conf, HiveConf.ConfVars.HIVEEXPLAINDEPENDENCYAPPENDTASKTYPES));ExplainTask explTask = (ExplainTask) TaskFactory.get(work, conf);fieldList = explTask.getResultSchema();rootTasks.add(explTask);}。