Simpana V10 重复数据删除(20130718)

- 格式:pptx

- 大小:1012.63 KB

- 文档页数:31

[键入文档标题]作者:IT168 李隽目录文件级与数据块级的重复数据删除....... 错误!未定义书签。

定长切割模式VS 非定长切割模式 ....... 错误!未定义书签。

基于备份源与基于目标端的重复数据删除. 错误!未定义书签。

不同重复数据删除方案的对比........... 错误!未定义书签。

不同条件下重复数据删除效果对比....... 错误!未定义书签。

重复数据删除如今已经不是新鲜的话题了,基本我们看到,市面上大部分备份产品已经具备重复数据删除功能,基本上已经成为备份领域产品的一项必备的选项。

但是市面上重复数据删除的产品林林总总,有备份类的,也有集成在虚拟带库中的重复数据删除,而一些重复数据删除的概念也让用户感到迷惑,比如全局重复数据删除?比如带内和带外重复数据删除……对于用户来说,面对如此繁多的产品究竟该如何选择呢?本文将梳理市场上大部分主流重复数据删除的产品的特点,并分析优劣势,帮助用户选择合适的重复数据删除产品。

文件级与数据块级的重复数据删除首先我们看一下重复数据删除的定义。

所谓重复数据删除,就是说我们要把一些相关的数据,它是一些重复性的,把它从一些生产上删除掉,这样可以大大节省我们生产空间的增长速度,从而降低我们的电耗,而且降低整个管理成本。

目前来说,大部分重复数据删除都采用了相似的处理过程,首先是通过特定的算法,把一个文件切割成不同的小块,其次是比较这些块的不同性,把一些重复的删除掉。

对于文件级的数据来说,组成文件的数据块其实是存在重复的,当文件被切割成更小的数据块后,重复率就大大增加了,然后系统在每个切割的数据块前面增加指针和索引,记录这些块是怎样组合成文件的。

再有文件记录进来,文件被打碎成小的数据块,系统就只会记录和已经的数据块不同的数据块。

并能够根据数据块前面的索引信息,将打碎后保存的唯一的数据块组合成文件。

将文件打碎成小的数据块,删除重复的数据块后,只存储唯一的数据块。

重复数据删除技术简介这篇文章基于现有的SNIA材料,描述了重复数据删除流程可以进行的几个不同的地方;探讨了压缩与单实例文件以及重复数据删除之间的不同点;研究了次文件层重复数据删除执行的几个不同方式。

它同时还解释了哪种类型的数据适合重复数据删除,以及哪些不适合。

介绍重复数据删除已经成为存储行业非常热门的话题和一大类商业产品。

这是因为重复数据删除可以大幅减少购置和运行成本,同时提高存储效率。

随着数据量的爆炸性增长,接近一半的数据中心管理员都将数据增长评为三大挑战之一。

根据最近的Gartner调查结果,重复数据删除可以减轻存储预算的压力并帮助存储管理员应对数据的增长。

虽然重复数据删除主要被视为一种容量优化技术,不过该技术也可以带来性能上的好处--随着所需存储的数据的减少,系统所需迁移的数据也减少。

重复数据删除技术可以应用在数据生命周期上的不同点上:从来源端重复数据删除,到传输中重复数据删除,一直到存储目标端重复数据删除。

这些技术还可以应用在所有的存储层上:备份、归档和主存储。

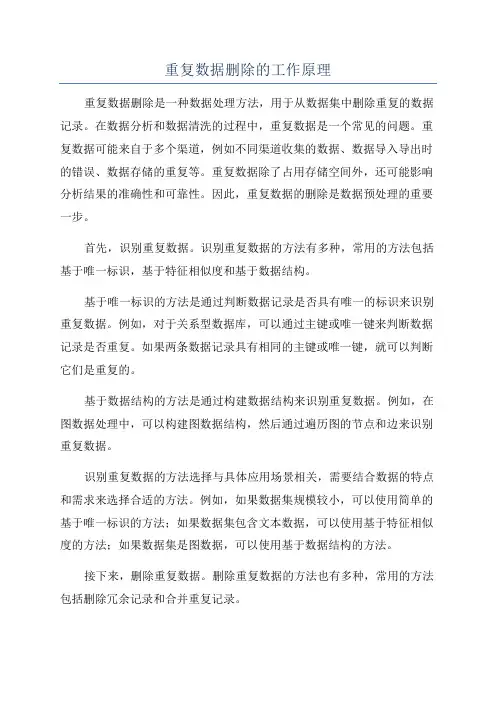

重复数据删除的解释无论使用哪种方式,重复数据删除就是一个在不同层次的粒度性上识别重复数据并将重复数据替代为指向共享复件的指针的过程,这样可以节约存储空间和迁移数据所需的带宽。

重复数据删除流程包括跟踪并识别那些被删除的重复数据,以及识别和存储那些新的和独一无二的数据。

数据的终端用户完全不会感到这些数据可能已经被执行重复数据删除流程并已经在其数据生命周期中被重建许多次。

对数据进行重复数据删除操作有几种不同的方式。

单实例存储(SIS)是在文件或块层次上进行重复数据删除。

重复副本会被一个带着指针的实例所取代,而指针则指向原始文件或对象。

次文件层重复数据删除的操作粒度则比文件或对象更小。

这种技术有两种常见的方式:固定块重复数据删除--数据被分解成固定长度的部分或块;可变长度重复数据删除--数据根据一个滑行的窗口进行重复数据删除。

数据压缩是对数据进行编码以减小它的大小;它还可以用于那些已经被重复数据删除的数据以进一步减少存储消耗。

重复数据删除的工作原理重复数据删除是一种数据处理方法,用于从数据集中删除重复的数据记录。

在数据分析和数据清洗的过程中,重复数据是一个常见的问题。

重复数据可能来自于多个渠道,例如不同渠道收集的数据、数据导入导出时的错误、数据存储的重复等。

重复数据除了占用存储空间外,还可能影响分析结果的准确性和可靠性。

因此,重复数据的删除是数据预处理的重要一步。

首先,识别重复数据。

识别重复数据的方法有多种,常用的方法包括基于唯一标识,基于特征相似度和基于数据结构。

基于唯一标识的方法是通过判断数据记录是否具有唯一的标识来识别重复数据。

例如,对于关系型数据库,可以通过主键或唯一键来判断数据记录是否重复。

如果两条数据记录具有相同的主键或唯一键,就可以判断它们是重复的。

基于数据结构的方法是通过构建数据结构来识别重复数据。

例如,在图数据处理中,可以构建图数据结构,然后通过遍历图的节点和边来识别重复数据。

识别重复数据的方法选择与具体应用场景相关,需要结合数据的特点和需求来选择合适的方法。

例如,如果数据集规模较小,可以使用简单的基于唯一标识的方法;如果数据集包含文本数据,可以使用基于特征相似度的方法;如果数据集是图数据,可以使用基于数据结构的方法。

接下来,删除重复数据。

删除重复数据的方法也有多种,常用的方法包括删除冗余记录和合并重复记录。

删除冗余记录是指直接删除重复数据记录。

例如,在关系型数据库中,可以使用DELETE语句来删除具有相同主键或唯一键的数据记录。

合并重复记录是指把重复的数据记录合并成一条记录。

这通常需要对数据进行一些数据处理和转换。

例如,在文本数据处理中,可以把两个文本的内容合并成一个文本;在图数据处理中,可以把两个节点合并成一个节点。

删除重复数据的方法选择与具体应用场景和需求相关。

例如,如果数据集规模较小,可以直接删除冗余记录;如果数据集包含大量重复数据但又不希望丢失信息,可以使用合并重复记录的方法。

重复数据删除的工作原理的具体实现与具体的数据处理工具和编程语言相关。

重复数据删除的工作原理作者:杨涛就在几年前,一提起备份大家就自然而然地想到磁带,但是在数据量爆炸式增长的今天,磁带技术由于其性能以及可靠性方面的固有缺陷变得越来越不能满足不断变化的业务需求,加之磁盘设备价格的下降,所以有越来越多的用户采用磁盘备份的解决方案。

但这在解决了性能和可靠性问题的同时又引入了新的问题——磁盘不能够象磁盘那样离线保存,不可能无限制的扩充容量,而用户数据增长的趋势却是无限的,并且由于其不能离线保存也导致了远程容灾数据的传送需要占用大量的带宽,这些都在经济上给用户造成了极大的压力。

那么有没有办法来缓解甚至解决这种磁盘容量的有限性和数据增长的无限性造成的矛盾呢?答案是“重复数据删除(Data de-duplication)”技术。

“重复数据删除”也称为“单实例存储(Single Instance Repository,简称SIR)”或者容量优化(Capacity Optimization),顾名思义,其根本作用是消减存储中的重复数据,以使任何一份数据只保存一份实例,达到充分利用存储空间的目的。

它是近年存储领域涌现出来的一门新兴技术,各大竞争厂商都生成其重复删除比可以达到1:20 左右甚至更高,被专家誉为是一种“将会改写存储行业的经济规则”的技术。

然而在实际和用户的接触中,大多数用户对该技术还存在许多疑问,诸如:“和增量备份有何区别”、“会不会造成数据损害”、“会不会影响备份性能”等等。

所以,在这里我们就详细探讨一下重复数据删除的工作原理。

首先,“重复数据删除”和“增量备份”是完全不同的概念。

“增量备份”是指只备份变化的文件;“重复数据删除”则是指只备份不重复的数据。

举个简单的例子说明它们的区别:比如有一个文件型数据库Access的文件finance..mdb ,如果向该库中新插入了几笔记录,那么则意味着该文件发生了变动。

当采用增量备份时会检查该文件的标志位,并将该文件整个重新备份;而如果使用“重复数据删除”技术,则只会备份新插入记录的数据。

删除数据库中重复数据的技巧在数据库中处理重复数据是非常常见的任务,这些重复数据会占用额外的存储空间,增加查询和操作的开销,并且可能导致数据不一致性的问题。

因此,删除数据库中的重复数据是非常重要的。

下面是一些可以帮助您处理数据库中重复数据的技巧:1.使用INNERJOIN和临时表:-创建一个临时表,用于存储重复的数据行。

-使用INNERJOIN将原始表和临时表连接起来,匹配重复的数据行。

-在连接条件中,使用GROUPBY来按照重复数据的列进行分组。

-通过删除临时表中的重复数据行,可以保留原始表中的唯一数据行。

2.使用ROW_NUMBER(函数:-使用ROW_NUMBER(函数为每个数据行分配一个唯一的序号。

-使用PARTITIONBY子句按照重复数据的列进行分区。

-使用ORDERBY子句按照所需的顺序对数据进行排序。

-通过删除序号大于1的数据行,可以删除重复的数据行。

3.使用CTE(公共表表达式):-使用CTE来创建一个临时的、可重用的查询。

-在CTE中使用ROW_NUMBER(函数给每个数据行分配一个唯一的序号。

-使用PARTITIONBY子句按照重复数据的列进行分区。

-使用ORDERBY子句按照所需的顺序对数据进行排序。

-通过删除序号大于1的数据行,可以删除重复的数据行。

4.使用DISTINCT:-使用DISTINCT关键字选择唯一的数据行。

-通过将DISTINCT关键字与GROUPBY子句一起使用,可以选择指定列上的唯一数据行。

-通过将DISTINCT关键字与ORDERBY子句一起使用,可以选择按照指定的列唯一排序的数据行。

5.使用临时表和索引:-创建一个临时表,用于存储重复数据行。

-使用插入语句将重复的数据行插入到临时表中。

-在临时表上创建一个索引,以加快删除操作的执行速度。

-使用DELETE语句从原始表中删除临时表中的重复数据行。

6.使用子查询和EXISTS子句:-使用子查询选择重复的数据行。

厂商采纳的执行重复数据删除的基本方法有三种与及各种的优缺点。

第一种是基于散列(hash)的方法,Data Domain、飞康、昆腾的DXi 系列设备都是采用SHA-1, MD-5 等类似的算法将这些进行备份的数据流断成块并且为每个数据块生成一个散列(hash)。

如果新数据块的散列(hash)与备份设备上散列索引中的一个散列匹配,表明该数据已经被备份,设备只更新它的表,以说明在这个新位置上也存在该数据。

基于散列(hash)的方法存在内置的可扩展性问题。

为了快速识别一个数据块是否已经被备份,这种基于散列(hash)的方法会在内存中拥有散列(hash)索引。

当被备份的数据块数量增加时,该索引也随之增长。

一旦索引增长超过了设备在内存中保存它所支持的容量,性能会急速下降,同时磁盘搜索会比内存搜索更慢。

因此,目前大部分基于散列(hash)的系统都是独立的,可以保持存储数据所需的内存量与磁盘空间量的平衡,这样,散列(hash)表就永远不会变得太大。

第二种方法是基于内容识别的重复删除,这种方法主要是识别记录的数据格式。

它采用内嵌在备份数据中的文件系统的元数据识别文件;然后与其数据存储库中的其它版本进行逐字节地比较,找到该版本与第一个已存储的版本的不同之处并为这些不同的数据创建一个增量文件。

这种方法可以避免散列(hash)冲突(请参阅下面的“不要惧怕冲突”),但是需要使用支持的备份应用设备以便设备可以提取元数据。

ExaGrid Systems的InfiniteFiler就是一个基于内容识别的重复删除设备,当备份数据时,它采用CommVault Galaxy 和Symantec Backup Exec 等通用的备份应用技术从源系统中识别文件。

完成备份后,它找出已经被多次备份的文件,生成增量文件(deltas)。

多个 InfiniteFilers合成一个网格,支持高达30 TB的备份数据。

采用重复删除方法的ExaGrid在存储一个1GB的 .PST文件类的新信息时表现优异,但它不能为多个不同的文件消除重复的数据,例如在四个.PST文件具有相同的附件的情况下。

如何选择重复数据删除解决方案删除重复数据随着数据量的不断增加,许多人面临着数据重复的问题。

在处理数据时,重复数据可能会导致结果不准确,占据不必要的存储空间,甚至可能会造成系统崩溃。

因此,删除重复数据已成为数据清洗的必要步骤之一。

本文将介绍如何选择重复数据删除解决方案,以帮助拥有重复数据问题的人们找到最佳解决方案。

一、了解重复数据问题要选择最合适的重复数据删除解决方案,首先需要了解数据重复问题的根源。

数据重复有多种可能性,包括数据录入错误、数据集成、数据备份等。

重复数据问题可能会带来以下问题:1. 浪费资源:重复数据会占用不必要的存储空间,使数据库变得臃肿不堪,增加了数据备份的时间和成本。

2. 影响准确性:重复数据存在于统计分析、建模、预测等关键领域中,可能会导致结果不准确,误导决策。

3. 崩溃风险:重复数据导致内存和磁盘空间不足,最终可能导致系统崩溃。

二、选择最佳解决方案了解重复数据问题后,接下来需要选择最佳的解决方案。

以下是几个可以考虑的解决方案。

1. 使用SQL命令SQL命令是处理重复数据的最常用方法之一,这种方法需要编写SQL代码来查找重复数据。

以下是使用SQL命令删除重复数据的示例:SELECT DISTINCT * INTO tempTable FROM duplicateTableDROP table duplicateTableSELECT * INTO duplicateTable FROM tempTableDROP table tempTable这是使用SQL命令删除重复数据的示例,具体方法包括创建一个具有DISTINCT标识符的表,使用INSERT INTO语句将数据插入该表,删除原始表,然后使用SELECT INTO语句从临时表创建一个新的重复数据删除表。

这种方法简单易行,适用于小规模数据库和简单的重复数据清洗任务。

2. 使用数据清洗工具数据清洗工具是一种简便的清洗重复数据的方法,适用于大型数据库和复杂的重复数据清洗任务。

如何选择重复数据删除解决方案删除重复数据重复数据的存在会影响数据分析的结果和数据存储空间的效率,因此删除重复数据是数据处理的一个重要步骤。

但是选择合适的重复数据删除解决方案并不是一件简单的事情,需要根据不同的数据特点和数据处理要求来选择。

以下是一些常见的重复数据删除解决方案和选择时的考虑因素。

1. Excel 中的“条件格式”和“删除重复项”功能如果数据量不大,且数据格式较为简单,可以考虑使用 Excel中的“条件格式”和“删除重复项”功能。

在 Excel 中,选中数据区域,点击“数据”菜单中的“删除重复项”,选择需要查重的列,即可删除重复数据。

要注意的是,该方法只适用于单个 Excel 文档中的数据处理,不适用于批量处理和大数据量的数据清洗。

2. 数据库中的去重操作数据库可以承载大规模数据,并且数据库提供了许多优秀的数据去重操作。

根据数据类型不同,数据库的去重方法也各不相同。

常见的数据库去重方法有:2.1. SELECT DISTINCT 语句在 SQL 中,使用 SELECT DISTINCT 语句可以消除重复项。

例如,使用以下 SQL 语句可以查找一张表中不重复的行:SELECT DISTINCT * FROM myTable;这种方法可以在单个表中删除重复项,但如果需要去重的字段跨多个表,则需要使用其他方法。

2.2. GROUP BY 语句GROUP BY 语句可以根据指定的列对数据进行分组,并且可以对每个组进行聚合操作。

例如,以下 SQL 语句可以将一个表按照名字列(Name)进行分组,并计算每个名字出现的次数:SELECT Name, COUNT(*) FROM myTable GROUP BY Name;这种方法可以应用于多表之间的去重,但可能会比较复杂。

3. 编程语言中的去重方法当数据量较大或者需要自动化处理时,可以考虑使用编程语言中的去重方法,例如 Python 中的 pandas 库或者 R 语言中的deduplication 库。

Pandas标记删除重复记录的⽅法Pandas提供了duplicated、Index.duplicated、drop_duplicates函数来标记及删除重复记录duplicated函数⽤于标记Series中的值、DataFrame中的记录⾏是否是重复,重复为True,不重复为Falsepandas.DataFrame.duplicated(self, subset=None, keep='first')pandas.Series.duplicated(self, keep='first')其中参数解释如下:subset:⽤于识别重复的列标签或列标签序列,默认所有列标签keep=‘frist':除了第⼀次出现外,其余相同的被标记为重复keep='last':除了最后⼀次出现外,其余相同的被标记为重复keep=False:所有相同的都被标记为重复import numpy as npimport pandas as pd#标记DataFrame重复例⼦df = pd.DataFrame({'col1': ['one', 'one', 'two', 'two', 'two', 'three', 'four'], 'col2': [1, 2, 1, 2, 1, 1, 1],'col3':['AA','BB','CC','DD','EE','FF','GG']},index=['a', 'a', 'b', 'c', 'b', 'a','c'])#duplicated(self, subset=None, keep='first')#根据列名标记#keep='first'df.duplicated()#默认所有列,⽆重复记录df.duplicated('col1')#第⼆、四、五⾏被标记为重复df.duplicated(['col1','col2'])#第五⾏被标记为重复#keep='last'df.duplicated('col1','last')#第⼀、三、四⾏被标记重复df.duplicated(['col1','col2'],keep='last')#第三⾏被标记为重复#keep=Falsedf.duplicated('col1',False)#Series([True,True,True,True,True,False,False],index=['a','a','b','c','b','a','c'])df.duplicated(['col1','col2'],keep=False)#在col1和col2列上出现相同的,都被标记为重复type(df.duplicated(['col1','col2'],keep=False))#pandas.core.series.Series#根据索引标记df.index.duplicated()#默认keep='first',第⼆、五、七⾏被标记为重复df.index.duplicated(keep='last')#第⼀、⼆、三、四被标记为重复df[df.index.duplicated()]#获取重复记录⾏df[~df.index.duplicated('last')]#获取不重复记录⾏#标记Series重复例⼦#duplicated(self, keep='first')s = pd.Series(['one', 'one', 'two', 'two', 'two', 'three', 'four'] ,index= ['a', 'a', 'b', 'c', 'b', 'a','c'],name='sname')s.duplicated()s.duplicated('last')s.duplicated(False)#根据索引标记s.index.duplicated()s.index.duplicated('last')s.index.duplicated(False)drop_duplicates函数⽤于删除Series、DataFrame中重复记录,并返回删除重复后的结果pandas.DataFrame.drop_duplicates(self, subset=None, keep='first', inplace=False)pandas.Series.drop_duplicates(self, keep='first', inplace=False)#删除DataFrame重复记录例⼦#drop_duplicates(self, subset=None, keep='first', inplace=False)df.drop_duplicates()df.drop_duplicates('col1')#删除了df.duplicated('col1')标记的重复记录df.drop_duplicates('col1','last')#删除了df.duplicated('col1','last')标记的重复记录df1.drop_duplicates(['col1','col2'])#删除了df.duplicated(['col1','col2'])标记的重复记录df.drop_duplicates('col1',keep='last',inplace=True)#inplace=True表⽰在原DataFrame上执⾏删除操作df.drop_duplicates('col1',keep='last',inplace=False)#inplace=False返回⼀个副本#删除Series重复记录例⼦#drop_duplicates(self, keep='first', inplace=False)s.drop_duplicates()以上这篇Pandas标记删除重复记录的⽅法就是⼩编分享给⼤家的全部内容了,希望能给⼤家⼀个参考,也希望⼤家多多⽀持。

数据处理中的重复数据处理方法随着大数据时代的到来,我们面临着海量的数据需要处理和分析。

而在数据处理的过程中,重复数据成为了我们经常遇到的问题之一。

重复数据不仅会增加数据分析的难度,还会导致数据结果的不准确性。

因此,重复数据的处理变得至关重要。

本文将介绍一些常用的重复数据处理方法,以帮助读者更好地处理数据。

1. 数据去重数据去重是最常见的重复数据处理方法之一。

在数据集中,同一条数据可能会出现多次。

这可能是因为数据来源的不同或是人为错误的原因造成的。

通过对数据进行去重处理,可以将重复的数据删除,以减少数据集的大小,并确保数据的准确性和一致性。

数据去重有多种方法,其中一种常用的方法是基于关键字段进行去重。

例如,在一份包含员工信息的数据集中,我们可以根据员工的工号进行去重。

具体实施时,我们可以使用数据库的DISTINCT关键字进行去重,或者通过编写程序代码进行去重操作。

2. 数据合并另一种处理重复数据的方法是数据合并。

当数据集中存在多个和同一实体相关的记录时,我们可以将这些记录合并为一个完整的记录。

这有助于简化数据集,提高数据分析的效率。

数据合并的方式有很多种,其中一种常用的方式是利用关键字段进行合并。

以合并两个包含客户信息的数据集为例,我们可以根据客户的唯一标识(如客户ID)将两个数据集进行合并。

在实际操作中,我们可以使用SQL的JOIN操作来实现数据的合并,或者通过编程语言中的合并函数来进行操作。

3. 数据匹配重复数据处理的另一个关键问题是数据匹配。

在许多情况下,我们需要将两个或多个数据集中相同的记录进行匹配,并获取匹配结果。

这就需要我们利用一些匹配算法来实现。

对于数据匹配,有一些常见的算法可以使用。

例如,我们可以使用Levenshtein距离算法来计算两个字符串之间的差异程度,从而实现字符串匹配和模糊匹配。

此外,还可以使用基于特征的匹配方法,例如使用TF-IDF算法来计算文本数据之间的相似性。

4. 数据标准化在数据处理中,数据标准化是一种对重复数据进行处理的重要方法。

SQL SERVER实用经验技巧集删除数据库中重复数据的几个方法数据库的使用过程中由于程序方面的问题有时候会碰到重复数据,重复数据导致了数据库部分设置不能正确设置……方法一方法二有两个意义上的重复记录,一是完全重复的记录,也即所有字段均重复的记录,二是部分关键字段重复的记录,比如Name字段重复,而其他字段不一定重复或都重复可以忽略。

1、对于第一种重复,比较容易解决,使用就可以得到无重复记录的结果集。

如果该表需要删除重复的记录(重复记录保留1条),可以按以下方法删除发生这种重复的原因是表设计不周产生的,增加唯一索引列即可解决。

2、这类重复问题通常要求保留重复记录中的第一条记录,操作方法如下假设有重复的字段为Name,Address,要求得到这两个字段唯一的结果集最后一个select即得到了Name,Address不重复的结果集(但多了一个autoID字段,实际写时可以写在select子句中省去此列)更改数据库中表的所属用户的两个方法大家可能会经常碰到一个数据库备份还原到另外一台机器结果导致所有的表都不能打开了,原因是建表的时候采用了当时的数据库用户…… --更改某个表--存储更改全部表SQL SERVER中直接循环写入数据没什么好说的了,大家自己看,有时候有点用处无数据库日志文件恢复数据库方法两则数据库日志文件的误删或别的原因引起数据库日志的损坏方法一1.新建一个同名的数据库2.再停掉sql server(注意不要分离数据库)3.用原数据库的数据文件覆盖掉这个新建的数据库4.再重启sql server5.此时打开企业管理器时会出现置疑,先不管,执行下面的语句(注意修改其中的数据库名)6.完成后一般就可以访问数据库中的数据了,这时,数据库本身一般还要问题,解决办法是,利用数据库的脚本创建一个新的数据库,并将数据导进去就行了.方法二事情的起因昨天,系统管理员告诉我,我们一个内部应用数据库所在的磁盘空间不足了。

重复数据删除进入主存储重复数据删除技术(De-Duplication)通过去除冗余数据来减少数据容量,由于其对磁盘存储使用量的有效降低,显著减少了磁盘存储的需求和能耗,从而降低了磁盘存储的购买成本和使用成本,目前已成为众多存储厂商追逐的目标。

重复数据删除技术自出现至今,几乎都是应用于数据备份和归档等二级存储,而没有应用在主存储中。

这是因为一般重复数据删除技术都是通过软件实现的,它势必会对系统的性能带来不可避免的影响,降低数据存储和读取的速度,而应用系统对主存储中的数据读取速度通常比数据备份时的要求要高得多。

因此,迄今,具有重复数据删除技术的存储产品一般都是针对备份应用的。

不过,近日Hifn公司打破了这一局面,推出了针对Windows服务器的重复数据删除解决方案,使重复数据删除技术不再受应用所限,正式进入主存储应用中。

日前,记者独家采访了Hifn公司亚太区副总裁杨钦铭,详细了解了Hifn 解决方案的特色和优势以及产品策略。

杨钦铭介绍说,Hifn公司推出的BitWackr 250和255高级数据缩减解决方案,使服务器OEM厂商、微软合作伙伴和装机商可以为Windows服务器增加硬件辅助型重复数据删除、数据压缩以及自动精简配置等功能。

服务器安装了BitWackr后,能与NAS、SharePoint、数据保护管理器(DPM)等受益于重复数据删除功能最多的Windows应用程序实现无缝集成。

据了解,Hifn公司在数据加密和数据压缩方面颇具特色,有多项专利技术,正是这些优势帮助了Hifn重复数据删除产品的诞生。

Hifn公司的这项专利技术能够提供实时、在线重复数据删除和数据压缩功能,从而减少写入磁盘的数据。

作为业内首款可以在数据产生时就能进行缩减的容量优化解决方案,BitWackr 250和255可以大大减少企业存储的成本,例如,减少了磁盘容量需求和采购,延长了现有存储设备的使用寿命,提升了投资回报(ROI),减少对存储设备的管理,降低散热和冷却开支以及减少功耗等。

重复数据操作方法

在数据处理过程中,重复数据是一个常见的问题,但是不同的上下文和数据需求需要不同的处理方法。

以下是一些常见的重复数据操作方法:

1. 删除重复数据:最常用的处理方法之一是删除重复数据。

可以根据特定的字段或整个行进行重复检查,然后将重复的数据删除。

例如,Pandas库中的drop_duplicates()函数可用于删除DataFrame中的重复行。

2. 合并重复数据:在某些情况下,可能需要将重复数据进行合并。

例如,如果存在多个电子邮件地址或电话号码,则可以合并它们以获得更全面的信息。

可以使用Pandas库中的groupby()函数将数据按照某个字段进行分组,然后将相同的值进行合并。

3. 标记重复数据:在某些情况下,可能需要标记重复数据,以便后续操作。

例如,可以创建一个布尔值列来指示每个行是否是重复的。

可以使用Pandas库中的duplicated()函数来查找重复值,并使用任何标记(例如True或False)来标记这些值。

4. 使用重复数据:在某些情况下,重复数据可能包含有价值的信息。

例如,在执行时间序列分析时,可能需要将重复数据视为连续的。

可以使用Pandas库中的resample()函数来将重复数据聚合到较长的时间段中。

总之,重复数据操作方法取决于数据需求和上下文。

2010excel表格中如何去重

推荐文章

在Excel2010表格中怎么进行粘贴预览热度:怎么样为Excel2010表格设置自动换行热度:Excel表格中的VLOOKUP函数怎么用热度:excel2010表格中系列产生在列里的方法步骤热度:Excel2010表格中如何筛选去掉不需要的保留想要的数据热度:在Excel工作簿中对大量数据进行分析检查的时候,往往会发现有大量重复相同的数据,如果数据不是很多,我们可以通过肉眼判断出来,并且删除,但如果数据达到了上百条,上千条,那我们还能用肉眼去判断吗,下面让店铺为你带来2010excel表格中如何去重的方法。

2010excel表格去重方法:

方法一:删除重复项

方法二:数据透视表

操作过程:选取数据》【插入】》【数据透视表】》【确定】。

我们有可能面对的数据有两种,一种是单列的,另一种是多列的(包括在不同工作表内),单列的非常简单,只要将需要去除重复的那一项字段勾选就完成了,多列的就要用到多重合并:

关于excel2010表格去重的相关文章推荐:。