语音端点检测方法的分析与实现

- 格式:pdf

- 大小:393.97 KB

- 文档页数:4

基于Matlab编写的语音端点检测专业:班级:姓名:指导教师:2011 年6月18 日一、实验目的1.学会MATLAB的使用,掌握MATLAB的程序设计方法;3.掌握语音处理的基本概念、基本理论和基本方法;4.掌握基于MATLAB编程实现带噪语音信号端点检测;5.学会用MATLAB对信号进行分析和处理。

二、实验内容简介:(1)采集一段语音信号,采样率为8KHZ,量化精度为16比特线性码;(2)分析帧长30ms(或10ms~50ms);(3)利用公式分别计算这段语音信号的短时能量、短时平均幅度、短时过零率曲线;(4)利用(3)中的结果画出短时零能比曲线;(零能比: 即同一时间段内的过零率和能量的比值)(5)根据上述结果判断找出其中的一帧浊音信号和一帧清音信号,分别计算他们的短时自相关函数和平均幅度差函数;(6)调整能量门限,设置参数。

实现语音端点的检测。

三,实验心得这次的实验,,给我最大的收获就是培养了独立思考和动手的能力,还有就是实验的灵活性,总得来说就是在独立与创新这二个环节,我更加掌握MATLAB 的程序设计方法,进一步的了解了掌握基于MATLAB编程实现带噪语音信号端点检测的原理,这充分锻炼了我们独立的动手能力和独立的解决所遇到的问题,让我对这门课程又有了新的理解。

四.课程设计原理端点检测是语音信号处理过程中非常重要的一步,它的准确性直接影响到语音信号处理的速度和结果,因此端点检测方法的研究一直是语音信号处理中的热点。

本设计使用传统的短时能量和过零率相结合的语音端点检测算法利用短时过零率来检测清音.用短时能量来检测浊音,两者相配合便实现了信号信噪比较大情况下的端点检测。

算法对于输入信号的检测过程可分为短时能量检测和短时过零率检测两个部分。

算法以短时能量检测为主,短时过零率检测为辅。

根据语音的统计特性,可以把语音段分为清音、浊音以及静音(包括背景噪声)三种。

在本算法中,短时能量检测可以较好地区分出浊音和静音。

详解python的webrtc库实现语⾳端点检测引⾔语⾳端点检测最早应⽤于电话传输和检测系统当中,⽤于通信信道的时间分配,提⾼传输线路的利⽤效率.端点检测属于语⾳处理系统的前端操作,在语⾳检测领域意义重⼤.但是⽬前的语⾳端点检测,尤其是检测⼈声开始和结束的端点始终是属于技术难点,各家公司始终处于能判断,但是不敢保证判别准确性的阶段.现在基于云端语义库的聊天机器⼈层出不穷,其中最著名的当属amazon的 Alexa/Echo 智能⾳箱.国内如⾬后春笋般出现了各种搭载语⾳聊天的智能⾳箱(如前⼏天在知乎上⼴告的若琪机器⼈)和各类智能机器⼈产品.国内语⾳服务提供商主要⾯对中⽂语⾳服务,由于语⾳不像图像有分辨率等等较为客观的指标,很多时候凭主观判断,所以较难判断各家语⾳识别和合成技术的好坏.但是我个⼈认为,国内的中⽂语⾳服务和国外的英⽂语⾳服务,在某些⽅⾯已经有超越的趋势.通常搭建机器⼈聊天系统主要包括以下三个⽅⾯:1. 语⾳转⽂字(ASR/STT)2. 语义内容(NLU/NLP)3. ⽂字转语⾳(TTS)语⾳转⽂字(ASR/STT)在将语⾳传给云端API之前,是本地前端的语⾳采集,这部分主要包括如下⼏个⽅⾯:1. 麦克风降噪2. 声源定位3. 回声消除4. 唤醒词5. 语⾳端点检测6. ⾳频格式压缩python 端点检测由于实际应⽤中,单纯依靠能量检测特征检测等⽅法很难判断⼈声说话的起始点,所以市⾯上⼤多数的语⾳产品都是使⽤唤醒词判断语⾳起始.另外加上声⾳回路,还可以做语⾳打断.这样的交互⽅式可能有些傻,每次必须喊⼀下唤醒词才能继续聊天.这种⽅式聊多了,个⼈感觉会嘴巴疼:-O .现在github上有snowboy唤醒词的开源库,⼤家可以登录snowboy官⽹训练⾃⼰的唤醒词模型.1. Kitt-AI : Snowboy2. Sensory : Sensory考虑到⽤唤醒词嘴巴会累,所以⼤致调研了⼀下,Python拥有丰富的库,直接import就能⾷⽤.这种⽅式容易受强噪声⼲扰,适合⼀个⼈在家玩玩.1. pyaudio: pip install pyaudio 可以从设备节点读取原始⾳频流数据,⾳频编码是PCM格式;2. webrtcvad: pip install webrtcvad 检测判断⼀组语⾳数据是否为空语⾳;当检测到持续时间长度 T1 vad检测都有语⾳活动,可以判定为语⾳起始;当检测到持续时间长度 T2 vad检测都没有有语⾳活动,可以判定为语⾳结束;完整程序代码可以从我的下载程序很简单,相信看⼀会⼉就明⽩了'''Requirements:+ pyaudio - `pip install pyaudio`+ py-webrtcvad - `pip install webrtcvad`'''import webrtcvadimport collectionsimport sysimport signalimport pyaudiofrom array import arrayfrom struct import packimport waveimport timeFORMAT = pyaudio.paInt16CHANNELS = 1RATE = 16000CHUNK_DURATION_MS = 30 # supports 10, 20 and 30 (ms)PADDING_DURATION_MS = 1500 # 1 sec jugementCHUNK_SIZE = int(RATE CHUNK_DURATION_MS / 1000) # chunk to readCHUNK_BYTES = CHUNK_SIZE 2 # 16bit = 2 bytes, PCMNUM_PADDING_CHUNKS = int(PADDING_DURATION_MS / CHUNK_DURATION_MS)# NUM_WINDOW_CHUNKS = int(240 / CHUNK_DURATION_MS)NUM_WINDOW_CHUNKS = int(400 / CHUNK_DURATION_MS) # 400 ms/ 30ms geNUM_WINDOW_CHUNKS_END = NUM_WINDOW_CHUNKS 2START_OFFSET = int(NUM_WINDOW_CHUNKS CHUNK_DURATION_MS 0.5 RATE)vad = webrtcvad.Vad(1)pa = pyaudio.PyAudio()stream = pa.open(format=FORMAT,channels=CHANNELS,rate=RATE,input=True,start=False,# input_device_index=2,frames_per_buffer=CHUNK_SIZE)got_a_sentence = Falseleave = Falsedef handle_int(sig, chunk):global leave, got_a_sentenceleave = Truegot_a_sentence = Truedef record_to_file(path, data, sample_width):"Records from the microphone and outputs the resulting data to 'path'" # sample_width, data = record()data = pack('<' + ('h' len(data)), data)wf = wave.open(path, 'wb')wf.setnchannels(1)wf.setsampwidth(sample_width)wf.setframerate(RATE)wf.writeframes(data)wf.close()def normalize(snd_data):"Average the volume out"MAXIMUM = 32767 # 16384times = float(MAXIMUM) / max(abs(i) for i in snd_data)r = array('h')for i in snd_data:r.append(int(i times))return rsignal.signal(signal.SIGINT, handle_int)while not leave:ring_buffer = collections.deque(maxlen=NUM_PADDING_CHUNKS) triggered = Falsevoiced_frames = []ring_buffer_flags = [0] NUM_WINDOW_CHUNKSring_buffer_index = 0ring_buffer_flags_end = [0] NUM_WINDOW_CHUNKS_ENDring_buffer_index_end = 0buffer_in = ''# WangSraw_data = array('h')index = 0start_point = 0StartTime = time.time()print(" recording: ")stream.start_stream()while not got_a_sentence and not leave:chunk = stream.read(CHUNK_SIZE)# add WangSraw_data.extend(array('h', chunk))index += CHUNK_SIZETimeUse = time.time() - StartTimeactive = vad.is_speech(chunk, RATE)sys.stdout.write('1' if active else '_')ring_buffer_flags[ring_buffer_index] = 1 if active else 0ring_buffer_index += 1ring_buffer_index %= NUM_WINDOW_CHUNKSring_buffer_flags_end[ring_buffer_index_end] = 1 if active else 0ring_buffer_index_end += 1ring_buffer_index_end %= NUM_WINDOW_CHUNKS_END# start point detectionif not triggered:ring_buffer.append(chunk)num_voiced = sum(ring_buffer_flags)if num_voiced > 0.8 NUM_WINDOW_CHUNKS:sys.stdout.write(' Open ')triggered = Truestart_point = index - CHUNK_SIZE 20 # start point# voiced_frames.extend(ring_buffer)ring_buffer.clear()# end point detectionelse:# voiced_frames.append(chunk)ring_buffer.append(chunk)num_unvoiced = NUM_WINDOW_CHUNKS_END - sum(ring_buffer_flags_end)if num_unvoiced > 0.90 NUM_WINDOW_CHUNKS_END or TimeUse > 10:sys.stdout.write(' Close ')triggered = Falsegot_a_sentence = Truesys.stdout.flush()sys.stdout.write('\n')# data = b''.join(voiced_frames)stream.stop_stream()print(" done recording")got_a_sentence = False# write to fileraw_data.reverse()for index in range(start_point):raw_data.pop()raw_data.reverse()raw_data = normalize(raw_data)record_to_file("recording.wav", raw_data, 2)leave = Truestream.close()程序运⾏⽅式sudo python vad.py以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

噪声背景下语音端点检测方法的研究摘要:在实际环境中,并没有完全纯净的语音信号,一段语音信号往往都伴有噪声信号,所以研究在背景噪声环境中的语音端点检测更为重要。

常用的短时过零率法、短时能量法以及双门限法都存在着一个共同的问题,即对信噪比要求较高。

为了解决这一问题我们提出了一改进算法,即基于谱减法思想的语音端点检测的方法,有效的提高检测的正确率。

关键词:端点检测噪声短时能量短时过零率谱减法1、引言语音端点检测是指用计算机数字处理技术来找出语音信号中的字或词等的起点和终点这俩个端点。

作为语音识别的前端,准确的端点检测可以提高识别的准确率。

语音端点检测的困难在于一段信号中的无声段或者录制一段语音段的前后人为呼吸等产生的杂音、语音开始处的弱摩擦音或弱爆破音以及终点处的鼻音,这些使得语音的端点需要综合利用语音的各种信号特征,从而确保定位的精确性,避免包含噪音信号和丢失语音信号。

常用语音端点检测法有短时过零率法、短时能量法以及双门限法。

但是对于信噪比要求较高,所以本文提出了一种基于谱减法思想的语音端点检测算法,提高语音端点检测的正确率。

2、语音端点检测方法常用方法中的短时能量法,语音和噪声的区别可以体现在它们的能量上,语音段的能量与噪声段能量相比,要大于噪声段的能量,因此可以以此为依据进行检测;短时过零率法,短时过零率可以区别语音是清音还是浊音[1,2],因此它可以从背景噪声中找出语音信号;传统双门限比较法,首先为短时能量和过零率分别确定两个门限,较低的门限对信号的变化比较敏感,较高的门限是用来确定进入语音段。

当低门限被超过时,未必是语音的开始而很有可能是由很小的噪声所引起的波动,但当高门限被超过并且在接下来的时间段内一直超过低门限时,则意味着语音信号的开始[3]。

但是上述三种方法在低信噪比时检测效果就不是很理想了。

因此我们提出了一种改进算法。

3、基于谱减法思想的语音端点检测算法的研究3.1 谱减法概述由于语音生成模型是低速率语音编码的基础,当语音受到噪声干扰时,提取的模型参数将很不准确,重建的语音质量急剧恶化。

语音端点检测方法研究1沈红丽,曾毓敏,李平,王鹏南京师范大学物理科学与技术学院,南京(210097)E-mail:orange.2009@摘要: 端点检测是语音识别中的一个重要环节。

有效的端点检测技术不仅能减少系统的处理时间,增强系统处理的实时性,而且能排除无声段的噪声干扰,增强后续过程的识别性。

可以说,语音信号的端点检测至今天为止仍是有待进一步深入的研究课题.鉴于此,本文介绍了语音端点算法的基本研究现状,接着讨论并比较了语音信号端点检测的方法,分析了各种方法的原理及优缺点,如经典的基于短时能量和过零率的检测方法,基于频带方差的检测方法,基于熵的检测方法,基于倒谱距离的检测方法等.并基于这些方法的分析,对端点检测方法做了进行了总结和展望,对语音信号的端点检测的进一步研究具有深远的意义。

关键词:语音信号;端点检测;噪声中图分类号:TP206. 11. 引言语音信号处理中的端点检测技术,是指从包含语音的一段信号中确定出语音信号的起始点及结束点。

语音信号的端点检测是进行其它语音信号处理(如语音识别、讲话人识别等)重要且关键的第一步. 研究表明[1],即使在安静的环境中,语音识别系统一半以上的识别错误来自端点检测器。

因此,作为语音识别系统的第一步,端点检测的关键性不容忽视,尤其是噪声环境下语音的端点检测,它的准确性很大程度上直接影响着后续的工作能否有效进行。

确定语音信号的起止点, 从而减小语音信号处理过程中的计算量, 是众多语音信号处理领域中一个基本而且重要的问题。

有效的端点检测技术不仅能减少系统的处理时间,增强系统处理的实时性,而且能排除无声段的噪声干扰,增强后续过程的识别性。

可以说,语音信号的端点检测至今天为止仍是有待进一步深入的研究课题。

2. 语音端点检测主要方法和分析在很长一段时间里,语音端点检测算法主要是依据语音信号的时域特性[2].其采用的主要参数有短时能量、短时平均过零率等,即通常说的基于能量的端点检测方法。

一种语音信号端点检测方法的研究吴亮春潘世永(西华大学数学与计算机学院,四川成都 610039)摘要在语音识别系统中,端点检测的误差会降低系统的识别率,进行有效准确的端点检测是语音识别的重要步骤。

因此端点检测逐渐成为语音信号处理中的一个热点。

本文提出了一种基于模型的Teager 能量端点检测方法。

实验证明,该算法比传统的能量过零率端点检测算法具有更高的识别率,能够更准确的检测出语音信号的端点。

关键词端点检测;模型;过零率1 引言语音是人类相互交流和通信最方便快捷的手段。

如何高效地实现语音传输、存储或通过语音实现人机交互,是语音信号处理领域中的重要研究课题。

而语音端点检测是语音分析、语音合成、语音编码、说话人识别中的一个重要环节,直接影响到后续工作的准确性。

在实际应用中,首先通常要求对系统的输入信号进行判断,准确地找出语音信号的起始点和终止点,这样才能采集真正的语音数据,减少数据量和运算量,并减少处理时间。

在语音识别中,通常是先根据一定的端点检测算法,对语音信号中的有声片段和无声片段进行分割,而后再针对有声片段,依据语音的某些特征进行识别。

研究表明,即使在安静的环境中,语音识别系统一半以上的识别错误来自端点检测器。

因此,作为语音识别系统的第一步,端点检测的关键不容忽视,尤其是噪声环境下语音的端点检测,它的准确性很大程度上直接影响着后续的工作能否有效进行。

可以说,语音信号的端点检测至今仍是有待进一步深入研究的课题。

2 语音信号的时域特征2.1 短时能量分析语音信号的能量随着时间变化比较明显,一般清音部分的能量比浊音的能量小的多,所以在区分清音和浊音,有声段和无声段的应用中效果比较明显。

对于信号{x(n)},短时能量的定义如下:式中,, E n表示在信号的第n个点开始加窗函数时的短时能量。

通过上式可以看出,短时能量式语音信号的平方经过一个线性低通滤波器的输出,该线性低通滤波器的单位冲激响应为h(n)。

由于短时能量是对信号进行平方运算,因而增加了高低信号之间的差距,在一些应用场合并不合适。

语音端点检测比例法-回复什么是语音端点检测比例法?语音端点检测比例法是一种常用的语音处理技术,旨在识别连续音频中的语音和非语音部分,并确定语音起始和终止点。

在许多语音处理应用中,如语音识别、语音合成和语音增强等,准确确定语音的位置非常重要。

而语音端点检测比例法就是为了完成这项任务而设计的。

语音端点检测比例法的基本原理是通过对连续音频信号的能量变化进行分析,找出能量显著增加的区域,即语音开始的位置。

当信号内的相对能量大于某个阈值时,可以认为该区域为语音。

而当连续一段时间内的相对能量小于阈值时,可以认为语音结束。

一般来说,语音信号的能量变化较为平缓,而非语音信号(如静音、噪声等)的能量变化较小。

因此,通过设置合适的阈值,语音端点检测比例法可以有效地区分语音和非语音部分。

以下是语音端点检测比例法的一般步骤:1. 预处理:首先,对原始音频进行预处理,如去除噪声、滤波、标准化等。

这一步旨在提高语音信号的质量,使后续的分析更加准确。

2. 分帧:将预处理后的音频信号分成多个帧,通常每帧长度为20-30毫秒。

这样可以保证每个帧内的信号基本稳定,便于后续能量计算。

3. 能量计算:对每个帧内的信号进行能量计算,可以采用能量计算公式:E = ∑x(n) ^2,其中x(n)代表第n个样本点的振幅。

通过累加每个样本点的平方值,得到该帧的能量。

4. 确定阈值:根据经验或统计分析,确定能量阈值。

阈值的设置要综合考虑语音信号的特性以及实际应用的要求。

通常可以通过计算整个语音信号的能量平均值和标准差,以及考虑到信号的动态变化,适当设置一个合适的能量阈值。

5. 端点判断:对于每一帧的能量值,与阈值进行比较。

如果能量值大于阈值,可以认为该帧内含有语音;如果能量值小于阈值,可以认为该帧为非语音。

根据相邻帧的语音非语音情况,可以进一步确定语音的起始和终止点。

6. 后处理:对端点进行后处理,如去除短时静音区域、合并相邻的语音段等。

这一步旨在优化端点的准确性和平滑性,以提高后续语音处理算法的性能。

《基于深度学习的语音端点检测》篇一一、引言随着人工智能技术的不断发展,语音信号处理在许多领域得到了广泛的应用。

其中,语音端点检测(Voice Activity Detection,VAD)是语音信号处理中的一项关键技术。

它主要用于确定语音信号中语音段的起始点和结束点,从而为后续的语音识别、语音合成等任务提供有效信息。

传统的语音端点检测方法往往基于简单的统计模型或者特定的语音特征进行阈值设置,对于复杂环境下的语音信号处理效果并不理想。

近年来,随着深度学习技术的发展,基于深度学习的语音端点检测方法逐渐成为研究热点。

本文旨在探讨基于深度学习的语音端点检测方法,以提高语音信号处理的准确性和鲁棒性。

二、相关工作传统的语音端点检测方法主要包括基于短时能量和过零率的检测方法、基于谱熵的检测方法等。

这些方法通常依赖于特定的语音特征和阈值设置,对于不同环境下的语音信号处理效果不稳定。

近年来,深度学习技术在语音信号处理领域得到了广泛应用,如基于深度神经网络的语音识别、语音合成等。

深度学习技术可以自动提取语音信号中的特征信息,从而提高了语音信号处理的准确性和鲁棒性。

因此,基于深度学习的语音端点检测方法逐渐成为研究热点。

三、基于深度学习的语音端点检测方法本文提出一种基于深度学习的语音端点检测方法。

该方法主要包括以下几个步骤:1. 数据预处理:对原始语音信号进行预处理,包括归一化、分帧等操作。

2. 特征提取:利用深度神经网络自动提取语音信号中的特征信息,如MFCC(Mel Frequency Cepstral Coefficients)等。

3. 模型训练:使用有标签的语音数据训练深度神经网络模型,以学习语音信号中的特征与端点之间的关系。

4. 端点检测:将提取的特征输入到训练好的模型中,得到每个时间点的概率值,从而确定语音段的起始点和结束点。

四、实验与分析本文使用公开的语音数据集进行实验,将基于深度学习的语音端点检测方法与传统的检测方法进行对比分析。

基于短时自相关及过零率的语音端点检测算

法

语音端点检测是计算机语音处理领域的一种常见应用,它主要用于语音识别、拼写校正以及声纹分析等语音处理技术中。

基于短时自相关(Short-Time Auto/orrelation, STAC)和过零率(Zero-Crossing Rate, ZCR)的语音端点检测算法是当前检测语音端点所使用的一种常用方法。

通常情况下,该算法的实现步骤如下:首先,将语音信号拆分为多小片段,每块片段的长度一般以毫秒为单位(通常取20ms),并将片段之间用某种滤波器连接;接着计算每块片段的自相关系数,并在计算结果中检测端点;最后,计算每个片段的ZCR,用相邻两个片段之间的ZCR变化来确定语音端点,其中该变化值还可以决定端点的类型—开始点或结束点。

检测完语音端点后,即可实现对语音信号的分割及识别。

现有的STAC-ZCR算法效果较为理想,其特点是计算量小、易于实现,因此深受人们的欢迎并发展至今。

实验一语音信号端点检测一、 实验目的1.学会MATLAB 的使用,掌握MATLAB 的程序设计方法;2.掌握语音处理的基本概念、基本理论和基本方法;3.掌握基于MATLAB 编程实现带噪语音信号端点检测;4.学会用MATLAB 对信号进行分析和处理。

5. 学会利用短时过零率和短时能量,对语音信号的端点进行检测。

二、 实验仪器设备及软件MATLAB三、 实验原理端点检测是语音信号处理过程中非常重要的一步,它的准确性直接影响到语音信号处理的速度和结果。

本次实验利用短时过零率和短时能量相结合的语音端点检测算法利用短时过零率来检测清音,用短时能量来检测浊音,两者相配合便实现了信号信噪比较大情况下的端点检测。

算法对于输入信号的检测过程可分为短时能量检测和短时过零率检测两个部分。

算法以短时能量检测为主,短时过零率检测为辅。

根据语音的统计特性,可以把语音段分为清音、浊音以及静音(包括背景噪声)三种。

在本算法中,短时能量检测可以较好地区分出浊音和静音。

对于清音,由于其能量较小,在短时能量检测中会因为低于能量门限而被误判为静音;短时过零率则可以从语音中区分出静音和清音。

将两种检测结合起来,就可以检测出语音段(清音和浊音)及静音段1、短时能量计算定义n 时刻某语言信号的短时平均能量En 为:∑∑--=+∞∞--=-=n N n m m n w m x m n w m x En )1(22)]()([)]()([式中N 为窗长,可见短时平均能量为一帧样点值的平方和。

特殊地,当窗函数为矩形窗时,有∑--==n N n m m x En )1(2)(2、短时过零率过零就是指信号通过零值。

过零率就是每秒内信号值通过零值的次数。

对于离散时间序列,过零则是指序列取样值改变符号,过零率则是每个样本的改变符号的次数。

对于语音信号,则是指在一帧语音中语音信号波形穿过横轴(零电平)的次数。

可以用相邻两个取样改变符号的次数来计算。

如果窗的起点是n=0,短时过零率Z 为波形穿过横轴(零电平)的次数|))1(())((|2110∑-=--=N n w w n S Sgn n S Sgn Z {00,1,1)sgn(≥<-=x x x短时过零可以看作信号频率的简单度量浊音的短时平均幅度最大,无声的短时平均幅度最小,清音的短时过零率最大,无声居中,浊音的短时过零率最小。

《基于深度学习的语音端点检测》篇一一、引言语音端点检测(Voice Activity Detection,VAD)是语音信号处理中的重要任务,广泛应用于自动语音识别、语音增强和音频编解码等应用中。

然而,传统的语音端点检测方法常常面临着复杂的音频环境和多变的语音特征所带来的挑战。

近年来,随着深度学习技术的发展,基于深度学习的语音端点检测方法逐渐成为研究热点。

本文旨在探讨基于深度学习的语音端点检测的高质量研究。

二、深度学习在语音端点检测中的应用深度学习技术为语音端点检测提供了新的解决方案。

通过构建深度神经网络模型,可以有效地提取音频中的特征信息,提高语音端点检测的准确性和鲁棒性。

在传统的语音端点检测方法中,通常采用基于阈值的简单算法。

然而,在实际应用中,由于音频环境的复杂性和多变性,单一的阈值很难适应不同的音频场景。

而深度学习技术可以有效地处理复杂多变的音频特征,从而提高语音端点检测的准确性。

三、基于深度学习的语音端点检测方法基于深度学习的语音端点检测方法通常采用卷积神经网络(CNN)或循环神经网络(RNN)等深度神经网络模型。

这些模型可以有效地提取音频中的特征信息,并根据音频时序信息进行分类或预测。

其中,CNN模型常用于特征提取和音频信号的短时分析。

RNN模型则能够处理具有时序依赖性的音频信号,如语音的连续性特征。

此外,还有一些基于深度学习的混合模型,如长短时记忆网络(LSTM)等,可以同时利用CNN和RNN的优点,提高语音端点检测的性能。

四、高质量的基于深度学习的语音端点检测研究高质量的基于深度学习的语音端点检测研究需要从以下几个方面进行:1. 数据集:高质量的数据集是保证语音端点检测性能的基础。

研究人员需要构建大规模的、多样化的音频数据集,以便于模型训练和验证。

2. 模型设计:合理的模型设计是提高语音端点检测性能的关键。

研究人员需要根据不同的应用场景和音频特征,选择合适的深度神经网络模型,并进行相应的优化和调整。

华南理工大学《语音信号处理》实验报告实验名称:端点检测姓名:学号:班级:10级电信5班日期:2013年5 月9日1.实验目的1.语音信号端点检测技术其目的就是从包含语音的一段信号中准确地确定语音的起始点和终止点,区分语音和非语音信号,它是语音处理技术中的一个重要方面。

本实验的目的就是要掌握基于MATLAB编程实现带噪语音信号端点检测,利用MATLAB对信号进行分析和处理,学会利用短时过零率和短时能量,对语音信号的端点进行检测。

2. 实验原理1、短时能量语音和噪声的区别可以体现在它们的能量上,语音段的能量比噪声段能量大,语音段的能量是噪声段能量叠加语音声波能量的和。

在信噪比很高时,那么只要计算输入信号的短时能量或短时平均幅度就能够把语音段和噪声背景区分开。

这是仅基于短时能量的端点检测方法。

信号{x(n)}的短时能量定义为:语音信号的短时平均幅度定义为:其中w(n)为窗函数。

2、短时平均过零率短时过零表示一帧语音信号波形穿过横轴(零电平)的次数。

过零分析是语音时域分析中最简单的一种。

对于连续语音信号,过零意味着时域波形通过时间轴;而对于离散信号,如果相邻的取样值的改变符号称为过零。

过零率就是样本改变符号次数。

信号{x(n)}的短时平均过零率定义为:式中,sgn为符号函数,即:过零率有两类重要的应用:第一,用于粗略地描述信号的频谱特性;第二,用于判别清音和浊音、有话和无话。

从上面提到的定义出发计算过零率容易受低频干扰,特别是50Hz交流干扰的影响。

解决这个问题的办法,一个是做高通滤波器或带通滤波,减小随机噪声的影响;另一个有效方法是对上述定义做一点修改,设一个门限T,将过零率的含义修改为跨过正负门限。

于是,有定义:3、检测方法利用过零率检测清音,用短时能量检测浊音,两者配合。

首先为短时能量和过零率分别确定两个门限,一个是较低的门限数值较小,对信号的变化比较敏感,很容易超过;另一个是比较高的门限,数值较大。

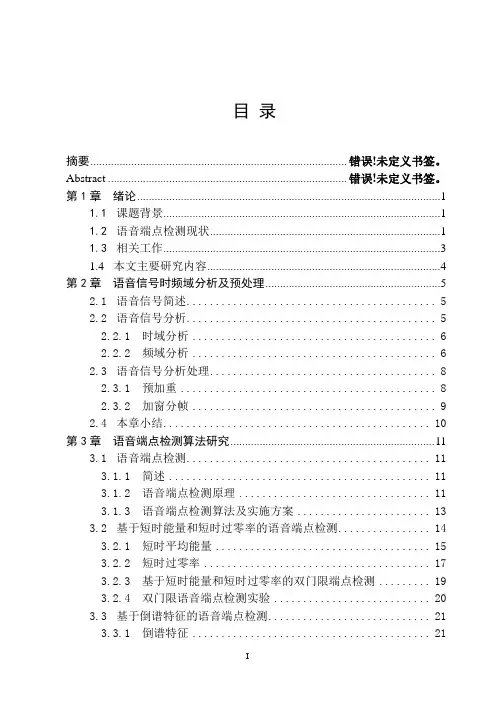

摘要摘要语音端点检测是指从一段语音信号中准确的找出语音信号的起始点和结束点,它的目的是为了使有效的语音信号和无用的噪声信号得以分离,因此在语音识别、语音增强、语音编码、回声抵消等系统中得到广泛应用。

目前端点检测方法大体上可以分成两类,一类是基于阈值的方法,该方法根据语音信号和噪声信号的不同特征,提取每一段语音信号的特征,然后把这些特征值与设定的阈值进行比较,从而达到语音端点检测的目的,该方法原理简单,运算方便,所以被人们广泛使用,本文主要对基于阀值的方法进行研究。

另一类方法是基于模式识别的方法,需要估计语音信号和噪声信号的模型参数来进行检测。

由于基于模式识别的方法自身复杂度高,运算量大,因此很难被人们应用到实时语音信号系统中去。

端点检测在语音信号处理中占有十分重要的地位,直接影响着系统的性能。

本文首先对语音信号进行简单的时域分析,其次利用短时能量和过零率算法、倒谱算法、谱熵算法进行语音端点检测,并对这几种算法进行端点检测,并进行实验分析。

本文首先分别用各算法对原始语音信号进行端点检测,并对各算法检测结果进行分析和比较。

其次再对语音信号加噪,对不同信噪比值进行端点检测,分析比较各算法在不同信噪比下的端点检测结果,实验结果表明谱熵算法语音端点检测结果比其他两种方法好。

关键词语音端点检测;语音信号处理;短时能量和过零率;倒谱;谱熵IAbstractEndpoint detection is a voice signal from the accurate speech signal to the identify start and the end points, the purpose is to enable to separated the effective voice signals and un-useful noise. So, in the speech recognition system, speech enhancement, speech coding, echo cancellation and other systems are widely used.In Current the endpoint detection can be roughly divided into two categories, one is based on the threshold method based on the different characteristics of speech signal and the noise signals, a voice signal for each extracted feature, and then set the values of these thresholds compare with the values to achieve the endpoint detection purposes, This method is simple, it convenient operation, it is widely used, the main in this paper is based on the method of threshold method. Another method is based on the method of pattern recognition , it needs to estimate the speech signal and the noise signal model parameters were detected. Because is based on the method of pattern recognition and high self-complexity, a large amount of computation, so it is difficult to be use in real-time voice signal system for people.The Endpoint detection is take a very important position in the speech recognition, it directly affects the performance of the system. In this article first domain analysis in simple speech signal time, than dual threshold algorithm, cepstrum algorithm, spectral entropy algorithm for endpoint detection, and these types of endpoint detection algorithms, and experimental analysis points. Firstly, the algorithm were used to the original speech signal detection, and the algorithm to analyze and compare results. Secondly, the speech signal and then adding noise, SNR values for different endpoint detection, analysis and comparison of various algorithms under different SNR endpoint detection results, experimental results show that the spectral entropy of speech endpoint detectionIIalgorithm results better than the other two methods.Keywords voice activity detection;Signal processing; Average energy use of short-term and short-time average zero-crossing rat; cepstrum; spectral entropyIII毕业设计(论文)原创性声明和使用授权说明原创性声明本人郑重承诺:所呈交的毕业设计(论文),是我个人在指导教师的指导下进行的研究工作及取得的成果。