Migratory Logistic Regression for Learning Concept Drift Between Two Data Sets with Applica

- 格式:pdf

- 大小:548.30 KB

- 文档页数:11

logistic regression法

(原创实用版)

目录

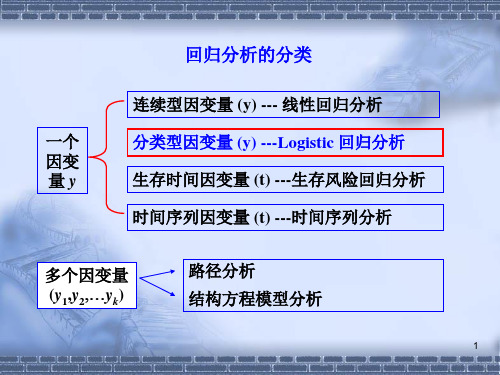

1.线性回归概述

2.Logistic 回归法的原理

3.Logistic 回归法的应用

4.Logistic 回归法的优缺点

正文

线性回归是一种常见的统计分析方法,主要用于研究因变量和自变量之间的关系。

在线性回归中,因变量通常是连续的,而自变量可以是连续的或离散的。

然而,当因变量为二分类或多分类时,线性回归就不再适用。

这时,Logistic 回归法就被引入了。

Logistic 回归法是一种用于解决分类问题的统计方法,其原理是基于逻辑斯蒂函数。

逻辑斯蒂函数是一种 S 型函数,其取值范围在 0 到 1 之间,可以用来表示一个事件发生的概率。

在 Logistic 回归法中,我们通过将自变量输入逻辑斯蒂函数,得到一个概率值,然后根据这个概率值来判断因变量所属的类别。

Logistic 回归法广泛应用于二分类和多分类问题中,例如信用风险评估、疾病预测、市场营销等。

在我国,Logistic 回归法也被广泛应用于各种领域,如金融、医疗、教育等。

Logistic 回归法虽然具有很多优点,但也存在一些缺点。

首先,Logistic 回归法对于自变量过多或者数据量过小的情况不太适用,因为这样容易导致过拟合。

其次,Logistic 回归法的计算过程比较复杂,需要用到特种数学知识,对计算资源的要求也比较高。

总的来说,Logistic 回归法是一种重要的分类方法,具有广泛的应

用前景。

logistic regression算法

Logistic regression (逻辑回归) 是一种用于二分类问题的统计学

习方法。

它基于一个由逻辑函数或Sigmoid函数表示的非线性

回归模型。

逻辑回归的目标是根据输入的特征,将样本分为两个离散的类别。

与线性回归不同,逻辑回归在结果上给出了0

和1之间的概率估计。

逻辑回归的实现步骤如下:

1. 收集训练数据集,该数据集应包含输入特征和对应的类别标签。

2. 准备数据,例如通过对特征进行归一化或者处理缺失数据。

3. 定义逻辑函数,该函数将输入特征映射到一个概率值,通常使用Sigmoid函数。

4. 定义损失函数,通常使用最大似然估计来定义损失函数,并使用梯度下降等优化算法来最小化该损失函数。

5. 训练模型,通过迭代优化算法,找到最优的参数值,使得损失函数最小化。

6. 对新样本进行预测,使用学习到的参数和逻辑函数,将输入特征映射到一个概率值,并根据阈值将其分类为正类或负类。

逻辑回归可以用于线性可分的和线性不可分的数据集。

它在进行预测时计算复杂度较低,模型也相对简单,易于解释和理解。

然而,逻辑回归对于非线性关系的学习能力较弱,因此在处理非线性问题时可能不够准确。

logistic regression原理(一)Logistic Regression原理1. 介绍•Logistic Regression(逻辑回归)是一种用于处理分类问题的机器学习算法。

•它可以用于二分类问题,也可以通过扩展用于多分类问题。

2. 基本概念•Logistic Regression的基本原理是通过拟合一个逻辑函数来预测分类概率。

•逻辑函数是一个S形曲线,将输入映射到0到1之间的值。

3. Sigmoid函数•逻辑函数通常使用Sigmoid函数来表示,公式如下:[Sigmoid Function](其中,z是线性方程的输出。

4. 线性方程•Logistic Regression使用一个线性方程加权求和输入特征来预测分类概率。

•线性方程的表示为:[Linear Equation](其中,x是输入特征,β是线性方程的权重。

5. 模型训练•训练Logistic Regression模型的目标是找到最佳的权重值,使得模型的预测结果与实际情况最为接近。

•常用的方法是最大似然估计,根据已有的训练数据,最大化模型预测正确性的概率。

6. 损失函数•损失函数用于衡量模型预测结果与实际情况之间的差异。

•在Logistic Regression中,常用的损失函数是对数损失函数(Log Loss)。

7. 模型预测•模型训练完成后,可以使用它来进行分类预测。

•根据输入特征,通过线性方程和Sigmoid函数,得到分类的概率值。

•一般而言,当概率大于时,预测为正类;当概率小于等于时,预测为负类。

8. 优点和局限性•优点:–算法简单,易于理解和实现;–训练速度快;–可以处理大规模数据;–可以输出分类概率值。

•局限性:–对特征之间的相关性敏感;–很难处理非线性关系。

9. 应用领域•Logistic Regression在许多领域都有广泛应用,例如:–金融行业中的风险评估和信用评分;–医疗领域中的疾病诊断;–电子商务中的用户购买行为预测。

用Logistic回归模型预测糖尿病人病情程度目录摘要 (Ⅰ)关键词 (Ⅰ)Abstract (Ⅱ)Keywords (Ⅱ)前言 (1)1.绪论 (1)1.1 研究意义 (1)1.2 研究背景 (2)2.Logistic回归模型简介 (2)2.1二分类Logistic回归模型 (3)2.2多分类Logistic回归模型 (4)2.3 Logisti c回归模型的参数估计方法 (5)3.用Logistic回归模型预测糖尿病人病情程度 (7)3.1问题分析 (7)3.2相关性分析 (8)3.3模型建立及检验 (10)3.4结论 (12)参考文献 (13)附表1 (14)附表2 (15)附表3 (17)附表4 (20)致谢 (22)用Logistic回归模型预测糖尿病人病情程度摘要:本文首先总结近年来有关Logistic回归模型的研究概况。

然后在Logistic回归模型的基础上,重点介绍了二分类和多分类变量Logistic回归模型。

并使用最大似然估计法对模型中的参数进行估计,然后根据拟合优度检验法对模型进行检验。

最后利用SPSS统计软件对糖尿病人的病情程度建立模型,进行系统的分析并将预测结果与实际结果进行比对。

关键词:Logistic回归模型;拟合优度;最大似然估计;回归系数Logistic regression model was used to predict the severity of diabeticpatientsAbstract:This topic summarizes some surveys researched in recent years about Logistic Regression Model. Then on the basis of Logistic Regression Model, introduce two categories and multiple categories variable of Logistic Regression Model, .Firstly, use maximum likelihood to estimste parameters of the model, and secondly, use the goodness of fit test for the model, thirdly, use SPSS statistical software to build model for the severity of patients with diabetes mellitus, carry out the system analysis and contrast the forecast and real result.Keywords:Logistic regression model; goodness of fit;maximum likelihood estimate; regression coefficients.前言Logistic回归模型作为重要的统计模型,对种群生态学的研究具有核心理论价值。

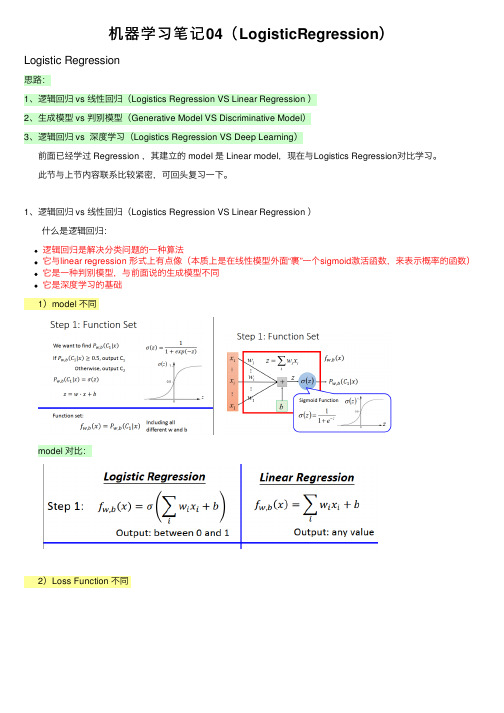

机器学习笔记04(LogisticRegression)Logistic Regression思路:1、逻辑回归 vs 线性回归(Logistics Regression VS Linear Regression )2、⽣成模型 vs 判别模型(Generative Model VS Discriminative Model)3、逻辑回归 vs 深度学习(Logistics Regression VS Deep Learning)前⾯已经学过 Regression ,其建⽴的 model 是 Linear model,现在与Logistics Regression对⽐学习。

此节与上节内容联系⽐较紧密,可回头复习⼀下。

1、逻辑回归 vs 线性回归(Logistics Regression VS Linear Regression ) 什么是逻辑回归:逻辑回归是解决分类问题的⼀种算法它与linear regression 形式上有点像(本质上是在线性模型外⾯“裹”⼀个sigmoid激活函数,来表⽰概率的函数)它是⼀种判别模型,与前⾯说的⽣成模型不同它是深度学习的基础1)model 不同model 对⽐:2)Loss Function 不同回顾我们线性回归的Loss函数中是跟训练数据(x1,y^1)中的y^1的差值平⽅和,那么逻辑回归是否也要建⽴与y^的联系呢。

下⾯就要开始拼凑了!Loss function对⽐:为什么不是⽤平⽅差?3)step 3 是类似的先算左边(红⾊框)的偏导,再算右边红⾊框的偏导,再整理式⼦:对⽐:2、⽣成模型 vs 判别模型(Generative Model VS Discriminative Model)两种不同的model,得到的 w,b 的参数不同。

但⼀般来说,判别模型表现得会⽐⽣成模型好,为什么?举例 ⽣成模型是基于假想的概率模型的,如果样本不平衡的话,计算出来的概率是会有误差的 但是⽣成模型也有优点: 1、样本量少的时候表现⽐判别模型好,因为它能⾃⼰脑补出⼀个假想模型 2、噪声对它影响较⼩,因为它没有过分依赖数据,它是按照⾃⼰假想模型⾛的3、逻辑回归 vs 深度学习(Logistics Regression VS Deep Learning)逻辑回归是解决分类问题的,实际中的问题⼤多是多分类的问题,多分类问题会⽤到softmax 以下⾯三分类问题为例:逻辑回归是有它的局限性的,这时候就需要深度学习了!举例:我们要⽤逻辑回归⽅法分类出下⾯的红点与蓝点,是需要⽤特征⼯程的⽅法的,⽽特征⼯程是需要我们⼈为地去建⽴⼀个特征函数去把这些点转化,实际上是⽐较难的,或者说⽐较费⼯夫的。

logisticregression简介Logistic Regression简介Logistic Regression(逻辑回归)是一种统计学习方法,用于解决分类问题。

它是由人们对线性回归模型的改进而来,通过引入逻辑函数将线性模型的输出限制在[0,1]之间,从而实现对二分类问题的建模。

Logistic Regression的基本原理是通过构建一个逻辑函数,将输入的特征与输出的概率联系起来。

逻辑函数一般采用Sigmoid函数,形式为:$$f(x) = \frac{1}{1+e^{-x}}$$其中,x为输入特征的线性组合。

Sigmoid函数具有将输入映射到[0,1]之间的特性,因此可以将输出解释为概率。

在Logistic Regression中,模型的参数是通过最大似然估计来求解的。

给定一个训练集,我们希望找到一组参数,使得模型对训练集的预测概率尽可能接近真实标签的概率。

具体来说,我们希望最大化似然函数:$$L(\theta) = \prod_{i=1}^{n}P(y^{(i)}|x^{(i)};\theta)$$其中,$y^{(i)}$为第i个样本的真实标签,$x^{(i)}$为其对应的特征向量,$\theta$为模型的参数。

对上式取对数,可以得到对数似然函数:$$l(\theta) = \sum_{i=1}^{n}\log P(y^{(i)}|x^{(i)};\theta)$$为了最大化对数似然函数,可以使用梯度上升法或者其他优化算法来求解。

Logistic Regression的优点之一是模型简单且易于解释。

由于模型的输出可以解释为概率,因此可以根据设定的阈值来进行分类预测。

此外,Logistic Regression对异常值和噪声有较好的鲁棒性,可以在一定程度上避免过拟合问题。

然而,Logistic Regression也有一些限制。

首先,它只能处理二分类问题,对于多分类问题需要进行扩展。

logistic regression逻辑回归算法-回复什么是逻辑回归算法(Logistic Regression Algorithm)?逻辑回归算法是一种广泛应用于机器学习和统计学领域的经典算法,用于建立分类模型。

它适用于用于预测二元分类问题的情况,即目标变量只有两个可能的输出。

逻辑回归通过将线性回归模型的输出转换为0和1之间的概率,从而实现分类。

逻辑回归算法的基本原理是将输入特征的加权和通过一个被称为"逻辑函数"或"sigmoid函数"的非线性函数进行转换。

这个函数可以将任何实数映射到[0,1]区间上的一个值。

逻辑函数常见的形式是:sigmoid(z) = \frac{1}{1 + e^{-z}}其中,z是线性回归模型的输出,由输入特征的加权和计算得到。

这个转换将使得输出可以被视为属于某个类别的概率。

逻辑回归算法的训练过程主要通过最大似然估计来确定模型的参数。

最大似然估计的目标是最大化给定数据样本的输出发生概率的乘积。

根据逻辑回归模型的假设,每个数据样本的输出概率可以由逻辑函数来表示。

因此,似然函数可以由所有数据样本的输出概率乘积来表示。

为了最大化似然函数,可以使用梯度下降法或牛顿法等优化算法来更新模型的参数,使得似然函数取得最大值。

这些优化算法会根据似然函数的梯度信息来调整参数的值,直至达到最优解。

在训练完成后,逻辑回归模型可以用于预测新的未知数据样本的类别。

通过计算输入特征的加权和,并将其输入逻辑函数中,可以得到一个概率值。

通常,概率值大于一个阈值(通常是0.5),模型将判定该数据样本属于正类别;反之则属于负类别。

逻辑回归算法具有许多优点。

首先,它的训练速度相对较快,尤其适用于大规模数据集。

其次,逻辑回归可以提供一个明确的概率值,而不仅仅是简单地判定一个样本属于哪个类别。

此外,逻辑回归模型也比较易于解释和理解。

然而,逻辑回归模型也有一些限制。

例如,它只适用于线性可分的数据集,因为它只能通过线性方式从输入特征中提取信息。

单因素逻辑回归英文名词When dealing with data analysis, one common technique we use is simple logistic regression. It's a statistical method that helps us understand the relationship between a binary outcome and a single predictor variable. In other words, it answers the question, "how likely is this event to happen based on one factor?" The simplicity of this approach makes it a great starting point for many researchers and analysts.The beauty of logistic regression lies in its ability to handle categorical outcomes. Unlike linear regression, which predicts continuous variables, logistic regression predicts probabilities of occurrence. This is especially useful when dealing with things like "yes/no" questions or binary outcomes.One of the coolest things about this method is that it provides us with an odds ratio. This ratio tells us how much the odds of an event change with each unit increase inthe predictor variable. So not only can we say that factor X is associated with an increase in the outcome, but we can also quantify exactly how much of an increase it is.Another aspect I love about logistic regression is its flexibility. While it's called "simple" here, we can easily extend it to include multiple predictor variables using multivariate logistic regression. This gives us the ability to capture complex relationships between many different factors and an outcome, making it a powerful tool in our data analysis arsenal.In summary, single-factor logistic regression is a straightforward yet powerful technique that allows us to understand the relationship between a binary outcome and a single predictor variable. Its simplicity, ability to handle categorical outcomes, provision of odds ratios, and flexibility make it a go-to method for many analysts and researchers.。

单因素logistic回归英文缩写English:"Single-factor logistic regression is abbreviated as SFLR. It is a statistical method used to model the relationship between a binary dependent variable and one independent variable. In SFLR, the dependent variable is categorical with two outcomes, usually coded as 0 and 1, representing, for example, failure and success or presence and absence. The independent variable can be continuous, categorical, or dichotomous. The logistic regression model estimates the probability of the occurrence of one of the outcomes based on the values of the independent variable. It calculates the odds ratio, which represents the odds of one outcome relative to the other. The logistic function, also known as the sigmoid function, transforms the linear combination of the independent variables into probabilities. SFLR is widely used in various fields such as medicine, epidemiology, and social sciences for predicting binary outcomes and understanding the factors influencing them."中文翻译:"单因素logistic回归的英文缩写是SFLR。