十三、logistic回归模型

- 格式:ppt

- 大小:681.50 KB

- 文档页数:82

logistic回归模型结果解读

x

一、 logistic回归模型结果解读

Logistic回归模型是一种分类数据模型,主要用于对不同类别的输出结果进行预测,因此,其结果解读也要以分类的形式来解释。

1、系数与因变量之间的关系

Logistic回归模型通过对因变量的分析,来推断被解释变量的概率。

结果中的系数提供了因变量与被解释变量之间的关系,比如我们可以分析不同系数值大小,从而获得因变量对被解释变量的影响程度,正相关的影响是系数的正值,反之是负值。

2、P值

P值是从回归结果中获取的,它可以反映特定因变量对被解释变量的重要性,P值越小,表明相对于其它因变量,该因变量对被解释变量影响越明显,则说明该因变量是重要因素。

3、R-Square和平均绝对值

R-Square是可决系数,它反映回归结果的好坏,R-Square的值越大,表明模型的预测效果越好,也就是越能够准确的来预测被解释变量的值。

平均绝对值也是可以用来判断模型好坏的指标,它比较每个样本的预测值和实际值之间的误差,值越小则表示模型的预测精度越高。

4、改进模型

可以通过以上结果,来判断模型的预测效果好坏,从而思考如何改进模型:比如可以进行特征选择,去掉系数值较小或者P值较大的因变量;也可以使用其它模型,如决策树或神经网络模型来进行比较,看哪一个模型对被解释变量的预测效果更好。

logistic回归模型——方法与应用

logistic回归模型是一种广泛应用于分类问题的统计学习方法。

它主要用于预测二分类问题,但也可以通过多类logistic回归

处理多分类问题。

方法:

1. 模型定义:logistic回归模型是一种线性分类模型,它

使用一个Logistic函数(也称为sigmoid函数)将线性模型生成

的线性组合转换为概率分数。

Logistic函数将线性组合映射到

0到1之间的值,表示输入属于正面类别的概率。

2. 模型训练:logistic回归模型的训练目标是找到一个权

重向量,使得模型能够最大化正面类别的概率。

训练算法通常采用最大似然估计方法,通过迭代优化权重向量来最小化负对数似然损失函数。

3. 预测:给定一个测试样本,logistic回归模型通过计算

样本的得分(也称为Logit),将其映射到0到1之间的概率分数。

如果概率分数超过一个预先定义的阈值,则将测试样本分类为正面类别,否则将其分类为负面类别。

应用:

1. 二分类问题:logistic回归模型最常用于解决二分类问题,例如垃圾邮件过滤、欺诈检测等。

2. 多类问题:通过多类logistic回归模型,可以将多个类别映射到0到1之间的概率分数,然后根据概率分数将测试样本分配到不同的类别中。

3. 特征选择:logistic回归模型可以用于特征选择,通过计算每个特征的卡方得分,选择与类别最相关的特征。

4. 文本分类:logistic回归模型在文本分类问题中得到广泛应用,例如情感分析、主题分类等。

logistic回归模型参数Logistic回归模型参数Logistic回归是一种常用的分类模型,它通过将线性回归模型的输出映射到[0,1]区间上,来进行二分类任务。

在Logistic回归模型中,有一些重要的参数需要考虑和理解。

本文将详细介绍这些参数的含义和作用。

1. 截距项(Intercept)截距项是Logistic回归模型中的一个重要参数。

它表示当所有自变量的取值都为0时,模型预测的概率为多少。

截距项可以理解为模型在没有考虑任何自变量的情况下的基准预测概率。

如果截距项较大,说明基准预测概率较高,反之则较低。

2. 斜率项(Coefficients)斜率项是Logistic回归模型中各自变量的系数。

每个自变量都有一个对应的系数,表示该自变量对模型预测的影响程度。

系数的正负可以告诉我们自变量与因变量之间的正负关系,系数的大小可以告诉我们自变量对因变量的影响程度。

3. 偏置(Bias)偏置是Logistic回归模型中的一个重要参数,它可以理解为模型的容忍度。

偏置越高,模型对噪声和异常值的容忍度越高,但可能会导致过拟合;偏置越低,模型对噪声和异常值的容忍度越低,但可能会导致欠拟合。

合适的偏置可以使模型在训练集和测试集上都有较好的表现。

4. 阈值(Threshold)阈值是Logistic回归模型中用于分类的一个重要参数。

当模型输出的概率大于等于阈值时,将样本划分为正类;当模型输出的概率小于阈值时,将样本划分为负类。

阈值的选择对模型的分类结果有重要影响。

较高的阈值会使正类的判定更加严格,较低的阈值会使正类的判定更加宽松。

5. 正则化参数(Regularization)正则化参数是Logistic回归模型中的一个重要参数,用于控制模型的复杂度。

正则化参数越大,模型的复杂度越低,有助于防止过拟合;正则化参数越小,模型的复杂度越高,有助于提高模型的拟合能力。

合适的正则化参数可以使模型在训练集和测试集上都有较好的表现。

logistic回归模型和logit模型引言部分:在机器学习领域中,分类问题一直是研究的热点之一。

Logistic回归模型和Logit模型是二分类问题中,表现优异的分类算法。

基于二项分布的原理,这两个模型能够有效的进行分类,因此受到了广泛的应用和研究。

正文部分:一、Logistic回归模型Logistic回归模型是一种广义线性模型,被广泛应用于分类问题中。

它通过Sigmoid函数将线性回归的结果映射到概率值,在进行分类时,将概率值与设定的阈值进行比较,从而进行分类。

Logistic回归模型的形式如下:$$ P(Y=1|X)=\frac{1}{1+e^{-(w^TX+b)}} $$其中,$w$表示特征的权值,$b$表示偏置的值,$X$表示输入的特征向量,$Y$表示输出的标签。

该模型的训练过程通常采用最大似然估计方法进行优化,从而得到最佳的模型参数。

二、Logit模型Logit模型也是一种二分类模型,它的实现基于对数几率的概念。

在Logit模型中,将正例的对数几率表示为输入向量的线性函数,而负例的对数几率为其相反数。

模型的形式如下:$$ \log(\frac{P(Y=1|X)}{1-P(Y=1|X)})=w^TX+b $$Logit模型使用最大似然估计法进行参数的学习,使得模型尽可能地对训练数据进行拟合。

通过计算输入向量对应的对数几率,可以得到相应的输出标签,从而进行分类。

三、Logistic回归模型与Logit模型的异同1. 形式不同:Logistic回归模型采用的是Sigmoid函数进行分类,而Logit模型则是基于对数几率的理论进行分类。

2. 拟合效果不同:Logistic回归模型在分类效果上表现出更好的鲁棒性,能够在处理多重共线性等情况下表现出较好的效果;而Logit模型的拟合效果较为稳定,能够更好地应对噪声和异常点的干扰。

3. 处理方式不同:Logistic回归模型通常采用迭代法和正则化方法来优化模型参数;而Logit模型常常采用牛顿法等基于优化的方法来更新模型参数。

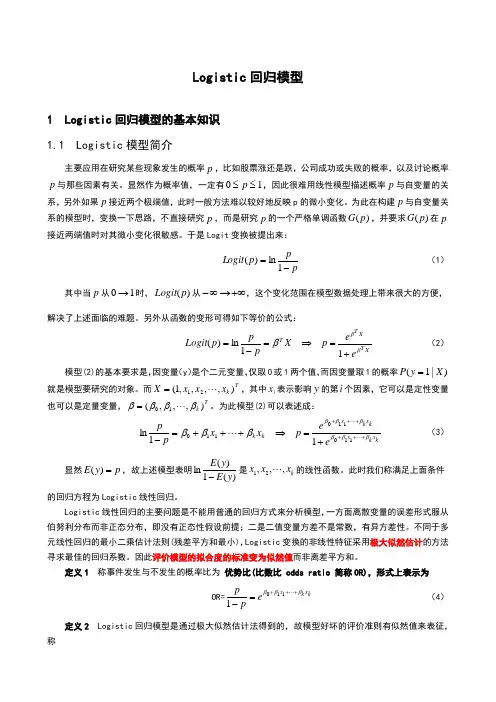

Logistic 回归模型1 Logistic 回归模型的基本知识 1.1 Logistic 模型简介主要应用在研究某些现象发生的概率p ,比如股票涨还是跌,公司成功或失败的概率,以及讨论概率p 与那些因素有关。

显然作为概率值,一定有10≤≤p ,因此很难用线性模型描述概率p 与自变量的关系,另外如果p 接近两个极端值,此时一般方法难以较好地反映p 的微小变化。

为此在构建p 与自变量关系的模型时,变换一下思路,不直接研究p ,而是研究p 的一个严格单调函数)(p G ,并要求)(p G 在p 接近两端值时对其微小变化很敏感。

于是Logit 变换被提出来:ppp Logit -=1ln)( (1)其中当p 从10→时,)(p Logit 从+∞→∞-,这个变化范围在模型数据处理上带来很大的方便,解决了上述面临的难题。

另外从函数的变形可得如下等价的公式:XT X T T eep X ppp Logit βββ+=⇒=-=11ln)( (2)模型(2)的基本要求是,因变量(y )是个二元变量,仅取0或1两个值,而因变量取1的概率)|1(X y P =就是模型要研究的对象。

而T k x x x X ),,,,1(21 =,其中i x 表示影响y 的第i 个因素,它可以是定性变量也可以是定量变量,Tk ),,,(10ββββ =。

为此模型(2)可以表述成:kx k x kxk x k k ee p x x p p βββββββββ+++++++=⇒+++=- 11011011011ln (3)显然p y E =)(,故上述模型表明)(1)(ln y E y E -是k x x x ,,,21 的线性函数。

此时我们称满足上面条件的回归方程为Logistic 线性回归。

Logistic 线性回归的主要问题是不能用普通的回归方式来分析模型,一方面离散变量的误差形式服从伯努利分布而非正态分布,即没有正态性假设前提;二是二值变量方差不是常数,有异方差性。

logistic回归原理

Logistic回归是一种有效的、相对简单的数据分类技术,用于确定某个事件或观测值属于某类的概率。

它可以解释二元数据和多类数据,并且能够应用于各种场景,比如风险分析、金融建模、社会研究等等。

Logistic回归源自线性模型,它是一种称为逻辑斯蒂(logit)模型的回归模型,该模型基于概率理论。

Logistic回归模型是由概率对数函数构建而成的,即:

Y = log(P/(1-P))

其中,P代表事件Y发生的概率。

Logistic归模型在数据分析中最主要的用途就是用于分类,它的原理是:假定输入的数据可以用一个线性函数来描述,并且拟合一条S型函数来获得概率,这个概率决定了每个样本点属于某一类的概率大小。

在使用Logistic回归之前,首先要处理好数据集,确保它具有足够的观测值,并且有合理的分类标签(例如“是”、“否”)。

接下来,要使用回归的模型,先把正确的观测值用正向的系数系数,将错误的观测值用负向的系数进行编码。

然后,确定正确的估计量结果,比如系数、拟合度指标和参数检验,以及误差分析。

最后,定义一个提升指标来评估结果,例如:准确率、召回率和精确率。

Logistic回归在机器学习中有各种应用,比如文本分类、情感分析和预测分析;在图像识别中,它可以用于目标检测、纹理识别和

边缘检测;在金融行业,它可以应用于信贷分析、欺诈检测和市场风险分析。

它也可以用于生物药物研究、病毒鉴别;在医学领域,它可以用于数据分析、诊断分析和临床预测等。

简而言之,Logistic回归是一种用于预测任意事件的概率发生的有效模型,可以用于多类数据的分类,在数据挖掘领域扮演着重要的角色,是结构化数据建模的常用工具。

Logistic 回归模型1 Logistic 回归模型的基本知识 1.1 Logistic 模型简介主要应用在研究某些现象发生的概率p ,比如股票涨还是跌,公司成功或失败的概率,以及讨论概率p 与那些因素有关。

显然作为概率值,一定有10≤≤p ,因此很难用线性模型描述概率p 与自变量的关系,另外如果p 接近两个极端值,此时一般方法难以较好地反映p 的微小变化。

为此在构建p 与自变量关系的模型时,变换一下思路,不直接研究p ,而是研究p 的一个严格单调函数)(p G ,并要求)(p G 在p 接近两端值时对其微小变化很敏感。

于是Logit 变换被提出来:ppp Logit -=1ln)( (1)其中当p 从10→时,)(p Logit 从+∞→∞-,这个变化范围在模型数据处理上带来很大的方便,解决了上述面临的难题。

另外从函数的变形可得如下等价的公式:XT XT T ee p Xppp Logit βββ+=⇒=-=11ln )( (2)模型(2)的基本要求是,因变量(y )是个二元变量,仅取0或1两个值,而因变量取1的概率)|1(X y P =就是模型要研究的对象。

而Tk x x x X ),,,,1(21 =,其中i x 表示影响y 的第i 个因素,它可以是定性变量也可以是定量变量,Tk ),,,(10ββββ =。

为此模型(2)可以表述成:kx k x k x k x kk eep x x pp βββββββββ+++++++=⇒+++=- 11011011011ln (3)显然p y E =)(,故上述模型表明)(1)(lny E y E -是k x x x ,,,21 的线性函数。

此时我们称满足上面条件的回归方程为Logistic 线性回归。

Logistic 线性回归的主要问题是不能用普通的回归方式来分析模型,一方面离散变量的误差形式服从伯努利分布而非正态分布,即没有正态性假设前提;二是二值变量方差不是常数,有异方差性。

logistic回归模型方程Logistic回归模型方程是一种常用的分类算法,它可以将数据分为两个或多个类别。

在这篇文章中,我们将介绍Logistic回归模型方程的基本概念和应用。

Logistic回归模型方程是一种基于概率的分类算法,它可以将数据分为两个或多个类别。

在Logistic回归模型中,我们使用一个S形函数来将输入变量映射到输出变量。

这个S形函数被称为Logistic 函数,它的形式如下:$$P(y=1|x)=\frac{1}{1+e^{-\beta_0-\beta_1x_1-\beta_2x_2-...-\beta_px_p}}$$其中,$P(y=1|x)$表示当输入变量为$x$时,输出变量为1的概率。

$\beta_0,\beta_1,\beta_2,...,\beta_p$是模型的参数,$x_1,x_2,...,x_p$是输入变量。

Logistic回归模型的训练过程是通过最大化似然函数来确定模型参数的。

似然函数是一个关于模型参数的函数,它描述了给定模型参数下观察到数据的概率。

在Logistic回归模型中,似然函数的形式如下:$$L(\beta)=\prod_{i=1}^{n}P(y_i|x_i;\beta)^{y_i}(1-P(y_i|x_i;\beta))^{1-y_i}$$其中,$n$是样本数量,$y_i$是第$i$个样本的输出变量,$x_i$是第$i$个样本的输入变量。

最大化似然函数的过程可以使用梯度下降等优化算法来实现。

Logistic回归模型可以应用于许多分类问题,例如垃圾邮件分类、疾病诊断等。

在这些问题中,我们需要将输入变量映射到输出变量,以便进行分类。

Logistic回归模型可以通过学习输入变量和输出变量之间的关系来实现这一目标。

Logistic回归模型方程是一种常用的分类算法,它可以将数据分为两个或多个类别。

在Logistic回归模型中,我们使用一个S形函数来将输入变量映射到输出变量。

[转载]logistic回归模型总结logistic回归模型是最成熟也是应用最广泛的分类模型,通过学习和实践拟通过从入门、进阶到高级的过程对其进行总结,以便加深自己的理解也为对此有兴趣者提供学习的便利。

一、有关logistic的基本概念logistic回归主要用来预测离散因变量与一组解释变量之间的关系最常用的是二值型logistic。

即因变量的取值只包含两个类别例如:好、坏;发生、不发生;常用Y=1或Y=0表示X 表示解释变量则P(Y=1|X)表示在X的条件下Y=1的概率,logistic回归的数学表达式为:log(p/1-p)=A+BX =L其中p/1-p称为优势比(ODDS)即发生与不发生的概率之比可以根据上式反求出P(Y=1|X)=1/(1+e^-L)根据样本资料可以通过最大似然估计计算出模型的参数然后根据求出的模型进行预测下面介绍logistic回归在SAS中的实现以及输出结果的解释二、logistic回归模型初步SAS中logistic回归输出结果主要包括预测模型的评价以及模型的参数预测模型的评价与多元线性回归模型的评价类似主要从以下几个层次进行(1)模型的整体拟合优度主要评价预测值与观测值之间的总体一致性。

可以通过以下两个指标来进行检验1、Hosmer-Lemeshowz指标HL统计量的原假设Ho是预测值和观测值之间无显著差异,因此HL指标的P-Value的值越大,越不能拒绝原假设,即说明模型很好的拟合了数据。

在SAS中这个指标可以用LACKFIT选项进行调用2、AIC和SC指标即池雷准则和施瓦茨准则与线性回归类似AIC和SC越小说明模型拟合的越好(2)从整体上看解释变量对因变量有无解释作用相当于多元回归中的F检验在logistic回归中可以通过似然比(likelihood ratiotest)进行检验(3)解释变量解释在多大程度上解释了因变量与线性回归中的R^2作用类似在logistic回归中可以通过Rsquare和C统计量进行度量在SAS中通过RSQ来调用Rsquare,C统计量自动输出(4)模型评价指标汇总<span style="font-family:宋体;mso-ascii-font-family:Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">统计量<span style="font-family:宋体;mso-ascii-font-family:Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">趋势<span style="font-family:宋体;mso-ascii-font-family:Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">拟合<span style="font-family:宋体;mso-ascii-font-family:Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">作用SAS<span style="font-family:宋体;mso-ascii-font-family:Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">调用命令<span style="font-family:宋体;mso-ascii-font-family:Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">备注AIC<span style="font-family:宋体;mso-ascii-font-family:Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">、SC<td valign="top" style="border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">越小<td valign="top" style="border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">越好<td width="197" valign="top" style="width:117.9pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">类似与多元回归中的残差平方和<td width="177" valign="top" style="width:106.3pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">模型自动输出<td width="123" valign="top" style="width:73.75pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">似然比卡方<td valign="top" style="border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">越大<td valign="top" style="border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">越好<td width="197" valign="top" style="width:117.9pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">类似与多元回归中的回归平方和<td width="177" valign="top" style="width:106.3pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">自动输出<td width="123" valign="top" style="width:73.75pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt">P<span style="font-family:宋体;mso-ascii-font-family:Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">值越小越好RSQUARE<td valign="top" style="border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">越大<td valign="top" style="border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">越好<td width="197" valign="top" style="width:117.9pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">类似与多元回归中的R^2<td width="177" valign="top" style="width:106.3pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">用RSQ<span style="font-family:宋体;mso-ascii-font-family:Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">选项调用<td width="123" valign="top" style="width:73.75pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt">C<span style="font-family:宋体;mso-ascii-font-family: Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">统计量<td valign="top" style="border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">越大<td valign="top" style="border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">越好<td width="197" valign="top" style="width:117.9pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">度量观测值和条件预测的相对一致性<td width="177" valign="top" style="width:106.3pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">自动输出<td width="123" valign="top" style="width:73.75pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt">HL<span style="font-family:宋体;mso-ascii-font-family: Calibri;mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">统计量<td valign="top" style="border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">越小<td valign="top" style="border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">越好<td width="197" valign="top" style="width:117.9pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt"><span style="font-family:宋体;mso-ascii-font-family:Calibri; mso-ascii-theme-font:minor-latin;mso-fareast-font-family:宋体;mso-fareast-theme-font:minor-fareast;mso-hansi-font-family:Calibri;mso-hansi-theme-font:minor-latin">度量观测值和预测值总体的一致性<td width="177" valign="top" style="width:106.3pt;border-top:none;border-left:none;border-bottom:solid windowtext 1.0pt;border-right:solid windowtext 1.0pt;mso-border-top-alt:solid windowtext .5pt;mso-border-left-alt:solid windowtext .5pt;mso-border-alt:solid windowtext .5pt;padding:0cm 5.4pt 0cm 5.4pt">。

Logistic回归模型和Logit模型都是常用的统计模型,它们在应用和特点上有一些不同。

Logit模型是线性概率模型在定量分析中的一种,但在分析分类变量时会遇到困难。

例如,当因变量是分类变量时,线性回归模型可能无法准确预测结果,因为对自变量的限定性不强,且因变量必须是连续变量。

另一方面,Logit模型的响应变量可以是多元的,也可以是多分类的。

Logistic回归模型属于回归分析,其分析结果为估计出自变量参数。

当因变量是多类的,Logistic回归模型同样适用,计算结果与Logit 模型并无多少差别。

总结来说,Logistic回归模型和Logit模型虽然都是常见的统计模型,但它们在应用和特点上有所区别。

选择使用哪种模型取决于研究目标、数据类型和分析需求等因素。

Logistic 回归模型一、 分组数据的Logistic 回归模型针对0-1型因变量产生的问题,我们对回归模型应该作两个方面的改进。

第一, 回归函数应该用限制在[0,1]区间内的连续曲线,而不能再沿用沿用直线回归方程。

限制在[0,1]区间内的连续曲线很多,例如所有连续变量的分布函数都符合要求,我们常用的是Logistic 函数与正如分布函数,Logistic 函数的形式为:()1xxe f x e =+Logistic 函数的中文名称逻辑斯蒂函数,简称逻辑函数 第二、因变量y 本身只取0、1两个离散值,不适合直接作为回归模型中的因变量,由于回归函数01()i i i E y x πββ==+表示在自变量为i x 的条件下i y 的平均值,而i y 是0-1型随机变量,因而()i i E y π=就是在自变量为i x 的条件下i y 等于1的比例.这就提示我们可以用i y 等于1的比例代替i y 本身作为因变量.二,例子 在一次住房展销会上,与房地产商签订初步购房意向书的共有325n =名顾客,在随后的3个月的时间内,只有一部分顾客确实购买了房屋.购买了房屋的顾客记为1,没有购买房屋的顾客记为0,以顾客的年家庭收入为自变量x,对下面表所示的数据,序号年家庭收入(万元)x 签订意向书人数n 实际购房人数m 实际购房比例p逻辑变换p′=ln(p/(1-p))权重w=np(1-p)1 1.52580.32-0.7537718 5.442 2.532130.40625-0.37948967.718753 3.558260.448276-0.207639414.344834 4.552220.423077-0.310154912.692315 5.543200.465116-0.139761910.697676 6.539220.5641030.257829119.58974477.528160.5714290.287682076.85714388.521120.5714290.287682075.14285799.515100.6666670.693147183.333333建立Logistic 回归模型:c i x x p i i i,,2,1,)exp(1)exp(1010 =+++=ββββ,其中,c 为分组数据的组数,本例中c=9.将以上回归方程作线性变换,令)1ln(iii p p p -=' 该变换称为逻辑变换,变换后的线性回归模型为 i i i x p εββ++='10该式是一个普通的一元线性回归模型。

logistic回归的模型公式Logistic回归是一种常用的分类算法,通过将线性回归模型的结果经过一个sigmoid函数进行转换,将连续的输出转换为概率值,从而进行分类预测。

在Logistic回归中,我们需要构建一个模型来预测某个事件发生的概率。

这个模型的输出值介于0和1之间,表示事件发生的概率。

我们可以将这个输出值看作是样本属于某个类别的概率,并将阈值设置为0.5,当输出值大于0.5时,我们将样本分类为正例,否则分类为负例。

Logistic回归的模型公式如下:$$P(y=1|x) = \frac{1}{1+e^{-z}}$$其中,$y$表示样本的类别,$x$表示样本的特征,$z$表示线性回归模型的输出。

$P(y=1|x)$表示样本属于类别1的概率。

这个概率值是根据样本的特征经过线性回归模型计算出来的。

在构建模型之前,我们需要对特征进行处理。

通常,我们会对特征进行标准化处理,使得特征的均值为0,方差为1。

这样可以提高模型的收敛速度和预测效果。

接下来,我们需要确定模型的参数。

在Logistic回归中,我们需要通过最大似然估计方法来确定参数的值。

最大似然估计方法是一种常用的参数估计方法,通过最大化样本的似然函数来确定参数的值。

似然函数表示给定参数的情况下,观察到当前样本的概率。

在Logistic回归中,似然函数可以表示为:$$L(\theta) = \prod_{i=1}^{m} P(y^{(i)}|x^{(i)};\theta)$$其中,$m$表示样本的数量,$y^{(i)}$表示第$i$个样本的类别,$x^{(i)}$表示第$i$个样本的特征,$\theta$表示模型的参数。

我们的目标是最大化似然函数,即找到最优的参数值$\hat{\theta}$,使得似然函数取得最大值。

由于似然函数通常比较复杂,我们通常采用对数似然函数来进行优化。

对数似然函数可以表示为:$$l(\theta) = \sum_{i=1}^{m} \log P(y^{(i)}|x^{(i)};\theta)$$通过最大化对数似然函数,我们可以得到最优的参数估计值$\hat{\theta}$。