lucene原理介绍以及使用方法

- 格式:doc

- 大小:24.50 KB

- 文档页数:3

lucene 基本概念Lucene 基本概念Lucene 是一个开源的全文搜索引擎库,被广泛地应用于高性能搜索和索引任务中。

它是 Apache 软件基金会的一个开源项目,并且被许多知名的商业产品使用。

本文将通过一步一步的方式,来介绍 Lucene 的基本概念和其原理。

一、Lucene 是什么?Lucene 是一个基于 Java 的全文搜索引擎库。

它提供了一系列的 API 和工具,用于创建、维护和搜索大规模文本数据集。

通过将文本数据索引到 Lucene 的索引库中,我们可以快速地进行全文搜索、排序和过滤等操作。

二、Lucene 的基本原理1. 倒排索引倒排索引是 Lucene 的核心概念之一。

它是一种数据结构,用于从词项到文档的映射。

通常,我们将文本数据分割成单词,然后对每个词项构建一个索引条目,该条目指向包含该词项的文档。

例如,假设我们有三个文档:文档1 包含 "Lucene 是一个搜索引擎库",文档2 包含 "Apache Lucene 是一个全文搜索库",文档3 包含 "Lucene 是基于 Java 的"。

在倒排索引中,我们将按照词项构建索引,如下所示:词项文档Lucene 1, 2, 3是 1, 2, 3一个 1, 2, 3搜索引擎库 1全文搜索库 2基于 3Java 3倒排索引的优势在于它能够快速地确定包含特定词项的文档,并且支持更复杂的查询表达式。

2. 分词器分词器是将原始文本分割成词项的模块。

Lucene 提供了多种分词器,如标准分词器、简单分词器等。

分词器还可以根据具体的需求进行定制。

分词器在构建索引和搜索时起到关键作用,它们确保在索引和搜索阶段都使用相同的分词规则。

3. 文档和字段在 Lucene 中,文档是一个最小的索引单位。

它由多个字段组成,每个字段包含一个词项或多个词项。

字段可以是文本、数值或日期等不同类型。

Lucene 中的文档和字段的设计灵活,可以根据实际需求进行定义和修改。

一、lucene模糊匹配原理概述lucene是一个开源的全文检索引擎工具,提供了强大的文本搜索和分析功能。

在实际应用中,经常需要进行模糊匹配,以处理用户输入的错别字、拼写错误或者同义词。

模糊匹配是lucene中非常重要的功能,它可以帮助用户找到相关的文档,提高搜索的准确性和全面性。

二、lucene模糊匹配的算法原理1. Levenshtein Distance算法Levenshtein Distance是衡量两个字符串相似程度的一种算法,也称为编辑距离。

在lucene中,模糊匹配主要使用Levenshtein Distance算法来实现。

该算法通过计算两个字符串之间的距离,从而确定它们的相似程度。

具体来说,它通过插入、删除和替换操作,将一个字符串转换成另一个字符串所需的最小步骤数来衡量相似度。

2. 模糊查询的实现方式在lucene中,模糊查询可以通过FuzzyQuery类来实现。

利用FuzzyQuery,可以指定一个最大编辑距离,从而允许匹配到具有一定相似度的文档。

FuzzyQuery会基于Levenshtein Distance算法来进行模糊匹配,找到编辑距离小于等于指定值的文档。

三、模糊匹配的应用场景1. 处理用户输入错误当用户在搜索框中输入错别字或者拼写错误时,模糊匹配可以帮助系统找到相关的文档,并提供纠正建议,提高搜索的准确性和用户体验。

2. 同义词匹配在自然语言处理中,同一个概念可能有多种不同的表达方式。

通过模糊匹配,可以将具有相似含义的词语进行匹配,从而提高搜索的全面性。

3. 解决词形变化问题词形变化是自然语言中常见的现象,同一个词可能有不同的变形形式。

通过模糊匹配,可以将不同词形的单词对应起来,使得搜索更加全面和准确。

四、模糊匹配的优化策略1. 设置合适的编辑距离阈值在使用模糊匹配时,需要根据具体的应用场景来设置合适的编辑距离阈值。

如果编辑距离过小,可能会产生大量的不必要匹配;如果编辑距离过大,可能会包含过多的无关文档。

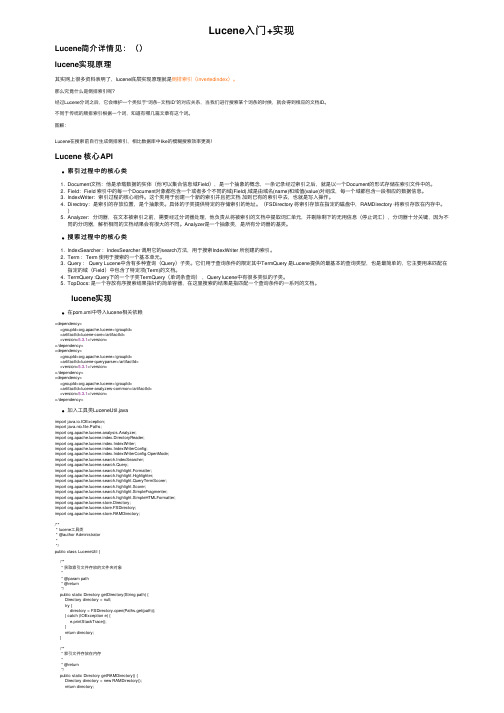

Lucene⼊门+实现Lucene简介详情见:()lucene实现原理其实⽹上很多资料表明了,lucene底层实现原理就是倒排索引(invertedindex)。

那么究竟什么是倒排索引呢?经过Lucene分词之后,它会维护⼀个类似于“词条--⽂档ID”的对应关系,当我们进⾏搜索某个词条的时候,就会得到相应的⽂档ID。

不同于传统的顺排索引根据⼀个词,知道有哪⼏篇⽂章有这个词。

图解:Lucene在搜索前⾃⾏⽣成倒排索引,相⽐数据库中like的模糊搜索效率更⾼!Lucene 核⼼API索引过程中的核⼼类1. Document⽂档:他是承载数据的实体(他可以集合信息域Field),是⼀个抽象的概念,⼀条记录经过索引之后,就是以⼀个Document的形式存储在索引⽂件中的。

2. Field:Field 索引中的每⼀个Document对象都包含⼀个或者多个不同的域(Field),域是由域名(name)和域值(value)对组成,每⼀个域都包含⼀段相应的数据信息。

3. IndexWriter:索引过程的核⼼组件。

这个类⽤于创建⼀个新的索引并且把⽂档加到已有的索引中去,也就是写⼊操作。

4. Directroy:是索引的存放位置,是个抽象类。

具体的⼦类提供特定的存储索引的地址。

(FSDirectory 将索引存放在指定的磁盘中,RAMDirectory ·将索引存放在内存中。

)5. Analyzer:分词器,在⽂本被索引之前,需要经过分词器处理,他负责从将被索引的⽂档中提取词汇单元,并剔除剩下的⽆⽤信息(停⽌词汇),分词器⼗分关键,因为不同的分词器,解析相同的⽂档结果会有很⼤的不同。

Analyzer是⼀个抽象类,是所有分词器的基类。

搜索过程中的核⼼类1. IndexSearcher :IndexSearcher 调⽤它的search⽅法,⽤于搜索IndexWriter 所创建的索引。

2. Term :Term 使⽤于搜索的⼀个基本单元。

lucene query 语法Lucene Query语法是Lucene搜索引擎中使用的一种搜索语法,由一系列的搜索参数和限制条件组成,用于为用户查询所需的结果。

虽然Lucene Query语法功能十分强大,但对于初学者来说可能有些复杂。

本文将为了帮助初学者更好地理解Lucene Query语法,介绍其特点、组成结构和使用方法等。

一、Lucene Query语法的特点1. 灵活性Lucene Query语法非常灵活,可以处理多种匹配和搜索需求,例如对单个词语、短语、模糊搜索以及实现排除性搜索等。

2. 分词器支持Lucene Query语法支持各种分词器,这样用户可以通过选择不同的分词器进行搜索结果的匹配。

3. 易于理解虽然Lucene Query语法具有很高的灵活性,但一旦熟悉了其语法结构,用户就很容易理解和应用查询条件。

二、Lucene Query语法的组成结构Lucene Query语法的查询结构由多个组成部分组成,每一个组件表示一个查询条件,可以是一个单独搜索条件,也可以是多个条件的组合形成的复合搜索条件连接。

1. 查询语法启动符:用于表示Lucene Query语法的开始,通常为“+”或“-”符号,用于表示是否搜索一个特定的项目或者排除一个项目2. 字段名:指定需要搜索的字段名称,可以是一个或多个,使用“:”符号将字段名和搜索参数或值隔开。

3. 搜索参数或值:需要搜索的参数或值,也可以使用布尔运算符(AND/OR)进行多个查询条件的组合。

例如:name:john AND age:254. 通配符:用于单个字符或多个字符的模糊匹配,例如:name:j* 可以匹配 john 或者 jacob5. 范围查找:指定需要查找的数据范围,使用“[ ]”表示查询范围6. 模糊搜索:使用“~”号后跟一个数字(0~1)表示模糊搜索的程度,数字越小表示模糊匹配程度越高7. 布尔运算符:用于将多个查询条件组合成一个复合查询条件。

Lucene中的KnnVectorField是用于支持向量搜索的字段类型。

它的原理是将文档内容表示为向量,并使用K近邻算法

(KNN)来搜索相似的向量。

具体来说,KnnVectorField首先将文档内容转换为向量表示。

这通常通过使用特征提取器(例如TF-IDF、Word2Vec 等)来提取文档中的特征,并将这些特征作为向量的各个维度。

每个维度对应于文档中的一个特征,其值取决于该特征在文档中的出现情况或与其他文档的相似度。

一旦文档被转换为向量表示,就可以使用K近邻算法来搜索相似的向量。

K近邻算法是一种基于距离度量的机器学习算法,它通过计算查询向量与存储在索引中的每个文档向量之间的距离来找到最相似的文档。

在Lucene中,KnnVectorField将文档向量存储在索引中,以便在搜索时进行快速匹配。

当查询时,Lucene会计算查询向量与索引中的每个文档向量之间的距离,并根据距离的排序返回最相似的文档。

需要注意的是,Lucene中的KnnVectorField主要用于支持向量搜索,而不是传统的文本搜索。

因此,它通常与传统的文本字段一起使用,以便在文本搜索和向量搜索之间进行

组合。

标题:探讨Lucene对比中文近义词用法1. 简介为了更好地理解Lucene对比中文近义词用法,我们首先需要了解Lucene的基本概念和中文近义词的特点。

Lucene是一个全文检索引擎库,它提供了丰富的API,可以用于构建强大的全文搜索功能。

而中文近义词则是指在中文语境中,表达相似意义的词语,这些词语在不同的语境中可能会有微小的差别,但整体的意思是相通的。

2. Lucene的基本原理和功能Lucene通过倒排索引的方式来快速定位文档中的关键词,从而实现全文搜索的功能。

它采用了分词器来处理文本,将文本分割成若干个独立的单词,并将这些单词进行索引。

在搜索时,用户输入的查询语句也经过相同的分词处理,再与索引进行匹配,最终返回相关的文档。

3. 中文近义词的特点在中文语境中,由于词语的复杂性和多义性,往往会存在大量的近义词。

这些近义词可能在不同的场景中有不同的使用方式,但它们的基本意思是一致的。

“喜欢”和“爱好”就是一对中文近义词,它们都表示喜爱或偏好的意思,只是在语感上有细微的区别。

4. Lucene对比中文近义词用法在使用Lucene进行搜索时,对于中文近义词的处理往往是一个挑战。

由于中文的特殊性,同一个词可能存在多种不同的表达方式,而传统的搜索引擎很难将它们准确地匹配在一起。

针对这一问题,Lucene提供了同义词扩展的功能,可以将一些近义词视作同一个词来处理。

这样一来,用户在搜索时无需考虑到所有的近义词,只需要输入其中一个,就能够搜索到相关的文档。

5. 个人观点和总结通过对Lucene对比中文近义词用法的探讨,我们可以发现,Lucene在处理中文近义词时的确存在一些挑战,但它也提供了相应的解决方案。

在实际应用中,我们可以根据具体的需求,合理地进行同义词扩展,以提升搜索结果的准确性和覆盖范围。

对于中文近义词的掌握也需要结合具体的语境和语气来理解,不能简单地进行机械替换。

Lucene对比中文近义词用法的探讨,有助于我们更好地理解和应用这一强大的全文搜索引擎库。

lucene 原理

Lucene原理可以归纳为以下几个方面:

1. 倒排索引:Lucene使用一种称为倒排索引的数据结构来存

储文档。

倒排索引是一种将词条映射到其出现的文档的数据结构。

它由一个词条词典和一系列倒排表组成。

词条词典将所有不重复的词条存储在一起,并记录每个词条在哪些文档中出现。

倒排表存储每个词条出现在哪些文档的具体位置。

2. 分词器:在建立倒排索引之前,Lucene需要将文档分割成

独立的词条。

分词器是负责此任务的组件。

Lucene提供了一

些内置的分词器,如标准分词器和简单分词器。

用户也可以自定义分词器来满足自己的需求。

3. 查询解析:Lucene支持用户使用查询字符串来进行检索。

查询解析器负责将查询字符串解析为内部的查询表达式。

查询解析器可以处理通配符、模糊查询以及布尔逻辑等。

解析的查询表达式可以直接用于搜索索引。

4. 相似度计算:在搜索过程中,Lucene根据查询对文档的匹

配程度来计算相似度得分。

相似度计算器使用了一种称为TF-IDF的算法,综合考虑了词频和逆文档频率。

相似度得分决定

了搜索结果的排序。

5. 检索评分:在对搜索结果进行排序时,Lucene使用了一种

称为检索评分的机制。

检索评分根据查询的相似度得分以及其他因素(如文档长度)来计算最终的结果得分。

结果得分决定

了搜索结果的排名。

通过以上原理,Lucene实现了高效的全文搜索功能。

它被广

泛应用于各种信息检索系统中,如搜索引擎、电子邮件过滤等。

lucene算法原理Lucene算法原理Lucene是一个开源的全文检索引擎工具包,采用Java语言编写,被广泛应用于各类信息检索系统中。

它的核心思想是将文本信息转化为可被计算机理解和处理的数据结构,以实现高效的文本搜索和检索功能。

本文将介绍Lucene算法的原理及其核心组成部分。

一、倒排索引Lucene的核心数据结构是倒排索引(Inverted Index),它是一种将文档中的单词映射到文档的数据结构。

传统的索引方式是顺序索引,即根据文档顺序逐个记录单词。

而倒排索引则是根据单词逐个记录文档,将每个单词对应的文档存储在一个倒排列表中。

这种方式可以极大地提高搜索效率,因为它能够快速地找到包含某个特定单词的文档。

二、分词器在构建倒排索引前,需要将文本进行分词处理。

分词器(Tokenizer)将文本切分成一个个独立的词项(Term),并去除停用词等无关信息。

Lucene提供了多种分词器,如标准分词器(StandardTokenizer)、简单分词器(SimpleTokenizer)等,用户也可以自定义分词器以适应不同的需求。

三、索引构建索引构建是指将文档转化为倒排索引的过程。

首先,需要创建一个索引目录(Index Directory),用于存储索引文件;然后,通过Analyzer对文档进行分词处理;最后,将分词结果按照倒排索引的结构存储到索引目录中。

四、搜索过程Lucene的搜索过程主要包括查询解析、查询扩展和评分排序三个步骤。

1. 查询解析:用户输入的查询语句经过查询解析器(Query Parser)处理,将其解析为一个个查询表达式。

查询解析器支持多种查询语法,如布尔查询、模糊查询、范围查询等。

2. 查询扩展:为了提高搜索的准确性和覆盖率,Lucene支持查询扩展功能。

通过分析用户查询的上下文,自动为查询语句添加相关的词项,从而扩展查询范围。

3. 评分排序:Lucene使用TF-IDF算法对搜索结果进行评分排序。

lucene 原理Lucene是一种开源的信息检索(IR)库,它提供了高效、可扩展的全文检索和索引功能。

下面是Lucene的一些详细原理解释:1. 倒排索引(Inverted Index):Lucene使用倒排索引的数据结构来实现全文检索。

传统的索引是从文档到词语的映射,而倒排索引则是从词语到文档的映射。

每个词语都对应一个或多个包含该词语的文档列表,方便快速地找到包含特定词语的文档。

2. 分词(Tokenization):在索引之前,Lucene会将文本分为一系列的词语或术语,这个过程称为分词。

分词的目的是将长文本拆分为可以被索引和搜索的离散单元。

Lucene提供多种分词器,以适应不同语言和需求。

3. 索引结构:Lucene使用多级索引结构以提高检索效率。

索引被划分为多个段(segments),每个段包含一个或多个文档。

每个段内部使用B树(B-tree)或前缀树(Trie)等数据结构来组织词项(term)和文档的映射关系。

4. 倒排列表(Inverted List):倒排列表是倒排索引的核心数据结构,用于存储每个词语在哪些文档中出现。

每个词语对应一个倒排列表,包含了所有出现该词语的文档ID及其相关的词频、位置和其他统计信息。

5. 相关性评分(Relevance Scoring):在执行搜索时,Lucene使用相关性评分算法来确定文档与查询的匹配程度。

默认的相关性评分算法是基于向量空间模型的TF-IDF(Term Frequency-Inverse Document Frequency),它考虑了词项在文档中出现的频率和在整个语料库中的重要性。

6. 查询解析和执行:Lucene使用查询解析器将用户的查询语句解析为内部查询对象。

查询对象由不同的查询类型(如词项查询、范围查询、布尔查询等)组成,并通过布尔运算来组合和匹配文档。

Lucene通过遍历倒排索引和倒排列表来执行查询,并根据相关性评分对文档进行排序。

现实世界中包含两种类型的数据:结构化数据和非结构化数据

结构化数据很容易进行搜索,比如数据库包含的就是结构化数据,可以利用sql进行查询。

但是对于非结构化数据,比如word、txt文件中包含的内容则属于非结构化数据。

要对这些数据进行查找,只能采用顺序扫描的方式,但是顺序扫描的方式速度很慢。

但是在Lucene的世界中,把所有数据都作为字符串来处理,通过Lucene来进行查找,通常会分成两步,一步就是创建索引,另一步就是查找索引。

因为创建好的索引属于结构化数据,所以可以很快的进行查找。

并且Lucene创建索引的方式采用的倒排索引的存储。

每个字符串都指向包含此字符串的文档(Document)链表,称谓倒排表。

采用倒排表进行存储的索引结构就称为倒排索引。

也许有人会说,创建索引的时间会非常长,加上搜索索引的时间不一定会比直接采用顺序查找的速度要快。

这个看法我是很赞同的,我就曾经采用Lucene创建索引,索引一篇word书籍,整整索引了八个小时才完成。

我想如果我打开word直接查找也就是几分钟的事情。

但是我为什么非要建立索引不可呢?原因也很简单,就是顺序扫描每次搜索都会重新执行一次,但是索引只需要索引一次,以后就都可以使用。

这也就是创建索引的根本目的:一次索引,多次使用。

在搜索的过程中,我们往往是想让相关度较高的排在前面,这就会用到权重的概念。

找出词(Term)对文档重要性的过程称为计算词的权重(Weight)的过程。

搜索出来的文档应该是按照权重的顺序进行排列,按从小到大的次序。

计算词的权重会关系到两个参数,一个是词(Term),另一个是文档(Document).

词的权重表示的是此词在此文档中的重要程度,越重要的词有越大的权重,因而在计算文档之间的相关性中将发挥更大的作用。

Lucene搜索过程通常分为三步:创建、索引、搜索

∙被索引的文档用Document对象表示

∙IndexWriter通过函数adDocument将文档添加到索引中,实现创建索引的过程

∙Lucene的索引采用的反向索引。

对应我前面说的反向链表

∙当用户有请求时,Query代表用户的查询语句。

∙IndexSearcher通过函数search搜索 Lucene Index

∙IndexSearcher计算term weight和score并且将结果返回给用户。

再返回给用户数据之前,Lucene还会按照权重进行排序

∙返回给用户的文档集合用TopDocsCollector表示

Lucene中的基本概念:Term (词) Document(文档) Field(字段(和数据库字段类似)) Query(查询) QueryParser(查询解析器) IndexWriter(负责生成索引并存储)

IndexReader(读取硬盘中的索引文件并存入内存) Hits(命中我也不能很好的翻译这个词的意思就是返回搜索的数据)

的基本使用方法

1 public void CreateIndex()//创建索引

2 {

3 Document doc = new Document();

4 doc.Add(new Field("name", "我是郭志奇", Field.Store.YES,

Field.Index.NOT_ANALYZED));

5 doc.Add(new Field("val", "", Field.Store.YES,

Field.Index.ANALYZED));

6 IndexWriter writer = new

IndexWriter(FSDirectory.Open(new DirectoryInfo("")), new Standard Analyzer(), true, IndexWriter.MaxFieldLength.LIMITED);

7 writer.AddDocument(doc);

8 writer.Optimize();

9 writer.Close();

10 }

11

12

13 public void Search(string queryString, int num)//搜索

14 {

15 IndexReader reader = IndexReader.Open("", true);

16 IndexSearcher searcher = new IndexSearcher(reader);

17 //创建查询

18 Analyzer analyzer = new StandardAnalyzer(.Util.Version.LUCENE_29);

19 QueryParser parser = new QueryParser("", analyzer);

20 Query query = parser.Parse(queryString);

21 TopScoreDocCollector collector = TopScoreDocCollector.create(num, true);

22 Hits hits = searcher.Search(query);

23 //以后就可以对获取到的collector数据进行操作

24 for (int i = 0; i < hits.Length(); i++)

25 {

26 Document doc = hits.Doc(i);

27 Field keyFieldVal = doc.GetField("key");

28 string strKey = keyFieldVal.StringValue();//获取到

Field 键值key的值

29 }

30 }

31 public void DeleteIndex()//删除索引

32 {

33

34 IndexWriter writer = new

IndexWriter(FSDirectory.Open(new DirectoryInfo("")), new Standard Analyzer(), true, IndexWriter.MaxFieldLength.LIMITED);

35 writer.DeleteAll();//删除所有的索引

36 writer.DeleteDocuments(new Term("key", "val"));//删除

该词条

37 //注意在执行这个删除操作的时候,其实lucene本身并没有将数据从

硬盘删除,而是保存到了一个单独的后缀名为.del的文件中。

38 mit();//进行提交操作标记为删除的索引会被从硬盘删除

39

40 }

Lucene可以进行的操作方法有很多,分词器也有很多,但是自带的分词器不能很好的支持中文,因此对于有中文的搜索我推荐盘古分词,很好很强大。

还有一点用惯.net的朋友使用的时候会觉得不习惯,因为在.net中是属性的东西,在中是用方法表示的,因为据我所知,在Java中是不存在和.net 中的属性一说的。